聚类分析算法解析

聚类分析算法解析

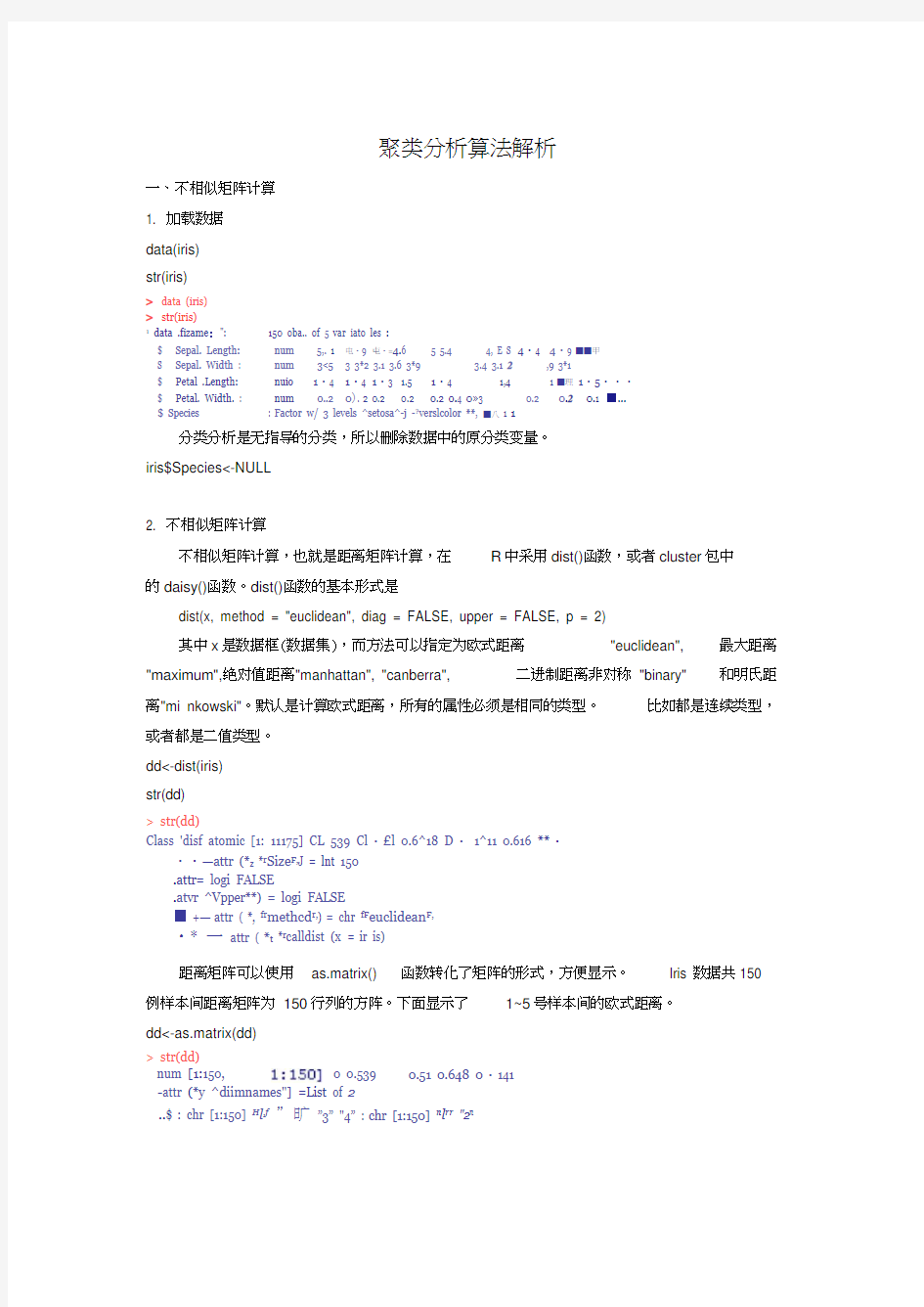

一、不相似矩阵计算 1. 加载数据 data(iris) str(iris)

> data (iris) > str(iris)

1 data .fizame

:": 150 oba.. of 5 var iato les : $ Sepal. Length:

num 5,. 1 电?9 屯?=4.6 5 5.4 4, E S 4?4 4?9 ■■甲 S Sepal. Width : num 3<5 3 3*2 3.1 3.6 3*9

3.4 3.1 2 ,9 3*1

$ Petal .Length: nuio

1?4 1?4 1?3 1.5 1?4

1,4 1 ■理 1?5???

$ Petal. Width. : num 0..2 0). 2 0.2 0.2 0.2 0.4 0?3 0.2 0.2 0.1 ■…

$ Species

: Factor w/ 3 levels ^setosa^-j -?verslcolor **, ■八 1 1

分类分析是无指导的分类,所以删除数据中的原分类变量。 iris$Species<-NULL

2. 不相似矩阵计算

不相似矩阵计算,也就是距离矩阵计算,在 R 中采用dist()函数,或者cluster 包中

的daisy()函数。dist()函数的基本形式是

dist(x, method = "euclidean", diag = FALSE, upper = FALSE, p = 2) 其中x 是数据框(数据集),而方法可以指定为欧式距离 "euclidean",

最大距离 "maximum",绝对值距离"manhattan", "canberra",

二进制距离非对称 "binary"

和明氏距

离"mi nkowski"。默认是计算欧式距离,所有的属性必须是相同的类型。 比如都是连续类型,

或者都是二值类型。 dd<-dist(iris) str(dd)

> str(dd)

Class 'disf atomic [1: 11175] CL 539 Cl ?£l 0.6^18 D ? 1^11 0.616 **?

??—attr (*z *r Size F,J = lnt 150

.attr= logi FALSE

.atvr ^Vpper**) = logi FALSE

■ +— attr ( *, fr methcd r,) = chr fF euclidean F, ?* 一 attr ( *t *r calldist (x = ir is)

距离矩阵可以使用 as.matrix() 函数转化了矩阵的形式,方便显示。

例样本间距离矩阵为 150行列的方阵。下面显示了 1~5号样本间的欧式距离。

dd<-as.matrix(dd)

> str(dd)

-attr (*y ^diimnames"] =List of 2

..$ : chr [1:150] H l ,f ”旷 ”3” "4” : chr [1:150] n l rr "2n

Iris 数据共150

0.51 0.648 0?141

num [1:150, 0 0.539

rr3n "4TF

1.聚类函数

R 中自带的聚类函数是 hclust(),为谱系聚类法。基本的函数指令是

hclust()可以使用的类间距离计算方法包含离差法

大距离法"complete",平均距离法"average" , "mcquitty",中位数法"median" 和重心法 "cen troid"。下面采用平均距离法聚类。 hc <- hclust(dist(iris), method="ave")

Call:

hclust (d - disc (itis) r method = rr ave") Cluster method : average Distance : euclidean

Number of objects : ISO

2.聚类函数的结果

聚类结果对象包含很多聚类分析的结果,可以使用数据分量的方法列出相应的计算结 果。 merge 和height 结果值的前6个。其行编号表示聚 类过程的步骤,X1, X2表示在该步合并的两类,该编号为负代表原始的样本序号,编号为 正代表新合成的类;变量height 表示合并时两类类间距离。

比如第1步,合并的是样本102

和143,其样本间距离是 0.0,合并后的类则使用该步的步数编号代表,即样本 合并为1类。再如第6行表示样本11和49合并,该两个样本的类间距离是 0.1,合并后的

类称为6类。

head (hc$merge,hc$height)

1 2 3 斗 5

dd[l:5z 1:5]

1

0.0000000

0.538516S 0,5099020 0. 6^307^11

1414214 2 S38S15S 0.0000000 □?3000000 0.3316625 0*6032763 3 0.509902 O,3O00OO 0?000000 □?244949 口

?4

0.6480741 0,3316625 CL 2 4^9490 CL 0000000

CL 6480741 5

0.1414214

O.6002763 0.5099020 0 + 6430741 0*0000000

二、用 hclust() 进行谱系聚类法(层次聚类)

结果对象<-hclust

(距离对象,method=方法)

"ward",最短距离法"single", 最

str(hc)

> 3tr(he)

Li3t □£ 7 jnerge he

order labels wetiiod call dist ?method int

S

S

$

-attr r ,

cla33rr )

1:2] -102 -9 -1 -10 -129 -11 -5 -20 -30 -S8 mini [ 1: 149] 0 D.l itit [1:

ISO] 42 15 NULL chu "avtr ■日莎” language hclust (d chr f *eucliciean ,* chr ^hclust"

□ ? 1 0.1 0.1 16 33 34 37 21 32 唱马 24 dist (iris) , method ■ "ave rr )

F 面列出了聚类结果对象 hc 包含的 -102 和-143

XI X2 hc?height

1-102 -143 0.0

2—8 -40 0T1

3-1 -18 0.1

4 "1口-3

5 0.1

-129 -133 0*1

-11一轻0,1

下面显示的聚类结果对象he包含的merge和height结果值的50~55步的结果。第50

步结果表明样本43与13类(即第13步的聚类合类结果)合并。所有的类编号负数j表示原数据的样本编号,正数i表示聚类过程的第i步形成的新类。再如54步,表示聚类过程

第7步和第37步形成的类合并为新类,新类成为第54类,其类间距离是0.2641715。data.frame(hc$merge,hc$height)[50:55]

> data, ft ame (he ge, hcS he ight)[50i 5S,]

XI X2 he ?height

50 -43 13 D.25S1139

51g31 0.2586802

52 -71 180,2618034

53 -6S 16□?263B95B

54737 0.2641715

55 -69 -8S 0,2645751

3. 绘制聚类图

聚类完成后可以使用plot()绘制出聚类的树图。

plot(hc, hang = -1, labels=iris$Species)

Cluster Dendrogram

distfiris)

hclustC ."average"]

4. 指定分类和类中心聚类

通过观察树形图,可见由于数据例很多,使图形很乱,不容易确定合理的分类,为简化图形,使用cutree()来确定最初的分类结果,先初步确定各个样本的最初分类的类数后,然后用hclust()再次聚类,重新聚类后,得出最后的分类结果。

memb <- cutree(hc, k = 10) #确定10个分类

table(memb) #各类中的样本数

> > inenii <- cutree (he, k=ICQ

> #各类中的样本数

> tab le (rtienib)

m enib

1234S67B 9 10

45 曲 1 37 22 4 24 9 1 3

为了进行重新聚类,需要计算各类的类中心的类中心,这里用各类的均向量来代表各类的类中心,计算程序如下。

cent <- NULL

for(k in 1:10){

cent <- rbin d(ce nt, colMea ns(irisSample[memb == k, , drop = FALSE]))

}

>cent <- NULL

>£or(用in 1:10){

4- cent <- rbind (centy colMeans (iris [metrib == k, , drop = FALSE])) > cent

Sepal? Length S epal.Uidth Petal + Length Petal.Width

[Id 4.968889 3*3866671*471111 CL 2466667

[2<] 5,550 口皿4,175000 1,400000 D?2250000

[3d 4.500000 2.3000001+3DOOOO□?3000000

[4门6*235135 2.851351 4*740541 1?5945946

[5 J S.631818 2.69545S 4.059091 1,2 409091

[6 J 5.000000 2.300000 3.275000 1?D250000

[G 541667 3.050000 5*529167 2?12OB333

[9J 7.433333 2,922222 6.266567 1.9888889

[叭] 4.900000 2.500000 4,500000 1?7000000

10J 7.500000 3.7333336*400000 2?2333333有了各类的类中心后,再次使用hclust()函数,从10类起重新开始聚类。hclust()函

数这时需要指定各类的类中心,并采用中心法来聚类。

hc1 <- hclust(dist(ce nt), method = "ce ntroid", members = table(memb)) plot(hc1)

hc1

Cluster Dendrogram

dist^cent) hclust "centroid 1!

再次聚类的树形图就很精简了。从树形图上看,确定为三类是比较合适的。

4.输出最终分类结果

使用cutree()来确定输出各个样本的最后分类。

memb <- cutree(hc, k =3 # 确定 3 个分类 table(memb) #各类中的样本数

> mert±i <- cutree (he, k = 3)

>需各类中的样本数

> mento J cutree(he, k = 3)再各类中的样亦数 > tab Le (merrib )

imeirib 12 3 50 64 36

下面将聚类结果和原始的分类比较可见聚类结果是不错的。

> data(iris)

> tolo le ( iris$Spec ies

me nib

12

3 setosa 50

0 versicolor 0 50 0

vircfinica 0 14 3 6

5. 直接数据距离阵聚类

可以直接输入距离矩阵,然后用 as.dist() 函数转为hclust()可以使

4—I O) 工 ir> o

g

错误率约为14/150=9.33%。