基于NUMA架构的服务器虚拟化性能优化研究综述-黄步添

基于NUMA架构的虚拟化平台的性能优化研究综述

黄步添

摘 要: 随着虚拟化、云计算技术的发展,用户的大型关键业务(如高性能计算业务和大型数据库业务)部署到虚拟化平台。特别以NUMA架构为基础的多核与内存硬件技术,为高性能计算提供了重要的硬件支持,并在传统的非虚拟化平台中广泛应用。在虚拟化环境中,为了有效运行大型关键业务,并使原来多机多核的高性能计算部署在巨型虚拟机中,需要进一步优化服务器的虚拟化性能。因此,基于NUMA架构的服务器虚拟化性能优化,是虚拟化领域一个重要的热点研究方向。本文针对操作系统虚拟化平台,从NUMA服务器架构、虚拟化平台的NUMA感知、基于NUMA架构的虚拟机的调度及迁移、基于NUMA架构的虚拟机性能评测及部署优化等四个方面的最新研究成果进行综述。论文分析了虚拟化平台面临的挑战,指出了虚拟化平台性能优化的难点、分析方法。最后对全文进行总结,提出未来值得进一步研究的方向。

关键词: 虚拟化;NUMA;VMM;Xen;KVM

1 引言

多核系统已经成为数据中心、云计算等的基础架构,越来越多的新的多核系统采用NUMA(Non Uniform Memory Access Architecture)架构。然而,由于数据局部性,片上内存资源的共享竞争,跨节点的数据共享的开销等,使得虚拟化性能问题进一步复杂化。由于物理硬件到虚拟硬件的不正确映射和抽象,程序和系统级的优化在虚拟机内往往不能奏效。

片上共享资源的竞争,严重影响了虚拟化平台所能提供的效率、公平性、QoS(Quality of Service)等特性[19]。现有的研究中,通过硬件技术[24]和程序优化[28]来减轻这种影响;通过一种更加灵活的方法-线程调度,来避免破坏性地使用共享资源[11,12,13,32],且有效地使用[16,51]。处理器上的共享缓存资源的合理利用是提高虚拟化平台性能的重要技术之一。通过使用PMU(Performance Monitor Unit)采集缓存失效率[1,11,12,32]以及内存带宽使用量[16]来量化共享资源的竞争及共享情况。

较早的研究中,更多关注于线程和内存管理策略的NUMA感知[53,54,55]。最近的研究,Dashti提出了内存密集型的应用引起的内存控制器的拥塞和互连问题,是影响性能的更关键因素[26]。目前研究中大多是侧重于内存负载均衡[49]或CPU负载均衡[1,48,52],Tian提出Linux的CFS(Completely Fair Schedule)调度器通过感知NUMA架构,来优化调度算法[41];集成负载表征,Chen提出一种综合性调度算法,避免不必要的任务迁移[52];Blagodurov提出一种命中率启发式算法,来减轻缓存共享引起的性能退化[11]。这些研究未能很好地感知NUMA架构的特点,且未能全局考虑负载均衡所引起的性能开销。

在虚拟化环境下,持锁者抢占(LHP)问题也是影响性能的关键因素。Strazdins提出采用co-scheduling 算法来避免LHP问题[56],但是该算法会带来CPU利用率碎片和不确定的系统延迟[57]。2010年3月,英特尔推出了6核32nm处理器家族Westmere,随它而来的也有一个新的VT-x虚拟化技术,即Pause-Loop Exiting(PLE,暂停-循环退出),它的主要用意就是减少因为循环等待而造成了CPU虚拟资源的浪费。基于PLE机制,Dong提出产生lock waiter任务,来避免CPU周期的浪费,使得提高性能[58]。

近几年的虚拟化研究,Kundu引入机器学习方法,对虚拟机运行指标特征进行分析,来优化虚拟机的放置策略[59];采用人工神经网络,来对虚拟化环境进行评估,来优化系统资源调度[60]。Tickoo基于benchmark vConsolidate,设计了一种虚拟机性能建模方法[61]。

本文从NUMA服务器架构、虚拟化平台的NUMA感知、虚拟机的NUMA调度及迁移、基于NUMA 架构下的虚拟机性能评测及部署优化等四个方面,对基于NUMA架构的虚拟化平台的性能优化问题进行系

统的分析和综述。论文第2节分析了基于NUMA架构的服务器特性及虚拟化性能评测方法;第3节提出了虚拟平台的NUMA感知;第4节提出在NUMA架构下的虚拟机的调度及迁移;第5节提出在NUMA架构下的虚拟机性能评测及部署优化;最后对全文进行总结,提出未来值得进一步研究的方向。

2 基于NUMA架构的服务器

2.1 NUMA体系架构

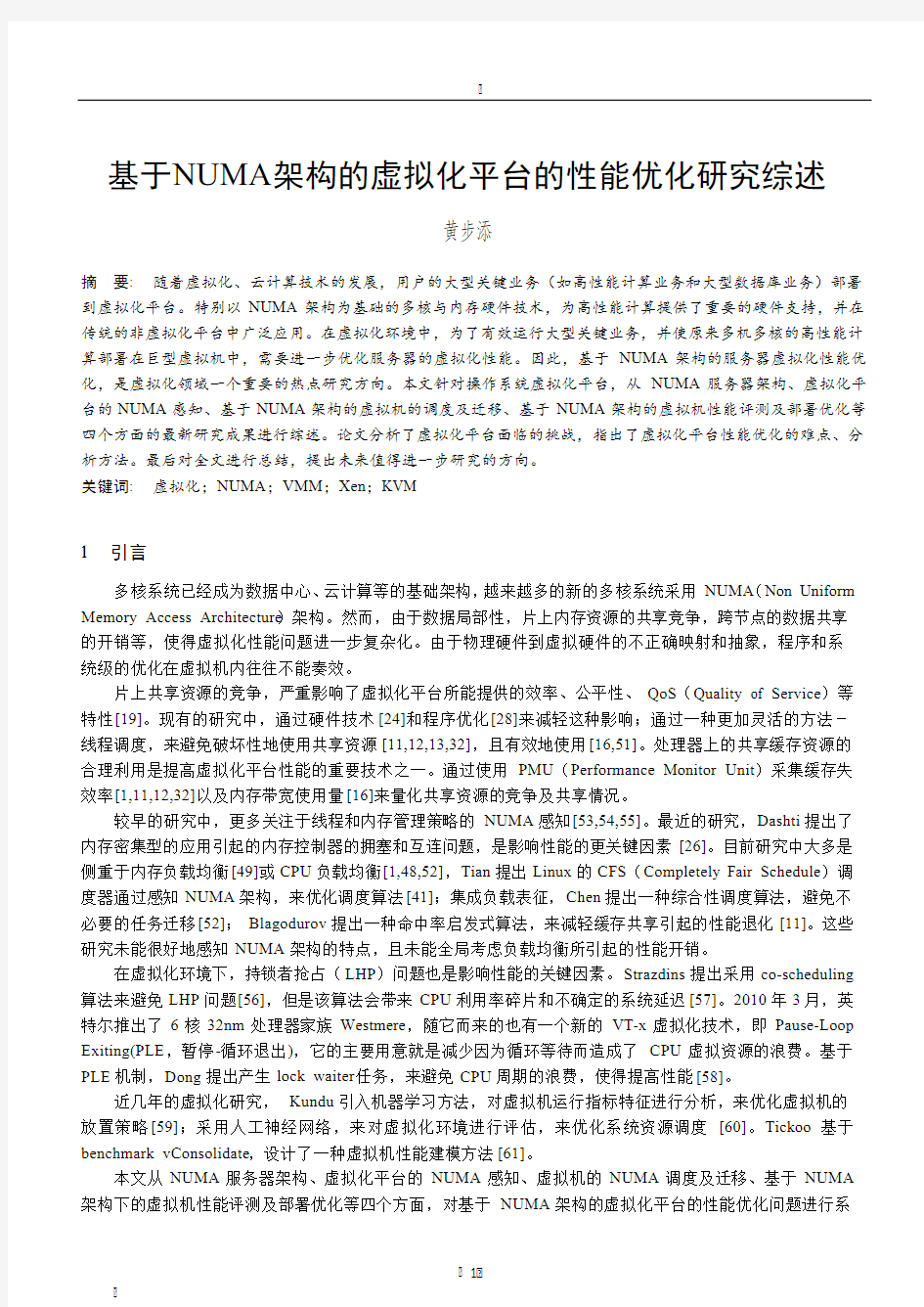

多核系统已经成为科学计算集群,数据中心,云计算的基础平台[89]。SMP(Symmetric Multi-Processing)的问题主要在CPU和内存之间的通信延迟较大、通信带宽受限于系统总线带宽,同时总线带宽会成为整个系统的瓶颈。由此应运而生了NUMA架构,如图1。NUMA(Non-Uniform Memory Access)是起源于AMD Opteron的微架构,同时被Intel Nehalem采用(英特尔志强E5500以上的CPU和桌面的i3、i5、i7均基于此架构)。这也应该是继AMD64后AMD对CPU架构的又一项重要改进。

图1 四个NUMA节点的服务器

NUMA架构将整台服务器分为若干个节点,每个节点上有单独的CPU和内存。内存访问有远端和本地之分。本地的内存访问直接通过内存控制器访问处理器所在节点上的内存,而远端访问则需要通过额外的节点间互联硬件设施。因此远端内存访问的开销要大于本地内存访问的开销。和所有处理器访问内存的时间都一样的UMA不同,NUMA的本地访问开销低,远端访问开销大,因此NUMA架构更依赖于软件层的优化。多核系统的资源共享会带来效率、公平性、QoS等问题。现有业界关注于硬件技术[24]和程序优化[28,63,64]来缓解以上问题。为了提升性能,现代操作系统如linux,会尽量增加本地内存访问,减少节点间内存访问的次数[65,66]。因此软件层的优化,一方面充分利用快速的本地访问,一方面通过分散负载来降低缓存竞争,充分利用更高的内存带宽。不同类型的负载对各种共享资源的使用情况不同,通过合理的组合,应用相应的资源分配策略可以充分利用资源,减小竞争。因此NUMA架构上任务调度的优化空间也要大于UMA架构。

2.2 虚拟化性能评测方法

在性能测试在性能测试和分析工具方面:有一些非虚拟系统中已有的测试工具可以被用来评价和获取虚拟机的性能。如SPEC[72](标准性能评测公司)提供的基准测试程序套件(Benchmark),SPECCPU,SPECJBB,SPECWEB,和原来用于高性能计算的测试程序集HPCC等。在测试的同时还有一些工具可以被用来对虚拟系统的性能进行分析,如Linux下性能分析工具Oprofile的修改版本Xenoprof[73],可以支持虚拟机性能事件分析,此外还有Xen自带的Xentrace,Xentop,Xenperf等工具。

在虚拟化性能评测研究方面:作为对不同虚拟机管理器性能的评测研究,Paul等人分析了Xen,VMware Workstation,User Mode Linux等性能差别[67]。针对虚拟化系统中的典型场景服务器整合场景,VMware公

司的Vikram等人提出了VMmark测试工具集[74]。与之相类似的是SPEC组织的vConsolidate测试集。Apparao 等人分析了虚拟机在多核平台上的虚拟机性能,认为影响多核平台上虚拟机性能的因素有核共享竞争、Cache竞争以及虚拟化开销[75]。针对虚拟机调度中至关重要的动态迁移机制,Huang等人提出了要从迁移时间,宕机时间,迁移过程中的数据传输,迁移虚拟机应用负载的降低来衡量虚拟机迁移的性能,并进行了相关实验[76]。Ye等人利用HPCC评测程序分析了基于Xen的虚拟集群环境下的高性能计算的性能表现特征[77]。

3 虚拟化平台的NUMA感知

3.1 NUMA架构的虚拟化

为了在多个虚拟机之间无缝的共享硬件,虚拟化层为每一个客户虚拟机提供了主机硬件的抽象。客户操作系统依赖于虚拟机器的翻译来访问真实的硬件。对于内存访问来说,客户操作系统所使用的物理地址需要翻译成主机上的物理内存地址。应用程序线程所在的虚拟CPU,需要被映射到物理CPU核上。为了使客户操作系统内的优化起作用,虚拟机到主机之间资源的映射需要反映出主机的NUMA拓扑结构。

虚拟化的硬件结构能否呈现真实的物理结构,会影响系统级的性能优化。ACPI的SRAT(Static Resource Affinity Table)表和SLIT(System Locality Information Table)表能从固件层收集系统资源拓扑信息,因此通过ACPI表获取节点拓扑信息是一个较好的方法[2,3,4]。

为了给虚拟机提供弹性的执行环境,现代的虚拟化平台[67,68]隐藏了物理层的细节,包括内存拓扑结构等。基于xen平台,VMM实现了虚拟的NUMA拓扑结构,则虚拟机可以感知NUMA拓扑结构[3]。VMWare、KVM也实现了这一特性[2,98]。除了NUMA拓扑结构外,Xen从内存迁移、balloon机制等方面增加了NUMA 感知功能[88]。

3.2 VMM的NUMA感知

Jiang[92,93]证明了即使我们知道了各线程之间在同一共享LLC下运行产生的性能下降,也很难作出好的决策。他们将每个需要调度的线程看作一个顶点,两顶点之间边的权重代表这两个线程运行在同一共享LLC运行下的性能下降。因为任何两个线程都有可能被调度在同一个LLC上,所以这就构成了一张完全图。寻找最优的调度方案就转换成了找这个图的最小权重完全匹配。对于每个LLC上两个核的机器,这个问题有很多多项式时间的解法,但是现实场景下很多机器的LLC上都是4个及以上的核,则这个问题会被证明是NP完全的[92]。但是存在一些多项式的近似算法,并提出了相应的算法,并且很接近最优结果[92,93]。

但是,在真实的应用场景中,我们是无法事先获得线程性能下降信息的。因此更加可行的方式就是通过在线采集得到的信息来进行调度。Blagodurov提出了DINO(Distributed Intensity NUMA Online)算法[12],这个算法实在UMA(Unified Memory Architecture)架构上的缓存竞争缓解算法DI(Distributed Intensity)基础上加入NUMA感知而得来的。DI算法管理下的线程性能和“最优”绑定策略下的性能相差不超过3%[19]。这里的“最优”绑定是通过离线将每种绑定策略进行测试,选出性能最优的绑定策略。

和DINO不同,Majo提出了N-MASS(NUMA-Multicore-Aware Scheduling Scheme)算法,可优先减少内存的远端访问[18]。N-MASS算法分为三个步骤。首先,在每个CPU核上,根据MPKI(Miss Per Thousand Instructions)递减对该核上的线程排序。之后将各CPU核上的有序进程列表根据MPKI合并,并且以最大化数据本地访问的原则将线程映射在核上,最后根据各CPU之间的负载情况和进程迁移的开销来调整分配结果,缓解缓存竞争。

4 基于NUMA架构的虚拟机调度及迁移

4.1 基于NUMA架构的虚拟机调度机制

操作系统调度的实施主要有两种方式,一是通过操作系统/虚拟机监视器层,二是用户层。Rao [1]提出的算法在Xen虚拟机监视器中实现,他们认为用户态的调度器会在系统中形成很多“资源孤岛”,因为用户态调度器的决策会覆盖系统调度器的决策,让系统调度器不能通过迁移这些线程来完成负载均衡,而且会使各线程的优先级得不到很好的保证。Blagodurov [12]则认为在用户态实现,会便于调度器的部署使用,是短期内提高NUMA上程序性能的很好的方式[20]。

Rao[1]提出了BRM(Bias Random vCPU Migration)算法。这个算法监视所有节点上的非核开销,找出运行着NUMA敏感信息的vCPU作上标记,以便调度时区别对待。如果发现某节点的非核开销大于其他节点,那么这个节点成为迁移目的节点的概率就会变大。这个算法在迁移决策时引入了随机性以使每次运行结果的差异减小,同时通过随机性避免核之间同步所产生的开销。

除了采用系统调用对线程或vCPU进行调度之外,还在AMD平台上,利用IBS(Instruction-Based Sampling)获取LLC适配访存地址实现了几种不同的内存迁移策略,包括从失配地址开始迁移,以失配地址为中心迁移[12]。通过实验发现,以失配地址为中心迁移的策略在这些策略中有最好的性能。Richard [71]提出一种内存放置和迁移策略,允许系统中存在一个虚拟页的多份物理拷贝。这种策略根据访存历史,支持迁移和复制两种操作,但如果没有硬件支持,那么通过软件收集访存历史会造成较大开销。VMware的ESX Server也类似的策略[70],它合并客户进程上相同的页,并且根据需要在每个节点上放置一份共享页的拷贝以减小内存远端访问。

4.2 基于NUMA架构的虚拟机迁移

现有的实时迁移机制更多关注于将虚拟机从一个主机迁移到另一个主机。在虚拟机动态迁移过程中,预拷贝[83]、后拷贝[84]、内存压缩[85]、跟踪回放[86]、实时组迁移[87]等技术,主要关注于如何减少内存数据的转移。Pre-copy技术尽量地减少宕机时间,并且不影响服务的运作;post-copy技术减少总的迁移时间,且让程序能够持续地执行;跟踪回放技术通过日志跟踪源主机,并采用同步算法来协调运行的源和目标虚拟机,使得到一个一致的状态;内存压缩技术通过批量压缩需要迁移的内存页,来减少内存迁移量;跟踪回放技术;实时组迁移技术提出如何将部署于同一台物理机器的一组VM并发进行动态迁移。

目前业界一般只关注迁移的速度以及宕机时间,未关注迁移后的虚拟机性能。特别是若迁移的目的主机是基于NUMA架构,则需考虑迁移后的虚拟机保持NUMA拓扑结构。目前,xen官方做了部分工作,但实际效果不好[88]。

在NUMA架构的物理机内部,虚拟机在节点间的迁移,VMware[91]提出了将虚拟机的内存从一个NUMA节点迁移到另一个NUMA节点的方法。一旦虚拟机被迁移到一个新的节点,使用率最高的页面获得最高优先级,首先迁移该页面,从而尽快使这些页面成为本地内存。

5 基于NUMA架构的虚拟机性能评测及部署优化

5.1 基于NUMA架构的虚拟化性能评测

调度器为了作出优化的调度决策,必须要合适的指标用来预测程序的性能。现有大多数研究着眼于LLC(Last Level Cache)上竞争的影响[11,6]。若要找到合适的指标来预测程序的性能,就要研究影响程序性能的因素。Ali [2]提出了一种调度算法,简单地采用LLC失配率作为指标判断程序对共享资源的占用情况。因为LLC失配率不单说明了程序在LLC上的行为,还反映了程序对整个内存系统的影响。通过实验发现,LLC失配率相近的程序对于共享LLC上同时运行的程序的影响程度没有明确的大小关系,但是如果两个程序LLC失配率相差较大,那么LLC失配率更大的程序一般对共享LLC上一同运行的程序的影响比LLC失

配率较小的程序程度要大。更加复杂一些的指标如SDP(Stack Distance Profiles) [8]和MRC(Miss Rate Curve)。SDP相当于一个直方图,每当发生cache命中,则在相应的LRU stack位置的计数器加一。这样,在n路关联缓存中获取的SDP信息可以预测程序在(n-1)路关联缓存中的额外cache失配。而失配率和cache大小的关系曲线就是MRC。Dhruba Chandra提出了一种算法通过将两个程序的SDP组合成一个来预测两个程序在共享LLC上一起运行时的额外cache失配情况[90],而且通过模拟器证实了这个算法是十分精确的,虽然这两种技术精确度十分的高,但是在现有的系统上并不容易在线获得[24]。

Blagodurov[12,94]还提出了一种方式来定量地计算出NUMA架构的物理机上的LLC、内存控制器、节点互联装置上的竞争所造成的开销。他们通过将两个基准测试程序以不同的绑定策略运行在两个节点的NUMA机器上。通过对比不同绑定方案性能的差异,来分析不同因素所造成的开销。但是这样的量化方式忽略了各因素之间的相互影响。

Majo[18]提出了NUMA penalty这个指标,用于指示程序在内存远端访问下的性能下降情况。

NUMA penalty=CPI remote/CPI local

其中CPI local指程序本地运行时的CPI(cycles per instruction),CPI remote指程序所用CPU和数据在不同节点上时的CPI。

Rao[1]认为引起程序性能下降的因素主要有三个:数据局部性,LLC竞争,共享引起的开销;并实现了一个基准测试来研究这三个因素。通过对因素单独和组合的测试,他们发现这三个因素之间有着复杂的相互作用,而且这三个因素在不同情况下分别起主导作用。如果仅考虑其中一个因素则不能很好地提高程序的性能,甚至会引起性能下降。Rao提出了“非核”开销的概念,即对不在CPU核上存储子系统的访问所造成的开销。对于同构的NUMA机器来说,每个核的配置都是相同的,那么不同的线程到核的映射所产生的不同性能只与非核开销有关。这个非核开销就包括了非核系统上的停顿周期。

5.2 基于NUMA架构的虚拟机部署优化

虚拟机部署优化是多虚拟机环境管理的核心问题。虚拟机部署优化的基本场景是:在多虚拟化场景中,虚拟机按照用户需求定制。随着虚拟机负载变化,整个集群的资源使用情况发生变化,系统动态地调整虚拟机在物理机的放置位置,实现整个集群的节能和动态优化。

Hermanier[78]针对调度决策的产生和调度操作的规划分别进行了讨论。在调度决策阶段,将虚拟机部署问题抽象成背包数量改变的二维多背包问题,对于背包数量固定的情况并利用二维背包动态规划算法进行求解,同时遍历不同的背包数量,最后找到一个背包数量最少且可以同时放下所有物品的情况。在求解过程中通过优化策略进行剪枝,如限制优化目标的范围,只针对背包数量减少的新情况求解等。

Li[80]等人面向节能的考虑,采用动态迁移技术实现虚拟机的动态部署,从而使运行的物理机数量最少。文中考虑了负载到达,负载离开,负载大小变化三类事件。负载到达时,采取修改过的Best-fit贪心部署虚拟机。负载离开时,对离开负载所在的物理机的所有虚拟机做负载到达操作。负载变化时,按照负载离开,以及一个变化后的负载进行处理。文中只是简单地通过Best-fit算法得到部署结果,但是在没有考虑每次调度过程中,由于迁移带来的影响。而且Best-fit的贪婪策略也不能保证全局上的部署最优。

特别是在NUMA架构下,Xen官方社区提出基于NUMA感知的虚拟机放置策略[97],根据NUMA节点的内存负载、vCPU复用比来确定虚拟机的放置。Prerna等人提出在NUMA物理机内部在虚拟机运行过程中,基于NumaSched和AutoNUMA来优化虚拟机的资源布局[27,95,96]。

总而言之,在NUMA架构下,基于集群的负载均衡,这就需要考虑NUMA架构特点,同时虚拟机迁移到目的节点时需保持vNUMA。

6 结语

本文综述了基于NUMA架构的虚拟化平台的性能优化技术,从NUMA架构特性、虚拟化平台的NUMA

感知、虚拟机的调度及迁移、虚拟机性能评测及部署优化等四个方面进行系统阐述。多核架构的发展,特别是NUMA架构,虚拟化平台性能优化带来诸多挑战。这就需要虚拟化平台支持NUMA拓扑结构,同时CPU调度时要支持NUMA亲和性;虚拟机迁移到目标主机时,要支持动态调节NUMA拓扑结构。为了更进一步提升NUMA架构下的虚拟化平台性能,我们需要优化虚拟机的初始放置,同时在运行过程中,动态调节虚拟机的部署。

基于NUMA架构的服务器虚拟化性能优化技术的研究目前还处在刚刚兴起的阶段,大多数的研究成果是最近几年才发表的,还存在很多问题需要进一步解决。下面我们根据对前人工作的总结,并结合自己的理解,给出未来虚拟化平台的性能优化领域中六个值得进一步研究的方向:

(1)基于NUMA架构的大页内存技术。在运行一些benchmark(CG, UA,SPECjbb)时,发现虚拟机的性能下降。我们发现导致其性能下降的因素是hot page,由于其访问内存的特征导致大量的内存访问都集中在了极少数的几个内存大页上面,PAMUP上升的很快,又由于这样的大页个数很少,甚至少于NUMA结点数,这就导致有的内存结点很繁忙,有的内存结点很空闲,即一些结点内部的流量过载。因此我们需要从大页机制的评测、动态开关大页机制的条件与算法、虚拟机的NUMA架构和大页机制影响等方面研究。

(2)vNUMA拓扑结构自适应调整。通过虚拟机初始放置,根据HVM guest内存的物理布局,自动分配物理资源给guest OS,呈现给guest OS NUMA架构。由于系统负载均衡机制,系统将某个节点上的虚拟机迁移到相对空闲的节点,这将破坏虚拟机的NUMA拓扑结构。同时由于内存复用机制,虚拟机的内存通过balloon机制会导致跨节点的现象,呈现给guest OS的虚拟NUMA架构与实际的物理NUMA架构会呈现不一致。因此需要通过一种虚拟NUMA的动态调节机制,使得呈现给VM的虚拟NUMA拓扑结构与实际的物理拓扑结构保持对应关系。

(3)基于NUMA架构的NUMA节点间的负载均衡。在虚拟化平台下,现有的业务应用部署在虚拟机内部,依托VM的客户机操作系统(Guest OS)运行。Guest OS不同于传统的裸机上的OS,无法感知NUMA 的存在,无法发挥NUMA架构的优势。现有的VMM或Hypervisor对于无NUMA感知的资源调度,导致虚拟机随vCPU核数增加,性能非线性增长。原因在于1)NUMA架构下,访问remote node内存访问延时较大;2)没有Guest NUMA支持,Guest OS不能为vCPU最优分配资源,可能导致访问远端节点的内存,导致业务性能下降。因此需要提供负载均衡机制,能够感知NUMA架构,根据物理node的CPU和MEM 的利用率,VM的vCPU和VMEM QoS,在负载高的情况下,把vCPU从一个node迁移至另一个node的物理CPU上运行。

(4)基于NUMA架构的Cache共享研究。多核平台的缓存和内存结构特点对多核虚拟化性能的影响越来越大。降低内存访问时间和有效利用缓存资源对虚拟化环境下系统性能的提高起到至关重要的作用。主流的多核平台架构中,多个CPU核共享LLC,LLC的容量越来越大,如何高效利用共享LLC成为多核虚拟化环境下亟待解决的问题。在虚拟机调度时,考虑共享Cache对VM调度的影响,利用共享Cache提升系统整体性能,从而解决多核(众核)处理器架构对虚拟化平台带来的性能冲击。

(5)基于NUMA架构的vCPU调度研究。目前的研究主要考虑局部性(增加访问本地节点概率),但实验发现NUMA下影响性能的主要因素是控制器拥塞和节点间通信拥塞。可通过量化建模,根据不同指标采用自适应的调度策略。基于多核架构下,多线程并行负载越来越常见,在虚拟化调度时出现一个线程运行一个挂起,造成性能低下(同步延迟很高)。通过控制抢占:VMM监控到IPI时,立刻唤醒receiver vCPU,保证sender vCPU一段时间不会被挂起;控制vCPU-pCPU分配:某个VM而言,尽量每个pCPU上只有一个vCPU,同时又能避开负载高的pCPU。在多核虚拟机中,系统通常为该虚拟机配置多个vCPU,多台虚拟机的vCPU共享物理多核处理器的pCPU。在一般情况下,hypervisor为vCPU映射合适的pCPU给虚拟机执行任务,pCPU的资源得到充分的利用。但是在某些任务调度过程中,多核虚拟机的众多vCPU访问共享资源时会产生极大的同步开销,从而对多核虚拟化平台带来性能上的不利影响。这就需要怎样通过识别持锁的vCPU,当出现等锁vCPU时优先调度持锁vCPU,持锁vCPU释放锁后,优先调度等锁vCPU。

(6)基于NUMA架构的内存复用机制研究。目前的研究中涉及通过修改balloon机制,使得不会从某些application中偷取内存,来提升自管理内存的application(比如数据库与JVM)的性能。目前内存复用机制,未很好地感知NUMA架构,可能会出现跨节点的情况,导致VM访问的内存或共享页处于远端访问。同时需要考虑QoS。

References:

[1] Rao, J.Wang, K.Zhou, X.Xu, C.Z."Optimizing Virtual Machine Scheduling in NUMA Multicore Systems," HPCA,2013.

[2] Ali, Q., et al. (2012). Performance Evaluation of HPC Benchmarks on VMware’s ESXi Server. Euro-Par 2011: Parallel Processing

Workshops, Springer.

[3] Rao, D. S. and K. Schwan (2010). vnuma-mgr: Managing vm memory on numa platforms. High Performance Computing (HiPC),

2010 International Conference on, IEEE.

[4] Bae, C. S., et al. (2012). Dynamic adaptive virtual core mapping to improve power, energy, and performance in multi-socket

multicores. Proceedings of the 21st international symposium on High-Performance Parallel and Distributed Computing, ACM. [5] Majo, Z. and T. R. Gross (2011). Memory system performance in a NUMA multicore multiprocessor. Proceedings of the 4th

Annual International Conference on Systems and Storage, ACM.

[6] McCurdy, C. and J. Vetter (2010). Memphis: Finding and fixing NUMA-related performance problems on multi-core platforms.

Performance Analysis of Systems & Software (ISPASS), 2010 IEEE International Symposium on, IEEE.

[7] Broquedis, F., et al. (2010). "ForestGOMP: an efficient OpenMP environment for NUMA architectures." International Journal of

Parallel Programming 38(5-6): 418-439.

[8] Gaud, F., et al. (2011). Application-Level Optimizations on NUMA Multicore Architectures: the Apache Case Study, Research

Report RR-LIG-011, LIG, Grenoble, France.

[9] Lachaize, R., et al. (2012). MemProf: a memory profiler for NUMA multicore systems. USENIX ATC.

[10] Pilla, L. L., et al. (2011). "Improving parallel system performance with a NUMA-aware load balancer." INRIA-Illinois Joint

Laboratory on Petascale Computing, Urbana, IL, Tech. Rep. TR-JLPC-11-02

[11] Blagodurov, S., et al. (2010). "Contention-aware scheduling on multicore systems." ACM Transactions on Computer Systems

(TOCS) 28(4): 8.

[12] Blagodurov, S., et al. (2010). A case for NUMA-aware contention management on multicore systems. Proceedings of the 19th

international conference on Parallel architectures and compilation techniques, ACM.

[13] Ebrahimi, E., et al. (2010). Fairness via source throttling: a configurable and high-performance fairness substrate for multi-core

memory systems. ACM Sigplan Notices, ACM.

[14] Banikazemi, M., et al. (2008). PAM: a novel performance/power aware meta-scheduler for multi-core systems. High Performance

Computing, Networking, Storage and Analysis, 2008. SC 2008. International Conference for, IEEE.

[15] Mutlu, O. and T. Moscibroda (2007). Stall-time fair memory access scheduling for chip multiprocessors. Proceedings of the 40th

Annual IEEE/ACM International Symposium on Microarchitecture, IEEE Computer Society.

[16] Tam, D., et al. (2007). "Thread clustering: sharing-aware scheduling on SMP-CMP-SMT multiprocessors." ACM SIGOPS

Operating Systems Review 41(3): 47-58.

[17] Thekkath, R. and S. J. Eggers (1994). Impact of sharing-based thread placement on multithreaded architectures. Computer

Architecture, 1994., Proceedings the 21st Annual International Symposium on, IEEE.

[18] Majo, Z. and T. R. Gross (2011). Memory management in NUMA multicore systems: trapped between cache contention and

interconnect overhead. ACM Sigplan Notices, ACM.

[19] Zhuravlev, S., et al. (2010). Addressing shared resource contention in multicore processors via scheduling. ACM SIGARCH

Computer Architecture News, ACM.

[20] Zhuravlev, S., et al. (2012). "Survey of scheduling techniques for addressing shared resources in multicore processors." ACM

Computing Surveys (CSUR) 45(1): 4.

[21] Kulkarni, A., et al. (2012). Optimizing latency and throughput for spawning processes on massively multicore processors.

Proceedings of the 2nd International Workshop on Runtime and Operating Systems for Supercomputers, ACM.

[22] Knauerhase, R., et al. (2008). "Using OS observations to improve performance in multicore systems." Micro, IEEE 28(3): 54-66.

[23] Lama, P. and X. Zhou (2012). NINEPIN: Non-invasive and energy efficient performance isolation in virtualized servers.

Dependable Systems and Networks (DSN), 2012 42nd Annual IEEE/IFIP International Conference on, IEEE.

[24] Qureshi, M. K., et al. (2006). A case for MLP-aware cache replacement. ACM SIGARCH Computer Architecture News, IEEE

Computer Society.

[25] An, D., et al. (2012). Reducing last level cache pollution in NUMA multicore systems for improving cache performance.

Computational Science and Its Applications–ICCSA 2012, Springer: 272-282.

[26] Dashti, M., et al. (2013). Traffic management: A holistic approach to memory placement on numa systems. Proceedings of the

eighteenth international conference on Architectural support for programming languages and operating systems, ACM.

[27] Saxena, P. and V. Srinivasan (2012). Optimizing Virtual Machine Resource Placement on Multi-Socket Platforms. Cloud

Computing in Emerging Markets (CCEM), 2012 IEEE International Conference on, IEEE.

[28] Majo, Z. and T. R. Gross (2012). Matching memory access patterns and data placement for NUMA systems. Proceedings of the

Tenth International Symposium on Code Generation and Optimization, ACM.

[29] Broquedis, F., et al. (2009). Dynamic task and data placement over NUMA architectures: an OpenMP runtime perspective.

Evolving OpenMP in an Age of Extreme Parallelism, Springer: 79-92.

[30] Jeannot, E. and G. Mercier (2010). Near-optimal placement of MPI processes on hierarchical NUMA architectures. Euro-Par

2010-Parallel Processing, Springer: 199-210.

[31] Su, C., et al. (2012). "Critical path-based thread placement for NUMA systems." ACM SIGMETRICS Performance Evaluation

Review 40(2): 106-112.

[32] Guo, F., et al. (2007). A framework for providing quality of service in chip multi-processors. Proceedings of the 40th Annual

IEEE/ACM International Symposium on Microarchitecture, IEEE Computer Society.

[33] Li, T., et al. (2009). "Efficient and scalable multiprocessor fair scheduling using distributed weighted round-robin." ACM Sigplan

Notices 44(4): 65.

[34] Heo, J., et al. (2009). Memory overbooking and dynamic control of xen virtual machines in consolidated environments. Integrated

Network Management, 2009. IM'09. IFIP/IEEE International Symposium on, IEEE.

[35] Iyer, R., et al. (2007). QoS policies and architecture for cache/memory in CMP platforms. ACM SIGMETRICS Performance

Evaluation Review, ACM.

[36] Rao, J., et al. (2011). DynaQoS: Model-free self-tuning fuzzy control of virtualized resources for QoS provisioning. Quality of

Service (IWQoS), 2011 IEEE 19th International Workshop on, IEEE.

[37] Lu, P. and K. Shen (2007). Virtual machine memory access tracing with hypervisor exclusive cache. USENIX Annual Technical

Conf.(USENIX).

[38] Salomie, T.-I., et al. (2013). Application level ballooning for efficient server consolidation. Proceedings of the 8th ACM European

Conference on Computer Systems, ACM.

[39] Mishra, V. K. and D. Mehta (2013). Performance enhancement of NUMA multiprocessor systems with on-demand memory

migration. Advance Computing Conference (IACC), 2013 IEEE 3rd International, IEEE.

[40] Lorenzo-Castillo, J. A., et al. (2013). "A flexible and dynamic page migration infrastructure based on hardware counters." The

Journal of Supercomputing: 1-19.

[41] Tian, H., et al. (2013). Analysis and Optimization of CFS Scheduler on NUMA-Based Systems. Emerging Technologies for

Information Systems, Computing, and Management, Springer: 181-189.

[42] Koufaty, D., et al. (2010). Bias scheduling in heterogeneous multi-core architectures. Proceedings of the 5th European conference

on Computer systems, ACM.

[43] Merkel, A., et al. (2010). Resource-conscious scheduling for energy efficiency on multicore processors. Proceedings of the 5th

European conference on Computer systems, ACM.

[44] Blagodurov, S. and A. Fedorova (2011). User-level scheduling on NUMA multicore systems under Linux. Proc. of Linux

Symposium.

[45] Blagodurov, S. and A. Fedorova (2012). Towards the contention aware scheduling in HPC cluster environment. Journal of Physics:

Conference Series, IOP Publishing.

[46] Pilla, L. L., et al. (2012). A Hierarchical Approach for Load Balancing on Parallel Multi-core Systems. Parallel Processing (ICPP),

2012 41st International Conference on, IEEE.

[47] Pilla, L. L., et al. (2012). Asymptotically Optimal Load Balancing for Hierarchical Multi-Core Systems. Parallel and Distributed

Systems (ICPADS), 2012 IEEE 18th International Conference on, IEEE.

[48] Olivier, S. L., et al. (2012). "OpenMP task scheduling strategies for multicore NUMA systems." International Journal of High

Performance Computing Applications 26(2): 110-124.

[49] Zhao, W., et al. (2009). "Dynamic memory balancing for virtual machines." ACM SIGOPS Operating Systems Review 43(3):

37-47.

[50] Vikranth, B., et al. (2013). "Topology Aware Task stealing for on-Chip NUMA Multi-Core Processors." Procedia Computer

Science 18: 379-388.

[51] Bellosa, F. and M. Steckermeier (1996). "The performance implications of locality information usage in shared-memory

multiprocessors." Journal of Parallel and Distributed Computing 37(1): 113.

[52] Chen RZ, et al. (2013). " Comprehensive Scheduling Algorithm for Asymmetric Multi-Core Processors." Journal of Software

24(2).

[53] Bolosky, W., et al. (1989). Simple but effective techniques for NUMA memory management. ACM SIGOPS Operating Systems

Review, ACM.

[54] Brecht, T. (1993). On the importance of parallel application placement in NUMA multiprocessors. Symposium on Experiences

with Distributed and Multiprocessor Systems (SEDMS IV).

[55] LaRowe Jr, R. P., et al. (1992). "Evaluation of NUMA memory management through modeling and measurements." Parallel and

Distributed Systems, IEEE Transactions on 3(6): 686-701.

[56] Strazdins, P. and J. Uhlmann (2004). A comparison of local and gang scheduling on a beowulf cluster. Cluster Computing, 2004

IEEE International Conference on, IEEE.

[57] Lee, W., et al. (1997). Implications of I/O for gang scheduled workloads. Job Scheduling Strategies for Parallel Processing,

Springer.

[58] Dong, Y., et al. (2010). Improving virtualization performance and scalability with advanced hardware accelerations. Workload

Characterization (IISWC), 2010 IEEE International Symposium on, IEEE.

[59] Kundu, S., et al. (2010). Application performance modeling in a virtualized environment. High Performance Computer

Architecture (HPCA), 2010 IEEE 16th International Symposium on, IEEE.

[60] Kundu, S., et al. (2012). "Modeling virtualized applications using machine learning techniques." ACM Sigplan Notices 47(7):

3-14.

[61] Tickoo, O., et al. (2010). "Modeling virtual machine performance: challenges and approaches." ACM SIGMETRICS Performance

Evaluation Review 37(3): 55-60.

[62] Waldspurger, C. A. (2002). "Memory resource management in VMware ESX server." SIGOPS Oper. Syst. Rev. 36(SI):

181-194.Chen Kang, Zheng Wei-Min. Cloud computing: system instances and current research. Journal of Software, 2009, 20(5):1337-1348

[63] Q. Yi, “Automated programmable control and parameterization of compiler optimizations,” in Proc. CGO, 2011.

[64] E. Z. Zhang, Y. Jiang, and X. Shen, “Does cache sharing on modern CMP matter to the performance of contemporary

multithreaded programs?” in Proc. of PPoPP, 2010.

[65] R. Bryant and J. Hawkes. OLS ’03 : Linux Scalability for Large NUMA Systems. In Ottawa Linux Symposium,2003.

[66] C. Lameter. Local and Remote Memory : Memory in a Linux/NUMA System. In https://www.360docs.net/doc/1215672028.html,, 2006.

[67] P. Barham, B. Dragovic, K. Fraser, S. Hand, T. Harris,A. Ho, R. Neugebauer, I. Pratt, and A. Warfield. Xen and the Art of

Virtualization. In SOSP ’03: Proceedings of the Nineteenth ACM Symposium on Operating Systems Principles, pages 164–177, New York, NY, USA, 2003.ACM.

[68] S. Devine, E. Bugnion, and M. Rosenblum. Virtualization System including a Virtual Machine Monitor for a Computer with a

Segmented Architecture. In US Patent,6397242, Oct. 1998.

[69] Kundu, S., et al. (2012). "Modeling virtualized applications using machine learning techniques." ACM Sigplan Notices 47(7):

3-14.

[70] VMware ESX Server 2 NUMA Support.https://www.360docs.net/doc/1215672028.html,/pdf/esx2NUMA.pdf

[71] Richard P, LaRowe Jr, Carla Schlatter Ellis, and Mark A.Holliday. Evaluation of numa memory management through modeling

and measurements. Parallel and Distributed Systems, IEEE Transactions on, 3(6):686—701,1992.

[72] SPEC. https://www.360docs.net/doc/1215672028.html,

[73] A.Menon, J.R.Santos, Y.Turner, G.(John)Janakiraman, and W.Zwaenepoel. Diagnosing performance overheads in the

xeDiagnosing performance overheads in the xen virtual machine environment. Proceedings of the 1st ACM/USENIX international conference on Virtual Proceedings of the 1st ACM/USENIX international conference on Virtual execution environments- VEE'05 ,pp.13.

[74] Vikram Makhija et al. VMmark: A Acalable Benchmark for Virtualized Systems.2006

[75] P.Apparao, R.lyer, and D.Newell. Towards modeling & analysis of consolidated CMP servers. ACM SIGARCH Computer

Architecture News, vol. 36, May. 2008,pp. 38

[76] Clark, C. and Fraser, K. and Hand, S. and Hansen, J.G. and Jul, E. and Limpach, C. and Pratt, I. and Warfield, A. A benchmark of

live migration of virtual machines

[77] K. Ye, X. Jiang, S. Chen, D. Huang, and B. Wang. Analyzing and Modeling the Performance in Xen-Based Virtual Cluster

Environment. 2010 12th IEEE International Conference on High Performance Computing and Communications, 2010, pp. 273-280 [78] F.Hermenier, X.Lorca, J.M. Menaud, G.Muller, and https://www.360docs.net/doc/1215672028.html,wall. Entropy: a consolidation manager for clusters. Proceedings of the

2009 ACM SIGPLAN/SIGOPS international conference on Virtual execution environments,2009, pp.41-50

[79] Hyser, C., et al. (2007). "Autonomic virtual machine placement in the data center." Hewlett Packard Laboratories, Tech. Rep.

HPL-2007-189: 2007-2189.

[80] Bo Li, Jianxin Li, Jinpeng Huai, Tianyu Wo, Qin Li, Liang Zhong. EnaCloud: An Energy-saving Application Live Placement

Approach for Cloud Computing Environments. IEEE International Conference on Cloud Computing,2009.

[81] Choi, H. W., et al. (2008). Autonomous learning for efficient resource utilization of dynamic vm migration. Proceedings of the

22nd annual international conference on Supercomputing, ACM.

[82] Wood, T., et al. (2007). Black-box and Gray-box Strategies for Virtual Machine Migration. NSDI.

[83] C. Clark, K. Fraser, S. Hand, J. G. Hansen, E. Jul, C. Limpach, I. Pratt, and A.Warfield. Live migration of virtual machines. In

Proceedings of NSDI, pages 273–286, 2005.

[84] M. R, Hines, and K. Gopalan. Post-copy based live virtual machine migration using adaptive pre-paging and dynamic

self-ballooning. In Proceedings of VEE, pages 51–60, 2009.

[85] H. Jin, L. Deng, and S. Wu. Live virtual machine migration with adaptive memory compression. In Proceedings of CLUSTER,

pages 1–10, 2009.

[86] H. Liu, H. Jin, and X. Liao. Live migration of virtual machine based on full system trace and replay. In Proceedings of HPDC,

pages 101–110, 2009.

[87] U. Deshpande, X. Wang, and K. Gopalan. Live gang migration of virtual machines. In Proceedings of HPDC, pages 135–146,

2011.

[88] https://www.360docs.net/doc/1215672028.html,/wiki/Xen_Roadmap/4.4

[89] Intel Corporation. Intel 64 and IA-32 Architectures Software Developer’s Manual.2009.

[90] Dhruba Chandra, Fei Guo, Seongbeom Kim, Solihin, Y. Predicting inter-thread cache contention on a chip multi-processor

architecture. High-Performance Computer Architecture, 2005. HPCA-11. 11th International Symposium on, pages 340-351.IEEE,2005.

[91] VMware, Inc., Palo Alto, CA(US) . System and method for improving memory locality of virtual https://www.360docs.net/doc/1215672028.html, 2011/8037280 B2

[92] Yunlian Jiang, Xipeng Shen, Jie Chen, and Rahul Tripathi. Analysis and approximation of optimal co-scheduling on chip

multiprocessors. In Proceedings of the 17th international conference on Parallel architectures and compilation techniques, pages 220-229. ACM, 2008.

[93] Kai Tian, Yunlian Jiang, and Xipeng Shen. A study on optimally co-scheduling jobs of different lengths on chip multiprocessors.

In Proceedings of the 6th ACM conference on Computing frontiers, pages 41-50. ACM, 2009.

[94] Liu, M. and T. Li (2014). Optimizing virtual machine consolidation performance on NUMA server architecture for cloud

workloads. Computer Architecture (ISCA), 2014 ACM/IEEE 41st International Symposium on, IEEE.

[95] P. Zjilstra, https://www.360docs.net/doc/1215672028.html,/lkml/2011/11/17/204 , Linux Kernel Mailing List, 2011.

[96] A. Arcangeli https://https://www.360docs.net/doc/1215672028.html,/lkml/2012/3/26/398, [patch] Linux Kernel Mailing List 2012.

[97] Scheduling and Placement of NUMA in Xen System, https://www.360docs.net/doc/1215672028.html,/wiki/Xen_Numa_Scheduling_and_Placement

[98] https://www.360docs.net/doc/1215672028.html,/page/Main_Page

服务器虚拟化解决方案

服务器虚拟化解决方案 一、Citrix XenServer服务器虚拟化解决方 案 方案综述 服务器虚拟化的业务及应用需求 随着企业业务的飞速发展,越来越多的业务系统依赖于数据中心的支撑,其中包括财务系统、OA系统、ERP系统和各种管理系统等等。在企业数据中心的建设过程中,随着各种业务系统的建设和更新换代,每个业务系统都占用了大量的新旧服务器,其硬件利用率低下、管理复杂、运行成本居高不下等问题正逐渐显现。 这是传统的数据中心建设模式的纵向结构所造成的。由于传统服务器的硬件和操作系统的绑定,使得服务器之间无法复用计算资源,只能通过为不同业务单元分别堆加服务器来满足业务要求,随着企业规模发展,显然传统模式的数据中心无法在快速响应和节省成本之间找到平衡点。 虚拟化技术的出现解决了这一矛盾,服务器虚拟化使得操作系统不再直接安装在硬件上,业务服务器成为逻辑服务器概念,形成了逻辑层和物理层分离的横向结构,不仅可以方便地复用硬件资源,管理效率也大大提高。同时Citrix结合服务器虚拟化、应用虚拟化和流技术,提出了新一代动态数据中心的建设模式,能够根据不同业务模块的资源消耗,自动地分配硬件资源,从而最大限度满足企业级数据中心的高效率、高性价比和自动化管理等要求。 由于业务系统的要求,目前企业数据中心越来越多地采用X86服务器,无论是系统扩展性还是系统可靠性都需要通过服务器虚拟化技术进行增强,目前这些服务器部署的主要问题包括: 利用效率低下,由于每种业务运行都有高峰和低谷的周期,服务器不得 不分别按照峰值配备,大量时间运行空闲,再加上可靠性考虑分别配置 双机,不得不牺牲更多的计算资源。

集团虚拟化平台方案建议书

集团虚拟化平台方案建议书

目录 第一章概述 (4) 1.1项目背景 (4) 1.2项目目标 (5) 第二章平台建设方案 (6) 2.1虚拟化平台现状分析 (6) 2.1.1部署架构 (6) 2.1.2平台软件配置 (7) 2.1.3主要问题分析 (7) 2.2平台总体架构 (9) 2.2.1方案设计原则 (9) 2.2.2业务场景梳理 (11) 2.2.3虚拟化平台方案拓扑 (11) 2.3硬件设计方案 (14) 2.3.1服务器设计 (14) 2.3.2存储设计 (14) 2.3.3网络带宽设计 (15) 2.4软件设计方案 (18) 2.4.1服务器虚拟化软件VMware vSphere (18) 2.4.2桌面虚拟化软件VMware? Horizon View (22) 2.4.3桌面虚拟化用户配置管理模块 (25) 2.4.4桌面虚拟化备份模块 (27) 2.4.5桌面安全防病毒模块 (30) 2.4.6云资源管理平台 (32) 2.4.7平台的监控告警模块 (48)

2.4.8运维管理设计 (52) 2.4.9方案可扩展性 (53) 2.5平台实施方案 (57) 2.5.1硬件基础环境安装 (57) 2.5.2虚拟桌面组件服务器部署 (59) 2.5.3标准镜像制作 (61) 2.5.4用户创建和桌面发放 (63) 2.5.5用户桌面迁移 (72) 2.5.6旧有虚拟桌面环境的迁移 (72) 2.6方案优势 (74) 第三章平台设备配置清单 (75) 3.1硬件产品配置说明 (75) 3.2软件产品及集成服务配置说明 (76) 第四章项目实施方案 (77) 4.1实施计划 (77) 4.1.1项目实施时间计划 (77) 4.1.2项目人员 (78) 4.2项目管理/质量管理 (78) 第五章测试及验收 (79) 5.1平台测试 (79) 5.2系统初验 (80) 5.3系统终验 (80) 第六章平台售后运维服务 (80)

服务器虚拟化技术方案

1项目概述 1.1竹溪县民政局现状 竹溪县民政局机房现有设备运行年限较长,各业务系统相对独立,造成管理难度大,基于这种现状我司推荐竹溪县民政局信息化启动平台化建设。 竹溪县民政局信息化平台是提高健康水平、提高政府服务质量和效率的有力推手,是规范医疗政府服务,方便群众办事,缓解群众看病难问题的主要手段,不仅对推动竹溪县政务整改工作有重要意义,也是当前竹溪县民政局信息化平台工作迫切的需求。 1.2竹溪县民政局信息化平台建设的基本原则 1)顶层设计,统筹协调原则:竹溪县民政局信息化平台建设要按照国家有 关信息化建设的总体部署和要求,结合竹溪县民政局实际,做好顶层设 计,进行信息资源统筹规划,统一建设规范、标准和管理制度,构建竹 溪县民政局信息化平台为建设目标和任务。运用不同机制和措施,因地 制宜、分类指导、分步推进,促进竹溪县民政局信息化平台工作协调发 展。 2)标准化原则:竹溪县民政局信息化平台建设要在统一标准、统一规范指 导原则下开展,相关技术、标准、协议和接口也须遵循国际、国家、部 颁有关标准,没有上述标准要分析研究,制定出适合竹溪县民政局信息 化平台的标准、规范。 3)开放和兼容性原则:竹溪县民政局信息化平台建设不是一个独立系统, 而是搭建一下通用平台,基于平台承载各类应用系统运行,因此,系统 设计应充分考虑其开放性,同时因发展需要,应具有较好的伸缩性,满 足发展需要。 4)先进性原则:采取业界先进系统架构理念和技术,为系统的升级与拓展 打下扎实基础,如在技术上采用业界先进、成熟的软件和开发技术,面

向对象的设计方法,可视化的面向对象的开发工具,支持 Internet/Ineternet网络环境下的分布式应用;客户/应用服务器/数据 服务器体系结构与浏览器/服务器(B/S)体系相结合的先进的网络计算 模式。 5)安全与可靠的原则:作为竹溪县民政局信息化平台,关乎到民生及医疗 数据安全,其数据库硬件平台必须具备最高的安全性及可靠性,可接近 连续可用。平台一旦出现故障可能会导致群体性事件,因此竹溪县民政 局信息化平台需要建立在一个科学稳定的硬件平台上,并达到系统要求 的安全性和可靠性。二是网络安全。在系统架构和网络结构设计上首先 考虑安全性,必须加强领导、落实责任,综合适用技术、经济、制度、 法律等手段强化网络的安全管理。三是信息安全。主要是数据安全即保 证数据的原始性和完整性,运行数据不可被他人修改或访问,记录者的 记录不容抵赖,访问和修改可追踪性等。在系统设计时既考虑系统级的 安全,又考虑应用级的安全。应用系统采用多级认证(系统级认证、模 块认证、数据库认证和表级认证)等措施,采用用户密码的加密技术以 防止用户口令被破解。同时需制定不断完善的信息系统应急处理预案和 合理的数据库备份策略,在灾难时也能快速从灾难中恢复。四是信息化 平台应具有较强数据I/O处理能力,同时系统在设计时必须考虑在大规 模并发,长期运行条件下的系统可靠性,满足竹溪县民政局信息化7× 24小时的服务要求,保证各机构单位数据交换和资源共享的需要。 6)协调合作原则:要求各有关方将以往的行为方式从独立行事向合作共事 转变,从独立决策向共同决策方式转变。各方在合作基础上,应在人力 资源和设备实体方面全力建立更加稳定的信息技术设施。 1.3平台需求 1.3.1硬件需求 竹溪县民政局信息化平台是支撑整个系统安全、稳定运行的硬件设备和网络设施建设,是系统平台的基础设施。主要包括支撑整个系统安全、稳定运行所需

虚拟化优缺点

1 引言 随着网络维护管理模式由分散式粗放型向集中式精细化管理模式迈进,铁通公司提出了“强化支撑能力,加强网络集中化管理,在集中化维护管理的基础上,逐步实现核心机房的联合值守和非核心机房的无人值守”的目标。 如何在有限的资金投资的前提下实现网管集中的目标,同时满足降低网络维护成本,达到维护出效率,节能减排的指标要求,是我们在网管集中工作中重点关注和努力的方向。由于铁通陕西分公司部分网管未搭建统一的集中化平台,制约了网管集中及维护管理模式集中化推进工作的整体实施,通过搭建虚拟化平台,实现了网管集中化维护管理的要求。 2 现有网管集中技术的缺陷及弊端 2.1技术落后、效率低下 既有网管接入方式主要采取将放置在机柜中的几十台工作站终端逐个接人KVM,通过KVM终端盒接入显示器,通过显示器进行切换分别进入不同的工作站终端进行维护操作。 从以下流程中可以看到。运维人员在处理一个区域的告警信息时无法看到其他区域的告警信息,只有在处理完这个区域的告警信息后才能处理下一个区域的信息,那么排在后面检查的区域告警往往得不到及时的处理,且随着业务系统的增加,维护人员需要管理的系统越来越多,这种轮询检查的方式将越来越成为制约维护效率提升的瓶颈。 2.2网管终端设备数量多维护成本居高不下。 几十台网管终端占据机房机柜资源,大量的终端清扫、部件维护和更换等在增加维护人员工作量的同时也增加了维护成本。同时新增系统时需增加网管终端

及机柜,受机房条件制约性很大。不算人工工作量,仅终端维修费支出每年平均在6.8万元。 2.3带来耗电量及运营成本的增加 从维护成本支出上计算,每台工作站终端按250W 能耗计算,在不考虑空调等耗电量的情况下,每年需要消耗近20万度电。 2.4系统架构分散使得管理难度、网管系统安全隐患增大。 由于系统架构分散,无备用终端,一旦故障,不能得到及时修复,对网络正常运行形成潜在威胁。 3 虚拟机技术介绍 计算机虚拟技术是指计算元件在虚拟的基础上而不是真实的基础上运行。虚拟化技术可以扩大硬件的容量,简化软件的重新配置过程。允许用户在一台服务器上同时运行多个操作系统,并且应用程序都可以在相互独立的空间内运行而互不影响,从而显著提高计算机的工作效率。虚拟化能在虚拟机技术(Virtual Machine Monitor)中,不再对底层的硬件资源进行划分,而是部署一个统一的Host系统。 在Host系统上,加装了Virtual Machine Monitor,虚拟层作为应用级别的软件而存在,不涉及操作系统内核。虚拟层会给每个虚拟机模拟一套独立的硬件设备。包含CPU、内存、主板、显卡、网卡等硬件资源,在其上安装所谓的Guest操作系统。最终用户的应用程序,运行在Guest操作系统中。 虚拟可支持实现物理资源和资源池的动态共享,提高资源利用率,特别是针对那些平均需求远低于需要为其提供专用资源的不同负载。这种虚拟机运行的方式主要有以下优势。

虚拟化解决方案

虚拟化解决方案

虚拟化解决方案 深圳市深信服科技有限公司 11月

第一章需求分析 1.1高昂的运维和支持成本 PC故障往往需要IT管理员亲临现场解决,在PC生命周期当中,主板故障、硬盘损坏、内存没插紧等硬件问题将不断发生,而系统更新、补丁升级、软件部署等软件问题也非常多,对于IT 管理员来说,其维护的工作量将是非常大的。同时,桌面运维工作是非常消耗时间的,而这段时间内将无法正常进行网上工作,因此也会影响到工作效率。最后,从耗电量方面来讲,传统PC+显示器为250W,那么一台电脑将产生高达352元/年【0.25(功耗)*8(每天8小时工作)*0.8(电费,元/千瓦时)*240(工作日)】本机能耗成本,而电脑发热量也比较大,在空间密集的情况下,散热的成本也在逐步上升。 因此,IDC预测,在PC硬件上投资10元,后续的运营开销将高达30元,而这些投资并不能为学校带来业务方面的价值,也即投入越大,浪费越多。 1.2 不便于进行移动办公 传统的PC模式将办公地点固定化,只能在办公室、微机房等固定区域进行办公,大大降低了工作的效率和灵活性,无法适应移动化办公的需求。

1.3数据丢失和泄密风险大 信息化时代,其数据存储和信息安全非常重要,在信息系统中存储着大量的与工作相关的重要信息。可是传统PC将数据分散存储于本地硬盘,PC硬盘故障率较高,系统问题也很多,这使得当出现问题时数据易丢失,同时由于数据的分散化存储,导致数据的备份及恢复工作非常难以展开,这些都是棘手的问题。另外,PC/笔记本上的资料能够自由拷贝,没有任何安全策略的管控,存在严重的数据泄密风险。 综上所述,桌面云解决方案是业界IT创新技术,当前已在众多行业机构得到广泛应用。经过基于服务器计算模式,将操作系统、应用程序和用户数据集中于数据中心,实现统一管控。此方案可经过革新的桌面交付模式,解决当前桌面管理模式中存在的运维难、不安全、灵活性差等问题,实现高效、便捷、防泄密的经济效益。

基于NUMA架构的服务器虚拟化性能优化研究综述-黄步添

基于NUMA架构的虚拟化平台的性能优化研究综述 黄步添 摘 要: 随着虚拟化、云计算技术的发展,用户的大型关键业务(如高性能计算业务和大型数据库业务)部署到虚拟化平台。特别以NUMA架构为基础的多核与内存硬件技术,为高性能计算提供了重要的硬件支持,并在传统的非虚拟化平台中广泛应用。在虚拟化环境中,为了有效运行大型关键业务,并使原来多机多核的高性能计算部署在巨型虚拟机中,需要进一步优化服务器的虚拟化性能。因此,基于NUMA架构的服务器虚拟化性能优化,是虚拟化领域一个重要的热点研究方向。本文针对操作系统虚拟化平台,从NUMA服务器架构、虚拟化平台的NUMA感知、基于NUMA架构的虚拟机的调度及迁移、基于NUMA架构的虚拟机性能评测及部署优化等四个方面的最新研究成果进行综述。论文分析了虚拟化平台面临的挑战,指出了虚拟化平台性能优化的难点、分析方法。最后对全文进行总结,提出未来值得进一步研究的方向。 关键词: 虚拟化;NUMA;VMM;Xen;KVM 1 引言 多核系统已经成为数据中心、云计算等的基础架构,越来越多的新的多核系统采用NUMA(Non Uniform Memory Access Architecture)架构。然而,由于数据局部性,片上内存资源的共享竞争,跨节点的数据共享的开销等,使得虚拟化性能问题进一步复杂化。由于物理硬件到虚拟硬件的不正确映射和抽象,程序和系统级的优化在虚拟机内往往不能奏效。 片上共享资源的竞争,严重影响了虚拟化平台所能提供的效率、公平性、QoS(Quality of Service)等特性[19]。现有的研究中,通过硬件技术[24]和程序优化[28]来减轻这种影响;通过一种更加灵活的方法-线程调度,来避免破坏性地使用共享资源[11,12,13,32],且有效地使用[16,51]。处理器上的共享缓存资源的合理利用是提高虚拟化平台性能的重要技术之一。通过使用PMU(Performance Monitor Unit)采集缓存失效率[1,11,12,32]以及内存带宽使用量[16]来量化共享资源的竞争及共享情况。 较早的研究中,更多关注于线程和内存管理策略的NUMA感知[53,54,55]。最近的研究,Dashti提出了内存密集型的应用引起的内存控制器的拥塞和互连问题,是影响性能的更关键因素[26]。目前研究中大多是侧重于内存负载均衡[49]或CPU负载均衡[1,48,52],Tian提出Linux的CFS(Completely Fair Schedule)调度器通过感知NUMA架构,来优化调度算法[41];集成负载表征,Chen提出一种综合性调度算法,避免不必要的任务迁移[52];Blagodurov提出一种命中率启发式算法,来减轻缓存共享引起的性能退化[11]。这些研究未能很好地感知NUMA架构的特点,且未能全局考虑负载均衡所引起的性能开销。 在虚拟化环境下,持锁者抢占(LHP)问题也是影响性能的关键因素。Strazdins提出采用co-scheduling 算法来避免LHP问题[56],但是该算法会带来CPU利用率碎片和不确定的系统延迟[57]。2010年3月,英特尔推出了6核32nm处理器家族Westmere,随它而来的也有一个新的VT-x虚拟化技术,即Pause-Loop Exiting(PLE,暂停-循环退出),它的主要用意就是减少因为循环等待而造成了CPU虚拟资源的浪费。基于PLE机制,Dong提出产生lock waiter任务,来避免CPU周期的浪费,使得提高性能[58]。 近几年的虚拟化研究,Kundu引入机器学习方法,对虚拟机运行指标特征进行分析,来优化虚拟机的放置策略[59];采用人工神经网络,来对虚拟化环境进行评估,来优化系统资源调度[60]。Tickoo基于benchmark vConsolidate,设计了一种虚拟机性能建模方法[61]。 本文从NUMA服务器架构、虚拟化平台的NUMA感知、虚拟机的NUMA调度及迁移、基于NUMA 架构下的虚拟机性能评测及部署优化等四个方面,对基于NUMA架构的虚拟化平台的性能优化问题进行系

服务器虚拟化方案

XX服务器 虚 拟 化 方 案

第一章概述 1.1项目背景 XX征信有限公司成立于北京,管理中心坐落于六朝古都南京,是国内早期从事非银行类信贷信息管理的公司之一。专门提供个人征信、企业评级、商家诚信认证等服务,被中国市场学会信用工作委员会授予副理事长单位,同时,聘请XX征信有限公司总经理XX先生为中国市场学会信用工作委员会副理事长。 XX征信在征信系统设计开发、区域信用体系建设、征信管理咨询等方面有着丰富的实践经验。在借鉴了国内外成熟的征信系统和完善的管理机制后,通过自主研发,建立了适应我国经济体制的非金融机构借贷信息共享平台,简称CMS平台。 CMS平台尽最大可能确保了信息主体记录的准确性、完整性、及时性和跨领域的一致性。此外,公司会实时更新录入者的具体信用情况,会员用户可以及时通过CMS平台查询主体信用信息,降低风险、寻找合作项目。。 1.2 项目目标 本着先进、实用的原则,XX利用虚拟化,将现有IT 基础架构转变成基于VMware vSphere,从而让IT 系统能够通过服务级别自动化提高控制力。降低资金成本和运营成本并最大限度提高IT 效益,同时保留选择任何应用程序、操作系统或硬件的自由。 ●通过将现有应用系统移植到虚拟化环境,保证系统的稳定性和可靠性,提高业务系 统的处理性能,提高IT业务效率。 ●通过服务器整合、自动化和高可用性来优化现有IT 基础架构。 ●利用业务连续性和灾难恢复来减少停机并提高可靠性。 ●利用我们的绿色IT 解决方案,通过减少运行的服务器数量和动态关闭未使用的服 务器来提高能效。

●让信息科人员将精力转移到打造具有变革意义的业务解决方案上,而不是放在对硬 件和软件的例行维护上。 ●更充分地利用现有IT资产,使数据中心的资金开销最多降低,大幅降低电力、散热 和占地空间需求,并使资源成本降低。 ●为下一步实现云数据中心提供基础和先决条件。 第二章虚拟化方案设计 2.1系统部署方案 XX征信虚拟化环境预期包含应用和数据库等多套应用,本次项目的主要实施目标是虚拟化环境建设,并将部分现在正在使用中的应用在虚拟化环境中进行部署和使用。 在3台服务器上安装虚拟化系统,组建HA,之后将使用中的核心数据库系统迁移到虚拟化平台上.之后可以根据实际使用情况酌情将其他应用系统迁移到虚拟化服务器上。 2.2 网络拓扑图

应用虚拟化解决方案

应用虚拟化解决方案 篇一:XXXX应用虚拟化解决方案 XXXX 统一接入平台项目 解决方案建议书 XX/9/21 第1章 第2章 第3章 概述................................................. ................................................... ..... 4 项目背景和目的................................................. .................................... 4 项目需求................................................. (5) 功能需求................................................. (5) 技术需

求................................................. (5) 实施要求................................................. (6) 其他要求................................................. (7) 解决方案及对应项目需求的实现................................................. ........ 8 对应功能需求的实现................................................. .......................... 10 集中管理 ................................................ .............................................. 10 应用发布 ................................................ .............................................. 10 存储隔离 ................................................ .. (11)

基于虚拟化的数据中心扩容建设_概括汇报材料

基于虚拟化的数据中心扩容建设 概述 目前***市信息办所有的应用系统设备均放至在***市数据中心机房内,中心数据机房整体建设完善,各业务系统有对应的管理机制,为进一步整合公共资源,提升***市公务信息化建设,需进行现有数据中心的扩容和升级,在原有数据中心建设的基础上,增加高性能服务器、大容量存储,并且需要通过升级扩容,形成机房综合管理系统,从而进一步提升***市信息办信息化平台建设水平。 新一代的信息办数据中心,应该设计成集中化、虚拟化和自动化管理的架构,不仅有利于数据的安全和系统的稳定,而且能够大大降低运营的成本,简化日常运营维护管理。本次***市信息办数据中心建设项目的设计目标是构造一个功能齐全、设备先进、运行高效、使用灵活、维护方便、易于扩展、投资省、高安全可靠的服务器及存储系统。 设计原则 根据项目实际需求,在系统设计原则及选型配置时应以满足当前的应用需求为基础,并具有良好的扩充能力,从实际应用和目前服务器技术发展趋势来看,服务器的选购应参考以下原则: 1.高效稳定、安全可靠 信息化建设必须秉承稳定为基础,兼顾高效率;故在设备选型及方案设计的初期,我们选择了先进的高端机架式服务器,同时应用业内最为先进的集群概念,通过采用虚拟化技术,在提高设备利用率的同时为上层应用系统提供更稳定更高效的基础平台支撑;进而实现信息化系统高效稳定的运行。 2.高可用 服务器涉及用户的关键应用和数据,因此高可用性的概念十分重要,“可用性”仍然是服务器的根本。 一般来讲,单台服务器的可用性通常需要考虑到关键部件的冗余。所以,提高可用性的一个普遍做法是部件的冗余配置,部件冗余对于高端服务器十分重要已是个不争的事实。然而,除了部件的冗余之外,还应该考虑采用HA和集群技

VMware虚拟化解决方案

呈送: 验收: 服务器虚拟化项目完成报告书 2012-09-25

项目概述 1, 硬件配置 服务器1 DELL R720 CPU : XEON E5-2650 8Core *2 RAM : 32G NIC : 1000M*4 HDD : 300G SAS *2 服务器2 DELL R720 CPU : XEON E5-2650 8Core *2 RAM : 32G NIC : 1000M*4 HDD : 300G SAS *2 存储器 DELL PowerVault MD3600f HDD:10*600GB " 15K RPM, 6Gbps SAS HDD ; Con troller Box1:PowerVault(TM) MD36x0f*1 ; Con troller Box2:PowerVault(TM) MD36x0f*1 SFP收发器:带2个SFP端口 *2 2, 软件 虚拟化平台: VMware vSphere 5 Esse ntials Plus Kit for 3 hosts (Max 2 processorsper host) and 192 GB vRAM en titleme nt (最大支持:一个标准版vCenter和三台虚拟主机(每台主机的物理CPU个数不超过2) 客户机OS: Win dows Server 2003 R2 STD 32BIT Win dows Server 2008 R2 STD 64BIT vCenter服务器OS: Windows Server 2008 R2 64BIT标准版 数据库:SQL Server 2008 Express

网络虚拟化技术介绍及应用实例

网络虚拟化介绍及应用实例 技术背景 随着社会生产力的不断发展,用户需求不断发展提高,市场也不断发展变化,谁能真正掌握市场迎合用户,谁就能够占领先机提高自己的核心竞争力。企业运营中关键资讯传递的畅通可以帮助企业充分利用关键资源,供应链、渠道管理,了解市场抓住商机,从而帮助企业维持甚至提高其竞争地位。作为网络数据存储和流通中心的企业数据中心,很显然拥有企业资讯流通最核心的地位,越来越受到企业的重视。当前各个企业/行业的基础网络已经基本完成,随着“大集中”思路越来越深入人心,各企业、行业越来越迫切的需要在原来的基础网络上新建自己的数据中心。数据中心设施的整合已经成为行业内的一个主要发展趋势,利用数据中心,企业不但能集中资源和信息加强资讯的流通以及新技术的采用,还可以改善对外服务水平提高企业的市场竞争力。一个好的数据中心在具有上述好处之外甚至还可以降低拥有成本。 1.虚拟化简介 在数据大集中的趋势下,数据中心的服务器规模越来越庞大。随着服务器规模的成倍增加,硬件成本也水涨船高,同时管理众多的服务器的维护成本也随着增加。为了降低数据中心的硬件成本和管理难度,对大量的服务器进行整合成了必然的趋势。通过整合,可以将多种业务集成在同一台服务器上,直接减少服务器的数量,有效的降低服务器硬件成本和管理难度。 服务器整合带来了巨大的经济效益,同时也带来了一个难题:多种业务集成在一台服务器上,安全如何保证?而且不同的业务对服务器资源也有不同的需求,如何保证各个业务资源的正常运作?为了解决这些问题,虚拟化应运而生了。虚拟化指用多个物理实体创建一个逻辑实体,或者用一个物理实体创建多个逻辑实体。实体可以是计算、存储、网络或应用资源。虚拟化的实质就是“隔离”—

IAAS平台虚拟化技术方案

IAAS平台VMware虚拟化技术方案IAAS Platform VMware Virtualization Technology Solution

目录 第1章IAAS平台项目需求概述 (3) 第2章IAAS平台VMWARE虚拟化解决方案 (4) 2.1虚拟化单机方案 (4) 2.1.1 单机方案拓扑图 (4) 2.1.2 单机方案推荐配置 (5) 2.1.3 单机方案说明 (6) 2.1.4 单机方案的重要功能 (7) 2.2虚拟化集群方案 (8) 2.2.1 集群方案拓扑图 (8) 2.2.2 集群方案推荐配置 (9) 2.2.3 集群方案说明 (10) 2.2.4 集群方案高级功能 (10) 第3章IAAS平台虚拟化方案价值 (17)

第1章IAAS平台项目需求概述 随着信息化社会的飞速发展,企业需要开展电子商务、办公自动化(OA)。信息化模块多样化带来的一个直接结果就是大量的硬件设备,且陈旧的硬件设备上支持的操作系统过老,不支持新业务所需的操作系统,目前公司已经有各类陈旧与空闲的服务器设备上百台,有很多设备已经进入淘汰期,需要充分的利用这些服务器设备降低IAAS平台的总拥有成本(TCO),提高IT投资回报率,必需解决好以下问题:1、实现硬件的整合,减少服务器硬件数量,以降低硬件管理维护成本,降低网络中心运营成本;2、充分的利用陈旧的服务器设备,提高服务器资源的利用率;3、使陈旧的设备上支持满足新业务所需操作系统和应用,使新操作系统和应用与老设备之间不存在兼容性问题;4、关键应用的性能必须要得到充分的保障,必须能做到7×24的不间断运行。运用虚拟化技术满足了这些需求,不仅可以大大降低TCO、提高运营效率、提高服务水平,而且虚拟化软件本身还为您提供高可用性和负载均衡特性,保证业务应用的连续性。

虚拟现实文献综述

《VRML虚拟现实技术在数字校园系统中应用研究》文献综述 摘要:教育部在一系列相关的文件中,多次涉及到了数字校园,阐明了数字校园的地位和作用。虚拟数字校园模拟真实世界,提供了一个生动的校园空间。将虚拟现实技术应用在数字校园系统的开发,有助于大学自身的宣传和信息的高度集中、配置和互动。它在数字校园的应用,可以大大提高校园展示效果,也能够体现校园个性方面的优势,对校园今后的推广及展示带来非常大的帮助 关键词:虚拟现实;数字校园;基本概况 前言 教育部在一系列相关的文件中,多次涉及到了虚拟校园,阐明了虚拟校园的地位和作用。建设虚拟三维数字校园可以比较直观的了解校园的各个区域,在这个三维的校园里,空间次序的视觉理解和感知变得非常容易,使浏览者对校园环境产生身临其境的感觉[1],其中的教学楼、实验楼、图书馆、宿舍楼、食堂、道路及绿化地带和种植的植物,都栩栩如生的呈现在我们的眼前,三维虚拟校园模拟真实世界,提供了一个生动的校园空间。三维虚拟校园可直接嵌入到大学的网站,直接通过网络浏览器察看,其丰富的、人性化的信息查询等功能,有效提高大学的美誉度,有助于大学自身的宣传和信息的高度集中、配置和互动。三维虚拟校园的直观特性,可以优化领导管理,对于校园信息管理、校园规划、建设等能够全局掌控。 一、虚拟现实技术的发展状况的研究 虚拟现实(Virtual Reality)技术是20世纪90年代初崛起的一种实用技术,它由计算机硬件、软件以及各种传感器构成三维信息的虚拟环境,可以真实地模拟现实中能实现的物理上的、功能上的事物和环境[2]。在虚拟现实环境中可以直接与虚拟现实场景中的事物交互,产生身临其境的感受,从而使人在虚拟空间中得到与自然世界同样的感受。该技术的兴起,为科学及工程领域大规模的数据及信息提供了新的描述方法。虚拟现实技术大量应用于建筑设计及其相关领域,该技术提供了“虚拟建筑”这种新型的设计、研究及交流的工具手段[3]。 在虚拟现实的发展过程中总结出虚拟现实系统应具有以下四个特征:(1)多感知性。指除一般计算机所具有的视觉感知外,还有听觉感知、触觉感知、运动感知、甚至还包括味觉、嗅觉、感知等。理想的虚拟现实应该具有一切人所具有的感知功能。(2)存在感。指用户感动作为主角存在于模拟环境中的真实程度。理想的模拟环境应该达到使用户难辨真假的程度。(3)交互性。指用户对模拟环境内物体的可操作程度和从环境得到反馈的自然程度。(4)自主性。指虚拟环境中物体依据现实世界物理运动定律动作的程度[4]。 虚拟现实技术自诞生以来,其应用一直受到科学界、工程界的重视,并不断取得进展,虚拟现实蕴藏的技术内涵与艺术魅力不断地激发着人们丰富的想象思维和创造的热情。从本质上讲,虚拟现实技术就是一种先进的人机交互技术[5],其追求的技术目标就是尽量使用户与电脑虚拟环境进行自然式的交互。因此,虚拟现实技术为我们架起了一座人与数字世界沟通的桥梁。 二、虚拟现实技术在数字校园系统的应用解析 目前,数字校园存在有2个定义,并分别带来不同的研究与实践。一种定义是从信息、网络和媒体技术发展角度,数字校园被理解为一个以计算机和网络为平台的、远程教学为主的信息主体;另一个事从因特网、虚拟现实技术、网络虚

服务器虚拟化全面了解

全面了解什么是服务器虚拟化 与过去相比,在服务器虚拟化技术方面,现在最大的不同就是参与者的队伍大大扩充了--从处理器层面的AMD和Intel到操作系统层面的微软的加入,从数量众多的第三方软件厂商的涌现到服务器系统厂商的高调,我们看到一个趋于完整的服务器虚拟化技术生态系统在逐渐形成。 “虚拟化正在从一个小市场向主流市场转变,尤其是在Microsoft进入该市场之后”,当微软宣布了其Virtual Server 2005计划之后,业内有这样的评价。在介绍微软的这个虚拟化项目的时候,几乎所有的媒体都做了这样的描述―与其他服务器虚拟化技术一样,Virtual Server 2005允许用户对服务器进行分区,以使这些服务器能够支持多个操作系统和应用。 在大多数人看来,虚拟化就是分区。实际上,我们认为这是对虚拟化技术的一种误解,所以有必要对这两者的关系进行进一步阐述。 虚拟化等于分区吗? 实际上,虚拟化技术可以通过两个方向来帮助服务器更加合理地分配资源,一种方向就是把一个物理的服务器虚拟成若干个独立的逻辑服务器,这个方向的典型代表就是分区;另一个方向,就是把若干个分散的物理服务器虚拟为一个大的逻辑服务器,这个方向的典型代表就是网格。

关于服务器虚拟化的概念,各个厂商有自己不同的定义,然而其核心思想是一致的,即它是一种方法,能够通过区分资源的优先次序并随时随地能将服务器资源分配给最需要它们的工作负载来简化管理和提高效率,从而减少为单个工作负载峰值而储备的资源。 根据我们目前看到的资料,所谓的这种方法,看上去就是分区。所以,很多人就理所当然地认为虚拟化技术就是分区技术。 实际上,分区与虚拟化技术是互补的,当它们结合使用时能发挥出最高的效率,但是两者之间的确是有区别的。分区能够将物理系统资源划分成多个不同、单独的部分,各部分彼此独立操作。通常,在物理资源与逻辑分区之间存在一一对应关系,以便创建“盒中盒”对等关系。如果没有进行分区,则所有物理部件都精确地各司其职。 最底层的力量 早在2005,英特尔就宣布了其初步完成的Vand erp ool技术外部架构规范(EAS),并称该技术可帮助改进未来虚拟化解决方案。英特尔表示,将在2006年把Vanderpool应用于安腾架构平台,同时还计划在台式机处理器和芯片组产品中采用该技术。 相比之下,AMD在虚拟化技术方面下手更早。Pacifi ca技术规范是AMD计划用于其64位产品中的虚拟化技术,该技术将用于基于x86架构的服务器、台式机和笔记本电脑等系列产品,“我们将进一步加快虚拟技术的开发步伐,增强虚拟化技术实力”,在去年底宣布Pacifica技术规范的时候,AMD副总裁兼计算

最新桌面虚拟化技术综述资料

把前段时间零零散散的文章总结了一下,整理成一篇比较全面的文章,希望对大家有全面的帮助。现在大家对概念的阐述都不一致,理解也比较混乱,希望大家看了能够理解以下几个问题: *桌面虚拟化的准确定义是什么 *什么是桌面虚拟化技术 ?桌面虚拟化技术发展历史 ?桌面虚拟化涉及的技术 *桌面虚拟化市场发展过程与当前状况 ?桌面虚拟化技术厂商有哪些,各自技术的优缺点与市场状态 *桌面虚拟化技术的价值和收益 一桌面虚拟化的定义 计算机虚拟化技术当前主要包括服务器虚拟化、应用虚拟化、桌面虚拟化。目前网络虚拟化,显卡虚拟化等技术都在快速发展,在不久的将来,当前物理的 设备将都支持虚拟化技术,实现IAAS (infrastructure as service ),实现真 正意义的云计算。而桌面虚拟化技术是当前发展最快的,也是最具应用前景的技术。 桌面虚拟化是指将计算机的桌面进行虚拟化,以达到桌面使用的安全性和灵 活性。 桌面虚拟化技术,维基百科上给出的定义是:“Desktop virtualization (或 者成为Virtual Desktop Infrastructure) 是一种基于服务器的计算模型,并且借用了传统的瘦客户端的模型,但是让管理员与用户能够同时获得两种方式的优点:将所有桌

面虚拟机在数据中心进行托管并统一管理;同时用户能够获得完整PC的使用体验。 用户可以通过瘦客户端,或者类似的设备在局域网或者远程访问获得与传统PC—致的用户体验。 很多商业方案同时提供了将用户远程转向到传统的共享系统,例如微软终端 服务,思杰应用服务器,刀片PC甚至是没有使用的物理PC机。” 简单的来说,桌面虚拟化是指:支持企业级实现桌面系统的远程动态访问与数据中心统一托管的技术。一个形象的类比,就是今天,我们可以通过任何设备、在任何地点,任何时间访问在网络上的我们的邮件系统,或者网盘;而未来我们可以通过任何设备,在任何地点,任何时间访问在网络上的属于我们个人的桌面系统。 二桌面虚拟化的历史 要了解桌面虚拟化的技术,我们就要了解桌面虚拟化的发展过程。我们可以比较简单地将桌面虚拟化技术分为一下3 个阶段: 1 第0.5 代的桌面虚拟化技术: 在我们还不知道什么叫桌面虚拟化的时代,这种技术的前身从不同的领域产生,发展直至成熟,使得现在的桌面虚拟化技术成为现实。这主要包括了2 种技术: a. 远程桌面

虚拟化平台解决方案设计.pdf

虚拟化平台解决方案设计 一、云计算平台核心管理模块软件架构 动态数据中心核心管理用户自服务模块与平台管理模块,是将数据中心管理的主要功能: -系统监控 -虚拟化管理 -数据备份 -配置管理 -身份管理 以Web Service方式包装成模块,调用成熟的产品组件System Center与FIM 的主要功能,实现高度可扩展的系统管理。 -系统监控模块 ?单个(或集群的)服务器的主要服务

?跟踪事件和日志服务器上生成的状态监测 ?跟踪性能计数器以测量和优化系统的使用 ?生成基于预定义的规则的事件或计数器的通知 -服务器部署和配置模块 ?自动设置服务器(虚拟和物理),管理虚拟服务器的配置设置 ?配置的网络交换机和创建的虚拟服务器的负载平衡 ?虚拟服务器和在最可用的物理服务器环境中的自动分配 ?创建和管理所创建的虚拟服务器实例使用的模板 ?创建和管理系统镜像,管理物理服务器实例 -数据保护模块 ?备份和还原的整个服务器 ?备份和还原的计算机正在运行的数据库 ?能够回滚在服务器中所做的更改 ?备份和还原所有服务器的单个文件和文件夹 -服务配置管理模块 ?跟踪资产硬件和软件许可证以及在环境中的配置 ?管理的软件更新(通过自定义的更新计划) ?定义和使用所需的服务器等计算资源的配置 ?生成报告已安装的软件,更新挂起的操作,等等 ?安装并维护应用程序等 另外,通过System Center Opalis与HP Open View, IBM Tivoli, BMC Patrol, NetIQ 等多厂家系统管理软件在IT管理流程层面进行整合,形成统一的运营监控体系。 充分发挥原有运营监控软件功能充分发挥原有投资。

深信服服务器虚拟化-技术白皮书

深信服服务器虚拟化产品技术白皮书 深信服科技

声明 市深信服电子科技所有,并保留对本文档及本声明的最终解释权和修改权。 本文档中出现的任何文字叙述、文档格式、插图、照片、方法、过程等容,除另有特别注明外,其著作权或其它相关权利均属于市深信服电子科技。未经市深信服电子科技书面同意,任何人不得以任何方式或形式对本文档的任何部分进行复制、摘录、备份、修改、传播、翻译成其他语言、将其全部或部分用于商业用途。 免责条款 本文档仅用于为最终用户提供信息,其容如有更改,恕不另行通知。 市深信服电子科技在编写本文档的时候已尽最大努力保证其容准确可靠,但市深信服电子科技不对本文档中的遗漏、不准确、或错误导致的损失和损害承担责任。 信息反馈 如果您有任何宝贵意见,请反馈: 信箱:省市学苑大道1001号南山智园A1栋邮编:518055 电话:09 传真:09 您也可以访问深信服科技:https://www.360docs.net/doc/1215672028.html,获得最新技术和产品信息

缩写和约定 英文缩写英文全称中文解释 Hypervisor Hypervisor 虚拟机管理器(和VMM同 义) VMM VMM Virtual Machine Manager 虚拟机监视器 HA HighAvailability 高可用性 vMotion vMotion 实时迁移 DRS Distributed Resource Scheduler 分布式资源调度程序 FC Fibre Channel 光纤通道 HBA Host Bus Adapter 主机总线适配器 RAID Redundant Arrays of Independent Disks 磁盘阵列 IOPS Input/Output Operations Per Second 每秒读写(I/O)操作的次数VM Virtual Machine 虚拟机 LUN Logical Unit Number 逻辑单元号

《云计算虚拟化技术与应用》—教学大纲

《云计算虚拟化技术与应用》教学大纲 学时: 代码: 适用专业: 制定: 审核: 批准: 一、课程的地位、性质和任务 本课程是云计算技术、计算机网络技术、计算机应用技术等专业的一门专业核心课程,主要讲授虚拟化技术发展史、虚拟化技术分类、虚拟化架构特性并对目前主流的虚拟化技术都有涉及,重点讲授虚拟化技术在服务器、桌面及网络上的应用。通过本课程的学习,使学生掌握虚拟化的基本知识,掌握虚拟化的基本原理和方法。能够对目前主流的虚拟化产品进行熟练的使用、部署及维护,并培养学生团结协作、严守规范、严肃认真的工作作风和吃苦耐劳、爱岗敬业等职业素养。 二、课程教学基本要求 1.了解虚拟化的基本概念及发展情况、虚拟化的技术分类及虚拟化的基本技术架构等知识。 2. 了解服务器虚拟化、存储虚拟化和网络虚拟化的基本概念及基础架构原理,了解市场主流虚拟化技术及产品。 3. 了解VMware ESXi的基本概念并熟练掌握VMware ESXi的安装、配置的基本方法与技术;了解VMware ESXi的重要功能并掌握VMware ESXi虚拟机的创建、定制技术。 4. 了解XenServer的功能特性、虚拟基础架构及XenServer系统架构,掌握XenServer服务器和XenCenter管理平台的安装、配置以及创建虚拟机环境的基本方法与技术。 5. 了解Microsoft Hyper-V的功能特性及系统架构,掌握安装Microsoft Hyper-V服务器角色以及创建、定制虚拟机环境的基本方法与技术。 6. 了解KVM的应用前景及基本功能,掌握KVM环境构建、硬件系统维护、KVM服务器安装及虚拟机维护的基本方法与技术。 7. 了解Docker的功能特性及系统架构,掌握Docker的使用技术,包括Docker的安装与卸载、Docker镜像与容器以及Docker Hub的应用技术等。 8. 掌握虚拟机服务器的部署,包括虚拟服务器的配置、工具的部署、虚拟服务器调优、虚拟服务器安全性、虚拟机备份、虚拟机业务迁移及物理机转虚拟机的方法及技术。 9. 了解虚拟化终端的类型及其特点、熟悉常见共享桌面的种类。了解主流虚拟桌面的产品及其厂商,掌握VMware View虚拟桌面的部署步骤过程。 10. 掌握虚拟专用网络VPN的部署与使用方法,包括硬件VPN和软件VPN;掌握虚拟局域网(VLAN)的部署与使用方法,包括标准VLAN、VMware VLAN和混合VLAN;掌握虚拟存储设备的配置与应用,包括IP-SAN在vSphere平台的挂载方法。 11. 掌握虚拟化架构规划的需求分析及设计选型的一般方法,能够针对具体的项目需求给出虚拟化架构规划实施方案。

虚拟化和云计算综述

虚拟化和云计算综述 一.虚拟化 1.简介 虚拟化主要是计算机方面的计算元件在虚拟基础上而不是真实的基础上运行,是一种解决方案,目的就是优化资源和管理。把有限的资源经过合理规划之后可以最大程度的利用,使空间更大,使管理不再复杂。虚拟化可以使某一台计算机运行多个虚拟机,也就意味着这台计算机的资源可以共享,不同的虚拟机在同一台物理机上可以运行不同的操作系统和各种程序。 虚拟化技术的每一个操作系统中都有多个系统运行,并且每一个操作系统运行在虚拟的主机或CPU 上,每个虚拟机都有属于自己的虚拟硬件。虚拟化技术可以扩大硬件的容量,简化软件的重新配置过程。CPU 的虚拟化技术可以单CPU 模拟多CPU 并行,允许一个平台同时运行多个操作系统,并且应用程序都可以在相互独立的空间内运行而互不影响,从而显著提高计算机的工作效率。 目前虚拟技术按照应用领域可划分为:服务器虚拟化、存储虚拟化、平台虚拟化、桌面虚拟化、网络虚拟化、CPU虚拟化、文件虚拟化等;按照实现层次来划分:硬件虚拟化、操作系统虚拟化、应用程序虚拟化。 2.特征 1)效率:虚拟化服务器可以实现资源共享,提高资源利用率,确保应用程序可以充分发挥性能。

2)隔离:在安全方面,虚拟机比传统的非虚拟机更注重安全性和可用性,在共享资源的同时,会保持彼此隔离,使运行的应用程序胜于普通计算机的应用程序。 3)可靠:如果某台服务器出现了故障,那么在短时间内就可会恢复正常,不影响整体的运行,这种独立的工作形式加大了运作的可靠性。 4)兼容:虚拟服务器与正常的x86 系统相兼容,将所有可能出现的问题降到最低点。 5)成本:降低了部署成本,只需要更少的服务器就可以实现需要更多服务器才能做到的事情,也间接降低了安全等其他方面的成本。 6)管理:提高了服务器/管理员比率,一个管理员可以轻松的管理比以前更多的服务器而不会造成更大的负担。 二.云计算 1.简介 原理:云计算(Cloud Computing)是并行计算(Parallel Computing)、分布式计算(Distributed Computing) 和网格计算(Grid Computing) 的发展,同时也是虚拟化(Virtualization)、公用计算(Utility Computing)、IaaS( 基础设施即服务)、PaaS( 平台即服务)、SaaS( 软件即服务) 等概念混合演进并跃升的结果。 云计算系统是以付费使用的形式向用户提供各种服务的分布式 计算系统,系统对用户来讲是透明的,其本质是对虚拟化的计算和存