haproxy透明代理配置

Haproxy使用tproxy实现透明代理

实验环境

Server1为代理服务器,有两个网卡

eth0:192.168.1.55用于对外服务

eth1:10.0.0.1gw10.0.0.254用于内网通讯

Server2为应用服务器,一块网卡

eth0:10.0.0.2gw10.0.0.1

service的网关一定要配成service的内网IP

准备工作

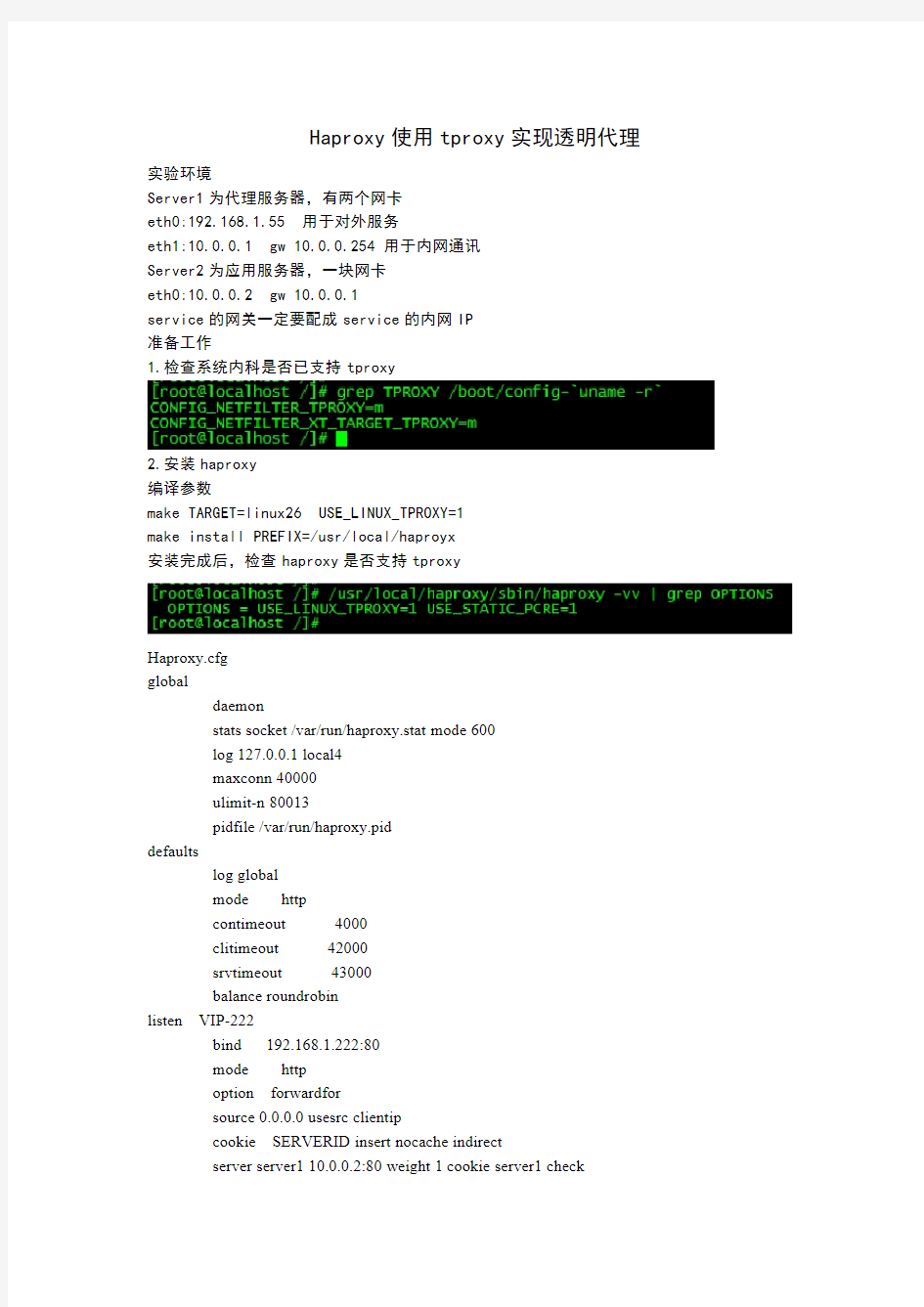

1.检查系统内科是否已支持tproxy

2.安装haproxy

编译参数

make TARGET=linux26USE_LINUX_TPROXY=1

make install PREFIX=/usr/local/haproyx

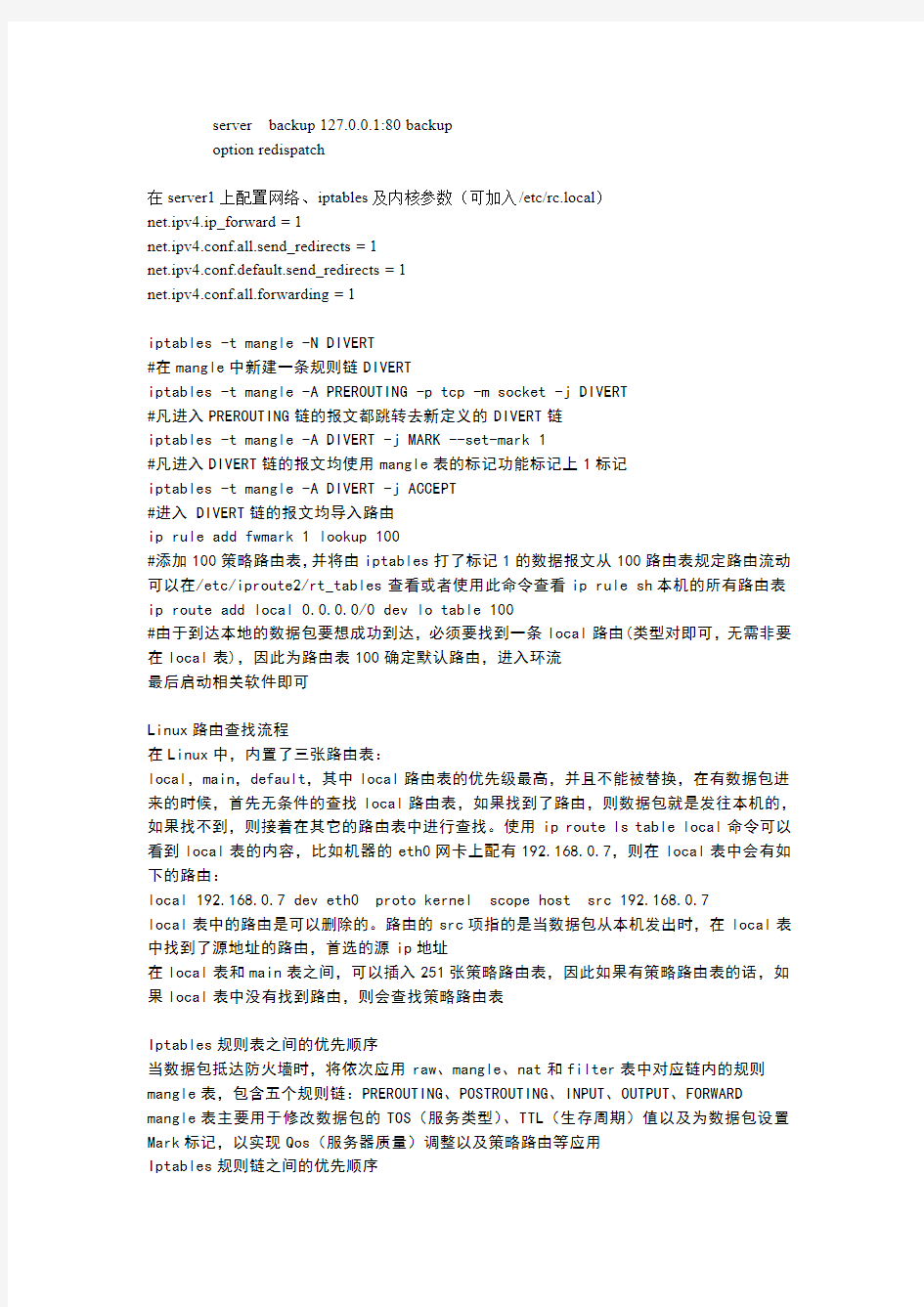

安装完成后,检查haproxy是否支持tproxy

Haproxy.cfg

global

daemon

stats socket/var/run/haproxy.stat mode600

log127.0.0.1local4

maxconn40000

ulimit-n80013

pidfile/var/run/haproxy.pid

defaults

log global

mode http

contimeout4000

clitimeout42000

srvtimeout43000

balance roundrobin

listen VIP-222

bind192.168.1.222:80

mode http

option forwardfor

source0.0.0.0usesrc clientip

cookie SERVERID insert nocache indirect

server server110.0.0.2:80weight1cookie server1check

server backup127.0.0.1:80backup

option redispatch

在server1上配置网络、iptables及内核参数(可加入/etc/rc.local)

net.ipv4.ip_forward=1

net.ipv4.conf.all.send_redirects=1

net.ipv4.conf.default.send_redirects=1

net.ipv4.conf.all.forwarding=1

iptables-t mangle-N DIVERT

#在mangle中新建一条规则链DIVERT

iptables-t mangle-A PREROUTING-p tcp-m socket-j DIVERT

#凡进入PREROUTING链的报文都跳转去新定义的DIVERT链

iptables-t mangle-A DIVERT-j MARK--set-mark1

#凡进入DIVERT链的报文均使用mangle表的标记功能标记上1标记

iptables-t mangle-A DIVERT-j ACCEPT

#进入DIVERT链的报文均导入路由

ip rule add fwmark1lookup100

#添加100策略路由表,并将由iptables打了标记1的数据报文从100路由表规定路由流动可以在/etc/iproute2/rt_tables查看或者使用此命令查看ip rule sh本机的所有路由表ip route add local0.0.0.0/0dev lo table100

#由于到达本地的数据包要想成功到达,必须要找到一条local路由(类型对即可,无需非要在local表),因此为路由表100确定默认路由,进入环流

最后启动相关软件即可

Linux路由查找流程

在Linux中,内置了三张路由表:

local,main,default,其中local路由表的优先级最高,并且不能被替换,在有数据包进来的时候,首先无条件的查找local路由表,如果找到了路由,则数据包就是发往本机的,如果找不到,则接着在其它的路由表中进行查找。使用ip route ls table local命令可以看到local表的内容,比如机器的eth0网卡上配有192.168.0.7,则在local表中会有如下的路由:

local192.168.0.7dev eth0proto kernel scope host src192.168.0.7

local表中的路由是可以删除的。路由的src项指的是当数据包从本机发出时,在local表中找到了源地址的路由,首选的源ip地址

在local表和main表之间,可以插入251张策略路由表,因此如果有策略路由表的话,如果local表中没有找到路由,则会查找策略路由表

Iptables规则表之间的优先顺序

当数据包抵达防火墙时,将依次应用raw、mangle、nat和filter表中对应链内的规则mangle表,包含五个规则链:PREROUTING、POSTROUTING、INPUT、OUTPUT、FORWARD mangle表主要用于修改数据包的TOS(服务类型)、TTL(生存周期)值以及为数据包设置Mark标记,以实现Qos(服务器质量)调整以及策略路由等应用

Iptables规则链之间的优先顺序

入站数据流向:来自外界的数据包到达防火墙后,首先被PREROUTING规则链处理(是否修改数据包地址等),之后进行路由选择(判断该数据包应发往何处),如果数据包的目标地址是防火墙本机(如Internet用户访问防火墙主机中web服务端数据包),那么内核将其传递给INPUT链进行处理(决定是否允许通过等),通过以后在交给系统上层的应用程序(如httpd 服务器)进行响应

PREROUTING:在对数据包做路由选择之前,应用此链中的规则

转发数据流向:来自外界的数据包到达防火墙后,首先被PREROUTING规则链处理,之后进行路由选择,如果数据包的地址是其外部地址(如果局域网通过网关访问QQ站点的数据包),则内核将其传递给FORWARD链进行处理(是否转发或拦截),然后再交给POSTROUTING规则链(是否修改数据包地址等)进行处理

出站数据流向:防火墙本机向外部地址发送到数据包(如在防火墙主机中测试公网DNS服务时),首先被OUTPUT规则链处理,之后进行路由选择,然后传递给POSTROUTING规则链(是否修改数据包的地址等)进行处理

iptables规则链内部各条防火墙规则之间的优先顺序

在数据包经由每条规则的处理过程中,依次按第一条、第二条......的顺序进行匹配,如果找到一条能够匹配该数据包的规则,则不继续检查后边的规则,如果比对完整个规则链,也找到和数据包相匹配的规则,就按照规则链的默认策略进行处理

零下七度:411898301

HAProxy的安装部署详细

HAProxy的安装和部署 考虑公司当前服务器的并发量,最终还是选定了HAProxy来实现负载均衡,相较于其他的负载均衡系统,HAProxy的配置和使用还是比较简单的。 下面是自己安装和部署haproxy的记录,比较重要的一点是解决了haproxy + syslog-ng的日志输出问题。 PS: 这个问题费了我好大神:-| PLATFORM: SUSE Linux Enterprise Server 11 (x86_64) 1. haproxy的编译安装 获取haproxy的源代码 官方地址:http://haproxy.1wt.eu/ 目前最新的版本:http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.8.tar.gz 命令:

wget http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.8.tar.gz 考虑到版本的更新,具体的安装属性可能会稍有改变,建议在安装前可以大致浏览下haproxy目录下的README和Makefile两个文件。 编译haproxy 进入解压后的haproxy的目录,用下列命令进行编译: make TARGET=os ARCH=arch CPU=cpu USE_xxx=1 ... 这里着重说明几个常用的选项。 TARGET 指定对目标操作系统在编译的时候进行优化,可选择如下值之一: Generic, linux22, linux24, linux24e, linux26, solaris, freebsd, openbsd, Cygwin, custom。 如果不确定目标系统,可以保留默认值generic。 CPU 指定对特定的CPU进行优化,可选择如下值之一:generic, i586, i686, ultrasparc, custom。默认值为generic。 ARCH 指定ARCH值可强制编译生成针对一个特定系统架构的程序。通常用于在一个系统架构的平台上生成针对另一个不同架构平台的程序,比如在一个64位架构的目标系统上编译生成一个32位的程序。 当前可选的值有:x86_64, i386, i486, i586, i686。 注:若选择上述其中的一个值,”-m32”或”-m64”会被添加到CFLAGS和LDFLAGS选 项中。

配置nginx到后端服务器负载均衡

nginx和haproxy一样也可以做前端请求分发实现负载均衡效果,比如一个tomcat服务如果并发过高会导致处理很慢,新来的请求就会排队,到一定程度时请求就可能会返回错误或者拒绝服务,所以通过负载均衡使用多个后端服务器处理请求,是比较有效的提升性能的方法;另外当单机性能优化到一定瓶颈之后,一般也会用负载均衡做集群,配置也很简单,下面是配置过程: 首先需要安装nginx服务器,我这里已经安装好了,比如这里有三个tomcat 服务器,地址如下: 192.168.1.23 8080 192.168.1.24 8080 192.168.1.25 8080 其中nginx安装在192.168.1.23上面,如果只有一个服务器测试,也可以在一个服务器上运行多个tomcat开多个端口来实现,这样也能提升性能首先看nginx配置,在nginx.conf中http {}块内并且server {}块之外添加如下配置: upstream my_service { server 127.0.0.1:8080 weight=2; server 192.168.1.24:8080 weight=1; server 192.168.1.25:8080 weight=1; } 上面的my_service是集群的名字,可以自己命名,server指定后端服务列表,weight是设置权重,权重越大,请求被分发过来的可能性就越大,这里本机权重设置了2,也就是说对到达的请求分配到本地上的会多一些配置这个之后,需要在server {}中添加location配置拦截请求并转发给后端的集群,最简单的配置如下: location / {

PXC5.6实验集群的安装与设置

PXC5.6实验集群的安装与设置

目录 1.目的: (4) 2.集群构成: (5) 2.1.集群构成图: (5) 2.2.集群构成明细: (5) 3.安装设置操作步骤: (6) 3.1.安装Percona Yum Repository: (6) 3.2.安装EPEL源: (7) 3.3.安装PXC (7) 3.4.创建及设置数据目录 (8) 3.5.开通PXC相关IP端口 (9) 3.6.关闭SELinux (10) 3.7.设置https://www.360docs.net/doc/364058776.html,f启动项文件 (10) 3.8.启动集群 (12) 4.通过HAProxy实现PXC集群负载均衡: (14) 4.1.安装HAProxy (14) 4.2.设置HAProxy (14) 4.3.启动HAProxy (16) 4.4.增加集群状态检查进程用Mysql用户权限 (16) 4.5.为集群每一个节点服务器安装xinetd (17) 4.6.配置xinetd (17) 4.7.通过HAProxy查看数据库集群状态: (18)

5.用Keepalived解决HAProxy单点故障: (20) 5.1.安装配置备份代理服务器 (20) 5.2.安装Keepalived (21) 5.3.在主HAProxy代理服务器中设置Keepalived (21) 5.4.在备份HAProxy代理服务器中设置Keepalived (23) 5.5.验证虚拟IP的漂移 (24) 6.问题排查及解决: (25) 6.1.ERROR 1047 (08S01): WSREP has not yet prepared node for application use (25)

haproxy高级配置

使用rchs集群套件基于conga界面配置apache高可用集群 电源设备采用“virtual machine fencing” Conga是一个基于web界面的c/s架构的配置集群的工具 c 集群节点作为被服务管理集群配置的客户端节点 s 专门用于管理集群、配置集群的一个服务端节点 在S服务端上安装luci的服务端软件,打开该软件提供的一个web界面,进行集群的配置(配置的步骤跟使用rhel5上的system-config-cluster雷同),唯一的区别是,服务端(本机)本身并不参与集群,并不属于集群中的成员。 在c客户端上安装ricci服务,该服务会与服务端的luci建立连接,接受服务端的集群管理操作。客户端才是集群中的成员。 准备: FQDN、静态IP 、hosts文件 clients | |----------------| node1 node2 https://www.360docs.net/doc/364058776.html, 192.168.29.11 https://www.360docs.net/doc/364058776.html, 192.168.29.12 资源: vip 192.168.29.10 httpd OS :rhel6 准备: 静态IP、FQDN、hosts 暂时关闭iptables ,selinux

[Base] name=Base baseurl=file:///soft/el63 enabled=1 gpgcheck=0 [HighAvailability] name=LoadBalancer baseurl=file:///soft/el63/HighAvailability enabled=1 gpgcheck=0 [ResilientStorage] name=ResilientStorage baseurl=file:///soft/el63/ResilientStorage enabled=1 gpgcheck=0 [ScalableFileSystem] name=ScalableFileSystem baseurl=file:///soft/el63/ScalableFileSystem enabled=1 gpgcheck=0 一、在宿主机上模拟fence设备 # yum install fence-virt.x86_64 fence-virtd.x86_64 fence-virtd-libvirt.x86_64 fence-virtd-multicast.x86_64 -y fence-virt 实际用于fence设备工具:实际用于关机、重启、启动客户机的工具 fence-virtd 模拟fence设备的服务:负责接受集群中的节点(客户机)fence指令 fence-virtd-libvirt.x86_64 <----操作虚拟化的接口库 fence-virtd-multicast.x86_64 组播的方式在宿主机(fence-virtd服务)和客户机(集群节点)之间传达电源指令《---以模块的形式存在 软件安装完毕后,存在一个配置文件/etc/fence_virt.conf 向导配置 # fence_virtd -c

HAPROXY安装及配置详解与算法

HAProxy安装及配置详解与算法 HAProxy提供高可用性、负载均衡以及基于TCP和HTTP应用的代理,支持虚拟主机,它是免费、快速并且可靠的一种解决方案。根据官方数据,其最高极限支持10G的并发。 HAProxy特别适用于那些负载特大的web站点,这些站点通常又需要会话保持或七层处理。HAProxy 运行在当前的硬件上,完全可以支持数以万计的并发连接。并且它的运行模式使得它可以很简单安全的整 合进您当前的架构中,同时可以保护你的web服务器不被暴露到网络上。 其支持从4层至7层的网络交换,即覆盖所有的TCP协议。就是说,Haproxy甚至还支持Mysql的 均衡负载。如果说在功能上,能以proxy反向代理方式实现WEB均衡负载,这样的产品有很多。包括Nginx,ApacheProxy,lighttpd,Cheroke等。 但要明确一点的,Haproxy并不是Http服务器。以上提到所有带反向代理均衡负载的产品,都 清一色是WEB服务器。简单说,就是他们能自个儿提供静态(html,jpg,gif..)或动态(php,cgi..) 文件的传输以及处理。而Haproxy仅仅,而且专门是一款的用于均衡负载的应用代理。其自身并不能提 供http服务。

但其配置简单,拥有非常不错的服务器健康检查功能还有专门的系统状态监控页面,当其代理的后端服务器出现故障,HAProxy会自动将该服务器摘除,故障恢复后再自动将该服务器加入。自1.3版本开始还引入了frontend,backend,frontend根据任意HTTP请求头内容做规则匹配,然后把请求定向到相关的backend。 1.安装 官方版本获取地址:http://haproxy.1wt.eu/,不过官方页面已经打不开了,请自行搜索! 上面中的26是linux系统内核,通过命令#uname-a可查看,我使用的是CentOS #tar xzvf haproxy-1.4.24.tar.gz #cd haproxy-1.4.24 #make TARGET=linux26PREFIX=/usr/local/haproxy #make install PREFIX=/usr/local/haproxyb 2.配置 安装完毕后,进入安装目录配置文件,默认情况下目录里是没有.cfg配置文件的,可以回到安装文件目录下将examples下的haproxy.cfg拷贝到usr/local/haproxy下。 #cd/usr/local/haproxy #vi haproxy.cfg 默认文件内容如下:(注意!!标示开始的为默认的配置文件没有的)

运维简历

个人简历 基本信息 姓名:现居地址:武汉 性别:男联系电话: 学历:大专电子邮件: 求职意向 到岗时间:随时到岗 工作性质:全职 目标职能:Linux运维工程师、系统管理员、Linux系统技术支持 求职状态:目前正在找工作 专业技能 1.熟悉主流Linux操作系统,例如redhat(centos)等,熟练使用Linux命令,能排除日常的错误等。 2.熟悉Linux shell环境,熟练使用shell脚本编程,并熟悉运用grep、awk、sed等脚本辅助工具。 3.熟练配置Linux系统的常见服务DHCP、DNS、SAMBA、VSFTP、Mail、Rsync、Squid、Ldap等。 4.熟悉WEB服务器系统的配置和软件服务器搭建如Apache/Nginx、Tomcat。 5.熟悉MySQL的基本SQL语句,并掌握MySQL的备份与还原,主从复制,读写分离,能使用脚本安装MySQL,Oracle。 6.熟悉cacti,nagios,zabbix等开源监控软件的安装,塔建与使用。 7.熟悉自动化Linux管理工具puppet,批量装机工具如kickstart,cobbler。 8.熟悉LVS+Keepalived、HAProxy、Heartbeat负载均衡,高可用的原理以及安装部署。 9.熟悉TCP/IP协议,熟悉Iptables基本配置和管理。 10.熟悉虚拟化VMware搭建及管理,了解KVM,XEN虚拟化技术和云计算平台。 11.有良好的英语阅读能力,能读阅读相关英语技术文档。 工作经历 时间/公司2015.6-2016.3 XXXX科技有限公司 岗位:Linux运维工程师 。 1负责网站平台的更新升级和对用户使用的问题进行解决,协助分析系统bug 跟踪处理进度,负责服务器日常维护,负责搭建及维护监控平台,编写并及时更新工作手册; ??2. 登录服务器检查数据库mysql运行情况;? ?3. 每日检查mysql备份及Linux系统资源运行状况; 4. 负责系统平台上线及更新并进行系统新功能的测试,并编写测试报告运维报告相关文档;? ?5. 编写常用脚本提高运维的准确和效率率,如mysql备份脚本; 6定期对机房主机设备进行健康检查8. 搭建监控平台nagios,并且负责后期的维护开发;? 7. 定期统计相关数据,比如系统访问量、访问人数; 项目经验

haproxy透明代理配置

Haproxy使用tproxy实现透明代理 实验环境 Server1为代理服务器,有两个网卡 eth0:192.168.1.55用于对外服务 eth1:10.0.0.1gw10.0.0.254用于内网通讯 Server2为应用服务器,一块网卡 eth0:10.0.0.2gw10.0.0.1 service的网关一定要配成service的内网IP 准备工作 1.检查系统内科是否已支持tproxy 2.安装haproxy 编译参数 make TARGET=linux26USE_LINUX_TPROXY=1 make install PREFIX=/usr/local/haproyx 安装完成后,检查haproxy是否支持tproxy Haproxy.cfg global daemon stats socket/var/run/haproxy.stat mode600 log127.0.0.1local4 maxconn40000 ulimit-n80013 pidfile/var/run/haproxy.pid defaults log global mode http contimeout4000 clitimeout42000 srvtimeout43000 balance roundrobin listen VIP-222 bind192.168.1.222:80 mode http option forwardfor source0.0.0.0usesrc clientip cookie SERVERID insert nocache indirect server server110.0.0.2:80weight1cookie server1check

HAProxy用法详解

HAProxy用法详解 一,HAProxy简介 (1)HAProxy是一款提供高可用性、负载均衡以及基于TCP(第四层)和HTTP (第七层)应用的代理软件,支持虚拟主机,它是免费、快速并且可靠的一种解决方案。HAProxy特别适用于那些负载特大的web站点,这些站点通常又需要会话保持或七层处理。HAProxy运行在时下的硬件上,完全可以支持数以万计的并发连接。并且它的运行模式使得它可以很简单安全的整合进您当前的架构中,同时可以保护你的web服务器不被暴露到网络上。 (2)HAProxy实现了一种事件驱动、单一进程模型,此模型支持非常大的并发连接数。多进程或多线程模型受内存限制、系统调度器限制以及无处不在的锁限制,很少能处理数千并发连接。事件驱动模型因为在有更好的资源和时间管理的用户端(User-Space) 实现所有这些任务,所以没有这些问题。此模型的弊端是,在多核系统上,这些程序通常扩展性较差。这就是为什么他们必须进行优化以使每个CPU时间片(Cycle)做更多的工作。 (3)HAProxy 支持连接拒绝: 因为维护一个连接的打开的开销是很低的,有时我们很需要限制攻击蠕虫(attack bots),也就是说限制它们的连接打开从而限制它们的危害。这个已经为一个陷于小型DDoS攻击的网站开发了而且已经拯救 了很多站点,这个优点也是其它负载均衡器没有的。 (4)HAProxy 支持全透明代理(已具备硬件防火墙的典型特点): 可以用客户端IP地址或者任何其他地址来连接后端服务器. 这个特性仅在Linux 2.4/2.6内核打了cttproxy补丁后才可以使用. 这个特性也使得为某特殊服务器处理部分流量同时又不修改服务器的地址成为可能。 性能: HAProxy借助于OS上几种常见的技术来实现性能的最大化。 1,单进程、事件驱动模型显著降低了上下文切换的开销及内存占用。 2,O(1)事件检查器(event checker)允许其在高并发连接中对任何连接的任何事件实现即时探测。 3,在任何可用的情况下,单缓冲(single buffering)机制能以不复制任何数据的方式完成读写操作,这会节约大量的CPU时钟周期及内存带宽;

Nginx 高可用+负载均衡部署文档V1.0.2

Nginx高可用+负载均衡部署指南 1软件版本说明 2基础软件安装 2.1Nginx安装 版本jdk-7u67-linux-x64.rpm,安装步骤略 安装后检验Nginx版本是否正确。 [root@localhost ~]# /usr/local/nginx/sbin/nginx –v nginx version: nginx/1.6.0 2.2Keepalived安装 2.2.1openssl安装 openssl必须安装,否则安装keepalived时无法编译,keepalived依赖openssl openssl安装 tar zxvf openssl-1.0.1g.tar.gz ./config--prefix=/usr/local/openssl ./config-t make depend make make test make install ln-s /usr/local/openssl/usr/local/ssl openssl配置 vi/etc/ld.so.conf #在/etc/ld.so.conf文件的最后面,添加如下内容:

/usr/local/openssl/lib vi/etc/profile export OPENSSL=/usr/local/openssl/bin export PATH=$PATH:$OPENSSL source/etc/profile yum install openssl-devel -y #如无法yum下载安装,请修改yum配置文件 测试: ldd /usr/local/openssl/bin/openssl linux-vdso.so.1 => (0x00007fff996b9000) libdl.so.2 => /lib64/libdl.so.2 (0x00000030efc00000) libc.so.6 => /lib64/libc.so.6 (0x00000030f0000000) /lib64/ld-linux-x86-64.so.2 (0x00000030ef800000) which openssl /usr/bin/openssl openssl version OpenSSL 1.0.0-fips 29 Mar 2010 2.2.2keepalived安装 本文在172.17.30.64、172.17.30.83两台机器进行keepalived安装 安装 tar zxvf keepalived-1.2.13.tar.gz cd keepalived-1.2.13 ./configure--prefix=/usr/local/keepalived make make install cp/usr/local/keepalived/sbin/keepalived/usr/sbin/ cp/usr/local/keepalived/etc/sysconfig/keepalived/etc/sysconfig/ cp/usr/local/keepalived/etc/rc.d/init.d/keepalived/etc/init.d/ mkdir/etc/keepalived cp/usr/local/keepalived/etc/keepalived/keepalived.conf /etc/keepalived

软件负载均衡优缺点总结

(总结)Nginx/LVS/HAProxy负载均衡软件的优缺点详解 PS:Nginx/LVS/HAProxy是目前使用最广泛的三种负载均衡软件,本人都在多个项目中实施过,参考了一些资料,结合自己的一些使用经验,总结一下。 一般对负载均衡的使用是随着网站规模的提升根据不同的阶段来使用不同的技术。具体的应用需求还得具体分析,如果是中小型的Web应用,比如日PV小于1000万,用Nginx就完全可以了;如果机器不少,可以用DNS轮询,LVS所耗费的机器还是比较多的;大型网站或重要的服务,且服务器比较多时,可以考虑用LVS。一种是通过硬件来进行进行,常见的硬件有比较昂贵的F5和Array等商用的负载均衡器,它的优点就是有专业的维护团队来对这些服务进行维护、缺点就是花销太大,所以对于规模较小的网络服务来说暂时还没有需要使用;另外一种就是类似于Nginx/LVS/HAProxy的基于Linux的开源免费的负载均衡软件,这些都是通过软件级别来实现,所以费用非常低廉。 目前关于网站架构一般比较合理流行的架构方案:Web前端采用 Nginx/HAProxy+Keepalived作负载均衡器;后端采用MySQL数据库一主多从和读写分离,采用LVS+Keepalived的架构。当然要根据项目具体需求制定方案。 下面说说各自的特点和适用场合。 Nginx的优点是: 1、工作在网络的7层之上,可以针对http应用做一些分流的策略,比如针对域名、目录结构,它的正则规则比HAProxy更为强大和灵活,这也是它目前广泛流行的主要原因之一,Nginx单凭这点可利用的场合就远多于LVS了。 2、Nginx对网络稳定性的依赖非常小,理论上能ping通就就能进行负载功能,这个也是它的优势之一;相反LVS对网络稳定性依赖比较大,这点本人深有体会; 3、Nginx安装和配置比较简单,测试起来比较方便,它基本能把错误用日志打印出来。LVS的配置、测试就要花比较长的时间了,LVS对网络依赖比较大。 3、可以承担高负载压力且稳定,在硬件不差的情况下一般能支撑几万次的并发量,负载度比LVS相对小些。 4、Nginx可以通过端口检测到服务器内部的故障,比如根据服务器处理网页返回的状态码、超时等等,并且会把返回错误的请求重新提交到另一个节点,不过其中缺点就是不支持url来检测。比如用户正在上传一个文件,而处理该上传的节点刚好在上传过程中出现故障,Nginx会把上传切到另一台服务器重新处理,而LVS就直接断掉了,如果是上传一个很大的文件或者很重要的文件的话,用户可能会因此而不满。 5、Nginx不仅仅是一款优秀的负载均衡器/反向代理软件,它同时也是功能强大的Web应用服务器。LNMP也是近几年非常流行的web架构,在高流量的环境中稳定性也很好。 6、Nginx现在作为Web反向加速缓存越来越成熟了,速度比传统的Squid服务器

Keepalived+HAproxy实现redis高可用负载均衡

Keepalived+HAproxy实现redis的高可用负载均衡 总概: Keepalived是一个类似于layer3, 4 & 5交换机制的软件,也就是我们平时说的第3层、第4层和第5层交换。Keepalived的作用是检测web服务器的状态,如果有一台web服务器死机,或工作出现故障,Keepalived将检测到,并将有故障的web服务器从系统中剔除,当web服务器工作正常后Keepalived自动将web服务器加入到服务器群中,这些工作全部自动完成,不需要人工干涉,需要人工做的只是修复故障的web服务器 HAProxy提供高可用性、负载均衡以及基于TCP和HTTP应用的代理,支持虚拟主机,它是免费、快速并且可靠的一种解决方案。HAProxy特别适用于那些负载特大的web站点,这些站点通常又需要会话保持或七层处理。HAProxy运行在当前的硬件上,完全可以支持数以万计的并发连接。并且它的运行模式使得它可以很简单安全的整合进您当前的架构中,同时可以保护你的web服务器不被暴露到网络上。 这里我利用HAproxy对多台redis服务器进行负载,然后用Keepalived对HAproxy进行监控:(主)服务器A:192.168.4.143 (从)服务器B:192.168.4.126 A上安装redis(主)、reids-slave1(从)、redis-slave2(从)、HAproxy、Keepalived B上安装redis-slave3(从)、redis-slave4(从)、HAproxy、Keepalived Keepalived监控A、B上的HAproxy,利用Keepalived的VIP漂移技术,若A、B上的HAprox 都工作正常,则VIP与优先级别高的服务器(主服务器)绑定,当主服务器当掉时,则与从服务器绑定,而VIP则是暴露给外部访问的ip;HAproxy利用Keepalived生产的VIP对多台redis(从)进行读负载,当某台redis当掉,则将其移除,回复后加入集群。 安装redis 1、下载后解压tar zxvf redis-2.6.14.tar.gz 到任意目录,例如/usr/local/redis-2.6.14 解压后,进入redis目录 cd /usr/local/redis-2.6.14 make&& make install 2、配置redis vi /usr/local/redis-2.6.14/redis.conf redis配置文件参数说明: 1. Redis默认不是以守护进程的方式运行,可以通过该配置项修改,使用yes启用守护进程 daemonize no 2. 当Redis以守护进程方式运行时,Redis默认会把pid写入/var/run/redis.pid文件,可以通过pidfile指定

负载均衡之Haproxy配置详解(及httpd配置)-lunique

负载均衡之Haproxy配置详解(及httpd配置) 下图描述了使用keepalived+Haproxy主从配置来达到能够针对前段流量进行负载均衡到多台后端web1、web2、web3、img1、img2.但是由于haproxy会存在单点故障问题,因此使用keepalived来实现对Haproxy单点问题的高可用处理。 常用开源软件负载均衡器有:Nginx、LVS、Haproxy。

衡量负载均衡器好坏的几个重要因素: 1、会话率:单位时间内的处理的请求数 2、会话并发能力:并发处理能力 3、数据率:处理数据能力 经过官方测试统计,haproxy 单位时间处理的最大请求数为20000个,可以同时维护40000-50000个并发连接,最大数据处理能力为10Gbps。综合上述,haproxy是性能优越的负载均衡、反向代理服务器。 总结HAProxy主要优点: 一、免费开源,稳定性也是非常好,这个可通过我做的一些小项目可以看出来,单Haproxy 也跑得不错,稳定性可以与LVS相媲美; 二、根据官方文档,HAProxy可以跑满10Gbps-New benchmark of HAProxy at 10 Gbps using Myricom's 10GbE NICs (Myri-10G PCI-Express),这个作为软件级负载均衡,也是比较惊人的; 三、HAProxy可以作为MySQL、邮件或其它的非web的负载均衡,我们常用于它作为MySQL(读)负载均衡; 四、自带强大的监控服务器状态的页面,实际环境中我们结合Nagios进行邮件或短信报警,这个也是我非常喜欢它的原因之一; 五、HAProxy支持虚拟主机。

软件级负载均衡器的特点和对比

软件级负载均衡器(LVS/HAProxy/Nginx)的特点和对比 现在网站发展的趋势对网络负载均衡的使用是随着网站规模的提升根据不同的阶段来使用不同的技术: 一种是通过硬件来进行进行,常见的硬件有比较昂贵的NetScaler、F5、Radware和Array 等商用的负载均衡器,它的优点就是有专业的维护团队来对这些服务进行维护、缺点就是花销太大,所以对于规模较小的网络服务来说暂时还没有需要使用;另外一种就是类似于LVS/HAProxy、Nginx的基于Linux的开源免费的负载均衡软件策略,这些都是通过软件级别来实现,所以费用非常低廉,所以我个也比较推荐大家采用第二种方案来实施自己网站的负载均衡需求。 近期朋友刘鑫(紫雨荷雪)的项目成功上线了,PV达到了亿级/日的访问量,最前端用的是HAProxy+Keepalived双机作的负载均衡器/反向代理,整个网站非常稳定;这让我更坚定了以前跟老男孩前辈聊的关于网站架构比较合理设计的架构方案:即 Nginx/HAProxy+Keepalived作Web最前端的负载均衡器,后端的MySQL数据库架构采用一主多从,读写分离的方式,采用LVS+Keepalived的方式。 在这里我也有一点要跟大家申明下:很多朋友担心软件级别的负载均衡在高并发流量冲击下的稳定情况,事实是我们通过成功上线的许多网站发现,它们的稳定性也是非常好的,宕机的可能性微乎其微,所以我现在做的项目,基本上没考虑服务级别的高可用了。相信大家对这些软件级别的负载均衡软件都已经有了很深的的认识,下面我就它们的特点和适用场合分别说明下。 LVS:使用集群技术和Linux操作系统实现一个高性能、高可用的服务器,它具有很好的可伸缩性(Scalability)、可靠性(Reliability)和可管理性(Manageability),感谢章文嵩博士为我们提供如此强大实用的开源软件。 LVS的特点是: 1、抗负载能力强、是工作在网络4层之上仅作分发之用,没有流量的产生,这个特点也决定了它在负载均衡软件里的性能最强的; 2、配置性比较低,这是一个缺点也是一个优点,因为没有可太多配置的东西,所以并不需要太多接触,大大减少了人为出错的几率;

redhat 6.4(64位)下HAproxy+Keepalived 负载均衡架构搭建

redhat 6.4(64位)下HAproxy+Keepalived 负载均衡架构搭建(实践版) 一、环境 系统:redhat 6.4 64位 软件:haproxy-1.4.25.tar.gz keepalived-1.2.12.tar.gz 网络: MASTER_IP(haproxy)=192.168.101.1 BACKUP_IP(haproxy)=192.168.101.2 VIP(虚拟IP)=192.168.101.4 关闭SELINUX # vi /etc/sysconfig/config (修改) SELINUX=disabled # setenforce 0 (这个为临时生效,上面的为重启后生效) 关闭防火墙 二、haproxy的安装配置(两台Haproxy的安装配置步骤一样) 1、192.168.101.1主机上的安装haproxy 检查系统的内核版本 # uname -a Linux rac1 2.6.32-358.el6.x86_64 #1 SMP Tue Jan 29 11:47:41 EST 2013 x86_64 x86_64 x86_64 GNU/Linux #使用uname -r查看内核,如:2.6.18-371.el5,此时该参数就为linux26 如x86_64 x86_64 x86_64 GNU/Linux,此时该参数就为x86_64 # tar zxvf haproxy-1.4.25.tar.gz # cd haproxy-1.4.25

# make TARGET=linux2628 ARCH=x86_64 PREFIX=/usr/local/haproxy \\编译参数参考README,其中TARGET是指定内核版本,ARCH指定CPU架构,PREFIX=/usr/local/haproxy安装目录。 gcc -m64 -march=x86-64 -g -o haproxy src/haproxy.o src/sessionhash.o src/base64.o src/protocols.o src/uri_auth.o src/standard.o src/buffers.o src/log.o src/task.o src/time.o src/fd.o src/pipe.o src/regex.o src/cfgparse.o src/server.o src/checks.o src/queue.o src/client.o src/proxy.o src/stick_table.o src/proto_uxst.o src/proto_http.o src/stream_sock.o src/appsession.o src/backend.o src/lb_chash.o src/lb_fwlc.o src/lb_fwrr.o src/lb_map.o src/stream_interface.o src/dumpstats.o src/proto_tcp.o src/session.o src/hdr_idx.o src/ev_select.o src/signal.o src/acl.o src/pattern.o src/memory.o src/freq_ctr.o src/auth.o src/ev_poll.o src/ev_epoll.o src/ev_sepoll.o ebtree/ebtree.o ebtree/eb32tree.o ebtree/eb64tree.o ebtree/ebmbtree.o ebtree/ebsttree.o ebtree/ebimtree.o ebtree/ebistree.o -lcrypt 注:README编译参数参考 Also, you might want to build with libpcre support, which will provide a very efficient regex implementation and will also fix some badness on Solaris' one. To build haproxy, you have to choose your target OS amongst the following ones and assign it to the TARGET variable : - linux22 for Linux 2.2 - linux24 for Linux 2.4 and above (default) - linux24e for Linux 2.4 with support for a working epoll (> 0.21) - linux26 for Linux 2.6 and above - linux2628 for Linux 2.6.28 and above (enables splice and tproxy) - solaris for Solaris 8 or 10 (others untested) - freebsd for FreeBSD 5 to 8.0 (others untested) - osx for Mac OS/X - openbsd for OpenBSD 3.1 to 5.2 (others untested) - aix52 for AIX 5.2 - cygwin for Cygwin - generic for any other OS. - custom to manually adjust every setting # make install PREFIX=/usr/local/haproxy install -d /usr/local/haproxy/sbin install haproxy /usr/local/haproxy/sbin install -d /usr/local/haproxy/share/man/man1 install -m 644 doc/haproxy.1 /usr/local/haproxy/share/man/man1 install -d /usr/local/haproxy/doc/haproxy for x in configuration architecture haproxy-en haproxy-fr; do \

HAproxy负载均衡配置教程

HAproxy负载均衡配置教程 一、简介 haproxy是一个开源的高性能负载均衡软件;支持双机热备、虚拟主机和图形化的管理界面,自带强大的对RS健康检查功能;支持TCP(四层)、HTTP(七层)应用代理功能;多用于PV很大,但是又需要七层应用代理的业务 二、工作原理 1、基于TCP负载均衡工作原理: 使用NAT方式接收和返回请求报文,只单纯对请求流量和返回流量做转发;RS不 用配置公网IP 2、基于HTTP负载均衡工作原理: 使用NAT方式接收和返回请求报文,在接收请求报文后会检查报文头信息,根据 报文头信息匹配Frontend(ACL规则)再转发给Backend(server池);RS不用配 置公网IP 三、安装HAproxy 1、下载haproxy源码包 下载地址:https://www.360docs.net/doc/364058776.html,/download.php?id=40475&ResourceID=12508 2、tar xf haproxy-1.4.22.tar.gz -C /home 3、cd /home/haproxy-1.4.22 4、make TARGET=linux26 ARCH=x86_64 5、make install PREFIX=/usr/local/haproxy 6、ln -s /usr/local/haproxy /usr/haproxy 7、cd /usr/local/haproxy 8、mkdir -p bin conf logs var/run var/chroot 9、cd examples/ 10、cp haproxy.cfg /usr/local/haproxy/etc 11、cp haproxy.init/etc/init.d/haproxy 12、chmod 700 /etc/init.d/haproxy 13、chkconfig --add haproxy 14、chkconfig haproxy on 四、配置基于四层负载均衡 1、vim haproxy.cfg ##全局配置信息### global chroot /usr/local/haproxy/var/chroot #chroot运行路径 daemon #以后台形式运行harpoxy group haproxy #启动程序所用组,随便写,只要下面我们 创建这个组即可 user haproxy #启动程序所用用户,随便写,只要下面我 们创建这个用户即可 log 127.0.0.1:514 local0 warring #定义haproxy 日志存放设备及级别

精选-HCIE-Cloud ManageOne 实验手册

HCIE-Cloud ManageOne 实验手册

1 实验环境介绍 1.1 关于本环境 FusionManager负责资源接入、配置、监控及维护等功能。ServiceCenter负责开户销户、云服务申请、审批、管理等功能。数据中心的FusionSphere OpenStack 可以接入到ServiceCenter中,使得用户可以统一使用数据中心的资源。 1.2 实验室组网介绍 图 1.2-1实验室整体组网 表1

表2

2 实验操作 2.1 配置对接FusionSphere openstack 使用浏览器进入FusionSphere openstack,默认账号cloud_admin,密码:FusionSphere123 (注:FusionManagerIP地址可以通过CPS当中查询出。): 浏览器建议使用Firefox或chrome,IE浏览器在部分场景可能出现兼容性问题。 在FusionManager配置—资源池管理—存储集群--配置存储集群界面;查看确认可用分区信息。

创建主机组:在FusionSphere资源--计算--主机组中,点击创建。 输入主机组名称,并选择可用分区。 为新创建的主机组添加可用分区资源

将左侧的fc-nova-compute添加到右侧的已选择界面,然后点击保存 在FusionSphere openstack查看对接FC资源状态: 为资源池注册镜像模板 在FusionSphere资源--计算—镜像中点击注册 填写镜像参数,类型选项FusionCompute,名称可以自定义,镜像的参数要跟模板文件一致或者不小于模板配置;上传方式选择HTTPS,镜像文件通过浏览的方式,选择VHD 文件。另外文件大小不要超过6G,否则无法上传。 完成后点击注册,然后等待上传完成,耗时大约十分钟左右。

haproxy安装和配置超详细步骤(全部流程)

haproxy安装和配置步骤(全部流程) 此文档是根据网上查找的资料,并通过测试成功配置haproxy负载均衡器整理出来的,这里我将所有操作步骤一步步列出来,这样可以节省大家很多的时间,而且最主要的是非常适合刚开始接触linux系统的初学者,即使什么都不懂也可以完成配置。 部署在centos 6.5系统 软件版本haproxy-1.5.15(1.3.20也可以用过) 假设公网ip地址10.10.10.10 本人都是以管理员身份进行安装。 下载软件 wget https://www.360docs.net/doc/364058776.html,/download/1.5/src/haproxy-1.5.15.tar.gz 解压 tarzxf haproxy-1.5.15.tar.g 进入文件夹后开始安装 cd haproxy-1.5.15 make TARGET=linux26 PREFIX=/usr/local/haproxy #上一条命令如果提示没有gcc编译器,使用下述语句进行安装 yum install ncurses-develgccgcc-c++ make rpm-build make install PREFIX=/usr/local/haproxy cd /usr/local/haproxy/ mkdirconf mkdir logs cd conf #配置文件放在此目录里 以上命令万一有看不懂的哈哈,请上网查一下。 #创建配置文件 vimhaproxy.cfg #如果提示没有vim ,使用下述语句进行安装 yum install vim 复制以下haproxy.cfg配置文件里的代码(可以在windows里创建好文件,用记事本打开编辑好了上传到/usr/local/haproxy/conf文件夹里) global log 127.0.0.1 local0 log 127.0.0.1 local3 #log 127.0.0.1 local1 notice maxconn 60000 chroot /usr/local/haproxy uid 501 gid 501 daemon pidfile /usr/local/haproxy/logs/haproxy.pid defaults