sqoop安装手册

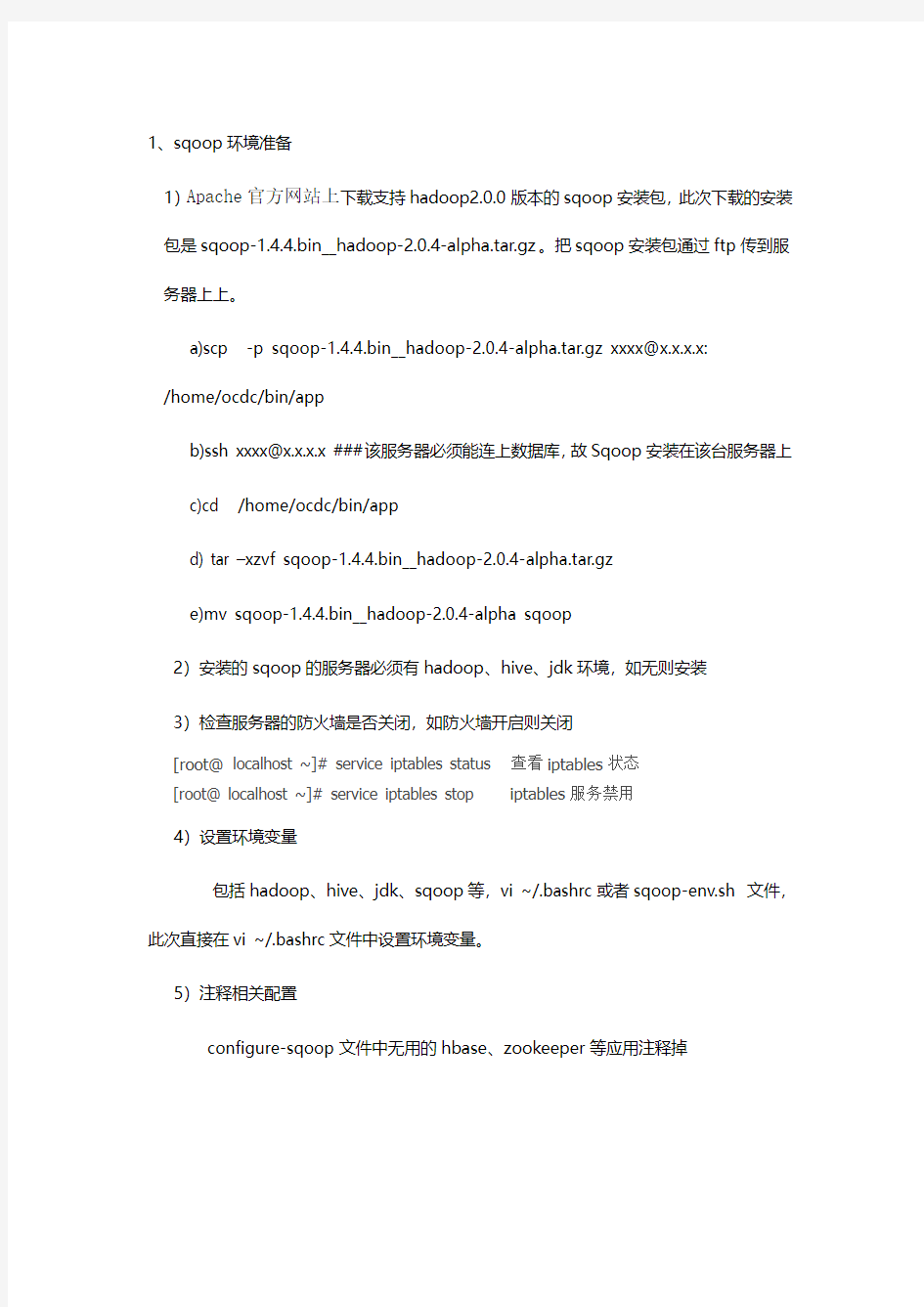

1、sqoop环境准备

1)Apache官方网站上下载支持hadoop2.0.0版本的sqoop安装包,此次下载的安装包是sqoop-1.4.4.bin__hadoop-2.0.4-alpha.tar.gz。把sqoop安装包通过ftp传到服务器上上。

a)scp -p sqoop-1.4.4.bin__hadoop-2.0.4-alpha.tar.gz xxxx@x.x.x.x:

/home/ocdc/bin/app

b)ssh xxxx@x.x.x.x ###该服务器必须能连上数据库,故Sqoop安装在该台服务器上

c)cd /home/ocdc/bin/app

d) tar –xzvf sqoop-1.4.4.bin__hadoop-2.0.4-alpha.tar.gz

e)mv sqoop-1.4.4.bin__hadoop-2.0.4-alpha sqoop

2)安装的sqoop的服务器必须有hadoop、hive、jdk环境,如无则安装

3)检查服务器的防火墙是否关闭,如防火墙开启则关闭

[root@localhost ~]# service iptables status 查看iptables状态

[root@ localhost ~]# service iptables stop iptables服务禁用

4)设置环境变量

包括hadoop、hive、jdk、sqoop等,vi ~/.bashrc或者sqoop-env.sh 文件,此次直接在vi ~/.bashrc文件中设置环境变量。

5)注释相关配置

configure-sqoop文件中无用的hbase、zookeeper等应用注释掉

vi /home/ocdc/bin/app/sqoop/bin/configure-sqoop 如

6)$sqoop help ##测试环境是否准备好

2、连接的数控环境设置

1)查询关系型数据库版本

2)下载关系型数据库JDBC驱动包

3)驱动包放到$SQOOP_HOME/lib目录下

3、测试sqoop环境是否联通

sqoop list-tables --connect jdbc:mysql://192.168.0.1:3306/hive --username 用户名--password密码

sqoop list-tables --connect jdbc:db2:// 192.168.0.1:50000/数据库名--username 用户名--password密码

安装使用手册详细版

Phoenix安装与使用文档 作者:宋亚飞 2015年3月27日 目录 Phoenix安装与使用文档1 目录1 描述1 Phoenix安装2 1、下载Phoenix2 2、上传压缩包3 3、解压缩文件3 4、配置Phoenix3 5、修改权限3 6、验证是否成功3 Phoenix使用4 1、建表4 2、导入数据4 3、查询数据4 查询1、查询全部记录5 查询2、查询记录总条数5 查询3、查询结果分组排序5 查询4、求平均值6 查询5、多字段分组,排序,别名。6 查询6、查询日期类型字段6 查询7、字符串,日期类型转换6 4、Phoenix基本shell命令7 5、用Phoenix Java api操作HBase8 Phoenix支持11 描述 现有hbase的查询工具有很多如:Hive,Tez,Impala,Shark/Spark,Phoenix等。今天主要记录Phoenix。

phoenix,中文译为“凤凰”,很美的名字。Phoenix是由https://www.360docs.net/doc/3710550511.html,开源的一个项目,后又捐给了Apache基金会。它相当于一个Java中间件,提供jdbc连接,操作hbase数据表。 但是在生产环境中,不可以用在OLTP中。在线事务处理的环境中,需要低延迟,而Phoenix在查询HBase时,虽然做了一些优化,但延迟还是不小。所以依然是用在OLAT中,再将结果返回存储下来。 Phoenix官网上,对Phoenix讲解已经很详细了。如果英语好,可以看官网,更正式一些。 Phoenix安装 1、下载Phoenix 下载地址:https://www.360docs.net/doc/3710550511.html,/apache/phoenix/ phoenix与HBase版本对应关系 Phoenix 2.x - HBase 0.94.x Phoenix 3.x - HBase 0.94.x Phoenix 4.x - HBase 0.98.1+ 我目前测试使用版本概况: Hadoop2.2.0--HBase0.98.2 所以我可以用phoenix4.x。下载的压缩包为phoenix-4.3.0-bin.tar.gz

实验13-Spark实验:部署Spark集群

实验十三Spark实验:部署Spark集群 13.1 实验目的 能够理解Spark存在的原因,了解Spark的生态圈,理解Spark体系架构并理解Spark 计算模型。学会部署Spark集群并启动Spark集群,能够配置Spark集群使用HDFS。 13.2 实验要求 要求实验结束时,每位学生均已构建出以Spark集群:master上部署主服务Master;slave1、2、3上部署从服务Worker;client上部署Spark客户端。待集群搭建好后,还需在client上进行下述操作:提交并运行Spark示例代码WordCount,将client上某文件上传至HDFS里刚才新建的目录。 13.3 实验原理 13.3.1 Spark简介 Spark是一个高速的通用型集群计算框架,其内部内嵌了一个用于执行DAG(有向无环图)的工作流引擎,能够将DAG类型的Spark-App拆分成Task序列并在底层框架上运行。在程序接口层,Spark为当前主流语言都提供了编程接口,如用户可以使用Scala、Java、Python、R等高级语言直接编写Spark-App。此外,在核心层之上,Spark还提供了诸如SQL、Mllib、GraphX、Streaming等专用组件,这些组件内置了大量专用算法,充分利用这些组件,能够大大加快Spark-App开发进度。 一般称Spark Core为Spark,Spark Core处于存储层和高层组建层之间,定位为计算引擎,核心功能是并行化执行用户提交的DAG型Spark-App。目前,Spark生态圈主要包括Spark Core和基于Spark Core的独立组件(SQL、Streaming、Mllib和Graphx)。 13.3.2 Spark适用场景 (1)Spark是基于内存的迭代计算框架,适用于需要多次操作特定数据集的应用场合。 (2)由于RDD的特性,Spark不适用那种异步细粒度更新状态的应用,例如web服务的存储或者是增量的web爬虫和索引。 (3)数据量不是特别大,但是要求实时统计分析需求。

spark standalone集群安装步骤总结

经过这两天的详细安装过程,总结Spark Standalone集群安装步骤如下: 环境准备: 1、?一台物理笔记本mac,8G内存;安装三个虚拟机(Virtualbox),虚拟机操作系统 ubuntu12-64bit; 2、三个虚拟机名称(修改主机名: vim /etc/hostname; 增加主机名与IP映射: vim /etc/hosts): 10.0.2.9 master 10.0.2.10 slave1 10.0.2.11 slave2 注意,Virtualbox虚拟机,在NAT模式下,三个节点的IP都是?一样的,能够访问mac主机(mac主机访问不了虚拟机节点); 如果想将三个节点作为集群,必须将??网络模式设置为:内部模式(intnet),linux情况下,?手?工设置IP 地址和?子??网掩码 3、为了避免权限?麻烦,?用户使?用root登录和使?用Ubuntu系统,?而Ubuntu在默认情况下并没有开启root ?用户,需要做如下设置: sudo -s 进?入root?用户权限模式 vim /etc/lightdm/lightdm.conf 增加: [SeatDefaults] greeter-session=unity-greeter user-session=ubuntu greeter-show-manual-login=true #?手?工输?入登录系统的?用户名和密码 allow-guest=false #不允许guest登录 sudo passwd root (?一)JDK安装配置: 1、下载JDK,并创建home??目录,将安装包解压到home??目录: mkdir /usr/lib/java tar zxf jdk-7u51-linux-x64.tar 根据你的操作系统选择jdk版本 2、设置环境变量: vim ~/.bashrc 增加: export JAVA_HOME=/usr/lib/java/jdk1.7.0_51 export JRE_HOME=${JAVA_HOME}/jre export CLASS_PATH=.:${JAVA_HOME}/lib:${JRE_HOME}/lib export PATH=${JAVA_HOME}/bin:${PATH} 使变量?生效: source ~/.bashrc 3、监测java运?行: java -version (?二)hadoop2.6.0安装脚本: (2.1) 安装SSH 1、安装ssh hadoop/spark是采?用ssh进?行通信的,此时我们需要设置密码为空,即不需要密码登录,这样免去每次通信时都输?入密码。 apt-get install ssh /etc/init.d/ssh start #启动ssh服务 ps -e |grep ssh #验证ssh服务是否正常启动 2、设置免密码登录,?生成私钥和公钥 ssh-keygen -t rsa -P "" 上述命令?行在/root/.ssh中?生成两个?文件:id_rsa和id_rsa.pub,id_rsa为私钥,id_rsa.pub为公钥,我们将公钥id_rsa.pub追加到authorized_keys中,命令如下: cat ~/.ssh/id_rsa.pub >> ~/.ssh/authorized.keys ssh master #检查是否免密码登录ssh 3、同理,在slave1和slave2节点上安装ssh并设置免密码登录 4、集群三个节点间免密码ssh登录设置

IDAP安装部署手册

IDAP安装部署手册 浪潮软件集团股份有限公司研发中心 2016.07

1.概述 针对IDAP在Tomcat下的部署过程进行一个简单概述,方便用户进行安装部署。 2.安装部署过程 2.1.将安装包部署到Tomcat 1、将IDAP的安装包复制到Tocmat的webapps目录下。 2、在Tomcat的bin目录下执行startup.sh(Windows下执行startup.bat),启动Tomcat。 3、在Tomcat的bin目录下执行shutdown.sh(Windows下执行shutdown.bat),停止Tomcat。 4、将webapps目录下的war包删除。

2.2.修改Tomcat编码格式 将Tomcat的编码格式改为UTF-8。修改server.xml文件相应端口的Connector 的属性,添加:URIEncoding="UTF-8",如下所示: 2.3.新建mysql数据库 1、验证mysql数据库大小写是否敏感。若大小写敏感,需改成大小写不敏感。编辑mysql安装目录下的https://www.360docs.net/doc/3710550511.html,f(Windows下是my.ini),在[mysqld]节下添加lower_case_table_names=1,保存退出后重启mysql数据库。需要说明的是:Linux 系统下默认是大小写敏感,Windows下默认是大小写不敏感。 2、新建idap数据库,字符集为utf8 -- UTF-8 Unicode。排序规则为utf8_general_ci。如下图所示: 2.4.配置数据源 1、修改Tomcat的conf目录下的context.xml,在末尾前添加连接池配置,如下所示,其中name为连接池名称,url 为数据库连接url,username 为数据库用户名,password为数据库密码。

Hadoop+Spark配置手册 - V3

第一章:Hadoop 2.6.1伪分布式配置手册 第一步:安装虚拟机环境 1.虚拟机环境:VMware workstation 8.0 Centos 6.5 2.文件资源:安装过程中所需要的Centos, Jdk, Hadoop包等可以在 如下地址获取ftp://10.221.18.114/ 3.虚拟机安装:由于机器性能和内存所限,安装虚拟机的时候请调低 内存大小,建议调至512M。在安装Centos系统时请选择命令行模 式,尽量不要以图形界面安装,要不然在做虚拟机集群的时候会很 卡。 4.关闭防火墙: 用chkconfig iptables off 命令关linux掉防火墙 5.配置虚拟机网络访问方式

6.重启系统 7.启动网卡:在虚拟机安装好CentOS后,网卡默认没有启动。通过 “ ifup eth0 ” 命令启动网卡(如果你的网卡不是eth0, 则选则相应网 卡)以便后续通过ssh 工具将安装文件从windows 主机传至虚拟机 第二步: 创建Hadoop 用户 1.使用groupadd创建一个的组 hadoop 命令:groupadd hadoop 2.向hadoop组中加入hadoop用户:useradd –g hadoop 和hadoop 3.创建hadoop 组用户密码: 第三步:配置SSH无密码登录 (https://www.360docs.net/doc/3710550511.html,/article/2fb0ba4043124a00f2ec5f0f.html) 1.在root 用户下修改/etc/ssh/sshd_config,将其中三行的 注释去掉,如下所示: 2.切换至hadoop 用户下,用”ssh-keygen -t rsa” 命令生成密钥对: ssh-keygen -t rsa -P ''

上海通用五菱 乐驰 SPARK维修手册 电路图——原厂

上汽通用五菱《SPARK 车身电器系统》 63 二.SPARK 车身电器系统 1.SPARK 电路图说明 (1 数字时钟线路 D 照明线路继电器 大灯开关 前右停车指示灯泡 组件名称 至头灯线路 图2-1 (2). 线路图各部分说明: 图示位置 说明 A 电源供给线: 30.15a. 15c.Ka.58. B 保险丝号码: Ef20: 引擎室保险丝盒内第#20号保险丝 F2: 车内保险丝盒第#2号保险丝 C 线路接头: C203上的第1号端子 D 时钟电路 E 照明继电器电路 F 大灯开关电路 G 线路颜色辨别 H 接地点: G102

上汽通用五菱《SPARK车身电气系统》 64 (3). 电源供给线路功能 识别符号电源供给情况 30 电瓶电压(B+) 15 点火开关在“II”与“III”位置时通电 15A 点火开关在“II”(IGN2)位置时通电 15C 点火开关在“I”与“II”位置时通电 Ka 仅当钥匙插入时通电. 58 大灯开关在第一,第二段(照明电路) 时通电 31 接地线 (4). 利用配线颜色识别 缩写颜色缩写颜色Br 棕色Sb 浅蓝色 G 绿色R 红色 V 紫色L 蓝色P 粉红色Y 黄色W 白色Gr 灰色Or 橙色 B 黑色Lg 浅绿 (5). 如何检查末端连接插头----------以C901第4针为例: 固定卡销 6针插头第4针 接头(油箱配线) 图2-2

上汽通用五菱《SPARK 车身电器系统》 65 2. 引擎室内保险丝及继电器盒 COOLING FAN HIGH SPEED RELAY: 冷却风扇高速继电器 MAIN RELAY: 主继电器 IGNITION RELAY: 点火继电器 A/C COMP RELAY: 空调压缩机继电器 ILLIMINATION RELAY: 照明继电器 COOLING FAN LOW SPEED RELAY: 冷却风扇低速继电器 FRT FOG RELAY: 前雾灯继电器 HEAD LAMP RELAY: 大灯继电器 HORN RELAY: 喇叭继电器 车内保险丝及继电器盒 BLINKER UNIT: 闪光继电器 WIPER RELAY: 雨刷继电器 REAR FOG LAMP RELAY: 后雾灯继电器 OVER SPEED WARNING BUZZER : 超速报警蜂鸣器(未装备)

Openfire_spark_安装手册

Openfire+Spark安装手册 王保政 QQ:29803446 Msn:baozhengw999@https://www.360docs.net/doc/3710550511.html, 关键字:快速开发平台openjweb 增删改查即时通信 2009-8-29

目录 第一章JA VA领域的IM解决方案 (3) 第二章安装OPENFIRE3.6.4 (3) 2.1配置机器的域名 (3) 2.2安装OPENFIRE (3) 2.2.1 安装 (3) 2.2.2 运行数据库脚本 (4) 2.2.3 数据库驱动jar包 (6) 2.2.4 openfire初始化配置 (6) 2.3设置用户 (12) 第三章安装SPARK客户端 (13) 第四章配置MSN网关 (15) 4.1服务端配置MSN网关 (15) 第五章RED5视频配置 (18) 5.1部署RED5.WAR (18) 5.2 SPARK客户端配置视频插件 (19) 第六章使用SMACK开发即时通信功能 (22)

第一章Java领域的IM解决方案 Java领域的即时通信的解决方案可以考虑openfire+spark+smack。当然也有其他的选择。Openfire是基于Jabber协议(XMPP)实现的即时通信服务器端版本,目前建议使用3.6.4版本,这个版本是当前最新的版本,而且网上可以找到下载的源代码。 即时通信客户端可使用spark2.5.8,这个版本是目前最新的release版本,经过测试发现上一版本在视频支持,msn网关支持上可能有问题,所以选择openfire3.6.4+spark2.5.8是最合适的选择。 Smack是即时通信客户端编程库,目前我已测通通过jsp使用smack的API向openfire 注册用户发送消息,并且可以通过监听器获得此用户的应答消息。 通过smack向msn用户和QQ用户,gtalk用户发送消息应该也可以实现,关于向gtalk 用户发送消息的例子较多。这个留待以后研究。至少目前可以通过程序向spark发消息了。对于局域网内部应用足以解决系统与用户交互的问题,甚至可以做自动应答机器人。 Spark支持聊天,语音,视频,会议,文件收发,截屏,连接msn等功能。 第二章安装openfire3.6.4 2.1 配置机器的域名 使用openfire需要配置机器的域名。如果局域网内没有安装域服务器,则需要手工为机器配置域名,打开C:\WINDOWS\system32\drivers\etc\hosts文件,增加一新行: https://www.360docs.net/doc/3710550511.html, (用户根据自己的需要可配置称别的名字,但最好符合带.的域名格式) 其他机器使用域名访问openfire,也需要在C:\WINDOWS\system32\drivers\etc\hosts中指定https://www.360docs.net/doc/3710550511.html,对应的ip地址,假设安装openfire的主机IP为192.168.1.10,则hosts文件中应增加一新行: 192.168.1.10 https://www.360docs.net/doc/3710550511.html, 通过这种方式指定主机域名,建议安装openfire的机器配置静态ip地址以免ip发生改变。 2.2 安装openfire 2.2.1 安装 安装程序为openfire_3_6_4.exe,运行后,语言选择简体中文,见下图:

Spark使用指南

即时通讯工具Spark安装指南 一.第1步安装(共2步): (2) 二.第2步初始化设置(共1步): (2) a)初始登录: (2) b)一键登录: (2) 三.常用设置: (3) a)联系人显示。 (3) b)面板总在最前。 (3) c)设置用户状态。 (3) 四.高级功能 (4) a)传输文件 (4) b)接收的文件在哪里? (4) c)即时通讯。 (4) d)查看用户信息 (5) e)截图 (6) f)查看会话历史 (6)

一.第1步安装(共2步): a)找到安装软件spark.exe。 b)安装过程全部默认即可。 二.第2步初始化设置(共1步): a)初始登录: 用户名: 系统中的用户名 密码: 系统中的密码 服务器: 请填写堡垒机IP地址,测试环境IP地址为192.168.168.98 设置后界面如下: 点击“登陆”即可。 b)一键登录: 如果设置“保存密码”和“自动登录”后,每次进spark就只要一键登录。

三.常用设置: a)联系人显示。 可以勾选“显示空团体”和“显示离线用户”。 勾选“显示空团体”,联系人列表显示如下: b)面板总在最前。 在系统设置中,勾选“主面板总在最前面”,可以使窗口总最前显示。 c)设置用户状态。

四.高级功能 a)传输文件 通过拖拽文件到对话框,就可以传输文件。或者点击对话框中的 b)接收的文件在哪里? 可以打开存放文件的文件夹。 c)即时通讯。 选中要通讯的人,打开对话框,可以输入文字。

d)查看用户信息 打开对话框,点击。 点击“查看全部档案”。

e)截图 打开对话框,点击。 f)查看会话历史 打开对话框,点击,可以打开聊天记录框。

Sparkplugin开发人员指南【汉化版】

Sparkplug开发人员指南 Sparkplugs是什么? Sparkplugs动态扩展Spark即时通讯客户端。使用Sparkplugs定制Spark,为您的企业或组织开发即时通讯系统,我们希望通过插件的API的描述,让你在开发灵活的Spark客户端变得更加简单,并充满使用乐趣。 本指南提供了SparkAPI和几种常见的例子,如果想更深入的了解请直接转到Javadocs文档中。 我编译了它(Spark),然后呢? 当你编译了超酷的Sparkplug后,就可以很容易的发布给用户,只要将你开发的插件拖到Spark的插件安装路径下,如果你的Sparkplug是普遍有用的,我们希望您能将你的插件分享到Spark社区,将你的Sparkplug插件发送到plugins@https://www.360docs.net/doc/3710550511.html,中,建立https://www.360docs.net/doc/3710550511.html,公共信息库 内容 本文件包含以下信息: ?Spark客户端概述 ?Sparkplug API概述 ?Sparkplug的Java文档 ?插件结构 ?准备开始写你的第一个插件 ?Spark例子和使用方法。在开发Spark的例子和常见的问题。 Spark客户端概述 Spark客户端的设计理念是让不同层次的用户熟悉和使用它,无论是Workspace还是ChatRoom,都可以根据您的需要访问它。

Spark API概述 Spark API提供了一个用于添加之上的协议和/或客户端UI Spark扩展框架。例如,你可以写自己的消息过滤器或添加一个按钮,一个聊天室和使用文件传输的API实现传送文件。Spark API具有以下特征: ?通过事件监听器拦截,得到通知,并响应特定事件IM的自定义代码。 ?允许定制用户界面,从简单的图标更改,添加按钮,以及添加自己的菜单项。 ?能够使用SMACK API添加自己的XMPP协议的功能。 ?管理器(Managers):Spark客户端为开发插件提供延迟加载的接口。相关的管理器的有: ?SparkManager—SparkManager的核心管理模块器。你可以使用这个管理器来获得 ChatManager,SessionManager,SoundManager和UserManager实例。 ?ChatManager—负责处理大多数聊天Chat监听器和过滤器的注册,以及聊天室的 创建和检索。它也可以用来检索ChatFrame用户界面。 ?SessionManager--包含有关当前会话信息,如连接到服务器,连接的错误和个人 存在(presence)变动的通知处理。 ?SoundManager --用于播放声音。 ?事件处理(Event Handlers):Spark包含了大量的监听和处理程序,以便把更多插件可以 嵌入到Spark client。比较常见的监听和处理程序有: ?ChatRoomListener(和ChatRoomListenerAdapter)- 允许的插件监听聊天室被打开,

SPARK乐驰使用手册

CHEVROLET S P A R K 只代表你! 用户手册Owner Manual

忠告 《用户手册》和《保养及保修手册》明确了上汽通用五菱汽车股份有 限公司与用户之间就有关产品的质量保证责任、售后服务方面权利和义务 产生和中止的约定。请务必在使用本公司产品前认真阅读《用户手册》与 《保养及保修手册》。 S P A R K 轿车用户手册 感谢您选择了上汽通用五菱汽车股份有限公司为您精心制造的SPARK轿车。 SPARK轿车采用了高新技术,性能优良。选择SPARK轿车,证明您对汽车的性能和款式都有极高的要求。 请通读本手册,因为其中的信息可让您了解如何正确操控SPARK汽车,并从中获得最大程度的驾乘享受。 本手册适用于LZW7080型轿车。 上汽通用五菱汽车股份有限公司 二○○三年十一月 上汽通用五菱汽车股份有限公司以其独特的经营理念和优秀的企业文化成为汽车工业的又一骄子。我们坚持以理想的车型、适中的价格来满足客户的需求。在这里,先进的技术和管理经验得以运用,各种文化得到充分的尊重和理解。因为我们怀着一个共同的目标,就是把拥有最好的雪佛兰汽车的美好体验带给我们的客户。 1911年,第一辆雪佛兰汽车问世。从此,作为通用汽车公司的旗舰产品,雪佛兰以不断创新和先进技术驰骋世界汽车工业90余年。我们始终将客户对安全、质量、舒适和技术的追求做为我们创造世界一流汽车的基石。90余年来,雪佛兰汽车屡获世界殊荣。在美国,雪佛兰被评为最持久耐用的汽车。迄今为止,雪佛兰汽车的生产和销售遍及世界60多个国家。 2002年6月4日,上汽五菱汽车股份有限公司和通用汽车公司在南宁国际大酒店签署合资协议,2002年11月18日正式成立上汽通用五菱汽车股份有限公司,总投资亿美元,上汽占%的股份、通用占34%的股份、五菱占%的股份。 雪佛兰品牌目标:安全、舒适、可靠、任时间考验 雪佛兰品牌价值: 经久耐用: 长达近一个世纪的承诺,赢得您无限的信赖。在细细品味雪佛兰舒适便捷的驾乘体验的同时,我们提供一流的服务,令您倍感自豪。 领先世界: 将创新带入设计、生产、销售及服务中,以领导者特有的魄力、远见、素质激发团队精

sparkonyarn安装配置手册

一.ssh无密码登陆 1.安装ssh yum install openssh-server 2.产生key ssh-keygen -t rsa -P "" Enter file in which to save the key (/root/.ssh/id_rsa):(按回车)3.使用key cat /root/.ssh/id_rsa.pub >> /root/.ssh/authorized_keys 二.安装配置JDK 1.解压 tar -zxvf jdk-7u71-linux-x64.tar.gz 2.打开全局变量配置文件 vim /etc/profile 3.在该文件末尾增加如下语句 4.使配置生效 source /etc/profile 5.确认JDK安装成功 三.安装配置hadoop 1.解压 tar -zxvf hadoop-2.2.0.tar.gz 2.配置hadoop-env.sh cd /opt/hadoop-2.2.0/etc/hadoop vim hadoop-env.sh 增加如下配置: 3.在/etc/profile里增加如下配置: 尤其最后两行,否则会导致启动错误。 4.配置core-site.xml cd /opt/hadoop-2.2.0/etc/hadoop vim core-site.xml 增加如下配置

还需增加如下配置,否则找不到库

上海通用五菱乐驰SPARK原厂电路图维修手册(可编辑)

上海通用五菱乐驰SPARK原厂电路图维修手册 二.SPARK 车身电器系统 1.SPARK 电路图说明 (1)如何读电路图 数字时钟线路 照明线路继电器 D 大灯开关 前右停车指示灯泡 组件名称

至头灯线路 图2-1 2 .线路图各部分说明: 图示位置说明 A 电源供给线: 30.15a. . B 保险丝号码: Ef20: 引擎室保险丝盒内第#20 号保险丝 F2:车内保险丝盒第#2 号保险丝 C 线路接头: C203 上的第 1 号端子 D 时钟电路

E 照明继电器电路 F 大灯开关电路 G 线路颜色辨别 H 接地点: G102 63 上汽通用五菱《SPARK 车身电器系统》 3 . 电源供给线路功能 识别符号电源供给情况 30 电瓶电压 B+ 15 点火开关在“II”与“III”位置时通电 15A 点火开关在“II” IGN2 位置时通电 15C 点火开关在“I”与“II”位置时通电

Ka 仅当钥匙插入时通电. 58 大灯开关在第一,第二段照明电路时通电 31 接地线 4 . 利用配线颜色识别 缩写颜色缩写 颜色 Br 棕色Sb 浅蓝色 G 绿色R 红色 V 紫色L 蓝色 P 粉红色Y

黄色 W 白色 Gr 灰色 Or 橙色 B 黑色 Lg 浅绿 5 . 如何检查末端连接插头----------以 C901 第 4 针为 例: 固定卡销 6 针插头第 4 针 接头油 箱配线 图2-2

上汽通用五菱《SPARK 车身电气系统》 64 2. 引擎室内保险丝及继电器盒 COOLING FAN HIGH SPEED RELAY: 冷却风扇高速继电器 MAIN RELAY: 主继电器 IGNITION RELAY: 点火继电器 A/C COMP RELAY: 空调压缩机继电器 ILLIMINATION RELAY: 照明继电器 COOLING FAN LOW SPEED RELAY: 冷却风扇低速继电器 FRT FOG RELAY: 前雾灯继电器 HEAD LAMP RELAY: 大灯继电器 HORN RELAY: 喇叭继电器

CDH5.14部署手册

CDH大数据集群部署手册 cdh5.14版本

目录 一、概述 (3) 二、集群部署准备 (3) 1.集群硬件信息 (3) 2.集群服务部署规划 (4) 3.管理节点到其他节点免密钥配置 (5) 4.系统优化 (5) 5.时钟同步 (6) 6.CDH本地yum源搭建 (9) 7.MySQL主从安装配置 (9) 8.创建集群各服务的数据库 (13) 三、应用部署 (13) 1.cloudera manager server安装 (13) 2.cloudera management service安装 (18) 3.hdfs安装 (19) 4.zookeeper安装 (20) 5.yarn安装 (20) 6.hive安装 (21) 7.spark安装 (21) 8.hbase安装 (22) 9.impala安装 (23) 10.oozie安装 (24) 11.sqoop安装 (25) 12.sqoop2安装 (25) 13.kafka安装 (25) 14.kudu安装 (26) 15.hue安装 (27) 16.hdfs高可用 (28) 17.yarn高可用 (30) 18.hiveserver2负载均衡 (30) 19.impalad负载均衡 (33) 20.hue 配置负载均衡的hiveserver2和impala (35) 四、安全部署 (35) 1.Kerberos高可用安装 (35) 2.集群enable Kerberos (41) 3.sentry安装 (43) 4.OpenLDAP安装 (46) 5.Linux系统集成OpenLDAP (51) 6.hue集成ldap用户同步 (54) 7.hive集成LDAP认证 (57) 8.impala集成LDAP认证 (57) 9.LDAP图形客户端Apache Directory Studio (58) 五、集群参数调优 (63)

SPARK安装使用手册

SparkSQL安装使用手册 一、Spark简介 1.1.什么是Spark Spark是UC Berkeley AMP lab所开源的类Hadoop MapReduce的通用并行框架,拥有Hadoop MapReduce所具有的优点;但不同于MapReduce的是Job中间输出结果可以保存在内存中,从而不再需要读写HDFS,因此Spark能更好地适用于数据挖掘与机器学习等需要迭代的MapReduce的算法。 与Hadoop采用MapReduce不同,Spark建立在统一抽象的RDD 之上,使得它可以以基本一致的方式应对不同的大数据处理场景。RDD,全称为Resilient Distributed Datasets,是一个容错的、并行的数据结构,可以让用户显式地将数据存储到磁盘和内存中,并能控制数据的分区。同时,RDD还提供了一组丰富的操作来操作这些数据。 基于Spark的并行运算框架之上,Spark提供了4类应用框架,一是SparkSQL,用于类似Hive的数据仓库方案;二是Spark Streaming,类似于Apache Storm的流计算框架;三是MLib,用于机器学习,四是GraphX,用于图计算。 本文档仅仅介绍SparkSQL相关的内容,其他相关框架在后续逐步学习理解后,将逐步形成文档。 SparkSQL与Hive有着千丝万缕的关系,SparkSQL的前身为Shark,Shark直接使用了Hive的语法解析器、查询优化器等,在后续的SparkSQL中,虽然摆脱了Hive的依赖,但SparkSQL在数据、语法上

完全保证了Hive的兼容。 1.2.Spark架构 Spark提供三种部署方式:独立运行模式(可配置HA模式)、Mesos 集群模式、YARN集群模式。 ?HA的独立运行模式 ?YARN模式 采用YARN模式的话,其实就是把Spark作为一个客户端提交作业给YARN的ResourceManager,实际运行程序的是YARN,就不需要部

SPARK手册

【编者按】时至今日,Spark已成为大数据领域最火的一个开源项目,具备高性能、易于使用等特性。然而作为一个年轻的开源项目,其使用上存在的挑战亦不可为不大,这里为大家分享SciSpike软件架构师Ashwini Kuntamukkala在Dzone上进行的Spark入门总结(虽然有些地方基于的是Spark1.0版本,但仍然值得阅读)——Apache Spark:An Engine for Large-Scale Data Processing,由OneAPM工程师翻译。 本文聚焦Apache Spark入门,了解其在大数据领域的地位,覆盖Apache Spark的安装及应用程序的建立,并解释一些常见的行为和操作。 一、为什么要使用Apache Spark 时下,我们正处在一个“大数据”的时代,每时每刻,都有各种类型的数据被生产。而在此紫外,数据增幅的速度也在显著增加。从广义上看,这些数据包含交易数据、社交媒体内容(比如文本、图像和视频)以及传感器数据。那么,为什么要在这些内容上投入如此多精力,其原因无非就是从海量数据中提取洞见可以对生活和生产实践进行很好的指导。 在几年前,只有少部分公司拥有足够的技术力量和资金去储存和挖掘大量数据,并对其挖掘从而获得洞见。然而,被雅虎2009年开源的Apache Hadoop对这一状况产生了颠覆性的冲击——通过使用商用服务器组成的集群大幅度地降低了海量数据处理的门槛。因此,许多行业(比如Health care、Infrastructure、Finance、Insurance、Telematics、Consumer、Retail、Marketing、E-commerce、Media、Manufacturing和Entertainment)开始了Hadoop的征程,走上了海量数据提取价值的道路。着眼Hadoop,其主要提供了两个方面的功能: ?通过水平扩展商用主机,HDFS提供了一个廉价的方式对海量数据进行容错存储。 ?MapReduce计算范例,提供了一个简单的编程模型来挖掘数据并获得洞见。 下图展示了MapReduce的数据处理流程,其中一个Map-Reduce step的输出将作为下一个典型Hadoop job的输入结果。

spark安装手册(1)

1.引言 本文档描述一个生产型hadoop和spark集群的安装、配置过程。设置单机部署在相应步骤中有描述,可参考。 2.软件包和版本 OS: SLES12 SP3 全部复制到/root/software目录下。 3.集群规范 推荐硬件配置: 处理器:2个6核或8核,主频3GHz 内存: 64-512 GB ECC 存储器:12-24块1-4TB SATA 网络:带链路聚合的千兆以太网 RAID: Namenode可以使用以保护元数据 Datanode 依靠JBOD技术,据说比RAID强 集群规模: 一般认为10个节点算小集群入门规模,咱先按照4台安装,分开部署master,分开部署主namenode和辅助namenode 网络拓扑: 推荐一个机架(rack)安装30-40台服务器,共享1个10GB交换机; 各机架间的交换机通过上行链路与核心交换机或路由器互联(至少 10GB); 同一机架内节点之间的总带宽远高于不同机架间的带宽。 4.创建linux用户账号 HDFS、mapreduce、yarn通常使用独立用户运行,分别命名为hdfs、mapred、yarn,同属于hadoop组。 5.安装java wiki上介绍的java版本都太老了,直接使用jdk8最新版本安装,统一安装在/opt下: cd ~/software tar zxf /opt 编辑/etc/profile,在文件最后添加: # # JAVA setting # export JAVA_HOME=/opt/ PATH=$JAVA_HOME/bin:$PATH export CLASSPATH=.:$JAVA_HOME/lib/:$JAVA_HOME/lib/

Spark平台搭建说明

Spark平台搭建配置文档 前言: 为搭建Spark平台准备Hadoop集群。 虚拟化软件、实验虚拟机准备 1. VMware Workstation 11 注册码/key :1F04Z-6D111-7Z029-AV0Q4-3AEH8 ***便于向vShpere管理的esxi服务器上传在PC机中配置好虚拟机,便于把调试好的试验环境迁移到生产环境。 2.模版机安装 OS:ubuntu-14.04.1-desktop-amd64.iso ***在Ubuntu 中安装VMwareTools以便于在宿主机和虚拟机之间共享内存,可以互相拷贝文本和文件,这个功能很方便,具体参见《Linux虚拟机中手动安装或升级 VMware Tools》。 备注:lolo用户密码为loujianlou,这个安装时候设置,自定义。 (一)登陆和使用系统 备注:以下用vim和gedit修改相应脚本文件均可,如果是命令行就用vim,如果是图形界面就用gedit。 1.进入root用户权限 lolo@lolo-virtual-machine:~$sudo -s root@lolo-virtual-machine:~# apt-get install vim 2.修改lightdm.conf环境变量 root@lolo-virtual-machine:~# vim /etc/lightdm/lightdm.conf [SeatDefaults] user-session=ubuntu greeter-session=unity-greeter 备注:允许用户登陆并关闭guest用户: greeter-show-manual-login=true allow-guest=false 3.启动root账号 root@lolo-virtual-machine:~# sudopasswd root 设置密码:ljl root@lolo-virtual-machine:~#gedit /root/.profile 打开文件后找到“mesg n”, 将其更改为“tty -s &&mesg n” 在刚修改完root权限自动登录后,发现开机出现以下提示: Error found when loading /root/.profile stdin:is not a tty ………… 解决方法:在终端中用命令: root@lolo-virtual-machine:~#reboot –h now

HadoopSpark集群部署手册

1软件环境整体情况说明 2安装包下载路径 3Hadoop2.2安装和配置 3.1集群网络环境 节点IP地址和主机名分布如下: 3.2环境搭建(每台机器都要操作) 3.2.1修改HostName(非必须) vim /etc/sysconfig/network 修改HOSTNAME为需要的名称

重启服务器,进行生效 reboot 3.2.2设置Host映射文件 1.使用root身份编辑/etc/hosts映射文件,设置IP地址及机器名的映射,设置信息如下:vim /etc/hosts 172.16.158.24 DashDB01.yun 172.16.158.25 spark01.yun 172.16.158.26 spark02.yun 172.16.158.27 spark03.yun 2.使用如下命令对网络设置进行重启 /etc/init.d/network restart 3.验证设置是否成功 3.2.3设置操作系统环境 3.2.3.1关闭防火墙 在Hadoop安装过程中需要关闭防火墙和SElinux,否则会出现异常

1.service iptables status查看防火墙状态,如下所示表示iptables已经开启 2.以root用户使用如下命令关闭iptables chkconfig iptables off 3.2.3.2关闭SElinux 1.使用getenforce命令查看是否关闭 2.修改/etc/selinux/config 文件 将SELINUX=enforcing改为SELINUX=disabled,执行该命令后重启机器生效

spark高可用集群(自动切换方式)搭建手册

spark高可用集群搭建手册 (版本7.0.0.5) 中国金融认证中心 2018年02月06日 版权声明:本文档的版权属于中国金融认证中心,任何人或组织未经许可,不得擅自修改、拷贝或以其它方式使用本文档中的内容

文档修订记录本文档会随时保持更新,请与中国金融认证中心索要最新版本

目录 1Hadoop Cluster Setup (1) 2Zookeeper Setup (1) 3 Spark Cluster Setup (1)

1Hadoop Cluster Setup 参考《Hadoop高可用集群搭建手册》 2Zookeeper Setup 1)下载zookeeper并解压 2)修改ZOOKEEPER_HOME/PATH 3)修改${ZOOKEEPER_HOME}/conf/zoo.cfg配置文件 4)拷贝配置文件zoo.cfg到其他节点 3Spark Cluster Setup 3.1 组件安装配置 1)在每台服务器上的/etc/hosts文件中添加. 192.168.114.69xfraud1 192.168.114.70xfraud2 192.168.114.74xfraud3 2)配置机器之间无密码登陆. 用户主目录/root/.ssh/下执行ssh-keygen –t rsa生成id_rsa.pub公钥

然后执行cp id_rsa.pubauthorized.keys 把authorized.keys拷贝到其他服务器上,执行 chmod 600 authorized_keys 3)JDK安装(1.7以上) a)下载jdk解压 地址:https://www.360docs.net/doc/3710550511.html,/technetwork/java/javase/downloads/index.html b)添加环境变量 export JAVA_HOME=/usr/local/jdk1.8.0_121 PATH=$JAVA_HOME/bin:$PATH CLASSPATH=.:$JAVA_HOME/lib/rt.jar export JAVA_HOME PATH CLASSPATH c)保存刷新配置 source /etc/profile 4)scala安装 a)下载scala安装包scala-2.*.*.rpm安装(或下载scala-2.*.*.tar解压) 执行rpm -ivh scala-2.*.*.rpm(tar -zxvf scala-2.*.*.tar) 下载地址:https://www.360docs.net/doc/3710550511.html,/files/archive/ b)添加Scala环境变量,在/etc/profile中添加 5)Spark安装 a)下载二进制包spark-2.*.*-bin-hadoop2.*.tgz 地址:https://www.360docs.net/doc/3710550511.html,/downloads.html b)解压spark tar -zxvf spark-*.tgz c)添加环境变量