深度学习2014-Jiang,Crookes-Deep Salience Visual Salience Modeling via Deep Belief Propagation

Deep Salience: Visual Salience Modeling via Deep Belief Propagation

Richard Jiang Automatic Control and System Engineering The University of Sheffield

Sheffield, United Kingdom

E-mail: richardjiang@https://www.360docs.net/doc/3712468757.html,

Danny Crookes

ECIT Institute Queen’s University Belfast Belfast, United Kingdom E-mail: d.crookes@https://www.360docs.net/doc/3712468757.html,

Abstract

Visual salience is an intriguing phenomenon observed in biological neural systems. Numerous attempts have been made to model visual salience mathematically using various feature contrasts, either locally or globally. However, these algorithmic models tend to ignore the problem’s biological solutions, in which visual salience appears to arise during the propagation of visual stimuli along the visual cortex. In this paper, inspired by the conjecture that salience arises from deep propagation along the visual cortex, we present a Deep Salience model where a multi-layer model based on successive Markov random fields (sMRF) is proposed to analyze the input image successively through its deep belief propagation. As a result, the foreground object can be automatically separated from the background in a fully unsupervised way. Experimental evaluation on the benchmark dataset validated that our Deep Salience model can consistently outperform eleven state-of-the-art salience models, yielding the higher rates in the precision-recall tests and attaining the best F-measure and mean-square error in the experiments.

Introduction

Automated detection of visual objects in images and videos is a subject of primary interest because of its wide application in image/video indexing, content-aware editing, medical image analysis, intelligent computer-human interface, robotic vision, and visual surveillance. Researchers in artificial intelligence and computer vision have successfully developed a number of methods for object detection, such as AdaBoost face detection (Viola and Jones 2001), SVM-based human detection (Vedalid et al2009; Dalal and Triggs 2005), and min-cut object segmentation (Rother et al 2004). These approaches usually depend on training on predefined datasets, or on user input such as scribbles or trimaps. However, when no prior knowledge of image content is available, unsupervised object detection is a hard problem, and it has attracted considerable interest from the research community.

The past decade has seen consistent progress towards unsupervised image segmentation and object detection. A widely-adopted approach is to consider an image principally as a set of hierarchical contours (Arbelaez et al 2011). This assumes that semantic content and the objects usually correspond to specific image structures. Recent research (Farabet et al 2013; Kohli et al 2013) has also suggested that this hierarchical view of image content may be correlated to the deep learning of image structures (Hinton et al 2006). In a development of this approach, we propose in this paper a Deep Salience model based on successive Markov Random Fields (sMRF) for unsupervised object detection. Our work is conceptually related to the recent pioneering work on hierarchical image analysis (Farabet et al 2013; Kohli et al 2013). Unsupervised object detection usually leads to the topic of visual salience, which stems from psychological research on biological visual perception (Koch and Ullman 1985; Itti and Koch 2001). The earliest bio-inspired computational salience model was proposed by Koch and Ullman (1985), where the contrast between visual stimuli (pixels) was considered as the origin of salience awareness. A number of publications (Itti et al 1998; Ma and Zhang 2003; Harel et al 2006; Hou and Zhang 2007; Judd 2009) have followed this roadmap to develop their salience models using a variety of features. These methods are usually based on local contrast and tend to produce higher salience values near edges instead of uniformly highlighting salient objects. Cheng et al(2011) categorized these approaches as local approaches. Recent efforts have been made towards using global contrasts, where pixels or regions were evaluated with respect to the entire image. Achanta et al(2009) proposed a frequency tuned method that defines pixel salience using region-averaged contrast. Goferman et al (2012) used block-based global contrast. Cheng et al (2011) extend Achanta’s method to region-based salience estimation. Perazzi et al (2012) further extend this region-contrast approach by leveraging superpixels. Jiang and Crookes (2012) used mutual information (MI) evaluation with a center-surround a priori map for global salience estimation. Peng et al(2013) introduced the low-rank matrix computation for salience modeling. In summary, both local and global methods have been based on modeling salience using various visual contrast definitions with various features based on pixels, blocks or regions. From a biological viewpoint, we consider the conjecture that human visual salience is a consequence of the deep

Copyright?2014,Association for the Advancement of Artificial

Intelligence(https://www.360docs.net/doc/3712468757.html,).All rights reserved.

Proceedings of the Twenty-Eighth AAAI Conference on Artificial Intelligence

propagation of visual stimuli along the human visual cortex (Ekstorm et al 2008). Hence, it is a complex procedure rather than a simple visual comparison using color contrast. To emulate this biological process, we present a Deep Salience model using our proposed successive Markov Random Fields (sMRF) model.

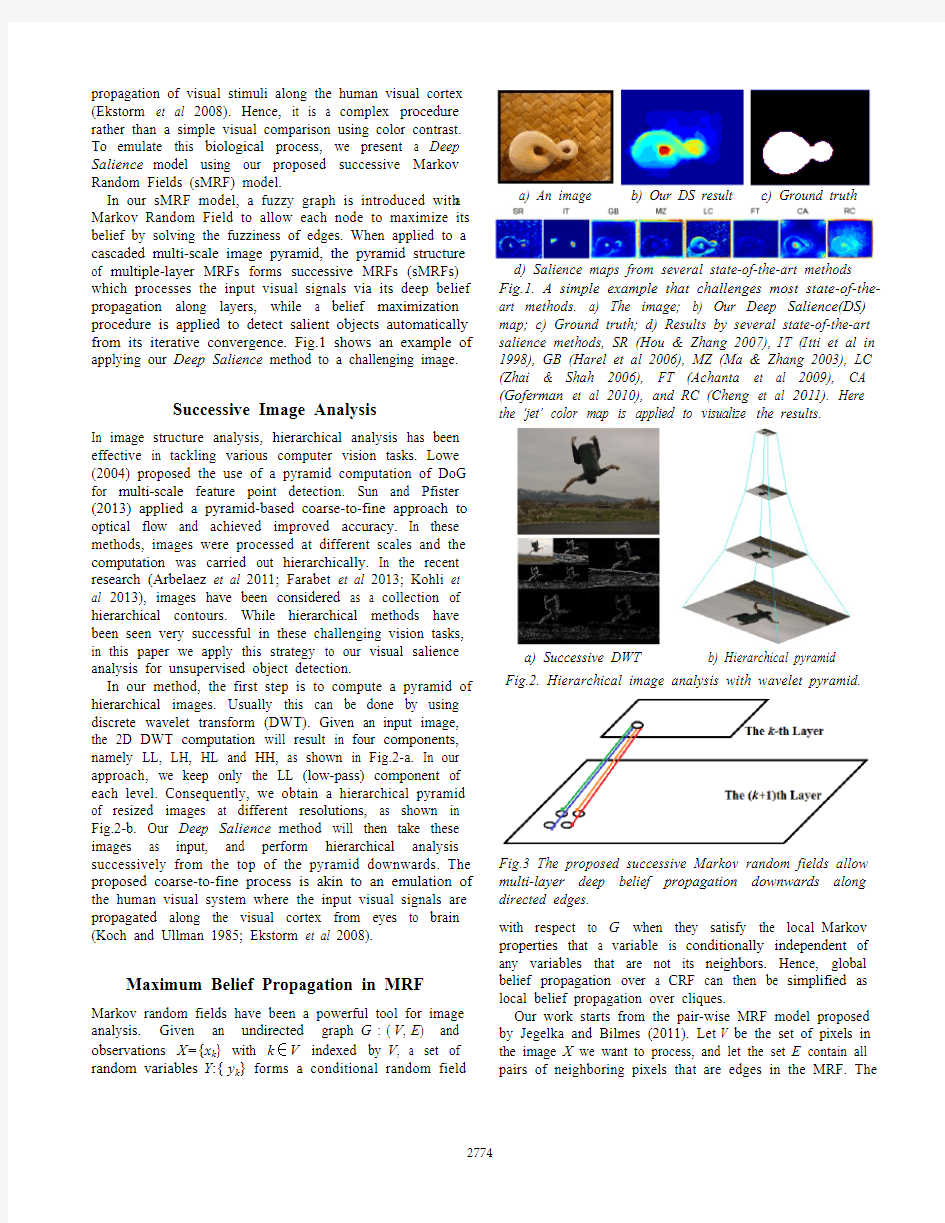

In our sMRF model, a fuzzy graph is introduced with a Markov Random Field to allow each node to maximize its belief by solving the fuzziness of edges. When applied to a cascaded multi-scale image pyramid, the pyramid structure of multiple-layer MRFs forms successive MRFs (sMRFs) which processes the input visual signals via its deep belief propagation along layers, while a belief maximization procedure is applied to detect salient objects automatically from its iterative convergence. Fig.1 shows an example of applying our Deep Salience method to a challenging image.

Successive Image Analysis

In image structure analysis, hierarchical analysis has been effective in tackling various computer vision tasks. Lowe (2004) proposed the use of a pyramid computation of DoG for multi-scale feature point detection. Sun and Pfister (2013) applied a pyramid-based coarse-to-fine approach to optical flow and achieved improved accuracy. In these methods, images were processed at different scales and the computation was carried out hierarchically. In the recent research (Arbelaez et al 2011; Farabet et al 2013; Kohli et al 2013), images have been considered as a collection of hierarchical contours. While hierarchical methods have been seen very successful in these challenging vision tasks, in this paper we apply this strategy to our visual salience analysis for unsupervised object detection.

In our method, the first step is to compute a pyramid of hierarchical images. Usually this can be done by using discrete wavelet transform (DWT). Given an input image, the 2D DWT computation will result in four components, namely LL, LH, HL and HH, as shown in Fig.2-a. In our approach, we keep only the LL (low-pass) component of each level. Consequently, we obtain a hierarchical pyramid of resized images at different resolutions, as shown in Fig.2-b. Our Deep Salience method will then take these images as input, and perform hierarchical analysis successively from the top of the pyramid downwards. The proposed coarse-to-fine process is akin to an emulation of the human visual system where the input visual signals are propagated along the visual cortex from eyes to brain (Koch and Ullman 1985; Ekstorm et al 2008).

Maximum Belief Propagation in MRF

Markov random fields have been a powerful tool for image analysis. Given an undirected graph G = (V , E ) and observations X={x k } with k ∈V indexed by V , a set of random variables Y ={y k } forms a conditional random field

with respect to G when they satisfy the local Markov properties that a variable is conditionally independent of any

variables

that are not its neighbors. Hence, global belief propagation over a CRF can then be simplified as local belief propagation over cliques.

Our work starts from the pair-wise MRF model proposed by Jegelka and Bilmes (2011). Let V be the set of pixels in the image X we want to process, and let the set E contain all pairs of neighboring pixels that are edges in the MRF. The

a) An image

b) Our DS result

c) Ground truth

d) Salience maps from several state-of-the-art methods Fig.1. A simple example that challenges most state-of-the-art methods. a) The image; b) Our Deep Salience(DS) map; c) Ground truth; d) Results by several state-of-the-art salience methods, SR (Hou & Zhang 2007), IT (Itti et al in 1998), GB (Harel et al 2006), MZ (Ma & Zhang 2003), LC (Zhai & Shah 2006), FT (Achanta et al 2009), CA (Goferman et al 2010), and RC (Cheng et al 2011). Here the ‘jet’ color map is applied to visualize the results.

a) Successive DWT b) Hierarchical pyramid Fig.2. Hierarchical image analysis with wavelet pyramid.

Fig.3 The proposed successive Markov random fields allow multi-layer deep belief propagation downwards along directed edges.

label of each pixel in V is given by a binary random variable y i whose labels (0/1) denote the label “foreground”/“background”.

Considering a clique of two vertices i and j , if the confidence on the i -th vertex is known as P i , the belief propagation along the clique edge can be inferred as a MAP (maximum a posteriori) formula:

ij

j i P P (1) ij denotes the conservative probability from the j th vertex

to the i th vertex, which can be simply formulated with the

feature difference between the i th and j th pixels:

j i ij x x (2)

Here, ψ(·) denotes a penalty function when the belief is propagated across two color-different pixels. For example, given a pixel k 0 with a confidence P 0, a neighbor k 1 with exactly the same color should have a confidence P 1=P 0 with ij =0.

A node in a

MRF

may have multiple edges. Typical MRF methods using mean field continuum approximation (Yedidia et al 2005) may easily bleach the edges in an image and allow the belief propagation to cross region borders. To address this problem, we introduce a maximum belief propagation algorithm. We consider all edges of a node as a potential fuzzy edge in a fuzzy graph (Kosko 1986; Blue and Bush 2002; Salzenstein and Collet 2006) E V G ~,~ . Hence, the pixel may have multiple choices of likelihood P i j inferred from different edges, and the fuzziness can be described by:

C

j ij j ij C

j j i ij P f P f Fi (3)

Here, f ij stands for the fuzziness of the j-th fuzzy edge. To

maximize the belief in propagation, we apply a winner-takes-all strategy in the local iteration over random fields,

otherwise ,0max arg when ,1j

i j ij P j f (4)

In the above winner-takes-all strategy, a node always favors the edge with the maximum confidence and dynamically sets other fuzzy edges as disconnected.

A major advantage of the above maximum belief propagation (MBP) algorithm is to guarantee that belief propagation in MRF will not blur the region borders in an input image. Besides, by disconnecting some edges dynamically, MBP inference problem is simplified into a local search of the winner in the fuzzy set of neighbors. In an analogy, the above MBP is more like a quantum mechanism (Birkhoff and Neumann 1936) that allows each node to switch between multiple quantum energy levels, while each fuzzy edge stands for a specific quantum energy level. For our convenience, we refer to our above simple implementation of MBP random fields as Quantum Random Fields (QRF) in this paper. Fig.5 shows the different belief propagation results in our Deep Salience model using typical MRF and our QRF. It is shown that QRF can easily converge on the salient object quickly.

Deep Belief Propagation via Successive MRF

Successive Markov Random Field

In research in unsupervised image segmentation and object detection, a common approach is to consider an image as a set of hierarchical contours (Arbelaez et al 2011). Recent

a) Sample image

b) Level 4

c) Level 3

d) Level 2 e) Level 1 f) Level 0 Fig.4. Deep Salience: Successive salience analysis via deep belief propagation over sMRF.

Images QRF (0.1sec) MRF (3.5sec) Fig.5. DS modeling with sMRF using our QRF or standard MRF at each layer. QRF-based DS takes only 0.1s and highlights the foreground object, while typical MRF based DS needs longer time (3.5s) and blurs the region borders.

Images One-layer MRF sMRF

Fig.6. sMRF vs one-layer MRF: sMRF helps overcome the texture problem by its deep belief propagation.

research (Farabet et al 2013; Kohli et al 2013) has also suggested that this hierarchical view of image content may be correlated to the deep learning of image structures.

As mentioned above, a pyramid of hierarchical images can be obtained from an input image using DWT, as shown in Fig.2. Each image in the pyramid can be mapped as an observation for each layer of successive MRF (sMRF). Fig.3 shows the concept of sMRF, where fuzzy edges not only present in one layer of random fields, but also connect a layer to the previous and next layers. Hence, the belief propagation is carried out down the pyramid of random fields. For a node in our successive QRF (sQRF), its inter-layer edges can be added into the search of its maximum belief,

},{max arg ,

i j i j m P P j (5)

Here

i P is the estimated belief propagated from the nodes in other layers. In this work, we assume that the inter-layer connection is unidirectional so that the belief can only propagate from the upper layer to its lower layer. This implies an inheritance of the confidence map hierarchically down the pyramid from coarse to fine.

Starting from the top level of sMRF, we carry out the maximum belief propagation process (in Eq.(5)) iteratively over each layer of our quantum random field to solve its fuzziness. The computation on the top image (the one resized to 1/2k ) gives the result as the k th level belief map G k . Then the belief map is propagated to the next layer down the pyramid.

Fig.4 shows an example of sMRF. Fig.4-a shows the sample image where, similar to Judd’s work (2009), we assume that most pixels on the borders are taken as background (P B =1). With this priori, the belief is then

propagated based on the coarse observation from the top level, and successively downward to the lower sMRF layers. It can be seen that the resolution of the confidence maps increases and the details are gradually added via deep belief propagation. In our experiment, we use SF method (Perazzi et al 2012) to initialize the border and keep non-salient pixels as initial background.

The benefits of sMRF over single-layer MRF stem from its successive analysis of hierarchical image structures. It focuses on global structures at its initial coarse level and gradually focuses on local details in the subsequent levels. Therefore, it can allow belief propagation to go across texture regions easily. Fig.6 shows several examples comparing sMRF against single-layer MRF. We can see that the belief propagation in single-layer MRF gets stuck in texture-like regions in the background, while sMRF can overcome these local textures and highlight the salient foreground objects successfully in these test images.

Computing Complexity

Usually, the computing complexity of MRF is not readily predictable. However in our sQRF, the problem can become much easier. While the belief propagation is simplified as a local maximum problem in Eq.(5), the computing time is proportional to the range for a belief to propagate from the source to the pixel, which is related to the number of pixels . As shown in Fig.7, our experiment validated that the convergence time of sQRF is nearly proportional to the number of pixels, namely O(N ).

It is noted that sMRF needs to converge on multiple layers. However, the number of nodes has been reduced to 1/2k , and the search space at the top level of the pyramid is then drastically reduced to (1/2k )2 as well. While the sMRF iteration moves downwards, the pre-converged confidence map is inherited by the next level and hence it can be expected to help reduce the total convergence time. Table I gives the experimental results of the computation times at different layers. The computing time was measured for a MATLAB solution. We can see that the single-level MRF took the longest time to converge (210 ms), while 5-level sMRF needs only 23 ms in total for all five levels. From this comparison we can see that successive MRF not only helps overcome texture background, but also helps reduce the computing time.

Experiments

We tested our method on the widely used object dataset ---the EPFL object dataset (Achanta et al 2009), which is publicly available and the ground truth of foreground objects is provided as binary masks. Most state-of-the-art methods have been reported with their benchmark results on this dataset. The EPFL dataset has the same images as MSRA-1000 except that it takes segmented objects as ground truth instead of gaze points from psychological

Fig.7. Computing time versus the number of pixels N. Table I. Convergence time vs the number of layers (ms)

Layers 1 Layer 2 Layer 3 Layer 4 Layer 5 Layer 1st 210 103 78 61 12 2nd -- 29 16 14 4 3rd -- -- 6 3 3 4th -- -- -- 2 2 5th -- -- -- -- 2 Total 210 132 100 80 23

measurement. Hence, the dataset is well suited to our purpose of unsupervised object detection.

Our algorithm was implemented in MATLAB. We ran our code on the dataset, and compared the results against 11 state-of-the-art unsupervised visual salience models. The methods for comparison include: SR (Hou & Zhang 2007), IT (Itti et al in 1998), GB (Harel et al 2006), MZ (Ma & Zhang 2003), LC (Zhai & Shah 2006), FT (Achanta

et al 2009), CA (Goferman et al 2010), HC and RC (Cheng et al 2011), MI (Jiang & Crookes 2012) and SF (Perazzi et al 2012). The following are our experimental results.

Visual Comparison

Fig.8 provides a visual comparison of the various methods using a number of sample images. Most of the state-of-the-art methods failed to find the salient objects in these test images. In comparison, we can see that our Deep Salience method using sMRF can robustly highlight salient objects from their background.

Fig.9 shows several more examples. By applying thresholds of 2*mean and 3*mean respectively to the salience maps, we have firstly identified object-like regions (shown as red rectangles) and then, even further, attempted to identify their salient parts (shown as green rectangles). The success of our sQRF-based object detection can be attributed to the use of hierarchical analysis that is able to capture the global spatial structures of an image. However, we note that we did not build any contrast-based salience model explicitly. Instead, object detection is a natural outcome of maximizing the belief iteratively over the sQRF.

Statistic Evaluation

Fig.10-a shows the typical statistical results of precision-recall curves for the EPFL dataset. The curves are computed in the same way as reported by previous work. Here, precision corresponds to the percentage of salient pixels correctly assigned, while recall rate corresponds to the fraction of detected salient pixels in relation to the number of ground truth salient pixels. As shown in Fig.10-a, our method achieves the best overall precision and recall rates of all the compared methods, and consistently outperforms previous salience models in term of precision and recall rates. It is also observed that the DS curve goes up much steeper than other methods.

Fig.8. Visual comparison of salience maps. From left to right columns: original images; ground truth; salience maps from 1) SR; 2) IT; 3) GB; 4) MZ; 5) LC; 6) FT; 7) CA; 8) HC; 9) RC; 10) SF; and our Deep Salience (DS) maps. It can be seen

that our DS model can robustly highlight salient objects in images where other algorithms failed.

a) Input images b) DS maps c) Detected objects Fig.9. Unsupervised object detection with our Deep Salience model. Red rectangles denote the object-like

regions, and green ones highlight the most salient parts.

Fig.10-b shows the results of F-measure , which combines both precision and recall to evaluate salience cut. Here, we use the adaptive threshold similar to that proposed by Achanta (2009), defined as twice the mean salience of the image. Appling this threshold to the salience map, we

can get the precision and recall of its binary cut, and then the F-measure can be subsequently computed by:

Precision Recall Recall Precision F (6)

From Fig.10-b, we can see that our Deep Salience achieves the best F-measure score than all the other methods in the comparison.

Precision and recall measures do not consider true negative salience assignment, i.e., the number of pixel correctly marked as non-salient. Moreover, the quality of the weighted, continuous saliency maps may be of higher importance than the binary masks from psychological view of visual attention. To measure how successful a method is in the detection of non-salient background regions, we also carried out the comparison using mean square error (MSE ) between the continuous saliency map S (before thresholding) and the binary ground truth G . MSE measure is then defined as,

x y

y x G y x S H W MSE 2

,,1 (7) where W and H are the width and the height of the respective saliency map and ground truth image.

Figure 11 shows that our method also outperforms other approaches in terms of the MSE measure, which provides a better estimate of the dissimilarity between the saliency map and ground truth. Results have been averaged over all images in the test dataset.

Conclusion

In conclusion, a new salience model has been successfully developed for unsupervised object detection via its deep belief propagation along the pyramid of successive Markov Random Fields (sMRF). The hierarchical structure of sMRF helps overcome the problem of background textures in belief propagation and also speeds up the convergence in multi-layer MRFs. It is also worth noting that our maximum belief propagation in QRF differs from typical mean-field approximation in that it employs a dynamic selection of fuzzy edges in its random fields, making it possible to guarantee that the belief propagation will not bleed over region borders in an image. Our benchmark experiments successfully validated that the proposed Deep Salience method consistently achieved better rates in precision-recall curves, and also attained better scores in both F-measure and MSE tests.

This work was initially inspired by the observed fact that visual salience arises during the propagation of visual stimuli along human visual cortex. Unlike most previous methods that are based on algorithmic math computation of various global contrasts, our salience estimation is a natural outcome of visual signal propagation over sMRF, which is more like the way how our human vision system processes the input visual signals.

a) Precision-recall test

b) F-measure test

Fig.10. Evaluation on the EPFL database. a) Precision-recall test: DS model consistently achieved the best prevision/recall rates; b) F-measure test: DS attained the best

scores

in F-measure and recall, and the precision after thresholding was exceeded only by RC and SF.

Fig.11. Mean square error (MSE) test.

References

Achanta, R.; Hemami, S.; Estrada, F.; Susstrunk, S. 2009. Frequency-tuned salient region detection. In CVPR’09, 1597–1604.

Arbelaez, P.;? Maire, M.;? Fowlkes, C.;? Malik, J. 2011. Contour detection and hierarchical image segmentation. In IEEE TP AMI, 33(5): 898-916.

Birkhoff, G.; Neumann, J. V. 1936. The Logic of Quantum Mechanics. Annals of Mathematics, 37: 823–843.

Blue, M.;? Bush, B. 2002. Unified approach to fuzzy graph problems. Fuzzy Sets and Systems, 125(3):355–368.

Cheng, M.; Zhang, G.; Mitra, N. J.; Huang, X.; Hu, S. 2011. Global Contrast based Salient Region Detection. In CVPR’11, 409-416.

Dalal, N.; Triggs, B. 2005. Histograms of oriented gradients for human detection. In CVPR’05.

Ekstrom, L. B.; Roelfsema, P. R.; Arsenault, J. T.; Bonmassar, G.; Vanduffel, W. 2008. Bottom-up dependent gating of frontal signals in early visual cortex. Science, 321(5887): 414-417. Farabet, C.;? Couprie, C.;? Najman L.;? LeCun, Y. 2013. Learning hierarchical features for scene labeling. In IEEE TP AMI, 35(8): 1915-1929.

Goferman, S.;? Zelnik-Manor, L.;? Tal, A. 2010. Context-aware saliency detection. In CVPR’10.

Harel, J.;? Koch, C.;? Perona, P. 2006. Graph-based visual saliency. In NIPS, 545–552.

Hou, X.;? Zhang, L. 2007. Saliency detection: A spectral residual approach. In CVPR’07, 1–8.

Hinton, G. E.;? Salakhutdinov, R. 2006. Reducing the dimensionality of data with neural networks. In Science, 313(5786): 504-507.

Itti, L.; Koch, C. 2001. Computational modelling of visual attention. Nature Reviews Neuroscience, 2:194–203.

Itti, L.;? Koch, C.;? Niebur, E. 1998. A model of saliency-based visual attention for rapid scene analysis. In IEEE TP AMI, 20(11):1254–1259.

Jegelka, S.;? Bilmes, J. 2011. Submodularity beyond submodular energies: Coupling edges in graph cuts. In CVPR’11, 1897-1904. Jiang, R.;? Crookes, D. 2012. Visual saliency estimation through manifold learning. In AAAI’12.

Judd, T. 2009. Learning to predict where humans look. In ICCV’09.

Kohli, P.;? Osokin, A.;? Jegelka, S. 2013. A principled deep random field model for image segmentation. In CVPR’13.

Koch, C.;? Ullman, S. 1985. Shifts in selective visual attention: towards the underlying neural circuitry. Human Neurobiology, 4:219–227.

Kosko, B. 1986. Fuzzy cognitive maps. International Journal of Man-Machine Studies, 24(1):65-75.

Lowe, D. G. 2004. Distinctive image features from scale-invariant keypoints. In IJCV, 60(2): 91-110.

Ma, Y. F.;? Zhang, H. J. 2003. Contrast-based image attention analysis by using fuzzy growing. In ACM Multimedia’03, 374-381.

Perazzi, F.;? Kr?henbül, P.;? Pritch, Y.;? Hornung, A. 2012. Saliency Filters: Contrast Based Filtering for Salient Region Detection. In CVPR’12.

Peng, H.;? Li, B.;? Ji, R.;? Hu, W. 2013. Salient object detection via low-rank and structured sparse matrix decomposition. In AAAI-13. Rother, C.;? Kolmogorov, V.;? Blake, A. 2004. Grabcut–Interactive foreground extraction using iterated graph cuts. In ACM Trans. Graph., 23(3): 309-314.

Salzenstein, F.;? Collet, C. 2006. Fuzzy Markov Random Fields versus Chains for Multispectral Image Segmentation. IEEE TP AMI, 28(11): 1753 - 1767.

Sun, D.;? Wulff, J.;? Sudderth, E. B.;? Pfister, H.;? Black, M. J. 2013.

A fully-connected layered model of foreground and background flow. In CVPR'13, 2451-2458.

Viola, P.;? Jones, M. 2001. Robust real-time object detection. In ICCV’01.

Vedaldi, A.;? Gulshan, V.;? Varma, M.;? Zisserman, A. 2009. Multiple kernels for object detection. In ICCV’09.

Yedidia, J. S.;? Freeman, W. T.;? Weiss, Y. 2005. Constructing Free Energy Approximations and Generalized Belief Propagation Algorithms. IEEE Trans. Information Theory, 51:2282-2312. Zhai, Y.;? Shah, M. 2006. Visual attention detection in video sequences using spatiotemporal cues. In ACM Multimedia’06, 815-824.

基于知识库的手写体数字识别

HUNAN UNIVERSITY 课程模式识别 题目基于知识库的手写体数字识别学生姓名 学生学号

专业班级 学院名称 2016 年6 月25 日

基于知识库的手写体数字识别 1案例背景: 手写体数字识别是图像识别学科下的一个分支,是图像处理和模式识别研究领域的重要应用之一,并且具有很强的通用性。由于手写数字的随意性很大,如笔画粗细、字体大小、倾斜角度等因素都有可能直接影响到字符的识别准确率,所以手写体数字识别是一个很有挑战性的课题。在过去的数十年中,研究者们提出了许多识别方法,并取得了一定的成果。在大规模数据统计如例行年检、人口普查、财务、税务、邮件分拣等应用领域都有广阔的应用前景。 本案例实现了手写阿拉伯数字的识别过程,并对手写数字识别的基于统计的方法进行了简要介绍和分析。本文实现的手写字体识别程序具有手写数字图像读取、特征提取、数字模板特征库以及识别功能。 2 理论基础: 2-1手写字体识别方法: 手写体数字识别是一个跨学科的复杂问题,综合了图像处理、模式识别、机器学习等多个领域的知识,其识别过程一般包含图像预处理、特征提取、分类器的设定及其后处理等组成。处理流程如图2-1所示。

图2-1 手写体数子识别流程图 2-2 图像预处理 手写体数字识别的首要工作是图像预处理。在图像预处理过程中需要解决的主要问题有:定位、图像二值化、平滑化(去噪)H J、字符切分、规范化等。图像二值化是指将整个图像呈现出明显的黑白效果。待识别的手写体数字图像在扫描过程中,常会带来一些噪声,用不同的扫描分辨率得到的数字图像,其质量也各不相同,故而要先将这些干扰因素排除掉。另外,还需要正确分割整幅文档图像中的手写体数字,而分割后的数字大小、字体常各不相同,故还需进行归一化处理。 2-3 特征提取 特征提取的目的是从经过预处理后的数字图像中,提取出用以区分与其它数字类别的本质属性并数值化,形成特征矢量的过程。常见的手写体数字特征有:模板特征、统计特征、结构特征和变换特征。 2-4 分类器 不同的分类方式对应不同的分类器,可选的分类器有神经网络、支持向量机

毕业论文计算机手写数字识别技术完整版

毕业论文计算机手写数 字识别技术 HEN system office room 【HEN16H-HENS2AHENS8Q8-HENH1688】

合肥学院 2007届毕业设计(论文) 基于模板匹配算法的字符识别系 设计(论文)题 目 统研究与实现 院系名称计算机科学与技术系 专业(班级)计算机科学与技术 2003级1班 姓名(学号)宋飞(0) 指导教师赵大政 系负责人袁暋 二O O七年五月二十三日 摘要 自从计算机问世以来,让机器具有模式识别能力一直是计算机科学家们的努力方向。研究表明,对视觉和听觉信息的处理过程,不仅仅是一个感知过程,也是一个认知过程。因此,研究模式识别,是理解人类智能的本质的重要途径。字符识别是一个传统和典型的模式识别问题,脱机手写数字识别是一个典型的大类别的模式识别问题。手写体数字具有不同字符字型相差不大、相同字符有多种不同写法、数字没有上下文关系等等特点,使得脱机手写体数字识别成为识别领域最大的难题和最终的目标。在这种大类别识别的研究中,传统上大多采用模板匹配的方法来解决问题。而在模板匹配算法中,得计算其特征值。图像需要经过二值化,细化等预处理。 关键字模板匹配;特征值;细化;二值化 ABSTRACT Since computer appeared, it has been an effort direction for scientist to let the computer has the ability of pattern recognition. Researching indicates that the procedure to deal with seeing and hearing not only a procedure of perception but also cognition. Therefore, studying pattern recognition is an important way in understanding the mankind’s intelligence

手写数字识别的实现

燕山大学 课程设计说明书 题目:手写数字识别的实现 学院(系):电气工程学院 年级专业: 08-自动化仪表 学号: 080103020179 学生姓名:付成超 指导教师:林洪彬程淑红 教师职称:讲师讲师 2010年 12 月 24 日

燕山大学课程设计(论文)任务书 院(系):电气工程学院基层教学单位:自动化仪表系 学号080103020179 学生姓名付成超专业(班级)自动化仪表设计题目手写数字识别实现 设 计技术参数 通过由数字构成的图像,自动实现几个不同数字的识别,设计识别方法,有较高的识别率 设计要求 设计图像中不同数字的识别方法,可以先从两个数字的识别开始,尽量实现多个不同数字的识别。设计中应该有自己的思想、设计体会 工作量1.分析图像特征,查阅相关资料,根据图像的特征提出解决问题的思路。2.查阅相关资料,学会MATLAB的编程方法 3.根据解决思路,编辑程序,根据调试结果,修改相应思路,找出最佳解决方案 工作计划周一分析图像,查阅各种资料,提出可行的解决方案。周二熟悉MATLAB软件,学会软件的简单编程方法。 周三根据可行的方法,编写程序,调试并修改方案。周四根据调试结果,选取最佳方案并完成设计论文。周五进一步完善设计论文,准备论文答辩。 参考资料[] MICHAEL SIPSER著,张立昂等译,《计算理论导引》,机械工业出版社,2000。 [2] 王晓龙,关毅等编,《计算机自然语言处理》,清华大学出版社,2005。 [3] R.C.Gonzales等著,阮秋崎等译,《数字图像处理》,电子工业出版社,2002。 [4] 王文杰等编,《人工智能原理》,人民邮电出版社,2003。 指导教师签字基层教学单位主任签字 2010年 12 月 24 日

人工智能,机器学习和深度学习之间的差异是什么

人工智能,机器学习和深度学习之间的差异是什么? 人工智能的定义可以分为两部分,即“人工”和“智能”。“人工”比较好理解,争议性也不大。有时我们会要考虑什么是人力所能及制造的,或者人自身的智能程度有没有高到可以创造人工智能的地步,等等。但总的来说,“人工系统”就是通常意义下的人工系统。 人工智能+区块链的发展趋势及应用调研报告 如果你在科技领域,你经常会听到人工智能,机器学习,甚至是深度学习。怎样才可以在正确的时间正确的使用这些词?他们都是一样的意思吗?然而更多时候,人们总是混淆的使用它们。 人工智能,机器学习和深度学习都是属于一个领域的一个子集。但是人工智能是机器学习的首要范畴。机器学习是深度学习的首要范畴。 深度学习是机器学习的一个子集,机器学习是人工智能的一个子集 这个领域的兴起应该归功于深度学习。人工智能和机器学习这个领域近年来一直在解决一系列有趣的问题,比如从自动化的杂货店购买到自动驾驶汽车。

人工智能: 人工智能的定义可以分为两部分,即“人工”和“智能”。“人工”比较好理解,争议性也不大。有时我们会要考虑什么是人力所能及制造的,或者人自身的智能程度有没有高到可以创造人工智能的地步,等等。但总的来说,“人工系统”就是通常意义下的人工系统。 尼尔逊教授对人工智能下了这样一个定义:“人工智能是关于知识的学科――怎样表示知识以及怎样获得知识并使用知识的科学。”而另一个美国麻省理工学院的温斯顿教授认为:“人工智能就是研究如何使计算机去做过去只有人才能做的智能工作。”这些说法反映了人工智能学科的基本思想和基本内容。即人工智能是研究人类智能活动的规律,构造具有一定智能的人工系统,研究如何让计算机去完成以往需要人的智力才能胜任的工作,也就是研究如何应用计算机的软硬件来模拟人类某些智能行为的基本理论、方法和技术。 人工智能是研究使计算机来模拟人的某些思维过程和智能行为(如学习、推理、思考、规划等)的学科,主要包括计算机实现智能的原理、制造类似于人脑智能的计算机,使计算机能实现更高层次的应用。人工智能将涉及到计算机科学、心

手写数字识别系统的设计与实现

] 手写数字识别系统的设计与实现 摘要本手写数字识别系统是一个以VISUAL STUDIO C++ 为编译环境,使用MFC进行图形图像界面开发的系统。主要功能是通过在点击手写数字识别菜单下的绘制数字标签弹出的绘制数字窗口中完成数字的手写,在此窗口中可以进行数字的保存及清屏,然后通过文件菜单中的打开标签打开所绘制的数字,从而进行数字的预处理,其中包括灰度化及二值化处理,然后进行特征提取,最后实现数字的识别。本系统的界面设计友好,流程正确,功能也较为完善。实验结果表明,本系统具有较高的识别率。 关键词:绘制数字;预处理;特征提取;特征库;数字识别 / ;

目录 前言 (1) 概述 (2) 1 需求分析 (4) 功能需求分析 (4) , 性能需求分析 (4) 数据需求分析 (5) 相关软件介绍 (5) 2 手写数字识别系统的设计与基本原理 (6) 系统整体功能模块设计 (6) 手写数字识别系统的基本原理 (6) 数字图像的绘制 (6) 图像的预处理 (6) ) 图像的特征提取 (7) 特征库的建立 (8) 图像数字的识别 (8) 3 手写数字识别系统程序设计 (8) 数字图像的绘制 (8) 数字的特征提取 (15) 模板特征库的建立 (18) 数字的识别 (20) (

总结 (23) 致谢 (24) 参考文献 (25)

前言 自上世纪六十年代以来,计算机视觉与图像处理越来越受到人们的关注,并逐渐成为一门重要的学科领域。而作为它们的研究对象的数字图像,也因为它含有研究目标的丰富信息而成为越来越重要的研究对象。图像识别的目标是用计算机自动完成某些信息的处理,用来替代人工去处理图像分类及识别的任务。 手写数字识别是图像识别学科下的一个分支,是图像处理和模式识别领域研究的课题之一,由于其具有很强的实用性一直是多年来的研究热点。由于手写体数字的随意性很大,例如,笔画的粗细,字体的大小,倾斜等等都直接影响到字符的正确识别,所以手写体数字识别是一个很有挑战性的课题。在过去的数十年中,研究者们提出了许多的识别方法,取得了较大的成果。手写体数字识别实用性很强,在大规模数据统计(如例行年检,人口普查),财务,税务,邮件分拣等等应用领域中都有广阔的应用前景。本课题拟研究手写体数字识别的理论和方法,开发一个小型的手写体数字识别系统。 在研究手写体数字识别理论和方法的基础上,开发这样一个小型的手写体数字识别系统需要完成以下主要方面的研究与设计工作:手写数字绘制的问题、数字的预处理问题、特征提取问题、特征库的建立问题、数字识别问题。

武汉大学文学院各专业培养方案(2010级、2011级、2012级用)

武汉大学文学院简介 文学院中文学科发端于1893年建校之初的自强学堂。起初开设“华文”课,后改称“汉文”。国立武昌高等师范学校时期,于1917年设立国文史地部。1922年正式成立国文系,中文学科从此有了独立的行政建制。1927年改称中国文学系。1928年国立武汉大学成立时设置文学院,闻一多先生出任首任院长。1953年,兄弟学校中文系并入武汉大学组建了新的中国语言文学系。1997年改建文学院。1999年与其他学院合并为人文科学学院。2003年7月恢复文学院建制至今。 文学院暨中文学科创建以来,名流云集,代有传人。在1928 年以前的初创时期,著名学者王葆心、黄福、黄侃、廖立勋、郁达夫、杨振声等等,筚路蓝缕,开启先路,奠定了文学院的坚实基础。其中,黄侃先生与章太炎先生所创立的“章黄学派”饮誉海内外,对文学院的学风和学术发展产生了深远影响。1928年之后的数十年是文学院的发展壮大时期。杨树达、闻一多、刘博平、刘永济、刘异、游国恩、苏雪林、叶圣陶、沈从文、朱东润、高亨、冯沅君、袁昌英、陈西滢、徐天闵、朱光潜、陈登恪、席鲁思、黄焯、程千帆、刘绶松、胡国瑞、李健章、周大璞、李格非等先辈,鞠躬尽瘁,不断开拓,使文学院的中文学科迅速发展壮大、走向辉煌,跃居全国同类学科前列。尤其是五十年代,以“五老八中”为代表的学术中坚声名远播。改革开放以来,是文学院奋发图强、蓬勃向上的时期。这一时期,刘禹昌、吴林伯、王启兴、陆耀东、王文生、吴志达、何国瑞、蔡守湘、易竹贤、罗立乾、陈美兰、李希贤、夏渌、郑远汉、宗福邦、杨合鸣、龙泉明等学者,励精图治,奋起直追,为文学院再铸辉煌做出了重要贡献。 如今的文学院,下设中国文学系、汉语言文化系、大学语文部、古籍整理研究所、《长江学术》杂志社、《写作》杂志社等常设机构,还与“国家汉办”合作建立了“汉语国际推广教学资源研究与开发基地”,建有海外孔子学院。共有教职工88人,其中专任教师65人。教师中教授32人,博士生导师30人,副教授26人。学院拥有中国语言文学一级学科博士学位授予权和博士后流动站;拥有国家重点学科一个,国家重点培育学科一个,中国语言文学一级学科被评为湖北省重点学科,中国现当代文学和中国古代文学分别被评为湖北省优势学科和特色学科。人才培养方面,在国家规定的中国语言文学学科的8个学位点中,除中国少数民族语言文学之

计算语言学与语义分析

汉语计算语言学与语义分析研究 编码——解码 表达——理解 自然语言生成——自然语言处理 只有真正熟悉了汉语的语素,词,词义以及相互之间的 关系,才能正确的理解出语义,并制定相关的语义解析 规则

一绪论 1、语义识别背景 语义识别是在语音识别(或其它模式识别)的基础上,对获取的客观字符文本数据,做进一步的分析挖掘,提取其中所包含 的用户主观意图 语义识别技术,目的是让计算机能够理解人类的语言。通俗的定义:即通过用户无规则的说话就能知道用户想做什么 语义识别技术涉及:海量数据处理、分词、语素、义素、语义特征建模、规则库等主要技术

音节和音节相连时,有的音节的调值会发生有规律的变化 有些音节的读音在一定条件下失去了原有声调的调值 句子不同的连停方式,也会对语义的理解产生影响语音中的重音强调不同,所含的语义也不同 语音影响语义 有些音节的读音在一定条件下失去了原有声调的调值 2、语音对语义识别的影响 汉字的读音影响机器语音识别,进而影响到语义识别

?2、语义识别的关键技术难点?(1)提供高准确率的语音识别系统?(2)系统分词算法的精确度?(3)计算机如何尽可能的消除歧义?(4)语义分析的特征建模 ?(5)服务于建模的规则库的建立

语法基本单位 语素最小的语法单位,是语言中最小的音 义结合体,既有声音,又有意义 “妹妹不吃白菜”就包 含 “妹”“妹”“不”“ 吃”“白”“菜”这六 个语素 词有意义的能独立运用的最小的语言语 法单位,词都是由语素构成的 妹—妹妹、白—菜—白 菜、不—吃—不吃 词组词和词按一定句法规则组合成的比词 大的语法单位 句子“长虹生产电视” 是由“长虹”和词组 “生产电视”组成的, 而“生产电视”又是由 词组“生产”和“电视” 组成的 句子语言中最大的语法单位,通常是由一 个词或者词组加上一个句调形成的 (1)你喜欢看电视吗? (2)能看高清电视了!

基于神经网络的手写数字识别系统的设计与实现

中南大学 本科生毕业论文(设计) 题目基于神经网络的手写数字 识别系统的设计与实现

目录 摘要 (Ⅰ) ABSTRACT (Ⅱ) 第一章绪论 (1) 1.1手写体数字识别研究的发展及研究现状 (1) 1.2神经网络在手写体数字识别中的应用 (2) 1.3 论文结构简介 (3) 第二章手写体数字识别 (4) 2.1手写体数字识别的一般方法及难点 (4) 2.2 图像预处理概述 (5) 2.3 图像预处理的处理步骤 (5) 2.3.1 图像的平滑去噪 (5) 2.3.2 二值话处理 (6) 2.3.3 归一化 (7) 2.3.4 细化 (8) 2.4 小结 (9) 第三章特征提取 (10) 3.1 特征提取的概述 (10) 3.2 统计特征 (10) 3.3 结构特征 (11) 3.3.1 结构特征提取 (11) 3.3.2 笔划特征的提取 (11) 3.3.3 数字的特征向量说明 (12) 3.3 知识库的建立 (12) 第四章神经网络在数字识别中的应用 (14) 4.1 神经网络简介及其工作原理 (14) 4.1.1神经网络概述[14] (14) 4.1.2神经网络的工作原理 (14) 4.2神经网络的学习与训练[15] (15) 4.3 BP神经网络 (16) 4.3.1 BP算法 (16) 4.3.2 BP网络的一般学习算法 (16)

4.3.3 BP网络的设计 (18) 4.4 BP学习算法的局限性与对策 (20) 4.5 对BP算法的改进 (21) 第五章系统的实现与结果分析 (23) 5.1 软件开发平台 (23) 5.1.1 MATLAB简介 (23) 5.1.2 MATLAB的特点 (23) 5.1.3 使用MATLAB的优势 (23) 5.2 系统设计思路 (24) 5.3 系统流程图 (24) 5.4 MATLAB程序设计 (24) 5.5 实验数据及结果分析 (26) 结论 (27) 参考文献 (28) 致谢 (30) 附录 (31)

手写体数字识别系统

石河子大学 信息科学与技术学院毕业论文 课题名称:手写体数字识别系统设计 学生姓名: 学号: 学院:信息科学与技术学院 专业年级:电子信息工程2007级 指导教师: 职称: 完成日期:二○一一年六月十一日

手写体数字识别系统设计 学生: 指导教师: [摘要] 随着科学技术的迅速发展,在邮政编码、统计报表、财务报表、银行票据等处理大量字符信息录入的场合,手写数字识别系统的应用需求越来越强烈,如何将数字方便、快速地输入到计算机中已成为关系到计算机技术普及的关键问题。本文设计实现了一个基于Matlab软件的手写体数字识别系统,采用模块化设计方法,编写了摄像头输入、直接读取图片、写字板输入三个模块,利用摄像头等工具,将以文本形式存在的手写体数字输入进计算机,完成对手写体数字图片的采集,并设计了一种手写数字识别方法,对手写体数字图像进行预处理、结构特征提取、分类识别,最终以文本形式输出数字,从而实现手写体数字的识别。 [关键词] 预处理,结构特征提取,分类识别,手写体数字识别 I

Handwritten Digit Recognition System Students: Teacher: Abstract:With the rapid development of science and technology, in zip code, statistics, reports, financial statements, Bank bills dealing with a large number of characters, such as information recorded occasions, handwritten digit recognition system of requirement has become stronger and stronger, how easily and quickly the number entered in the computer has become a key issue relates to the popularization of computer technology. This article design implementation has a based on Matlab software of handwriting body digital recognition system, used module of design method, write has camera entered, and directly read pictures, and write Board entered three a module, using camera, tools, will to text form exists of handwriting body digital entered into computer, completed on handwriting body digital pictures of collection, and design has a handwriting digital recognition method, on handwriting body digital image for pretreatment, and structure features extraction, and classification recognition, eventually to text form output digital, to implementation handwriting body digital of recognition. Key words: Pretreatment, structure feature extraction, classification and recognition, handwritten digit recognition. II

手写数字识别的原理及应用

手写数字识别的原理及应用 林晓帆丁晓青吴佑寿 一、引言 手写数字识别(Handwritten Numeral Recognition)是光学字符识别技术(Optical Character Recognition,简称OCR)的一个分支,它研究的对象是:如何利用电子计算机自动辨认人手写在纸张上的阿拉伯数字。 在整个OCR领域中,最为困难的就是脱机手写字符的识别。到目前为止,尽管人们在脱机手写英文、汉字识别的研究中已取得很多可喜成就,但距实用还有一定距离。而在手写数字识别这个方向上,经过多年研究,研究工作者已经开始把它向各种实际应用推广,为手写数据的高速自动输入提供了一种解决方案。 二、研究的实际背景 字符识别处理的信息可分为两大类:一类是文字信息,处理的主要是用各国家、各民族的文字(如:汉字,英文等)书写或印刷的文本信息,目前在印刷体和联机手写方面技术已趋向成熟,并推出了很多应用系统;另一类是数据信息,主要是由阿拉伯数字及少量特殊符号组成的各种编号和统计数据,如:邮政编码、统计报表、财务报表、银行票据等等,处理这类信息的核心技术是手写数字识别。这几年来我国开始大力推广的“三金”工程在很大程度上要依赖数据信息的输入,如果能通过手写数字识别技术实现信息的自动录入,无疑会促进这一事业的进展。因此,手写数字的识别研究有着重大的现实意义,一旦研究成功并投入应用,将产生巨大的社会和经济效益。 三、研究的理论意义 手写数字识别作为模式识别领域的一个重要问题,也有着重要的理论价值: 1.阿拉伯数字是唯一的被世界各国通用的符号,对手写数字识别的研究基本上与文化背景无关,这样就为各国,各地区的研究工作者提供了一个施展才智的大舞台。在这一领域大家可以探讨,比较各种研究方法。 2.由于数字识别的类别数较小,有助于做深入分析及验证一些新的理论。这方面最明显的例子就是人工神经网络(ANN)------相当一部分的ANN模型和算法都以手写数字识别作为具体的实验平台,验证理论的有效性,评价各种方法的优缺点。 3.尽管人们对手写数字的识别已从事了很长时间的研究,并已取得了很多成果,但到目前为止机器的识别本领还无法与人的认知能力相比,这仍是一个有难度的开放问题(Open problem)。

手写体数字识别系统的设计与实现

大学生研究计划项目 论文报告 项目名称:_手写体数字识别系统的设计与实现 负责人:_________ _______________ 学院/专业:_____ ______ 学号:____ ________ 申请经费:_____ _________________ 指导教师:______ _______ 项目起止时间:2011年6月-2012年3月

摘要 手写体数字识别系统依托计算机应用软件为载体,利用C++程序设计的相关知识,运用模块设计等相关技术,最终完成手写体设计系统的程序综合设计。 关键字:手写体数字处理模式识别程序设计 一、论题概述 模式识别是六十年代初迅速发展起来的一门学科。由于它研究的是如何用机器来实现人(及某些动物)对事物的学习、识别和判断能力,因而受到了很多科技领域研究人员的注意,成为人工智能研究的一个重要方面。 字符识别是模式识别的一个传统研究领域。从50年代开始,许多的研究者就在这一研究领域开展了广泛的探索,并为模式识别的发展产生了积极的影响。 字符识别一般可以分为两类:1.联机字符识别;2.光学字符识别(Optical Chara- cter Recognition,OCR)或称离线字符识别。在联机字符识别中,计算机能够通过与计算机相连的输入设备获得输入字符笔划的顺序、笔划的方向以及字符的形状,所以相对OCR来说它更容易识别一些。但联机字符识别有一个重要的不足就是要求输入者必须在指定的设备上书写,然而人们在生活中大部分的书写情况是不满足这一要求的,比如人们填写各种表格资料,开具支票等。如果需要计算机去认识这些己经成为文字的东西,就需要OCR技术。比起联机字符识别来,OCR不要求书写者在特定输入设备上书写,它可以与平常一样书写,所以OCR 的应用更为广泛。OCR所使用的输入设备可以是任何一种图像采集设备,如CCD、扫描仪、数字相机等。通过使用这类采集设备,OCR系统将书写者已写好的文字作为图像输入到计算机中,然后由计算机去识别。由于OCR的输入只是简单的一副图像,它就不能像联机输入那样比较容易的从物理特性上获得字符笔划的顺序信息,因此OCR是一个更具挑战性的问题。 数字识别是多年来的研究热点,也是字符识别中的一个特别问题,它是本文研究的重点。数字识别在特定的环境下应用特别广泛,如邮政编码自动识别系统,税表和银行支票自动处理系统等。一般情况下,当涉及到数字识别时,人们往往要求识别器有很高的识别可靠性,特别是有关金额的数字识别时,如支票中填写

从语言学到深度学习nlp一文概述自然语言处理

从语言学到深度学习nlp一文概述自然语言处理 自然语言处理(NLP)近来因为人类语言的计算表征和分析而获得越来越多的关注。它已经应用于许多如机器翻译、垃圾邮件检测、信息提取、自动摘要、医疗和问答系统等领域。本论文从历史和发展的角度讨论不同层次的NLP 和自然语言生成(NLG)的不同部分,以呈现NLP 应用的各种最新技术和当前的趋势与挑战。 1 前言 自然语言处理(NLP)是人工智能和语言学的一部分,它致力于使用计算机理解人类语言中的句子或词语。NLP 以降低用户工作量并满足使用自然语言进行人机交互的愿望为目的。因为用户可能不熟悉机器语言,所以NLP 就能帮助这样的用户使用自然语言和机器交流。 语言可以被定义为一组规则或符号。我们会组合符号并用来传递信息或广播信息。NLP 基本上可以分为两个部分,即自然语言理解和自然语言生成,它们演化为理解和生成文本的任务(图1)。 图1:NLP 的粗分类 语言学是语言的科学,它包括代表声音的音系学(Phonology)、代表构词法的词态学(Morphology)、代表语句结构的句法学(Syntax)、代表理解的语义句法学(Semantics

syntax)和语用学(Pragmatics)。 NLP 的研究任务如自动摘要、指代消解(Co-Reference Resolution)、语篇分析、机器翻译、语素切分(Morphological Segmentation)、命名实体识别、光学字符识别和词性标注等。自动摘要即对一组文本的详细信息以一种特定的格式生成 一个摘要。指代消解指的是用句子或更大的一组文本确定哪些词指代的是相同对象。语篇分析指识别连接文本的语篇结构,而机器翻译则指两种或多种语言之间的自动翻译。词素切分表示将词汇分割为词素,并识别词素的类别。命名实体识别(NER)描述了一串文本,并确定哪一个名词指代专有名词。光学字符识别(OCR)给出了打印版文档(如PDF)中间的文字信息。词性标注描述了一个句子及其每个单词的词性。虽然这些NLP 任务看起来彼此不同,但实际上它们经常多个任务协同处理。 2 NLP 的层级 语言的层级是表达NLP 的最具解释性的方法,能通过实现内容规划(Content Planning)、语句规划(Sentence Planning)与表层实现(Surface Realization)三个阶段,帮助NLP 生成文本(图2)。 图2:NLP 架构的阶段 语言学是涉及到语言、语境和各种语言形式的学科。与NLP 相关的重要术语包括:

计算语言学概论——应用语言学系列教材

本书简介 本教材从“基础”“算法”和“应用”三个方面,较为系统地介绍计算语言学的基础理论、相关的自然语言处理技术和应用。 基础部分(包括一、二、三章)主要讲述计算语言学的数学和语言学基本概念,计算语言学和自然语言处理技术的关系,自然语言处理的基本流程等内容。此外,作为计算语言学的重要分支之一,语料库语言学得到了较大发展,有关语料库语言学的基础概念、基本理论、近年来的一些发展概况在第三章中加以介绍。介绍这部分内容的目的,是让读者在不涉及技术细节的情况下,对计算语言学有一个初步的,同时也是较为全面的理解和掌握。 算法部分(包括第四、五章)主要介绍计算语言学的常用技术和算法。从处理对象来讲,主要包括词法层面的分析技术、句法层面的分析技术和语义层面的处理技术;从处理方法来讲,既有传统的规则方法,也有基于语料库的统计方法的介绍。这部分内容的主旨是希望通过本章学习后,使学生能对计算语言学的领域中的一些主流技术(比如隐马尔可夫模型在词性标注中的应用,GLR算法 ,部分分析技术等)有一个概要的认识,并能运用这些技术进行计算语言学相关的工作实践。

应用部分(包括第六、七章)主要讲授自然语言处理应用系统。需要说明的是,基于语言信息处理技术的应用系统很多,本教材只是重点介绍一些常见的系统,介绍这些系统的工作机理、发展、取得的成绩,也客观介绍这些系统存在的问题和困难。主要包括机器翻译系统,信息检索系统、信息提取系统,文本分类系统等。 目录 第一章 绪论:什么是计算语言学 第一节 计算语言学的研究对象 第二节 计算语言学的研究方法 第三节 计算语言学的实际应用 第四节 小结 第二章 语言知识的形式化表达 第一节 语言与语言知识 第二节 形式化表达手段 第三节 语法知识的形式化表述理论体系 第四节 语义知识的形式化表述理论体系 第五节 语篇知识的形式化表述理论体系 第六节 小结 第三章 语料库:语言知识的另一种表示形式 第一节 语料库研究概况 第二节 语料的收集与加工 第三节 语料库的应用 第四节 小结 第四章 词法分析 第一节 概述 第二节 “词”的识别 第三节 词性标注 第四节 词义标注 第五节 小结 第五章 句法分析 第一节 句法分析导引 第二节 广义LR分析算法 第三节 基于线图的分析技术 第四节 其他句法分析技术 第五节 小结 第六章 机器翻译 第一节 机器翻译概述 第二节 基于规则的机器翻译 第三节 基于语料库的机器翻译以及混合式机器翻译 第四节 机器翻译的困难、对策和评价 第五节 小结 第七章 面向文本的智能信息处理 第一节 信息检索 第二节 信息提取 第三节 文本自动分类 第四节 小结

手写数字识别实践指导手册

手写数字系统实践指导手册 1 问题描述 设计一个简单的手写数字识别系统,能够识别手写输入的数字1-9并且能够识别选中的文本文件中的数字,应具有简单方便的操作界面,输入输出等。 1.1功能需求分析 通过分析,以及从用户的角度考虑,系统应该具有以下功能: (1)数字的手写输入。作为一个手写数字识别系统,首先应该能够让用户过绘制窗口进行数字绘制,系统得到用户的手写输入进行处理。 (2)直接选择文件。用户还可以选择系统中的文本文件进行处理。 (3)数据预处理。包括计算数据大小、二值化、格式化处理等。 (4)数字提取。将经过二值化后的图像中的个数字区域进行提取,只有能够将数字进行准确的提取,才能将其一一识别。 (5)基准库的选择与建立。选择一个可供系统训练和测试的样本库非常重要,本系统的训练集和测试集选择的是《机器学习实战》中所给的数据。 (6)识别数字。经过训练集进行训练后,使用knn算法对需要识别的数字识别。 2 数据集获取 ●任务要求: 从网上爬取或者下载适合进行手写数字识别系统的训练集和测试集 ●实践指导: 方式一:自己从网上找适合的数据下载 方式二:推荐数据集:“手写数字数据集的光学识别”一文中的数据集合,该文登载与2010年10月3日的UCI机器学习资料库中https://www.360docs.net/doc/3712468757.html,/ml

3 功能设计与实现 3.1手写数字识别系统结构图: 图一:系统结构图 3.2识别用户选择手选文件功能设计与实现 ●任务要求: 用户可以自己从电脑中选择文本文件进行识别。 ●实践指导: KNN分类器的构造思路及原理如下: 1)选择训练集和测试集。系统所采用的数据集选用的是“手写数字数据集的光学识别”一文中的数据集合。0-9每个数字大约有200个训练数据20个测试数据。数字的文本格式如图所示。

手写体数字识别方法的研究与实现

手写体数字识别方法的研究与实现 摘要 1引言 手写体数字识别是文字识别中的一个研究课题,是多年来的研究热点,也是模式识别领域中最成功的应用之一。由于识别类型较少,在实际生活中有深远的应用需求,一直得到广泛的重视。近年来随着计算机技术和数字图像处理技术的飞速发展,数字识别在电子商务、机器自动输入等场合已经获得成功的实际应用。尽管人们对手写数字的研究己从事了很长时间的研究,并己取得了很多成果,但到目前为止,机器的识别本领还无法与人的认知能力相比,这仍是一个有难度的开放问题,所以对手写数字识别的进一步研究,寻求如何更高效更准确更节能地实现手写数字的自动录入和识别的解决方案对提高经济效益、推动社会发展都有深远的意义。 近年来, 人工神经网技术发展十分迅速, 它具有模拟人类部分形象思维的能力, 为模式识别开辟了新的途径, 成了模拟人工智能的一种重要方法,特别是它的信息并行分布式处理能力和自学习功能等显著优点, 更是激起了人们对它的极大的兴趣。BP(Back Propagation)网络是神经网络中一种,是1986年由Rumelhart和McCelland为首的科学家小组提出,是一种按误差逆传播算法训练的多层前馈网络,可以很好地解决非线性问题,在函数逼近、模式识别和数据压缩等方面都有很广泛的应用。我们在认真地研究了神经网络的基本原理和机制的基础上, 结合手写体数字识别这一具体课题, 提出了用BP神经网络方法来实现手写体数字 识别的方案。 2手写体数字识别概述 2.1手写数字识别简述 模式识别是六十年代初迅速发展起来的一门学科。由于它研究的是如何用机器来实现人及某些动物对事物的学习、识别和判断能力,因而受到了很多科技领域研究人员的注意,成为人工智能研究的一个重要方面。 字符识别是模式识别的一个传统研究领域。从50年代开始,许多的研究者就在这一研究领域开展了广泛的探索,并为模式识别的发展产生了积极的影响。 手写体数字识别是多年来的研究热点也是字符识别中的一个特别问题。手写体数字识别在特定的环境下,如邮政编码自动识别系统,税表和银行支票自动处理系统等一般情况。当涉及到数字识别时,人们往往要求识别器有很高的识别可靠性,特别是有关金额的数字识别时,如支票中填写的金额部分,更是如此。因此针对这类问题的处理系统设计的关键环节之一就是设计出高可靠性和高识别率的手写体数字识别方法。这个领域取得了飞速的发展,部分是由于更好的学习算法,部分是由于更优良的训练集。美国国家科学学会(NIST)建立了

数字识别的主要算法

BP神经网络识别手写数字 1.图像的预处理 对手写数字图像样本灰度化处理,二值化处理,归一化调整等预处理。其中二值化处理利用greythresh函数得到图像的全局阈值,然后使用im2bw将灰度图像转换为二值图像。 Ibw = im2bw(I1,greythresh(I1)); --Ibw为二值化图像的存储矩阵。 bw2 = edu_imgcrop(Ibw); %找到图像边界 [y2temp x2temp] = size(bw); x1=1; y1=1; x2=x2temp; y2=y2temp; % 找左边空白 cntB=1; while (sum(bw(:,cntB))==y2temp) x1=x1+1; cntB=cntB+1; end

% 左边 cntB=1; while (sum(bw(cntB,:))==x2temp) y1=y1+1; cntB=cntB+1; end % 上边 cntB=x2temp; while (sum(bw(:,cntB))==y2temp) x2=x2-1; cntB=cntB-1; end % 下边 cntB=y2temp; while (sum(bw(cntB,:))==x2temp) y2=y2-1; cntB=cntB-1; end bw2=imcrop(bw,[x1,y1,(x2-x1),(y2-y1)]); --对图像进行裁剪,使边框完全贴近字符。 归一化处理将图片归一化为28×28像素点阵图。 2.特征提取 将经过预处理的后的数字图像中提取最能体现这个字符特点的特征向量,然后提取出训练样本中的特征向量带入BP网络中就可以对网络进行训练。可以采用逐像素特征提取方法提取数字样本的特征向量。归一化后的图像形成一个28 28 的布尔矩阵,依次取每列的元素转化为784×1的列矩阵,及数字字符的特征向量。还可以对每幅单个手写体图像进行边缘裁剪后,将裁减后的二值图像

《计算语言学》简评

龙源期刊网 https://www.360docs.net/doc/3712468757.html, 《计算语言学》简评 作者:刘金路 来源:《湖北函授大学学报》2015年第13期 [摘要]计算语言学是一门横跨语言学、数学和计算机科学的边缘性交叉学科。《计算语言学》是清华大学中国语言文学系刘颖教授的新作,该书系统介绍了计算语言学的相关理论及计算方法。从方法论视角看,该书对推动语言学或计算语言学学科建设及发展具有重要意义。 [关键词]计算语言学;计算机科学;交叉学科 [中图分类号]G642 [文献标识码]A [文章编号]1671-5918(2015)13-0122-03 计算语言学(Computational Linguistics)是当代语言学中的一个新兴学科。《计算语言学》是清华大学中国语言文学系刘颖教授的一部新作,由清华大学出版社于2014年9月出版。刘颖教授研究计算语言学、自然语言处理和机器翻译多年,已出版著作四部,发表相关专业论文近六十篇。本书是2002年10月出版的《计算语言学》的修订版本,全书系统介绍了计算语言学的相关理论与计算方法,以及统计语言学与机器翻译的相关理论。近十几年来,国内对于计算语言学的相关著作尤其是系统性介绍的书籍还是为数不多的,许多对计算语言学感兴趣的研究者们迫切需要这样的一本较为全面性的书籍问世。相信本书应该会受到计算语言学界学者及研究者的极大关注。本文首先探讨计算语言学的背景,之后简要介绍该书各章节的主要内容,最后在此基础之上对该书作出简要评价。 一、背景介绍 二十世纪四十年代到五十年代末这段时期可谓是计算语言学的萌芽期。虽然“计算语言学”这个术语概念还未被提出,但是有很多具备先见之明的研究者及学者们就开始从计算的角度来探讨语言现象,揭示语言所具有的数学性。 二十世纪六十年代的中期到八十年代末可以算作是计算语言学的主要发展期。在此期间,许多的相关学科在相互借鉴,互为补充的基础上取得了不少鼓舞人心的成果。 在二十世纪九十年代的最后五年,计算语言学的研究变化显著,出现了空前繁荣的局面。这主要表现在以下三个方面:首先,概率与数据驱动方法成了计算语言学的标准方法。其次,由于计算机速度与其存储量的增加,使得在计算语言学的某些领域,特别是语音合成、语音识别、文字识别、拼写检查、语法检查这些应用领域,有可能进行商品化的开发。第三,随着网

大学计算机基础--人工智能基础思考与练习[1]

思考与练习 一、单选题 1.人工智能是一门( B )。 A.数学和生理学 B.心理学和生理学 C.语言学 D.综合性的交叉学科和边缘学科 2.机器学习的核心任务是在新的、未知的数据中执行得好。而这种在未知数据中执行的能力,称为( A )。 A.泛化能力 B.过拟合 C.欠拟合 D.正则化 3.( A )以住宅为平台,兼备建筑设备、网络通讯、信息家电和设备自动化,集系统、结构、服务、管理为一体的高效、舒适、安全、便利、环保的居住环境。 A.智能家居 B.专家系统 C.模式识别 D.智能控制 4.以下属于机器学习研究领域的是( D )。 A.模式识别 B.计算机视觉 C.语音识别 D.以上都是 5.人工智能概念的确立是在( D )年。 A.1946 B.1960 C.1916 D.1956 6.下面不属于人工智能研究基本内容的是( C )。 A.机器感知 B.机器学习 C.自动化 D.机器思维 7.要想让机器具有智能,必须让机器具有知识。因此,在人工智能中有一个研究领域,主要研究计算机如何自动获取知识和技能,实现自我完善,这门研究分支学科叫( B )。 A.专家系统 B.机器学习 C.神经网络 D.模式识别 8.人工智能的目的是让机器能够( A ),以实现某些脑力劳动的机械化。 A.模拟、延伸和扩展人的智能 B.具有完全的智能

C.和人脑一样考虑问题 D.完全代替人 9.自然语言理解是人工智能的重要应用领域,下面列举中的( C )不是它要实现的目标。 A.理解别人讲的话 B.对自然语言表示的信息进行分析概括或编辑 C.欣赏音乐 D.机器翻译 10.下列关于人工智能的叙述不正确的是( C )。 A.人工智能技术它与其他科学技术相结合极大地提高了应用技术的智能化水平。 B.人工智能是科学技术发展的趋势。 C.因为人工智能的系统研究是从上世纪五十年代才开始的,非常新,所以十分重要。 D.人工智能有力地促进了社会的发展。 11.为了解决如何模拟人类的感性思维,例如视觉理解、直觉思维、悟性等,研究者找到一个重要的信息处理的机制是( B ) 。 A.专家系统 B.人工神经网络 C.模式识别 D.智能代理 12.下列哪个表达式在Python中是非法的?( B ) A.x = y = z = 1 B.x = (y = z + 1) C.x, y = y, x D.x += y 13.下列代码的运行结果是?( C ) print (‘a' < 'b' < 'c') A.a B.c C.True D.False 14.a与b定义如下,下列哪个是正确的?( B ) a = '123' b = '123' A.a != b B.a is b C.a == 123