双数组Trie树算法优化极其应用研究

决策树算法研究及应用概要

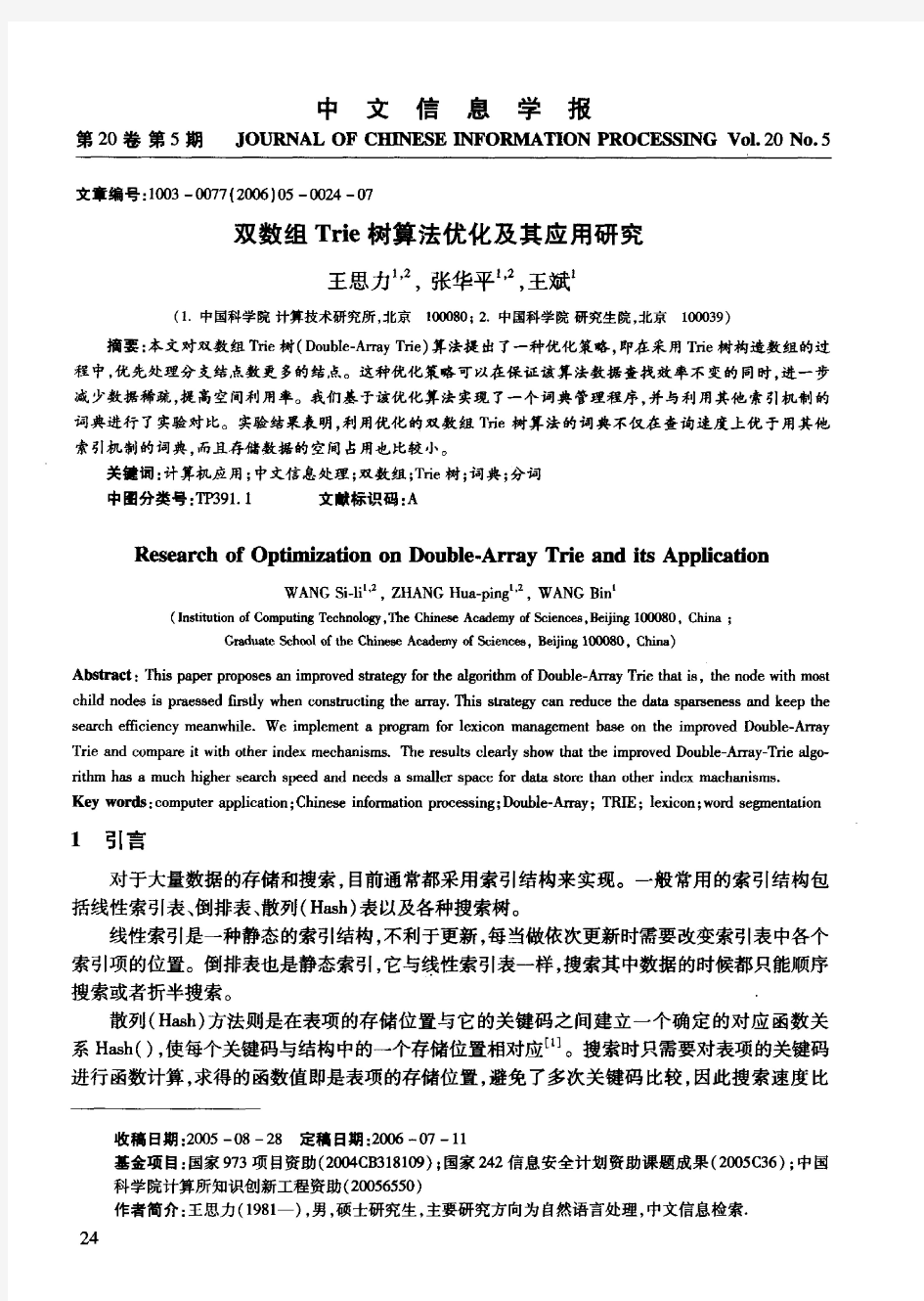

决策树算法研究及应用? 王桂芹黄道 华东理工大学实验十五楼206室 摘要:信息论是数据挖掘技术的重要指导理论之一,是决策树算法实现的理论依据。决 策树算法是一种逼近离散值目标函数的方法,其实质是在学习的基础上,得到分类规则。本文简要介绍了信息论的基本原理,重点阐述基于信息论的决策树算法,分析了它们目前 主要的代表理论以及存在的问题,并用具体的事例来验证。 关键词:决策树算法分类应用 Study and Application in Decision Tree Algorithm WANG Guiqin HUANG Dao College of Information Science and Engineering, East China University of Science and Technology Abstract:The information theory is one of the basic theories of Data Mining,and also is the theoretical foundation of the Decision Tree Algorithm.Decision Tree Algorithm is a method to approach the discrete-valued objective function.The essential of the method is to obtain a clas-sification rule on the basis of example-based learning.An example is used to sustain the theory. Keywords:Decision Tree; Algorithm; Classification; Application 1 引言 决策树分类算法起源于概念学习系统CLS(Concept Learning System,然后发展 到ID3

基于Hash和Trie树的IPv6高速查找和快速增量更新路由算法设计与实现

昆明学院2012届毕业设计(论文) 设计(论文)题目基于Hash和Trie树的IPv6高速查找和快速增量更新路由算法设计与实现 子课题题目 姓名刘晓青 学号 20081101420 所属系信息技术学院 专业年级08级计算机科学与技术 指导教师何英 2012年5月

摘要 由于Internet的速度不断提高、网络流量不断增加和网络规模不断扩大,使得路由器成为制约Internet性能的主要瓶颈之一。随着路由器技术的发展,路由查找速度依然是进一步提高路由器性能的关键要素。本论文首先研究了各种经典的IPv6路由查找算法,并分析了各种路由查找算法的复杂度和存在的问题,对IPv4向IPv6过度的路由查找算法的存在的问题以及路由查找算法的性能参数和复杂度,给出了一种基于hash和trie树高速查找和快速增量更新路由查找算法;其次,对路由缓存优化策略进行改进,并就路由节点进行生物智能化处理,使得路由负载平衡得到改善;最后,通过仿真实验,得出该算法优于以往算法。 关键字:路由查找;最长前缀匹配;Hash表;Trie树;生物智能

Abstract With the development of the internet,the increasing of throughput and the expanding of network,making the router becomes the one of the main bottleneck restricting the internet performance.With the development of routing technology,the speed of the routing lookup is still a key element to further improvement of router performance.This paper studied various classic IPv6 routing lookup algorithms firstly, then analysis the complexity of the various routing lookup algorithms and some existing problems,find the exiting problems in routing lookup algorithms from IPv4 to IPv6 and the performance parameters and complexity of routing lookup algorithms,i served a high speed lookup and fast incremental update routing lookup algorithms based on hash and trie tree;Secondly,i have been done for route cache optimization strategies improvement and conducted route nodal biological intelligent,make the routing load balancing improving;Finally,via the simulation experiment,i know that this algorithm is better than before. Keywords :Route lookup;Longest prefix match;Hash table;Tire;Biological intelligence;

决策树算法介绍(DOC)

3.1 分类与决策树概述 3.1.1 分类与预测 分类是一种应用非常广泛的数据挖掘技术,应用的例子也很多。例如,根据信用卡支付历史记录,来判断具备哪些特征的用户往往具有良好的信用;根据某种病症的诊断记录,来分析哪些药物组合可以带来良好的治疗效果。这些过程的一个共同特点是:根据数据的某些属性,来估计一个特定属性的值。例如在信用分析案例中,根据用户的“年龄”、“性别”、“收入水平”、“职业”等属性的值,来估计该用户“信用度”属性的值应该取“好”还是“差”,在这个例子中,所研究的属性“信用度”是一个离散属性,它的取值是一个类别值,这种问题在数据挖掘中被称为分类。 还有一种问题,例如根据股市交易的历史数据估计下一个交易日的大盘指数,这里所研究的属性“大盘指数”是一个连续属性,它的取值是一个实数。那么这种问题在数据挖掘中被称为预测。 总之,当估计的属性值是离散值时,这就是分类;当估计的属性值是连续值时,这就是预测。 3.1.2 决策树的基本原理 1.构建决策树 通过一个实际的例子,来了解一些与决策树有关的基本概念。 表3-1是一个数据库表,记载着某银行的客户信用记录,属性包括“姓名”、“年龄”、“职业”、“月薪”、......、“信用等级”,每一行是一个客户样本,每一列是一个属性(字段)。这里把这个表记做数据集D。 银行需要解决的问题是,根据数据集D,建立一个信用等级分析模型,并根据这个模型,产生一系列规则。当银行在未来的某个时刻收到某个客户的贷款申请时,依据这些规则,可以根据该客户的年龄、职业、月薪等属性,来预测其信用等级,以确定是否提供贷款给该用户。这里的信用等级分析模型,就可以是一棵决策树。在这个案例中,研究的重点是“信用等级”这个属性。给定一个信用等级未知的客户,要根据他/她的其他属性来估计“信用等级”的值是“优”、“良”还是“差”,也就是说,要把这客户划分到信用等级为“优”、“良”、“差”这3个类别的某一类别中去。这里把“信用等级”这个属性称为“类标号属性”。数据集D中“信用等级”属性的全部取值就构成了类别集合:Class={“优”,

最优化理论与算法(第八章)

第八章 约束优化最优性条件 §8.1 约束优化问题 一、 问题基本形式 min ()f x 1()0 1,,.. ()0 ,,i e i e c x i m s t c x i m m +==?? ≥=?L L (8.1) 特别地,当()f x 为二次函数,而约束是线性约束时,称为二次规划。 记 {} 1()0 (1,,);()0 ,,i e i e X x c x i m c x i m m +===≥=L L ,称之为可行域(约束域)。 {}1,,e E m =L ,{}1,,e I m m +=L ,{}()()0 i I x i c x i I ==∈ 称()E I x U 是在x X ∈处的积极约束的指标集。积极约束也称有效约束,起作用约束或紧约束(active constraints or binding constraints )。 应该指出的是,如果x * 是(1)的局部最优解,且有某个0i I ∈,使得 0()0i c x *> 则将此约束去掉,x * 仍是余下问题的局部最优解。 事实上,若x *不是去掉此约束后所得问题的局部极小点,则意味着0δ?>,存在x δ,使得 x x δδ*-<,且()()f x f x δ*<,这里x δ满足新问题的全部约束。注意到当δ充分小时,由0() i c x 的连续性,必有0()0i c x δ≥,由此知x δ是原问题的可行解,但()()f x f x δ*<,这与x * 是局部极小 点矛盾。 因此如果有某种方式,可以知道在最优解x * 处的积极约束指标集()()A x E I x * *=U ,则问题 可转化为等式的约束问题: min ()f x .. ()0i s t c x = ()i A x *∈ (8.2) 一般地,这个问题较原问题(8.1)要简单,但遗憾的是,我们无法预先知道()A x * 。

数据挖掘决策树算法的改进与实现-精选资料

数据挖掘决策树算法的改进与实现 Data Mining Decision Tree Improvement&Implementation Xia Yan,Zhou Xiaohong,Wang Dong (Changchun Technology College,Changchun130033,China) :The author studied on existing Data Mining decision tree classification method based on the practical application,and applied to the system,achieved a decision support module. Keywords:Data Mining;Decision tree algorithm;Improve;Achieve 随着数据库技术的不断发展及数据库管理系统的广泛应用数据库中存储的数据量急剧增大, 在大量的数据背后隐藏着许多重要的信息, 如果能把这些信息从数据库中抽取出来, 将会产生重要的作用。 因此,数据挖掘涉及的学科领域逐渐扩大, 数据挖掘的方法也在不断地改进和提高。分类在数据挖掘中是一项非常重要的任务, 分类算法可以分为决策树分类算法、遗传算法、神经网络方法、K-最近邻分类算法等。这里,以疾病防控与儿童免疫管理系统中决策支持子系统的开发过程为例, 对决策树分类算法的改进及在实际中的应用进行阐述。 、数据选取和数据预处理

在本系统中 , 以预防接种中遇到异常反应后记录的“异常反 中的数据为例进行说明。具体实现过程详细说明 : 首 先输入训练集 , 由于在真实的 SQL Server 数据库当中 存储要求和减少存储时间 , 并非真正存储每个数据项的 属性值 而是用存储数字来对应相应的意义 , 如在数据库的数据表 程序页面时再映射回原来的值 , 为了说理清晰又限于篇幅 , 这里 只将所有数据集中有代表性的十几组数据作为分类模型创建的 输入训练集。 二、生成决策树 对训练集的每一个属性 , 计算其信息增益。以“月龄”属性 为例 , 每个结点中的正反例的个数分别为 [2,3] 、[3,2] 、[4,0], 分别计算如下 : info[2,3]= =0.971; info[3,2]= =0.971;info[4,0]=0; 计算信息熵 :E ( 月龄 )= =0.693; 计算该属性的信息增益量 , 选取信息增益最大的属性为节点 按该属性的值划分数据集合 :Gain ( 月龄 )=Info (9,5)-E ( 月 龄)=0.940-0.693=0.247; 属性都可计算每个结点的正反例的个数 ( 由于篇幅有限 , 不作计 算) 。通过对各属性信息增益的计算结果 , 选择“月龄”属性作为应调查表” , 为了降低 中, “性 性别”字段中 1”代表“男”、 “2”代表“女” , 反应到 同理, 对“注射反应”属性、 “出生状态”属性、 常住地”

决策树算法分析报告

摘要 随着信息科技的高速发展,人们对于积累的海量数据量的处理工作也日益增重,需发明之母,数据挖掘技术就是为了顺应这种需求而发展起来的一种数据处理技术。 数据挖掘技术又称数据库中的知识发现,是从一个大规模的数据库的数据中有效地、隐含的、以前未知的、有潜在使用价值的信息的过程。决策树算法是数据挖掘中重要的分类方法,基于决策树的各种算法在执行速度、可扩展性、输出结果的可理解性、分类预测的准确性等方面各有千秋,在各个领域广泛应用且已经有了许多成熟的系统,如语音识别、模式识别和专家系统等。本文着重研究和比较了几种典型的决策树算法,并对决策树算法的应用进行举例。 关键词:数据挖掘;决策树;比较

Abstract With the rapid development of Information Technology, people are f acing much more work load in dealing with the accumulated mass data. Data mining technology is also called the knowledge discovery in database, data from a large database of effectively, implicit, previou sly unknown and potentially use value of information process. Algorithm of decision tree in data mining is an important method of classification based on decision tree algorithms, in execution speed, scalability, output result comprehensibility, classification accuracy, each has its own merits., extensive application in various fields and have many mature system, such as speech recognition, pattern recognition and expert system and so on. This paper studies and compares several kinds of typical decision tree algorithm, and the algorithm of decision tree application examples. Keywords: Data mining; decision tree;Compare

字符串前缀、后缀、子串、字典树

Sicily 1426. Phone List(判断电话号码是否前缀重复)Sample Input 2 3 911 97625999 91125426 5 113 12340 123440 12345 98346 Sample Output NO YES/*用string 类型数组读进所有电话号码,然后用sort 函数对其进行排序。 排序与每个号码的长短无关(前面相同的较短的较小),而是从首位开始逐位比较。 如对13,123,124,11456使用sort函数进行排序,结果会是11456,123,124,13 这样排序之后如果有不相容的两个号码肯定会出现在相邻的两位了,所以对整个数组所有相邻的两位逐位进行比对即可得到结果。*/ #include

数据挖掘决策树算法的改进与实现

数据挖掘决策树算法的改进与实现 发表时间:2010-05-13T09:55:26.653Z 来源:《计算机光盘软件与应用》2010年第4期供稿作者:夏琰,周晓红,王东[导读] 本文作者从实际应用出发,对现存数据挖掘决策树分类方法进行了研究,并应用到系统当中,实现了决策支持模块。 夏琰,周晓红,王东 (长春职业技术学院,长春 130033)摘要:本文作者从实际应用出发,对现存数据挖掘决策树分类方法进行了研究,并应用到系统当中,实现了决策支持模块。关键词:数掘挖掘;决策树算法;改进;实现 中图分类号:TP301.6 文献标识码:A 文章编号:1007-9599 (2010) 04-0000-02 Data Mining Decision Tree Improvement&Implementation Xia Yan,Zhou Xiaohong,Wang Dong (Changchun Technology College,Changchun 130033,China)Abstract:The author studied on existing Data Mining decision tree classification method based on the practical application,and applied to the system,achieved a decision support module. Keywords:Data Mining;Decision tree algorithm;Improve;Achieve 随着数据库技术的不断发展及数据库管理系统的广泛应用,数据库中存储的数据量急剧增大,在大量的数据背后隐藏着许多重要的信息,如果能把这些信息从数据库中抽取出来,将会产生重要的作用。 因此,数据挖掘涉及的学科领域逐渐扩大,数据挖掘的方法也在不断地改进和提高。分类在数据挖掘中是一项非常重要的任务,分类算法可以分为决策树分类算法、遗传算法、神经网络方法、K-最近邻分类算法等。这里,以疾病防控与儿童免疫管理系统中决策支持子系统的开发过程为例,对决策树分类算法的改进及在实际中的应用进行阐述。 一、数据选取和数据预处理 在本系统中,以预防接种中遇到异常反应后记录的“异常反应调查表”中的数据为例进行说明。具体实现过程详细说明:首先输入训练集,由于在真实的SQL Server数据库当中,为了降低存储要求和减少存储时间,并非真正存储每个数据项的属性值,而是用存储数字来对应相应的意义,如在数据库的数据表中,“性别”字段中“1”代表“男”、“2”代表“女”,反应到程序页面时再映射回原来的值,为了说理清晰又限于篇幅,这里只将所有数据集中有代表性的十几组数据作为分类模型创建的输入训练集。 表1 判断是否需要计划外加强免疫的属性表 儿童编号月龄出生状态常住地上次注射后反 应是否需要计划外加强免疫 0405102<=2正常产城市无不良反应否 0405495<=2正常产农村无不良反应否 0401342>5正常产城市无不良反应是 04054352…5正常产城市轻度反应是 04065342…5非正常产城市重度反应是 04072342…5非正常产农村重度反应否 0401544>5非正常产农村重度反应是 0408519<=2正常产城市轻度反应否 0404566<=2非正常产城市重度反应是 04035472…5非正常产城市轻度反应是 0401534<=2非正常产农村轻度反应是 0405856>5正常产农村轻度反应是 0409533>5非正常产城市无不良反应是 04053442…5正常产农村轻度反应否 二、生成决策树 对训练集的每一个属性,计算其信息增益。以“月龄”属性为例,每个结点中的正反例的个数分别为[2,3]、[3,2]、[4,0],分别计算如下: info[2,3]=; info[3,2]=;info[4,0]=0; 计算信息熵:E(月龄)==0.693; 计算该属性的信息增益量,选取信息增益最大的属性为节点,按该属性的值划分数据集合:Gain(月龄)=Info(9,5)-E(月龄)=0.940-0.693=0.247; =0.971 =0.971

字典树及应用

Trie树(字典树) Trie树就是字符树,其核心思想就是空间换时间。 举个简单的例子。 给你100000个长度不超过10的单词。对于每一个单词,我们要判断他出没出现过,如果出现了,第一次出现第几个位置。 这题当然可以用hash来,但是我要介绍的是trie树。在某些方面它的用途更大。比如说对于某一个单词,我要询问它的前缀是否出现过。这样hash就不好搞了,而用trie还是很简单。 现在回到例子中,如果我们用最傻的方法,对于每一个单词,我们都要去查找它前面的单词中是否有它。那么这个算法的复杂度就是O(n^2)。显然对于100000的范围难以接受。现在我们换个思路想。假设我要查询的单词是abcd,那么在他前面的单词中,以b,c,d,f之类开头的我显然不必考虑。而只要找以a开头的中是否存在abcd就可以了。同样的,在以a开头中的单词中,我们只要考虑以b作为第二个字母的……这样一个树的模型就渐渐清晰了…… 假设有b,abc,abd,bcd,abcd,efg,hii这6个单词,我们构建的树就是这样的。 对于每一个节点,从根遍历到他的过程就是一个单词,如果这个节点被标记为红色,就表示这个单词存在,否则不存在。

那么,对于一个单词,我只要顺着他从跟走到对应的节点,再看这个节点是否被标记为红色就可以知道它是否出现过了。把这个节点标记为红色,就相当于插入了这个单词。 这样一来我们询问和插入可以一起完成,所用时间仅仅为单词长度,在这一个样例,便是10。 我们可以看到,trie树每一层的节点数是26^i级别的。所以为了节省空间。我们用动态链表,或者用数组来模拟动态。空间的花费,不会超过单词数×单词长度。 由字母a~z所组成的字符串的一个集合中,各个字符的长度之和为n。设计一个O(n)时间的算法,将这个集合中所有字符串依字典进行排序。注意,这里可能存在非常长的字符串。 #include

C45算法生成决策树的研究

精心整理 C4.5算法生成决策树 1、基础知识 当我们需要对一个随机事件的概率分布进行预测时,我们的预测应当满足全部已知的条件,而对未知的情况不要做任何主观假设。在这种情况下,概率分布最均SEE5、SLIQ 算法的的标准,克服了ID3算法中信息增益选择属性时偏向选择取值多的属性的不足,并能够完成对连续属性离散化的处理,还能够对不完整数据进行处理。根据分割方法的不同,目前决策的算法可以分为两类:基于信息论(InformationTheory )的方法和最小GINI 指标(LowestGINIindex )方法。对应前者的算法有ID3、C4.5,后者的有CART 、SLIQ 和SPRINT 。

C4.5算法是以信息论为基础,以信息熵和信息增益度为衡量标准,从而实现对数据的归纳分类。 2、算法 以下图数据为例,介绍用C4.5建立决策树的算法。 表1 ID3算法最初假定属性都是离散值,但在实际应用中,很多属性值都是连续的。C4.5对ID3不能处理连续型属性的缺点进行了改进。如果存在连续型的描述性属性,首先将连续型属性的值分成不同的区间,即“离散化”。

对上表中将实际耗电量分为10个区间(0—9) (300~320,320~340,340~360,360~380,380~400,400~420,420~440,440~460,460~480,480~500)因为最终是要得到实际的耗电量区间,因此“实际耗电量”属于“类别属性”。“室外温度”、“室内温度”、“室外湿度”、“风力大小”、“机房楼层”、“机房朝向”、“机房开启设备总额定功率”属于“非类别属性”。 表2 通过表 知,实 际耗电的个数表3

最优化理论与算法 fibonacci法

function [a,b,n,x]=fibonacci(fname,a,b,d,L) % fname函数句柄,d辨别常数,L最终区间长度a(1)=a; b(1)=b; F=zeros(1,10); %选择fibonacci数列k值为10,可任意更改 F(1)=1; F(2)=2; for k=2:10 %k取到10,生成fibonacci数列 F(k+1)=F(k)+F(k-1); F(k); end Fn=(b(1)-a(1))/L; Fk=[F Fn]; N=sort(Fk); n=find(Fn==N); %查找计算函数值的次数n t(1)=a(1)+F(n-2)*(b(1)-a(1))/F(n); %计算试探点t(1),u(1) u(1)=a(1)+F(n-1)*(b(1)-a(1))/F(n); for k=1:n-2 ft=feval(fname,t(k)); fu=feval(fname,u(k)); if ft>fu a(k+1)=t(k); b(k+1)=b(k); t(k+1)=u(k); u(k+1)=a(k+1)+F(n-k-1)*(b(k+1)-a(k+1))/F(n-k); while k==n-2 t(n)=t(n-1); u(n)=t(n-1)+d; ft=feval(fname,t(n)); fu=feval(fname,u(n)); if ft>fu a(n)=t(n); b(n)=b(n-1); else a(n)=a(n-1); b(n)=t(n); end end else a(k+1)=a(k); b(k+1)=u(k); u(k+1)=t(k); if k~=n-2 t(k+1)=a(k+1)+F(n-k-2)*(b(k+1)-a(k+1))/F(n-k); ft=feval(fname,t(k));

最优化理论与算法

最优化理论与算法笔记 在老师的指导下,我学习了最优化理论与算法这门课程。最优化理论与算法是一个重要的数学分支,它所研究的问题是讨论在众多方案中什么样的方案最优以及怎样找出最优方案。 由于生产和科学研究突飞猛进的发展,特别是计算机的广泛应用,使最优化问题的研究不仅成为了一种迫切的需要,而且有了求解的有力工具,因此迅速发展起来形成一个新的学科。至今已出现了线性规划、整数规划、非线性规划、几何规划、动态规划、随机规划、网络流等许多分支。 整个学习安排如下,首先介绍线性与非线性规划问题,凸集和凸函数等基本知识及线性规划的基本性质;然后再这个基础上学习各种算法,包括单纯形法、两阶段法、大M法、最速下降法、牛顿法、共轭梯度法等,以及各种算法相关的定理和结论;最后了解各种算法的实际应用。 主要学习的基础知识: 1、一般线性规划问题的标准形式 学会引入松弛变量将一般问题化为标准问题;同时掌握基本可行解的存在问题,通过学习容易发现线性规划问题的求解,可归结为求最优基本可行解的问题。 2、熟练掌握单纯形法、两阶段法和大M法的概念及其计算步骤。

单纯形法是一种是用方便、行之有效的重要算法,它已成为线性规划的中心内容。其计算步骤如下: 1)解 求得 ,令 计算目标函数值 ; 2)求单纯形乘子 ,解 ,得到 ; 3)解 ,若 ,即 的每个分量均非正数,则停止计算,问 题不存在有限最优解,否则,进行步骤(4); 4)确定下标r,使 ,得到新的基矩阵B,返回第一

步。 两阶段法:第一阶段是用单纯形法消去人工变量,即把人工变量都变换成非基变量,求出原来问题的一个基本可行解;第二阶段是从得到的基本可行解出发,用单纯形法求线性规划的最优解。 大M法:在约束中增加人工变量 ,同时修改目标函数,加上罚项 ,其中 是很大的正数,这样,在极小化目标函数的过程中,由于 的存在,将迫使人工变量离基。 3、掌握最速下降法的概念及其算法,并且能够讨论最速下降算法的收敛性。掌握牛顿法,能够熟练运用牛顿迭代公式: ,掌握共轭梯度法及其相关结论,以及其收敛性的讨论,掌握最小二乘法及其基本步骤。 最速下降法:迭代公式为 。 计算步骤:1)给定点 ,允许误差 置 ; 2)计算搜索方向

Trie图的构建、活用与改进

Trie图的构建、活用与改进 Maigo 2006.1.14 我们知道trie树(也叫字母树)这种数据结构。它是词典的一种存储方式。词典中的每一个单词在trie树中表现为一条从根结点出发的路径,路径中边上的字母连起来就形成对应的单词。图1就是一棵trie树,其中含有a,abc,bac,bbc,ca五个单词。 利用trie树可以对词典中的单词进行一些适合用树这种数据结构进行的操作,如求两个单词的公共前缀长度(在树中表现为求两个单词对应结点的最近公共祖先)。其实,如果把trie树加以改造,多连一些边,形成的trie图在解决多模式串匹配问题上会发挥奇效。 左:图1,一棵含有五个单词的trie树。红色表示单词终止的位置。 右:图2,由图1的trie树改造成的trie图。红色表示危险结点,白色表示真安全结点,蓝色表示新加的边。为简单起见,危险结点以下的结点及与之关联的边没有画出。 一、Trie图的构建 我们通过一个例题来探究trie图的构建方法。 【例1】不良单词探测器 【题目描述】给出一个词典,其中的单词为不良单词。单词均为小写字母。再给出一段文本,文本的每一行也由小写字母构成。判断文本中是否含有任何不良单词。例如,若rob是不良单词,那么文本problem含有不良单词。 【输入】第一行为一个整数n,表示不良单词的个数。接下来n行是词典。下面一行为一个整数m,表示文本的行数。接下来m行是文本。 【输出】如果文本包含不良单词,输出一行“Yes”,否则输出一行“No”。 【样例输入】 1 rob 1 internetproblemsolvingcontest 【样例输出】 Yes 【备注】因本题只是用来讨论trie图的构建方法,故未给出数据范围。 【分析】判断文本是否包含不良单词可以一行一行地判断。而判断长为L的一行文本s是否含有不良单词可以这样进行:让i从1变化到L,依次判断s的前i个字符构成的字符串是否以不良单词结尾。

最优化理论与算法(第三章)

第三章 牛顿法 §3.1 最速下降法 一、最速下降法 在极小化算法中,若每次都以迭代点处的负梯度方向为搜索方向,产生的算法称为最速下降法,它是无约束最优化算法中最简单、最基本的算法。 算法描述: 1) 给出初始点0n x R ∈,允许误差0ε>,0k =; 2) 计算k k d g =-,若k g ε≤,Stop 令 * k x x ≈; 3) 由一维搜索确定步长因子k α,使得 ()min ()k k k k k f x d f x d ααα≥+=+ 4) 令1k k k k x x d α+=+,1k k =+,go to 2). 的每个聚点均为驻点。 令{}1 k K d 有界,且 2 ()(())()0T f x f x f x ?-?=-?= 故有 ()0f x ?=。 定理 3.2 设()f x 二次连续可微,且2()f x M ?≤,则对任何给定的初始点0n x R ∈,最速下降算法或有限终止,或lim ()k k f x →∞ =-∞,或lim ()0k k f x →∞ ?=。

证明:不妨设k ?,()0k f x ?≠。由定理2.5有 2 11()()()2k k k f x f x f x M +-≥ ? 于是 []1 2 010 1 ()()()()()2k k k i i i i i f x f x f x f x f x M -+==-=-≥ ?∑∑ 令k →∞,由{()}k f x 为单调下降序列,则要么 lim ()k k f x →∞ =-∞,要么 lim k →∞ ?定理3.3 设1 f C ∈证明:直接由定理2.14可得。 注:1) 2 1λ,n λ分别为G 的 ≤ ()k k I G x α- 其中k α使 (())(())k k k f I G x f I G x αα-≤-, 0α?≥ 若设 ()1k P t t α=-,()Q t ut λ=- 其中,u R λ∈。则有 ()Q G I uG λ=-,而(0)Q λ=,

最优化理论与算法

最优化理论与算法笔记 在老师的指导下,我学习了最优化理论与算法这门课程。最优化理论与算法是一个重要的数学分支,它所研究的问题是讨论在众多方案中什么样的方案最优以及怎样找出最优方案。 由于生产和科学研究突飞猛进的发展,特别是计算机的广泛应用,使最优化问题的研究不仅成为了一种迫切的需要,而且有了求解的有力工具,因此迅速发展起来形成一个新的学科。至今已出现了线性规划、整数规划、非线性规划、几何规划、动态规划、随机规划、网络流等许多分支。 整个学习安排如下,首先介绍线性与非线性规划问题,凸集和凸函数等基本知识及线性规划的基本性质;然后再这个基础上学习各种算法,包括单纯形法、两阶段法、大M 法、最速下降法、牛顿法、共轭梯度法等,以及各种算法相关的定理和结论;最后了解各种算法的实际应用。 主要学习的基础知识: 1、一般线性规划问题的标准形式 1min n j j j c x =∑ 1 .., 1,...,, 0, 1,...,. n ij j i j j s t a x b i m x j n ===≥=∑ 学会引入松弛变量将一般问题化为标准问题;同时掌握基本可行解的存在问题,通过学习容易发现线性规划问题的求解,可归结为求最优基本可行解的问题。 2、熟练掌握单纯形法、两阶段法和大M 法的概念及其计算步骤。 单纯形法是一种是用方便、行之有效的重要算法,它已成为线性规划的中心内容。其计算步骤如下: 1)解,B Bx b =求得1B x B b b -==,令0,N x =计算目标函数值B B f c x =;

2)求单纯形乘子ω,解B B c ω= ,得到1B c B ω-=; 3)解k k By p =,若0k y ≤,即k y 的每个分量均非正数,则停止计算,问 题不存在有限最优解,否则,进行步骤(4); 4)确定下标r ,使min{0}r r rk rk rk b b y y y =>,得到新的基矩阵B ,返回第一 步。 两阶段法:第一阶段是用单纯形法消去人工变量,即把人工变量都变换成非基变量,求出原来问题的一个基本可行解;第二阶段是从得到的基本可行解出发,用单纯形法求线性规划的最优解。 大M 法:在约束中增加人工变量a x ,同时修改目标函数,加上罚项T a Me x ,其中M 是很大的正数,这样,在极小化目标函数的过程中,由于M 的存在,将迫使人工变量离基。 3、掌握最速下降法的概念及其算法,并且能够讨论最速下降算法的收敛性。掌握牛顿法,能够熟练运用牛顿迭代公式:(1) ()2()()()()k k k k x x f x x x +=-?- ,掌 握共轭梯度法及其相关结论,以及其收敛性的讨论,掌握最小二乘法及其基本步骤。 最速下降法:迭代公式为(1) ()()k k k k x x d λ+=-。 计算步骤:1)给定点(1)n x R ∈,允许误差0,ε>臵1k =; 2)计算搜索方向() ()()k k d f x =-?; 3)若() k d ε≤,则停止计算,否则,从()k x 出发,沿()k d 进行一维搜索,求k λ,使()()()() ()min ()k k k k k f x d f x d λλλ≥+=+; 4)令(1) ()()k k k k x x d λ+=-,臵:1k k =+,转步骤(2)。

Trie图

Trie图的构建、活用与改进 Maigo 我们知道trie树(也叫字母树)这种数据结构。它是词典的一种存储方式。词典中的每一个单词在trie树中表现为一条从根结点出发的路径,路径中边上的字母连起来就形成对应的单词。图1就是一棵trie树,其中含有a,abc,bac,bbc,ca五个单词。 利用trie树可以对词典中的单词进行一些适合用树这种数据结构进行的操作,如求两个单词的公共前缀长度(在树中表现为求两个单词对应结点的最近公共祖先)。其实,如果把trie树加以改造,多连一些边,形成的trie图在解决多模式串匹配问题上会发挥奇效。 左:图1,一棵含有五个单词的trie树。红色表示单词终止的位置。 右:图2,由图1的trie树改造成的trie图。红色表示危险结点,白色表示真安全结点,蓝色表示新加的边。为简单起见,假安全结点及与之关联的边没有画出。 一、Trie图的构建 我们通过一个例题来探究trie图的构建方法。 【例1】不良单词探测器 【题目描述】给出一个词典,其中的单词为不良单词。单词均为小写字母。再给出一段文本,文本的每一行也由小写字母构成。判断文本中是否含有任何不良单词。例如,若rob是不良单词,那么文本problem含有不良单词。 【输入】第一行为一个整数n,表示不良单词的个数。接下来n行是词典。下面一行为一个整数m,表示文本的行数。接下来m行是文本。 【输出】如果文本包含不良单词,输出一行“Y es”,否则输出一行“No”。 【样例输入】 1 rob 1 internetproblemsolvingcontest 【样例输出】 Yes 【备注】因本题只是用来讨论trie图的构建方法,故未给出数据范围。 【分析】判断文本是否包含不良单词可以一行一行地判断。而判断长为L的一行文本s是否含有不良单词可以这样进行:让i从1变化到L,依次判断s的前i个字符构成的字符串是否以不良单词结尾。

决策树算法总结

决策树研发二部

目录 1. 算法介绍 (1) 1.1.分支节点选取 (1) 1.2.构建树 (3) 1.3.剪枝 (10) 2. sk-learn中的使用 (12) 3. sk-learn中源码分析 (13)

1.算法介绍 决策树算法是机器学习中的经典算法之一,既可以作为分类算法,也可以作为回归算法。决策树算法又被发展出很多不同的版本,按照时间上分,目前主要包括,ID3、C4.5和CART版本算法。其中ID3版本的决策树算法是最早出现的,可以用来做分类算法。C4.5是针对ID3的不足出现的优化版本,也用来做分类。CART也是针对ID3优化出现的,既可以做分类,可以做回归。 决策树算法的本质其实很类似我们的if-elseif-else语句,通过条件作为分支依据,最终的数学模型就是一颗树。不过在决策树算法中我们需要重点考虑选取分支条件的理由,以及谁先判断谁后判断,包括最后对过拟合的处理,也就是剪枝。这是我们之前写if语句时不会考虑的问题。 决策树算法主要分为以下3个步骤: 1.分支节点选取 2.构建树 3.剪枝 1.1.分支节点选取 分支节点选取,也就是寻找分支节点的最优解。既然要寻找最优,那么必须要有一个衡量标准,也就是需要量化这个优劣性。常用的衡量指标有熵和基尼系数。 熵:熵用来表示信息的混乱程度,值越大表示越混乱,包含的信息量也就越多。比如,A班有10个男生1个女生,B班有5个男生5个女生,那么B班的熵值就比A班大,也就是B班信息越混乱。 基尼系数:同上,也可以作为信息混乱程度的衡量指标。

有了量化指标后,就可以衡量使用某个分支条件前后,信息混乱程度的收敛效果了。使用分支前的混乱程度,减去分支后的混乱程度,结果越大,表示效果越好。 #计算熵值 def entropy(dataSet): tNum = len(dataSet) print(tNum) #用来保存标签对应的个数的,比如,男:6,女:5 labels = {} for node in dataSet: curL = node[-1] #获取标签 if curL not in labels.keys(): labels[curL] = 0 #如果没有记录过该种标签,就记录并初始化为0 labels[curL] += 1 #将标签记录个数加1 #此时labels中保存了所有标签和对应的个数 res = 0 #计算公式为-p*logp,p为标签出现概率 for node in labels: p = float(labels[node]) / tNum res -= p * log(p, 2) return res #计算基尼系数 def gini(dataSet): tNum = len(dataSet) print(tNum) # 用来保存标签对应的个数的,比如,男:6,女:5 labels = {} for node in dataSet: curL = node[-1] # 获取标签 if curL not in labels.keys(): labels[curL] = 0 # 如果没有记录过该种标签,就记录并初始化为0 labels[curL] += 1 # 将标签记录个数加1 # 此时labels中保存了所有标签和对应的个数 res = 1 # 计算公式为-p*logp,p为标签出现概率