Google Megastore分布式存储技术全揭秘

Google Megastore分布式存储技术全揭秘

发表于2011-02-16 09:52| 50869次阅读| 来源CSDN| 29条评论| 作者李智

数据结构数据中心googlemegastore分布式存储

摘要:TUP第九期云计算技术沙龙将于04月23日在中国科学院计算技术研究所一层报告厅举行,本次沙龙活动主要涉及基于MySQL的B2C电商系统前端数据层架构、应对规模和复杂性挑战、Hadooop未来走向等话题

导读:本文根据Google最新Megastore论文翻译而来,原作者为Google团队,团队人员包括:Jason Baker,Chris Bond,James C.Corbett,JJ Furman,AndreyKhorlin,James Larson,Jean-Michel Léon,Yawei Li,Alexander Lloyd,VadimYushprakh。翻译者为国内知名IT人士。

在上个月举行的创新数据系统研讨会上(CIDR),Google公开了其Megastore分布式存储技术的白皮书。

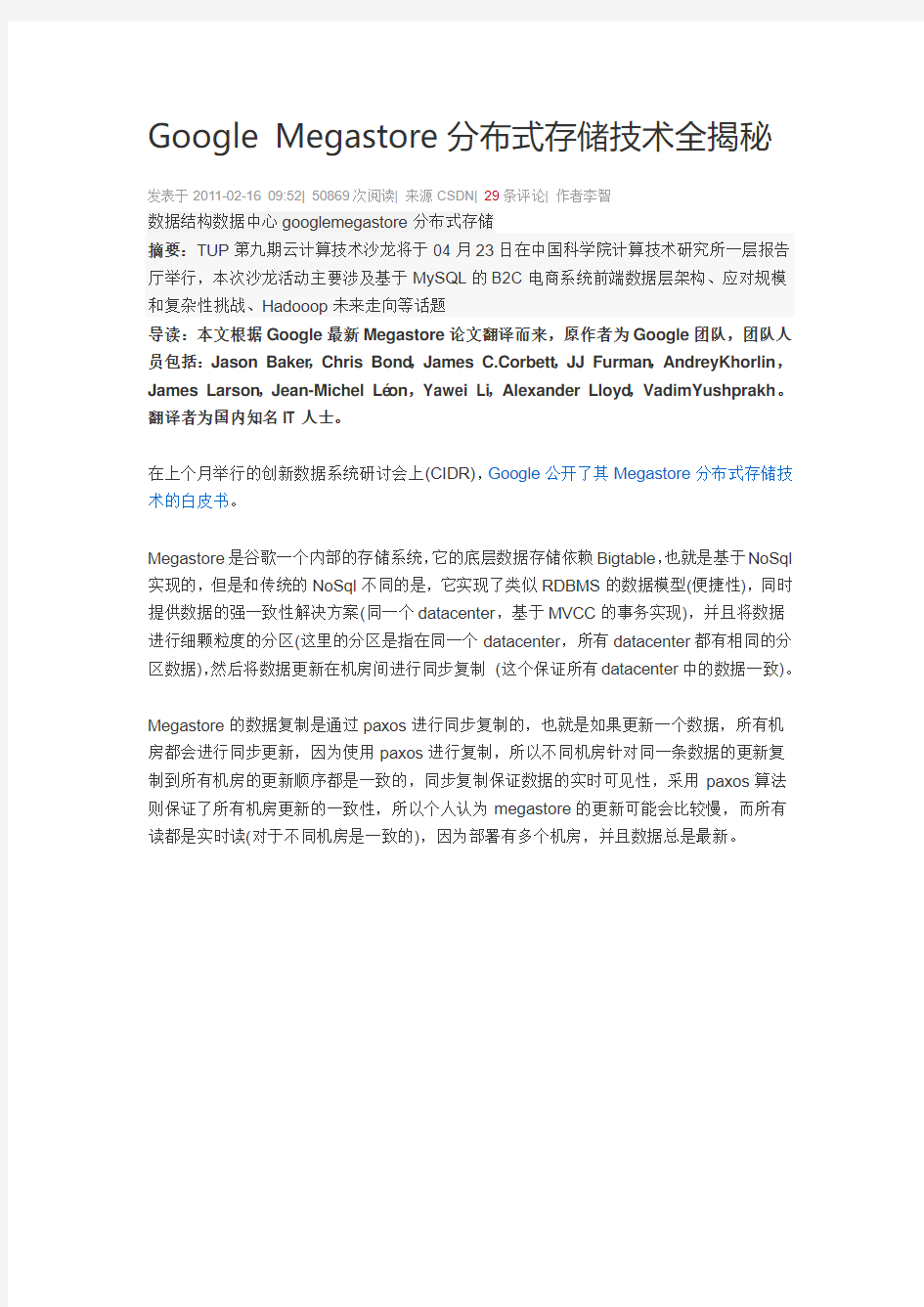

Megastore是谷歌一个内部的存储系统,它的底层数据存储依赖Bigtable,也就是基于NoSql 实现的,但是和传统的NoSql不同的是,它实现了类似RDBMS的数据模型(便捷性),同时提供数据的强一致性解决方案(同一个datacenter,基于MVCC的事务实现),并且将数据进行细颗粒度的分区(这里的分区是指在同一个datacenter,所有datacenter都有相同的分区数据),然后将数据更新在机房间进行同步复制(这个保证所有datacenter中的数据一致)。

Megastore的数据复制是通过paxos进行同步复制的,也就是如果更新一个数据,所有机房都会进行同步更新,因为使用paxos进行复制,所以不同机房针对同一条数据的更新复制到所有机房的更新顺序都是一致的,同步复制保证数据的实时可见性,采用paxos算法则保证了所有机房更新的一致性,所以个人认为megastore的更新可能会比较慢,而所有读都是实时读(对于不同机房是一致的),因为部署有多个机房,并且数据总是最新。

为了达到高可用性,megastore实现了一个同步的,容错的,适合长距离连接的日志同步器

为了达到高可扩展性,megastore将数据分区成一个个小的数据库,每一个数据库都有它们自己的日志,这些日志存储在NoSql中

Megastore将数据分区为一个Entity Groups的集合,这里的Entity Groups相当于一个按id切分的分库,这个Entity Groups里面有多个Entity Group(相当于分库里面的表),而一个Entity Group有多个Entity(相当于表中的记录)

在同一个Entity Group中(相当于单库)的多个Entity的更新事务采用single-phase ACID事务,而跨Entity Group(相当于跨库)的Entity更新事务采用two-phase ACID事务(2段提交),但更多使用Megastore提供的高效异步消息实现。需要说明的一点是,这些事务都是在同一个机房的,机房之间的数据交互都是通过数据复制来实现的。

传统关系型数据库使用join来满足用户的需求,对于Megastore来说,这种模型(也就是完全依赖join的模型)是不合适的。原因包括

1.高负载交互性型应用能够从可预期的性能提升得到的好处多于使用一种代价高昂的查询语言所带来的好处。

2.Megastore目标应用是读远远多于写的,所以更好的方案是将读操作所需要做的工作转移到写操作上面(比如通过具体值代替外键以消除join)

3.因为megastore底层存储是采用BigTable,而类似BigTable的key-value存储对于存取级联数据是直接的

所以基于以上几个原因,Megastore设计了一种数据模型和模式语言来提供基于物理地点的细颗粒度控制,级联布局,以及申明式的不正规数据存储来帮助消除大部分joins。查询时只要指定特定表和索引即可。

当然可能有时候不得不使用到join,Megastore提供了一种合并连接算法实现,具体算法这里我还是没弄清楚,原文是[the user provides multiple queries that return primary keys for the same table in the same order; we then return the intersection of keys for all the provided queries.]

使用Megastore的应用通过并行查询实现了outer joins。通常先进行一个初始的查询,然后利用这个查询结果进行并行索引查询,这个过程我理解的是,初始查询查出一条数据,就马上根据这个结果进行并行查询,这个时候初始查询继续取出下一条数据,再根据这个结果并行查询(可能前面那个外键查询还在继续,使用不同的线程)。这种方法在初始查询数据量较小并且外键查询使用并行方式的情况下,是一种有效的并且具有sql风格的joins。

Megastore的数据结构介于传统的RDBMS和NoSql之间的,前者主要体现在他的schema 表示上,而后者体现在具体的数据存储上(BigTable)。和RDBMS一样,Megastore的数据模型是定义schema中并且是强类型的。每一个schema有一个表集合,每个表包含一个实体集合(相当于record),每个实体有一系列的属性(相当于列属性),属性是命名的,并且指定类型,这些类型包括字符串,各种数字类型,或者google的protocol buffer。这些属性可以被设置成必需的,可选的,或者可重复的(一个属性上可以具有多个值)。一个或者多个属性可以组成一个主键。

在上图中,User和Photo共享了一个公共属性user_id,IN TABLE User这个标记直接将Photo和User这两张表组织到了同一个BigTable中,并且键的顺序(PRIMARY

KEY(user_id,photo_id)?是这个还是schema中定义的顺序?)保证Photo的实体存储在对应的User实体邻接位置上。这个机制可以递归的应用,加速任意深度的join查询速度。这样,用户能够通过操作键的顺序强行改变数据级联的布局。其他标签请参考原文。Megastore支持事务和并发控制。一个事务写操作会首先写入对应Entity Group的日志中,然后才会更新具体数据。BigTable具有一项在相同row/column中存储多个版本带有不同时间戳的数据。正是因为有这个特性,Megastore实现了多版本并发控制(MVCC,这个包括oracle,innodb都是使用这种方式实现ACID,当然具体方式会有所不同):当一个事务的多个更新实施时,写入的值会带有这个事务的时间戳。读操作会使用最后一个完全生效事务的时间戳以避免看到不完整的数据.读写操作不相互阻塞,并且读操作在写事务进行中会被隔离(?)。

Megastore 提供了current,snapshot,和inconsistent读,current和snapshot级别通常是读取单个entity group。当开始一个current读操作时,事务系统会首先确认所有之前提交的写已经生效了;然后系统从最后一个成功提交的事务时间戳位置读取数据。对于snapshot读取,系统拿到己经知道的完整提交的事务时间戳并且从那个位置直接读取数据,和current读取不同的是,这个时候可能提交的事务更新数据还没有完全生效(提交和生效是不同的)。Megastore提供的第三种读就是inconsistent读,这种读无视日志状态并且直接读取最后一个值。这种方式的读对于那些对减少延迟有强烈需求,并且能够容忍数据过期或者不完整的读操作是非常有用的。

一个写事务通常开始于一个current读操作以便确定下一个可用的日志位置。提交操作将数据变更聚集到日志,并且分配一个比之前任何一个都高的时间戳,并且使用Paxos将这个log entry加入到日志中。这个协议使用了乐观并发:即使有可能有多个写操作同时试图写同一个日志位置,但只会有1个成功。所有失败的写都会观察到成功的写操作,然后中止,并且重试它们的操作。咨询式的锁定能够减少争用所带来的影响。通过特定的前端服务器分批写入似乎能够完全避免竞争(这几句有些不能理解) [ Advisory locking is available to reduce the effects of contention. Batching writes through session affinity to a particular front-end server can avoid contention altogether.]。

完整事务生命周期包括以下步骤:

1.读:获取时间戳和最后一个提交事务的日志位置

2.应用逻辑:从BigTable读取并且聚集写操作到一个日志Entry

3.提交:使用Paxos将日志Entry加到日志中

4.生效:将数据更新到BigTable的实体和索引中

5.清理:删除不再需要的数据

写操作能够在提交之后的任何点返回,但是最好还是等到最近的副本(replica)生效(再返回)。

Megastore提供的消息队列提供了在不同Entity Group之间的事务消息。它们能被用作跨Entity Group的操作,在一个事务中分批执行多个更新,或者延缓工作(?)。一个在单个Entity Group上的事务能够原子性地发送或者收到多个信息除了更新它自己的实体。每个消息都有一个发送和接收的Entity Group;如果这两个Entity Group是不同的,那么传输将会是异步的。

消息队列提供了一种将会影响到多个Entity Group的操作的途径,举个例子,日历应用中,每一个日历有一个独立的Entity Group,并且我们现在需要发送一个邀请到多个其他人的日历中,一个事务能够原子地发送邀请消息到多个独立日历中。每个日历收到消息都会把邀请加入到它自己的事务中,并且这个事务会更新被邀请人状态然后删除这个消息。Megastore 大规模使用了这种模式:声明一个队列后会自动在每一个Entity Group上创建一个收件箱。

Megastore支持使用二段提交进行跨Entity Group的原子更新操作。因为这些事务有比较高的延迟并且增加了竞争的风险,一般不鼓励使用。

接下来内容具体来介绍下Megastore最核心的同步复制模式:一个低延迟的Paxos实现。Megastore的复制系统向外提供了一个单一的,一致的数据视图,读和写能够从任何副本(replica)开始,并且无论从哪个副本的客户端开始,都能保证ACID语义。每个Entity Group 复制结束标志是将这个Entity Group事务日志同步地复制到一组副本中。写操作通常需要一个数据中心内部的网络交互,并且会跑检查健康状况的读操作。current级别的读操作会有以下保证:

1.一个读总是能够看到最后一个被确认的写。(可见性)

2.在一个写被确认后,所有将来的读都能够观察到这个写的结果。(持久性,一个写可能在确认之前就被观察到)

数据库典型使用Paxos一般是用来做事务日志的复制,日志中每个位置都由一个Paxos实例来负责。新的值将会被写入到之前最后一个被选中的位置之后。

Megastore在事先Paxos过程中,首先设定了一个需求,就是current reads可能在任何副本中进行,并且不需要任何副本之间的RPC交互。因为写操作一般会在所有副本上成功,所以允许在任何地方进行本地读取是现实的。这些本地读取能够很好地被利用,所有区域的低延迟,细颗粒度的读取failover,还有简单的编程体验。

Megastore设计实现了一个叫做Coordinator(协调者)的服务,这个服务分布在每个副本的数据中心里面。一个Coordinator服务器跟踪一个Entity Groups集合,这个集合中的Entity Groups需要具备的条件就是它们的副本已经观察到了所有的Paxos写。在这个集合中的Entity Groups,它们的副本能够进行本地读取(local read)。

写操作算法有责任保持Coordinator状态是保守的,如果一个写在一个副本上失败了,那么这次操作就不能认为是提交的,直到这个entity group的key从这个副本的coordinator中去除。(这里不明白)

为了达到快速的单次交互的写操作,Megastore采用了一种Master-Slave方式的优化,如

果一次写成功了,那么会顺带下一次写的保证(也就是下一次写就不需要prepare去申请一个log position),下一次写的时候,跳过prepare过程,直接进入accept阶段。Megastore 没有使用专用的Masters,但是使用Leaders。

Megastore为每一个日志位置运行一个Paxos算法实例。[ The leader for each log position is a

distinguished replica chosen alongside the preceding log position's consensus value.] Leader仲裁在0号提议中使用哪一个值。第一个写入者向Leader提交一个值会赢得一个向所有副本请求接收这个值做为0号提议最终值的机会。所有其他写入者必需退回到Paxos

的第二阶段。

因为一个写入在提交值到其他副本之前必需和Leader交互,所以必需尽量减少写入者和Leader之间的延迟。Megastore设计了它们自己的选取下一个写入Leader的规则,以同一地区多数应用提交的写操作来决定。这个产生了一个简单但是有效的原则:使用最近的副本。(这里我理解的是哪个位置提交的写多,那么使用离这个位置最近的副本做为Leader)

Megastore的副本中除了有日志有Entity数据和索引数据的副本外,还有两种角色,其中一种叫做观察者(Witnesses),它们只写日志,并且不会让日志生效,也没有数据,但是当副

本不足以组成一个quorum的时候,它们就可以加入进来。另外一种叫只读副本(Read-Only),它刚刚和观察者相反,它们只有数据的镜像,在这些副本上只能读取到最近过去某一个时间点的一致性数据。如果读操作能够容忍这些过期数据,只读副本能够在广阔的地理空间上进行数据传输并且不会加剧写的延迟。

上图显示了Megastore的关键组件,包括两个完整的副本和一个观察者。应用连接到客户端库,这个库实现了Paxos和其他一些算法:选择一个副本进行读,延迟副本的追赶,等等。

Each application server has a designated local replica. The client library makes Paxos operations on that replica durable by submitting transactions directly to the local Bigtable.To minimize wide-area roundtrips, the library submits remote Paxos operations to stateless intermediary replication servers communicating with their local Bigtables.

客户端,网络,或者BigTable失败可能让一个写操作停止在一个中间状态。复制的服务器会定期扫描未完成的写入并且通过Paxos提议没有操作的值来让写入完成。

接下来介绍下Megastore的数据结构和算法,每一个副本存有更新和日志Entries的元数据。为了保证一个副本能够参与到一个写入的投票中即使是它正从一个之前的宕机中恢复数据,Megastore允许这个副本接收不符合顺序的提议。Megastore将日志以独立的Cells存储在BigTable中。

当日志的前缀不完整时(这个前缀可能就是一个日志是否真正写入的标记,分为2段,第一段是在写入日志之前先写入的几个字节,然后写入日志,第二段是在写入日志之后写入的几个字节,只有这个日志前缀是完整的,这个日志才是有效的),日志将会留下holes。下图表示了一个单独Megastore Entity Group的日志副本典型场景。0-99的日志位置已经被清除了,100的日志位置是部分被清除,因为每个副本都会被通知到其他副本已经不需要这个日志了。101日志位置被所有的副本接受了(accepted),102日志位置被Y所获得,103日志

位置被A和C副本接受,B副本留下了一个hole,104日志位置因为副本A和B的不一致,复本C的没有响应而没有一致结果。

在一个current读的准备阶段(写之前也一样),必需有一个副本要是最新的:所有之前更新必需提交到那个副本的日志并且在该副本上生效。我们叫这个过程为catchup。

省略一些截止超时的管理,一个current读算法步骤如下:

1.本地查询:查询本地副本的Coordinator,判定当前副本的Entity Group是最新的

2.查找位置:确定最高的可能已提交的日志位置,然后选择一个己经将这个日志位置生效的副本

a.(Local read) 如果步骤1发现本地副本是最新的,那么从本地副本中读取最高的被接受(accepted)的日志位置和时间戳。

b.(Majority read)如果本地副本不是最新的(或者步骤1或步骤2a超时),那么从一个多数派副本中发现最大的日志位置,然后选取一个读取。我们选取一个最可靠的或者最新的副本,不一定总是是本地副本

3.追赶:当一个副本选中之后,按照下面的步骤追赶到已知的日志位置:

a.对于被选中的不知道共识值的副本中的每一个日志位置,从另外一个副本中读取值。对于任何一个没有已知已提交的值的日志位置,发起一个没有操作的写操作。Paxos将会驱动多数副本在一个值上打成共识-----可能是none-op的写操作或者是之前提议的写操作

b.顺序地将所有没有生效的日志位置生效成共识的值,并将副本的状态变为到分布式共识状态(应该是Coordinator的状态更新)

如果失败,在另外一个副本上重试。

4.验证:如果本地副本被选中并且之前没有最新,发送一个验证消息到coordinator断定(entity group,replica)能够反馈(reflects)所有提交的写操作。不要等待回应----如果请求失败,下一个读操作会重试。

5.查询数据:从选中的副本中使用日志位置所有的时间戳读取数据。如果选中的副本不可用,选取另外一个副本重新开始执行追赶,然后从它那里读取。一个大的读取结果有可能从多个副本中透明地读取并且组装返回

注意在实际使用中1和2a通常是并行执行的。

在完整的读操作算法执行后,Megastore发现了下一个没有使用的日志位置,最后一个写操作的时间戳,还有下一个leader副本。在提交时刻,所有更新的状态都变为打包的(packaged)和提议(proposed),并且包含一个时间戳和下一个leader 候选人,做为下一个日志位置的共识值。如果这个值赢得了分布式共识,那么这个值将会在所有完整的副本中生效。否则整个事务将会终止并且必需重新从读阶段开始。

就像上面所描述的,Coordinators跟踪Entity Groups在它们的副本中是否最新。如果一个写操作没有被一个副本接受,我们必需将这个Entity Group的键从这个副本的Coordinator

中移除。这个步骤叫做invalidation(失效)。在一个写操作被认为提交的并且准备生效,所有副本必需已经接受或者让这个Entity Group在它们coordinator上失效。

写算法的步骤如下:

1.接受Leader:请求Leader接受值做为0号提议的值。如果成功。跳到第三步

2.准备:在所有副本上执行Paxos Prepare阶段,使用一个关于当前log位置更高的提议号。将值替换成拥有最高提议号的那个值。[Replace the value being written withthe

highest-numbered proposal discovered, if any]

3.接受:请求余下的副本接受这个值。如果多数副本失败,转到第二步。

4.失效:将没有接受值的副本coordinator失效掉。错误处理将在接下来描述

5.生效:将更新在尽可能多的副本上生效。如果选择的值不同于原始提议的,返回冲突错误[?]

Coordinator进程在每一个数据中心运行并且只保持其本地副本的状态。在上述的写入算法中,每一个完整的副本必需接受或者让其coordinator失效,所以这个可能会出现任何单个副本失效就会引起不可用。在实际使用中这个不是一个寻常的问题。Coordinator是一个简单的进程,没有其他额外的依赖并且没有持久存储,所以它表现得比一个BigTable服务器更高的稳定性。然而,网络和主机失败仍然能够让coordinator不可用。

Megastore使用了Chubby锁服务:Coordinators在启动的时候从远程数据中心获取指定的Chubby locks。为了处理请求,一个Coordinator必需持有其多数locks。一旦因为宕机或者网络问题导致它丢失了大部分锁,它就会恢复到一个默认保守状态----认为所有在它所能看见的Entity Groups都是失效的。随后(该Coordinator对应的)副本中的读操作必需从多数其他副本中得到日志位置直到Coordinator重新获取到锁并且Coordinator的Entries重新验证的。

写入者通过测试一个Coordinator是否丢失了它的锁从而让其在Coordinator不可用过程中得到保护:在这个场景中,一个写入者知道在恢复之前Coordinator会认为自己是失效的。

在一个数据中心活着的Coordinator突然不可用时,这个算法需要面对一个短暂(几十秒)的写停顿风险---所有的写入者必需等待Coordinator的Chubby locks过期(相当于等待一个master failover后重新启动),不同于master failover,写入和读取都能够在coordinator状态重建前继续平滑进行。

除了可用性问题,对于Coordinator的读写协议必需满足一系列的竞争条件。失效的信息总是安全的,但是生效的信息必需小心处理。在coordinator中较早的写操作生效和较晚的写操作失效之间的竞争通过带有日志位置而被保护起来。标有较高位置的失效操作总是胜过标有较低位置的生效操作。一个在位置n的失效操作和一个在位置m 总体来说,使用Coordinator从而能够在任何数据中心进行快速的本地读取对于可用性的影响并不是完全没有的。但是实际上,以下因素能够减轻使用Coordinator所带来的问题。 1.Coordinators是比任何的BigTable服务器更加简单进程,机会没有依赖,所以可用性更高。 2.Coordinators简单,均匀的工作负载让它们能够低成本地进行预防措施。 3.Coordinators轻量的网络传输允许使用高可用连接进行服务质量监控。 4.管理员能够在维护期或者非安全期集中地让一批Coordinators失效。对于默写信号的监测是自动的。 5.一个Chubby qunrum能够监测到大多数网络问题和节点不可用。 总结 文章总体介绍了下google megastore的实现思路,其主要解决的问题就是如何在复杂的环境下(网络问题,节点失效等等)保证数据存取服务的可用性。对于多机房,多节点,以及ACID 事务支持,实时非实时读取,错误处理等等关键问题上给出了具体方案。 ONEStor 分布式存储系统介绍 关于ONEStor 分布式存储系统介绍,小编已在金信润天 容: 技术特点 H3C ONEStor 存储系统采用分布式设计,可以运行在通用 x86服务器上,在部署该软件时, 会把所有服务器的本地硬盘组织成一个虚拟存储资源池,对上层应用提供块存储功能。 H3C ONEStor 分布式存储软件系统具有如下特点: 领先的分布式架构 H3CONEStor 存储软件的采用全分布式的架构: 分布式管理集群,分布式哈希数据分布算法, 分布式无状态客户端、分布式Cache 等,这种架构为存储系统的可靠性、 可用性、自动运维、 高性能等方面提供了有力保证。其系统架构组成如下图所示: jyionitors 上图中,ONEStor 逻辑上可分为三部分: OSD Monitor 、Client 。在实际部署中,这些逻辑 Get 到了部分资料,整理出以下内 QSDs CliEnt£ Object I/O V* Failure reporting, v ------ map distribution 组件可灵活部署,也就是说既可以部署在相同的物理服务器上,也可以根据性能和可靠性等方面的考虑,部署在不同的硬件设备上。下面对每一部分作一简要说明。 OSD:Object-based Storage Device OSD由系统部分和守护进程(OSD deamon两部分组成。OSD系统部分可看作安装了操作系统和文件系统的计算机,其硬件部分包括处理器、内存、硬盘以及网卡等。守护进程即运行在内存中的程序。在实际应用中,通常将每块硬盘(SSD或HDD对应一个OSD并将其视 为OSD的硬盘部分,其余处理器、内存、网卡等在多个OSD之间进行复用。ONEStor存储集群中的用户都保存在这些OSD中。OSDdeamon负责完成OSD的所有逻辑功能,包括与monitor 和其他OSD(事实上是其他OSD的deamon)通信以维护更新系统状态,与其他OSD共同完成数据的存储和维护,与client 通信完成各种数据对象操作等等。 Monitor : Monitor 是集群监控节点。Monitor 持有cluster map 信息。所谓Cluster Map ,粗略的说就是关于集群本身的逻辑状态和存储策略的数据表示。ONEStor Cluster Map包括Monitor map osd map pg map crush map等,这些map构成了集群的元数据。总之,可以认为Monitor 持有存储集群的一些控制信息,并且这些map信息是轻量级的,只有在集群的物理设备(如主机、硬盘)和存储策略发生变化时map信息才发生改变。 Client : 这里的Client可以看出外部系统获取存储服务的网关设备。client通过与OSD或者Monitor 的交互获取cluster map然后直接在本地进行计算,得出数据的存储位置后,便直接与对应的OSD 通信,完成数据的各种操作。在此过程中,客户端可以不依赖于任何元数据服务器,不进行任何查表操作,便完成数据访问流程。这一点正是ONEStor分布式存储系统可以实现扩展性的重要保证。 客户的数据到达Clie nt后,如何存储到OSD上,其过程大致如下图所示: 根据did you know(https://www.360docs.net/doc/3317148211.html,/)的数据,目前互联网上可访问的信息数量接近1秭= 1百万亿亿 (1024)。毫无疑问,各个大型网站也都存储着海量的数据,这些海量的数据如何有效存储,是每个大型网站的架构师必须要解决的问题。分布式存储技术就是为了解决这个问题而发展起来的技术,下面让将会详细介绍这个技术及应用。 分布式存储概念 与目前常见的集中式存储技术不同,分布式存储技术并不是将数据存储在某个或多个特定的节点上,而是通过网络使用企业中的每台机器上的磁盘空间,并将这些分散的存储资源构成一个虚拟的存储设备,数据分散的存储在企业的各个角落。 具体技术及应用: 海量的数据按照结构化程度来分,可以大致分为结构化数据,非结构化数据,半结构化数据。本文接下来将会分别介绍这三种数据如何分布式存储。 结构化数据的存储及应用 所谓结构化数据是一种用户定义的数据类型,它包含了一系列的属性,每一个属性都有一个数据类型,存储在关系数据库里,可以用二维表结构来表达实现的数据。 大多数系统都有大量的结构化数据,一般存储在Oracle或MySQL的等的关系型数据库中,当系统规模大到单一节点的数据库无法支撑时,一般有两种方法:垂直扩展与水平扩展。 ? 垂直扩展:垂直扩展比较好理解,简单来说就是按照功能切分数据库,将不同功能的数据,存储在不同的数据库中,这样一个大数据库就被切分成多个小数据库,从而达到了数据库的扩展。一个架构设计良好的应用系统,其总体功能一般肯定是由很多个松耦合的功能模块所组成的,而每一个功能模块所需要的数据对应到数据库中就是一张或多张表。各个功能模块之间交互越少,越统一,系统的耦合度越低,这样的系统就越容易实现垂直切分。 ? 水平扩展:简单来说,可以将数据的水平切分理解为按照数据行来切分,就是将表中的某些行切分到一个数据库中,而另外的某些行又切分到其他的数据库中。为了能够比较容易地判断各行数据切分到了哪个数据库中,切分总是需要按照某种特定的规则来进行的,如按照某个数字字段的范围,某个时间类型字段的范围,或者某个字段的hash值。 垂直扩展与水平扩展各有优缺点,一般一个大型系统会将水平与垂直扩展结合使用。 实际应用:图1是为核高基项目设计的结构化数据分布式存储的架构图。 分布式存储系统节能技术研究综述 发表时间:2016-04-18T11:33:29.663Z 来源:《电力设备》2016年1期供稿作者:于辉 [导读] 广东电网有限责任公司东莞供电局信息中心)企业的信息系统产生小规模的数据,小的数据存储中心即可对数据进行存储,这个时期企业所观注的是数据中心的性能和可靠性。 于辉 (广东电网有限责任公司东莞供电局信息中心) 摘要:随着大数据时代的到来,企业所需要存储的数据越来越多,不得不对现有的数据存储中心进行扩容,以实现更大级别数据量的存储。分布式存储系统为构建数据中心的重要方式之一,存储系统的能耗情况是衡量一个存储系统性能的重要指标,因此,研究分布式存储系统的节能技术具有一定的必要性。本文的主要工作是对分布式存储技术的节能技术进行综述,以使读者了解现有的分布式存储系统节能研究现状。 关键字:大数据、分布式、节能、能耗 一、前言 大数据时间,数据存储中心的能耗越来越受到人们的重视,它也逐渐变成继性能和可靠性之后,衡量数据存储中心的第三个指标。在信息系统应用初期,企业引进信息系统来改善管理,提高企业的经营和管理效率。这个时期,企业的信息系统产生小规模的数据,小的数据存储中心即可对数据进行存储,这个时期企业所观注的是数据中心的性能和可靠性。 而随这互联网、大数据时代的到来,企业生产运营所积累的数据成几何级的增加,小的数据中心已不能支持新的数据存储需求,企业不得不对原有的数据中心进行扩容,大量的新增设备新加入到数据中心中,此时,数据中心的能耗已经成为企业所考虑的一个企业经营成本问题,如何降低数据中心的能耗已经成为企业管理者所思考的一个问题。图1给出了数据中心管理者眼中的最大挑战,可见能耗问题排在第一位[8]。 图1 数据中心管理者眼中的最大挑战 对于大规模的数据存储中心。为了保证低成本和高扩展性,通常会选择分布式存储技术。数据存储是分布式存储服务的基础,分布式存储系统中能耗最高的部分主要在设备耗能方面。因此,在分布式环境下,如果能有效降低存储系统的能耗,对降低数据中心的整体能耗有显著效果。 二、分布式存储系统 传统分布式存储系统重点考虑在分布式环境中如何解决诸如数据复制、负载均衡、集群关系管理、可靠性保证、高性能等技术问题。目前,基于OpenPower、X86等架构的国产服务器逐步采用低功耗多核处理器、高带宽内存以及异构存储等硬件资源,传统分布式存储系统在系统设计、技术优化等方面没有充分发挥上述硬件的特点。具体来说,包括以下三方面: 1 分布式存储在面向低功耗多核处理器时的不足 传统的分布式存储没有充分利用存储节点的处理能力,而存储节点的处理能力完全有能力承担除存储服务之外的任务,例如将部分计算任务迁移到存储节点上,从而提高整个集群的计算能力。另一方面,国产服务器采用的低功耗处理器提供不同功耗模式以适应不同的工作负载,可以动态变化。现有的分布式存储没有针对上述处理器特点进行设计和技术优化考虑。 2 分布式存储在面向高带宽内存时的不足 随着国产服务器逐步采用高带宽内存技术,处理器与内存间的数据移动效率越来越高,以适应大数据应用场景。如何将更有价值的数据保留在处理器缓存中,如何利用每个服务器节点上的高带宽内存形成高效的分布式缓存层,以减少对存储层的访问压力,这些问题都是现有分布式存储没有给予充分考虑,并作相应设计优化的。 3、分布式存储在面向机械硬盘与SSD组成的异构存储时的不足 大数据环境下,对存储的容量和性能等提出了更高的要求。从性能、成本的角度考虑,不允许将所有数据都统一存储于集中式的存储设备上,因此异构存储越来越受到重视。现有分布式存储系统虽然有考虑异构存储架构,但是仅以数据冷热、I/O特征作为异构存储资源分配因素。此外,现有分布式存储系统仅考虑存储层,没有将异构存储对存储以及计算与存储结合等应用场景产生的影响进行考虑分析。 三节能技术综述 由磁盘的能耗工式可知,磁盘的主要能耗取决于磁盘的转速,磁盘处于Standby状大下时,其能耗远小于在Idle和Active状态下的能耗。S.Gurumurthi 等人在TPM(Traditional Power Management)的基础上,提出了 DRPM(Dynamical RPM)技术[2]。该技术通过细分 分布式数据库技术在大数据中的应用 分布式数据库技术在大数据中的应用 摘要随着当前运营商对数据管理和应用需求的不断增加,分布式数据库技术得到极大的发展。在本文中首先对当前大数据环境下的分布式数据库技术进行介绍,然后分析分布式数据库技术在大数据中的具体应用。 关键词分布式数据库;数据管理;数据处理 中图分类号 TP3 文献标识码 A 文章编号 1674-6708(2016)165-0108-01 随着当前移动互联网技术的迅猛发展,数据的种类和数量呈现快速的增长,传统的处理方式逐渐的不能够适应当前的发展需要,基于此种背景下,分布式数据库技术需要得到更快的发展,以达到对大数据的存储、管理以及分析等处理要求。 1 大数据中发展分布式数据库的意义 在面对当前的大数据时代,传统的集中式数据库已经逐渐的不能够满足人们的使用要求,需要找到新的处理方式来进行更新,分布式数据库就是在这样的背景下逐渐的被发展和应用。分布式数据库在使用中有着许多传统集中式数据库不具备的优点:第一,分布式数据库有着极为强大的扩展能力,这是传统数据库所不具备的,在数据的存储方面表现出巨大的优势;第二,来自于成本上的优势。 在大数据中,如果仍旧采用原有的数据库,在进行扩容的时候,会花费大量的资金,使得成本上花费巨大,而且所取得的效果也是有限的。分布式数据库则只需要较少的资金就能够完成扩容处理,占据着特别大的优势[1];第三,分布式数据库在用户上有着很大的优势,分布式数据库让人们对大数据的存储、分析和处理变得容易和快捷。 2 分布式数据库技术分析 在大数据中,分布式数据库技术得到极大的发展,也正是由于分布式数据库技术表现出来的先进性能,才使得分布式数据库得到广泛的使用。在分布式数据库中,其由很多个并行的处理单元组成,而且每个处理单元都是一个完整的系统,其中包括数据的存储,数据的分析等,对于每一个处理单元来说,其所处的位置和作用都是对等的,而且是相对独立的。混合存储技术:突破传统行存的限制,实现行列混合存储。该项技术对于分布式数据库的性能有着很大的提升,使得分布式数据库在运行速度和运行的灵活性上都有很大的提高。再就是智能索引技术,该种技术所占用的空间减少,并且能够很好的解决后面数据库慢的问题,不会对后面的索引数据造成影响[2]。除此之外,分布式数据库中还具有许多先进的技术,如并行处理技术、高效透明压缩技术等,都是传统数据库中所不具备 信息技术的发展带来数据的爆炸性增长,毋庸置疑,我们已经全面跨入大数据时代,PB 规模的非结构化数据越来越常见,如何有效地管理这些数据,并进一步发掘数据价值,已成为IT 管理者所必须重视的问题。同时大数据4V 特性也对存储系统的大容量、高性能、易扩展、易用性等提出了更高要求。传统的SAN 和NAS 存储架构已经难以满足海量数据的密集型I/O 并发访问需求。 ParaStor300S 并行分布式云存储系统,是在曙光公司近10年来海量数据存储与处理的基础之上,针对大数据时代的特点,全新设计并全面优化的高端存储系统。 产品定位 集群文件/对象统一存储 基于曙光完全自主研发的并行分布式软件ParaStor 构建的集群存储系统,对外统一提供多种存储协议: 提供文件存储服务,包括Linux POSIX 、NFS 、SMB 、FTP 等,满足Windows 、Linux 、Unix 等异构平台的不同访问需求; 提供对象存储服务,兼容Amazon S3接口,满足云生态的应用需求。 特别地,同一集群可以同时提供文件/对象接口,访问方式更为灵活。 Scale-Out 横向扩展的并行架构 基于服务器构建的并行分布式存储系统,对外提供单一的命名空间。支持3~4096节点的弹性无缝扩展,单一存储空间容量可扩展至EB 级。 具备超强的横向扩展能力,只需简单地增加存储节点,即可获得更大的存储容量和更多的数据通道,从而获得更高的系统聚合带宽和I/O 性能。 面向海量非结构化数据存储场景 ParaStor300S 并行分布式云存储系统适用于存在数据共享需求的多种应用领域,如高性能计算、生物信息、气象预报、环境监测分析、地震监测、能源勘探、卫星遥感、视频监控、媒资管理、视频编辑处理等,可以广泛应用于政府、教育、科研、医疗、石油、广电、企业等行业。 ParaStor300S 并行分布式云存储系统 新一代自主研发的海量非结构化数据存储 EB 级共享空间 ? 3~4096节点 ? 单一命名空间 ? 按需分配,在线扩容 多种访问协议 ? Linux POSIX ? NFS/CIFS/FTP ? S3 多款硬件平台 ? 2U12、4U24、4U36 ? SATA/SAS/SSD 混插 智能存储策略 ? SSD 读缓存加速 ? 细粒度配额管理 多重数据保护 ? 2~4副本 ? N+M:b 纠删码 ? 快照 ? 全冗余设计,无单点故障 简易运维管理 ? 多套集群统一管理 ? 资源、状态实时监控 ? 邮件、短信、SNMP 告警 内容目录 1核心观点 (3) 1.1核心推荐逻辑 (3) 1.2我们区别于市场的观点 (3) 2分布式存储将成为下一代互联网基础设施 (3) 2.1以IPFS 协议为代表的分布式存储带来新思路 (3) 2.2分布式存储将带来互联网基础架构变革 (7) 3分布式存储开辟互联网基础设施产业新格局 (9) 3.1分布式存储开发新的存储市场 (9) 3.2分布式存储已和传统存储不断融合应用 (10) 4分布式存储面临的技术瓶颈与发展机遇 (12) 4.1数据价值分层是分布式存储经济激励的关键 (12) 4.2I/O 性能瓶颈需要底层和应用层联合优化解决 (13) 4.3服务质量保障 (15) 4.4在应用、运营层面中心化组织与分布式存储将进一步融合 (15) 图表目录 图表1:IPFS 协议的分布式系统 (4) 图表2:IPFS 协议构架 (4) 图表3:集中化的版本控制系统 (5) 图表4:分布式版本控制系统 (5) 图表5:Merkle DAG 数据结构及功能特点 (6) 图表6:DHT 网络工作原理 (6) 图表7:全球数据圈每年规模 (7) 图表8:IPFS 协议关注的基础问题 (7) 图表9:IPFS 与HTTP 协议的对比 (8) 图表10:IPFS 与HTTP 寻址方式对比 (8) 图表11:全球数据量增长状况 (9) 图表12:中国云存储市场规模及增速 (9) 图表13:中国公有云市场规模及增速 (9) 图表14:个人云盘行业用户渗透率及MAU (10) 图表15:储迅部分合作伙伴 (11) 图表16:高性能分布式文件系统 (11) 图表17:CRUST 技术架构:工作量证明层MPoW、区块链共识层GPoW 及分布式云存储/计算层 (12) 图表18:CRUST 部分合作伙伴 (12) 图表19:数据价值分层是分布式存储经济激励的关键 (13) 图表20:IPFS 与HTTP 性能对比:远程读取操作的平均延迟 (14) 图表21:IPFS 与HTTP 性能对比:远程读取操作的延迟范围 (14) 图表22:IPFS 与HTTP 性能对比:远程读取操作的吞吐量 (14) 图表23:分布式存储面临的技术瓶颈与发展机遇 (15) 基于DHT的分布式云存储系统综述 题目:基于云计算的知识管理综述 专业:计算机应用技术 年级: 2014级 学号: 2014303100×× 姓名:静水流云 上海××大学信息工程学院 2014 年 12 月28 日 基于DHT的分布式云存储系统的综述 摘要:随着信息爆炸式的增长,集中式的存储方式的瓶颈效应愈发明显的遏制了数据存储的扩展性和并 发访问的效率等,SAN 和NAS 等传统集中式存储系统越来越难以满足海量数据存储的需要。为了解决诸 如此类的传统存储的瓶颈问题,分布式存储系统和云存储系统相继被提出,并成为学术研究和商用的热点 内容。分布式存储系统实现涉及并使用的技术有很多,本文主要介绍基于DHT的分布式存储系统,重点在 搜索技术方面。 1 引言 把用户的文件分片后均衡存储在不同的分布式存储节点上,并利用虚拟目录服务器和基于P2P—DHT 的目录服务器把文件元数据与文件数据片高效地对应起来,以提供高效目录服务,分布式存储节点以P2P 方式工作以快速完成用户对文件数据的请求任务。分布式网络存储系统DNSS充分利用了DHT原理和P2P 的搜索技术优势[3],有较高的可用性、可靠性和可扩展性。P2P技术突破了传统的C/S架构的模式,具 有非常好的扩展性,但存在安全性、可控性问题[2]。利用DHT的资源管理优势和P2P的高扩展性,可以 构建一个在全互联网范围内使用的可靠高效的海量分布式存储系统。而对于海量数据的分布式存储,主要 涉及的技术问题是如何处理好数据的添加、删除以及最为重要的查找效率,本文结合分布式hash表的一 致特性,重点讲述一下如何构造一个基于DHT的分布式存储系统,当然主要内容是DHT原理部分[1]。 2 p2p网络和hash函数概述 2.1 p2p网络简介 p2p网络又称工作组,网上各台计算机有相同的功能,无主从之分,一台计算机都是既可作为服务器,设定共享资源供网络中其他计算机所使用,又可以作为工作站,没有专用的服务器,也没有专用的工作站。在P2P网络环境中,成千上万台彼此连接的计算机都处于对等的地位,整个网络一般来说不依赖专用的集 中服务器。网络中的每一台计算机既能充当网络服务的请求者,又对其它计算机的请求作出响应,提供资 源和服务。其主要分为两种:非结构化p2p网络和结构化p2p网络[4]。前者有网络拓扑是任意的、内容 的存储位置与网络拓扑无关的特点;后者网络拓扑结构是有规律的,每个节点都随机生成一个标识(ID), 内容的存储位置与网络拓扑相关,内容的存储位置与节点标识之间存在着映射关系。 2.2 hash函数简介 Hash函数可以根据给定的一段任意长的消息计算出一个固定长度的比特串,通常称为消息摘要(MD:Message Digest),一般用于消息的完整性检验。Hash函数有以下特性:给定 P,易于计算出 MD(P) 只给出 MD(P),几乎无法找出 P无法找到两条具有同样消息摘要的不同消息Hash函数MD5:消息摘要 长度固定为128比特;SHA-1:消息摘要长度固定为160比特。Hash函数应用于P2P的特性唯一性:不同 的输入明文,对应着不同的输出摘要将节点IP地址的摘要作为节点ID,保证了节点ID在P2P环境下的 唯一性SHA-1(“202.38.64.1”) =24b92cb1d2b81a47472a93d06af3d85a42e463ea。 3 DHT原理 3.1 DHT简述 DHT(Distributed Hash Table,分布式哈希表)算法就是使用分布式哈希函数来解决结构化的分布式 存储问题[1]。分布式哈希表实际上是一张散列表,每个节点被分配给一个属于自己的散列块,并成为这 个散列块的管理者。目前,典型的DHT协议包括美国MIT的Chord、UC Berkeley的pastry和CAN、纽约 大学的Kademlia [2]。本文主要介绍chord和pastry。将内容索引抽象为 1DFS系统 (DFS) 是AFS的一个版本,作为开放软件基金会(OSF)的分布 分布式文件系统 式计算环境(DCE)中的文件系统部分。 如果文件的访问仅限于一个用户,那么分布式文件系统就很容易实现。可惜的是,在许多网络环境中这种限制是不现实的,必须采取并发控制来实现文件的多用户访问,表现为如下几个形式: 只读共享任何客户机只能访问文件,而不能修改它,这实现起来很简单。 受控写操作采用这种方法,可有多个用户打开一个文件,但只有一个用户进行写修改。而该用户所作的修改并不一定出现在其它已打开此文件的用户的屏幕上。 并发写操作这种方法允许多个用户同时读写一个文件。但这需要操作系统作大量的监控工作以防止文件重写,并保证用户能够看到最新信息。这种方法即使实现得很好,许多环境中的处理要求和网络通信量也可能使它变得不可接受。 NFS和AFS的区别 NFS和AFS的区别在于对并发写操作的处理方法上。当一个客户机向服务器请求一个文件(或数据库记录),文件被放在客户工作站的高速缓存中,若另一个用户也请求同一文件,则它也会被放入那个客户工作站的高速缓存中。当两个客户都对文件进行修改时,从技术上而言就存在着该文件的三个版本(每个客户机一个,再加上服务器上的一个)。有两种方法可以在这些版本之间保持同步: 无状态系统在这个系统中,服务器并不保存其客户机正在缓存的文件的信息。因此,客户机必须协同服务器定期检查是否有其他客户改变了自己正在缓存的文件。这种方法在大的环境中会产生额外的LAN通信开销,但对小型LAN来说,这是一种令人满意的方法。NFS 就是个无状态系统。 回呼(Callback)系统在这种方法中,服务器记录它的那些客户机的所作所为,并保留它们正在缓存的文件信息。服务器在一个客户机改变了一个文件时使用一种叫回叫应答(callbackpromise)的技术通知其它客户机。这种方法减少了大量网络通信。AFS(及OSFDCE的DFS)就是回叫系统。客户机改变文件时,持有这些文件拷贝的其它客户机就被回叫并通知这些改变。 无状态操作在运行性能上有其长处,但AFS通过保证不会被回叫应答充斥也达到了这一点。方法是在一定时间后取消回叫。客户机检查回叫应答中的时间期限以保证回叫应答是当前有效的。回叫应答的另一个有趣的特征是向用户保证了文件的当前有效性。换句话说,若 ONEStor分布式存储系统介绍 关于ONEStor分布式存储系统介绍,小编已在金信润天Get到了部分资料,整理出以下内容: 技术特点 H3C ONEStor存储系统采用分布式设计,可以运行在通用x86服务器上,在部署该软件时,会把所有服务器的本地硬盘组织成一个虚拟存储资源池,对上层应用提供块存储功能。H3C ONEStor分布式存储软件系统具有如下特点: 领先的分布式架构 H3C ONEStor存储软件的采用全分布式的架构:分布式管理集群,分布式哈希数据分布算法,分布式无状态客户端、分布式Cache等,这种架构为存储系统的可靠性、可用性、自动运维、高性能等方面提供了有力保证。其系统架构组成如下图所示: 上图中,ONEStor逻辑上可分为三部分:OSD、Monitor、Client。在实际部署中,这些逻辑 组件可灵活部署,也就是说既可以部署在相同的物理服务器上,也可以根据性能和可靠性等方面的考虑,部署在不同的硬件设备上。下面对每一部分作一简要说明。 OSD:Object-based Storage Device OSD由系统部分和守护进程(OSD deamon)两部分组成。OSD系统部分可看作安装了操作系统和文件系统的计算机,其硬件部分包括处理器、内存、硬盘以及网卡等。守护进程即运行在内存中的程序。在实际应用中,通常将每块硬盘(SSD或HDD)对应一个OSD,并将其视为OSD的硬盘部分,其余处理器、内存、网卡等在多个OSD之间进行复用。ONEStor存储集群中的用户都保存在这些OSD中。OSD deamon负责完成OSD的所有逻辑功能,包括与monitor 和其他OSD(事实上是其他OSD的deamon)通信以维护更新系统状态,与其他OSD共同完成数据的存储和维护,与client通信完成各种数据对象操作等等。 Monitor: Monitor是集群监控节点。Monitor持有cluster map信息。所谓Cluster Map,粗略的说就是关于集群本身的逻辑状态和存储策略的数据表示。 ONEStor Cluster Map包括Monitor map、osd map、pg map、crush map等,这些map构成了集群的元数据。总之,可以认为Monitor 持有存储集群的一些控制信息,并且这些map信息是轻量级的,只有在集群的物理设备(如主机、硬盘)和存储策略发生变化时map信息才发生改变。 Client: 这里的Client可以看出外部系统获取存储服务的网关设备。client通过与OSD或者Monitor 的交互获取cluster map,然后直接在本地进行计算,得出数据的存储位置后,便直接与对应的OSD通信,完成数据的各种操作。在此过程中,客户端可以不依赖于任何元数据服务器,不进行任何查表操作,便完成数据访问流程。这一点正是ONEStor分布式存储系统可以实现扩展性的重要保证。 客户的数据到达Client后,如何存储到OSD上,其过程大致如下图所示: 大数据存储技术研究 3013218099 软工二班张敬喆 1.背景介绍 大数据已成为当前社会各界关注的焦点。从一般意义上讲,大数据是指无法在可容忍的时间内,用现有信息技术和软硬件工具对其进行感知、获取、管理、处理和服务的数据集合。近年来,大数据的飙升主要来自人们的日常生活,特别是互联网公司的服务。据著名的国际数据公司(IDC)的统计,2011年全球被创建和复制的数据总量为1.8ZB(1ZB=1021B),其中75%来自于个人(主要是图片、视频和音乐),远远超过人类有史以来所有印刷材料的数据总量(200PB,1PB=1015B)。 然而,与大数据计算相关的基础研究,诸如大数据的感知与表示、组织与存储、计算架构与体系、模式发现与效应分析等,目前还没有成体系的理论成果。对于大数据计算体系的研究,一方面,需要关注大数据如何存储,提供一种高效的数据存储平台;另一方面,为了应对快速并高效可靠地处理大数据的挑战,需要建立大数据的计算模式以及相关的优化机制。 2.相关工作 为了应对数据处理的压力,过去十年间在数据处理技术领域有了很多的创新和发展。除了面向高并发、短事务的OLTP内存数据库外(Altibase,Timesten),其他的技术创新和产品都是面向数据分析的,而且是大规模数据分析的,也可以说是大数据分析的。 在这些面向数据分析的创新和产品中,除了基于Hadoop环境下的各种NoSQL外,还有一类是基于Shared Nothing架构的面向结构化数据分析的新型数据库产品(可以叫做NewSQL),如:Greenplum(EMC收购),Vertica(HP 收购),Asterdata(TD 收购),以及南大通用在国内开发的GBase 8a MPP Cluster等。目前可以看到的类似开源和 王东临论分布式存储及系统指标存储是IT核心技术 众所周知,美国是IT技术执牛耳者,几乎垄断了IT业。近些年,中国在IT 应用技术逐渐赶超美国,甚至在移动支付等个别领域已经反超美国。但是IT核心技术仍然被国际巨头把持,其中IT基础架构技术是最重要的IT核心技术。 IT基础架构技术为应用层提供存储能力和计算能力,包括存储、计算、网络三大件。存储技术是其中重要组成部分,甚至很多存储从业人士认为,存储比计算和网络更为重要。不管这个观点是否得到认同,存储是IT核心技术的重要组成部分,这一点是无可置疑的。 存储产业长期被国际巨头所把持 在桌面级存储时代,中国是全军覆没。当年兴起的众多硬盘厂家,全部倒闭。FAT等流行的桌面文件系统,也全都是美国厂商的。 在企业级存储时代,Dell/EMC、NetApp、IBM、HPE、HDS等美日巨头处于一流水平,把持着产业,中国的华为存储几千人的团队奋斗十几年,已经达到世界二流水平,而且处于二流水平的前列,正在向世界一流水平发起冲击,但尚有一定距离。即使在中国市场,也是到了最近两年才有一些小银行开始尝试使用华为存储,其它银行的核心存储是宁愿用日本的HDS也不用华为的。 在云存储时代,AWS、Azure和Google位于世界一流,阿里云在马云的强力推动下成功位居世界二流水平,但阿里云虽然借助各种因素成为中国市场的霸主,在全球市场依然难以突破。最近,阿里云美国市场也不得不做出调整,从面向美国主流市场调整为面向做中国生意的美国企业。 区块链存储时代虽然还在孕育中,但给中国人带来了新的机会。抓住一个产业新机会,跃居世界一流水平,成为所有中国存储人的期盼。 分布式存储 分布式存储是一个有歧义的名词,在不同的行业有不同的含义。在存储行业, 1一级视频云存储系统设计 1.1一级网络视频云存储概述 本项目采用华为网络视频云存储VCN3000设计一级视频云存储子系统.采取分布式直接存储,集中管理的方式,针对摄像头视频存储硬件采用针对视频存储优化的网络视频存储和磁盘阵列,所有的存储设备部署在各辖区运营商机房(六个),前端摄像头采用标准的H.264编码RTP流,直写到网络视频存储中。 华为网络视频云存储VCN3000采用由管理平台、IP网络,通过虚拟化、云结构化和高精确视频直接存储模式。运用负载均衡、对象存储等技术,结合视频、图片数据特点,面向应用,满足视频监控业务高可靠性、不间断的海量存储需求。采用分散存储技术加速大数据智能分析快速提取和分析效率。 华为网络视频云存储VCN3000系统使用存储虚拟化技术针对海量存储应用需求,为用户提供透明存储构架、高可扩展性的云管理存储服务。在云管理存储系统中将信令与业务承载码流相分离,云管理服务器只处理控制信令而不处理视频数据,实时视频数据直接写入到云管理存储物理存储节点,无需中间环节。 视频云管理存储管理软件在市局监控中心以集群方式进行部署,实现全市所有监控点和所有云管理存储物理设备的统一管理。 视频云管理存储系统中,IPC直写存储设备,采用云管理方案解决云管理存储管理单节点失效问题,利用负载均衡技术充分利用各存储节点的性能。云管理存储系统采用统一接口与视频管理平台对接,降低平台维护和用户管理复杂度。 华为网络视频云存储VCN3000支持基于GB/T28181标准实现与各级标准平台(符合GB/T28181规范的标准平台)间的互联互通,平台之间通过信令安全路由网关进行信令对接,在信令的控制下媒体通过媒体服务器互联。该体系构架可以支持上下级级联、平级级联以及监控报警专网与公安网的互联。 1.前言 1.1.简介 1)MinIO 是在Apache License v2.0 下发布的对象存储服务器。它 与Amazon S3 云存储服务兼容。它最适合存储非结构化数据,如照片,视频,日志文件,备份和容器/ VM 映像。对象的大小可以从几KB 到最大5TB。 2)MinIO 服务器足够轻,可以与应用程序堆栈捆绑在一起,类似于 NodeJS,Redis 和MySQL。 3)一种高性能的分布式对象存储服务器,用于大型数据基础设施。 它是机器学习和其他大数据工作负载下Hadoop HDFS 的理想s3 兼容替代品 1.2.特点 Minio使用纠删码erasure code和校验和checksum来保护数据免受硬件故障和无声数据损坏。即便丢失一半数量(N/2)的硬盘,仍然可以恢复数据。 2.预研目的 检验在分布式部署条件下,minio在多种实验环境下的数据的安全性。 3.预研环境 4.环境部署 4.1.系统初始化 1)关闭防火墙 2)关闭selinux 3)关闭NetworkManager 4.2.下载minio二进制包 curl -O https://dl.min.io/server/minio/release/linux-amd64/minio 4.3.安装minio chmod +x minio mv minio /usr/bin/ 4.4.创建节点export 在minio的4个节点上各创建1个export,为了方便理解给每个export取名为/data_{+ip地址的最后一位数},最后生成的export如下表所示: 4.5.编写运行脚本 cat minio_startup.sh #!/bin/bash export MINIO_ACCESS_KEY=Admin#Geostar,5 export MINIO_SECRET_KEY=Super#Geostar,5 /usr/bin/minio server http://172.16.150.5/data_05 http://172.16.150.14/data_14 http://172.16.150.21/data_21 http://172.16.150.24/data_24 & chmod +x minio_startup.sh LINGHANG TECHNOLOGIES CO.,LTD 中科分布式存储系统技术白皮书 北京领航科技 2014年04 目录 1、产品介绍 (3) 1.1 云时代的政府/企业烦恼 (3) 1.2 产品服务与定位 (3) 2、中科分布式存储应用场景 (4) 2.1 目标用户 (4) 2.2 产品模式 (4) 2.2.1高性能应用的底层存储 (4) 2.2.2企业级海量数据存储平台 (5) 2.2.3容灾备份平台 (5) 2.3 使用场景 (5) 2.3.1企业级数据存储 (5) 2.3.2私有云计算 (6) 2.3.3海量数据存储 (6) 2.3.4大数据分析 (7) 2.3.5 容灾备份 (7) 3、中科分布式存储核心理念 (8) 4、中科分布式存储功能服务 (9) 4.1 存储系统功能介绍 (9) 4.2 WEB监控管理端功能介绍 (11) 5、系统技术架构 (12) 5.1 系统总体架构 (12) 5.2 系统架构性特点 (12) 5.3 技术指标要求 (14) 5.4 系统软硬件环境 (15) 1、产品介绍 1.1云时代的政府/企业烦恼 ?政府、企事业单位每天产生的大量视频、语音、图片、文档等资料,存在 哪里? ?政府、企事业单位各个部门、各个子系统之间强烈的数据共享需求如何满 足? ?大数据如何高效处理以达到统一存取、实时互动、价值传播、长期沉淀? ?您是否为单位电子邮箱充斥大量冗余数据还要不断扩容而烦恼? ?政府、企事业单位的私有云平台为什么操作和数据存取这么慢? ?政府、企事业单位的存储平台数据量已接近临界值需要扩容,但上面有重 要业务在运行,如何能在线扩展存储空间? ?公司的每一个子公司都有重要客户数据,要是所在的任何一个城市发生大 规模灾难(比如地震)数据怎么办? ?政府、企事业单位有一些历史数据平时比较少用到,但又不能丢掉,占用 了大量的高速存储资源,能否移到更廉价的存储设备上去? 1.2产品服务与定位 大数据时代已经来临! 面对数据资源的爆炸性增长,政府、企事业单位每天产生的海量视频、语音、图片、文档和重要客户数据等资料如何有效存取?政府多个部门之间、公司和子公司之间、公司各个部门之间强烈的数据共享需求如何满足?如果 2014/10/17 云计算环境下的分布式存储技术的研究与分析 李世敏 (四川大学计算机学院,四川成都610225) Cloud Computing Environment of Distributed Storage Technology Research and Analysis LI Shi-Min (Department of SiChuan, University, City ChengDu, China) Corresponding author: E-mail: 2586975148@https://www.360docs.net/doc/3317148211.html, Abstract: cloud computing describes a new IT service value based on the Internet, use and delivery mode, is a combination of data sharing and Shared services computing mode.As the cloud of promotion and popular, how high rate, low cost of storage and management of large amounts of data generated in the clouds, has become a focus in the study of major enterprises and organizations, which requires good cloud structure design, data storage and processing pattern and cloud storage platform.From the combination of cloud computing and cloud storage technology, aiming at how to improve the scalability of the storage, fault tolerance and lower the energy consumption of the storage, such as target, from the design of the data center network, data storage, etc were summarized, the key technology in the current distribution of storage, and on this basis, to the cloud environment of distributed storage system under the challenges faced by summarized and expounded. Key words: cloud computing;The data center;Data storage way;Storage challenges 摘要: 云计算描述了一种新的基于互联网的IT服务增值、使用和交付模式,是数据共享与服务共享计算模式的结合体。随着云计的推广和流行,如何高速率、低成本储存和管理生成于云端的大量数据,也成为各大企业和组织研究的重点,这就需要有良好的云结构设计、数据存储及处理模式和云存储平台。从云计算与云存储技术的结合入手,针对如何提高存储的可扩展性、容错性以及降低存储的能耗等目标,从数据中心网络的设计、数据的存储方式等方面对当前分布存储的关键技术进行了综述,并在此基础上,对云环境下的分布式存储系统所面临的挑战进行总结和阐述。 关键词: 云计算;数据中心;数据存储方式;存储挑战 1 引言 云计算是随着计算、存储以及通信技术的快速发展而出现的一种崭新的共享基础资源的商业计算模型,被誉为“革命性的计算模型”。云计算不同于传统的以个人计算机为中心的本地计算,它以互联网为中心,通过构建一个或多个由大量(百万级以上)普通机器和网络设备连接构成的数据中心,把海量的数据存储到数 1 大数据技术原理及应用 (总10页) -CAL-FENGHAI.-(YICAI)-Company One1 -CAL-本页仅作为文档封面,使用请直接删除 大数据技术原理及应用 大数据处理架构—Hadoop简介 Hadoop项目包括了很多子项目,结构如下图 Common 原名:Core,包含HDFS, MapReduce和其他公共项目,从Hadoop 版本后,HDFS和MapReduce分离出去,其余部分内容构成Hadoop Common。Common为其他子项目提供支持的常用工具,主要包括文件系统、RPC(Remote procedure call) 和串行化库。 Avro Avro是用于数据序列化的系统。它提供了丰富的数据结构类型、快速可压缩的二进制数据格式、存储持久性数据的文件集、远程调用RPC的功能和简单的动态语言集成功能。其中,代码生成器既不需要读写文件数据,也不需要使用或实现RPC协议,它只是一个可选的对静态类型语言的实现。Avro系统依赖于模式(Schema),Avro数据的读和写是在模式之下完成的。这样就可以减少写入数据的开销,提高序列化的速度并缩减其大小。 Avro 可以将数据结构或对象转化成便于存储和传输的格式,节约数据存储空间和网络传输带宽,Hadoop 的其他子项目(如HBase和Hive)的客户端和服务端之间的数据传输。 HDFS HDFS:是一个分布式文件系统,为Hadoop项目两大核心之一,是Google file system(GFS)的开源实现。由于HDFS具有高容错性(fault-tolerant)的特点,所以可以设计部署在低廉(low-cost)的硬件上。它可以通过提供高吞吐率(high throughput)来访问应用程序的数据,适合那些有着超大数据集的应ONEStor分布式存储系统介绍

分布式存储技术及应用介绍

分布式存储系统节能技术研究综述

分布式数据库技术在大数据中的应用复习过程

曙光ParaStor300S并行分布式云存储系统产品技术白皮书V1.6

分布式存储发展趋势及技术瓶颈分析

基于DHT分布式云存储系统综述

分布式文件存储方案

ONEStor分布式存储系统介绍

大数据存储技术研究

王东临论分布式存储及系统指标

一级视频云存储技术方案

MinIO分布式存储技术预研报告

中科分布式存储系统技术白皮书V2.0

云计算环境下的分布式存储技术的研究与分析——李世敏——1143041362

大数据技术原理及应用