清除网页历史记录,屏蔽后退按钮

清除网页历史记录,屏蔽后退按钮

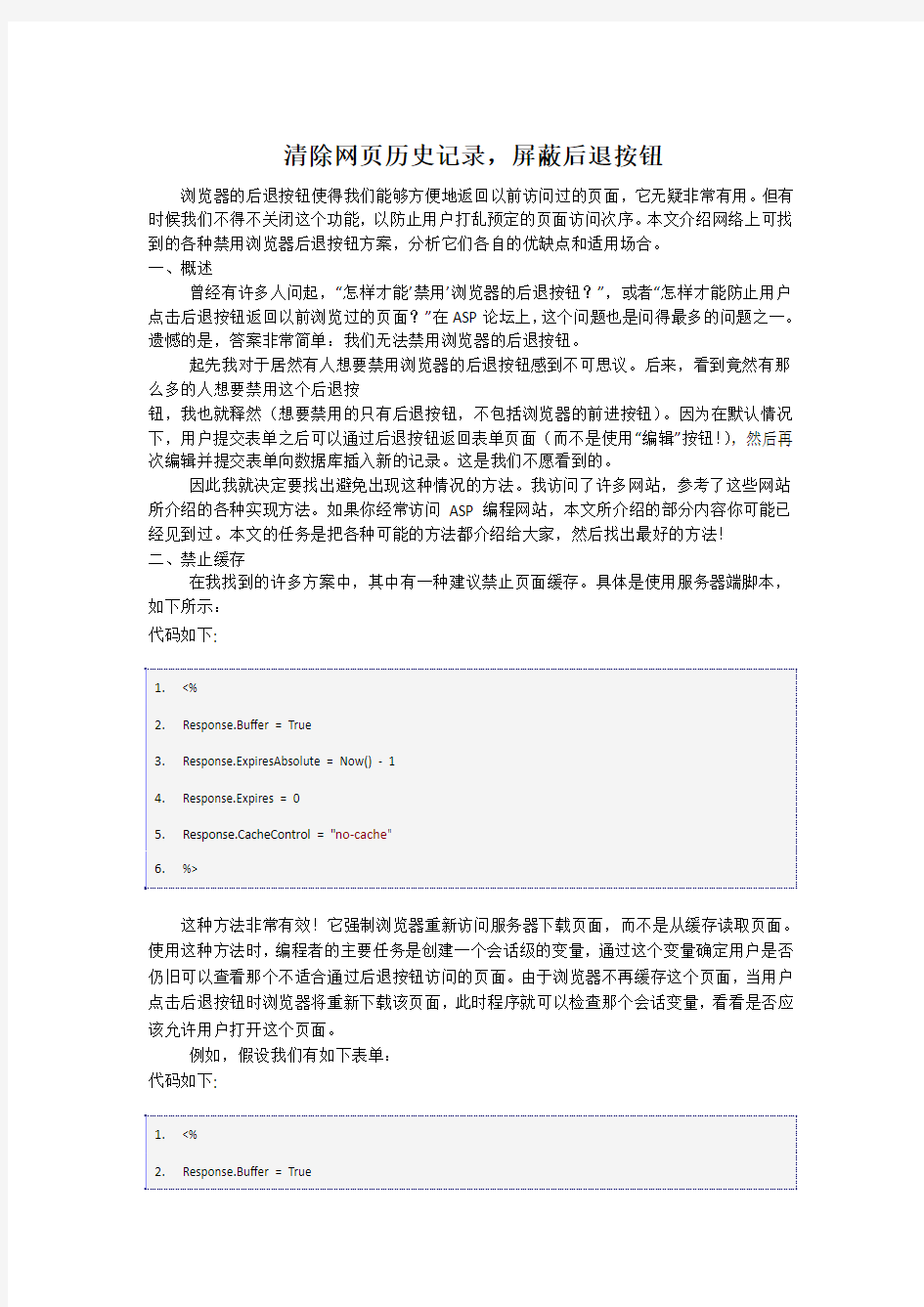

浏览器的后退按钮使得我们能够方便地返回以前访问过的页面, 它无疑非常有用。 但有 时候我们不得不关闭这个功能, 以防止用户打乱预定的页面访问次序。 本文介绍网络上可找 到的各种禁用浏览器后退按钮方案,分析它们各自的优缺点和适用场合。 一、概述 曾经有许多人问起,“怎样才能’ 禁用’ 浏览器的后退按钮?”,或者“怎样才能防止用户 点击后退按钮返回以前浏览过的页面?”在 ASP 论坛上, 这个问题也是问得最多的问题之一。 遗憾的是,答案非常简单:我们无法禁用浏览器的后退按钮。 起先我对于居然有人想要禁用浏览器的后退按钮感到不可思议。后来,看到竟然有那 么多的人想要禁用这个后退按 钮,我也就释然(想要禁用的只有后退按钮,不包括浏览器的前进按钮) 。因为在默认情况 下,用户提交表单之后可以通过后退按钮返回表单页面(而不是使用“编辑”按钮! ) ,然后再 次编辑并提交表单向数据库插入新的记录。这是我们不愿看到的。 因此我就决定要找出避免出现这种情况的方法。我访问了许多网站,参考了这些网站 所介绍的各种实现方法。如果你经常访问 ASP 编程网站,本文所介绍的部分内容你可能已 经见到过。本文的任务是把各种可能的方法都介绍给大家,然后找出最好的方法! 二、禁止缓存 在我找到的许多方案中,其中有一种建议禁止页面缓存。具体是使用服务器端脚本, 如下所示: 代码如下:

1. 2. 3. 4. 5. 6. <% Response.Buffer = True Response.Expi resAbsolute = Now() - 1 Response.Expi res = 0 Response.Ca cheControl = "no-ca che" %>

这种方法非常有效!它强制浏览器重新访问服务器下载页面,而不是从缓存读取页面。 使用这种方法时, 编程者的主要任务是创建一个会话级的变量, 通过这个变量确定用户是否 仍旧可以查看那个不适合通过后退按钮访问的页面。 由于浏览器不再缓存这个页面, 当用户 点击后退按钮时浏览器将重新下载该页面, 此时程序就可以检查那个会话变量, 看看是否应 该允许用户打开这个页面。 例如,假设我们有如下表单: 代码如下:

1. 2. <% Response.Buffer = True

3. 4. 5. 6. 7. 8. 9.

Response.Expi resAbsolute = Now() - 1 Response.Expi res = 0 Response.Ca cheControl = "no-ca che" If Len(Session("Firs tTimeToPage")) > 0 then &single; 用户已经访问过当前页面,现在是再次返回访问。 &single; 清除会话变量,将用户重定向到登录页面。 Session("Fi rs tTi meToPage") = ""

10. Response.Redi rect "/Bar.asp" 11. Response.End 12. End If 13. &single; 如果程序运行到这里,说明用户能够查看当前页面 14. &single; 以下开始创建表单 15. %> 16.

我们借助会话变量 FirstTimeToPage 检查用户是否是第一次访问当前页面。如果不是 第一次(即 Session("FirstTimeToPage")包含某个值),那么我们就清除会话变量的值,然 后把用户重新定向到一个开始页面。 这样, 当表单提交时 (此时 SompePage.asp 被打开) , 我们必须赋予 FirstTimeToPage 一个值。 即, 在 SomePage.asp 中我们需要加上下面的代码:

1. Session("Fi rs tTi meToPage") = "NO"

这样,已经打开 SomePage.asp 的用户如果点击后退按钮,浏览器将重新请求服务器 下载页面,服务器检查到 Session("FirstTimeToPage")包含了一个值,于是就清除 Session(" FirstTimeToPage"),并把用户重定向到其他页面。当然,所有这一切都需要用户启用了 Co okie,否则会话变量将是无效的。(有关该问题的更多说明,请参见 For session variables to work, must the Web visitor have cookies enabled? ) 另外,我们也可以用客户端代码使浏览器不再缓存 Web 页面: 代码如下:

1. 2.

3. 4. 5. 6.

如果使用上面的方法强制浏览器不再缓存 Web 页面,必须注意以下几点: 1. 只有在使用安全连接时“Pragma: no-cache”才防止浏览器缓存页面。 对于不受安全保护的页 面,“Pragma: no-cache”被视为与“Expires: -1”相同,此时浏览器仍旧缓存页面,但把页面标 记为立即过期。 2. 在 IE 4 或 5 中,“Cache-Control”META HTTP-EQUIV 标记将被忽略,不起作用。 在实际应用中我们可以加上所有这些代码。然而,由于这种方法不能适用于所有的浏 览器,所以是不推荐使用的。但如果是在 Intranet 环境下,管理员可以控制用户使用哪种 浏览器,我想还是有人会使用这种方法。 三、其他方法 接下来我们要讨论的方法以后退按钮本身为中心,而不是浏览器缓存。这儿有一篇文 章 Rewiring the Back Button 很值得参考。不过我注意到,如果使用这种方法,虽然用户 点击一下后退按钮时他不会看到以前输入数据的页面, 但只要点击两次就可以, 这可不是我 们希望的效果,因为很多时候,固执的用户总是能够找到绕过预防措施的办法。 另外一种禁用后退按钮的办法是用客户端 JavaScript 打开一个没有工具条的窗口,这 使得用户很难返回前一页面,但 不是不可能。一种更安全但相当恼人的方法是,当表单提交时打开一个新的窗口,与此同时 关闭表单所在的窗口。但我觉 得这种方法不值得认真考虑,因为我们总不能让用户每提交一个表单就打开一个新窗口。 那么,在那个我们不想让用户返回的页面是否也可以加入 JavaScript 代码呢?在这个 页面中加入的 JavaScript 代码可用来产生点击前进按钮的效果, 这样也就抵消了用户点击后 退按钮所产生的动作。用于实现该功能的 JavaScript 代码如下所示: 代码如下:

1. 2. 3. 4. 5.

同样地,这种方法虽然有效,但距离“ 最好的方法”还差得很远。后来我又看到有人建 议用 location.replace 从一个页面转到另一个页面。这种方法的原理是,用新页面的 URL 替 换当前的历史纪录,这样浏览历史记录中就只有一个页面,后退按钮永远不会变为可用。我

想这可能正是许多人所寻求的方法, 但这种方法仍旧不是任何情况下的最好方法。 使用这种 方法的实例如下所示:

1. 禁 止后退到本页面的链接

这种方法的缺点在于:简单地运用 Response.Redirect 将不再有效,这是因为每次用 户从一个页面转到另一个页面, 我们都必须用客户端代码清除 location.history 。 另外还要注 意,这种方法清除的是最后一个访问历史记录,而不是全部的访问记录。 点击上面的链接,你将打开一个简单的 HTML 页面。再点击后退按钮,你可以看到这 时打开的不是本页面,而是本页面之前的页面!(当然,你必须在浏览器中启用了客户端 J avaScript 代码。) 经过一番仔细的寻寻觅觅之后,我发现仍旧无法找出真正能够完全禁用浏览器后退按 钮的办法。 所有这里介绍的方法都能够在不同程度上、 以不同的方式禁止用户返回前一页面, 但它们都有各自的局限。 由于不存在能够完全禁用后退按钮的方法, 所以最好的方案应该是: 混合运用客户端脚本和服务器端脚本。

如何抓取网页数据,以抓取安居客举例

如何抓取网页数据,以抓取安居客举例 互联网时代,网页上有丰富的数据资源。我们在工作项目、学习过程或者学术研究等情况下,往往需要大量数据的支持。那么,该如何抓取这些所需的网页数据呢? 对于有编程基础的同学而言,可以写个爬虫程序,抓取网页数据。对于没有编程基础的同学而言,可以选择一款合适的爬虫工具,来抓取网页数据。 高度增长的抓取网页数据需求,推动了爬虫工具这一市场的成型与繁荣。目前,市面上有诸多爬虫工具可供选择(八爪鱼、集搜客、火车头、神箭手、造数等)。每个爬虫工具功能、定位、适宜人群不尽相同,大家可按需选择。本文使用的是操作简单、功能强大的八爪鱼采集器。以下是一个使用八爪鱼抓取网页数据的完整示例。示例中采集的是安居客-深圳-新房-全部楼盘的数据。 采集网站:https://https://www.360docs.net/doc/4117403685.html,/loupan/all/p2/ 步骤1:创建采集任务 1)进入主界面,选择“自定义模式”

如何抓取网页数据,以抓取安居客举例图1 2)将要采集的网址复制粘贴到网站输入框中,点击“保存网址”

如何抓取网页数据,以抓取安居客举例图2 步骤2:创建翻页循环 1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。将页面下拉到底部,点击“下一页”按钮,在右侧的操作提示框中,选择“循环点击下一页”,以建立一个翻页循环

如何抓取网页数据,以抓取安居客举例图3 步骤3:创建列表循环并提取数据 1)移动鼠标,选中页面里的第一个楼盘信息区块。系统会识别此区块中的子元素,在操作提示框中,选择“选中子元素”

如何抓取网页数据,以抓取安居客举例图4 2)系统会自动识别出页面中的其他同类元素,在操作提示框中,选择“选中全部”,以建立一个列表循环

网页正文提取

我为开源做贡献,网页正文提取——Html2Article 2014-1-7 14:38|发布者: 红黑魂|查看: 16722|评论: 4|原作者: StanZhai|来自: 博客园 摘要: 为什么要做正文提取一般做舆情分析,都会涉及到网页正文内容提取。对于分析而言,有价值的信息是正文部分,大多数情况下,为了便于分析,需要将网页中和正文不相干的部分给剔除。可以说正文提取的好坏,直接影响了分 ... 为什么要做正文提取 一般做舆情分析,都会涉及到网页正文内容提取。对于分析而言,有价值的信息是正文部分,大多数情况下,为了便于分析,需要将网页中和正文不相干的部分给剔除。可以说正文提取的好坏,直接影响了分析结果的好坏。 对于特定的网站,我们可以分析其html结构,根据其结构来获取正文信息。先看一下下面这张图: 正文部分,不同的网站,正文所在的位置不同,并且Html的结构也不同,对于 爬虫而言,抓取的页面是各种各样的,不可能针对所有的页面去写抓取规则来提取正文内容,因此需要一种通用的算法将正文提取出来。

现有的网页正文提取算法 ?基于标签用途的正文提取算法(比如title或h1,h2标签一般用作标题,p一 般表示正文段落,根据标签的含义去提取正文) ?基于标签密度判定(这个简单,说白了就是字符统计,正文部分html标签的密度比较低,确定一个阈值,按照标签密度提取正文部分) ?基于数据挖掘思想的网页正文抽取方法(这里会涉及到统计学和概率论的一些知识,在高深点就成了机器学习了,没有深入研究) ?基于视觉网页块分析技术的正文抽取(CV这种高端大气上档次的东西,岂是 我等这么容易就能研究明白的。虽然实现上复杂,但就提取效果而言,这种方法提取的精度还是不错的) 前2中方法还是比较容易实现的,主要是处理简单,先前我把标签密度的提取算法实现了,但实际用起来错误率还是蛮高的;后2种方法在实现上就略复杂了,从算法效率上讲应该也高不了哪去。 我们需要的是一种简单易实现的,既能保证处理速度,提取的准确率也不错的算法。于是结合前两种算法,研究网页html页面结构,有了一种比较好的处理思 路,权且叫做基于文本密度的正文提取算法吧。后来从网上找了一下类似的算法,发现也有使用类似的处理方法来处理正文提取的,不过还是有些不同。接下来跟大家分享一下这个算法的一些处理思想。 网页分析 我任意取了百度,搜狐,网易的一篇新闻类网页,拿来作分析。 先看一篇百度的文章 任正非为什么主动与我合影,https://www.360docs.net/doc/4117403685.html,/article/2011 首先请求这个页面,然后过滤到所有的html标签,只保留文本信息,我们可以 看到正文信息集中在一下位置:

网页设计与制作试题(HTML基础)有答案

1.HTML 文件必须使用htm 或者(B)作为文件扩展名。 A.doc B. html C. jsp D. aspx 2.HTMl是指(A)。 A.超文本标签语言 B. 汇编语言 C. 服务端端语言 D.脚本语言 3.WWW是(B)的意思。 A.网页B.万维网C.浏览器D.超文本传输协议 4.在网页中显示特殊字符,如果要输入“<”,应使用(D)。 A.lt; B.≪ C.< D.< 5.以下说法中,错误的是:(D)。 A.获取WWW服务时,需要使用浏览器作为客户端程序。 B.WWW服务和电子邮件服务是Internet提供的最常用的两种服务。 C.网站就是一系列逻辑上可以视为一个整体的页面的集合。 D.所有网页的扩展名都是.htm。 6.以下说法中,错误的是:(B)。 A.网页的本质就是HTML源代码。 B.网页就是主页。 C.使用“记事本”编辑网页时,通常应将其保存为.htm 或.html 后缀。 D.本地网站通常就是一个完整的文件夹。 7.浏览网页时,通常使用以下协议:(C)。 A.mailto B.FTP C.HTTP D.TCP/IP 8.在网页中显示特殊字符,如果要输入空格,应使用(D)。 A.nbsp; B.&Nbsp; C. D. 9.以下软件中,不能直接用来编辑HTML 文件的是:(C)。 A.记事本B.FrontPage C.Flash D.Dreamweaver 10.以下有关HTML 标记符的属性的说法中,错误的是:(C)。 A.在HTML中,所有的属性都放置在开始标记符的尖括号里。 B.属性与HTML标记符的名称之间用空格分隔。 C.属性的值放在相应属性之后,用等号分隔;而不同的属性之间用分号分隔。 D.HTML 属性通常也不区分大小写。 二、填空题 1.如果要为网页指定黑色的背景颜色,应使用以下html语句:

。 2.上网浏览网页时,应使用_____浏览器____作为客户端程序。 3.TITLE 标记符应位于___head______标记符之间。 4.要设置网页在黑色背景下显示白色文字,应使用__语句。 5.要设置整个网页的背景颜色,应在body标记符中设置____bgcolor_____属性。 三、判断题 1.用H1标记符修饰的文字通常比用H6标记符修饰的要小。╳ 2.B标记符表示用粗体显示所包括的文字。√ 3.指定滚动字幕时,不允许其中嵌入图象。╳ 4.指定水平线粗细的属性是size。√ 5.指定水平线粗细的属性是width。╳HTML网页制作基础题试题与答案

HTML网页制作基础题 一、选择 1. 在一个框架的属性面板中,不能设置下面哪一项。( D )A.源文件B .边框颜色C.边框宽度D.滚动条 2. 下列哪一项表示的不是按钮。( C ) A.type="submit" B.type="reset" C.type="image" D .type="button" 3. 下面哪一个属性不是文本的标签属性?( A ) A.nbsp; B .align C .color D.face 4. 下面哪一项的电子邮件链接是正确的?( B ) A.https://www.360docs.net/doc/4117403685.html, B .xxx@.net C.xxx@com D .xxx@https://www.360docs.net/doc/4117403685.html, 5. 当链接指向下列哪一种文件时,不打开该文件,而是提供给浏览器下载。( C )A.ASP B.HTML C.ZIP D.CGI 6. 关于表格的描述正确的一项是。( D )A.在单元格内不能继续插入整个表格 B .可以同时选定不相邻的单元格C.粘贴表格时,不粘贴表格的内容 D .在网页中,水平方向可以并排多个独立的表格 7. 如果一个表格包括有 1 行4 列,表格的总宽度为“ 699”,间距为“ 5”,填充为“ 0”,边框为“ 3”,每列的宽度相同,那么应将单元格定制为多少像素宽。( D ) A.126 B.136 C.147 D.167 8. 关于文本对齐,源代码设置不正确的一项是:(A.居中对齐:

D. 10. 下列哪一项是在新窗口中打开网页文档。(B )A._self B ._blank C._top D._parent 11. 下面对JPEG格式描述不正确的一项是。( C ) A.照片、油画和一些细腻、讲求色彩浓淡的图片常采用JPEG格式 B.JPEG支持很高的压缩率,因此其图像的下载速度非常快C.最高只能以256 色显示的用户可能无法观看JPEG图像 D.采用JPEG格式对图片进行压缩后,还能再打开图片,然后对它重新整饰、编辑、压缩

网页数据抓取方法详解

https://www.360docs.net/doc/4117403685.html, 网页数据抓取方法详解 互联网时代,网络上有海量的信息,有时我们需要筛选找到我们需要的信息。很多朋友对于如何简单有效获取数据毫无头绪,今天给大家详解网页数据抓取方法,希望对大家有帮助。 八爪鱼是一款通用的网页数据采集器,可实现全网数据(网页、论坛、移动互联网、QQ空间、电话号码、邮箱、图片等信息)的自动采集。同时八爪鱼提供单机采集和云采集两种采集方式,另外针对不同的用户还有自定义采集和简易采集等主要采集模式可供选择。

https://www.360docs.net/doc/4117403685.html, 如果想要自动抓取数据呢,八爪鱼的自动采集就派上用场了。 定时采集是八爪鱼采集器为需要持续更新网站信息的用户提供的精确到分钟的,可以设定采集时间段的功能。在设置好正确的采集规则后,八爪鱼会根据设置的时间在云服务器启动采集任务进行数据的采集。定时采集的功能必须使用云采集的时候,才会进行数据的采集,单机采集是无法进行定时采集的。 定时云采集的设置有两种方法: 方法一:任务字段配置完毕后,点击‘选中全部’→‘采集以下数据’→‘保存并开始采集’,进入到“运行任务”界面,点击‘设置定时云采集’,弹出‘定时云采集’配置页面。

https://www.360docs.net/doc/4117403685.html, 第一、如果需要保存定时设置,在‘已保存的配置’输入框内输入名称,再保存配置,保存成功之后,下次如果其他任务需要同样的定时配置时可以选择这个配置。 第二、定时方式的设置有4种,可以根据自己的需求选择启动方式和启动时间。所有设置完成之后,如果需要启动定时云采集选择下方‘保存并启动’定时采集,然后点击确定即可。如果不需要启动只需点击下方‘保存’定时采集设置即可。

网页内容如何批量提取

https://www.360docs.net/doc/4117403685.html, 网页内容如何批量提取 网站上有许多优质的内容或者是文章,我们想批量采集下来慢慢研究,但内容太多,分布在不同的网站,这时如何才能高效、快速地把这些有价值的内容收集到一起呢? 本文向大家介绍一款网络数据采集工具【八爪鱼数据采集】,以【新浪博客】为例,教大家如何使用八爪鱼采集软件采集新浪博客文章内容的方法。 采集网站: https://www.360docs.net/doc/4117403685.html,/s/articlelist_1406314195_0_1.html 采集的内容包括:博客文章正文,标题,标签,分类,日期。 步骤1:创建新浪博客文章采集任务 1)进入主界面,选择“自定义采集”

https://www.360docs.net/doc/4117403685.html, 2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”

https://www.360docs.net/doc/4117403685.html, 步骤2:创建翻页循环

https://www.360docs.net/doc/4117403685.html, 1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。) 2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax加载数据”,超时时间设置为5秒,点击“确定”。

https://www.360docs.net/doc/4117403685.html, 步骤3:创建列表循环 1)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。 2)鼠标点击“循环点击每个链接”,列表循环就创建完成,并进入到第一个循环项的详情页面。

JAVA通过url获取网页内容

import java.io.*; import https://www.360docs.net/doc/4117403685.html,.URL; import https://www.360docs.net/doc/4117403685.html,.URLConnection; public class TestURL { public static void main(String[] args) throws IOException { test4(); test3(); test2(); test(); } /** * 获取URL指定的资源。 * * @throws IOException */ public static void test4() throws IOException { URL url = new URL("https://www.360docs.net/doc/4117403685.html,/attachment/200811/200811271227767778082.jpg"); //获得此URL 的内容。 Object obj = url.getContent(); System.out.println(obj.getClass().getName()); } /** * 获取URL指定的资源 * * @throws IOException */ public static void test3() throws IOException { URL url = new URL("https://www.360docs.net/doc/4117403685.html,/down/soft/45.htm"); //返回一个URLConnection 对象,它表示到URL 所引用的远程对象的连接。 URLConnection uc = url.openConnection(); //打开的连接读取的输入流。 InputStream in = uc.getInputStream(); int c; while ((c = in.read()) != -1) System.out.print(c); in.close(); } /** * 读取URL指定的网页内容

网页文字提取工具使用教程

https://www.360docs.net/doc/4117403685.html, 网页文字提取工具使用教程 如何从海量的网页里提取到我们想要的信息,对于不会编程序不会打代码来说,能有一款好用的网页提取工具真是最好不过了 今天就给大家介绍一款免费网页文字抓取器抓取本文介绍使用八爪鱼采集新浪博客文章的方法。 采集网站: https://www.360docs.net/doc/4117403685.html,/s/articlelist_1406314195_0_1.html 采集的内容包括:博客文章正文,标题,标签,分类,日期。 步骤1:创建新浪博客文章采集任务 1)进入主界面,选择“自定义采集”

https://www.360docs.net/doc/4117403685.html, 2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”

https://www.360docs.net/doc/4117403685.html, 步骤2:创建翻页循环 1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。)

https://www.360docs.net/doc/4117403685.html, 2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax 加载数据”,超时时间设置为5秒,点击“确定”。

https://www.360docs.net/doc/4117403685.html, 步骤3:创建列表循环 1)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。

https://www.360docs.net/doc/4117403685.html, 2)鼠标点击“循环点击每个链接”,列表循环就创建完成,并进入到第一个循环项的详情页面。

如何抓取网页数据

网页源码中规则数据的获取过程: 第一步:获取网页源码。 第二步:使用正则表达式匹配抽取所需要的数据。 第三步:将结果进行保存。 这里只介绍第一步。 https://www.360docs.net/doc/4117403685.html,.HttpWebRequest; https://www.360docs.net/doc/4117403685.html,.HttpWebResponse; System.IO.Stream; System.IO.StreamReader; System.IO.FileStream; 通过C#程序来获取访问页面的内容(网页源代码)并实现将内容保存到本机的文件中。 方法一是通过https://www.360docs.net/doc/4117403685.html,的两个关键的类 https://www.360docs.net/doc/4117403685.html,.HttpWebRequest; https://www.360docs.net/doc/4117403685.html,.HttpWebResponse; 来实现的。 具体代码如下 方案0:网上的代码,看明白这个就可以用方案一和方案二了 HttpWebRequest httpReq; HttpWebResponse httpResp; string strBuff = ""; char[] cbuffer = new char[256]; int byteRead = 0; string filename = @"c:\log.txt"; ///定义写入流操作 public void WriteStream() { Uri httpURL = new Uri(txtURL.Text); ///HttpWebRequest类继承于WebRequest,并没有自己的构造函数,需通过WebRequest 的Creat方法建立,并进行强制的类型转换 httpReq = (HttpWebRequest)WebRequest.Create(httpURL); ///通过HttpWebRequest的GetResponse()方法建立HttpWebResponse,强制类型转换 httpResp = (HttpWebResponse) httpReq.GetResponse(); ///GetResponseStream()方法获取HTTP响应的数据流,并尝试取得URL中所指定的网页内容///若成功取得网页的内容,则以System.IO.Stream形式返回,若失败则产生 ProtoclViolationException错误。在此正确的做法应将以下的代码放到一个try块中处理。这里简单处理 Stream respStream = httpResp.GetResponseStream(); ///返回的内容是Stream形式的,所以可以利用StreamReader类获取GetResponseStream的内容,并以StreamReader类的Read方法依次读取网页源程序代码每一行的内容,直至行尾(读取的编码格式:UTF8) StreamReader respStreamReader = new StreamReader(respStream,Encoding.UTF8); byteRead = respStreamReader.Read(cbuffer,0,256);

HTML基础试题

《HTML基础试题》 一、单项选择题: 1、下面哪一个属性不是文本的标签属性?() A. B.size C.color D.face 2、当链接指向下列哪一种文件时,不打开该文件,而是提供给浏览器下载。() A.ASP B.HTML C.ZIP D.CGI 3、关于文本水平对齐,源代码设置不正确的一项是:() A.居中对齐:

D. 5、下列哪一项是在新窗口中打开网页文档。() A._self B._blank C._top D._parent 6、下面对JPEG格式描述不正确的一项是。() A.照片、油画和一些细腻、讲求色彩浓淡的图片常采用JPEG格式 B.JPEG支持很高的压缩率,因此其图像的下载速度非常快 C.最高只能以256色显示的用户可能无法观看JPEG图像 D.采用JPEG格式对图片进行压缩后,还能再打开图片,然后对它重新整饰、编辑、压缩 7、常用的网页图像格式有____和_____( ) ,tiff B.tiff,jpg C.gif,jpg D.bmp,png 8、下面说法错误的是( ) 样式表可以将格式和结构分离 B.CSS样式表可以控制页面的布局 样式表可以使许多网页同时更新 D.CSS样式表不能制作体积更小下载更快的网页 9、CSS样式表不可能实现( )功能。 A将格式和结构分离 B.一个CSS文件控制多个网页 C.控制图片的精确位置 D.兼容所有的浏览器 10、在HTML中,( )不是链接的目标属性。 B.new C.blank D.top 11、在网页设计中,( )是所有页面中的重中之重,是一个网站的灵魂所在。 A.标题栏 B.脚本页面 C.导航栏 D.页面内容 12、为了标识一个HTML文件应该使用的HTML标记是( )。 A. B.

HTML基础设计教案

教案编写日期:20XX年11月20日授课时间:20XX年11月21日-25日授课班级:高二3-8班授课地点:高中微机教室 第六章HTML代码基础 §1.1 HTML语言 指导思想与理论依据:HTML语言基础广西科学技术出版社《信息技术高中第三册》第一单元第六章——“了解一点HTML”的入门知识,HTML语言是超文本标记语言的缩写(HyperTextMarkupLanguage) ,它是网页设计中应用最广泛的一种语言,也是网页制作中学生感到最头疼难学的一个内容。掌握html语言基础会让动态网页制作的学习事半功倍,因而本部分知识显得非常重要,因此在本节课程的教学中,结合新课标及教材的特点,采用多种教学法结合方式(启发式教学法、任务驱动法、演示法等等...),激发学生学习兴趣,尤其是注重对学生的引导,采用任务驱动方式教学,引导学生通过自主学习平台自主学习从而提高学生的学习效率,本节内容是在学生已经掌握了利用FRONTPAGE制作普通网页的基础上,对网页语言的深入学习。 学情背景分析: 本节之前,学生已经学习了如何利用FrontPage进行网页以及网站的制作,但是对于网页的认识还知识停留在页面的直观设计上,缺少对HTML代码的认识。本节课主要对学生讲述HTML的基本概念,为学生培养良好的代码结构意识打下基础。 在本节课程的教学中,结合新课改的理念,采用创设情境演示教学的方法,激发学生学习兴趣,采用任务驱动方式教学,引导学生通过自主学习平台自主学习从而提高学习效率。 教学目标 1、掌握HTML基本概念、格式,理解其与网页的关系; 2、掌握基本的HTML 标签的作用与用法; 过程与方法:通过对简单网页html代码的观察对和html语言的基本结构进行自我概括,掌握HTML文件的基本结构,能够明确HTML语言的结构和特点,并能在实验的过程中尝试自我修改。 情感态度价值观:本课主要锻炼学生分析能力,语言构成能力。在相应的实验中,还能提升学生自主探究、自我学习的能力。 教学重点:HTML标签的基本用法及其意义 教学难点:HTML主要标签属性的具体意义及使用 教学方法:任务驱动法(引导学生自主学习)、演示法(激发学生学习兴趣)、上机操作实习法(精讲多练)、联系对比法(化难为易,照葫芦画瓢) 教学媒体:教材、多媒体课件、电脑等

如何爬取网站数据

https://www.360docs.net/doc/4117403685.html, 如何爬取网站数据 在这信息爆炸的时代,互联网数据就像无底洞一样,有多少都可以装下去,并且这些网站数据大多是开放的。所有人均可通过网络来爬取这些网站数据,网页上能看到的数据,99%都是可以抓取的,所见即所得,今天我们使用八爪鱼采集器来演示如何去爬取网站数据。 采集网站: https://https://www.360docs.net/doc/4117403685.html,/ch/news_hot/ 步骤1:创建采集任务 1)进入主界面选择,选择“自定义模式”

https://www.360docs.net/doc/4117403685.html, 网站数据抓取能抓取哪些数据图1 2)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址” 网站数据抓取能抓取哪些数据图2

https://www.360docs.net/doc/4117403685.html, 3)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的信息是这次演示要采集的内容 网站数据抓取能抓取哪些数据图3 步骤2:设置ajax页面加载时间 ●设置打开网页步骤的ajax滚动加载时间 ●找到翻页按钮,设置翻页循环 ●设置翻页步骤ajax下拉加载时间

https://www.360docs.net/doc/4117403685.html, 1)网页打开后,需要进行以下设置:打开流程图,点击“打开网页”步骤,在右侧的高级选项框中,勾选“页面加载完成向下滚动”,设置滚动次数,每次滚动间隔时间,一般设置2秒,这个页面的滚动方式,选择直接滚动到底部;最后点击确定 网站数据抓取能抓取哪些数据图4 注意:今日头条的网站属于瀑布流网站,没有翻页按钮,这里的滚动次数设置将影响采集的数据量

https://www.360docs.net/doc/4117403685.html, 网站数据抓取能抓取哪些数据图5 步骤3:采集新闻内容 创建数据提取列表 1)如图,移动鼠标选中评论列表的方框,右键点击,方框底色会变成绿色 然后点击“选中子元素”

用Excel自动获取网页数据

用Excel自动获取网页数据 利用Excle可以自动获取网页数据,譬如从网页中自动获取基金净值数据,取得所关注基金的净值,列出当日涨幅最高的基金。本文用简单的Web查询结合Excel公式的方法完成上述需求,当然也可以用VBA 编写功能更加丰富的自动查询网页数据工具。 一: 1.创建和编辑Web 查询 Excel2003 数据- 导入外部数据- 新建web 查询- 在“地址”栏输入URL 地址( 这里我选用的基金净值网址是:) - 转到- 选择表格中的箭头符号- 导入- 外部数据区域属性中可以选择打开工作簿时自动刷新 选择了打开工作簿时自动刷新选项后,每次打开文档便会自动从指定网页中获取数据。 Excel2007 数据- 自网站- 在“地址”栏输入URL 地址- 转到... 后面与excel2003 设置方法一致2. 列出所关注基金的净值 这一步就非常简单了,用vlookup 在更新的表格中查询所关注的基金净值显示在汇总页中3. 列出当日涨幅最高的基金 基金净值的涨幅数据在“ 基金净值” sheet 的K 列,用函数=MATCH(MAX(基金净 值!K:K),基金净值!K:K,0) 取得涨幅最大值所在的行。用函数= INDEX(基金净值!1:65536,汇总!H6,4) 取得涨幅最大值对应的单元格(基金名),其中“ 汇总!H6” 为计算得到的最大值所在的行。 二: 使用VB实现Excel自动获取外部数据 Excel表格生成和公式设置十分强大便利,是一个强有力的信息分析与处理工具。Visual Basic 是一套可视化、面向对象、事件驱动方式的结构化高级程序设计语言,正成为高效率的Windows应用程序开发工具。由于微软的努力,Visual Basic应用程序版可作为一种通用宏语言被所有微软可编程应用软件共享。 Excel面始之初带有表格处理类软件中功能最强的宏语言,通过单击“工具”菜单中的“宏”,

如何高效的抓取网页数据,以京东商品信息采集为例

https://www.360docs.net/doc/4117403685.html, 如何高效的抓取网页数据,以京东商品信息采集为例 哪些网页数据是可以被抓取的?99%直接可见的互联网公开数据都是可以抓取的。网页的结构和使用的技术不尽相同,反爬虫策略也有很多,常见的如AJAX、验证码等,在采集过程中需根据具体网页进行具体操作。可抓取的对象格式可以是文字、图片、音频、文件,文字一般比较简单,图片、音频等数据抓取难度相对大一些。 如何高效的抓取网页数据?用python 或其他语言写程序进行爬取,自然无可厚非。但如果从一个普通人(非程序员)来讲,写爬虫程序需要一定的积累和门槛,短时间内无法快速实现。对于没有编程基础的普通人来说,利用好的数据抓取工具,会让我们事半功倍。 八爪鱼浏览器,通过模仿人浏览网页的操作来完成数据抓取。过程完全可视化,上手相对容易,能实现99%网页的抓取,更有自动登录、验证码识别、IP代理、云采集等功能以应对网站的防采集措施。以下是一个使用八爪鱼抓取网页数据的完整示例,示例中以京东网为例。 采集网站: https://https://www.360docs.net/doc/4117403685.html,/list.html?cat=1713,3258,3304&page=1&sort=sort_totalsales15_ desc&trans=1&JL=4_2_0#J_main 步骤1:创建采集任务 1)进入主界面选择,选择自定义模式

https://www.360docs.net/doc/4117403685.html, 如何高效的抓取网页数据,以京东商品信息采集为例图1 2)将上面网址的网址复制粘贴到网站输入框中,点击“保存网址”

https://www.360docs.net/doc/4117403685.html, 如何高效的抓取网页数据,以京东商品信息采集为例图2 3)保存网址后,页面将在八爪鱼采集器中打开,红色方框中的图书数据是这次演示采集的信息 如何高效的抓取网页数据,以京东商品信息采集为例图3 步骤2:创建翻页循环 找到翻页按钮,设置翻页循环 1)将页面下拉到底部,找到下一页按钮,鼠标点击,在右侧操作提示框中,

HTML基础试题》

《H T M L基础试题》 一、单项选择题: 1、下面哪一个属性不是文本的标签属性?() A. B.size C.color D.face 2、当链接指向下列哪一种文件时,不打开该文件,而是提供给浏览器下载。 () A.ASP B.HTML C.ZIP D.CGI 3、关于文本水平对齐,源代码设置不正确的一项是:() A.居中对齐:

D. 5、下列哪一项是在新窗口中打开网页文档。() A._self B._blank C._top D._parent 6、下面对JPEG格式描述不正确的一项是。()

A.照片、油画和一些细腻、讲求色彩浓淡的图片常采用JPEG格式 B.JPEG支持很高的压缩率,因此其图像的下载速度非常快 C.最高只能以256色显示的用户可能无法观看JPEG图像 D.采用JPEG格式对图片进行压缩后,还能再打开图片,然后对它重新整饰、 编辑、压缩 7、常用的网页图像格式有____和_____( ) A.gif,tiff B.tiff,jpg C.gif,jpg D.bmp,png 8、下面说法错误的是( ) A.CSS样式表可以将格式和结构分离 B.CSS样式表可以控制页面的布局 C.CSS样式表可以使许多网页同时更新 D.CSS样式表不能制作体积更小下 载更快的网页 9、CSS样式表不可能实现( )功能。 A将格式和结构分离 B.一个CSS文件控制多个网页 C.控制图片的精确位置 D.兼容所有的浏览器 10、在HTML中,( )不是链接的目标属性。 A.self B.new C.blank D.top 11、在网页设计中,( )是所有页面中的重中之重,是一个网站的灵魂所在。 A.标题栏 B.脚本页面 C.导航栏 D.页面内容 12、为了标识一个HTML文件应该使用的HTML标记是( )。 A. B.

如何抓取网页文字

如何抓取网页文字 第一种情况,出现“ 版权所有、严禁复制!”。这是由于网页文件中被加入了如下代码( 破解方法(先选中目标,然后在目标上按下鼠标右键,此时会弹出提示窗口,这时不要松开右键,将鼠标指针移到提示窗口的“确定”按钮上,然后按下左键。现在松开鼠标左键,限制窗口被关闭了,再将鼠标移到目标上松开鼠标右键,弹出了鼠标右键菜单,限制取消了?第二种情况,出现“添加到收藏夹”的。破解方法如下: 在目标上点鼠标右键,出现添加到收藏夹的窗口,这时不要松开右键,也不要移动鼠标,而是使用键盘的TAB键,移动焦点到取消按钮上,按下空格键,这时窗口就消失了,松开右键后,我们熟悉的右键菜单又出现了。 第三种情况,超链接无法用鼠标右键弹出“在新窗口中打开”菜单的。这时用上面的两种方法无法破解,看看我这一招:在超链接上点鼠标右键,弹出窗口,这时不要松开右键,按键盘上的空格键,窗口消失了,这时松开右键,右键菜单又出现了,选择其中的“在新窗口中打开”就可以了。第四种情况,在浏览器中点击“查看”菜单上的“源文件”命令,这样就可以看到html源代码了。不过如果网页使用了框架,你就只能看到框架页面的代码,此方法就不灵了,我们还可以按Shift+F10或按动键盘上与右手边的Ctrl键紧挨着的那个

键,都可以轻松的破解上面这种对鼠标右键的屏蔽。 第五种情况,最近在某网页中又遇一新的屏蔽方法,使用上面这些破解方法无效。关键代码如下( 在屏蔽鼠标右键的页面中点右键,出现警告窗口,此时不要松开右键,用左手按键盘上的ALT+F4组合键,这时提示窗口就被我们关闭了,松开鼠标右键,还是没有反应?想当初这招可是“百发百中”的?现在居然也不管用了?它既然能用javascript限制我们使用鼠标右键,我们就应该能用javascript来破解它? 仔细看看上面的代码,关键是这句 (“document.oncontextmenu=stop”,如果我们能让其中的“stop”失效不就成功的破解了吗;让我们来试试,具体方法 是( 在浏览器地址栏中键入 “java_s:alert(document.oncontextmenu='')”,输入时不要输入双引号!,此时会弹出个对话框,点击“确定”按钮,然后再对着你的目标,图片或文字!点击鼠标右键就可以看到弹出菜单了?第六种情况,网页中的鼠标右键锁定是基 于javascript的基础实现的?以下有个很方便的方法就可以 破掉它?在网址中输入 (void(document.body.oncontextmenu=null) 按一下回 车键,页面没反应?但是你按一下右键,看看是不是可以打开了?1/3页同样的原理也可以破解掉页面的“防复制”,“防选取”等限制?韵率谴耄?br /> 选取

如何快速提取网页文字

https://www.360docs.net/doc/4117403685.html, 如何快速提取网页文字 我们在浏览网页时,有时候需要将网页上的一些文字内容复制下来,保存到本地电脑或者数据库中,手工复制粘贴费时费力,效率又低,这时我们可以借助网页文字采集器来轻松提取网页上可见的文字内容,甚至是那些被大面积的广告覆盖看不到的文字内容,网页文字采集器都可以帮你把想要的网页文字内容给提取出来,简单方便,又大大的提升了效率。 下面就为大家介绍一款免费好用的网页文字采集器来提取网页文字。本文以使用八爪鱼采集器采集新浪博客文章为例子,为大家详细讲解如何快速提取网页文字。 采集网站: https://www.360docs.net/doc/4117403685.html,/s/articlelist_1406314195_0_1.html 采集的内容包括:博客文章正文,标题,标签,分类,日期。 步骤1:创建新浪博客文章采集任务 1)进入主界面,选择“自定义采集”

https://www.360docs.net/doc/4117403685.html, 2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”

https://www.360docs.net/doc/4117403685.html, 步骤2:创建翻页循环 1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。)

https://www.360docs.net/doc/4117403685.html, 2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax 加载数据”,超时时间设置为5秒,点击“确定”。

https://www.360docs.net/doc/4117403685.html, 步骤3:创建列表循环 1)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。

网页设计基础知识(HTML基础)

第1 章网页设计基础知识 1.1 网站 网站(Web Site)是一个存放网络服务器上的完整信息的集合体。它包含一个或多个网页,这些网页以一定的方式链接在一起,成为一个整体,用来描述一组完整的信息或达到某种期望的宣传效果。有的网站内容众多,如新浪、搜狐等门户网站;有的网站只有几个页面,如个人网站。 1.2 网页 网页(Web Page)实际上是一个文件,网页里可以有文字、图像、声音及视频信息等。网页可以看成是一个单一体,是网站的一个元素。 平常我们所听说的“新浪”、“搜狐”、“网易”等,即是俗称的“网站”。而当我们访问这些网站的时候,最直接访问的就是“网页”了。这许许多多的网页则组成了整个站点,也就是网站。 1.3 首页 首页(Home page),它是一个单独的网页,和一般网页一样,可以存放各种信息,同时又是一个特殊的网页,作为整个网站的起始点和汇总点。例如,当浏览者输入搜狐网站地址“https://www.360docs.net/doc/4117403685.html,”后出现在第一个页面,即sohu网站的首页。 问题:首页和主页有区别吗? 通常网站为方便浏览者查找和分类浏览网站的信息,会将信息分类,并建立一个网页以放置网站信息的目录,即网站的主页。 并非所有的网站都将主页设置为首页,有的网站喜欢在首页放置一段进入动画,并将主页的链接放置在首页上,浏览者需要单击首页的链接进入主页。 1.4网页的表现形式 1.静态网页:客户端与服务器端不发生交互 访问者只能被动地浏览网站建设者提供的网页内容。其特点: 网页内容不会发生变化,除非网页设计者修改了网页的内容。不能实现和浏览网页的用户之间的交互。信息流向是单向的。

2.动态网页:客户端与服务器端要发生交互 动态网页是指浏览器可以和服务器数据库进行实时数据交流的交互网页,而不是加上了动画等效果的动感网页。动态网页技术的网站可以实现更多的功能,如用户注册、用户登录、搜索查询、用户管理、订单管理等。信息流向是双向的。 2.1 网站LOGO 1.通常网站为体现其特色与内涵,涉及并制作一个LOGO图像放置在网站的左上角或其他醒目的位置。 2.企业网站常常使用企业的标志或者注册商标。 3.一个设计优秀的LOGO可以给浏览者留下深刻的印象,为网站和企业形象宣传起到十分重要的作用。 2.2 导航条 导航条是网页的重要组成元素。设计的目的是将站点内的信息分类处理,然后放在网页中以帮助浏览者快速查找站内信息。 导航条的形式多种多样,包括文本导航条、图像导航条以及动画导航条等。 有些使用特殊技术(例如Flash、JavaScript、CSS)制作的导航条还可以具有下拉菜单的功能。 2.3 Banner Banner的中文意思是横幅。Banner的内容通常为网页中的广告。 在网页布局中,大部分网页将Banner放置在与导航条相邻处,或者其他醒目的位置以吸引浏览者浏览。 2.4 内容版块 网页的内容版块是整个页面的组成部分。 设计人员可以通过该页面的栏目要求来设计不同版块,每个版块可以有一个标题内容,并且每个内容版块主要来显示不同文本信息。 2.5 版尾或版权版块 版尾,即页面最低端的版块。 这部分位置通常放置网页的版权信息,以及网页所有者、设计者的联系方式等。 有的网站也将网站的友情链接以及一些附属的导航条放置在这里。

抓取网页数据工具json提取示例

抓取网页数据工具json提取示例 使用过最新版火车采集器V9的朋友应该都发现V9新增了json提取的功能,但是许多使用抓取网页数据工具的朋友在操作此功能的时候都会觉得有点弄不明白,这里特意为大家整理了json提取的教程示例,感兴趣的朋友可以仔细研究一下。 首先大家需要明白JSON 是有两种结构,简单的说json就是javascript中的对象和数组,所以这两种结构就是对象和数组两种,通过这两种结构可以表示各种复杂的结构。下面具体说明一下 1、对象:对象在js中表示为“{}”括起来的内容,数据结构为 {key:value,key:value,...}的键值对的结构,在面向对象的语言中,key为对象的属性,value为属性值,所以很容易理解,取值方法为对象key 获取属性值value,这个属性值的类型可以是数字、字符串、数组、对象几种。 2、数组:数组在js中是中括号“[]”括起来的内容,数据结构为["java","javascript","vb",...],取值方式和所有语言中一样,使用索引获取,字段值的类型可以是数字、字符串、数组、对象几种。 经过对象、数组2种结构就可以组合成复杂的数据结构了。如下: { "name": "中国", "province": [{ "name": "黑龙江", "cities": { "city": ["哈尔滨", "大庆"] } }, { "name": "广东", "cities": { "city": ["广州", "深圳", "珠海"] } }, { "name": "台湾", "cities": { "city": ["台北", "高雄"] } }, { "name": "新疆", "cities": { "city": ["乌鲁木齐"] } }] } 我们可以借助工具https://www.360docs.net/doc/4117403685.html,/codeformat/json测试是否是JSON,格式化后如图:

抓取网页数据工具的内容获取方式

抓取网页数据工具的内容获取方式 抓取网页数据的工具火车采集器在获取内容时,需要对数据内容的标签进行编辑定义,在火车采集器V9中对数据内容标签进行编辑定义,从而获取数据的方法有三类:A).从源码中获取数据B).生成固定格式的数据C).已有标签组合,下面分别讲解下具体的含义。 A).从源码中获取数据:可精确地设置标签的来源是从默认页的源码、返回头信息和网页地址中,或者是分页、循环分块、多页中。其源码提取的方式包括:前后截取、正则提取、正文提取、Xpath提取,JSON 提取五种,后面详细示范。 B).生成固定格式的数据:可生成固定的字符串、系统时间、随机字符串、随机数字、系统时间戳,随机抽取信息。 C).已有标签组合:可通过组合已有的标签,来生成新的标签内容。 其中最常用的是从源码中获取数据,其对应的五种获取方式的操作如下: A.a).前后截取 通过设置开始字符串和结束字符串,来获取中间的字符,可以在开始和结束字符串中设置通配符(*)。比如一段源代码为“