sift matlab

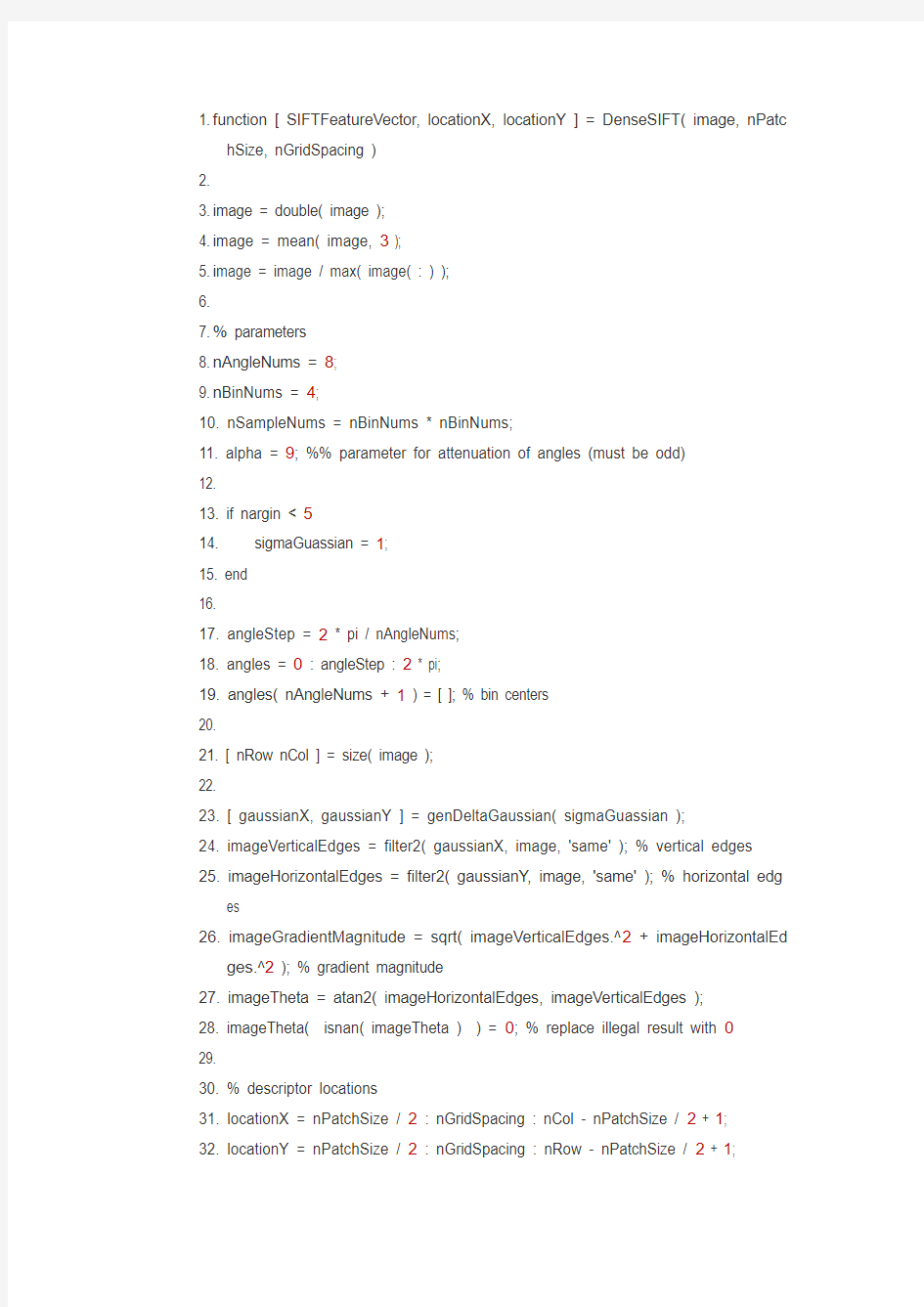

1. f unction [ SIFTFeatureVector, locationX, locationY ] = DenseSIFT( image, nPatc

hSize, nGridSpacing )

2.

3. i mage = double( image );

4. i mage = mean( image, 3 );

5. i mage = image / max( image( : ) );

6.

7. % parameters

8. n AngleNums = 8;

9. n BinNums = 4;

10. nSampleNums = nBinNums * nBinNums;

11. alpha = 9; %% parameter for attenuation of angles (must be odd)

12.

13. if nargin < 5

14. sigmaGuassian = 1;

15. end

16.

17. angleStep = 2 * pi / nAngleNums;

18. angles = 0 : angleStep : 2 * pi;

19. angles( nAngleNums + 1 ) = [ ]; % bin centers

20.

21. [ nRow nCol ] = size( image );

22.

23. [ gaussianX, gaussianY ] = genDeltaGaussian( sigmaGuassian );

24. imageVerticalEdges = filter2( gaussianX, image, 'same' ); % vertical edges

25. imageHorizontalEdges = filter2( gaussianY, image, 'same' ); % horizontal edg

es

26. imageGradientMagnitude = sqrt( imageVerticalEdges.^2 + imageHorizontalEd

ges.^2 ); % gradient magnitude

27. imageTheta = atan2( imageHorizontalEdges, imageVerticalEdges );

28. imageTheta( isnan( imageTheta ) ) = 0; % replace illegal result with 0

29.

30. % descriptor locations

31. locationX = nPatchSize / 2 : nGridSpacing : nCol - nPatchSize / 2 + 1;

32. locationY = nPatchSize / 2 : nGridSpacing : nRow - nPatchSize / 2 + 1;

33.

34. % make orientation images

35. imageOrientation = zeros( [ nRow, nCol, nAngleNums ], 'single' );

36.

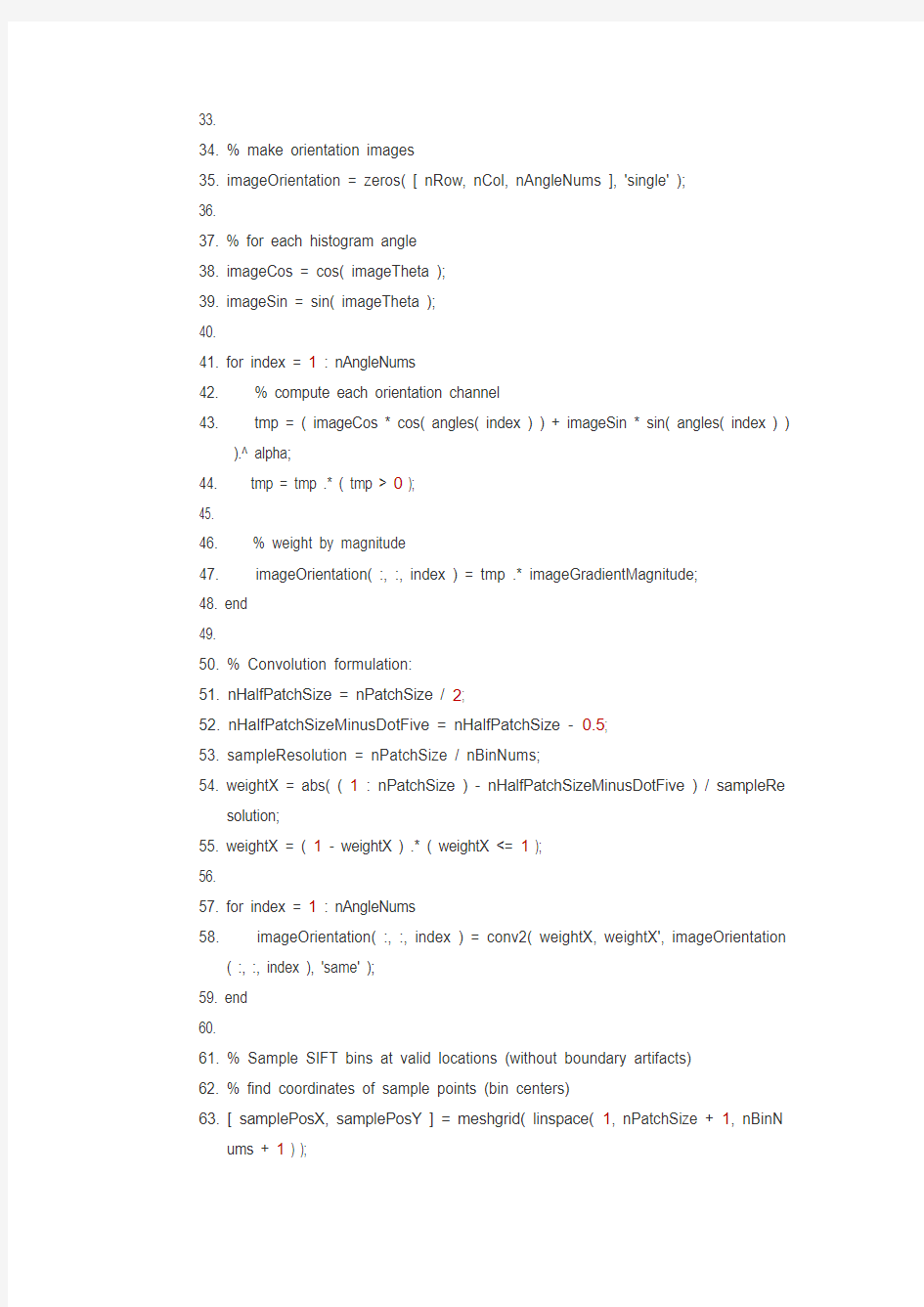

37. % for each histogram angle

38. imageCos = cos( imageTheta );

39. imageSin = sin( imageTheta );

40.

41. for index = 1 : nAngleNums

42. % compute each orientation channel

43. tmp = ( imageCos * cos( angles( index ) ) + imageSin * sin( angles( index ) )

).^ alpha;

44. tmp = tmp .* ( tmp > 0 );

45.

46. % weight by magnitude

47. imageOrientation( :, :, index ) = tmp .* imageGradientMagnitude;

48. end

49.

50. % Convolution formulation:

51. nHalfPatchSize = nPatchSize / 2;

52. nHalfPatchSizeMinusDotFive = nHalfPatchSize - 0.5;

53. sampleResolution = nPatchSize / nBinNums;

54. weightX = abs( ( 1 : nPatchSize ) - nHalfPatchSizeMinusDotFive ) / sampleRe

solution;

55. weightX = ( 1 - weightX ) .* ( weightX <= 1 );

56.

57. for index = 1 : nAngleNums

58. imageOrientation( :, :, index ) = conv2( weightX, weightX', imageOrientation

( :, :, index ), 'same' );

59. end

60.

61. % Sample SIFT bins at valid locations (without boundary artifacts)

62. % find coordinates of sample points (bin centers)

63. [ samplePosX, samplePosY ] = meshgrid( linspace( 1, nPatchSize + 1, nBinN

ums + 1 ) );

64. samplePosX = samplePosX( 1 : nBinNums, 1 : nBinNums ); samplePosX = sa

mplePosX( : ) - nPatchSize / 2;

65. samplePosY = samplePosY( 1 : nBinNums, 1 : nBinNums ); samplePosY = sa

mplePosY( : ) - nPatchSize / 2;

66.

67. SIFTFeatureVector = zeros( [ length( locationY ) length( locationX ) nAngleNu

ms * nSampleNums ] , 'single' );

68.

69. nOffset = 0;

70. for n = 1 : nBinNums * nBinNums

71. SIFTFeatureVector( :, :, nOffset + 1 : nOffset + nAngleNums ) = imageOrien

tation( locationY + samplePosY(n), locationX + samplePosX(n), : );

72. nOffset = nOffset + nAngleNums;

73. end

74.

75. clear imageOrientation

76.

77.

78. % Outputs:

79. [ locationX, locationY ] = meshgrid( locationX, locationY );

80. [ nrows, ncols, cols ] = size( SIFTFeatureVector );

81.

82. % normalize SIFT descriptors

83. SIFTFeatureVector = reshape( SIFTFeatureVector, [nrows * ncols nAngleNum

s * nSampleNums ] );

84. SIFTFeatureVector = SIFTNormalization( SIFTFeatureVector );

85. SIFTFeatureVector = reshape( SIFTFeatureVector, [ nrows ncols nAngleNum

s * nSampleNums] );

86.

87.

88. function [ GX, GY ] = genDeltaGaussian( sigma )

89.

90. % laplacian of size sigma

91.

92. G = genGaussian(sigma);

93. [ GX, GY ] = gradient( G );

94.

95. GX = GX * 2 ./ sum( sum( abs( GX ) ) );

96. GY = GY * 2 ./ sum( sum( abs( GY ) ) );

97.

98. function G = genGaussian( sigma )

99.

100. if all( size( sigma ) == [ 1, 1 ] )

101. % isotropic gaussian

102. filterWindow = 4 * ceil( sigma ) + 1;

103. G = fspecial( 'gaussian', filterWindow, sigma );

104. else

105. % anisotropic gaussian

106. filterWindowX = 2 * ceil( sigma( 1 ) ) + 1;

107. filterWindowY = 2 * ceil( sigma( 2 ) ) + 1;

108. GaussianX = normpdf( -filterWindowX: filterWindowX, 0, sigma( 1 ) ); 109. GaussianY = normpdf( -filterWindowY: filterWindowY, 0, sigma( 2 ) ); 110. G = GaussianY' * GaussianX;

111. end

112.

113. function SIFTFeatureVector = SIFTNormalization( SIFTFeatureVector ) 114. % normalize SIFT descriptors (after Lowe)

115.

116. % find indices of descriptors to be normalized (those whose norm is larger t han 1)

117. tmp = sqrt( sum( SIFTFeatureVector.^2, 2 ) );

118. normalizeIndex = find( tmp > 1 );

119.

120. SiftFeatureVectorNormed = SIFTFeatureVector( normalizeIndex, : ); 121. SiftFeatureVectorNormed = SiftFeatureVectorNormed ./ repmat( tmp( norm alizeIndex, : ), [ 1 size( SIFTFeatureVector, 2 ) ] );

122.

123. % suppress large gradients

124. SiftFeatureVectorNormed( SiftFeatureVectorNormed > 0.2 ) = 0.2;

125.

126. % finally, renormalize to unit length

127. tmp = sqrt( sum( SiftFeatureVectorNormed.^2, 2 ) );

128. SiftFeatureVectorNormed = SiftFeatureVectorNormed ./ repmat( tmp, [ 1 siz e( SIFTFeatureVector, 2 ) ] );

129.

130. SIFTFeatureVector( normalizeIndex, : ) = SiftFeatureVectorNormed;

图像三维重建技术

1概述 随着计算机软硬件技术的快速发展,大规模复杂场景的实时绘制已经成为可能,这也加快了虚拟现实技术的发展,又对模型的复杂度和真实感提出了新的要求。虚拟场景是虚拟现实系统的重要组成部分,它的逼真度将直接影响整个虚拟现实系统的沉浸感。客观世界在空间上是三维的,而现有的图像采集装置所获取的图像是二维的。尽管图像中含有某些形式的三维空间信息,但要真正在计算机中使用这些信息进行进一步的应用处理,就必须采用三维重建技术从二维图像中合理地提取并表达这些 三维信息。 三维建模工具虽然日益改进,但构建稍显复杂的三维模型依旧是一件非常耗时费力的工作。而很多要构建的三维模型都存在于现实世界中,因此三维扫描技术和基于图像建模技术就成了人们心目中理想的建模方式;又由于前者一般只能获取景物的几何信息,而后者为生成具有照片级真实感的合成图像提供了一种自然的方式,因此它迅速成为目前计算机图形学领域中的研究热点。 2三维建模技术 三维重建技术能够从二维图像出发构造具有真实感的三维图形,为进一步的场景变化和组合运算奠定基础,从而促进图像和三维图形技术在航天、造船、司法、考古、 工业测量、 电子商务等领域的深入广泛的应用。3基于图像的三维重建技术 基于图像的建模最近几年兴起的一门新技术,它使用直接拍摄到的图像,采用尽量少的交互操作,重建场 景。 它克服了传统的基于几何的建模技术的许多不足,有无比的优越性。传统的三维建模工具虽然日益改进,但构建稍显复杂的三维模型依旧是一件非常耗时费力的工作。考虑到我们要构建的很多三维模型都能在现实世界中找到或加以塑造,因此三维扫描技术和基于图像建模技术就成了人们心目中理想的建模方式;又由于前者一般只能获取景物的几何信息,而后者为生成具有照片级真实感的合成图像提供了一种自然的方式,因此它迅速成为目前计算机图形学领域中的研究热点。 4 基于图像重建几何模型的方法 4.1 基于侧影轮廓线重建几何模型 物体在图像上的侧影轮廓线是理解物体几何形状的 一条重要线索1当以透视投影的方式从多个视角观察某一空间物体时,在每个视角的画面上都会得到一条该物体的侧影轮廓线,这条侧影轮廓线和对应的透视投影中心共同确定了三维空间中一个一般形状的锥体1显然,该物体必将位于这个锥体之内;而所有这些空间锥体的交则构成了一个包含该物体的空间包络1这个空间包络被称为物体的可见外壳,当观察视角足够多时,可见外壳就可以被认为是该物体的一个合理的逼近。鉴于此类算法一般需要大量的多视角图像,因此图像的定标工作就变得非常复杂。 4.2采用立体视觉方法重建几何模型 基于立体视觉重建三维几何是计算机视觉领域中的经典问题,被广泛应用于自动导航装置。近年来,立体视觉 图像三维重建技术 康皓,王明倩,王莹莹 (装甲兵技术学院电子工程系,吉林长春130117) 摘要:基于图像的三维重建属于计算机视觉中的一个重要的研究方向,从提出到现在已有十多年的历史。文章首先对三维重建技术做了详细阐述,并着重从计算机图形学的研究角度对基于图像建模技术进行了综述,介绍了 具有代表性的基于图像建模的方法及其最新研究进展,给出了这些方法的基本原理, 并对这些方法进行分析比较,最后对基于图像建模技术的未来研究给出了一些建议和应解决的问题。关键词:三维建模技术;图像建模技术;计算机图形学;虚拟现实中图分类号:TP271文献标识码:A 文章编号1006-8937(2009)11-0042-02 Three-dimensional image reconstruction technique KANG Hao,WANG Ming-qian,WANG Ying-ying (DepartmentofElectronicEngineering,ArmoredInstituteofTechnology,Changchun,Jilin130117,China) Abstract:Image-based Three-dimensional reconstruction is an important research direction in computer vision ,from now more than ten years'history.This article first describes three-dimensional reconstruction technique in detail and review image-based modeling techniques from the perspective of computer graphics research,introduce a representative of the method of image-based modeling and the latest research progress,give the basic principles of these methods,analysis and compare these methods,finally,give a number of recommendations and problems which should be solved on image-based modeling technology for future research. Keywords:three-dimensional modeling techniques;image modeling techniques;computer graphics;virtual reality 收稿日期:2009-03-19 作者简介:康皓(1978-),女,吉林长春人,硕士研究生,讲师,研 究方向:计算机辅助设计与编程。 TECHNOLOGICAL DEVELOPMENT OF ENTERPRISE 2009年6月Jun.2009 企业技术开发 第28卷

三维重建综述

三维重建综述 三维重建方法大致分为两个部分1、基于结构光的(如杨宇师兄做的)2、基于图片的。这里主要对基于图片的三维重建的发展做一下总结。 基于图片的三维重建方法: 基于图片的三维重建方法又分为双目立体视觉;单目立体视觉。 A双目立体视觉: 这种方法使用两台摄像机从两个(通常是左右平行对齐的,也可以是上下竖直对齐的)视点观测同一物体,获取在物体不同视角下的感知图像,通过三角测量的方法将匹配点的视差信息转换为深度,一般的双目视觉方法都是利用对极几何将问题变换到欧式几何条件下,然后再使用三角测量的方法估计深度信息这种方法可以大致分为图像获取、摄像机标定、特征提取与匹配、摄像机校正、立体匹配和三维建模六个步骤。王涛的毕业论文就是做的这方面的工作。双目立体视觉法的优点是方法成熟,能够稳定地获得较好的重建效果,实际应用情况优于其他基于视觉的三维重建方法,也逐渐出现在一部分商业化产品上;不足的是运算量仍然偏大,而且在基线距离较大的情况下重建效果明显降低。 代表文章:AKIMOIO T Automatic creation of3D facial models1993 CHEN C L Visual binocular vison systems to solid model reconstruction 2007 B基于单目视觉的三维重建方法: 单目视觉方法是指使用一台摄像机进行三维重建的方法所使用的图像可以是单视点的单幅或多幅图像,也可以是多视点的多幅图像前者主要通过图像的二维特征推导出深度信息,这些二维特征包括明暗度、纹理、焦点、轮廓等,因此也被统称为恢复形状法(shape from X) 1、明暗度(shape from shading SFS) 通过分析图像中的明暗度信息,运用反射光照模型,恢复出物体表面法向量信息进行三维重建。SFS方法还要基于三个假设a、反射模型为朗伯特模型,即从各个角度观察,同一点的明暗度都相同的;b、光源为无限远处点光源;c、成像关系为正交投影。 提出:Horn shape from shading:a method for obtaining the shape of a smooth opaque object from one view1970(该篇文章被引用了376次) 发展:Vogel2008年提出了非朗伯特的SFS模型。 优势:可以从单幅图片中恢复出较精确的三维模型。 缺点:重建单纯依赖数学运算,由于对光照条件要求比较苛刻,需要精确知道光源的位置及方向等信息,使得明暗度法很难应用在室外场景等光线情况复杂的三维重建上。 2、光度立体视觉(photometric stereo) 该方法通过多个不共线的光源获得物体的多幅图像,再将不同图像的亮度方程联立,求解出物体表面法向量的方向,最终实现物体形状的恢复。 提出:Woodham对SFS进行改进(1980年):photometric method for determining surface orientation from multiple images(该文章被引用了891次) 发展:Noakes:非线性与噪声减除2003年; Horocitz:梯度场合控制点2004年; Tang:可信度传递与马尔科夫随机场2005年; Basri:光源条件未知情况下的三维重建2007年; Sun:非朗伯特2007年; Hernandez:彩色光线进行重建方法2007年;

医学图像三维重建的体绘制技术综述

医学图像三维重建的体绘制技术综述 摘要:体绘制技术是目前医学图像三维重建的主要方法之一,是一种能够准确反映出数据内部信息的可视化技术,是可视化研究领域的一个重要分支,是目前最活跃的可视化技术之一。本文首先分析了医学图像三维重建的两大方法及其基本思想,并将体绘制技术与面绘制技术进行了比较;然后分别描述了射线投射法、足迹法、剪切-曲变法、基于硬件的3D纹理映射、频域体绘制法以及基于小波的体绘制等典型算法;最后通过比较分析给出了各类算法的性能评价,并在此基础上展望了体绘制技术研究的发展前景。 关键字:体绘制;三维重建;可视化;性能评价 Abstract:Volume rendering techniques is one of the main methods of 3D reconstruction of medical images currently. It's also an important branch of visual technology which can reflect the inside information of data.It is one of the most active visualization technology.This paper first introduces are the two methods of 3D reconstruction of medical image and the basic thought of them,then volume rendering technology and surface rendering technology are compared.Secondly,the author introduces some kinds of algorithm for volume rendering:Ray Casting ,Splatting,Shear-Warp,3D Texture-Mapping Hardware,Frequency Domin V olume Rendering,Wavelet .Based V olume Rendering.The differences of their performances are compared and discussed in the last. Then some results are presented and their perspective are given in the end. Key words:Volume rendering techniques;3D reconstruction of medical images;visual technology;Performance evaluation

SIFT算法实现及代码详解

经典算法SIFT实现即代码解释: 以下便是sift源码库编译后的效果图:

为了给有兴趣实现sift算法的朋友提供个参考,特整理此文如下。要了解什么是sift算法,请参考:九、图像特征提取与匹配之SIFT算法。ok,咱们下面,就来利用Rob Hess维护的sift 库来实现sift算法: 首先,请下载Rob Hess维护的sift 库: https://www.360docs.net/doc/4318372228.html,/hess/code/sift/ 下载Rob Hess的这个压缩包后,如果直接解压缩,直接编译,那么会出现下面的错误提示: 编译提示:error C1083: Cannot open include file: 'cxcore.h': No such file or directory,找不到这个头文件。 这个错误,是因为你还没有安装opencv,因为:cxcore.h和cv.h是开源的OPEN CV头文件,不是VC++的默认安装文件,所以你还得下载OpenCV并进行安装。然后,可以在OpenCV文件夹下找到你所需要的头文件了。 据网友称,截止2010年4月4日,还没有在VC6.0下成功使用opencv2.0的案例。所以,如果你是VC6.0的用户请下载opencv1.0版本。vs的话,opencv2.0,1.0任意下载。 以下,咱们就以vc6.0为平台举例,下载并安装opencv1.0版本、gsl等。当然,你也可以用vs编译,同样下载opencv(具体版本不受限制)、gsl等。 请按以下步骤操作: 一、下载opencv1.0 https://www.360docs.net/doc/4318372228.html,/projects/opencvlibrary/files/opencv-win/1.0/OpenCV_1.0.exe

SIFT算法原理

3.1.1尺度空间极值检测 尺度空间理论最早出现于计算机视觉领域,当时其目的是模拟图像数据的多尺度特征。随后Koendetink 利用扩散方程来描述尺度空间滤波过程,并由此证明高斯核是实现尺度变换的唯一变换核。Lindeberg ,Babaud 等人通过不同的推导进一步证明高斯核是唯一的线性核。因此,尺度空间理论的主要思想是利用高斯核对原始图像进行尺度变换,获得图像多尺度下的尺度空间表示序列,对这些序列进行尺度空间特征提取。二维高斯函数定义如下: 222()/221 (,,)2x y G x y e σσπσ-+= (5) 一幅二维图像,在不同尺度下的尺度空间表示可由图像与高斯核卷积得到: (,,(,,)*(,)L x y G x y I x y σσ)= (6) 其中(x,y )为图像点的像素坐标,I(x,y )为图像数据, L 代表了图像的尺度空间。σ称为尺度空间因子,它也是高斯正态分布的方差,其反映了图像被平滑的程度,其值越小表征图像被平滑程度越小,相应尺度越小。大尺度对应于图像的概貌特征,小尺度对应于图像的细节特征。因此,选择合适的尺度因子平滑是建立尺度空间的关键。 在这一步里面,主要是建立高斯金字塔和DOG(Difference of Gaussian)金字塔,然后在DOG 金字塔里面进行极值检测,以初步确定特征点的位置和所在尺度。 (1)建立高斯金字塔 为了得到在不同尺度空间下的稳定特征点,将图像(,)I x y 与不同尺度因子下的高斯核(,,)G x y σ进行卷积操作,构成高斯金字塔。 高斯金字塔有o 阶,一般选择4阶,每一阶有s 层尺度图像,s 一般选择5层。在高斯金字塔的构成中要注意,第1阶的第l 层是放大2倍的原始图像,其目的是为了得到更多的特征点;在同一阶中相邻两层的尺度因子比例系数是k ,则第1阶第2层的尺度因子是k σ,然后其它层以此类推则可;第2阶的第l 层由第一阶的中间层尺度图像进行子抽样获得,其尺度因子是2k σ,然后第2阶的第2层的尺度因子是第1层的k 倍即3 k σ。第3阶的第1层由第2阶的中间层尺度图像进行子抽样获得。其它阶的构成以此类推。 (2)建立DOG 金字塔 DOG 即相邻两尺度空间函数之差,用(,,)D x y σ来表示,如公式(3)所示: (,,)((,,)(,,))*(,)(,,)(,,)D x y G x y k G x y I x y L x y k L x y σσσσσ=-=- (7) DOG 金字塔通过高斯金字塔中相邻尺度空间函数相减即可,如图1所示。在图中,DOG 金字塔的第l 层的尺度因子与高斯金字塔的第l 层是一致的,其它阶也一样。

SAR三维立体重建实验报告要点

SAR立体三维重建 姓名: ******* 学号: ********* 班级: ************* 指导教师: ******

1实验目的 1、理解基于合成孔径雷达立体像对的灰度信息进行三维重建的基本原理与方法; 2、了解ERDAS IMAGINE的基本功能,熟练掌握StereoSAR模块的使用方法; 3、理解SAR传感器几何模型及基于地面控制点(Ground Control Points, GCPs)几何模型精化的原理与方法; 4、通过真实SAR像对的数据处理,掌握SAR立体三维重建的基本流程。 2实验数据说明 本实验采用ERDAS IMAGINE软件的示例数据,RADASAT影像StereoSAR_Ref.img和StereoSAR_Match.img,这两景影像分别拍摄于1996年9月24日和1996年9月17日。 3实验原理 经过试验九的操作,使我们对InSAR提取测区DEM有了一定的掌握。而摄影测量中我们也学习了基于立体像对制作测区三维景观图,因此在此次实验中我们利用摄影测量的原理基于SAR影像进行三维重建。 3.1 SAR立体图像的获取 立体图像在摄影测量中称为立体相对。所谓立体相对是由不同摄站摄取的具有一定重叠的两张相片。因此雷达立体图像也可以定义为:由天线位置探测获取的具有一定影像重叠的两幅雷达图像[1]。 雷达立体图像的获取方式有两种:同侧立体观测和异侧立体观测。前者是指飞行器沿着不同的航线飞行(两次飞行方向可以相同或者相反),雷达从地物的

一侧对同一地区成像,同侧立体观测有可分为同一高度和不同高度两类;异侧立体观测是指雷达从地物的两侧分别对同一地区成像。 图 3.1-1 雷达立体图像获取方式 异侧立体观测获取的雷达立体图像视差明显,基高比(摄影基线与航高之比)大,有利于提高地物目标点高程的测量精度。但是地形起伏较大的地区,目标地物在立体像对的两幅图像上的相应影像不仅颜色差异很大,而且由于地形起伏引起的几何变形差异也很大。因为高出地面地物目标的左侧向着左航线的雷达天线,有效反射面积大,影像为浅色调;而对于右航线,该地物目标左侧反射信号弱或者为盲区,所以影像为深色调。同理,地物目标右侧在两幅图像上的色调与地物目标左侧色调刚好相反,由于异侧飞行所获取的雷达立体图像,使一幅图像上的阴影位于地物目标的一侧,而另一幅图像上的阴影在地物目标的另一侧,这就给立体观察与测量带来了极大的困难。另外,采用斜距显示的雷达图像由于地形起伏的影响,同一地物目标在立体像对的两幅图像上的变形差异也很大。因此,异侧(对侧)获取的雷达立体图像,只适于平坦或丘陵而不适合山地的立体观察与测量[2]。 同侧同高度或者不同高度获取的雷达立体图像,视差和基高比虽然比异侧获取的雷达立体图像要小,但两幅图像上相应影像的色调和图像变形差异较小,只要对雷达工作参数进行适当选择,还是能获得较好的立体效应的,故在丘陵地、山地一般都采用同侧获取雷达立体图像进行地物目标的三维定位和立体测图[2]。 3.2 SAR立体图像的视差 SAR立体图像的视差指高出某一基准面的地物目标在两幅图像上的位移差。摄影测量中称之为立体像对的左右视差,是地物目标点高差的反应,由左右视差

数字化重建三维模型技术规范-

工厂数字化重建三维模型技术规范 南京恩吉尔工程发展研究中心 2014

目录 1 目标 (3) 2 范围 (3) 3 规范性引用文件 (3) 4 定义 (3) 4.1 建模对象 (3) 4.2 建模分类 (3) 4.3 建模区域 (3) 4.4 建模精度 (3) 5 建模范围 (4) 5.1 三维模型的建模范围 (4) 5.2 建模的功能分类与应用 (5) 6 建模精度要求 (6) 6.1 精度等级 (6) 6.2 专业建模描述 (7) 6.3 功能性建模 (8) 7 建模对象属性要求 (9) 7.1 一般对象属性 (9) 7.2 功能与属性的对照 (11) 8 装备拆解建模与建筑建模 (11) 8.1 装备建模 (11) 8.2 建筑建模 (12) 9 工厂信息采集及文档 (12) 9.1 建模文档及信息收集 (12) 9.2 三维扫描及场景照片 (13) 9.3 现场测绘及草图 (13) 9.4 工程变更信息收集 (13) 10 建模审查与交付 (14) 10.1 建模的中间审查 (14) 10.2 建模的终审与数字化交付 (14) 11 附件:资料收集一览表 (14)

1目标 工厂数模重建主要面向工厂的实际运营和维护需求的数字化,不同于三维工厂设计及建造建模,主要面向工厂建设和制造。而现代的数字化设计建造产生的数字化交付成果,可以通过迁移转换重用,还需要通过数字化的重建,补充大量的后续工厂数模信息,满足工程运维的数字化需求和大工厂物联网的大数据建设需求。 本规范适用于企业已建工厂的数字化重建工作。定义数字化三维模型重建工作中的建模类型、范围、编码规则、建模精度及模型属性等方面的要求和规则。 2范围 三维的数字化建模主要包括工厂的主装置区、辅助装置区、公用工程区、厂前区;以工厂的专属的站场、码头、管网、办公楼及辅助设施等。 3规范性引用文件 下列文件对于建模及信息收集应用是必不可少的。 ISO 15926(GB/T 18975)《工业自动化系统与集成及流程工厂(包括石油和天然气生产设施)生命周期数据集成》 GB/T 28170《计算机图形和图像处理可扩展三维组件》 HG/T 20519-2009《化工工艺施工图内容和深度统一规定》 4定义 4.1建模对象 指流程工厂模型的基本单元,如设备、管子、管件、结构、建筑、门、窗等。一个模型对象具有四类关键信息:唯一标识、几何属性、工程属性、拓扑关系(与其他模型对象间)。 4.2建模分类 三维工厂重建分为功能性建模和一般建模。 功能性建模:配合运维的管理功能要求,建立的符合一定功能需求的全息数模; 一般性建模:主要用于辅助管理功能要求的虚拟环境(如模型参考、信息索引、标识)的数模建模。 4.3建模区域 指按一定标准将工厂进行划分所得的空间分区(如装置区、功能区),区域间不可重叠。一般将以工程初始设计中的区域定义为准则。 4.4建模精度 建模精度按照一定的功能性需求分为:粗模、精模、全息模。分别在模型的尺寸及

基于虚拟现实的三维重建复原技术

基于虚拟现实的三维重建复原技术 产品简介 基于虚拟现实的三维重建复原技术, 集成了三维360度全景照相技术、三维虚拟现实动态仿真技术(增强现实技术)为一体,北京金视和科技股份有限公司致力于VR技术在各行业的研发,结合实际情况,并联合相关的高校专家共同研发制成,完全满足现在公安系统里现场全景照相、全景三维测量、三维重建、模拟、和分析的应用。基于虚拟现实的三维重建复原技术生成高度逼真的三维场景图片和动画片,把这些全景图片、三维场景、动画片和声音、文字结合,为侦查、技术、指挥人员生成各种三维虚拟案件现场场景的多媒体影音和影像材料。对这些数字化多媒体信息进行分析、演示,并可以在网络服务器上发布、保存、修改案例,其他用户可以通过网络服务器进行查询、观看案例。为案件的侦破、记录、汇报、存档查询,都提供了便利的直观方便。 产品特点 全自动拍照 刑侦人员将设备架好后,无需人工调整角度,挪动设备。特制照相设备自动将现场记录到设备里。 照片拼接 具备多照片全自动智能拼接功能,对白墙、同色区域等单张照片边缘特征不明显的情况也可准确全自动拼接,无需手动拼接;平均一组全景拼接≤30秒;具备100组及以上批量照片全自动、快速拼接功能,批量拼接无需编程或设置(平均一组图像拼接≤50秒);具备处理超大、超高清晰度图像的全景合成能力(能够拼接图像尺寸≥20000*10000像素的全景图)。 全景图预览 可以生成多种格式的三维全景图(html、flash、mov、exe等),可自动可视化生成雷达导航效果,使雷达与全景方向同步;可以生成exe可执行文件,跨平台播放;可以全满屏观看全景图,现场细目、导航栏、工具栏、现场地图等均可自由隐藏、显现。 全景图热点编辑 可在全景图中快速方便的添加热点,热点可添加文字标注、并具备超链接常见格式的图片(bmp、jpg、tiff)、视频(avi、mpg、wmv、mp4)、音频(mp3、wma)、动画、其他文档等功能;具备鼠标拖动、释放即实现热点链接功能,自动对热点进行分类,自动为热点添加三态图标。 全景图转换编辑 全景图自动生成平面示意图;全景图内可以任意截取照片。 全景测量 具备真正的空间三维测量功能,可测量全景图内任意两点间的空间距离,误差符合工程误差标准;三维测量时,被测物体无需地面有投影,无需预先构建图形;测量过程无条件限制。

SIFT 特征提取算法详解

SIFT 特征提取算法总结 主要步骤 1)、尺度空间的生成; 2)、检测尺度空间极值点; 3)、精确定位极值点; 4)、为每个关键点指定方向参数; 5)、关键点描述子的生成。 L(x,y,σ), σ= 1.6 a good tradeoff

D(x,y,σ), σ= 1.6 a good tradeoff

关于尺度空间的理解说明:图中的2是必须的,尺度空间是连续的。在 Lowe 的论文中, 将第0层的初始尺度定为1.6,图片的初始尺度定为0.5. 在检测极值点前对原始图像的高斯平滑以致图像丢失高频信息,所以Lowe 建议在建立尺度空间前首先对原始图像长宽扩展一倍,以保留原始图像信息,增加特征点数量。尺度越大图像越模糊。 next octave 是由first octave 降采样得到(如2) , 尺度空间的所有取值,s为每组层数,一般为3~5 在DOG尺度空间下的极值点 同一组中的相邻尺度(由于k的取值关系,肯定是上下层)之间进行寻找

在极值比较的过程中,每一组图像的首末两层是无法进行极值比较的,为了满足尺度 变化的连续性,我们在每一组图像的顶层继续用高斯模糊生成了 3 幅图像, 高斯金字塔有每组S+3层图像。DOG金字塔每组有S+2层图像.

If ratio > (r+1)2/(r), throw it out (SIFT uses r=10) 表示DOG金字塔中某一尺度的图像x方向求导两次 通过拟和三维二次函数以精确确定关键点的位置和尺度(达到亚像素精度)?

直方图中的峰值就是主方向,其他的达到最大值80%的方向可作为辅助方向 Identify peak and assign orientation and sum of magnitude to key point The user may choose a threshold to exclude key points based on their assigned sum of magnitudes. 利用关键点邻域像素的梯度方向分布特性为每个关键点指定方向参数,使算子具备 旋转不变性。以关键点为中心的邻域窗口内采样,并用直方图统计邻域像素的梯度 方向。梯度直方图的范围是0~360度,其中每10度一个柱,总共36个柱。随着距中心点越远的领域其对直方图的贡献也响应减小.Lowe论文中还提到要使用高斯函 数对直方图进行平滑,减少突变的影响。

机器视觉—三维重建技术简介

三维重建技术简介 一、视觉理论框架 1982年,Marr立足于计算机科学,首次从信息处理的角度系统的概括了心理生理学、神经生理学等方面已经取得的重要成果,提出了一个迄今为止比较理想的视觉理论框架。尽管Marr提出的这个视觉理论框架仍然有可以进行改进和完善的瑕疵,但是在近些年,人们认为,计算机视觉这门学科的形成和发展和该框架密不可分。 第一方面,视觉系统研究的三个层次。 Marr认为,视觉是一个信息处理系统,对此系统研究应分为三个层次:计算理论层次,表示与算法层次,硬件实现层次,如下图所示: 计算机理论层次是在研究视觉系统时首先要进行研究的一层。在计算机理论层次,要求研究者回答系统每个部分的计算目的与计算策略,即视觉系统的输入和输出是什么,如何由系统的输入求出系统的输出。在这个层次上,将会建立输入信息和输出信息的一个映射关系,比如,系统输入是二维灰度图像,输出则是灰度图像场景中物体的三维信息。视觉系统的任务就是研究如何建立输入输出之间的关系和约束,如何由二维灰度图像恢复物体的三维信息。 在表示与算法层次,要给出第一层中提到的各部分的输入信息、输出信息和内部信息的表达,还要给出实现计算理论所对应的功能的算法。对于同样的输入,如果计算理论不同,可能会产生不同的输出结果。 最后一个层次是硬件实现层次。在该层次,要解决的主要问题就是将表示与算法层次所提出的算法用硬件进行实现。 第二方面,视觉信息处理的三个阶段。 Marr认为,视觉过程分为三个阶段,如表所示:

第一阶段,也称为早期阶段,该阶段是求取基元图的阶段,该阶段对原始图像进行处理,提取出那些能够描述图像大致三维形状二维特征,这些特征的集合构成所构成的就是基元图(primary sketch)"。 第二阶段也称中期阶段,是对环境的2.5维描述,这个阶段以观察者或者摄像机为中心,用基元图还原场景的深度信息,法线方向(或一说物体表面方向)等,但是在该阶段并没有对物体进行真正的三维恢复,因此称为2.5维。 第三阶段也称为后期阶段,在一个固定的坐标系下对2.5维图进行变换,最终构造出场景或物体的三维模型。 二、三维重建技术现状 目前三维重建的方法大致可分为三类,即:用建模软件构造的方式,多幅二维图像匹配重建的方式以及三维扫描重建的方式。 对于第一种方式,目前使用比较广泛的是3D Max, Maya, Auto Cad以及MultiGen-Creator等软件。这些三维建模软件,一般都是利用软件提供的一些基本几何模型进行布尔操作或者平移旋转缩放等操作,来创建比较复杂的三维模型。这样所构建出来的模型,比较美观,而且大小比例等非常精确。然而,这需要建模者精确知道三维场景的尺寸、物体位置等信息,如果没有这些信息,就无法建立精准的模型。 第二种方式是利用实时拍摄的图像或者视频恢复场景的三维信息。这种方式是基于双目立体视觉,对同一物体拍摄不同角度的图像,对这些图像进行立体匹

三维血管的重建

血管的三维重建 摘要 对于血管的三维重建,本文研究了血管这一类特殊管道的中轴线及其半径的算法,绘制中轴线在XY 、YZ 、ZX 平面的投影图这些问题,问题分为三部分。 针对第一部分,先将100张切片图片在MATLAB 中导出生成0-1矩阵数据,在计算100张切片的最大内切圆半径及对应圆心坐标,为减小误差求100张切片最大内切圆的平均半径41666.29 d 。中轴线的曲线方程可在MATLAB 中拟合得到。 针对第二部分,得到中轴线曲线方程在MATLAB 中绘制出中轴线方程的空间曲线,之后将其投影在XY 、YZ 、ZX 平面上。 针对第三部分,对100张切片进行叠加重合,得到血管的三维立体图,再通过MATLAB 对血管的三维立体图进行优化完成血管的三维重建。 关键词:MATLAB 软件 管道半径中轴线曲线方程

一、问题重述 1.1基本情况 断面可用于了解生物组织、器官等的形态。如果用切片机连续不断地将样本切成数十、成百的平行切片,可依次逐片观察。根据拍照并采样得到的平行切片数字图象,运用计算机可重建组织、器官等准确的三维形态。 1.2相关信息 假设某些血管可视为一类特殊的管道,该管道的表面是由球心沿着某一曲线(称为中轴线)的球滚动包络而成。 现有某管道的相继100张平行切片图象,记录了管道与切片的交。图象文件名依次为0.bmp、1.bmp、…、99.bmp,格式均为BMP,宽、高均为512个象素(pixel)。 取坐标系的Z轴垂直于切片,第1张切片为平面Z=0,第100张切片为平面Z=99。Z=z切片图象中象素的坐标依它们在文件中出现的前后次序为(-256,-256,z),(-256,-255,z),…(-256,255,z), (-255,-256,z),(-255,-255,z),…(-255,255,z), …… (255,-256,z),(255,-255,z),…(255,255,z)。 1.3提出的问题 问题一:计算出管道的中轴线与半径,给出具体的算法。 问题二:绘制中轴线在XY、YZ、ZX平面的投影图。 问题三:绘制血管的三维重建立体图。

SIFT算法英文详解

SIFT: Scale Invariant Feature Transform The algorithm SIFT is quite an involved algorithm. It has a lot going on and can be come confusing, So I’ve split up the entire algorithm into multiple parts. Here’s an outline of what happens in SIFT. Constructing a scale space This is the initial preparation. You create internal representations of the original image to ensure scale invariance. This is done by generating a “scale space”. LoG Approximation The Laplacian of Gaussian is great for finding interesting points (or key points) in an image. But it’s computationally expensive. So we cheat and approximate it using the representation created earlier. Finding keypoints With the super fast approximation, we now try to find key points. These are maxima and minima in the Difference of Gaussian image we calculate in step 2 Get rid of bad key points Edges and low contrast regions are bad keypoints. Eliminating these makes the algorithm efficient and robust. A technique similar to the Harris Corner Detector is used here. Assigning an orientation to the keypoints An orientation is calculated for each key point. Any further calculations are done relative to this orientation. This effectively cancels out the effect of orientation, making it rotation invariant. Generate SIFT features Finally, with scale and rotation invariance in place, one more representation is generated. This helps uniquely identify features. Lets say you have 50,000 features. With this representation, you can easily identify the feature you’re looking for (sa y, a particular eye, or a sign board). That was an overview of the entire algorithm. Over the next few days, I’ll go through each step in detail. Finally, I’ll show you how to implement SIFT in OpenCV! What do I do with SIFT features? After you run through the algorithm, you’ll have SIFT features for your image. Once you have these, you can do whatever you want. Track images, detect and identify objects (which can be partly hidden as well), or whatever you can think of. We’ll get into this later as well. But the catch is, this algorithm is patented. >.< So, it’s good enough for academic purposes. But if you’re looking to make something commercial, look for something else! [Thanks to aLu for pointing out SURF is patented too] 1. Constructing a scale space Real world objects are meaningful only at a certain scale. You might see a sugar cube perfectly on a table. But if looking at the entire milky way, then it simply does not exist. This multi-scale nature of objects is quite common in nature. And a scale space attempts to replicate this concept

SIFT算法C语言逐步实现详解

SIFT算法C语言逐步实现详解(上) 引言: 在我写的关于sift算法的前倆篇文章里头,已经对sift算法有了初步的介绍:九、图像特征提取与匹配之SIFT算法,而后在:九(续)、sift算法的编译与实现里,我也简单记录下了如何利用opencv,gsl等库编译运行sift程序。 但据一朋友表示,是否能用c语言实现sift算法,同时,尽量不用到opencv,gsl等第三方库之类的东西。而且,Rob Hess维护的sift 库,也不好懂,有的人根本搞不懂是怎么一回事。 那么本文,就教你如何利用c语言一步一步实现sift算法,同时,你也就能真正明白sift算法到底是怎么一回事了。 ok,先看一下,本程序最终运行的效果图,sift 算法分为五个步骤(下文详述),对应以下第二--第六幅图:

sift算法的步骤 要实现一个算法,首先要完全理解这个算法的原理或思想。咱们先来简单了解下,什么叫sift算法: sift,尺度不变特征转换,是一种电脑视觉的算法用来侦测与描述影像中的局部性特征,它在空间尺度中寻找极值点,并提取出其位置、尺度、旋转不变量,此算法由David Lowe 在1999年所发表,2004年完善总结。 所谓,Sift算法就是用不同尺度(标准差)的高斯函数对图像进行平滑,然后比较平滑后图像的差别, 差别大的像素就是特征明显的点。 以下是sift算法的五个步骤: 一、建立图像尺度空间(或高斯金字塔),并检测极值点 首先建立尺度空间,要使得图像具有尺度空间不变形,就要建立尺度空间,sift算法采用了高斯函数来建立尺度空间,高斯函数公式为:

上述公式G(x,y,e),即为尺度可变高斯函数。 而,一个图像的尺度空间L(x,y,e) ,定义为原始图像I(x,y)与上述的一个可变尺度的2维高斯函数G(x,y,e) 卷积运算。 即,原始影像I(x,y)在不同的尺度e下,与高斯函数G(x,y,e)进行卷积,得到L(x,y,e),如下: 以上的(x,y)是空间坐标,e,是尺度坐标,或尺度空间因子,e的大小决定平滑程度,大尺度对应图像的概貌特征,小尺度对应图像的细节特征。大的e值对应粗糙尺度(低分辨率),反之,对应精细尺度(高分辨率)。 尺度,受e这个参数控制的表示。而不同的L(x,y,e)就构成了尺度空间,具体计算的时候,即使连续的高斯函数,都被离散为(一般为奇数大小)(2*k+1) *(2*k+1)矩阵,来和数字图像进行卷积运算。 随着e的变化,建立起不同的尺度空间,或称之为建立起图像的高斯金字塔。 但,像上述L(x,y,e) = G(x,y,e)*I(x,y)的操作,在进行高斯卷积时,整个图像就要遍历所有的像素进行卷积(边界点除外),于此,就造成了时间和空间上的很大浪费。 为了更有效的在尺度空间检测到稳定的关键点,也为了缩小时间和空间复杂度,对上述的操作作了一个改建:即,提出了高斯差分尺度空间(DOG scale-space)。利用不同尺度的高斯差分与原始图像I(x,y)相乘,卷积生成。 DOG算子计算简单,是尺度归一化的LOG算子的近似。 ok,耐心点,咱们再来总结一下上述内容: 1、高斯卷积 在组建一组尺度空间后,再组建下一组尺度空间,对上一组尺度空间的最后一幅图像进行二分之一采样,得到下一组尺度空间的第一幅图像,然后进行像建立第一组尺度空间那样的操作,得到第二组尺度空间,公式定义为 L(x,y,e) = G(x,y,e)*I(x,y)

基于双目立体视觉三维重建系统的制作流程

本技术公开了一种基于双目立体视觉三维重建系统,涉及三维重建系统技术领域;机箱的底部四角处均固定安装有行走轮,机箱的内部分别固定安装有蓄电池与处理计算机,机箱的上端分别固定安装有显示器与安装架,安装架上通过轴承座固定安装有主轴,主轴的下端固定安装有安装齿轮,安装齿轮与驱动齿轮相啮合,驱动齿轮固定安装有驱动电机的轴上,驱动电机通过螺栓安装在安装架上,主轴的上端固定安装有连接轴,连接轴为横向设置,连接轴的两端固定安装有双摄像头,连接轴的中上端固定安装有照明灯;本技术能够实现快速控制,稳定性高,且控制准确,操作简便,能够节省时间;使用方便,结构简单,且效率高,能够在检测时进行补光。 技术要求

1.一种基于双目立体视觉三维重建系统,其特征在于:包括机箱、行走轮、蓄电池、处理计算机、显示器、安装架、驱动齿轮、驱动电机、安装齿轮、主轴、连接轴、双摄像头、照明灯;机箱的底部四角处均固定安装有行走轮,机箱的内部分别固定安装有蓄电池与处理计算机,机箱的上端分别固定安装有显示器与安装架,安装架上通过轴承座固定安装有主轴,主轴的下端固定安装有安装齿轮,安装齿轮与驱动齿轮相啮合,驱动齿轮固定安装有驱动电机的轴上,驱动电机通过螺栓安装在安装架上,主轴的上端固定安装有连接轴,连接轴为横向设置,连接轴的两端固定安装有双摄像头,连接轴的中上端固定安装有照明灯,蓄电池通过导线与处理计算机、显示器的电源端电连接,双摄像头通过导线与处理计算机的输入端电连接,处理计算机的输出端分别与驱动电机、照明灯电连接,显示器与处理计算机的输入、输出端电连接。 2.根据权利要求1所述的一种基于双目立体视觉三维重建系统,其特征在于:所述显示器为触摸式显示屏。 3.根据权利要求1所述的一种基于双目立体视觉三维重建系统,其特征在于:所述行走轮为减震式万向行走轮。 4.根据权利要求1所述的一种基于双目立体视觉三维重建系统,其特征在于:所述驱动电机为低速电机。 5.根据权利要求1所述的一种基于双目立体视觉三维重建系统,其特征在于:所述照明灯为LED灯。 技术说明书 一种基于双目立体视觉三维重建系统 技术领域 本技术属于三维重建系统技术领域,具体涉及一种基于双目立体视觉三维重建系统。 背景技术