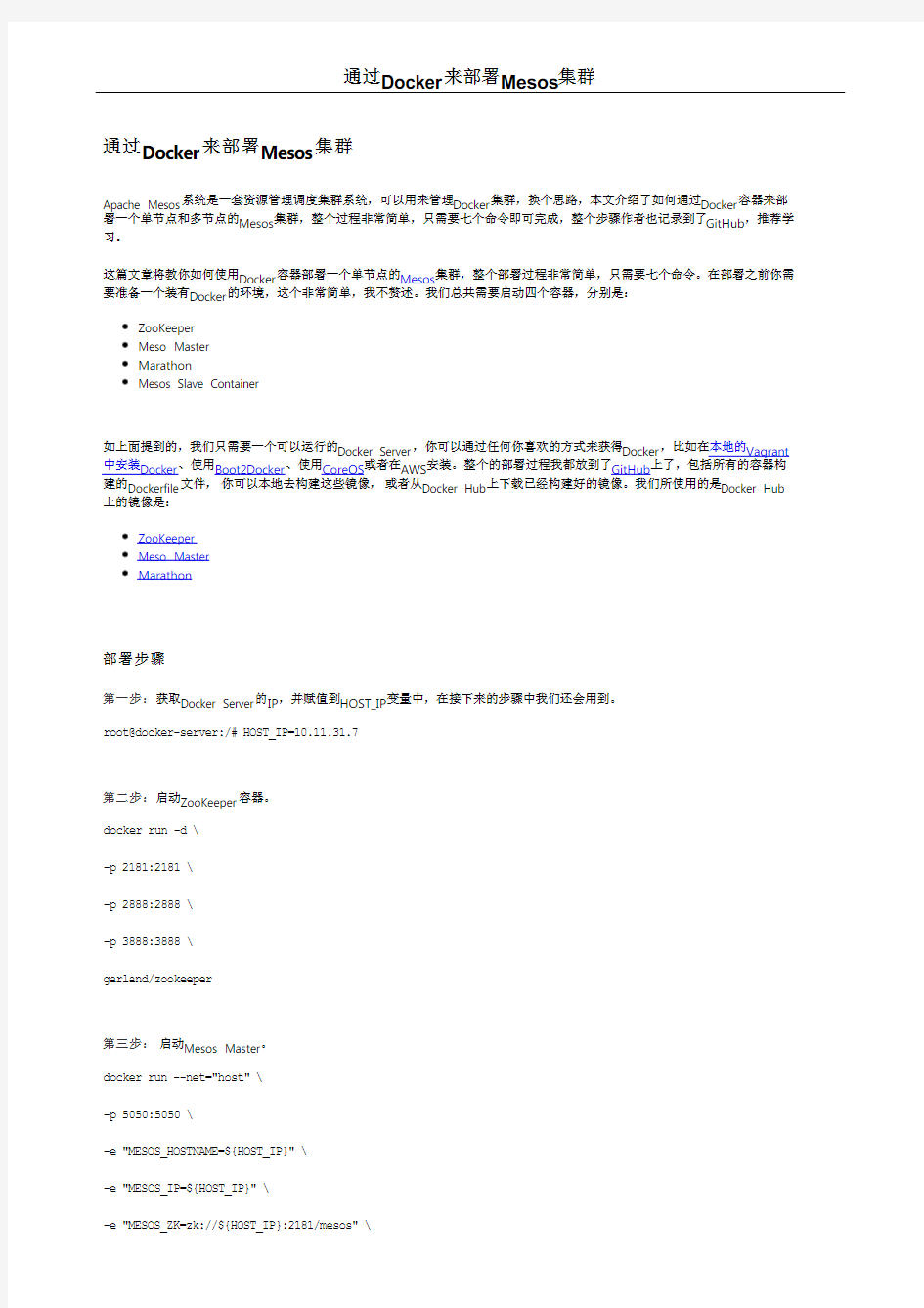

通过Docker来部署Mesos集群

-e "MESOS_PORT=5050" \

-e "MESOS_LOG_DIR=/var/log/mesos" \

-e "MESOS_QUORUM=1" \

-e "MESOS_REGISTRY=in_memory" \

-e "MESOS_WORK_DIR=/var/lib/mesos" \

-d \

garland/mesosphere-docker-mesos-master

第四步:启动Marathon。

docker run \

-d \

-p 8080:8080 \

garland/mesosphere-docker-marathon --master zk://${HOST_IP}:2181/mesos --zk zk://${HOST_IP}:2181/marathon

第五步:启动Mesos Slave。

docker run -d \

--name mesos_slave_1 \

--entrypoint="mesos-slave" \

-e "MESOS_MASTER=zk://${HOST_IP}:2181/mesos" \

-e "MESOS_LOG_DIR=/var/log/mesos" \

-e "MESOS_LOGGING_LEVEL=INFO" \

garland/mesosphere-docker-mesos-master:latest

第六步:访问 Mesos 页面。

Mesos Web 页面地址是:

http://${HOST_IP}:5050

第七步:通过Marathon的Web页面启动一个Job。Marathon Web页面地址是:http://${HOST_IP}:8080。

Marathon 可以让你部署长期运行的Job到Mesos Slave容器上,这个可以帮助你去检查你的集群是否启动,并且处于running的

状态,打开上面的地址后你会看到下面的页面:

以到容器中查看文件是否创建,并检查下这个Job是不是一直在运行。

第八步:检查Job/Task是不是在运行

接下来让我们检查下Job/Task是不是一直在Mesos Slave上面运行。

在Docker Server上运行下面的命令,这个命令会让你进到Mesos Slave 容器中,然后再使用面的内容。

WAS集群部署方案及安装配置手册

1. 部署方案参考 如上图所示,中间件平台主要包括两大部分: ●负载分发层 ?包括两台服务器,通过Heartbeat实现HA,提供浮动IP给客户端,保证了系 统不存在单点故障问题 ?负载分发软件采用IBM HTTP Server实现 ?通过IBM HTTP Server配置虚拟主机,实现对不同应用的请求进行分发到不同 的后台W AS中间件集群。 ●WAS中间件集群 ?包括两台4CPU(每CPU 4Core)服务,每个服务器上通过水平扩展可以启动多 个W AS服务器。 ?基于应用部署要求,为每个应用建立一个集群,逻辑上实现应用之间的隔离。 ?每个集群可以根据应用的负载,动态分配WAS服务器实例数。如HR应用访 问量较大则分配4个WAS实例。 ?但最小要保证一个集群至少包括2个W AS实现,并且这两个实例分别在不同 的物理服务器上,这样才能保证不出现单点故障。 ?部署管理器,部署在WAS Server1上。 2. WebSphere 7安装及配置 此安装配置说明仅供参考,还需要根据现场实现情况进行调整。

2.1.WAS安装 一、四台服务器拓朴结构 四台机器IP地址,名称与安装内容 其中DM控制台管理用户admin,口令 两个web服务器的管理用户也是admin,口令 二、安装后验收 http://**.**.**.**:9060/ibm/console可打开应用服务器主机的控制管理台,管理用户admin,口令****** 服务器->集群下建有应用集群 服务器->应用服务器下建有两个WEB服务 节点共有五个,分别是一个控制节点(一个dmgr节点),两个受控节点(两个app节点),两个非受控节点(两个web节点)

集群方案

Ecology系统HA集群方案及常见问题解决 目录: 一、常用的ecology 高可用环境部署架构 (2) 二、常见的负载均衡器(硬件和软件) (2) 三、常见的服务器类型 (3) 四、服务器配置建议 (3) 五、服务器操作系统分区建议 (3) 六、ecology系统安装部署 (3) 七、集群模式下https部署 (9) 八、常见问题及相应解决方法 (10)

一、常用的ecology 高可用环境部署架构 OA 系统部署拓扑示意图 二、常见的负载均衡器(硬件和软件) 首先说一下什么是负载均衡: 负载均衡说白了是一种代理,也就是说客户端访问应用服务器的统一入口点,客户端通过负载均衡(F5)来将请求转发到应用服务器,而不是客户端直接请求到应用服务器。负载均衡(F5)可以建立一个应用服务器资源池,然后根据不同的策略将请求分发到应用服务器资源池中的其中一台服务器中,进而应用服务器完成相关的业务请求工作。 注:负载均衡和集群之间的理解: 集群是指应用服务器之间的协同工作,应用服务器和应用服务器之间的业务交互,即ecology 系统之间的数据交互。 负载均衡指负载均衡设备和应用服务器之间的业务关系,它是将客户端请求通过负载均衡设备转发到应用服务器,应用服务器处理完毕后,将结果返回到负载均衡,然后负载均衡将结果返回到客户端。 常见的负载均衡设备: 硬件设备:F5、A10、ARRAY 、深信服、梭子鱼等等 软件设备:NGINX 、HAPROXY 、LVS 等等(注:LVS 用的不是太多) 针对我们的ecology 系统,以上负载均衡设备均可使用。 注:由于ecology 系统session 同步的局限性,负载均衡设备分发模式需要配置成:最小连接数模式。(硬件负载均衡) 针对于负载均衡的硬件设备可以咨询相应的硬件厂商,

服务器虚拟化集群技术方案

XX科研院所 服务器虚拟集群系统 技术方案

目录 1前言 (1) 2项目建设必要性分析 (1) 3方案设计 (3) 3.1总体拓扑 (3) 3.2方案概述 (3) 3.3VM WARE 服务器虚拟化方案 (5) 3.3.1服务器虚拟化方案概述 (5) 3.3.2方案架构及描述 (7) 3.3.3方案优势 (15) 3.4C ITRIX X EN DE SKTOP桌面虚拟化方案 (16) 3.4.1桌面虚拟化概述 (16) 3.4.2方案架构及描述 (29) 3.4.3Citrix产品及功能描述 (36) 3.5V F OGLIGHT虚拟环境监控方案 (40) 3.5.1虚拟环境监控方案概述 (40) 3.5.2方案介绍 (44) 3.6接入网络解决方案 (54) 3.6.1方案描述 (54) 3.6.2物理布局设计 (58) 3.6.3方案优势 (59) 3.6.4业务服务器区接入层设计的创新发展 (60) 3.6.5基于Nexus产品的创新设计总结 (64) 4配置方案 (65)

1前言 广泛采用的IT 平台在应用范围和复杂性方面急速发展,服务器数量、网络复杂程度和存储容量也随着一波波的技术变革而激增。由此导致的诸多问题目前仍在困扰着各信息化部门。如:服务器利用率低下、多应用并存导致系统不稳定、整机备份还原困难、计划内或计划外的停机导致服务中断等。 服务器虚拟化技术,经过数十年的发展,成功的解决了这些问题,为基础资源整合提供了理想的解决方案。通过部署服务器虚拟集群,将多个服务器、网络存储设备、备份系统等作为一个资源池,从资源池中灵活的分配适当的资源给相应的应用,使得上述问题迎刃而解。今天,服务器虚拟化技术已经被广泛应用在各个领域,作为绿色数据中心的核心技术手段,发挥着重大的作用。 2项目建设必要性分析 随着信息化工作的不断推进,XX科研院所已建立若干重要应用系统等。这些系统的正常运行切实保障了XX科研院所的科研生产顺利开展,大大提高了工作效率和科研能力。这些应用无不需要良好的服务器环境作为支撑,而且随着应用数量及性能要求的不断提高,对服务器环境资源的要求也将越来越高。同时,随着科研生产对信息化的依赖性增强,保障数据中心稳定、不间断的运行显得越来越重要。 数据中心现有多台服务器,每台服务器都运行多个应用服务。目前主要存在以下几个问题: 1.服务器资源使用率不均匀平均使用率低于40%。 2.计划外或计划内停机维护,影响应用服务的不间断运行。 3.部署新应用的成本较高。 这些问题越来越严重的影响着数据中心安全稳定的运行,解决这些问题迫在眉睫。

MySQL_Cluster集群配置方案

在为某证券公司设计其OA架构时,初期客户是30万用户在线;然而在项目实施中,客户又提出50万用户同时在线的需求,而且都有写的需求;这样初始的设计master-master-slave,读写分离满足不了客户的要求,所以我们打算采用Mysql Cluster方案;MySQL Cluster 是MySQL适合于分布式计算环境的高实用、高冗余版本。它采用了NDB Cluster 存储引擎,允许在1个Cluster中运行多个MySQL服务器。在MyQL 5.0及以上的二进制版本中、以及与最新的Linux版本兼容的RPM中提供了该存储引擎。 一、MySQL Cluster概述 MySQL Cluster 是一种技术,该技术允许在无共享的系统中部署“内存中”数据库的 Cluster 。通过无共享体系结构,系统能够使用廉价的硬件,而且对软硬件无特殊要求。此外,由于每个组件有自己的内存和磁盘,不存在单点故障。 MySQL Cluster 由一组计算机构成,每台计算机上均运行着多种进程,包括MySQL服务器,NDB Cluster 的数据节点,管理服务器,以及(可能)专门的数据访问程序。 所有的这些节点构成一个完成的MySQL集群体系。数据保存在“NDB存储服务器”的存储引擎中,表(结构)则保存在“MySQL服务器”中。应用程序通过“MySQL服务器”访问这些数据表,集群管理服务器通过管理工具(ndb_mgmd)来管理“NDB存储服务器”。 通过将MySQL Cluster 引入开放源码世界,MySQL为所有需要它的人员提供了具有高可用性、高性能和可缩放性的 Cluster 数据管理。 二、MySQL Cluster 基本概念 “NDB” 是一种“内存中”的存储引擎,它具有可用性高和数据一致性好的特点。 MySQL Cluster 能够使用多种故障切换和负载平衡选项配置NDB存储引擎,但在 Cluster 级别上的存储引擎上做这个最简单。MySQL Cluster的NDB存储引擎包含完整的数据集,仅取决于 Cluster本身内的其他数据。 目前,MySQL Cluster的 Cluster部分可独立于MySQL服务器进行配置。在MySQL Cluster中, Cluster的每个部分被视为1个节点。 管理(MGM)节点:这类节点的作用是管理MySQL Cluster内的其他节点,如提供配置数据、启动并停止节点、运行备份等。由于这类节点负责管理其他节点的配置,应在启动其他节点之前首先启动这类节点。MGM节点是用命令 “ndb_mgmd”启动的。 数据节点:这类节点用于保存 Cluster的数据。数据节点的数目与副本的数目相关,是片段的倍数。例如,对于两个副本,每个副本有两个片段,那么就

Linux下高可用集群方案

Linux下高可用集群方案很多,本文介绍的是性价比比较高的一种: 使用Heartbeat 2.0配置Linux高可用性集群。 一、准备工作 你首先需要两台电脑,这两台电脑并不需要有相同的硬件(或者内存大小等),但如果相同的话,当某个部件出现故障时会容易处理得多。接下来您需要决定如何部署。你的集群是通过Heartbeat 软件产生在两台电脑之间心跳信号来建立的。为了传输心跳信号,需要在节点之间存在一条或多条介质通路(串口线通过modem电线,以太网通过交叉线,等等)。现在可以开始配置硬件了。既然想要获得高可用性(HA),那么您很可能希望避免单点失效。在本例中,可能是您的null modem线/串口,或者网卡(NIC)/ 交叉线。因此便需要决定是否希望为每个节点添加第二条串口null modem连线或者第二条NIC/交叉线连接。我使用一个串口和一块额外的网卡来作为heartbeat的通路,这是因为我只有一条null modem线和一块多余的网卡,并且认为有两种介质类型传输heartbeat信号比较好。硬件配置完成之后,便需要安装操作系统以及配置网络(我在本文中使用的是RedHat)。假设您有两块网卡,那么有一块应该配置用于常规网络用途,另一块作为集群节点之间的专用网络连接(通过交叉线)。例如,假设集群节点有如表-1下的IP地址: 表-1集群节点的IP地址 输入如下命令检查您的配置: ifconfig 这将显示您的网卡及其配置。也可以使用命令“netstat –nr”来获得网络路由信息。如果一切正常,接下来要确定可以来两个节点之间通过所有接口ping通对方。如果使用了串口,便需要检测其连接情况。把一个节点作为接收者,输入命令: cat

DHCP服务器群集的部署方案

Windows 网络服务架构系列课程详解(五)---------DHCP服务器群集的部署方案 实验背景: 在路由交换中,关于负载平衡和冗余备份的技术我们已接触过不少,比如说利用PVST技术实现三层交换机上每VLAN的负载均衡以及可靠性;利用HSRP实现了客户端网关的负载均衡以及可靠性;利用NAT 里的TCP负载实现了多台WEB服务器的负载均衡。在windows中我们利用DFS复制实现共享文件夹的冗余备份;利用BDC实现DC的冗余备份。但是,在企业内部的网络中,又如何保障DHCP、MS SOL Server、Exchanger Server等服务器(服务器和用户之间是一个交互的过程,也就是说服务器上的数据是随着用户的申请或者更改而动态变化的过程,而网络负载平衡群集相对于用户起得的作用是只提供给用户内容,不需要用户更改,如FTP,web,ISA,VPN等)的负载均衡以及可靠性呢?这就需要windows服务器群集技术进行解决。Windows服务群集是由独立的计算机系统(称为节点,最多8个节点)构成的组,不同节点协同工作,但是存储的数据都在一个仲裁磁盘上,不过只有2个版本的windows server 2003系统支持(Enterprise Edition和Datacenter Edition) Windows群集模式有单节点群集,用于开发和测试平台;单仲裁设备群集,用于群集储存设备上的高可用性的应用程序;多数节点群集,主要用于地理分散的服务器群集。本实验采用单仲裁群集模式。

实验目的: 1、掌握在虚拟机上模拟仲裁磁盘的方法和实验环境的搭建 2、了解DHCP服务器的搭建方法 3、掌握服务器群集的搭建方法 4、使用DHCP服务器验证服务器群集的功能 实验网络拓扑: 实验步骤 1、准备测试环境 首先准备三台虚拟机,其中两台为windows server 2003(做服务器群集节点),另一台为windows xp(做测试客户机),真机为win

Hadoop集群部署方案

Hadoop集群部署方案

目录 1.网络拓扑 (1) 2.软件安装 (1) 2.1.修改主机名 (1) 2.2.修改host文件 (1) 2.3.创建Hadoop 用户 (2) 2.4.禁用防火墙 (2) 2.5.设置ssh登录免密码 (2) 2.6.安装hadoop (4) 3.集群配置 (5) 3.1.修改脚本 (5) 3.1.1................................................ hadoop-env.sh 5 3.1.2................................................... y arn-env.sh 5 3.2.配置文件 (5) 3.2.1................................................ core-site.xml 5 3.2.2................................................ hdfs-site.xml 7 3.2.3.............................................. mapred-site.xml 10 3.2. 4................................................ yarn-site.xml 11 3.2.5.配置datanode 14 3.3.创建目录 (14)

4.启动zk集群 (14) 5.启动hadoop (14) 5.1.启动所有节点journalnode (14) 5.2.格式化h1 namenode (15) 5.3.在h1上格式化ZK (15) 5.4.启动h1的namenode,zkfc (16) 5.5.启动h2上namenode (16) 5.6.同步h1上的格式化数据到h2 (16) 5.7.启动 HDFS (17) 5.8.启动 YARN (18) 5.9.启动h2 ResourceManager (18) 5.10........................................ h4上启动 JobHistoryServer 19 5.11.......................................... 查看ResourceManager状态19 6.浏览器访问 (19) https://www.360docs.net/doc/5d4577755.html,node管理界面 (19) 6.1.1............................... http://192.168.121.167:50070 19 6.1.2............................... http://192.168.121.168:50070 20 6.2.ResourceManager管理界面 (20) 6.2.1............................... http://192.168.121.167:8088/ 21 6.2.2............................... http://192.168.121.168:8088/ 21 6.3.JournalNode HTTP 服务 (21) 6.3.1............................... http://192.168.121.167:8480/ 21 6.4.Datanode HTTP服务 (22)

WAS集群部署方案及安装配置手册

W A S集群部署方案及安装 配置手册 Prepared on 24 November 2020

1. 部署方案参考 如上图所示,中间件平台主要包括两大部分: ●负载分发层 ?包括两台服务器,通过Heartbeat实现HA,提供浮动IP给客户 端,保证了系统不存在单点故障问题 ?负载分发软件采用IBM HTTP Server实现 ?通过IBM HTTP Server配置虚拟主机,实现对不同应用的请求进行 分发到不同的后台WAS中间件集群。 ●WAS中间件集群 ?包括两台4CPU(每CPU 4Core)服务,每个服务器上通过水平扩展可 以启动多个WAS服务器。 ?基于应用部署要求,为每个应用建立一个集群,逻辑上实现应用之 间的隔离。 ?每个集群可以根据应用的负载,动态分配WAS服务器实例数。如 HR应用访问量较大则分配4个WAS实例。

?但最小要保证一个集群至少包括2个WAS实现,并且这两个实例 分别在不同的物理服务器上,这样才能保证不出现单点故障。 ?部署管理器,部署在WAS Server1上。 2. WebSphere 7安装及配置 此安装配置说明仅供参考,还需要根据现场实现情况进行调整。 2.1.WAS安装 一、四台服务器拓朴结构 四台机器IP地址,名称与安装内容 主机名IP 安装软件(组件)

其中DM控制台管理用户admin,口令 两个web服务器的管理用户也是admin,口令 二、安装后验收 可打开应用服务器主机的控制管理台,管理用户admin,口令****** 服务器->集群下建有应用集群 服务器->应用服务器下建有两个WEB服务 节点共有五个,分别是一个控制节点(一个dmgr节点),两个受控节点(两个app 节点),两个非受控节点(两个web节点) 集群下各受控节点已同步,并启动服务;两个WEB服务已生成插件、传播插件并启动。 在DMGR控制管理台可直接控制两个WEB的启动与停止。 三、安装前系统检查 ?群集安装时,确认所有机子的日期要一致 ?确认磁盘空间足够 两个应用服务器的安装文件放在/was_install 两个WEB服务器的安装文件放在/http_install 安装目录都是安装于默认的/opt目录下

DM7集群部署方案之数据共享集群Linux(2节点)

DM7集群部署方案之数据共享集群 Linux(2节点) 武汉达梦数据库有限公司 2019年9月

版本历史

目录 1 前期准备工作 (1) 1.1硬件准备 (1) 1.2网络架构 (1) 1.3硬件环境建议 (1) 1.4硬件环境环境验证 (2) 1.5集群规划 (2) 1.6修改主机名 (2) 1.7关闭防火墙 (3) 1.8网卡自启 (3) 1.9修改系统参数 (3) 2 创建目录并安装数据库 (3) 2.1A机器 (3) 2.2B机器 (4) 3 存储准备 (4) 3.1划存储 (4) 3.2挂存储方法1:直接挂 (4) 3.3挂存储方法2:多路径绑定 (5) 4 搭建DSC (6) 4.1配置DMDCR_CFG.INI (6) 4.2初始化磁盘组 (7) 4.3配置DMASVRMAL.INI (7) 4.4配置DMDCR.INI (7) 4.5启动CSS、ASM服务 (8) 4.6创建DMASM磁盘组 (9) 4.7配置DMINIT.INI (9) 4.8初始化数据库 (9) 4.9配置DMARCH.INI (10)

4.10启动DMSERVER服务 (10) 4.11设置后台启动脚本 (11) 4.12启停集群 (12) 5 配置监视器 (13) 5.1配置DMCSSM.INI (13) 5.2启动监视器 (13) 6配置DM_SVC.CONF文件 (13) 6.1 DM_SVC.CONF配置内容 (13) 6.2应用连接 (14) 7附加操作 (14) 7.1操作系统/数据库调优 (14) 7.2数据库备份 (14) 7.3项目管理维护 (14)

集群方案对比分析

集群方案分析 前言 目的 在我司部分项目实施过程中,用户提出了要求采用”双机”的方案。目前业内双机技术方案比较多,能解决的问题、达到的目标、用户拥有成本也不相同。本文试图给出主要技术方案的比较,供项目选型参考。 集群的概念 计算机集群简称集群是一种计算机系统,它通过一组松散集成的计算机软件和/或硬件连接起来高度紧密地协作完成计算工作。在某种意义上,他们可以被看作是一台计算机。集群系统中的单个计算机通常称为节点,通常通过局域网连接,但也有其它的可能连接方式。集群计算机通常用来改进单个计算机的计算速度和/或可靠性。一般情况下集群计算机比单个计算机,比如工作站或超级计算机性能价格比要高得多。 按功效,可将集群分为: 高可用性集群High-availability (HA) clusters 负载均衡集群Load balancing clusters 高性能计算集群High-performance (HPC) clusters 网格计算Grid computing 高可用性集群提供了尽可能大的平均无故障时间时间、尽可能小的平均故障恢复时间。在集群内部署冗余设备,当系统中某台机器发生故障时,备用机器立刻启动接管任务。我们通常说的双机热备就是一种高可用性集群。 负载均衡集群提供了根据各个节点的闲置能力情况,将并发访问分散到各个节点上的功能,以使得集群整体的处理能力最大化,或当个任务的等待时间最小。 高性能集群、网格计算着眼点在于如何将一个大型任务分解到集群的各个节点中协同处理。主要应用领域包括天气预报、核试验仿真等。在我司目前及未来的主要项目中,一般不包含此类大型任务处理的需求,而主要处理多用户并发的小任务。这些并发小任务处理的性能问题特别适合使用负载均衡集群予以解决。 按照各种集群产品的技术路线,可将集群分为: 系统层集群 系统层集群是集群平台。在这个平台之上可以部署各个应用。由集群负责管理、监控应用,当节点发生故障时,集群将各种应用转移到后备节点上。Windows 故障转移群集就是其典型代表。 应用层集群 特定应用所构成的集群。例如,数据库应用集群,web服务器集群。相应的集群只能实现特定应用的故障转移。

DM7集群部署方案之数据守护集群Linux(主备)

DM7集群部署方案之数据守护集群 Linux(主备) 武汉达梦数据库有限公司 2019年9月

版本历史

目录 1 安装前准备 (1) 1.1集群规划 (1) 1.2网络架构 (1) 1.3硬件环境建议 (2) 1.4硬件环境环境验证 (2) 1.5A机器:实例、启服务 (2) 2 配置A机器 (2) 2.1注册服务 (2) 2.2配置DM.INI (3) 2.3配置DMARCH.INI (3) 2.4配置DMMAL.INI (4) 2.5配置DMWATCHER.INI (4) 2.6配置DMWATCHER.CTL (4) 2.7拷贝实例 (5) 3 配置B机器 (5) 3.1注册服务 (5) 3.2配置DM.INI (6) 3.3配置DMARCH.INI (6) 3.4相同配置项 (6) 4 配置监视器 (6) 4.1注册服务 (6) 4.2配置DMMONITOR.INI (7) 4.3监视器使用 (7) 5 启动服务及查看信息 (8) 5.1启动数据库服务并修改参数 (8) 5.2查询主备库信息是否一致 (8) 5.3启动守护进程 (8)

5.4启动监视器 (8) 5.5启停集群 (9) 6 配置DM_SVC.CONF文件 (9) 6.1 DM_SVC.CONF配置内容 (9) 6.2应用连接 (9) 7 附加操作 (10) 7.1操作系统/数据库调优 (10) 7.2数据库备份 (10) 7.3项目管理维护 (10)

1安装前准备 1.1集群规划 说明:具体规划及部署方式以现场环境为准。 1.2网络架构 主机备机

1.3硬件环境建议 心跳网络方面:①集群间的心跳网络要走数据,最好走两个交换机,来实现冗余和负载均衡。②需要把服务器多个心跳网卡绑定为一个逻辑网卡来使用(比如bond方式)。③交换机速度建议至少为千兆。 存储方面:①需要在每台机器上挂在独立存储,其中主机所在机器挂载的存储建议大一些。②需要格式化好,且所有机器挂载路径保持一致。③在空间不够用时,要求支持在挂载目录上直接进行扩充。④文件系统建议使用ext4。 1.4硬件环境环境验证 心跳网络方面:①关闭其中一台交换机或者模拟其中一条线路故障,是否能做到网络方面的冗余。②测试心跳网络的稳定性,会不会出现断连或者丢包等情况。 存储方面:反复重启集群机器,检查存储是否会出现只读、脱挂、挂载路径是否会发生改变等情况。 1.5A机器:实例、启服务 2配置A机器 2.1注册服务 ①复制数据库和守护进程服务文件到/etc/rc.d/init.d目录 ②vi /etc/rc.d/init.d/DmServiceRT1_01文件 ③vi /etc/rc.d/init.d/DmServiceWatcher文件 ④修改启动服务的等级连接

Cognos服务器环境集群部署解决方案

C o g n o s服务器环境集群部署解决方案 操作风险项目组 2020-11-20

修改记录

目录 1. ...................................................................................................................................................... 前言1 1.1. ............................................................................................................................................. 目的1 1. 2. ................................................................................................................................... 适用读者1 1.3. ................................................................................................................................... 名词解释1 2. .......................................................................................... Cognos服务器集群服务的原理1 2.1. ........................................................................................................................ 单机访问模式1 2.2. ........................................................................................................................ 集群服务模式2 3. ................................................................................................................................. 集群部署案例4 3.1. ................................................................................................................................... 准备工作5 3.2. ................................................................................................................................... 具体操作5 3.3. ................................................................................................................................... 测试集群11 3. 4. ........................................................................................................................ 监控运行情况12

金蝶EAS系统部署方案20090708

集成管理随需应变 -----金蝶EAS系统部署方案 金蝶软件(中国)有限公司 金蝶EAS通过国际厂商和国际组织的权威测试和认证!

目录 1.前言 (4) 2.技术架构 (5) 3.系统部署方式 (6) 3.1.标准方案 (6) 3.2.双机互备方案 (6) 3.3.应用级集群部署方案 (7) 3.3.1.集群模型特点 (7) 3.3.2.集群部署建议 (8) 3.4.系统级集群方案 (8) 3.4.1.IBM P系列服务器群集技术(HACMP) (8) 3.4.2.HP MC/ServiceGuard 集群方案 (9) 3.5.分区技术 (10) 4.网络安全 (10) 4.1.防火墙 (10) 4.2.VPN技术 (11) 4.3.C ITRIX解决方案 (12) 5.网络环境 (14) 5.1.网络指标 (14) 5.2.局域网 (15) 5.3.无线局域网(WLAN) (15) 5.4.广域网 (16) 5.5.南北电信互联互通问题 (19) 6.服务器选型与配置 (19) 6.1.EAS运行支持环境 (19) 6.2.服务器硬件选型 (20) 6.3.磁盘存储系统 (22) 6.4.数据备份 (23) 6.5.数据库选型 (24) 6.6.应用服务器选型 (24) 6.7.客户端硬件配置 (24) 7.典型配置 (25) 7.1.20个并发用户以内 (25) 7.2.20-50个并发用户数 (27) 7.3.50-100个并发用户数 (28) 7.4.100-200个并发用户数 (30) 7.5.200-500个并发用户数 (31) 7.6.500个并发用户数以上 (33) 8.附件:性能测试报告 (35) 8.1.EAS IBM IIC(上海)性能测试报告 (35) 8.2.EAS HP方案解决中心性能测试报告 (39) 8.3.EAS S UN F IRE服务器兼容性暨性能测试报告 (42) 8.4.金蝶EAS V6.0IBM POWERBLADE服务器性能测试报告 (46)

weblogic多机集群部署(F5方案)

Weblogic多机多服务部署 此次以10.128.22.21和10.128.22.22两台服务器为例,来描述应用部署的步骤。并以10.128.22.21:7001作为管理服务器 主管服务器相关配置 创建domain /home/weblogic/weblog10/wlserver_10.3/common/bin/config.sh 执行config.sh 选择创建新的weblogic域 选择weblogic Platfrom 组件

选择要使用的模板这里直接点击下一步即可 输入需要创建的domain的名称(主管服务器和受管服务器名称建议一致) 选择默认位置

根据提示输入用户口令并进行确认 根据需要选择开发模式或者生产模式这里选择生产模式 选择预先设置好的JDK

下一步根据提示创建好domain 启动weblogic服务 /home/weblogic/weblog10/user_projects/domains/tpcenter_domain 执行startWebLogic.sh 此时需要根据提示输入之前设置的weblogic用户名和密码,密码输入正确则可以正常启动成功启动weblogic服务之后进入 /home/weblogic/weblog10/user_projects/domains/tpcenter_domain/servers/AdminServer 目录下创建security文件夹并在文件夹中写入boot.properties username=XXXXX password=xxxxxx 之后重新启动weblogic服务,系统会自动读取boot.properties并对用户名和密码进行加密,后续启动无需手动输入weblogic用户名密码 新建server 登录domain的控制台,查看环境->服务器

EasyDSS集群配置方案

EasyDSS集群简单配置方案 1. 说明 EasyDSS支持配置RTMP拉流转发和RTMP推流转发。在做EasyDSS集群时,我们可以配置一台EasyDSS为接收推流的服务器,并配置推流转发至其他的EasyDSS服务器用于流分发,当然,接收推流的EasyDSS也可用于流分发。 这样流分发服务器提供的播放地址都相同,只需要提供一台管理服务用于分配播放地址即可。 2. 配置 推流配置 rtmp { server { #rtmp监听端口,默认10085 listen 10085; #自动推流配置 application live { live on; #rtmp地址为推流地址,name指定rtmp的name #当EasyDSS接收app为live,name为stream1的rtmp流时 #可以同步转发到指定的rtmp推流地址 push rtmp://ip:port/app/stream1 name=stream1; #当EasyDSS接收app为live的推流时 #可以同步转发到指定的rtmp推流地址 #rtmp流的name将自动添加到转发地址进行转发 #如:接收推流为/live/stream #则会转发到rtmp://ip:port/app/stream push rtmp://ip:port/app; } } } 3. 示例 如果我们现在有4台EasyDSS服务器,分别为A、B、C、D,A用于接收推流,转发给其他3台B、C、D用于流分发,A也用于流分发。这样,我们需要在A服务进行配置即可。

我们假设A服务器的IP地址为192.168.1.5,B为192.168.1.6,C为192.168.1.7,D为192.168.1.8,他们的RTMP端口都为10085。 #A服务器配置 application hls { live on; hls on; hls_path www/hls; hls_fragment 4s; push rtmp://192.168.1.6:10085/hls; push rtmp://192.168.1.7:10085/hls; push rtmp://192.168.1.8:10085/hls; } #B、C、D服务器配置 application hls { live on; hls on; hls_path www/hls; hls_fragment 4s; } 当A服务器接收推流为rtmp://192.168.1.5:10085/hls/stream时,则 服务的分发地址为: A: rtmp://192.168.1.5:10085/hls/stream http://192.168.1.5/hls/stream/stream_live.m3u8 B: rtmp://192.168.1.6:10085/hls/stream http://192.168.1.6/hls/stream/stream_live.m3u8 C: rtmp://192.168.1.7:10085/hls/stream http://192.168.1.7/hls/stream/stream_live.m3u8 D: rtmp://192.168.1.8:10085/hls/stream http://192.168.1.8/hls/stream/stream_live.m3u8

(仅供参考)Cloudera平台部署架构建议方案

Cloudera平台参考部署架构

Cloudera平台软件体系结构 Cloudera的软件体系结构中包含了以下模块:系统部署和管理,数据存储,资源管理,处理引擎,安全,数据管理,工具库以及访问接口。一些关键组件的角色信息:

硬件配置 集群服务器按照节点承担的任务分为管理节点和工作节点。管理节点上一般部署各组件的管理角色,工作节点一般部署有各角色的存储、容器或计算角色。根据业务类型不同,集群具体配置也有所区别: 1.实时流处理服务集群:Hadoop实时流处理性能对节点内存和CPU有较高要求,基于Spark Streaming的流处理消息吞吐量可随着节点数量增加而线性增长。 管理节点工作节点 处理器两路Intel?至强处理器,可选用E5- 2630处理器两路Intel?至强处理器,可选用E5-2660处理器 内核数6核/CPU(或者可选用8核/CPU), 主频2.3GHz或以上6核/CPU(或者可选用8核/CPU),主频2.0GHz或以上 内存128GB ECC DDR3 128GB ECC DDR3 硬盘2个2TB的SAS硬盘(3.5寸), 7200RPM, RAID1 4-12个4TB的SAS硬盘(3.5寸), 7200RPM,不使用RAID 网络至少两个1GbE以太网电口,推荐使 用光口提高性能。 可以两个网口链路聚合提供更高带 宽。至少两个1GbE以太网电口,推荐使用光口提高性能。 可以两个网口链路聚合提供更高带宽。 硬件尺寸1U或2U 1U或2U 接入交换机48口千兆交换机,要求全千兆,可堆叠 聚合交换机 (可选) 4口SFP+万兆光纤核心交换机,一般用于50节点以上大规模集群

Oracle与SQLServer集群部署方案对比及实例

Oracle与SQLServer集群部署方案对比及实例 一、需求背景 1、大型全国系统的稳定性、安全性必须在现有基础上进一步提高,需要升级到综合性能更强大的硬件,实现更加完善的故障转移、数据冗余、灾难备份等容错手段。 2、全国系统中,以数据量和访问量为代表的系统负载将会大幅度提升,数据库的性能将成为关键瓶颈。数据库服务器需要从现有的双机故障转移集群升级为可支持负载均衡的集群方式,在满足性能要求的同时,为未来的动态性能扩展打下基础。二、Oracl e RAC与SQL Server的集群方案对比 1,方案与需求分析 关键功能与费用矩阵分析表: 集群方案与需求矩阵分析表:

由上表可见: 集群分两个层面:系统层群集和应用层群集,Oracle RAC 和SQL Server 故障转移集群都是属于应用集群,两种集群都能够实现高可用性即容错的要求。 两者最大的不同之处在于:Oracle RAC虽成本较高,但能实现负载平衡的需求,支持动态添加服务器节点来应对负载的增加。而SQL Server集群成本虽然较低,但系统不具备方便的负载性能扩展的能力,当出现数据库系统的性能不能满足应用的负载时,只能更换更高配置的机器,这个问题也是到目前为止微软自身的集群解决方案具有的通病。尽管也有一些号称是支持SQL Server实现负载均衡的增值开发,但对这样一个全国系统来说,使用非微软原生的第三方系统需要慎重考虑。 另外,对于一个大型全国系统来说,要求的高可用性的需求和场景还应该包括有其他的内容,例如数据的冗余、异地灾难备份,这些需求可能需要我们用集群以外的方式来实现,还需要进一步制定在上述集群之外的方案,而在Oracle数据库所具备的ASM 和DATA GUARD功能也为数据冗余和异地灾难备份提供了更多更好的可能性。 2,功能实现方式对比 以下再进一步从故障转移、负载均衡、可扩展性等各个方面的功能实现方式上,对两种集群方式进行更加详细的对比。

WAS集群部署方案及安装配置手册

【经典方案WORD文档,可编辑修改】 部署方案参考 如上图所示,中间件平台主要包括两大部分: 负载分发层 包括两台服务器,通过Heartbeat实现HA,提供浮动IP给客户端,保证了系 统不存在单点故障问题 负载分发软件采用IBM HTTP Server实现 通过IBM HTTP Server配置虚拟主机,实现对不同应用的请求进行分发到不同 的后台WAS中间件集群。 WAS中间件集群 包括两台4CPU(每CPU 4Core)服务,每个服务器上通过水平扩展可以启动多个 WAS服务器。 基于应用部署要求,为每个应用建立一个集群,逻辑上实现应用之间的隔离。 每个集群可以根据应用的负载,动态分配WAS服务器实例数。如HR应用访问 量较大则分配4个WAS实例。 但最小要保证一个集群至少包括2个WAS实现,并且这两个实例分别在不同的 物理服务器上,这样才能保证不出现单点故障。

部署管理器,部署在WAS Server1上。 1.WebSphere 7安装及配置 此安装配置说明仅供参考,还需要根据现场实现情况进行调整。 1.1.WAS安装 一、四台服务器拓朴结构 四台机器IP地址,名称与安装内容 主机名IP安装软件(组件) app1WASND ( WAS)(DM+APPSRV01) app2( WAS)( APPSRV01) web1HIS+PLUGINS web2HIS+PLUGINS 其中DM控制台管理用户admin,口令 两个web服务器的管理用户也是admin,口令 二、安装后验收

可打开应用服务器主机的控制管理台,管理用户admin,口令****** 服务器->集群下建有应用集群 服务器->应用服务器下建有两个WEB服务 节点共有五个,分别是一个控制节点(一个dmgr节点),两个受控节点(两个app节点),两个非受控节点(两个web节点) 集群下各受控节点已同步,并启动服务;两个WEB服务已生成插件、传播插件并启动。 在DMGR控制管理台可直接控制两个WEB的启动与停止。 三、安装前系统检查 群集安装时,确认所有机子的日期要一致 确认磁盘空间足够 两个应用服务器的安装文件放在/was_install 两个WEB服务器的安装文件放在/http_install 安装目录都是安装于默认的/opt目录下 两个应用服务器安装后生成目录 /opt/IBM/WebServer/AppServer 两个WEB服务器安装后生成目录/opt/IBM/HTTPServer 两个WEB服务器的目录/opt/IBM/HTTPServer/plugins放有插件