偏最小二乘回归分析_matlab

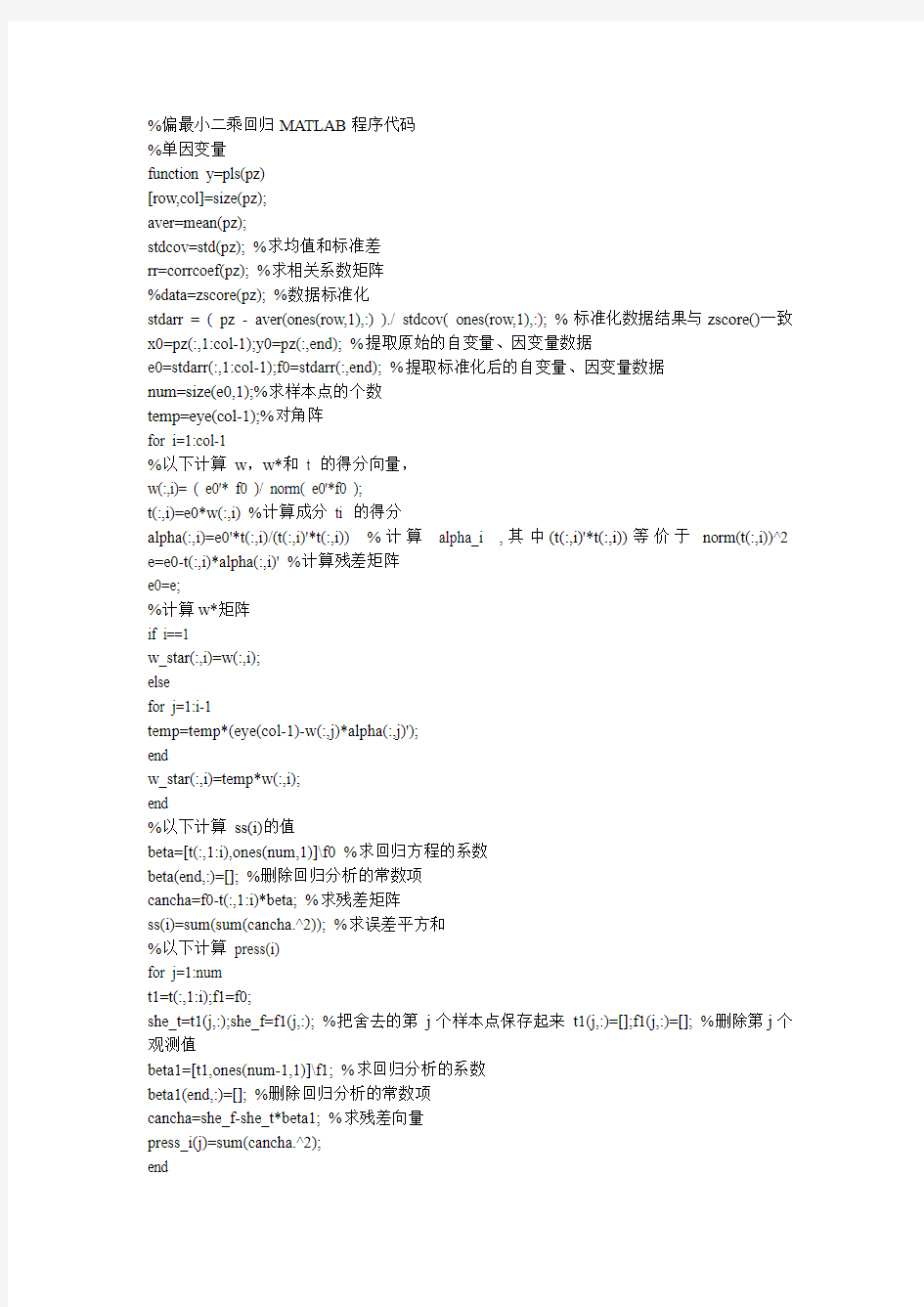

%偏最小二乘回归MA TLAB程序代码

%单因变量

function y=pls(pz)

[row,col]=size(pz);

aver=mean(pz);

stdcov=std(pz); %求均值和标准差

rr=corrcoef(pz); %求相关系数矩阵

%data=zscore(pz); %数据标准化

stdarr = ( pz - aver(ones(row,1),:) )./ stdcov( ones(row,1),:); % 标准化数据结果与zscore()一致x0=pz(:,1:col-1);y0=pz(:,end); %提取原始的自变量、因变量数据

e0=stdarr(:,1:col-1);f0=stdarr(:,end); %提取标准化后的自变量、因变量数据

num=size(e0,1);%求样本点的个数

temp=eye(col-1);%对角阵

for i=1:col-1

%以下计算w,w*和t 的得分向量,

w(:,i)= ( e0'* f0 )/ norm( e0'*f0 );

t(:,i)=e0*w(:,i) %计算成分ti 的得分

alpha(:,i)=e0'*t(:,i)/(t(:,i)'*t(:,i)) %计算alpha_i ,其中(t(:,i)'*t(:,i))等价于norm(t(:,i))^2 e=e0-t(:,i)*alpha(:,i)' %计算残差矩阵

e0=e;

%计算w*矩阵

if i==1

w_star(:,i)=w(:,i);

else

for j=1:i-1

temp=temp*(eye(col-1)-w(:,j)*alpha(:,j)');

end

w_star(:,i)=temp*w(:,i);

end

%以下计算ss(i)的值

beta=[t(:,1:i),ones(num,1)]\f0 %求回归方程的系数

beta(end,:)=[]; %删除回归分析的常数项

cancha=f0-t(:,1:i)*beta; %求残差矩阵

ss(i)=sum(sum(cancha.^2)); %求误差平方和

%以下计算press(i)

for j=1:num

t1=t(:,1:i);f1=f0;

she_t=t1(j,:);she_f=f1(j,:); %把舍去的第j个样本点保存起来t1(j,:)=[];f1(j,:)=[]; %删除第j个观测值

beta1=[t1,ones(num-1,1)]\f1; %求回归分析的系数

beta1(end,:)=[]; %删除回归分析的常数项

cancha=she_f-she_t*beta1; %求残差向量

press_i(j)=sum(cancha.^2);

end

press(i)=sum(press_i)

if i>1

Q_h2(i)=1-press(i)/ss(i-1)

else

Q_h2(1)=1

end

if Q_h2(i)<0.0985

fprintf('提出的成分个数r=%d',i);

r=i;

break

end

end

beta_z=[t,ones(num,1)]\f0; %求标准化Y关于主成分得分向量t的回归系数beta_z(end,:)=[]; %删除常数项

xishu=w_star*beta_z; %求标准化Y关于X的回归系数,且是针对标准数据的回归系数,每一列是一个回归方程

mu_x=aver(1:col-1);mu_y=aver(end);

sig_x=stdcov(1:col-1);sig_y=stdcov(end);

ch0=mu_y-mu_x./sig_x*sig_y*xishu; %计算原始数据的回归方程的常数项

xish=xishu'./sig_x*sig_y; %计算原始数据的回归方程的系数,每一列是一个回归方程Rc=corrcoef(x0*xish'+ch0,y0)

sol=[ch0;xish'] %显示回归方程的系数,每一列是一个方程,每一列的第一个数是常数项多因变量

function y=pls(pz,Xnum,Ynum)

[row,col]=size(pz);

aver=mean(pz);

stdcov=std(pz); %求均值和标准差

rr=corrcoef(pz); %求相关系数矩阵

data=zscore(pz); %数据标准化

stdarr = ( pz - aver(ones(row,1),:) )./ stdcov( ones(row,1),:); % 标准化自变量

n=Xnum;m=Ynum; %n 是自变量的个数,m是因变量的个数

x0=pz(:,1:n);y0=pz(:,n+1:end); %提取原始的自变量、因变量数据

e0=data(:,1:n);f0=data(:,n+1:end); %提取标准化后的自变量、因变量数据

num=size(e0,1);%求样本点的个数

temp=eye(n);%对角阵

for i=1:n

%以下计算w,w*和t 的得分向量,

matrix=e0'*f0*f0'*e0;

[vec,val]=eig(matrix) %求特征值和特征向量

val=diag(val); %提出对角线元素

[val,ind]=sort(val,'descend');

w(:,i)=vec(:,ind(1)) %提出最大特征值对应的特征向量

t(:,i)=e0*w(:,i) %计算成分ti 的得分

alpha(:,i)=e0'*t(:,i)/(t(:,i)'*t(:,i)) %计算alpha_i ,其中(t(:,i)'*t(:,i))等价于norm(t(:,i))^2

e=e0-t(:,i)*alpha(:,i)' %计算残差矩阵

e0=e;

%计算w*矩阵

if i==1

w_star(:,i)=w(:,i);

else

for j=1:i-1

temp=temp*(eye(n)-w(:,j)*alpha(:,j)');

end

w_star(:,i)=temp*w(:,i);

end

%以下计算ss(i)的值

beta=[t(:,1:i),ones(num,1)]\f0 %求回归方程的系数

beta(end,:)=[]; %删除回归分析的常数项

cancha=f0-t(:,1:i)*beta; %求残差矩阵

ss(i)=sum(sum(cancha.^2)); %求误差平方和

%以下计算press(i)

for j=1:num

t1=t(:,1:i);f1=f0;

she_t=t1(j,:);she_f=f1(j,:); %把舍去的第j个样本点保存起来

t1(j,:)=[];f1(j,:)=[]; %删除第j个观测值

beta1=[t1,ones(num-1,1)]\f1; %求回归分析的系数

beta1(end,:)=[]; %删除回归分析的常数项

cancha=she_f-she_t*beta1; %求残差向量

press_i(j)=sum(cancha.^2);

end

press(i)=sum(press_i)

if i>1

Q_h2(i)=1-press(i)/ss(i-1)

else

Q_h2(1)=1

end

if Q_h2(i)<0.0985

fprintf('提出的成分个数r=%d',i);

r=i;

break

end

end

beta_z=[t(:,1:r),ones(num,1)]\f0; %求标准化Y关于t 的回归系数

beta_z(end,:)=[]; %删除常数项

xishu=w_star(:,1:r)*beta_z; %求标准化Y关于X的回归系数,且是针对标准数据的回归系数,每一列是一个回归方程

mu_x=aver(1:n);mu_y=aver(n+1:end);

sig_x=stdcov(1:n);sig_y=stdcov(n+1:end);

for i=1:m

ch0(i)=mu_y(i)-mu_x./sig_x*sig_y(i)*xishu(:,i); %计算原始数据的回归方程的常数项end

for i=1:m

xish(:,i)=xishu(:,i)./sig_x'*sig_y(i); %计算原始数据的回归方程的系数,每一列是一个回归方程

end

sol=[ch0;xish] %显示回归方程的系数,每一列是一个方程,每一列的第一个数是常数项

用matlab实现最小二乘递推算法辨识系统参数

用matlab实现最小二乘递推算法辨识系统参 数 自动化系统仿真实验室指导教师: 学生姓名班级计082-2 班学号撰写时间: 全文结束》》-3-1 成绩评定: 一.设计目的 1、学会用Matlab实现最小二乘法辨识系统参数。 2、进一步熟悉Matlab的界面及基本操作; 3、了解并掌握Matlab中一些函数的作用与使用;二.设计要求最小二乘递推算法辨识系统参数,利用matlab编程实现,设初始参数为零。z(k)-1、5*z(k-1)+0、7*z(k-2)=1*u(k-1)+0、5*u(k-2)+v(k); 选择如下形式的辨识模型:z(k)+a1*z(k- 1)+a2*z(k-2)=b1*u(k-1)+b2*u(k-2)+v(k);三.实验程序 m=3;N=100;uk=rand(1,N);for i=1:Nuk(i)=uk(i)*(-1)^(i-1);endyk=zeros(1,N); for k=3:N yk(k)=1、5*yk(k-1)-0、 7*yk(k-2)+uk(k-1)+0、5*uk(k-2); end%j=100;kn=0;%y=yk(m:j);%psi=[yk(m-1:j-1);yk(m-2:j-2);uk(m-1:j-1);uk(m-2:j- 2)];%pn=inv(psi*psi);%theta=(inv(psi*psi)*psi*y);theta=[0 ;0;0;0];pn=10^6*eye(4);for t=3:Nps=([yk(t-1);yk(t-

2);uk(t-1);uk(t-2)]);pn=pn- pn*ps*ps*pn*(inv(1+ps*pn*ps));theta=theta+pn*ps*(yk(t)-ps*theta);thet=theta;a1=thet(1);a2=thet(2);b1=thet(3);b2= thet(4); a1t(t)=a1;a2t(t)=a2;b1t(t)=b1;b2t(t)=b2;endt=1:N;plot(t,a 1t(t),t,a2t(t),t,b1t(t),t,b2t(t));text(20,1、 47,a1);text(20,-0、67,a2);text(20,0、97,b1);text(20,0、47,b2);四.设计实验结果及分析实验结果图:仿真结果表明,大约递推到第步时,参数辨识的结果基本到稳态状态,即a1=1、5999,b1=1,c1=0、5,d1=-0、7。五、设计感受这周的课程设计告一段落了,时间短暂,意义重大。通过这次次练习的机会,重新把matlab课本看了一遍,另外学习了系统辨识的有关内容,收获颇丰。对matlab的使用更加纯熟,也锻炼了自己在课本中搜索信息和知识的能力。在设计过程中虽然遇到了一些问题,但经过一次又一次的思考,一遍又一遍的检查终于找出了原因所在,也暴露出了前期我在这方面的知识欠缺和经验不足。同时我也进一步认识了matlab软件强大的功能。在以后的学习和工作中必定有很大的用处。

Matlab最小二乘法拟合笔记

最小二乘法拟合 在科学实验的统计方法研究中,往往要从一组实验数据中寻找出自变量x 和因变量y之间的函数关系y=f(x) 。由于观测数据往往不够准确,因此并 不要求y=f(x)经过所有的点,而只要求在给定点上误差 按照某种标准达到最小,通常采用欧氏范数作为误差量度的标准。这就是所谓的最小二乘法。在MATLAB中实现最小二乘法拟合通常采用polyfit函数进行。 函数polyfit是指用一个多项式函数来对已知数据进行拟合,我们以下列数据为例介绍这个函数的用法: >> x=0:0.1:1; >> y=[ -0.447 1.978 3.28 6.16 7.08 7.34 7.66 9.56 9.48 9.30 11.2 ] 为了使用polyfit,首先必须指定我们希望以多少阶多项式对以上数据进行拟合,如果我们指定一阶多项式,结果为线性近似,通常称为线性回归。我们选择二阶多项式进行拟合。 >> P= polyfit (x, y, 2) P= -9.8108 20.1293 -0.0317 函数返回的是一个多项式系数的行向量,写成多项式形式为: 为了比较拟合结果,我们绘制两者的图形: >> xi=linspace (0, 1, 100); %绘图的X-轴数据。 >> Z=polyval (p, xi); %得到多项式在数据点处的值。 当然,我们也可以选择更高幂次的多项式进行拟合,如10阶: >> p=polyfit (x, y, 10); >> xi=linspace (0, 1,100);

>> z=ployval (p, xi); 读者可以上机绘图进行比较,曲线在数据点附近更加接近数据点的测量值了,但从整体上来说,曲线波动比较大,并不一定适合实际使用的需要,所以在进行高阶曲线拟合时,“越高越好”的观点不一定对的。

matlab建立多元线性回归模型并进行显著性检验及预测问题

matlab建立多元线性回归模型并进行显着性检验及预测问题 例子; x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; X=[ones(16,1) x]; 增加一个常数项Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; [b,bint,r,rint,stats]=regress(Y,X) 得结果:b = bint = stats = 即对应于b的置信区间分别为[,]、[,]; r2=, F=, p= p<, 可知回归模型y=+ 成立. 这个是一元的,如果是多元就增加X的行数! function [beta_hat,Y_hat,stats]=regress(X,Y,alpha) % 多元线性回归(Y=Xβ+ε)MATLAB代码 %? % 参数说明 % X:自变量矩阵,列为自变量,行为观测值 % Y:应变量矩阵,同X % alpha:置信度,[0 1]之间的任意数据 % beta_hat:回归系数 % Y_beata:回归目标值,使用Y-Y_hat来观测回归效果 % stats:结构体,具有如下字段 % =[fV,fH],F检验相关参数,检验线性回归方程是否显着 % fV:F分布值,越大越好,线性回归方程越显着 % fH:0或1,0不显着;1显着(好) % =[tH,tV,tW],T检验相关参数和区间估计,检验回归系数β是否与Y有显着线性关系 % tV:T分布值,beta_hat(i)绝对值越大,表示Xi对Y显着的线性作用% tH:0或1,0不显着;1显着 % tW:区间估计拒绝域,如果beta(i)在对应拒绝区间内,那么否认Xi对Y显着的线性作用 % =[T,U,Q,R],回归中使用的重要参数 % T:总离差平方和,且满足T=Q+U % U:回归离差平方和 % Q:残差平方和 % R∈[0 1]:复相关系数,表征回归离差占总离差的百分比,越大越好% 举例说明 % 比如要拟合y=a+b*log(x1)+c*exp(x2)+d*x1*x2,注意一定要将原来方程线化% x1=rand(10,1)*10; % x2=rand(10,1)*10; % Y=5+8*log(x1)+*exp(x2)+*x1.*x2+rand(10,1); % 以上随即生成一组测试数据 % X=[ones(10,1) log(x1) exp(x2) x1.*x2]; % 将原来的方表达式化成Y=Xβ,注意最前面的1不要丢了

matlab多元线性回归模型

云南大学数学与统计学实验教学中心 实验报告 一、实验目的 1.熟悉MATLAB的运行环境. 2.学会初步建立数学模型的方法 3.运用回归分析方法来解决问题 二、实验内容 实验一:某公司出口换回成本分析 对经营同一类产品出口业务的公司进行抽样调查,被调查的13家公司,其出口换汇成本与商品流转费用率资料如下表。试分析两个变量之间的关系,并估计某家公司商品流转费用率是6.5%的出口换汇成本. 实验二:某建筑材料公司的销售量因素分析 下表数据是某建筑材料公司去年20个地区的销售量(Y,千方),推销开支、实际帐目数、同类商品

竞争数和地区销售潜力分别是影响建筑材料销售量的因素。1)试建立回归模型,且分析哪些是主要的影响因素。2)建立最优回归模型。 提示:建立一个多元线性回归模型。

三、实验环境 Windows 操作系统; MATLAB 7.0. 四、实验过程 实验一:运用回归分析在MATLAB 里实现 输入:x=[4.20 5.30 7.10 3.70 6.20 3.50 4.80 5.50 4.10 5.00 4.00 3.40 6.90]'; X=[ones(13,1) x]; Y=[1.40 1.20 1.00 1.90 1.30 2.40 1.40 1.60 2.00 1.00 1.60 1.80 1.40]'; plot(x,Y,'*'); [b,bint,r,rint,stats]=regress(Y,X,0.05); 输出: b = 2.6597 -0.2288 bint = 1.8873 3.4322 -0.3820 -0.0757 stats = 0.4958 10.8168 0.0072 0.0903 即==1,0?6597.2?ββ,-0.2288,0?β的置信区间为[1.8873 3.4322],1,?β的置信区间为[-0.3820 -0.0757]; 2r =0.4958, F=10.8168, p=0.0072 因P<0.05, 可知回归模型 y=2.6597-0.2288x 成立. 1 1.5 2 2.5 散点图 估计某家公司商品流转费用率是6.5%的出口换汇成本。将x=6.5代入回归模型中,得到 >> x=6.5; >> y=2.6597-0.2288*x y = 1.1725

多元回归分析matlab剖析

回归分析MATLAB 工具箱 一、多元线性回归 多元线性回归:p p x x y βββ+++=...110 1、确定回归系数的点估计值: 命令为:b=regress(Y , X ) ①b 表示???? ?? ????????=p b βββ?...??10 ②Y 表示????????????=n Y Y Y Y (2) 1 ③X 表示??? ??? ????? ???=np n n p p x x x x x x x x x X ...1......... .........1 (12) 1 22221 11211 2、求回归系数的点估计和区间估计、并检验回归模型: 命令为:[b, bint,r,rint,stats]=regress(Y ,X,alpha) ①bint 表示回归系数的区间估计. ②r 表示残差. ③rint 表示置信区间. ④stats 表示用于检验回归模型的统计量,有三个数值:相关系数r 2、F 值、与F 对应的概率p. 说明:相关系数2 r 越接近1,说明回归方程越显著;)1,(1-->-k n k F F α时拒绝0H ,F 越大,说明回归方程越显著;与F 对应的概率p α<时拒绝H 0,回归模型成立. ⑤alpha 表示显著性水平(缺省时为0.05) 3、画出残差及其置信区间. 命令为:rcoplot(r,rint) 例1.如下程序. 解:(1)输入数据. x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; X=[ones(16,1) x]; Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; (2)回归分析及检验. [b,bint,r,rint,stats]=regress(Y ,X) b,bint,stats 得结果:b = bint =

matlab 最小二乘最优问题

最小二乘最优问题(转) 默认分类2009-05-21 14:56:33 阅读62 评论1 字号:大中小 1.约束线性最小二乘 有约束线性最小二乘的标准形式为 sub.to 其中:C、A、Aeq 为矩阵;d、b、beq、lb、ub、x 是向量。 在MA TLAB5.x 中,约束线性最小二乘用函数conls 求解。 函数lsqlin 格式x = lsqlin(C,d,A,b) %求在约束条件下,方程Cx = d 的最小二乘解x。 x = lsqlin(C,d,A,b,Aeq,beq) %Aeq、beq 满足等式约束,若没有不等式约束,则设A=[ ],b=[ ]。 x = lsqlin(C,d,A,b,Aeq,beq,lb,ub) %lb、ub 满足,若没有等式约束,则Aeq=[ ],beq=[ ]。 x = lsqlin(C,d,A,b,Aeq,beq,lb,ub,x0) % x0 为初始解向量,若x 没有界,则lb=[ ],ub=[ ]。 x = lsqlin(C,d,A,b,Aeq,beq,lb,ub,x0,options) % options 为指定优化参 数 [x,resnorm] = lsqlin(...) % resnorm=norm(C*x-d)^2,即2-范数。 [x,resnorm,residual] = lsqlin(...) %residual=C*x-d,即残差。 [x,resnorm,residual,exitflag] = lsqlin(...) %exitflag 为终止迭代的条 件 [x,resnorm,residual,exitflag,output] = lsqlin(...) % output 表示输出

Matlab回归分析

1、 考察温度x 对产量y 的影响,测得下列10组数据: 区间(置信度95%). x=[20:5:65]'; Y=[13.2 15.1 16.4 17.1 17.9 18.7 19.6 21.2 22.5 24.3]'; X=[ones(10,1) x]; plot(x,Y,'r*'); [b,bint,r,rint,stats]=regress(Y,X); b,bint,stats; rcoplot(r,rint) %残差分析,作残差图 结果: b = 9.1212 0.2230 bint = 8.0211 10.2214 0.1985 0.2476 stats = 0.9821 439.8311 0.0000 0.2333 即01 ??9.1212,0.2230ββ==;0?β的置信区间为[8.0211,10.2214]1?β的置信区间为[0.1985,0.2476]; 2r =0.9821 , F=439.831, p=0.0000 ,p<0.05, 可知回归模型 y=9.1212+0.2230x 成立. 将x=42带入得到18.4872.

从残差图可以看出,所有数据的残差离零点均较近,且残差的置信区间均包含零点,这说明回归模型y=9.1212+0.2230x能较好的符合原始数据。 2 某零件上有一段曲线,为了在程序控制机床上加工这一零件,需要求这段曲线的解析表达式,在曲线横坐标xi处测得纵坐标yi共11对数据如下: 求这段曲线的纵坐标y关于横坐标x的二次多项式回归方程。 t=0:2:20; s=[0.6 2.0 4.4 7.5 11.8 17.1 23.3 31.2 39.6 49.7 61.7]; T=[ones(11,1) ,t',(t.^2)']; [b,bint,r,rint,stats]=regress(s',T); b,stats; Y=polyconf(p,t,S) plot(t,s,'k+',t,Y,'r') %预测及作图 b = 1.0105 0.1971 0.1403

MATLAB---回归预测模型

MATLAB---回归预测模型 Matlab统计工具箱用命令regress实现多元线性回归,用的方法是最小二乘法,用法是: b=regress(Y,X) [b,bint,r,rint,stats]=regress(Y,X,alpha) Y,X为提供的X和Y数组,alpha为显著性水平(缺省时设定为0.05),b,bint 为回归系数估计值和它们的置信区间,r,rint为残差(向量)及其置信区间,stats是用于检验回归模型的统计量,有四个数值,第一个是R2,第二个是F,第三个是与F对应的概率 p ,p <α拒绝 H0,回归模型成立,第四个是残差的方差 s2 。 残差及其置信区间可以用 rcoplot(r,rint)画图。 例1合金的强度y与其中的碳含量x有比较密切的关系,今从生产中收集了一批数据如下表 1。 先画出散点图如下: x=0.1:0.01:0.18; y=[42,41.5,45.0,45.5,45.0,47.5,49.0,55.0,50.0]; plot(x,y,'+') 可知 y 与 x 大致上为线性关系。

设回归模型为 y =β 0 +β 1 x 用regress 和rcoplot 编程如下: clc,clear x1=[0.1:0.01:0.18]'; y=[42,41.5,45.0,45.5,45.0,47.5,49.0,55.0,50.0]'; x=[ones(9,1),x1]; [b,bint,r,rint,stats]=regress(y,x); b,bint,stats,rcoplot(r,rint) 得到 b =27.4722 137.5000 bint =18.6851 36.2594 75.7755 199.2245 stats =0.7985 27.7469 0.0012 4.0883 即β 0=27.4722 β 1 =137.5000 β0的置信区间是[18.6851,36.2594], β1的置信区间是[75.7755,199.2245]; R2= 0.7985 , F = 27.7469 , p = 0.0012 , s2 =4.0883 。 可知模型(41)成立。 观察命令 rcoplot(r,rint)所画的残差分布,除第 8 个数据外其余残差的置信区间均包含零点第8个点应视为异常点,

最小二乘法MATLAB程序及结果

最小二乘递推算法的MATLAB仿真 针对辨识模型,有z(k)-+a1*z(k-1)+a2*z(k-2)=b1*u(k-1)+b2*u(k-2)+v(k)模型结构,对其进行最小二乘递推算法的MATLAB仿真,对比真值与估计值。更改a1、a2、b1、b2参数,观察结果。 仿真对象:z(k)-1.5*z(k-1)+0.7*z(k-2)=u(k-1)+0.5*u(k-2)+v(k) 程序如下: L=15; y1=1;y2=1;y3=1;y4=0; %四个移位寄存器的初始值 for i=1:L; %移位循环 x1=xor(y3,y4); x2=y1; x3=y2; x4=y3; y(i)=y4; %取出作为输出信号,即M序列 if y(i)>0.5,u(i)=-0.03; %输入信号 else u(i)=0.03; end y1=x1;y2=x2;y3=x3;y4=x4; end figure(1); stem(u),grid on z(2)=0;z(1)=0; for k=3:15; z(k)=1.5*z(k-1)-0.7*z(k-2)+u(k-1)+0.5*u(k-2); %输出采样信号 end c0=[0.001 0.001 0.001 0.001]'; %直接给出被识别参数的初始值 p0=10^6*eye(4,4); %直接给出初始状态P0 E=0.000000005; c=[c0,zeros(4,14)]; e=zeros(4,15); for k=3:15; %开始求k h1=[-z(k-1),-z(k-2),u(k-1),u(k-2)]'; x=h1'*p0*h1+1; x1=inv(x); k1=p0*h1*x1; %开始求k的值 d1=z(k)-h1'*c0;c1=c0+k1*d1; e1=c1-c0; e2=e1./c0; %求参数的相对变化 e(:,k)=e2; c0=c1; c(:,k)=c1; p1=p0-k1*k1'*[h1'*p0*h1+1]; %求出P(k)的值 p0=p1;

Matlab多变量回归分析教程

本次教程的主要内容包含: 一、多元线性回归 2# 多元线性回归:regress 二、多项式回归 3# 一元多项式:polyfit或者polytool 多元二项式:rstool或者rsmdemo 三、非线性回归 4# 非线性回归:nlinfit 四、逐步回归 5# 逐步回归:stepwise 一、多元线性回归 多元线性回归: 1、b=regress(Y, X ) 确定回归系数的点估计值

2、[b, bint,r,rint,stats]=regress(Y,X,alpha)求回归系数的点估计和区间估计、并检验回归模型 ①bint表示回归系数的区间估计. ②r表示残差 ③rint表示置信区间 ④stats表示用于检验回归模型的统计量,有三个数值:相关系数r2、F值、与F对应的概率p 说明:相关系数r2越接近1,说明回归方程越显著;时拒绝H0,F越大,说明回归方程越显著;与F对应的概率p<α时拒绝H0 ⑤alpha表示显著性水平(缺省时为0.05) 3、rcoplot(r,rint)画出残差及其置信区间 具体参见下面的实例演示 4、实例演示,函数使用说明 (1)输入数据 1.>>x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; 2.>>X=[ones(16,1) x]; 3.>>Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; 复制代码 (2)回归分析及检验 1. >> [b,bint,r,rint,stats]=regress(Y,X) 2. 3. b = 4. 5. -1 6.0730 6.0.7194 7. 8. 9.bint =

最小二乘定位解算matlab代码

R1=6378137; C=3e8; DeltaT=1e-3; SatellitePosition=[177461757273651;12127-9774210911;13324-181********;14000 -130********;19376-15756-73651;zeros(19,4);6400200-12000]; SatellitePosNew=ones(1,3); VisSatNum=0; %VisSatNum:可见的卫星个数; CalculateOK=1; for k=1:24 if(SatellitePosition(k,4)==1) VisSatNum=VisSatNum+1; SatellitePosNew=[SatellitePosNew;SatellitePosition(k,1:3)]; end end SatellitePosNew(1,:)=[];%把SatellitePosNew的第一行去掉 if(VisSatNum<4) CalculateOK=0; CalUserPosition=[000]; return end Prange=ones(1,VisSatNum); UserPos=SatellitePosition(25,1:3); for n=1:VisSatNum Prange(1,n)= sqrt((SatellitePosNew(n,:)-UserPos)*(SatellitePosNew(n,:)-UserPos)')+C*DeltaT; end CalculateRecord=[111]; XYZ0=[6400100-1200]; DeltaT0=0; Wxyz=SatellitePosNew; Error=1000; ComputeTime=0; while((Error>1)&(ComputeTime<1000)) ComputeTime=ComputeTime+1; R=ones(1,VisSatNum); for n=1:VisSatNum R(1,n)=sqrt((Wxyz(n,:)-XYZ0)*(Wxyz(n,:)-XYZ0)')+DeltaT*C;%DeltaT0???? end

matlab中回归分析实例分析

1.研究科研人员的年工资与他的论文质量、工作年限、获得资助指标之间的关系.24位科研人员的调查数据(ex81.txt): 设误差ε~(0,σ 2 ), 建立回归方程; 假定某位人员的观测值 , 预测年工资及置信度为 95%的置信区间. 程序为:A=load('ex81.txt') Y=A(:,1) X=A(1:24,2:4) xx=[ones(24,1) X] b = regress(Y,X) Y1=xx(:,1:4)*b x=[1 5.1 20 7.2] s=sum(x*b) 调出Y 和X 后,运行可得: b = 17.8469 1.1031 0.3215 1.2889 010203(,,)(5.1,20,7.2)x x x =

x = 1.0000 5.1000 20.0000 7.2000 s = 39.1837 所以,回归方程为:Y= 17.8469+1.1031X1+0.3215X2+1.2889X3+ε 当 时,Y=39.1837 2、 54位肝病人术前数据与术后生存时间(ex82.txt,指标依次为凝血值,预后指数,酵素化验值,肝功能化验值,生存时间). (1) 若用线性回归模型拟合, 考察其各假设合理性; (2) 对生存是时间做对数变换,用线性回归模型拟合, 考察其各假设合理性; (3) 做变换 用线性回归模型拟合, 考察其各假设合理性; (4) 用变量的选择准则,选择最优回归方程 010203 (,,)(5.1,20,7.2)x x x =0.0710.07 Y Z -=

(5)用逐步回归法构建回归方程 程序为:A=load('ex82.txt') Y=A(:,5) X=A(1:54,1:4) xx=[ones(54,1) X] [b,bint,r,rint,stats]=regress(Y,xx) 运行结果为: b = -621.5976 33.1638 4.2719 4.1257 14.0916 bint = -751.8189 -491.3762 19.0621 47.2656 3.1397 5.4040 3.0985 5.1530 -11.0790 39.2622

Matlab实现多元回归实例

Matlab 实现多元回归实例 (一)一般多元回归 一般在生产实践和科学研究中,人们得到了参数(),,n x x x =???1和因变量y 的数据,需要求出关系式()y f x =,这时就可以用到回归分析的方法。如果只考虑 f 是线性函数的情形,当自变量只有一个时,即,(),,n x x x =???1中n =1时,称 为一元线性回归,当自变量有多个时,即,(),,n x x x =???1中n ≥2时,称为多元线性回归。 进行线性回归时,有4个基本假定: ① 因变量与自变量之间存在线性关系; ② 残差是独立的; ③ 残差满足方差奇性; ④ 残差满足正态分布。 在Matlab 软件包中有一个做一般多元回归分析的命令regeress ,调用格式如下: [b, bint, r, rint, stats] = regress(y,X,alpha) 或者 [b, bint, r, rint, stats] = regress(y,X) 此时,默认alpha = 0.05. 这里,y 是一个1n ?的列向量,X 是一个()1n m ?+的矩阵,其中第一列是全1向量(这一点对于回归来说很重要,这一个全1列向量对应回归方程的常数项),一般情况下,需要人工造一个全1列向量。回归方程具有如下形式: 011m m y x x λλλε=++???++ 其中,ε是残差。 在返回项[b,bint,r,rint,stats]中, ①01m b λλλ=???是回归方程的系数; ②int b 是一个2m ?矩阵,它的第i 行表示i λ的(1-alpha)置信区间; ③r 是1n ?的残差列向量; ④int r 是2n ?矩阵,它的第i 行表示第i 个残差i r 的(1-alpha)置信区间; 注释:残差与残差区间杠杆图,最好在0点线附近比较均匀的分布,而不呈现一定的规律性,如果是这样,就说明回归分析做得比较理想。 ⑤ 一般的,stast 返回4个值:2R 值、F_检验值、阈值f ,与显著性概率相关的p 值(如果这个p 值不存在,则,只输出前3项)。注释:

matlab最小二乘法

4. 设某物理量Y与X 满足关系式Y=aX2+bX+c,实验获得一批数据如 下表,试辨识模型参数a,b和c 。(50分) X 1.01 2.03 3.02 4.015 6.027.038.049.0310 Y9.6 4.1 1.30.40.050.10.7 1.8 3.89.0单,最后给出结果及分析。 (1) 问题描述: 由题意知,这是一个已知模型为Y=aX2+bX+c,给出了10组实验输入输出数据,要求对模型参数a,b,c进行辨识。这里对该模型参数辨识采用递推最小二乘法。 (2) 参数估计原理 对该模型参数辨识采用递推最小二乘法,即RLS(recurisive least square),它是一种能够对模型参数进行在线实时估计的辨识方法。 其基本思想可以概括为:新的估计值=旧的估计值+修正项 下面将批处理最小二乘法改写为递推形式即递推最小二乘参数估计的计算方法。 批处理最小二乘估计为,设k时刻的批处理最小二乘估计为: 令 K时刻的最小二乘估计可以表示为 = =;式中,因为要推导出P(k)和K(k)的递推方程,因此这里介绍一下矩阵求逆引理:设A、(A+BC)和(I+)均为非奇异方阵,则通过运用矩阵求逆引理,把复杂的矩阵求逆转化为标量求倒数,大大减小了计算量。与间的递推关系。最终得到递推最小二乘参数递推估计公式如下: (3)程序流程图 (如右图1所示) 递推最小二乘法(RLS)步骤如下: 已知:、和d。 Step 1 :设置初值和P(0),输入初始数据; Step2 :采样当前输出y(k)、和输入u(k) Step3 :利用上面式计算、和; Step4 :kk+1,返回step2,继续循环。

利用MATLAB进行回归分析及应用

利用MATLAB进行回归分析 一、实验目的: 1.了解回归分析的基本原理,掌握MATLAB实现的方法; 2. 练习用回归分析解决实际问题。 二、实验内容: 题目1 社会学家认为犯罪与收入低、失业及人口规模有关,对20个城市的犯罪率y(每10万人中犯罪的人数)与年收入低于5000美元家庭的百分比1x、失业率2x和人口总数3x(千人)进行了调查,结果如下表。 (1)若1x~3x中至多只许选择2个变量,最好的模型是什么? (2)包含3个自变量的模型比上面的模型好吗?确定最终模型。 (3)对最终模型观察残差,有无异常点,若有,剔除后如何。 理论分析与程序设计: 为了能够有一个较直观的认识,我们可以先分别作出犯罪率y与年收入低于5000美元家庭的百分比1x、失业率2x和人口总数 x(千人)之间关系的散点图,根据大致分布粗略估计各因素造 3 成的影响大小,再通过逐步回归法确定应该选择哪几个自变量作为模型。

编写程序如下: clc; clear all; y=[11.2 13.4 40.7 5.3 24.8 12.7 20.9 35.7 8.7 9.6 14.5 26.9 15.7 36.2 18.1 28.9 14.9 25.8 21.7 25.7]; %犯罪率(人/十万人) x1=[16.5 20.5 26.3 16.5 19.2 16.5 20.2 21.3 17.2 14.3 18.1 23.1 19.1 24.7 18.6 24.9 17.9 22.4 20.2 16.9]; %低收入家庭百分比 x2=[6.2 6.4 9.3 5.3 7.3 5.9 6.4 7.6 4.9 6.4 6.0 7.4 5.8 8.6 6.5 8.3 6.7 8.6 8.4 6.7]; %失业率 x3=[587 643 635 692 1248 643 1964 1531 713 749 7895 762 2793 741 625 854 716 921 595 3353]; %总人口数(千人) figure(1),plot(x1,y,'*'); figure(2),plot(x2,y,'*'); figure(3),plot(x3,y,'*'); X1=[x1',x2',x3']; stepwise(X1,y) 运行结果与结论:

matlab与统计回归分析解析

一Matlab作方差分析 方差分析是分析试验(或观测)数据的一种统计方法。在工农业生产和科学研究中,经常要分析各种因素及因素之间的交互作用对研究对象某些指标值的影响。在方差分析中,把试验数据的总波动(总变差或总方差)分解为由所考虑因素引起的波动(各因素的变差)和随机因素引起的波动(误差的变差),然后通过分析比较这些变差来推断哪些因素对所考察指标的影响是显著的,哪些是不显著的。 【例1】(单因素方差分析)一位教师想要检查3种不同的教学方法的效果,为此随机地选取水平相当的15位学生。把他们分为3组,每组5人,每一组用一种方法教学,一段时间以后,这位教师给15位学生进行统考,成绩见下表1。问这3种教学方法的效果有没有显著差异。 表1 学生统考成绩表 Matlab中可用函数anova1(…)函数进行单因子方差分析。 调用格式:p=anova1(X) 含义:比较样本m×n的矩阵X中两列或多列数据的均值。其中,每一列表示一个具有m 个相互独立测量的独立样本。 返回:它返回X中所有样本取自同一总体(或者取自均值相等的不同总体)的零假设成立的概率p。

解释:若p 值接近0(接近程度有解释这自己设定),则认为零假设可疑并认为至少有一个样本均值与其它样本均值存在显著差异。 Matlab 程序: Score=[75 62 71 58 73;81 85 68 92 90;73 79 60 75 81]’; P=anova1(Score) 输出结果:方差分析表和箱形图 ANOVA Table Source SS df MS F Prob>F Columns 604.9333 2 302.4667 4.2561 0.040088 Error 852.8 12 71.0667 Total 1457.7333 14 1 2 3 60 65707580 8590V a l u e s Column Number 由于p 值小于0.05,拒绝零假设,认为3种教学方法存在显著差异。

最小二乘法matlab多项式拟合

最小二乘法拟合探究 吴春晖 (中国海洋大学海洋环境学院山东青岛 266100) 摘要: 本文的拟合对象为含多个变量的待定系数的多项式。通过最小二乘法对多项式作出拟合,以向量矩阵的形式来解出待定的系数。在matlab中,通过算法,写出具体的解法。之后,先对最小二乘法的准确性作出检验,分析该方法在应对复杂情况的误差。在检验该方法的可行性之后,对给定的变量值进行拟合与解题。同时,本文将对基于Laguerre多项式的最小二乘法进行分析检验, 关键词:最小二乘法拟合多变量Laguerre多项式 引言: 在之前的计算方法中,在给出已知节点后,如果需要根据给出的节点来确定未知节点的值,我们需要运用插值。在对插值的精准性进行分析后,我们发现不同插值方式的误差都极大,而且插值所得出的函数的特征由插值方式所决定,并不能反映具体的节点原来可能的规律与分布。所以,拟合的方法相比插值而言,并不要求函数值在原节点处的值相等,却能在一定程度上反映原函数的规律。在该文中,我们主要运用最小二乘法进行拟合。

目录 第一章matlab最小二乘法拟合程序 (3) 1.1最小二乘法拟合的数学法 (3) 1.2 编写最小二乘法的matlab拟合程序 (3) 1.2.1程序算法 (3) 1.2.2 最小二乘法拟合的程序 (4) 1.3程序的分析说明 (4) 第二章最小二乘拟合法的检验及应用 (5) 2.1 最小二乘法拟合的检验 (5) 2.2最小二乘法拟合的实际应用 (7) 第三章Laguerre多项式的最小二乘拟合 (8) 3.1 算法与程序 (8) 3.2检验与分析 (9) 第四章最小二乘法拟合的分析总结 (11)

系统辨识最小二乘参数估计matlab

最小二乘参数估计 摘要: 最小二乘的一次性完成辨识算法(也称批处理算法),他的特点是直接利用已经获得的所有(一批)观测数据进行运算处理。这种算法在使用时,占用内存大,离线辨识,观测被辨识对象获得的新数据往往是逐次补充到观测数据集合中去的。在应用一次完成算法时,如果要求在每次新增观测数据后,接着就估计出系统模型的参数,则需要每次新增数据后要重新求解矩阵方程()Z l T l l T l ΦΦΦ-∧=1θ。 最小二乘辩识方法在系统辩识领域中先应用上已相当普及,方法上相当完善,可以有效的用于系统的状态估计,参数估计以及自适应控制及其他方面。 关键词: 最小二乘(Least-squares ),系统辨识(System Identification ) 目录: 1.目的 (2) 2.设备 (2) 3引言 (2) 课题背景 (2) 4数学模型的结构辨识 (3) 5 程序 (4) M 序列子函数 (4) 主程序 (5) 6实验结果: (7) 7参考文献: (7) 1.目的 掌握系统辨识的理论、方法及应用 熟练Matlab 下最小二乘法编程 掌握M 序列产生方法 2.设备 PC 机1台(含Matlab 软件) 3引言 课题背景 最小二乘理论是有高斯()在1795年提出:“未知量的最大可能值是这样一个数值,它使各次实际观测值和计算值之间的差值的平方乘以度量其精度的数值以后的和最小。”这就是最小二乘法的最早思想。 最小二乘辨识方法提供一个估算方法,使之能得到一个在最小方差意义上与实验数据最好拟合的数学模型。递推最小二乘法是在最小二乘法得到的观测数据的基础上,用新引入的

数据对上一次估计的结果进行修正递推出下一个参数估计值,直到估计值达到满意的精确度为止。 4数学模型的结构辨识 根据汉格尔矩阵估计模型的阶次 设一个可观可控的SISO 过程的脉冲响应序列为{个g(1),g(2),……g(L)},可以通过汉格尔(Hankel )矩阵的秩来确定系统的阶次。 令Hankel 阵为: ????? ???????-++-++++-++=)22()1()1()()2()1()1()1()(),(l k g k g l k g l k g k g k g l k g k g k g k l H ,其中l 决定),(k l H 阵地维数,k 可在1至()22+-l L 间任意选择。则有[]k n l n k l H rank ?≥=,,),(00。 如果0n l ≥(过程的真实阶次),那么Hankel 阵的秩等于0n 。因此可以利用Hankel 阵的奇异性来确定系统的阶次0n 。 根据残差平方和估计模型的阶次 SISO 过程的差分方程模型的输出残差为)(~k z ,数据长度L ,n H ?为n ?阶时的数据矩阵,n ??θ为n ?阶时的参数的估计量,n ?为模型阶次估计值,0n 为真实阶次,则残差平方和函数J : )(~1)?()?(1~~1)?(1 2??????00k z L H z H z L z z L n J L n n k n n n T n n n n T n ∑++==--==θθ 残差平方和有这样的性质:当L 足够大时,随着n ?增加)?(n J 先是显著地下降,当n ?>0n 时,)?(n J 值显著下降的现象就终止。这就是损失函数法来定阶的原理。

利用Matlab进行线性回归分析

利用Matlab进行线性回归分析 回归分析是处理两个及两个以上变量间线性依存关系的统计方法。可以通过软件Matlab实现。 1.利用Matlab软件实现 在Matlab中,可以直接调用命令实现回归分析, (1)[b,bint,r,rint,stats]=regress(y,x),其中b是回归方程中的参数估计值,bint是b的置信区间,r和rint分别表示残差及残差对应的置信区间。stats包含三个数字,分别是相关系数,F统计量及对应的概率p值。 (2)recplot(r,rint)作残差分析图。 (3)rstool(x,y)一种交互式方式的句柄命令。 以下通过具体的例子来说明。 例现有多个样本的因变量和自变量的数据,下面我们利用Matlab,通过回归分析建立两者之间的回归方程。 % 一元回归分析 x=[1097 1284 1502 1394 1303 1555 1917 2051 2111 2286 2311 2003 2435 2625 2948 3, 55 3372];%自变量序列数据 y=[698 872 988 807 738 1025 1316 1539 1561 1765 1762 1960 1902 2013 2446 2736 2825];%因变量序列数据 X=[ones(size(x')),x'],pause [b,bint,r,rint,stats]=regress(y',X,0.05),pause%调用一元回归分析函数 rcoplot(r,rint)%画出在置信度区间下误差分布。

% 多元回归分析 % 输入各种自变量数据 x1=[5.5 2.5 8 3 3 2.9 8 9 4 6.5 5.5 5 6 5 3.5 8 6 4 7.5 7]'; x2=[31 55 67 50 38 71 30 56 42 73 60 44 50 39 55 7040 50 62 59]'; x3=[10 8 12 7 8 12 12 5 8 5 11 12 6 10 10 6 11 11 9 9]'; x4=[8 6 9 16 15 17 8 10 4 16 7 12 6 4 4 14 6 8 13 11]'; %输入因变量数据 y=[79.3 200.1 163.1 200.1 146.0 177.7 30.9 291.9 160 339.4 159.6 86.3 237.5 107.2 155 201.4 100.2 135.8 223.3 195]'; X=[ones(size(x1)),x1,x2,x3,x4]; [b,bint,r,rint,stats]=regress(y,X)%回归分析 Q=r'*r sigma=Q/18 rcoplot(r,rint); %逐步回归 X1=[x1,x2,x3,x4]; stepwise(X1,y,[1,2,3])%逐步回归 % X2=[ones(size(x1)),x2,x3]; % X3=[ones(size(x1)),x1,x2,x3]; % X4=[ones(size(x1)),x2,x3,x4]; % [b1,b1int,r1,r1int,stats1]=regress(y,X2) % [b2,b2int,r2,r2int,stats2]=regress(y,X3); % [b3,b3int,r3,r3int,stats3]=regress(y,X4);