基于点特征匹配的SUSAN_Harris算子比较

第27卷 第4期2007年12月

西安科技大学学报

JOURNAL OF XI′AN UN I V ERSI TY OF S C I E NCE AND TECHNOLOGY

Vol.27 No14

Dec12007

文章编号:1672-9315(2007)04-0608-04

基于点特征匹配的SUS AN,Harris算子比较3

张春森

(西安科技大学测量工程系,陕西西安710054)

摘 要:基于点特征的影像匹配是计算机视觉界比较流行的匹配方法,包括特征提取和特征匹配2个步骤。在介绍保持结构的形态学方法———S US AN算子和Harris算子原理的基础上,根据真实影像,就特征点提取的数量、分布及匹配有效性等方面对上述2种算子进行分析比较。编程实现S US AN,Harris算子影像的点特征提取,基于匹配支持度的松弛匹配算法,从而获得研究实验数据。实验表明:这2种算子在特征提取及影像匹配等方面各自具有其独特的优势,且均具有操作简单、易于实现的特点。

关键词:S US AN算子;Harris算子;点特征提取;影像匹配

中图分类号:TP751 文献标识码:A

Compare S USAN and Harris corner detector

based on poi n t feature matchi n g

ZHANG Chun2sen

(D ept.of Survey Engineering,X i′an U niversity of Science and Technology,X i′an710054,China)

Abstract:The method of matching based on point feature is popular in computer visi on.It includes t w o step s,which are feature extracti on and feature matching.After intr oducing the p rinci p le of S US AN, which is structure p reserving mor phol ogical operati on and Harris corner detect or,we compared and ana2 lyzed the t w o corner detect or fr om the a mount of interest points they p icked up,distributing and validity of matching etc.The experi m ent indicates that the t w o kinds of corner detect or have their own unique advantages.

Key words:S US AN&Harris operat or;feature extracti on;i m age matching

0 引 言

从图像中提取特征点是基于点特征影像匹配的第一步。这里的特征点通常是指灰度变化剧烈的点,包括物体轮廓上的曲率变化最大的点、直线的交点、单调背景上的孤立点等。关于特征点的提取通常采用[1]:①从图像中提取边缘,再在边缘组成的链上搜索曲率最大的,或采用通过精确得到组成交(角)点的2条边缘直线,求解边缘直线交点,从而确定交点特征的方法;②首先定义某种算子,通过在灰度图像上寻找该算子的极值提取特征点;③定义某种点模板,将模板与图像上同样大小的区域相匹配,把位于模板内图像的每个点乘以模板的相应栅格中指示的数据,然后把结果相加,得到最大输出值的点的位置,即为特

3收稿日期:2006-10-10

基金项目:陕西省教育厅专项科研计划项目(06KJ239)

作者简介:张春森(1963-),男,陕西西安人,博士,副教授,主要从事数字摄影测量、遥感应用及GI S方面的教学与研究.

征点坐标的位置。文中讨论方法②。需要说明的是所论述的点特征提取,主要是用于基于点特征的影像匹配,而不是用于影像分析和数字摄影测量中影像目标的精确定位。

1 SUSAN 点特征提取算子

[2]S US AN 算法由S m ith S M 在1997年提出,是“S mallest Univalue Seg ment A ssi m ilating Nucleus ”的缩写,

即同化核分割最小值

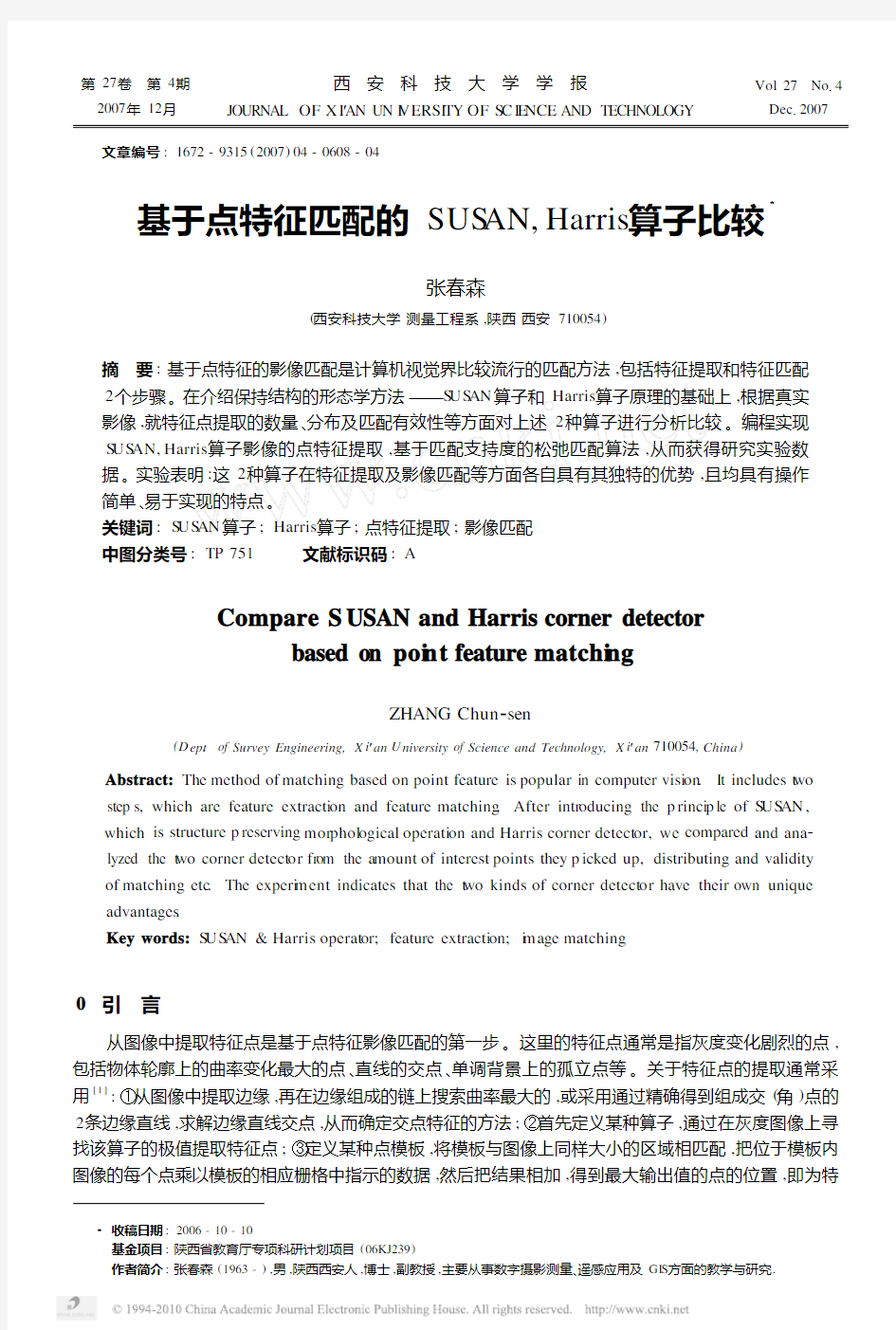

。图1 圆形掩模图Fig .1 The mask chart of circular

如图1所示,假设有一个圆形的区域,称其为掩模。它的中心有一

个核,假设这个核的灰度值与黑色区域的灰度值相近。在整个区域内

移动这个掩模,它与黑色区域将有不同的接触情况。不失一般性,在图

中表示了其中的4种情况:在掩模所处的区域内,这些点与掩模核的灰

度值如果相近的话,就称这些点构成的区域是US AN (Univalue Seg ment

A ssi m ilating Nucleus ),即同化核分割相同值区域。根据这一定义可知

图1各种情况下,由设定的掩模所确定的US AN 如图2所示。

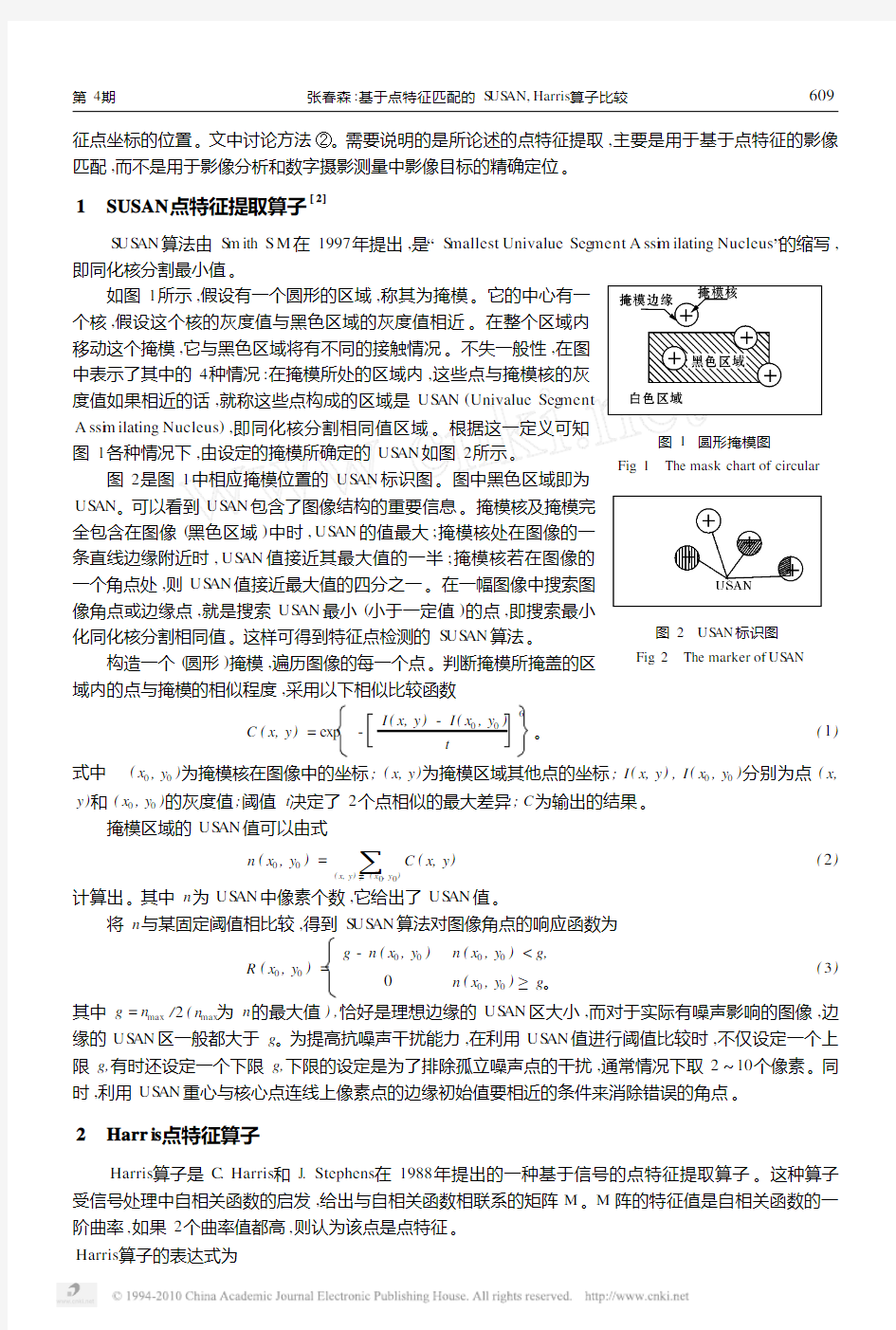

图2是图1中相应掩模位置的US AN 标识图

。图中黑色区域即为

图2 US AN 标识图Fig .2 The marker of US AN US AN 。可以看到US AN 包含了图像结构的重要信息。掩模核及掩模完全包含在图像(黑色区域)中时,US AN 的值最大;掩模核处在图像的一

条直线边缘附近时,US AN 值接近其最大值的一半;掩模核若在图像的

一个角点处,则US AN 值接近最大值的四分之一。在一幅图像中搜索图

像角点或边缘点,就是搜索US AN 最小(小于一定值)的点,即搜索最小

化同化核分割相同值。这样可得到特征点检测的S US AN 算法。

构造一个(圆形)掩模,遍历图像的每一个点。判断掩模所掩盖的区

域内的点与掩模的相似程度,采用以下相似比较函数

C (x,y )=exp -I (x,y )-I (x 0,y 0)

t 6。(1)

式中 (x 0,y 0)为掩模核在图像中的坐标;(x,y )为掩模区域其他点的坐标;I (x,y ),I (x 0,y 0)分别为点(x,y )和(x 0,y 0)的灰度值;阈值t 决定了2个点相似的最大差异;C 为输出的结果。

掩模区域的US AN 值可以由式

n (x 0,y 0)=

6(x,y )≠(x 0,y 0)C (x,y )(2)

计算出。其中n 为US AN 中像素个数,它给出了US AN 值。

将n 与某固定阈值相比较,得到S US AN 算法对图像角点的响应函数为

R (x 0,y 0)=g -n (x 0,y 0)n (x 0,y 0) 0n (x 0,y 0)≥g 。(3) 其中g =n max /2(n max 为n 的最大值),恰好是理想边缘的US AN 区大小,而对于实际有噪声影响的图像,边缘的US AN 区一般都大于g 。为提高抗噪声干扰能力,在利用US AN 值进行阈值比较时,不仅设定一个上限g,有时还设定一个下限g,下限的设定是为了排除孤立噪声点的干扰,通常情况下取2~10个像素。同时,利用US AN 重心与核心点连线上像素点的边缘初始值要相近的条件来消除错误的角点。 2 Harr is 点特征算子 Harris 算子是C .Harris 和J.Stephens 在1988年提出的一种基于信号的点特征提取算子。这种算子受信号处理中自相关函数的启发,给出与自相关函数相联系的矩阵M 。M 阵的特征值是自相关函数的一阶曲率,如果2个曲率值都高,则认为该点是点特征。 Harris 算子的表达式为 906第4期 张春森:基于点特征匹配的S US AN,Harris 算子比较 M =G (s ) g x g x g y g x g y g y ,(4)I =Det (M )-k Trac e 2(M ,k =0104)。 (5)式中 g x 为x 方向的梯度;g y 为y 方向的梯度;G (s )为高斯模板; 为卷积操作;I 为每点的兴趣值;Det 为矩阵的行列式;Trac 为矩阵的迹;k 为默认常数。 1)对操作的灰度图像的每个点,计算该点在横向和纵向的一阶导数,以及二者的乘积。这样可以得到3幅新的图像。3幅图像中的每个像素对应的属性值分别为g x ,g y 和g x g y 。对这3幅图像进行高斯滤波,最后计算原图像上对应的每个点的兴趣值I 。 2)Harris 算法认为,特征点是局部范围内的极大兴趣值对应的像素点。因此,在计算完各点的兴趣值后,要提取出原始图像中的所有局部兴趣值最大的点。实际操作中,可以依次取出每个像素的8邻域中的8个像素,从中心像素和这8个像素中提出最大值。如果中心点像素的兴趣值就是最大值,则该点就是特征点。 3)在用公式(5)提取特征点时,凡满足I 大于某一阈值T 的像素点均可被认为是特征点。阈值T 依赖于实际图像的属性如尺寸、纹理等,由于T 不具有直观的物理意义,其具体值难以确定,为此,采取间接确定T 的方法:即通过确定图像中所能提取的最大可能的特征点数目N max 来选择I 值最大的若干像素点作为特征点。局部极值点的数目往往很多,根据I 值进行排序,取其前N max 个为特征点。对特征点进行加权重心化,可使其达到子像素精度。公式中k 一般取0104。 3 实验分析 [3,4]通过双目立体视觉系统分别获取模型汽车的单幅影像与立体影像对,在V isual C ++610平台上编程实现对S US AN ,Harris 算子的点特征提取,并采用基于匹配支持度的松弛匹配算法对立体影像对进行匹配比 较。对于单幅影像,由于Harris 算子点特征提取操作是通过确定图像中所能提取的最大可能的特征点数目N max 来选择I 值最大的若干像素点作为特征点,因此,当采用Harris 算子提取同一目标物影像中的特征点时,可设置不同数目的N max 来观察提取特征点的分布和数量。图3表示当高斯模板方差为017,N max 分 别为100,200时的特征提取结果,其特征点数目分别为61,134。 图3 N max 分别为100,200的特征提取结果 Fig 13 The result of feature extracti on which N max is 100,200res pectively (a )N max =100 (b )N max =200 从影像可以看出,随着N max 的不同,提取出的特征点的数量和分布也不相同。在S US AN 算子特征提取中,包括掩模核与掩模区域中其他点灰度值最大差异的阈值t ,S US AN 算法对影像特征点响应的阈值g ,排除影像孤立噪声点干扰的阈值d 等多组阈值参数。相比之下,采用Harris 算子提取影像中的特征点,其阈值参数的选择就要简单得多,只需选择确定影像中所能提取的最大可能的特征点数目N max ,并可以此作为调整特征点分布的参考。 对于立体影像对,分别采用S US AN ,Harris 算子,在提取特征点数目基本相同的情况下(25,31),同时利用基于匹配支持度的松弛法匹配算法对其进行立体匹配。匹配结果如图4和图5所示。 016 西安科技大学学报 2007年 图4 基于S US AN 算子点特征提取匹配结果 Fig 14 Result of feature matching with S US AN operat or 图5 基于Harris 算子点特征提取匹配结果 Fig 15 Result of feature matching with Harris operat or 其中采用S US AN 算子提取特征点并进行立体匹配的正确率为80%,而采用Harris 算子提取特征点并进行影像匹配的正确率为9315%。分析发现,匹配采用S US AN 算子提取点特征并进行匹配的错误处,主要位于影像纹理相近处,如图中模型汽车顶部“HAT O BUS ”字样的角点处。对于影像纹理信息较丰富区域的角点,如模型汽车的车身部分,2种提取方法都能得到较好的匹配。从所提取特征点的分布看,在提取特征点数目基本相同的情况下,S US AN 算子提取的点特征均匀、合理,基本分布在角点明显处。Har 2ris 算子提取的特征点虽然也分布均匀,但在部分区域存在特征点冗余的现象(如图中模型汽车顶部“HA 2T O BUS ”字样处)。将影像放大比较,S US AN 算子提取的特征点位于边缘内(黑色区域);Harris 算子提取的特征点位于边缘外部(浅色区域),更加贴近特征点的最佳位置。从图4,图5还可看出,在纹理信息丰富的区域,S US AN 算子对明显角点提取的能力较强;在纹理相近处,Harris 算子提取角点的能力较强。 当对原始图像分别人为加入不同程度的平均噪声时,通过实验得出噪声对2种不同算子特征提取与影像匹配的影响结果(表1,表2)。 表1 Harr is 算子抗噪声效果 Tab 11 Result of resist no ise w ith Harr is opera tor 噪声强度 原始影像10%20%特征点数 312511错误点数 343正确率/%93158483表2 SUSAN 算子抗噪声效果Tab 12 Result of resist no ise w ith SUSAN opera tor 噪声强度原始影像10%20%特征点数252230错误点数5718正确率/%806840 从表中可以看出,随着噪声的逐渐增大,采用Harris 算子特征点提取并进行影像匹配的抗噪声能力较S US AN 算子强。这与Gouet “即使存在有图像的旋转、灰度的变化、噪声影响和视点的变化等情况,Harris 算子也是最稳定的一种点特征提取算子”的结论相一致。此外Harris 算子还具有对光照条件等情况不敏感的特性。[5,6] 4 结 论 利用Harris 算子不需设置阈值,整个过程的自动化程度高,可以根据匹配结果,定量调整提取的特征点数。同时具有抗干扰强、精度高的特点。S US AN 算子提取特征点分布合理,较适合提(下转第616页) 1 16第4期 张春森:基于点特征匹配的S US AN,Harris 算子比较 以优势互补,更好地发挥它们的作用,解决一些综合性的问题[8~12]。基于DE M 的电子地图实现了三维的DE M 和二维的电子地图的垂直集成,不仅极大地提高了电子地图的空间表现能力和量算水平,还大大地扩展了对DE M 的应用潜力。利用它还可以进行一些综合性的地图分析,但需要进一步探讨。 模型方法是地图分析中常有的、有效且很有潜力的一种方法。在常规的地图分析中,由于模型建立和解算的复杂性,在一定程度上制约了模型方法的应用。计算机强有力的数据处理能力为模型方法的应用创造了极好的条件。建立和应用好的模型可以促进地图量算精度与速度,以及地图信息的深入分析应用,有利于发挥地图的效益,是地图学研究的一项重要内容。 参考文献: [1] 刘光运,韩丽斌.电子地图技术与应用[M ].北京:测绘出版社,1996. [2] 李志林,朱 庆.数字高程模型[M ].第二版.武汉:武汉大学出版社,2003. [3] 张祖勋,张剑清.数字摄影测量学[M ].武汉:武汉大学出版社,1996. [4] 汤国安.计算机地学制图与分析[M ].西安:西北大学出版社,1994. [5] 杨永崇.基于AUT O CAD 测绘工业场地现状图的方法[J ].西安科技学院学报,2001,21(3):217-220. [6] 段虎荣,郭新成,丁 宁.最小二乘预估法在GPS 高程转换中的应用[J ].西安科技大学学报,2006,26(1):62-64.[7] 杨永崇,郭达志.基于地理坐标的数字地图量算模型[J ].西南交通大学学报,2005,40(3):318-321.[8] 郭岚.三维数字地形图及其应用的研究[J ].测绘通报,2002,(5):10-11. [9] 刘万林,郭 岚,王利.多面函数法与移动法的加权综合模型在GPS 水准中的应用[J ].西安科技大学学报,2004,24(3):310-312.[10]高俊1数字地图,21世纪测绘业的支柱[J ]1测绘通报,1999,(10):114-120. [11]国家自然科学基金委员会.地球空间信息科学[M ].北京:高等教育出版社,2001. [12]施加松,刘建忠13D GI S 技术研究发展综述[J ]1测绘科学,2005,30(5):117-119. (上接第611页) 取图像边缘上的拐点。由于它不需对图像求导数,所以也有较强的抗噪声能力。利用S US AN 算法提取图像拐点,阈值的选取是关键。它没有自适应算法,也不像Harris 算法可根据需要提出一定数目的特征点。该算法编程容易,易于硬件实现。为克服影像灰度值分布不均对提取S US AN 算子角点的影响,可对影像采取二值化(或多值化)分割,以进一步改进提取效果。 参考文献: [1] 李红梅,黄梦涛,田爱玲,等.亚像素级标定角点提取新算法[J ].西安科技大学学报,2006,26(4):536-540. [2] S m ith SM ,B rady J M.S US AN ———A ne w app r oach t o l ow level i m age p r ocessing[J ].Journal of V isi on,1997,23(1):45- 78. [3] 张春森.序列立体图像三维运动物体定位与跟踪[D ].武汉:武汉大学,2004. [4] 谢东海.改进Harris 算子用于点特征的精确定位[J ].测绘信息与工程,2003,28(2):22-23. [5] 管海燕.常用图像边缘检测算子定位精度对比研究[J ].测绘与空间地理信息,2005,12(1):36-40. [6] 张 迁,刘政凯,庞彦伟,等.基于S US AN 算法的航空影像的自动配准[J ].测绘学报,2003,32(3):245-250.616 西安科技大学学报 2007年 图像特征描述子之FREAK ?在前【给力追-女生资-源】面的博文中,介绍的BRIEF、ORB、BRISK 算法都是基于特征点周围邻域像素点对之间的比较,形成二进制编码串作为特征【QQ】描述子,这种描述方法计算速度快,且占用内存小,满足一些实时【⒈】应用场景的需求。对于这类特征描述子,关键是确定邻域哪些像【0】素点对进行比较,以及如何匹配。BRIEF算法中特征点邻域的像素【1】点对是随机采样生成的,ORB算法是通过贪婪穷举的方法,在所有【6】可能的像素点对中选取相关性较小的若干点对,BRISK则是采用平【9】均采样的方法生成若干采样点。特征匹配方法通常都是采样Ham【⒌】ming距离来进行度量,由于是二进制编码方式,可通过异或操作快速计【2】算。 特征点检【б】测 ?FAST算法可实现快速检测图像特征点,而且对应有一个加速版本AGAST,因此在诸多特征描述子中,都是首先通过FAST算法搜索定位特征点,再加以描述。FREAK同BRISK算法类似,也是建立多尺度空间,在不同尺度的图像上使用FAST算法检测特征点。 采样模式 ?FREAK算法中采样模式接近于人眼视网膜接收图像信息的采样模型,如下图所示,人眼视网膜中,Fovea区域主要对高精度的图像信息进行处理,而Para区域则主要对低精度的图像信息进行处理。 在FREAK的采样模式中,图中每一个黑点代表一个采样点,每个圆圈代表一个感受野,每个采样点需进行高斯模糊处理,以降低噪声影响,感受野的半径表示高斯模糊的标准差。这种采样模式与BRISK的不同之处在于,感受野之间存在重叠的区域;与BRIEF和ORB算法的不同之处在于,FREAK的采样点根据与特征点的距离远近,采用了不同大小的高斯核函数进行平滑处理。不同大小的感受野在人眼视网膜中也存在类似的结构,通过重叠的感受野,可以获得更多的信息,使最终的描述符更具独特性和可区分性。最终FREAK算法的采样结构为6、6、6、6、6、6、6、1,6代表每层中有6个采样点并且这6个采样点在一个同心圆上,一共有7个同心圆,最后的1表示特征点。 特征描述 ?FREAK算法同样采用二进制编码描述特征点,用FF表示编码特征 F=Σ0≤aN2aT(Pa) F=Sigma_{0 leq a < N} 2^a T(P_a) T(Pa)={1,I(Pr1a)I(Pr2a) 0,otherwise T(P_a) = begin{cases} 1,I(P_a^{r_1}) > I(P_a^{r_2}) 0,otherwise end{cases} 式中,I(Pr1a)I(P_a^{r_1})表示采样点经过高斯模糊后的灰度值。 ?FREAK的采样模式中一共有43个采样点,可以产生N=43(43?1)-2=903N = 43(43 - 1)-2 = 903个采样点对,有些采样点对的编码值对特征描述并没有实际作用,反而会造成特征冗余,因此需要对特征的描述向量进行筛选,也就是降维。原论文中采用与ORB中类似的贪婪 北京联合大学毕业设计(论文)开题报告 题目:基于图像特征提取与匹配的目标识别系统设计 专业:通信工程指导教师:韩玺 学院:信息学院学号:30 班级:2008080304430姓名:赵宇凡 一、课题任务与目的 1、课题的主要任务:以DSP平台为系统硬件平台,并基于DM6437为处理器核心,设计硬件原理图,编写特征点提取算法,使系统通过特征点匹配对静态目标进行识别。 2、课题的主要目的:设计并实现一个功能完整,操作简单的目标识别系统,使其能够对静态图像目标进行特征提取与匹配,从而进行目标识别。 二、调研资料情况 1、课题的学术状态: (1)DM6437关键特性 时钟频率达600MHz,1个TVP5146M2视频解码器4个视频DACV输出,128MDDR2DRAM,提供16M non-volatile flash memory, 64M NAND flash, 2M SRAM 提供UART, CAN,I/O接口,AIC33立体音频编码器,10/100 MBS以太网接口,可配置的boot load选项,嵌入式的JTAG仿真器接口,4个用户LEDs及4个用户切换点,提供子板扩展插槽,VLYNQ接口,提供S/PDIF接口。 (2)SIFT算法 从理论上说,SIFT是一种相似不变量,即对图像尺度变化和旋转是不变量。然而,由于构造SIFT特征时,在很多细节上进行了特殊处理,使得SIFT对图像的复杂变形和光照变化具有了较强的适应性,同时运算速度比较快,定位精度比较高。如:在多尺度空间采用DOG算子检测关键点,运算速度大大加快;关键点的精确定位不仅提高了精度,而且大大提高了关键点的稳定性;在构造描述子时,以子区域的统计特性,而不是以单个像素作为研究对象,提高了对图像局部变形的适应能力;对于16*16的关键点邻域和4*4的子区域,在处理梯度幅度时都进行了类似于高斯函数的加权处理,强化了中心区域,淡化了边缘区域的影响,从而提高了算法对几何变形的适应性;该方法不仅对通用的线 角点提取与匹配算法实验报告 1 说明 本文实验的目标是对于两幅相似的图像,通过角点检测算法,进而找出这两幅图像的共同点,从而可以把这两幅图像合并成一幅图像。 下面描述该实验的基本步骤: 1.本文所采用的角点检测算法是Harris 角点检测算法,该算法的基本原理是取以目标像素点为中心的一个小窗口,计算窗口沿任何方向移动后的灰度变化,并用解析形式表达。设以像素点(x,y)为中心的小窗口在X 方向上移动u ,y 方向上移动v ,Harris 给出了灰度变化度量的解析表达式: 2 ,,|,|,,()(x y x y x u y v x y x y I I E w I I w u v o X Y ??= -=++??∑∑ (1) 其中,,x y E 为窗口内的灰度变化度量;,x y w 为窗口函数,一般定义为2 2 2 ()/,x y x y w e σ +=; I 为图像灰度函数,略去无穷小项有: 222222 ,,[()()2]2x y x y x y x y E w u I v I uvI I Au Cuv Bv = ++=++∑ (2) 将,x y E 化为二次型有: ,[]x y u E u v M v ?? =???? (3) M 为实对称矩阵: 2 ,2 x y x x y x y y I I I M w I I I ???= ???????∑ (4) 通过对角化处理得到: 11 ,200x y E R R λλ-??= ??? (5) 其中,R 为旋转因子,对角化处理后并不改变以u,v 为坐标参数的空间曲面的形状,其特征值反应了两个主轴方向的图像表面曲率。当两个特征值均较小时,表明目标点附近区域为“平坦区域”;特征值一大一小时,表明特征点位于“边缘”上;只有当两个特征值均比较大时,沿任何方向的移动均将导致灰度的剧烈变化。Harris 的角点响应函数(CRF)表达式由此而得到: 2 (,)det()(())C RF x y M k trace M =- (6) 诚信声明 本人声明: 我所呈交的本科毕业设计论文是本人在导师指导下进行的研究工作及取得的研究成果。尽我所知,除了文中特别加以标注和致谢中所罗列的内容以外,论文中不包含其他人已经发表或撰写过的研究成果。与我一同工作的同志对本研究所做的任何贡献均已在论文中作了明确的说明并表示了谢意。本人完全意识到本声明的法律结果由本人承担。 申请学位论文与资料若有不实之处,本人承担一切相关责任。 本人签名:日期:2010 年05 月20日 毕业设计(论文)任务书 设计(论文)题目: 学院:专业:班级: 学生指导教师(含职称):专业负责人: 1.设计(论文)的主要任务及目标 (1) 了解图象匹配技术的发展和应用情况,尤其是基于特征的图象匹配技术的发展和应用。 (2) 学习并掌握图像匹配方法,按要求完成算法 2.设计(论文)的基本要求和内容 (1)查阅相关中、英文文献,完成5000汉字的与设计内容有关的英文资料的翻译。(2)查阅15篇以上参考文献,其中至少5篇为外文文献,对目前国内外图象匹配技术的发展和应用进行全面综述。 (3)学习图象匹配算法,尤其是基于特征的图象匹配算法。 (4)实现并分析至少两种基于特征的图象匹配算法,并分析算法性能。 3.主要参考文献 [1]谭磊, 张桦, 薛彦斌.一种基于特征点的图像匹配算法[J].天津理工大学报,2006, 22(6),66-69. [2]甘进,王晓丹,权文.基于特征点的快速匹配算法[J].电光与控制,2009,16(2), 65-66. [3]王军,张明柱.图像匹配算法的研究进展[J].大气与环境光学学报,2007,2(1), 12-15. Feature descriptor comparison report Sharing my research work of behavior of several types of feature descriptors. This article is an update of old "Comparison of feature descriptors" post. I've added a brand new ORB feature descriptor to the test suite, also SIFT descriptor included as well. And a new version of LAZY descriptor present in this test too. For this test i have written special test framework, which allows me to easily add the new kind of descriptors and test cases and generate report data in CSV-like format. Than i upload it in Google docs and create this awesome charts. Five quality and one performance test was done for each kind of descriptor. o Rotation test - this test shows how the feature descriptor depends on feature orientation. o Scaling test - this test shows how the feature descriptor depends on feature size. o Blur test - this test shows how the feature descriptor is robust against blur. o Lighting test - this test shows how the feature descriptor is robust against lighting. o Pattern detection test - this test performs detection of planar平面object (image) on the real video. In contrast to the synthetic综合tests, this test gives a real picture of the overall stability of the particular descriptor. o Performance test is a measurement of description extraction time. All quality tests works in similar way. Using a given source image we generate a synthetic test data: transformed images corresponding feature points. The transformation algorithm depends on the particular test. For the rotation test case, it's the rotation of the source image around it's center for 360 degrees, for scaling - it's resizing of image from 0.25X to 2x size of original. Blur test uses gaussian blur with several steps and the lighting test changes the overall picture brightness. The pattern detection test deserves a special attention. This test is done on very complex and noisy video sequence. So it's challenging task for any feature descriptor algorithm to demonstrate a good results in this test. The metric for all quality tests is the percent of correct matches between the source image and the transformed one. Since we use planar object, we can easily select the inliers from all matches using the homography estimation. I use OpenCV's function cvFindHomography for this. This metric gives very good and stable results. I do no outlier detection of matches before homography estimation because this will affect the results in unexpected way. The matching of descriptors is done via brute-force matching from the OpenCV. 毕业设计(论文)题目基于SIFT特征的图像匹配 姓名张建华 学号0811111101 所在学院理学院 专业班级08信计 指导教师吴颖丹 日期2012 年 6 月 2 日 摘要 当今社会已经进入信息时代,随着计算机技术、通信技术和数学的发展,图像信息处理能力和水平也不断提高,相应的也得到更多关注、研究和更加广泛的应用。图像匹配是处理和解决各种图像信息的基础,已经成为虚拟现实和计算机可视化领域的研究热点。一直以来,研究人员对图像匹配技术进行了大量的研究,推出了许多匹配算法,其中特征匹配算法有着较高的精确度和稳定性。SIFT (Scale Invariant Feature Transform)特征匹配算法是Lowe提出来的用于图像特征匹配的算法,是目前特征匹配领域的热点,对图像的旋转,尺度缩放和亮度变换保持不变,对视角变换,仿射变换保持一定程度的稳定。SIFT特征点是图像的一种尺度不变局部特征点,具有独特性好,信息量丰富,多量性,高速性,可扩展性等特点。正是借助于这些特点,使得传统图像配准中的许多诸如前面提到的共性问题得到了很大程度的改善。该算法首先给出了尺度空间的生成方法,检测出极值点;接下来给出了SIFT特征点的提取步骤和精确定位极值点的方法;然后基于特征点邻域像素的梯度和方向生成了关键点的描述向量;最后根据特征向量给出了匹配方法,提取了SIFT的特征点,并其应用于图像匹配。 本文首先简要介绍了图像匹配所需的基础知识,然后详细介绍了SIFT算法的具体流程。通过大量的实验证明SIFT算法具有较强的匹配能力和鲁棒性,是一种较好的图像匹配算法。 关键字:SIFT; 图像匹配; 尺度空间; 极值点; 特征向量 SIFT 特征点匹配算法 基于SIFT 方法的图像特征匹配可分为特征提取和特征匹配两个部分,可细化分为五个部分: ① 尺度空间极值检测(Scale-space extrema detection ); ② 精确关键点定位(Keypoint localization ) ③ 关键点主方向分配(Orientation assignment ) ④ 关键点描述子生成(Keypoint descriptor generation ) ⑤ 比较描述子间欧氏距离进行匹配(Comparing the Euclidean distance of the descriptors for matching ) 1.1 尺度空间极值检测 特征关键点的性质之一就是对于尺度的变化保持不变性。因此我们所要寻找的特征点必须具备的性质之一,就是在不同尺度下都能被检测出来。要达到这个目的,我们可以在尺度空间内寻找某种稳定不变的特性。 Koenderink 和Lindeberg 已经证明,变换到尺度空间唯一的核函数是高斯函数。因此一个图像的尺度空间定义为:(,,)L x y σ,是由可变尺度的高斯函数(,,)G x y σ与输入图像(,)I x y 卷积得到,即: ),(),,(),,(y x I y x G y x L *=σσ (1.1) 其中:2222/)(221 ),,(σπσσy x e y x G +-= 在实际应用中,为了能相对高效地计算出关键点的位置,建议使用的是差分高斯函数(difference of Gaussian )(,,)D x y σ。其定义如下: ) ,,(),,() ,()),,(),,((),,(σσσσσy x L k y x L y x I y x G k y x G y x D -=*-= (1.2) 如上式,D 即是两个相邻的尺度的差(两个相邻的尺度在尺度上相差一个相乘系数k )。 研究背景 在日常生活中,我们主要依赖于视觉来感知外界的信息,比起听觉,视觉能给我们更加丰富的描述。人们一直想通过计算机视觉来描述视觉信息中有意义和有用的东西。首先,我们必须回答什么类型的信息是我们想要的?如何提取这样的特征信息?有人定义视觉为发现图像是什么和在哪里的过程,这强调了视觉是一个信息处理任务[]。而如何构建一个视觉系统来进行这样的信息处理任务是很多学者研究的问题之一。其中,达成统一共识是利用不同的特征层来构建这一个视觉模型系统,最简单的三层体系结构为低层、中层、高层。而本文基于最基本的图像描述方法——尺度的概念,利用尺度空间表示法来分析最低层图像数据。尺度空间方法是一种尺度参数连续、不同尺度空间下采样保持一致性的视觉多尺度分析。 视觉多尺度分析是一种新的视觉信息处理方法,其基本思想是:当我们用眼睛观察物体且物体和观察者之间的距离(将距离视为尺度参数)不断变化时,视网膜将感知到不断变化的图像信息,分析和综合这些不同尺度下的视觉信息以获得被观察物体的本质特征,这种视觉分析方法即称为视觉多尺度分析。 尺度空间方法的基本思想是:在视觉信息(图像信息)处理模型中引入一个被视为尺度的参数,通过连续变化尺度参数获得不同尺度下的视觉处理信息,然后综合这些信息以深入地挖掘图像的本质特征。尺度空间方法将传统的单尺度视觉信息处理技术纳入尺度不断变化的动态分析框架中,因此更容易获得图像的本质特征。 为什么要研究尺度空间?可以从以下几个通俗的描述来说明: 1)现实世界的物体由不同尺度的结构所组成; 2)在人的视觉中,对物体观察的尺度不同,物体的呈现方式也不同; 3)对计算机视觉而言,无法预知某种尺度的物体结构是有意义的,因此有必要将所有尺度的结构表示出来; 4)从测量的角度来说,对物体的测量数据必然是依赖于某个尺度的,例如温度曲线的采集,不可能是无限的,而是在一定温度范围进行量化采集。温度范围即是选择的尺度; 5)采用尺度空间理论对物体建模,即将尺度的概念融合入物理模型之中。 尺度空间数学定义表示如下: 设多尺度分析的初始图像为0()u x (x , 为图像区域),(,)u x t 为多尺度分析用于图像所获得的在尺度(0)t t 时的图像,称0:()(,)t T u x u x t 为尺度空间算子,尺度空间算子族 0t t T 为尺度空间,并称为0:()(,)t h T u x t u x t h 尺度由t 变化到t h 的尺度空间算子。 依据尺度空间公理,尺度空间算子应满足如下定义的视觉不变性: 定义2 设t T 为尺度空间算子,称t T 具有 二 特征点提取算法 1、基于SIFT (Scale Invariant Feature Transform )方法的图像特征匹配 参看David G. Lowe 的“Distinctive Image Features from Scale-Invariant Keypoints ” 基于SIFT 方法的图像特征匹配可分为特征提取和特征匹配两个部分,可细化分为五个部分: ① 尺度空间极值检测(Scale-space extrema detection ); ② 精确关键点定位(Keypoint localization ) ③ 关键点主方向分配(Orientation assignment ) ④ 关键点描述子生成(Keypoint descriptor generation ) ⑤ 比较描述子间欧氏距离进行匹配(Comparing the Euclidean distance of the descriptors for matching ) 1.1 尺度空间极值检测 特征关键点的性质之一就是对于尺度的变化保持不变性。因此我们所要寻找的特征点必须具备的性质之一,就是在不同尺度下都能被检测出来。要达到这个目的,我们可以在尺度空间内寻找某种稳定不变的特性。 Koenderink 和Lindeberg 已经证明,变换到尺度空间唯一的核函数是高斯函数。因此一个图像的尺度空间定义为:(,,)L x y σ,是由可变尺度的高斯函数(,,)G x y σ与输入图像(,)I x y 卷积得到,即: ),(),,(),,(y x I y x G y x L *=σσ (1.1) 其中:2222/)(221 ),,(σπσσy x e y x G +-= 在实际应用中,为了能计算的相对高效,所真正使用的是差分高斯尺度空间(difference of Gaussian )(,,)D x y σ。其定义如下: ) ,,(),,() ,()),,(),,((),,(σσσσσy x L k y x L y x I y x G k y x G y x D -=*-= (1.2) 如上式,D 即是由两个相邻的尺度的差(两个相邻的尺度在尺度上相差一个相乘系数k )。 点特征提取编程实习报告 一.实习简介 本次实习利用VC++6.0编程实现了对8位BMP灰度图像的读取、显示,并用Moravec算子对图像进行点特征的提取。 二.程序设计 1.用MFC创建一个多文档程序框架,用来显示BMP图像: 2.为该程序框架添加菜单: 3.创建一个对话框输入参数: 4.最后提取结果可以显示在视图中: 三.程序框图及核心代码Array 分别定义四个函数计算四个方向的灰度差平方和: 提取特征点: 实验结果分析 1、下图中阈值为8000,窗口大小从上到下从左到右分别为9*9、7*7、5*5、3*3。可 以看出随着窗口的增大,提取到的特征点个数越来越少,但是精度提高,可以防止将噪声提取出来。 2、下图中窗口大小为9,阈值从左到右从上到下分别为20000、15000、10000、5000。 可以看出,随着阈值的增大,能投提取到的特征点越来越少,只有灰度变化十分剧烈的点才能被提取出来,如下图中左上角是阈值为20000时的提取结果,可以发现没有提取出任何特征点。。 实习总结 Moravec 算子是点特征提取算子中的经典算子之一,它具有计算量小, 不丢失灰度信息等优点。用该算子提取特征点时阈值的选取直接影响着提取结果。如本次实习过程中所用的图像是武汉地区的TM影像,这幅影像的灰度范围很小,所以阈值不宜取得过大,否则会丢失很多特征点,如:当阈值选为20000时,没有提取出任何特征点。为了验证对比度对特征点提取的影响,我用Photoshop对图像做了一个对比度的增强,之后用5*5的窗口和10000的阈值对其进行特征点的提取并与原图像的提取结果做了对比,发现增强了对比度的图像中提取出的特 征点确实比原图像中的特征点多,如下图: Forstner算子提取特征点(原创) ;------------------------------ ;Forstner算子 ;; image:输入原始图像 ; vwsize:窗口宽度 ; ithresh:初选差分阈值 ; qthresh:兴趣值阈值 function Forstner,image,vwsize=vwsize,ithresh=ithresh,Tq=Tq IF N_Elements(vwsize) eq 0 THEN vwsize=5 IF N_Elements(ithresh) eq 0 THEN ithresh=50 IF N_Elements(Tq) eq 0 THEN Tq=0.5 image=float(image) imgSize = Size(image, /Dimensions) xsize=imgSize[0] ysize=imgSize[1] ;灰度的协方差矩阵 result=fltarr(xsize,ysize) ;第一步:利用差分算子提取初选点 for i=1,xsize-2 do begin for j=1,ysize-2 do begin dg1=abs(image[i,j]-image[i+1,j]) dg2=abs(image[i,j]-image[i,j+1]) dg3=abs(image[i,j]-image[i-1,j]) dg4=abs(image[i,j]-image[i,j-1]) dg=[dg1,dg2,dg3,dg4] temp=dg[sort(dg)] if temp[2] gt ithresh then begin result[i,j]=255 endif else begin result[i,j]=0 endelse endfor endfor ;第二步:在以初选点为中心的3*3的窗口中计算协方差矩阵与圆度 ;此处可用where提高循环效率 ;权重矩阵 wMatrix=fltarr(xsize,ysize) for i=1,xsize-2 do begin for j=1,ysize-2 do begin ;是初选点 if result[i,j] eq 255 then begin gu2=0.0 & gv2=0.0 & guv=0.0 for ii=-1,1 do begin for jj=-1,1 do begin gu2=gu2+(image[i+1,j+1]-image[i,j])^2 gv2=gv2+(image[i,j+1]-image[i+1,j])^2 guv=guv+(image[i+1,j+1]-image[i,j])*(image[i,j+1]-image[i+1,j]) endfor endfor DetN=gu2*gv2-guv trN=gu2+gv2 q=4*DetN/(trN*trN) ;第三步:设定阈值Tq,若满足则计算权值 if q gt Tq then wMatrix[i,j]=DetN/trN endif 三个描述符的比较:SURF,FREAK和BRISK =================分割线================= 我认为从事对象识别,图像注册和使用关键点提取的其他领域的开发人员和研究人员可以发现这个帖子很有用。最近(从2.4.2),一个新的特征描述符算法被添加到OpenCV库中。据称FREAK描述符优于ORB和SURF描述符,但速度非常快(与ORB相当)。也有人在我的博客上的评论提到BRISK描述符,这是比SURF更新,更高效。那么,最后我找到一个时间来比较他们,并发表我的研究成果。 这篇文章与我过去的OpenCV比较报告非常相似。虽然这些报告是多年前发表的,但它们还是有些实际的。对于这个测试,我决定从头开始重写整个测试框架。源代码即将可用。但现在,让我解释我做了什么来找到最好的三种算法。将图像转换为描述符的主要目标是什么?从像素域移动到更紧凑的表示形式相同的数据。此外,我们希望我们的表示是旋转和比例不变的(例如,当源图像旋转或缩放时,表示保持不变或略微变化)。SURF,FREAK和BRISK描述符宣称它们是旋转和尺度不变的。 ========================分割线============================== 就像在OpenCV比较报告中一样,测试应用程序与测试模式图像一起工作。我们有四个基本的转换:旋转,缩放,模糊和亮度调整。这里是如何旋转转换类看起来像: class ImageRotationTransformation : public ImageTransformation ImageRotationTransformation(float startAngleInDeg, float endAngleInDeg, float step, cv::Point2f rotationCenterInUnitSpace) : ImageTransformation("Rotation") , m_startAngleInDeg(startAngleInDeg) , m_endAngleInDeg(endAngleInDeg) , m_step(step) , m_rotationCenterInUnitSpace(rotationCenterInUnitSpace) -- Fill the arguments for (float arg = startAngleInDeg; arg = endAngleInDeg; arg += step) m_args.push_back(arg); virtual std::vector getX() const return m_args; virtual void transform(float t, const cv::Mat source, cv::Mat result) const cv::Point2f center(source.cols * m_rotationCenterInUnitSpace.x, source.cols * m_rotationCenterInUnitSpace.y); 图像局部特征(一)--概述 本文根据下面这篇文章,做下简单修改。 研究图像特征检测已经有一段时间了,图像特征检测的方法很多,又加上各种算法的变形,所以难以在短时间内全面的了解,只是对主流的特征检测算法的原理进行了学习。总体来说,图像特征可以包括颜色特征、纹理特等、形状特征以及局部特征点等。其中局部特点具有很好的稳定性,不容易受外界环境的干扰,本篇文章也是对这方面知识的一个总结。 1. 局部特征点 图像特征提取是图像分析与图像识别的前提,它是将高维的图像数据进行简化表达最有效的方式,从一幅图像的M×N×3?M×N×3的数据矩阵中,我们看不出任何信息,所以我们必须根据这些数据提取出图像中的关键信息,一些基本元件以及它们的关系。 局部特征点是图像特征的局部表达,它只能反正图像上具有的局部特殊性,所以它只适合于对图像进行匹配,检索等应用。对于图像理解则不太适合。而后者更关心一些全局特征,如颜色分布,纹理特征,主要物体的形状等。全局特征容易受到环境的干扰,光照,旋转,噪声等不利因素都会影响全局特征。相比而言,局部特征点,往往对应着图像中的一些线条交叉,明暗变化的结构中,受到的干扰也少。 而斑点与角点是两类局部特征点。斑点通常是指与周围有着颜色和灰度差别的区域,如草原上的一棵树或一栋房子。它是一个区域, 所以它比角点的噪能力要强,稳定性要好。而角点则是图像中一边物体的拐角或者线条之间的交叉部分。 2. 斑点检测原理与举例 2.1 LoG与DoH 斑点检测的方法主要包括利用高斯拉普拉斯算子检测的方法(LOG),以及利用像素点Hessian矩阵(二阶微分)及其行列式值的方法(DOH)。 LoG的方法已经在斑点检测这入篇文章里作了详细的描述。因为二维高斯函数的拉普拉斯核很像一个斑点,所以可以利用卷积来求出图像中的斑点状的结构。 DoH方法就是利用图像点二阶微分Hessian矩阵: H(L)=[L?xx?L?xy?L?xy?L?yy?]?H(L)=[LxxLxyLxyLyy] 以及它的行列式的值DoH(Determinant of Hessian): det=σ?4?(L?xx?(x,y,σ)L?yy?(x,y,σ)?L?2?xy?(x,y,σ))?de t=σ4(Lxx(x,y,σ)Lyy(x,y,σ)?Lxy2(x,y,σ)) Hessian矩阵行列式的值,同样也反映了图像局部的结构信息。与LoG相比,DoH对图像中的细长结构的斑点有较好的抑制作用。 无论是LoG还是DoH,它们对图像中的斑点进行检测,其步骤都可以分为以下两步: 1)使用不同的σ?σ生成(?2?g?x?2?+?2?g?y?2?)?(?2g?x2+?2g?y2) 或?2?g?x?2?,?2?g?y?2?,?2?g?x?y?2g?x2,?2g?y2,?2g?x?y模板,并 图像处理特征不变算子系列之DoG算子(五) 时间 2013-09-12 00:24:07 CSDN博客原 文https://www.360docs.net/doc/8117225575.html,/kezunhai/article/details/11403733 图像处理特征不变算子系列之DoG算子(五) kezunhai@https://www.360docs.net/doc/8117225575.html, https://www.360docs.net/doc/8117225575.html,/kezunhai 在前面分别介绍了:图像处理特征不变算子系列之Moravec算子(一)、图像处理特征不变算子系列之Harris算子(二)、图像处理特征不变算子系列之SUSAN算子(三)和图像处理特征不变算子系列之FAST算子(四)。今天我们将介绍另外一个特征检测算子---DoG算子,DoG算子是 由 Lowe D.G. 提出的,对噪声、尺度、仿射变化和旋转等具有很强的鲁棒性,能够提供更丰富的局部特征信息,本文将对DoG算子进行详细地分析。 在开始介绍DoG之前,有必要对尺度空间有一定的了解。尺度空间最早是由Tony Lindeberg提出的,并不断的发展和完善。日常生活中,我们自觉或不自觉的在使用尺度的概念。举个我们个人自觉的经历,当我们读小学的时候,同学间互相询问来自哪个组;当我们读中学的时候,同学们互相询问自哪个村;当我们读高中的时候,同学们互相询问来自哪个镇;当读大学的时候,同学们互相询问来自哪个省?这里的组、村、镇、省就是我们不自觉使用的尺寸。还有一个例子,当我们打开google地图的时候,随着鼠标的滚动,地图会由五大洲逐渐定位到国家--》省---》市---》区---》街道办等,这也是尺度的表现。 1)尺度空间 在尺度空间中,尺度越大图像就越模糊,尺度空间中各尺度图像的模糊程度逐渐变大,能够模拟目标由远及近人对目标的感知过程。那为什么要讨论尺度空间呢?因为在用机器视觉系统分析未知场景时,机器并不知道图像中物体的尺度,只有通过对图像的多尺度描述,才能获得对物体感知的最佳尺度。如果在不同尺度上,对输入的图像都能检测到相同的关键点特征,那么在不同尺度下也可以实现关键点的匹配,从而实现关键点的尺度不变特性。尺度空间描述的就是图像在不同尺度下的描述,如果对尺度空间有兴趣,请参考Tony Lindeberg的论文:Scale-Space。 2)金字塔多分辨率 常常有人会将DoG与图像金字塔弄混,从而导致对SIFT算法第一步构造DoG不甚理解。这里首先介绍下金字塔多分辨率。金字塔是早起图像多尺度的表示形式,图像金字塔一般包括2个步骤,分别是使用低通滤波平滑图像;对图像进行降采样(也即图像缩小为原来的1/4,长宽高缩小为1/2),从而得到一系列尺寸缩小的图像。金字塔的构造如下所示: LBP算子介绍 LBP(Local Binary Pattern,局部二值模式)是一种用来描述图像局部纹理特征的算子;显然,它的作用是进行特征提取,而且,提取的特征是图像的纹理特征,并且,是局部的纹理特征; 原始的LBP算子定义为在3*3的窗口内,以窗口中心像素为阈值,将相邻的8个像素的灰度值与其进行比较,若周围像素值大于中心像素值,则该像素点的位置被标记为1,否则为0。这样,3*3领域内的8个点可产生8bit的无符号数,即得到该窗口的LBP值,并用这个值来反映该区域的纹理信息。如下图所示: 原始的LBP提出后,研究人员不断对其提出了各种改进和优化,从而得到了诸如半 径为R的圆形区域内含有P个采样点的LBP算子;LBP均匀模式;LBP旋转不变模式;LBP等价模式等等,具体请参考T. Ojala在IEEE TPAMI上2002年发表的那篇文章“Multiresolution Gray-Scale and Rotation Invariant Texture Classification with Local Binary Pat terns”。另外,LBP算子的中文参考文章,可以参考以下: (1)基于LBP的人脸识别研究,黄非非,重庆大学硕士毕业论文,2009年 (2)基于LBP的特征提取研究,王玲,北京交通大学硕士毕业论文,2009年 (3)基于局部二值模式的人脸识别方法研究,周凯,中南大学硕士毕业论文,2009年 显而易见的是,上述提取的LBP算子在每个像素点都可以得到一个LBP“编码”,那么,对一幅图像提取其原始的LBP算子之后,得到的原始LBP特征依然是“一幅图片”。不过,这里我们已经将物体从图片(图片可以理解为物体在原始测量空间得到的测量特征)转换为二次特征,也就是得到了我们通常说的“特征”。不过,这个所谓的“特征”并不能直接用于判别分析。因为,从上面的分析我们可以看出,这个“特征”跟位置信息是紧密相关的。直接对两幅图片提取这种“特征”,并进行判别分析的话,会因为“位置没有对准”而产生很大的误差。后来,研究人员发现,可以将一幅图片划分为若干的子区域,对每个子区域内的每个像素点都提取LBP特征,然后,在每个子区域内建立LBP特征的统计直方图。如此一来,每个子区域,就可以用一个统计直方图来进行描述;整个图片就由若干个统计直方图组成;例如:一幅100*100像素大小的图片,划分为10*10=100个子区域,每个子区域的大小为10*10像素;在每个子区域内的每个像素点,提取其LBP特征,然后,建立统 基于特征点的图像匹配技术研究及应用 文献综述 1.图像匹配的概念 图像匹配[1]是指通过一定的匹配算法在两幅或多幅图像之间识别同名点,如二维图像匹配中通过比较目标区和搜索区中相同大小的窗口的相关系数,取搜索区中相关系数最大所对应的窗口中心点作为同名点。其实质是在基元相似性的条件下,运用匹配准则的最佳搜索问题。 图像匹配中事先获得的图像称为基准图像(base image),在匹配过程中在线或者实时获得的图像称为实时图像(real time image)。基准图像可以比实时图像大也可以比实时图像小。当基准图像比实时图像大时,匹配过程就是在基准图像中搜寻实时图像位置的过程;当实时图像比基准图像大时,匹配过程就是在实时图像中寻找作为目标的基准图像的过程。在地图导航系统[2]中,基准图像比实时图像大。如图1.1所示。 M2 图1.1 地图导航系统中的图像匹配示意图 基准图像和实时图像是对同一对象有差别的近似描述,设和分别为基准图像和实时图像的灰度分布,在不考虑关照变换等影响下,两者存在如下关系: 鍏紡 其中是高斯白噪声,可以通过一定的滤波方法滤除。是上的点在X和Y方向上的位置偏差,称为定位噪声。位置偏差往往是因为图像的几何形变造成的。 实际上利用计算机进行处理的并不是连续图像,图像的位置和灰度都被划分为离散的值,常用像素矩阵来表示一副图像。在地图匹配导航中,通常基准图像比实时图像大。直接进行相关匹配的两幅图像应该是大小一样的,为了确定实时图像在基准图像中的位置,就必须在基准图像中提出与实时图像大小相等的基准子图,并逐个与实时图像进行比较,以便找出与实时图像匹配的那个基本子图,从而确定实时图像在基准图像中的位置。所以一般图像匹配的过程就是不断从基准图像中提取基准子图与实时图像进行相关运算的过程,这个过程 点特征提取编程实习报告 实习简介 本次实习利用VC++6.0编程实现了对8位BMP灰度图像的读取、显示,并用Moravec 算子对图像进行点特征的提取。 程序设计 1.用MFC创建一个多文档程序框架,用来显示BMP图像: 0 073 - [ZM.BMP] 一= “ 一=. I亘災 2.为该程序框架添加菜单: 特征提取窗口帶助[ 3.创建一个对话框输入参数: 4.最后提取结果可以显示在视图中: 程序框图及核心代码 Value〉阈 值 在该像素处画上十字丝 提取特征点: BOOL CDib::llorauec(int size,int limit) if(ll_pBHI= = NULL) "屮向位图指针是否为空,若为空,说明役有谄数据,程序返回return FALSE: UORD wBitCnunt =m_pBMI->bniHeader.biBitCount; "得到影像的莓个像素所占比特数if(wBitCount?=8) < AFxlle SSageB ox(-该分类方袪只能处理目位图橡!”); return FALSE: } int nWidth=n_pBM[->bniHeader,biMidtn: int nlleight-ri」RH[-〉bniHE3dE?r .biUEight; "我得愚像的宽厅和高度 ±nt Wi(lthej|tes=WIDTH8VTES(nWidth>24);"快耳丿爭槪厨亍的买际程悔融 LPBVTE IpD.ta-iijaits; 义宇符扌謝菱量,用来慄存範图窮四彎芬起始地址int k=size/2; (W BitCount-=8)"如果是P位桩图,则开始握取特征点 < int i f j: nu(n=0; int ul T V2,u3,u4,uaiue; for (i=k;iF R E A K 特 征 点 匹 配 算 法 介 绍 ( 2 0 2 0 )

赵宇凡开题报告-基于图像特征提取与匹配的目标识别系统设计

图像中角点(特征点)提取与匹配算法

基于特征的图像匹配算法毕业设计论文(含源代码)

特征描述算子评测

基于SIFT特征的图像匹配

SIFT特征点提取与匹配算法

图像局部特征描述子研究分析(未完-待续)

SIFT特征点提取与匹配算法

Moravec算子特征提取

forstner算子提取特征点

F R E A K 特 征 点 匹 配 算 法 介 绍 ( 2 0 2 0 )

F R E A K 特 征 点 匹 配 算 法 介 绍

图像处理特征不变算子系列之DoG算子(五)

LBP算子介绍

基于特征点的图像匹配技术研究及应用

Moravec算子特征提取