什么是BeautifulSoup

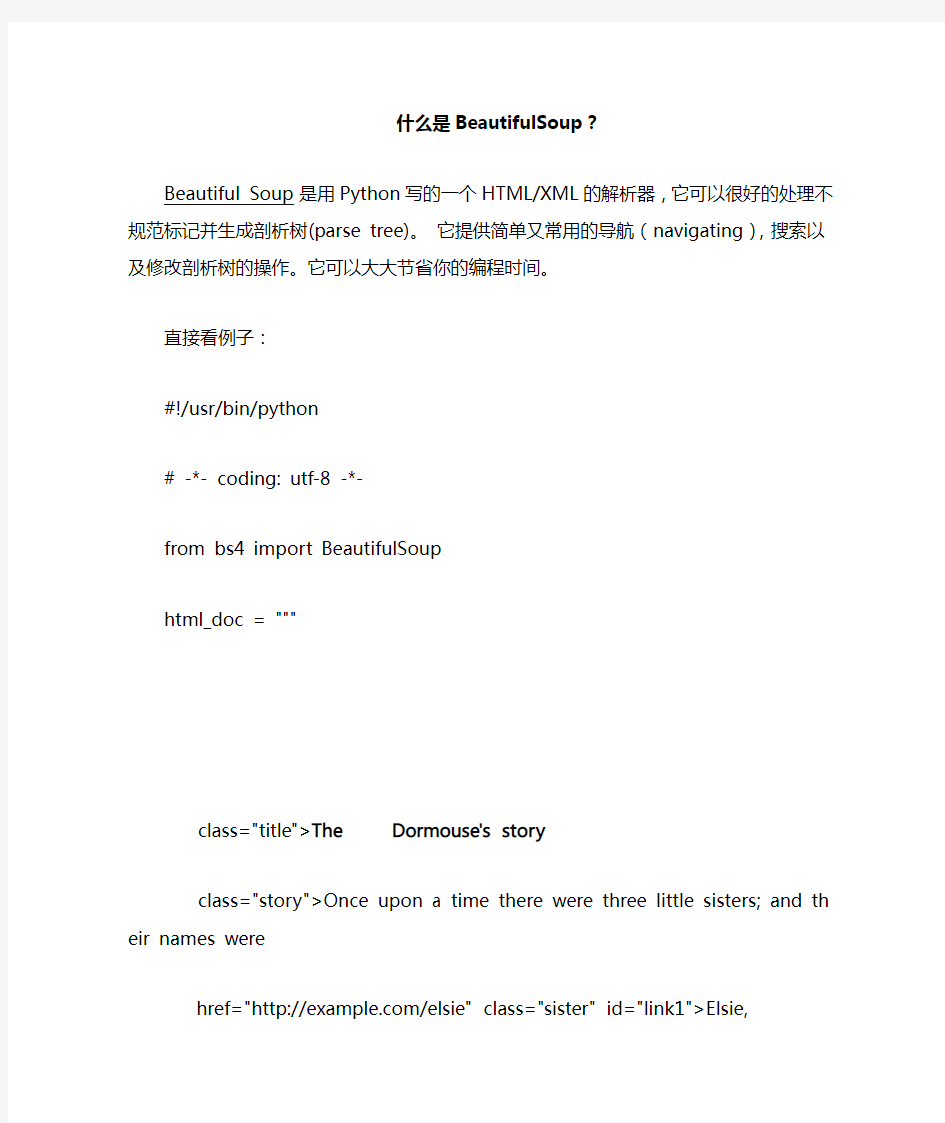

什么是BeautifulSoup?

Beautiful Soup 是用Python写的一个HTML/XML的解析器,它可以很好的处理不规范标记并生成剖析树(parse tree)。它提供简单又常用的导航(navigating),搜索以及修改剖析树的操作。它可以大大节省你的编程时间。

直接看例子:

#!/usr/bin/python

# -*- coding: utf-8 -*-

from bs4 import BeautifulSoup

html_doc = """

The Dormouse's story

Once upon a time there were three little sisters; a nd their names were

and they lived at the bottom of a well.

...

"""

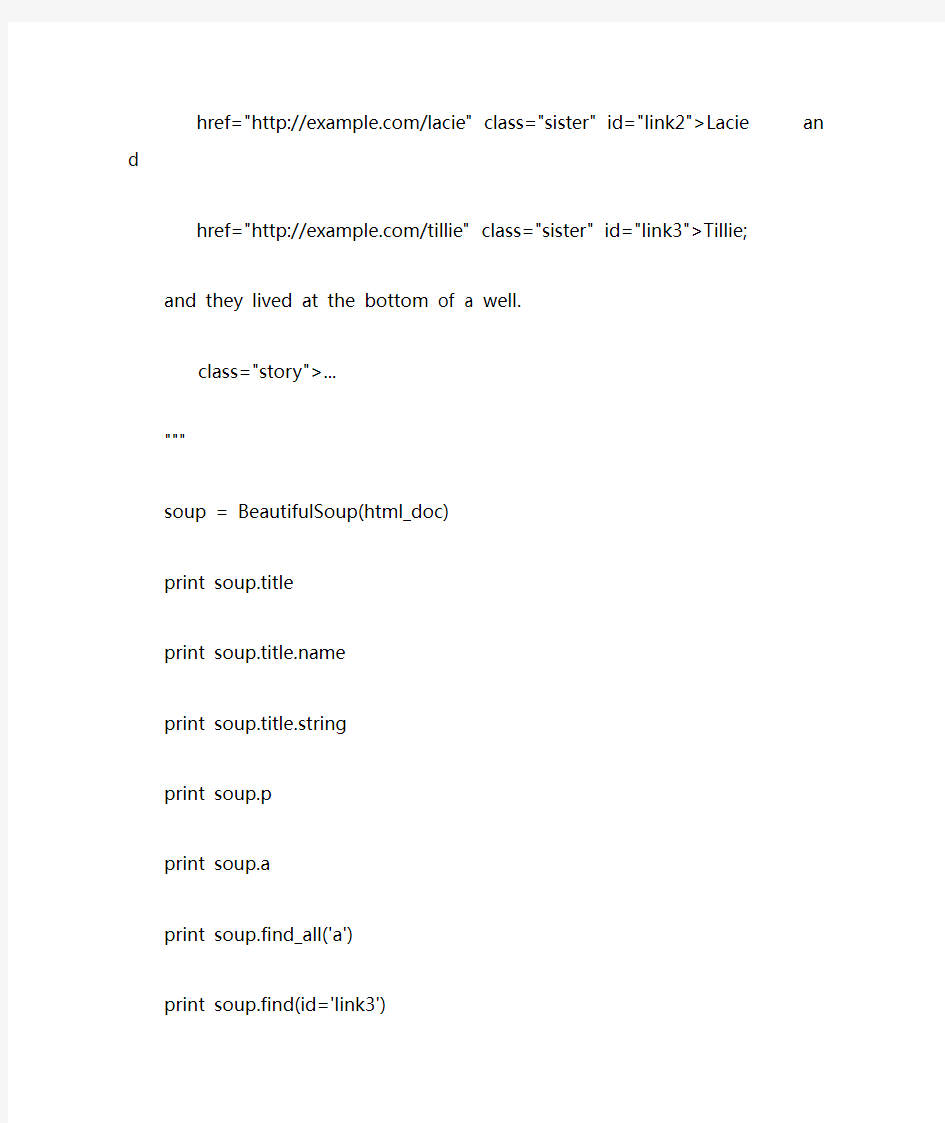

soup = BeautifulSoup(html_doc)

print soup.title

print https://www.360docs.net/doc/a112431187.html,

print soup.title.string

print soup.p

print soup.a

print soup.find_all('a')

print soup.find(id='link3')

print soup.get_text()

结果为:

title

The Dormouse's story

The Dormouse's story

The Dormouse's story

The Dormouse's story

Once upon a time there were three little sisters; and their names w ere

Elsie,

Lacie and

Tillie;

and they lived at the bottom of a well.

...

可以看出:soup 就是BeautifulSoup处理格式化后的字符串,soup.title 得到的是title标签,soup.p 得到的是文档中的第一个p标签,要想得到所有标签,得用find_all

函数。find_all 函数返回的是一个序列,可以对它进行循环,依次得到想到的东西. get_text() 是返回文本,这个对每一个BeautifulSoup处理后的对象得到的标签都是生效的。你可以试试 print soup.p.get_text()

其实是可以获得标签的其他属性的,比如我要获得a标签的href属性的值,可以使用print soup.a['href'],类似的其他属性,比如class也是可以这么得到的(sou p.a['class'])。

特别的,一些特殊的标签,比如head标签,是可以通过soup.head 得到,其实前面也已经说了。

如何获得标签的内容数组?使用contents 属性就可以比如使用 print soup.he ad.contents,就获得了head下的所有子孩子,以列表的形式返回结果,

可以使用[num] 的形式获得,获得标签,使用.name 就可以。

获取标签的孩子,也可以使用children,但是不能print soup.head.children

没有返回列表,返回的是

不过使用list可以将其转化为列表。当然可以使用for 语句遍历里面的孩子。

关于string属性,如果超过一个标签的话,那么就会返回None,否则就返回具体的字符串print soup.title.string 就返回了 The Dormouse's story

超过一个标签的话,可以试用strings

向上查找可以用parent函数,如果查找所有的,那么可以使用parents函数

查找下一个兄弟使用next_sibling,查找上一个兄弟节点使用previous_sibling,如果是查找所有的,那么在对应的函数后面加s就可以

如何遍历树?

使用find_all 函数

find_all(name, attrs, recursive, text, limit, **kwargs)

举例说明:

print soup.find_all('title')

print soup.find_all('p','title')

print soup.find_all('a')

print soup.find_all(id="link2")

print soup.find_all(id=True)

返回值为:

[

[

The Dormouse's story

]通过css查找,直接上例子把:

print soup.find_all("a", class_="sister")

print soup.select("p.title")

通过属性进行查找

print soup.find_all("a", attrs={"class": "sister"})

通过文本进行查找

print soup.find_all(text="Elsie")

print soup.find_all(text=["Tillie", "Elsie", "Lacie"])

限制结果个数

print soup.find_all("a", limit=2)

结果为:

[

The Dormouse's story

][u'Elsie']

[u'Elsie', u'Lacie', u'Tillie']

总之,通过这些函数可以查找到想要的东西。

山东建筑大学计算机网络课程设计基于Python的网络爬虫设计

山东建筑大学 课程设计成果报告 题目:基于Python的网络爬虫设计课程:计算机网络A 院(部):管理工程学院 专业:信息管理与信息系统 班级: 学生姓名: 学号: 指导教师: 完成日期:

目录 1 设计目的 0 2 设计任务内容 0 3 网络爬虫程序总体设计 0 4 网络爬虫程序详细设计 0 4.1 设计环境和目标分析 0 4.1.1 设计环境 0 4.1.2 目标分析 (1) 4.2 爬虫运行流程分析 (1) 4.3 控制模块详细设计 (2) 4.3 爬虫模块详细设计 (2) 4.3.1 URL管理器设计 (2) 4.3.2 网页下载器设计 (2) 4.3.3 网页解析器设计 (2) 4.4数据输出器详细设计 (3) 5 调试与测试 (3) 5.1 调试过程中遇到的问题 (3) 5.2测试数据及结果显示 (4) 6 课程设计心得与体会 (4) 7 参考文献 (5) 8 附录1 网络爬虫程序设计代码 (5) 9 附录2 网络爬虫爬取的数据文档 (8)

1 设计目的 本课程设计是信息管理与信息系统专业重要的实践性环节之一,是在学生学习完《计算机网络》课程后进行的一次全面的综合练习。本课程设计的目的和任务: 1.巩固和加深学生对计算机网络基本知识的理解和掌握; 2.培养学生进行对网络规划、管理及配置的能力或加深对网络协议体系结构的理解或提高网络编程能力; 3.提高学生进行技术总结和撰写说明书的能力。 2 设计任务内容 网络爬虫是从web中发现,下载以及存储内容,是搜索引擎的核心部分。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。 参照开放源码分析网络爬虫实现方法,给出设计方案,画出设计流程图。 选择自己熟悉的开发环境,实现网络爬虫抓取页面、从而形成结构化数据的基本功能,界面适当美化。给出软件测试结果。 3 网络爬虫程序总体设计 在本爬虫程序中共有三个模块: 1、爬虫调度端:启动爬虫,停止爬虫,监视爬虫的运行情况 2、爬虫模块:包含三个小模块,URL管理器、网页下载器、网页解析器。 (1)URL管理器:对需要爬取的URL和已经爬取过的URL进行管理,可以从URL 管理器中取出一个待爬取的URL,传递给网页下载器。 (2)网页下载器:网页下载器将URL指定的网页下载下来,存储成一个字符串,传递给网页解析器。 (3)网页解析器:网页解析器解析传递的字符串,解析器不仅可以解析出需要爬取的数据,而且还可以解析出每一个网页指向其他网页的URL,这些URL被解析出来会补充进URL管理器 3、数据输出模块:存储爬取的数据 4 网络爬虫程序详细设计 4.1 设计环境和目标分析 4.1.1 设计环境

python抓取网页数据的常见方法

https://www.360docs.net/doc/a112431187.html, python抓取网页数据的常见方法 很多时候爬虫去抓取数据,其实更多是模拟的人操作,只不过面向网页,我们看到的是html在CSS样式辅助下呈现的样子,但爬虫面对的是带着各类标签的html。下面介绍python抓取网页数据的常见方法。 一、Urllib抓取网页数据 Urllib是python内置的HTTP请求库 包括以下模块:urllib.request 请求模块、urllib.error 异常处理模块、urllib.parse url解析模块、urllib.robotparser robots.txt解析模块urlopen 关于urllib.request.urlopen参数的介绍: urllib.request.urlopen(url, data=None, [timeout, ]*, cafile=None, capath=None, cadefault=False, context=None) url参数的使用 先写一个简单的例子:

https://www.360docs.net/doc/a112431187.html, import urllib.request response = urllib.request.urlopen(' print(response.read().decode('utf-8')) urlopen一般常用的有三个参数,它的参数如下: urllib.requeset.urlopen(url,data,timeout) response.read()可以获取到网页的内容,如果没有read(),将返回如下内容 data参数的使用 上述的例子是通过请求百度的get请求获得百度,下面使用urllib的post请求 这里通过https://www.360docs.net/doc/a112431187.html,/post网站演示(该网站可以作为练习使用urllib的一个站点使用,可以 模拟各种请求操作)。 import urllib.parse import urllib.request data = bytes(urllib.parse.urlencode({'word': 'hello'}), encoding='utf8')

Python网络数据采集笔记

1.BeautifulSoup简介 from urllib.request import urlopen from bs4 import BeautifulSoup html = urlopen('https://www.360docs.net/doc/a112431187.html,')#打开一个网址 bsObj = BeautifulSoup(html.read(),'html.parser') #建立了一个美丽汤对象,以网页内容为参数 #调用html.read获取网页的HTML内容 #这样就可以把HTML内容传到美丽汤对象 print (bsObj.h1) #提取h1标签 导入urlopen,然后调用html.read()获取网页的HTML内容,这样就可以把HTML内容传到BeautifulSoup对象 用bsObj.h1从对象里提取h1标签 任何HTML文件的任意节点的信息都可以被提取出来 处理异常 html = urlopen('https://www.360docs.net/doc/a112431187.html,/pages/page1.html') 这一句可能出现两种异常: 网页在服务器上不存在(提取网页时出现错误)——返回HTTP错误,urlopen函数抛出HTTPError异常 处理:try: html = urlopen('https://www.360docs.net/doc/a112431187.html,/pages/page1.html') except HTTPError as e:

print(e)#返回空值,中断程序,或者执行另一个方案 else: #程序继续 服务器不存在(连接打不开、写错了),urlopen就会返回一个None对象,可以增加一个判断语句检测返回的html是不是None: if html is None: print(‘URL is not found’) else: #程序继续 第一个爬虫: from urllib.request import urlopen from urllib.error import HTTPError,URLError from bs4 import BeautifulSoup def getTitle(url): try: html = urlopen(url) except (HTTPError,URLError) as e: return None try: bsObj = BeautifulSoup(html.read(),'html.parser') title = bsObj.html.head.title

南开20春学期《网络爬虫与信息提取》在线作业满分答案

南开20春学期《网络爬虫与信息提取》在线作业满分答案 1 浏览器用来记录用户状态信息的数据叫 A session B cookies C moonpies D selenium 答案:B 2 ()是一个传递信息的通道。它负责将爬取博文列表页获取到的信息传递给负责爬取正文页的方法中。 A meta B head C header D body 答案:A 3 如果使用Python的数据结构来做类比的话,MongoDB中集合相当于一个() A 列表 B 元组 C 字典 D 集合 答案:A 4 下列关于mitmproxy的安装说法错误的是() A 对于Mac OS系统,使用Homebrew安装mitmproxy,命令为:brew install mitmproxy B 在Ubuntu中,要安装mitmproxy,首先需要保证系统的Python为Python 3.5或者更高版本 C 在windows系统中无法使用linux的命令,只能通过下载安装包来安装 D UBUNTU中执行命令sudo pip3 install mitmproxy 进行安装 答案:C 5 ()是Scrapy官方开发的,用来部署、运行和管理Scrapy爬虫的工具 A Scrapyd B ScrapyDeploy C Deploy D Scrapy_Deploy 答案:A 6 PyMongo中逻辑查询表示大于的符号是() A $gt B $lt C $gte$$lte 答案:A

7 Python中把列表转换为集合需要使用1 函数 A set B list C convert D change 答案:A 8 Redis中往集合中添加数据,使用关键字() A sadd B add C append D sappend 答案:A 9 下面Python代码输出为(): def default_para_without_trap(para=[], value=0): if not para: para = [] para.append(value) return para print('第一步:{}'.format(default_para_trap(value=100))) print('第二步:{}'.format(default_para_trap(value=50))) A 第一步:[100] 第二步:[100,50] B 第一步:[100] 第二步:[50] C 第一步:[100] 第二步:[] D 第一步:[100] 第二步:[100] 答案:B 10 Python写CSV文件需要哪个方法() A CSVWriter B CsvWriter C DictWriter D FileWriter 答案:C 11 使用python定制mitmproxy,下面的语句请求的是()。{req.headers["User-Agent"]} A headers B 文本内容 C 目标网站

Beautiful Soup中文文档

几个简单的浏览结构化数据的方法: from bs4 import BeautifulSoup soup = BeautifulSoup (html_doc ) print (soup .prettify ())# #

## # The Dormouse's story # # #

# Once upon a time there were three little sisters; and their names were # # Elsie # # , # # Lacie # # and # # Tillie # # ; and they lived at the bottom of a well.# #

# ...# # #

从文档中找到所有标签的链接: 从文档中获取所有文字内容: soup .title # The Dormouse's story soup .p ['class']# u'title' soup .a # Elsie soup .find_all ('a') # [Elsie,# Lacie,# Tillie] soup .find (id ="link3") # Tillie for link in soup .find_all ('a'): print (link .get ('href')) # https://www.360docs.net/doc/a112431187.html,/elsie # https://www.360docs.net/doc/a112431187.html,/lacie # https://www.360docs.net/doc/a112431187.html,/tillie 第35卷 第5期 福 建 电 脑 Vol. 35 No.5 2019年5月 Journal of Fujian Computer May 2019 ——————————————— 陈嘉发,男,1985年生,工程硕士,网络工程师,主要研究领域为计算机校园信息化建设、计算机网络应用。E-mail: texchan@https://www.360docs.net/doc/a112431187.html, 。 Python 数据可视化的应用研究 陈嘉发 (惠州卫生职业技术学院 广东 惠州 516025) 摘 要 教育领域与数据可视化紧密联系。结合Python 数据分析技术,使用Pandas 库和Matplotlib 库,对学习日志和学习成绩进行可视化分析,有利于教师发现学生的网络学习规律和实现对教学效果的综合分析,帮助教师调整教学手段和指导学生改善学习效率,促进教育决策科学化。 关键词 Python ;数据分析;可视化 中图法分类号 TP39 DOI:10.16707/https://www.360docs.net/doc/a112431187.html,ki.fjpc.2019.05.039 Study on Applications Based on Python Data Visualization CHEN Jiafa (Huizhou Health Sciences Polytechnic, Huizhou, China, 516025) 1 引言 数据可视化促进教育决策科学化,《教育信息 化“十三五”规划》提出的“网络学习空间人人通”进一步推动了教育模式和教学资源的创新,强调了数据分析服务的重要性,使得教育领域和数据可视化的融合应用变得极其重要。当前,基于Moodle 技术建立的网络学习平台,除了单点科技公司开发的付费主题集成的插件以外,只能提供日志、课程活动报表、活动进度统计等简单的可视化功能[1]。为了更好地帮助教师分析学生学习行为,促进教学方法的调整,本文借助Python 丰富的第三方库和数据分析功能,实现了网络学习数据的可视化。 2 Python 及其发展 Python 是一种面向对象、解释型计算机程序设 计语言,被称为胶水语言,能够和其他语言如C++、Java 等结合。它具有语法简洁、数据结构高效等特点,开源且能够跨Windows 、Linux 、MacOS 平台使用。据编程语言流行指数PYPL 官方公布的二月榜单, Python 语言超越Java 成为了最流行的编程 语言。与传统的数据处理、制图、计算的软件 R 语言相比,Python 只需解释器便可执行,具有运算速度快和内存管理效率高的优势[2],被广泛应用在web 开发、游戏脚本、网页爬虫、数据分析等领域。 图1 PYPL 编程语言排行榜 3 Python 数据分析应用的优势 Python 数据可视化分析的优势在于其强大的集成性和丰富的第三方库,Anaconda 和PyCharm 可以帮助用户实现Python 的高效开发,把数据读取、数据清洗、数据分析和数据展示都集成在Python IDE ,无需添加额外的开发程序。 本文由我司收集整编,推荐下载,如有疑问,请与我司联系 如何使用Python抓取需要首先登录的网站First of all, I think it’s worth saying that, I know there are a bunch of similar questions but NONE of them works for me... ?首先,我认为值得一提的是,我知道有很多类似的问题但是没有一个对我有用...... I’m a newbie on Python, html and web scraper. I’m trying to scrape user information from a website which needs to login first. In my tests I use scraper my email settings from github as examples. The main page is ‘https://github/login’ and the target page is ‘https://github/settings/emails’ ?我是Python,html和web scraper的新手。我正试图从需要先登录的网站上抓取用户信息。在我的测试中,我使用来自github的刮刀我的电子邮件设置作为示例。主页是“https://github/login”,目标页面是“https://github/settings/emails” Here are a list of methods I’ve tried ?以下列出了我尝试过的方法 ?##################################### Method 1import mechanizeimport cookielibfrom BeautifulSoup import BeautifulSoupimport html2textbr = mechanize.Browser()cj = cookielib.LWPCookieJar()br.set_cookiejar(cj)# Browser optionsbr.set_handle_equiv(True)br.set_handle_gzip(True)br.set_handle_redirect(True)br. set_handle_referer(True)br.set_handle_robots(False)br.set_handle_refresh(mechanize._htt p.HTTPRefreshProcessor(), max_time=1)# The site we will navigate into, handling it’s sessionbr.open(‘https://github/login’)for f in br.forms(): print fbr.select_form(nr=0)# User credentialsbr.form[‘login’] = ‘myusername’br.form[‘password’] = ‘mypwd’# Loginbr.submit()br.open(‘github/settings/emails’).read()cj = cookielib.CookieJar()opener = urllib2.build_opener(urllib2.HTTPCookieProcessor(cj))login_data = urllib.urlencode({‘username’ : username, ‘j_password’ : password})opener.open(‘https://github/login’, login_data)resp = opener.open(‘https://github/settings/emails’)print resp.read()opener = 什么是BeautifulSoup? Beautiful Soup 是用Python写的一个HTML/XML的解析器,它可以很好的处理不规范标记并生成剖析树(parse tree)。它提供简单又常用的导航(navigating),搜索以及修改剖析树的操作。它可以大大节省你的编程时间。 直接看例子: #!/usr/bin/python # -*- coding: utf-8 -*- from bs4 import BeautifulSoup html_doc = """ The Dormouse's story Once upon a time there were three little sisters; a nd their names were Elsie, Lacie and Tillie; and they lived at the bottom of a well. ... """ soup = BeautifulSoup(html_doc) print soup.title print https://www.360docs.net/doc/a112431187.html, print soup.title.string print soup.p print soup.a print soup.find_all('a') print soup.find(id='link3') print soup.get_text() 结果为: https://www.360docs.net/doc/a112431187.html, python爬虫技术:动态页面抓取超级指南_光环大数据Python培训 当我们进行网页爬虫时,我们会利用一定的规则从返回的 HTML 数据中提取出有效的信息。但是如果网页中含有 JavaScript 代码,我们必须经过渲染处理才能获得原始数据。此时,如果我们仍采用常规方法从中抓取数据,那么我们将一无所获。浏览器知道如何处理这些代码并将其展现出来,但是我们的程序该如何处理这些代码呢?接下来,我将介绍一个简单粗暴的方法来抓取含有JavaScript 代码的网页信息。 大多数人利用lxml和BeautifulSoup这两个包来提取数据。本文中我将不会介绍任何爬虫框架的内容,因为我只利用最基础的lxml包来处理数据。也许你们会好奇为啥我更喜欢lxml。那是因为lxml利用元素遍历法来处理数据而不是像BeautifulSoup一样利用正则表达式来提取数据。本文中我将介绍一个非常有趣的案例——之前我突然发现我的文章出现在最近的 Pycoders weekly issue 147中,因此我想爬取 Pycoders weekly 中所有档案的链接。 很明显,这是一个含有 JavaScript 渲染的网页。我想要抓取网页中所有的档案信息和相应的链接信息。那么我该怎么处理呢?首先,我们利用 HTTP 方法无法获得任何信息。 import requestsfrom lxml import html# storing responseresponse = requests.get('https://www.360docs.net/doc/a112431187.html,/archive')# creating lxml tree from response bodytree = html.fromstring(response.text)# Finding all anchor tags in responseprint tree.xpath('//div[@class="campaign"]/a/@href') 当我们运行上述代码时,我们无法获得任何信息。这怎么可能呢?网页中明明显示那么多档案的信息。接下来我们需要考虑如何解决这个问题? 如何获取内容信息? Beautiful Soup中文文档 from BeautifulSoup import BeautifulSoup # For processing HTML from BeautifulSoup import BeautifulStoneSoup # For processing XML import BeautifulSoup# To get everything 下面的代码是Beautiful Soup基本功能的示范。你可以复制粘贴到你的python文件中,自己运行看看。from BeautifulSoup import BeautifulSoup import re doc = [' This is paragraph one.', ' This is paragraph two.', ''] soup = BeautifulSoup(''.join(doc)) print soup.prettify() # # # This is paragraph # # one # # . # # # This is paragraph # # two # # . # # # navigate soup的一些方法: soup.contents[0].name # u'html' soup.contents[0].contents[0].name # u'head' head = soup.contents[0].contents[0] https://www.360docs.net/doc/a112431187.html, # u'html' head.next # This is paragraph one. head.nextSibling.contents[0].nextSibling # This is paragraph two. 下面是一些方法搜索soup,获得特定标签或有着特定属性的标签: titleTag = soup.html.head.title titleTag # This is paragraph one. ] soup.find('p', align="center") # This is paragraph one. soup('p', align="center")[0]['id'] # u'firstpara' soup.find('p', align=https://www.360docs.net/doc/a112431187.html,pile('^b.*'))['id'] # u'secondpara' soup.find('p').b.string # u'one' soup('p')[1].b.string # u'two' 修改soup也很简单: titleTag['id'] = 'theTitle' titleTag.contents[0].replaceWith("New title") soup.html.head # 〇. python 基础 先放上python 3 的官方文档:https://https://www.360docs.net/doc/a112431187.html,/3/ (看文档是个好习惯) 关于python 3 基础语法方面的东西,网上有很多,大家可以自行查找. 一. 最简单的爬取程序 爬取百度首页源代码: 来看上面的代码: ?对于python 3来说,urllib是一个非常重要的一个模块,可以非常方便的模拟浏览器访问互联网,对于python 3 爬虫来说, urllib更是一个必不可少的模块,它可以帮助我们方便地处理URL. ?urllib.request是urllib的一个子模块,可以打开和处理一些复杂的网址The urllib.requestmodule defines functions and classes which help in opening URLs (mostly HTTP) in a complex world —basic and digest authentication, redirections, cookies and more. ?urllib.request.urlopen()方法实现了打开url,并返回一个http.client.HTTPResponse对象,通过http.client.HTTPResponse的read()方法,获得response body,转码最后通过print()打印出来. urllib.request.urlopen(url, data=None, [timeout, ]***, cafile=None, capath=None, cadefault=Fals e, context=None)For HTTP and HTTPS URLs, this function returns a http.client.HTTPResponseobject slightly modified.< 出自: https://https://www.360docs.net/doc/a112431187.html,/3/library/urllib.request.html > ?decode('utf-8')用来将页面转换成utf-8的编码格式,否则会出现乱码二模拟浏览器爬取信息 在访问某些网站的时候,网站通常会用判断访问是否带有头文件来鉴别该访问是否为爬虫,用来作为反爬取的一种策略。 先来看一下Chrome的头信息(F12打开开发者模式)如下: 《网络数据采集实验》课程教学大纲 课程编码:12120801314 课程性质:方向课 学分:2 课时:36 开课学期:6 适用专业:电子商务 一、课程简介 《网络数据采集》是面向计电子商务专业本科生开设的一门专业方向课。以Python语言为例进行讲解。本课程主要讲述BeautifulSoup的安装与使用、正则表达式、HTML解析、Scrapy的使用,MySQL数据库。通过本课程的学习,可以使学生了解网络采集数据的原理与基本思想,如何解析网页结构并提取出需要的内容。本课程的先修课程为:计算机文化基础,Python程序设计。 二、教学目标 通过本课程的教学应实现以下目标: 了解该课程的基本内容,了解网络数据采集的常用方法; 理解该课程的主要网络数据采集模块,并能够熟练使用; 掌握该课程的主要技能并能在实际工作中应用,包括编写具有基本功能的爬虫,使用爬虫框架等。 三、实验项目与课时分配 四、实验条件 五、实验内容及要求 六、实验报告 实验报告内容有:实验名称、目的、内容、原理、实验步骤、实验记录、数据处理(实验现象描述、原理论证、结构说明、误差分析等)、讨论等。 七、考核办法和成绩评定 1.考核方式:操作 2.成绩评定:实验总评成绩=平时考核成绩×30%+操作考核×70% 八、推荐实验指导书 1.《Python网络数据采集》(第1版),米切尔 (Ryan Mitchell) (作者), 陶俊杰 (译者), 陈小莉 (译者),人民邮电出版社,2016年。 2.《Python网络爬虫实战》(第1版),胡松涛编著,清华大学出版社,2017年。 3. 《用Python写网络爬虫》(第1版),[澳]理查德劳森 (作者), 李斌 (译者),人民邮电出版社,2016年。 大纲制订人:杜亚敏 大纲审定人:黄铭 制订时间: 2017年 9月 3 日 Beautiful Soup 4.2.0 文 档? Beautiful Soup是一个可以从HTML或XML文件中提取数据的Python库.它能够通过你喜欢的转换器实现惯用的文档导航,查找,修改文档的方式.Beautiful Soup会帮你节省数小时甚至数天的工作时间. 这篇文档介绍了BeautifulSoup4中所有主要特性,并切有小例子.让我来向你展示它适合做什么,如何工作,怎样使用,如何达到你想要的效果,和处理异常情况. 文档中出现的例子在Python2.7和Python3.2中的执行结果相同 你可能在寻找Beautiful Soup3的文档,Beautiful Soup 3 目前已经停止开发,我们推荐在现在的项目中使用Beautiful Soup 4, 移植到BS4 如果你有关于BeautifulSoup的问题,可以发送邮件到讨论组 .如果你的问题包含了一段需要转换的HTML代码,那么确保你提的问题描述中附带这段HTML文档的代码诊断[1] 下面的一段HTML代码将作为例子被多次用到.这是爱丽丝梦游仙境的的一段内容(以后内容中简称为爱丽丝的文档): html_doc =""" The Dormouse's story Once upon a time there were three little sisters; and their names werePython数据可视化的应用研究

【IT专家】如何使用Python抓取需要首先登录的网站

什么是BeautifulSoup

python爬虫技术 动态页面抓取超级指南_光环大数据Python培训

Beautiful Soup中文文档

北大青鸟:你需要的python爬虫笔记

网络数据采集

Beautiful Soup 4.2.0 文档