基于单摄像机视线跟踪的眼控鼠标

基于单摄像机视线跟踪的眼控鼠标?

刘瑞安1, 2+,靳世久1,吴晓荣2

1(天津大学 精密测试技术及仪器国家重点实验室,天津 300072)

2(天津师范大学 物理与电子信息学院,天津 300074)

摘 要:提出一种能对用户头部位置变化自动适应的视线跟踪方法,减少了系统对使用者的头部限制。依据瞳孔边界点的灰度信息、梯度信息及瞳孔边界曲线的平滑信息综合判据,给出了一种提取瞳孔边缘点的一维算法;为提高系统的分辨率和精确度,提出了一种眼睛红外图像中瞳孔亚像素边缘检测与中心定位算法。利用眼睛角膜反射光斑和瞳孔中心的位置关系来确定视线方向,推导出人眼在计算机屏幕上的注视点,进而实现人眼对鼠标的定位与操作,其在显示屏上定位精度可达到40像素以内。

关键词:视线跟踪;眼控鼠标;角膜反射;边缘检测;亚像素;椭圆拟合

1. 引言

眼睛是人类从周围世界中获取信息的重要器官,也是反映人的心理活动的窗口。将视线应用于人机交互可带来直接性、自然性和双向性[1]等优点。眼注视是一种非常好的能使人机对话变得简便、自然的候选输入通道,将人的眼睛作为输入媒介,通过眼睛盯视,对外部设备进行控制可以实现多任务操作,在一些工业控制、机器人学和临床医学上有着广泛的发展前景。

目前,人机交互已成为计算机科学研究的一个越来越重要的领域。在个人电脑飞速发展的今天,鼠标一直是最为重要的人机交互设备之一。而眼控鼠标是利用图像处理技术对捕获的眼睛图像进行处理,提取人眼视线方向及注视点位置,进而实现人眼对鼠标的定位与操作。视线跟踪技术是未来智能人机接口的关键技术之一,在人机交互领域有着广阔的应用前景。国际上一些公司与科研机构正致力于眼控鼠标的开发与研究,日本净冈大学的海泽嘉教授开发出一种可以用眼球控制的鼠标系统;布拉格捷克技术大学的研究人员也推出了一款可用眼睛控制电脑的操作系统。

视线方向的识别、跟踪,是实现眼控鼠标的关键技术。而利用角膜反射原理的视线跟踪技术,具有非侵入的优点,近年来取得了较快进展,人们也进行了将该技术应用于人机交互领域的大量研究工作[2,3]。该技术在用户头部不动情况下可获得较高精度,但对头动敏感。为减少对用户的限制,Sugioka[4]使用超声技术测得CCD和人眼之间的距离,Ebisawa[5]增加两个摄像机来获得眼睛的三维空间坐标。这不仅增加了系统复杂性,且系

* 基金项目:天津市高等学校科技发展基金项目(20051017)

* 刘瑞安,Email: wdxylra@https://www.360docs.net/doc/a718952194.html,

统精度受位置测量精度的局限。为克服上述困难,本文提出了一种能对用户头部位置变化自动适应的视线跟踪方法,实现了人眼对鼠标的定位与操作。

2. 系统原理与控制模型

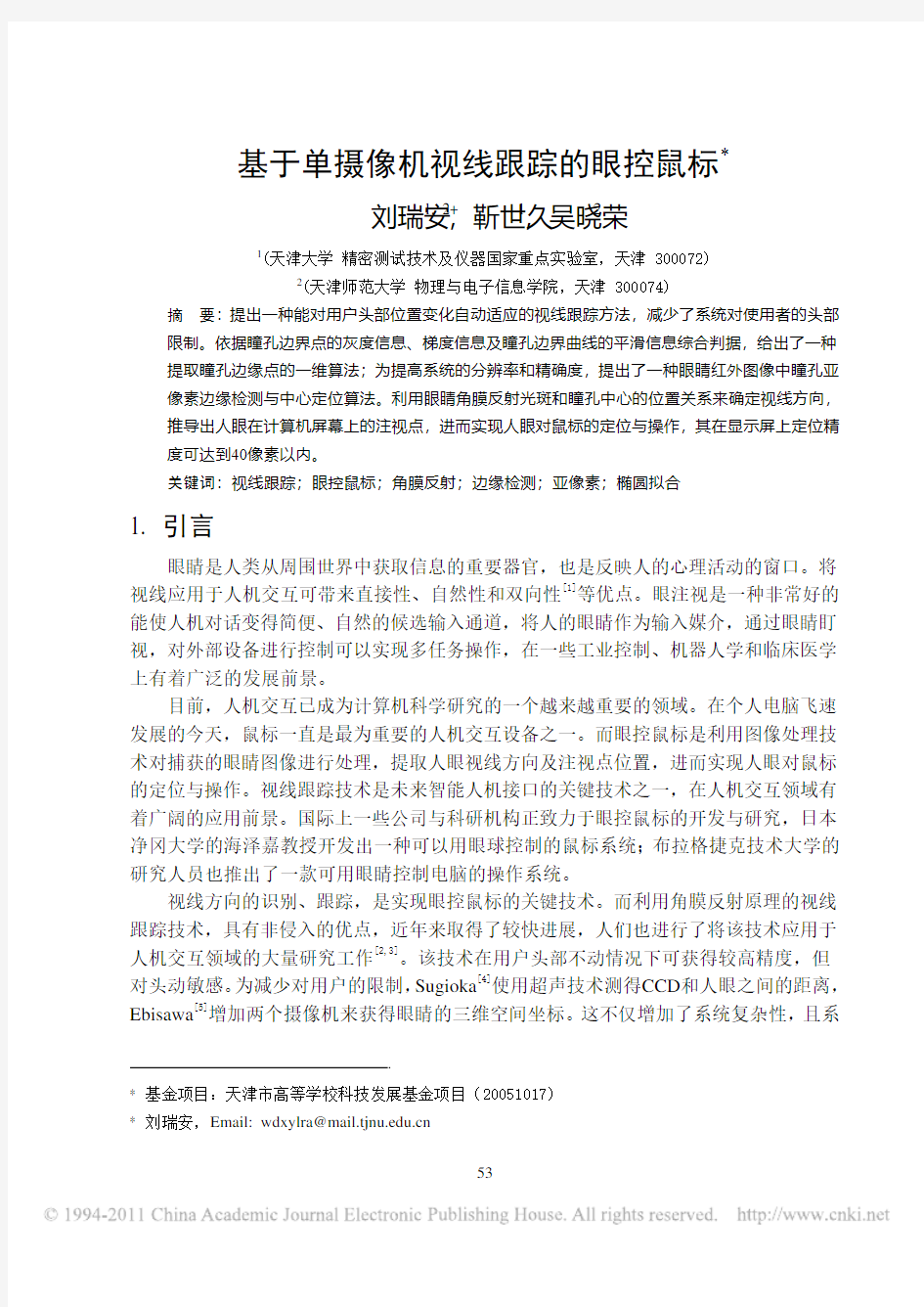

系统采用角膜反射原理。近红外光源发出的光在用户眼睛角膜上形成高亮度反射点(glints),利用瞳孔中心和光斑的相对位置关系确定视线方向。硬件组成如图1所示。

图1 系统硬件结构框图

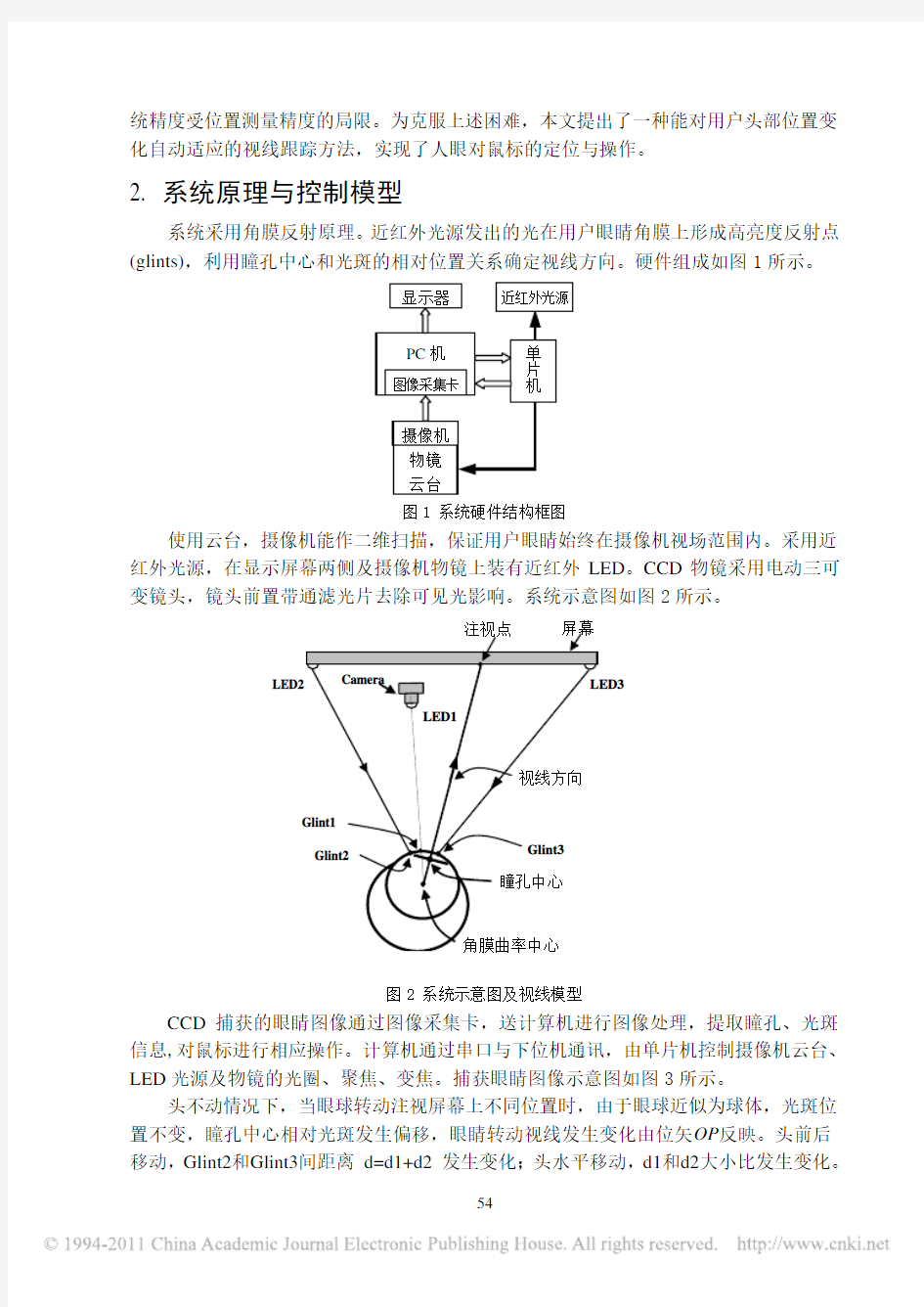

使用云台,摄像机能作二维扫描,保证用户眼睛始终在摄像机视场范围内。采用近红外光源,在显示屏幕两侧及摄像机物镜上装有近红外LED。CCD物镜采用电动三可变镜头,镜头前置带通滤光片去除可见光影响。系统示意图如图2所示。

图2 系统示意图及视线模型

CCD捕获的眼睛图像通过图像采集卡,送计算机进行图像处理,提取瞳孔、光斑信息,对鼠标进行相应操作。计算机通过串口与下位机通讯,由单片机控制摄像机云台、LED光源及物镜的光圈、聚焦、变焦。捕获眼睛图像示意图如图3所示。

头不动情况下,当眼球转动注视屏幕上不同位置时,由于眼球近似为球体,光斑位置不变,瞳孔中心相对光斑发生偏移,眼睛转动视线发生变化由位矢OP反映。头前后移动,Glint2和Glint3间距离 d=d1+d2 发生变化;头水平移动,d1和d2大小比发生变化。

利用光斑 Glint2和Glint3 的中间位置控制云台;以光斑 Glint2和Glint3 的间距为依据调节镜头焦距,保证光学系统成像放大率不变,克服头部前后运动影响;利用光斑的灰度值来调节物镜光圈及LED 发光功率;依据瞳孔边界点的梯度平均值和光斑大小调节聚焦。由于头部运动,图像中眼睛丢失时,开大CCD 视场,关闭 LED2和LED3,此时仅 LED1亮,它和CCD 光轴同轴,出现亮瞳孔现象;而 LED2和LED3 打开时,对应暗瞳

孔图像。利用明、暗图像差法[2,3,5,6],可克服环境干扰,快速搜索到眼睛位置。

图3 捕获图像示意图

3. 瞳孔中心精确定位

3.1 瞳孔边界点提取

很多算法对整个眼睛图像利用边缘算子提取瞳孔边界,考虑到瞳孔边界只占图像很小部分,故这些方法时间开销大,效率不高。

依据光斑位置,确定瞳孔搜索区域。利用搜索窗内瞳孔二值化图粗定瞳孔中心,并作为搜索瞳孔边界的起始点。在不同方向上做一维扫描,在搜索线上感兴趣区域,结合像素点灰度值、梯度值及边界曲线的平滑特性,由(1)式通过寻找最大值,决定边缘点位置r ,提取边界点。

)())(()()(1210?????=n r r k Ip r I k r G k r f (1) f 为判据函数,)(r I 为搜索点灰度值,Ip 为瞳孔阈值,)(r G 为搜索点梯度值,由一维梯度算子[-1 0 1]计算得到,1?n r 为相邻搜索线上得到的边界点半径,0k 、1k 、2k 为由试验定值的权重参数。

考虑到东方人眼敛常常张的不是特别开的特点,常出现瞳孔被眼敛、眼睫毛部分遮挡;在眼睛及头部运动情况下,光斑有时落在瞳孔边界上或附近区域。在瞳孔边界点提取过程中,受遮挡影响及边界上的其它噪声(像阴影、光斑等),会产生一些虚假边界点,如图4中p1、p2点,其存在严重影响后续椭圆拟合算法,进而影响瞳孔中心定位。剔除虚假边界点,才能进一步提高定位精度。图4中P1为粗定瞳孔中心,P2为包含p1、p2时椭圆拟合中心,P3为剔除p1、p2后的拟合中心。

Ohno [7]利用两次椭圆拟合来去除干扰。Starburst 算法[8]采用填充方法,将光斑删除,根据邻近区域灰度值对其插值填充。上述算法复杂且耗时。根据光斑所处位置,将搜索到的光斑附近的瞳孔虚假边界点直接剔除,简单省时。对眼敛遮挡,依据相邻边界点连线的导数变化情况,确定为虚假边界点后采用了类似处理方法。

图4 去除瞳孔边界处干扰示意图

剔除虚假边界点后,在搜索线方向上,对得到的像素级边缘点前后邻近的几个像素点计算其一维梯度值,然后对亚像素位置进行梯度的一维多项式插值,通过寻找局部极值点得到亚像素位置精度的边缘点位置,提高系统的精度和分辨率。

3.2 瞳孔中心定位

瞳孔经光学系统在CCD 成像为平面椭圆,所以对提取的边缘点进行椭圆最小二乘拟合链接成边界,即可确定瞳孔中心位置。椭圆方程取为:

022=+++++E Dy Cx By Axy x (2) 椭圆拟合可求得椭圆方程的5个参数A、B、C、D 和 E ,椭圆中心计算公式如下:

B A AD B

C x 4220??=, B

A AD D y 4220??= (3) 实验图像经上述算法处理,处理效果图如图5所示。

图5 瞳孔边缘检测与中心定位

4. 鼠标控制的实现

图像中光斑面积小、亮度大,受干扰小,采用圆模型处理,提取光斑区域质心位置。 求出瞳孔中心坐标及光斑位置后,可得到瞳孔中心与光斑的位置相对偏移量。用

P1

),(p p y x 表示瞳孔中心的图像坐标,),(g g y x 表示光斑参考位置(图3中点O )的图像坐标。瞳孔中心与光斑的位置相对偏移量为:

g p g p y y dy x x dx ?=?=, (4) 用),(Ys Xs 表示眼睛注视点的屏幕坐标。通过多项式变换建立如下映射关系: ),(),(s s Y X dy dx f →:

22)(5)(4))((3)(2)(10dy a dx a dy dx a dy a dx a a Xs +++++= (5) 22)(5)(4))((3)(2)(10dy b dx b dy dx b dy b dx b b Ys +++++= (6) 通过校准环节,可由最小均方差法定出参数5050~,~b b a a 。被测水平移动,得到不同位置变换参数,经插值运算后可用于实测。

系统可工作在一般办公室环境,人眼距离计算机屏幕50-80cm 左右,屏幕17英寸,分辨率是1280x1024 pixels。将屏幕区域划分为40×40像素的小方格,可依据测试者注视点的变化改变对应方格颜色。针对不同测试者,先进行调校实验,设置各项参数后,基本能够实现对视线的跟踪与定位。统计数据表明,准确率平均高达92%。

5. 结束语

本文探讨的眼控鼠标以较高精度实现了鼠标的定位。该技术可用于盯视输入系统,作为对键盘、鼠标等传统人机交互方式的补充,可应用于助残、机器人人机交互平台等。未来工作主要针对提高跟踪速度,简化校准环节展开研究,以实现真正的非接触、高精度、可应用于多领域的实用视线跟踪技术。

参考文献

[1] WANG JIAN. “Integration of eye-gaze, voice and manual response in multimodal user interface”. In Proc. of the IEEE International Conference on System, Man and Cybemetics. IEEE. 1995. Piscataway, N.J. P3938-3942.

[2] Zhiwei Zhu, Qiang Ji. “Eye and gaze tracking for interactive graphic display”. Machine Vision and Applications. 2004. 15, P139-148.

[3]B. Noureddin, P.D. Lawrence, C.F. Man. “A non-contact device for tracking gaze in a human computer interface”. Computer Vision and Image Understanding.2005.98, P52-82.

[4]A.SUGIOKA, Y. EBISAWA, M. OHTANI. “Noncontact video-based eye-gaze detection method allowing large head displacements”. In: IEEE Internet. Conf. on Medicine and Biology Society. IEEE.1996. Amsterdam.P526-528. [5]YOSHINOBU EBISAWA. “Realtime 3D position detection of human pupil”.VECIMS 2004-IEEE

International Conference on Virtual Environments, Human-Computer Interfaces, and Measurement Systems. IEEE. 2004. Boston.P8-12.

[6]DONG HYUN YOO, MYUNG JIN CHUNG. “A novel non-intrusive eye gaze estimation using cross-ratio under large head motion”. Computer Vision and Image Understanding.2005.98, P25-51.

[7]T. OHNO, N. MUKAWA, A. YOSHIKAWA. “FreeGaze: a gaze tracking system for everyday gaze interaction”. In Proc. of Eye Tracking Research and Applications Symposium. ETRA.2002.New Orleans.P125-132.

[8]DONGHENG Li, DAVID WINFIELD, DERRICK J. PARKHURST. “Starburst: A hybrid algorithm for video-based eye tracking combining feature-based and model-based approaches”. https://www.360docs.net/doc/a718952194.html,/openEyes.

Eye-Controlled Mouse Based on Eye-Gaze Tracking

Using One Camera

LIU Rui-An1,2+, JIN Shi-Jiu1, WU Xiao-Rong2

1(State Key Laboratory of Precision Measuring Technology and Instruments, Tianjin

University, Tianjin 300072,China)

2(College of Phy sics and Electronic Information Science, Tianjin Normal University,

Tianjin 300074,China)

+ Corresponding author: Phn: +86-022-2371-0378, E-mail:wdxylra@https://www.360docs.net/doc/a718952194.html,

Key words: gaze tracking; eye-controlled mouse; corneal reflection; edge detection; subpixel; ellipse fitting

Abstract: An eye-gaze tracking method, which can make this system be adaptive to the user’s head movements freely, was put forward to alleviate the restriction on the user’s head movements. On the basis of the brightness, gradient of the edge points of the pupil and the smoothness of the pupil boundary, the edge points could be obtained by a 1D line search. To improve the resolution and accuracy of the system, a Sub-pixel edge detection algorithm was proposed in order to locate the center of the pupil accurately in IR image of the eye. The gaze direction was determined by the relationship between the position of the pupil center and the corneal reflections. The gaze point on the computer screen was derived and the mouse position could be determined through the eye. The accuracy of the position of the cursor on the screen is within 40 pixels.

基于标记点检测的视线跟踪注视点估计

基于标记点检测的视线跟踪注视点估计 龚秀锋,李 斌,邓宏平,张文聪 (中国科学技术大学电子科学与技术系,合肥 230027) 摘 要:传统的头戴式视线跟踪系统需要借助额外的头部位置跟踪器或其他辅助设备才能定位视线方向。针对该问题,提出一种基于标记点检测的注视点估计方法。该方法通过计算机视觉的方法检测标记点,建立场景图像与真实场景中计算机屏幕之间的空间关系,将场景图像中的注视点坐标映射到计算机屏幕中。实验结果表明,该方法简单易行,可以较好地估计出用户在真实场景中的注视点坐标。 关键词:视线跟踪;注视点估计;头戴式视线跟踪系统;标记点检测 Eye Tracking Gaze Estimation Based on Marker Detection GONG Xiu-feng, LI Bin, DENG Hong-ping, ZHANG Wen-cong (Department of Electronic Science and Technology, University of Science and Technology of China, Hefei 230027, China) 【Abstract 】For head-mounted eye gaze tracking, additional head position sensors is needed to determine the gaze direction, a new method based on marker detection is proposed to estimate the gaze of point for head-mounted system in this paper. The markers are detected by computer vision method, and the relationship between scene image and computer screen is constructed with point correspondences in two views. The point of gaze in the scene image is translated to computer screen coordinate. Experimental result shows that this method can estimate the point of gaze in real scene easily irrespective of user’s head position. 【Key words 】eye tracking; gaze estimation; head-mounted eye tracking system; marker detection DOI: 10.3969/j.issn.1000-3428.2011.06.100 计 算 机 工 程 Computer Engineering 第37卷 第6期 V ol.37 No.6 2011年3月 March 2011 ·开发研究与设计技术· 文章编号:1000—3428(2011)06—0289—02文献标识码:A 中图分类号:TP391 1 概述 视线跟踪系统是通过视频设备监控眼球运动状态,估计眼睛的视线方向或注视点的设备。眼睛的视线方向或注视区域通常反映了人感兴趣或引起注意的内容,因此,视线是一种非常好的人机交互输入通道[1]。近些年来,视线跟踪技术作为人机交互接口已经引起国内外广泛的研究。 头戴式视线跟踪系统是将眼部摄像头和场景摄像头等硬件固定在头盔或者镜架上,允许用户头部自由活动的一类视线跟踪设备。头戴式视线跟踪系统提供的注视点坐标是位于场景摄像机的像平面内而不是在真实场景中,用户不能直接与真实场景交互。一般情况下,头戴式视线跟踪系统需要配合头部姿态定位仪才能准确定位视线方向。如文献[2]采用在头顶固定一个磁感应器检测头部位置。采用附加头部位置跟踪装置的方法,不仅增加了系统的复杂度,也会将头部定位的误差引入系统中,降低系统的精度。 本文提出一种基于计算机视觉的标记点检测的头戴式视线跟踪系统注视点估计方法。在位于场景中的计算机屏幕四周设置若干标记点,实时检测场景图像中标记点的坐标位置,并与标记点在屏幕中的坐标组成点对应,利用射影变换技术建立场景图像与计算机屏幕之间的映射关系,通过该映射关系将注视点在场景图像中的坐标转化成在计算机屏幕中的坐标,最终计算出用户在真实场景中的注视点。 2 头戴式视线跟踪系统模型 基于标记点检测的头戴式视线跟踪系统如图1所示。眼 部摄像头和场景摄像头固定在头部前方,眼部摄像头实时采集眼部图像,场景摄像头实时并且与眼部摄像头同步的采集 视线前方的场景图像。通过场景摄像头,将随头部转动而相对变化的场景转化为相对于头部静止的场景图像。因此,通 过标定程序建立场景图像和眼部图像的映射关系,计算出每帧场景图像中的注视点[3]。本文通过建立场景图像坐标和真实场景中计算机屏幕的空间映射关系,计算用户在真实场景 图 1 头戴式视线跟踪系统 2.1 场景图像和计算机屏幕之间的映射模型 如图1所示,计算机屏幕通过场景摄像头拍摄成场景图像。计算机屏幕与场景图像中的对应点满足三维到二维的摄像机投影映射关系,采用摄像机的针孔模型,空间中的点与2D 像平面中对应点满足[4]: 34X x Y y P Z w T ×?? ???????? =???????????? ?? (1) 如果所有的点都在同一平面(Z =0),则式(1)简化为: 33x X y P Y w T ×???????? =???????????? (2) 基金项目:国家自然科学基金广东联合基金资助项目(U0835002) 作者简介:龚秀锋(1984-),女,硕士研究生,主研方向:视线跟踪,模式识别;李 斌,副教授、博士;邓宏平、张文聪,博士研究生 收稿日期:2010-07-21 E-mail :gxiufeng@https://www.360docs.net/doc/a718952194.html,

视线跟踪技术在人机交互中的研究

摘要:人们在观察外部世界时眼睛总是与其它人体活动自然协调地工作,并且眼动所需的认知负荷很低,人眼的注视包含着当前的任务状况以及人的内部状态等信息,因此眼注视是一 种非常好的能使人机对话变得简便、自然的候选输入通道.本文介绍了视线跟踪的基本原理、方法,对视线跟踪作为人机交互通道所具有的特点进行了讨论,并指出了其在人机交互领域 中的应用及前景. 关键词:人机交互;视线跟踪;多通道用户界面 目前用户界面所使用的任何人机交互技术几乎都有视觉参与。早期的视线跟踪技术首先应用于心理学研究(如阅读研究),后被用于人机交互。眼动在人的视觉信息加工过程中,起着重要的作用。它有三种主要形式:跳动(Saccades), 注视(Fixations)和平滑尾随跟踪( Smooth Pursuit)。在正常的视觉观察过程中,眼动表现为在被观察目标上一系列的停留及在这停留点之间的飞速跳动,这些停留一般至少持续100ms以上,称为注视。绝大多数信息只有在注视时才能获得并进行加工。注视点间的飞速跳跃称为眼跳动。眼跳动是一种联合眼动(即双眼同时移动),其大小为1到40 度视角,持续时间为30到120ms,最高运动速度为400-600度/秒。 视线跟踪精度与在测量时对用户的限制和干扰就是一对矛盾.在多通道用户界面设计中,减少这种限制和干扰是非常重要的,视线作为交互装置最直接的用处就是代替鼠标器作为一种指点装置。 一、视线跟踪的基本原理、方法 视线跟踪技术及装置有强迫式(intrusiveness)与非强迫式(non-intrusiveness)、穿戴式与非穿戴式、接触式(如Eyeglass-mounted)与非接触式(Remote)之分;其精度从0.1°至1°或2°不等,制造成本也有巨大差异。在价格、精度与方便性等因素之间作出权衡是一件困难的事情,例如视线跟踪精度与对用户的限制和干扰就是一对尖锐的矛盾。有关视觉输入的人机界面研究主要涉及两个方面:一是视线跟踪原理和技术的研究;二是在使用这种交互方 式后,人机界面的设计技术和原理的研究. 眼睛能平滑地追踪运动速度为1到30度/秒的目标,这种缓慢、联合追踪眼动通常称为平滑尾随跟踪。平滑尾随跟踪必须有一个缓慢移动的目标,在没有目标的情况下,一般不能执行这种眼动。在人机交互中,主要表现为跳动和注视两种形式。而主要的视线跟踪技术方法如图所示:

关于目标自动跟踪智能摄像机的探讨汇总

关于目标自动跟踪智能 摄像机的探讨 【摘要】:智能一体化球型摄像机在视频监控领域发挥着越来越重要的作用,而目标检测与自动跟踪逐渐成为球型摄像机的一个重要发展方向。本文实现了智能球型摄像机控制系统软件功能,并在PC上实现了目标检测,在此基础上将检测到的目标信息处理后通过PC串口发送给球型摄像机,球型摄像机控制云台运动,从而实现目标跟踪.以自动跟踪为特点的球型摄像机被誉为“解放人力的运动的跟踪技术”,采用这种摄像机的监控系统可以智能地探测、跟踪运动目标,实现对运动目标的自动跟踪、录像、报警,彻底改变了视频监控系统只能作为辅助系统的局面。 【关键词】智能球形摄像机;目标检测;自动跟踪 一、概述 智能追踪高速球型摄像机是专为IP网络监控系统而设计的.搭载新一代电子活动目标识别和追踪技术,实现全方位无盲点监控.代表新一代安防监控产品的发展潮流。集成了全天候防护罩、云台和数字解码器及多种变焦功能的彩色/黑白一体化摄像机。全天候防护罩符合国际标准IP66防护等级,内置自动恒温装置。可适用于恶劣环境,安装方式采用吊装或壁装。球机可在水平方向实现360°无限位旋转,垂直方向180°旋转。 智能追踪高速球型摄像机支持自动追踪、定时追踪、越界追踪、报警追踪四种追踪模式的设置。也支持手动追踪模式。用户可以根据自己的需求进行灵活编排。智能追踪高速球型摄像机支持系统接力追踪,当某个智能追踪球的活动目标逃离当前追踪画面,系统自动通知附近路线的智能追踪球启动追踪模式或者通知周围的普通摄像机启动活动目标检测功能。从而实现了球机到球机、球机到枪机、枪机到球机、枪机到球机的智能接力追踪。同时智能追踪高速球型摄像机支持绊线检测功能。用户可以在画面上设置虚拟的周界,当有活动目

基于视线跟踪技术的职业素质测评模式

《商场现代化》2012年10月(下旬刊)总第699期图1视线跟踪技术图2视线信息人力资源 基于视线跟踪技术的职业素质测评模式 ■杜鹏 大连海洋大学文法学院 基金项目:国家自然基金课题(71072085);云南省教育厅科学研究课题(2011Y329);云南省哲学社会科学规划课题(QN201116);大连海洋大学教改项目课题(JG2011YB35) [摘要]如何有效客观测评员工职业素质,是当前国内外一个重要研究课题。本文首次创新性提出基于视线跟踪技术的职业素 质测评模式,该模式能客观的考察员工职业知识的掌握程度,而且能进一步测评被测试者的思维模式、 思维习惯等隐性的职业素质能力,这些信息能更加全面客观地测评员工的职业素质。本文的研究不论对今后职业素质测评模式研究还是对企业人员招聘,都有重要的理论及实际意义。 [关键词]视线跟踪职能能力视线信息环视线轨迹 职业素质(Professional Quality )是劳动者对社会职业了解与适 应能力的一种综合体现,主要包括职业兴趣、 职业素质、职业个性及职业情况等方面。影响和制约职业素质的因素很多,例如:受教育程度、实践经验、社会环境、工作经历以及自身的一些基本情况。职业素质测评:是指测评主体从特定的人力资源管理目的出发,运用各种测量技术,收集受测人在主要活动领域中的表征信息,对人的素质进行 全面系统的评价,以求对人有客观、 全面、深入的了解,从而为人力资源开发和管理提供科学的决策依据。 目前的测评方法主要有:1.公文筐测验:是对实际工作中管理人员掌握和分析资料、处理各种信息以及做出决策的工作活动的抽象和集中。2.无领导小组讨论:是评价中心常用的一种无角色群体自由讨论的测评形式。3.管理游戏:在这种测评中,各位被试人置身于一个模拟的环境中,面临一些管理中常常遇到的各种现实问题,并被分配一定的任务,但这些问题必须合作才能较好地完成。4.角色扮演:在这种测评活动中,主试人设置了一系列尖锐的人际矛盾与人际冲突,要求被试者扮演某一角色并进入角色情境去处理各种 问题和矛盾。 以上方法比较有效的测评被测试了人员的职业素质能力,但是目前很多职前教育机构和培训机构为应对公司和企业对员工的职业素质的测评,为被测评者提供职业素质水平测评的题库和答案以及应对的技巧,使得这些职业素质能力测评在一定程度上失去客观性。 如何能有效的测评职业素质,是目前国内外非常关注研究的课题,而国内外目前研究方向多集中在测评题目的设定和心理学分析上,虽有了一定的成效,但没有突破原有的测评方法,效果一般。本文突破性地提出了基于视线跟踪技术的职能素质测评模式,该模式增加了测试信息的获得量并更大程度的保证了测试的客观性,而且这种测试方法能有效地规避职前教育机构和培训机构对测试人员的培训技巧。 一、视线跟踪技术 人类对外界信息获取过程中,信息摄取和辨析在很大程度上依赖视觉信息,约有80%~90%的外界信息通过人的眼睛获得。由于人的视线具有直接性、自然性和双向性等其它信息所无法具备的特点[1],使得视线信息在人类对各种信息的利用中具有更高的权重和信服性。 如图1所示视线跟踪技术是利用摄像技术、光学原理、图像处理、 三维建模等技术分析出观察者视线的轨迹并跟踪其变化,最终获得其中的各种视线信息。随着视线跟踪技术的逐步成熟,视线跟踪技术也开始应用的越来越广泛。例如警察的预审研判系统,医疗的心理咨询,商业的广告测评、货架排放测评,残疾人的视觉轮椅,交互功能的家用电器,虚拟现实和游戏等领域。 而本文创新性的首次将视线跟踪技术应用到了员工职业素质测评中,下文将详细论述在职业素质测评过程中,通过视线跟踪技术能获得的各种隐性信息以及这些信息对职业测评的作用。 二、职业素质测评中的隐性信息传统的职业素质测评方法中,通过测评的考题所能获得的信息有限,不能全面客观反应出被测试人员的职业素质能力,例如作弊或应用面试应 对技巧时,传统测评便不能反映员工 的职业素质。 职业素质测评中除答题信息外还 存在着很多隐性信息。 通过视线跟踪技术,获得被测试者测评过程中的各种视线变化信息,如图2所示,本文将这些信息分为视线信息环、视线轨迹信息、视线驻留时间信息。通过这些信息的数 据挖掘,可分析出被测评者在测评中的 思维模式,看问题的侧重点,观察事物的顺序等隐性信息。结合这些隐性信息就可客观全面反映出被测试者职业素质能力。 1.视线信息环。由于人眼的构造结构决定,人在观看事物时,不可能只观察一个点,而是以眼球的视轴为中心形成环形的信息面,我 们把这些环形的信息面称作视线信息环,如图2所示, 视线信息环的中心,观察者获得的信息较多,而从视线环中心越向外获得的信息越少。在职业素质测评中,我们可以通过分析被测评人员观察题目信息时的信息环,获得更多的职能能力测评信息,例如,如果在职能力测评中,被测评者在测评信息屏幕上视线留下各个信息环中,没有覆盖正确答案的信息环,可以说明被测评者在对题目的解答时可能是抄袭或者是随意蒙选。 2.视线驻留时间。人类在观察事物的过程行为中,表现出来的是眼球在一系列视线信息环上的停留以及在这些视线环上跳动,当在 视线环上的停留时间在100毫秒 (ms )以上时,人才能通过视觉观察事物获得外界信息。 我们通过视线跟踪技术,可以获得被测评人员在职业素质测评时,屏幕上留下每个视线环上的驻留时间,而通过对这些信息可以分析出被测评人员对特定信息的反应时间并协助判断测评人员对事物的关注点。 3.视线轨迹信息。注视点之间的飞速跳动称为眼球跳动。眼球的 跳动(saccades ) 由巴黎大学的Javal (1897)教授发现。例如在阅读文章或看一个物体时,人们往往认为自己的眼睛是沿着一行句子或图形的形状平滑地运动。事实上,我们的眼睛总是先在对象的一部分上停留一段时间,注视以后又跳到另一部分上,再对新的部分进行注 视。人眼在观察事物时眼球在视线信息环间的跳动,会形成移动的轨迹,我们把这样的轨迹信息称为视线轨迹信息。 在职业素质测评的过程中,我们可以通过对被测评人员观察事物的视线轨迹信息的分析,了解到被测评人员的思维模式,而对多个这种思维模式的分析可以了解到被测评人员的思维习惯。这些信息的获得,更加有利于员工职业素质的测评。 85

获取当前鼠标所在的窗口句柄

用到的API函数: GetCursorPos 基本信息 函数功能:该函数检取光标的位置,以屏幕坐标表示。 函数原型:BOOL GetCursorPos(LPPOINT lpPoint); 参数: IpPoint:POINT结构指针,该结构接收光标的屏幕坐标。 使用时要先定义一个数据结构: Public Type POINTAPI x As Long y As Long End Type 例如: dim biao as POINTAPI GetCursorPos biao 那么biao.x用来存放当前光标的x轴坐标,biao.y用来存放当前y轴的坐标。 返回值:如果成功,返回值非零;如果失败,返回值为零。若想获得更多错误信息,请调用GetLastError函数。 备注: 1.光标的位置通常以屏幕坐标的形式给出,它并不受包含该光标的窗口的映射模式的影响。该调用过程必须具有对窗口站的WINSTA_READATTRIBUTES访问权限。 2.此函数为api函数,调用时要函数声明:Public Declare Function GetCursorPos Lib "user32" (lpPoint As POINTAPI) As Long 速查:Windows NT:3.1及以上版本:Windows:95及以上版本;Windows CE:不支持;头文件:winuser.h;库文件:user32.lib。 WindowFromPoint 函数功能:该函数获得包含指定点的窗口的句柄。 函数原型:HWND WindowFromPoint(POINT Point); 参数:

Point:指定一个被检测的点的POINT结构。 返回值S:返回值为包含该点的窗口的句柄。如果包含指定点的窗口不存在,返回值为NULL。如果该点在静态文本控件之上,返回值是在该静态文本控件的下面的窗口的句柄。 备注:WindowFromPoint函数不获取隐藏或禁止的窗口句柄,即使点在该窗口内。应用程序应该使用ChildWindowFromPoint函数进行无限制查询,这样就可以获得静态文本控件的句柄。 速查:Windows NT:3.1以上版本:Windows:95以上版本;Windows CE:1.0以上版本:头文件:Winuser.h;库文件:user32.lib。 获取当前鼠标所在的窗口句柄代码: POINT pNow = {0,0}; If (GetCursorPos(&pNow)) { HWND hwndPointNow = NULL; hwndPointNow = WindowFromPoint(pNow); if (hwndPointNow) cout <<“Success!!”<< endl; else cout <<“Error!!”<< endl; } else cout <<“Error!!”<< endl;

用3DMAX打造逼真鼠标模型的教程

鼠标是最常用的电脑外设了,时间长了对它也会有一种特殊的感情,下面我们用3DMAX来打造一只常见的滚轮鼠标模型。 效果图: 制作工具:3DMAX9.0 制作过程: 1、在视图中创建4个用于拟合放样的二维模型,分别为基础路径、基础截面、X轴拟合图形、Y轴拟合图形,如图所示。

2、在顶视图中选择“基础路径”,然后进行基本放样操作,选择前视图中的“基础截面”。 3、进入修改命令面板,展开“变形”卷展栏,单击其中的“拟合”按钮,在弹出的窗口中单击“均衡”按钮取消坐标轴的锁定状态,这样可以分别对两个轴进行调整,效果如图所示。

4、单击“获取图形”按钮,然后在顶视图中选取“X轴拟合图形”,这时可以看到视图中出现了一个变形的造型。单击“顺时针旋转90度”按钮,效果如图所示。

5、在“拟合变形”窗口中单击“显示Y轴”按钮,并在左视图中选取“Y轴拟合图形”,然后单击“水平镜像”按钮,此时可以产生基本的鼠标造型效果,如图所示。 6、制作凹槽,在视图中的创建如图所示的模型作为布尔运算的模型,利用“选择并移动”工具调整好位置。

7、选择放样模型,在“几何体”面板中的下拉列表框中选择“复合对象”选项,然后单击“布尔”按钮,进行布尔运算,产生鼠标凹槽。 8、单击“标准基本体”面板中的“圆环”按钮,在左视图中创建一个圆环作为滚轮,并修改相关的属性参数。 9、单击“图形”面板中的“线”按钮,在顶视图中创建一条曲线。再利用“图形”面板中的“圆”工具在前视图中创建一个圆形。 10、选择绘制的曲线,然后在“几何体”面板中的下拉列表框中选择“复合对象”,并单击其中的“放样”按钮,实现放样操作,此时放样操作拾取的截面为前视图中的圆形。

会议摄像跟踪

会议摄像跟踪系统方案 一、系统概述 顺泰伟成语音激励会议录播系统采用先进的、主流的技术,对行业应用进行专业研发主要用于会议视频摄像系统、麦克风拾音系统的自动控制和管理。通过语音激励实现视频拍摄画面对应的数字编程,麦克音频通道优先权的设定,满足在会议过程中采用通讯型多点电子定位会议跟踪摄像机,对现场发言人进行特写画面的自动跟踪拍摄,满足会议视频自动采集需要。 二、系统功能 信息采集 会场内配置4台高清摄像机(最多 支持8台摄像机),分别放置于与 会代表的两端(拍摄两端与会代 表)、会场后端(拍摄会议主席)、 会场对角处(拍摄会议全景),高 清摄像机支持多角度拍摄,焦距可 自动调节,全方位记录会议现场。 会议互动 通过网络技术实现远程会议/多个 会议是进行互动交流,提高会议效 率。 多重数据保障 支持双光盘和硬盘同步直刻,支持通 过外接U盘和硬盘备份,也可以实 时的同步的上传到后台管理服务器,

对会议现场的音视频信息进行独立备份,支持断电恢复,当出现意外断电或故障的时候录像的内容不会丢失,保障数据安全 音视频管理 支持会议过程中各种声音的混音处理; 支持多画面合成。多画面同屏编辑视窗的数 字设定,根据采用摄像机的数量,对合成画 面进行画中画、三画面、四画面、五画面、 六画面、七画面、八画面任意编辑组合。利 用语音激励声控方式、对发言人的特写画面的默认全景切换; 支持光盘刻录。实时对会议信息(包括会议录像、讲稿展示、与会者发言等信息)进行一画面或多画面光盘刻录,用于随卷归档等用途。应具有光盘封盘、防擦写、防篡改、防剪辑等安全保护措施。

三、系统说明 1、系统连接图 2、会议室布局图

大漠插件后台找图、自动获取坐标窗口句柄鼠标多点左单击脚本

大漠插件后台找图、自动获取坐标窗口句柄鼠标多点左单击 脚本 一、准备工作 第一步:下载大漠插件、解压,运行“注册大漠插件到系统.bat”,把全部东东都复制到按键精灵的plugin目录下吧~ 第二步:创建一个文件夹,以d:\test 为例。把你要找的图(60.bmp)、大漠插件里的dm.dll 和RegDll.dll复制到这个文件夹。 第三步:打开按键精灵,创建一个新脚本。往附件(在软件左边框选项)里面添加dm.dll、Reg.dll和图60.bmp 二、复制以下代码到按键精灵 dim ys1,ys2,ys3,a,b,zbx,zby//自定义变量 ys1=9000//1和2点延时 ys1=9000//2和3点延时 ys1=9000//3和1点延时 a=15//纵向下移15单位 b=-15//纵向上移15单位 zbx=100//获取窗口句柄给定的坐标x zby=100//获取窗口句柄给定的坐标y PutAttachment "d:\test", "*.*" //意思是释放所有附件到d:\test目录。就是把有用的文件打包到test目录下 PutAttachment ".\Plugin", "RegDll.dll" //意思是释放RegDll.dll文件到按键精灵安装目录的Plugin目录下,用来完成大漠插件的注册 Call Plugin.RegDll.Reg("d:\test\dm.dll") //调用大漠插件,在按键精灵中使用 Set dm = createobject("dm.dmsoft") //用大漠插件创建一个对象dm dm_ret = dm.SetPath("d:\test") // 设置全局路径,以后你找图用的图片都默认是test目录里的图片了,否则你要用绝对路径d:\test\1.bmp来该表示图片 dm_ret = dm.LoadPic("*.bmp") // 字面意思是加载test目录下的所有图片 Hwnd = dm.GetPointWindow(zbx,zby)//用大漠软件获取给定坐标(zbx,zby)的窗口句柄,保存在Hwnd里 Call Plugin.Window.Move(Hwnd, 0, 0) // 把窗口移到屏幕的(0,0),即左上角 dm_ret = dm.BindWindow(Hwnd,"gdi","windows","windows",0) //这句用来绑定辅助操作的对象窗口 //下面是一条判断语句,如果绑定失败就会提示。那就从前面几几步中找原因吧 Delay 10 If dm_ret = 1 Then Else MessageBox "绑定失败,重启脚本或联系作者" EndScript

人机交互论文—视线跟踪技术

目录 1 引言 (1) 2 视线跟踪技术概述 (2) 3 视线跟踪的基本原理 (2) 4 视线跟踪技术分析 (3) 4.1常见视线跟踪技术 (3) 4.1.1 眼电图法 (3) 4.1.2巩膜接触镜/ 搜寻线圈法 (3) 4.1.3照片图像法(POG)、视频图像法(VOG ) (4) 4.1.3.1角膜- 巩膜异色边缘反射法 (4) 4.1.3.2 角膜反射法 (4) 4.1.3.3双普金野象法 (4) 4.1.3.4基于视频结合瞳孔和角膜反射的方法 (4) 4.2各种方法的比较 (5) 5 视线跟踪技术在人机交互通道中的特点 (6) 6视线跟踪方法的研究趋势 (6) 7 视线跟踪技术在人机交互领域中的应用及前景 (7) 8 小结 (9) 9 参考文献 (9)

视线跟踪技术及其应用 摘要:本文介绍了研究、应用视线跟踪技术的必要性,回顾了视线跟踪技术的研究历程,概述了主要的视线跟踪技术及其原理,比较各种视线跟踪技术的优缺点。重点探讨了当前常用的基于视频的瞳孔-角膜高光向量法的原理和技术,并介绍了视线跟踪技术的研究方向和发展趋势。最后对视线跟踪技术在人机交互、智能机器等领域的应用前景进行了介绍和展望。 关键词:视线跟踪研究方向人机交互 1 引言 随着对人机交互技术研究的不断深入,多通道的交互备受关注,人机界面更强调“以人为中心”的原则,使用户能运用各种感觉通道以最自然的方式和计算机交互。 现有的人机交互输入绝大多数通过鼠标、键盘等实现,这些输入需要视觉或听觉接收输出信息相配合。此外,语音识别输入技术在逐渐成熟;而对身体姿势的理解、触觉的输入输出等技术在智能虚拟现实环境中得到了较多的研究。 人们在观察外部世界时眼 睛总是与其它人体活动自然协 调地工作,并且眼动所需的认 知负荷很低,人眼的注视包含 着当前的任务状况以及人的内 部状态等信息,因此眼注视是 一种非常好的能使人机对话变 得简便、自然的候选输入通道。 由于常见的上下文信息还隐藏于我们的视线中,视线反应了我们感兴趣的对象、目的和需求,具有输入输出双向性特点。视线检测使得抽取对人机交互有用的信息成为可能,从而实现自然的、直觉的和有效的交互,因此,对视线跟踪技术及其在人机交互中应用的研究具有特殊的价值。 目前,视线跟踪技术和对视线所蕴含信息的理解还处在实验研究阶段。

华为视讯智能跟踪摄像机VPT300 产品概述

VPT300智能摄像机V500R003C10 产品概述 文档版本发布日期01 2017-01-05 华为技术有限公司

版权所有?华为技术有限公司2017。保留一切权利。 非经本公司书面许可,任何单位和个人不得擅自摘抄、复制本文档内容的部分或全部,并不得以任何形式传播。 商标声明 和其他华为商标均为华为技术有限公司的商标。 本文档提及的其他所有商标或注册商标,由各自的所有人拥有。 注意 您购买的产品、服务或特性等应受华为公司商业合同和条款的约束,本文档中描述的全部或部分产品、服务或特性可能不在您的购买或使用范围之内。除非合同另有约定,华为公司对本文档内容不做任何明示或默示的声明或保证。 由于产品版本升级或其他原因,本文档内容会不定期进行更新。除非另有约定,本文档仅作为使用指导,本文档中的所有陈述、信息和建议不构成任何明示或暗示的担保。 华为技术有限公司 地址:网址:北四环中路229号海泰大厦616 https://www.360docs.net/doc/a718952194.html,

前言 概述 本文档描述了HUWEI VPT300智能摄像机的产品定位、特点、组网应用以及技术参数 指标。 读者对象 本文档主要适用于以下用户阅读: ● 最终用户 代理商 ● 符号约定 在本文中可能出现下列标志,它们所代表的含义如下。 符号说明 用于警示紧急的危险情形,若不避免,将会导致人员死亡或严重 的人身伤害。 用于警示潜在的危险情形,若不避免,可能会导致人员死亡或严 重的人身伤害。 用于警示潜在的危险情形,若不避免,可能会导致中度或轻微的 人身伤害。 用于传递设备或环境安全警示信息,若不避免,可能会导致设备 损坏、数据丢失、设备性能降低或其它不可预知的结果。 “注意”不涉及人身伤害。 用于突出重要/关键信息、最佳实践和小窍门等。 “说明”不是安全警示信息,不涉及人身、设备及环境伤害。

API 鼠标坐标获取

效率就是你了解的类库。每天学习一点点。 c# private void Form1_MouseMove(object sender, MouseEventArgs e) { this.Text = Cursor.Position.X.ToString() + ":" + Cursor.Position.Y.ToString(); } 调用API using System; using System.Collections.Generic; using https://www.360docs.net/doc/a718952194.html,ponentModel; using System.Data; using System.Drawing; using System.Linq; using System.Text; using System.Windows.Forms; using System.Runtime.InteropServices; namespace mouse { public partial class Form1 : Form { public Form1() { InitializeComponent(); } public delegate int HookProc(int ncode, IntPtr wParam, IntPtr lParam); static int hHook = 0; public const int WH_MOUSE = 7; //private System.Windows.Forms.Button button1; //Declare MouseHookProcedure as HookProc type. HookProc MouseHookProcedure; //Declare wrapper managed POINT class. [StructLayout(LayoutKind.Sequential)] public class POINT { public int x; public int y; }

深度分析眼动追踪技术

深度分析眼动追踪技术 著名科学家霍金教授生前因患有肌肉萎缩疾病,几乎完全瘫痪,既不能通过双手,也不能通过语言与外界沟通。因特尔研究院的技术专家经过长期努力,研发出一款环境感知辅助系统,最终有效改善了这位科学天才与世界的沟通方式。霍金使用的智能输入法,其里面就含有眼球追踪以及面部肌肉识别等技术,正是由于这项的技术的实现,让霍金打字或者演讲的效率提高了好几倍。 视觉追踪技术也称为眼动追踪技术,就是追踪眼睛的运动。准确来讲就是通过图像处理技术,定位瞳孔位置,获取瞳孔中心坐标,并通过某种方法,计算人的注视点,让电脑知道你正在看什么。 眼睛是心灵的窗口,透过这个窗口我们可以探究人的许多心理活动的规律。人类的信息加工在很大程度上依赖于视觉,来自外界的信息约有80 %~90 %是通过人的眼睛获得的。因此对于"人是如何看事物" 的科学研究一直没有间断过。关于这一点,对于眼球运动( 以下称眼动) 的研究被认为是视觉信息加工研究中最有效的手段。 眼动追踪技术属于机器视觉的一种技术,通过对眼动轨迹的记录从中提取诸如注视点,注视时间和次数,眼跳距离,瞳孔大小等数据,从而研究个体的内在认知过程。它利用软件算法、机械、电子、光学等各种检测手段获取受试者当前视觉注意方向的技术,通过图像传感器来捕捉到眼球的图像,根据图像的处理来识别每个人的眼球瞳孔里的特征,通过这些特征实时地反算出看屏幕的注视点。 眼动追踪技术的历史 早在19世纪就有人通过考察人的眼球运动来研究人的心理活动,通过分析记录到的眼动数据来探讨眼动与人的心理活动的关系。眼动仪的问世为心理学家利用眼动技术探索人在各种不同条件下的视觉信息加工机制,观察其与心理活动直接或间接奇妙而有趣的关系,提供了新的有效工具。

Direct3D中实现图元的鼠标拾取

Direct3D中实现图元的鼠标拾取 查看文章 Direct3D中实现图元的鼠标拾取 2007-05-05 15:46 3D交互图形应用程序中,常常要用鼠标去选择图形,其实现的机制基于鼠标拾取算法。本文主要讲述如何在D3D中实现图元的鼠标拾取。为了讨论简单,本文假定读者理解D3D 坐标变换流程和基本的图形学知识,如果阅读有困难请参考相关资料。 1、什么是拾取,拾取能做什么, 首先,拾取操作指当我们在屏幕上用鼠标点击某个图元应用程序能返回该图元的一个标志和某些相关信息。有图形程序设计经验的人都知道,有这些信息就表示我们有了对该图元的控制权,我们可以删除,可以编辑,可以任意对待该图元,至于你到底想干什么,就是阁下自己的事了^_^。 2、拾取操作的步骤和实现 拾取算法的思想很简单:得到鼠标点击处的屏幕坐标,通过投影矩阵和观察矩阵把该坐标转换为通过视点和鼠标点击点的一条射入场景的光线,该光线如果与场景模型的三角形相交(本文只处理三角形图元),则获取该相交三角形的信息。本文讲述的方法除可以得到三角形的一个索引号以外还可以得到相交点的重心坐标。 从数学角度来看,我们只要得到射线的方向矢量和射线的出射点,我们就具备了判断射线与空间一个三角面是否相交的条件,本文主要讨论如何获得这些条件,并描述了射线三角面相交判断算法和D3D的通常实现方法。根据拾取操作的处理顺序,大概可以依次分为以下几个步骤 2.1( 变换并获得通过视点和屏幕上点击点的射线矢量(Dir) 详细介绍之前,为了大家方便理解,我们要先简单说一下d3d坐标转换的大概流程,如下图:

所以我们要通过一系列的反变换,得到我们关心的值在世界坐标中的表示。 2.1.1 确定鼠标选取点的屏幕坐标 这一步是非常简单的Windows给我们提供了API来完成屏幕坐标的获取,使用GetCursorPos获得鼠标指针位置,然后再利用ScreenToClient转换坐标到客户区 坐标系(以窗口视区左上角为坐标原点,单位为像素),设该坐标为(POINT screenPt)。 2.1.2 得到Dir在观察坐标空间内的表示 在观察坐标系中,Dir是一条从观察坐标原点出发的射线,所以我们只需要再 确定一个该射线经过的点,就可以得到它在观察坐标系中的表示。假设我们要求的 射线上的另外一点为该射线与透视投影平截头体近剪切面的交点,针对最普遍的透 视投影而言,透视投影平截头体经投影变换后,变成一个1/2立方体(请允许我这 么叫^_^,因为它的大小为一个正方体的一半,x,y方向边长为2,z方向为1)如图: 投影坐标系以近剪切面中心为坐标原点,该立方体从z轴负向看过去与图形程 序视区相对应,最终近剪切面(前剪切面)上一点与屏幕坐标之间的对应关系如下图 所示:

JavaScript 获取鼠标点击位置坐标

JavaScript 获取鼠标点击位置坐标 在一些DOM操作中我们经常会跟元素的位置打交道,鼠标交互式一个经常用到的方面,令人失望的是不同的浏览器下会有不同的结果甚至是有的浏览器下没结果,这篇文章就上鼠标点击位置坐标获取做一些简单的总结,没特殊声明代码在IE8,FireFox,Chrome下进行测试兼容 鼠标点击位置坐标相对于屏幕 如果是涉及到鼠标点击确定位置相对比较简单,获取到鼠标点击事件后,事件screenX,screenY获取的是点击位置相对于屏幕的左边距与上边距,不考虑iframe因素,不同浏览器下表现的还算一致。function getMousePos(event) { var e = event || window.event; return {'x':e.screenX,'y':screenY} } 相对浏览器窗口 简单代码即可实现,然而这是还不够,因为绝大多数情况下我们希望获取鼠标点击位置相对于浏览器窗口的坐标,event的clientX,clientY属性分别表示鼠标点击位置相对于文档的左边距,上边距。于是类似的我们写出了这样的代码function getMousePos(event) { var e = event || window.event; return {'x':e.clientX,'y':clientY} } 相对文档 简单测试也没什么问题,但是clientX与clientY获取的是相对于当前屏幕的坐标,忽略页面滚动因素,这在很多条件下很有用,但当我们需要考虑页面滚动,也就是相对于文档(body 元素)的坐标时怎么办呢?加上滚动的位移就可以了,下边我们试试怎么计算页面滚动的位移。 其实在Firefox下问题会简单很多,因为Firefox支持属性pageX,与pageY属性,这两个属性已经把页面滚动计算在内了。 在Chrome可以通过document.body.scrollLeft,document.body.scrollTop计算出页面滚动位移,而在IE下可以通过document.documentElement.scrollLeft ,document.documentElement.scrollTop function getMousePos(event) { var e = event || window.event; var scrollX = document.documentElement.scrollLeft || document.body.scrollLeft; var scrollY = document.documentElement.scrollTop || document.body.scrollTop; var x = e.pageX || e.clientX + scrollX; var y = e.pageY || e.clientY + scrollY; //alert('x: ' + x + '\ny: ' + y); return { 'x': x, 'y': y }; } getBoundingClientRect() 来获取页面元素的位置

基于单摄像机视线跟踪的眼控鼠标

基于单摄像机视线跟踪的眼控鼠标? 刘瑞安1, 2+,靳世久1,吴晓荣2 1(天津大学 精密测试技术及仪器国家重点实验室,天津 300072) 2(天津师范大学 物理与电子信息学院,天津 300074) 摘 要:提出一种能对用户头部位置变化自动适应的视线跟踪方法,减少了系统对使用者的头部限制。依据瞳孔边界点的灰度信息、梯度信息及瞳孔边界曲线的平滑信息综合判据,给出了一种提取瞳孔边缘点的一维算法;为提高系统的分辨率和精确度,提出了一种眼睛红外图像中瞳孔亚像素边缘检测与中心定位算法。利用眼睛角膜反射光斑和瞳孔中心的位置关系来确定视线方向,推导出人眼在计算机屏幕上的注视点,进而实现人眼对鼠标的定位与操作,其在显示屏上定位精度可达到40像素以内。 关键词:视线跟踪;眼控鼠标;角膜反射;边缘检测;亚像素;椭圆拟合 1. 引言 眼睛是人类从周围世界中获取信息的重要器官,也是反映人的心理活动的窗口。将视线应用于人机交互可带来直接性、自然性和双向性[1]等优点。眼注视是一种非常好的能使人机对话变得简便、自然的候选输入通道,将人的眼睛作为输入媒介,通过眼睛盯视,对外部设备进行控制可以实现多任务操作,在一些工业控制、机器人学和临床医学上有着广泛的发展前景。 目前,人机交互已成为计算机科学研究的一个越来越重要的领域。在个人电脑飞速发展的今天,鼠标一直是最为重要的人机交互设备之一。而眼控鼠标是利用图像处理技术对捕获的眼睛图像进行处理,提取人眼视线方向及注视点位置,进而实现人眼对鼠标的定位与操作。视线跟踪技术是未来智能人机接口的关键技术之一,在人机交互领域有着广阔的应用前景。国际上一些公司与科研机构正致力于眼控鼠标的开发与研究,日本净冈大学的海泽嘉教授开发出一种可以用眼球控制的鼠标系统;布拉格捷克技术大学的研究人员也推出了一款可用眼睛控制电脑的操作系统。 视线方向的识别、跟踪,是实现眼控鼠标的关键技术。而利用角膜反射原理的视线跟踪技术,具有非侵入的优点,近年来取得了较快进展,人们也进行了将该技术应用于人机交互领域的大量研究工作[2,3]。该技术在用户头部不动情况下可获得较高精度,但对头动敏感。为减少对用户的限制,Sugioka[4]使用超声技术测得CCD和人眼之间的距离,Ebisawa[5]增加两个摄像机来获得眼睛的三维空间坐标。这不仅增加了系统复杂性,且系 * 基金项目:天津市高等学校科技发展基金项目(20051017) * 刘瑞安,Email: wdxylra@https://www.360docs.net/doc/a718952194.html,

自动跟踪球型摄像机系统测试报告

自动跟踪系统测试报告 测试目的 为了实际了解自动跟踪系统的性能,利用公司现有资源及场地,对天地伟业公司配套的自动跟踪系统进行测试和分析。方案设计部和工程部希望通过此次测试,发现项目设计和实施过程中的难点、隐患点,技术薄弱环节等问题的相应解决方案,为今后库尔勒项目的开展和实施做好充分的准备。 测试系统与环境 系统由自动跟踪高速球型摄像机、DVR、服务器组成。 测试环境在公司内部对平安城市项目的偏僻处与实施区域进行模拟并测试:

基本功能测试 测试系统自身基本功能,并通过对各种环境、天气状况、场景复杂程度的观察和模拟,测试系统在多变环境下工作的稳定性、识别效能、适应性等指标,充分了解系统的使用范围和阻抗能力。 一、自动跟踪功能 自动跟踪功能多用于人流较少的重要区域,对于入侵范围内的移动元素,进行跟踪。可根据用户需要,作出输出报警、抓拍告警图片、录制入侵录像等联动作为依据。自动跟踪功能对限定区域的安全起到监视作用。 1、光照条件好的晴好白天环境。 测试地点定于公司13楼走道、14楼顶空旷处,执行自动跟踪检测数次,测试效果如下: 第一组测试:

第二组测试: 第三组测试:

在此环境下,自动跟踪球机能较快速的检测和识别出画面出现的移动目标,并对目标进行跟踪,并输出报警信息。多个目标同时出现时,自动跟踪会出现随机性,球机先对其中一个目标进行跟踪,如果另一个目标还没超出监控范围,球机将会跳到另一个目标继续跟踪。 2、光照条件不好的阴雨白天环境 测试地点相同,执行自动跟踪检测数次,测试效果如下: 第一组测试: 第二组测试:

第三组测试: 在此环境下,自动跟踪球机对目标出现后的识别反应较慢,对目标的检测灵敏度不高,当目标有较大的移动幅度时,球机能检测出目标。球机在大雨中会出现视频被遮挡的情况,球机的检测反应速度被大大降低,经常出现误报。 2、晴朗的夜间环境 测试地点相同,执行自动跟踪检测数次,测试效果如下: 第一组测试: 第二组测试: