周志华:数据挖掘与机器学习

机器学习与数据挖掘

周志华

南京大学计算机软件新技术国家重点实验室,南京210093

“机器学习”是人工智能的核心研究领域之一,其最初的研究动机是为了让计算机系统具有人的学习能力以便实现人工智能,因为众所周知,没有学习能力的系统很难被认为是具有智能的。目前被广泛采用的机器学习的定义是“利用经验来改善计算机系统自身的性能”[1]。事实上,由于“经验”在计算机系统中主要是以数据的形式存在的,因此机器学习需要设法对数据进行分析,这就使得它逐渐成为智能数据分析技术的创新源之一,并且为此而受到越来越多的关注。

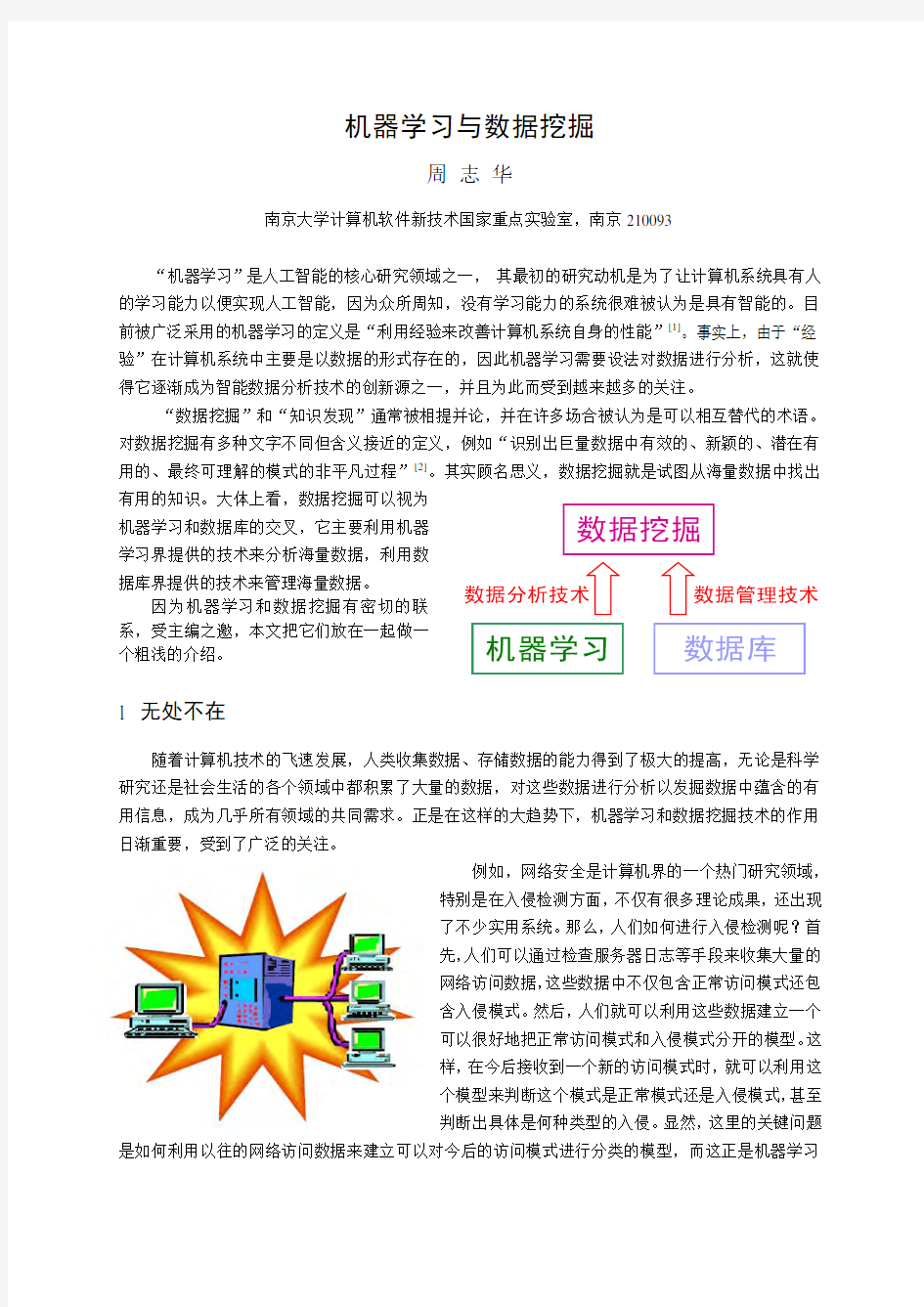

“数据挖掘”和“知识发现”通常被相提并论,并在许多场合被认为是可以相互替代的术语。对数据挖掘有多种文字不同但含义接近的定义,例如“识别出巨量数据中有效的、新颖的、潜在有用的、最终可理解的模式的非平凡过程”[2]。其实顾名思义,数据挖掘就是试图从海量数据中找出有用的知识。大体上看,数据挖掘可以视为

机器学习和数据库的交叉,它主要利用机器

学习界提供的技术来分析海量数据,利用数

据库界提供的技术来管理海量数据。

因为机器学习和数据挖掘有密切的联

系,受主编之邀,本文把它们放在一起做一

个粗浅的介绍。

1 无处不在

随着计算机技术的飞速发展,人类收集数据、存储数据的能力得到了极大的提高,无论是科学研究还是社会生活的各个领域中都积累了大量的数据,对这些数据进行分析以发掘数据中蕴含的有用信息,成为几乎所有领域的共同需求。正是在这样的大趋势下,机器学习和数据挖掘技术的作用日渐重要,受到了广泛的关注。

例如,网络安全是计算机界的一个热门研究领域,

特别是在入侵检测方面,不仅有很多理论成果,还出现

了不少实用系统。那么,人们如何进行入侵检测呢?首

先,人们可以通过检查服务器日志等手段来收集大量的

网络访问数据,这些数据中不仅包含正常访问模式还包

含入侵模式。然后,人们就可以利用这些数据建立一个

可以很好地把正常访问模式和入侵模式分开的模型。这

样,在今后接收到一个新的访问模式时,就可以利用这

个模型来判断这个模式是正常模式还是入侵模式,甚至

判断出具体是何种类型的入侵。显然,这里的关键问题是如何利用以往的网络访问数据来建立可以对今后的访问模式进行分类的模型,而这正是机器学习

和数据挖掘技术的强项。

实际上,机器学习和数据挖掘技术已经开始在多媒体、计算机图形学、计算机网络乃至操作系统、软件工程等计算机科学的众多领域中发挥作用,特别是在计算机视觉和自然语言处理领域,机器学习和数据挖掘已经成为最流行、最热门的技术,以至于在这些领域的顶级会议上相当多的论文都与机器学习和数据挖掘技术有关。总的来看,引入机器学习和数据挖掘技术在计算机科学的众多分支领域中都是一个重要趋势。

机器学习和数据挖掘技术还是很多交叉学

科的重要支撑技术。例如,生物信息学是一个

新兴的交叉学科,它试图利用信息科学技术来

研究从DNA到基因、基因表达、蛋白质、基

因电路、细胞、生理表现等一系列环节上的现

象和规律。随着人类基因组计划的实施,以及

基因药物的美好前景,生物信息学得到了蓬勃

发展。实际上,从信息科学技术的角度来看,

生物信息学的研究是一个从“数据”到“发现”

的过程,这中间包括数据获取、数据管理、数

据分析、仿真实验等环节,而“数据分析”这

个环节正是机器学习和数据挖掘技术的舞台。

正因为机器学习和数据挖掘技术的进展对计算机科学乃至整个科学技术领域都有重要意义,美国NASA-JPL实验室的科学家2001年9月在《Science》上专门撰文[3]指出,机器学习对科学研究的

整个过程正起到越来越大的支持作用,并认为该领域将稳定而快速地发

展,并将对科学技术的发展发挥更大的促进作用。NASA-JPL实验室的

全名是美国航空航天局喷气推进实验室,位于加州理工学院,是美国尖

端技术的一个重要基地,著名的“勇气”号和“机遇”号火星机器人正

是在这个实验室完成的。从目前公开的信息来看,机器学习和数据挖掘

技术在这两个火星机器人上有大量的应用。

除了在科学研究中发挥重要作用,机器学习和数据挖掘技术和普通人的生活也息息相关。例如,在天气预报、地震预警、环境污染检测等方面,有效地利用机器学习和数据挖掘技术对卫星传递回来的大量数据进行分析,是提高预报、预警、检测准确性的重要途径;在商业营销中,对利用条形码技术获得的销售数据进行分析,不仅可以帮助商家优化进货、库存,还可以对用户行为进行分析以设计有针对性的营销策略;……。下面再举两个例子。

公路交通事故是人类面临的最大杀手之一,全世界每年有上百万人丧生车轮,仅我国每年就有约10万人死于车祸。美国一直在对自动驾驶车辆进行研究,因为自动驾驶车辆不仅在军事上有重要意义,还对减少因酒后、疲劳而引起的车祸有重要作用。2004年3月,在美国DARPA(国防部先进研究计划局)组织的自动驾驶车辆竞赛中,斯坦福大学的参赛车在完全无人控制的情况下,成功地在6小时53分钟内走完了132英里(约212公里)的路程,获得了冠军。比赛路段是在内华达州西南部的山区和沙漠中,路况相当复杂,有的地方路面只有几米宽,一边是山岩,另一边是百尺深沟,即使有丰富驾驶经验的司机,在这样的路段上行车也是一个巨大的挑战。这一结果显示出自动

驾驶车辆已经不再是一个梦想,可能在不久的将来就会走

进普通人的生活。值得一提的是,斯坦福大学参赛队正是

由一位机器学习专家所领导的,而获胜车辆也大量使用了

机器学习和数据挖掘技术。

Google、Yahoo、百度等互联网搜索引擎已经开始改变

了很多人的生活方式,例如很多人已经习惯于在出行前通

过网络搜索来了解旅游景点的背景知识、寻找合适的旅馆、

饭店等。美国新闻周刊曾经对Google有个“一句话评论”:

“它使得任何人离任何问题的答案之间的距离只有点击一下鼠标这么远”。现在很少有人不知道互联

网搜索引擎的用处,但可能很多人并不了解,机器学习和数

据挖掘技术正在支撑着这些搜索引擎。其实,互联网搜索引

擎是通过分析互联网上的数据来找到用户所需要的信息,而

这正是一个机器学习和数据挖掘任务。事实上,无论Google、

Yahoo还是微软,其互联网搜索研究核心团队中都有相当大

比例的人是机器学习和数据挖掘专家,而互联网搜索技术也

正是机器学习和数据挖掘目前的热门研究话题之一。

2 雄关漫道

机器学习是人工智能研究发展到一定阶段的必然产物。从20世纪50年代到70年代初,人工智能研究处于“推理期”,人们认为只要给机器赋予逻辑推理能力,机器就能具有智能。这一阶段的代表性工作主要有A. Newell和H. Simon的“逻辑理论家”程序以及此后的“通用问题求解”程序等,这些工作在当时取得了令人振奋的成果。例如,“逻辑理论家”程序在1952年证明了著名数学家罗素和怀特海的名著《数学原理》中的38条定理,在1963年证明了全部的52条定理,而且定理2.85甚至比罗素和怀特海证明得更巧妙。A. Newell和H. Simon因此获得了1975年图灵奖。然而,随着研究向前发展,人们逐渐认识到,仅具有逻辑推理能力是远远实现不了人工智能的。E.A. Feigenbaum 等人认为,要使机器具有智能,就必须设法使机器拥有知识。在他们的倡导下,20世纪70年代中期开始,人工智能进入了“知识期”。在这一时期,大量专家系统问世,在很多领域做出了巨大贡献。

E.A. Feigenbaum作为“知识工程”之父在1994年获得了图灵奖。但是,专家系统面临“知识工程瓶颈”,简单地说,就是由人来把知识总结出来再教给计算机是相当困难的。于是,一些学者想到,如果机器自己能够学习知识该多好!

实际上,图灵在1950年提出图灵测试的文章中,就已经提到了机器学习的可能,而20世纪50年代其实已经开始有机器学习相关的研究工作,主要集中在基于神经网络的连接主义学习方面,代表性工作主要有F. Rosenblatt的感知机、B. Widrow的Adaline等。在20世纪6、70年代,多种学习技术得到了初步发展,例如以决策理论为基础的统计学习技术以及强化学习技术等,代表性工作主要有A.L. Samuel的跳棋程序以及N.J. Nilson的“学习机器”等,20多年后红极一时的统计学习理论的一些重要结果也是在这个时期取得的。在这一时期,基于逻辑或图结构表示的符号学习技术也开始出现,代表性工作有P. Winston的“结构学习系统”、R.S. Michalski等人的“基于逻辑的归纳学习系统”、E.B. Hunt等人的“概念学习系统”等。

1980年夏天,在美国卡内基梅隆大学举行了第一届机器学习研讨会;同年,《策略分析与信息系统》连出三期机器学习专辑;1983年,Tioga出版社出版了R.S. Michalski、J.G. Carbonell和T.M. Mitchell主编的《机器学习:一种人工智能途径》[4],书中汇集了20位学者

撰写的16篇文章,对当时的机器学习研究工作进行了总结,产生了很大反

响a;1986年,《Machine Learning》创刊;1989年,《Artificial Intelligence》

出版了机器学习专辑,刊发了一些当时比较活跃的研究工作,其内容后来出

现在J.G. Carbonell主编、MIT出版社1990年出版的《机器学习:风范与方法》

[5]一书中。总的来看,20世纪80年代是机器学习成为一个独立的学科领域

并开始快速发展、各种机器学习技术百花齐放的时期。

R.S. Michalski等人[4]中把机器学习研究划分成“从例子中学习”、“在问

题求解和规划中学习”、“通过观察和发现学习”、“从指令中学习”等范畴;而E.A. Feigenbaum在著名的《人工智能手册》b中[6],则把机器学习技术划分为四大类,即“机械学习”、“示教学习”、“类比学习”、“归纳学习”。机械学习也称为“死记硬背式学习”,就是把外界输入的信息全部记下来,在需要的时候原封不动地取出来使用,这实际上没有进行真正的学习;示教学习和类比学习实际上类似于R.S. Michalski等人所说的“从指令中学习”和“通过观察和发现学习”;归纳学习类似于“从例子中学习”,即从训练例中归纳出学习结果c。20世纪80年代以来,被研究得最多、应用最广的是“从例子中学习”(也就是广义的归纳学习),它涵盖了监督学习(例如分类、回归)、非监督学习(例如聚类)等众多内容。下面我们对这方面主流技术的演进做一个简单的回顾。

在20世纪 90年代中期之前,“从例子中学习”的一大主流技术是归纳逻辑程序设计(Inductive Logic Programming),这实际上是机器学习和逻辑程序设计的交叉。它使用1阶逻辑来进行知识表示,

通过修改和扩充逻辑表达式(例

如Prolog表达式)来完成对数据的

归纳。这一技术占据主流地位与

整个人工智能领域的发展历程是

分不开的。如前所述,人工智能在20世纪50年代到80年代经历了“推理期”和“知识期”,在“推理期”中人们基于逻辑知识表示、通过演绎技术获得了很多成果,而在知识期中人们基于逻辑知识表示、通过领域知识获取来实现专家系统,因此,逻辑知识表示很自然地受到青睐,而归纳逻辑程序设计技术也自然成为机器学习的一大主流。归纳逻辑程序设计技术的一大优点是它具有很强的知识表示能力,可以较容易地表示出复杂数据和复杂的数据关系。尤为重要的是,领域知识通常可以方便地写成逻辑表达式,因此,归纳逻辑程序设计技术不仅可以方便地利用领域知识指导学习,还可以通过学习对领域知识进行精化和增强,甚至可以从数据中学习出领域知识。事实上,机器学习在20世纪80年代正是被视为“解决知识工程瓶颈问题的关键”而走到人工智能主舞台的聚光灯下的,归纳逻辑程序设计的一些良好特性对此无疑居功至伟d。S.H. Muggleton主编的书[7]对90年代中期之前归纳逻辑程序设计方面的研

a Morgan Kaufmann出版社后来分别于1986年和1990年出版了该书的续篇,编为第二卷和第三卷。

b该书共4卷,分别由E.A. Feigenbaum与不同的学者合作编写而成。

c“归纳学习”有狭义的解释和广义的解释。前者要求从训练数据中学得概念,因此也被称为“概念学习”或“概念形成”;后者则对学习结果是否是可理解的概念不做要求。

d“归纳逻辑程序设计”这个名字其实是1991年S. Muggleton才提出的。

究工作做了总结。然而,归纳逻辑程序设计技术也有其局限,最严重的问题是由于其表示能力很强,学习过程所面临的假设空间太大,对规模稍大的问题就很难进行有效的学习,只能解决一些“玩具问题”。因此,在90年代中期后,归纳程序设计技术方面的研究相对陷入了低谷。

20世纪 90年代中期之前,“从例子中学习”的另一大主流技术是基于神经网络的连接主义学习。连接主义学习技术在20世纪50年代曾经历了一个大发展时期,但因为早期的很多人工智能研究者对符号表示有特别的偏爱,例如H. Simon曾说人工智能就是研究“对智能行为的符号化建模”,因此当时连接主义的研究并没有被纳入主流人工智能的范畴。同时,连接主义学习自身也遇到了极大的问题,M. Minsky和S. Papert在1969年指出,(当时的)神经网络只能用于线性分类,对哪怕“异或”这么简单的问题都做不了。于是,连接主义学习在此后近15年的时间内陷入了停滞期。直到1983年,J.J. Hopfield利用神经网络求解TSP问题获得了成功,才使得连接主义重新受到人们的关注。1986年,D.E. Rumelhart和J.L. McClelland主编了著名的《并行分布处理—认知微结构的探索》[8]一书,对PDP小组的研究工作进行了总结,轰动一时。特别是D.E. Rumelhart、G.E. Hinton和R.J. Williams 重新发明了著名的BP算法e,产生了非常大的影

响。该算法可以说是最成功的神经网络学习算法,

在当时迅速成为最流行的算法,并在很多应用中

都取得了极大的成功。与归纳逻辑程序设计技术

相比,连接主义学习技术基于“属性-值”的表示

形式(也就是用一个特征向量来表示一个事物;

这实际上是命题逻辑表示形式),学习过程所面临

的假设空间远小于归纳逻辑程序设计所面临的空

间,而且由于有BP这样有效的学习算法,使得它可以解决很多实际问题。事实上,即使在今天,BP 仍然是在实际工程应用中被用得最多、最成功的算法之一。然而,连接主义学习技术也有其局限,一个常被人诟病的问题是其“试错性”。简单地说,在此类技术中有大量的经验参数需要设置,例如神经网络的隐层结点数、学习率等,夸张一点说,参数设置上差之毫厘,学习结果可能谬以千里。在实际工程应用中,人们可以通过调试来确定较好的参数设置,但对机器学习研究者来说,对此显然是难以满意的。

20世纪90年代中期,统计学习粉墨登场并迅速独占鳌头。其实早在20世纪6、70年代就已经

有统计学习方面的研究工作,统计学习理论[9]在那个时期也已经

打下了基础,例如V.N. Vapnik早在1963年就提出了“支持向量”

的概念,他和A.J. Chervonenkis在1968年提出了VC维,在1974

年提出了结构风险最小化原则等,但直到90年代中期统计学习

才开始成为机器学习的主流技术。这一方面是由于有效的支持向

量机算法在90年代才由B.E. Boser、I. Guyon和V.N. Vapnik提出,

而其优越的性能也是到90年代中期才在T. Joachims等人对文本

分类的研究中显现出来;另一方面,正是在连接主义学习技术的

局限性凸显出来之后,人们才把目光转向了统计学习。事实上,

e实际上,P. Werbos在他1974年哈佛大学的博士学位论文中曾经发明了这个算法,但由于当时正处于连接主义的“冰河期”,因此没有得到应有的重视。

统计学习与连接主义学习有着密切的联系,例如RBF神经网络其实就是一种很常用的支持向量机。

在支持向量机被普遍接受后,支持向量机中用到的核(kernel)技巧被人们用到了机器学习的几乎每一个角落中,“核方法”也逐渐成

为机器学习的一种基本技巧。但其实

这并不是一种新技术,例如Mercer定

理是在1909年发表的,核技巧也早已

被很多人使用过,即使只考虑机器学

习领域,至少T. Poggio在1975年就使

用过多项式核。如果仔细审视统计学

习理论,就可以发现其中的绝大多数

想法在以往机器学习的研究中都出现

过,例如结构风险最小化原则实际上

就是对以往机器学习研究中经常用到的最小描述长度原则的另一个说法。但是,统计学习理论把这些有用的片段整合在同一个理论框架之下,从而为人们研制出泛化能力f有理论保证的算法奠定了基础,与连接主义学习的“试错法”相比,这是一个极大的进步。然而,统计学习也有其局限,例如,虽然理论上来说,通过把原始空间利用核技巧转化到一个新的特征空间,再困难的问题也可以容易地得到解决,但如何选择合适的核映射,却仍然有浓重的经验色彩。另一方面,统计学习技术与连接主义学习技术一样是基于“属性-值”表示形式,难以有效地表示出复杂数据和复杂的数据关系,不仅难以利用领域知识,而且学习结果还具有“黑箱性”。此外,传统的统计学习技术往往因为要确保统计性质或简化问题而做出一些假设,但很多假设在真实世界其实是难以成立的。如何克服上述缺陷,正是很多学者正在关注的问题。

需要说明的是,机器学习目前已经是一个很大的学科领域,而本节只是管中窥豹,很多重要的内容都没有谈及。T.G. Dietterich曾发表过一篇题为《机器学习研究:当前的四个方向》[10]的很有影响的文章,在文章中他讨论了集成学习、可扩展机器学习(例如对大数据集、高维数据的学习等)、强化学习、概率网络等四个方面的研究进展,有兴趣的读者不妨一读。

如前所述,机器学习之所以备受瞩目,主要是因为它已成为智能数据分析技术的创新源之一。但是机器学习还有一个不可忽视的功能,就是通过建立一些关于学习的计算模型来帮助人们了解“人类如何学习”。例如,P. Kanerva在20世纪80年代中期提出SDM(Sparse Distributed Memory)模型时并没有刻意模仿人脑生理结构,但后来的研究发现,SDM的工作机制非常接近于人类小脑,这为理解小脑的某些功能提供了帮助。自然科学研究的驱动力归结起来无非是人类对宇宙本源、物质本性、生命本质、自我本识的好奇,而“人类如何学习”无疑是一个有关自我本识的重大问题。从这个意义上说,机器学习不仅在信息科学中占有重要地位,还有一定的自然科学色彩。与此不同,数据挖掘[11]则是一个直接为实际应用而生的学科领域。20世纪60年代,早期的数据库问世,人们开始利用计算机对数据进行管理;到了70年代之后,随着关系数据库的出现和发展,人们管理数据的能力越来越强,收集存储的数据也越来越多。如果只利用数据库进行一些简单的事务处理,显然没有对数据进行充分的利用,从数据中挖掘出有用的知识,才可以更好地实现数据的价值。

f提高泛化能力(generalization ability)是机器学习中最重要的问题之一。泛化能力表征了机器学习系统对新事件的适用性,简单地说,泛化能力越强,系统对新事件的适用能力(例如做出正确预测的能力)就越强。

1989年8月,第11届国际人工智能联合会议(IJCAI’89)

在美国底特律举行,GTE实验室的G. Piatetsky-Shapiro在J.G.

Carbonell、W. Frawley、K. Parsaye、J.R. Quinlan、M. Siegel、

R. Uthurusamy等人的支持下,组织了一个名为“在数据库中发

现知识”的研讨会,这个研讨会后来被认为是数据挖掘成为一

个领域的标志。早期人们一直称其为“数据挖掘与知识发现”,

但随着该领域的发展壮大,越来越多的人直接称其为数据挖掘g。值得注意的是,数据挖掘的对象早就不限于数据库,而可以是存放在任何地方的数据,甚至包括Internet上的数据。

数据挖掘受到了很多学科领域的影响,其中数据库、机器学习、统计学无疑影响最大[12]。粗糙地说,数据库提供数据管理技术,机器学习和统计学提供数据分析技术。由于统计学界往往醉心于理论的优美而忽视实际的效用,因此,统计学界提供的很多技术通常都要在机器学习界进一步研究,变成有效的机器学习算法之后才能再进入数据挖掘领域。从这个意义上说,统计学主要是通过机器学习来对数据挖掘发挥影响,而机器学习和数据库则是数据挖掘的两大支撑技术。

从数据分析的角度来看,绝大多数数据挖掘技术都来自机器学习领域。但能否认为数据挖掘只不过就是机器学习的简单应用呢?答案是否定的。一个重要的区别是,传统的机器学习研究并不把海量数据作为处理对象,很多技术是为处理中小规模数据设计的,如果直接把这些技术用于海量数据,效果可能很差,甚至可能用不起来。因此,数据挖掘界必须对这些技术进行专门的、不简单的改造。例如,决策树是一种很好的机器学习技术,不仅有很强的泛化能力,而且学得结果具有一定的可理解性,很适合数

据挖掘任务的需求。但

传统的决策树算法需要

把所有的数据都读到内

存中,在面对海量数据

时这显然是无法实现

的。为了使决策树能够

处理海量数据,数据挖

掘界做了很多工作,例如通过引入高效的数据结构和数据调度策略等来改造决策树学习过程,而这其实正是在利用数据库界所擅长的数据管理技术。实际上,在传统机器学习算法的研究中,在很多问题上如果能找到多项式时间的算法可能就已经很好了,但在面对海量数据时,可能连O(n3)的算法都是难以接受的,这就给算法的设计带来了巨大的挑战。

另一方面,作为一个独立的学科领域,必然会有一些相对“独特”的东西。对数据挖掘来说,这就是关联分析。简单地说,关联分析就是希望从数据中找出“买尿布的人很可能会买啤酒”这样看起来匪夷所思但可能很有意义的模式h。如果在100位顾客中有20位购买了尿布,购买尿布的20位顾客中有16位购买了啤酒,那么就可以写成“尿布→啤酒[支持度=20%,置信度=80%]”这样的

g“数据挖掘”这个词其实很久以前就在统计学界出现并略带贬义,但由于数据挖掘领域的发展壮大,这个词目前已经没有贬义了。

h“尿布和啤酒”的故事可能是对数据挖掘最好的宣传策划。对“买尿布的人很可能会买啤酒”的一个解释是说,婴儿出世后母亲在家照管孩子,父亲在下班回家的路上买尿布,会顺手捎几瓶啤酒回家。

一条关联规则。挖掘出这样的规则可以有很多用处,例如商家可以考虑把尿布展柜和啤酒展柜放到一起以促进销售。实际上,在面对少量数据时关联分析并不难,可以直接使用统计学中有关相关性的知识,这也正是机器学习界没有研究关联分析的一个重要原因。关联分析的困难其实完全是由海量数据造成的,因为数据量的增加会直接造成挖掘效率的下降,当数据量增加到一定程度,问题的难度就会产生质变,例如,在关联分析中必须考虑因数据太大而无法承受多次扫描数据库的开销、可能产生在存储和计算上都无法接受的大量中间结果等,而关联分析技术正是围绕着“提高效率”这条主线发展起来的。在R. Agrawal等人首先对关联规则挖掘进行研究之后,大批学者投身到这方面的研究中并产生了很多成果,代表性工作有R. Agrawal和R. Srikant的Apriori算法以及J. Han等人的FP-Growth算法等,有兴趣的读者可以参考一些相关书籍[11][13]。

3 坐看云起

机器学习和数据挖掘在过去10年经历了飞速发展,目前已经成为子领域众多、内涵非常丰富的学科领域。“更多、更好地解决实际问题”成为机器学习和数据挖掘发展的驱动力。事实上,过去若干年中出现的很多新的研究方向,例如半监督学习、代价敏感学习、流数据挖掘、社会网络分析等,都起源于实际应用中抽象出来的问题,而机器学习和数据挖掘领域的研究进展,也很快就在众多应用领域中发挥作用。值得指出的是,在计算机科学的很多领域中,成功的标志往往是产生了某种看得见、摸得着的系统,而机器学习和数据挖掘则恰恰相反,它们正在逐渐成为基础性、透明化、无处不在的支持技术、服务技术,在它们真正成功的时候,可能人们已经感受不到它们的存在,人们感受到的只是更健壮的防火墙、更灵活的机器人、更安全的自动汽车、更好用的搜索引擎……

由于机器学习和数据挖掘技术的重要性,各国都对这方面的研究非常关注。例如,美国计算机科学研究的重镇——卡内基梅隆大学2006年宣布成立“机器学习系”。而美国DARPA从2003年开始启动5年期的PAL(Perceptive Assistant that Learns)计划[14],首期1-1.5年投资即达2千9百万美元,总投资超过1亿美元。从名字就可以看出,这是一个以机器学习为核心的计划。具体来说,该计划包含两个子计划,一个称为RADAR,由卡内基梅隆大学单独承担,其目标为研制出一种软件,它“通过与其人类主人的交互,并且通过接收明晰的建议和指令来学习”、“将帮助繁忙的管理人员处理耗时的任务”。另一个子计划称为CALO,牵头单位为斯坦福国际研究院,参加单位包括麻省理工学院、斯坦福大学、卡内基梅隆大学、加州大学伯克利分校、华盛顿大学、密歇根大学、德克萨斯大学奥斯汀分校、波音公司等20家单位,首期投资即达2千2百万美元。显然,CALO是整个PAL 计划的核心,因为其参加单位不仅包含了美国在计算机

科学和人工智能方面具有强大力量的主要高校以及波音

公司这样的企业界巨头,其经费还占据了PAL计划整个

首期投资的76%。DARPA没有明确公布CALO的目标,,

但从其描述[15]可见端倪:“CALO软件将通过与为其提

供指令的用户一起工作来进行学习……它将能够处理

常规任务,还能够在突发事件发生时提供协助”,考虑到

911之后美国对突发事件处理能力的重视,以及波音公

司对该计划的参与,该计划的(部分)成果很可能会用

于反恐任务。DARPA还说[15],“CALO的名字源于拉丁文calonis,含义是‘战士的助手’”,而且

DARPA 曾在网站上放置了这样一幅军官与虚拟参谋人员讨论战局的画面,可以预料,该计划的(部分)成果会直接用于军方。从上述情况来看,美国已经把对机器学习的研究上升到国家安全的角度来考虑。

如果要列出目前计算机科学中最活跃的研究分支,那么机器学习和数据挖掘必然位列其中。随着机器学习和数据挖掘技术被应用到越来越多的领域,可以预见,机器学习和数据挖掘不仅将为研究者提供越来越大的研究空间,还将给应用者带来越来越多的回报。

对发展如此迅速的机器学习和数据挖掘领域,要概述其研究进展或发展动向是相当困难的,感兴趣的读者不妨参考近年来机器学习和数据挖掘方面一些重要会议和期刊发表的论文。在机器学习方面,最重要的学术会议是NIPS、ICML、ECML和COLT,最重要的学术期刊是《Machine Learning》和《Journal of Machine Learning Research》;在数据挖掘方面,最重要的学术会议是SIGKDD、ICDM、SDM、PKDD和PAKDD,最重要的学术期刊是《Data Mining and Knowledge Discovery》和《IEEE Transactions on Knowledge and Data Engineering》。此外,人工智能领域的顶级会议如IJCAI和AAAI、数据库领域的顶级会议如SIGMOD、VLDB、ICDE,以及一些顶级期刊如《Artificial Intelligence》、《Journal of Artificial Intelligence Research》、《IEEE Transactions on Pattern Analysis and Machine Intelligence》、《Neural Computation》等也经常发表机器学习和数据挖掘方面的论文。

参考文献

[1]T. M. Mitchell. Machine Learning, New York: McGraw-Hill, 1997.

[2]U. Fayyad, G. Piatetsky-Shapiro, R. Smyth. Knowledge discovery and data mining: Towards a

unifying framework. In: Proc. KDD’96, Portland, OR, 82-88.

[3] E. Mjolsness, D. DeCoste. Machine learning for science: State of the art and future prospects. Science,

2001, 293(5537): 2051-2055.

[4]R. S. Michalski, J. G. Carbonell, T. M. Mitchell, eds. Machine Learning: An Artificial Intelligence

Approach, Palo Alto, CA: Tioga Publishing Co., 1983.

[5]J. G. Carbonell, ed. Machine Learning: Paradigms and Methods, Cambridge, MA: MIT Press, 1990.

[6]P. R. Cohen, E. A. Feigenbaum, eds. The Handbook of Artificial Intelligence, vol.3, New York:

William Kaufmann, 1983.

[7]S. H. Muggleton, ed. Inductive Logic Programming, London: Academic Press, 1992.

[8] D. E. Rumelhart, J. L. McClelland, eds. Parallel Distributed Processing: Explorations in the

Microstructure of Cognition, Cambridge, MA: MIT Press, 1986.

[9]V. N. Vapnik, Statistical Learning Theory, New York: Wiley, 1998.

[10]T. G. Dietterich. Machine learning research: Four current directions. AI Magazine, 1997, 18(4):

97-136.

[11]J. Han, M. Kamber, Data Mining: Concepts and Techniques, 2nd edition, Singapore: Elsevier, 2006.

[12]Z.-H. Zhou. Three perspectives of data mining. Artificial Intelligence, 2003, 143(1): 139-146.

[13]P.-N. Tan, M. Steinbach, V. Kumar, Introduction to Data Mining, Reading, MA: Addison-Wesley,

2006.

[14]DARPA News Release. DARPA, Jul. 2003.

[15]CALO Overview. DARPA, 2003.

作者介绍:

周志华,南京大学计算机科学与技术系教授,博士生导师,教育部长江学者特聘

教授。2000年于南京大学计算机科学与技术系获博士学位。中国计算机学会人

工智能与模式识别专业委员会副主任。主要研究领域为人工智能,机器学习,数

据挖掘等。

统计学考试1

统计学考试1

————————————————————————————————作者:————————————————————————————————日期: 2

现代经管学院试卷 试卷代码:A 课程学时:48 课程名称:统计学适用对象:08国际贸易2班 一、单项选择题(在括弧內填入所选答案标号;每小题1分,共10分) 1. 一个统计总体 A、只能有一个标志 B、只能有一个指标 C、可以有多个标志 D、可以有多个指标 2. 统计学是一门 A、自然科学 B、新兴科学 C、方法论科学 D、实质性科学 3. 人口按年龄分组的数列属于 A、品质数列 B、变量数列 C、等距数列 D、单项式数列 4. 调查一些主要煤炭基地,可以了解我国煤炭生产的基本情况,这种调查是: A、重点调查 B、普查 C、典型调查 D、抽样调查 5. 抽样调查与典型调查都是非全面调查,两者的根本区别在于( ) A.灵活程度不同 B.误差的大小不同 C.作用不同 D.选取调查单位的方法不同 6. 具有可加性的相对指标只有 A、结构相对指标 B、强度相对指标 C、比较相对指标 D、动态相对指标 7. 在变量数列中,若各种权数完全相等,则平均数 A、不受权数影响 B、只受权数影响 C、既受变量值的影响,也受权数的影响 D、计算没有意义 8. 增长1%的绝对值是( ) A.报告期水平的1% B.基期水平的1% C.报告期累积增长量的1% D.基期逐期增长量的1% 9. 某工业企业产品产量为10万件,期末库存量为3.8万件,它们() A、都是时期指标 B、前者是时期指标,后者是时点指标 C、都是时点指标 D、前者是时点指标,后者是时期指标 10.若销售量增加,销售额持平,则物价指数 A、降低 B、增长 C、不变 D、无法确定 二、判断题(认为表述对的在括弧內打√,错的打×;每小题1分,共10分) 3

数理统计学的起源和发展doc

统计学起源于收集数据的活动,小至个人的事情,大至治理一个国家,都有必要收集种种有关的数据,如在我国古代典籍中,就有不少关于户口、钱粮、兵役、地震、水灾和旱灾等等的记载。现今各国都设有统计局或相当的机构。当然,单是收集、记录数据这种活动本身并不能等同于统计学这门科学的建立,需要对收集来的数据进行排比、整理,用精炼和醒目的形式表达,在这个基础上对所研究的事物进行定量或定性估计、描述和解释,并预测其在未来可能的发展状况。例如根据人口普查或抽样调查的资料对我国人口状况进行描述,根据适当的抽样调查结果,对受教育年限与收入的关系,对某种生活习惯与嗜好(如吸烟)与健康的关系作定量的评估。根据以往一般时间某项或某些经济指标的变化情况,预测其在未来一般时间的走向等,做这些事情的理论与方法,才能构成一门学问——数理统计学的内容。 这样的统计学始于何时?恐怕难于找到一个明显的、大家公认的起点。一种受到某些著名学者支持的观点认为,英国学者葛朗特在1662年发表的著作《关于死亡公报的自然和政治观察》,标志着这门学科的诞生。中世纪欧洲流行黑死病,死亡的人不少。自1604年起,伦敦教会每周发表一次“死亡公报”,记录该周内死亡的人的姓名、年龄、性别、死因。以后还包括该周的出生情况——依据受洗的人的名单,这基本上可以反映出生的情况。几十年来,积累了很多资料,葛朗特是第一个对这一庞大的资料加以整理和利用的人,他原是一个小店主的儿子,后来子承父业,靠自学成才。他因这一部著作被选入当年成立的英国皇家学会,反映学术界对他这一著作的承认和重视。 这是一本篇幅很小的著作,主要内容为8个表,从今天的观点看,这只是一种例行的数据整理工作,但在当时则是有原创性的科研成果,其中所提出的一些概念,在某种程度上可以说沿用至今,如数据简约(大量的、杂乱无章的数据,须注过整理、约化,才能突出其中所包含的信息)、频率稳定性(一定的事件,如“生男”、“生女”,在较长时期中有一个基本稳定的比率,这是进行统计性推断的基础)、数据纠错、生命表(反映人群中寿命分布的情况,至今仍是保险与精算的基础概念)等。 葛朗特的方法被他同时代的政治经济学家佩蒂引进到社会经济问题的研究中,他提倡在这类问题的研究中不能尚空谈,要让实际数据说话,他的工作总结在他去世后于1690年出版的《政治算术》一书中。 当然,也应当指出,他们的工作还停留在描述性的阶段,不是现代意义下的数理统计学,那时,概率论尚处在萌芽的阶段,不足以给数理统计学的发展提供充分的理论支持,但不能由此否定他们工作的重大意义,作为现代数理统计学发展的几个源头之一,他们以及后续学者在人口、社会、经济等领域的工作,特别是比利时天文学家兼统计学家凯特勒19世纪的工作,对促成现代数理统计学的诞生起了很大的作用。 数理统计学的另一个重要源头来自天文和测地学中的误差分析问题。早期,测量工具的精度不高,人们希望通过多次量测获取更多的数据,以便得到对量测对象的精度更高的估计值。量测误差有随机性,适合于用概率论即统计的方法处理,远至伽利略就做过这方面的工作,他对测量误差的性态作了一般性的描述,法国大数学家拉普拉斯曾对这个问题进行了长时间的研究,现今概率论中著名的“拉普拉斯分布”,即是他在这研究中的一个产物,这方面最著名且影响深远的研究成果有二:一是法国数学家兼天文家勒让德19世纪初(1805)

分析报告、统计分析和数据挖掘的区别

分析报告、统计分析和数据挖掘的区别 关于数据挖掘的作用,Berry and Linoff的定义尽管有些言过其实,但清晰的描述了数据挖掘的作用。“分析报告给你后见之明 (hindsight);统计分析给你先机 (foresight);数据挖掘给你洞察力(insight)”。 举个例子说。 你看到孙悟空跟二郎神打仗,然后写了个分析报告,说孙悟空在柔韧性上优势明显,二郎神在力气上出类拔萃,所以刚开始不相上下;结果两个人跑到竹林里,在竹子上面打,孙悟空的优势发挥出来,所以孙悟空赢了。这叫分析报告。 孙悟空要跟二郎神打架了,有个赌徒找你预测。你做了个统计,发现两人斗争4567次,其中孙悟空赢3456次。另外,孙悟空斗牛魔王,胜率是89%,二郎神斗牛魔王胜率是71%。你得出趋势是孙悟空赢。因为你假设了这次胜利跟历史的关系,根据经验作了一个假设。这叫统计分析。 你什么都没做,让计算机自己做关联分析,自动找到了出身、教育、经验、单身四个因素。得出结论是孙悟空赢。计算机通过分析发现贫苦出身的孩子一般比皇亲国戚功夫练得刻苦;打架经验丰富的人因为擅长利用环境而机会更多;在都遇得到明师的情况下,贫苦出身的孩子功夫可能会高些;单身的人功夫总比同样环境非单身的高。孙悟空遇到的名师不亚于二郎神,而打架经验绝对丰富,并且单身,所以这次打头,孙悟空赢。这叫数据挖掘。 数据挖掘跟LOAP的区别在于它没有假设,让计算机找出这种背后的关系,而这种关系可能是你所想得到的,也可能是所想不到的。比如数据挖掘找出的结果发现在2亿条打斗记录中,姓孙的跟姓杨的打,总是姓孙的胜利,孙悟空姓孙,所以,悟空胜利。 用在现实中,我们举个例子来说,做OLAP分析,我们找找哪些人总是不及时向电信运营商缴钱,一般会分析收入低的人往往会缴费不及时。通过分析,发现不及时缴钱的穷人占71%。而数据挖掘则不同,它自己去分析原因。原因可能是,家住在五环以外的人,不及时缴钱。这些结论对推进工作有很深的价值,比如在五环外作市场调研,发现需要建立更多的合作渠道以方便缴费。这是数据挖掘的价值。

上海立信会计学院统计学官方整理资料

第一章绪论 思考题 1.什么是统计学?请简要说明一下它的发展过程。 统计学是关于数据搜集、整理、归纳、分析的方法论科学。 统计学的发展主要经历了三个阶段: (1)17世纪中叶至18世纪,统计学的产生和形成阶段; (2)18世纪末至20世纪中叶,统计推断方法和理论体系确立的阶段; (3)20世纪50年代以来,统计理论、方法和应用进入了一个全面发展的阶段。 2.统计学、统计数据,以及统计活动之间有什么关系? 统计活动直接影响统计数据的数量和质量;统计学是统计实践活动的理论概括,同时,它又用理论和方法研究分析统计实践活动,统计学和统计活动是理论与实践的关系。 3.统计学的研究方法有哪些,它们有怎样的关系?并举例说明。 主要方法有两个: (1)描述统计:搜集由试验或调查所获得的资料,进行整理、归类,计算出各种用于说 明总体数量特征的数据,并运用图形或表格的形式将它们显示出来。 (2)推断统计:指利用概率论的理论,根据试验或调查获得的样本信息科学地推断总体 的数量特征。 关系:描述统计和推断统计都是统计方法的两个组成部分,前者是统计学的基础,后者是现代统计学的主要内容。由于现实问题中,要获得总体数据存在很大的难度,能够获得的数据多为样本数据,因此,推断统计在现代统计学中的地位和作用越来越重要,它已成为统计学的核心内容。当然,描述统计的重要性不可忽略,通过它得到可靠的统计数据并为后面的推断统计提供有效的样本信息,只有这样,才可以运用推断统计方法得出符合实际情况的结论。 4.简要说明总体、样本、变量的概念。 总体:根据一定的目的确定的所要研究对象的全体,它是统计问题最基本的要素; 样本:从总体中随机抽取的若干单位构成的集合体,它是统计问题的第二要素; 变量:可变的数量;变量的具体表现,即可变数量的不同取值,称为变量值。

数据统计在统计学中的地位

数据统计在统计学中的地位 XXX XX级X班XXXXXXXXX 一、数理统计与统计学的主要特点 (一)数理统计的主要特点 数理统计就是通过对随机现象有限次的观测或试验所得数据进行归纳,找出这有限数据的内在数量规律性,并据此对整体相应现象的数量规律性做出推断或判断的一门学科。概括起来有如下几方面的特点:一是随机性,就是说数理统计的研究对象应当具有随机性,确定性现象不是数理统计所要研究的内容。二是有限性,就是说数理统计据以研究的随机现象数量表现的次数是有限的。三是数量性,即数理统计以研究随机现象的数量规律性为主,而对随机现象质的研究为次。四是采用的研究方法主要为归纳法。最后,数理统计通过对小样本的研究以达到对整体的推断都具有一定的概率可靠性。用样本推断总体误差的存在是客观的,但是数理统计不仅重在研究误差的大小,还指出误差发生的可能性的大小。 从数理统计的学科特征来看,数理统计是应用数学中最重要、最活跃的学科之一。由此可见!数理统计从学科划分来说,应属于数学学科,但是其重在应用!而不是纯数学理论或方法的研究,故其采用的方法也就重在归纳法,而不是数学的演绎法。 综上所述,数理统计的主要特点可以用一句话概括为、数理统计是一门对随机现象进行有限次的观测或试验的结果进行数量研究,并依之对总体的数量规律性做出具有一定可靠性推断的应用数学学科。 (二)统计学的主要特点 统计学是一门收集、整理和分析统计数据的方法论科学,其目的在于探索数据的内在数量规律性,以达到对客观事物的科学认识。 统计学从其研究的范围来说有三大领域:数据的收集$数据的整理和数据的分析。首先,这三大领域随着统计学的不断发展,已很难分辨出哪个领域更重要些。也许有很多人认为数据的分析要相对重要些。在对1900 年和1910年美国两次农业普查资料进行分析时,列宁曾指出:“全部问题,任务的全部困难在于,如何综合这些资料,才能确切地从政治上经济上说明不同种类或类型的农户的整个情况。”这足见数据整理的重要性。近年来困扰我国统计研究的并不是数据的分析方法,而是缺少充分真实有效的统计数据,造成无法用数据去检验或证实相应的经济理论、经济模型和经济政策。数据收集的重要性可见一斑。其次,统计学是一门方法论科学。长期以来,人们一直认为在这众多的方法中,统计研究的基本方法是大量观察法、统计指标法、统计分组法和模型推断法。特别是大量观察法更成为统计学最重要的基本特征方法之一,也可以说这是统计学与数理统计的根本区别之一,否则,统计学也就真的成了现代西方数理统计学了。随着统计学由早期的纯粹描述统计不断拓展为描述统计与推断统计并重,直至有的学者认为现代统计学应该以推断统计为主,描述统计为辅,暂且不论这种观点是否有不妥之处,但可足见推断统计学已在现代社会生活中起到举足轻重的作用。事实上,推断统计已成为现代统计学的基本特征之一。再次,统计学从其成为一门科学的那一天起,就把对现象数量方面的研究作为自己的基本特征,但是,同时强调要以

统计学试题-简答题和名字解释

1.解释总体与样本、参数和统计量的含义。 总体:是人们研究的所有基本单位(通常是人、物体、交易或事件)的总和。 样本:是总体的一部分单位。 参数:描述总体特征的概括性数字度量,它是研究者想要了解的总体的某种特征值。 统计量:根据样本数据计算出来的一个量。 2.解释总体分布、样本分布和抽样分布的含义。 总体分布就是与总体相联系的随机变量的概率分布, 样本分布是与样本相联系的随机变量的联合概率分布, 抽样分布就是作为样本的函数的统计量的分布。 3.甲企业近四年产品销售量分别增长了9%、7%、8%、6%;乙企业这四年产品的次品率也正好是9%、7%、8%、6%。这两个企业这四年的平均增长率和平均次品率的计算是否一样?为什么? 答:不一样。因为计算的对象不同,所使用的方法不同。 平均增长率要将增长率变成发展速度后,通过几 何平均法求出平均发展速度后减去1得平均增长率,即: 四年的平均增长率=()()()()%100%61%81%71%914-+?+?+?+ 平均次品率是以每年的产品量(包括次品)为权数对每年的次品率进行加权算术平均得到的,设四年的产品量分别为A 、B 、C 、D ,则 四年的平均次品率=(9%A+7%B+8%C+6%D )/(A+B+C+D) 4、解释置信水平、置信区间、显著性水平的含义,它们有什么联系。 置信水平:指在对参数估计的许多置信区间中包含总体参数真值的次数所占的比例。 置信区间:在区间估计中,由样本统计量所构造的总体参数的估计区间。 显著性水平:假设检验中犯第一类错误的概率。 它们的联系是:置信水平越高,置信区间越宽,显著性水平越低。 6、简述假设检验的一般步骤。 ⑴陈述原假设和备择假设 ⑵从所研究的总体中抽出一个随机样本 ⑶确定一个适当的检验统计量,并利用样本数据算出其具体数值 ⑷确定一个适当的显著性水平,并计算出其临界值,指定拒绝域 ⑸将统计量的值与临界值进行比较,作出决策。 7、简述第Ⅰ类错误和第Ⅱ类错误的概念,它们发生的概率之间存在怎样的关系? 当原假设为真时拒绝原假设,所犯的错误称为第Ⅰ类错误,又称为弃真错误,犯第Ⅰ类错误的概率通常 记为a 。当原假设为假时没有拒绝原假设,所犯的错误称为第Ⅱ类错误,又称为取伪错误,犯第Ⅱ类错误的概率通常记为b 。 两者的关系:当a 增大时,b 减小;当b 增大时,a 减小。 8、简述众数、中位数和均值的特点和应用场合。 (1)众数是一种位置代表值,它的应用场合比较有限;众数最容易计算,但不是永远存在,同时作为集 中趋势代表值应用的场合很少; (2)中位数具有稳健性,数据值与中位数之差的绝对值之和最小;中位数很容易理解、很直观,它不受 极端值的影响,这既是它有价值的方面,也是它数据信息利用不够充分的地方; (3)均值就是算术平均数,是数据集中趋势的最主要测度值。均值是对所有数据平均后计算的一般水平 代表值,数据信息提取得最充分。 9、简述移动平均法的基本原理和特点。 基本原理:是通过移动平均消除时间序列中的不规则变动和其他变动,从而揭示出时间序列的长期趋 势。 特点:当时间数列的变动趋势为线性状态时,可采用移动平均法进行描述和分析。该方法是通过扩大

数理统计论文——统计源于生活

统计源于生活,生活演绎统计 ——《女士品茶》读书随笔在老师推荐的几本统计学著作中,我毫不犹豫地选择了这本《女士品茶——20世纪统计怎样改变了科学》,我不知道女士品茶与统计学有何关联,其中的微妙之处让我产生了好奇。同时它的名字会让我们立刻脱离冷冰冰、一大串复杂的统计学公式,而转到一个更加贴近生活和应用的角度去欣赏统计学的魅力。书中作者试图用20世纪统计学革命中的权威大师们的生平故事来向大众阐述什么是统计模型?它们是怎么来的?在现实生活中它们意味着什么?初略本书的目录,着实给人一种和某些平乏生硬的教科书不一样的感觉,一个个故事生动地演绎着统计学一个又一个突破与飞跃! 本书一开头便解开读者心头的疑惑——女士品茶与统计学有何关联? 故事是在20世纪20年代后期发生的,在英国剑桥一个夏日的午后,一群大学的绅士和他们的夫人们,还有来访者,正围坐在户外的桌旁,享用着下午茶。在品茶过程中,一位女士坚称:把茶加进奶里,或把奶加进茶里,不同的做法,会使茶的味道品起来不同。在场的一帮科学精英们,对这位女士的“胡言乱语”嗤之以鼻。这怎么可能呢?他们不能想象,仅仅因为加茶加奶的先后顺序不同,茶就会发生不同的化学反应。 这时唯独一个身材矮小、戴着厚眼镜、下巴上蓄着的短尖髯开始变灰的先生,却不这么看,他对这个问题很感兴趣,认为这种现象可以作为一个假设并做实验验证,于是设计一个实验来测试这位女士是否能喝出两种冲泡法的区别,让她在不知情的情况下尝奶茶,猜这杯是先加奶还是先加茶。为了避免蒙中,茶的杯数要足够多,但也不能无限制的喝下去,那么为了确定那个女士能猜到多准,最少该喝多少杯呢? 这个实验很著名,是个似然估计问题。故事中那位蓄短胡须的先生便是在统计发展史上地位显赫、大名鼎鼎的罗纳德·艾尔默·费歇尔(Ronald Aylmer Fisher)。他是英国统计学家,近代数理统计的开创者。后来费歇尔在自己的著作中讨论了这个实验的各种可能结果,其中有关实验设计的著述是科学革命的要素之一。费歇尔在自己孜孜不倦地求索过程中得出一个结论:科学家需要从潜在实验结果的数据模型开始工作,这是一系列数据公式,其中一些符号代表实验中

统计学和数据挖掘区别

统计学和数据挖掘区别 数据分析微信公众号datadw——关注你想了解的,分享你需要的。 1.简介 统计学和数据挖掘有着共同的目标:发现数据中的结构。事实上,由于它们的目标相似,一些人(尤其是统计学家)认为数据挖掘是统计学的分支。这是一个不切合实际的看法。因为数据挖掘还应用了其它领域的思想、工具和方法,尤其是计算机学科,例如数据库技术和机器学习,而且它所关注的某些领域和统计学家所关注的有很大不同。 统计学和数据挖掘研究目标的重迭自然导致了迷惑。事实上,有时候还导致了反感。统计学有着正统的理论基础(尤其是经过本世纪的发展),而现在又出现了一个新的学科,有新的主人,而且声称要解决统计学家们以前认为是他们领域的问题。这必然会引起关注。更多的是因为这门新学科有着一个吸引人的名字,势必会引发大家的兴趣和好奇。把“数据挖掘”这个术语所潜在的承诺和“统计学”作比较的话,统计的最初含义是“陈述事实”,以及找出枯燥的大量数据背后的有意义的信息。当然,统计学的现代的含义已经有很大不同的事实。而且,这门新学科同商业有特殊的关联(尽管它还有科学及其它方面的应用)。 本文的目的是逐个考察这两门学科的性质,区分它们的异同,并关注与数据挖掘相关联的一些难题。首先,我们注意到“数据挖掘”对统计学家来说并不陌生。例如,Everitt定义它为:“仅仅是考察大量的数据驱动的模型,从中发现最适合的”。统计学家因而会忽略对数据进行特别的分析,因为他们知道太细致的

研究却难以发现明显的结构。尽管如此,事实上大量的数据可能包含不可预测的但很有价值的结构。而这恰恰引起了注意,也是当前数据挖掘的任务。 2.统计学的性质 试图为统计学下一个太宽泛的定义是没有意义的。尽管可能做到,但会引来很多异议。相反,我要关注统计学不同于数据挖掘的特性。 差异之一同上节中最后一段提到的相关,即统计学是一门比较保守的学科,目前有一种趋势是越来越精确。当然,这本身并不是坏事,只有越精确才能避免错误,发现真理。但是如果过度的话则是有害的。这个保守的观点源于统计学是数学的分支这样一个看法,我是不同意这个观点的。尽管统计学确实以数学为基础(正如物理和工程也以数学为基础,但没有被认为是数学的分支),但它同其它学科还有紧密的联系。 数学背景和追求精确加强了这样一个趋势:在采用一个方法之前先要证明,而不是象计算机科学和机器学习那样注重经验。这就意味着有时候和统计学家关注同一问题的其它领域的研究者提出一个很明显有用的方法,但它却不能被证明(或还不能被证明)。统计杂志倾向于发表经过数学证明的方法而不是一些特殊方法。数据挖掘作为几门学科的综合,已经从机器学习那里继承了实验的态度。这并不意味着数据挖掘工作者不注重精确,而只是说明如果方法不能产生结果的话就会被放弃。

数理统计

数理统计 数理统计(Mathematics Statistics) 什么是数理统计 数理统计是以概率论为基础,研究社会和自然界中大量随机现象数量变化基本规律的一种方法。其主要内容有参数估计、假设检验、相关分析、试验设计、非参数统计、过程统计等。 数理统计的特点 它以随机现象的观察试验取得资料作为出发点,以概率论为理论基础来研究随机现象.根据资料为随机现象选择数学模型,且利用数学资料来验证数学模型是否合适,在合适的基础上再研究它的特点,性质和规律性. 例如灯泡厂生产灯泡,将某天的产品中抽出几个进行试验.试验前不知道该天灯泡的寿命有多长,概率和其分布情况.试验后得到这几个灯泡的寿命作为资料,从中推测整批生产灯泡的使用寿命.合格率等.为了研究它的分布,利用概率论提供的数学模型进行指数分布,求出值,再利用几天的抽样试验来确定指数分布的合适性. 数理统计的起源与发展 数理统计是伴随着概率论的发展而发展起来的一个数学分支,研究如何有效的由集、整理和分析受随机因素影响的数据,并对所考虑的问题作出推断或预测,为采取某种决策和行动提供依据或建议. 数理统计起源于人口统计、社会调查等各种描述性统计活动.公元前2250年,大禹治水,根据山川土质,人力和物力的多寡,分全国为九州;殷周时代实行井田制,按人口分地,进行了土地与户口的统计;春秋时代常以兵车多寡论诸侯实力,可见已进行了军事调查和比较;汉代全国户口与年龄的统计数字有据可查;明初编制了黄册与鱼鳞册,黄册乃全国户口名册,鱼鳞册系全国土地图籍,绘有地形,完全具有现代统计图表的性质.可见,我国历代对统计工作非常重视,只是缺少系统研究,未形成专门的著作. 在西方各国,统计工作开始于公元前3050年,埃及建造金字塔,为征收建筑费用,对全国人口进行普查和统计.到了亚里土多德时代,统计工作开始往理性演变.这时,统计在卫生、保险、国内外贸易、军事和行政管理方面的应用,都有详细的记载.统计一词,就是从意大利一词逐步演变而成的. 数理统计的发展大致可分为古典时期、近代时期和现代时期三个阶段.

会计-统计学原理

技术学院夜大学2012学年第二学期考试 3、()是统计整理的初始阶段,也是整个统计整理工作的基础。 A.数据审核 B.数据检查 C.数据校订 D.数据筛选 4、在下列几个成数数值中,方差最大的成数是()。 A.0.9 B.0.8 C.0.7 D.0.6 5、定基发展速度等于相应的各个环比发展速度()。 A.之和B.之差C.之积D.之商 6、 1101 p q p q - ∑∑表明()。 A.由于销售量的变化对销售额的影响B.由于价格的变化对销售额的影响 C.由于销售量的变化对价格的影响D.由于价格的变化对销售量的影响 7、所谓大样本是指样本单位数为()。 A.30个 B.50个 C.不少于30个 D.不少于50个 8、在区间估计中,由样本统计量所构造的总体参数的估计区间,称为()。 A.有效区间 B.置信水平 C.估计值 D.置信区间 9、下列对总体参数μ建立的假设中,正确的是()。 A. 0010 :;: H H μμμμ <≥ B. 0010 :;: H H μμμμ ≥> C. 0010 :;: H H μμμμ ≤< D. 0010 :;: H H μμμμ ≥< 10、在线性相关条件下,说明两个现象之间相关关系的方向和密切程序的统计分析指标是()。 A.相关系数 B.估计标准误差 C.相关表 D.相关图 三、多项选择题。(每题3分,共30分) 1、下列属于定性数据的有()。 A.利润率 B.产品品种 C.产值 D.企业所有制 E.统计人员技术职务 2、总体、总体单位、标志、指标这几个概念间的相应关系表现为()。 A.没有总体单位也没有总体,总体单位也离不开总体而存在。 B.总体单位是标志的承担者。 C.总体随统计任务的改变而改变。 D.指标是说明总体特征的,标志是说明单体单位特征的 E.指标和标志都能用数值表现。 3、桌面调查的特点是()。 A.桌面调查所搜集的是别人加工处理过的数据 B.桌面调查所搜集的是原始数据 开卷○闭卷● 卷①●卷②○

大数据、数据分析和数据挖掘的区别

大数据、数据分析和数据挖掘的区别 大数据、数据分析、数据挖掘的区别是,大数据是互联网的海量数据挖掘,而数据挖掘更多是针对内部企业行业小众化的数据挖掘,数据分析就是进行做出针对性的分析和诊断,大数据需要分析的是趋势和发展,数据挖掘主要发现的是问题和诊断。具体分析如下: 1、大数据(big data): 指无法在可承受的时间范围内用常规软件工具进行捕捉、管理和处理的数据集合,是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产; 在维克托·迈尔-舍恩伯格及肯尼斯·库克耶编写的《大数据时代》中大数据指不用随机分析法(抽样调查)这样的捷径,而采用所有数据进行分析处理。大数据的5V特点(IBM提出):Volume(大量)、Velocity(高速)、Variety(多样)、Value(价值)Veracity(真实性) 。 2、数据分析:

是指用适当的统计分析方法对收集来的大量数据进行分析,提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。这一过程也是质量管理体系的支持过程。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。 数据分析的数学基础在20世纪早期就已确立,但直到计算机的出现才使得实际操作成为可能,并使得数据分析得以推广。数据分析是数学与计算机科学相结合的产物。 3、数据挖掘(英语:Data mining): 又译为资料探勘、数据采矿。它是数据库知识发现(英语:Knowledge-Discovery in Databases,简称:KDD)中的一个步骤。数据挖掘一般是指从大量的数据中通过算法搜索隐藏于其中信息的过程。数据挖掘通常与计算机科学有关,并通过统计、在线分析处理、情报检索、机器学习、专家系统(依靠过去的经验法则)和模式识别等诸多方法来实现上述目标。 简而言之: 大数据是范围比较广的数据分析和数据挖掘。 按照数据分析的流程来说,数据挖掘工作较数据分析工作靠前些,二者又有重合的地方,数据挖掘侧重数据的清洗和梳理。 数据分析处于数据处理的末端,是最后阶段。 数据分析和数据挖掘的分界、概念比较模糊,模糊的意思是二者很难区分。 大数据概念更为广泛,是把创新的思维、信息技术、统计学等等技术的综合体,每个人限于学术背景、技术背景,概述的都不一样。

数理统计的基础知识

第4章数理统计的基础知识 数理统计与概率论是两个有密切联系的学科, 它们都以随机现象的统计规律为研究对象.但在研究问题的方法上有很大区别:概率论——已知随机变量服从某分布,寻求分布的性质、数字特征、及其应用; 数理统计——通过对实验数据的统计分析, 寻找所服从的分布和数字特征, 从而推断整体的规律性. 数理统计的核心问题——由样本推断总体 从本章开始,我们将讨论另一主题:数理统计。 数理统计是研究统计工作的一般原理和方法的科学,它主要阐述搜集、整理、分析统计数据,并据以对研究对象进行统计推断的理论和方法,是统计学的核心和基础。 本章将介绍数理统计的基本概念:总体、样本、统计量与抽样分布。 由于大量随机现象必然呈现出它的规律性,因而从理论上讲,只要对随机现象进行足够多次观察,被研究的随机现象的规律性一定能清楚地呈现出来。但客观上只允许我们对随机现象进行次数不多的观察试验,也就是说, 我们获得的只是局部观察资料。 数理统计就是在概率论的基础上研究怎样以有效的方式收集、整理和分析可获的有限的, 带有随机性的数据资料,对所考察问题的统计性规律尽可能地作出精确而可靠的推断或预测,为采取一定的决策和行动提供依据和建议.

§4.1 总体与样本 一、 总体与总体分布 1.总体:具有一定的共同属性的研究对象全体。总体中每个对象或成员称为个体。 研究某批灯泡的质量,该批灯泡寿命的全体就是总体;考察国产 轿车的质量,所有国产轿车每公里耗油量的全体就是总体;某高校学习“高等数学”的全体一年级学生。 个体与总体的关系,即集合中元素与集合之间的关系。统计学中关心的不是每个个体的所有具体特性,而是它的某一项或某几项数量指标。某高校一年级学生“高等数学”的期末考试成绩。 对于选定的数量指标 X (可以是向量)而言,每个个体所取的值是不同的,这一数量指标X 就是一个随机变量(或向量);X 的概率分布就完全描述了总体中我们所关心的这一数量指标的分布情况。数量指标X 的分布就称为总体的分布。 说明 例如 服装厂生产的各式服装,玩具厂生产的儿童玩具,检验部门通常将产品分成若干等级。 3X 总体分布就是设定的表示总体的随机变量.的分布. 4.1 X X 定义统计学中称随机变量(或向量)为,并把随机 变量(或向量)的分布称为总体总体分布.1X 表示总体的既可以是随机变量,也可以.是随机向量.2 有时个体的特性本身不是直接由数量指.标来描述的.

《统计学》会计专业总复习-完整版

统计学总复习 第一章绪论 1、统计学是一门什么学科? 2、统计学的分类 3、掌握统计学几组基本概念的区别与联系 如何确定总体总体单位和总体单位数 第二章统计数据的搜集 统计数据的误差(这些误差是否可以计算和控制) 第三章统计数据的整理与显示 1、统计分组的作用 (1)划分现象的类型(2)揭示现象的内部结构(3)分析现象之间的依存关系 2、统计数据的显示方法 统计表统计图 3、组距分组的组中值的计算 4、箱线图的分析 第四章统计数据分布特征的度量 1、集中趋势度量有哪些?哪些受极端值的影响? 2、离散程度的度量有哪些? 3、哪些是位置平均数?哪些是数值平均数? 4、总体标准差样本标准差离散系数的计算 5、两组数据如何比较各平均数的代表性、均衡性、稳定性? (1)平均数相同时,比较它们的标准差的大小,谁小就谁的平均数就具有代表性、均衡性、稳定性。谁大谁的平均数就不具有代表性、均衡性、稳定性,也就是数据更加分散 (2)平均数不同时,比较它们的离散系数的大小,谁小就谁的平均数就具有代表性、均衡性、稳定性。谁大谁的平均数就不具有代表性、均衡性、稳定性,也就是数据更加分散 (3)如果比较两组数据中同一个人的哪个成绩好,则需要使用哪个度量值?参考教材p129 4、计算:简单算术均值加权算术均值几何均值 5、众数、中位数、均值的比较

分清在哪种情况下:x 统计学和数据挖掘:交叉学科 摘要:统计学和数据挖掘有很多共同点,但与此同时它们也有很多差异。本文讨论了两门学科的性质,重点论述它们的异同。 关键词:统计学知识发现 1.简介 统计学和数据挖掘有着共同的目标:发现数据中的结构。事实上,由于它们的目标相似,一些人(尤其是统计学家认为数据挖掘是统计学的分支。这是一个不切合实际的看法。 因为数据挖掘还应用了其它领域的思想、工具和方法,尤其是计算机学科,例如数据库技术和机器学习,而且它所关注的某些领域和统计学家所关注的有很大不同。 统计学和数据挖掘研究目标的重迭自然导致了迷惑。事实上,有时候还导致了反感。统计学有着正统的理论基础(尤其是经过本世纪的发展,而现在又出现了一个新的学科,有新的主人,而且声称要解决统计学家们以前认为是他们领域的问题。这必然会引起关注。更多的是因为这门新学科有着一个吸引人的名字,势必会引发大家的兴趣和好奇。把“数据挖掘”这个术语所潜在的承诺和“统计学”作比较的话,统计的最初含义是“陈述事实”,以及找出枯燥的大量数据背后的有意义的信息。当然,统计学的现代的含义已经有很大不同的事实。而且,这门新学科同商业有特殊的关联(尽管它还有科学及其它方面的应用。 本文的目的是逐个考察这两门学科的性质,区分它们的异同,并关注与数据挖掘相关联的一些难题。首先,我们注意到“数据挖掘”对统计学家来说并不陌生。例如,Everitt定义它为:“仅仅是考察大量的数据驱动的模型,从中发现最适合的”。统计学家因而会忽略对数据进行特别的分析,因为他们知道太细致的研究却难以发现明显的结构。尽管如此,事实上大量的数据可能包含不可预测的但很有价值的结构。而这恰恰引起了注意,也是当前数据挖掘的任务。 数理统计中的几种统计推断方法 ——导学文章之九 数理统计的基本问题是根据样本所提供的信息,对总体的分布以及分布的数字特征作出统计推断。统计推断的主要内容分为两大类:一是参数估计问题,另一类是假设检验问题。 本篇文章主要讨论总体参数的点估计、区间估计和假设检验。 一、点估计 1、矩估计 首先讲“矩”的概念, 定义:设X 是随机变量,k 是一正整数,若k EX 存在,则称k EX 为随机变量X 的k 阶原点矩,记为k a ;若存在,则称它为X 的k 阶中心矩,记为k b 。 显然,数学期望EX 就是1阶原点矩,方差DX 就是2阶中心矩。 简单的说就是用样本矩去估计相应的总体矩,用样本矩的连续函数去估计相应的总体矩的连续函数。矩估计法的理论基础是大数定理。因为大数定理告诉我们样本矩依概率收敛于总体的相应矩,样本矩的连续函数依概率收敛于相应总体矩的连续函数。 我们通常样本的均值X 去估计总体的均值E X :即总体为X 时,我们从中取出n 个样本12,,n X X X ,我们认为总体的均值就是1 1 n i i X X n ==∑,(当然这只是对总体均值的一 种估计,当然会有误差) 当2 EX 存在的时候,我们通常用 2 1 1 n i i X n =∑作为总体X 的2EX 的估计 一般地,我们用 1 1 n k i i X n =∑作为总体X 的k EX 的估计,用 1 1 () n k i i X X n =-∑作为总体的 () k E X EX -的估计。 例:设总体X 在[,]a b 上服从均匀分布,参数,a b 未知,12,,n X X X 是一个样本,求,a b 的矩估计量。 解:由矩估计法知道:2 a b EX += 由于2 2 ()DX EX EX =-,因此2 2 2 2 ()() ()124 b a a b EX D X EX -+=+= + 用矩估计法,也即用1 1 n i i X X n == ∑作为E X 的估计,用 2 1 1 n i i X n =∑作为2EX 的估计, [统计学之我见] 姓名: [牛丽霞] 学号: [201211002119] 学院: [会计学院] 班级: [会计学1241] 河南工程学院考查课 专业论文 统计学之我见 学生姓名:牛丽霞 学院:会计学院 专业班级:会计学1241班专业课程:统计学 任课教师:樊冬梅 2014 年 6 月 3 日 统计学之我见 摘要:统计学在高速发展的和科技竞争尤为激烈的情况下越来越被重视,统计学在当今社会中起着不可替代的作用,而且人类越来越需要它。统计学是一门通过对已有的数据的分析与综合,达到一定的科学目的,统计学在各个领域起着举足轻重的地位。现如今,对统计学的要求越来越高,需要更多的统计方法、更完善的统计数据、更科学的调查分析、更有效的统计结果等来做出详细的分析,从而得到更好的解决方法。 统计方法作为一种实证性研究,广泛运用在社会生活的各个层面,它为理论研究提供了验证的依据,使得理论与实践更加紧密地结合在一起。统计方法在心理与教育统计学中的运用,丰富了教育理论研究,为大量的理论假设提供检验性依据,综述各种统计方法在实际中的运用情况,并且结合实际探讨统计学的发展趋势。 关键字:统计学;发展;思想;趋势;应用 1、统计学的概述及发展历程 (1) 1.1统计学的发展历程 (1) 1.2统计学的概述 (1) 2、统计学的分支学科 (2) 3、常用的统计方法 (2) 4、统计学中的几种统计思想 (2) 4.1均值思想 (2) 4.2变异思想 (2) 4.3估计思想 (2) 4.4相关思想 (2) 4.5拟合思想 (3) 4.6检验思想 (3) 4.7统计思想的特点 (3) 5、统计学的现状 (3) 5.1对系统性及系统复杂性的认识为统计学的未来发展增加了新的思路。 (3) 5.2定性与定量相结合的综合集成法将为统计分析方法的发展提供新的思想。.. 3 5.3统计科学与其他科学渗透将为统计学的应用开辟新的领域。 (4) 6、统计学的基本发展趋势 (4) 6.1统计学与实质性学科结合的趋势 (4) 6.2统计学与计算机科学结合的趋势 (5) 7、统计学的应用 (6) 7.1统计学与实质性学科结合的趋势 (6) 7.2统计学与计算机科学结合的趋势 (6) 7.3统计学与其它方法论学科结合的趋势 (6) 8、总结 (6) 9、参考文献 (7) https://www.360docs.net/doc/b412653486.html, 机器学习和数据挖掘的联系与区别_光环大数据培训 光环大数据培训机构了解到,从数据分析的角度来看,数据挖掘与机器学习有很多相似之处,但不同之处也十分明显,例如,数据挖掘并没有机器学习探索人的学习机制这一科学发现任务,数据挖掘中的数据分析是针对海量数据进行的,等等。从某种意义上说,机器学习的科学成分更重一些,而数据挖掘的技术成分更重一些。 机器学习(Machine Learning,ML)是一门多领域交叉学科,涉及概率论、统计学、逼近论、凸分析、算法复杂度理论等多门学科。其专门研究计算机是怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构,使之不断改善自身的性能。 数据挖掘是从海量数据中获取有效的、新颖的、潜在有用的、最终可理解的模式的非平凡过程。数据挖掘中用到了大量的机器学习界提供的数据分析技术和数据库界提供的数据管理技术。 学习能力是智能行为的一个非常重要的特征,不具有学习能力的系统很难称之为一个真正的智能系统,而机器学习则希望(计算机)系统能够利用经验来改善自身的性能,因此该领域一直是人工智能的核心研究领域之一。在计算机系统中,“经验”通常是以数据的形式存在的,因此,机器学习不仅涉及对人的认知学习过程的探索,还涉及对数据的分析处理。实际上,机器学习已经成为计算机数据分析技术的创新源头之一。由于几乎所有的学科都要面对数据分析任务,因此机 https://www.360docs.net/doc/b412653486.html, 器学习已经开始影响到计算机科学的众多领域,甚至影响到计算机科学之外的很多学科。机器学习是数据挖掘中的一种重要工具。然而数据挖掘不仅仅要研究、拓展、应用一些机器学习方法,还要通过许多非机器学习技术解决数据仓储、大规模数据、数据噪声等实践问题。机器学习的涉及面也很宽,常用在数据挖掘上的方法通常只是“从数据学习”。然而机器学习不仅仅可以用在数据挖掘上,一些机器学习的子领域甚至与数据挖掘关系不大,如增强学习与自动控制等。所以笔者认为,数据挖掘是从目的而言的,机器学习是从方法而言的,两个领域有相当大的交集,但不能等同。 典型的数据挖掘和机器学习过程 下图是一个典型的推荐类应用,需要找到“符合条件的”潜在人员。要从用户数据中得出这张列表,首先需要挖掘出客户特征,然后选择一个合适的模型来进行预测,最后从用户数据中得出结果。 把上述例子中的用户列表获取过程进行细分,有如下几个部分。 业务理解:理解业务本身,其本质是什么?是分类问题还是回归问题?数据怎么获取?应用哪些模型才能解决? 数据理解:获取数据之后,分析数据里面有什么内容、数据是否准确,为下 数理统计学习感想 学习了一学期的数理统计,我学会了如何在生活中运用所学的知识去解决一些问题。 现实中常常存在这种情况,我们所掌握的数据只是部分单位的数据或有限单位的数据,而我们所关心的却是整个总体甚至是无限总体的数量特征。例如,民意测验谁会当选主席体育锻炼对增强心脏功能是否有益某种新药是否提高疗效全国婴儿性别比例如何等等。这时只靠部分数据的描述是无法获得总体特征的知识。 我们利用统计推断的方法来解决。所谓统计推断就是以一定的置信标准要求,根据样本数据来判断总体数量特征的归纳推理的方法。统计推断是逻辑归纳法在统计推理的应用,所以称为归纳推理的方法。统计推断可以用于总体数量特征的估计,也可以用于对总体某些假设的检验,所以又有不同的推断方法。下面就参数估计和假设检验的基本概念及原理简单谈谈。 参数估计是根据从总体中抽取的样本估计总体分布中包含的未知参数的方法。它是统计推断的一种基本形式,是数理统计学的一个重要分支,分为点估计和区间估计两部分。参数估计包括点估计和区间估计两种方法。点估计是依据样本估计总体分布中所含的未知参数或未知参数的函数。通常它们是总体的某个特征值,如数学期望、方差和相关系数等。点估计问题就是要构造一个只依赖于样本的量,作为未知参数或未知参数的函数的估计值。构造点估计常用的方法是:①矩估计法。用样本矩估计总体矩,如用样本均值估计总体均值。 ②最大似然估计法。于1912年由英国统计学家.费希尔提出,利用样本分布密度构造似然函数来求出参数的最大似然估计。③最小二乘法。主要用于线性统计模型中的参数估计问题。 ④贝叶斯估计法。基于贝叶斯学派(见贝叶斯统计)的观点而提出的估计法。 区间估计是依据抽取的样本,根据一定的正确度与精确度的要求,构造出适当的区间,作为总体分布的未知参数或参数的函数的真值所在范围的估计。例如人们常说的有百分之多少的把握保证某值在某个范围内,即是区间估计的最简单的应用。1934年统计学家J.奈曼创立了一种严格的区间估计理论。求置信区间常用的三种方法:①利用已知的抽样分布。②利用区间估计与假设检验的联系。③利用大样本理论。 假设检验是抽样推断中的一项重要内容。它是根据原资料作出一个总体指标是否等于某一个数值,某一随机变量是否服从某种概率分布的假设,然后利用样本资料采用一定的统计方法计算出有关检验的统计量,依据一定的概率原则,以较小的风险来判断估计数值与总体统计学和数据挖掘(中文).

数理统计中的几种统计推断方法

统计学论文

机器学习和数据挖掘的联系与区别_光环大数据培训

数理统计学习感想