web集群方案_haproxy+varnish+LNMP+memcached配置

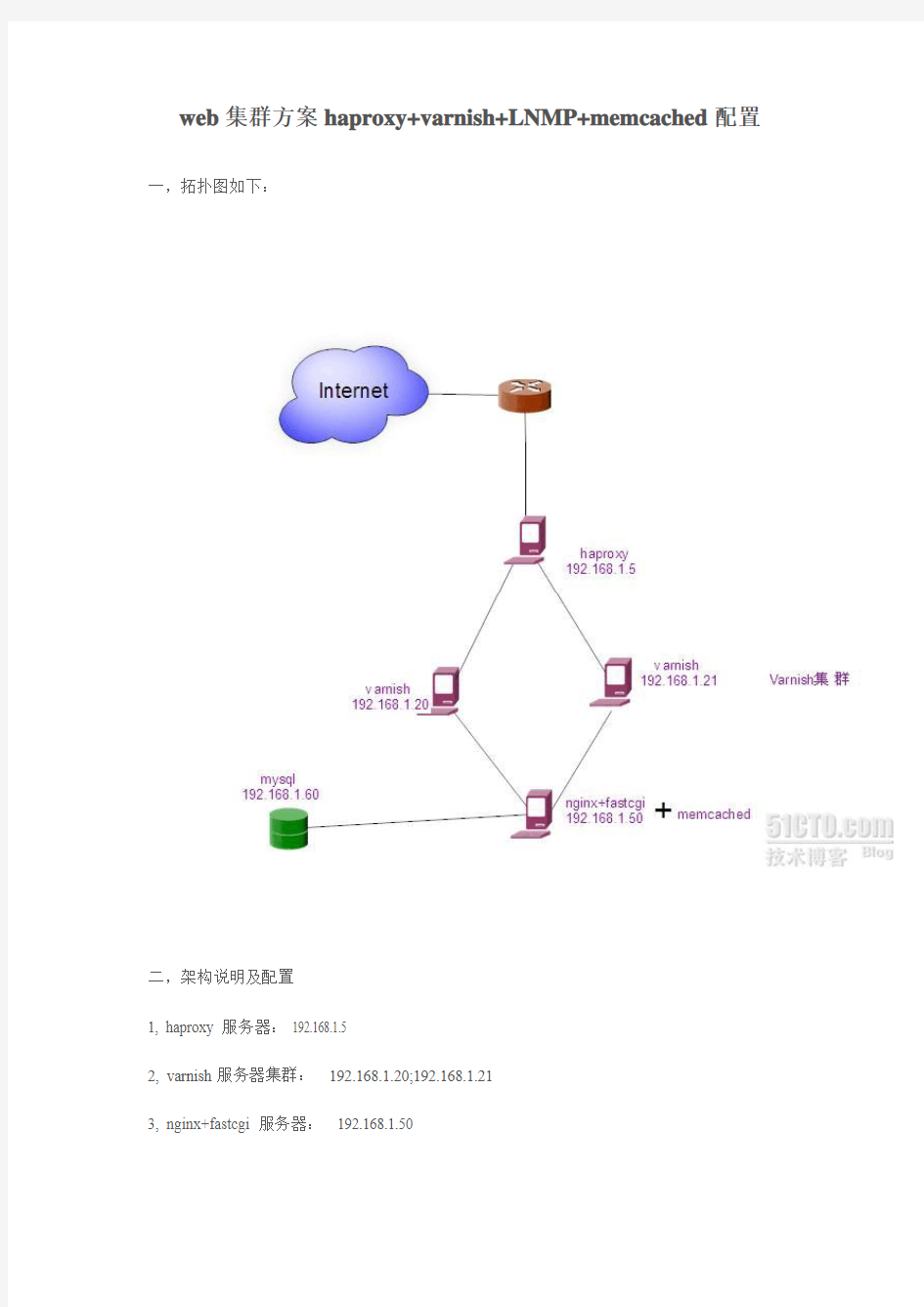

web集群方案haproxy+varnish+LNMP+memcached配置一,拓扑图如下:

二,架构说明及配置

1, haproxy 服务器: 192.168.1.5

2, varnish服务器集群: 192.168.1.20;192.168.1.21

3, nginx+fastcgi 服务器: 192.168.1.50

4, memcached 服务器:memcached我是装在nginx+fastcgi服务器上的,192.168.1.50

5, mysql服务器:192.168.1.60

三,具体配置以下我们来一个个讲解,我们先从后端来个个讲解,

1,在192.168.1.60 服务器上安装 mysql

2, 在192.168.1.50 服务器上安装 nginx+fastcgi.

mysql+nginx+fastcgi 配置,这里不讲解了,网上包括我的博客里面都有讲解如何时安装。3,memcached安装配置。

这里的memcached 我安装在 192.168.1.50 服务器上安装步骤如下:

(1)下载所需要的软件(memcached目前最新版本为1.4.13)

安装memcached需要libevent库支持,我们下载libevent1.3版本即可

1.#wget https://www.360docs.net/doc/ee8746096.html,/files/memcached-1.4.13.tar.gz

2.#wget https://www.360docs.net/doc/ee8746096.html,/~provos/libevent-1.

3.tar.gz

(2)先安装libevent:

1.# tar zxvf libevent-1.3.tar.gz

2.# cd libevent-1.3

3.# ./configure --prefix=/usr

4.# make

5.# make install

(3)安装memcached,同时需要安装中指定libevent的安装位置:

1.# cd /tmp

2.# tar zxvf memcached-1.4.1

3.tar.gz

3.# cd memcached-1.

4.13

4.# ./configure --with-libevent=/usr

5.# make

6.# make install

安装完成后会把memcached放到 /usr/local/bin/memcached

(4)fastcgi 安装memcache扩展模块,让php支持memcached

1.在https://www.360docs.net/doc/ee8746096.html,/package/memcache 选择相应想要下载的memcache版本。

2.安装PHP的memcache扩展

1.#tar vxzf memcache-

2.2.1.tgz

2.#cd memcache-2.2.1

3.#/usr/local/webserver/php/bin/phpize

4.#./configure--enable-memcache --with-php-config=/usr/local/webserver/php

/bin/php-config --with-zlib-dir

5.#make

6.#make install

3.上述安装完后会有类似这样的提示:

1.Installing shared extensions: /usr/local/webserver/php/lib/php/extension

s/no-debug-non-zts-20060613/

4,在php.ini 添加一行来载入memcache扩展:

1.#extension = "memcache.so"

如下图

5,重新加载php 配置文件

启动memcached

1.# /usr/local/bin/memcached -d -m 1024 -u root -l 127.0.0.1 -p 11211 -c 1

0240 -P /tmp/memcached.pid

我们来看一下是否正常启动

端口已正常启动。

1.memcache启动参数备注:

2.-d选项是启动一个守护进程,

3.-m是分配给Memcache使用的内存数量,单位是MB,我这里是10MB,

4.-u是运行Memcache的用户,我这里是root,

5.-l是监听的服务器IP地址,为了安全我这里指定了 127.0.0.1,

6.-p是设置Memcache监听的端口,我这里设置了11211,最好是1024以上的端口,

7.-c选项是最大运行的并发连接数,默认是1024,我这里设置10240,按照你服务器的负载量来设

定

8.-P是设置保存Memcache的pid文件,我这里是保存在 /tmp/memcached.pid,

9.

Memcached安装完毕。我们来测试一下是否能缓存mysql数据

我们在此服务器上架设一个php网站,此处我先用的是占用资源比较大的magento程序网站,调试好配置文件,绑定一下host文件。看网站是否能正常打开。

好,网站打开正常,接下来我们看一下,memcached是否发挥了他的作用

这里我们用一个软件 memadmin (网上可以下载到)来监控一下memcached的缓存命中率,如下图:

命中率还是挺高的。

4,varnish服务器安装

以下在192.168.1.20 和 192.168.1.21 上操作

下载varnish软件(此处下载3.0版本)

1.#wget https://www.360docs.net/doc/ee8746096.html,/source/varnish-3.0.0.tar.gz

2.#tar -xvf varnish-

3.0.0.tar.gz

3.#cd varnish-3.0.0

4.#./configure --prefix=/usr/local/varnish

5.#make &&make install

至此安装完成。

我们来配置一下

1.#vim /usr/local/varnish/etc/varnish/vcl.conf

以下为配置代码:(除backend 及vcl_recv外,其他地方无需更改,这里是更改其访问的主机名,及定义后端服务器地址,字数有限,其他代码这里就不解释了)

1.#Cache for linuxtone sites

2.#backend vhost

3.backend wwwyaozhibingceshicom {

4..host = "https://www.360docs.net/doc/ee8746096.html,";

5..port = "80";

6.}

7.#acl

8.acl purge {

9. "localhost";

10. "127.0.0.1";

11. "192.168.0.0"/24;

12.}

13.sub vcl_recv {

14. if (req.http.Accept-Encoding) {

15. if (req.url ~ "\.(jpg|png|gif|jpeg|flv)$" ) {

16. remove req.http.Accept-Encoding;

17. remove req.http.Cookie;

18. } else if (req.http.Accept-Encoding ~ "gzip") {

19. set req.http.Accept-Encoding = "gzip";

20. } else if (req.http.Accept-Encoding ~ "deflate") {

21. set req.http.Accept-Encoding = "deflate";

22. } else {

23. remove req.http.Accept-Encoding;

24. }

25. }

26. if (req.http.host ~ "(.*)https://www.360docs.net/doc/ee8746096.html,") {

27. set req.backend = wwwyaozhibingceshicom;

28. }

29. else {

30. error 404 "This website is maintaining or not ex

ist!";

31. }

32. if (req.request == "PURGE") {

33. if (!client.ip ~purge) {

34. error 405 "Not Allowed";

35. }

36.#.dd.....

37. return(lookup);

38. }

39.#...GET...url...jpg,png,gif. ..cookie

40. if (req.request == "GET"&& req.url ~ "\.(png|gif|jpeg|jpg|ico|swf|css|

js|html|htm|gz|tgz|bz2|tbz|mp3|ogg|mp4|flv|f4v|pdf)$") {

41. unset req.http.cookie;

42. }

43.#..GET...url.php....cache....

44. if (req.request =="GET"&&req.url ~ "\.php($|\?)"){

45. return (pass);

46. }

47.# if (req.restarts == 0) {

48. if (req.http.x-forwarded-for) {

49. set req.http.X-Forwarded-For =

50. req.http.X-Forwarded-For + ", " + client.ip;

51. } else {

52. set req.http.X-Forwarded-For = client.ip;

53. }

54.# }

55.#........pipe..

56. if (req.request != "GET" &&

57. req.request != "HEAD" &&

58. req.request != "PUT" &&

59. req.request != "POST" &&

60. req.request != "TRACE" &&

61. req.request != "OPTIONS" &&

62. req.request != "DELETE") {

63. return (pipe);

64. }

65.#..GET .HEAD.....

66. if (req.request != "GET" && req.request != "HEAD") {

67. return (pass);

68. }

69. if (req.http.Authorization) {

70. return (pass);

71. }

72. return (lookup);

73.}

74.#..url+host hash......

75.sub vcl_hash {

76. hash_data(req.url);

77. if (req.http.host) {

78. hash_data(req.http.host);

79. } else {

80. hash_data(server.ip);

81. }

82. return (hash);

83.}

84.# .....purge .....

85.sub vcl_hit {

86. if (req.request == "PURGE") {

87. set obj.ttl = 0s;

88. error 200 "Purged";

89. }

90. return (deliver);

91.}

92.sub vcl_fetch {

93. if (req.url ~ "\.(jpeg|jpg|png|gif|gz|tgz|bz2|tbz|mp3|ogg|ico|

swf|flv|dmg|js|css|html|htm)$") {

94. set beresp.ttl = 2d;

95. set beresp.http.expires = beresp.ttl;

96. set beresp.http.Cache-Control = "max-age=172800";

97. unset beresp.http.set-cookie;

98. }

99. if (req.url ~ "\.(dmg|js|css|html|htm)$") {

100. set beresp.do_gzip = true;

101. }

102. if (beresp.status == 503) {

103. set beresp.saintmode = 15s;

104. }

105.}

106.sub vcl_deliver {

107. set resp.http.x-hits = obj.hits ;

108. if (obj.hits > 0) {

109. set resp.http.X-Cache = "HIT You!";

110. } else {

111. set resp.http.X-Cache = "MISS Me!";

112. }

113.}

配置文件保存退出 ,并启动 varnish,如下图

由于我这域名没有注册,所以我们在这两台机器的hosts文件里绑定一下

另外一台机器我们同样配置

Varnish 已经成功启动了,我们来分别把域名在本地绑定一下,直接访问varnish服务器,看是否能正常打开网站,并查看缓存合中率

从上图可以看出来,绑定varnish 服务器网站是可以正常打开,而且从varnish自带的命

令 varnishstat 来看,平均缓存命中率能达到 92%,命中率也是非常的高!另一台同样的测试方法

至此,varnish 服务器集群安装配置完成。

5,Haproxy 服务器安装配置

以下配置在 192.168.1.5;192.168.1.6 服务器上运行

下载 haproxy 软件(目前最新版本为1.4.19)

1.wget http://haproxy.1wt.eu/download/1.4/src/haproxy-1.4.19.tar.gz

2.#tar -xvf haproxy-1.4.19.tar.gz

3.#cd haproxy-1.

4.19

4.#make TARGET=linux26 PREFIX=/usr/local/haproxy

5.#make install PREFIX=/usr/local/haproxy

安装完成,接下来配置一下我解析几个比较重要的参数

1.# cd /usr/local/haproxy

2.# vim haproxy.conf

3.global

4. maxconn 5120

5. chroot /usr/local/haproxy

6. uid 99

7. gid 99

8. daemon

9. quiet

10. nbproc 2

11. pidfile /usr/local/haproxy/haproxy.pid

12.defaults

13. log global

14. mode http

15. option httplog

16. option dontlognull

17. log 127.0.0.1 local3

18. retries 3

19. option redispatch

20. maxconn 20000

21. contimeout 5000

22. clitimeout 50000

23. srvtimeout 50000

24.listen https://www.360docs.net/doc/ee8746096.html, 0.0.0.0:80

25. mode http

26. stats uri /status (后端服务器状态查看地址)

27. stats realm Haproxy\ statistics

28. stats auth admin:admin (状态查看页面登陆帐号密码)

29. balance source (调度算法,调度算法有很多,我这里用source是和nginx的

ip_hash同理,解决session问题)

30. option httpclose

31. option forwardfor

32.server app1_1 192.168.1.20:80 cookie app1inst1 check inter 2000 rise 2 f

all 5

33.server app1_2 192.168.1.21:80 cookie app1inst2 check inter 2000 rise 2 f

all 5

最下面两行,定义了后端的两台服务器,如果有更多,再另起一行,根据上面的格式写上即可。

配置好后,启动haproxy 并查看是否启动成功

这样看,是启动成功了的

好的,我们来把域名。绑定到这台haproxy服务器上看网站是否能正常打开。

我们发现,网站也是可以正常打开的,

haproxy 有宕机检测功能,当后端服务器宕机后,他能自动检测,并禁止链接再发往宕机的机器.

注:haproxy 后端服务器状态查看方法

配置文件里注明了 stats uri /status 即访问www.域名.com/status即可查看后端服务器状态如图:

这次方案由于资本有限,所以在服务器这块,大大的减少了。如果做到高可用性,

应该要做到 haproxy 集群,nginx+fastcgi集群,以及数据库这块的集群。

但是道理都是一样的,只是多加一些服务器,要达到千万级PV的网站,借用老男孩的一句来说,就是“把所有的用户访问请求都尽量往前推”。

QQ:410018348

SQLOracle数据库群集实施方案

南宁海关信息系统基础平台数据库群集实施报告 2016年9月13号

目录 1 MS SQL数据库群集 ................................................................. 错误!未定义书签。 项目概述.............................................................................. 错误!未定义书签。 SQL群集拓朴图................................................................. 错误!未定义书签。 运行网SQL群集拓朴图............................................ 错误!未定义书签。 管理网SQL群集拓朴图.............................................. 错误!未定义书签。 SQL群集配置信息............................................................. 错误!未定义书签。 运行网SQL群集配置表............................................ 错误!未定义书签。 管理网SQL群集配置.................................................. 错误!未定义书签。 SQL群集安装配置............................................................. 错误!未定义书签。 网络配置...................................................................... 错误!未定义书签。 两台服务器功能及角色安装...................................... 错误!未定义书签。 Win2008集群验证和配置.......................................... 错误!未定义书签。 添加MSDTC的集群资源.......................................... 错误!未定义书签。 添加SP1功能 .............................................................. 错误!未定义书签。 优化网络配置................................................................ 错误!未定义书签。 安装SQLServer2008集群.................................................... 错误!未定义书签。 安装第一个集群节点.................................................... 错误!未定义书签。 添加第二个集群节点.................................................... 错误!未定义书签。 验证SQL2008群集.................................................... 错误!未定义书签。2Oracle RAC高可用群集........................................................ 错误!未定义书签。 项目概述.............................................................................. 错误!未定义书签。 Oracle群集拓朴图 ...................................................... 错误!未定义书签。 Oracle群集配置信息.......................................................... 错误!未定义书签。 系统及数据库版本........................................................ 错误!未定义书签。 主机IP地址................................................................ 错误!未定义书签。 共享存储配置................................................................ 错误!未定义书签。 安装目录配置................................................................ 错误!未定义书签。

全局负载均衡解决方案

全局负载均衡解决方案 1 需求分析 无论用户的数据中心内部采用多么完善的冗余机制、安全防范工具以及先进的负载均衡技术,单个数据中心的运行方式仍然不能保证关键业务可以7*24不间断运行。 而为了满足处于全球范围内不同地点的用户在访问应用时可以具备相同的快速访问感受,单一的数据中心却完法实现。 基于以上两个最主要的原因,用户通过在不同物理位置构建多个数据中心的方式已经成为用户的必然选择。然而,在构建了多个数据中心后,如何通过有效手段实现多个数据中心间的协调工作,引导用户访问最优的站点,或者当某个站点出现灾难性故障后使用户仍然可以访问其他站点上的关键业务等问题成为用户最关注的问题。 2 Radware 全局负载均衡解决方案 Radware 的全局负载均衡解决方案能够帮助客户通过将相同服务内容布署在处于不同物理地点的多个数据中心中得到更高的可用性、性能、以及更加经济和无懈可击的安全性,以便在全球范围内的客户获得更快的响应时间。 Radware的全局负载均衡解决方案支持Radware 下一代APSolute OS 软件体系结构的全部功能,彻底解决了网络可用性、性能和安全问题,使得应用在多个数据中心中获得更高的灵敏并具有自适应性。配合Radware 的高速度、高容量ASIC芯片+NP处理器的专用硬件应用交换设备,可有效保障网络应用的高可用性、提升网络性能,加强安全性,全面提升IT服务器等网络基础设施的升值潜力。 结合Radware多年来在智能应用流量管理领域的经验,以及对用户实际需求的分析,我们认为负载均衡器应具备如下功能:

?能够通过唯一的IP地址或域名的方式作为所有提供相同服务的数据中心的逻辑入口点。 ?全局负载均衡交换机具有灵活的流量分配算法与机制,以确保用户总能访问可以为其提供最优服务的数据中心的内容。 ?通过部署高性能的负载均衡产品,能够及时发现各数据中心或数据中心内部的服务器的健康状况,当某个数据中心出现故障时,保证把后续用户的访问导向到正常运行的数据中心上。 ?针对基于会话的业务,可以提供多种会话保持机制,确保用户在处理业务时的连续性。避免将用户的相同会话的业务请求,分配到不同的数据中心而造成访问失败。 ?应具备安全过虑及防DOS/DDOS的功能,为服务器提供多一层安全保障 ?具有很好的升级与可扩展性,能够适应特定的和不断变化的业务需求。 2.1 方案拓扑图 2.2 AppDirector-Global实现全局及本地负载均衡 在全局及本地负载均衡方面,AppDirector-Global主要在网络中实现以下功能: 2.2.1 全局负载均衡策略 Radware支持多种全局负载均衡策略,能够通过唯一的IP地址或域名的方式作为所有提供相同服务的数据中心的逻辑入口点。根据用户的实际情况,可以选择其中以下的一种,也可以组合同时使用。

负载均衡解决方案V1

负载均衡解决方案 公司:XX 日期:XX年XX月XX日

目录 1. 负载均衡概述 (3) 2. 项目现状 (3) 3. 项目需求分析 (4) 4. 项目解决方案 (4) 5. 负载均衡结构介绍 (7) 5.1. 负载均衡 (7) 5.2. 负载均衡实现设备[2] (8) 5.3. 负载均衡系统结构 (9) 5.3.1. 两层结构的负载均衡系统 (9) 5.3.2. 三层结构的负载均衡系统 (9) 5.4. 负载均衡实现的方法 (11) 6. Web服务器集群环境配置与测试 (11) 6.1. 搭建环境 (11) 6.1.1. 软硬件环境的搭建 (11) 6.1.2. 软件的安装与配置 (11) 6.2. 环境的测试 (13) 6.3. 集群系统负载均衡测试 (13) 6.4. 集群系统负载均衡测试分析 (13) 6.5. 本系统的不足之处 (14)

1.负载均衡概述 为了提高集群系统对用户的快速响应与整体吞吐量,必须采取一定的策略将Web访问均衡地分配到集群中的每一个服务器。基于此思想本文针对传统的单机思想给出了一种多机三层结构的负载均衡系统。实验结果表明了它在负载均衡方面的优越性。 Internet的快速增长,特别是电子商务应用的发展,使Web应用成为目前最重要最广泛的应用,Web服务器动态内容越来越流行。目前,网上信息交换量几乎呈指数增长,需要更高性能的Web服务器提供更多用户的Web服务,因此,Web服务器面临着访问量急剧增加的压力,对其处理能力和响应能力等带来更高的要求,如果Web 服务器无法满足大量Web访问服务,将无法为用户提供稳定、良好的网络应用服务。 由于客观存在的服务器物理内存、CPU 处理速度和操作系统等方面的影响因素,当大量突发的数据到达时,Web服务器无法完全及时处理所有的请求,造成应答滞后、请求丢失等,严重的导致一些数据包因延时而重发,使传输线路和服务器的负担再次增加。传统的方法是提高Web 服务器的CPU 处理速度和增加内存容量等硬件办法但无论如何增加Web 服务器硬件性能,均无法满足日益增加的对用户的访问服务能力。 面对日渐增加的Web 访问服务要求,必须对Web 服务器按一定策略进行负载分配。利用负载均衡[1]的技术,按照一定策略将Web 访问服务分配到几台服务器上,负载处理对用户透明,整体上对外如同一台Web 服务器为用户提供Web服务。 2.项目现状 本案例公司中现有数量较多的服务器群: ?WEB网站服务器 4台

几种负载均衡策略比较~

PS:Nginx/LVS/HAProxy是目前使用最广泛的三种负载均衡软件,本人都在多个项目中实施过,参考了一些资料,结合自己的一些使用经验,总结一下。 一般对负载均衡的使用是随着网站规模的提升根据不同的阶段来使用不同的技术。具体的应用需求还得具体分析,如果是中小型的Web应用,比如日PV小于1000万,用Nginx就完全可以了;如果机器不少,可以用DNS轮询,LVS所耗费的机器还是比较多的;大型网站或重要的服务,且服务器比较多时,可以考虑用LVS。一种是通过硬件来进行进行,常见的硬件有比较昂贵的F5和Array等商用的负载均衡器,它的优点就是有专业的维护团队来对这些服务进行维护、缺点就是花销太大,所以对于规模较小的网络服务来说暂时还没有需要使用;另外一种就是类似于Nginx/LVS/HAProxy的基于Linux的开源免费的负载均衡软件,这些都是通过软件级别来实现,所以费用非常低廉。 目前关于网站架构一般比较合理流行的架构方案:Web前端采用 Nginx/HAProxy+Keepalived作负载均衡器;后端采用MySQL数据库一主多从和读写分离,采用LVS+Keepalived的架构。当然要根据项目具体需求制定方案。 下面说说各自的特点和适用场合。 一、Nginx Nginx的优点是: 1、工作在网络的7层之上,可以针对http应用做一些分流的策略,比如针对域名、目录结构,它的正则规则比HAProxy更为强大和灵活,这也是它目前广泛流行的主要原因之一,Nginx单凭这点可利用的场合就远多于LVS了。 2、Nginx对网络稳定性的依赖非常小,理论上能ping通就就能进行负载功能,这个也是它的优势之一;相反LVS对网络稳定性依赖比较大,这点本人深有体会; 3、Nginx安装和配置比较简单,测试起来比较方便,它基本能把错误用日志打印出来。LVS的配置、测试就要花比较长的时间了,LVS对网络依赖比较大。 3、可以承担高负载压力且稳定,在硬件不差的情况下一般能支撑几万次的并发量,负载度比LVS相对小些。 4、Nginx可以通过端口检测到服务器内部的故障,比如根据服务器处理网页返回的状态码、超时等等,并且会把返回错误的请求重新提交到另一个节点,不过其中缺点就是不支持url来检测。比如用户正在上传一个文件,而处理该上传的节点刚好在上传过程中出现故障,Nginx会把上传切到另一台服务器重新处理,而LVS就直接断掉了,如果是上传一个很大的文件或者很重要的文件的话,用户可能会因此而不满。 5、Nginx不仅仅是一款优秀的负载均衡器/反向代理软件,它同时也是功能强大的Web应用服务器。LNMP也是近几年非常流行的web架构,在高流量的环境中稳定性也很好。 6、Nginx现在作为Web反向加速缓存越来越成熟了,速度比传统的Squid服务器更快,可以考虑用其作为反向代理加速器。 7、Nginx可作为中层反向代理使用,这一层面Nginx基本上无对手,唯一可以对比

专题数据库建设方案

一,数据仓库的数据模型 1. 数据源 数据源,顾名思义就是数据的来源,互联网公司的数据来源随着公司的规模扩张而呈递增趋势,同时自不同的业务源,比如埋点采集,客户上报等。 2. ODS层 数据仓库源头系统的数据表通常会原封不动地存储一份,这称为ODS(Operation Data Store)层, ODS层也经常会被称为准备区(Staging area),它们是后续数据仓库层(即基于Kimball维度建模生成的事实表和维度表层,以及基于这些事实表和明细表加工的汇总层数据)加工数据的来源,同时ODS层也存储着历史的增量数据或全量数据。 3. DW层 据仓库明细层(Data Warehouse Detail ,DWD)和数据仓库汇总层(Data Warehouse Summary, DWS)是数据仓库的主题内容。DWD和DWS层的数据是ODS 层经过ETL清洗、转换、加载生成的,而且它们通常都是基于Kimball的维度建模理论来构建的,并通过一致性维度和数据总线来保证各个子主题的维度一致性。 4. DWS层 应用层汇总层主要是将DWD和DWS的明细数据在hadoop平台进行汇总,然后将产生的结果同步到DWS数据库,提供给各个应用。 二,数据采集

数据采集的任务就是把数据从各种数据源中采集和存储到数据存储上,期间有可能会做一些简单的清洗。 比较常见的就是用户行为数据的采集 先做sdk埋点,通过kafka实时采集到用户的访问数据,再用spark做简单的清洗,存入hdfs作为数据仓库的数据源之一。 三,数据存储 随着公司的规模不断扩张,产生的数据也越来越到,像一些大公司每天产生的数据量都在PB级别,传统的数据库已经不能满足存储要求,目前hdfs是大数据环境下数据仓库/数据平台最完美的数据存储解决方案。 在离线计算方面,也就是对实时性要求不高的部分,Hive还是首当其冲的选择,丰富的数据类型、内置函数;压缩比非常高的ORC/PARQUET文件存储格式;非常方便的SQL 支持,使得Hive在基于结构化数据上的统计分析远远比MapReduce要高效的多,一句SQL可以完成的需求,开发MR可能需要上百行代码;而在实时计算方面,flink是最优的选择,不过目前仅支持java跟scala开发。 四,数据同步 数据同步是指不同数据存储系统之间要进行数据迁移,比如在hdfs上,大多业务和应用因为效率的原因不可以直接从HDFS上获取数据,因此需要将hdfs上汇总后的数据同步至其他的存储系统,比如mysql;sqoop可以做到这一点,但是Sqoop太过繁重,而且不

数据库负载均衡解决方案

双节点数据库负载均衡解决方案 问题的提出? 在SQL Server数据库平台上,企业的数据库系统存在的形式主要有单机模式和集群模式(为了保证数据库的可用性或实现备份)如:失败转移集群(MSCS)、镜像(Mirror)、第三方的高可用(HA)集群或备份软件等。伴随着企业的发展,企业的数据量和访问量也会迅猛增加,此时数据库就会面临很大的负载和压力,意味着数据库会成为整个信息系统的瓶颈。这些“集群”技术能解决这类问题吗?SQL Server数据库上传统的集群技术 Microsoft Cluster Server(MSCS) 相对于单点来说Microsoft Cluster Server(MSCS)是一个可以提升可用性的技术,属于高可用集群,Microsoft称之为失败转移集群。 MSCS 从硬件连接上看,很像Oracle的RAC,两个节点,通过网络连接,共享磁盘;事实上SQL Server 数据库只运行在一个节点上,当出现故障时,另一个节点只是作为这个节点的备份; 因为始终只有一个节点在运行,在性能上也得不到提升,系统也就不具备扩展的能力。当现有的服务器不能满足应用的负载时只能更换更高配置的服务器。 Mirror 镜像是SQL Server 2005中的一个主要特点,目的是为了提高可用性,和MSCS相比,用户实现数据库的高可用更容易了,不需要共享磁盘柜,也不受地域的限制。共设了三个服务器,第一是工作数据库(Principal Datebase),第二个是镜像数据库(Mirror),第三个是监视服务器(Witness Server,在可用性方面有了一些保证,但仍然是单服务器工作;在扩展和性能的提升上依旧没有什么帮助。

负载均衡解决方案设计设计

一、用户需求 本案例公司中现有数量较多的服务器群: WEB网站服务器 4台 邮件服务器 2台 虚拟主机服务器 10台 应用服务器 2台 数据库 2台(双机+盘阵) 希望通过服务器负载均衡设备实现各服务器群的流量动态负载均衡,并互为冗余备份。并要求新系统应有一定的扩展性,如数据访问量继续增大,可再添加新的服务器加入负载均衡系统。 二、需求分析 我们对用户的需求可分如下几点分析和考虑: 1.新系统能动态分配各服务器之间的访问流量;同时能互为冗余,当其中 一台服务器发生故障时,其余服务器能即时替代工作,保证系统访问的 不中断; 2.新系统应能管理不同应用的带宽,如优先保证某些重要应用的带宽要 求,同时限定某些不必要应用的带宽,合理高效地利用现有资源;

3.新系统应能对高层应用提供安全保证,在路由器和防火墙基础上提供了 更进一步的防线; 4.新系统应具备较强的扩展性。 o容量上:如数据访问量继续增大,可再添加新的服务器加入系统; o应用上:如当数据访问量增大到防火墙成为瓶颈时,防火墙的动态负载均衡方案,又如针对链路提出新要求时关于Internet访问 链路的动态负载均衡方案等。 三、解决方案 梭子鱼安全负载均衡方案总体设计 采用服务器负载均衡设备提供本地的服务器群负载均衡和容错,适用于处在同一个局域网上的服务器群。服务器负载均衡设备带给我们的最主要功能是:

当一台服务器配置到不同的服务器群(Farm)上,就能同时提供多个不同的应用。可以对于每个服务器群设定一个IP地址,或者利用服务器负载均衡设备的多TCP端口配置特性,配置超级服务器群(SuperFarm),统一提供各种应用服务。

MSSQL数据库高可用性方案

高可用MS SQL Server数据库解决方案 建设目标 减少硬件或软件故障造成的影响,保持业务连续性,从而将用户可以察觉到的停机时间减至最小,确保数据库服务7*24小时(RTO为99.9%)运转,建设一套完整的高可用性MS SQL Server数据库系统。 需求分析 服务器宕机造成的影响 服务器宕机时间使得丢失客户收益并降低员工生产效率,为了避免对业务造成影响,从两个方面采取预防措施: 一、计划宕机时的可用性: ●补丁或补丁包安装 ●软硬件升级 ●更改系统配置 ●数据库维护 ●应用程序升级 二、防止非计划性宕机: ●人为错误导致的失败 ●站点灾难 ●硬件故障

●数据损毁 ●软件故障 现有状况 ●服务器存在单点故障; ●数据库未做高可用性配置; ●数据库版本为MS SQL Server2008; ●服务器配置为CPU E7540 2.0,24G存; ●数据库容量约800G 技术解决方案 解决思路 考虑到本项目的需求和最佳性能,为了达到最佳可用性,方案采用两台数据库服务器做故障转移集群,连接同一台存储做数据库的共享存储,实现故障自动转移。同时,将旧服务器作为镜像数据库,采用SQL Server 2012的alwayson 功能来再次完成自动故障转移,并可以分担查询的负载。

架构拓扑 新数据库:承担数据库主体计算功能,用于生产数据,采用双机集群,实现自动故障转移。 旧数据库:通过镜像功能,存储数据库副本,用于发生故障时的转移。也可配置为只读,承担备份的负载。 存储:存储采用双控制器,双FC连接两台服务器,避免单点故障。 主/辅域控制器:采用双机模式,SQL Server 2012 实现高可用的必备基础设施。 高可靠性技术方案 SQL Server的企业版支持所有的高可用性功能,这些功能包括:

链路负载均衡解决方案

Array Networks 链路负载均衡解决方案 -Array APV系列、AppVelocity应用于企业网络优化

目录 1. 多链路接入背景介绍 (3) 1.1 单链路接入单点故障 (3) 1.2 运营商之间互访 (4) 1.3 双链路解决方案的产生以及其衍生的问题 (4) 2. Array 提供最佳的解决方案 (6) 2.1 方案介绍 (6) 2.2 流出(Outbound)流量处理 (7) 2.3 其它重要功能设置: (8) 2.4 流入(Inbound)流量处理 (8) 3. 解决方案功能特点介绍 (10) 3.1. 全面的链路监控能力 (10) 3.2. 全路经健康检查 (10) 3.3. 策略路由 (11) 3.4. APV-LLB的链路负载均衡解决方案具有以下功能和优点: (11) 3.5. 链路优化功能与其他应用性能提高功能 (11) 3.5.1. Http 压缩功能 (11) 3.5.2. Cache 功能 (11) 3.5.3. Connection Multiplexing(连接复用)技术 (12) 3.5.4. Connection Pooling(连接池)技术 (12) 3.5.5. Array SpeedStack?技术 (12) 3.6. 安全防护功能 (13) 3.7. Cluster技术 (13) 3.8. Array APV 配置管理 (14) 3.9. 可扩展性 (14) 3.9.1. 服务器负载均衡与广域网负载均衡 (14) 3.9.2. 扩展的SSL加速适用于电子商务 (14) 4. 链路负载均衡对企业的价值 (14)

A10服务器负载均衡解决方案解读

1SJ tit works ***** 单位 A10负载均衡解决方案 A10 Networks Inc. 1SJ tit works

目录 1.项目概述 (1) 2.需求分析及讨论 (1) 2.1应用系统所面临的共性问题 (1) 2.2需求分析 (2) 3.A10公司负载均衡解决方案 (3) 3.1网络结构图 (3) 3.2A10负载均衡解决方案 (3) 3.2.1APP Server负载均衡的实现 (4) 3.2.2应用优化的实现 (4) 3.3解决方案说明 (5) 3.4方案的优点 (6) 4.A10 AX的优点及各型号指标总结 (7) 5.A10公司简介 (7) 6.AX介绍 (8) 6.1 A10公司AX简介 (8) AX系列功能 (8)

1. 项目概述 2. 需求分析及讨论 2.1应用系统所面临的共性问题 随着用户量增大及业务的发展,一个应用系统往往会出现各种问题。瓶颈可能出现在服务器、存储、网络设备,带宽等的性能不足,而运行一旦出现故障给业务带来的影响范围是巨大的,服务器可能出现的问题表现为如下几点: ?高可用问题 关健性应用要求7*24稳定运行不被中断,高可用性问题被放在首要位置。 ?利用“不平衡”现象 数据的大集中使得服务器的访问压力日益增大,服务器性能往往会成为一个系统的瓶颈,随着性能问题的产生,单点故障的发生也将比较频繁,为了解决这些问题,传统的方式多为采取更换更好的服务器并且采用双机备份系统提供服务的方式,这样必然存在 一半的资源浪费的情况,而在压力不断上升的情况下,这种动作讲不断的重复,不但服务器的利用率不平衡,而且持续引起投资的浪费。 ?“峰值”问题 服务器的处理多存在“波峰”和“波谷”的变化。而且“波峰”时,业务量大小的变化又不规律,这就使服务器不得不面对“峰值堵塞”问题。原有解决方法为增加服务器或主机数量,提高处理能力。但仍存在性能不平衡问题,且这样做,投资成本大。 ?多米诺”现象 单台服务器的设置,不可避免会出现“单点故障”,需要进行服务器“容错”。为实现容错,往往在主服务器旁安置一台或多台备份服务器。但这样做,平时只有一台服务器工作,其它服务器处于空闲状态,无法完全利用所有服务器的处理资源,当出现“峰值堵塞”时,“多米 诺”效应往往会发生,即所有服务器连续被“堵”至“死”。最终的结果将导致系统的瘫痪。 ?“扩展”不便 随着物理和应用的集中,服务器上所要处理的数据量(traffic )增大,客户交易产生

(完整版)F5服务器负载均衡解决方案要点

F5服务器负载均衡解决方案 目录 一.大量数据处理所面临的问题 (2) 1.目前存在隐患 (3) 2.应用系统问题综述 (3) 1)“峰值”问题 (4) 2)多米诺”现象 (4) 3)“N+1”方式 (4) 4)“扩展”不便 (5) 5)“免疫力”差 (5) 6)“容灾”.................................................................................... 错误!未定义书签。 7)应用与网络脱节 (6) 二.F5解决方案 (6) 2.1 网络结构 (6) 2.2 方案优势 (7) 2.2.1避免“不平衡”现象 (7) 2.2.2解决因“峰值堵塞”带来的性能调整“不平衡” (9) 2.2.3避免“多米诺”现象 (9) 2.2.4更好的提供系统容错,提高系统可靠性 (10) 2.2.5“扩展”灵活 (11) 2.2.6“免疫力”强 (12) 2.2.7“容灾” (13) 2.2.8网络感知应用,应用控制网络 (14) 三.相关技术资料 (17) BIG-IP提供支持99.999%的正常运行 (17) 四.成功案例 (19) F5为中国某税务机关提供高可用性解决方案 (19)

一.大量数据处理所面临的问题 在现今的企业中,不论是否提供关键性任务的服务,都需要一个持续运行不断的高可用性网络计算环境以维持不间断的高品质服务。所谓高可用性的环境,也是信息管理人员所必须考虑的四件事: 1.使数据有一个安全的存储和运作方式,即使在设备故障时仍能保持数据的完整 一致。 2.使服务器系统持续运行,即使发生故障仍然让服务持续下去。 3.使整个计算环境能更好的管理,如何容错、容灾、集群共享。 4.如何使投资有最好的效益,使系统有最佳的扩充能力,有最低的整体拥有成本, 也就是在任何情况之下均能确保数据的完整一致,系统持续运行,使服务不间 断,同时有最好的投资回报率。 高可用性被定义为计算系统的连续运行。根据故障停机的业务影响,应用系统需要不同的可用性水平。要想实现一个应用系统的高可用性,所有组件(包括应用和数据库服务器、存储设备以及端到端网络)都需要提供连续的服务。 企业和机构对网络化应用及Internet 的日益依赖,加上语音和数据的集成,创造了对高可用性应用的增加需求。任何类型的系统故障停机都可能意味着收入、信誉和客户满意的巨大损失。 高度网络可用性的利用,企业实施高可用性网络来: ?防止财务损失 ?防止生产力损失 ?改进用户满意度 ?改进客户满意/信任 ?降低反应性IT支持成本,提高IT生产力 ?部署关键任务应用支持新业务实践的好处 ?典型的业务要求 为了实现高度的网络可用性,需要部署下列组件:

人口基础数据库建设方案【智慧城市应用】

智慧城市应用之人口基础数据库 转型期的中国是人口发展的关键时期,经济发展和社会建设面临的重大问题无不与人口密切相关,人口问题的聚集与凸显是当前政府面临的重要问题。如何运用信息化的手段进行人口数据的科学有效管理,建立人口基础数据库(简称“人口库”),从而切实提高社会管理与民生服务水平就显得相当重要和紧迫。 人口库建设的意义和重要性 人口基础信息是国家重要的基础信息之一,现行人口管理模式和信息应用模式是一种“条块分割”式的管理,各个相关部门只是从本部门的角度出发对人口 信息进行管理,相互间不能很好地协调起来。随着市场经济体制的建立和完善, 这种“条块分割”式的、孤立的人口信息管理和应用模式的弊病已显端倪:一方面是造成了许多不必要的重复劳动,另一方面各部门间信息不能共享,不能更好地服务百姓。 1、建立人口基础数据库平台是有效实施人口战略的重要依据,是提高政府 决策科学化的支撑。 人口信息是社会的基础信息,是政府进行科学决策和公共行政管理的重要依据。长期以来,我国人口管理建立在户籍制度基础上,随着社会主义市场经济体制改革的深入发展,人口流动性越来越大,旧的管理模式已经不适应社会的发展需要。公安局、劳保局、建交委、社发局、工商局等部门都在实施对部分人口的 专门管理,其要求是对实际居住地人口的管理,取得一定成效。由于各部门对人口管理和发展存在差异,统计口径也不一致,造成人口管理、统计的基础和基数始终不能统一,致使不能得到准确的人口及其分布状况信息。因此,迫切需要建立一个以公安人口信息为基础,以公民身份号码(境外人口为护照号)为唯一代码,以其他部门为补充和核准的,具有权威性、基础性和战略性的人口基础数据

负载均衡软件实现与硬件实现方案

该文档是word2003—word2007兼容版 软件、硬件负载均衡部署方案 目录 1、硬件负载均衡之F5部署方案 (2) 1.1网络拓扑结构 (2) 1.2反向代理部署方式 (3) 2软件负载均衡方案 (4) 2.1负载均衡软件实现方式之一- URL重定向方式 (4) 2.2负载均衡软件实现方式之二- 基于DNS (5) 2.3负载均衡软件实现方式之三- LVS (8) 2.4负载均衡软件实现方式之四- 专业负载均衡软件 (16) 总结: (16)

1、硬件负载均衡之F5部署方案 对于所有的对外服务的服务器,均可以在BIG-IP上配置Virtual Server实现负载均衡,同时BIG-IP可持续检查服务器的健康状态,一旦发现故障服务器,则将其从负载均衡组中摘除。 BIG-IP利用虚拟IP地址(VIP由IP地址和TCP/UDP应用的端口组成,它是一个地址)来为用户的一个或多个目标服务器(称为节点:目标服务器的IP地址和TCP/UDP应用的端口组成,它可以是internet的私网地址)提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。根据服务类型不同分别定义服务器群组,可以根据不同服务端口将流量导向到相应的服务器。BIG-IP连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG-IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。如果能够充分利用所有的服务器资源,将所有流量均衡的分配到各个服务器,我们就可以有效地避免“不平衡”现象的发生。 利用UIE+iRules可以将TCP/UDP数据包打开,并搜索其中的特征数据,之后根据搜索到的特征数据作相应的规则处理。因此可以根据用户访问内容的不同将流量导向到相应的服务器,例如:根据用户访问请求的URL将流量导向到相应的服务器。 1.1网络拓扑结构 网络拓扑结构如图所示:

数据库架构规划方案

数据库架构规划方案

架构的演变 架构演变一定是根据当时要求的场景、压力下性能的需要、安全性、连续性的要求、技术的发展..... 我把架构的发展分为大概4个阶段: 1.单机模式 IT建设初期,高速建设阶段,大家要做的只有一件事,我需要什么构建什么,我需要ERP我买软件,需要HIS买HIS,这个时期按需构建大量的系统基本在这个时期产生,当然那个时候也没什么高可用的要求。 2.双机热备和镜像 基本是20年前的技术了,在高速构建后,一堆的系统运行中,用户发现我们的核心业务如果坏掉业务受影响,停机几个小时做恢复这是无法接受的,那么双机热备或镜像,Active-Standby的模式出现,这样一台机器工作,一台备用坏了在短时间可以接管业务,造成的损失会低很多!

那么问题也很明显,备机资源浪费,依赖存储,数据还是单点,成本较高。产品也很多:RoseHA/RoseMirrorHA、NEC ExpressCluster、微软MSCS、Symantec VCS、Legato、RHCS 太多太多了。 随后为了解决数据单点的问题有出现了存储的主备,存储的双活这厂商也太多了,这里就不介绍了 基本上传统企业依然停留在第一和第二阶段,也就是要么单机,要么双机热备 3.节点多活

随着业务量越来越大,数据量不断飚升,系统高效性的矛盾显现出来,系统卡慢、报表、接口业务无法分离OLAP OLTP业务混合导致系统锁情况严重,资源消耗极其庞大,光靠升级硬件已经无法满足要求,横向扩展已经成为大势所趋。 同时切换时间、备机无法启动的问题也困扰着用户。 那么节点多活,多台机器同时对外提供访问的技术登上舞台,代表的ORACLE RAC、微软ALWAYSON 、MOEBIUS集群 多活的两种模式也是从第二带架构的演变 oracle rac 把双机热备的辅助节点变的可以访问,关键点数据在多节点内存中的调配 Microsoft awo、Moebius 则是把镜像的辅助节点变的可以访问,关键点数据多节点同步 这样横向扩展来分担压力,并且可以在业务上进行分离。 4.分布式架构 分布式架构真的不知道从何说起,概念太大,每个人理解的都不一样,只能意会不能言传: 比如说一份数据分开存成多份

软件负载均衡优缺点总结

(总结)Nginx/LVS/HAProxy负载均衡软件的优缺点详解 PS:Nginx/LVS/HAProxy是目前使用最广泛的三种负载均衡软件,本人都在多个项目中实施过,参考了一些资料,结合自己的一些使用经验,总结一下。 一般对负载均衡的使用是随着网站规模的提升根据不同的阶段来使用不同的技术。具体的应用需求还得具体分析,如果是中小型的Web应用,比如日PV小于1000万,用Nginx就完全可以了;如果机器不少,可以用DNS轮询,LVS所耗费的机器还是比较多的;大型网站或重要的服务,且服务器比较多时,可以考虑用LVS。一种是通过硬件来进行进行,常见的硬件有比较昂贵的F5和Array等商用的负载均衡器,它的优点就是有专业的维护团队来对这些服务进行维护、缺点就是花销太大,所以对于规模较小的网络服务来说暂时还没有需要使用;另外一种就是类似于Nginx/LVS/HAProxy的基于Linux的开源免费的负载均衡软件,这些都是通过软件级别来实现,所以费用非常低廉。 目前关于网站架构一般比较合理流行的架构方案:Web前端采用 Nginx/HAProxy+Keepalived作负载均衡器;后端采用MySQL数据库一主多从和读写分离,采用LVS+Keepalived的架构。当然要根据项目具体需求制定方案。 下面说说各自的特点和适用场合。 Nginx的优点是: 1、工作在网络的7层之上,可以针对http应用做一些分流的策略,比如针对域名、目录结构,它的正则规则比HAProxy更为强大和灵活,这也是它目前广泛流行的主要原因之一,Nginx单凭这点可利用的场合就远多于LVS了。 2、Nginx对网络稳定性的依赖非常小,理论上能ping通就就能进行负载功能,这个也是它的优势之一;相反LVS对网络稳定性依赖比较大,这点本人深有体会; 3、Nginx安装和配置比较简单,测试起来比较方便,它基本能把错误用日志打印出来。LVS的配置、测试就要花比较长的时间了,LVS对网络依赖比较大。 3、可以承担高负载压力且稳定,在硬件不差的情况下一般能支撑几万次的并发量,负载度比LVS相对小些。 4、Nginx可以通过端口检测到服务器内部的故障,比如根据服务器处理网页返回的状态码、超时等等,并且会把返回错误的请求重新提交到另一个节点,不过其中缺点就是不支持url来检测。比如用户正在上传一个文件,而处理该上传的节点刚好在上传过程中出现故障,Nginx会把上传切到另一台服务器重新处理,而LVS就直接断掉了,如果是上传一个很大的文件或者很重要的文件的话,用户可能会因此而不满。 5、Nginx不仅仅是一款优秀的负载均衡器/反向代理软件,它同时也是功能强大的Web应用服务器。LNMP也是近几年非常流行的web架构,在高流量的环境中稳定性也很好。 6、Nginx现在作为Web反向加速缓存越来越成熟了,速度比传统的Squid服务器

F5多出口链路负载均衡解决方案

F5 Networks 多出口链路负载均衡解决方案建议

目录 一.多出口链路负载均衡需求分析 (3) 二.多出口链路负载均衡解决方案概述 (4) 2.1多出口链路负载均衡网络拓朴设计 (4) 2.2方案描述 (5) 2.3方案优点 (7) 2.3.1 拓扑结构方面 (7) 2.3.2安全机制方面 (7) 三.技术实现 (8) 3.1F5多出口链路负载均衡(产品选型:B IGIP LC) (8) 3.2O UTBOUND流量负载均衡实现原理 (10) 3.3I NBOUND流量负载均衡实现原理 (11) 3.4在链路负载均衡环境中的DNS设计和域名解析方式 (13) 3.4.1 Root DNS(注册DNS)直接与F5多链路负载均衡器配合 (13) 3.4.2 Root DNS(注册DNS)通过第三方DNS Server与F5多链路负载均衡器配合(我们 建议这种方式) (14) 3.5F5设备双机冗余----毫秒级切换原理 (16) 3.6S TATEFUL F AIL O VER 技术(与F5设备双机冗余有关) (17) 四.产品介绍 (18) 4.1F5B IGIP (18)

一.多出口链路负载均衡需求分析 为了保证XXXX出口链路的高可用性和访问效率,计划拥有两条线路:一条中国网通链路,一条中国电信链路。F5公司的多链路负载均衡设备(Bigip)能够提供独具特色的解决方案,不但能够充分利用这两条链路(双向流量按照预设的算法分担到不同的链路上,一旦一条链路不通的情况下,能够无缝切换到另外一条可用链路上);而且可以根据对不同链路的侦测结果,将最快速的链路提供给外部用户进行响应,从而解决目前广泛存在的多个ISP之间的互联互通问题。具体解决方案特色如下: ?提供网至internet流量的负载均衡(Outbound) ?实现从Internet对服务器访问流量的负载均衡(Inbound) ?支持自动检测和屏蔽故障Internet链路 ?支持多种静态和动态算法智能均衡多个ISP链路的流量 ?支持多出口链路动态冗余,流量比率和切换 ?支持多种DNS解析和规划方式,适合各种用户网络环境 ?支持Layer2-7交换和流量管理控制功能 ?完全支持各种应用服务器负载均衡,防火墙负载均衡 ?多层安全增强防护,抵挡黑客攻击 ?业界领先的双机冗余切换机制,能够做到毫秒级切换 ?详细的链路监控报表,提供给网络管理员直观详细的图形界面 ?对于用户完全透明 ?对所有应用无缝支持

数据库系统建设方案

数据库系统建设方案

校园一卡通项目数据库安全系统 建设方案书 一、系统现状概述 校园一卡通在学校内也称为校园卡系统,是数字校园的有机组成部分,校园一卡通工程是数字校园的标志性工程和前导性工程。校园卡是将广大师生员工与数字校园有机连接在一起的最有效的媒介,实现了“一卡在手,走遍校园”,校园卡是校园数字化的重要形象和重要标志之一。

校园一卡通系统是架构在校园网上,以感应式射频IC卡为媒介,综合提供身份识别与电子支付服务功能的系统平台,以及其架构在此平台上的各种信息化应用系统。 核心系统都运行在Oracle数据库之上,为整个系统提供稳定性基础。Oracle数据库系统是一个较为复杂的数据库,作为校园一卡通的基础数据存储和运行平台,存储着核心数据资料和基本业务逻辑,其稳定性与否直接关系着校园一卡通的对外服务能力。 以下通过介绍数据各种主流数据保护和恢复的技术,根据业务系统的用户规模大小和用户的数据库维护能力以及项目投入成本,提出我们的建议解决方案。 1.1 双机热备系统特点与优势 双机热备包括广义与狭义两种。 从广义上讲,就是服务器高可用应用的另一种说法,英译为:high available,而我们通常所说的热备是根据意译而来,同属于高可用范畴,而双机热备只限定了高可用中的两台服务器。热备软件是用来解决一种不可避免的计划和非计划系统宕机问题的软件解决方案,当然也有硬件的。是构筑高可有集群系统的基础软件,对于任何导致系统宕机或服务中断的故障,都会触发软件流程来进行错误判定、故障隔离、以及通地联机恢复来继续执行被中断的服务。在这个过程中,用户只需要经受一定程度可接受的时延,而能够在最短的时间内恢复服务。

负载均衡软件实现方式

负载均衡软件实现方式之一- URL重定向方式 有一种用软件实现负载均衡的方式,是基于"URL重定向"的. 先看看什么是URL重定向: "简单的说,如果一个网站有正规的URL和别名URL,对别名URL进行重定向到正规URL,访问同一个网址,或者网站改换成了新的域名则把旧的域名重定向到新的域名,都叫URL 重定向" (https://www.360docs.net/doc/ee8746096.html,/service/host_faq.php) "很多网络协议都支持“重定向”功能,例如在HTTP协议中支持Location指令,接收到这个指令的浏览器将自动重定向到Location指明的另一个URL上。" (https://www.360docs.net/doc/ee8746096.html,/art/200604/25388.htm) 这种方式,对于简单的网站,如果网站是自己开发的,也在一定程度上可行.但是它存在着较多的问题: 1、“例如一台服务器如何能保证它重定向过的服务器是比较空闲的,并且不会再次发送Location指令,Location指令和浏览器都没有这方面的支持能力,这样很容易在浏览器上形成一种死循环。” 2、在哪里放LOCATION,也是一个问题。很有可能用户会访问系统的很多个不同URL,这个时候做起来会非常麻烦。并且,对URL的访问,有的时候是直接过来的,可以被重定向,有的时候是带着SESSION之类的,重定向就可能会出问题。并且,这种做法,将负载均衡这个系统级的问题放到了应用层,结果可能是麻烦多多。 3、这种方式一般只适用于HTTP方式,但是实际上有太多情况不仅仅是HTTP方式了,特别是用户如果在应用里面插一点流媒体之类的。 4、重定向的方式,效率远低于IP隧道。 5、这种方式,有的时候会伴以对服务器状态的检测,但往往也是在应用层面实现,从而实时性大打折扣。 实际上,这种方式是一种“对付”的解决方法,并不能真正用于企业级的负载均衡应用(这里企业级是指稍微复杂一点的应用系统) 可以看一下专业的负载均衡软件是如何来实现的: https://www.360docs.net/doc/ee8746096.html,/pcl/pcl_sis_theory.htm 对比一下可以发现,专业的负载均衡软件要更适用于正规应用,而重定向方式则比较适用于