基于Hadoop的搜索引擎用户行为分析

CN43 1258/T P ISSN1007 130X 计算机工程与科学

CO M PU T ER ENG IN EERI NG&SCIENCE

2011年第33卷第4期

V ol 33,No 4,2011

文章编号:1007 130X(2011)04 0115 06

基于H adoop的搜索引擎用户行为分析*

An A nalysis of the Search Engine U ser

Behaviors Based on H adoop

王振宇1,郭 力2

WANG Zhen yu1,GUO Li2

(1.华南理工大学软件学院,广东广州510006;2.华南理工大学计算机科学与工程学院,广东广州510006)

(1.S chool of Softw are Engineering,S outh C hina U niversity of T echnology,Guangzhou510006;

(2.School of C omputer Science and Enginee ring,S outh China Univer sity of T echnology,Guangzhou510006,C hina)

摘 要:搜索引擎用户行为分析是网络信息检索技术的研究热点。通过分析用户点击行为,利用Web数据挖掘技术获取有用信息,提高搜索引擎的检索算法和检索服务的效率,把用户从大量无序的搜索结果中解放出来。本文针对传统并行计算模型在易扩展和易编程方面遇到的瓶颈,给出一种基于H a do op的海量日志数据处理模型,通过基于H adoop的分布式文件系统H DFS与MapReduce并行计算模型提高系统扩展性和易编程性,并应用该模型分析了So gou搜索引擎一个月内约2200万条查询日志,分析结果对于掌握用户搜索行为,评测及改进搜索引擎检索、排序算法等均有较好的指导意义。

Abstract:Sear ch engine user behaviors analy sis is a focus of netw o rk inform ation retrieval.It is a m ethod of analyzing the user s behaviors throug h clicks to mine useful info rmation to improv e search en gine s efficiency and r etrieval ser vices.In face of easy ex pansio n and progr am ming bottlenecks in tradi tional parallel co mputatio n m odels,a m assive log data processing m odel based on H ado op is given, w hich improv es scalability and easy pro gramm ing through H adoop Distr ibuted File Sy stem and MapRe duce.Mo reo ver,the exper im ent of analy zing22million query logs of the Sogo u search engine in one m onth is car ried out based on this model.T he analysis result is instructive and m eaning ful to mastering the user s behaviors,evaluating and improving the searching and sorting alg orithm s.

关键词:H adoo p;分布式计算;用户行为分析;海量数据

Key w ords:H ado op;distributed com puting;user behavior analysis;m assiv e data

doi:10.3969/j.issn.1007 130X.2011.04.022

中图分类号:TP391.3文献标识码:A

1 引言

随着Web2.0的发展,网络信息膨胀速度呈指数级增长。在此背景下,搜索引擎技术迅猛发展并成为人们获取信息的重要手段。用户在提交查询后的检索结果中只有小部分对用户有用,如对结果不作处理,用户将面对大量无用信息,因此结果排序尤为重要。

目前的排序技术主要基于两方面。首先,利用

115

*收稿日期:2010 03 28;修订日期:2010 07 15

基金项目:广东省科技计划资助项目(2007B01020049)

通讯地址:510006广东省广州市华南理工大学软件学院

Address:School of Softw are En gineering,South Chin a University of Techn ology,Guangzh ou,Gu angdong510006,P.R.Chin a

网页间链接关系进行链接分析、量化网页信息。其中美国Stanford大学的Goog le研究小组和IBM 公司的Clever系统开发小组分别提出了著名的Pag eRank[1]技术和H IT S[2,3]技术;其次,在Web 查询模式下产生了新的可用信息,即对用户反馈信息的研究。其中Dir ect H it[4]系统通过跟踪用户对检索结果的后继行为获取大量有用信息来提高检索质量,由用户决定网页的重要度,因为用户既是搜索引擎的直接使用者,也是服务质量的最终评判者。

一般大型搜索引擎日访问量可达数亿,记录的用户查询日志文件通常是海量文件。通常对海量文件处理是建立在并行计算环境下的多线程、多任务分解,编程难度较高且不易扩展。本文提出基于H ado op的搜索引擎用户行为分析,采用分布式文件系统和并行计算模型支撑海量日志文件的处理。

2 Hadoop整体架构

H ado op是Apache软件基金会的开源分布式计算框架,且在众多大型企业得到应用[5]。H a do op实现了M apReduce并行编程模型,提供了分布式文件系统H DFS(H adoop Distributed File System,简称H DFS),为分布式计算提供底层存储支持。H ado op具有以下优势:

(1)可扩展性:可靠存储和处理petaby tes级别数据,并能无限扩充存储和计算能力。

(2)经济性:将数据分布到由廉价PC机组成的集群(Cluster)中处理,每个集群可由成千上万个节点(Node)组成。

(3)高效性:通过数据、任务分发,H adoop可在多节点上并行处理。

(4)可靠性:维护一份数据的多个拷贝并自动将失败的计算任务重新部署。

(5)易用性:H adoop的并行处理、容错机制、本地优化和负载平衡对用户透明。

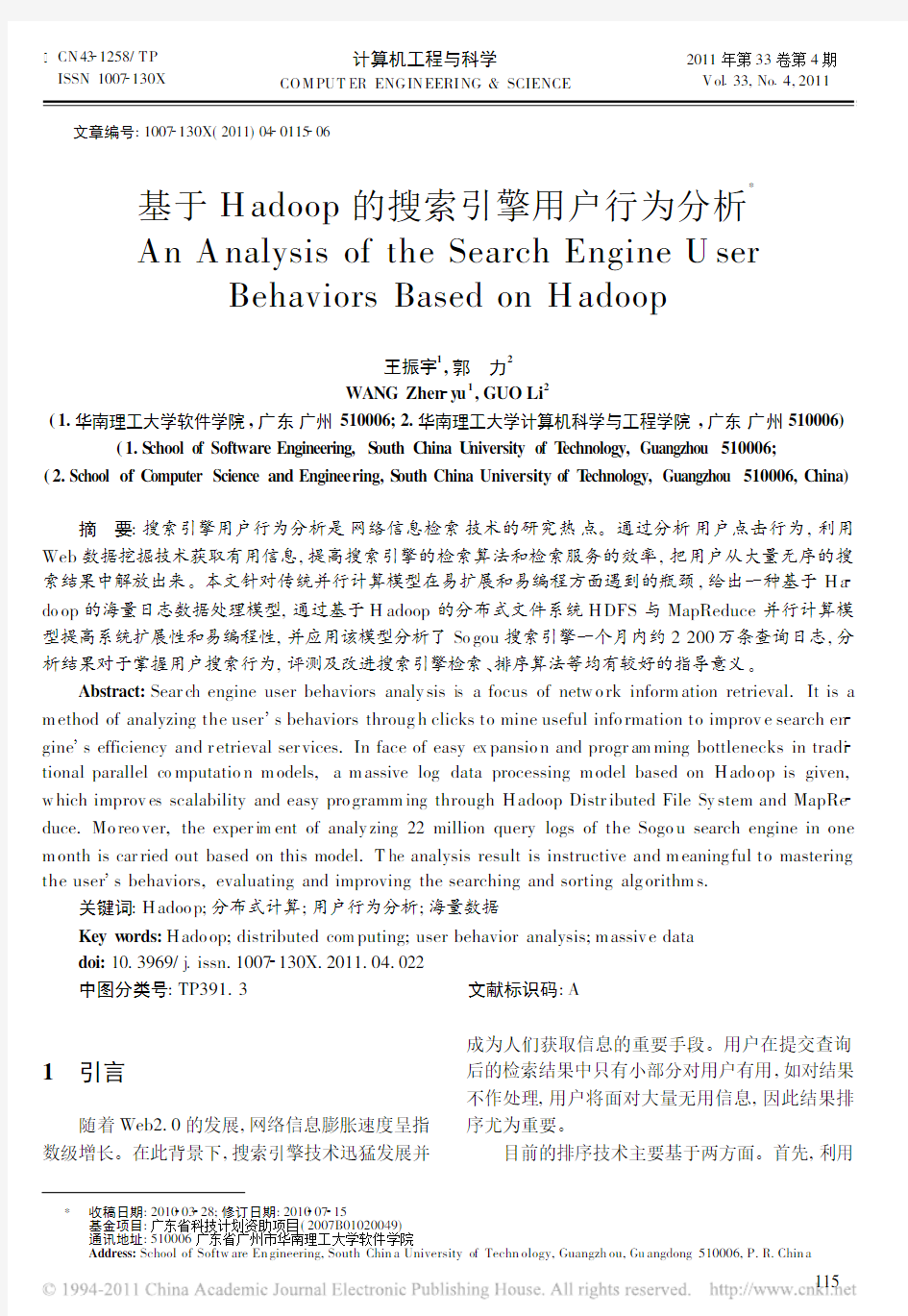

2.1 Hadoop分布式文件系统

H DFS采用M aster/Slave架构,由一个管理节点(Nam eNode)和N个数据节点(DataNode)组成[6]。使用上同单机文件系统类似,并提供了统一的应用程序编程接口(API),其底层实现是把文件切割成Block块并分散存储于不同DataNo de上,每个Blo ck还会复制数份(可配置)到不同DataN ode上,达到容错容灾目的。Nam eNode是整个H DFS的核心,通过维护一些数据结构来记录每个文件切割情况及Block存储位置等重要信息,系统架构如图1所示。

H DFS具有高容错性,硬件错误是正常而非异常事件,而且H DFS很适合大数据集的应用,在H DFS中一个典型的文件大小是GB甚至TB级别。由于H DFS应用程序适合 一次写,多次读 的文件访问模型,文件一旦被创建、写入、关闭后就不应再被修改,因此简化了数据一致性问题而保证

了高吞吐量的数据访问。

图1 H adoo p分布式文件系统架构

2.2 MapReduce并行编程模型

M apReduce是Goog le提出[7]的并行编程模型,支持海量数据集的并行计算且应用领域广泛,包括分布式grep、分布式排序、Web访问日志分析、反向索引构建、文档聚类、机器学习等。

M apReduce并行编程模型的数据流以键值对(Key/Value Pairs)方式提供,首先处理输入键值对并产生输出键值对,此输出键值对又可作为下次运算的输入。用户通过两个函数实现并行计算: M ap函数和Reduce函数。

M ap函数由用户定义。首先处理输入键值对并产生一组中间(Intermediate)键值对;MapRe duce底层自动合并(Combine)所有具有相同键值I的中间键值对并发送给Reduce函数。

Reduce函数同样由用户定义,它处理键值I 以及与之相关的值集合。提供给Reduce函数的中间值通过迭代器(Iter ator)给出,因此可用来处理超过内存容量的值列表。

H adoop中有一个称为主控节点的JobTr ack er,用于调度和管理其它计算节点(T askTr ack er)[8]。JobT racker可运行于集群中任一台计算机上,T askTracker负责执行任务且必须运行于Da taNode上,便于本地优化。JobT racker将M ap任务和Reduce任务分发给空闲的T askTracker并行执行并监控任务运行情况。如果某个T askTr ack er宕机,JobTracker将该机的任务转交给另一个空闲的TaskT racker重新运行,因此H adoop可构

116

建高可靠的分布式计算框架。图2 M ap/Reduce 数据去重处理流程

3 基于Hadoop 的海量日志数据处

理模型设计

3.1 实验环境

我们使用5台PC 机搭建基于H ado op 的分布式计算平台,命名为pc1~pc5,其中pc1作Nam e Node 同时也作Jo bT racker,pc2~pc5作DataN ode 和TaskT racker 。每台PC 机具体配置如下:硬件环境:Intel(R)Pentium (R )4CPU 3.00GH z 2;1GB 内存;80G 硬盘;100M bps 网口。

软件环境:Linux Fedora 10;JDK1.6.0_0;H ado op 0.19.1。3.2 系统设计与实现3.2.1 数据集及数据格式

实验使用的搜索引擎用户行为日志由搜狗实验室[9]提供,一个月内(2006/8/1~2006/8/31)约2200万条Sog ou 搜索引擎查询及用户点击日志集(约1.56GB)。其中每条查询记录格式见表1。

表1 查询记录日志格式

字段名称 说明 S ess ionID 用户C ookie 信息Qu ery Term 查询词

Ran k

被点击U RL 的排名S equence Num ber 用户点击的顺序号U RL

用户点击的U RL

例如,某记录为 6029750673720081[四级成绩]https://www.360docs.net/doc/f45004486.html,/ ,则对应SessionID 为 6029750673720081 ,查询词为 四级成绩 ,用户点击的URL 为 https://www.360docs.net/doc/f45004486.html,/ ,该URL 在结果中排名为1,用户点击该U RL 为第1次点击。应用基于H ado op 的分布式计算框架对海量日志进行用户行为分析,统计出用户查询词的平均长度、用户点击与排名的关系、热门词汇搜索等,为搜索引擎性能评价及算法改进提供数据支持。下

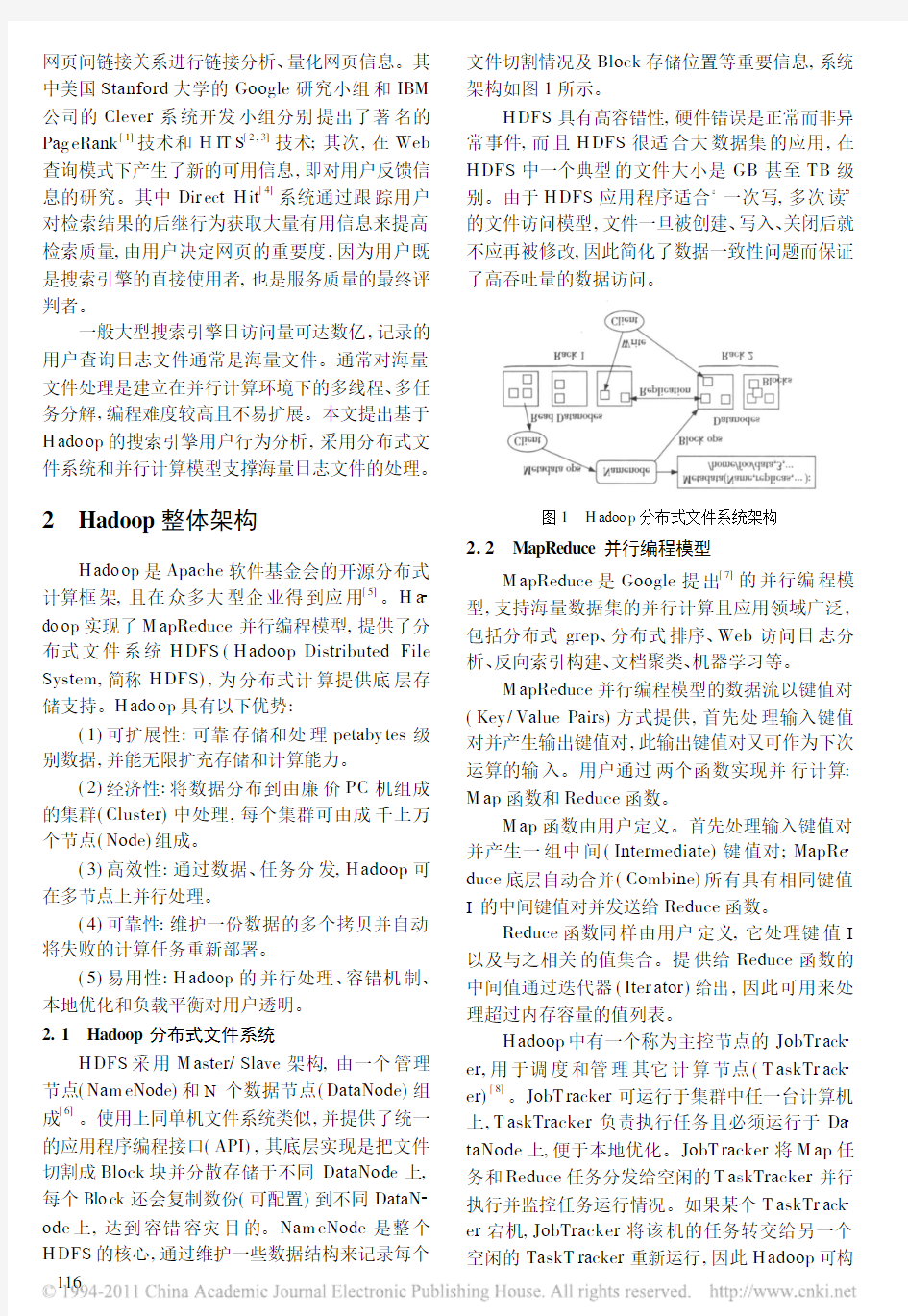

面重点讨论数据去重和热榜分析算法实现。3.2.2 数据去重

Sog ou 数据集中含有大量重复记录,比如:8510431220399626 [北京+天气]11w https://www.360docs.net/doc/f45004486.html,/detail.php?city =%B1%B1%BE%A9

8510431220399626 [北京+天气]32w w w.bjmb.go https://www.360docs.net/doc/f45004486.html,/qxx x /index.asp

以上2条记录表示用户连续点击了结果集的2条链接,但在统计分析时只能看作一次查询,需去除重复数据。采用M apReduce 并行计算模型的数据去重流程如图2所示。

步骤如下:

(1)首先上传初始日志文件到H DFS,默认将逐行读取日志文件块(默认大小为64M B)并将行号及该行内容映射为初始键值对输入,M ap 函数将对值部分进行处理并提取session 值和查询词,形成中间键值对。

(2)自动合并具有相同键值的键值对,与之对应的多个值被封装在迭代器中,合并后的结果作为Reduce 操作的输入键值对。

(3)在Reduce 函数中,只需将重复查询词过滤便完成数据去重处理。如需对数据进一步处理,可将Reduce 函数的输出键值对作为下个操作的初始输入数据。

算法1 数据去重

map(St ring lineN o,St ring lineContent){

//lineN o:行号;lineContent:行内容

Str ing splitStr[]=lineCo ntent.split();/*拆分字符串*/

//字符串操作,提取session 值和查询词 co llect(sessio nI d,term);//收集数据并送至r educe }

r educe(Str ing sessionId,Iterat or ter ms){

//sessionId:session 值;ter ms:查询词迭代器 fo r each term in ter ms

117

{

//查询词判重 }

collect(sessio nId,newT erms);//收集数据并输出}

3.2.3 数据分析

采用MapReduce 编程模型,可实现多角度数据分析与挖掘,包括热榜分析、用户点击与排名关系分析等。

热榜分析是统计每个查询词的访问量并按访问量排序。传统技术在存储和计算上存在瓶颈,难以进行大规模数据集统计。利用H adoop 分布式计算框架,可根据数据集的大小实现存储及运算能力的灵活扩展,按需部署。热榜分析数据处理流程如图3所示。

图3 M ap/Reduce 热榜分析处理流程

数据去重的输出文件作为热榜分析的初始输入数据,在M ap 函数中提取出每个查询词并赋访问量为1而形成中间键值对,经合并后传递给Re duce 函数。在Reduce 函数中,通过遍历迭代器便得出每个查询词的访问量,然后再做一次M ap 操作实现按访问量的排序。

算法2 热榜分析

map(Str ing lineNo ,Str ing lineCo ntent){

//lineNo :行号;lineContent:行内容

Str ing split St r[]=lineContent.split();/*拆分字符串*/

//字符串操作,提取出查询词集合ter ms fo r each t erm in terms {

collect(term,1);//收集数据并送至r educe }}

r educe(String term,Iterato r v alues)

{

//ter m:查询词;values:访问量迭代器 int co unt=0;//访问量计数器 fo r each value in va lues {

co unt+=va lue;//统计访问量 }

co llect(term,count);//收集数据并输出}

4 结果及分析

4.1 查询词长度分析

查询词长度指查询词所包含词的个数(用空格隔开)。经统计,在给定数据集下中文查询词的平均长度为1.78个词,比Silverstein C 等人[10]分析的英文查询词平均长度为2.35个词要短。这表明中文搜索引擎得到的用户需求信息量更少,面对的挑战更大。需要对用户查询词进行更加深入的研究分析,包括语义分析、行为分析、智能人机交互技术分析等,以提高网络信息检索的准确度和用户满意度。4.2 热榜分析

访问量前100的访问次数分布如图4所示。通过对Sogo u 数据集分析,访问量排名前100的访问量占总访问量的65.32%,说明搜索引擎每天处理的查询请求有很多是重复请求。可从两方面对搜索引擎进行优化,首先可对频发访问词的检索结果排序进行优化,提高搜索引擎检索质量;其次可以引入缓存(Cache)机制。4.3 用户点击与排名关系分析

U RL 排名与用户点击次数的关系反映了搜索

118

图4 热榜分析

引擎结果排序算法的优劣,其中对Sogo u 数据集统计分析结果如图5所示。可以看出,用户点击的U RL 集中在返回结果的前10个,即返回结果页面的首页。统计得出用户点击排名前10的U RL 占所有点击量的86.67%,比美国搜索引擎营销专业服务商iProspect 和市场研究公司Jupiter Re search 联合调查显示的结果62%[11]

要高,说明中文搜索引擎的使用者更倾向只点击结果集的首页。另外,T REC 11[12]提出的Web 检索评测及针对中文信息检索的评测

[13~16]

等都将答案所处位置作为

评价搜索引擎性能的一个定量指标,搜索引擎结果排序算法须尽可能将反映用户查询需求的结果放

在首页。

图5 U RL 的排名与用户点击次数关系图

4.4 分布式计算平台效率分析

基于H adoop 的分布式计算平台提供了三种启动模式

[17]

,分别称为单机模式(Standalone

M ode)、伪分布式模式(Pseudo Distributed M ode)

和完全分布式模式(Fully Distr ibuted M ode)。其中单机模式又称为本地模式,属于非分布式计算模型;完全分布式模式简称分布式模式。4.4.1 伪分布式与分布式

伪分布式是指在同一节点启动5个[17]

守护进程(Daemon Process)模拟的分布式计算环境。我们分别在伪分布式和分布式计算环境下针对数据去重进行实验,并将结果绘成图6。

如图6所示,分布式计算平台相比伪分布式计算平台在执行效率上有明显优势。经计算:

在相同

图6 伪分布式与分布式平台执行效率对比

数据集下,分布式计算环境下的平均执行时间只有伪分布式的1/3;而且,随着待处理数据集增加,伪分布式计算平台效率逐渐降低(图中表现为斜率变大),特别当数据集过大(超过1G)时尤为明显。基于H adoop 的分布式计算平台具有良好的扩展性,理论上可无限扩充数据存储和计算能力,因此特别适合海量数据的处理。4.4.2 Reduce 任务数分析

在分布式计算环境下,影响执行效率的除机器配置、网络通信环境等硬件设施外,M ap 和Reduce 任务数,即任务颗粒度也会对效率产生影响。用户通常会指定Reduce 任务值,因为每个Reduce 任务最终对应着一个独立的输出文件[7]

。为了分析Reduce 任务数对计算效率的影响,实验中我们设定M ap 任务数为4,然后将Reduce 任务数分别设为4(表示为Reduce/4)和16(表示为Reduce/16)时的执行情况绘成图7

。

图7 不同R educe 任务数时执行图

如图7所示,当数据集较小时,由于节点间的频繁通信及文件I/O 占用了较多执行时间,Re duce/4比Reduce/16的执行速度要快;而随着数据集的增大,Reduce/16的优势也逐渐体现出来,排除网络偶然性影响,在应用H adoop 进行海量数据处理时,随着数据量、处理复杂度及集群中机器

数量的增加,H ado op 优势将越来越明显。

5 结束语

搜索引擎用户行为分析通过分析用户查询日志并利用Web 数据挖掘技术提高获取信息的准确

119

性,帮助改进站点结构,为用户提供个性化服务并对用户搜索结果进行相关处理,实现查全率和查准率的有机结合。

本文设计并实现了基于H ado op的海量日志数据处理模型,将该模型成功应用于搜索引擎海量日志文件处理。通过对用户查询日志的处理和结果分析,表明把H adoo p分布式计算框架运用于搜索引擎的海量日志数据处理中,可有效解决传统并行计算模型在易扩展和易编程上的瓶颈,分析结果对于改进搜索引擎排序、检索算法等均有较好的指导意义。

参考文献:

[1] Page L,Brin S,M otw ani R,et al.T he Pageran k Citation

Ranking:Bringing Ord er to the W eb[R].Technical Report, S tanford Digital Lib rary T ech nologies Project,1998.

[2] Kleinberg J M.Authoritative S ou rces in a H yperlinked Envi

ronm ent[J].Journ al of the ACM,1999,46(5):604 632. [3] Ch ak rabarti S,Dom B,Raghavan P,et al.Automatic Re

s ou rce List Compilation by An alyz ing H yperlink Stru cture and Ass ociated T ext[EB/OL].[2009 11 17].http://cites e https://www.360docs.net/doc/f45004486.html,/chak rabarti98autom atic.h tm l.

[4] Culliss https://www.360docs.net/doc/f45004486.html,er Popularity Rank ed Search E ngine[EB/OL].

[2009 11 17].http://w w https://www.360docs.net/doc/f45004486.html,/search engin es/

b oston1999/culliss/index.htm.

[5] Pow eredBy H adoop W iki[EB/OL].[2009 11 17].h ttp://

w ik i.apach https://www.360docs.net/doc/f45004486.html,/hadoop/Pow eredBy.

[6] Borthak ur D.HDFS Architectu re[EB/OL].[2009 11 17].

http://h adoop.apach https://www.360docs.net/doc/f45004486.html,/comm on/d ocs/cur rent/hdfs_de s ign.pdf.

[7] Dean J,Ghemaw at S.M apReduce:S implified Data Process

ing on Large C lusters[J].Communications of th e ACM, 2005,51(1):107 113.

[8] M ap/Reduce T utorial[EB/OL].[2009 11 17].http://h a

https://www.360docs.net/doc/f45004486.html,/common/docs/current/map red_tu torial.

pdf.

[9] 搜狗实验室(S ogou Labs)[E B/OL].[2009 11 17].h ttp://

w w https://www.360docs.net/doc/f45004486.html,/lab s/.[10] S ilvers tein C,H enz inger M,M arais H,et al.Analysis of a

Very Large Web Search Engine Qu ery Log[J].InS IGIR

Forum,1998,33(1):6 12.

[11] iProspect S earch Engine U ser Behavior Study[E B/OL].

[2009 11 17].http://w w w.iprosp https://www.360docs.net/doc/f45004486.html,/premiumPDFs/

W hitePaper_2006_S earchEn gineU erBehavior.pdf.

[12] H aw king D,Crasw ell N.Overview of th e TREC 2002W eb

T rack[C] Proc of the Eleventh T ext Retrieval Confer

ence,Techn ology,2003:86 95.

[13] SE WM 2004中文Web检索测试指南[E B/OL].[2009 11

17].http://w ww.cw https://www.360docs.net/doc/f45004486.html,/2004WebTrack/

S EWM2004W eb TrackGuidelines.pdf.

[14] SE WM2005中文W eb检索评测指南[EB/OL].[2009 11

17].http://w ww.cw https://www.360docs.net/doc/f45004486.html,/2005WebTrack/

S EWM2005W eb TrackGuidelines.pdf.

[15] SE WM2006中文W eb检索评测指南[EB/OL].[2009 11

17].h ttp://w w w.cw https://www.360docs.net/doc/f45004486.html,/2006WebTrack/

S EWM2006W eb TrackGuide.pdf.

[16] SE WM2007中文W eb检索评测指南[EB/OL].[2009 11

17].http://ww w.cw https://www.360docs.net/doc/f45004486.html,/20 07WebTrack/

S EWM2007W eb TrackGuide.pdf.

[17] Qucik S tart[E B/OL].[2009 11 17].http://hadoop.a

https://www.360docs.net/doc/f45004486.html,/common/docs/cur rent/quick s tart.

pdf.

王振宇(1967-),男,河南许昌人,博

士,教授,研究方向为分布式计算与SO A、

操作系统与虚拟化技术、嵌入式系统和实

时处理。E mail:w ang zy@https://www.360docs.net/doc/f45004486.html,

WANG Zhen yu,bo rn in1967,PhD, pro fesso r,his research interests include distr ibut ed co mpu ting and SOA,o per ating system and virtualizat ion,embed ded system and r eal time pr

ocessing.

郭力(1987-),男,湖北仙桃人,硕士,

研究方向为网络存储技术和分布式计算系

统。E mail:gl_scut@qq.co m

GUO Li,born in1987,M S,his re

search interests include netw or k sto rag e technolo gy,and distr ibut ed comput ing system.

120

Hadoop大数据平台架构与实践--基础篇

Hadoop大数据平台架构与实践--基础篇 大数据时代已经到来,越来越多的行业面临着大量数据需要存储以及分析的挑战。Hadoop,作为一个开源的分布式并行处理平台,以其高扩展、高效率、高可靠等优点,得到越来越广泛的应用。 本课旨在培养理解Hadoop的架构设计以及掌握Hadoop的运用能力。 导师简介 Kit_Ren,博士,某高校副教授,实战经验丰富,曾担任过大型互联网公司的技术顾问,目前与几位志同道合的好友共同创业,开发大数据平台。 课程须知 本课程需要童鞋们提前掌握Linux的操作以及Java开发的相关知识。对相关内容不熟悉的童鞋,可以先去《Linux达人养成计划Ⅰ》以及《Java入门第一季》进行修炼~~ 你能学到什么? 1、Google的大数据技术 2、Hadoop的架构设计 3、Hadoop的使用 4、Hadoop的配置与管理 大纲一览 第1章初识Hadoop 本章讲述课程大纲,授课内容,授课目标、预备知识等等,介绍Hadoop的前世今生,功能与优势 第2章 Hadoop安装 本章通过案例的方式,介绍Hadoop的安装过程,以及如何管理和配置Hadoop 第3章 Hadoop的核心-HDFS简介 本章重点讲解Hadoop的组成部分HDFS的体系结构、读写流程,系统特点和HDFS

的使用。 第4章 Hadoop的核心-MapReduce原理与实现 本章介绍MapReduce的原理,MapReduce的运行流程,最后介绍一个经典的示例WordCount 第5章开发Hadoop应用程序 本章介绍在Hadoop下开发应用程序,涉及多个典型应用,包括数据去重,数据排序和字符串查找。 课程地址:https://www.360docs.net/doc/f45004486.html,/view/391

Hadoop大数据平台介绍

Hadoop是什么 Apache Hadoop is an open source software framework for storage and large scale processing of data-sets on clusters of commodity hardware

Hadoop名字的由来 Hadoop was created by Doug Cutting and Mike Cafarella in 2005 Named the project after son's toy elephant

从移动数据到移动算法

Hadoop的核心设计理念?可扩展性 ?可靠性

相对于传统的BI 架构转变 数据仓库电子表格 视觉化工 具 数据挖掘集成开发工具 数据集市 企业应用工具 传统文件日志社交& 网络遗留系 统结构化 非结构化 音视频数据应用非关系型数据库内存数据库NO SQL 应用 Nod e Nod e Nod e Hadoop * Web Apps MashUps 导出/导入INSIGHTS 消费Create Map 存储/计算实时数据处理通道(Spark,Storm)数据交换平台数据存储计算平台数据访问 层Kafka Flume Goldengat e Shareplex ..传感器传感器

hadoop 的适用场景 小数据+ 小计算量OLTP 业务系统:ERP/CRM/EDA 大数据+ 小计算量如全文检索,传统的ETL 小数据+大计算量D a t a Compute 数据 计算 实时性

Hadoop大数据平台-测试报告及成功案例

Hadoop大数据平台测试报告及成功案例

目录 1技术规范书应答书 ................................. 错误!未定义书签。2技术方案建议 ......................................... 错误!未定义书签。3测试及验收 ............................................. 错误!未定义书签。4项目实施与管理 ..................................... 错误!未定义书签。5人员资质与管理 ..................................... 错误!未定义书签。6技术支持及保修 ..................................... 错误!未定义书签。7附录 ......................................................... 错误!未定义书签。

1.1 大数据平台测试报告 1.1.1某银行Cloudera CDH 性能测试测试 某银行现有HODS在支撑行内业务方面已经遇到瓶颈。希望通过搭建基于Hadoop 的历史数据平台(新HODS),以提升平台运行效率及数据覆盖面,支撑未来大数据应用,满足未来业务发展需求。本次POC测试的主要目的是验证Hadoop商业发行版(EDH) 是否可以满足某银行HODS应用特点,主要考察点包括: ?验证产品本身的易用性、可扩展性,主要涉及集群的部署、运维、监控、升级等; ?验证产品对安全性的支持,包括认证、授权、审计三大方面; ?验证产品对资源分配的控制与调度; ?验证Hadoop基本功能,包括可靠性、稳定性、故障恢复等; ?验证Hadoop子系统(包括HDFS、HBase、Hive、Impala等) 的性能、使用模式、设计思想、迁移代价等。 1.1.1.1基础设施描述 1.1.1.1.1硬件配置 硬件配置分为两类:管理节点(master node) 与计算节点(worker node)。 管理节点配置(2) CPU Intel? Xeon? E5-2650 v3 2.3GHz,25M Cache,9.60GT/s QPI,Turbo,HT,10C/20T (105W) Max Mem 2133MHz (40 vcore) 内存16GB RDIMM, 2133MT/s, Dual Rank, x4 Data Width (128GB) 网络Intel X520 DP 10Gb DA/SFP+ Server Adapter, with SR Optics

基于Hadoop的大数据平台实施——整体架构设计

基于Hadoop的大数据平台实施——整体架构设计大数据的热度在持续的升温,继云计算之后大数据成为又一大众所追捧的新星。我们暂不去讨论大数据到底是否适用于您的公司或组织,至少在互联网上已经被吹嘘成无所不能的超级战舰。好像一夜之间我们就从互联网时代跳跃进了大数据时代!关于到底什么是大数据,说真的,到目前为止就和云计算一样,让我总觉得像是在看电影《云图》——云里雾里的感觉。或许那些正在向你推销大数据产品的公司会对您描绘一幅乌托邦似的美丽画面,但是您至少要保持清醒的头脑,认真仔细的慎问一下自己,我们公司真的需要大数据吗? 做为一家第三方支付公司,数据的确是公司最最重要的核心资产。由于公司成立不久,随着业务的迅速发展,交易数据呈几何级增加,随之而来的是系统的不堪重负。业务部门、领导、甚至是集团老总整天嚷嚷的要报表、要分析、要提升竞争力。而研发部门能做的唯一事情就是执行一条一条复杂到自己都难以想象的SQL语句,紧接着系统开始罢工,内存溢出,宕机........简直就是噩梦。OMG!please release me!!! 其实数据部门的压力可以说是常人难以想象的,为了把所有离散的数据汇总成有价值的报告,可能会需要几个星期的时间或是更长。这显然和业务部门要求的快速响应理念是格格不入的。俗话说,工欲善其事,必先利其器。我们也该鸟枪换炮了......。 网上有一大堆文章描述着大数据的种种好处,也有一大群人不厌其烦的说着自己对大数据的种种体验,不过我想问一句,到底有多少人多少组织真的在做大数据?实际的效果又如何?真的给公司带来价值了?是否可以将价值量化?关于这些问题,好像没看到有多少评论会涉及,可能是大数据太新了(其实底层的概念并非新事物,老酒装新瓶罢了),以至于人们还沉浸在各种美妙的YY中。 做为一名严谨的技术人员,在经过短暂盲目的崇拜之后,应该快速的进入落地应用的研究中,这也是踩着“云彩”的架构师和骑着自行车的架构师的本质区别。说了一些牢骚话,

Hadoop大数据平台-建设要求及应答方案

Hadoop大数据平台建设要求及应答方案

目录 2技术规范书应答书 (2) 2.1业务功能需求 (4) 2.1.1系统管理架构 (4) 2.1.2数据管理 (12) 2.1.3数据管控 (26) 2.1.4数据分析与挖掘 (27) 2.2技术要求 (30) 2.2.1总体要求 (30) 2.2.2总体架构 (31) 2.2.3运行环境要求 (32) 2.2.4客户端要求 (35) 2.2.5数据要求 (36) 2.2.6集成要求 (36) 2.2.7运维要求 (37) 2.2.8性能要求 (49) 2.2.9扩展性要求 (50) 2.2.10可靠性和可用性要求 (52) 2.2.11开放性和兼容性要求 (57) 2.2.12安全性要求 (59)

1大数据平台技术规范要求 高度集成的Hadoop平台:一个整体的数据存储和计算平台,无缝集成了基于Hadoop 的大量生态工具,不同业务可以集中在一个平台内完成,而不需要在处理系统间移动数据;用廉价的PC服务器架构统一的存储平台,能存储PB级海量数据。并且数据种类可以是结构化,半结构化及非结构化数据。存储的技术有SQL及NoSQL,并且NoSQL能提供企业级的安全方案。CDH提供统一的资源调度平台,能够利用最新的资源调度平台YARN分配集群中CPU,内存等资源的调度,充分利用集群资源; 多样的数据分析平台–能够针对不用的业务类型提供不同的计算框架,比如针对批处理的MapReduce计算框架;针对交互式查询的Impala MPP查询引擎;针对内存及流计算的Spark框架;针对机器学习,数据挖掘等业务的训练测试模型;针对全文检索的Solr搜索引擎 项目中所涉及的软件包括: ?Hadoop软件(包括而不限于Hadoop核心) ?数据采集层:Apache Flume, Apache Sqoop ?平台管理:Zookeeper, YARN ?安全管理:Apache Sentry ?数据存储:HDFS, HBase, Parquet ?数据处理:MapReduce, Impala, Spark ?开发套件:Apache Hue, Kite SDK ?关系型数据库系统:SAP HANA企业版 ?ETL工具:SAP Data Services 数据管控系统的二次开发量如下: ?主数据管理功能 通过二次开发的方式实现主数据管理功能,并集成甲方已有的主数据管理系统。

部署Hadoop大数据平台部署Hadoop平台

课题:项目3 部署Hadoop大数据平台第2部分部署Hadoop平台课次:第7次教学目标及要求: (1)任务1 JDK的安装配置(熟练掌握) (2)任务2部署Hadoop(熟练掌握) (3)任务3 理解启动Hadoop(熟练掌握) 教学重点: (1)任务1 JDK的安装配置 (2)任务2 部署Hadoop (3)任务3 启动Hadoop 教学难点: (1)任务2 部署Hadoop (2)任务3 启动Hadoop 思政主题: 旁批栏: 教学步骤及内容: 1.课程引入 2.本次课学习内容、重难点及学习要求介绍 (1)任务1 JDK的安装配置 (2)任务2 部署Hadoop (3)任务3 启动Hadoop 3.本次课的教学内容 (1)任务1 JDK的安装配置(熟练掌握) Hadoop的不同版本与JDK的版本存在兼容性问题,所有必须选择对应 版本的JDK进行安装,表中列出了Hadoop和JDK兼容表。我们通过测试 使用Hadoop3.0.0 和JDK1.8。 安装JDK我们使用JDK包安装的方式。首先我们新建JDK的安装目录 /opt/bigddata。操作步骤为://定位opt目录【操作新建目录/opt/bigdata】

[root@master /]# cd /opt/ //在opt目录下新建bigdata文件夹 [root@master /]# mkdir bigdata //查看opt目录下文件夹是否存在 [root@master /]# ls bigdata [root@master /]# Jdk解压安装,步骤为:【操作解压步骤】 [root@master opt]# cd / [root@master /]# cd /opt/ [root@master opt]# ls bigdata jdk-8u161-linux-x64.tar.gz //解压jdk压缩包 [root@master opt]# tar -zxvf jdk-8u161-linux-x64.tar.gz [root@master opt]# ls bigdata jdk1.8.0_161 jdk-8u161-linux-x64.tar.gz //把Jdk目录移动至bigdata目录 [root@master opt]# mv jdk1.8.0_161/ bigdata [root@master opt]# cd bigdata/ //查看是否移动成功 [root@master bigdata]# ls jdk1.8.0_161 [root@master bigdata]# JDK配置环境变量,此步骤为添加JA V A_HOME变量,并配置JDK。具体步骤为:【操作JDK的配置】 //进入环境变量配置文件 [root@master /]# vi /etc/profile //添加如下信息 export JA V A_HOME="/opt/bigdata/jdk1.8.0_161" export PATH=$JA V A_HOME/bin:$PATH //激活环境变量配置文件 [root@master /]# source /etc/profile //验证JDK是否配置完成 [root@master /]# java -version java version "1.8.0_161" Java(TM) SE Runtime Environment (build 1.8.0_161-b12) Java HotSpot(TM) 64-Bit Server VM (build 25.161-b12, mixed mode)

HADOOP大数据平台配置方法(懒人版)

HADOOP大数据平台配置方法(完全分布式,懒人版) 一、规划 1、本系统包括主节点1个,从节点3个,用Vmware虚拟机实现; 2、主节点hostname设为hadoop,IP地址设为192.168.137.100; 3、从节点hostname分别设为slave01、slave02,slave03,IP地址设为192.168.137.201、192.168.137.202、192.168137.203。今后如要扩充节点,依此类推; 基本原理:master及slave机器的配置基本上是一样的,所以我们的操作方式就是先配置好一台机器,然后克隆3台机器出来。这样可以节省大量的部署时间,降低出错的概率。安装配置第一台机器的时候,一定要仔细,否则一台机器错了所有的机器都错了。 二、前期准备 1、在Vmware中安装一台CentOS虚拟机; 2、设置主机名(假设叫hadoop)、IP地址,修改hosts文件; 3、关闭防火墙; 4、删除原有的JRE,安装JDK,设置环境变量; 5、设置主节点到从节点的免密码登录(此处先不做,放在第七步做); 三、安装Hadoop 在hadoop机上以root身份登录系统,按以下步骤安装hadoop: 1、将hadoop-1.0.4.tar.gz复制到/usr 目录; 2、用cd /usr命令进入/usr目录,用tar –zxvf hadoop-1.0.4.tar.gz进行 解压,得到一个hadoop-1.0.4目录; 3、为简单起见,用mv hadoop-1.0.4 hadoop命令将hadoop-1.0.4文件夹 改名为hadoop; 4、用mkdir /usr/hadoop/tmp命令,在hadoop文件夹下面建立一个tmp 目录; 5、用vi /etc/profile 修改profile文件,在文件最后添加以下内容: export HADOOP_HOME=/usr/hadoop export PATH=$PATH:$HADOOP_HOME/bin 6、用source /usr/profile命令使profile 立即生效; 四、配置Hadoop Hadoop配置文件存放在/usr/hadoop/conf目录下,本次有4个文件需要修改。这4个文件分别是hadoop-env.sh、core-site.xml、hdfs-site.xml、mapred-site.xml。 1、修改hadoop-env.sh,在文件末添加如下内容: export JAVA_HOME=/usr/jdk (此处应与Java所在的目录一致) 2、修改core-site.xml文件,在文件中添加如下内容(教材109):

文秘知识-浅谈大数据Hadoop技术 精品

浅谈大数据Hadoop技术 摘要:随着移动互联网、物联网、共享经济的高速发展,互联网每天都会产生数以万亿 的数据,这些海量数据被称作为大数据。在这个大数据时代,数据资源对我们生活产 生了巨大影响,对企业经营决策也有着前瞻性指导意义。因此,大数据已经被视为一 种财富、一种被衡量和计算价值的不可或缺的战略资源。该文从大数据Hadoop技术谈起、分别从Hadoop的核心技术、生态系统和Hadoop技术在教学中的应用四个方面进 行了阐述。 关键词:大数据;Hadoop; HDFS; MapReduce 中图分类号:TP393 文献标识码:A 文章编号:1009-3044(2019)32-0010-02 当前,我国以信息技术为主导的创新经济高速发展,特别是依托于移动互联网和物联 网技术的网络购物、移动支付、共享单车、微信通信交流等等,给人们生活方式带来 了深刻的变革。整个互联网正在从IT(Information Technology)时代向DT(Data Technology)时代D变,在这个DT时代,人们从被动的数据浏览者转变为主动的数据 生产者,人们每天的网络购物信息、各种电子支付信息、使用共享单车信息、微信中 浏览朋友圈的信息等等,都会产生数以万亿级的数据,这样庞大的数据如何存储、如 何传输、如何计算、如何分析、如何保证数据的完整性和安全性等等一系列新的技术 挑战应运而生。然而,Hadoop技术代表着最新的大数据处理所需的新的技术和方法, 也代表着大数据分析和应用所带来的新发明、新服务和新的发展机遇。 1 什么是Hadoop Hadoop是一个由Apache基金会所开发的,开源的分布式系统基础架构。简单地说就是一套免费的分布式操作系统。我们以前使用的计算机系统,都是安装在一台独立主机 上的单机版操作系统。例如我们熟知的微软公司的Windows操作系统和苹果公司的Mac OS。而分布式系统则是通过高速网络把大量分布在不同地理位置、不同型号、不同硬 件架构、不同容量的服务器主机连结在一起,形成一个服务器集群。分布式系统把集 群中所有硬件资源(CPU、硬盘、内存和网络带宽)进行整合统一管理,形成具有极高 运算能力,庞大存储能力和高速的传输能力的系统。 Hadoop就是以Linux系统为原型开发的大数据分布式系统。Hadoop具有很强的扩展性,只要是接通网络它就可以不断加入不同地域、不同型号、不同性能的服务器主机,以 提升集群的运算、存储和网络带宽,以满足大数据所需要的硬件要求。此外,Hadoop 还具有极强的安全性,由于分布式系统数据是存储在不同物理主机上的,而且Hadoop 数据一般每个数据存储三份,而且分布不同物理主机上,一旦其中一份数据损坏,其 余正常数据会很快替代它,这样很好地解决了数据完整性和安全性问题,为大数据提 供了安全高速稳定的系统平台。

hadoop是什么_华为大数据平台hadoop你了解多少

hadoop是什么_华为大数据平台hadoop你了解多少 Hadoop得以在大数据处理应用中广泛应用得益于其自身在数据提取、变形和加载(ETL)方面上的天然优势。Hadoop的分布式架构,将大数据处理引擎尽可能的靠近存储,对例如像ETL这样的批处理操作相对合适,因为类似这样操作的批处理结果可以直接走向存储。Hadoop的MapReduce功能实现了将单个任务打碎,并将碎片任务(Map)发送到多个节点上,之后再以单个数据集的形式加载(Reduce)到数据仓库里。Hadoop是一个能够对大量数据进行分布式处理的软件框架。Hadoop 以一种可靠、高效、可伸缩的方式进行数据处理。Hadoop 是可靠的,因为它假设计算元素和存储会失败,因此它维护多个工作数据副本,确保能够针对失败的节点重新分布处理。Hadoop 是高效的,因为它以并行的方式工作,通过并行处理加快处理速度。Hadoop 还是可伸缩的,能够处理PB 级数据。此外,Hadoop 依赖于社区服务,因此它的成本比较低,任何人都可以使用。 华为大数据平台hadoop你了解多少提到大数据平台,就不得不提Hadoop。Hadoop有三大基因:第一,Hadoop需要sharenothing的架构,所以它可以scale-out。第二,它是一个计算存储解耦的架构,好处是计算引擎可以多样化。举个例子,批处理有Hive,交互查询有Spark,机器学习还可以有后面的tensorflow这些深度学习的框架。第三,Hadoop是近数据计算的。因为大数据平台是一个数据密集的计算场景,在这种非场景下,IO会是个瓶颈,所以把计算移动到数据所在地会提升计算的性能。 网络技术的发展是推动大数据平台发展的一个关键因素。2012年以前是一个互联网的时代,这个时期互联网公司和电信运营商,掌握着海量的数据,所以他们开始利用Hadoop 平台来进行大数据的处理。那时候程序员自己写程序跑在Hadoop平台上来解决应用问题。2012年以后移动互联网的迅猛发展,这使得服务行业率先数字化。例如在金融行业,手机App让用户可以随时随地查询、转账,此时银行开始面临海量数据和高并发的冲击,就需要一个大数据平台来解决这个问题。这也就是为什么华为在2013年面向行业市场推出大