SVD奇异值分解

矩阵的奇异值分解及其实际应用

矩阵的奇异值分解及其实际应用矩阵的奇异值分解(Singular Value Decomposition,SVD)是一种重要的矩阵分解方法,它在数据处理、信号处理、图像处理、自然语言处理等领域有广泛的应用。

一、SVD的定义和原理SVD是一种矩阵分解方法,把一个矩阵分解为三个矩阵的乘积,即:$A=U\Sigma V^T$其中,$A$为一个$m\times n$的矩阵,$U$为$m\times m$的酉矩阵,$\Sigma$为$m\times n$的对角矩阵,$V$为$n\times n$的酉矩阵,$T$表示转置。

$\Sigma$中的对角元素称为奇异值,是矩阵$A$的奇异值分解中的核心。

$\Sigma$中的奇异值按从大到小的顺序排列,它们可以用来表示原始矩阵$A$的主要特征。

在一些情况下,我们只需要保留前$k$个最大的奇异值对应的列向量组成的$\Sigma$和对应的$U$、$V$矩阵,即可以得到一个$k$维的近似矩阵,这种方法称为截断奇异值分解。

SVD的原理可以利用矩阵的特征值和特征向量的概念来解释。

对于一个$n\times n$的矩阵$A$,它可以表示为:$A=Q\Lambda Q^{-1}$其中,$Q$为特征向量矩阵,$\Lambda$为特征值矩阵,这里我们假设$A$是对称矩阵。

SVD可以看做是对非对称矩阵的特征值和特征向量的推广,它把矩阵$A$分解为$U\Sigma V^T$,其中,$U$矩阵的列向量为$AA^T$的特征向量,$V$矩阵的列向量为$A^TA$的特征向量,而$\Sigma$则由$AA^T$和$A^TA$的特征值的平方根构成。

二、SVD的应用SVD在数据处理、信号处理、图像处理、自然语言处理等领域都有广泛的应用。

1、数据处理在数据分析和数据挖掘中,我们常常需要对数据进行降维,以便于可视化和分析。

SVD可以对数据进行降维,并且保留了数据的主要特征。

例如,我们可以利用SVD对用户-物品评分矩阵进行降维,得到一个低维的用户-主题矩阵和一个低维的主题-物品矩阵,从而实现推荐系统。

SVD(奇异值分解)算法及其评估

2

促进人们研究 SVD 并且应用 SVD 比较早的应该是最小二乘法问题了, 在前一份关于 QR 分解的报告已经对 LS 问题进行了一些介绍,这里继续讨 论 SVD 在 LS 问题中的应用。 LS 问题即相当于,设 A ∈ R m×n (m > n), b ∈ R m ,求 x ∈ R n 使得 Ax −= b 2 min{ Av − b 2 : v ∈ R n }. ……(2.1) 假设已知矩阵 A 有式子(1.1)得到的 SVD 分解式为 U ΣV T , U 和 V 分别为 m, n 阶正交方阵,而 ∑ 为和 A 具有相同维数的对角矩阵,那么我们可以得到[4]: Ax − b = U ΣV T x − b

同理如果将 V 划分为以下的形式 V = (V1 , V2 ) 其中 V1 为 n × r 的矩阵,则 V1 的列向量构成矩阵 A 的行空间的正交向量

⊥ 基。且 RA = V1V1T 为投影到矩阵 A 的行空间上的正交投影算子;而 RA = V2V2T 则是到矩阵 A 行空间的正交补空间上的投影。 (3) 最小二乘法问题(LS 问题)

定义 1.1 设 A ∈ R m×n , AT A 的特征值的非负平方根称作 A 的奇异值; A 的奇异 值的全体记作 σ ( A ) [1]。 当 A 为复矩阵 C m×n 时,只需将 AT A 改为 AH A ,定义 1.1 仍然成立。 定理 1.1(奇异值分解定理) 设 A ∈ R m×n ,则必存在正交矩阵 m×m = U [u1 ,..., um ] ∈ R= 和 V [ v1 ,..., vn ] ∈ R n×n 使得 Σ U T AV = r 0

首先来对 SVD 算法的发展来做简单的回顾[11,12]:关于 SVD 算法的研究最早 可以追溯到 1873 年 Beltrami 所做的工作, 这中间在理论方面进行了大量的工作, 这 个历史过程可以参考 Stewart 的文献[8]。 但是直到 1965 年 Golub 和 Kahan 才在 SVD 的数值计算领域取得突破性进展[9],并且于 1969 给出了比较稳定的算法[10](以下 简称传统 QR 迭代算法) ,这也是后来在 LINPACK 中所采用的方法[3]。它的中心思 想是用正交变换将原矩阵化为双对角线矩阵,然后再对双对角线矩阵迭代进行 QR 分解。 六十年代一份没有出版的技术报告中,Kahan 证明了双对角线矩阵的奇异值可 以精确地计算,具有和原矩阵元素的相对的精确度;进一步,1990 年 Demmel 和 Kahan 给出了一种零位移的 QR 算法(zero-shift QR algorithm),这种算法计算双对角 矩阵的奇异值具有很高的相对精度[13],并且由此得到的奇异向量也具有很高的精 度[14]。 Fernando 和 Parlett 在 1994 年将 qd 算法应用到奇异值的计算上,从而得到了一 种全新的比 zero-shift QR algorithm 更加精确和快速的计算奇异值的算法[15,16]。 而 Demmel 和 Veselic 在文献[17]中则说明了用 Jacobi 方法与其它方法相比计算 所得到的奇异值和奇异向量具有更高的精度,可惜 Jacobi 算法比 DK 算法速度要慢 的多;在文献[18]中对 Jacobi 方法进行了改进使得其在速度上几乎和 DK 算法相当。 和 Strassen 算法类似,SVD 问题也有快速的分而制之算法,在文献[19,20]对其 有详细的介绍, 由此得到的算法在总计算量上比现有的 LAPACK 软件包中所采用的 方法要少的多。 在文献[21,22]中给出的 bisection 算法也可以对双对角线矩阵计算得到具有相对 精度的全部奇异值。 以下就开始对各种算法原理进行详细说明,并分析它们的计算量,计算的精确 度,以及所占得内存。

奇异值分解原理

奇异值分解原理

奇异值分解(Singular Value Decomposition,SVD)是一种矩阵分解技术,它可以将一个矩阵分解为三个矩阵的乘积,这三个矩阵分别是左奇异矩阵,奇异值矩阵和右奇异矩阵。

奇异值分解的主要应用之一是矩阵的减少,这种减少可以用来减少矩阵的计算复杂度,以及减少需要存储的内存大小。

奇异值分解的另一个主要应用是降维,它可以将原始数据集中的特征映射到较低维度的特征空间,从而能够去除噪声和保留最重要的特征。

这样做的好处是减少计算量和节省内存,同时还能提高计算机的运行效率。

此外,奇异值分解还可以用于机器学习中的特征提取和特征抽取,它可以将原始数据的高维特征映射到较低维特征空间,从而提取出最重要的特征,并减少噪声的影响。

总之,奇异值分解是一种非常有用的数学工具,可以用于减少矩阵计算复杂度,减少内存大小,降维,特征提取以及特征抽取等任务。

它可以有效地帮助我们解决许多数据分析问题,因此被广泛应用于许多机器学习领域。

奇异值分解与特征值分解的比较分析(Ⅰ)

奇异值分解与特征值分解是线性代数中两个重要的矩阵分解方法。

它们在数据分析、信号处理、图像压缩等领域都有着广泛的应用。

本文将对这两种分解方法进行比较分析,探讨它们的优缺点及适用范围。

一、奇异值分解(SVD)奇异值分解是一种将一个矩阵分解成三个矩阵的方法,即将一个m×n的矩阵A分解为U、Σ和V三个矩阵的乘积,其中U是一个m×m的酉矩阵,Σ是一个m×n的对角矩阵,V是一个n×n的酉矩阵。

奇异值分解有着许多优点,比如对于任意的矩阵A,都存在奇异值分解。

并且,对于奇异值分解的性质有许多重要的应用,比如在矩阵压缩和降维、矩阵逆的计算等方面。

二、特征值分解(EVD)特征值分解是一种将一个方阵分解成三个矩阵的方法,即将一个n×n的方阵A分解为P、Λ和P-1三个矩阵的乘积,其中P是一个n×n的可逆矩阵,Λ是一个n×n的对角矩阵,P-1是P的逆矩阵。

特征值分解也有着诸多优点,比如对于对称矩阵来说,特征值分解是唯一的,而且特征值分解在对称矩阵的对角化、矩阵对称化等方面有着重要的应用。

三、奇异值分解与特征值分解的比较分析1. 计算复杂度在计算复杂度方面,特征值分解的计算复杂度通常比奇异值分解高。

特征值分解需要解特征值问题,而奇异值分解只需要进行奇异值分解,因此在计算复杂度上,奇异值分解更加高效。

2. 适用范围特征值分解对于对称矩阵有着很好的适用性,而奇异值分解对于任意矩阵都有着适用性。

因此,在实际应用中,奇异值分解的适用范围更广。

3. 稳定性在矩阵的微小扰动下,特征值分解的结果可能会有较大的变化,而奇异值分解对于矩阵的微小扰动具有更好的稳定性。

因此在数值计算中,奇异值分解更加稳定可靠。

四、结论奇异值分解与特征值分解是两种重要的矩阵分解方法,它们在不同的领域有着不同的应用。

在计算复杂度、适用范围和稳定性等方面,奇异值分解相对于特征值分解具有更多的优势。

svd奇异值分解

1. 奇异值的特征1) 奇异值分解的第一个特征是可以降维。

A 表示n 个m 维向量,通过奇异值分解可表示成m+n 个r 维向量,若A 的秩r 远远小于m 和n ,则通过奇异值分解可以大大降低A 的维数。

可以计算出,当1nm r m n =++时,可以达到降维的目的,同时可以降低计算机对存贮器的要求。

2)奇异值分解的第二个特征是奇异值对矩阵的扰动不敏感,而特征值对矩阵的扰动敏感。

3)奇异值的第三个特征是奇异值的比例不变性。

4)奇异值的第四个特征是奇异值的旋转不变性。

奇异值的比例和旋转不变性特征在数字图像的旋转、镜像、平移、放大、缩小等几何变化方面有很好的应用。

5) 当A 是方阵时,其奇异值的几何意义是:若x 是n 维单位球面上的一点,则Ax 是一个n 维椭球面上的点,其中椭球的n 个半轴长正好是A 的n 个奇异值。

简单地说,在二维情况下,A 将单位圆变成了椭圆,A 的两个奇异值是椭圆的长半轴和短半轴。

2.基于SVD 的图像水印数值分析中的奇异值分解 ( SVD) 是一种将矩阵对角化的数值算法. 在图像处理中应用 SVD 的主要理论背景是 : ( 1) 图像奇异值的稳定性非常好 ,即当图像被施加小的扰动时 ,图像的奇异值不会有大的变化 ; (2) 奇异值所表现的是图像的内蕴特性而非视觉特性.从线性代数的角度看 , 一幅灰度图像可以被看成是一个非负矩阵. 若一幅图像用 A 表示定义为n n A R ⨯∈ ( 为方便起见 , 以后均只对方阵进行讨论) , 其中 R 表示实数域. 则矩阵A 的奇异值分解定义如下 : TA USV = ( 1)其中n n U R ⨯∈和n n V R ⨯∈均为正交阵 , n n S R ⨯∈为对角阵 ,上标 T 表示矩阵转置.水印的嵌入和检测SVD 方法的基本原理是将水印嵌入到原始图像的奇异值中. 在水印的嵌入过程中 , 先做 n ×n 灰度图像 A 的奇异值分解 , 得到两个正交矩阵 U 、 V 及一个对角矩阵 S . 尽管假设 A 是方阵 , 但其他非方阵可以完全用同样的方法来处理. 这个特性是 SVD 方法的一个优点 , 因为很多流行的水印算法都不能直接处理长方阵. 水印n n W R ⨯∈被叠加到矩阵 S 上 , 对新产生的矩阵 S +aW 进行奇异值分解 , 得到 U1 、 S1 和 V1( S + aW =111T U S V ) ,其中常数 a > 0 调节水印的叠加强度. 然后将矩阵 U 、 S1 和TV 相乘 , 得到处理后的包含水印的图像 A1 . 即如果矩阵 A 和W 分别表示原始图像和水印 , 那么通过如下三个步骤得到水印图像 A1 :T A USV ⇒,111T S W U SV +⇒,11T A USV ⇐. 在水印的检测过程中 , 如果给出矩阵 U1 、 S 、 V1 和可能损坏的水印图像*A , 那么通过简单的逆过程就就可以提取出可能已经失真的水印*W , 即 :****1T A U S V ⇒,**111T D U S V ⇐,**1(D S)W a⇐- 注意到三个矩阵 U1 、 S 和 V1 的总的自由度为2n , 即等于一个 n ×n 矩阵的自由度. 与其他一些水印算法要求原始图像来提取水印不同的是 , SVD 算法需要上面的三个矩阵来提取水印 , 但没有要求额外的信息量。

奇异值分解

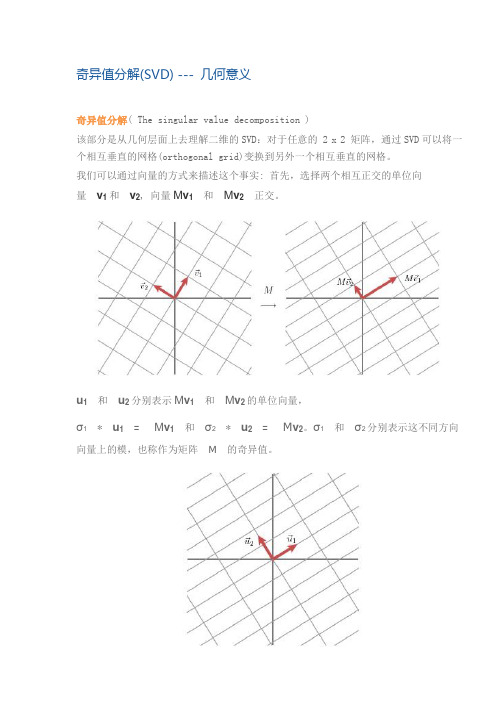

奇异值分解(SVD) --- 几何意义奇异值分解( The singular value decomposition )该部分是从几何层面上去理解二维的SVD:对于任意的 2 x 2 矩阵,通过SVD可以将一个相互垂直的网格(orthogonal grid)变换到另外一个相互垂直的网格。

我们可以通过向量的方式来描述这个事实: 首先,选择两个相互正交的单位向量v1 和v2, 向量M v1和M v2正交。

u1和u2分别表示M v1和M v2的单位向量,σ1* u1= M v1和σ2* u2= M v2。

σ1和σ2分别表示这不同方向向量上的模,也称作为矩阵M的奇异值。

这样我们就有了如下关系式M v1= σ1u1M v2= σ2u2我们现在可以简单描述下经过M线性变换后的向量x 的表达形式。

由于向量v1和v2是正交的单位向量,我们可以得到如下式子:x = (v1x) v1 + (v2x) v2这就意味着:M x = (v1x) M v1 + (v2x) M v2M x = (v1x) σ1u1 + (v2x) σ2u2向量内积可以用向量的转置来表示,如下所示v x = v T x最终的式子为M x = u1σ1v1T x + u2σ2v2T xM = u1σ1v1T + u2σ2v2T上述的式子经常表示成M = UΣV Tu 矩阵的列向量分别是u1,u2 ,Σ是一个对角矩阵,对角元素分别是对应的σ1和σ2,V 矩阵的列向量分别是v1,v2。

上角标T表示矩阵V 的转置。

这就表明任意的矩阵M是可以分解成三个矩阵。

V 表示了原始域的标准正交基,u 表示经过M 变换后的co-domain的标准正交基,Σ表示了V 中的向量与u 中相对应向量之间的关系。

(V describes an orthonormal basis in the domain, and U describes an orthonormal basis in the co-domain, and Σ describes how much the vectors in V are stretched to give the vectors in U.)如何获得奇异值分解?( How do we find the singular decomposition? ) 事实上我们可以找到任何矩阵的奇异值分解,那么我们是如何做到的呢?假设在原始域中有一个单位圆,如下图所示。

奇异值分解定理

奇异值分解定理奇异值分解(Singular Value Decomposition,简称SVD)是线性代数中一种重要的矩阵分解方法,常用于数据分析、信号处理、图像压缩等领域。

SVD的定理表明,任何矩阵都可以分解成三个矩阵的乘积,其中一个矩阵是正交矩阵,另外两个矩阵是对角矩阵,且对角线上的元素称为奇异值。

奇异值分解定理的数学概念比较复杂,需要一定的线性代数基础。

下面将对奇异值分解定理进行详细解释。

给定一个m行n列的实数矩阵A,假设rank(A)为r.那么存在两个实数方阵U(m×r)和V(n×r),使得:A = UΣV^T其中,U的每一列是A^TA的特征向量,V的每一列是AA^T的特征向量,Σ是一个对角矩阵,对角线上的元素称为奇异值。

奇异值分解定理的证明比较复杂,这里只给出一个简要的证明思路。

假设A的列向量为{a1, a2, ..., an},它们构成了一个n维向量空间的一组基。

我们可以将这组基转化为标准正交基,得到一组正交矩阵U和V。

然后我们可以通过对U和V进行一些数学操作,得到UΣV^T形式的矩阵。

最后,我们可以证明这个矩阵确实满足奇异值分解定理的要求。

奇异值分解定理在数据分析中有广泛的应用。

例如,在推荐系统中,我们可以通过SVD将用户对物品的评分矩阵分解,得到用户和物品的特征矩阵,从而进行个性化推荐。

在语音识别中,我们可以通过SVD将语音信号分解成一组基本声音的叠加,从而实现语音信号的降噪和特征提取。

在图像压缩中,我们可以通过SVD将图像分解成一组基本的图像模式,从而实现图像的降噪和压缩。

奇异值分解定理的应用不仅局限于上述领域,还可以应用于信号处理、图像处理、文本处理等其他领域。

通过奇异值分解,我们可以将复杂的问题转化为简单的线性代数运算,从而大大简化问题的求解过程。

然而,奇异值分解也有一些限制。

首先,奇异值分解是一种数值方法,对计算精度要求较高。

其次,奇异值分解的计算复杂度较高,对于大规模矩阵的分解可能会很耗时。

奇异值分解意义作用SVD分解意义

奇异值分解意义作用SVD分解意义在SVD中,U是一个m×m的正交矩阵,Σ是一个m×n的矩阵,其中对角线上的元素称为奇异值(singular value),V是一个n×n的正交矩阵。

SVD的意义和作用有很多,以下是其中几个重要的方面:1.数据压缩和去噪:SVD可以降低数据的维度,并保留特征值较大的分量。

通过保留较少的奇异值,可以压缩数据并减少存储空间。

同时,通过去掉奇异值较小的分量,还可以去除数据中的噪声和冗余信息。

2.矩阵逼近和数据重建:SVD可以用于逼近一个给定的矩阵。

通过保留奇异值较大的分量,可以用较低维度的逼近矩阵来近似原始矩阵。

这在图像压缩、音频处理等领域中具有重要的应用。

3.特征值计算:SVD可以用于计算矩阵的特征值和特征向量。

对于一个对称矩阵,SVD可以求解其特征值和特征向量,而且在计算上更加稳定和高效。

4.矩阵分解和线性方程求解:SVD可以将一个矩阵分解为三个部分的乘积,即UΣV^T。

这个分解可以简化矩阵的运算,并且可以用于求解线性方程组、矩阵的逆等。

5.推荐系统和信息检索:SVD在推荐系统和信息检索中有广泛的应用。

通过对用户-项目矩阵进行SVD分解,可以得到用户的偏好和项目的特征,从而进行个性化的推荐。

6.图像处理和计算机视觉:SVD可以用于图像压缩、图像去噪、图像修复等图像处理任务。

通过将图像分解为较低维度的逼近矩阵,可以达到压缩图像和去除噪声的效果。

总之,SVD在数据分析、模式识别、信号处理、推荐系统等众多领域中有着广泛的应用。

它可以对数据进行降维和压缩,去除噪声和冗余信息,计算特征值和特征向量,解决线性方程组,并且提供了独特的方法来理解和分析矩阵的结构和性质。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

SVD奇异值分解

继而可以得到A矩阵的奇异值分解:

现在可以来对A矩阵的映射过程进行分析了:如果在 n维空间中找到一个(超)矩形,其边都落在A'A的特 征向量的方向上,那么经过A变换后的形状仍然为(超)矩形! vi为A'A的特征向量,称为A的右奇异向量,ui=Avi实际上为AA'的特征向量,称为A的左奇异向量。下面 利用SVD证明文章一开始的满秩分解:

特征值分解——EVD

所以可得到A的特征值分解(由于对称阵特征向量两两正交,所以U为正交阵,正交阵的逆矩阵等于其转置)

SVD奇异值分解

现在假设存在M*N矩阵A,事实上,A矩阵将n维空间中的向量映射到k(k<=m)维空间中, k=Rank(A)。现在的目标就是:在n维空间中找一组正交基,使得经过A变换后还是正交的。假设已经找到 这样一组正交基: 则A矩阵将这组基映射为: 如果要使他们两两正交,即 根据假设,存在

利用矩阵分块乘法展开得:

SVD奇异值分解

可以看到第二项为0,有

令

则A=XY即是A的满秩分解。

SVD奇异值分解

SVD奇异值分解

SVD奇异值分解

SVD奇异值分解

SVD奇异值分解

SVD奇异值分解

这样就找到了正交基使其映射后还是正交基了,现在,将映射后的正交基单位化: 因为

SVD奇异值分解

所以有

所以取单位向量

由此可得 当k < i <= m时,对u1,u2,...,uk进行扩展u(k+1),...,um,使得u1,u2,...,um为m维空间中的一组 正交基,即

同样的,对v1,v2,...,vk进行扩展v(k+1),...,vn(这n-k个向量存在于A的零空间中,即Ax=0的解空间的 基),使得v1,v2,...,vn为n维空间中的一组正交基,即