SAS系统和数据分析逐步回归分析

sas回归分析

sas回归分析数据预处理->数据探索->模型选择->残差检验、共线性争端,强影响点判断->模型修正(否->模型选择,是->模型预测)⼀:数据预处理⼆:数据探索看y是否服从正态分布(PP图)proc univariate data=reg.b_fitness;var Runtime -- Performance;histogram Runtime -- Performance / normal; /*主要从统计指标上⾯看*/probplot Runtime -- Performance /normal (mu=est sigma=est color=red w=2);/*主要从图形来看*/run;看x的离散程度(散点图)看y与x的相关系数(散点图,R^2)proc gplot data=reg.b_fitness;plot Oxygen_Consumption *(Run_PulseRest_PulseMaximum_PulsePerformanceRuntimeAgeWeight);symbol v=dot color=red;run;quit;proc corr data=reg.b_fitness;var Run_Pulse Rest_Pulse Maximum_Pulse Performance Runtime Age Weight;with Oxygen_Consumption;run;三:模型选择CP法(全模型法)功能:在特定的模型⼤⼩范围内,找出指定的最佳模型(具有最⼩CP)BEST=N 表⽰在不同的变量个数组成的模型中,选择N个最好的模型,所有组合数为[2^(变量个数)-1]在由1个⾃变量组成的模型中选N个最好的在由2个⾃变量组成的模型中选N个最好的。

在由M(总共变量的个数)个⾃变量组成的模型中选N个最好的总共会选M*N个模型这⾥统计量为Cp,建议是Cp<=p ,p是所有变量个数加1逐步法向前回归法特点:和变量进⼊的顺序有很⼤关系,如果第⼀个进来的变量的解释效应过⼤,很可能造成后进的变量进不来模型引⼊第⼀个变量进⼊⽅程,对整个⽅程进⾏F检验,并对单个回归系数进⾏T检验,计算残差平⽅和Se1,如果通过检验则保留,否则剔除引⼊第⼆个变量进⼊⽅程,对整个⽅程进⾏F检验,并对单个回归系数进⾏T检验,计算残差平⽅和Se2,那么Se1>Se2,称Se1-Se2为第⼆个变量的偏回归平⽅和,如果该值明显偏⼤,则保留,说明其对因变量有影响,否则剔除。

第7章SAS统计相关与回归分析

第7章SAS统计相关与回归分析相关与回归分析是SAS统计的重要方法之一,用于研究变量之间的关系以及预测和解释变量的变化。

本文将介绍相关与回归分析的基本概念、方法和SAS的实现步骤。

相关分析是一种用来衡量两个或多个变量之间关系强度的统计方法。

它可以通过计算相关系数来量化这种关系。

相关系数的取值范围在-1到1之间,其中1表示完全正相关,-1表示完全负相关,0表示没有相关性。

常用的相关系数有皮尔逊相关系数和斯皮尔曼相关系数。

皮尔逊相关系数用于度量两个连续变量之间的线性关系,而斯皮尔曼相关系数则适用于度量有序变量之间的非线性关系或连续变量之间的非线性关系。

回归分析则是用来建立和预测两个或多个变量之间关系的方法。

它可以通过构建回归模型来找到自变量与因变量之间的最佳拟合线。

常用的回归模型有简单线性回归和多元线性回归。

简单线性回归是指只有一个自变量与一个因变量之间的关系,而多元线性回归则指有多个自变量与一个因变量之间的关系。

回归模型的好坏可以通过R方值来评估,其值越接近1表明模型的拟合度越好。

在SAS中进行相关与回归分析需要使用PROCCORR和PROCREG两个过程。

PROCCORR用于计算相关系数,而PROCREG则用于建立和拟合回归模型。

首先,我们使用PROCCORR过程计算相关系数。

以下是SAS代码示例:```proc corr data=dataset;var variable1 variable2;run;```其中,dataset代表数据集的名称,variable1和variable2代表需要计算相关系数的变量。

运行以上代码后,SAS会输出皮尔逊相关系数和斯皮尔曼相关系数的结果。

接下来,我们使用PROCREG过程进行回归分析。

以下是SAS代码示例:```proc reg data=dataset;model dependent = independent1 independent2;run;```其中,dependent代表因变量,independent1和independent2代表自变量。

SAS系统和数据分析一元线性回归分析

第三十一课一元线性回归分析回归分析是一种统计分析方法,它利用两个或两个以上变量之间的关系,由一个或几个变量来预测另一个变量。

在SAS/STA T中有多个进行回归的过程,如REG、GLM等,REG过程常用于进行一般线性回归模型分析。

一、回归模型1. 基本概念回归模型是一种正规工具,它表示统计关系中两个基本的内容:①用系统的形式表示因变量Y随一个或几个自变量X变化的趋势;②表现观察值围绕统计关系曲线的散布情况。

这两个特点是由下列假设决定的:●在与抽样过程相联系的观察值总体中,对应于每一个X值,存在Y的一个概率分布;这些概率分布的均值以一些系统的方式随X变化。

●图31.1是用透视的方法来显示回归曲线。

Y对给定X具有概率分布这一概念总是与统计关系中的经验分布形式上相对应;同样,描述概率分布的均值与X之间关系的回归曲线,与统计关系中Y系统地随X变化的一般趋势相对应。

图31.1线性回归模型的图示在回归模型中,X称为“自变量”,Y称为“因变量”;这只是传统的称法,并不表明在给定的情况下Y因果地依赖于X,无论统计关系多么密切,回归模型不一定是因果关系,在某些应用中,比如我们由温度表水银柱高度(自变量)来估计温度(因变量)时,自变量实际上依赖于因变量。

此外,回归模型的自变量可以多于一个。

2. 回归模型的构造(1)自变量的选择构造回归模型时必须考虑到易处理性,所以在有关的任何问题中,回归模型只能(或只应该)包括有限个自变量或预测变量。

(2) 回归方程的函数形式选择回归方程函数形式与选择自变量紧密相关。

有时有关理论可能指出适当的函数形式。

然而,通常我们预先并不能知道回归方程的函数形式,要在收集和分析数据后,才能确定函数形式。

我们经常使用线性和二次回归函数来作为未知性质回归方程的最初近似值。

图31.2(a)表示复杂回归函数可以由线性回归函数近似的情况,图31.2(b)表示复杂回归函数可以由两个线性回归函数分段近似的情况。

SAS整理下之相关分析和回归分析

SAS整理下之相关分析和回归分析相关分析1.⽤INSIGHT模块作相关分析先说⼀下建⽴数据集,找到题中的某句话的意思是,“为了弄清楚。

形成的原因,或者是为了分析。

的影响因素。

”找到这句话就成功⼀半了,将这个。

元素就写到Y的列下,其他的元素就设成X1 X2。

这样,有⼏个元素就⼏列,但是Y只有⼀列,⽽X就看题中给得了!!1. 制作散点图⾸先制作变量之间的散点图,以便判断变量之间的相关性。

步骤如下:1) 在INSIGHT模块中,打开数据集;2) 选择菜单“Analyze(分析)”→“Scatter Plot (Y X)(散点图)”;3) 在打开的“Scatter Plot (Y X)”对话框中选定Y变量:Y;选定X变量:x1、x2、x3、x4;4) 单击“OK”按钮,得到变量的分析结果。

从各散点的分布情况看,初步有⼀个跟每个元素的线性关系密切或不密切就⾏了。

2. 相关系数计算1) 在INSIGHT模块中,打开数据集;2) 选择菜单“Analyze(分析)”→“Multivariate (Y X)(多变量)”;3) 在打开的“Multivariate (Y X)”对话框中选定Y变量:Y;选定X变量:x1、x2、x3、x4;4) 单击“OK”按钮,得到分析结果。

结果显⽰各变量的统计量和相关(系数)矩阵,从相关矩阵中可以看出,相关系数⾼的就关系密切,相关系数低的就关系不密切。

5) 为了检验各总体变量的相关系数是否为零,选择菜单:“Tables”→“CORR p-values”,得到相关系数为零的原假设的p值,如图所⽰。

基于这些p值,拒绝原假设,即Y因素与其他⼏个变量之间均存在着显著的正相关关系;若p值>0.05,则⽆法拒绝原假设。

3. 置信椭圆继续上述步骤。

6) 选择菜单:“Curves”→“Scatter Plot Cont Ellipse”→“Prediction:95%”,得到Y与其他⼏个变量的散点图及预测值的置信椭圆变量Y和x1间散点图上的这个椭圆被拉得很长,表明变量Y和x1之间有很强的相关性。

SAS-4-回归与相关分析

一、利用SAS进行回归和相关分析 二、利用Excel的分析工具库进行回归

和相关分析

直线回归分析

直线回归分析(Linear Regression)是基于最小二 乘法(Least Square Method)原理产生的最优无偏 估计。

它是研究一个自变量(Independent)与一个因变 量(Dependent)之间是否存在某种线性关系的统 计学方法。

byx SPxy

b

2 yx

SS

x

SPx2y SS x

SSe SS y SSR

回归方程显著性检验的方差分析表

变异来源 回归 离回归 总平方和

平方和

SSR SSe SSy

自由度

dfR=1 dfe=n-2 dfy=n-1

均方 MSR=SSR/dfR MSe=SSe/dfe

F值 F=MSR/MSe

回归系数和回归截距的显著性检验

直线回归分析又叫简单回归分析(Simple Regression)。

回归分析基本公式

byx

SPxy SS x

,a

y byx x

SPxy (x x)( y y) ;

SS x (x x) 2

直线回归方程的显著性检验

SS y ( yˆ y) 2 ( yi yˆ ) 2

SS R

相关系数与协方差的计算

简单相关系数的基本公式

rxy

SPxy SSx SS y

SPxy (x x)(y y)

SSy ( y y)2

SSx (x x)2

CORREL( ) 函数

协方差的计算

协方差的基本公式

总体协方差

cov xy

SPxy n

样本协方差

(整理)SAS讲义第三十三课逐步回归分析.

第三十三课 逐步回归分析一、 逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的那些情况下,使用“最优”子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X 变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

本质上说,这种方法在每一步增加或剔除一个X 变量时,产生一系列回归模型。

增加或剔除一个X 变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F 统计量来表示。

无疑选择自变量要靠有关专业知识,但是作为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从有关专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F 水平,记作F in 和F out ,在每一步时,只有一个回归因子,比如说X i ,如果剔除它可能引起RSS 的减少不超过残差均方MSE (即ESS/(N-k-1))的F out 倍,则将它剔除;这就是在当前的回归模型中,用来检验 βi =0的F 比=MSE x x x RSS x x x x RSS i i i /)),,(),,,((121121---ΛΛ是小于或等于F out 。

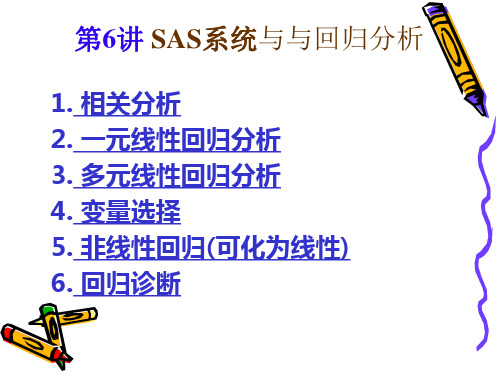

sas 课件第6讲 SAS系统与回归分析

简单线性回归模型

因变量Y和自变量x的n次观测数据(xi ,Yi) 可以用以下方程表示: Yi = 0 + 1 xi + i (i=1,2,. . .,n) Yi : 因变量的第 i 次观测值; xi : 自变量的第 i 次观测值;

0,1: 待估计的未知参数. 0是截距参数,它对应自变量为0时因变

35

一元线性回归分析

一元线性回归的计算--例子

•proc reg data=hbs.fitness ; • model oxygen = runtime ; •run; •proc reg data=hbs.fitness ; • model oxygen = runtime / p cli clm ; • id runtime; • output out=outfit p=poxy r=roxy • l95=l95oxy u95=u95oxy; •run;

相关系数(Correlation Coef.)

• 线性联系是描述变量间联系中最简单 和最常用的一种(Y=a1x1+a2x2+b);

• 相关系数是描述两个变量间线性联系 程度 的统计指标; • 相关系数的计算公式:

r

( X X )(Y Y ) ( X X ) (Y Y )

例:讨论英国11年有执照汽车数x(万辆)与车祸次数Y(千次)的

相关关系(数据见DATA步的数据行),并进行预测.

解:(1) 用编程,首先生成SAS数据集dreg.

data dreg; input year y x @@; cards; 1947 166 352 1948 153 1950 201 441 1951 216 1953 227 529 1954 238 1956 268 692 1957 274 ;

SAS第三十三课逐步回归分析

第三十三课 逐步回归分析一、 逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的那些情况下,使用“最优”子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X 变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

本质上说,这种方法在每一步增加或剔除一个X 变量时,产生一系列回归模型。

增加或剔除一个X 变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F 统计量来表示。

无疑选择自变量要靠有关专业知识,但是作为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从有关专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F 水平,记作F in 和F out ,在每一步时,只有一个回归因子,比如说X i ,如果剔除它可能引起RSS 的减少不超过残差均方MSE (即ESS/(N-k-1))的F out 倍,则将它剔除;这就是在当前的回归模型中,用来检验 βi =0的F 比=MSE x x x RSS x x x x RSS i i i /)),,(),,,((121121--- 是小于或等于F out 。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

SAS系统和数据分析逐步回归分析电子商务系列第三十三课逐步回归分析一、逐步回归分析在一个多元线性回归模型中,并不是所有的自变量都与因变量有显著关系,有时有些自变量的作用可以忽略。

这就产生了怎样从大量可能有关的自变量中挑选出对因变量有显著影响的部分自变量的问题。

在可能自变量的整个集合有40到60个,甚至更多的自变量的情况下,使用“最优”子集算法可能并不行得通。

那么,逐步产生回归模型要含有的X变量子集的自动搜索方法,可能是有效的。

逐步回归方法可能是应用最广泛的自动搜索方法。

这是在求适度“好”的自变量子集时,同所有可能回归的方法比较,为节省计算工作量而产生的。

从本质上说,这种方法在每一步增加或剔除一个X变量时,产生一系列回归模型。

增加或剔除一个X变量的准则,可以等价地用误差平方和缩减量、偏相关系数或F统计量来表示。

无疑选择自变量要靠有关专业知识,但是作电子商务系列 为起参谋作用的数学工具,往往是不容轻视的。

通常在多元线性模型中,我们首先从专业角度选择有关的为数众多的因子,然后用数学方法从中选择适当的子集。

本节介绍的逐步回归法就是人们在实际问题中常用的,并且行之有效的方法。

逐步回归的基本思想是,将变量一个一个引入,引入变量的条件是偏回归平方和经检验是显著的,同时每引入一个新变量后,对已选入的变量要进行逐个检验,将不显著变量剔除,这样保证最后所得的变量子集中的所有变量都是显著的。

这样经若干步以后便得“最优”变量子集。

逐步回归是这样一种方法,使用它时每一步只有一个单独的回归因子引进或从当前的回归模型中剔除。

Efroymoson (1966)编的程序中,有两个F 水平,记作F in 和F out ,在每一步时,只有一个回归因子,比如说X i ,如果剔除它可能引起RSS 的减少不超过残差均方MSE (即ESS/(N-k-1))的F out 倍,则将它剔除;这就是在当前的回归模型中,用来检验βi =0的F 比MSE x x x RSS x x x x RSS i i i /)),,(),,,((121121--- 是小于或等于F out 。

若剔除的变量需要选择,则就选择使RSS 减电子商务系列少最少的那一个(或等价的选择F比最小的)。

用这种方式如果没有变量被剔除,则开始引进一个回归因子,比如X j,如果引进它后使RSS的增加,至少是残差均方的F in倍,则将它引进。

即若在当前模型加X j项后,为了检验βj=0的F比,F ≥F in时,则引进X j,其次,若引进的变量需要选择,则选择F比最大的。

程序按照上面的步骤开始拟合,当没有回归因子能够引进模型时,该过程停止。

二、变量选择的方法若在回归方程中增加自变量X i,称为“引入”变量X i,将已在回归方程中的自变量X j从回归方程中删除,则称为“剔除”变量X j。

无论引入变量或剔除变量,都要利用F检验,将显著的变量引入回归方程,而将不显著的从回归方程中剔除。

记引入变量F检验的临界值为F in(进),剔除变量F检验的临界值为F out(出),一般取F in≥F out,它的确定原则一般是对k个自变量的m个(m≤k),对显著性水平df1=1,df2=1-N的F分布表-m的值,记为F*,则取F in=F out= F*。

一般来说,电子商务系列 也可以直接取F in =F out =2.0或2.5。

当然,为了回归方程中还能够多进入一些自变量,甚至也可以取为1.0或1.5。

1. 变量增加法首先对全部k 个自变量,分别对因变量Y 建立一元回归方程,并分别计算这k 个一元回归方程的k 个回归系数F 检验值,记为{11211,,kF F F },选其最大的记为1i F = max{11211,,k F F F },若有1iF ≥ F in ,则首先将X 1引入回归方程,不失一般性,设X i 就是X 1。

接着考虑X 1分别与X 2,X 3,...,X k 与因变量Y 组成二元回归方程,对于这k -1个回归方程中X 2,...,X k 的回归系数进行F 检验,计算F 值,并选其最大的F 值2j F ,若2jF ≥F in ,则接着就将X j 引入回归方程,不失一般性,设X j 就是X 2。

对已经引入回归方程的变量X 1和X 2,如同前面的方法做下去,直至所有未被引入方程的变量的F 值均小于F in 时为止。

这时的回归方程就是最终选定的回归方程。

显然,这种增加法有一定的缺点,主要是,它不能反映后来变化的情况。

因为对于某个自变电子商务系列 量,它可能开始是显著的,即将其引入到回归方程,但是,随着以后其他自变量的引入,它也可能又变为不显著了,但是,并没有将其及时从回归方程中剔除掉。

也就是增加变量法,只考虑引入而不考虑剔除。

2. 变量减少法与变量增加法相反,变量减少法是首先建立全部自变量X 1,X 2,...,X k 对因变量Y 的回归方程,然后对k 个回归系数进行F 检验,记求得的F 值为{11211,,k F F F },选其最小的记为1i F =min{11211,,k F F F },若有1iF ≤F out ,则可以考虑将自变量X i 从回归方程中剔除掉,不妨设X i 就取为X 1。

再对X 2,X 3,...,X k 对因变量Y 建立的回归方程重复上述过程,取最小的F 值为2j F ,若有2jF ≤F out ,则将X j 也从回归方程中剔除掉。

不妨设X j 就是X 2。

重复前面的做法,直至在回归方程中的自变量F 检验值均大于F out ,即没有变量可剔除为止。

这时的回归方程就是最终的回归方程。

这种减少法也有一个明显的缺点,就是一开始把全部变量都引入回归方程,这样计算量比较大。

若对一些不重要的变量,一开始就不引入,电子商务系列 这样就可以减少一些计算。

3. 变量增减法前面的两种方法各有其特点,若自变量X 1,X 2,...,X k 完全是独立的,则可结合这两种方法,但是,在实际的数据中,自变量X 1,X 2,...,X k 之间往往并不是独立的,而是有一定的相关性存在的,这就会使得随着回归方程中变量的增加和减少,某些自变量对回归方程的贡献也会发生变化。

因此一种很自然的想法是将前两种方法综合起来,也就是对每一个自变量,随着其对回归方程贡献的变化,它随时可能被引入回归方程或被剔除出去,最终的回归模型是在回归方程中的自变量均为显著,不在回归方程中的自变量均不显著。

三、 引入变量和剔除变量的依据如果在某一步时,已有l 个变量被引入到回归方程中,不妨设为lX X X ,,,21 ,即已得回归方程: ll X X X Y ββββ++++= 22110ˆ (33.1) 并且有平方和分解式:ESS RSS TSS += (33.2)显然,回归平方和RSS 及残差平方和ESS 均与引电子商务系列 入的变量相关。

为了使其意义更清楚起见,将其分别设为RSS (l X X X ,,,21 )及ESS (l X X X ,,,21 )。

下面我们来考虑,又有一个变量iX (l ≤i ≤k )被引入回归方程中,这时对于新的回归方程所对应的平方和分解式为:TSS = RSS (l X X X ,,,21 ,i X )+ ESS (l X X X ,,,21 , i X ) (33.3)当变量X i 引入后,回归平方和从RSS (l X XX ,,,21 )增加到RSS (l X X X ,,,21 ,iX ),而相应的残差平方和却从ESS (lX X X ,,,21 )降到ESS (l X X X ,,,21 , i X ),并有: RSS (l X XX ,,,21 , i X )-RSS (l X X X ,,,21 ) = ESS (l X X X ,,,21 )-ESS (l X X X ,,,21 , iX ) (33.4) 记),,,(),,,,(2121l i l i X X X RSS X X X X RSS W -=,它反映了由于引入i X 后,i X 对回归平方和的贡献,也等价于引入i X 后残差平方和所减少的量,称其为i X 对因变量Y 的方差贡献,故考虑检验统计量: ()()()1/,,,,,,,2121--=l N X X X X ESS X X X W F i l l i i (33.5) 其中N 为样本量,l 是已引入回归方程的变量个数,这时若有in i F F ≥,则可以考虑将自变量i X 引入回归方程,否则不能引入。

实际上大于F in 的变量开始时可能同时有几电子商务系列 个,那么是否将它们都全部引入呢?实际编程序时并不是一起全部引入,而是选其最大的一个引入回归方程。

关于剔除变量,如果已有l 个变量被引入回归方程,不失一般性,设其为l X X X ,,,21 ,所对应的平方和分解公式为: ),,,,(),,,,,(2121l i l i X X X X ESS X X X X RSS TSS += (33.6) 其中l i ,,2,1 =为了研究每个变量在回归方程中的作用,我们来考虑分别删掉X i (i =1,2,...,l 后相应的平方和分解公式为:),,,,,(),,,,(11211121l i i l i i X X X X X ESS X X X X X RSS TSS +-+-+= (33.7)这时,回归平方和从),,,,,(21l i X X X X RSS 降为),,,,(1121l i i X X X X X RSS +-,同时残差也发生相应的变化。

残差平方和从),,,,(21l i X X X X ESS 增加到),,,,,(1121l i i X X X X X ESS +-,i X 对回归平方和的贡献,也等价于删除i X 后残差平方和所增加的量,同理可表示为:),,,,(),,,,(),,,,(),,,,(211121112121l i l i i l i i l i i X X X X ESS X X X X X ESS X X X X X RSS X X X X RSS W -=-=+-+- (33.8) 同理,我们来构造检验统计量:()()()1/,,,,,,,,,2121--=l N X X X X ESS X X X X W F l i l i i i (33.9)电子商务系列显然,这时F i 越小,则说明iX 在回归方程中起的作用(对回归方程的贡献)越小,也就是若有out i F F ≤,则可以考虑将自变量iX 从回归方程中剔除掉,我们在编程序时,每次只剔除一个,因此,我们每次选择最小的),,,min(21l i F F F F=来与out F 进行比较。

若有out i F F>则可以不考虑剔除,而开始考虑引入。