生存分析-随机森林实验与代码

随机森林模型在生存分析中的应用

【摘要】目的:本文探讨随机森林方法用于高维度、强相关、小样本的生存资料分析时,可以起到变量筛选的作用。方法:以乳腺癌数据集构建乳腺癌转移风险评估模型为实例进行实证分析,使用随机森林模型进行变量选择,然后拟合cox回归模型。结果:随机森林模型通过对变量的选择,有效的解决数据维度高且强相关的情况,得到了较高的AUC值。

一、数据说明

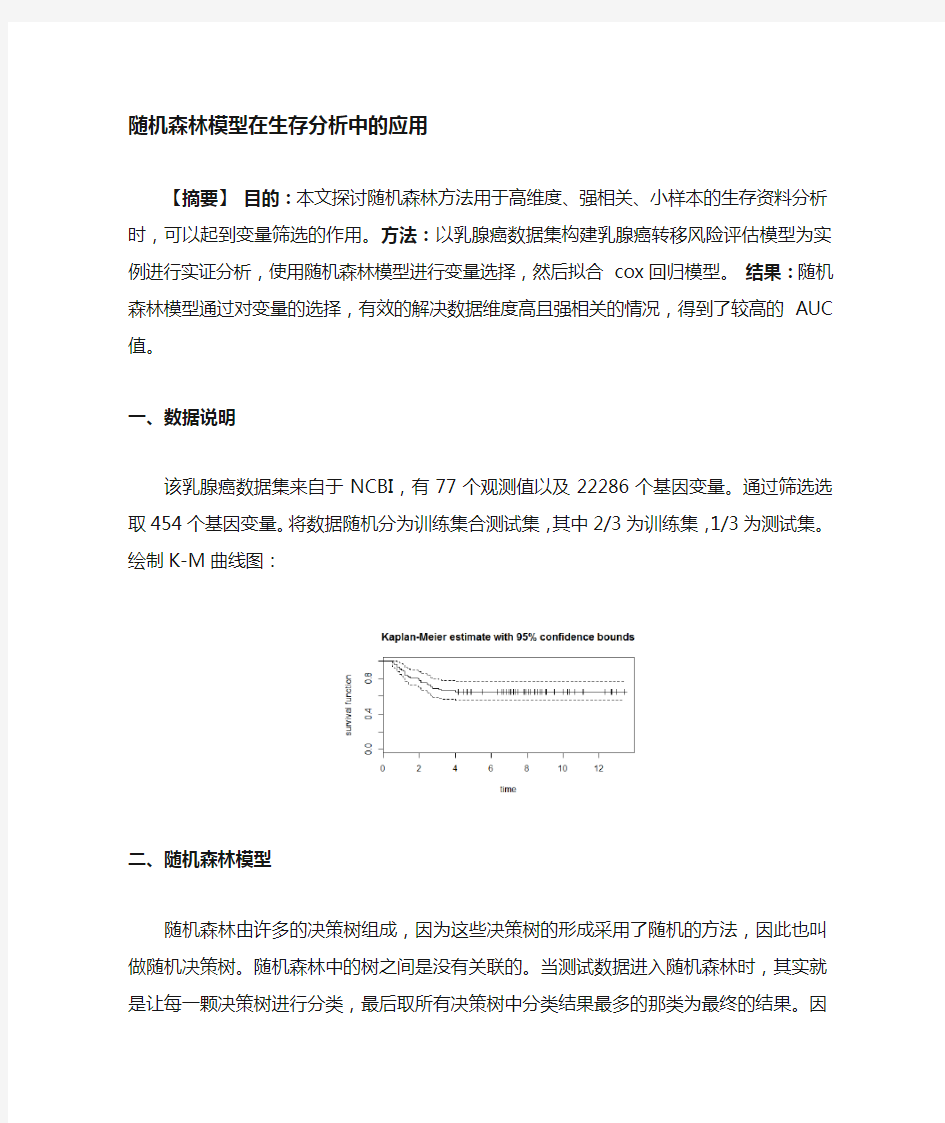

该乳腺癌数据集来自于NCBI,有77个观测值以及22286个基因变量。通过筛选选取454个基因变量。将数据随机分为训练集合测试集,其中2/3为训练集,1/3为测试集。绘制K-M曲线图:

二、随机森林模型

随机森林由许多的决策树组成,因为这些决策树的形成采用了随机的方法,因此也叫做随机决策树。随机森林中的树之间是没有关联的。当测试数据进入随机森林时,其实就是让每一颗决策树进行分类,最后取所有决策树中分类结果最多的那类为最终的结果。因此随机森林是一个包含多个决策树的分类器,并且其输出的类别是由个别树输出的类别的众数而定。

使用randomForestSRC包得到的随机森林模型具有以下性质:

Number of deaths: 27

Number of trees: 800

Minimum terminal node size: 3

Average no. of terminal nodes: 14.4275

No. of variables tried at each split: 3

Total no. of variables: 452

Analysis: RSF

Family: surv

Splitting rule: logrank

Error rate: 19.87%

发现直接使用随机森林得到的模型,预测误差很大,达到了19.8%,进一步考虑使用随机森林模型进行变量选择,结果如下:

> our.rf$rfsrc.refit.obj

Sample size: 52

Number of deaths: 19

Number of trees: 500

Minimum terminal node size: 2

Average no. of terminal nodes: 11.554

No. of variables tried at each split: 3

Total no. of variables: 9

Analysis: RSF

Family: surv

Splitting rule: logrank *random*

Number of random split points: 10

Error rate: 11.4%

> our.rf$topvars

[1] "213821_s_at""219778_at""204690_at""220788_s_at""202202_s_at" [6] "211603_s_at""213055_at""219336_s_at""37892_at"

一共选取了9个变量,同时误差只有11.4%

接下来,使用这些变量做cox回归,剔除模型中不显著(>0.01)的变量,最终参与模型建立的变量共有4个。模型结果如下:

exp(coef) exp(-coef) lower .95 upper .95

`218150_at` 1.6541 0.6046 0.11086 24.6800

`200914_x_at` 0.9915 1.0086 0.34094 2.8833

`220788_s_at` 0.2649 3.7750 0.05944 1.1805

`201398_s_at` 1.7457 0.5729 0.33109 9.2038

`201719_s_at` 2.4708 0.4047 0.93808 6.5081

`202945_at` 0.4118 2.4284 0.03990 4.2499

`203261_at` 3.1502 0.3174 0.33641 29.4983

`203757_s_at` 0.7861 1.2720 0.61656 1.0024

`205068_s_at` 0.1073 9.3180 0.02223 0.5181

最后选取六个变量拟合生存模型,绘制生存曲线如下:

下面绘制ROC曲线,分别在训练集和测试集上绘制ROC曲线,结果如下:训练集:

测试集:

由于测试集上的样本过少,所以得到的AUC值波动大,考虑使用bootstrap 多次计算训练集上的AUC值并求平均来测试模型的效果:

AUC at 1 year:0.8039456

AUC at 3 year:0.6956907

AUC at 5 year:0.7024846

由此可以看到,随机森林通过删除贡献较低的变量,完成变量选择的工作,在测试集上具有较高的AUC值,但是比lasso-cox模型得到的AUC略低。

附录:

load("~/R/brea.rda")

library(survival)

set.seed(10)

i<-sample(1:77,52)

train<-dat[i,]

test<-dat[-i,]

library(randomForestSRC)

disease.rf<-rfsrc(Surv(time,status)~.,data = train,

ntree = 800,mtry = 3,

nodesize = 3,splitrule = "logrank")

disease.rf

our.rf<- var.select(object=disease.rf, vdv,

method = "vh.vimp", nrep = 50)

our.rf$rfsrc.refit.obj

our.rf$topvars

index<-numeric(var.rf$modelsize)

for(i in 1:var.rf$modelsize){

index[i]<-which(names(dat)==var.rf$topvars[i])

}

data<-dat[,c(1,2,index)]

i<-sample(1:77,52)

train<-data[i,]

test<-data[-i,]

mod.brea<-coxph(Surv(time,status)~.,data=train)

train_data<-train[,c(1,2,which(summary(mod.brea)$coefficients[,5]<=0.1)+2)]

tset_data<-test[,c(1,2,which(summary(mod.brea)$coefficients[,5]<=0.1)+2)]

mod.brea1<-coxph(Surv(time,status)~.,data=train_data)

summary(mod.brea1)

names(coef(mod.brea1))

plot(survfit(mod.brea1),xlab="Time",ylab = "Proportion",main="Cox Model",conf.int=TRUE,col=c("black","red","red"),ylim=c(0.6,1))

index0<-numeric(length(coef(mod.brea1)))

coefficients<-coef(mod.brea1)

name<-gsub("\`","",names(coefficients))

for(j in 1:length(index0)){

index0[j]<-which(names(dat)==name[j])

}

library(survivalROC)

riskscore<-as.matrix(dat[i,index0])%*% as.matrix(coefficients)

y1<-survivalROC(Stime=train$time,status=train$status,marker=riskscore,predict.time =1,span = 0.25*(nrow(train))^(-0.20))

y3<-survivalROC(Stime=train$time,status=train$status,marker=riskscore,predict.time =3,span = 0.25*(nrow(train))^(-0.20))

y5<-survivalROC(Stime=train$time,status=train$status,marker=riskscore,predict.time =5,span = 0.25*(nrow(train))^(-0.20))

a<-matrix(data=c("y1","y3","y5",y1$AUC,y3$AUC,y5$AUC),nrow=3,ncol=2);a

plot(y1$FP,y1$TP,type="l",xlab="False Positive Rate",ylab = "True Positive Rate",main="Time-dependent ROC curve",col="green")

lines(y3$FP,y3$TP,col="red",lty=2)

lines(y5$FP,y5$TP,col="blue",lty=3)

legend("bottomright",bty="n",legend = c("AUC at 1 year:0.9271","AUC at 3 years:0.8621","AUC at 5 years:0.8263"),col=c("green","red","blue"),lty=c(1,2,3),cex=0.9)

abline(0,1)

riskscore<-as.matrix(dat[-i,index0])%*% as.matrix(coefficients)

y1<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time= 1,span = 0.25*(nrow(train))^(-0.20))

y3<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time= 3,span = 0.25*(nrow(train))^(-0.20))

y5<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time= 5,span = 0.25*(nrow(train))^(-0.20))

a<-matrix(data=c("y1","y3","y5",y1$AUC,y3$AUC,y5$AUC),nrow=3,ncol=2);a

plot(y1$FP,y1$TP,type="l",xlab="False Positive Rate",ylab = "True Positive Rate",main="Time-dependent ROC curve",col="green")

lines(y3$FP,y3$TP,col="red",lty=2)

lines(y5$FP,y5$TP,col="blue",lty=3)

legend("bottomright",bty="n",legend = c("AUC at 1 year:0.8761","AUC at 3 years:0.7611","AUC at 5 years:0.7611"),col=c("green","red","blue"),lty=c(1,2,3),cex=0.9)

abline(0,1)

a<-matrix(0,30,3)

for (c in 1:30){

i<-sample(1:77,52)

train<-data[i,]

test<-data[-i,]

mod.brea<-coxph(Surv(time,status)~.,data=train)

train_data<-train[,c(1,2,which(summary(mod.brea)$coefficients[,5]<=0.1)+2)]

tset_data<-test[,c(1,2,which(summary(mod.brea)$coefficients[,5]<=0.1)+2)] mod.brea1<-coxph(Surv(time,status)~.,data=train_data)

names(coef(mod.brea1))

index0<-numeric(length(coef(mod.brea1)))

coefficients<-coef(mod.brea1)

name<-gsub("\`","",names(coefficients))

for(j in 1:length(index0)){

index0[j]<-which(names(dat)==name[j])

}

riskscore<-as.matrix(dat[-i,index0])%*% as.matrix(coefficients)

y1<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time= 1,span = 0.25*(nrow(train))^(-0.20))

y3<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time=

3,span = 0.25*(nrow(train))^(-0.20))

y5<-survivalROC(Stime=test$time,status=test$status,marker=riskscore,predict.time= 5,span = 0.25*(nrow(train))^(-0.20))

a[c,]<-c(y1$AUC,y3$AUC,y5$AUC)

}

随机信号分析实验报告

一、实验名称 微弱信号的检测提取及分析方法 二、实验目的 1.了解随机信号分析理论如何在实践中应用 2.了解随机信号自身的特性,包括均值、方差、相关函数、频谱及功率谱密度等 3.掌握随机信号的检测及分析方法 三、实验原理 1.随机信号的分析方法 在信号与系统中,我们把信号分为确知信号和随机信号。其中随机信号无确定的变化规律,需要用统计特新进行分析。这里我们引入随机过程的概念,所谓随机过程就是随机变量的集合,每个随机变量都是随机过程的一个取样序列。 随机过程的统计特性一般采用随机过程的分布函数和概率密度来描述,他们能够对随机过程作完整的描述。但由于在实践中难以求得,在工程技术中,一般采用描述随机过程的主要平均统计特性的几个函数,包括均值、方差、相关函数、频谱及功率谱密度等来描述它们。本实验中算法都是一种估算法,条件是N要足够大。 2.微弱随机信号的检测及提取方法 因为噪声总会影响信号检测的结果,所以信号检测是信号处理的重要内容之一,低信噪比下的信号检测是目前检测领域的热点,而强噪声背景下的微弱信号提取又是信号检测的难点。 噪声主要来自于检测系统本身的电子电路和系统外空间高频电磁场干扰等,通常从以下两种不同途径来解决 ①降低系统的噪声,使被测信号功率大于噪声功率。 ②采用相关接受技术,可以保证在信号功率小于噪声功率的情况下,人能检测出信号。 对微弱信号的检测与提取有很多方法,常用的方法有:自相关检测法、多重自相法、双谱估计理论及算法、时域方法、小波算法等。 对微弱信号检测与提取有很多方法,本实验采用多重自相关法。 多重自相关法是在传统自相关检测法的基础上,对信号的自相关函数再多次做自相关。即令: 式中,是和的叠加;是和的叠加。对比两式,尽管两者信号的幅度和相位不同,但频率却没有变化。信号经过相关运算后增加了信噪比,但其改变程度是有限的,因而限制了检测微弱信号的能力。多重相关法将 当作x(t),重复自相关函数检测方法步骤,自相关的次数越多,信噪比提高的越多,因此可检测出强噪声中的微弱信号。

北理工随机信号分析实验报告

本科实验报告实验名称:随机信号分析实验

实验一 随机序列的产生及数字特征估计 一、实验目的 1、学习和掌握随机数的产生方法。 2、实现随机序列的数字特征估计。 二、实验原理 1、随机数的产生 随机数指的是各种不同分布随机变量的抽样序列(样本值序列)。进行随机信号仿真分析时,需要模拟产生各种分布的随机数。 在计算机仿真时,通常利用数学方法产生随机数,这种随机数称为伪随机数。伪随机数是按照一定的计算公式产生的,这个公式称为随机数发生器。伪随机数本质上不是随机的,而且存在周期性,但是如果计算公式选择适当,所产生的数据看似随机的,与真正的随机数具有相近的统计特性,可以作为随机数使用。 (0,1)均匀分布随机数是最最基本、最简单的随机数。(0,1)均匀分布指的是在[0,1]区间上的均匀分布,即 U(0,1)。实际应用中有许多现成的随机数发生器可以用于产生(0,1)均匀分布随机数,通常采用的方法为线性同余法,公式如下: )(m od ,110N ky y y n n -= N y x n n /= 序列{}n x 为产生的(0,1)均匀分布随机数。 下面给出了上式的3组常用参数: 1、10 N 10,k 7==,周期7 510≈?; 2、(IBM 随机数发生器)31 16 N 2,k 23,==+周期8 510≈?; 3、(ran0)31 5 N 21,k 7,=-=周期9 210≈?; 由均匀分布随机数,可以利用反函数构造出任意分布的随机数。 定理 1.1 若随机变量 X 具有连续分布函数F X (x),而R 为(0,1)均匀分布随机变量,则有 )(1R F X x -= 由这一定理可知,分布函数为F X (x)的随机数可以由(0,1)均匀分布随机数按上式进行变

生存分析-随机森林实验与代码

随机森林模型在生存分析中的应用 【摘要】目的:本文探讨随机森林方法用于高维度、强相关、小样本的生 存资料分析时,可以起到变量筛选的作用。方法:以乳腺癌数据集构建乳腺癌转 移风险评估模型为实例进行实证分析, 使用随机森林模型进行变量选择,然后拟 合cox 回归模型。 结果:随机森林模型通过对变量的选择,有效的解决数据维 度高且强相关的情况,得到了较高的 AUC 值。 一、数据说明 该乳腺癌数据集来自于NCBI ,有77个观测值以及22286个基因变量。通过 筛选选取454个基因变量。将数据随机分为训练集合测试集,其中2/3为训练集, 1/3为测试集。绘制K-M 曲线图: 二、随机森林模型 随机森林由许多的决策树组成,因为这些决策树的形成采用了随机的方法, 因此也叫做随机决策树。随机森林中的树之间是没有关联的。当测试数据进入随 机森林时,其实就是让每一颗决策树进行分类,最后取所有决策树中分类结果最 多的那类为最终的结果。因此随机森林是一个包含多个决策树的分类器, 并且其 输出的类别是由个别树输出的类别的众数而定 使用randomForestSRC 包得到的随机森林模型具有以下性质: Kaplan-Meker estlmaie wHh 95% conndence bounds S ?2 S

Number of deaths: 27 Number of trees: 800 Mini mum term inal node size: 3 Average no. of term inal no des: 14.4275 No. of variables tried at each split: 3 Total no. of variables: 452 Analysis: RSF Family: surv Splitting rule: logrank Error rate: 19.87% 发现直接使用随机森林得到的模型,预测误差很大,达到了19.8%进一步考虑使用随机森林模型进行变量选择,结果如下: > our.rf$rfsrc.refit.obj Sample size: 52 Number of deaths: 19 Number of trees: 500 Minimum terminal node size: 2 Average no. of term inal no des: 11.554 No. of variables tried at each split: 3 Total no. of variables: 9 Analysis: RSF Family: surv Splitting rule: logrank *random* Number of random split points: 10 Error rate: 11.4% > our.rf$topvars [1] "213821_s_at" "219778_at" "204690_at" "220788_s_at" "202202_s_at" [6] "211603_s_at" "213055_at" "219336_s_at" "37892_at" 一共选取了9个变量,同时误差只有11.4% 接下来,使用这些变量做cox回归,剔除模型中不显著(>0.01 )的变量,最终 参与模型建立的变量共有4个。模型结果如下: exp(coef) exp(-coef) lower .95 upper .95 '218150_at' 1.6541 0.6046 0.11086 24.6800 '200914_x_at' 0.9915 1.0086 0.34094 2.8833 '220788_s_at' 0.2649 3.7750 0.05944 1.1805 '201398_s_at' 1.7457 0.5729 0.33109 9.2038 '201719 s at' 2.4708 0.4047 0.93808 6.5081

随机森林

学习算法 根据下列算法而建造每棵树: 1. 用N 来表示训练例子的个数,M表示变量的数目。 2. 我们会被告知一个数m ,被用来决定当在一个节点上做决定时,会使用到多少个变量。m应小于M 3. 从N个训练案例中以可重复取样的方式,取样N次,形成一组训练集(即bootstrap取样)。并使用这棵树来对剩余预测其类别,并评估其误差。 4. 对于每一个节点,随机选择m个基于此点上的变量。根据这m 个变量,计算其最佳的分割方式。 5. 每棵树都会完整成长而不会剪枝(Pruning)(这有可能在建完一棵正常树状分类器后会被采用)。 优点 随机森林的优点有: 1. 对于很多种资料,它可以产生高准确度的分类器。 2. 它可以处理大量的输入变量。 3. 它可以在决定类别时,评估变量的重要性。 4. 在建造森林时,它可以在内部对于一般化后的误差产生不偏差的估计。 5. 它包含一个好方法可以估计遗失的资料,并且,如果有很大一部分的资料遗失,仍可以维持准确度。 6. 它提供一个实验方法,可以去侦测variable interactions 。 7. 对于不平衡的分类资料集来说,它可以平衡误差。 8. 它计算各例中的亲近度,对于数据挖掘、侦测偏离者(outlier)和将资料视觉化非常有用。 9. 使用上述。它可被延伸应用在未标记的资料上,这类资料通常是使用非监督式聚类。也可侦测偏离者和观看资料。 10. 学习过程是很快速的。 缺点 1. 随机森林已经被证明在某些噪音较大的分类或回归问题上会过拟 2. 对于有不同级别的属性的数据,级别划分较多的属性会对随机森林产生更大的影响,所以随机森林在这种数据上产出的属性权值是不可信的。

随机信号分析上机实验指导书

目录 实验1 离散随机变量的仿真与计算(验证性实验) (1) 实验2 离散随机信号的计算机仿真(验证性实验) (5) 实验3 随机信号平稳性分析(验证性实验) (8) 实验4 实验数据分析(综合性实验) (10) 实验5 窄带随机过程仿真分析 (验证性实验) (11) 实验6 高斯白噪声通过线性系统分析(综合实验) (13)

实验1 离散随机变量的仿真与计算(验证性实验) 一、实验目的 掌握均匀分布的随机变量产生的常用方法。 掌握由均匀分布的随机变量产生任意分布的随机变量的方法。 掌握高斯分布随机变量的仿真,并对其数字特征进行估计。 二、实验步骤 无论是系统数学模型的建立,还是原始实验数据的产生,最基本的需求就是产生一个所需分布的随机变量。比如在通信与信息处理领域中,电子设备的热噪声,通信信道的畸变,图像中的灰度失真等都是遵循某一分布的随机信号。在产生随机变量时候,虽然运算量很大,但是基本上都是简单的重复,利用计算机可以很方便的产生不同分布的随机变量。各种分布的随机变量的基础是均匀分布的随机变量。有了均匀分不得阿随机变量,就可以用函数变换等方法得到其他分布的随机变量。 1.均匀分布随机数的产生 利用混合同余法产生均匀分布的随机数,并显示所有的样本,如图1所示。 yn+1=ayn+c (mod M) xn+1=yn+1/M

2.高斯分布随机数的仿真 根据随机变量函数变换的原理,如果能将两个分布之间的函数关系用显式表达,那么就可以利用一种分布的随机变量通过变换得到另一种分布的随机变量。 若X 是分布函数为FX (x )的随机变量,且分布函数FX (x )为严格单调升函数,令Y=FX (x ),则Y 必是在[0,1]上均匀分布的随机变量。繁殖,若Y 是在[0,1]上均匀分布的随机变量,那么 X=F-1X(Y) (1.4.5) 就是分布函数为FX (x )的随机变量。这样,欲求某个分布的随机变量,先产生[0,1]区间上的均匀分布随机数,在经过(1.4.5)的变换,便可以求得所需要分布的随机数, 产生指数分布的随机数 fX(x)=ae-ax Y=FX(X)=1-e-aX X=-ln(1-Y)/a 利用函数变换法产生高斯分布的随机数的方法 : 图1-1生成均匀分布随机数的结果

随机森林

随机森林 定义:随机森林是一个分类器,它有一系列的单株树决策器{h (X,,θk );k=1,......} 来组成,其中{θk }是独立同分布的随机变量。再输入X 时,每一棵树只投一票给它认为最合适的类。在机器学习中,随机森林是一个包含多个决策树的分类器, 并且其输出的类别是由个别树输出的类别的众数而定,构成随机森林的基础分类器称为决策树。 Leo Breiman 和Adele Cutler 发展出推论出随机森林的算法。 这个术语是1995年由贝尔实验室的Tin Kam Ho 所提出的随机决策森林(random decision forests )而来的。这个方法则是结合 Breimans 的 "Bootstrap aggregating" 想法和 Ho 的"random subspace method"" 以建造决策树的集合。 随机森林是一个组合分类器,构成随机森林的基础分类器是决策树。 决策树算法 决策树可以视为一个树状预测模型,它是由结点和有向边组成的层次结构。树中包含3个节点:根节点。内部节点,终节点(叶子节点)。决策树只有一个根节点,是全体训练集的结合。树中的每个内部节点都是一个分裂问题,它将到达该节点的样本按某个特定的属性进行分割,可以将数据集合分割成2块或若干块。每个终结点(叶子节点)是带有分裂标签的数据集合,从决策树的根节点到叶子节点的每一条路径都形成一个类;决策树的算法很多,例如ID3算法,CART 算法等。这些算法均采用自上而下的贪婪的算法,每个内部节点选择分类效果最好的属性进行分裂节点,可以分为两个或若干个子节点,继续此过程到这可决策树能够将全部训练数据准确的分类,或所有属性都被用到为止。具体步骤如下: 1)假设T 为训练样本集。 2)选择一个最能区分T 中样本的一个属性。 3)创建一个数的节点,它的值是所选择的属性,创建此节点的子节点,每个子链代表所选属性的唯一值,适用子链的值进一步将样本细分为子类。 对于3)创建的三个子类 (1)如果子类的样本满足预定义的标准,或者树的这条路的剩余可选属性集为空,为沿此路径的新的样本指定类别。 (2)如果子类不满足于定义的标准,或者至少有一个属性能细分树的路径,设T 为当前子类样本的集合,返回步骤2),以下简单的给出二分树的结构图示: 根节点 中间节点 叶节点 规则1 叶节点 规则2 中间节点

随机信号处理实验

随机信号处理实验 专业:电子信息科学与技术 班级: 学号: 学生姓名: 指导教师:钱楷

一、实验目的 1、熟悉GUI 格式的编程及使用。 2、掌握随机信号的简单分析方法 3、熟悉语音信号的播放、波形显示、均值等的分析方法及其编程 3、熟悉各种随机信号分析及处理方法。 4、掌握运用MATLAB 中的统计工具包和信号处理工具包绘制概率密度的方法 二、实验原理 1、语音的录入与打开 在MATLAB 中,[y,fs,bits]=wavread('Blip',[N1 N2]);用于读取语音,采样值放在向量y 中,fs 表示采样频率(Hz),bits 表示采样位数。[N1 N2]表示读取从N1点到N2点的值。 2、高斯白噪声 白噪声信号是一个均值为零的随机过程,任一时刻是均值为零的随机变量,而服从高斯分布的白噪声即称为高斯白噪声。在matlab 中,有x=rand (a ,b )产生均匀白噪声序列的函数,通过与语言信号的叠加来分析其特性。 3、均值 随机变量X 的均值也称为数学期望,它定义为:,对于离散型随机变量,假定随机变量X 有N 个可能取值,各个取值的概率为,则均值定义为E(X)=,离散型随机变量的均值等于随机变量的取值乘以取值的概率之和,如果取值是等概率的,那么均值就是取值的算术平均值,如果取值不是等概率的,那么均值就是概率加权和,所以,均值也称为统计平均值。 4、方差 定义为随机过程x(t)的方差。方差通常也记为 D[X (t )] ,随机过程的方差也是时间 t 的函数, 由方差的定义可以看出,方差是非负函数。 5、协方差 设两个随机变量X 和Y ,定义:为X 和Y 的协方差。其相关函数为: ?? +∞∞-+∞ ∞ -= =dxdy t t y x xyf t Y t X E t t R XY XY ),,,()}()({),(212121 由此可见协方差的相关性 与X 和Y 是密切相关的,表征两个函数变化的相似性。 5、协方差 设任意两个时刻1t , 2t ,定义: 为随机过程X (t )的自相关函数,简称为相关函数。自相关函数可正,可负,其绝对值越大表示相关性越强。 7、互相关 互相关函数定义为: 如果X (t )与Y (t )是相互独立的,则一定是不相关的。反之则不一定成立。它是两个随机过程联合统计特性中重要的数字特征。 8、平滑滤波 平滑滤波可以与中值滤波结合使用,对应的线性平滑器可以仅仅用低阶的低通滤波器(如果采用高阶的系统,则将抹掉信号中应该保存的不连续性)。 121212121212 (,)[()()](,,,)X R t t E X t X t x x f x x t t dx dx +∞+∞-∞ -∞ ==???? +∞∞-+∞ ∞ -==dxdy t t y x xyf t Y t X E t t R XY XY ),,,()}()({),(212121

随机信号分析实验报告二 2

《随机信号分析》实验报告二 班级: 学号: 姓名:

实验二高斯噪声的产生和性能测试 1.实验目的 (1)掌握加入高斯噪声的随机混合信号的分析方法。 (2)研究随机过程的均值、相关函数、协方差函数和方差。 ⒉实验原理 (1)利用随机过程的积分统计特性,给出随机过程的均值、相关函数、协方差函数和方差。 (2)随机信号均值、方差、相关函数的计算公式,以及相应的图形。 ⒊实验报告要求 (1)简述实验目的及实验原理。 (2)采用幅度为1,频率为25HZ的正弦信号错误!未找到引用源。为原信号,在其中加入均值为2,方差为0.04的高斯噪声得到混合随机信号X(t)。 试求随机过程 的均值、相关函数、协方差函数和方差。用MATLAB进行仿真,给出测试的随机过程的均值、相关函数、协方差函数和方差图形,与计算的结果作比较,并加以解释。 (3)分别给出原信号与混合信号的概率密度和概率分布曲线,并以图形形式分别给出原信号与混合信号均值、方差、相关函数的对比。 (4)读入任意一幅彩色图像,在该图像中加入均值为0,方差为0.01的高斯噪声,请给出加噪声前、后的图像。 (5)读入一副wav格式的音频文件,在该音频中加入均值为2,方差为0.04的高斯噪声,得到混合随机信号X(t),请给出混合信号X(t)的均值、相关函数、协方差函数和方差,频谱及功率谱密度图形。 4、源程序及功能注释 (2)源程序: clear all; clc; t=0:320; %t=0:320 x=sin(2*pi*t/25); %x=sin(2*p1*t/25) x1=wgn(1,321,0); %产生一个一行32列的高斯白噪声矩阵,输出的噪声强度为0dbw

随机森林原理解释与其中各个参数地含义中文解释

一、RF原理解释: 首先,从给定的训练集通过多次随机的可重复的采样得到多个bootstrap 数据集。接着,对每个 bootstrap 数据集构造一棵决策树,构造是通过迭代的将数据点分到左右两个子集中实现的,这个分割过程是一个搜 索分割函数的参数空间以寻求最大信息增量意义下最佳参数的过程。然后,在每个叶节点处通过统计训练 集中达到此叶节点的分类标签的直方图经验的估计此叶节点上的类分布。这样的迭代训练过程一直执行到 用户设定的最大树深度(随机森林提出者Breiman采用的是 ntree=500 )或者直到不能通过继续分割获取更 大的信息增益为止,网上的代码中作者都是对树的最大深度设置了最大值。 二、函数,参数的中文解释 function model = classRF_train(X,Y,ntree,mtry, extra_options) 随机森林中模型的训练 X, 表示输入的数据矩阵 Y 输出 Ntree 设置的树的数目 Mtry 的默认值为 floor(sqrt(size(X,2)) ,表示不超过矩阵X列数的二次开根值的整数。 extra_options 包含很多控制RF的项 取值为 1或0,默认值为1,表示是否做变量替换 表示预先知道的类,函数首先得到一个升序排列的标签然后给先前的类 同样的排序。 只在分类器中使用的一个向量,长度等于类的数目。对类的观察值是取 对cutoff 投票占的的最大比例的一个。 用于分层抽样 样本的长度 表示终端节点的最小值,这个参数设置得越大会使更小的树生长,耗 时更少。 判断是否需要对预测器的importance 进行评估 决定是否对casewise 的重要性度量进行计算 判别是否计算行之间的距离 判断是否计算out-of-bag 如果设定为TRUE,当随机森林运行的时候输出更多冗长的数据。如果 设置为一些整数,输出每个追踪树。 通过树的数目矩阵跟踪每个样本在树上的in-bag 。 norm_votes 统计每一类的投票数 importance 对于分类器来说是一个列数等于类别数加二,第一列计算精度下降值。在ncalss+1列表示所有类平均精度减少值。最后一列表示Gini 指数平均减小值。在随机森林用于回归的应用 中importance 表示的含义又不一样,我们只用到分类的作用,所以对回归的含义不做介绍。importanceSD 标准差 localImp 包含importance 标准化残差测量值的矩阵 ntree 生长的树的数目 mtry 在每一个分裂节点处样本预测器的个数。 Votes 一个矩阵,行表示每一个输入数据点,列表示每一类,记录投票数。 Proximity 如果proximity=TRUE 表示随机森林被调用。

随机森林算法

随机森林算法 1.算法简介 随机森林由LeoBreiman(2001)提出,它通过自助法(bootstrap)重采样技术,从原始训练样本集N中有放回地重复随机抽取k个样本生成新的训练样本集合,然后根据自助样本集生成k个分类树组成随机森林,新数据的分类结果按分类树投票多少形成的分数而定。其实质是对决策树算法的一种改进,将多个决策树合并在一起,每棵树的建立依赖于一个独立抽取的样品,森林中的每棵树具有相同的分布,分类误差取决于每一棵树的分类能力和它们之间的相关性。特征选择采用随机的方法去分裂每一个节点,然后比较不同情况下产生的误差。能够检测到的内在估计误差、分类能力和相关性决定选择特征的数目。单棵树的分类能力可能很小,但在随机产生大量的决策树后,一个测试样品可以通过每一棵树的分类结果经统计后选择最可能的分类。 2.算法原理 决策树(decision tree)是一个树结构(可以是二叉树或非二叉树)。其每个非叶节点表示一个特征属性上的测试,每个分支代表这个特征属性在某个值域上的输出,而每个叶节点存放一个类别。使用决策树进行决策的过程就是从根节点开始,测试待分类项中相应的特征属性,并按照其值选择输出分支,直到到达叶子节点,将叶子节点存放的类别作为决策结果。 随机森林模型的基本思想是:首先,利用bootstrap抽样从原始训练集抽取k 个样本,且每个样本的样本容量都与原始训练集一样;其次,对k个样本分别建立k个决策树模型,得到k种分类结果;最后,根据k种分类结果对每个记录进行投票表决决定其最终分类,如下图所示。 在建立每一棵决策树的过程中,有两点需要注意采样与完全分裂。首先是两个随机采样的过程,random forest对输入的数据要进行行、列的采样。对于行采样,采用有放回的方式,也就是在采样得到的样本集合中,可能有重复的样本。

随机信号实验报告

随机信号分析 实验报告 目录 随机信号分析 (1) 实验报告 (1) 理想白噪声和带限白噪声的产生与测试 (2) 一、摘要 (2) 二、实验的背景与目的 (2) 背景: (2) 实验目的: (2) 三、实验原理 (3) 四、实验的设计与结果 (4) 实验设计: (4) 实验结果: (5) 五、实验结论 (12) 六、参考文献 (13) 七、附件 (13) 1

理想白噪声和带限白噪声的产生与测试一、摘要 本文通过利用MATLAB软件仿真来对理想白噪声和带限白噪声进行研究。理想白噪声通过低通滤波器和带通滤波器分别得到低通带限白噪声和帯通带限白噪声。在仿真的过程中我们利用MATLAB工具箱中自带的一些函数来对理想白噪声和带限白噪声的均值、均方值、方差、功率谱密度、自相关函数、频谱以及概率密度进行研究,对对它们进行比较分析并讨论其物理意义。 关键词:理想白噪声带限白噪声均值均方值方差功率谱密度自相关函数、频谱以及概率密度 二、实验的背景与目的 背景: 在词典中噪声有两种定义:定义1:干扰人们休息、学习和工作的声音,引起人的心理和生理变化。定义2:不同频率、不同强度无规则地组合在一起的声音。如电噪声、机械噪声,可引伸为任何不希望有的干扰。第一种定义是人们在日常生活中可以感知的,从感性上很容易理解。而第二种定义则相对抽象一些,大部分应用于机械工程当中。在这一学期的好几门课程中我们都从不同的方面接触到噪声,如何的利用噪声,把噪声的危害减到最小是一个很热门的话题。为了加深对噪声的认识与了解,为后面的学习与工作做准备,我们对噪声进行了一些研究与测试。 实验目的: 了解理想白噪声和带限白噪声的基本概念并能够区分它们,掌握用MATLAB 或c/c++软件仿真和分析理想白噪声和带限白噪声的方法,掌握理想白噪声和带限白噪声的性质。

随机森林原理解释及其中各个参数的含义中文解释

随机森林原理解释及其中各个参数的含义中文 解释 The document was finally revised on 2021

一、RF原理解释: 首先,从给定的训练集通过多次随机的可重复的采样得到多个 bootstrap 数据集。接着,对每个bootstrap 数据集构造一棵决策树,构造是通过迭代的将数据点分到左右两个子集中实现的,这个分割过程是一个搜索分割函数的参数空间以寻求最大信息增量意义下最佳参数的过程。然后,在每个叶节点处通过统计训练集中达到此叶节点的分类标签的直方图经验的估计此叶节点上的类分布。这样的迭代训练过程一直执行到用户设定的最大树深度(随机森林提出者Breiman采用的是ntree=500)或者直到不能通过继续分割获取更大的信息增益为止,网上的代码中作者都是对树的最大深度设置了最大值。 二、函数,参数的中文解释 function model = classRF_train(X,Y,ntree,mtry, extra_options) 随机森林中模型的训练 X,表示输入的数据矩阵 Y输出 Ntree 设置的树的数目 Mtry的默认值为 floor(sqrt(size(X,2)),表示不超过矩阵X列数的二次开根值的整数。 extra_options 包含很多控制RF的项 取值为1或0,默认值为1,表示是否做变量替换 表示预先知道的类,函数首先得到一个升序排列的标签然后给先前的类同样的排序。 只在分类器中使用的一个向量,长度等于类的数目。对类的观察值是取对cutoff投票占的的最大比例的一个。 用于分层抽样 样本的长度 表示终端节点的最小值,这个参数设置得越大会使更小的树生长,耗时更少。 判断是否需要对预测器的importance进行评估 决定是否对casewise的重要性度量进行计算 判别是否计算行之间的距离 判断是否计算out-of-bag 如果设定为TRUE,当随机森林运行的时候输出更多冗长的数据。如果设置为一些整数,输出每个追踪树。 通过树的数目矩阵跟踪每个样本在树上的in-bag。 norm_votes 统计每一类的投票数 importance 对于分类器来说是一个列数等于类别数加二,第一列计算精度下降值。在ncalss+1列表示所有类平均精度减少值。最后一列表示Gini指数平均减小值。在随机森林用于回归的应用中importance表示的含义又不一样,我们只用到分类的作用,所以对回归的含义不做介绍。importanceSD 标准差 localImp 包含importance标准化残差测量值的矩阵 ntree 生长的树的数目 mtry 在每一个分裂节点处样本预测器的个数。 Votes 一个矩阵,行表示每一个输入数据点,列表示每一类,记录投票数。 Proximity 如果proximity=TRUE表示随机森林被调用。 Combine 把树结合起来

随机森林

随机森林 基础内容: 这里只是准备简单谈谈基础的内容,主要参考一下别人的文章,对于随机森林与GBDT,有两个地方比较重要,首先是information gain,其次是决策树。这里特别推荐Andrew Moore大牛的Decision Trees Tutorial,与Information Gain Tutorial。Moore的Data Mining Tutorial系列非常赞,看懂了上面说的两个内容之后的文章才能继续读下去。 决策树实际上是将空间用超平面进行划分的一种方法,每次分割的时候,都将当前的空间一分为二,比如说下面的决策树: 就是将空间划分成下面的样子: 这样使得每一个叶子节点都是在空间中的一个不相交的区域,在进行决策的时候,会根据输入样本每一维feature的值,一步一步往下,最后使得样本落入N个区域中的一个(假设有N个叶子节点) 随机森林(Random Forest):

随机森林是一个最近比较火的算法,它有很多的优点: ?在数据集上表现良好 ?在当前的很多数据集上,相对其他算法有着很大的优势 ?它能够处理很高维度(feature很多)的数据,并且不用做特征选择 ?在训练完后,它能够给出哪些feature比较重要 ?在创建随机森林的时候,对generlization error使用的是无偏估计 ?训练速度快 ?在训练过程中,能够检测到feature间的互相影响 ?容易做成并行化方法 ?实现比较简单 随机森林顾名思义,是用随机的方式建立一个森林,森林里面有很多的决策树组成,随机森林的每一棵决策树之间是没有关联的。在得到森林之后,当有一个新的输入样本进入的时候,就让森林中的每一棵决策树分别进行一下判断,看看这个样本应该属于哪一类(对于分类算法),然后看看哪一类被选择最多,就预测这个样本为那一类。 在建立每一棵决策树的过程中,有两点需要注意- 采样与完全分裂。首先是两个随机采样的过程,random forest对输入的数据要进行行、列的采样。对于行采样,采用有放回的方式,也就是在采样得到的样本集合中,可能有重复的样本。假设输入样本为N个,那么采样的样本也为N个。这样使得在训练的时候,每一棵树的输入样本都不是全部的样本,使得相对不容易出现over-fitting。然后进行列采样,从M 个feature中,选择m个(m << M)。之后就是对采样之后的数据使用完全分裂的方式建立出决策树,这样决策树的某一个叶子节点要么是无法继续分裂的,要么里面的所有样本的都是指向的同一个分类。一般很多的决策树算法都一个重要的步骤- 剪枝,但是这里不这样干,由于之前的两个随机采样的过程保证了随机性,所以就算不剪枝,也不会出现over-fitting。 按这种算法得到的随机森林中的每一棵都是很弱的,但是大家组合起来就很厉害了。我觉得可以这样比喻随机森林算法:每一棵决策树就是一个精通于某一个窄领域的专家(因为我们从M个feature中选择m让每一棵决策树进行学习),这样在随机森林中就有了很多个精通不同领域的专家,对一个新的问题(新的输入数据),可以用不同的角度去看待它,最终由各个专家,投票得到结果。 随机森林的过程请参考Mahout的random forest。这个页面上写的比较清楚了,其中可能不明白的就是Information Gain,可以看看之前推荐过的Moore的页面。

随机信号分析实验报告(基于MATLAB语言)

随机信号分析实验报告 ——基于MATLAB语言 姓名: _ 班级: _ 学号: 专业:

目录 实验一随机序列的产生及数字特征估计 (2) 实验目的 (2) 实验原理 (2) 实验内容及实验结果 (3) 实验小结 (6) 实验二随机过程的模拟与数字特征 (7) 实验目的 (7) 实验原理 (7) 实验内容及实验结果 (8) 实验小结 (11) 实验三随机过程通过线性系统的分析 (12) 实验目的 (12) 实验原理 (12) 实验内容及实验结果 (13) 实验小结 (17) 实验四窄带随机过程的产生及其性能测试 (18) 实验目的 (18) 实验原理 (18) 实验内容及实验结果 (18) 实验小结 (23) 实验总结 (23)

实验一随机序列的产生及数字特征估计 实验目的 1.学习和掌握随机数的产生方法。 2.实现随机序列的数字特征估计。 实验原理 1.随机数的产生 随机数指的是各种不同分布随机变量的抽样序列(样本值序列)。进行随机信号仿真分析时,需要模拟产生各种分布的随机数。 在计算机仿真时,通常利用数学方法产生随机数,这种随机数称为伪随机数。伪随机数是按照一定的计算公式产生的,这个公式称为随机数发生器。伪随机数本质上不是随机的,而且存在周期性,但是如果计算公式选择适当,所产生的数据看似随机的,与真正的随机数具有相近的统计特性,可以作为随机数使用。 (0,1)均匀分布随机数是最最基本、最简单的随机数。(0,1)均匀分布指的是在[0,1]区间上的均匀分布, U(0,1)。即实际应用中有许多现成的随机数发生器可以用于产生(0,1)均匀分布随机数,通常采用的方法为线性同余法,公式如下: y0=1,y n=ky n(mod N) ? x n=y n N 序列{x n}为产生的(0,1)均匀分布随机数。 定理1.1若随机变量X 具有连续分布函数F x(x),而R 为(0,1)均匀分布随机变量,则有 X=F x?1(R) 2.MATLAB中产生随机序列的函数 (1)(0,1)均匀分布的随机序列函数:rand 用法:x = rand(m,n) 功能:产生m×n 的均匀分布随机数矩阵。 (2)正态分布的随机序列 函数:randn 用法:x = randn(m,n) 功能:产生m×n 的标准正态分布随机数矩阵。 如果要产生服从N(μ,σ2)分布的随机序列,则可以由标准正态随机序列产生。 (3)其他分布的随机序列 分布函数分布函数 二项分布binornd 指数分布exprnd 泊松分布poissrnd 正态分布normrnd 离散均匀分布unidrnd 瑞利分布raylrnd 均匀分布unifrnd X2分布chi2rnd 3.随机序列的数字特征估计 对于遍历过程,可以通过随机序列的一条样本函数来获得该过程的统计特征。这里我们假定随机序列X(n)为遍历过程,样本函数为x(n),其中n=0,1,2,……N-1。那么,

《随机信号分析与处理》实验报告完整版(GUI)内附完整函数代码

随机信号分析与处理》 实验报告 指导教师: 班级:学号:姓名:

实验一熟悉MATLAB勺随机信号处理相关命令 一、实验目的 1、熟悉GUI格式的编程及使用。 2、掌握随机信号的简单分析方法 3、熟悉语音信号的播放、波形显示、均值等的分析方法及其编程 二、实验原理 1、语音的录入与打开 在MATLAB^, [y,fs,bits]=wavread('Blip',[N1 N2]); 用于读取语音,采样值放在向量y中,fs表示采 样频率(Hz),bits表示采样位数。[N1 N2]表示读取从N1点到N2点的值。 2、均匀分布白噪声 在matlab中,有x=rand (a,b)产生均匀白噪声序列的函数,通过与语言信号的叠加来分析其特性。 3、均值 随机变量X的均值也称为数学期望,它定义为 e+oc 对于离散型随机变量,假定随机变量X有N个可能取值,各个取值的概率为- p y --1则均值定义为 £(X) = £.r fPf /=1 上式表明,离散型随机变量的均值等于随机变量的取值乘以取值的概率之和,如果取值是等概率的,那么均值就是取值的算术平均值,如果取值不是等概率的,那么均值就是概率加权和,所以,均值也称为统计平均值。 4、方差 定义 为随机过程<r >的方差。方差通常也记为D【X(t)】,随机过程的方差也是时间t的函数,由方差的定义可以看岀,方差是非负函数。 5、自相关函数 设任意两个时刻t1,t2,定义:::: R X (叩2)= E[X(tJX(t2)] = Jq JX1X2 f (X1, X2,t1,t2)dX1dX2 为随机过程X(t)的自相关函数,简称为相关函数。自相关函数可正,可负,其绝对值越大表示相关性越强。 6. 哈明(hamming)窗 0.54+0.46 (10.100) 0,

随机森林算法介绍及R语言实现

随机森林算法介绍及R语言实现 随机森林算法介绍 算法介绍: 简单的说,随机森林就是用随机的方式建立一个森林,森林里面有很多的决策树,并且每棵树之间是没有关联的。得到一个森林后,当有一个新的样本输入,森林中的每一棵决策树会分别进行一下判断,进行类别归类(针对分类算法),最后比较一下被判定哪一类最多,就预测该样本为哪一类。 随机森林算法有两个主要环节:决策树的生长和投票过程。 决策树生长步骤: 1.从容量为N的原始训练样本数据中采取放回抽样方式(即bootstrap取样) 随机抽取自助样本集,重复k(树的数目为k)次形成一个新的训练集N,以此生成一棵分类树; 2.每个自助样本集生长为单棵分类树,该自助样本集是单棵分类树的全部训 练数据。设有M个输入特征,则在树的每个节点处从M个特征中随机挑选m(m < M)个特征,按照节点不纯度最小的原则从这m个特征中选出一个特征进行分枝生长,然后再分别递归调用上述过程构造各个分枝,直到这棵树能准确地分类训练集或所有属性都已被使用过。在整个森林的生长过程中m将保持恒定; 3.分类树为了达到低偏差和高差异而要充分生长,使每个节点的不纯度达到 最小,不进行通常的剪枝操作。 投票过程: 随机森林采用Bagging方法生成多个决策树分类器。 基本思想: 1.给定一个弱学习算法和一个训练集,单个弱学习算法准确率不高,可以视 为一个窄领域专家; 2.将该学习算法使用多次,得出预测函数序列,进行投票,将多个窄领域专 家评估结果汇总,最后结果准确率将大幅提升。 随机森林的优点: ?可以处理大量的输入变量; ?对于很多种资料,可以产生高准确度的分类器; ?可以在决定类别时,评估变量的重要性; ?在建造森林时,可以在内部对于一般化后的误差产生不偏差的估计;

工程信号处理MATLAB实验指导书v1p0_2008完全版

工程信号处理——MATLAB实验指导书—— 伍星机电工程学院KUST-HMI联合实验室 2008.02

目录 1信号分析基础 (3) 1.1实验1典型时间信号的波形图 (3) 1.2实验2信号数据文件的读取与显示 (4) 2确定信号的频谱分析 (4) 2.1实验3周期信号的傅立叶级数三角函数展开式 (4) 2.2实验4非周期信号的傅立叶变换 (4) 2.3实验5时域有限信号的周期延拓 (5) 3时域分析 (5) 3.1实验6自相关和互相关分析 (5) 4随机信号分析 (5) 4.1实验7随机信号的数字特征 (5) 4.2实验8随机信号的功率谱分析 (6) 5系统分析概述 (6) 5.1实验9线性系统的主要性质 (6) 5.2实验10测定系统特性参数的方法 (7) 6模拟信号的离散化 (7) 6.1实验11时域采样定理 (7) 6.2实验12时域截断与泄露 (7) 7离散傅立叶变换 (7) 7.1实验13离散傅立叶变换 (7) 7.2实验14用X K计算信号的频谱 (8) 8快速傅立叶变换及其工程应用 (8) 8.1实验15快速傅立叶变换 (8) 8.2实验16快速傅立叶变换的应用 (9)

【预备知识】 机械工程测试技术、机械控制工程、MATLAB、虚拟仪器技术等。 【资料检索方法】 1.校图书馆相关书籍。 2.校图书馆数据库:维普中文科技期刊全文数据库,万方会议论文全文库, 万方硕博论文全文库,Elsevier外文期刊数据库,国外免费学位论文全文 数据库,超星电子图书系统。 3.互联网搜索引擎:https://www.360docs.net/doc/2113340262.html,,https://www.360docs.net/doc/2113340262.html,,https://www.360docs.net/doc/2113340262.html,。1信号分析基础 1.1实验1典型时间信号的波形图 【实验目的】 (1)熟悉MATLAB环境,掌握与信号处理相关的常用MATLAB语句和命令; (2)熟悉MATLAB生成典型信号的方法; (3)掌握MATLAB绘制信号波形图的方法; (4)掌握M脚本文件和函数文件的编制方法。 【实验内容】 (1)熟悉各种典型信号生成的关键参数,对于大多数的连续时间信号,两个 关键要素是信号的起止时间、信号的幅值、频率等; (2)编制确定信号和随机信号的M自定义函数文件,包括的典型信号如下: z确定信号 周期信号:正弦信号(MySin),三角波信号(MyTri),方波信号(MySquare)。 非周期信号:准周期信号(MyStdPeriod),矩形脉冲信号(MyImpulse),指数衰减正弦信号(MyExpSin)。 z随机信号:白噪声信号(MyWhiteNoise) (3)使用上述M函数产生如下信号: z幅值为5,频率为10Hz的正弦信号; z幅值为1,频率为8Hz的三角波信号; z幅值为2.5,频率为20Hz,占空比为50%的方波信号; z使用两个幅值为1的正弦信号构成一个准周期信号; z幅值为10,脉宽为1,时间范围0~6s的矩形脉冲信号; z幅值为5,频率为20Hz,衰减系数为-10的指数衰减正弦信号; z幅值范围为-3~3的白噪声信号。

数据挖掘之随机森林算法实验报告

太原师范学院 实验报告 Experimentation Report of Taiyuan Normal University 系部计算机系年级大三课程大数据分析 姓名XXX 同组者日期 项目数据挖掘之随机森林算法 一、实验目的 1.了解随机森林。随机森林就是通过集成学习的思想将多棵树 集成的一种算法,它的基本单元是决策树,而它的本质属于 机器学习的一大分支——集成学习(Ensemble Learning)方 法。 2.掌握随机森林的相关知识,信息、熵、信息增益等的概念。 3.掌握随机森林中数据分析的几种基本方法,决策树算法, CART算法等。 4.了解集成学习的定义和发展。 5.掌握随机森林的生成规则,随机森林的生成方法,随机森林 的特点等相关知识。 二、实验内容 1.结合老师上课所讲内容及课本知识,通过查找相关资料,

学习与决策树,随机森林相关的知识。 2.查找相关例题,深入理解随机森林的各种算法。 3.找一个数据集,利用随机森林的相关算法训练随机森林, 对样本进行判段并计算其判断的准确度。 三、实验仪器及平台 计算机一台MATLAB 2018a 四、实验原理 1.随机森林的基本概念: 通过集成学习的思想将多棵树集成的一种算法,它的基本单 元是决策树,而它的本质属于机器学习的一大分支——集成 学习(Ensemble Learning)方法。随机森林的名称中有两个 关键词,一个是“随机”,一个就是“森林”。“森林”我们 很好理解,一棵叫做树,那么成百上千棵就可以叫做森林了, 这样的比喻还是很贴切的,其实这也是随机森林的主要思想 --集成思想的体现。 2.决策树 2.1信息、熵、信息增益 这三个基本概念是决策树的根本,是决策树利用特征来分类 时,确定特征选取顺序的依据。 2.2决策树算法 决策树算法是一种逼近离散函数值的方法。它是一种典型的分类方法,首先对数据进行处理,利用归纳算法生成可