keepalived中vrrp实现分析

Keepalived中vrrp实现分析

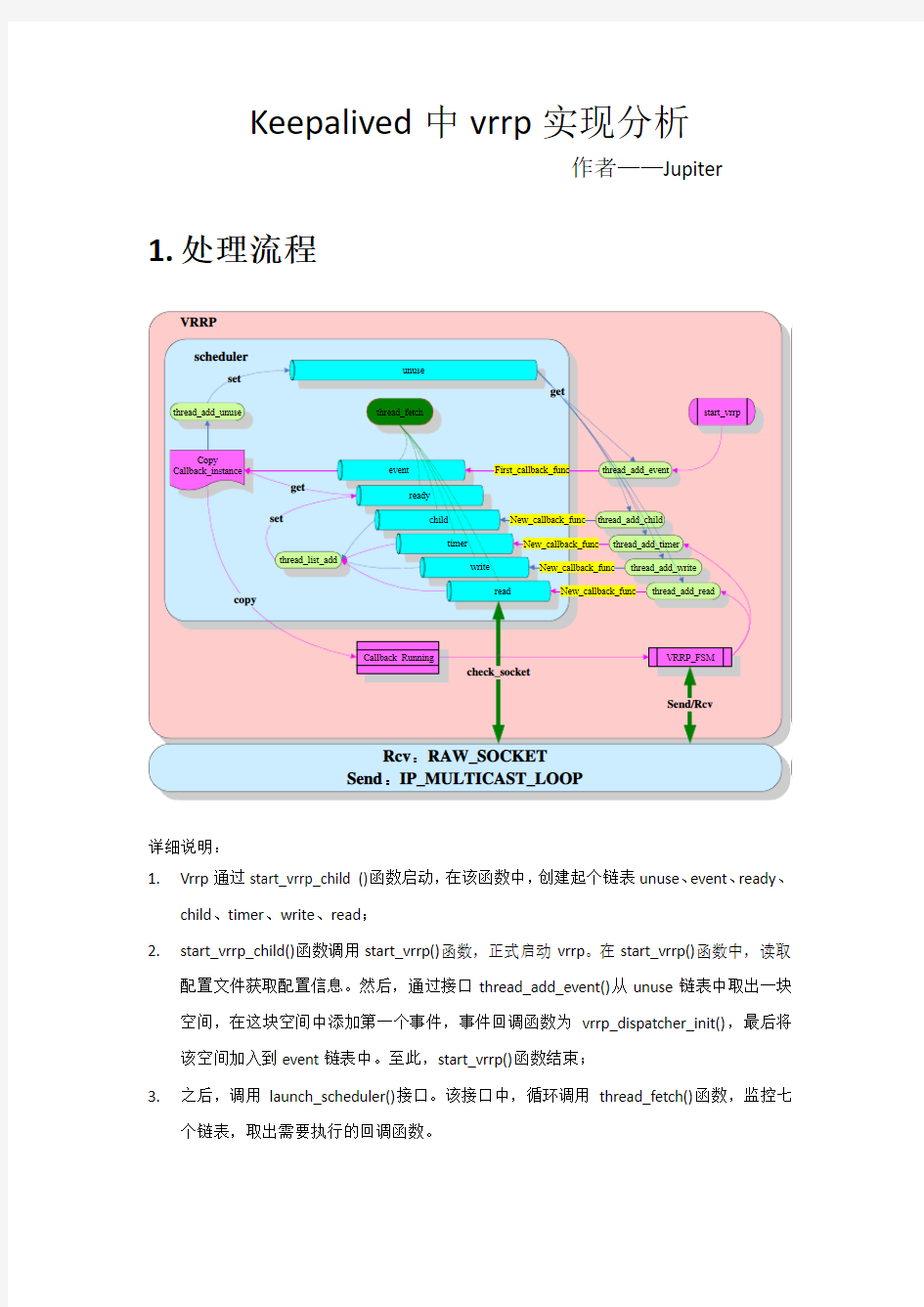

作者——Jupiter 1.处理流程

详细说明:

1.Vrrp通过start_vrrp_child ()函数启动,在该函数中,创建起个链表unuse、event、ready、

child、timer、write、read;

2.start_vrrp_child()函数调用start_vrrp()函数,正式启动vrrp。在start_vrrp()函数中,读取

配置文件获取配置信息。然后,通过接口thread_add_event()从unuse链表中取出一块空间,在这块空间中添加第一个事件,事件回调函数为vrrp_dispatcher_init(),最后将该空间加入到event链表中。至此,start_vrrp()函数结束;

3.之后,调用launch_scheduler()接口。该接口中,循环调用thread_fetch()函数,监控七

个链表,取出需要执行的回调函数。

?在thread_fetch()函数中,先检查event链表中事件,并取出执行回调函数;

?如果event链表中没有需要处理的事件,再检查ready中事件,并取出执行回调函

数;

?如果ready链表中没有需要处理的事件,再检查其他四个链表timer、read、write、

child中事件,并取出放入ready链表中等待处理。

?event和ready链表处理完成,把使用完的空间放入unuse链表中。

4.在步骤2中提到,start_vrrp()注册第一个事件,回调函数vrrp_dispatcher_init()。

thread_fetch()函数获取后,首先执行该回调函数。在该函数中,创建接收和发送socket。

?接收socket句柄为fd_in:此socket为ROW socket,创建完成后被加入到vrrp组播

组中,并绑定到指定网络设备。

?发送socket句柄为fd_out:此socket为ROW socket,创建完成后设置socket属性

为IP_HDRINCL(抓起数据包中包含ip报头),设置socket为IP_MULTICAST_LOOP

(组播),并绑定到指定网络设备。

5.然后,根据fd_in的值添加一个回调函数到指定链表。

?如果fd_in=-1,通过thread_add_timer()添加定时处理到timer链表,回调函数为

vrrp_read_dispatcher_thread();

?如果fd_in=-1,通过thread_add_read ()添加读取处理到read链表,回调函数为

vrrp_read_dispatcher_thread();

6.thread_fetch()函数检查所有链表,最中执行vrrp_read_dispatcher_thread()函数。

vrrp_read_dispatcher_thread()函数会根据fd_in的状态和当前thread->type,决定是读取数据包,还是从本地保存的数据中查找一个vrrp实体。

7.查找到vrrp实体后,调用VRRP_FSM_READ_TO(vrrp)或者VRRP_FSM_READ(vrrp)执行状

态机。在状态机中,根据当前状态进行相应处理;

?初始状态(Initialize)

◆如果本地优先级为255,也就是说自己是IP拥有者路由器,那么接下来它会:

●发送VRRP通告报文;

●广播免费ARP请求报文,内部封装是虚拟MAC和虚拟IP的对应,有几个

虚拟IP地址,那么就发送几个免费ARP请求报文;

●启动一个Adver_Timer计时器,初始值为Advertisement_Interval(缺省是

1秒),当该计时器超时后,会发送下一个VRRP通告报文;

●本地VRRP进程将自己切换为Master路由器;

◆如果本地优先级不是255,,那么接下来它会:

●设置Master_Down_Timer计时器等于Master_Down_Interval,也就是主路

由器死亡时间间隔,如果此计时器超时,那么Backup路由器就会宣布主

路由器死亡。其中Master_Down_Interval = (3*Advertisement_Interval)+

Skew_time举例来说,一个VRRP实例(也就是一个VRRP虚拟器)的优先

级是100,报文发送间隔是1秒,那么Master_Down_Interval = 3*1s +

(256-100)/256s = 3.609秒;

●本地VRRP进程将自己切换为Backup路由器;

?备份路由器状态(Backup)

◆备份路由器是为了监控Master路由器的状态,如果一个VRRP路由器处于此

状态,那么它会:

●不响应对虚拟IP地址的ARP请求报文;

●丢弃帧头目的MAC地址是虚拟MAC的帧;

●丢弃IP头中目的IP地址是虚拟IP的IP包;

◆如果此时该VRRP路由器收到了一个shutdown事件,那么它会:

●取消Master_Down_Timer;

●转换为初始状态(Initialize state);

◆如果Master_Down_Timer超时,那么该VRRP路由器会执行:

●发送一个VRRP通告报文;

●广播免费ARP请求报文,内部封装是虚拟MAC和虚拟IP的对应,有几个

虚拟IP;

●地址,那么就发送几个免费ARP请求报文;

●设置Adver_Timer计时器为Advertisement_Interval(缺省为1秒);

●切换到Master状态;

◆如果该Backup状态的VRRP路由器收到了一个VRRP通告报文;

●当该VRRP通告报文的优先级字段为0时,那么路由器会将当前的

Master_Down_Timer 设置为Skew_Time;

●如果优先级不为0,并且大于或等于本地优先级,那么本地路由器会重置

Master_Down_Timer计时器并保持Backup状态;

●如果优先级不为0,并且小于本地优先级,如果开启了抢占模式(Preempt

mode),那么该Backup路由器等待指定的抢占延迟时间后将自己切换为

Master路由器;并执行Master路由器的所有动作;例如:vrrp 1 preempt

delay minimum 10,表示等待10秒后切换自己为Master;

●如果优先级不为0,并且小于本地优先级,如果没有开启抢占模式

(Preempt mode),那么本地路由器保持Backup状态;

?Master路由器(Master state)

◆处于Master状态的路由器会执行目的MAC为虚拟MAC数据帧的转发,这里

要清楚的是对于下行设备的arp表里,该虚拟MAC是和虚拟IP地址相对应的;

◆当路由器处于Master状态时,会进行下面的动作:

●响应对虚拟IP地址的ARP请求;

●转发目的MAC地址是虚拟MAC的数据帧;

●拒绝目的IP地址是虚拟IP的数据包,除非它是IP地址拥有者(也就是优

先级是255的那个路由器);

◆如果处于Master状态的VRRP进程收到了一个shutdown事件,那么它会:

●取消Adver_Timer计时器;

●发送一个优先级字段为零的VRRP通告报文;

●切换为初始状态(Intialize state);

◆如果Adver_Timer计时器超时,那么:

●发送一个VRRP通告报文;

●重置Adver_Timer计时器;

◆如果收到了一个VRRP报文,且其优先级为0,那么:

●发送一个VRRP通告报文;

●重置Adver_Timer计时器;

◆如果收到了一个VRRP报文,且其优先级高于本地优先级,或者收到的VRRP

报文优先级等于本地优先级但是主IP地址高于本地的主IP地址,那么:

●取消Adver_Timer计时器

●设置Master_Down_Timer计时器为Master_Down_Interval

●切换为Backup状态

8.状态机处理完成后,重复步骤5、6、7。

Jupiter:此文章为自学成果,如有错误请批评指正。邮箱:sxyzzzzzzz@https://www.360docs.net/doc/212385260.html,谢谢!

广域网负载均衡原理简单介绍

广域网负载均衡 多链路广域网负载均衡 (1)Inbound多链路负载均衡算法策略:RTT+Topology+RoundRobin 具体描述: 当外部用户访问九州梦网网站时,首先由F5的3DNS对客户端的LDNS进行RTT(Round Trip Time)探测,对比从两条链路返回的探测结果(可以从统计列表中看到),选择一条返回值小的链路IP地址返回给客户端,从而客户端再发起访问请求;当F5的3DNS探测不到客户端的LDNS(由于LDNS安全防护等原因)时,F5的3DNS自动启用Topology算法,来静态匹配客户端的LDNS地理位置,从而根据客户端的来源,返回正确的A记录;当探测不到的LDNS又不在地址列表中时,F5 3DNS自动启用Global Availability 算法作为默认算法,将所有无法计算结果并且不在Topology范围之内的LocalDNS请求,定义到系统的默认线路上。 F5 的3DNS具备二十多种Inbound算法,可以根据需要进行组合。 ①RTT算法运行机制: 通过3DNS的RTT就近性算法会自动运算生成一个ldns就近分布表,通过这个动态的表,每个客户上来都会提供一个最快速的链路进行访问,由于站点有ISP1和ISP2的两条广域网线路。在3DNS上会针对站点服务器(以https://www.360docs.net/doc/212385260.html, 为例)解析ISP1和ISP2的两个不同的公网地址。 对应于https://www.360docs.net/doc/212385260.html,域名,在3DNS上配置wideip:https://www.360docs.net/doc/212385260.html,,对应两个Virtual Server:VS1:202.106.83.177,VS2:219.17.66.100。分别属于ISP1和ISP2两条线路分配的IP地址段。在3DNS内部,同时定义两个DataCenter分别与ISP1和ISP2相对应。 用户的访问流程如下:

F5负载均衡基本原理

F5 Application Management Products 服务器负载均衡原理 F5 Networks Inc

1.服务器负载平衡市场需求 (3) 2.负载平衡典型流程 (4) 2..1 通过VIP来截获合适的需要负载平衡的流量 (4) 2.2 服务器的健康监控和检查 (5) 2.3 负载均衡和应用交换功能,通过各种策略导向到合适的服务器 (6)

1.服务器负载平衡市场需求 随着Internet的普及以及电子商务、电子政务的发展,越来越多的应用系统需要面对更高的访问量和数据量。同时,企业对在线系统的依赖也越来越高,大量的关键应用需要系统有足够的在线率及高效率。这些要求使得单一的网络服务设备已经不能满足这些需要,由此需要引入服务器的负载平衡,实现客户端同时访问多台同时工作的服务器,一则避免服务器的单点故障,再则提高在线系统的服务处理能力。从业界环境来说,如下的应用需求更是负载均衡发展的推动力: ?业务系统从Client-Server转向采用Browser-Server 系统结构,关键系统需要高可用性 ?电子商务系统的高可用性和高可靠性需要 ?IT应用系统大集中的需要(税务大集中,证券大集中,银行大集中) ?数据中心降低成本,提高效率 负载均衡技术在现有网络结构之上提供了一种廉价、有效、透明的方法,来扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。它有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。 BIG/IP利用定义在其上面的虚拟IP地址来为用户的一个或多个应用服务器提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。BIG/IP 连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG/IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。 下图描述了一个负载平衡发生的流程:

GNS3环境下做vrrp实验

VRRP实验 在这个实验配置了两个VRRP组——vrrp 1和vrrp 2。在vrrp 1中,路由器R1为主虚拟路由器,R2为备用虚拟路由器;在vrrp 2中,路由器R1为备用虚拟路由器,路由器R1为主虚拟路由器。在两个路由器都正常工作的时候,PC1和PC2通过R1访问远端R3。 路由器R1的具体配置: R1(config-if)#int s1/0 R1(config-if)#ip add 200.0.1.1 255.255.255.0 R1(config-if)#no shutdown R1(config-if)#int f0/0 R1(config-if)#ip address 10.0.0.253 255.255.255.0 R1(config-if)#no shutdown R1(config-if)#vrrp 1 ip 10.0.0.253 R1(config-if)#vrrp 1 priority 200 // Priority change will have no effect whilst interface is VRRP address owner R1(config-if)#vrrp 1 preempt R1(config-if)#vrrp 2 ip 10.0.0.254 R1(config-if)#vrrp 2 priority 100 R1(config-if)#vrrp 2 preempt R1(config-if)#exit R1(config)#router rip R1(config)#ver 2 R1(config)#network 10.0.0.0 R1(config)#network 200.0.1.0 R1(config)#no auto-summary 路由器R2的配置: R2(config-if)#int s1/0 R2(config-if)# ip address 200.0.2.1 255.255.255.0 R2 (config-if)#no shutdown R2 (config-if)#int f0/0 R2 (config-if)#ip address 10.0.0.254 255.255.255.0 R2 (config-if)#no shutdown R2 (config-if)#vrrp 1 ip 10.0.0.253 R2 (config-if)#vrrp 1 priority 150 R2 (config-if)#vrrp 1 preempt R2 (config-if)#vrrp 2 ip 10.0.0.254 R2 (config-if)#vrrp 2 priority 200 R2 (config-if)#vrrp 2 preempt R2 (config-if)#exit

VRRP+MSTP+OSPF实验

VRRP+MSTP实验 要求: 1.client1属于VLAN2(19 2.168.1.1/24) client2属于VLAN3 (192.168.2.1/24) 2.SW1SW2 SW3运行MSTP+VRRP,SW1作为1.0的根桥(同时作为网关VRRP为MASTER)SW2作为2.0 的根桥(同时作为网关VRRP为MASTER) 3.SW1SW2之间链路聚合 4.用R1的两个环回口模拟OABOSS服务器IP分别为1.1.1.1,2.2.2.2 5.client1选择SW1到OABOSS ,client2选择SW2到OABOSS 6.SW1SW2 AR1之间运行OSPF协议 7.在AR1上起两个环回口模拟OABOSS服务器 8.CLIENT1和CLIENT2能相互通信并且二者都可以和OABOSS服务器通信

配置如下: AR1: interface GigabitEthernet0/0/0 ip address 172.16.1.2 255.255.255.0 # interface GigabitEthernet0/0/1 ip address 172.16.2.2 255.255.255.0 # interface LoopBack0 ip address 1.1.1.1 255.255.255.255//模拟OA网# interface LoopBack1 ip address 2.2.2.2 255.255.255.255//模拟BOSS网# ospf 1 area 0.0.0.0 network 1.1.1.1 0.0.0.0 network 2.2.2.2 0.0.0.0 network 172.16.1.2 0.0.0.0 network 172.16.2.2 0.0.0.0 # SW1: vlan batch 2 to 3 20 # stp instance 1 root primary stp instance 2 root secondary # stp region-configuration region-name xx instance 1 vlan 2 instance 2 vlan 3 active region-configuration # interface Vlanif2 ip address 192.168.1.251 255.255.255.0 vrrpvrid 1 virtual-ip 192.168.1.254 vrrpvrid 1 priority 120 # interface Vlanif3 ip address 192.168.2.251 255.255.255.0 vrrpvrid 2 virtual-ip 192.168.2.254 # interface Vlanif20 ip address 172.16.1.1 255.255.255.0

神州数码交换机VRRP实验

实验三十八、交换机VRRP实验 一、 实验目的 1、熟悉VRRP协议的使用方式和配置方法; 2、理解VRRP协议的适用场合。 二、 应用环境 VRRP和HSRP具有类似的功能,实现方法上略有不同,VRRP是由IETF提出,是一个标准协议,HSRP是由CISCO公司制定的。 VRRP(Virtual Router Redundancy Protocol,虚拟路由器冗余协议)是一种容错协议,运行于局域网的多台路由器上,它将这几台路由器组织成一台“虚拟”路由器,或称为一个备份组(Standby Group)。在VRRP备份组内,总有一台路由器或以太网交换机是活动路由器(Master),它完成“虚拟”路由器的工作;该备份组中其它的路由器或以太网交换机作为备份路由器(Backup,可以不只一台),随时监控Master的活动。当原有的Master出现故障时,各Backup将自动选举出一个新的Master来接替其工作,继续为网段内各主机提供路由服务。由于这个选举和接替阶段短暂而平滑,因此,网段内各主机仍然可以正常地使用虚拟路由器,实现不间断地与外界保持通信。 三、 实验设备 1、DCRS-7604(或6804)交换机2台 2、HUB或交换机1台 3、PC机2-4台 4、Console线1-2根 5、直通网线若干根

五、 实验要求 1、在交换机7604A和交换机7604B上分别划分基于端口的VLAN: 交换机 VLAN 端口成员 IP 1 24 10.1.157.1/24 DCRS-7604A 100 1 192.168.100.1/24 10 8-16 192.168.10.1/24 DCRS-7604B 1 24 10.1.157.2/24 100 1 192.168.100.2/24 20 8-16 192.168.20.1/24 2、PC1-PC4的网络设置为: 设备 IP地址 gateway Mask PC1 192.168.100.101 192.168.100.1255.255.255.0 PC2 192.168. 100.102 192.168.100.1255.255.255.0 PC3 192.168.10.2 192.168.10.1 255.255.255.0 PC4 192.168.20.2 192.168.20.1 255.255.255.0 3、验证: 无论拔掉192.168.100.1的线还是192.168.100.2的线,PC1和PC2不需要做网络设置的改变都可以与PC3和PC4通信。则证明VRRP正常工作。

路由与交换实验课7——VRRP协议

#RT1

F5负载均衡原理

F5负载均衡原理 一负载均衡基本概念 1、什么是负载均衡? 负载均衡技术在现有网络结构之上提供了一种廉价、有效、透明的方法,来扩展网络设备和服务器的带宽、增加吞吐量、加强网络数据处理能力、提高网络的灵活性和可用性。它有两方面的含义:首先,大量的并发访问或数据流量分担到多台节点设备上分别处理,减少用户等待响应的时间;其次,单个重负载的运算分担到多台节点设备上做并行处理,每个节点设备处理结束后,将结果汇总,返回给用户,系统处理能力得到大幅度提高。 BIG/IP利用定义在其上面的虚拟IP地址来为用户的一个或多个应用服务器提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。BIG/IP 连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG/IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。 下图描述了一个负载平衡发生的流程: 1. 客户发出服务请求到VIP 2. BIGIP接收到请求,将数据包中目的IP地址改为选中的后台服务器IP地址,然后将数据包发出到后台选定的服务器 3. 后台服务器收到后,将应答包按照其路由发回到BIGIP 4. BIGIP收到应答包后将其中的源地址改回成VIP的地址,发回客户端,由此就完成了一个标准的服务器负载平衡的流程。

2.负载平衡典型流程 ●通过VIP来截获合适的需要负载平衡的流量 ●服务器监控和健康检查,随时了解服务器群的可用性状态 ●负载均衡和应用交换功能,通过各种策略导向到合适的服务器 2.1 通过VIP来截获合适的需要负载平衡的流量 在BIGIP上通过设置VIP来截获需要进行负载平衡的流量,这个VIP地址可以是一个独立的主机地址和端口的组合(例如:202.101.112.115:80)也可以是一个网络地址和端口的组合(例如:202.101.112.0:80),当流量经过BIGIP的时候,凡是命中VIP 的流量都将被截获并按照规则进行负载平衡。 2.2 服务器的健康监控和检查 服务器 (Node) - Ping (ICMP) BIGIP可以定期的通过ICMP包对后台服务器的IP地址进行检测,如果在设定的时间内能收到该地址的ICMP的回应,则认为该服务器能提供服务 服务 (Port) – Connect BIGIP可以定期的通过TCP包对后台服务器的服务端口进行检测,如果在设定的时间内能收到该服务器端口的回应,则认为该服务器能提供服务 扩展内容查证(ECV: Extended Content Verification)—ECV ECV是一种非常复杂的服务检查,主要用于确认应用程序能否对请求返回对应的数据。如果一个应用对该服务检查作出响应并返回对应的数据,则BIG/IP控制器将该服务器标识为工作良好。如果服务器不能返回相应的数据,则将该服务器标识为宕机。宕机一旦修复,BIG/IP就会自动查证应用已能对客户请求作出正确响应并恢复向该服务器传送。该功能使BIG/IP可以将保护延伸到后端应用如Web内容及数据库。BIG/ip的ECV 功能允许您向Web服务器、防火墙、缓存服务器、代理服务器和其它透明设备发送查询,然后检查返回的响应。这将有助于确认您为客户提供的内容正是其所需要的。 扩展应用查证(EAV: Extended Application Verification) EAV是另一种服务检查,用于确认运行在某个服务器上的应用能否对客户请求作出响应。为完成这种检查,BIG/IP控制器使用一个被称作外部服务检查者的客户程序,该程序为BIG/IP提供完全客户化的服务检查功能,但它位于BIG/IP控制器的外部。例如,该外部服务检查者可以查证一个Internet或Intranet上的从后台数据库中取出数据并在HTML网页上显示的应用能否正常工作。EAV是BIG/IP提供的非常独特的功能,它提供管理者将BIG/IP客户化后访问各种各样应用的能力,该功能使BIG/IP在提供标准的可用性查证之外能获得服务器、应用及内容可用性等最重要的反馈。

华为和思科vrrp实验

华为和思科vrrp实验 下面是他发给我的设备配置: 华为:dis cur(vrp1。74-105)interface Ethernet0 ip address 192.168.1.2 255.255.255.0 vrrp vrid 1 virtual-ip 192.168.1.3 vrrp vrid 1 priority 150 vrrp vrid 1 track Ethernet1 reduced 35 vrrp authentication simple cisco interface Ethernet1 ip address 192.168.2.2 255.255.255.0 vrrp vrid 1 virtual-ip 192.168.2.3 vrrp vrid 1 priority 150 vrrp vrid 1 track Ethernet0 reduced 35 vrrp authentication simple cisco cisco:show run(IOS12.3) interface FastEthernet0/0 description link to switch ip address 192.168.1.4 255.255.255.0 speed 100 full-duplex vrrp 1 ip 192.168.1.3 vrrp 1 timers advertise 3 vrrp 1 timers learn vrrp 1 priority 120 vrrp 1 authentication text cisco ! interface FastEthernet0/1 description link to shenju ip address 192.168.2.4 255.255.255.0 speed auto full-duplex vrrp 1 ip 192.168.2.3 vrrp 1 timers advertise 3 vrrp 1 timers learn vrrp 1 priority 120 vrrp 1 authentication text cisco

负载均衡器部署方式和工作原理

负载均衡器部署方式和工作原理 2011/12/16 小柯信息安全 在现阶段企业网中,只要部署WEB应用防火墙,一般能够遇到负载均衡设备,较常见是f5、redware的负载均衡,在负载均衡方面f5、redware的确做得很不错,但是对于我们安全厂家来说,有时候带来了一些小麻烦。昨日的一次割接中,就遇到了国内厂家华夏创新的负载均衡设备,导致昨日割接失败。 在本篇博客中,主要对负载均衡设备做一个介绍,针对其部署方式和工作原理进行总结。 概述 负载均衡(Load Balance) 由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。 负载均衡实现方式分类 1:软件负载均衡技术 该技术适用于一些中小型网站系统,可以满足一般的均衡负载需求。软件负载均衡技术是在一个或多个交互的网络系统中的多台服务器上安装一个或多个相应的负载均衡软件来实现的一种均衡负载技术。软件可以很方便的安装在服务器上,并且实现一定的均衡负载功能。软件负载均衡技术配置简单、操作也方便,最重要的是成本很低。 2:硬件负载均衡技术 由于硬件负载均衡技术需要额外的增加负载均衡器,成本比较高,所以适用于流量高的大型网站系统。不过在现在较有规模的企业网、政府网站,一般来说都会部署有硬件负载均衡设备(原因1.硬件设备更稳定,2.也是合规性达标的目的)硬件负载均衡技术是在多台服务器间安装相应的负载均衡设备,也就是负载均衡器来完成均衡负载技术,与软件负载均衡技术相比,能达到更好的负载均衡效果。 3:本地负载均衡技术

负载均衡的基础原理说明

大家都知道一台服务器的处理能力,主要受限于服务器自身的可扩展硬件能力。所以,在需要处理大量用户请求的时候,通常都会引入负载均衡器,将多台普通服务器组成一个系统,来完成高并发的请求处理任务。 之前负载均衡只能通过DNS来实现,1996年之后,出现了新的网络负载均衡技术。通过设置虚拟服务地址(IP),将位于同一地域(Region)的多台服务器虚拟成一个高性能、高可用的应用服务池;再根据应用指定的方式,将来自客户端的网络请求分发到

服务器池中。网络负载均衡会检查服务器池中后端服务器的健康状态,自动隔离异常状态的后端服务器,从而解决了单台后端服务器的单点问题,同时提高了应用的整体服务能力。 网络负载均衡主要有硬件与软件两种实现方式,主流负载均衡解决方案中,硬件厂商以F5为代表目前市场占有率超过50%,软件主要为NGINX与LVS。但是,无论硬件或软件实现,都逃不出基于四层交互技术的“转发”或基于七层协议的“代理”这两种方式。四层的转发模式通常性能会更好,但七层的代理模式可以根据更多的信息做到更智能地分发流量。一般大规模应用中,这两种方式会同时存在。 2007年F5提出了ADC(Application delivery controller)的概念为传统的负载均衡器增加了大量的功能,常用的有:SSL卸载、压缩优化和TCP连接优化。NGINX也支持很多ADC的特性,但F5的中高端型号会通过硬件加速卡来实现SSL卸载、压缩优化这一类CPU密集型的操作,从而可以提供更好的性能。 F5推出ADC以后,各种各样的功能有很多,但其实我们最常用的也就几种。这里我也简单的总结了一下,并和LVS、Nginx对比了一下。

vrrp学习总结

VRRP学习总结 一、VRRP介绍 VRRP(Virtual Router Redundancy Protocol)虚拟路由冗余协议,通过配置VRRP,可以实现当主机的下一跳设备出现故障时,及时将业务切换到备份设备,从而保持通讯的连续性和可靠性。通过将多台设备虚拟为一台网关设备,将虚拟网关设备的IP地址作为用户的缺省网关实现与外部网络通信。当网关设备发生故障时,VRRP机制能够选举新的网关设备承担数据流量,从而保障网络的可靠通信。 如上图所示,在SwitchA和SwitchB上配置VRRP备份组后,VRRP备份组将 两台设备虚拟成一台网关设备,虚拟网关设备具有虚拟IP地址和虚拟MAC地址,主机只感知这个虚拟网关设备的存在,以它为网关与外部进行通信。正常情况下,用户侧的流量通过Master设备转发。当Master设备出现故障时,通过VRRP协商,从Backup设备中选举出新的Master设备,即SwitchB,继续承担流量转发 工作。 二、VRRP心跳线

如上图所示,在SwitchA和SwitchB上配置VRRP备份组,当Switch为其他厂商设备或者Switch上部署了某些特性(例如:配置VLAN内的未知组播报文丢弃功能)有可能会导致VRRP功能受到影响。 为了解决此问题,可以在SwitchA和SwitchB之间部署一条心跳线,用于传递VRRP协议报文。需要将Interface1和Interface2加入与VRRP备份组相对应的VLAN(例如,VRRP备份组配置在VLANIF100接口下,则需要配置Interface1和Interface2加入VLAN100)。 由于配置了心跳线之后,SwitchA、SwitchB和Switch之间会存在环路,还需要配置破环协议来破除环路(例如,可以配置STP协议来破除环路)。 三、VRRP缺省配置 四、VRRP主备 1.如上图,通过虚拟网关将交换机A和B虚拟为一台网关设备,虚拟网关 地址为10.1.1.111,正常情况下A 为master(通过vrrp vrid 1 priority 120,因为缺省为100),B为backup,当A出现故障之后,B状态变为Master。 当A恢复之后,等待自己设定的时间之后,A又转为Master状态,B又为

Vrrp双机热备

实验三 实验目标: 1.全网互通 2.双机热备负载均衡 3.Vlan10和vlan20正常情况下通过R2通信 4.Vlan30和vlan40正常情况下通过R3通信

Vlan da Vlan 10 Vlan 20 Vlan 30 Vlan 40 Exit Conf t in fa 1/0 Sw acc vlan 10 No shut Exit In fa 1/1 Sw acc vlan 20 No shut Exit In fa 1/2 Sw acc vlan 30 No shut Exit In fa 1/3 Sw acc vlan 40 No shut Exit In ra fa 1/14 - 15 No shut Sw mode t Exot

vlan da Vlan 10 Vlan 20 Vlan 30 Vlan 40 Exit Conf t In vlan 10 Ip add 192.168.1.252 255.255.255.0 In vlan 20 Ip add 192.168.2.252 255.255.255.0 In vlan 30 Ip add 192.168.3.252 255.255.255.0 In vlan 40 Ip add 192.168.4.252 255.255.255.0 Exit In ra fa 1/14 - 15 No shut Sw mode t Exit

vlan da Vlan 10 Vlan 20 Vlan 30 Vlan 40 Exit Conf t In vlan 10 Ip add 192.168.1.253 255.255.255.0 In vlan 20 Ip add 192.168.2.253 255.255.255.0 In vlan 30 Ip add 192.168.3.253 255.255.255.0 In vlan 40 Ip add 192.168.4.253 255.255.255.0 Exit In ra fa 1/14 - 15 No shut Sw mode t Exit

负载均衡方案及详细配置

Apache+Tomcat+mod_jk实现负载均衡方案 一、概述: 原理图: 提高系统可用性,对系统性能影响较小。对于一台服务器Down机后,可自动切换到另 最少需要两台机器,Tomcat1 和Tomcat2可在同一台服务器上。若条件允许最好是各用一台服务器。 二、详细配置步骤: 1、Apache http Server安装 32位的按照提示操作即可。 64位系统的不是安装包。 64位安装配置: 以管理员身份运行cmd 执行:httpd -k install 若无法运行并提示配置错误,请先安装vcredist_x64.exe后再执行。 安装后在Testing httpd.conf...时会报错,不影响。 httpd -k start 启动Apache、httpd -k shutdown 停止Apache 、httpd -k restart重启测试Apache:

在IE中输入:127.0.0.1 打开网页显示It work就OK 2、将Mod_jk的压缩包解压,找到mod_jk.so 复制到Apache目录下modules目录下 64位的下载mod_jk1.2.30_x64.zip 32位的下载tomcat-connectors-1.2.35-windows-i386-httpd-2.0.x.zip 3、修改Apache conf目录下的httpd.conf文件 在最后增加:Include conf/extra/mod_jk.conf 4、在conf/extra 下创建mod_jk.conf文件 增加如下: #load module mod_jk.so LoadModule jk_module modules/mod_jk.so #mod_jk config #load workers JkWorkersFile conf/workers.properties #set log file JkLogFile logs/mod_jk.log #set log level JkLogLevel info #map to the status server #mount the status server JkMount /private/admin/mystatus mystatus JkMount /* balance 5.在conf目录下创建workers.properties文件 增加:worker.tomcat1 中的tomcat1和tomcat2必须和Tomcat中的配置相同。Tomcat配置下面介召 worker.list=balance,mystatus #first worker config worker.tomcat1.type=ajp13 worker.tomcat1.host=192.168.8.204 worker.tomcat1.port=8009 #Tomcat的监听端口 worker.tomcat1.lbfactor=1 worker.tomcat1.socket_timeout=30 worker.tomcat1.socket_keepalive=1 #second worker config worker.tomcat2.type=ajp13 worker.tomcat2.host=192.168.8.204 worker.tomcat2.port=8010 #Tomcat的监听端口实验是在同一机器上做的,所以两个不同

VRRP配置实验

HCDA交换实验——VRRP配置 实验拓扑: 实验配置: 路由器的配置 # interface GigabitEthernet0/0/0 ip address 192.168.11.1 255.255.255.0 # interface GigabitEthernet0/0/1 ip address 192.168.12.1 255.255.255.0 # interface LoopBack100 ip address 100.100.100.100 255.255.255.0 # interface LoopBack200 ip address 200.200.200.200 255.255.255.0 # ospf 1 router-id 1.1.1.1 area 0.0.0.0

network 100.100.100.100 0.0.0.0 network 192.168.11.1 0.0.0.0 network 192.168.12.1 0.0.0.0 network 200.200.200.200 0.0.0.0 # LSW1的配置 # sysname LSW1 # vlan batch 10 20 # interface Vlanif1 ip address 192.168.11.2 255.255.255.0 # interface Vlanif10 ip address 192.168.10.252 255.255.255.0 vrrp vrid 10 virtual-ip 192.168.10.1 vrrp vrid 10 priority 120 vrrp vrid 10 track interface GigabitEthernet0/0/1 reduced 30 # interface Vlanif20 ip address 192.168.20.252 255.255.255.0 vrrp vrid 20 virtual-ip 192.168.20.1 # interface GigabitEthernet0/0/2 port link-type trunk port trunk allow-pass vlan 2 to 4094 # interface GigabitEthernet0/0/3 port link-type trunk undo port trunk allow-pass vlan 1 port trunk allow-pass vlan 2 to 4094 # ospf 1 router-id 2.2.2.2 import-route direct area 0.0.0.0 network 192.168.11.2 0.0.0.0 LSW2的配置

软件负载均衡优缺点总结

(总结)Nginx/LVS/HAProxy负载均衡软件的优缺点详解 PS:Nginx/LVS/HAProxy是目前使用最广泛的三种负载均衡软件,本人都在多个项目中实施过,参考了一些资料,结合自己的一些使用经验,总结一下。 一般对负载均衡的使用是随着网站规模的提升根据不同的阶段来使用不同的技术。具体的应用需求还得具体分析,如果是中小型的Web应用,比如日PV小于1000万,用Nginx就完全可以了;如果机器不少,可以用DNS轮询,LVS所耗费的机器还是比较多的;大型网站或重要的服务,且服务器比较多时,可以考虑用LVS。一种是通过硬件来进行进行,常见的硬件有比较昂贵的F5和Array等商用的负载均衡器,它的优点就是有专业的维护团队来对这些服务进行维护、缺点就是花销太大,所以对于规模较小的网络服务来说暂时还没有需要使用;另外一种就是类似于Nginx/LVS/HAProxy的基于Linux的开源免费的负载均衡软件,这些都是通过软件级别来实现,所以费用非常低廉。 目前关于网站架构一般比较合理流行的架构方案:Web前端采用 Nginx/HAProxy+Keepalived作负载均衡器;后端采用MySQL数据库一主多从和读写分离,采用LVS+Keepalived的架构。当然要根据项目具体需求制定方案。 下面说说各自的特点和适用场合。 Nginx的优点是: 1、工作在网络的7层之上,可以针对http应用做一些分流的策略,比如针对域名、目录结构,它的正则规则比HAProxy更为强大和灵活,这也是它目前广泛流行的主要原因之一,Nginx单凭这点可利用的场合就远多于LVS了。 2、Nginx对网络稳定性的依赖非常小,理论上能ping通就就能进行负载功能,这个也是它的优势之一;相反LVS对网络稳定性依赖比较大,这点本人深有体会; 3、Nginx安装和配置比较简单,测试起来比较方便,它基本能把错误用日志打印出来。LVS的配置、测试就要花比较长的时间了,LVS对网络依赖比较大。 3、可以承担高负载压力且稳定,在硬件不差的情况下一般能支撑几万次的并发量,负载度比LVS相对小些。 4、Nginx可以通过端口检测到服务器内部的故障,比如根据服务器处理网页返回的状态码、超时等等,并且会把返回错误的请求重新提交到另一个节点,不过其中缺点就是不支持url来检测。比如用户正在上传一个文件,而处理该上传的节点刚好在上传过程中出现故障,Nginx会把上传切到另一台服务器重新处理,而LVS就直接断掉了,如果是上传一个很大的文件或者很重要的文件的话,用户可能会因此而不满。 5、Nginx不仅仅是一款优秀的负载均衡器/反向代理软件,它同时也是功能强大的Web应用服务器。LNMP也是近几年非常流行的web架构,在高流量的环境中稳定性也很好。 6、Nginx现在作为Web反向加速缓存越来越成熟了,速度比传统的Squid服务器

VRRP详细配置

Vrrp基本配置 实验目的: 掌握网络通信链路冗余(路由器出口链路)备份的配置 介绍: 采用两个路由器,一个作为主路由器,一个作为备份路由器,当主路由器出现故障时,备份路由器自动启动,充当主路由器的角色。

路由器R1配置: R1(config)interface Ethernet0/1 R1(config-if)ip address 172.16.1.1255.255.255.0 R1(config-if) no shut R1(config-if) exit R1(config) track 1Eterface e0/1 line-protocol// R1(config)interface Ethernet0/0 R1(config-if)ip address 192.168.1.254 255.255.255.0 R1(config-if)full-duplex R1(config-if)vrrp 1 ip 192.168.1.100 R1(config-if)vrrp 1 priority 250 R1(config-if)vrrp 1 track 1 decrement 100 R1(config)router rip R1(config-router)network 172.16.1.0 R1(config-router)network 192.168.1.0 路由器R2配置: R2(config)interface Ethernet0/1 R2(config-if)ip address 172.41.1.1255.255.255.0 R2(config-if) no shut R2(config-if) exit R2(config) track 1Eterface e0/1 line-protocol R2(config)interface Ethernet0/0 R2(config-if)ip address 192.168.1.253255.255.255.0 R2(config-if)full-duplex R2(config-if)vrrp 1 ip 192.168.1.100 R2(config-if)vrrp 1 priority 200 R2(config-if)vrrp 1 track 1 decrement 100 R2(config)router rip R2(config-router)network 172.41.1.0 R2(config-router)network 192.168.1.0 路由器R3配置: R3(config)interface Ethernet0/0 R3(config-if)ip address 192.168.2.254255.255.255.0 R3(config-if) no shut R3(config)interface Ethernet0/1 R3(config-if)ip address 172.16.1.2255.255.255.0 R3(config-if) no shut R3(config)interface Ethernet0/2 R3(config-if)ip address 172.41.1.2255.255.255.0 R3(config-if) no shut R3(config)router rip

负载均衡系统构架

负载均衡系统构架 负载均衡系统构架 【摘要】随着计算机网络和Internet应用的飞速发展,信息共享日益广泛化,并深入到人们工作和生活的各个领域。人们对信息共享的依赖正逐渐增强。而作为提供信息载体的服务器的压力也越来越大,对于电子商务、信息共享平台急需合理分配访问流量来减少服务器的压力。 本文对目前的负载均衡技术进行简单的阐述,并对现有均衡算法进行简单的比较,分析其不足之处。并采用LVS(Linux虚拟服务器)实现负载均衡的架构。采用Keepalived技术实现负载均衡的高可用性。并对LVS不同策略上实现的均衡结果进行详细的比较。最终完成对负载均衡系统的构建同时提供了详细的系统搭建步骤,为研究该方向的人员提供可靠的参考资料。 【关键词】负载均衡、LVS、Keepalived、高并发 中图分类号:TN711 文献标识码:A 文章编号: 简介 1.1背景 目前随着网络技术的迅速崛起,网络信息共享数据越来越大,访问量和数据流量的快速增长,所需的处理能力和运算强度也越来越大,使得单一的服务器设备根本无法承担。在此情况下,如果花大量的资金进行硬件方面的升级,会造成大量的资源浪费。并且对于下一次升级来说,将会投入更大的成本,如何才能利用现有资源,在少量的投入下解决该问题? 针对此情况而衍生出来的一种廉价有效透明的方法来扩展现有网络设备和服务器的带宽、增加吞吐量、加强网络数 据处理能力、提高网络的灵活性和可用性的技术就是负载均 衡(Load Balance)。 1.2负载均衡技术概述 负载均衡(又称为负载分担),英文名称为Load Balance,其