信息论与编码(第二版)曹雪虹(最全版本)答案

《信息论与编码(第二版)》曹雪虹答案

第二章

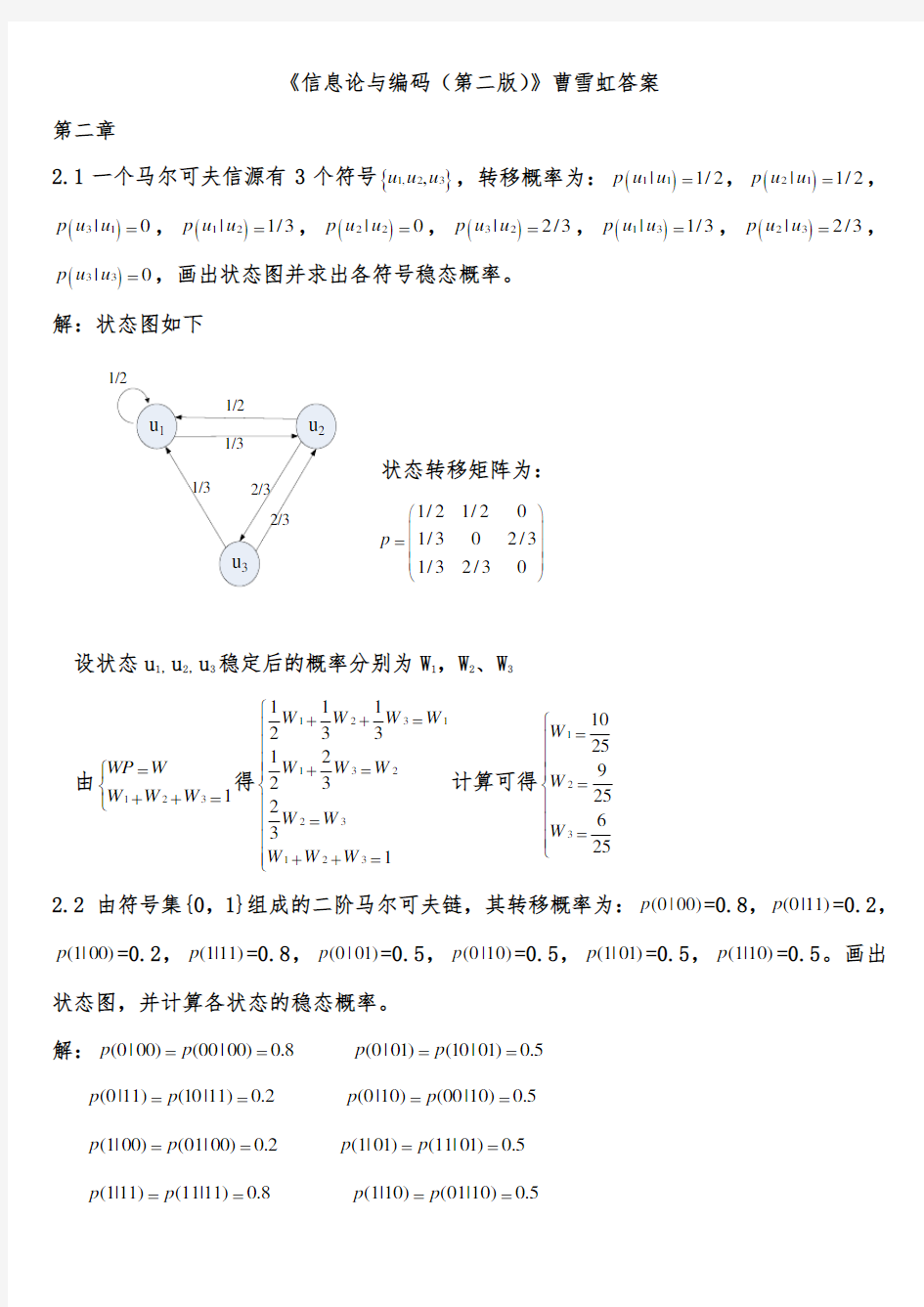

2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =,

()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。

解:状态图如下

状态转移矩阵为:

1/21/2

01/302/31/32/30p ?? ?= ? ???

设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3

由1231WP W W W W =??++=?得1231132231231

112331223231W W W W W W W W W W W W ?++=???+=???=???++=?

计算可得1231025925625W W W ?=???

=?

?

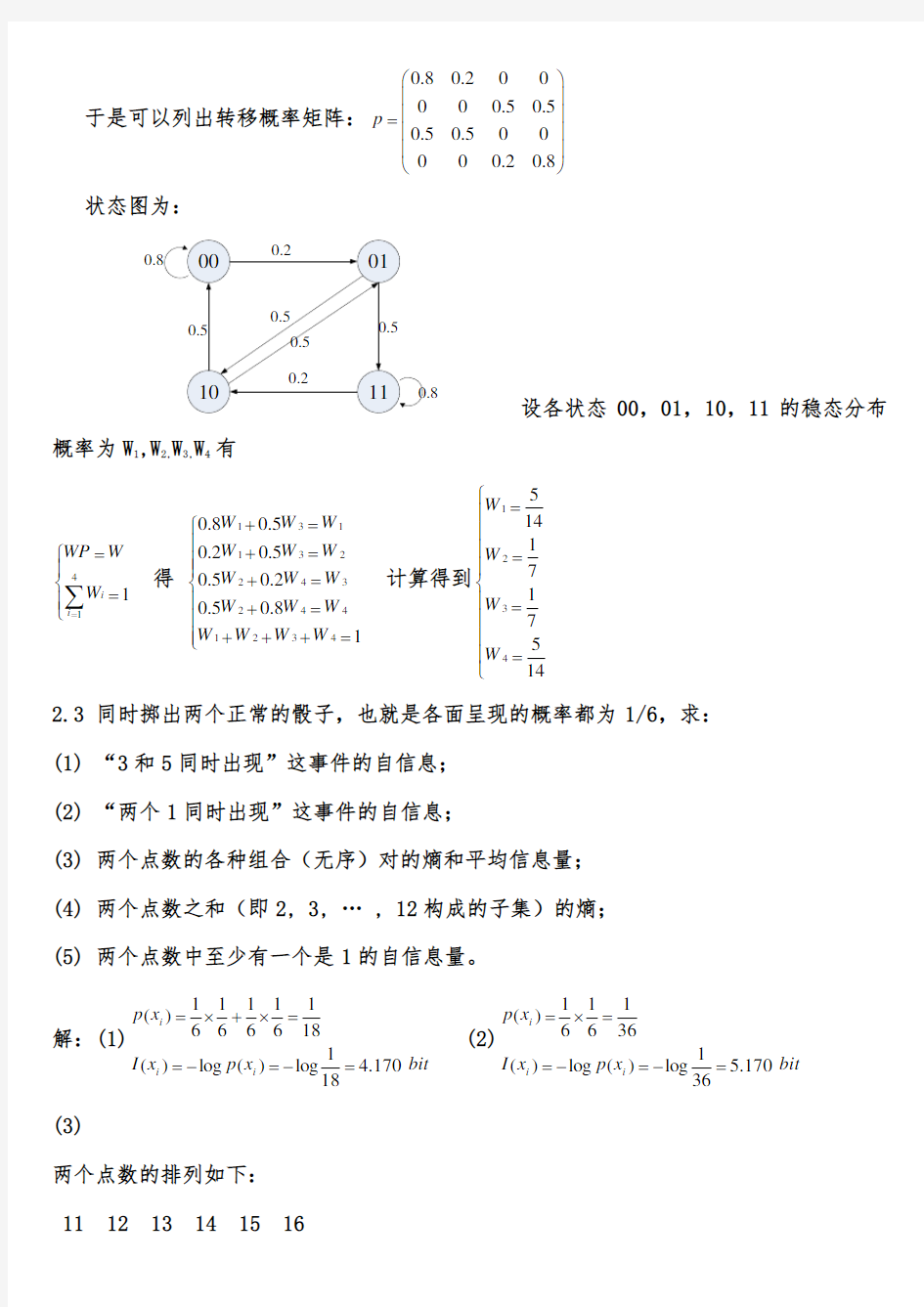

?=?? 2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,

(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。画出

状态图,并计算各状态的稳态概率。

解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p ==

(0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p ==

于是可以列出转移概率矩阵:0.80.20

0000.50.50.50.500000.20.8p ?? ?

?= ? ???

状态图为:

设各状态00,01,10,11的稳态分布

概率为W 1,W 2,W 3,W 4 有

41

1i i WP W W ==???=??∑ 得 131

132

24324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=??+=??+=??+=?+++=?? 计算得到123451417

175

14W W W W ?

=??

?=???=???=

?

2.3 同时掷出两个正常的骰子,也就是各面呈现的概率都为1/6,求: (1) “3和5同时出现”这事件的自信息; (2) “两个1同时出现”这事件的自信息;

(3) 两个点数的各种组合(无序)对的熵和平均信息量; (4) 两个点数之和(即2, 3, … , 12构成的子集)的熵; (5) 两个点数中至少有一个是1的自信息量。

解:(1)bit x p x I x p i i i 170.418

1

log

)(log )(181

61616161)(=-=-==

?+?= (2)bit x p x I x p i i i 170.536

1

log

)(log )(361

6161)(=-=-==

?=

(3)

两个点数的排列如下: 11 12 13 14 15 16

21 22 23 24 25 26 31 32 33 34 35 36 41 42 43 44 45 46 51 52 53 54 55 56 61 62 63 64 65 66

共有21种组合:

其中11,22,33,44,55,66的概率是3616

161=

? 其他15个组合的概率是18

161612=?? symbol bit x p x

p X H i

i i / 337.4181log 18115361log 3616)(log )()(=??? ??

?+?-=-=∑

(4)参考上面的两个点数的排列,可以得出两个点数求和的概率分布如下:

symbol bit x p x p X H X P X i

i i / 274.3 61log 61365log 365291log 912121log 1212181log 1812361log 36

12 )

(log )()(36112181111211091936586173656915121418133612)(=?

?? ??

+?+?+?+?+?-=-=??????????=?

?????∑(5)

bit x p x I x p i i i 710.136

11

log

)(log )(3611116161)(=-=-==

??=

2-4

2.5 居住某地区的女孩子有25%是大学生,在女大学生中有75%是身高160厘米以上的,

而女孩子中身高160厘米以上的占总数的一半。假如我们得知“身高160厘米以上的某女孩是大学生”的消息,问获得多少信息量? 解:

设随机变量X 代表女孩子学历

X x 1(是大学生) x 2(不是大学生) P(X)

0.25

0.75

设随机变量Y 代表女孩子身高

Y y 1(身高>160cm ) y 2(身高<160cm ) P(Y)

0.5 0.5

已知:在女大学生中有75%是身高160厘米以上的 即:bit x y p 75.0)/(11=

求:身高160厘米以上的某女孩是大学生的信息量 即:bit y p x y p x p y x p y x I 415.15

.075

.025.0log )()/()(log

)/(log )/(11111111=?-=-=-=

2.6 掷两颗骰子,当其向上的面的小圆点之和是3时,该消息包含的信息量是多少?当小圆点之和是7时,该消息所包含的信息量又是多少? 解:

1)因圆点之和为3的概率1()(1,2)(2,1)18

p x p p =+= 该消息自信息量()log ()log18 4.170I x p x bit =-== 2)因圆点之和为7的概率

1

()(1,6)(6,1)(2,5)(5,2)(3,4)(4,3)6p x p p p p p p =+++++=

该消息自信息量()log ()log6 2.585I x p x bit =-== 2.7 设有一离散无记忆信源,其概率空间为123401233/8

1/41/41/8X x x x x P ====????

= ?

????

?

(1)求每个符号的自信息量

(2)信源发出一消息符号序列为{202 120 130 213 001 203 210 110 321 010 021 032 011 223 210},求该序列的自信息量和平均每个符号携带的信息量 解:12

2118

()log log 1.415()3

I x bit p x === 同理可以求得233()2,()2,()3I x bit I x bit I x bit ===

因为信源无记忆,所以此消息序列的信息量就等于该序列中各个符号的信息量之和 就有:123414()13()12()6()87.81I I x I x I x I x bit =+++= 平均每个符号携带的信息量为

87.81

1.9545

=bit/符号 2.8 试问四进制、八进制脉冲所含信息量是二进制脉冲的多少倍? 解:

四进制脉冲可以表示4个不同的消息,例如:{0, 1, 2, 3} 八进制脉冲可以表示8个不同的消息,例如:{0, 1, 2, 3, 4, 5, 6, 7} 二进制脉冲可以表示2个不同的消息,例如:{0, 1} 假设每个消息的发出都是等概率的,则:

四进制脉冲的平均信息量symbol bit n X H / 24log log )(1=== 八进制脉冲的平均信息量

symbol bit n X H / 38log log )(2===

二进制脉冲的平均信息量symbol bit n X H / 12log log )(0===

所以:四进制、八进制脉冲所含信息量分别是二进制脉冲信息量的2倍和3倍。 2-9 “-” 用三个脉冲 “●”用一个脉冲

(1) I(●)= I(-)= (2) H= 2-10 (2) P(黑/黑)= P(白/黑)= H(Y/黑)=

(3) P(黑/白)= P(白/白)=

H(Y/白)= (4) P(黑)= P(白)= H(Y)=

2.11 有一个可以旋转的圆盘,盘面上被均匀的分成38份,用1,…,38的数字标示,其中有两份涂绿色,18份涂红色,18份涂黑色,圆盘停转后,盘面上的指针指向某一数字和颜色。

(1)如果仅对颜色感兴趣,则计算平均不确定度 (2)如果仅对颜色和数字感兴趣,则计算平均不确定度 (3)如果颜色已知时,则计算条件熵

解:令X 表示指针指向某一数字,则X={1,2,……….,38} Y 表示指针指向某一种颜色,则Y={l 绿色,红色,黑色} Y 是X 的函数,由题意可知()()i j i p x y p x = (1)3

112381838

()()log

log 2log 1.24()3823818

j j j H Y p y p y ===+?=∑bit/符号 (2)2(,)()log 38 5.25H X Y H X ===bit/符号

(3)(|)(,)()()() 5.25 1.24 4.01H X Y H X Y H Y H X H Y =-=-=-=bit/符号

2.12 两个实验X 和Y ,X={x 1 x 2 x 3},Y={y 1 y 2 y 3},l 联合概率(),i j ij r x y r =为

1112

132122233132

337/241/2401/241/41/2401/247/24r r r r r r r

r r ????

? ?= ? ? ? ?????

(1) 如果有人告诉你X 和Y 的实验结果,你得到的平均信息量是多少? (2) 如果有人告诉你Y 的实验结果,你得到的平均信息量是多少?

(3) 在已知Y 实验结果的情况下,告诉你X 的实验结果,你得到的平均信息量是多少? 解:联合概率(,)i j p x y 为

2

2221(,)(,)log (,)

72411

2log 4log 24log 4247244

i j i j ij

H X Y p x y p x y ==?

+?+∑ =2.3bit/符号

X 概率分布 21

()3log 3 1.583

H Y =?=bit/符号

(|)(,)() 2.3 1.58H X Y H X Y H Y =-=- Y 概率分布是

=0.72bit/符号

2.13 有两个二元随机变量X 和Y ,它们的联合概率为

并定义另一随机变量Z = XY (一般乘积),试计算: (1) H(X), H(Y), H(Z), H(XZ), H(YZ)和H(XYZ);

(2) H(X/Y), H(Y/X), H(X/Z), H(Z/X), H(Y/Z), H(Z/Y), H(X/YZ), H(Y/XZ)和H(Z/XY); (3) I(X;Y), I(X;Z), I(Y;Z), I(X;Y/Z), I(Y;Z/X)和I(X;Z/Y)。 解: (1)

symbol bit y p y p Y H y x p y x p y p y x p y x p y p symbol bit x p x p X H y x p y x p x p y x p y x p x p j

j j i

i i / 1)(log )()(2

1

8183)()()(218381)()()(/ 1)(log )()(2

1

8183)()()(218381)()()(22212121112212221111=-==

+=+==+=

+==-==

+=+==+=

+=∑∑

Z = XY 的概率分布如下:

symbol

bit z p Z H z z Z P Z k k / 544.081log 8187log 87

)()(8187

10)(2

21=??? ??+-=-=???

???????===??????∑

symbol

bit z x p z x p XZ H z p z x p z x p z x p z p z x p z p z x p z x p z x p z p x p z x p z x p z x p z x p x p i k

k i k i / 406.181log 8183log 8321log 21

)(log )()(8

1

)()()()()(8

35.087)()()()()()(5.0)()(0)()()()(2222221211112121111112121111=??? ??++-=-==

=+==-=-=+====+=∑∑

symbol

bit z y p z y p YZ H z p z y p z y p z y p z p z y p z p z y p z y p z y p z p y p z y p z y p z y p z y p y p j k

k j k j / 406.181log 8183log 8321log 21

)(log )()(8

1

)()()()()(8

35.087)()()()()()(5.0)()(0)()()()(2222221211112121111112121111=??? ??++-=-==

=+==-=-=+====+=∑∑

symbol

bit z y x p z y x p XYZ H y x p z y x p y x p z y x p z y x p z y x p y x p z y x p y x p z y x p z y x p z y x p z x p z y x p z x p z y x p z y x p y x p z y x p y x p z y x p z y x p z y x p z y x p z y x p i

j

k

k j i k j i / 811.181log 8183log 8383log 8381log 8

1

)(log )()(8

1)()()

()()(0

)(8

3)()()()()(8

38121)()()()()()(8/1)()()()()(0

)(0)(0)(22222222222122122121121221211211111121111111211111111211111212221211=??? ??+++-=-==

==+====+=-=-==+===+===∑∑∑

(2)

symbol

bit XY H XYZ H XY Z H symbol bit XZ H XYZ H XZ Y H symbol bit YZ H XYZ H YZ X H symbol

bit Y H YZ H Y Z H symbol bit Z H YZ H Z Y H symbol bit X H XZ H X Z H symbol bit Z H XZ H Z X H symbol bit X H XY H X Y H symbol bit Y H XY H Y X H symbol

bit y x p y x p XY H i j

j i j i / 0811.1811.1)()()/(/ 405.0406.1811.1)()()/(/ 405.0406.1811.1)()()/(/ 406.01406.1)()()/(/ 862.0544.0406.1)()()/(/ 406.01406.1)()()/(/ 862.0544.0406.1)()()/(/ 811.01811.1)()()/(/ 811.01811.1)()()/(/ 811.181log 8183log 8383log 8381log 81

)(log )()(2=-=-==-=-==-=-==-=-==-=-==-=-==-=-==-=-==-=-==??? ??+++-==-=∑∑

(3)

symbol

bit YZ X H Y X H Y Z X I symbol bit XZ Y H X Y H X Z Y I symbol bit YZ X H Z X H Z Y X I symbol

bit Z Y H Y H Z Y I symbol bit Z X H X H Z X I symbol bit Y X H X H Y X I / 406.0405.0811.0)/()/()/;(/ 457.0405.0862.0)/()/()/;(/ 457.0405.0862.0)/()/()/;(/ 138.0862.01)/()();(/ 138.0862.01)/()();(/ 189.0811.01)/()();(=-=-==-=-==-=-==-=-==-=-==-=-=

2-14 (1)

P(ij)= P(i/j)=

(2) 方法1: = 方法2:

2-15 P(j/i)=

2.16 黑白传真机的消息元只有黑色和白色两种,即X={黑,白},一般气象图上,黑色的出现概率p(黑)=0.3,白色出现的概率p(白)=0.7。

(1)假设黑白消息视为前后无关,求信源熵H(X),并画出该信源的香农线图

(2)实际上各个元素之间是有关联的,其转移概率为:P(白|白)=0.9143,P(黑|白)=0.0857,P(白|黑)=0.2,P(黑|黑)=0.8,求这个一阶马尔可夫信源的信源熵,并画出该信源的香农线图。

(3)比较两种信源熵的大小,并说明原因。 解:(1)221010

()0.3log 0.7log 0.881337

H X =+=bit/符号 P(黑|白)=P(黑)

P(白|白)=P(白) 黑

白

0.7

0.3

0.7

0.3

P(黑|黑)=P(黑) P(白|黑)=P(白)

(2)根据题意,此一阶马尔可夫链是平稳的(P(白)=0.7不随时间变化,P(黑)=0.3不随时 间变化)

212

222

2

1()(|)(,)log (,)

111

0.91430.7log 0.08570.7log 0.20.3log 0.91430.08570.2

10.80.3log 0.8

i j i j ij

H X H X X p x y p x y ∞===?+?+?+?∑ =0.512bit/符号

2.17 每帧电视图像可以认为是由3

105个像素组成的,所有像素均是独立变化,且每像

素又取128个不同的亮度电平,并设亮度电平是等概出现,问每帧图像含有多少信息量?若有一个广播员,在约10000个汉字中选出1000个汉字来口述此电视图像,试问广播员描述此图像所广播的信息量是多少(假设汉字字汇是等概率分布,并彼此无依赖)?若要恰当的描述此图像,广播员在口述中至少需要多少汉字? 解:1)

symbol

bit X NH X H symbol

bit n X H N

/ 101.27103)()(/ 7128log log )(6

5

22?=??===== 2)

symbol

bit X NH X H symbol bit n X H N / 13288288.131000)()(/ 288.1310000log log )(22=?=====

3)158037288

.13101.2)()(6=?==

X H X H N N 2.20 给定语音信号样值X 的概率密度为1

()2

x p x e λλ-=,x -∞<<+∞,求H c (X),并证明它小于同样方差的正态变量的连续熵。 解

201()()log ()()log 21

()log ()()log 211log log ()2211

1log log ()log

()222

11

log 2log 22x

c x x x x x x

x x

H X p x p x dx p x e dx

p x dx p x x edx

e e x dx

e e x dx e x dx e xe λλλλλλλλλλλλλλλλ+∞+∞

--∞-∞+∞

+∞

-∞-∞+∞

--∞

+∞

--∞+∞-=-=-=---=-+=-+?-+=-+???????

?0

1log log (1)212log log log

2x x dx

e x e e e λλλλλλ

+∞

-??=--+??=-+= 2

2

()0,()E X D X λ==

,221214()log 2log log log ()22e H X e H X ππλλλλ

=

==>= 2.24 连续随机变量X 和Y 的联合概率密度为:?????≤+=其他

1

),(2222

r y x r

y x p π,求H(X), H(Y),

H(XYZ)和I(X;Y)。

(提示:?-=20222log 2

sin log π

π

xdx )

解:

???

?

??????

??????

?

-+-=+

==-==--=--=--=-+-=--=---=--=-=≤≤--===----------

---202020

220

2

20

20222

20

2

20

222222

2222222222222

22222

222

22sin log 2

2cos 1422cos 1log 4

sin log sin 4

log sin 4

sin log sin 4

sin log sin 4)

cos (sin log sin 4cos log 4log 2log )(/ log 2

1

log log 2

1

1log 2log log )(2log log )(2

log )( 2log )( )(log )()()( 21)()(2

2222

22

2π

π

π

π

π

ππθ

θθ

πθθπθ

θθπ

θθπ

θθθπ

θθθπθθθπθπππππππππd d r d rd d r d r r r r d r r r r x dx x r x r r dx x r r x r dx

x r x p symbol

bit e r e

r r dx

x r x p r dx

x r x p dx r

x p dx

r x r x p dx

x p x p X H r x r r

x r dy r dy xy p x p r

r

r r

r

r r r r r r r

r r

r c x r x r x r x r 令其中:

e

e e d e d e d e d e d e

d d d e

r d r d d r r d d d r d r 220

2220

220

22

0220

2220

22

20

20

20

220

20

220

20

20

20

20

log 21

2sin log 21log 212cos log 1

log 122cos 1log 2

cos log 2

sin log cos cos sin 21

sin log 2sin sin log 2sin 12sin sin log 1

sin log 2cos 2

log 2

1

1log sin log 2cos 2

1log sin log 2cos 2

)2log 2

(2

2sin log 1

log sin log 2cos 2

sin log 2

2cos log 2

log 2

-=--=--=+-

=-=-=?

??

?

??-==

+-=-

-=-

-

+

-

=-

+

-

=

?????

?

?

?

?

?

??

?

??π

π

ππ

π

π

π

π

π

π

π

π

π

π

π

π

π

θ

πθ

θπ

θπθ

θ

πθ

θπ

θ

θ

θθ

θπ

θθθθπθ

θπθ

θθπθ

θθπθ

θθππ

π

θπ

θ

θθπθθπθθπ

θπ

其中:

bit/symbol

e r e r XY H Y H X H Y X I bit/symbol r dxdy xy p r dxdy r xy p dxdy

xy p xy p XY H bit/symbol

e r X H Y H x p y p r y r r y r dx r dx xy p y p c c c c R

R

R

c C C y r y r y r y r log log log log log 2 )()()();( log )(log 1

log

)( )(log )()( log 2

1

log )()()

()()

( 21

)()(222222222

222

2222

222222

2-=--=-+===-=-=-===≤≤--===???????

?

---

---πππππππππ

2.25 某一无记忆信源的符号集为{0, 1},已知P(0) = 1/4,P(1) = 3/4。 (1) 求符号的平均熵;

(2) 有100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。 解:

(1)symbol bit x p x p X H i

i i / 811.043log 4

341log 4

1)(log )()(=??

? ??+-=-=∑

(2)

bit m x p x I x p m

i i m

m

m i 585.15.4143

log

)(log )(4

34341)(100

100100

100100+=-=-==?

??

?????? ??=---

(3) symbol bit X H X H / 1.81811.0100)(100)(100=?== 2-26

P(i)= P(ij)= H(IJ)=

2.29 有一个一阶平稳马尔可夫链1,2,,,r X X X L L ,各X r 取值于集合{}1,2,3A a a a =,已知起始概率P(X r )为1231/2,1/4p p p ===,转移概率如下图所示

j i 1

2

3

1 2 3

1/2 2/3 2/3

1/4 0 1/3

1/4 1/3 0

(1)

求123(,,)X X X 的联合熵和平均符号熵

(2) 求这个链的极限平均符号熵 (3)

求012,,H H H 和它们说对应的冗余度

解:(1)

12312132,112132(,,)()(|)(|)

()(|)(|)

H X X X H X H X X H X X X H X H X X H X X =++=++

1111111

()log log log 1.5/224444

H X bit =---=符号

X 1,X 2的联合概率分布为

212()()j i j i

p x p x x =∑

X 2的概率分

布为

那么

21111131131

(|)log 4log 4log 4log log3log log348862126212

H X X =++++++

=1.209bit/符号 X 2X 3的联合概率分布为

那么

32771535535

(|)log 2log 4log 4log log3log log3244883627236272

H X X =

++++++ =1.26bit/符号

123(,,) 1.5 1.209 1.26 3.969H X X X bit =++=/符号

所以平均符号熵3123 3.969

(,,) 1.3233

H X X X bit =

=/符号

(2)设a 1,a 2,a 3稳定后的概率分布分别为W1,W2,W3,转移概率距阵为11

12442

103321033

P ?? ? ?

?= ? ? ? ???

由1i WP W W =???=??∑ 得到 123132123122123311431

W W W W W W W W W ?++=??

?+=?

?

++=???

计算得到12347

314314W W W ?=???=???=?? 又满足不可约性和非周期性

31

4111321

()(|)(,,)2(,,0) 1.2572441433i i i H X W H X W H H bit ∞===+?=∑u u v /符号

(3)0log3 1.58H bit ==/符号 1 1.5H bit =/符号 2 1.5 1.209

1.3552

H bit +=

=/符号 00 1.25110.211.58γη=-=-=11 1.25110.6171.5γη=-=-= 22 1.25

110.0781.355

γη=-=-=

a 1

a 3

a 21/2

2/3

1/4

1/32/31/4

2-30 (1) 求平稳概率 P(j/i)= 解方程组 得到 (2)

信源熵为:

2-31

P(j/i)= 解方程组 得到W1= , W2= , W3=

2.32 一阶马尔可夫信源的状态图如图2-13所示,信源X 的符号集为(0,1,2)。 (1)求信源平稳后的概率分布P(0),P(1),P(2) (2)求此信源的熵

(3)近似认为此信源为无记忆时,符号的概率分布为平稳分布。求近似信源的熵H(X)并与H ∞进行比较

1

2

1-p

p/2

1-p

p/2

p/2

p/2

p/2

p/2

1-p

解:根据香农线图,列出转移概率距阵1/2/2/21/2/2/21p p p P p p p p p p -??

??=-??

??-??

令状态0,1,2平稳后的概率分布分别为W1,W2,W3

31

1i i WP W W ==???=??∑ 得到 1231

1232123(1)2

2

(1)221p p p W W W W p

p W p W W W W W W ?

-++=???+-+=??++=???

计算得到131313W W W ?=??

?

=??

?=??

由齐次遍历可得

112

()(|)3(1,,)(1)log log 3221i i i p p H X W H X W H p p p p p ∞==?-=-+-∑u u v u u v

,

()log 3 1.58/H X bit ==符号 由最大熵定理可知()H X ∞u u v

存在极大值

或者也可以通过下面的方法得出存在极大值:

()121log(1)(1)log log

1222(1)H X p p p

p p p p p p ∞???-=---+-++??=-???--?

?u u v

112(1)22(1)p p p =

-+-- 又01p ≤≤所以[]0,2(1)p p ∈+∞-当p=2/3时12(1)p

p =- 0 ()log 02(1)H X p p p ∞?=->?-u u v 2/3 ()log 02(1) H X p p p ∞?=- 符号 所以,()()H X H X ∞≤u u v 2-33 (1) 解方程组: 得p(0)=p(1)=p(2)= (2) (3) 当p=0或p=1时 信源熵为0 练习题:有一离散无记忆信源,其输出为{}0,1,2X ∈,相应的概率为0121/4,1/4,1/2p p p ===,设计两个独立的实验去观察它,其结果分别为{}{}120,1,0,1Y Y ∈∈,已知条件概率: 实验好些 (1) 求1(;)I X Y 和2(;)I X Y ,并判断哪一个实验比做 (2) 求12(;)I X Y Y ,并计算做Y 1和Y 2两个 Y 1和Y 2中的一个实验可多得多少关于X 的信息 (3) 求12(;|)I X Y Y 和21(;|)I X Y Y ,并解释它们的含义 解:(1)由题意可知 P(y 1=0)=p(y 1=1)=1/2 p(y 2=1)=p(y 2=1)=1/2 11111111 (;)()(|)log 2log log 2log 2 42424 I X Y H Y H Y X ∴=-=---?=0.5bit/符号 222111 (;)()(|)log 2log1log1log11/442 I X Y H Y H Y X bit =-=---=符号>1(;)I X Y 所以第二个实验比第一个实验好 1、有一个二元对称信道,其信道矩阵如下图所示。设该信道以1500个二元符号/秒的速度传输输入符号。现有一消息序列共有14000个二元符号,并设在这消息中P(0)=P(1)=1/2。问从信息传输的角度来考虑,10秒钟内能否将这消息序列无失真地传送完? 解答:消息是一个二元序列,且为等概率分布,即P(0)=P(1)=1/2,故信源的熵为H(X)=1(bit/symbol)。则该消息序列含有的信息量=14000(bit/symbol)。 下面计算该二元对称信道能传输的最大的信息传输速率: 信道传递矩阵为: 信道容量(最大信息传输率)为: C=1-H(P)=1-H(0.98)≈0.8586bit/symbol 得最大信息传输速率为: Rt ≈1500符号/秒× 0.8586比特/符号 ≈1287.9比特/秒 ≈1.288×103比特/秒 此信道10秒钟内能无失真传输得最大信息量=10× Rt ≈ 1.288×104比特 可见,此信道10秒内能无失真传输得最大信息量小于这消息序列所含有的信息量,故从信息传输的角度来考虑,不可能在10秒钟内将这消息无失真的传送完。 2、若已知信道输入分布为等概率分布,且有如下两个信道,其转移概率矩阵分别为: 试求这两个信道的信道容量,并问这两个信道是否有噪声? 3 、已知随即变量X 和Y 的联合分布如下所示: 01 100.980.020.020.98P ?? =?? ??11112222 1111222212111122221111222200000000000000000000000000000000P P ????????????==????????????11 222 2111 2222 2 log 4(00)1/()log 42/log 8(000000)2/(),H bit symbol H X bit symbol C C H bit symbol H X C =-===>=-==1解答:(1)由信道1的信道矩阵可知为对称信道故C 有熵损失,有噪声。(2)为对称信道,输入为等概率分布时达到信道容量无噪声 一、(11’)填空题 (1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 (2)必然事件的自信息是 0 。 (3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 (4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。 (5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。 (6)对于香农编码、费诺编码和霍夫曼编码,编码方法惟一的是香农编码。(7)已知某线性分组码的最小汉明距离为3,那么这组码最多能检测出_2_______个码元错误,最多能纠正___1__个码元错误。 (8)设有一离散无记忆平稳信道,其信道容量为C,只要待传送的信息传输率R__小于___C(大于、小于或者等于),则存在一种编码,当输入序列长度n足够大,使译码错误概率任意小。(9)平均错误概率不仅与信道本身的统计特性有关,还与___译码规则____________和___编码方法___有关 三、(5')居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。 假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则 P(A)=0.25 p(B)=0.5 p(B|A)=0.75 (2分) 故 p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0.75*0.25/0.5=0.375 (2分) I(A|B)=-log0.375=1.42bit (1分) 四、(5')证明:平均互信息量同信息熵之间满足 I(X;Y)=H(X)+H(Y)-H(XY) 证明: 一填空题 1、平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y 获得的关于每个X 的平均信息量,也表示发X 前后Y 的平均不确定性减少的量,还表示通信前 后整个系统不确定性减少的量。 2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大,最大熵值为。 3、香农公式为 为保证足够大的信道容量,可采用(1)用频带换信噪比; (2)用信噪比换频带。 4、只要,当N 足够长时,一定存在一种无失真编码。 5、当R <C 时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 6、1948年,美国数学家 香农 发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 7.人们研究信息论的目的是为了 高效、可靠、安全 地交换和利用各种各样的信息。 8.信息的 可度量性 是建立信息论的基础。 9.统计度量 是信息度量最常用的方法。 10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用 随机矢量 描述。 11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为 其发生概率对数的负值 。 12、自信息量的单位一般有 比特、奈特和哈特 。 13、必然事件的自信息是 0 。 14、不可能事件的自信息量是 ∞ 。 15、两个相互独立的随机变量的联合自信息量等于 两个自信息量之和 。 16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量 趋于变小 。 17、离散平稳无记忆信源X 的N 次扩展信源的熵等于离散信源X 的熵的 N 倍 。 18、离散平稳有记忆信源的极限熵,=∞H )/(lim 121-∞→N N N X X X X H 。 19、对于n 元m 阶马尔可夫信源,其状态空间共有 n m 个不同的状态。 20、一维连续随即变量X 在[a ,b]区间内均匀分布时,其信源熵为 log2(b-a ) 。 一、概念简答题(每题5分,共40分) 1.什么是平均自信息量与平均互信息,比较一下这两个概念的异同? 答:平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2.简述最大离散熵定理。对于一个有m个符号的离散信源,其最大熵是多少? 答:最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 最大熵值为。 3.解释信息传输率、信道容量、最佳输入分布的概念,说明平均互信息与信源的概率分布、信道的传递概率间分别是什么关系? 答:信息传输率R指信道中平均每个符号所能传送的信息量。信道容量是一个信道所能达到的最大信息传输率。信息传输率达到信道容量时所对应的输入概率分布称为最佳输入概率分布。 平均互信息是信源概率分布的∩型凸函数,是信道传递概率的U型凸函数。 4.对于一个一般的通信系统,试给出其系统模型框图,并结合此图,解释数据处理定理。 答:通信系统模型如下: 数据处理定理为:串联信道的输入输出X、Y、Z组成一个马尔可夫链,且有, 。说明经数据处理后,一般只会增加信息的损失。 5.写出香农公式,并说明其物理意义。当信道带宽为5000Hz,信噪比为30dB时求信道容量。 .答:香农公式为,它是高斯加性白噪声信道在单位时间内的信道容量,其值取决于信噪比和带宽。 由得,则 6.解释无失真变长信源编码定理。 .答:只要,当N足够长时,一定存在一种无失真编码。 7.解释有噪信道编码定理。 答:当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8.什么是保真度准则?对二元信源,其失真矩阵,求a>0时率失真函数的和? 答:1)保真度准则为:平均失真度不大于允许的失真度。 2)因为失真矩阵中每行都有一个0,所以有,而。 二、综合题(每题10分,共60分) 1.黑白气象传真图的消息只有黑色和白色两种,求: 第三章 3.1 设二元对称信道的传递矩阵为? ?????????32313132 (1) 若P(0) = 3/4, P(1) = 1/4,求H(X), H(X/Y), H(Y/X)和I(X;Y); (2) 求该信道的信道容量及其达到信道容量时的输入概率分布; 解: 1) symbol bit Y X H X H Y X I symbol bit X Y H Y H X H Y X H X Y H Y H Y X H X H Y X I symbol bit y p Y H x y p x p x y p x p y x p y x p y p x y p x p x y p x p y x p y x p y p symbol bit x y p x y p x p X Y H symbol bit x p X H j j i j i j i j i i i / 062.0749.0811.0)/()();(/ 749.0918.0980.0811.0)/()()()/() /()()/()();(/ 980.0)4167.0log 4167.05833.0log 5833.0()()(4167 .03 2 413143)/()()/()()()()(5833.031 413243)/()()/()()()()(/ 918.0 10 log )3 2 lg 324131lg 314131lg 314332lg 3243( ) /(log )/()()/(/ 811.0)41 log 4143log 43()()(222221212221221211112111222=-==-==+-=+-=-=-==?+?-=-==?+?=+=+==?+?= +=+==??+?+?+?-=-==?+?-=-=∑∑∑∑ 2) 2221122 max (;)log log 2(lg lg )log 100.082 /3333 mi C I X Y m H bit symbol ==-=++?=其最佳输入分布为1 ()2 i p x = 3-2某信源发送端有2个符号,i x ,i =1,2;()i p x a =,每秒发出一个符号。接受端有3 种符号i y ,j =1,2,3,转移概率矩阵为1/21/201/21/41/4P ?? =? ? ?? 。 (1) 计算接受端的平均不确定度; (2) 计算由于噪声产生的不确定度(|)H Y X ; (3) 计算信道容量。 1. 有一个马尔可夫信源,已知p(x 1|x 1)=2/3,p(x 2|x 1)=1/3,p(x 1|x 2)=1,p(x 2|x 2)=0,试画出该信源的香农线图,并求出信源熵。 解:该信源的香农线图为: 1/3 ○ ○ 2/3 (x 1) 1 (x 2) 在计算信源熵之前,先用转移概率求稳定状态下二个状态x 1和 x 2 的概率)(1x p 和)(2x p 立方程:)()()(1111x p x x p x p =+)()(221x p x x p =)()(2132x p x p + )()()(1122x p x x p x p =+)()(222x p x x p =)(0)(2131x p x p + )()(21x p x p +=1 得4 3 1)(=x p 4 12)(=x p 马尔可夫信源熵H = ∑∑- I J i j i j i x x p x x p x p )(log )()( 得 H=0.689bit/符号 2.设有一个无记忆信源发出符号A 和B ,已知4 341)(.)(= =B p A p 。求: ①计算该信源熵; ②设该信源改为发出二重符号序列消息的信源,采用费诺编码方法,求其平均信息传输速率; ③又设该信源改为发三重序列消息的信源,采用霍夫曼编码方法,求其平均信息传输速率。 解:①∑- =X i i x p x p X H )(log )()( =0.812 bit/符号 ②发出二重符号序列消息的信源,发出四种消息的概率分别为 用费诺编码方法 代码组 b i BB 0 1 BA 10 2 AB 110 3 AA 111 3 无记忆信源 624.1)(2)(2 ==X H X H bit/双符号 平均代码组长度 2B =1.687 bit/双符号 B X H R )(22==0.963 bit/码元时间 ③三重符号序列消息有8个,它们的概率分别为 用霍夫曼编码方法 代码组 b i BBB 64 27 0 0 1 BBA 64 9 0 )(6419 1 110 3 4-1 设有一个二元等该率信源{}1,0∈X ,2/110==p p ,通过一个二进制对称信道(BSC )。其失真函数ij d 与信道转移概率ij p 分别定义为 j i j i d ij =≠???=,0,1 ,j i j i p ij =≠? ??-=,1,εε 试求失真矩阵d 和平均失真D 。 解:由题意得, 失真矩阵为d ??????=0110d ,信道转移概率矩阵为P ?? ????--=εεεε11)(i j 平均失真为ε εεεε=?-+?+?+?-= =∑0)1(211211210)1(21),()()(,j i d i j p i p D j i 4-3 设输入符号与输出符号X 和Y 均取值于{0,1,2,3},且输入符号的概率分布为P(X=i)=1/4,i=0,1,2,3,设失真矩阵为 ????? ???????=0111101111011110d 求)(),(,,max min max min D R D R D D 以及相应的编码器转移概率矩阵。 解:由题意,得 0min =D 则symbol bit X H R D R /24log )()0()(2min ==== 这时信源无失真,0→0,1→1,2→2,3→3,相应的编码器转移概率矩阵为 ????? ???????=1000 010*********)j (i P ∑===30 3,2,1,0max ),()(min i j j i d i p D ,,14 1141041141141141141041min{?+?+?+??+?+?+?= }04 1141141141141041141141?+?+?+??+?+?+?, 43}43,43,43,43min{== 则0)(max =D R 此时输出概率分布可有多种,其中一种为:p(0)=1,p(1)=p(2)=p(3)=0 则相应的编码器转移概率矩阵为????? ???????=0001000100010001)(i j P 信息论与编码期中试题答案 一、(10’)填空题 (1)1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 (2)必然事件的自信息是0 。 (3)离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的N倍。 (4)对于离散无记忆信源,当信源熵有最大值时,满足条件为__信源符号等概分布_。 (5)若一离散无记忆信源的信源熵H(X)等于2.5,对信源进行等长的无失真二进制编码,则编码长度至少为 3 。 二、(10?)判断题 (1)信息就是一种消息。(? ) (2)信息论研究的主要问题是在通信系统设计中如何实现信息传输、存储和处理的有效性和可靠性。(? ) (3)概率大的事件自信息量大。(? ) (4)互信息量可正、可负亦可为零。(? ) (5)信源剩余度用来衡量信源的相关性程度,信源剩余度大说明信源符号间的依赖关系较小。 (? ) (6)对于固定的信源分布,平均互信息量是信道传递概率的下凸函数。(? ) (7)非奇异码一定是唯一可译码,唯一可译码不一定是非奇异码。(? ) (8)信源变长编码的核心问题是寻找紧致码(或最佳码)。 (? ) (9)信息率失真函数R(D)是关于平均失真度D的上凸函数. ( ? ) 三、(10?)居住在某地区的女孩中有25%是大学生,在女大学生中有75%是身高1.6米以上的,而女孩中身高1.6米以上的占总数的一半。 假如我们得知“身高1.6米以上的某女孩是大学生”的消息,问获得多少信息量? 解:设A表示“大学生”这一事件,B表示“身高1.60以上”这一事件,则 P(A)=0.25 p(B)=0.5 p(B|A)=0.75 (5分) 故p(A|B)=p(AB)/p(B)=p(A)p(B|A)/p(B)=0.75*0.25/0.5=0.375 (4分) I(A|B)=-log0.375=1.42bit (1分) 2-1.解:该一阶马尔可夫信源,由转移概率构成的转移矩阵为: 对应的状态图如右图所示。设各符号稳定概率为:1p ,2p ,3p 则可得方程组: 1p = 211p +312p +313p 2p =211p +323p 3p =3 22p 1p +2p +3p =1 解得各符号稳态概率为: 1p = 2510,2p =259,3p =25 6 2-2.解:该马尔可夫信源的符号条件概率矩阵为: 状态转移概率矩阵为: 对应的状态图如右图所示。 设各状态的稳态分布概率为1W ,2W ,3W ,4W ,则可得方程组为: 1W =0.81W +0.53W 2W =0.21W +0.53W 3W =0.52W +0.24W 4W =0.52W +0.84W 1W +2W +3W +4W =1 解得稳定分布的概率为: 1W = 145,2W =142,3W =142,4W =14 5 2-3.解:(1)“3和5同时出现”事件的概率为: p(3,5)= 18 1 故其自信息量为: I(3,5)=-㏒2 18 1 =4.17bit (2)“两个1同时出现”事件的概率为: p(1,1)= 36 1 故其自信息量为: I(1,1)=- ㏒2 36 1 =5.17bit (3)两个点数的各种组合构成的信源,其概率空间为: 则该信源熵为: H(x 1)=6× 36 1 lb36+15×181lb18=4.337bit/事件 (4)两个点数之和构成的信源,其概率空间为: 则该信源的熵为: H(x 2)=2× 361 lb36+2×181lb18+2×121lb12+2×91lb9+2×365lb 536+6 1lb6 =3.274bit/事件 (5)两个点数中至少有一个是1的概率为: p(1)= 36 11 故其自信息量为: I(1)= -㏒2 36 11 =1.7105bit 2-7.解:(1)离散无记忆信源的每个符号的自信息量为 I(x 1)= -㏒2 83 =1.415bit I(x 2)= -㏒241 =2bit I(x 3)= -㏒241 =2bit I(x 4)= -㏒28 1 =3bit (2)由于信源发出消息符号序列有12个2,14个0,13个1,6个3,故该消息符 号序列的自信息量为: I(x)= -㏒2( 8 3)14 (41)25 (81)6 =87.81bit 平均每个符号携带的信息量为: L H (x)= 45 ) (x I =1.95bit/符号 2-10 解:用1x 表示第一次摸出的球为黑色,用2x 表示第一次摸出的球为白色,用1y 表示第二次摸出的球为黑色,用2y 表示第二次摸出的球为白色,则 (1)一次实验包含的不确定度为: H(X)=-p(1x )lbp(1x )-p(2x )lbp(2x )=- 13lb 13-23lb 2 3 =0.92 bit (2)第一次实验X 摸出的球是黑色,第二次实验Y 给出的不确定度: H(Y|1x )=-p(1y |1x )lb p(1y |1x )-p(2y |1x )lb p(2y |1x ) = - 27lb 27-57lb 57 = 0.86 bit (3)第一次实验X 摸出的球是白色,第二次实验Y 给出的不确定度: 第二章 信息量和熵 2.2 八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的 信息速率。 解:同步信息均相同,不含信息,因此 每个码字的信息量为 2?8log =2?3=6 bit 因此,信息速率为 6?1000=6000 bit/s 2.3 掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。问各得到多少信 息量。 解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1} )(a p =366=6 1 得到的信息量 =) (1 log a p =6log =2.585 bit (2) 可能的唯一,为 {6,6} )(b p =361 得到的信息量=) (1 log b p =36log =5.17 bit 2.4 经过充分洗牌后的一副扑克(52张),问: (a) 任何一种特定的排列所给出的信息量是多少? (b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量? 解:(a) )(a p =! 521 信息量=) (1 log a p =!52log =225.58 bit (b) ???????花色任选 种点数任意排列 13413!13 )(b p =13 52134!13A ?=1352 13 4C 信息量=1313 52 4log log -C =13.208 bit 2.9 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的 点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、 ),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。 解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立, 则1x X =,21x x Y +=,321x x x Z ++= )|(Y Z H =)(3x H =log 6=2.585 bit )|(X Z H =)(32x x H +=)(Y H =2?( 361log 36+362log 18+363log 12+364log 9+365log 536)+36 6 log 6 =3.2744 bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ] 而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H =1.8955 bit 或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H =1.8955 bit ),|(Y X Z H =)|(Y Z H =)(X H =2.585 bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =1.8955+2.585=4.4805 bit 2.10 设一个系统传送10个数字,0,1,…,9。奇数在传送过程中以0.5的概 率错成另外一个奇数,其余正确接收,求收到一个数字平均得到的信息量。 解: 8,6,4,2,0=i √ );(Y X I =)(Y H -)|(X Y H 因为输入等概,由信道条件可知, 一填空题(本题20分,每小题2分) 1、平均自信息为 表示信源的平均不确定度,也表示平均每个信源消息所提供的信息量。 平均互信息 表示从Y获得的关于每个X的平均信息量,也表示发X前后Y的平均不确定性减少的量,还表示通信前后整个系统不确定性减少的量。 2、最大离散熵定理为:离散无记忆信源,等概率分布时熵最大。 3、最大熵值为。 4、通信系统模型如下: 5、香农公式为为保证足够大的信道容量,可采用(1)用频带换信噪比;(2)用信噪比换频带。 6、只要,当N足够长时,一定存在一种无失真编码。 7、当R<C时,只要码长足够长,一定能找到一种编码方法和译码规则,使译码错误概率无穷小。 8、在认识论层次上研究信息的时候,必须同时考虑到形式、含义和效用三个方面的因素。 9、1948年,美国数学家香农发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。 按照信息的性质,可以把信息分成语法信息、语义信息和语用信息。 按照信息的地位,可以把信息分成客观信息和主观信息。 人们研究信息论的目的是为了高效、可靠、安全地交换和利用各种各样的信息。 信息的可度量性是建立信息论的基础。 统计度量是信息度量最常用的方法。 熵是香农信息论最基本最重要的概念。 事物的不确定度是用时间统计发生概率的对数来描述的。 10、单符号离散信源一般用随机变量描述,而多符号离散信源一般用随机矢量描述。 11、一个随机事件发生某一结果后所带来的信息量称为自信息量,定义为其发生概率对数的负值。 12、自信息量的单位一般有比特、奈特和哈特。 13、必然事件的自信息是 0 。 14、不可能事件的自信息量是∞。 15、两个相互独立的随机变量的联合自信息量等于两个自信息量之和。 16、数据处理定理:当消息经过多级处理后,随着处理器数目的增多,输入消息与输出消息之间的平均互信息量趋于变小。 17、离散平稳无记忆信源X的N次扩展信源的熵等于离散信源X的熵的 N倍。 18、离散平稳有记忆信源的极限熵,。 19、对于n元m阶马尔可夫信源,其状态空间共有 nm 个不同的状态。 20、一维连续随即变量X在[a,b]区间内均匀分布时,其信源熵为 log2(b-a)。 信息论与编码理论习题解 第二章-信息量和熵 解: 平均每个符号长为:154 4.0312.032= ?+?秒 每个符号的熵为9183.03log 3 1 23log 32=?+?比特/符号 所以信息速率为444.34 15 9183.0=?比特/秒 解: 同步信号均相同不含信息,其余认为等概, 每个码字的信息量为 3*2=6 比特; 所以信息速率为600010006=?比特/秒 解:(a)一对骰子总点数为7的概率是 36 6 所以得到的信息量为 585.2)366(log 2= 比特 (b) 一对骰子总点数为12的概率是36 1 所以得到的信息量为 17.536 1 log 2= 比特 解: (a)任一特定排列的概率为 ! 521 ,所以给出的信息量为 58.225! 521 log 2 =- 比特 (b) 从中任取13张牌,所给出的点数都不相同的概率为 1352 13 13 521344!13C A =? 所以得到的信息量为 21.134 log 1313 52 2=C 比特. 解:易证每次出现i 点的概率为 21 i ,所以 比特比特比特比特比特比特比特398.221 log 21)(807.1)6(070.2)5(392.2)4(807.2)3(392.3)2(392.4)1(6,5,4,3,2,1,21 log )(26 12=-==============-==∑ =i i X H x I x I x I x I x I x I i i i x I i 解: 可能有的排列总数为 27720! 5!4!3! 12= 没有两棵梧桐树相邻的排列数可如下图求得, Y X Y X Y X Y X Y X Y X Y X Y 图中X 表示白杨或白桦,它有???? ??37种排法,Y 表示梧桐树可以栽 种的位置,它有???? ??58种排法,所以共有???? ??58*???? ??37=1960种排法保证没有 两棵梧桐树相邻,因此若告诉你没有两棵梧桐树相邻时,得到关于树排列的信息为1960log 27720log 22-= 比特 解: X=0表示未录取,X=1表示录取; Y=0表示本市,Y=1表示外地; Z=0表示学过英语,Z=1表示未学过英语,由此得 《信息论与编码(第二版)》曹雪虹答案 第二章 2.1一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =, ()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。 解:状态图如下 状态转移矩阵为: 1/21/2 01/302/31/32/30p ?? ?= ? ??? 设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3 由1231WP W W W W =??++=?得1231132231231 112331223231W W W W W W W W W W W W ?++=???+=???=???++=? 计算可得1231025925625W W W ?=??? =? ? ?=?? 2.2 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2, (1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。画出 状态图,并计算各状态的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 没文化,真可怕!!! 第三章 3.1 设二元对称信道的传递矩阵为? ?????????32313132 (1) 若P(0) = 3/4, P(1) = 1/4,求H(X), H(X/Y), H(Y/X)和I(X;Y); (2) 求该信道的信道容量及其达到信道容量时的输入概率分布; 解: 1) symbol bit Y X H X H Y X I symbol bit X Y H Y H X H Y X H X Y H Y H Y X H X H Y X I symbol bit y p Y H x y p x p x y p x p y x p y x p y p x y p x p x y p x p y x p y x p y p symbol bit x y p x y p x p X Y H symbol bit x p X H j j i j i j i j i i i / 062.0749.0811.0)/()();(/ 749.0918.0980.0811.0)/()()()/() /()()/()();(/ 980.0)4167.0log 4167.05833.0log 5833.0()()(4167 .03 2 413143)/()()/()()()()(5833.031 413243)/()()/()()()()(/ 918.0 10 log )3 2 lg 324131lg 314131lg 314332lg 3243( ) /(log )/()()/(/ 811.0)41 log 4143log 43()()(222221212221221211112111222=-==-==+-=+-=-=-==?+?-=-==?+?=+=+==?+?= +=+==??+?+?+?-=-==?+?-=-=∑∑∑∑ 2) 2221122 max (;)log log 2(lg lg )log 100.082 /3333 mi C I X Y m H bit symbol ==-=++?=其最佳输入分布为1 ()2 i p x = 3-2某信源发送端有2个符号,i x ,i =1,2;()i p x a =,每秒发出一个符号。接受端有3 种符号i y ,j =1,2,3,转移概率矩阵为1/21/201/21/41/4P ?? =???? 。 (1) 计算接受端的平均不确定度; 一个马尔可夫信源有3个符号{}1,23,u u u ,转移概率为:()11|1/2p u u =,()21|1/2p u u =, ()31|0p u u =,()12|1/3p u u =,()22|0p u u =,()32|2/3p u u =,()13|1/3p u u =,()23|2/3p u u =,()33|0p u u =,画出状态图并求出各符号稳态概率。 解:状态图如下 状态转移矩阵为: 1/21/2 01/302/31/32/30p ?? ?= ? ??? 设状态u 1,u 2,u 3稳定后的概率分别为W 1,W 2、W 3 由1231WP W W W W =??++=?得1231132231231 112331223 231W W W W W W W W W W W W ?++=???+=???=???++=? 计算可得1231025925625W W W ?=??? =?? ?=?? 由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =,(0|11)p =,(1|00)p =, (1|11)p =,(0|01)p =,(0|10)p =,(1|01)p =,(1|10)p =。画出状态图,并计算各状态 的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 一、填空题(每空1分,共35分) 1、1948年,美国数学家 发表了题为“通信的数学理论”的长篇论文,从而创立了信息论。信息论的基础理论是 ,它属于狭义信息论。 2、信号是 的载体,消息是 的载体。 3、某信源有五种符号}{,,,,a b c d e ,先验概率分别为5.0=a P ,25.0=b P ,125.0=c P ,0625.0==e d P P ,则符号“a ”的自信息量为 bit ,此信源的熵为 bit/符号。 4、某离散无记忆信源X ,其概率空间和重量空间分别为1 234 0.50.250.1250.125X x x x x P ????=??? ?????和1234 0.5122X x x x x w ???? =??????? ? ,则其信源熵和加权熵分别为 和 。 5、信源的剩余度主要来自两个方面,一是 ,二是 。 6、平均互信息量与信息熵、联合熵的关系是 。 7、信道的输出仅与信道当前输入有关,而与过去输入无关的信道称为 信道。 8、马尔可夫信源需要满足两个条件:一、 ; 二、 。 9、若某信道矩阵为????? ????? ??01000 1 000001 100,则该信道的信道容量C=__________。 10、根据是否允许失真,信源编码可分为 和 。 11、信源编码的概率匹配原则是:概率大的信源符号用 ,概率小的信源符号用 。(填 短码或长码) 12、在现代通信系统中,信源编码主要用于解决信息传输中的 性,信道编码主要用于解决信息传输中的 性,保密密编码主要用于解决信息传输中的安全性。 13、差错控制的基本方式大致可以分为 、 和混合纠错。 14、某线性分组码的最小汉明距dmin=4,则该码最多能检测出 个随机错,最多能纠正 个随机错。 15、码字101111101、011111101、100111001之间的最小汉明距离为 。 16、对于密码系统安全性的评价,通常分为 和 两种标准。 17、单密钥体制是指 。 18、现代数据加密体制主要分为 和 两种体制。 19、评价密码体制安全性有不同的途径,包括无条件安全性、 和 。 20、时间戳根据产生方式的不同分为两类:即 和 。 二、选择题(每小题1分,共10分) 1、下列不属于消息的是( )。 A. 文字 B. 信号 C. 图像 D. 语言 2、设有一个无记忆信源发出符号A 和B ,已知4341)(,)(==B p A p ,发出二重符号序列消息的信源, 无记忆信源熵)(2X H 为( )。 A. 0.81bit/二重符号 B. 1.62bit/二重符号 C. 0.93 bit/二重符号 D . 1.86 bit/二重符号 3、 同时扔两个正常的骰子,即各面呈现的概率都是1/6,若点数之和为12,则得到的自信息为( )。 A. -log36bit B. log36bit C. -log (11/36)bit D. log (11/36)bit 4、 二进制通信系统使用符号0和1,由于存在失真,传输时会产生误码,用符号表示下列事件,x0: 发出一个0 、 x1: 发出一个1、 y0 : 收到一个0、 y1: 收到一个1 ,则已知收到的符号,被告知发出的符号能得到的信息量是( )。 A. H(X/Y) B. H(Y/X) C. H( X, Y) D. H(XY) 5、一个随即变量x 的概率密度函数P(x)= x /2,V 20≤≤x ,则信源的相对熵为( )。 A . 0.5bit B. 0.72bit C. 1bit D. 1.44bit 6、 下面哪一项不属于熵的性质: ( ) A .非负性 B .完备性 C .对称性 D .确定性 信息论与编码 信息论与编码 信息论与编码习题参考答案 第一章 单符号离散信源 同时掷一对均匀的子,试求: (1)“2和6同时出现”这一事件的自信息量; (2)“两个5同时出现”这一事件的自信息量; (3)两个点数的各种组合的熵; (4)两个点数之和的熵; (5)“两个点数中至少有一个是1”的自信息量。 解: bit P a I N n P bit P a I N n P c c N 17.536log log )(361 )2(17.418log log )(362)1(36 662221111 616==-=∴====-=∴== =?==样本空间: (3)信源空间: bit x H 32.436log 36 16236log 36215)(=??+?? =∴ (4)信源空间: bit x H 71.3636 log 366536log 3610 436log 368336log 366236log 36436log 362)(=??+?+?+??= ∴++ (5) bit P a I N n P 17.111 36 log log )(3611333==-=∴== 如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它们的坐标分别为(Xa ,Ya ), (Xb ,Yb ),但A ,B 不能同时落入同一方格内。 (1) 若仅有质点A ,求A 落入任一方格的平均信息量; (2) 若已知A 已落入,求B 落入的平均信息量; (3) 若A ,B 是可辨认的,求A ,B 落入的平均信息量。 解: bit a P a P a a P a I a P A i 58.548log )(log )()(H 48log )(log )(481 )(:)1(48 1 i i i i i ==-=∴=-=∴= ∑=落入任一格的概率Θ bit b P b P b b P b I b P A i 55.547log )(log )()(H 47 log )(log )(47 1 )(:B ,)2(48 1i i i i i ==-=∴=-=∴=∑=落入任一格的概率是落入任一格的情况下在已知Θ 模拟试题一 一、概念简答题(共10题,每题5分) 1.简述离散信源和连续信源的最大熵定理。 2.什么是平均自信息(信息熵)?什么是平均互信息?比较一下两个概念的异同之处。 3.解释等长信源编码定理和无失真变长信源编码定理,说明对于等长码和变长码,最佳码的每符号平均码长最小为多少?编码效率最高可达多少? 4.解释最小错误概率译码准则,最大似然译码准则和最小距离译码准则,说明三者的关系。 5.设某二元码字C={111000,001011,010110,101110}, ①假设码字等概率分布,计算此码的编码效率? ②采用最小距离译码准则,当接收序列为110110时,应译成什么码字? 6.一平稳二元信源,它在任意时间,不论以前发出过什么符号,都按发出符 号,求和平均符号熵 7.分别说明信源的概率分布和信道转移概率对平均互信息的影响,说明平均互信息与信道容量的关系。 8.二元无记忆信源,有求: (1)某一信源序列由100个二元符号组成,其中有m个“1”,求其自信息量? (2)求100个符号构成的信源序列的熵。 9.求以下三个信道的信道容量: ,, 10.已知一(3,1,3)卷积码编码器,输入输出关系为: 试给出其编码原理框图。 二、综合题(共5题,每题10分) 1.二元平稳马氏链,已知P(0/0)=0.9,P(1/1)=0.8,求: (1)求该马氏信源的符号熵。 (2)每三个符号合成一个来编二进制Huffman码,试建立新信源的模型,给出编码结果。 (3)求每符号对应的平均码长和编码效率。 2.设有一离散信道,其信道矩阵为,求: (1)最佳概率分布? (2)当,时,求平均互信息信道疑义度 (3)输入为等概率分布时,试写出一译码规则,使平均译码错误率最小,并求此 3.设线性分组码的生成矩阵为,求: (1)此(n,k)码的n=? k=?,写出此(n,k)码的所有码字。 (2)求其对应的一致校验矩阵H。 (3)确定最小码距,问此码能纠几位错?列出其能纠错的所有错误图样和对应的伴随式。 (4)若接收码字为000110,用伴随式法求译码结果。 4.二元对称信道的信道矩阵为,信道传输速度为1500二元符号/秒,设信源为等概率分布,信源消息序列共有13000个二元符号,问: (1)试计算能否在10秒内将信源消息序列无失真传送完? (2)若信源概率分布为,求无失真传送以上信源消息序列至少需要多长时间? 5.已知(7,4)循环码的生成多项式,求: (1)求该码的编码效率? (2)求其对应的一致校验多项式 1-3 (5分)请简述一个通信系统中包括的各主要功能模块及其作用。 一般的通信系统模型如上图所示。一个通信系统的主要功能模块包括信源、信道、信宿、信源编码、信道编码等。各功能模块的作用分别为: 1)信源:信源是产生消息的源,消息是信息的载体。 2)信宿:信宿是消息传送的对象。 3)信道:信道是信号从信源传送到信宿的通路。 4)干扰源:整个通信系统中各种干扰的集中反映。 5)信源编码:压缩冗余度,提高通信系统传输消息的效率。 6)信道编码:提高信息传输的可靠性。 7)加密编码:提高通信的安全性。 8)解码(译码):是编码的逆过程,译码有信源译码、信道译码、解密译码。 2-2(10分)由符号集{0,1}组成的二阶马尔可夫链,其转移概率为:(0|00)p =0.8,(0|11)p =0.2,(1|00)p =0.2,(1|11)p =0.8,(0|01)p =0.5,(0|10)p =0.5,(1|01)p =0.5,(1|10)p =0.5。画出状态图,并计算各状态的稳态概率。 解:(0|00)(00|00)0.8p p == (0|01)(10|01)0.5p p == (0|11)(10|11)0.2p p == (0|10)(00|10)0.5p p == (1|00)(01|00)0.2p p == (1|01)(11|01)0.5p p == (1|11)(11|11)0.8p p == (1|10)(01|10)0.5p p == 于是可以列出转移概率矩阵:0.80.20 0000.50.50.50.500000.20.8p ?? ? ?= ? ??? 状态图为: 设各状态00,01,10,11的稳态分布概率为W 1,W 2,W 3,W 4 有 41 1i i WP W W ==???=??∑ 得 131 132 24324412340.80.50.20.50.50.20.50.81W W W W W W W W W W W W W W W W +=??+=??+=??+=?+++=?? 计算得到123451417175 14W W W W ?=?? ?=?? ?=???= ? 2-6 (5分)掷两颗骰子,当其向上的面的小圆点之和是3时,该消息包含的信息量是多少? 当小圆点之和是7时,该消息所包含的信息量又是多少? 解:1)因圆点之和为3的概率1 ()(1,2)(2,1)18 p x p p =+= 该消息自信息量()log ()log18 4.170I x p x bit =-==答案~信息论与编码练习

信息论与编码试卷与答案

信息论与编码试题集与答案(2014)

信息论与编码试卷及答案(多篇)

信息论与编码第三章曹雪虹习题答案

信息论与编码课后习题答案

信息论与编码习题与答案第四章

信息论与编码期中试卷及答案

信息论与编码(曹雪虹_张宗橙)第二、三章答案

信息论与编码理论习题答案

信息论与编码试题集与答案

信息论与编码理论课后习题答案高等教育出版社

信息论与编码(第二版)曹雪虹(最全版本)答案

信息论与编码第三章曹雪虹习题答案

信息论与编码课后答案

信息理论与编码期末试卷A及答案

信息论与编码习题参考答案(全)

信息论与编码试题

信息论与编码第三版一二章练习与答案