数据仓库与数据挖掘实验报告

数据仓库与数据挖掘课程APRIORI算法学习

一简介

Apriori算法是一种挖掘关联规则的频繁项集算法,其核心思想是通过候选集生成和情节的向下封闭检测两个阶段来挖掘频繁项集。而且算法已经被广泛的应用到商业、网络安全等各个领域。它是一种最有影响的挖掘布尔关联规则频繁项集的算法。其核心是基于两阶段频集思想的递推算法。该关联规则在分类上属于单维、单层、布尔关联规则。在这里,所有支持度大于最小支持度的项集称为频繁项集,简称频集[1]。

二基本思想

该算法的基本思想是:首先找出所有的频集,这些项集出现的频繁性至少和预定义的最小支持度一样。然后由频集产生强关联规则,这些规则必须满足最小支持度和最小可信度。然后使用第1步找到的频集产生期望的规则,产生只包含集合的项的所有规则,其中每一条规则的右部只有一项,这里采用的是中规则的定义。一旦这些规则被生成,那么只有那些大于用户给定的最小可信度的规则才被留下来。为了生成所有频集,使用了递归的方法。挖掘步骤:

(1) 依据支持度[2]找出所有频繁项集(频度)。

(2) 依据置信度[3]产生关联规则(强度)。

三核心流程

Apriori算法是一种最有影响的挖掘布尔关联规则频繁项集的算法。是基于这样的事实:算法使用频繁项集性质的先验知识。Apriori使用一种称作逐层搜索的迭代方法,k-项集用于探索(k+1)-项集。首先,找出频繁1-项集的集合。该集合记作L1。L1用于找频繁2-项集的集合L2,而L2用于找L3,如此下去,直到不能找到频繁k-项集。找每个Lk需要一次数据库扫描。

这个算法的思路,简单的说就是如果集合I不是频繁项集,那么所有包含集合I的更大的集合也不可能是频繁项集。

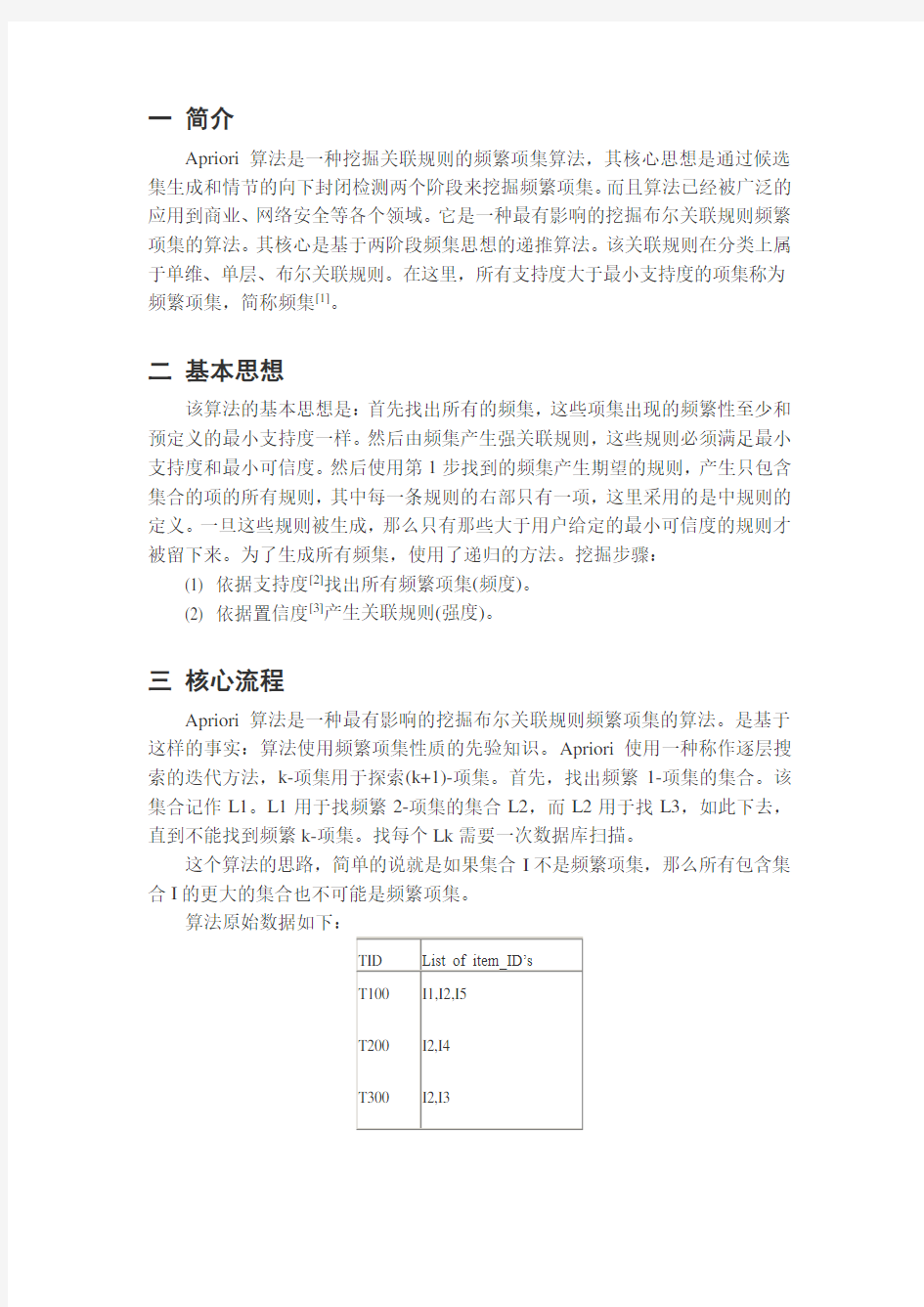

算法原始数据如下:

TID List of item_ID’s

T100 T200 T300 I1,I2,I5 I2,I4 I2,I3

T400 T500

T600 T700 T800 T900

I1,I2,I4 I1,I3 I2,I3 I1,I3 I1,I2,I3,I5 I1,I2,I3

算法的基本过程如下图:

首先扫描所有事务,得到1-项集C1,根据支持度要求滤去不满足条件项集,得到频繁1-项集。

下面进行递归运算:

已知频繁k-项集(频繁1-项集已知),根据频繁k-项集中的项,连接得到所有可能的K+1_项,并进行剪枝(如果该k+1_项集的所有k 项子集不都能满足支持度条件,那么该k+1_项集被剪掉),得到1+k C 项集,然后滤去该1+k C 项集中不满

足支持度条件的项得到频繁k+1-项集。如果得到的1 k C 项集为空,则算法结束。

连接的方法:假设k L 项集中的所有项都是按照相同的顺序排列的,那么如果

]

[i k L 和

]

[j k L 中的前k-1项都是完全相同的,而第k 项不同,则

]

[i k L 和

]

[j k L 是可连

接的。比如2L 中的{I1,I2}和{I1,I3}就是可连接的,连接之后得到{I1,I2,I3},但是{I1,I2}和{I2,I3}是不可连接的,否则将导致项集中出现重复项。

关于剪枝再举例说明一下,如在由2L 生成3L 的过程中,列举得到的3_项集包括{I1,I2,I3},{I1,I3,I5},{I2,I3,I4},{I2,I3,I5},{I2,I4,I5},但是由于{I3,I4}和{I4,I5}没有出现在2L 中,所以{I2,I3,I4},{I2,I3,I5},{I2,I4,I5}被剪枝掉了。

简单的讲:

发现频繁项集,过程为(1)扫描(2)计数(3)比较(4)产生频繁项集(5)连接、剪枝,产生候选项集。重复步骤(1)~(5)直到不能发现更大的频集。

2、产生关联规则,过程为:根据前面提到的置信度的定义,关联规则的产生如下:

(1)对于每个频繁项集L ,产生L 的所有非空子集; (2)对于L 的每个非空子集S ,如果 P (L )/P (S )≧min_conf 则输出规则“S àL-S ”

注:L-S 表示在项集L 中除去S 子集的项集 伪代码 伪代码描述: // 找出频繁 1 项集

L1 =find_frequent_1-itemsets(D);

For(k=2;Lk-1 !=null;k++){

// 产生候选,并剪枝

Ck =apriori_gen(Lk-1 );

// 扫描 D 进行候选计数

For each 事务t in D{

Ct =subset(Ck,t); // 得到 t 的子集 For each 候选 c 属于 Ct c.count++; }

//返回候选项集中不小于最小支持度的项集

Lk ={c 属于 Ck | c.count>=min_sup}

}

Return L= 所有的频繁集;

第一步:连接(join)

Procedure apriori_gen (Lk-1 :frequent(k-1)-itemsets)

For each 项集l1 属于Lk-1

For each 项集l2 属于Lk-1

If( (l1 [1]=l2 [1])&&( l1 [2]=l2 [2])&& ……&& (l1 [k-2]=l2 [k-2])&&(l1 [k-1] then{ c = l1 连接l2 // 连接步:产生候选 //若k-1项集中已经存在子集c则进行剪枝 if has_infrequent_subset(c, Lk-1 ) then delete c; // 剪枝步:删除非频繁候选 else add c to Ck; } Return Ck; 第二步:剪枝(prune) Procedure has_infrequent_sub (c:candidate k-itemset; Lk-1 :frequent(k-1)-itemsets) For each (k-1)-subset s of c If s 不属于Lk-1 then Return true; Return false; 四具体实例及代码实现 交易ID 商品ID列表 T100 I1,I2,I5 T200 I2,I4 T300 I2,I3 T400 I1,I2,I4 T500 I1,I3 T600 I2,I3 T700 I1,I3 T800 I1,I2,I3,I5 T900 I1,I2,I3 上图为某商场的交易记录,共有9个事务,利用Apriori算法寻找所有的频繁项集的过程如下: 详细介绍下候选3项集的集合C3的产生过程:从连接步,首先C3={{I1,I2,I3},{I1,I2,I5},{I1,I3,I5},{I2,I3,I4},{I2,I3,I5},{I2,I4,I5}}(C3是由L2与自身连接产生)。根据Apriori性质,频繁项集的所有子集也必须频繁的,可以确定有4个候选集{I1,I3,I5},{I2,I3,I4},{I2,I3,I5},{I2,I4,I5}}不可能时频繁的,因为它们存在子集不属于频繁集,因此将它们从C3中删除。注意,由于Apriori算法使用逐层搜索技术,给定候选k项集后,只需检查它们的(k-1)个子集是否频繁。 伪代码: L1=find_frequent_1-itemsets(D); // 找出所有频繁1项集 For(k=2;Lk-1!=null;k++){ Ck=apriori_gen(Lk-1); // 产生候选,并剪枝 For each 事务t in D{ // 扫描D进行候选计数 Ct =subset(Ck,t); // 得到t的子集 For each 候选c 属于Ct c.count++; } Lk={c属于Ck | c.count>=min_sup} } Return L=所有的频繁集; Procedure apriori_gen(Lk-1:frequent(k-1)-itemsets) For each项集l1属于Lk-1 For each项集l2属于Lk-1 If((l1[1]=l2[1])&&( l1[2]=l2[2])&&…….. && (l1[k-2]=l2[k-2])&&(l1[k-1] c=l1连接l2 //连接步:产生候选 if has_infrequent_subset(c,Lk-1) then delete c; //剪枝步:删除非频繁候选 else add c to Ck; } Return Ck; Procedure has_infrequent_sub(c:candidate k-itemset; Lk-1:frequent(k-1)-itemsets) For each(k-1)-subset s of c If s不属于Lk-1 then Return true; Return false; Java代码 package com.apriori; import java.util.ArrayList; import java.util.Collections; import java.util.HashMap; import java.util.List; import java.util.Map; import java.util.Set; public class Apriori { private final static int SUPPORT = 2; // 支持度阈值 private final static double CONFIDENCE = 0.7; // 置信度阈值 private final static String ITEM_SPLIT=";"; // 项之间的分隔符 private final static String CON="->"; // 项之间的分隔符 private final static List static{//初始化交易记录 transList.add("1;2;5;"); transList.add("2;4;"); transList.add("2;3;"); transList.add("1;2;4;"); transList.add("1;3;"); transList.add("2;3;"); transList.add("1;3;"); transList.add("1;2;3;5;"); transList.add("1;2;3;"); } public Map Map frequentCollectionMap.putAll(getItem1FC()); Map itemkFcMap.putAll(getItem1FC()); while(itemkFcMap!=null&&itemkFcMap.size()!=0){ Map candidateCollection=getCandidateCollection(itemkFcMap); Set //对候选集项进行累加计数 for(String trans:transList){ for(String candidate:ccKeySet){ boolean flag=true;// 用来判断交易中是否出现该候选项,如果出现,计数加1 String[] candidateItems=candidate.split(ITEM_SPLIT); for(String candidateItem:candidateItems){ if(trans.indexOf(candidateItem+ITEM_SPLIT)==-1){ flag=false; break; } } if(flag){ Integer count=candidateCollection.get(candidate); candidateCollection.put(candidate, count+1); } } } //从候选集中找到符合支持度的频繁集项 itemkFcMap.clear(); for(String candidate:ccKeySet){ Integer count=candidateCollection.get(candidate); if(count>=SUPPORT){ itemkFcMap.put(candidate, count); } } //合并所有频繁集 frequentCollectionMap.putAll(itemkFcMap); } return frequentCollectionMap; } private Map Map HashMap Set Set for(String itemk1:itemkSet1){ for(String itemk2:itemkSet2){ //进行连接 String[] tmp1=itemk1.split(ITEM_SPLIT); String[] tmp2=itemk2.split(ITEM_SPLIT); String c=""; if(tmp1.length==1){ if(tmp1[0].compareTo(tmp2[0])<0){ c=tmp1[0]+ITEM_SPLIT+tmp2[0]+ITEM_SPLIT; } }else{ boolean flag=true; for(int i=0;i if(!tmp1[i].equals(tmp2[i])){ flag=false; break; } } if(flag&&(tmp1[tmp1.length-1].compareTo(tmp2[tmp2.length-1])<0)){ c=itemk1+tmp2[tmp2.length-1]+ITEM_SPLIT; } } //进行剪枝 boolean hasInfrequentSubSet = false; if (!c.equals("")) { String[] tmpC = c.split(ITEM_SPLIT); for (int i = 0; i < tmpC.length; i++) { String subC = ""; for (int j = 0; j < tmpC.length; j++) { if (i != j) { subC = subC+tmpC[j]+ITEM_SPLIT; } } if (itemkFcMap.get(subC) == null) { hasInfrequentSubSet = true; break; } } }else{ hasInfrequentSubSet=true; } if(!hasInfrequentSubSet){ candidateCollection.put(c, 0); } } } return candidateCollection; } private Map Map HashMap Map HashMap for(String trans:transList){ String[] items=trans.split(ITEM_SPLIT); for(String item:items){ Integer count=sItem1FcMap.get(item+ITEM_SPLIT); if(count==null){ sItem1FcMap.put(item+ITEM_SPLIT, 1); }else{ sItem1FcMap.put(item+ITEM_SPLIT, count+1); } } } Set for(String key:keySet){ Integer count=sItem1FcMap.get(key); if(count>=SUPPORT){ rItem1FcMap.put(key, count); } } return rItem1FcMap; } public Map Map HashMap Set for (String key : keySet) { double countAll=frequentCollectionMap.get(key); String[] keyItems = key.split(ITEM_SPLIT); if(keyItems.length>1){ List Collections.addAll(source, keyItems); List ArrayList buildSubSet(source,result);//获得source的所有非空子集 for(List if(itemList.size() List for(String sourceItem:source){ if(!itemList.contains(sourceItem)){ otherList.add(sourceItem); } } String reasonStr="";//前置 String resultStr="";//结果 for(String item:itemList){ reasonStr=reasonStr+item+ITEM_SPLIT; } for(String item:otherList){ resultStr=resultStr+item+ITEM_SPLIT; } double countReason=frequentCollectionMap.get(reasonStr); double itemConfidence=countAll/countReason;//计算置信度 if(itemConfidence>=CONFIDENCE){ String rule=reasonStr+CON+resultStr; relationRules.put(rule, itemConfidence); } } } } } return relationRules; } private void buildSubSet(List // 仅有一个元素时,递归终止。此时非空子集仅为其自身,所以直接添加到result中 if (sourceSet.size() == 1) { List set.add(sourceSet.get(0)); result.add(set); } else if (sourceSet.size() > 1) { // 当有n个元素时,递归求出前n-1个子集,在于result 中 buildSubSet(sourceSet.subList(0, sourceSet.size() - 1), result); int size = result.size();// 求出此时result的长度,用于后面的追加第n个元素时计数 // 把第n个元素加入到集合中 List single.add(sourceSet.get(sourceSet.size() - 1)); result.add(single); // 在保留前面的n-1子集的情况下,把第n个元素分别加到前n个子集中,并把新的集加入到result中; // 为保留原有n-1的子集,所以需要先对其进行复制 List for (int i = 0; i < size; i++) { clone = new ArrayList for (String str : result.get(i)) { clone.add(str); } clone.add(sourceSet.get(sourceSet.size() - 1)); result.add(clone); } } } public static void main(String[] args){ Apriori apriori=new Apriori(); Map System.out.println("----------------频繁集"+"----------------"); Set for(String fcKey:fcKeySet){ System.out.println(fcKey+" : "+frequentCollectionMap.get(fcKey)); } Map relationRulesMap=apriori.getRelationRules(frequentCollectionMap); System.out.println("----------------关联规则"+"----------------"); Set for(String rrKey:rrKeySet){ System.out.println(rrKey+" : "+relationRulesMap.get(rrKey)); } } } 五缺点 海量数据下,Apriori算法的时空复杂度都不容忽视。 空间复杂度:如果数量达到的量级,那么中的候选项将达到的量级。由频繁k-1项集进行自连接生成的候选频繁k项集数量巨大。 时间复杂度:每计算一次就需要扫描一遍数据库。在验证候选频繁k项集的时候需要对整个数据库进行扫描,非常耗时。 六改进与优化 上网搜索查到的频集算法的几种优化方法:1. 基于划分的方法。2. 基于hash 的方法。3. 基于采样的方法。4. 减少交易的个数。 我看了下“基于划分的方法”改进算法,其实现思想: 基于划分(partition)的算法,这个算法先把数据库从逻辑上分成几个互不相交的块,每次单独考虑一个分块并对它生成所有的频集,然后把产生的频集合并,用来生成所有可能的频集,最后计算这些项集的支持度。 其中,partition算法要注意的是分片的大小选取,要保证每个分片可以被放入到内存。当每个分片产生频集后,再合并产生产生全局的候选k-项集。若在多个处理器分片,可以通过处理器之间共享一个杂凑树来产生频集。 七应用 Apriori(先验的,推测的)算法应用广泛,可用于消费市场价格分析,猜测顾客的消费习惯;网络安全领域中的入侵检测技术;可用在用于高校管理中,根据挖掘规则可以有效地辅助学校管理部门有针对性的开展贫困助学工作;也可用在移动通信领域中,指导运营商的业务运营和辅助业务提供商的决策制定。 经典的关联规则数据挖掘算法Apriori 算法广泛应用于各种领域,通过对数据的关联性进行了分析和挖掘,挖掘出的这些信息在决策制定过程中具有重要的参考价值。 Apriori算法广泛应用于商业中,应用于消费市场价格分析中,它能够很快的求出各种产品之间的价格关系和它们之间的影响。通过数据挖掘,市场商人可 以瞄准目标客户,采用个人股票行市、最新信息、特殊的市场推广活动或其他一些特殊的信息手段,从而极大地减少广告预算和增加收入。百货商场、超市和一些老字型大小的零售店也在进行数据挖掘,以便猜测这些年来顾客的消费习惯。 Apriori算法应用于网络安全领域,比如时候入侵检测技术中。早期中大型的电脑系统中都收集审计信息来建立跟踪档,这些审计跟踪的目的多是为了性能测试或计费,因此对攻击检测提供的有用信息比较少。它通过模式的学习和训练可以发现网络用户的异常行为模式。采用作用度的Apriori算法削弱了Apriori 算法的挖掘结果规则,是网络入侵检测系统可以快速的发现用户的行为模式,能够快速的锁定攻击者,提高了基于关联规则的入侵检测系统的检测性。 Apriori算法应用于高校管理中。随着高校贫困生人数的不断增加,学校管理部门资助工作难度也越加增大。针对这一现象,提出一种基于数据挖掘算法的解决方法。将关联规则的Apriori算法应用到贫困助学体系中,并且针对经典Apriori挖掘算法存在的不足进行改进,先将事务数据库映射为一个布尔矩阵,用一种逐层递增的思想来动态的分配内存进行存储,再利用向量求"与"运算,寻找频繁项集。实验结果表明,改进后的Apriori算法在运行效率上有了很大的提升,挖掘出的规则也可以有效地辅助学校管理部门有针对性的开展贫困助学工作。 Apriori算法被广泛应用于移动通信领域。移动增值业务逐渐成为移动通信市场上最有活力、最具潜力、最受瞩目的业务。随着产业的复苏,越来越多的增值业务表现出强劲的发展势头,呈现出应用多元化、营销品牌化、管理集中化、合作纵深化的特点。针对这种趋势,在关联规则数据挖掘中广泛应用的Apriori 算法被很多公司应用。依托某电信运营商正在建设的增值业务Web数据仓库平台,对来自移动增值业务方面的调查数据进行了相关的挖掘处理,从而获得了关于用户行为特征和需求的间接反映市场动态的有用信息,这些信息在指导运营商的业务运营和辅助业务提供商的决策制定等方面具有十分重要的参考价值。 八备注 [1] 如果事件A中包含k个元素,那么称这个事件A为k项集事件A满足最小支持度阈值的事件称为频繁k项集。 [2] 支持度:P(A ∩ B),既有A又有B的概率 [3] 置信度:P(B|A),在A发生的事件中同时发生B的概率p(AB)/P(A)。同时满足最小支持度阈值和最小置信度阈值的规则称为强规则。例如购物篮分析:牛奶?面包例子:[支持度:3%,置信度:40%] 支持度3%:意味着3%顾客同时购买牛奶和面包 置信度40%:意味着购买牛奶的顾客40%也购买面包 《数据挖掘》Weka实验报告 姓名_学号_ 指导教师 开课学期2015 至2016 学年 2 学期完成日期2015年6月12日 1.实验目的 基于https://www.360docs.net/doc/2812411429.html,/ml/datasets/Breast+Cancer+WiscOnsin+%28Ori- ginal%29的数据,使用数据挖掘中的分类算法,运用Weka平台的基本功能对数据集进行分类,对算法结果进行性能比较,画出性能比较图,另外针对不同数量的训练集进行对比实验,并画出性能比较图训练并测试。 2.实验环境 实验采用Weka平台,数据使用来自https://www.360docs.net/doc/2812411429.html,/ml/Datasets/Br- east+Cancer+WiscOnsin+%28Original%29,主要使用其中的Breast Cancer Wisc- onsin (Original) Data Set数据。Weka是怀卡托智能分析系统的缩写,该系统由新西兰怀卡托大学开发。Weka使用Java写成的,并且限制在GNU通用公共证书的条件下发布。它可以运行于几乎所有操作平台,是一款免费的,非商业化的机器学习以及数据挖掘软件。Weka提供了一个统一界面,可结合预处理以及后处理方法,将许多不同的学习算法应用于任何所给的数据集,并评估由不同的学习方案所得出的结果。 3.实验步骤 3.1数据预处理 本实验是针对威斯康辛州(原始)的乳腺癌数据集进行分类,该表含有Sample code number(样本代码),Clump Thickness(丛厚度),Uniformity of Cell Size (均匀的细胞大小),Uniformity of Cell Shape (均匀的细胞形状),Marginal Adhesion(边际粘连),Single Epithelial Cell Size(单一的上皮细胞大小),Bare Nuclei(裸核),Bland Chromatin(平淡的染色质),Normal Nucleoli(正常的核仁),Mitoses(有丝分裂),Class(分类),其中第二项到第十项取值均为1-10,分类中2代表良性,4代表恶性。通过实验,希望能找出患乳腺癌客户各指标的分布情况。 该数据的数据属性如下: 1. Sample code number(numeric),样本代码; 2. Clump Thickness(numeric),丛厚度; 昆明理工大学信息工程与自动化学院学生实验报告 (2014 —2015 学年第 1 学期) 课程名称:数据库仓库与数据挖掘开课实验室:信自楼4442014 年12月28日 一、实验内容和目的 目的: 1.理解数据库与数据仓库之间的区别与联系; 2.掌握典型的关系型数据库及其数据仓库系统的工作原理以及应用方法; 3.掌握数据仓库建立的基本方法及其相关工具的使用。 二、实验原理及基本技术路线图(方框原理图) 数据库(DataBase,DB)是长期存储在计算机内、有组织的、统一管理的相关数据的集合。DB能为各种用户共享,具有较小的冗余度、数据间联系紧密而又有较高的数据独立性等特点。构成的三要素是数据结构、数据操作、约束性条件。 三、所用仪器、材料(设备名称、型号、规格等) PC机和Microsoft SQL Server 2008 四、实验方法、步骤 1、登录SQL Server 登录名:localhost 2、使用SQL语句构建数据库(1)还原数据库 (2)建立数据 --建立数据 USE cd CREATE DATABASE[DW]ON PRIMARY (NAME=N'DW',FILENAME=N'G:\DW.mdf') LOG ON (NAME=N'DW_log',FILENAME=N'G:\DW_log.ldf') GO (3)建立数据库:数据库→新建数据库 (4)建维表 ①SQL语句 USE DW -------------------------------- --1、建维表 /*1.1 订单方式*/ CREATE TABLE DIM_ORDER_METHOD (ONLINEORDERFLAG INT,DSC VARCHAR(20)) /*1.2 销售人员及销售地区*/ CREATE TABLE DIM_SALEPERSON (SALESPERSONID INT, DSC VARCHAR(20), SALETERRITORY_DSC VARCHAR(50)) 数据挖掘实验报告(一) 数据预处理 姓名:李圣杰 班级:计算机1304 学号:1311610602 一、实验目的 1.学习均值平滑,中值平滑,边界值平滑的基本原理 2.掌握链表的使用方法 3.掌握文件读取的方法 二、实验设备 PC一台,dev-c++5.11 三、实验内容 数据平滑 假定用于分析的数据包含属性age。数据元组中age的值如下(按递增序):13, 15, 16, 16, 19, 20, 20, 21, 22, 22, 25, 25, 25, 25, 30, 33, 33, 35, 35, 35, 35, 36, 40, 45, 46, 52, 70。使用你所熟悉的程序设计语言进行编程,实现如下功能(要求程序具有通用性): (a) 使用按箱平均值平滑法对以上数据进行平滑,箱的深度为3。 (b) 使用按箱中值平滑法对以上数据进行平滑,箱的深度为3。 (c) 使用按箱边界值平滑法对以上数据进行平滑,箱的深度为3。 四、实验原理 使用c语言,对数据文件进行读取,存入带头节点的指针链表中,同时计数,均值求三个数的平均值,中值求中间的一个数的值,边界值将中间的数转换为离边界较近的边界值 五、实验步骤 代码 #include 数据仓库与数据挖掘 实验一 Weka 实验环境初探 选择上端的 Associate 选项页,即数据挖掘中的关联规则挖掘选项,此处要 做的是从上述数据集中寻找关联规则。点击后进入如下界面: 选择上端的 Associate 选项页,但是在 Associate 选项卡中 Start 按钮为灰色的, 也就是说这个时候无法使用 Apriori 算法进行规则的挖掘,原因在于 Apriori 算法 不能应用于连续型的数值类型。所以现在需要对数值进行离散化,就是类似于将 20-30℃划分为“热”,0-10℃定义为“冷”,这样经过对数值型属性的离散化, 就可以应用 Apriori 算法了。Weka 提供了良好的数据预处理方法。第一步:选 择要预处理的属性 temperrature 大数据理论与技术读书报告 -----K最近邻分类算法 指导老师: 陈莉 学生姓名: 李阳帆 学号: 201531467 专业: 计算机技术 日期 :2016年8月31日 摘要 数据挖掘是机器学习领域内广泛研究的知识领域,是将人工智能技术和数据库技术紧密结合,让计算机帮助人们从庞大的数据中智能地、自动地提取出有价值的知识模式,以满足人们不同应用的需要。K 近邻算法(KNN)是基于统计的分类方法,是大数据理论与分析的分类算法中比较常用的一种方法。该算法具有直观、无需先验统计知识、无师学习等特点,目前已经成为数据挖掘技术的理论和应用研究方法之一。本文主要研究了K 近邻分类算法,首先简要地介绍了数据挖掘中的各种分类算法,详细地阐述了K 近邻算法的基本原理和应用领域,最后在matlab环境里仿真实现,并对实验结果进行分析,提出了改进的方法。 关键词:K 近邻,聚类算法,权重,复杂度,准确度 1.引言 (1) 2.研究目的与意义 (1) 3.算法思想 (2) 4.算法实现 (2) 4.1 参数设置 (2) 4.2数据集 (2) 4.3实验步骤 (3) 4.4实验结果与分析 (3) 5.总结与反思 (4) 附件1 (6) 1.引言 随着数据库技术的飞速发展,人工智能领域的一个分支—— 机器学习的研究自 20 世纪 50 年代开始以来也取得了很大进展。用数据库管理系统来存储数据,用机器学习的方法来分析数据,挖掘大量数据背后的知识,这两者的结合促成了数据库中的知识发现(Knowledge Discovery in Databases,简记 KDD)的产生,也称作数据挖掘(Data Ming,简记 DM)。 数据挖掘是信息技术自然演化的结果。信息技术的发展大致可以描述为如下的过程:初期的是简单的数据收集和数据库的构造;后来发展到对数据的管理,包括:数据存储、检索以及数据库事务处理;再后来发展到对数据的分析和理解, 这时候出现了数据仓库技术和数据挖掘技术。数据挖掘是涉及数据库和人工智能等学科的一门当前相当活跃的研究领域。 数据挖掘是机器学习领域内广泛研究的知识领域,是将人工智能技术和数据库技术紧密结合,让计算机帮助人们从庞大的数据中智能地、自动地抽取出有价值的知识模式,以满足人们不同应用的需要[1]。目前,数据挖掘已经成为一个具有迫切实现需要的很有前途的热点研究课题。 2.研究目的与意义 近邻方法是在一组历史数据记录中寻找一个或者若干个与当前记录最相似的历史纪录的已知特征值来预测当前记录的未知或遗失特征值[14]。近邻方法是数据挖掘分类算法中比较常用的一种方法。K 近邻算法(简称 KNN)是基于统计的分类方法[15]。KNN 分类算法根据待识样本在特征空间中 K 个最近邻样本中的多数样本的类别来进行分类,因此具有直观、无需先验统计知识、无师学习等特点,从而成为非参数分类的一种重要方法。 大多数分类方法是基于向量空间模型的。当前在分类方法中,对任意两个向量: x= ) ,..., , ( 2 1x x x n和) ,..., , (' ' 2 ' 1 'x x x x n 存在 3 种最通用的距离度量:欧氏距离、余弦距 离[16]和内积[17]。有两种常用的分类策略:一种是计算待分类向量到所有训练集中的向量间的距离:如 K 近邻选择K个距离最小的向量然后进行综合,以决定其类别。另一种是用训练集中的向量构成类别向量,仅计算待分类向量到所有类别向量的距离,选择一个距离最小的类别向量决定类别的归属。很明显,距离计算在分类中起关键作用。由于以上 3 种距离度量不涉及向量的特征之间的关系,这使得距离的计算不精确,从而影响分类的效果。 哈尔滨工业大学 数据挖掘理论与算法实验报告(2016年度秋季学期) 课程编码S1300019C 授课教师邹兆年 学生姓名汪瑞 学号 16S003011 学院计算机学院 一、实验内容 决策树算法是一种有监督学习的分类算法;kmeans是一种无监督的聚类算法。 本次实验实现了以上两种算法。在决策树算法中采用了不同的样本划分方式、不同的分支属性的选择标准。在kmeans算法中,比较了不同初始质心产生的差异。 本实验主要使用python语言实现,使用了sklearn包作为实验工具。 二、实验设计 1.决策树算法 1.1读取数据集 本次实验主要使用的数据集是汽车价值数据。有6个属性,命名和属性值分别如下: buying: vhigh, high, med, low. maint: vhigh, high, med, low. doors: 2, 3, 4, 5more. persons: 2, 4, more. lug_boot: small, med, big. safety: low, med, high. 分类属性是汽车价值,共4类,如下: class values:unacc, acc, good, vgood 该数据集不存在空缺值。 由于sklearn.tree只能使用数值数据,因此需要对数据进行预处理,将所有标签类属性值转换为整形。 1.2数据集划分 数据集预处理完毕后,对该数据进行数据集划分。数据集划分方法有hold-out法、k-fold交叉验证法以及有放回抽样法(boottrap)。 Hold—out法在pthon中的实现是使用如下语句: 其中,cv是sklearn中cross_validation包,train_test_split 方法的参数分别是数据集、数据集大小、测试集所占比、随机生成方法的可 数据挖掘实验报告(二)关联规则挖掘 姓名:李圣杰 班级:计算机1304 学号:1311610602 一、实验目的 1. 1.掌握关联规则挖掘的Apriori算法; 2.将Apriori算法用具体的编程语言实现。 二、实验设备 PC一台,dev-c++5.11 三、实验内容 根据下列的Apriori算法进行编程: 四、实验步骤 1.编制程序。 2.调试程序。可采用下面的数据库D作为原始数据调试程序,得到的候选1项集、2项集、3项集分别为C1、C2、C3,得到的频繁1项集、2项集、3项集分别为L1、L2、L3。 代码 #include 数据仓库与数据挖掘 实验报告 姓名:岩羊先生 班级:数技2011 学号:XXXXXX 实验日期:2013年11月14日 目录 实验 ........................................................................................................................ 错误!未定义书签。 【实验目的】....................................................................................... 错误!未定义书签。 1、熟悉SQLservermanager studio和VisualStudio2008软件功能和操作特点; ................................................................................................................ 错误!未定义书签。 2、了解SQLservermanager studio和VisualStudio2008软件的各选项面板和 操作方法; .............................................................................................. 错误!未定义书签。 3、熟练掌握SQLserver manager studio和VisualStudio2008工作流程。错误! 未定义书签。 【实验内容】....................................................................................... 错误!未定义书签。 1.打开SQLserver manager studio软件,逐一操作各选项,熟悉软件功能; (4) 2.根据给出的数据库模型“出版社销售图书Pubs”优化结构,新建立数据库并导 出; (4) 3.打开VisualStudio2008,导入已有数据库、或新建数据文件,设计一个“图书 销售分析”的多维数据集模型。并使用各种输出节点,熟悉数据输入输出。 (4) 【实验环境】....................................................................................... 错误!未定义书签。 【实验步骤】....................................................................................... 错误!未定义书签。 1.打开SQL Server manager studio; (5) 2.附加备份的数据库文件pubs_DW_Data.MDF和pubs_DW_Log.LDF并且做出 数据分析与挖掘实验报告 《数据挖掘》实验报告 目录 1.关联规则的基本概念和方法 (1) 1.1数据挖掘 (1) 1.1.1数据挖掘的概念 (1) 1.1.2数据挖掘的方法与技术 (2) 1.2关联规则 (5) 1.2.1关联规则的概念 (5) 1.2.2关联规则的实现——Apriori算法 (7) 2.用Matlab实现关联规则 (12) 2.1Matlab概述 (12) 2.2基于Matlab的Apriori算法 (13) 3.用java实现关联规则 (19) 3.1java界面描述 (19) 3.2java关键代码描述 (23) 4、实验总结 (29) 4.1实验的不足和改进 (29) 4.2实验心得 (30) 1.关联规则的基本概念和方法 1.1数据挖掘 1.1.1数据挖掘的概念 计算机技术和通信技术的迅猛发展将人类社会带入到了信息时代。在最近十几年里,数据库中存储的数据急剧增大。数据挖掘就是信息技术自然进化的结果。数据挖掘可以从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的,人们事先不知道的但又是潜在有用的信息和知识的过程。 许多人将数据挖掘视为另一个流行词汇数据中的知识发现(KDD)的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤。知识发现过程如下: ·数据清理(消除噪声和删除不一致的数据)·数据集成(多种数据源可以组合在一起)·数据转换(从数据库中提取和分析任务相关的数据) ·数据变换(从汇总或聚集操作,把数据变换和统一成适合挖掘的形式) ·数据挖掘(基本步骤,使用智能方法提取数 据模式) ·模式评估(根据某种兴趣度度量,识别代表知识的真正有趣的模式) ·知识表示(使用可视化和知识表示技术,向用户提供挖掘的知识)。 1.1.2数据挖掘的方法与技术 数据挖掘吸纳了诸如数据库和数据仓库技术、统计学、机器学习、高性能计算、模式识别、神经网络、数据可视化、信息检索、图像和信号处理以及空间数据分析技术的集成等许多应用领域的大量技术。数据挖掘主要包括以下方法。神经网络方法:神经网络由于本身良好的鲁棒性、自组织自适应性、并行处理、分布存储和高度容错等特性非常适合解决数据挖掘的问题,因此近年来越来越受到人们的关注。典型的神经网络模型主要分3大类:以感知机、bp反向传播模型、函数型网络为代表的,用于分类、预测和模式识别的前馈式神经网络模型;以hopfield 的离散模型和连续模型为代表的,分别用于联想记忆和优化计算的反馈式神经网络模型;以art 模型、koholon模型为代表的,用于聚类的自组 一、实验目的 使用数据挖掘中的分类算法,对数据集进行分类训练并测试。应用不同的分类算法,比较他们之间的不同。与此同时了解Weka平台的基本功能与使用方法。 二、实验环境 实验采用Weka 平台,数据使用Weka安装目录下data文件夹下的默认数据集iris.arff。 Weka是怀卡托智能分析系统的缩写,该系统由新西兰怀卡托大学开发。Weka使用Java 写成的,并且限制在GNU通用公共证书的条件下发布。它可以运行于几乎所有操作平台,是一款免费的,非商业化的机器学习以及数据挖掘软件。Weka提供了一个统一界面,可结合预处理以及后处理方法,将许多不同的学习算法应用于任何所给的数据集,并评估由不同的学习方案所得出的结果。 三、数据预处理 Weka平台支持ARFF格式和CSV格式的数据。由于本次使用平台自带的ARFF格式数据,所以不存在格式转换的过程。实验所用的ARFF格式数据集如图1所示 图1 ARFF格式数据集(iris.arff) 对于iris数据集,它包含了150个实例(每个分类包含50个实例),共有sepal length、sepal width、petal length、petal width和class五种属性。期中前四种属性为数值类型,class属性为分类属性,表示实例所对应的的类别。该数据集中的全部实例共可分为三类:Iris Setosa、Iris Versicolour和Iris Virginica。 实验数据集中所有的数据都是实验所需的,因此不存在属性筛选的问题。若所采用的数据集中存在大量的与实验无关的属性,则需要使用weka平台的Filter(过滤器)实现属性的筛选。 实验所需的训练集和测试集均为iris.arff。 四、实验过程及结果 应用iris数据集,分别采用LibSVM、C4.5决策树分类器和朴素贝叶斯分类器进行测试和评价,分别在训练数据上训练出分类模型,找出各个模型最优的参数值,并对三个模型进行全面评价比较,得到一个最好的分类模型以及该模型所有设置的最优参数。最后使用这些参数以及训练集和校验集数据一起构造出一个最优分类器,并利用该分类器对测试数据进行预测。 1、LibSVM分类 Weka 平台内部没有集成libSVM分类器,要使用该分类器,需要下载libsvm.jar并导入到Weka中。 用“Explorer”打开数据集“iris.arff”,并在Explorer中将功能面板切换到“Classify”。点“Choose”按钮选择“functions(weka.classifiers.functions.LibSVM)”,选择LibSVM分类算法。 在Test Options 面板中选择Cross-Validatioin folds=10,即十折交叉验证。然后点击“start”按钮: 数据仓库与数据挖掘上机实验报告 实验目的:学习Analysis Services的操作 实验内容: 浏览SQL Server 2000 Analysis Services 随机教程;规划需求分析;仓库设计;建立分析数据库,设置数据源;建立多维数据库(Cube);设置多维数据库的数据存储方式及访问权限实验分析: 下面进行实验,建立多维数据库(使用Northwind数据库),先用数据清洗转换,将需要的表从源库转换到新数据库,为数据仓库提供需要的数据,要形成的维表有Products,Category,Employees,Dates,Facts(事实表),在实验二中Products和Category将组成雪花架构的维表。 实验过程:建立多维数据库 内容:建立多维数据库(cube),要建立事实表Facts和维表Products,Categories,Employees,Dates,设置多维数据库的数据存储方式 目的:学会建立事实表,度量,时间维度,雪花表,使用数据存储方式 步骤: 1) 设置数据源,建立myNorthwind数据库。 2) 建立多维数据集的事实表,使用Analysis Server的向导。此时显示刚才选中的myNorthwind数据集,还有一个系统自带的FoodMart数据集。向导提示选择事实数据表,在这里我们选好了Facts表作为事实表。 *在下一步用了定义度量值的数据中选择TotalPrice,UnitPrice,Quantity,Discount作为度量,度量值的选择与决策者关心的项目有关。在这里假设决策者关心的是价格对销量产生的影响,从这些数据中可以得出进一步的经营方针。 3)定义好事实表后,我们要建立cube的维度表 ①选择维度的创建方式,维度表的结构有星型架构,雪花架构等等,在本实验中,只用到前两个架构,因为本实验中根本没必要用到其他的结构。而雪花架构的运用也只是用于学习和研究,在实际中,如此简单的数据仓库结构也不需要雪花架构,因为它会降低系统的性能。 实验一 ID3算法实现 一、实验目的 通过编程实现决策树算法,信息增益的计算、数据子集划分、决策树的构建过程。加深对相关算法的理解过程。 实验类型:验证 计划课间:4学时 二、实验内容 1、分析决策树算法的实现流程; 2、分析信息增益的计算、数据子集划分、决策树的构建过程; 3、根据算法描述编程实现算法,调试运行; 4、对所给数据集进行验算,得到分析结果。 三、实验方法 算法描述: 以代表训练样本的单个结点开始建树; 若样本都在同一个类,则该结点成为树叶,并用该类标记; 否则,算法使用信息增益作为启发信息,选择能够最好地将样本分类的属性; 对测试属性的每个已知值,创建一个分支,并据此划分样本; 算法使用同样的过程,递归形成每个划分上的样本决策树 递归划分步骤,当下列条件之一成立时停止: 给定结点的所有样本属于同一类; 没有剩余属性可以进一步划分样本,在此情况下,采用多数表决进行 四、实验步骤 1、算法实现过程中需要使用的数据结构描述: Struct {int Attrib_Col; // 当前节点对应属性 int Value; // 对应边值 Tree_Node* Left_Node; // 子树 Tree_Node* Right_Node // 同层其他节点 Boolean IsLeaf; // 是否叶子节点 int ClassNo; // 对应分类标号 }Tree_Node; 2、整体算法流程 主程序: InputData(); T=Build_ID3(Data,Record_No, Num_Attrib); OutputRule(T); 释放内存; 3、相关子函数: 3.1、 InputData() { 输入属性集大小Num_Attrib; 输入样本数Num_Record; 分配内存Data[Num_Record][Num_Attrib]; 输入样本数据Data[Num_Record][Num_Attrib]; 获取类别数C(从最后一列中得到); } 3.2、Build_ID3(Data,Record_No, Num_Attrib) { Int Class_Distribute[C]; If (Record_No==0) { return Null } N=new tree_node(); 计算Data中各类的分布情况存入Class_Distribute Temp_Num_Attrib=0; For (i=0;i 通信与信息工程学院 课程设计说明书 课程名称: 数据仓库与数据挖掘课程设计题目: 超市商品销售分析及数据挖掘专业/班级: 电子商务(理) 组长: 学号: 组员/学号: 开始时间: 2011 年12 月29 日完成时间: 2012 年01 月 3 日 目录 1.绪论 (1) 1.1项目背景 (1) 1.2提出问题 (1) 2.数据仓库与数据集市的概念介绍 (1) 2.1数据仓库介绍 (1) 2.2数据集市介绍 (2) 3.数据仓库 (3) 3.1数据仓库的设计 (3) 3.1.1数据仓库的概念模型设计 (4) 3.1.2数据仓库的逻辑模型设计 (5) 3.2 数据仓库的建立 (5) 3.2.1数据仓库数据集成 (5) 3.2.2建立维表 (8) 4.OLAP操作 (10) 5.数据预处理 (12) 5.1描述性数据汇总 (12) 5.2数据清理与变换 (13) 6.数据挖掘操作 (13) 6.1关联规则挖掘 (13) 6.2 分类和预测 (17) 6.3决策树的建立 (18) 6.4聚类分析 (22) 7.总结 (25) 8.任务分配 (26) 数据挖掘实验报告 1.绪论 1.1项目背景 在商业领域中使用计算机科学与技术是当今商业的发展方向,而数据挖掘是商业领域与计算机领域的乔梁。在超市的经营中,应用数据挖掘技术分析顾客的购买习惯和不同商品之间的关联,并借由陈列的手法,和合适的促销手段将商品有魅力的展现在顾客的眼前, 可以起到方便购买、节约空间、美化购物环境、激发顾客的购买欲等各种重要作用。 1.2提出问题 那么超市应该对哪些销售信息进行挖掘?怎样挖掘?具体说,超市如何运用OLAP操作和关联规则了解顾客购买习惯和商品之间的关联,正确的摆放商品位置以及如何运用促销手段对商品进行销售呢?如何判断一个顾客的销售水平并进行推荐呢?本次实验为解决这一问题提出了解决方案。 2.数据仓库与数据集市的概念介绍 2.1数据仓库介绍 数据仓库,英文名称为Data Warehouse,可简写为DW或DWH,是在数据库已经大量存在的情况下,为了进一步挖掘数据资源、为了决策需要而产生的,它并不是所谓的“大型数据库”。........ 2.2数据集市介绍 数据集市,也叫数据市场,是一个从操作的数据和其他的为某个特殊的专业人员团体服务的数据源中收集数据的仓库。....... 3.数据仓库 3.1数据仓库的设计 3.1.1数据库的概念模型 3.1.2数据仓库的模型 数据仓库的模型主要包括数据仓库的星型模型图,我们创建了四个 一、上机目的及内容 目的: 1.理解数据挖掘的基本概念及其过程; 2.理解数据挖掘与数据仓库、OLAP之间的关系 3.理解基本的数据挖掘技术与方法的工作原理与过程,掌握数据挖掘相关工具的使用。 内容: 将创建一个数据挖掘模型以训练销售数据,并使用“Microsoft 决策树”算法在客户群中找出购买自行车模式。请将要挖掘的维度(事例维度)设置为客户,再将客户的属性设置为数据挖掘算法识别模式时要使用的信息。然后算法将使用决策树从中确定模式。下一步需要训练模型,以便能够浏览树视图并从中读取模式。市场部将根据这些模式选择潜在的客户发送自行车促销信息。 要求: 利用实验室和指导教师提供的实验软件,认真完成规定的实验内容,真实地记录实验中遇到的各种问题和解决的方法与过程,并根据实验案例绘出模型及操作过程。实验完成后,应根据实验情况写出实验报告。 二、实验原理及基本技术路线图(方框原理图或程序流程图) 关联分析:关联分析是从数据库中发现知识的一类重要方法。 时序模式:通过时间序列搜索出重复发生概率较高的模式。 分类:分类是在聚类的基础上对已确定的类找出该类别的概念描述,代表了这类数据的整体信息,既该类的内涵描述,一般用规则或决策树模式表示。 三、所用仪器、材料(设备名称、型号、规格等或使用软件) 1台PC及Microsoft SQL Server套件 四、实验方法、步骤(或:程序代码或操作过程)及实验过程原始记录( 测试数据、图表、计算等) 创建Analysis Services 项目 1.打开Business Intelligence Development Studio。 2.在“文件”菜单上,指向“新建”,然后选择“项目”。 3.确保已选中“模板”窗格中的“Analysis Services 项目”。 4.在“名称”框中,将新项目命名为AdventureWorks。 5.单击“确定”。 数据预处理 一、实验原理 预处理方法基本方法 1、数据清洗 去掉噪声和无关数据 2、数据集成 将多个数据源中的数据结合起来存放在一个一致的数据存储中 3、数据变换 把原始数据转换成为适合数据挖掘的形式 4、数据归约 主要方法包括:数据立方体聚集,维归约,数据压缩,数值归约,离散化和概念分层等二、实验目的 掌握数据预处理的基本方法。 三、实验内容 1、R语言初步认识(掌握R程序运行环境) 2、实验数据预处理。(掌握R语言中数据预处理的使用) 对给定的测试用例数据集,进行以下操作。 1)、加载程序,熟悉各按钮的功能。 2)、熟悉各函数的功能,运行程序,并对程序进行分析。 对餐饮销量数据进统计量分析,求销量数据均值、中位数、极差、标准差,变异系数和四分位数间距。 对餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析),画出帕累托图。 3)数据预处理 缺省值的处理:用均值替换、回归查补和多重查补对缺省值进行处理 对连续属性离散化:用等频、等宽等方法对数据进行离散化处理 四、实验步骤 1、R语言运行环境的安装配置和简单使用 (1)安装R语言 R语言下载安装包,然后进行默认安装,然后安装RStudio 工具(2)R语言控制台的使用 1.2.1查看帮助文档 1.2.2 安装软件包 1.2.3 进行简单的数据操作 (3)RStudio 简单使用 1.3.1 RStudio 中进行简单的数据处理 1.3.2 RStudio 中进行简单的数据处理 2、R语言中数据预处理 (1)加载程序,熟悉各按钮的功能。 (2)熟悉各函数的功能,运行程序,并对程序进行分析 2.2.1 销量中位数、极差、标准差,变异系数和四分位数间距。 , 2.2.2对餐饮企业菜品的盈利贡献度(即菜品盈利帕累托分析),画出帕累托图。 数据挖掘实验报告-实验1-W e k a基础操作 学生实验报告 学院:信息管理学院 课程名称:数据挖掘 教学班级: B01 姓名: 学号: 实验报告 课程名称数据挖掘教学班级B01 指导老师 学号姓名行政班级 实验项目实验一: Weka的基本操作 组员名单独立完成 实验类型■操作性实验□验证性实验□综合性实验实验地点H535 实验日期2016.09.28 1. 实验目的和要求: (1)Explorer界面的各项功能; 注意不能与课件上的截图相同,可采用打开不同的数据文件以示区别。 (2)Weka的两种数据表格编辑文件方式下的功能介绍; ①Explorer-Preprocess-edit,弹出Viewer对话框; ②Weka GUI选择器窗口-Tools | ArffViewer,打开ARFF-Viewer窗口。(3)ARFF文件组成。 2.实验过程(记录实验步骤、分析实验结果) 2.1 Explorer界面的各项功能 2.1.1 初始界面示意 其中:explorer选项是数据挖掘梳理数据最常用界面,也是使用weka最简单的方法。 Experimenter:实验者选项,提供不同数值的比较,发现其中规律。 KnowledgeFlow:知识流,其中包含处理大型数据的方法,初学者应用较少。 Simple CLI :命令行窗口,有点像cmd 格式,非图形界面。 2.1.2 进入Explorer 界面功能介绍 (1)任务面板 Preprocess(数据预处理):选择和修改要处理的数据。 Classify(分类):训练和测试分类或回归模型。 Cluster(聚类):从数据中聚类。聚类分析时用的较多。 Associate(关联分析):从数据中学习关联规则。 Select Attributes(选择属性):选择数据中最相关的属性。 Visualize(可视化):查看数据的二维散布图。 (2)常用按钮 时间序列的模型法和数据挖掘两种方法比较分析研究 实验目的:通过实验能对时间序列的模型法和数据挖掘两种方法的原理和优缺点有更清楚的认识和比较. 实验内容:选用1952-2006年的中国GDP,分别对之用自回归移动平均模型(ARIMA) 和时序模型的数据挖掘方法进行分析和预测,并对两种方法的趋势和预测结果进行比较并 给出解释. 实验数据:本文研究选用1952-2006年的中国GDP,其资料如下 日期国内生产总值(亿元)日期国内生产总值(亿元) 2006-12-312094071997-12-3174772 2005-12-311830851996-12-31 2004-12-311365151995-12-31 2003-12-311994-12-31 2002-12-311993-12-31 2001-12-311992-12-31 2000-12-31894041991-12-31 1999-12-31820541990-12-31 1998-12-31795531989-12-31 1988-12-311969-12-31 1987-12-311968-12-31 1986-12-311967-12-31 1985-12-311966-12-311868 1984-12-3171711965-12-31 1983-12-311964-12-311454 1982-12-311963-12-31 1981-12-311962-12-31 1980-12-311961-12-311220 1979-12-311960-12-311457 1978-12-311959-12-311439 1977-12-311958-12-311307 1976-12-311957-12-311068 1975-12-311956-12-311028 1974-12-311955-12-31910 1973-12-311954-12-31859 1972-12-311953-12-31824 1971-12-311952-12-31679 1970-12-31 表一 国内生产总值(GDP)是指一个国家或地区所有常住单位在一定时期内生产活动的最终成果。这个指标把国民经济全部活动的产出成果概括在一个极为简明的统计数字之中为评价和衡量国家经济状况、经济增长趋势及社会财富的经济表现提供了一个最为综合的尺度,可以说, 实验三 一、实验原理 K-Means算法是一种 cluster analysis 的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 在数据挖掘中,K-Means算法是一种cluster analysis的算法,其主要是来计算数据聚集的算法,主要通过不断地取离种子点最近均值的算法。 算法原理: (1) 随机选取k个中心点; (2) 在第j次迭代中,对于每个样本点,选取最近的中心点,归为该类; (3) 更新中心点为每类的均值; (4) j<-j+1 ,重复(2)(3)迭代更新,直至误差小到某个值或者到达一定的迭代步 数,误差不变. 空间复杂度o(N) 时间复杂度o(I*K*N) 其中N为样本点个数,K为中心点个数,I为迭代次数 二、实验目的: 1、利用R实现数据标准化。 2、利用R实现K-Meams聚类过程。 3、了解K-Means聚类算法在客户价值分析实例中的应用。 三、实验内容 依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。对其进行标准差标准化并保存后,采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。编写R程序,完成客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 四、实验步骤 1、依据航空公司客户价值分析的LRFMC模型提取客户信息的LRFMC指标。 2、确定要探索分析的变量 3、利用R实现数据标准化。 4、采用k-means算法完成客户的聚类,分析每类的客户特征,从而获得每类客户的价值。 客户的k-means聚类,获得聚类中心与类标号,并统计每个类别的客户数 六、思考与分析 使用不同的预处理对数据进行变化,在使用k-means算法进行聚类,对比聚类的结果。 kmenas算法首先选择K个初始质心,其中K是用户指定的参数,即所期望的簇的个数。 这样做的前提是我们已经知道数据集中包含多少个簇. 1.与层次聚类结合 经常会产生较好的聚类结果的一个有趣策略是,首先采用层次凝聚算法决定结果数据挖掘实验报告

数据仓库的建立实验一

数据挖掘实验报告(一)

数据仓库与数据挖掘实验指导书王浩畅资料

实 验 指 导 书

东北石油大学计算机与信息技术系 王浩畅

一、实验名称: Weka 实验环境初探

二、实验目的: 通过一个已有的数据集,在 weka 环境下,测试常用数据挖掘算法,熟悉 Weka

环境。 三、实验要求

1. 熟悉 weka 的应用环境。 2. 了解数据挖掘常用算法。 3. 在 weka 环境下,测试常用数据挖掘算法。 四、实验平台 新西兰怀卡托大学研制的 Weka 系统 五、实验数据 Weka 安装目录下 data 文件夹中的数据集 weather.nominal.arff,weather.arff

六、实验方法和步骤 1、首先,选择数据集 weather.nominal.arff,操作步骤为点击 Explorer,进入主界 面,点击左上角的“Open file...”按钮,选择数据集 weather.nominal.arff 文件, 该文件中存储着表格中的数据,点击区域 2 中的“Edit”可以看到相应的数据:

2、现在打开 weather.arff,数据集中的类别换成数字。数据挖掘实验报告资料

数据挖掘报告

数据挖掘实验报告-关联规则挖掘

数据仓库与数据挖掘实验报告

数据分析与挖掘实验报告

大数据挖掘weka大数据分类实验报告材料

数据仓库实验报告

数据挖掘实验报告1

数据挖掘实验报告 超市商品销售分析及数据挖掘

数据仓库和数据挖掘实验报告

数据挖掘实验报告一

数据挖掘实验报告-实验1-Weka基础操作

数据挖掘实验报告(参考)

数据挖掘实验报告三