利用IRIS软件进行数据报的传输分析

实验四、利用IRIS软件进行数据报的传输分析

一、实验目的

1.掌握如何利用协议分析工具分析IP数据报报文格式,体会数据报发送、转发的过程。在学习的过程中可以直观地看到数据的具体传输过程。

2.通过分析截获TCP报文首部信息,理解首部中的序号、确认号等字段是TCP可靠连接的基础。

3.通过分析TCP连接的三次握手建立和释放过程,理解TCP连接建立和释放机制。

二、实验内容和要求

1)学习协议分析工具IRIS的基本使用方法;

2)利用IRIS进行IP数据报报文的抓取;

3)对抓取到的数据报文进行分析,体会数据报发送、转发的过程。

三、实验(设计)仪器设备和材料

1.计算机及操作系统:PC机,Windows;

2.网络环境:可以访问互联网;

四、实验方法、步骤及结构测试

1、测试例子:将1号机计算机中的一个文件通过FTP下载到208号机中。

2、IRIS的设置。

由于IRIS具有网络监听的功能,如果网络环境中还有其它的机器将抓很多别的数据包,这样为学习带来诸多不便,为了看清楚上述例子的传输过程首先将IRIS设置为只抓208号机和1号机之间的数据包。设置过程如下:

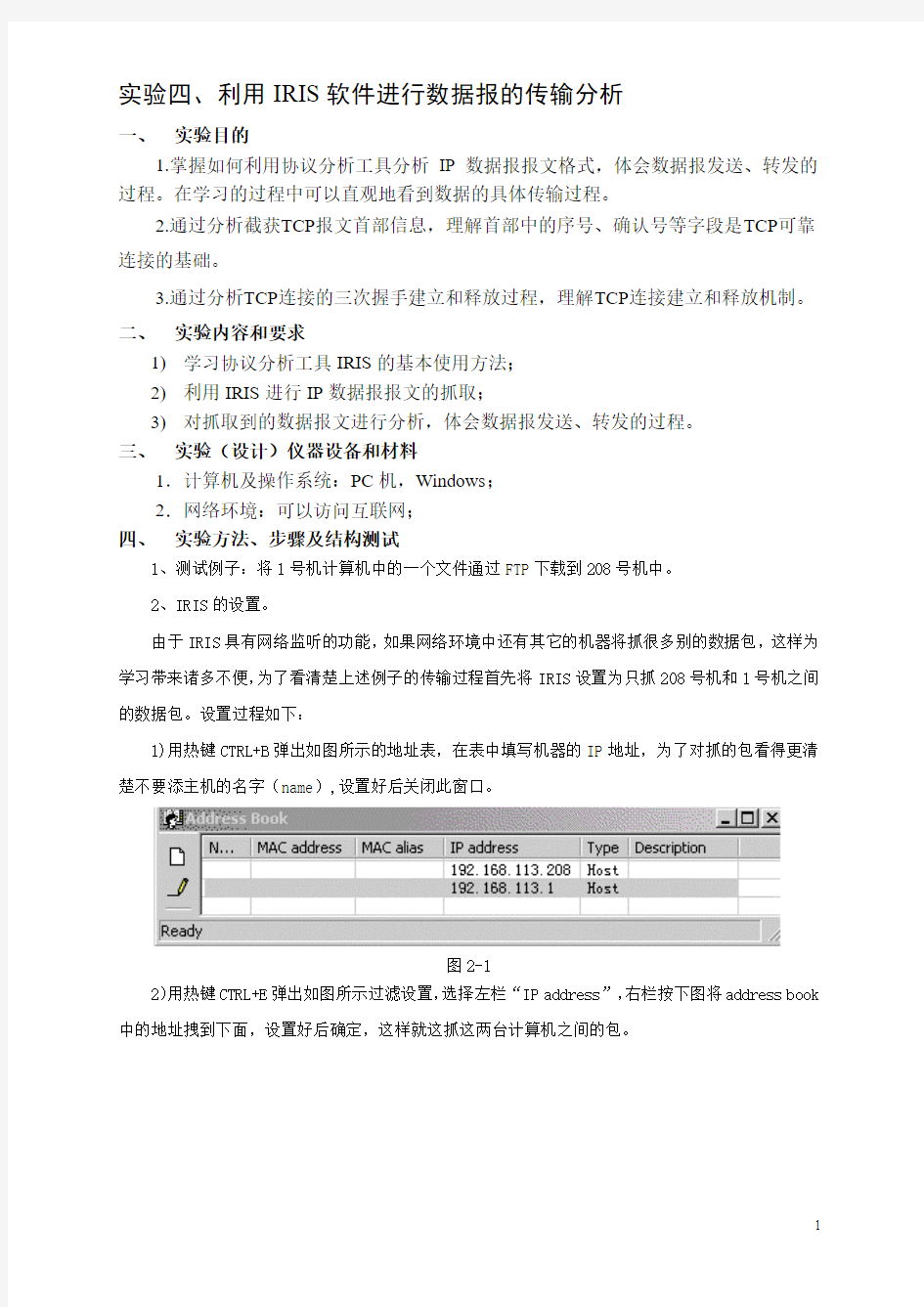

1)用热键CTRL+B弹出如图所示的地址表,在表中填写机器的IP地址,为了对抓的包看得更清楚不要添主机的名字(name),设置好后关闭此窗口。

图2-1

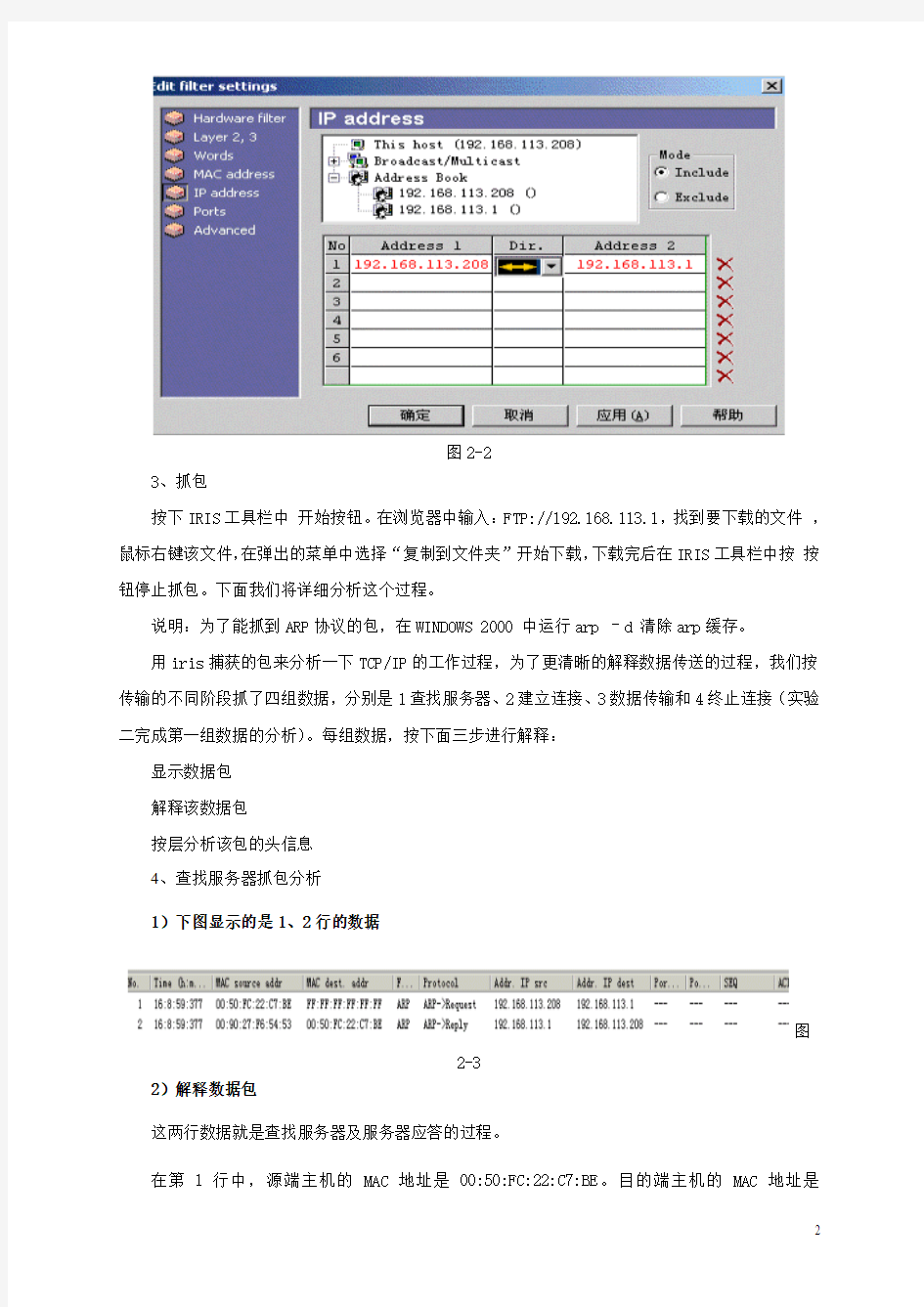

2)用热键CTRL+E弹出如图所示过滤设置,选择左栏“IP address”,右栏按下图将address book 中的地址拽到下面,设置好后确定,这样就这抓这两台计算机之间的包。

图2-2

3、抓包

按下IRIS工具栏中开始按钮。在浏览器中输入:FTP://192.168.113.1,找到要下载的文件,鼠标右键该文件,在弹出的菜单中选择“复制到文件夹”开始下载,下载完后在IRIS工具栏中按按钮停止抓包。下面我们将详细分析这个过程。

说明:为了能抓到ARP协议的包,在WINDOWS 2000 中运行arp –d 清除arp缓存。

用iris捕获的包来分析一下TCP/IP的工作过程,为了更清晰的解释数据传送的过程,我们按传输的不同阶段抓了四组数据,分别是1查找服务器、2建立连接、3数据传输和4终止连接(实验二完成第一组数据的分析)。每组数据,按下面三步进行解释:

显示数据包

解释该数据包

按层分析该包的头信息

4、查找服务器抓包分析

1)下图显示的是1、2行的数据

图

2-3

2)解释数据包

这两行数据就是查找服务器及服务器应答的过程。

在第1行中,源端主机的MAC地址是00:50:FC:22:C7:BE。目的端主机的MAC地址是

FF:FF:FF:FF:FF:FF,这个地址是十六进制表示的,F换算为二进制就是1111,全1的地址就是广播地址。所谓广播就是向本网上的每台网络设备发送信息,电缆上的每个以太网接口都要接收这个数据帧并对它进行处理,这一行反映的是步骤5)的内容,ARP发送一份称作ARP请求的以太网数据帧给以太网上的每个主机。网内的每个网卡都接到这样的信息“谁是192.168.113.1的IP地址的拥有者,请将你的硬件地址告诉我”。

第2行反映的是步骤6)的内容。在同一个以太网中的每台机器都会"接收"到这个报文,但正常状态下除了1号机外其他主机应该会忽略这个报文,而1号的主机的ARP层收到这份广播报文后,识别出这是发送端在寻问它的IP地址,于是发送一个ARP应答。告知自己的IP地址和MAC地址。第2行可以清楚的看出1号回答的信息__自己的MAC地址00:50:FC:22:C7:BE。

这两行反映的是数据链路层之间一问一答的通信过程。

3)头信息分析

下图左栏所示,第1数据包包含了两个头信息:以太网(Ethernet)和ARP。

图

2-4

下表2-1是以太网的头信息,括号内的数均为该字段所占字节数,以太网报头中的前两个字段是以太网的源地址和目的地址。目的地址为全1的特殊地址是广播地址。电缆上的所有以太网接口都要接收广播的数据帧。两个字节长的以太网帧类型表示后面数据的类型。对于ARP请求或应答来说,该字段的值为0806。

第2行中可以看到,尽管ARP请求是广播的,但是ARP应答的目的地址却是1号机的(00 50 FC 22 C7 BE)。ARP应答是直接送到请求端主机的。

表2-1 以太网头信息

下表2-2是ARP协议的头信息。硬件类型字段表示硬件地址的类型。它的值为1即表示以太网地址。协议类型字段表示要映射的协议地址类型。它的值为0800即表示IP地址。它的值与包含I P 数据报的以太网数据帧中的类型字段的值相同。接下来的两个1字节的字段,硬件地址长度和协议地址长度分别指出硬件地址和协议地址的长度,以字节为单位。对于以太网上IP地址的ARP请求或应答来说,它们的值分别为6和4。Op即操作(Operation),1是ARP请求、2是ARP应答、3是RARP 请求和4为RARP应答,第二行中该字段值为2表示应答。接下来的四个字段是发送端的硬件地址、发送端的IP地址、目的端的硬件地址和目的端IP地址。注意,这里有一些重复信息:在以太网的数据帧报头中和ARP请求数据帧中都有发送端的硬件地址。对于一个ARP请求来说,除目的端硬件地址外的所有其他的字段都有填充值。

表2-2的第2行为应答,当系统收到一份目的端为本机的ARP请求报文后,它就把硬件地址填进去,然后用两个目的端地址分别替换两个发送端地址,并把操作字段置为2,最后把它发送回去。

表2-2 ARP协议头信息

1、建立连接

1)下图显示的是3-5行的数据

图2-5

2)解释数据包

这三行数据是两机建立连接的过程。

这三行的核心意思就是TCP协议的三次握手。TCP的数据包是靠IP协议来传输的。但IP协议是只管把数据送到出去,但不能保证IP数据报能成功地到达目的地,保证数据的可靠传输是靠TCP协议来完成的。当接收端收到来自发送端的信息时,接受端详发送短发送一条应答信息,意思是:“我已收到你的信息了。”第三组数据将能看到这个过程。TCP是一个面向连接的协议。无论哪一方向另一方发送数据之前,都必须先在双方之间建立一条连接。建立连接的过程就是三次握手的过程。

这个过程就像要我找到了张三向他借几本书,第一步:我说:“你好,我是担子”,第二步:

张三说:“你好,我是张三”,第三步:我说:“我找你借几本书。”这样通过问答就确认对方身份,建立了联系。

下面来分析一下此例的三次握手过程。

1)请求端208号机发送一个初始序号(SEQ)987694419给1号机。

2)服务器1号机收到这个序号后,将此序号加1值为987694419作为应答信号(ACK),同时随机产生一个初始序号(SEQ)1773195208,这两个信号同时发回到请求端208号机,意思为:“消息已收到,让我们的数据流以1773195208这个数开始。”

3)请求端208号机收到后将确认序号设置为服务器的初始序号(SEQ)1773195208加1为1773195209作为应答信号。

以上三步完成了三次握手,双方建立了一条通道,接下来就可以进行数据传输了。

下面分析TCP头信息就可以看出,在握手过程中TCP头部的相关字段也发生了变化。

3)头信息分析

如图2-5所示,第3数据包包含了三头信息:以太网(Ethernet)和IP和TCP。

头信息少了ARP多了IP、TCP,下面的过程也没有ARP的参与,可以这样理解,在局域网内,ARP 负责的是在众多联网的计算机中找到需要找的计算机,找到工作就完成了。

以太网的头信息与第1、2行不同的是帧类型为0800,指明该帧类型为IP。

图

2-6

IP协议头信息

IP是TCP/IP协议族中最为核心的协议。从图2-6可以看出所有的TCP、UDP、ICMP及IGMP数据都以IP数据报格式传输的,有个形象的比喻IP协议就像运货的卡车,将一车车的货物运向目的地。主要的货物就是TCP或UDP分配给它的。需要特别指出的是IP提供不可靠、无连接的数据报传送,也就是说I P仅提供最好的传输服务但不保证IP数据报能成功地到达目的地。看到这你会不会

担心你的E_MAIL会不会送到朋友那,其实不用担心,上文提过保证数据正确到达目的地是TCP的工作,稍后我们将详细解释。

如表2-3是IP协议的头信息。

表2-3 IP数据报格式及首部中的各字段

图2-6中所宣布分45 00—71 01为IP的头信息。这些数是十六进制表示的。一个数占4位,

例如:4的二进制是0100

4位版本:表示目前的协议版本号,数值是4表示版本为4,因此IP有时也称作IPv4;

4位首部长度:头部的是长度,它的单位是32位(4个字节),数值为5表示IP头部长度为20字节。8位服务类型(TOS):00,这个8位字段由3位的优先权子字段,现在已经被忽略,4位的TOS子字段以及1 位的未用字段(现在为0)构成。4位的TOS子字段包含:最小延时、最大吞吐量、最高可靠性以及最小费用构成,这四个1位最多只能有一个为1,本例中都为0,表示是一般服务。

16位总长度(字节数):总长度字段是指整个IP数据报的长度,以字节为单位。数值为00 30,换算为十进制为48字节,48字节=20字节的IP头+28字节的TCP头,这个数据报只是传送的控制信息,还没有传送真正的数据,所以目前看到的总长度就是报头的长度。

16位标识:标识字段唯一地标识主机发送的每一份数据报。通常每发送一份报文它的值就会加1,第3行为数值为30 21,第5行为30 22,第7行为30 23。分片时涉及到标志字段和片偏移字段,本文不讨论这两个字段。

8位生存时间(TTL):TTL(time-to-live)生存时间字段设置了数据报可以经过的最多路由器数。它指定了数据报的生存时间。ttl的初始值由源主机设置,一旦经过一个处理它的路由器,它的值就减去1。可根据TTL值判断服务器是什么系统和经过的路由器。本例为80,换算成十进制为128,WINDOWS操作系统TTL初始值一般为128,UNIX操作系统初始值为255,本例表示两个机器在同一网段且操作系统为WINDOWS。

8位协议:表示协议类型,6表示传输层是TCP协议。

16位首部检验和:当收到一份I P数据报后,同样对首部中每个16 位进行二进制反码的求和。由于接收方在计算过程中包含了发送方存在首部中的检验和,因此,如果首部在传输过程中没有发生任何差错,那么接收方计算的结果应该为全1。如果结果不是全1,即检验和错误,那么IP就丢弃收到的数据报。但是不生成差错报文,由上层去发现丢失的数据报并进行重传。

32位源IP地址和32位目的IP地址:实际这是IP协议中核心的部分,但介绍这方面的文章非常多,本文搭建的又是一个最简单的网络结构,不涉及路由,本文对此只做简单介绍,相关知识请参阅其它文章。32位的IP地址由一个网络ID和一个主机ID组成。本例源IP地址为C0 A8 71 D0,转换为十进制为:192.168.113.208; 目的IP地址为C0 A8 71 01,转换为十进制为:192.168.113.1。网络地址为192.168.113,主机地址分别为1和208,它们的网络地址是相同的所以在一个网段内,这样数据在传送过程中可直接到达。

TCP协议头信息的分析

TCP协议头信息

如表3-1是TCP协议的头信息。

表3-1 TCP包首部

第三行TCP的头信息是:04 28 00 15 3A DF 05 53 00 00 00 00 70 02 40 00 9A 8D 00 00 02 04 05 B4 01 01 04 02

端口号:常说FTP占21端口、HTTP占80端口、TELNET占23端口等,这里指的端口就是TCP或UDP 的端口,端口就像通道两端的门一样,当两机进行通讯时门必须是打开的。源端口和目的端口各占16位,2的16次方等于65536,这就是每台电脑与其它电脑联系所能开的“门”。一般作为服务一方每项服务的端口号是固定的。本例目的端口号为00 15,换算成十进制为21,这正是FTP的默认端口,需要指出的是这是FTP的控制端口,数据传送时用另一端口,第三组的分析能看到这一点。客户端与服务器联系时随机开一个大于1024的端口,本例为04 28,换算成十进制为1064。你的电脑中了木马也会开一个服务端口。观察端口非常重要,不但能看出本机提供的正常服务,还能看出不正常的连接。Windows察看端口的命令时netstat。

32位序号:也称为顺序号(Sequence Number),简写为SEQ,从上面三次握手的分析可以看出,当一方要与另一方联系时就发送一个初始序号给对方,意思是:“让我们建立联系吧?”,服务方收到后要发个独立的序号给发送方,意思是“消息收到,数据流将以这个数开始。”由此可看出,TCP 连接完全是双向的,即双方的数据流可同时传输。在传输过程中双方数据是独立的,因此每个TCP 连接必须有两个顺序号分别对应不同方向的数据流。

32位确认序号:也称为应答号(Acknowledgment Number),简写为ACK。在握手阶段,确认序号将发送方的序号加1作为回答,在数据传输阶段,确认序号将发送方的序号加发送的数据大小作为回答,表示确实收到这些数据。在第三组的分析中将看到这一过程。

4位首部长度:。这个字段占4位,它的单位时32位(4个字节)。本例值为7,TCP的头长度为28字节,等于正常的长度2 0字节加上可选项8个字节。,TCP的头长度最长可为60字节(二进制1111换算为十进制为15,15*4字节=60字节)。

6个标志位。

URG 紧急指针,告诉接收TCP模块紧要指针域指着紧要数据

ACK 置1时表示确认号(为合法,为0的时候表示数据段不包含确认信息,确认号被忽略。

PSH 置1时请求的数据段在接收方得到后就可直接送到应用程序,而不必等到缓冲区满时才传送。RST 置1时重建连接。如果接收到RST位时候,通常发生了某些错误。

SYN 置1时用来发起一个连接。

FIN 置1时表示发端完成发送任务。用来释放连接,表明发送方已经没有数据发送了。

下面的3个图分别为3-5行TCP协议的头信息,这三行是三次握手的过程,如图3-1请求端208号机发送一个初始序号(SEQ)987694419给1号机。标志位SYN置为1。

如图13-2服务器1号机收到这个序号后,将应答信号(ACK)和随机产生一个初始序号(SEQ)1773195208发回到请求端208号机,因为有应答信号和初始序号,所以标志位ACK和SYN都置为1。如图3-3请求端208号机收到1号机的信号后,发回信息给1号机。标志位ACK置为1,其它标志为都为0。注意此时SYN值为0,SYN是标示发起连接的,上两部连接已经完成。

16位窗口大小:TCP的流量控制由连接的每一端通过声明的窗口大小来提供。窗口大小为字节数,起始于确认序号字段指明的值,这个值是接收端正期望接收的字节。窗口大小是一个16字节字段,因而窗口大小最大为65535字节。

16位检验和:检验和覆盖了整个的TCP报文段: TCP首部和TCP数据。这是一个强制性的字段,一定是由发端计算和存储,并由收端进行验证。

16位紧急指针:只有当U R G标志置1时紧急指针才有效。紧急指针是一个正的偏移量,和序号字段中的值相加表示紧急数据最后一个字节的序号。

选项:图3-1和图3-2有8个字节选项,图3-3没有选项。最常见的可选字段是最长报文大小,又称为MSS (Maximum Segment Size)。每个连接方通常都在握手的第一步中指明这个选项。它指明本端所能接收的最大长度的报文段。图3-1可以看出208号机可以接受的最大字节数为1460字节,1460也是以太网默认的大小,在第三组的数据分析中可以看到数据传送正是以1460字节传送的。

握手小结

上面我们分开讲了三次握手,看着有点散,现在小结一下。

图3-4

第三组数据传输

1)下图显示的是57-60行的数据

图3-5

2)解释数据包

这四行数据是数据传输过程中一个发送一个接收的过程。

前文说过,TCP提供一种面向连接的、可靠的字节流服务。当接收端收到来自发送端的信息时,接受端要发送一条应答信息,表示收到此信息。数据传送时被TCP分割成认为最适合发送的数据块。一般以太网在传送时TCP将数据分为1460字节。也就是说数据在发送方被分成一块一块的发送,接受端收到这些数据后再将它们组合在一起。

57行显示1号机给208号机发送了大小为1514字节大小的数据,注意我们前文讲过数据发送时是层层加协议头的,1514字节=14字节以太网头 + 20字节IP头 + 20字节TCP头 + 1460字节数据58行显示的应答信号ACK为:1781514222,这个数是57行得SEQ序号1781512762加上传送的数据1460,208号机将这个应答信号发给1号机说明已收到发来的数据。

59、60行显示的是继续传送数据的过程。

3)头信息

图3-8和图3-9分别是57行和58行的头信息,解释参考第二组。

第四组终止连接

1)下图显示的是93-96行的数据

图3-8

2)解释数据包

93-96是两机通讯完关闭的过程。

建立一个连接需要三次握手,而终止一个连接要经过4次握手。这是因为一个TCP连接是全双工(即数据在两个方向上能同时传递),每个方向必须单独地进行关闭。4次握手实际上就是双方单独关闭的过程。

本例文件下载完后,关闭浏览器终止了与服务器的连接图的93-96行显示的就是终止连接所经过4次握手过程。

93行数据显示的是关闭浏览器后,如图3-9所示208号机将FIN置1连同序号(SEQ)987695574发给1号机请求终止连接。

94行数据和图3-10显示1号机收到FIN关闭请求后,发回一个确认,并将应答信号设置为收到序号加1,这样就终止了这个方向的传输。

95行数据和图3-11显示1号机将FIN置1连同序号(SEQ)1773196056发给208号机请求终止连接。

96行数据和图3-12显示208号机收到FIN关闭请求后,发回一个确认,并将应答信号设置为收到序号加1,至此TCP连接彻底关闭。

3)头信息

五、实验报告要求

要求采用学校的实验报告书(16开)。如打印也应采用实验报告书的版头(A4纸)。并提交实验报告电子版及相关实验数据文档及资料。

参考资料:利用IRIS学习TCP/IP

一、前言

目前,网络的速度发展非常快,学习网络的人也越来越多,稍有网络常识的人都知道TCP/IP 协议是网络的基础,是Internet的语言,可以说没有TCP/IP协议就没有互联网的今天。目前搞网络的人非常多,许多人就是从一把夹线钳,一个测线器联网开始接触网络的,如果只是联网玩玩,知道几个Ping之类的命令就行了,如果想在网络上有更多的发展不管是黑道还是红道,必须要把TCP/IP协议搞的非常明白。

学习过TCP/IP协议的人多都有一种感觉,这东西太抽象了,没有什么数据实例,看完不久就忘了。本文将介绍一种直观的学习方法,利用分析监测工具IRIS学习TCP/IP,在学习的同时通过IRIS能直观的看到数据的具体传输过程,这对学习TCP/IP能起到事半功倍的效果。

为了初学者更容易理解,本文将搭建一个最简单的网络环境,不包含子网。

二、试验环境

1、网络环境

如图1所示

图1

为了表述方便,下文中208号机即指地址为192.168.113.208的计算机,1号机指地址为192.168.113.1的计算机。

2、操作系统

两台机器都为Windows 2000 ,1号机机器作为服务器,安装FTP服务

3、协议分析工具

Windows环境下常用的工具有:Sniffer Pro、Natxray、IRIS以及windows 2000自带的网络监视器等。本文选用IRIS作为协议分析工具。

在客户机208号机安装IRIS软件。

三、测试过程

1、测试例子:将1号机计算机中的一个文件通过FTP下载到208号机中。

2、IRIS的设置。

由于IRIS具有网络监听的功能,如果网络环境中还有其它的机器将抓很多别的数据包,这样为学习带来诸多不便,为了清楚地看清楚上述例子的传输过程首先将IRIS设置为只抓

208号机和1号机之间的数据包。设置过程如下:

1) 用热键CTRL+B弹出如图所示的地址表,在表中填写机器的IP地址,为了对抓的包看得更清楚不要添主机的名字(name),设置好后关闭此窗口。

图2

2)用热键CTRL+E弹出如图所示过滤设置,选择左栏―IP address‖,右栏按下图将address book中的地址拽到下面,设置好后确定,这样就这抓这两台计算机之间的包。

图3

3、抓包

按下IRIS工具栏中开始按钮。在浏览器中输入:FTP://192.168.113.1,找到要下载的文件,鼠标右键该文件,在弹出的菜单中选择―复制到文件夹‖开始下载,下载完后在IRIS 工具栏中按按钮停止抓包。图4显示的就是FTP的整个过程,下面我们将详细分析这个过程。

图4

说明:为了能抓到ARP协议的包,在WINDOWS 2000 中运行arp –d 清除arp缓存。

四、过程分析

1、TCP/IP的基本原理

本文的重点虽然是根据实例来解析TCP/IP,但要讲明白下面的过程必须简要讲一下TCP/IP的基本原理。

A.网络是分层的,每一层分别负责不同的通信功能。

B.TCP/IP通常被认为是一个四层协议系统,TCP/IP协议族是一组不同的协议组合在一起构成的协议族。尽管通常称该协议族为TCP/IP,但TCP和IP只是其中的两

种协议而已,如表1所示。每一层负责不同的功能:

表1

分层的概念说起来非常简单,但在实际的应用中非常的重要,在进行网络设置和排除故障时对网络层次理解得很透,将对工作有很大的帮助。例如:设置路由是网络层IP协议的事,要查找MAC地址是链路层ARP的事,常用的Ping命令由ICMP协议来做的。

图5显示了各层协议的关系,理解它们之间的关系对下面的协议分析非常重要。

图5

b. 数据发送时是自上而下,层层加码;数据接收时是自下而上,层层解码。

当应用程序用TCP传送数据时,数据被送入协议栈中,然后逐个通过每一层直到被当作一串比特流送入网络。其中每一层对收到的数据都要增加一些首部信息(有时还要增加尾部信息),该过程如图6所示。TCP传给IP的数据单元称作TCP报文段或简称为TCP段。IP传给网络接口层的数据单元称作IP数据报。通过以太网传输的比特流称作帧(Frame)。

数据发送时是按照图6自上而下,层层加码;数据接收时是自下而上,层层解码。

图6

C. 逻辑上通讯是在同级完成的

垂直方向的结构层次是当今普遍认可的数据处理的功能流程。每一层都有与其相邻层的接口。为了通信,两个系统必须在各层之间传递数据、指令、地址等信息,通信的逻辑流程与真正的数据流的不同。虽然通信流程垂直通过各层次,但每一层都在逻辑上能够直接与远程计算机系统的相应层直接通信。

从图7可以看出,通讯实际上是按垂直方向进行的,但在逻辑上通信是在同级进行的。

图7

2、过程描述

为了更好的分析协议,我们先描述一下上述例子数据的传输步骤。如图8所示:

图8

1) FTP客户端请求TCP用服务器的IP地址建立连接。

2) TCP发送一个连接请求分段到远端的主机,即用上述IP地址发送一份IP数据报。

3) 如果目的主机在本地网络上,那么IP数据报可以直接送到目的主机上。如果目的主机在一个远程网络上,那么就通过IP选路函数来确定位于本地网络上的下一站路由器地址,并让它转发IP数据报。在这两种情况下,IP数据报都是被送到位于本地网络上的一台主机或路由器。

4) 本例是一个以太网,那么发送端主机必须把32位的IP地址变换成48位的以太网地址,该地址也称为MAC地址,它是出厂时写到网卡上的世界唯一的硬件地址。把IP地址翻译到对应的MAC地址是由ARP协议完成的。

5) 如图的虚线所示,ARP发送一份称作ARP请求的以太网数据帧给以太网上的每个主机,这个过程称作广播。ARP请求数据帧中包含目的主机的IP地址,其意思是―如果你是这个IP地址的拥有者,请回答你的硬件地址。‖

6) 目的主机的ARP层收到这份广播后,识别出这是发送端在寻问它的IP地址,于是发送一个ARP应答。这个ARP应答包含IP地址及对应的硬件地址。

7) 收到ARP应答后,使ARP进行请求—应答交换的IP数据包现在就可以传送了。

8) 发送IP数据报到目的主机。

3、实例分析

下面通过分析用IRIS捕获的包来分析一下TCP/IP的工作过程,为了更清晰的解释数据传送的过程,我们按传输的不同阶段抓了四组数据,分别是查找服务器、建立连接、数据传输和终止连接。每组数据,按下面三步进行解释。

显示数据包

解释该数据包

按层分析该包的头信息

第一组查找服务器

1)下图显示的是1、2行的数据。

图9

2)解释数据包

这两行数据就是查找服务器及服务器应答的过程。

在第1行中,源端主机的MAC地址是00:50:FC:22:C7:BE。目的端主机的MAC地址是FF:FF:FF:FF:FF:FF,这个地址是十六进制表示的,F换算为二进制就是1111,全1的地址就是广播地址。所谓广播就是向本网上的每台网络设备发送信息,电缆上的每个以太网接口都要接收这个数据帧并对它进行处理,这一行反映的是步骤5)的内容,ARP发送一份称作ARP 请求的以太网数据帧给以太网上的每个主机。网内的每个网卡都接到这样的信息―谁是

192.168.113.1的IP地址的拥有者,请将你的硬件地址告诉我‖。

第2行反映的是步骤6)的内容。在同一个以太网中的每台机器都会"接收"到这个报文,但正常状态下除了1号机外其他主机应该会忽略这个报文,而1号的主机的ARP层收到这份广播报文后,识别出这是发送端在寻问它的IP地址,于是发送一个ARP应答。告知自己的IP地址和MAC地址。第2行可以清楚的看出1号回答的信息__自己的MAC地址

00:50:FC:22:C7:BE。

这两行反映的是数据链路层之间一问一答的通信过程。这个过程就像我要在一个坐满人的教室找一个叫―张三‖的人,在门口喊了一声―张三‖,这一声大家都听见了,这就叫广播。张三听到后做了回应,别人听到了没做回应,这样就与张三取得了联系。

3)头信息分析

如下图左栏所示,第1数据包包含了两个头信息:以太网(Ethernet)和ARP。

图10

下表2是以太网的头信息,括号内的数均为该字段所占字节数,以太网报头中的前两个字段是以太网的源地址和目的地址。目的地址为全1的特殊地址是广播地址。电缆上的所有以太网接口都要接收广播的数据帧。两个字节长的以太网帧类型表示后面数据的类型。对于ARP

请求或应答来说,该字段的值为0806。

第2行中可以看到,尽管ARP请求是广播的,但是ARP应答的目的地址却是1号机的(00 50 FC 22 C7 BE)。ARP应答是直接送到请求端主机的。

行以太网目的地址(6)以太网源地址(6)帧类型(2)

1 FF FF FF FF FF FF 00 50 FC 2

2 C7 BE 08 06

2 00 50 FC 22 C7 BE 00 90 27 F6 54 5

3 08 06

表2

下表3是ARP协议的头信息。硬件类型字段表示硬件地址的类型。它的值为1即表示以太网地址。协议类型字段表示要映射的协议地址类型。它的值为0800即表示IP地址。它的值与包含IP数据报的以太网数据帧中的类型字段的值相同。接下来的两个1字节的字段,硬件地址长度和协议地址长度分别指出硬件地址和协议地址的长度,以字节为单位。对于以太网上IP 地址的ARP请求或应答来说,它们的值分别为6和4。Op即操作(Opoperation),1是ARP 请求、2是ARP应答、3是RARP请求和4为RARP应答,第二行中该字段值为2表示应答。接下来的四个字段是发送端的硬件地址、发送端的IP地址、目的端的硬件地址和目的端IP地址。注意,这里有一些重复信息:在以太网的数据帧报头中和ARP请求数据帧中都有发送端的硬件地址。对于一个ARP请求来说,除目的端硬件地址外的所有其他的字段都有填充值。

表3的第2行为应答,当系统收到一份目的端为本机的ARP请求报文后,它就把硬件地址填进去,然后用两个目的端地址分别替换两个发送端地址,并把操作字段置为2,最后把它发送回去。

行 1 2

硬件类型(2) 00 01 00 01

协议类型(2) 08 00 08 00

硬件地址长度(1) 06 06

协议地址长度(1) 04 04

Op(2) 00 01 00 02

发送端以太网地址(6) 00 50 FC 22 C7 BE 00 90 27 F6 54 53

发送端IP地址(4) C0 A8 71 D0 C0 A8 7101

目的以太网地址(6) 00 00 00 00 00 00 00 50 FC 22 C7 BE

目的IP地址(4) C0 A8 71 01 C0 A8 71 D0

表3

本文中我们推出了用协议分析工具IRIS学习TCP/IP协议的上半部份,剩下的内容我们将在下半部份中一起推出。

第二组建立连接

1)下图显示的是3-5行的数据。

图11

2)解释数据包

这三行数据是两机建立连接的过程。

这三行的核心意思就是TCP协议的三次握手。TCP的数据包是靠IP协议来传输的。但IP协议是只管把数据送到出去,但不能保证IP数据报能成功地到达目的地,保证数据的可靠传输是靠TCP 协议来完成的。当接收端收到来自发送端的信息时,接受端详发送短发送一条应答信息,意思是:“我已收到你的信息了。”第三组数据将能看到这个过程。TCP是一个面向连接的协议。无论哪一方向另一方发送数据之前,都必须先在双方之间建立一条连接。建立连接的过程就是三次握手的过程。

这个过程就像要我找到了张三向他借几本书,第一步:我说:“你好,我是担子”,第二步:张三说:“你好,我是张三”,第三步:我说:“我找你借几本书。”这样通过问答就确认对方身份,建立了联系。

下面来分析一下此例的三次握手过程。

A.请求端208号机发送一个初始序号(SEQ)987694419给1号机。

B.服务器1号机收到这个序号后,将此序号加1值为987694419作为应答信号(ACK),同时随机产生一个初始序号(SEQ)1773195208,这两个信号同时发回到请求端208号机,意思为:“消息已收到,让我们的数据流以1773195208这个数开始。”

C.请求端208号机收到后将确认序号设置为服务器的初始序号(SEQ)1773195208加1为1773195209作为应答信号。

以上三步完成了三次握手,双方建立了一条通道,接下来就可以进行数据传输了。

下面分析TCP头信息就可以看出,在握手过程中TCP头部的相关字段也发生了变化。

3)头信息分析

如图12所示,第3数据包包含了三头信息:以太网(Ethernet)和IP和TCP。

头信息少了ARP多了IP、TCP,下面的过程也没有ARP的参与,可以这样理解,在局域网内,ARP负责的是在众多联网的计算机中找到需要找的计算机,找到工作就完成了。

以太网的头信息与第1、2行不同的是帧类型为0800,指明该帧类型为IP。

数据挖掘与预测分析

数据挖掘是一个多学科交叉研究领域,它融合了数据库技术、人工智能、机器学习、统计学、知识工程、面向对象方法、信息检索、高性能计算以及数据可视化等最新技术的研究成果。数据挖掘是目前人工智能和数据库领域研究的热点问题,所谓数据挖掘是指从数据库的大量数据中揭示出隐含的、先前未知的并有潜在价值的信息的非平凡过程。数据挖掘是一种决策支持过程,高度自动化地分析企业的数据,做出归纳性的推理,从中挖掘出潜在的模式,帮助决策者调整市场策略,减少风险,做出正确的决策。预测分析是一种统计或数据挖掘解决方案,包含可在结构化和非结构化数据中使用以确定未来结果的算法和技术。可为预测、优化、预报和模拟等许多其他用途而部署。预测分析可帮助用户评审和权衡潜在决策的影响力。可用来分析历史模式和概率,预测未来业绩并采取预防措施。 数据挖掘的含义是广泛的,每个人有每个人不同的体会,每个人有每个人的见解。但这些体会、见解是有许多共通之处的,从而可以归纳出数据挖掘的技术定义以及商业定义:从技术角度,数据挖掘(Data Mining)就是从大量的、不完全的、有噪声的、模糊的、随机的数据中,提取隐含在其中的、人们事先不知道的但又是潜在有用的信息和知识的过程。它是涉及机器学习、模式识别、统计学、人工智能、数据库管理及数据可视化等学科的边缘学科。由于每个人的思维方式不同,这个定义可以被解读为以下几个层次:①数据源必须是真实的、大量的、含噪声的;②发现的是用户感兴趣的知识;③发现的知识要可接受、可理解、可运用;④这些知识是相对的,是有特定前提和约束条件的,在特定领域中具有实际应用价值。 预测是大数据的核心,数据挖掘之后的预测分析无疑成为开拓市场的重要环节。预测分析是一种统计或数据挖掘解决方案,包含可在结构化和非结构化数据中使用以确定未来结果的算法和技术。可为预测、优化、预报和模拟等许多其他用途而部署。预测分析和假设情况分析可帮助用户评审和权衡潜在决策的影响力。可用来分析历史模式和概率,以预测未来业绩并采取预防措施。这种级别的分析可以为规划流程提供各种信息,并对企业未来提供关键洞察。不仅可提供预测分析,使用户可以执行高级分析、发布并与更广泛的用户群交流。还可以提供

数据挖掘工具应用及前景分析

数据挖掘工具应用及前景

介绍以下数据挖掘工具分别为: 1、 Intelligent Miner 2、 SAS Enterpreise Miner 3、SPSS Clementine 4、马克威分析系统 5、GDM Intelligent Miner 一、综述:IBM的Exterprise Miner简单易用,是理解数据挖掘的好的开始。能处理大数据量的挖掘,功能一般,可能仅满足要求.没有数据探索功能。与其他软件接口差,只能用DB2,连接DB2以外的数据库时,如Oracle, SAS, SPSS需要安装DataJoiner作为中间软件。难以发布。结果美观,但同样不好理解。 二、基本内容:一个挖掘项目可有多个发掘库组成;每个发掘库包含多个对象和函数对象: 数据:由函数使用的输入数据的名称和位置。 离散化:将记录分至明显可识别的组中的分发操作。 名称映射:映射至类别字段名的值的规范。 结果:由函数创建的结果的名称和位置。 分类:在一个项目的不同类别之间的关联层次或点阵。 值映射:映射至其它值的规范。 函数: 发掘:单个发掘函数的参数。 预处理:单个预处理函数的参数。 序列:可以在指定序列中启动的几个函数的规范。 统计:单个统计函数的参数。 统计方法和挖掘算法:单变量曲线,双变量统计,线性回归,因子分析,主变量分析,分类,分群,关联,相似序列,序列模式,预测等。 处理的数据类型:结构化数据(如:数据库表,数据库视图,平面文件) 和半结构化或非结构化数据(如:顾客信件,在线服务,传真,电子邮件,网页等) 。 架构:它采取客户/服务器(C/S)架构,并且它的API提供了C++类和方法 Intelligent Miner通过其独有的世界领先技术,例如自动生成典型数据集、发现关联、发现序列规律、概念性分类和可视化呈现,可以自动实现数据选择、数据转换、数据挖掘和结果呈现这一整套数据挖掘操作。若有必要,对结果数据集还可以重复这一过程,直至得到满意结果为止。 三、现状:现在,IBM的Intelligent Miner已形成系列,它帮助用户从企业数据资产中 识别和提炼有价值的信息。它包括分析软件工具——Intelligent Miner for Data和IBM Intelligent Miner forText ,帮助企业选取以前未知的、有效的、可行的业务知识——

数据挖掘与分析心得体会

正如柏拉图所说:需要是发明之母。随着信息时代的步伐不断迈进,大量数据日积月累。我们迫切需要一种工具来满足从数据中发现知识的需求!而数据挖掘便应运而生了。正如书中所说:数据挖掘已经并且将继续在我们从数据时代大步跨入信息时代的历程中做出贡献。 1、数据挖掘 数据挖掘应当更正确的命名为:“从数据中挖掘知识”,不过后者显得过长了些。而“挖掘”一词确是生动形象的!人们把数据挖掘视为“数据中的知识发现(KDD)”的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤! 由此而产生数据挖掘的定义:从大量数据中挖掘有趣模式和知识的过程!数据源包括数据库、数据仓库、Web、其他信息存储库或动态地流入系统的数据。作为知识发现过程,它通常包括数据清理、数据集成、数据变换、模式发现、模式评估和知识表示六个步骤。 数据挖掘处理数据之多,挖掘模式之有趣,使用技术之大量,应用范围之广泛都将会是前所未有的;而数据挖掘任务之重也一直并存。这些问题将继续激励数据挖掘的进一步研究与改进! 2、数据分析 数据分析是指用适当的统计方法对收集来的大量第一手资料和第二手资料进行分析,以求最大化地开发数据资料的功能,发挥数据的作用。是为了提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。 数据分析有极广泛的应用范围。典型的数据分析可能包含以下三个步: 1、探索性数据分析:当数据刚取得时,可能杂乱无章,看不出规律,通过作图、造表、用各种形式的方程拟合,计算某些特征量等手段探索规律性的可能形式,即往什么方向和用何种方式去寻找和揭示隐含在数据中的规律性。 2、模型选定分析,在探索性分析的基础上提出一类或几类可能的模型,然后通过进一步的分析从中挑选一定的模型。 3、推断分析:通常使用数理统计方法对所定模型或估计的可靠程度和精确程度作出推断。 数据分析的目的是把隐没在一大批看来杂乱无章的数据中的信息集中、萃取和提炼出来,以找出所研究对象的内在规律。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。数据分析是组织有目的地收集数据、分析数据,使之成为信息的过程。这一过程是质量管理体系的支持过程。在产品的整个寿命周期,包括从市场调研到售后服务和最终处置的各

《SAS数据分析范例》(SAS数据集)

《SAS数据分析范例》数据集 目录 表1 sas.bd1 (3) 表2 sas.bd3 (4) 表3 sas.bd4 (5) 表4 sas.belts (6) 表5 sas.c1d2 (7) 表6 sas.c7d31 (8) 表7 sas.dead0 (9) 表8 sas.dqgy (10) 表9 sas.dqjyjf (11) 表10 sas.dqnlmy3 (12) 表11 sas.dqnlmy (13) 表12 sas.dqrjsr (14) 表13 sas.dqrk (15) 表14 sas.gjxuexiao0 (16) 表15 sas.gnsczzgc (17) 表16 sas.gnsczzs (18) 表17 sas.gr08n01 (19) 表18 sas.iris (20) 表19 sas.jmcxck0 (21) 表20 sas.jmjt052 (22) 表21 sas.jmjt053 (23) 表22 sas.jmjt054 (24) 表23 sas.jmjt055 (25) 表24 sas.jmxfsps (26) 表25 sas.jmxfspzs0 (27) 表26 sas.jmxfzss (28) 表27 sas.jmxfzst (29) 表28 sas.kscj2 (30) 表29 sas.modeclu4 (31) 表30 sas.ms8d1 (32) 表31 sas.nlmyzzs (33) 表32 sas.plates (34) 表33 sas.poverty (35) 表34 sas.rjnycpcl0 (36) 表35 sas.rjsrs (37) 表36 sas.sanmao (38) 表37 sas.sczz1 (39) 表38 sas.sczz06s (40) 表39 sas.sczz (41) 表40 sas.sczzgc1 (42)

5种数据挖掘工具分析比较

数据挖掘工具调查与研究 姓名:马蕾 学号:18082703

5种数据挖掘工具分别为: 1、 Intelligent Miner 2、 SAS Enterpreise Miner 3、SPSS Clementine 4、马克威分析系统 5、GDM Intelligent Miner 一、综述:IBM的Exterprise Miner简单易用,是理解数据挖掘的好的开始。能处理大数据量的挖掘,功能一般,可能仅满足要求.没有数据探索功能。与其他软件接口差,只能用DB2,连接DB2以外的数据库时,如Oracle, SAS, SPSS需要安装DataJoiner作为中间软件。难以发布。结果美观,但同样不好理解。 二、基本内容:一个挖掘项目可有多个发掘库组成;每个发掘库包含多个对象和函数对象: 数据:由函数使用的输入数据的名称和位置。 离散化:将记录分至明显可识别的组中的分发操作。 名称映射:映射至类别字段名的值的规范。 结果:由函数创建的结果的名称和位置。 分类:在一个项目的不同类别之间的关联层次或点阵。 值映射:映射至其它值的规范。 函数: 发掘:单个发掘函数的参数。 预处理:单个预处理函数的参数。 序列:可以在指定序列中启动的几个函数的规范。 统计:单个统计函数的参数。 统计方法和挖掘算法:单变量曲线,双变量统计,线性回归,因子分析,主变量分析,分类,分群,关联,相似序列,序列模式,预测等。 处理的数据类型:结构化数据(如:数据库表,数据库视图,平面文件) 和半结构化或非结构化数据(如:顾客信件,在线服务,传真,电子邮件,网页等) 。 架构:它采取客户/服务器(C/S)架构,并且它的API提供了C++类和方法 Intelligent Miner通过其独有的世界领先技术,例如自动生成典型数据集、发现关联、发现序列规律、概念性分类和可视化呈现,可以自动实现数据选择、数据转换、数据挖掘和结果呈现这一整套数据挖掘操作。若有必要,对结果数据集还可以重复这一过程,直至得到满意结果为止。 三、现状:现在,IBM的Intelligent Miner已形成系列,它帮助用户从企业数据资产中 识别和提炼有价值的信息。它包括分析软件工具——Intelligent Miner for Data和IBM Intelligent Miner forText ,帮助企业选取以前未知的、有效的、可行的业务知识——

数据清洗、数据分析、数据挖掘

数据清洗 1.基本概念 数据清洗从名字上也看的出就是把"脏"的"洗掉",指发现并纠正数据文件中可识别的错误的最后一道程序,包括检查数据一致性,处理无效值和缺失值等。因为数据仓库中的数据是面向某一主题的数据的集合,这些数据从多个业务系统中抽取而来而且包含历史数据,这样就避免不了有的数据是错误数据、有的数据相互之间有冲突,这些错误的或有冲突的数据显然是我们不想要的,称为"脏数据"。我们要按照一定的规则把"脏数据""洗掉",这就是数据清洗。而数据清洗的任务是过滤那些不符合要求的数据,将过滤的结果交给业务主管部门,确认是否过滤掉还是由业务单位修正之后再进行抽取。不符合要求的数据主要是有不完整的数据、错误的数据、重复的数据三大类。数据清洗是与问卷审核不同,录入后的数据清理一般是由计算机而不是人工完成。 ?残缺数据 这一类数据主要是一些应该有的信息缺失,如供应商的名称、分公司的名称、客户的区域信息缺失、业务系统中主表与明细表不能匹配等。对于这一类数据过滤出来,按缺失的内容分别写入不同Excel文件向客户提交,要求在规定的时间内补全。补全后才写入数据仓库。 折叠错误数据

这一类错误产生的原因是业务系统不够健全,在接收输入后没有进行判断直接写入后台数据库造成的,比如数值数据输成全角数字字符、字符串数据后面有一个回车操作、日期格式不正确、日期越界等。这一类数据也要分类,对于类似于全角字符、数据前后有不可见字符的问题,只能通过写SQL语句的方式找出来,然后要求客户在业务系统修正之后抽取。日期格式不正确的或者是日期越界的这一类错误会导致ETL运行失败,这一类错误需要去业务系统数据库用SQL 的方式挑出来,交给业务主管部门要求限期修正,修正之后再抽取。 折叠重复数据 对于这一类数据--特别是维表中会出现这种情况--将重复数据记录的所有字段导出来,让客户确认并整理。 数据清洗是一个反复的过程,不可能在几天内完成,只有不断的发现问题, 解决问题。对于是否过滤,是否修正一般要求客户确认,对于过滤掉的数据,写入Excel文件或者将过滤数据写入数据表,在ETL开发的初期可以每天向业务单位发送过滤数据的邮件,促使他们尽快地修正错误,同时也可以做为将来验证数据的依据。数据清洗需要注意的是不要将有用的数据过滤掉,对于每个过滤规则认真进行验证,并要用户确认。 数据分析是指用适当的统计分析方法对收集来的大量数据进行分析,提取有用信息和形成结 论而对数据加以详细研究和概括总结的过程。这一过程也是质量管理体系的支持过程。在实 用中,数据分析可帮助人们作出判断,以便采取适当行动。 类型 在统计学领域,有些人将数据分析划分为描述性统计分析、探索性数据分析以及验证性数据分析;其中,探索性数据分析侧重于在数据之中发现新的特征,而验证性数据分析则侧重于已有假设的

模式识别-贝叶斯统计-iris数据集

IRIS数据集下基于最小错误率和最小风险的贝叶斯决策的实验与分析 贺翔 3115370035 硕5101

1.问题描述 1.1 Iris 数据集 Iris 数据集包含3类4维样本,分别标为1, 2, 3。其中, 每类样本数目为50, 且服从正态分布,每个数据样本有4个特征向量,分别代表萼片长度, 萼片宽度, 花瓣长度和花瓣宽度。 1.2要求 假设Iris 数据是正态分布的,要求考虑各种实验可能性(分组数量、分组策略、先验概率等),用样本对多维正态密度函数进行参数估计(均值向量和协方差矩阵),最后对3类Iris 两两分类。 2.原理描述 2.1贝叶斯公式 已知共有M 类别M i i ,2,1,=ω,统计分布为正态分布,已知先验概率)(i P ω及条件概率密度函数)|(i X P ω,对于待测样品,贝叶斯公式可以计算出该样品分属各类别的概率,即后验概率。贝叶斯公式为 M i P X P P X P X P M j j j i i i ,2,1,)()|() ()|()|(1==∑=ωωωωω 因此给定一个未知类别的数据样本X ,贝叶斯分类法将预测X 属于具有最高后验概率的类。故此问题的数学描述为:多元正态概率模型下的贝叶斯分类。

2.2参数估计 其中,条件概率密度函数)|(i X P ω为正态密度函数,用大量样本对其中未知参数进行估计,多维正态密度函数为 )]()(21exp[)2(1)(12/12/μμπ---=-X S X S X P T n 式中,),,(21n x x x X =为n 维向量; ),,(21n μμμμ =为n 维均值向量; ]))([(T X X E S μμ--=为n 维协方差矩阵; 1-S 是S 的逆矩阵; S 是S 的行列式。 大多数情况下,条件密度可以采用多维变量的正态密度函数来模拟。 )]}()(21exp[)2(1 ln{)|()(1)(2/12/i i X X S X X S X P i T i n i ωωπω---=- i i T S n X X S X X i i ln 212ln 2)()(21)(1)(-----=-πωω )(i X ω为i ω类的均值向量。 2.3先验概率 设数据集样本有d 个属性,因此可用一个d 维列向量12[,,...,]T d x x x x =来表示。同时假定有c 个类12,,...c ωωω。如果类的先验概率未知,则可以假定这些类是等概率的,即 12()()...()c P P P ωωω===,且()i i S P S ω= 其中,i S 是类i ω中的训练样本数,而S 是训练样本总数。 2.4贝叶斯决策

数据挖掘在大数据时代下的应用

数据挖掘在大数据时代下的应用 【摘要】数据挖掘一直是各个行业的关注的重点。 近几年,数据挖掘伴随着大数据的火热开始迎来更大的机遇。本文介绍了数据挖掘相关的概念,一些常用的数据挖掘的分析方法,最后介绍了数据挖掘技术几个常见的应用领域。 【关键词】数据挖掘分析方法应用 一、基本概念介绍 1、大数据。2011 年5 月,麦肯锡全球研究院在《大数据:创新、竞争和生产力的下一个新领域》中指出,大数据是一种规模大到在获取、存储、管理、分析方面大大超出了传统数据库软件工具能力范围的数据集合,具有海量的数据规模、快速的数据流转、多样的数据类型和价值密度低四大特征。数据已经渗透到每一个行业和业务职能领域,逐渐成为重要的生产要素;而人们对于大数据的运用预示着新一波生产率增长和消费者盈余浪潮的到来。据估计,在未来,数据将至少保持每年50%的增长速度。 2、数据挖掘。数据挖掘是一门新兴的学科,它诞生于20 世纪80 年代,主要面向商业应用的人工智能研究领域. 从技术角度看,数据挖掘就是从大量的、复杂的、不规则的、随机的、模糊的数据中获取隐含的、人们事先没有发觉的、

有潜在价值的信息和知识的过程.从商业角度来说,数据挖掘就是从庞大的数据库中抽取、转换、分析一些潜在规律和价值,从中获取辅助商业决策的关键信息和有用知识。 二、数据挖掘的基本分析方法 分析方法是数据挖掘的核心工作,通过科学可靠的算法才能实现数据的挖掘,找出数据中潜在的规律。通过不同的分析方法,将解决不同类型的问题,在现实中针对不同的分析目标,找出相对应的方法。目前常用的分析方法主要有聚类分析、分类和预测、关联分析等。 1、聚类分析。聚类分析就是将物理或抽象对象的集合进行分组,然后组成为由类似或相似的对象组成的多个分类的分析过程,其目的就是通过相似的方法来收集数据分类。它是一种无先前知识,无监督的学习过程,从数据对象中找出有意义的数据,然后将其划分在一个未知的类。这不同于分类,因为它无法获知对象的属性。“物以类聚,人以群分”,通过聚类来分析事物之间类聚的潜在规律。聚类分析广泛运用于心理学、统计学、医学、生物学、市场销售、数据识别、机器智能学习等领域。聚类分析根据隶属度的取值范??可分为硬聚类和模糊聚类两种方法。硬聚类就是将对象划分到距离最近聚类的类,非此即彼,也就是说属于一类,就必然不属于另一类。模糊聚类就是根据隶属度的取值范围的大小差异来划分类。一个样本可能属于多个类。常见的聚类算法主

数据挖掘技术在软件工程中的应用分析

数据挖掘技术在软件工程中的应用分析 黎庆剑 中国软件与技术服务股份有限公司,北京 102200 摘要:信息大爆炸的新时期,人们所需要处理的信息越来越多,如何利用信息技术帮助人们处理这些复杂的数据,挖掘出对人们有帮助的信息是非常有意义的。本文对数据挖掘技术在软件工程中的应用进行了分析。 关键词:数据挖掘;软件工程;应用 现如今随着经济的迅猛发展,社会各方面物质文化水平都在一定程度上得以提升,从而使得人们的生活状态也较以前发生了翻天覆地的变化。近年来,信息技术的发生更是进一步推动了社会的进步,复杂而又充实的信息环境使得人们所接触的事物也更加清晰,但是在这些信息里面需要认真加以辨别,只有从中获取有益的信息才能给自己带来更大的益处。 因此有必要对现有的数据进行整合处理直接为人们所使用。在这个信息爆炸的时代里,人们获取的信息量是非常惊人的。对信息数据的挖掘在软件工程中的地位也逐步提升。 1 软件工程数据挖掘技术概述 1.1数据挖掘技术在软件工程中的应用发展 所谓的数据挖掘技术还有一个比较常用的称呼,就是数据库中的信息资源提取,该技术与数据库相互依存,不可割舍。从刚开始的提出,到最后的实践应用,该技术渐渐地走向更为多向化和多功能化,并且在该项技术中融入了相当多的重要领域技术。而对于软件工程来说,其最原始的意义起源于一九六七年,该项工程自提出以后就一直受到重点研究和关注,就其功能将其进行定义为采用工程化的途径或者是方法对具有实用意义的并且高质量的和存在一定功能效用的软件内容进行构造和创建,这样的软件构建预期的目标是在一定的背景条件下以及成本基础上,所研究开发出的软件产品能够满足使用者的大部分需求。在二十世纪后期的时候,这一领域的研究人员就意识到了单纯的数据挖掘技术其实意义不大,需要结合实际的数据特性将工程类软件与之结合在一起,从而相互攫取双方的优点,从而在极大程度上提升数据挖掘技术的作用。这一理念同时也得到了相关学者的一致认同,从而使得这一想法进一步融入了实际生产运作过程中,使得如今的数据挖掘技术变得越发完善。

用户界面设计实验-系统界面设计实例完整版.doc

用户界面设计实例 ● 设计的系统名称:个人日常事务管理系统 ● 针对用户群是:广大电脑用户(有一定的电脑操作基础),officer 和广大学 生。 一、系统需求分析(The system requirement ) 针对officer 和学生们的需求分析,从我自身分析:对于我日常的安排我平 时会用专门的记事本记录和更改,对于日常各种事务可能会冲突或不变携带,现在针对这些需求,设计出符合此人群适合的一款系统来帮助人们更好的安排日程和完成工作。此系统是要面向个人的,同企业系统相比,此软件要力求操作简单,效率要高效,由于针对的人群是officer 和大学生,这些人都是年轻的一代人,对计算机和系统都比较了解,而且倾向于华丽的界面,但是该系统同时要解决高效,较少的操作较快地达到用户的需求。由于工作原因或计算机系统崩溃等用户在本机保存的日程安排等数据可能丢失的情况,同时,有些情况下可能无法连接网络,此系统应支持 1.、本机数据保存。2、可以上传到服务器数据库,用户注册可获得免费的空间,用户注册后,只要登录就能在随时随地获得自己的日程安排等信息。 二、系统功能定义(The function definitions ) 个人日程管理系统主要是提供个人时间日程安排系统软件,它具有相当方便的操作接口,让用户能够对所安排的行程一目了然,除去主要功能还附带了更多功能和小工具,安排的行程可以生成通行路线,并会根据天气预报提醒当天安排是否影响。而且用户可以注册,注册后用户有更多的服务,安排的日程数据可以保存到本地同时可以更新到服务器,这样用户就算到外地也可以随时查看自己的日程安排,同时其他功能有:时钟提醒、通讯录、效率评估等。 实现功能(主界面导航): 个人日常事 务管理系统

分析报告、统计分析和数据挖掘的区别

分析报告、统计分析和数据挖掘的区别 关于数据挖掘的作用,Berry and Linoff的定义尽管有些言过其实,但清晰的描述了数据挖掘的作用。“分析报告给你后见之明 (hindsight);统计分析给你先机 (foresight);数据挖掘给你洞察力(insight)”。 举个例子说。 你看到孙悟空跟二郎神打仗,然后写了个分析报告,说孙悟空在柔韧性上优势明显,二郎神在力气上出类拔萃,所以刚开始不相上下;结果两个人跑到竹林里,在竹子上面打,孙悟空的优势发挥出来,所以孙悟空赢了。这叫分析报告。 孙悟空要跟二郎神打架了,有个赌徒找你预测。你做了个统计,发现两人斗争4567次,其中孙悟空赢3456次。另外,孙悟空斗牛魔王,胜率是89%,二郎神斗牛魔王胜率是71%。你得出趋势是孙悟空赢。因为你假设了这次胜利跟历史的关系,根据经验作了一个假设。这叫统计分析。 你什么都没做,让计算机自己做关联分析,自动找到了出身、教育、经验、单身四个因素。得出结论是孙悟空赢。计算机通过分析发现贫苦出身的孩子一般比皇亲国戚功夫练得刻苦;打架经验丰富的人因为擅长利用环境而机会更多;在都遇得到明师的情况下,贫苦出身的孩子功夫可能会高些;单身的人功夫总比同样环境非单身的高。孙悟空遇到的名师不亚于二郎神,而打架经验绝对丰富,并且单身,所以这次打头,孙悟空赢。这叫数据挖掘。 数据挖掘跟LOAP的区别在于它没有假设,让计算机找出这种背后的关系,而这种关系可能是你所想得到的,也可能是所想不到的。比如数据挖掘找出的结果发现在2亿条打斗记录中,姓孙的跟姓杨的打,总是姓孙的胜利,孙悟空姓孙,所以,悟空胜利。 用在现实中,我们举个例子来说,做OLAP分析,我们找找哪些人总是不及时向电信运营商缴钱,一般会分析收入低的人往往会缴费不及时。通过分析,发现不及时缴钱的穷人占71%。而数据挖掘则不同,它自己去分析原因。原因可能是,家住在五环以外的人,不及时缴钱。这些结论对推进工作有很深的价值,比如在五环外作市场调研,发现需要建立更多的合作渠道以方便缴费。这是数据挖掘的价值。

利用IRIS软件进行数据报的传输分析

实验四、利用IRIS软件进行数据报的传输分析 一、实验目的 1.掌握如何利用协议分析工具分析IP数据报报文格式,体会数据报发送、转发的过程。在学习的过程中可以直观地看到数据的具体传输过程。 2.通过分析截获TCP报文首部信息,理解首部中的序号、确认号等字段是TCP可靠连接的基础。 3.通过分析TCP连接的三次握手建立和释放过程,理解TCP连接建立和释放机制。 二、实验内容和要求 1)学习协议分析工具IRIS的基本使用方法; 2)利用IRIS进行IP数据报报文的抓取; 3)对抓取到的数据报文进行分析,体会数据报发送、转发的过程。 三、实验(设计)仪器设备和材料 1.计算机及操作系统:PC机,Windows; 2.网络环境:可以访问互联网; 四、实验方法、步骤及结构测试 1、测试例子:将1号机计算机中的一个文件通过FTP下载到208号机中。 2、IRIS的设置。 由于IRIS具有网络监听的功能,如果网络环境中还有其它的机器将抓很多别的数据包,这样为学习带来诸多不便,为了看清楚上述例子的传输过程首先将IRIS设置为只抓208号机和1号机之间的数据包。设置过程如下: 1)用热键CTRL+B弹出如图所示的地址表,在表中填写机器的IP地址,为了对抓的包看得更清楚不要添主机的名字(name),设置好后关闭此窗口。 图2-1 2)用热键CTRL+E弹出如图所示过滤设置,选择左栏“IP address”,右栏按下图将address book 中的地址拽到下面,设置好后确定,这样就这抓这两台计算机之间的包。

图2-2 3、抓包 按下IRIS工具栏中开始按钮。在浏览器中输入:FTP://192.168.113.1,找到要下载的文件,鼠标右键该文件,在弹出的菜单中选择“复制到文件夹”开始下载,下载完后在IRIS工具栏中按按钮停止抓包。下面我们将详细分析这个过程。 说明:为了能抓到ARP协议的包,在WINDOWS 2000 中运行arp –d 清除arp缓存。 用iris捕获的包来分析一下TCP/IP的工作过程,为了更清晰的解释数据传送的过程,我们按传输的不同阶段抓了四组数据,分别是1查找服务器、2建立连接、3数据传输和4终止连接(实验二完成第一组数据的分析)。每组数据,按下面三步进行解释: 显示数据包 解释该数据包 按层分析该包的头信息 4、查找服务器抓包分析 1)下图显示的是1、2行的数据 图 2-3 2)解释数据包 这两行数据就是查找服务器及服务器应答的过程。 在第1行中,源端主机的MAC地址是00:50:FC:22:C7:BE。目的端主机的MAC地址是

数据挖掘导论Iris KDD分析(DOC)

` 题目 iris数据集的KDD实验学院名称信息科学与技术学院专业名称计算机科学与技术学生姓名何东升 学生学号201413030119 指导教师 实习地点成都理工大学 实习成绩 二〇一六年 9月

iris数据集的KDD实验 第1章、实验目的及内容 1.1 实习目的 知识发现(KDD:Knowledge Discovery in Database)是从数据集中识别出有效的、新颖的、潜在有用的,以及最终可理解的模式的非平凡过程。知识发现将信息变为知识,从数据矿山中找到蕴藏的知识金块,将为知识创新和知识经济的发展作出贡献。该术语于1989年出现,Fayyad定义为"KDD"是从数据集中识别出有效的、新颖的、潜在有用的,以及最终可理解的模式的非平凡过程”。 KDD的目的是利用所发现的模式解决实际问题,“可被人理解”的模式帮助人们理解模式中包含的信息,从而更好的评估和利用。 1.2 算法的核心思想 作为一个KDD的工程而言,KDD通常包含一系列复杂的挖掘步骤. Fayyad,Piatetsky-Shapiro 和Smyth 在1996年合作发布的论文

数据挖掘与传统分析的区别是什么

数据挖掘与传统分析的区别是什么 欢迎大家在这里学习数据挖掘与传统分析的区别!下面是我们给大家整理出来的精彩内容。希望大家学业有成,工作顺利 ?回归分析、聚类、关联规则、特征、变化和偏差分析、Web页挖掘等, 它们分别从不同的角度对数据进行挖掘。①分类。分类是找出数据库中一组数据对象的共同特点并按照分类模式将其划分为不同的类,其目的是通过分类模型,将数据库中的数据项映射到某个给定的类别。它可以应用到客户的分类、客户的属性和特征分析、客户满意度分析、客户的购买趋势预测等,如一个汽车零售商将客户按照对汽车的喜好划分成不同的类,这样营销人员就可以将新型汽车的广告手册直接邮寄到有这种喜好的客户手中,从而大大增加了商业机会。②回归分析。回归分析方法反映的是事务数据库中属性值在时间上的特征,产生一个将数据项映射到一个实值预测变量的函数,发现变量或属性间的依赖关系,其主要研究问题包括数据序列的趋势特征、数据序列的预测以及数据间的相关关系等。它可以应用到市场营销的各个方面,如客户寻求、保持和预防客户流失活动、产品生命周期分析、销售趋势预测及有针对性的促销活动等。③聚类。聚类分析是把一组数据按照相似性和差异性分为几个类别,其目的是使得属于同一类别的数据间的相似性尽可能大,不同类别中的数据间的相似性尽可能小。它可以应用到客户群体的分类、客户背景分析、客户购买趋势预测、市场的细分等。④关联规则。关联规则是描述数据库中数据项之间所存在的关系的规则,即根据一个事务中某些项的出现可导出另一些项在同一事务中也出现,即隐藏在数据间的关联或相互关系。在客户关系管理中,通过对企业的客户数据库里的大量数据进行

大数据、数据分析和数据挖掘的区别

大数据、数据分析和数据挖掘的区别 大数据、数据分析、数据挖掘的区别是,大数据是互联网的海量数据挖掘,而数据挖掘更多是针对内部企业行业小众化的数据挖掘,数据分析就是进行做出针对性的分析和诊断,大数据需要分析的是趋势和发展,数据挖掘主要发现的是问题和诊断。具体分析如下: 1、大数据(big data): 指无法在可承受的时间范围内用常规软件工具进行捕捉、管理和处理的数据集合,是需要新处理模式才能具有更强的决策力、洞察发现力和流程优化能力的海量、高增长率和多样化的信息资产; 在维克托·迈尔-舍恩伯格及肯尼斯·库克耶编写的《大数据时代》中大数据指不用随机分析法(抽样调查)这样的捷径,而采用所有数据进行分析处理。大数据的5V特点(IBM提出):Volume(大量)、Velocity(高速)、Variety(多样)、Value(价值)Veracity(真实性) 。 2、数据分析:

是指用适当的统计分析方法对收集来的大量数据进行分析,提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。这一过程也是质量管理体系的支持过程。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。 数据分析的数学基础在20世纪早期就已确立,但直到计算机的出现才使得实际操作成为可能,并使得数据分析得以推广。数据分析是数学与计算机科学相结合的产物。 3、数据挖掘(英语:Data mining): 又译为资料探勘、数据采矿。它是数据库知识发现(英语:Knowledge-Discovery in Databases,简称:KDD)中的一个步骤。数据挖掘一般是指从大量的数据中通过算法搜索隐藏于其中信息的过程。数据挖掘通常与计算机科学有关,并通过统计、在线分析处理、情报检索、机器学习、专家系统(依靠过去的经验法则)和模式识别等诸多方法来实现上述目标。 简而言之: 大数据是范围比较广的数据分析和数据挖掘。 按照数据分析的流程来说,数据挖掘工作较数据分析工作靠前些,二者又有重合的地方,数据挖掘侧重数据的清洗和梳理。 数据分析处于数据处理的末端,是最后阶段。 数据分析和数据挖掘的分界、概念比较模糊,模糊的意思是二者很难区分。 大数据概念更为广泛,是把创新的思维、信息技术、统计学等等技术的综合体,每个人限于学术背景、技术背景,概述的都不一样。

基于isodata算法的Iris数据分类

一.实验目的 通过对Iris data 采用Isodata 算法进行聚类,掌握Isodata 算法的原理以及具体实施步骤。 二.实验原理 C 均值算法比较简单,但它的自我调整能力也比较差。这主要表现在类别数不能改变,受代表点初始选择的影响也比较大。ISODATA 算法的功能与C 均值算法相比,在下列几方面有改进。 1.考虑了类别的合并与分裂,因而有了自我调整类别数的能力。合并主要发生在某一类内样本个数太少的情况,或两类聚类中心之间距离太小的情况。为此设有最小类内样本数限制N θ,以及类间中心距离参数C θ。若出现两类聚类中心距离小于C θ的情况,可考虑将此两类合并。 分裂则主要发生在某一类别的某分量出现类内方差过大的现象,因而宜分裂成两个类别,以维持合理的类内方差。给出一个对类内分量方差的限制参数S θ,用以决定是否需要将某一类分裂成两类。 2.由于算法有自我调整的能力,因而需要设置若干个控制用参数,如聚类数期望值K ,每次迭代允许合并的最大聚类对数L 、及允许迭代次数I 等。 下面我们将ISODATA 算法的步骤列出: 步骤1(确定控制参数及设置代表点) 需确定的控制参数为,聚类期望数K ,一个聚类中的最少样本数N θ,标准偏差控制参数,用于控制分裂S θ,类间距离控制参数,用于控制合并C θ,每次迭代允许合并的最大聚类对数L ,允许迭代的次数I 。设初始聚类数为c 及聚类中心,1,2...,i m i c =。 步骤2(分类) 对所有样本,按给定的c 个聚类中心,以最小距离进行分类,即若 步骤3(撤消类内样本数过小类别) 若有任何一个类j Γ,其样本数j N N θ<,则舍去j Γ,令1c c =-,将j Γ原样本分配至其它类; 步骤4(更新均值向量) 按现有样本分类结果,调整均值参数 步骤5(计算类内平均距离) 每类中各样本离开均值的平均距离

设计师必备的五种数据分析UI设计

学IT技能上我学院网https://www.360docs.net/doc/2c13636859.html, 设计师必备的五种数据分析UI设计 数据分析在UI设计中运用非常多,且在大数据的前景下,数据分析的地位也非常高,UI设计中过多运用视觉设计技巧,往往忽视了用户体验,很大程度上只是在欣赏数据分析的视觉冲击,但却不懂分析的内容,这是致命的,也不是数据分析设计的初衷,那么如何做到让数据分析设计更易看懂,更加人性化,不仅能够做到美观,而且还能够很轻易的表达出意义来呢,我们来探讨这个问题。 本文会教你如何设计出极具美感的数据分析界面,且达到数据分析的效果,加强交互设计,让用户轻易获取数据信息。 一、数据可视化分析 1、原始数据分析 有时客户并不完全了解自己的数据,人员更替,平台迁移,数据遗失,没有专门的负责人去进行数据的管理和维护,都会造成数据的资源浪费。虽然随着时间过去,越早的数据价值越小,但是有人(我)说过,不能坦然面对过去的人,也无法面对将来。所以,先从整理过去开始吧。

学IT技能上我学院网https://www.360docs.net/doc/2c13636859.html, 2、营销数据分析 营销数据的重要性就不用赘述,既要多纬度多,又要分析深刻结论明了。最好又美观又能方便导出,还可以通过邮箱分享或者嵌入网页。

学IT技能上我学院网https://www.360docs.net/doc/2c13636859.html, 3、业务场景数据分析 能把已有业务场景数据可视化是比较个性化的需求了,但是一旦实现出来,某种程度来说还是能增加工作效率。

学IT技能上我学院网https://www.360docs.net/doc/2c13636859.html, 4、地理位置数据分析 一般的LBS场景是,将业务数据放置于地图中,用户可以获取可视化的数据分析,并能自行上传位置数据。但是现在也有结合物联网需求的可视化地理位置分析,是不是更有实感?看见我的快递努力的在朝我的方向移动,突然有点感动是怎么回事。 5、用户画像 当我真的被准确的定位成女屌丝的那一刻,我发现,我不太喜欢这个功能。所以并不面向用户本身的话,可能还不错。让商家去具象的了解用户的信息,做出判断和营销。

数据分析与挖掘实验报告

数据分析与挖掘实验报告

《数据挖掘》实验报告 目录 1.关联规则的基本概念和方法 (1) 1.1数据挖掘 (1) 1.1.1数据挖掘的概念 (1) 1.1.2数据挖掘的方法与技术 (2) 1.2关联规则 (5) 1.2.1关联规则的概念 (5) 1.2.2关联规则的实现——Apriori算法 (7) 2.用Matlab实现关联规则 (12) 2.1Matlab概述 (12) 2.2基于Matlab的Apriori算法 (13) 3.用java实现关联规则 (19) 3.1java界面描述 (19) 3.2java关键代码描述 (23) 4、实验总结 (29) 4.1实验的不足和改进 (29) 4.2实验心得 (30)

1.关联规则的基本概念和方法 1.1数据挖掘 1.1.1数据挖掘的概念 计算机技术和通信技术的迅猛发展将人类社会带入到了信息时代。在最近十几年里,数据库中存储的数据急剧增大。数据挖掘就是信息技术自然进化的结果。数据挖掘可以从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的,人们事先不知道的但又是潜在有用的信息和知识的过程。 许多人将数据挖掘视为另一个流行词汇数据中的知识发现(KDD)的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤。知识发现过程如下: ·数据清理(消除噪声和删除不一致的数据)·数据集成(多种数据源可以组合在一起)·数据转换(从数据库中提取和分析任务相关的数据) ·数据变换(从汇总或聚集操作,把数据变换和统一成适合挖掘的形式) ·数据挖掘(基本步骤,使用智能方法提取数

据模式) ·模式评估(根据某种兴趣度度量,识别代表知识的真正有趣的模式) ·知识表示(使用可视化和知识表示技术,向用户提供挖掘的知识)。 1.1.2数据挖掘的方法与技术 数据挖掘吸纳了诸如数据库和数据仓库技术、统计学、机器学习、高性能计算、模式识别、神经网络、数据可视化、信息检索、图像和信号处理以及空间数据分析技术的集成等许多应用领域的大量技术。数据挖掘主要包括以下方法。神经网络方法:神经网络由于本身良好的鲁棒性、自组织自适应性、并行处理、分布存储和高度容错等特性非常适合解决数据挖掘的问题,因此近年来越来越受到人们的关注。典型的神经网络模型主要分3大类:以感知机、bp反向传播模型、函数型网络为代表的,用于分类、预测和模式识别的前馈式神经网络模型;以hopfield 的离散模型和连续模型为代表的,分别用于联想记忆和优化计算的反馈式神经网络模型;以art 模型、koholon模型为代表的,用于聚类的自组

iris数据集的贝叶斯分类

IRIS 数据集的Bayes 分类实验 一、 实验原理 1) 概述 模式识别中的分类问题是根据对象特征的观察值将对象分到某个类别中去。统计决策理论是处理模式分类问题的基本理论之一,它对模式分析和分类器的设计有着实际的指导意义。 贝叶斯(Bayes )决策理论方法是统计模式识别的一个基本方法,用这个方法进行分类时需要具备以下条件: 各类别总体的分布情况是已知的。 要决策分类的类别数是一定的。 其基本思想是:以Bayes 公式为基础,利用测量到的对象特征配合必要的先验信息,求出各种可能决策情况(分类情况)的后验概率,选取后验概率最大的,或者决策风险最小的决策方式(分类方式)作为决策(分类)的结果。也就是说选取最有可能使得对象具有现在所测得特性的那种假设,作为判别的结果。 常用的Bayes 判别决策准则有最大后验概率准则(MAP ),极大似然比准则(ML ),最小风险Bayes 准则,Neyman-Pearson 准则(N-P )等。 2) 分类器的设计 对于一个一般的c 类分类问题,其分类空间: {}c w w w ,,,21 =Ω 表特性的向量为: ()T d x x x x ,,,21 = 其判别函数有以下几种等价形式: a) ()()i j i w w i j c j w w x w P x w P ∈→≠=∈→>,且,,,2,11 , b) ()()() ()i j j i w w i j c j w P w x p w P w x p ∈→≠=>,且,,,2,1i c) ()() () ()()i i j j i w w i j c j w P w P w x p w x p x l ∈→≠=>=,且,,,2,1 d) ()()() ()i j j i i w w i j c j w P w x np w P w x p ∈→≠=+>+,且,,,2,1ln ln ln 3) IRIS 数据分类实验的设计

数据挖掘及其应用

《数据挖掘论文》 数据挖掘分类方法及其应用 课程名称:数据挖掘概念与技术 姓名 学号: 指导教师: 数据挖掘分类方法及其应用 作者:来煜 摘要:社会的发展进入了网络信息时代,各种形式的数据海量产生,在这些数据的背后隐藏这许多重要的信息,如何从这些数据中找出某种规律,发现有用信息,越来越受到关注。为了适应信息处理新需求和社会发展各方面的迫切需要而发展起来一种新的信息分析技术,这种局势称为数据挖掘。分类技术是数据挖掘中应用领域极其广泛的重要技术之一。各种分类算法有其自身的优劣,适合于不同的领域。目前随着新技术和新领域的不断出现,对分类方法提出了新的要求。 。 关键字:数据挖掘;分类方法;数据分析 引言 数据是知识的源泉。但是,拥有大量的数据与拥有许多有用的知识完全是两回事。过去几年中,从数据库中发现知识这一领域发展的很快。广阔的市场和研究利益促使这一领域的飞速发展。计算机技术和数据收集技术的进步使人们可以从更加广泛的范围和几年前不可想象的速度收集和存储信息。收集数据是为了得到信息,然而大量的数据本身并不意味信息。尽管现代的数据库技术使我们很容易存储大量的数据流,但现在还没有一种成熟的技术帮助我们分析、理解并使数据以可理解的信息表示出来。在过去,我们常用的知识获取方法是由知识工程师把专家经验知识经过分析、筛选、比较、综合、再提取出知识和规则。然而,由于知识工程师所拥有知识的有局限性,所以对于获得知识的可信度就应该打个折扣。目前,传统的知识获取技术面对巨型数据仓库无能为力,数据挖掘技术就应运而生。 数据的迅速增加与数据分析方法的滞后之间的矛盾越来越突出,人们希望在对已有的大量数据分析的基础上进行科学研究、商业决策或者企业管理,但是目前所拥有的数据分析工具很难对数据进行深层次的处理,使得人们只能望“数”兴叹。数据挖掘正是