Hadoop云计算平台搭建最详细过程(共22页)

Hadoop云计算平台及相关组件搭建安装过程详细教程

——Hbase+Pig+Hive+Zookeeper+Ganglia+Chukwa+Eclipse等

一.安装环境简介

根据官网,Hadoop已在linux主机组成的集群系统上得到验证,而windows平台是作为开发平台支持的,由于分布式操作尚未在windows平台上充分测试,所以还不作为一个生产平台。Windows下还需要安装Cygwin,Cygwin是在windows平台上运行的UNIX模拟环境,提供上述软件之外的shell支持。

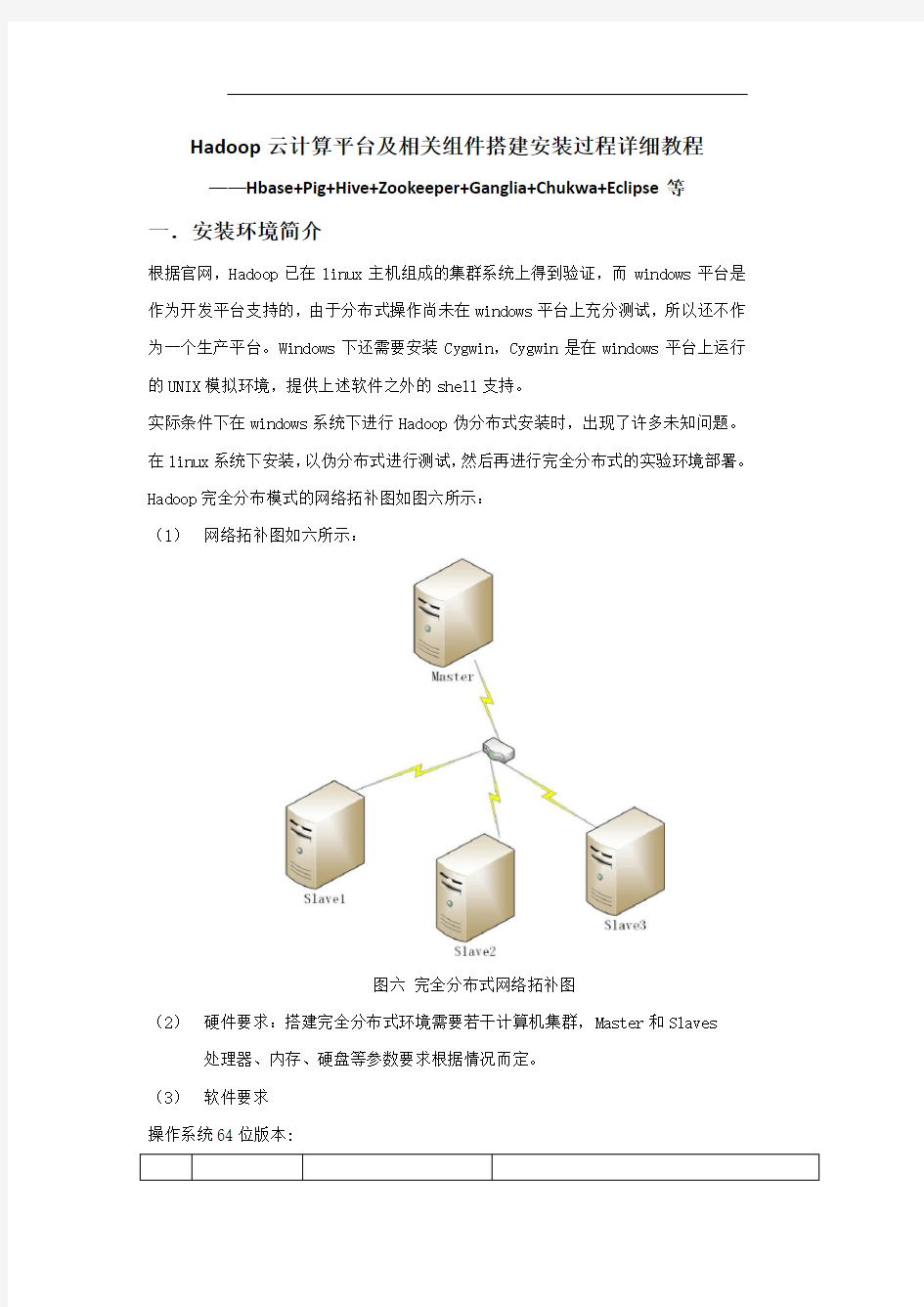

实际条件下在windows系统下进行Hadoop伪分布式安装时,出现了许多未知问题。在linux系统下安装,以伪分布式进行测试,然后再进行完全分布式的实验环境部署。Hadoop完全分布模式的网络拓补图如图六所示:

(1)网络拓补图如六所示:

图六完全分布式网络拓补图

(2)硬件要求:搭建完全分布式环境需要若干计算机集群,Master和Slaves 处理器、内存、硬盘等参数要求根据情况而定。

(3)软件要求

操作系统64位版本:

并且所有机器均需配置SSH免密码登录。

二. Hadoop集群安装部署

目前,这里只搭建了一个由三台机器组成的小集群,在一个hadoop集群中有以下角色:Master和Slave、JobTracker和TaskTracker、NameNode和DataNode。下面为这三台机器分配IP地址以及相应的角色:

——master,namenode,jobtracker——master(主机名)

——slave,datanode,tasktracker——slave1(主机名)

——slave,datanode,tasktracker——slave2(主机名)

实验环境搭建平台如图七所示:

图七 hadoop集群实验平台

并且,Hadoop要求集群上每台的用户账户名和密码相同。具体安装步骤如下:(1)下载和安装JDK,版本为的安装目录为/usr/lib/jvm,创建此文件夹,在终端输入命令:

mkdir /usr/lib/jvm

(2)权限不够的话重新改下用户密码就可以了,命令: sudo passwd,之后重新输入密码。

(3)移动jdk到/usr/lib/jvm,并解压,然后为了节省空间删除安装包。命令: mv /usr/lib/jvm

1.tar –zxvf –rf 配置环境变量

在终端输入命令:sudo gedit /etc/profile

打开profile文件,在文件最下面输入如下内容,如图八所示:

图八 JAVA环境变量设置

即为:

# set java environment

export JAVA_HOME=/usr/lib/jvm/

CLASSPATH=”.:$JAVA_HOME/lib:$CLASSPATH”

export PATH=”$JAVA_HOME/:$PATH”

这一步的意义是配置环境变量,使系统可以找到jdk。

2.验证JDK是否安装成功

(1)输入命令:java –version,如图九所示。如果出现java版本信息,说明当前安装的jdk并未设置成ubuntu系统默认的jdk,接下来还需要手

动将安装的jdk设置成系统默认的jdk。

图九 java版本信息

(2)手动设置需输入以下命令:

sudo update-alternatives –install /usr/bin/java java /usr/lib/jvm/ 300

sudo update-alternatives –install /usr/bin/javac javac /usr/lib/jvm/ 300

sudo update-alternatives –config java

然后输入java –version就可以看到所安装的jdk的版本信息。

3.三台主机上分别设置/etc/hosts和/etc/hostname

Hosts这个文件用于定义主机名和IP地址之间的对应关系,而hostname这个文件用于定义你的Ubuntu的主机名。

(1)修改/etc/hosts,命令sudo gedit /etc/hosts

localhost

master

slave1

slave2

(2)修改/etc/hostname,命令 sudo gedit /etc/hostname(修改完重启有效) master

以及slave1 ,slave2

4.在这两台主机上安装OpenSSH,并配置SSH可以免密码登录

(1)确认已经连接上网,输入命令:

sudo apt-get install ssh

(2)配置为可以免密码登录本机,接下来输入命令:

ssh-keygen –t dsa –P ‘’ –f ~/.ssh/id_dsa

解释一下,ssh-keygen 代表生成密匙,-t表示指定生成的密匙类型,dsa

是密匙认证的意思,即密匙类型,-P用于提供密语,-f指定生成的密匙

文件。这个命令会在.ssh文件夹下创建id_dsa以及两个文件,这是ssh

一对私匙和公匙,把追加到授权的key中。输入命令:

cat ~/.ssh/ >> ~/.ssh/authorized_keys

(3)验证ssh是否已经安装成功,输入命令:ssh –version。

将文件复制到slave主机相同的文件夹内,输入命令:

scp authorized_keys slave1:~/.ssh/

scp authorized_keys slave2:~/.ssh/

(4)看是否可以从master主机免密码登录slave,输入命令:

ssh slave1

ssh slave2

5.配置两台主机的Hadoop文件

首先到Hadoop的官网下载包,默认讲Hadoop解压到 /home/u(你的Ubuntu用户名)/ 目录下

(1)进入hadoop内的conf文件夹,找到,修改:

export JAVA_HOME=/usr/lib/jvm/,指定JDK的安装位置,如图十所示:

图十 JAVA_HOME 路径设置

(2)修改,这是Hadoop的核心配置文件,这里配置的是HDFS的地址及端号:

(3)修改

(4)修改

(5)修改conf/masters

master

(6)修改conf/slaves

slave1

slave2

6.启动hadoop

在启动之前,需要格式化hadoop的文件系统HDFS,进入hadoop文件夹,输入命令格式化:bin/hadoop namenode –format,如图十一所示: