基于贝叶斯网络的各种抽样方法比较

摘要: 本文主要介绍了贝叶斯网的基本概念以及重要性抽样方法的基本理论和概率推理, 重点介绍了两种重要的抽样方法, 即逻辑抽样方法和似然加权法, 并且比较了它们的优缺点

关键词: 贝叶斯网 抽样法 无偏估计

1.引言

英国学者T.贝叶斯1763年在《论有关机遇问题的求解》中提出一种归纳推理的理论, 后被一些统计学者发展为一种系统的统计推断方法, 称为贝叶斯方法.采用这种方法作统计推断所得的全部结果, 构成贝叶斯统计的内容.认为贝叶斯方法是唯一合理的统计推断方法的统计学者, 组成数理统计学中的贝叶斯学派, 其形成可追溯到 20世纪 30 年代.到50~60年代, 已发展为一个有影响的学派.Zhang 和Poole 首先提出了变量消元法, 其原理自关于不定序动态规划的研究(Bertele and Brioschi,1972).相近的工作包括D`Ambrosio (1991)、Shachter (1994)、Shenoy (1992)等人的研究.近期关于变量消元法的研究可参见有关文献【1】由于变量消元法不考虑步骤共享, 故引进了团树传播法, 如Hugin 方法.在实际应用中, 网络节点往往是众多的, 精确推理算法是不适用的, 因而近似推理有了进一步的发展. 重要性抽样法(Rubinstein, 1981)是蒙特尔洛积分中降低方差的一种手段, Henrion (1988)提出了逻辑抽样, 它是最简单也是最先被用于贝叶斯网近似推理的重要性抽样算法. Fung 和Chang (1989)、Shachter 和Peot (1989)同时提出了似然加权算法. Shachter 和Peot (1989)还提出了自重要性抽样和启发式重要性抽样算法. Fung 和Favero (1994)提出了逆序抽样(backward sam-pling ), 它也是重要性抽样的一个特例. Cheng 和Druzdzel (2000)提出了自适应重要性抽样算法, 同时也给出了重要性抽样算法的通用框架, 这就是各种抽样方法的发展状况. 本文就近似推理阐述了两种重要的抽样方法即逻辑抽样方法和似然加权法, 并比较了它们的优缺点.

2. 基本概念

2.1 贝叶斯网络的基本概念

贝叶斯网络是一种概率网络, 用来表示变量之间的依赖关系, 是带有概率分布标注的有向无环图, 能够图形化地表示一组变量间的联合概率分布函数.

贝叶斯网络模型结构由随机变量(可以是离散或连续)集组成的网络节点, 具有因果关系的网络节点对的有向边集合和用条件概率分布表示节点之间的影响等组成.其中节点表示了随机变量, 是对过程、事件、状态等实体的某些特征的描述; 边则表示变量间的概率依赖关系.起因的假设和结果的数据均用节点表示, 各变量之间的因果关系由节点之间的有向边表示, 一个变量影响到另一个变量的程度用数字编码形式描述.因此贝叶斯网络可以将现实世界的各种状态或变量画成各种比例, 进行建模.

2.2重要性抽样法基本理论

设()f X 是一组变量X 在其定义域n X R Ω?上的可积函数.考虑积分

()()X I f X d X Ω=

? (2.2.1)

为了近似计算这一积分, 重要性抽样方法将上式改写为如下形式:

()()()()

X f X I P X d X P X Ω=

? (2.2.2) 这里, X 被看成是一组随机变量, ()P X 是X 的一个联合分布, 称为重要性分布, 它满足以下条件: 对X 的任意取值x , 如果()0f X x =≠, 那么()0P X x =≠.

接下来, 重要性抽样方法()P X 从独立地抽取m 个样本12,,...,,m D D D 并基于这些样本来对积分I 进行估计:

1()1.()

m i m i i f D I m P D ==∑ (2.2.3) 可以证明, m I 是I 的一个无偏估计, 且根据强大数定律, 当样本量m 趋于无穷时, m I 几乎收敛于I .

重要性抽样法的性能主要从两个方面来衡量: 一个是算法复杂度, 另一个是近似解的精度.因此, 人们用计算m I 所需的时间t 和m I 的方差var()m I 之积var()m t I *来度量重要性抽样法的效率:var()m t I *越小, 算法的效率越高, 收敛速度也就越快, 从而获得高精度近似所需的样本量不大.这里, 方差可用下式计算:

221()var()()()X m f X I d X I m P X Ω??=-??????

? (2.2.4) 重要性分布的选择是提高算法效率的关键.由于重要性分布的选择对时间复杂度的影响不大, 因此为了提高算法的效率, 应该选用使得方差var()m I 尽可能小的重要性分布.根据式(2.2.4),若被积函数()0f x >, 则最优重要性分布为*()()/P X f X I =.此时v a r ()0m I =, 样本被集中在()f X 值较大的"重要"区域.由于I 本身是未知的, 在实

际中很少能够从*()P X 抽样, 只能寻找与*()P X 尽量接近的分布.重要性分布与最优分

布*()P X 越接近, 方差var()m I 就越小.

2.3重要性抽样法的概率推理

考虑一个贝叶斯网μ, 用X 记其中所有变量的集合,()P X 记μ所表示的联合概率分布.设观测到证据E e =.下面将讨论如何近似计算一组查询变量Q 取某值q 的后验概率(|)P Q q E e ==.

设W 是一些变量的集合, Y 是的W 一个子集合, \Z W Y =, 并设y 为Y 的一个取值.定义函数

1,()(,)0,Y y Y y Y y W Y Z χχ===?==?≠?

若若Y y (2.3.1) 按条件概率的定义, 有

(,)(|)()

P Q q E e P Q q E e P E e ======. (2.3.2) 根据式(2.3.1)(,)P Q q E e ==和()P E e =可以分别表示成如下形式:

(,)()()(),Q q E e X

P Q q E e X X P X χχ=====∑ (2.3.3)

()()()E e X

P E e X P X χ===∑. (2.3.4)

于是可以利用重要性抽样法来对它们进行近似.

对于近似的一般性质, 有一点需要注意.根据以上讨论, 利用重要性抽样法获得的对(,)P Q q E e ==和()P E e =的估计是无偏的.

3. 重要性抽样方法

3.1逻辑抽样法

要用重要性抽样法解决式(2.3.3)和式(2.3.4)的问题, 首先需要选择一个重要性分布.一个很自然的想法就是选用联合分布()P X 本身来作为重要性分布, 其中{}12,,...,n X X X X =, 这样就得到了逻辑抽样.

逻辑抽样法首先从()P X 分布中抽取样本.注意到()P X 分解为

()(|()),X X

X X P X P π∈=∏

其中()X π表示那些在拓扑序排列中那些在节点X 之前的节点12,,...,i X X X 的一个集合.因此可以按照贝叶斯网μ的拓扑序对其中的变量逐个进行抽样: 对待抽样变量i X ,若它是根节点, 则按分布()i P X 进行抽样; 若是非根节点, 则按分布是(|())i i P X X r π=进行抽样, 这里()i X r π=是父节点的抽样结果, 在对i X 抽样时是已知的, 为顺序抽样, 此过程需要从一些单变量概率分布随即抽样.

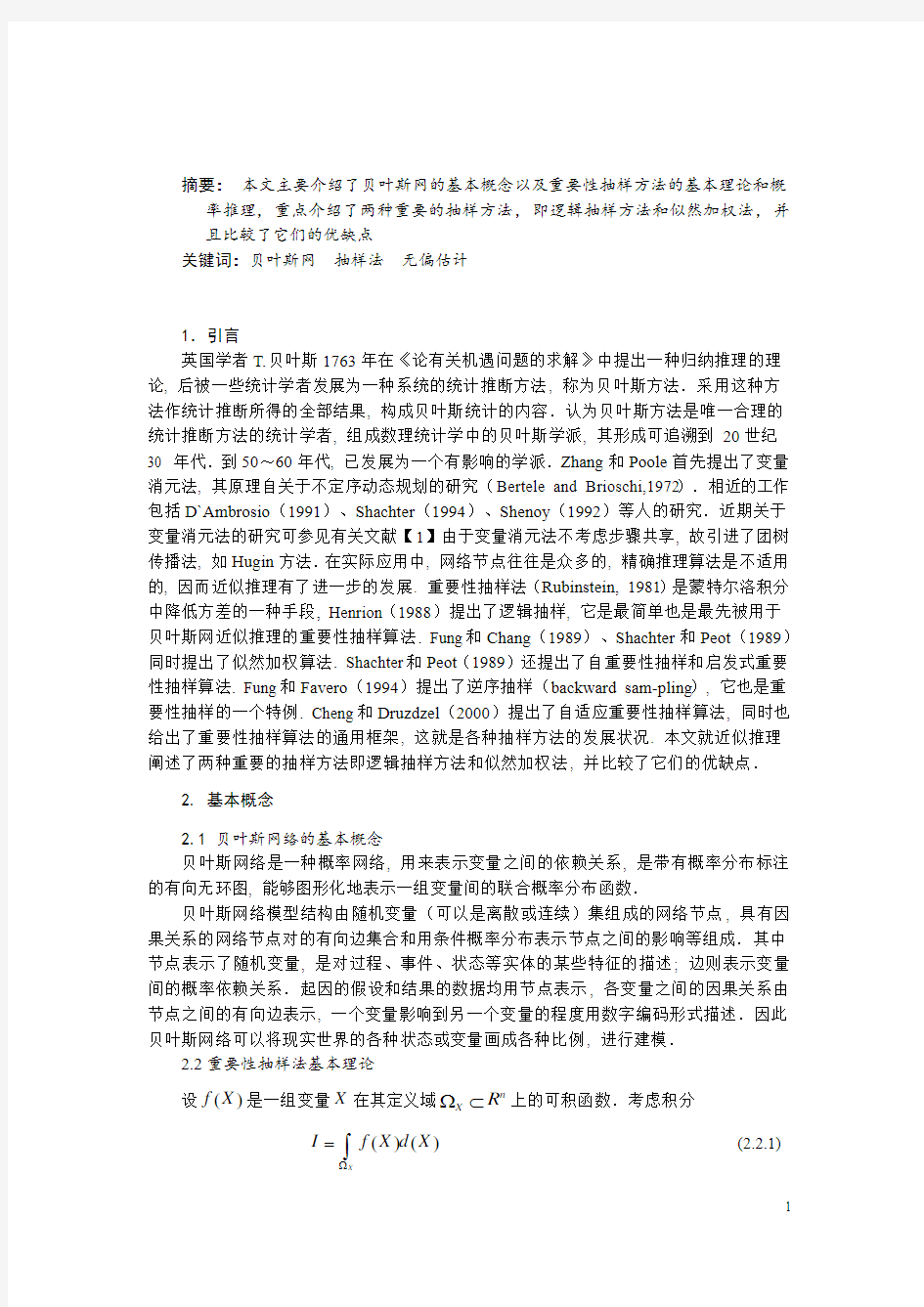

(图1)

对图1所示的贝叶斯网, 用逻辑抽样法计算(|E )P Q q e ==, 逻辑抽样法生成一个样本的过程如下:

假设对()P X 顺序抽样过程获得了m 个独立样本12,D D …m D , 其中满足E e =的有e m 个, 而在这e m 个样本中, 进一步满足Q q =的有,q e m 个.根据式(2.2.3)和式(2.3.3) , 有

1()()()1(,)()

m Q q i E e i i i i D D P D P Q q E e m P D χχ=====≈∑

1

1()()m

Q q i E e i i D D m χχ====∑ ,.q e

m m =

类似地, 根据式(2.2.3)和(2.3.4)可得

1

1()()m

E e i i P E e D m χ===≈∑ =

e m m

. 将上面两式代入式(2.3.2), 可得 ,(|)q e

e m P Q q E e m ==≈, (4.1.1)

这就是通过逻辑抽样法获得的对后验概率的近似, 它是在所有满足E e =的样本中, 进一步满足Q q =的样本比例.

逻辑抽样法所产生与证据E e =不一致的那些样本相当于被舍弃.因此, 逻辑抽样有时也称为舍选抽样.

3.2似然加权法

似然加权法是重要性抽样的一个特例, 提出它的一个主要目的是避免逻辑抽样因舍弃样本而造成浪费.

在抽样过程中, 它按拓扑序对每个变量进i X 行抽样: 当i X 不是证据变量时, 抽样方法与逻辑方法一致; 而当是i X 证据变量时, 则以的i X 观测值作为抽样结果.这样保证了每一个样本都与证据E e =一致, 从而可以利用, 不必舍弃.

对图1所示的贝叶斯网, 用似然加权法计算(|)P R t S t ==, 似然加权法生成一个样本的过程如下:

(1)对根节点C , 从()P C 抽样, 假设得到C t =;

(2)对节点S , 因为S E ∈是证据变量, 所以抽样结果被视为它的观测值t ;

(3)对节点R , 抽样分布为(|)P R C t =, 假设得到R t =;

(4)最后对叶节点W 抽样, 抽样分布为(|,)P W R t S t ==,假设得到W t =.最后产生的样本为D ={,,,C t R t S t W t ====}.

设12,D D ,…m D 是通过上述过程抽得的m 个样本.下面讨论怎样基于它们对(,)P Q q E e ==和()P E e =进行近似.

设Y 是X 的一个子集.对任一Y 的函数()h Y , 用()|i D h Y 表示当变量Y 取i D 中的值时, 这个函数的函数值.对任一X X ∈, (|())X X P π是X 中一些变量的函数.于是, (|())|i D X X P π是当变量取i D 中的值时, 这个函数的函数值.

用Z 记所有非证据变量的集合, 即\Z X E =,设'()P X 是似然加权法所使用的重要

性分布.不难看出, '()()E e P E E χ==, 而

'(|)(|)(|())X X

X X P Z E P Z E P π∈==∏

于是有

''()(,)P X P Z E =

''()(|)P E P Z E =

()

(|())X E e X X X E P χπ=∈=∏ 注意()(,)()E e E e E e X E Z E χχχ=====.于是有

'()()(|())X

E e X X X P X X P χπ=∈=∏ 对每个i =1,2, …, m , 样本i D 与证据E e =一致, 因此对一函数()h X , 有()()()|i

E e i i D D h D h X χ==.所以, . '(X)=

(|())|X i D Z X X P P π∈∏ ()()(|())|X i

E e i i D Z X X D P D P χπ=∈=∏.

根据式(2.2.3)和式(2.3.3), 可得

'1()()()1(,)()

m Q q i E e i i i i D D P D P Q q E e m P D χχ=====≈∑ 1(|())|1()(|())|X

X i i D m

X Q q i i D Z

X X X X P D m P πχπ∈==∈=∏∑∏ 11()(|())|X

i m

Q q i D i E X X D P m χπ==∈=∑∏ 1

1()(),m

Q q i i i D w D m χ===∑ (4.1.2) 其中()(|())|

X i i D E X X w D P π∈=∏. 类似地, 根据式(2.2.3)和式(2.3.4), 可得

'1()()1()()

m E e i i i i D P D P E e m P D χ===≈∑ =1

1()m

i i w D m =∑. (4.1.3) 将式(4.1.2)和式(4.1.3)代入式(2.3.2), 得

11

()()(|)()

m Q q

i i i m i i D w D P Q q E e w D χ=====≈∑∑. (4.1.4)

4. 两种抽样方法的优缺点

逻辑抽样的优点是简单易行, 缺点是当概率()P E e =很小时, 算法效率低, 收敛速度慢.事实上, 问题的最优重要性分布是()()

()E e X P X P E e χ==, 而抽样使用的是分布()P X ,

两者差别显著: 前者的概率质量集中在X 的与E e =一致的那些取值处, 而后者在这些区域的概率值却很小, 随着()P E e =的减小, 所抽得的与E e =一致的样本个数将会减少, 因此大量样本被舍弃, 造成了计算资源的浪费.

与逻辑抽样相比, 似然加权法相当于为每个样本i D 都赋予一个权重()i w D .设i z 为i D 中Z 的取值, 则i D 可以写成i D (,)i Z z E e ===.当所有证据变量都是叶节点时, 权重是()i w D , 即给定E e =时i Z z =的似然度.似然加权法的优点是每个样本都被利用, 效率比逻辑抽样有很大提高. 当所有证据变量都位于网络顶端时, 重要性分布'()P X 正好就是最优分布, 似然加权的效率达到最优.在其它情况下, 重要性分布与最优分布可能差别显著, 尤其是当概率()P E e =很小时.这时, 算法的收敛会很慢, 即要获得高精度的近似所需的样本量会增加.

参考文献

[1] Becker A,Geiger D.2001.A sufficiently fast algorithm for finding close to optimal clique trees.Artificial Intelligence,125(1-2):3~17

[2] Bertele U,Brioschi F.Nonserial dynamic programming.New York:Academic Press

[3] D`Ambrosio B.1991.Local expression languages for probabilistic dependence:a preliminary report. In UAI`91:Proceedings of the Seventh Conference on Uncertainty in Artificial Intelligence .San Francisco:Morgan Kaufmann Publishers.95~102

[4] Shachter R D 1994.Symbolic probabilistic inference in belief networks. In Proceedings of the Eighth National Conference on Artificial Intelligence.126~131

[5] Zhang N L,PooleD.1994.A simple approach to Bayesian network computations.In Proc.of the Tenth Canadian Conference on Artificial Intelligence.171~178

[6]李奔波.多品种小批量生产工序能力和控制图研究[D].重庆: 重庆大学数学系研究所.2006.4: 1~7.

[7] 王洪琦, 许有玲.1999.面向21世纪—中医基础理论研究状和未来[M].北京: 军事医学科学出版社.

[8]秦静等.质量管理学[M].北京: 科学出版社, 2007.

[9]徐岚等.SPC在多品种小批量生产线的应用研究[J].微电子学, 2007,37(5):

682 684

[10]袁普及.基于成组技术的质量控制的研究[D].南京:南京航空航天大学,2003.5.

[11]韩玉启, 朱慧明.多元质量特性的贝叶斯均值向量控制图[J].南京理工大学学报,2003,27(5):561 566

[12]王建稳.多品种小批量生产情形下的工序质量控制图[J].数理统计与管理, 2002, 21(4):34 37

[13]王学明.应用多元分析[M].上海: 上海财经大学出版社,1999

[14]胡兴才.基于小批量的统计过程控制研究与系统开发[D].南京: 南京航空航天大学,2006.2.

[15]朱慧明、韩玉启.贝叶斯多元统计推断理论[M].北京: 科学出版社,2006

matlab神经网络工具箱简介

MATLAB软件中包含MATLAB神经网络工具箱,工具箱以人工神经网络为基础,只要根据自己需要调用相关函数,就可以完成网络设计、权值初始化、网络训练等,MATLAB神经网络工具箱包括的网络有感知器、线性网络、BP神经网络、径向基网络、自组织网络和回归网络,BP神经网络工具箱主要包括newff,sim和train三个神经网络函数各函数的解释如下:1 newff::::BP神经网络参数设置函数神经网络参数设置函数神经网络参数设置函数神经网络参数设置函数 函数功能:构建一个BP神经网络。 函数形式:net = newff(P,T,S,TF,BTF,BLF,PF,IPF,OPF,DDF) P:输入数据矩阵 T:输出数据矩阵 S:隐含层节点数 TF:节点传递函数,包括硬限幅传递函数hardlim,对称硬限幅传递函数hardlims,线性传递函数purelin,正切S型传递函数tansig,对数S型传递函数logsig BTF:训练函数,包括梯度下降BP算法训练函数traingd,动量反传的梯度下降BP算法训练函数traingdm,动态自适应学习率的梯度下降BP算法训练函数traingda,动量反传和动态自适应学习率的梯度下降BP算法训练函数traingdx,Levenberg_Marquardt 的BP算法训练函数trainlm BLF:网络学习函数,包括BP学习规则learngd,带动量项的BP学习规则learngdm PF:性能分析函数,包括均值绝对误差性能分析函数mae,均方差性能分析函数mse IPF:输入处理函数 OPF:输出处理函数 DDF:验证数据划分函数 一般在使用过程中设置前六个参数,后四个参数采用系统默认参数。 2 train::::BP神经网络训练函数神经网络训练函数神经网络训练函数神经网络训练函数函数功能:用训练数据训练BP神经网络。 函数形式:[net,tr] = train(NET,X,T,Pi,Ai) NET:待训练网络 X:输入数据矩阵 T:输出数据矩阵 Pi:初始化输入层条件 Ai:初始化输出层条件 net:训练好的网络 tr:训练过程记录 一般在使用过程中设置前三个参数,后两个参数采用系统默认参数。 3 sim::::BP神经网络预测函数神经网络预测函数神经网络预测函数神经网络预测函数 函数功能:用训练好的BP神经网络预测函数输出 函数形式:y=sim(net,x) net:训练好的网络 x:输入数据 y:网络预测数据 只要我们能够熟练掌握上述三个函数,就可以完整的编写一个BP神经网络预测或者分类的程序。

如何使用贝叶斯网络工具箱

如何使用贝叶斯网络工具箱 2004-1-7版 翻译:By 斑斑(QQ:23920620) 联系方式:banban23920620@https://www.360docs.net/doc/4115735667.html, 安装 安装Matlab源码 安装C源码 有用的Matlab提示 创建你的第一个贝叶斯网络 手工创建一个模型 从一个文件加载一个模型 使用GUI创建一个模型 推断 处理边缘分布 处理联合分布 虚拟证据 最或然率解释 条件概率分布 列表(多项式)节点 Noisy-or节点 其它(噪音)确定性节点 Softmax(多项式 分对数)节点 神经网络节点 根节点 高斯节点 广义线性模型节点 分类 / 回归树节点 其它连续分布 CPD类型摘要 模型举例 高斯混合模型 PCA、ICA等 专家系统的混合 专家系统的分等级混合 QMR 条件高斯模型 其它混合模型

参数学习 从一个文件里加载数据 从完整的数据中进行最大似然参数估计 先验参数 从完整的数据中(连续)更新贝叶斯参数 数据缺失情况下的最大似然参数估计(EM算法) 参数类型 结构学习 穷举搜索 K2算法 爬山算法 MCMC 主动学习 结构上的EM算法 肉眼观察学习好的图形结构 基于约束的方法 推断函数 联合树 消元法 全局推断方法 快速打分 置信传播 采样(蒙特卡洛法) 推断函数摘要 影响图 / 制定决策 DBNs、HMMs、Kalman滤波器等等

安装 安装Matlab代码 1.下载FullBNT.zip文件。 2.解压文件。 3.编辑"FullBNT/BNT/add_BNT_to_path.m"让它包含正确的工作路径。 4.BNT_HOME = 'FullBNT的工作路径'; 5.打开Matlab。 6.运行BNT需要Matlab版本在V5.2以上。 7.转到BNT的文件夹例如在windows下,键入 8.>> cd C:\kpmurphy\matlab\FullBNT\BNT 9.键入"add_BNT_to_path",执行这个命令。添加路径。添加所有的文件夹在Matlab的路 径下。 10.键入"test_BNT",看看运行是否正常,这时可能产生一些数字和一些警告信息。(你可 以忽视它)但是没有错误信息。 11.仍有问题?你是否编辑了文件?仔细检查上面的步骤。

贝叶斯网络研究现状与发展趋势的文献计量分析

Computer Science and Application 计算机科学与应用, 2020, 10(3), 493-504 Published Online March 2020 in Hans. https://www.360docs.net/doc/4115735667.html,/journal/csa https://https://www.360docs.net/doc/4115735667.html,/10.12677/csa.2020.103052 The Bibliometric Analysis of Current Studies and Developing Trends on Bayesian Network Research Zhongzheng Xiao1, Nurbol2, Hongyang Liu3 1College of Information Science and Engineering, Xinjiang University, Urumqi Xinjiang 2Network Center, Xinjiang University, Urumqi Xinjiang 3Xichang Satellite Launch Center, Xichang Sichuan Received: Feb. 26th, 2020; accepted: Mar. 12th, 2020; published: Mar. 19th, 2020 Abstract In this paper, 2,930 literatures related to Bayesian network in the recent 10 years in the web of science were taken as the research object. Based on the literature metrological content analysis method, the focus, development rules of research context, existing commonalities and differences, and research status at home and abroad were systematically reviewed. The study found that, as of now, especially in the prevalence of neural networks, Bayesian networks can be deepened and have great potential because of their strong mathematical interpretability. The analysis results are helpful to provide reference for the research status and progress of scholars in the field of Bayesian network research in China. Keywords Bayesian Network, Map Analysis, Citespace, Research Context 贝叶斯网络研究现状与发展趋势的文献计量 分析 肖中正1,努尔布力2,刘宏阳3 1新疆大学信息科学与工程学院,新疆乌鲁木齐 2新疆大学网络中心,新疆乌鲁木齐 3西昌卫星发射中心,四川西昌 收稿日期:2020年2月26日;录用日期:2020年3月12日;发布日期:2020年3月19日

朴素贝叶斯分类算法及其MapReduce实现

最近发现很多公司招聘数据挖掘的职位都提到贝叶斯分类,其实我不太清楚他们是要求理解贝叶斯分类算法,还是要求只需要通过工具(SPSS,SAS,Mahout)使用贝叶斯分类算法进行分类。 反正不管是需求什么都最好是了解其原理,才能知其然,还知其所以然。我尽量简单的描述贝叶斯定义和分类算法,复杂而有全面的描述参考“数据挖掘:概念与技术”。贝叶斯是一个人,叫(Thomas Bayes),下面这哥们就是。 本文介绍了贝叶斯定理,朴素贝叶斯分类算法及其使用MapReduce实现。 贝叶斯定理 首先了解下贝叶斯定理 P X H P(H) P H X= 是不是有感觉都是符号看起来真复杂,我们根据下图理解贝叶斯定理。 这里D是所有顾客(全集),H是购买H商品的顾客,X是购买X商品的顾客。自然X∩H是即购买X又购买H的顾客。 P(X) 指先验概率,指所有顾客中购买X的概率。同理P(H)指的是所有顾客中购买H 的概率,见下式。

X P X= H P H= P(H|X) 指后验概率,在购买X商品的顾客,购买H的概率。同理P(X|H)指的是购买H商品的顾客购买X的概率,见下式。 X∩H P H|X= X∩H P X|H= 将这些公式带入上面贝叶斯定理自然就成立了。 朴素贝叶斯分类 分类算法有很多,基本上决策树,贝叶斯分类和神经网络是齐名的。朴素贝叶斯分类假定一个属性值对给定分类的影响独立于其他属性值。 描述: 这里有个例子假定我们有一个顾客X(age = middle,income=high,sex =man):?年龄(age)取值可以是:小(young),中(middle),大(old) ?收入(income)取值可以是:低(low),中(average),高(high) ?性别(sex)取值可以是:男(man),女(woman) 其选择电脑颜色的分类标号H:白色(white),蓝色(blue),粉色(pink) 问题: 用朴素贝叶斯分类法预测顾客X,选择哪个颜色的分类标号,也就是预测X属于具有最高后验概率的分类。 解答: Step 1 也就是说我们要分别计算X选择分类标号为白色(white),蓝色(blue),粉色(pink)的后验概率,然后进行比较取其中最大值。 根据贝叶斯定理

matlab工具箱的使用_Toolbox

神经网络工具箱的使用 本章主要介绍神经网络工具箱的使用,使用nntool可以使得原本用编程来创建神经网络变得容易,而且不容易出错。 1 神经网络的创建与训练 神经网络的创建主要分为以下四步: 1)在命令窗口键入nntool命令打开神经网络工具箱。如图1: 图 1 2)点击Import按钮两次,分别把输入向量和目标输出加入到对应的窗口([Inputs]和[Targets])中,有两种可供选择的加入对象(点击Import后可以看见),一种是把当前工作区中的某个矩阵加入,另一种是通过.mat文件读入。如图2和图3:

图 2 图 3 3)点击[New Network]按钮,填入各参数:(以最常用的带一个隐层的3层神经网络为例说明,下面没有列出的参数表示使用默认值就可以了,例如Network Type为默认的BP神经网络);

i)Input Range——这个通过点击Get From Input下拉框选择你加入的输入向量便可自动完成,当然也可以自己手动添加。 ii) Training Function——最好使用TRAINSCG,即共轭梯度法,其好处是当训练不收敛时,它会自动停止训练,而且耗时较其他算法(TRAINLM,TRAINGD)少,也就是收敛很快(如果收敛的话),而且Train Parameters输入不多,也不用太多的技巧调整,一般指定迭代次数、结果显示频率和目标误差就可以了(详见下文)。 iii) Layer 1 Number of Neurons——隐层的神经元个数,这是需要经验慢慢尝试并调整的,大致上由输入向量的维数、样本的数量和输出层(Layer2)的神经元个数决定。一般来说,神经元越多,输出的数值与目标值越接近,但所花费的训练时间也越长,反之,神经元越少,输出值与目标值相差越大,但训练时间会相应地减少,这是由于神经元越多其算法越复杂造成的,所以需要自己慢慢尝试,找到一个合适的中间点。比如输入是3行5000列的0-9的随机整数矩阵,在一开始选择1000个神经元,虽然精度比较高,但是花费的训练时间较长,而且这样神经网络的结构与算法都非常复杂,不容易在实际应用中实现,尝试改为100个,再调整为50个,如果发现在50个以下时精度较差,则可最后定为50个神经元,等等。 iv)Layer 1 Transfer Function——一般用TANSIG(当然也可以LOGSIG),即表示隐层输出是[-1,1]之间的实数,与LOGSIG相比范围更大。 v) Layer 2 Number of Neurons——输出层的神经元个数,需要与输出的矩阵行数对应,比如设置为3,等等。 vi) Layer 2 Transfer Function——如果是模式识别的两类(或者多类)问题,一般用LOGSIG,即表示输出层的输出是[0,1]之间的实数;如果输出超过[0,1]则可选择PURELIN。如图4和图5。

五种贝叶斯网分类器的分析与比较

五种贝叶斯网分类器的分析与比较 摘要:对五种典型的贝叶斯网分类器进行了分析与比较。在总结各种分类器的基础上,对它们进行了实验比较,讨论了各自的特点,提出了一种针对不同应用对象挑选贝叶斯网分类器的方法。 关键词:贝叶斯网;分类器;数据挖掘;机器学习 故障诊断、模式识别、预测、文本分类、文本过滤等许多工作均可看作是分类问题,即对一给定的对象(这一对象往往可由一组特征描述),识别其所属的类别。完成这种分类工作的系统,称之为分类器。如何从已分类的样本数据中学习构造出一个合适的分类器是机器学习、数据挖掘研究中的一个重要课题,研究得较多的分类器有基于决策树和基于人工神经元网络等方法。贝叶斯网(Bayesiannetworks,BNs)在AI应用中一直作为一种不确定知识表达和推理的工具,从九十年代开始也作为一种分类器得到研究。 本文先简单介绍了贝叶斯网的基本概念,然后对五种典型的贝叶斯网分类器进行了总结分析,并进行了实验比较,讨论了它们的特点,并提出了一种针对不同应用对象挑选贝叶斯分类器的方法。 1贝叶斯网和贝叶斯网分类器 贝叶斯网是一种表达了概率分布的有向无环图,在该图中的每一节点表示一随机变量,图中两节点间若存在着一条弧,则表示这两节点相对应的随机变量是概率相依的,两节点间若没有弧,则说明这两个随机变量是相对独立的。按照贝叶斯网的这种结构,显然网中的任一节点x均和非x的父节点的后裔节点的各节点相对独立。网中任一节点X均有一相应的条件概率表(ConditionalProbabilityTable,CPT),用以表示节点x在其父节点取各可能值时的条件概率。若节点x无父节点,则x的CPT为其先验概率分布。贝叶斯网的结构及各节点的CPT定义了网中各变量的概率分布。 贝叶斯网分类器即是用于分类工作的贝叶斯网。该网中应包含一表示分类的节点C,变量C的取值来自于类别集合{C,C,....,C}。另外还有一组节点x=(x,x,....,x)反映用于分类的特征,一个贝叶斯网分类器的结构可如图1所示。 对于这样的一贝叶斯网分类器,若某一待分类的样本D,其分类特征值为x=(x,x,....,x),则样本D属于类别C的概率为P(C=C|X=x),因而样本D属于类别C的条件是满足(1)式: P(C=C|X=x)=Max{P(C=C|X=x),P(C=C|X=x),...,P(C=C|X=x)}(1) 而由贝叶斯公式 P(C=C|X=x)=(2) 其中P(C=Ck)可由领域专家的经验得到,而P(X=x|C=Ck)和P(X=x)的计算则较困难。应用贝叶斯网分类器分成两阶段。一是贝叶斯网分类器的学习(训练),即从样本数据中构造分类器,包括结构(特征间的依赖关系)学习和CPT表的学习。二是贝叶斯网分类器的推理,即计算类结点的条件概率,对待分类数据进行分类。这两者的时间复杂性均取决于特征间的依赖程度,甚至可以是NP完全问题。因而在实际应用中,往往需

matlab贝叶斯神经网络工具箱的下载安装与使用

matlab贝叶斯神经网络工具箱的下载安装与使用 前言:其实通过Matlab神经网络工具的一些命令组合,可以轻易实现贝叶斯神经网络工具箱的功能,这里所讲的贝叶斯神经网络工具箱是有第三方开放,比较容易使用的贝叶斯神经网络工具箱。 备注(by math):另外一个工具箱PRtools(中文翻译:模式识别工具箱)也可以实现贝叶斯神经网络工具箱的所有功能,而且PRtools的工具箱功能更强,我会在另外一个帖子里再介绍PRtools模式识别工具箱。 Matlab的Bayes贝叶斯神经网络工具箱是Kevin Murphy开发的,最近一次的更新时间是在2007年,此工具的开发,得到了Intel员工的协助! 一,下载: 请直接点此下载,或者点此下载附件FullBNT-1.0.4.zip(2.13MB) 二,安装: 解压刚刚下载的zip文件,把你刚才所解压的路径,添加到Matlab的Path里.打开Matlab,在命令行下输入: >>cd C:\Users\JasonZhang\Desktop\FullBNT-1.0.4%设置成你自己的路径>>addpath(genpathKPM(pwd)); 这时候,你会看到一大推的warning,原因是这个工具箱里的有些函数与MATLAB 自带的函数名字一样,会出现冲突。 我个人的建议是,先记下这些冲突的函数,以后发现程序冲突的时候,可以临时把刚刚添加的path从matlab的path中删除掉。如果你用到此工具箱,再添加这个路径。 如果想测试添加是否成功,在命令下面输入: >>test_BNT 即使有时候出现错误信息也没有关系,通常是由于MATLAB版本更新引起的,有些函数(比如说isfinite)在旧的版本里有,新的版本里就换了,只要看一下MATLAB的更新历史,去把相应的函数换掉即可。 三、使用matlab贝叶斯神经网络工具箱 matlab贝叶斯神经网络工具箱有完整的帮助文件,请点击这里阅读,或者下载此文件How to use the Bayes Net Toolbox.pdf(407.53KB)

神经网络工具箱操作

1. 打开MATLAB,在命令行输入nntool,将出现如下界面: 图1 神经网络工具箱主界面 其中最主要的分为6个部分:第1部分中显示的是系统的输入数据;第2部分是系统的期望输出;第3部分是网络的计算输出;第4部分是网络的误差,即2 和3之间的差异;第5部分呈现的是已经建立的神经网络实例;第6部分的两个按钮分别负责数据的导入和网络模型的建立。 2. 点击“Import”按钮,分别导入输入数据与目标输出数据(数据可从工作区导入,也可从文件导入): 图2 导入输入数据集

图3 导入期望输出数据集 导入数据后主界面的情况如下: 图4 导入数据后的情况 重要说明:神经网络的数据是以列为基本单位的,即输入与输出数据的列数必须相同,否则将报错!如果原先数据是以行为单位组织的话,可以先在MATLAB 中实现转置然后再导入,即B = A’。

3.现在需要的数据已经有了,下一步就是建立一个神经网络模型对数据集进行学习。以下步骤以BP网络为例,首先点击“New”按钮,出现如下界面: 几个重要部分已在上图中框出:1处用于定义该神经网络的名称;2处用于选择神经网络的类型;3处用于选择网络的输入数据;4处用于确定网络的期望输出数据;5、6、7处分别对神经网络的主要机制函数进行设置;8处设置网络层数;9处用于选择各网络层(需要说明的是:第1层指的是隐含层而不是输入层),从而在10和11处可以对该层的神经元个数和传递函数进行设置;12处按钮可以用于查看当前所设置的神经网络的结构图(下附图);点击13处按钮即可生成对应的神经网络模型。前面只是简单地介绍了各个部分的作用,具体参数应该如何设置就只有各位自行去学习相关的文献了,此处不再多言。

贝叶斯网络工具箱使用

matlab贝叶斯网络工具箱使用 2010-12-18 02:16:44| 分类:默认分类| 标签:bnet 节点叶斯matlab cpd |字号大中小订阅 生成上面的简单贝叶斯网络,需要设定以下几个指标:节点,有向边和CPT表。 给定节点序,则只需给定无向边,节点序自然给出方向。 以下是matlab命令: N = 4; %给出节点数 dag = false(N,N); %初始化邻接矩阵为全假,表示无边图C = 1; S = 2; R = 3; W = 4; %给出节点序 dag(C,[R,S])=true; %给出有向边C-R,C-S dag([R,S],W)=true; %给出有向边R-W,S-W discrete_nodes = 1:N; %给各节点标号 node_sizes = 2*ones(1,N); %设定每个节点只有两个值 bnet = mk_bnet(dag, node_sizes); %定义贝叶斯网络bnet %bnet结构定义之后,接下来需要设定其参数。 bnet.CPD{C} = tabular_CPD(bnet, C, [0.5 0.5]); bnet.CPD{R} = tabular_CPD(bnet, R, [0.8 0.2 0.2 0.8]); bnet.CPD{S} = tabular_CPD(bnet, S, [0.5 0.9 0.5 0.1]); bnet.CPD{W} = tabular_CPD(bnet, W, [1 0.1 0.1 0.01 0 0.9 0.9 0.99]); 至此完成了手工输入一个简单的贝叶斯网络的全过程。 要画结构图的话可以输入如下命令: G=bnet.dag; draw_graph(G); 得到:

matlab-BP神经网络(贝叶斯正则化算法程序)

close all clear echo on clc % NEWFF——生成一个新的前向神经网络 % TRAIN——对BP 神经网络进行训练 % SIM——对BP 神经网络进行仿真 pause % 敲任意键开始 clc % 定义训练样本矢量 % P 为输入矢量 sqrs=[0.0000016420520 0.0000033513140 0.0000051272540 0.0000069694860 0.0000088776310 0.0000139339960 -0.0000594492310 -0.0001080022920 -0.0001476714860 ... 0.0000112367340 0.0002021567880 0.0008695337800 -0.0001189929700 -0.0000912336690 0.0002160472130 0.0006358522040 0.0012365884200 0.0049930394010 ]./0.001657904949 ; sqjdcs=[0.0000399039272 0.0000805129702 0.0001218448339 0.0001639173001 0.0002067504102 0.0003172835720 0.0000421189848 0.0000870310694 0.0001350858140 ... 0.0001866997652 0.0002423599348 0.0004033628719 0.0000394450224 0.0000830935373 0.0001317612004 0.0001864881262 0.0002486249700 0.0004497441812 ]./0.000533286; sqglmj=[0.0000068430669 0.0000147605347 0.0000240097285 0.0000349372747 0.0000480215187 0.0000954580176 0.0000005804238 0.0000011640375 0.0000017508228 ... 0.0000023407605 0.0000029338317 0.0000044301058 0.0000030813582 0.0000071511410 0.0000126615618 0.0000203910217 0.0000318028637 0.0001118629438 ]./0.000034868299 ; s1=[0.0001773503110 0.0003553133430 0.0005338922010 0.0007130899610 0.0008929096590 0.00#### 0.0005747667510 0.0012111415700 0.0019195724060 ... 0.0027130110200 0.0036077110840 0.0064386221260 0.0005056929850 0.0010189193420 0.00#### 0.0020685403470 0.0026052286500 0.0039828224110 ]./0.00275071; %s2=[25.9167875445 24.0718476818 22.2364947192 20.4105777318 18.5939487791 14.0920619223 990.2535888432 1040.4661104131 1096.3830297389 1159.029******* ... % 1229.6925839338 1453.3788619676 164.1136642277 142.4834641073 121.6137611080 101.4436832756 81.9180522413 35.6044841634]; glkyl=[1 1 1 1 1 1 2 2 2 2 2 2 3 3 3 3 3 3];

贝叶斯网络构建算法

3.1 贝叶斯网络构建算法 算法3.1:构建完全连接图算法 输入:样本数据D ;一组n 个变量V={V l ,V 2,…,V n }变量。 输出:一个完全连接图S 算法: 1、 连接任意两个节点,即连接边 L ij=1,i ≠j 。 2、 为任一节点V i 邻接点集合赋值,B i= V\{V i }。 算法3.2:构建最小无向图算法 输入:样本数据D ;一组n 个变量V={V l ,V 2,…,V n }变量。及算法3.1中得到的邻接点集B i ,连接边集 L ij 先验知识:节点V i ,V j 间连接边是否存在 变量说明:L 为连接边,|L|=n(n –1)/2为连接边的数量,B i 表示变量V i 的直接邻近集,|B i |表示与变量B i 相邻的变量数。(V i ⊥V j |Z)表示V i 和V j 在Z 条件下条件独立,设∧(X ,Y)表示变量X 和Y 的最小d-分离集。 输出:最小无向图S 1、根据先验知识,如果V i 和V j 不相连接,则L ij =0 . 2、对任一相连接边,即L ij ≠0,根据式(3-12)计算互信息I (V i ,V j ) ),(Y X I =))()(|),((y p x P y x p D =????? ?)()(),(log ),(Y p X p Y X p E y x P (3-12) if I (V i ,V j )ε≤ then { L ij =0 //V i 和V j 不相连接 B i= V\{V j }, B j= V\{V i } //调整V i 和V j 邻接集 } else I ij = I (V i ,V j ) //节点V i 和V j 互信息值 3、对所有连接边,并按I ij 升序排序 4、如果连接边集L ij 不为空,那么按序选取连接边L ij ,否则 goto 10 if |B i |≥ |B j |,令Z= B i else Z= B j //为后面叙述方便,这里先假设|B i |≥ |B j | 5、逐一计算L ij 的一阶条件互信息I(V i ,V j |Z 1),Z 1={Y k }, Y k ∈Z, if I(V i ,V j |Z 1)ε≤ then { L ij =0 //V i 和V j 关于Z 1条件独立 B i= V\{V j }, B j= V\{V i } //调整V i 和V j 邻接集 d ij = Z 1 //L ij 最小d 分离集为Z 1 goto 4

不错的Matlab神经网络工具箱实用指南

Matlab的神经网络工具箱实用指南 文章摘要:第一章是神经网络的基本介绍,第二章包括了由工具箱指定的有关网络结构和符号的基本材料以及建立神经网络的一些基本函数,例如new、init、adapt和train。第三章以反向传播网络为例讲解了反向传播网络的原理和应用的基本过程。 第一章介绍 1.神经网络 神经网络是单个并行处理元素的集合,我们从生物学神经系统得到启发。在自然界,网络功能主要由神经节决定,我们可以通过改变连接点的权重来训练神经网络完成特定的功能。 一般的神经网络都是可调节的,或者说可训练的,这样一个特定的输入便可得到要求的输出。如下图所示。这里,网络根据输出和目标的比较而调整,直到网络输出和目标匹配。作为典型,许多输入/目标对应的方法已被用在有监督模式中来训练神经网络。 神经网络已经在各个领域中应用,以实现各种复杂的功能。这些领域包括:模式识别、鉴定、分类、语音、翻译和控制系统。 如今神经网络能够用来解决常规计算机和人难以解决的问题。我们主要通过这个工具箱来建立示范的神经网络系统,并应用到工程、金融和其他实际项目中去。 一般普遍使用有监督训练方法,但是也能够通过无监督的训练方法或者直接设计得到其他的神经网络。无监督网络可以被应用在数据组的辨别上。一些线形网络和Hopfield网络是直接设计的。总的来说,有各种各样的设计和学习方法来增强用户的选择。 神经网络领域已经有50年的历史了,但是实际的应用却是在最近15年里,如今神经网络仍快速发展着。因此,它显然不同与控制系统和最优化系统领域,它们的术语、数学理论和设计过程都已牢固的建立和应用了好多年。我们没有把神经网络工具箱仅看作一个能正常运行的建好的处理轮廓。我们宁愿希望它能成为一个有用的工业、教育和研究工具,一个能够帮助用户找到什么能够做什么不能做的工具,一个能够帮助发展和拓宽神经网络领域的工具。因为这个领域和它的材料是如此新,这个工具箱将给我们解释处理过程,讲述怎样运用它们,并且举例说明它们的成功和失败。我们相信要成功和满意的使用这个工具箱,对范例

贝叶斯分类多实例分析总结

用于运动识别的聚类特征融合方法和装置 提供了一种用于运动识别的聚类特征融合方法和装置,所述方法包括:将从被采集者的加速度信号 中提取的时频域特征集的子集内的时频域特征表示成以聚类中心为基向量的线性方程组;通过求解线性方程组来确定每组聚类中心基向量的系数;使用聚类中心基向量的系数计算聚类中心基向量对子集的方差贡献率;基于方差贡献率计算子集的聚类中心的融合权重;以及基于融合权重来获得融合后的时频域特征集。 加速度信号 →时频域特征 →以聚类中心为基向量的线性方程组 →基向量的系数 →方差贡献率 →融合权重 基于特征组合的步态行为识别方法 本发明公开了一种基于特征组合的步态行为识别方法,包括以下步骤:通过加速度传感器获取用户在行为状态下身体的运动加速度信息;从上述运动加速度信息中计算各轴的峰值、频率、步态周期和四分位差及不同轴之间的互相关系数;采用聚合法选取参数组成特征向量;以样本集和步态加速度信号的特征向量作为训练集,对分类器进行训练,使的分类器具有分类步态行为的能力;将待识别的步态加速度信号的所有特征向量输入到训练后的分类器中,并分别赋予所属类别,统计所有特征向量的所属类别,并将出现次数最多的类别赋予待识别的步态加速度信号。实现简化计算过程,降低特征向量的维数并具有良好的有效性的目的。 传感器 →样本及和步态加速度信号的特征向量作为训练集 →分类器具有分类步态行为的能力 基于贝叶斯网络的核心网故障诊断方法及系统 本发明公开了一种基于贝叶斯网络的核心网故障诊断方法及系统,该方法从核心网的故障受理中心采集包含有告警信息和故障类型的原始数据并生成样本数据,之后存储到后备训练数据集中进行积累,达到设定的阈值后放入训练数据集中;运用贝叶斯网络算法对训练数据集中的样本数据进行计算,构造贝叶斯网络分类器;从核心网的网络管理系统采集含有告警信息的原始数据,经贝叶斯网络分类器计算获得告警信息对应的故障类型。本发明,利用贝叶斯网络分类器构建故障诊断系统,实现了对错综复杂的核心网故障进行智能化的系统诊断功能,提高了诊断的准确性和灵活性,并且该系统构建于网络管理系统之上,易于实施,对核心网综合信息处理具有广泛的适应性。 告警信息和故障类型 →训练集 —>贝叶斯网络分类器

如何用MATLAB的神经网络工具箱实现三层BP网络

如何用MA TLAB的神经网络工具箱实现三层BP网络? % 读入训练数据和测试数据 Input = []; Output = []; str = {'Test','Check'}; Data = textread([str{1},'.txt']); % 读训练数据 Input = Data(:,1:end-1); % 取数据表的前五列(主从成分) Output = Data(:,end); % 取数据表的最后一列(输出值) Data = textread([str{2},'.txt']); % 读测试数据 CheckIn = Data(:,1:end-1); % 取数据表的前五列(主从成分) CheckOut = Data(:,end); % 取数据表的最后一列(输出值) Input = Input'; Output = Output'; CheckIn = CheckIn'; CheckOut = CheckOut'; % 矩阵赚置 [Input,minp,maxp,Output,mint,maxt] = premnmx(Input,Output); % 标准化数据 %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%%% %%%% % 神经网络参数设置 %====可以修正处 Para.Goal = 0.0001; % 网络训练目标误差 Para.Epochs = 800; % 网络训练代数 Para.LearnRate = 0.1; % 网络学习速率 %==== Para.Show = 5; % 网络训练显示间隔 Para.InRange = repmat([-1 1],size(Input,1),1); % 网络的输入变量区间 Para.Neurons = [size(Input,1)*2+1 1]; % 网络后两层神经元配置

贝叶斯网络

贝叶斯网络 2007-12-27 15:13 贝叶斯网络 贝叶斯网络亦称信念网络(Belief Network),于1985 年由Judea Pearl 首先提出。它是一种模拟人类推理过程中因果关系的不确定性处理模型,其网络拓朴结构是一个有向无环图(DAG)。它的节点用随机变量或命题来标识,认为有直接关系的命题或变量则用弧来连接。例如,假设结点E 直接影响到结点H,即E→H,则建立结点E 到结点H 的有向弧(E,H),权值(即连接强度)用条件概率P(H/E)来表示,如图所示: 一般来说,有 n 个命题 x1,x2,,xn 之间相互关系的一般知识可用联合概率分布来描述。但是,这样处理使得问题过于复杂。Pearl 认为人类在推理过程中,知识并不是以联合概率分布形表现的,而是以变量之间的相关性和条件相关性表现的,即可以用条件概率表示。如 例如,对如图所示的 6 个节点的贝叶斯网络,有 一旦命题之间的相关性由有向弧表示,条件概率由弧的权值来表示,则命题之间静态结构关系的有关知识就表示出来了。当获取某个新的证据事实时,要对每个命题的可能取值加以综合考查,进而对每个结点定义一个信任度,记作 Bel(x)。可规定 Bel(x) = P(x=xi / D) 来表示当前所具有的所有事实和证据 D 条件下,命题 x 取值为 xi 的可信任程度,然后再基于 Bel 计算的证据和事实下各命题

的可信任程度。 团队作战目标选择 在 Robocode 中,特别在团队作战中。战场上同时存在很多机器人,在你附近的机器人有可能是队友,也有可能是敌人。如何从这些复杂的信息中选择目标机器人,是团队作战的一大问题,当然我们可以人工做一些简单的判断,但是战场的信息是变化的,人工假定的条件并不是都能成立,所以让机器人能自我选择,自我推理出最优目标才是可行之首。而贝叶斯网络在处理概率问题上面有很大的优势。首先,贝叶斯网络在联合概率方面有一个紧凑的表示法,这样比较容易根据一些事例搜索到可能的目标。另一方面,目标选择很容易通过贝叶斯网络建立起模型,而这种模型能依据每个输入变量直接影响到目标选择。 贝叶斯网络是一个具有概率分布的有向弧段(DAG)。它是由节点和有向弧段组成的。节点代表事件或变量,弧段代表节点之间的因果关系或概率关系,而弧段是有向的,不构成回路。下图所示为一个简单的贝叶斯网络模型。它有 5 个节 点和 5 个弧段组成。图中没有输入的 A1 节 点称为根节点,一段弧的起始节点称为其末节点的母节点,而后者称为前者的子节点。 简单的贝叶斯网络模型 贝叶斯网络能够利用简明的图形方式定性地表示事件之间复杂的因果关系或概率关系,在给定某些先验信息后,还可以定量地表示这些关系。网络的拓扑结构通常是根据具体的研究对象和问题来确定的。目前贝叶斯网络的研究热点之一就是如何通过学习自动确定和优化网络的拓扑结构。 变量 由上面贝叶斯网络模型要想得到理想的目标机器人,我们就必须知道需要哪些输入变量。如果想得到最好的结果,就要求我们在 Robocode 中每一个可知的数据块都要模拟为变量。但是如果这样做,在贝叶斯网络结束计算时,我们会得到一个很庞大的完整概率表,而维护如此庞大的概率表将会花费我们很多的系统资源和计算时间。所以在开始之前我们必须要选择最重要的变量输入。这样从比赛中得到的关于敌人的一些有用信息有可能不会出现在贝叶斯网络之内,比如速

神经网络工具箱

神经网络工具箱 版本6.0.4(R2010a版本)25-JAN-2010 图形用户界面的功能。 nctool - 神经网络分类的工具。 nftool - 神经网络拟合工具。 nprtool - 神经网络模式识别工具。 nntool - 神经网络工具箱的图形用户界面。 nntraintool - 神经网络训练工具。 视图- 查看一个神经网络。 分析功能。 混乱- 分类混淆矩阵。 errsurf - 单输入神经元的误差表面。 maxlinlr - 最大的学习率的线性层。 鹏- 受试者工作特征。 距离函数。 boxdist - 箱距离函数。 DIST - 欧氏距离权重函数。 mandist - 曼哈顿距离权重函数。 linkdist - 链路距离函数。 格式化数据。 combvec - 创建载体的所有组合。 con2seq - 转换并行向量连续载体。 同意- 创建并发偏载体。 dividevec - 创建载体的所有组合。 ind2vec - 转换指数为载体。 最小最大- 矩阵行范围。 nncopy - 复印基质或细胞阵列。 normc - 规格化矩阵的列。 normr - 规格化行的矩阵的。 pnormc - 矩阵的伪规格化列。 定量- 值离散化作为数量的倍数。 seq2con - 转换顺序向量并发载体。 vec2ind - 将矢量转换成指数。 初始化网络功能。 initlay - 层- 层网络初始化函数。 初始化层功能。

initnw - 阮层的Widrow初始化函数。 initwb - 从重量和- 偏置层初始化函数。 初始化的重量和偏见的功能。 initcon - 良心的偏见初始化函数。 initzero - 零重量/偏置初始化函数。 initsompc - 初始化SOM的权重与主要成分。 中点- 中点重初始化函数。 randnc - 归一列重初始化函数。 randnr - 归行重初始化函数。 兰特- 对称随机重量/偏置初始化函数。 学习功能。 learncon - 良心的偏见学习功能。 learngd - 梯度下降重量/偏置学习功能。 learngdm - 梯度下降W /气势重量/偏置学习功能。 learnh - 赫布重学习功能。 learnhd - 赫布衰变重学习功能。 learnis - 重量龄学习功能。 learnk - Kohonen的重量学习功能。 learnlv1 - LVQ1重学习功能。 learnlv2 - LVQ2重学习功能。 learnos - Outstar重学习功能。 learnsomb - 批自组织映射权重学习功能。 learnp - 感知重量/偏置学习功能。 learnpn - 归感知重量/偏置学习功能。 learnsom - 自组织映射权重学习功能。 learnwh - 的Widrow - 霍夫重量/偏置学习规则。 在线搜索功能。 srchbac - 回溯搜索。 srchbre - 布伦特的结合黄金分割/二次插值。 srchcha - Charalambous“三次插值。 srchgol - 黄金分割。 srchhyb - 混合二分/立方搜索。 净输入功能。 netprod - 产品净输入功能。 netsum - 求和净输入功能。 网络创造的功能。 网络- 创建一个自定义的神经网络。 NEWC - 创建一个有竞争力的层。 newcf - 创建级联转发传播网络。

算法杂货铺——分类算法之贝叶斯网络(Bayesian networks)

算法杂货铺——分类算法之贝叶斯网络(Bayesian networks) 2010-09-18 22:50 by EricZhang(T2噬菌体), 2561 visits, 网摘, 收藏, 编辑 2.1、摘要 在上一篇文章中我们讨论了朴素贝叶斯分类。朴素贝叶斯分类有一个限制条件,就是特征属性必须有条件独立或基本独立(实际上在现实应用中几乎不可能做到完全独立)。当这个条件成立时,朴素贝叶斯分类法的准确率是最高的,但不幸的是,现实中各个特征属性间往往并不条件独立,而是具有较强的相关性,这样就限制了朴素贝叶斯分类的能力。这一篇文章中,我们接着上一篇文章的例子,讨论贝叶斯分类中更高级、应用范围更广的一种算法——贝叶斯网络(又称贝叶斯信念网络或信念网络)。 2.2、重新考虑上一篇的例子 上一篇文章我们使用朴素贝叶斯分类实现了SNS社区中不真实账号的检测。在那个解决方案中,我做了如下假设: i、真实账号比非真实账号平均具有更大的日志密度、各大的好友密度以及更多的使用真实头像。 ii、日志密度、好友密度和是否使用真实头像在账号真实性给定的条件下是独立的。 但是,上述第二条假设很可能并不成立。一般来说,好友密度除了与账号是否真实有关,还与是否有真实头像有关,因为真实的头像会吸引更多人加其为好友。因此,我们为了获取更准确的分类,可以将假设修改如下: i、真实账号比非真实账号平均具有更大的日志密度、各大的好友密度以及更多的使用真实头像。 ii、日志密度与好友密度、日志密度与是否使用真实头像在账号真实性给定的条件下是独立的。 iii、使用真实头像的用户比使用非真实头像的用户平均有更大的好友密度。