探索性数据分析

分布的概念

一个变量的分布是该变量的取值的具体表现形式,它不仅描述了该变量的不同取值,同时也描述了其每个值的可能性。

一、变量类型及其分布

1、首先我们打开life expectancy这个数据表。本例中的每个国家都有13年的年度观察

数据,并且每个国家的13年数据都是以年份为序依次排序。JMP将这种编排方式称为堆叠数据。

区分四类变量:定类变量(定名型、定序型),定量变量(定距型、定比型)

二、定类变量的分布

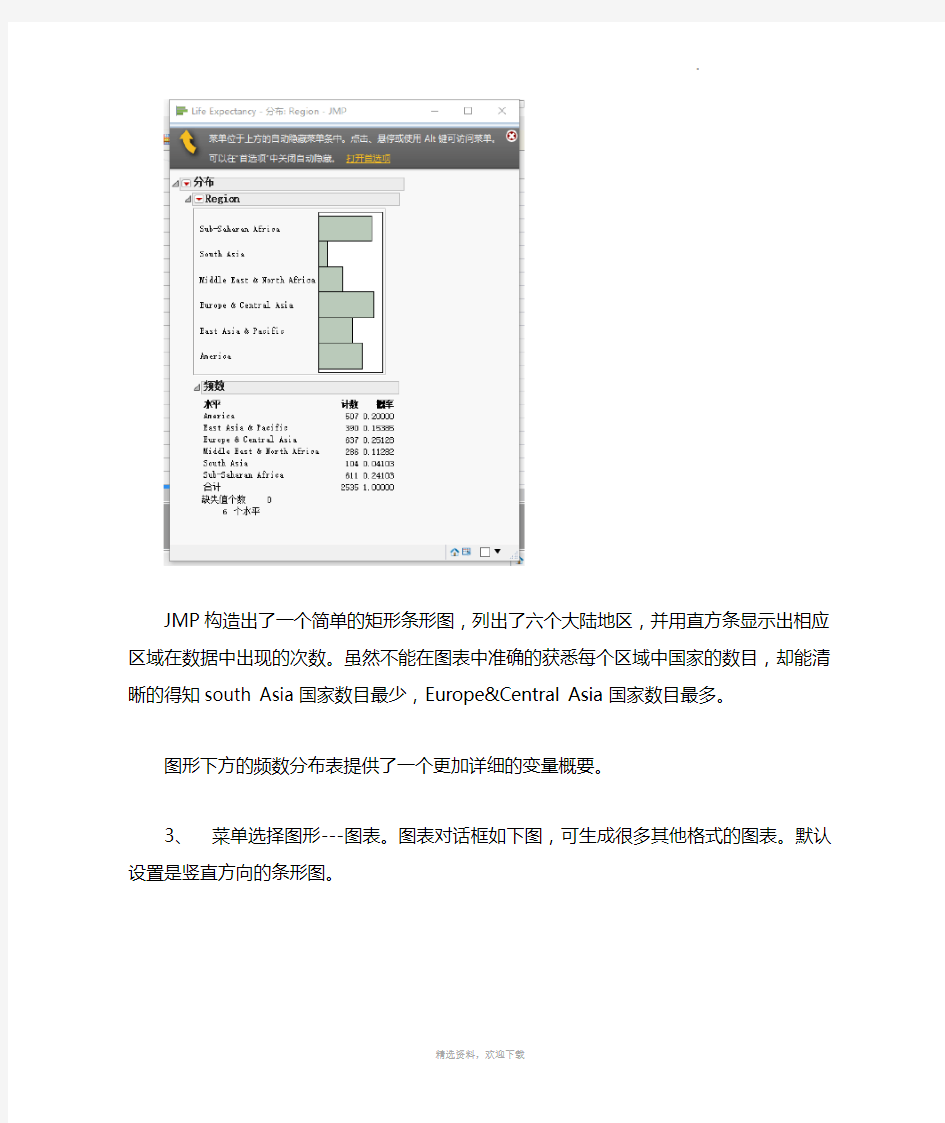

2、选择菜单---分析。将region作为Y,列变量。点击确定,得到如下结果。

JMP构造出了一个简单的矩形条形图,列出了六个大陆地区,并用直方条显示出相应区域在数据中出现的次数。虽然不能在图表中准确的获悉每个区域中国家的数目,却能清晰的得知south Asia国家数目最少,Europe&Central Asia国家数目最多。

图形下方的频数分布表提供了一个更加详细的变量概要。

3、菜单选择图形---图表。图表对话框如下图,可生成很多其他格式的图表。默认设置是

竖直方向的条形图。

4、选择列框中点击Region,并点击按钮统计量,选择数量。结果得到一张可以显示每个区域观察对象数量的条形图。

可以通过点击图表右侧的红色三角形按钮进行更改和自定义图形。

5.JMP自动按照字母顺序对定类数据进行结果输出。我们也可以修改输出结果。

6.在数据表格中或者在列框中右击Region,选择列信息。

7.点击列属性,选择值排序。

8.选择一个变量值名,使用按钮上移和下移,最后确定。

9.需要点击图表标题右侧的红色三角形按钮,选择脚本——重新运行分析。最后才得到我们需要的顺序的图形。

三、定量变量的分布

1、选择数据表的一部分

某些时候我们需要从数据表中选择某一些特定的行进行分析。JMP为我们提供了在分析包含和剔除行的多种方法。

菜单选择行—行选择—选择符合条件的行。

如下图所示,选择那些year等于2010的行,点击添加条件,最后点击确定。

菜单选择表---子集。在子集对话框中要确保做出的选择是选定行选项,并点击确定。

窗口中会显示出第二张打开的数据表。该表中有与第一张表相同的四个变量,但仅有195行。在每个案例中,观察年份都是2010年,并且每个国家只有一行数据。

2、连续型数据直方图的构建

●菜单选择分析——分布。将LifeExp选入Y,列框中。

●当分布窗口打开时,点击LifeExp左侧的红色三角形按钮,选择直方图选项——

垂直。该操作会清空垂直选项前的复选框,将直方图变成更加符合传统的水平方

向。

、

上面的直方图是世界各国预期寿命分布的一种表示方法,它给我们提供了关于寿命预期是如何变动的视图,直方图上方是一个箱线图。

寿命预期在40~45岁的国家很少,相对的,许多国家预期寿命在70~75岁之间。

形状:涉及以下两个方面:直方图的对称性和图形中峰值的数目。显然图中可以看出,是一个非对称图形,图形左侧尾部的观察值很少,而右侧聚集了大量的观察值。我们称具有该形状的图形是左偏分布。峰值在70~75岁。

中心:分布的中心有多种定义,包括统计意义上的均值、中位数、众数。从视觉上看,我们可以将直方图的中心定义为横轴的中心值(中位数该例接近60~65岁),或有最大频数的区间(众数,该例为70~75岁),或视觉上的均衡点(均值,该例中接近65~70岁)或其他方式的定义。

离散程度:中心的概念注重于变量取值的代表性,离散程度的概念则注重于对代表性取值的偏离程度。

1、返回至原始的Life Expectancy数据表。

2、菜单选择行—数据过滤器。添加Year作为过滤器列。

3、数据过滤器能帮助我们确定所需行。

4、同时选择如上所示复选框中的包括;默认设置是选择。

5、从主菜单栏中,选择分析—分布。

6、如下图所示,选择LifeExp作为Y,列。

7、由于我们想要对各个年份分别进行分析,因此选择Year作为依据,并点击确

定。上述操作将会产生两个垂直方向的直方图。观察可知,第一个分布的数轴

变化在25岁~75岁,而第二个则是从40岁~85岁。

8、在分布的输出中,按住Ctrl键的同时点击分布左侧的红色三角形标志便选择

统一尺度。

9、再次点击红色三角形,选择堆叠。

此时显示的图形如上图所示。与2010年的分布相比,1950年的分布的形状有哪些不同?造成这两个分布形状上的差异是什么?

从两个直方图可以看出,人们现在比1950年时生存时间更长。2010年寿命的预期分布的位置远比1950年的偏右。我们可以得知1950年的预期分布比2010年更加分散。以上分析可以揭示过去60年间寿命预期发生了什么变化。

Welcome !!! 欢迎您的下载,资料仅供参考!

探索性数据分析

分布的概念 一个变量的分布是该变量的取值的具体表现形式,它不仅描述了该变量的不同取值,同时也描述了其每个值的可能性。 一、变量类型及其分布 1、首先我们打开life expectancy这个数据表。本例中的每个国家都有13年的年度观察数据, 并且每个国家的13年数据都是以年份为序依次排序。JMP将这种编排方式称为堆叠数据。 区分四类变量:定类变量(定名型、定序型),定量变量(定距型、定比型) 二、定类变量的分布 2、选择菜单---分析。将region作为Y,列变量。点击确定,得到如下结果。 JMP构造出了一个简单的矩形条形图,列出了六个大陆地区,并用直方条显示出相应区域在数据中出现的次数。虽然不能在图表中准确的获悉每个区域中国家的数目,却能清晰的得知south Asia国家数目最少,Europe&Central Asia国家数目最多。 图形下方的频数分布表提供了一个更加详细的变量概要。 3、菜单选择图形---图表。图表对话框如下图,可生成很多其他格式的图表。默认设置是竖 直方向的条形图。

4、选择列框中点击Region,并点击按钮统计量,选择数量。结果得到一张可以显示每个区域观察对象数量的条形图。 可以通过点击图表右侧的红色三角形按钮进行更改和自定义图形。

5.JMP自动按照字母顺序对定类数据进行结果输出。我们也可以修改输出结果。 6.在数据表格中或者在列框中右击Region,选择列信息。 7.点击列属性,选择值排序。 8.选择一个变量值名,使用按钮上移和下移,最后确定。 9.需要点击图表标题右侧的红色三角形按钮,选择脚本——重新运行分析。最后才得到我们需要的顺序的图形。 三、定量变量的分布 1、选择数据表的一部分 某些时候我们需要从数据表中选择某一些特定的行进行分析。JMP为我们提供了在分析包含和剔除行的多种方法。 菜单选择行—行选择—选择符合条件的行。 如下图所示,选择那些year等于2010的行,点击添加条件,最后点击确定。 菜单选择表---子集。在子集对话框中要确保做出的选择是选定行选项,并点击确定。 窗口中会显示出第二张打开的数据表。该表中有与第一张表相同的四个变量,但仅有195行。在每个案例中,观察年份都是2010年,并且每个国家只有一行数据。 2、连续型数据直方图的构建 ●菜单选择分析——分布。将LifeExp选入Y,列框中。 ●当分布窗口打开时,点击LifeExp左侧的红色三角形按钮,选择直方图选项——垂 直。该操作会清空垂直选项前的复选框,将直方图变成更加符合传统的水平方向。

人口大数据行业分析调研报告

2019年人口大数据行业分析调研报告 2019年11月

目录 1.人口大数据行业概况及市场分析 (5) 1.1人口大数据行业结构分析 (5) 1.2人口大数据行业PEST分析 (6) 1.3人口大数据行业特征分析 (7) 1.4人口大数据行业国内外对比分析 (8) 2.人口大数据行业存在的问题分析 (10) 2.1政策体系不健全 (10) 2.2基础工作薄弱 (10) 2.3地方认识不足,激励作用有限 (10) 2.4产业结构调整进展缓慢 (11) 2.5技术相对落后 (11) 2.6隐私安全问题 (11) 2.7与用户的互动需不断增强 (12) 2.8管理效率低 (13) 2.9盈利点单一 (13) 2.10过于依赖政府,缺乏主观能动性 (14) 2.11法律风险 (14) 2.12供给不足,产业化程度较低 (14) 2.13人才问题 (15) 2.14产品质量问题 (15) 3.人口大数据行业政策环境 (17)

3.1行业政策体系趋于完善 (17) 3.2一级市场火热,国内专利不断攀升 (17) 3.3“十三五”期间人口大数据建设取得显著业绩 (18) 4.人口大数据产业发展前景 (19) 4.1中国人口大数据行业市场驱动因素分析 (19) 4.2中国人口大数据行业市场规模前景预测 (19) 4.3人口大数据进入大面积推广应用阶段 (19) 4.4政策将会持续利好行业发展 (20) 4.5细分化产品将会最具优势 (20) 4.6人口大数据产业与互联网等产业融合发展机遇 (21) 4.7人口大数据人才培养市场大、国际合作前景广阔 (21) 4.8巨头合纵连横,行业集中趋势将更加显著 (22) 4.9建设上升空间较大,需不断注入活力 (23) 4.10行业发展需突破创新瓶颈 (23) 5.人口大数据行业发展趋势 (25) 5.1宏观机制升级 (25) 5.2服务模式多元化 (25) 5.3新的价格战将不可避免 (25) 5.4社会化特征增强 (25) 5.5信息化实施力度加大 (26) 5.6生态化建设进一步开放 (26) 5.7呈现集群化分布 (27)

人口分析报告

一、实验目的 为了对我国人口情况的了解,对我国其他经济、政治状况有所深刻的了解,对2009年的人口作分析是很有必要的。这样可以预测我国未来与现在的人口变动情况,也可以指引着我国政府提前对政策作出决定,以管理我国一切事物。 二、数据收集 通过从中国统计局网站获得2009年及以前的部分人口数据,可以就这一数据可以对中国人口作简单分析,了解我国人口的基本情况。 三、人口分析 (一)人口结构分析 1、从1980--2009年全国人口男女比例来看,可以利用Excel 可以作出男女比例变动的曲线图如下: 我国男女比例变动趋势 46.00 47.0048.0049.0050.0051.0052.00 1980 1983 1986 1989 1992 1995 1998 2001 2004 2007 年份 比例(%) 男女 从图中可以看出中国近30年来男性比例都大于女性比例,这可能是由于中国传统思想所导致的。随着时间的推移,中国人口性别比例有向着均衡的趋势发展。

2、年龄结构分析 2009年全国人口的年龄调查,对其数据的构成画出了柱状图如下: (10.00)(5.00) 0.00 5.00 10.00 人口百分比 0-9 20-29 40-4960-6980-89 年龄段 人口金子塔图 男女 从图中可以看出中国目前的年龄结构,成熟型的人口结构,并且可以通过这个图形对未来的人口结构作出预测,可能中国在过20年,人口老龄化将更加严重,因此,我国政府应提前做好防止未来因人口老龄化而带来的社会问题。 3、家庭规模分析 通过对我国家庭人口调查数据分析,得出折线图如下:

家庭规模构成图 20000 400006000080000100000120000一人户二人户三人户四人户五人户六人户七人户八人户九人户十人户及以上 规模 户数 家庭户数 从图中可以看出中国目前以家庭为单位生活的规模情况,大多数是以三人户为主,还有二人户和四人户居多,因此可以判断中国现在家庭以独生子女居多,两个子女其次,两个老人和未育子女夫妇的也居多,这间接地反映了我国20年前的计划生育政策的效果现在明显凸现了。 (二)受教育程度分析 从2009年的人口数据来看,对我国居民的文化教育程度可以作出饼图如下: 文化教育程度分布图 初 中42% 大专及以上 7% 未上过学7% 小 学30% 高 中 14%

粤港澳大湾区人口流动分析洞察报告-TalkingData

粤港澳大湾区人口流动分析洞察报告2018年8月 T alkingData、华人大数据协会联合编制

前言 “管理”的本质是将所有的信息集中在决策者手上,並不习惯于使用生态外的数据去増强自身的洞察力。同时大数据,可以说是人类历史上第一次有机会让收集及整合数据变得更简单及有效率。经过了十年的发展,互联网、移动互联网及金融服务业已经成为了数据大户,随之而来是政府公共服务也加入到大数据的生态行列中。当中积累了人们在城市中基于他是谁(Who),在哪(Where),什么时候(When),做过什么(What)的生活习惯与状态数据。任何城市或者企业都可以运用这些大数据作出分析及响应,这可能就是我们常提到智慧的一种解读。 为了让更多人能体会到上述的方式,华人大数据学会特意邀请了TalkingData使用移动终端数据上的能力为大湾区淮备这份粤港澳大湾区人口流动洞察分析報告,期间又得到了BBD的帮助加入了大湾区9个城市过去一年的高新科技行业招聘情况的分析。 因此,我在此呼吁更多的企业都夠大力支持,让大数据帮助成为洞察城市问题与机会的动力,也成为建立更美好城市的源泉。 华人大数据协会会长车品觉

?编制团队 ?与华人大数据协会联合编制 ?分析师:魏文雯刘涛 ?数据来源 ?数据中心数据来自、、的行业数据采集,以及诸多合作伙伴的数据交换,如应用市场、渠道、运营商等多种不同来源的数据复合而成; ?招聘数据来自公司。 ?数据周期 ?人口流动数据:年月、年月、年月; ?招聘数据:年上半年、年上半年。

?概念定义 ?跨市出行指数某城市跨市出行度大湾区各城市跨市出行度的均值,其中,出行度为跨市出行人次与常住人口的比值,如某城市跨市出行指数大于,则表示该城市的用户跨市出行活跃度较高。 ?跨市流入度:湾区其他城市出行至某城市的用户数量标准化后的分值; ?跨市流出度:某城市出行到湾区其他城市的用户数量标准化后的分值; ?人口联系强度:两两城市之间的人口联系强度为该两个城市的跨市流入度和跨市流出度之和,某城市与湾区整体的人口联系强度指的是该城市与湾区其他所有城市的人口联系强度值求和; ?工作用户流出量:如某用户居住在A城市去大湾区其他城市工作,则该用户是A城市的工作流出用户,A城市所有工作流出用户的数量即为工作用户流出量; ?工作用户流入量:如某用户居住在大湾区其他城市来A城市工作,则该用户是A城市的工作流入用户,A城市所有工作流入用户的数量即为工作用户流入量; ?工作用户净流出率=(工作用户流出量-工作用户流入量)/居住用户总量,如果A城市的工作用户净流出率为负数,说明该城市对其他城市具有就业吸附力,且值越低,就业吸附力越强,如果A城市的工作用户净流出率为正,说明该城市居住属性较强。

科学史上最有名的数据分析例子

科学史上最有名的数据分析例子 开普勒三定律 数据来源:第谷?布拉赫(,丹麦人),观察力极强的天文学家,一辈子(年)观察记录了颗行星资料,位置误差不超过°。 观测数据可以视为实验模型。 数据处理:开普勒(,德国人),身体瘦弱、近视又散光,不适合观天,但有一个非常聪明的数学头脑、坚韧的性格(甚至有些固执)和坚强的信念

(宇宙是一个和谐的整体),花了年()研究第谷的观测数据,得到了开普勒三定律。 开普勒三定律则为唯象模型。 .数据分析法 思想 采用数理统计方法(如回归分析、聚类分析等)或插值方法或曲线拟合方法,对已知离散数据建模。 适用范围:系统的结构性质不大清楚,无法从理论分析中得到系统的规律,也不便于类比,但有若干能表征系统规律、描述系统状态的数据可利用。 数据分析法 基础知识 ()数据也称观测值,是实验、测量、观察、调查等的结果,常以数量的形式给出; ()数据分析()是指分析数据的技术和理论; ()数据分析的目的是把隐没在一大批看来杂乱无章的数据中的信息集中、萃取和提炼出来,以找出所研究对象的内在规律; ()作用:在实用中,它可帮助人们作判断,以采取适当行动。 ()实际问题所涉及的数据分为: ①受到随机性影响(随机现象)的数据; ②不受随机性影响(确定现象)的数据; ③难以确定性质的数据(如灰色数据)。 ()数理统计学是一门以收集和分析随机数据为内容的学科,目的是对数据所来自的总体作出判断,总体有一定的概率模型,推断的结论也往往一概率的形式表达(如产品检验合格率)。 ()探索性数据分析是在尽量少的先验假定下处理数据,以表格、摘要、图示等直观的手段,探索数据的结构及检测对于某种指定模型是否有重大偏离。它可以作为进一步分析的基础,也可以对数据作出非正式的解释。实验者常常据此扩充或修改其实验方案(作图法也该法的重要方法,如饼图、直方图、条形图、走势图或插值法、曲线(面)拟合法等)。

基于人口统计的大数据融合算法

基于人口统计多源数据融合算法的提出 目录 一、算法需求背景 (1) 二、D-S算法简介 (2) 三、算法过程简述 (2) (一) 先确定证据框架 (2) (二) 基本概率分配 (3) (三) 计算信任函数 (3) (四) 似然函数 (4) (五) 证据合成 (4) (六) 计算扩样系数 (5) (七) 计算扩样结果 (6) 一、算法需求背景 目前公司在人口统计算法上已逐步形成系列,但算法在地理区域适应性上易体现出精度不高的现象。目前的做法是按照统计区域,做出不同的扩样策略。这将导致在每个区域需要大量专业人力去做扩样策略,为了提高算法的精确度以及减少算法人员的重复人力消耗,从而提出人口统计的多源融合算法。如果该算法经过验证,该算法是公司将要开发的SaaS平台中动态模型引擎里重要的一环。

人口统计多源数据融合算法可以融合包括影响精度的所有因素,如:地理环境、城市类型、城市等级、城市周边、面积、年鉴、人口结构等等。 传统的算法是将影响精度的因素或因素所含的因子,按照策略赋以权值,然后在利用组合规则进行n-1 次的上层统计学算法得出结果。该方法在因素的可信度上难以有一个较精确的权值,并且对因素的“环境”变化无法动态分析。 人口统计应该是用一个概率区间而不是单一概率数值去建模不确定性。所以有了下面的构思。 二、D-S算法简介 1、D-S证据理论源于20世纪60年代Dempster在多值映射方面的工作,从本质上讲,属于人工智能的范畴,它由于具有处理不确定性的能力以及在工程上表现出来的实用性能,近年来在不确定推理多传感器信息融合、模式识别、不确定信息决策等领域得到了广泛的应用。. 2、基于D-S证据理论算法,与概率推理等理论相比,D-S证据理论在不确定性的度量上更灵活,推理机制更简洁,尤其对于未知的处理更接近于人的自然思维习惯。该理论的核心超越了概率统计推断的理论框架,可以适应于专家系统、人工智能、模式识别和系统决策等领域的实际问题,而且此理论很快发展成了智能学习和多源信息融合的重要组成部分。该算法理论经过多年的发展,在智能交通、医学、航空、人工智能科学等应用广泛。 3、D-S合成规则的标准化过程中,因为证据因素过多,证据之间容易产生大量冲突,比如有些低可信度的证据往往却是真命题。这也是该算法相比于其它算法不同的地方,冲突证据合成一直是D-S证据理论所关注的重要问题之一。距离(每多个证据之间的距离)法解决证据之间的冲突是多年来国内外研究的结果,经过多年的演变,也有多个不同的版本。 三、算法过程简述 (一) 先确定证据框架 算法假定有一个影响模型数据精度的证据框架,该证据框架可以是用字母Θ表示的因素集合,该集合是一个具有互斥和可穷举元素的集合: Θ= { θ1 , θ2 , …, θn }

探索性数据分析

探索性数据分析 探索性数据分析是利用ArcGIS提供的一系列图形工具和适用于数据的插值方法,确定插值统计数据属性、探测数据分布、全局和局部异常值(过大值或过小值)、寻求全局的变化趋势、研究空间自相关和理解多种数据集之间相关性。探索性空间数据分析对于深入了解数据,认识研究对象,从而对与其数据相关的问题做出更好的决策。 一数据分析工具 1.刷光(Brushing)与链接(Linking) 刷光指在ArcMap数据视图或某个ESDA工具中选取对象,被选择的对象高亮度显示。链接指在ArcMap数据视图或某个ESDA工具中的选取对象操作。在所有视图中被选取对象均会执行刷光操作。如在下面章节将要叙述的探索性数据分析过程中,当某些ESDA工具(如直方图、V oronoi图、QQplot图以及趋势分析)中执行刷光时,ArcMap数据视图中相应的样点均会被高亮度显示。当在半变异/协方差函数云中刷光时,ArcMap数据视图中相应的样点对及每对之间的连线均被高亮度显示。反之,当样点对在ArcMap数据视图中被选中,在半变异/协方差函数云中相应的点也将高亮度显示。 2.直方图 直方图指对采样数据按一定的分级方案(等间隔分级、标准差分级)进行分级,统计采样点落入各个级别中的个数或占总采样数的百分比,并通过条带图或柱状图表现出来。直方图可以直观地反映采样数据分布特征、总体规律,可以用来检验数据分布和寻找数据离群值。 在ArcGIS中,可以方便的提取采样点数据的直方图,基本步骤为: 1)在ArcMap中加载地统计数据点图层。 2)单击Geostatistical Analyst模块的下拉箭头选择Explore Data并单击Histogram。 3)设置相关参数,生成直方图。 A.Bars:直方图条带个数,也就是分级数。 B.Translation:数据变换方式。None:对原始采样数据的值不作变换,直接生成直方图。 Log:首先对原始数据取对数,再生成直方图。Box-Cox:首先对原始数据进行博克斯-考克斯变换(也称幂变换),再生成直方图。 https://www.360docs.net/doc/4915201996.html,yer:当前正在分析的数据图层。 D.Attribute:生成直方图的属性字段。 从图3.1a和图3.1b的对比分析可看出,该地区GDP原始数据并不服从正态分布,经过对数变换处理,分布具有明显的对数分布特征,并在最右侧有一个明显的离群值。 在直方图右上方的窗口中,显示了一些基本统计信息,包括个数(count)、最小值(min)、最大值(max)、平均值(mean)、标准差(std. dev.)、峰度(kurtosis)、偏态(skewness)、

第六次人口普查数据及其数据分析

第六次人口普查数据及其分析摘要:本文收集了中国统计年鉴的一些数据,对中国2010年和之前的数据做了一下整理,主要是从全国人口、男女比例、城市化水平等方面做的个人评析。 关键词:全国人口、男女比例、城市化概念及中国城市化 正文: 2001~2010年人口数据及构成 本表各年人口未包含香港、澳门特别行政区和台湾省的人口数据。单位:万人 {

数据分析: 一、全国人口 从全国人口角度考虑(不包含港澳台),2001-2010年间,中国总人口持续上升,其中:2001-2002年,人口增长826万,2002-2003年,人口增长774万,2003-2004年,人口增长761万,2004-2005年,人口增长768万,2005-2006年,人口增长692万,2006-2007年,人口增长681万,2007-2008年,人口增长673万,2008-2009年,人口增长672万。由此我们可以看出,2001-2010年期间,人口总数不断增加,但增长的人口数呈不断下降的趋势,人口的自然增长率不断下降。 这次人口普查登记的全国总人口为13 3972 4852人,与2000年第五次全国人口普查相比,十年增加7390万人,增长%,年平均增长%,比1990年到2000年的年平均增长率%下降个百分点。数据表明,十年来我国人口增长处于低生育水平阶段。 出现这样的结果很大程度上与我国的基本国策——计划生育制度有关,它对中国的人口问题和发展问题的积极作用不可忽视,但计划生育一味的只控制人口数量,忽略世代更替,造成国家严重的老龄化,未富先老的格局。如今,我国对计划生育政策做了一些修改,有一定程度的放松。 我国人口自然增长率的下降,还与我国经济的发展与综合国力的提升有莫大的关系。如今我过社会保障体系不断完善,像以前那样“养儿防老”的现象愈来愈少,许多年轻夫妇都只生一胎甚至不愿生孩子,

探索性空间数据分析

研究生课程探索性空间数据分析 杜世宏 北京大学遥感与GIS研究所

提纲 一、地统计基础 二、探索性数据分析

?地统计(Geostatistics)又称地质统计,是在法国著名统计学家Matheron大量理论研究的基础上逐渐形成的一门新的统计学分支。 它是以区域化变量为基础,借助变异函数,研究既具有随机性又具有结构性,或空间相关性和依赖性的自然现象的一门科学。凡是与空间数据的结构性和随机性,或空间相关性和依赖性,或空间格局与变异有关的研究,并对这些数据进行最优无偏内插估计,或模拟这些数据的离散性、波动性时,皆可应用地统计学的理论与方法。 ?地统计学与经典统计学的共同之处在于:它们都是在大量采样的基础上,通过对样本属性值的频率分布或均值、方差关系及其相应规则的分析,确定其空间分布格局与相关关系。但地统计学区别于经典统计学的最大特点是:地统计学既考虑到样本值的大小,又重视样本空间位置及样本间的距离,弥补了经典统计学忽略空间方位的缺陷。?地统计分析理论基础包括前提假设、区域化变量、变异分析和空间估值。

? 1. 前提假设 –⑴随机过程。与经典统计学相同的是,地统计学也是在大量样本的基础上,通过分析样本间的规律,探索其分布规 律,并进行预测。地统计学认为研究区域中的所有样本值 都是随机过程的结果,即所有样本值都不是相互独立的, 它们是遵循一定的内在规律的。因此地统计学就是要揭示 这种内在规律,并进行预测。 –⑵正态分布。在统计学分析中,假设大量样本是服从正态分布的,地统计学也不例外。在获得数据后首先应对数据 进行分析,若不符合正态分布的假设,应对数据进行变换,转为符合正态分布的形式,并尽量选取可逆的变换形式。

人口大数据平台解决方案

人口大数据平台解决方案

目录 1.政策背景 (3) 2.解决方案 (3) 2.1.x数据模型算法 (3) 2.2.技术实现路线 (4) 2.2.1活跃用户分析统计 (4) 2.2.2工作/居住人口分析 (4) 2.2.3定点区域人口统计分析 (5) 2.2.4区域人流量监测 (6) 2.3.产品基础功能 (6) 2.4.x标准化产品 (9) 2.4.1数据集/报告 (9) 2.4.2城市月/点次API (12) 2.4.3数据能力开放DaaS平台 (16) 2.4.4大数据可视化平台 (18) 2.4.5城市感知平台 (22) 3.商业模式 (25) 4.产品报价参考 (26) 5.成功案例 (26)

1.政策背景 对政府和城市管理部门而言,居民的居住地和工作地,是一个重要的参考数据源。在规划和政策实施前,可通过了解居民的居住地和工作地,对城市内部小区的功能定位,以及小区周边基础设施的配置等,进行指导。在规划和政策实施后,又可以通过居住地和工作地的比例,评估规划效果,进而指导下一轮的规划。对两者的获取,传统的做法,是问卷调查,但调查的比例有限,难以大范围评估,而且周期也比较长。 以x手机信令数据为基础,从人口密集度、人口出行情况、交通路网信息、关键节点吞吐量、人口迁徙、人口结构特征等方面进行数据监测与分析,反映人口迁徙及交通拥堵情况,为其基础设置建设优先级提供决策辅助。 2.解决方案 2.1.x数据模型算法 x算法模型介绍: ●人口规模统计 根据x集团在当地活跃缴费用户数统计实际人口规模,参照x用户市场占比通过算法推测城市全量人口规模。最小时间粒度为小时分别以以下几种口径进行一天24小时人口统计。 ●人口总数量 通过x当地付费活跃用户数推测城市人口总数量。 工作人口数:周一至周五9:00~17:00时间段内连续一个自然月用户累积所在时间最长的网格为用户工作地,统计其网格内工作人口数。分别统计在本市居住且在网格内工作的人数,网格内居住且在非本市工作的人数,非本市居住且在网格内工作的人数,网格内工作的外省人群数量。 ●居住人口数 每天21:00~5:00时间段内连续一个自然月用户累积所在时间最长的网格为用户居住地,统计其网格内居住人口数。 常住人口数:连续在本市出现六个月,每个月的周一至周五每天在本市驻留不少于5个

探索性数据分析中的统计图形应用

万方数据

万方数据

万方数据

万方数据

万方数据

统计与信息论坛 [11]贺宝龙,唐湘晋.广义线性混合模型在信度理论中的应用[J].金融经济,2008(20):86—87. [12]卢志义,刘乐平.广义线性模型在非寿险精算中的应用及其研究进展[J].统计与信息论坛,2007,22(7):26—31. [13]王济川,谢海义,姜宝法.多层统计分析模型一方法与应用[M].北京:高等教育出版社,2008. (责任编辑:郭诗梦) GeneralizedLinearMixedModelsforEmpiricalRatemaking KANGMeng-meng (SchoolofSatistics,RenminUniversityofChina,Bdjing100872,‰) Abstract:Credibilitymodelisthemostimportantaehievementinnon—lireinsuranceactuarialsdenee.There0redifferenttypesofcredibilitymechanisms:limitedfluctuationsca'edibilityandgreatestaccuracycredibility.Limitedfluctuationscredibilitymodelemphasizesthestabilityoftheresults,whilegreatestaccuracycredibilitymodelemphasizestheaccuracyoftheresults.Inthispaper,wedeveloplinksbetweencredibilitytheoriesinactuarialscienceandgeneralizedlinearmixedmodelsinstatistics.Bydecompositionofcredibility,wecanseethatthetraditionalcredibilitytheorydescribingriskhasthesimilarstructureofgeneralizedlinearmixedmodels.Sowe∞nusegeneralizedlinearmixedmodelstodeterminetheexperiencerate.Keywnms:empiricalratemaking;generalizedlinearmixedmodels;credibilitytheory (上接第17页) 参考文献: [1]贾俊平,何晓群,金勇进.统计学[M].北京:中国人民大学出版社,2004:1-2. [2]ThooJB.Apictureisworthatlx)usandw∞随J].TheCollegeMathematicsJournal,1998,29(5):408-411. [3]KomEdwardL,GraubardBarryI.Scatterplots谢t}lsurveydata[J].TheAmerie翘aStatistician,1998(1):58-69. [4]金勇进,邵军.缺失数据的统计处理[M].北京:中国统计出版社,2009:1—19. [5]DianneCook,SwayneEb_.borahF.Interactiveanddynamicgraphicsfordataanalysis[M].NewYork:Sp咖ger,2007:47—62. [6]SusanHinkimH.LockOh,FritzScheuran.InversesamplingdesignMgorithms[J].SurveyMetlxxlology,1997,23(1):11—21. datastructures:80盯letheoryandapplicationsofinversesampling[7]RaoJNK,ScottAJ,BenhlnE.Undoing00mplex survey [J].SurveyMethodology,2003,29(2):107—128. (责任编辑:王南丰) ISSUESontheExploratoryDataAnalysisofComplexSurveyData XIEJia-bin。JINYong-jin (SchodofStatistics,RenminUniversityofChina,Beijing100872,China) Abstract:Datacollectedinacomplexsurveyhavesomeadditionalfeatures.Ordinarystatisticalgraphicsthatignorethesefeatures bemisleading01"hardtointerpret.Wesummarizedthesefeaturesanddiscussedcan accordingtothesefeatures,howtocarryoutexploratorystatisticalanalysisbased011somemodifiedstatisticalgraphics.。 Keywords:complexsurvey;statisticalgraphics;sampleweights;missingdata;re——sampling 万方数据

大数据数据分析方法、数据处理流程实战案例

数据分析方法、数据处理流程实战案例 大数据时代,我们人人都逐渐开始用数据的眼光来看待每一个事情、事物。确实,数据的直观明了传达出来的信息让人一下子就能领略且毫无疑点,不过前提是数据本身的真实性和准确度要有保证。今天就来和大家分享一下关于数据分析方法、数据处理流程的实战案例,让大家对于数据分析师这个岗位的工作内容有更多的理解和认识,让可以趁机了解了解咱们平时看似轻松便捷的数据可视化的背后都是有多专业的流程在支撑着。 一、大数据思维 在2011年、2012年大数据概念火了之后,可以说这几年许多传统企业也好,互联网企业也好,都把自己的业务给大数据靠一靠,并且提的比较多的大数据思维。 那么大数据思维是怎么回事?我们来看两个例子: 案例1:输入法 首先,我们来看一下输入法的例子。 我2001年上大学,那时用的输入法比较多的是智能ABC,还有微软拼音,还有五笔。那时候的输入法比现在来说要慢的很多,许多时候输一个词都要选好几次,去选词还是调整才能把这个字打出来,效率是非常低的。 到了2002年,2003年出了一种新的输出法——紫光拼音,感觉真的很快,键盘没有按下去字就已经跳出来了。但是,后来很快发现紫光拼音输入法也有它的问题,比如当时互联网发展已经比较快了,会经常出现一些新的词汇,这些词汇在它的词库里没有的话,就很难敲出来这个词。

在2006年左右,搜狗输入法出现了。搜狗输入法基于搜狗本身是一个搜索,它积累了一些用户输入的检索词这些数据,用户用输入法时候产生的这些词的信息,将它们进行统计分析,把一些新的词汇逐步添加到词库里去,通过云的方式进行管理。 比如,去年流行一个词叫“然并卵”,这样的一个词如果用传统的方式,因为它是一个重新构造的词,在输入法是没办法通过拼音“ran bing luan”直接把它找出来的。然而,在大数据思维下那就不一样了,换句话说,我们先不知道有这么一个词汇,但是我们发现有许多人在输入了这个词汇,于是,我们可以通过统计发现最近新出现的一个高频词汇,把它加到司库里面并更新给所有人,大家在使用的时候可以直接找到这个词了。 案例2:地图 再来看一个地图的案例,在这种电脑地图、手机地图出现之前,我们都是用纸质的地图。这种地图差不多就是一年要换一版,因为许多地址可能变了,并且在纸质地图上肯定是看不出来,从一个地方到另外一个地方怎么走是最好的?中间是不是堵车?这些都是有需要有经验的各种司机才能判断出来。 在有了百度地图这样的产品就要好很多,比如:它能告诉你这条路当前是不是堵的?或者说能告诉你半个小时之后它是不是堵的?它是不是可以预测路况情况? 此外,你去一个地方它可以给你规划另一条路线,这些就是因为它采集到许多数据。比如:大家在用百度地图的时候,有GPS地位信息,基于你这个位置的移动信息,就可以知道路的拥堵情况。另外,他可以收集到很多用户使用的情况,可以跟交管局或者其他部门来采集一些其他摄像头、地面的传感器采集的车辆的数量的数据,就可以做这样的判断了。

大数据可视化分析平台介绍演示教学

大数据可视化分析平 台介绍

大数据可视化分析平台 一、背景与目标 基于邳州市电子政务建设的基础支撑环境,以基础信息资源库(人口库、法人库、宏观经济、地理库)为基础,建设融合业务展示系统,提供综合信息查询展示、信息简报呈现、数据分析、数据开放等资源服务应用。实现市府领导及相关委办的融合数据资源视角,实现数据信息资源融合服务与创新服务,通过系统达到及时了解本市发展的综合情况,及时掌握发展动态,为政策拟定提供依据。 充分运用云计算、大数据等信息技术,建设融合分析平台、展示平台,整合现有数据资源,结合政务大数据的分析能力与业务编排展示能力,以人口、法人、地理,人口与地理,法人与地理,实现基础展示与分析,融合公安、交通、工业、教育、旅游等重点行业的数据综合分析,为城市管理、产业升级、民生保障提供有效支撑。 二、政务大数据平台 1、数据采集和交换需求:通过对各个委办局的指定业务数据进行汇聚,将分散的数据进行物理集中和整合管理,为实现对数据的分析提供数据支撑。将为跨机构的各类业务系统之间的业务协同,提供统一和集中的数据交互共享服务。包括数据交换、共享和ETL 等功能。 2、海量数据存储管理需求:大数据平台从各个委办局的业务系统里抽取的数据量巨大,数据类型繁杂,数据需要持久化的存储和访问。不论是结构化数据、半结构化数据,还是非结构化数据,经

过数据存储引擎进行建模后,持久化保存在存储系统上。存储系统要具备高可靠性、快速查询能力。 3、数据计算分析需求:包括海量数据的离线计算能力、高效即席数据查询需求和低时延的实时计算能力。随着数据量的不断增加,需要数据平台具备线性扩展能力和强大的分析能力,支撑不断增长的数据量,满足未来政务各类业务工作的发展需要,确保业务系统的不间断且有效地工作。 4、数据关联集中需求:对集中存储在数据管理平台的数据,通过正确的技术手段将这些离散的数据进行数据关联,即:通过分析数据间的业务关系,建立关键数据之间的关联关系,将离散的数据串联起来形成能表达更多含义信息集合,以形成基础库、业务库、知识库等数据集。 5、应用开发需求:依靠集中数据集,快速开发创新应用,支撑实际分析业务需要。 6、大数据分析挖掘需求:通过对海量的政务业务大数据进行分析与挖掘,辅助政务决策,提供资源配置分析优化等辅助决策功能,促进民生的发展。

《探索性数据分析》测验试卷参考答案

《探索性数据分析》测验试卷 班级: 姓名: 学号: 1.(15分)你所知道的数据类型有哪些?请至少举出四种,并说明这 些数据类型的特点。 2.(共15分)(1). 请叙述矩估计和极大似然估计的定义。 (2). 设总体X ~),(2σμN ,n X X ???,1为来总体的样本,求使 05.0)(=>t X P 的点t 的极大似然估计。 解: 假设)(?Φ为标准正态分布的分布函数,则, )(1)(1)(σμ -Φ-=≤-=>t t X P t X P 由已知可得,95.0)( =-Φσμt . 令05.0t 为标准正态分布的上侧0.05分位数,则05.0t t =-σμ. 于是,由极大似然估计的不变性可知,t 的极大似然估计为,n S t X t ??05.0+=,其中∑==n i i X n X 11, ∑=-=n i i n X X n S 1 2)(1?. (3). 矩估计唯一吗?是,请证明;否,请举反例。 答: 矩估计不唯一,例如泊松分布均值的估计。具体的说,假设总体X 服从参数为λ的泊松(Poisson )分布,由于λ==)()(X Var X E ,故由 矩估计法知: X =1?λ,∑=-=n i i X X n 1 22)(1?λ都可作为参数λ的矩估计量, 然而样本均值是总体均值的无偏估计,且比样本二阶中心矩的阶数低,故优先选取样本均值作为参数的矩估计.

3. (10分)设X 和Y的方差都存在,证明 2|cov(,)|()()X Y Var X Var Y ≤?. 解:(该题是证明相关系数介于-1,1之间的理论依据,所以其实严格来讲由相关系数的取值范围来推得这个命题的做法是错误的)。令X EX μ=,Y EY μ=,t 为任一实数,则0)]()[(2≥-+-Y X Y t X μμ,由积分 的性质可知 0)]()[(2≥-+-Y X Y t X E μμ,另一方面, VarY t Y X tCov VarX Y E t Y X tE X E Y t X E Y Y X X Y X 22222),(2)()])([(2)()]()[(++=-+--+-=-+-μμμμμμ 上式为t 的二次函数,故 0)()(4)],([42≤-Y Var X Var Y X Cov ,得证. 4. (20分)已知T与C独立,且,X T C =∧()I T C δ=≤,设T 与C 的分布函数分别为F 和G ,已知{(,)}0E m T θ=,其中m(.)为已知函数,假设观察样本为11,,,,n n X X δδ???,???,试证明: (1){(,)}01()E m T G T δ θ=- (2)请用观察样本给出θ的一个合适估计。 (1)证明: 利用条件期望的性质可得: 0)],([]|[)(1),(]|),()(1[)},()(1{==? ?????-=??????-=-θδθθδθδT m E T E T G T m E T T m T G E E T m T G E (2)解: 由(1)可知 0),()(1=? ?????-θδX m X G E <1> 于是,我们可以用估计方程方法给出θ的一个估计。上式的样本类似为 ∑=-n i i i i X m X G n 1),() (11θδ <2> 令0),() (111=-∑=n i i i i X m X G n θδ,由该方程解出来的估计θ?称为估计方程估

空间数据探索性分析与地统计分析

1.数据检查,即空间数据探索分析(ESDA) 在地统计分析中,克里格方法是建立在平稳假设的基础上,这种假设在一定程度上要求所有数据值具有相同的变异性。另外,一些克里格插值(如普通克里格法、简单克里格法和泛克里格法等)都假设数据服从正态分布。如果数据不服从正态分布,需要进行一定的数据变换使其服从正态分布。因此,在用地统计分析创建表面之前,了解数据的分布状况十分重要。在ArcGIS GA模块中,主要提供了两种方法检验数据的分布:直方图法和正态QQPlot 图法。 (1)直方图显示数据的概率分布特征以及概括性的统计指标 图1 上图中所展示的数据,中值接近均值、峰值指数接近3。从图中观察可认为近似于正态分布。 (2)正态QQ Plot 图 图2 正态QQ 图上的点可指示数据集的单变量分布的正态性。如果数据是正态分布的,点将落在45 度参考线上。如果数据不是正态分布的,点将会偏离参考线。所以正态QQ 图可以用来检查数据的正态分布情况。作图原理是用分位图思想。直线表示正态分布,从图中可以看出数据很接近正态分布。 该研究通过地统计分析工具生成35个样本点的直方图和正态QQPlot 图,分别如图1、图2所示。从图1及其各种统计指标值可以看出,该样本点近乎于正态分布。在图2中,该例选取的35个样本点基本沿直线分布,也说明样本点接近于服从正态分布。在本研究区的样本点近乎于正态分布,而且区域化变量NO2的期望值是未知的,经过分析,在后期预测表面时,采用普通克里格插值是最为合适的。

(3)趋势分析图 上图为NO2的空间分布趋势图,x 轴正向指向东,y 轴正向指向北,z 轴正向指向属性(此处为NO2浓度)值增大的方向,采样点(即空气质量监测站)位于xy 平面上,黑色的垂直杆的高度代表NO2浓度的大小,分别将散点投影到xz 平面和yz 平面上,然后分别用二次曲线拟合,xz 平面上的绿色曲线代表东西方向的趋势,yz 平面上的蓝色曲线代表南北方向的趋势。从图中可以看到,NO2的浓度南北方向呈现出倒U 型的趋势,东西方向也呈现出倒U 型的趋势,说明在该地区的中部地区NO2浓度最高。 趋势分析工具提供用户研究区平面上的采样点转化为以感兴趣的属性值为高度的三维视图,然后用户从不同视角分析采样数据集的全局趋势。趋势分析图中的每一根竖棒代表了一个数据点的值(该实验中是NO2的浓度)和位置。这些点被投影到一个东西向的和一个南北向的正交平面上。通过投影点可以做出一条最佳拟合线,并用它来模拟特定方向上存在的趋势。此实验中的趋势分析图中南北方向和东西方向上有明显的趋势出现,因此需要用二次曲面拟合,即在后续剔除趋势的操作中选择二次(second)。可见,使用趋势分析来分析样本点数据的走向,可以使后续的表面拟合更加客观,拟合的结果具有更大的可信程度。 (4)Voronoi 图 Voronoi 图可以用来发现离群值。Voronoi 图的生成方法:每个多边形内有一个样点,多变形内任一点到该点的距离都小于其他多边形到该点的距离,生成多边形后。某个样点的相邻样点便会与该样点的多边形有相邻边。 利用相邻点的这个定义,可计算多种局部统计量。“Voronoi 图”工具提供下列方法来指定或计算面的值。 简单:指定给面的值是在该面内的采样点处记录的值。 平均值:指定给面的值是根据面及其相邻面计算出的平均值。 众数:利用五个组距对所有多边形进行分类。指定给面的值是面及其相邻面的众数(最常出现的组)。 聚类:利用五个组距对所有多边形进行分类。如果面的组距与其每个相邻面的组距都不同,则该面将灰显并放进第六组以区分该面与其相邻面。 熵:所有的面都利用基于数据值(小分位数)的自然分组的五个组进行分类。

《探索性数据分析》测验试卷参考答案

《探索性数据分析》测验试卷 班级:姓名:学号: 1.(15分)你所知道的数据类型有哪些?请至少举出四种,并说明这些数据类型的特点。 2.(共15分)(1). 请叙述矩估计和极大似然估计的定义。 (2). 设总体X~) , (2 σ μ N,n X X???, 1 为来总体的样本,求使05 .0 ) (= >t X P的点t的极大似然估计。 解:假设)(? Φ为标准正态分布的分布函数,则, ) ( 1 ) ( 1 ) ( σ μ - Φ - = ≤ - = > t t X P t X P 由已知可得,95 .0 ) (= - Φ σ μ t. 令 05 .0 t为标准正态分布的上侧0.05分位 数,则 05 .0 t t = - σ μ. 于是,由极大似然估计的不变性可知, t的极大似 然估计为, n S t X t? ? 05 .0 + =,其中∑ = = n i i X n X 1 1, ∑ = - = n i i n X X n S 1 2 ) ( 1 ?. (3). 矩估计唯一吗?是,请证明;否,请举反例。 答:矩估计不唯一,例如泊松分布均值的估计。具体的说,假设总体X服从参数为λ的泊松(Poisson)分布,由于λ = =) ( ) (X Var X E,故由

矩估计法知: X =1?λ,∑=-=n i i X X n 1 22)(1?λ都可作为参数λ的矩估计量, 然而样本均值是总体均值的无偏估计,且比样本二阶中心矩的阶数低,故优先选取样本均值作为参数的矩估计. 3. (10分)设X 和Y的方差都存在,证明 2|cov(,)|()()X Y Var X Var Y ≤?. 解:(该题是证明相关系数介于-1,1之间的理论依据,所以其实严格来讲由相关系数的取值范围来推得这个命题的做法是错误的)。令X EX μ=,Y EY μ=,t 为任一实数,则0)]()[(2≥-+-Y X Y t X μμ,由积分 的性质可知 0)]()[(2≥-+-Y X Y t X E μμ,另一方面, VarY t Y X tCov VarX Y E t Y X tE X E Y t X E Y Y X X Y X 22222),(2)()])([(2)()]()[(++=-+--+-=-+-μμμμμμ 上式为t 的二次函数,故 0)()(4)],([42≤-Y Var X Var Y X Cov ,得证. 4. (20分)已知T与C独立,且,X T C =∧()I T C δ=≤,设T 与C 的分布函数分别为F 和G ,已知{(,)}0E m T θ=,其中m(.)为已知函数,假设观察样本为11,,,,n n X X δδ???,???,试证明: (1){(,)}01()E m T G T δ θ=- (2)请用观察样本给出θ的一个合适估计。 (1)证明: 利用条件期望的性质可得: 0)],([]|[)(1),(]|),()(1[)},()(1{==? ?????-=??????-=-θδθθδθδT m E T E T G T m E T T m T G E E T m T G E (2)解: 由(1)可知