WAS服务器负载测试软件导读

WAS服务器负载测试软件导读

发布: 2008-2-02 17:14 | 作者: 不详 | 来源: 51CMM | 查看: 591次 | 进入软件测试论坛讨论

你的Web服务器和应用到底能够支持多少并发用户访问?在出现大量并发请求的情况下,软件会出现问题吗?这些问题靠通常的测试手段是无法解答的。本文介绍了Microsoft为这个目的而提供的免费工具WAS及其用法。另外,本文介绍了一种Web应用的性能优化方法,并利用WAS测试了它的性能改善程度。原文出处:

https://www.360docs.net/doc/4d9170649.html,/articles/20000420.htm

编译如下:

随着服务器端处理任务的日益复杂以及网站访问量的迅速增长,服务器性能的优化也成了非常迫切的任务。在优化之前,最好能够测试一下不同条件下服务器的性能表现。找出性能瓶颈所在是设计性能改善方案之前的一个至关紧要的步骤。

本文介绍Microsoft的Web Application Stress Tool(WAS,Web应用负载测试工具)在Web服务器性能测试中的应用(注:Stress基本含义为“重压;压力”等,本文称之为“负载”)。另外,我们还将通过WAS评估一种相对简单的网站性能改善方法,这种方法的基本思想是在服务器上生成静态的HTML页面、避免过多的数据库调用。

负载测试是任何Web应用的开发周期中一个重要的步骤。如果你在构造一个为大量用户服务的应用,搞清楚你的产品配置能够承受多大的负载非常重要。如果你在构造一个小型的Intranet网站,测试能够暴露出最终会导致服务器崩溃的内存漏洞以及竞争情况。

无论是哪种情形,花些时间对应用进行负载测试可以获得重要的基准性能数据,为未来的代码优化、硬件配置以及系统软件升级带来方便。即使经费有限的开发组织也可以对它们的网站进行负载测试,因为Microsoft的WAS 是可以免费下载的。WAS要求Windows NT 4.0 SP4或者更高,或者Windows 2000。为了对网站进行负载测试,WAS 可以通过一台或者多台客户机模拟大量用户的活动。WAS支持身份验证、加密和Cookies,也能够模拟各种浏览器类型和Modem速度,它的功能和性能可以与数万美元的产品相媲美。如果你对WAS和Microsoft的另外一个测试工具Web Capacity Analysis Tool (WCAT)之间的差别感兴趣,可以访问Microsoft Web工具的比较页面。

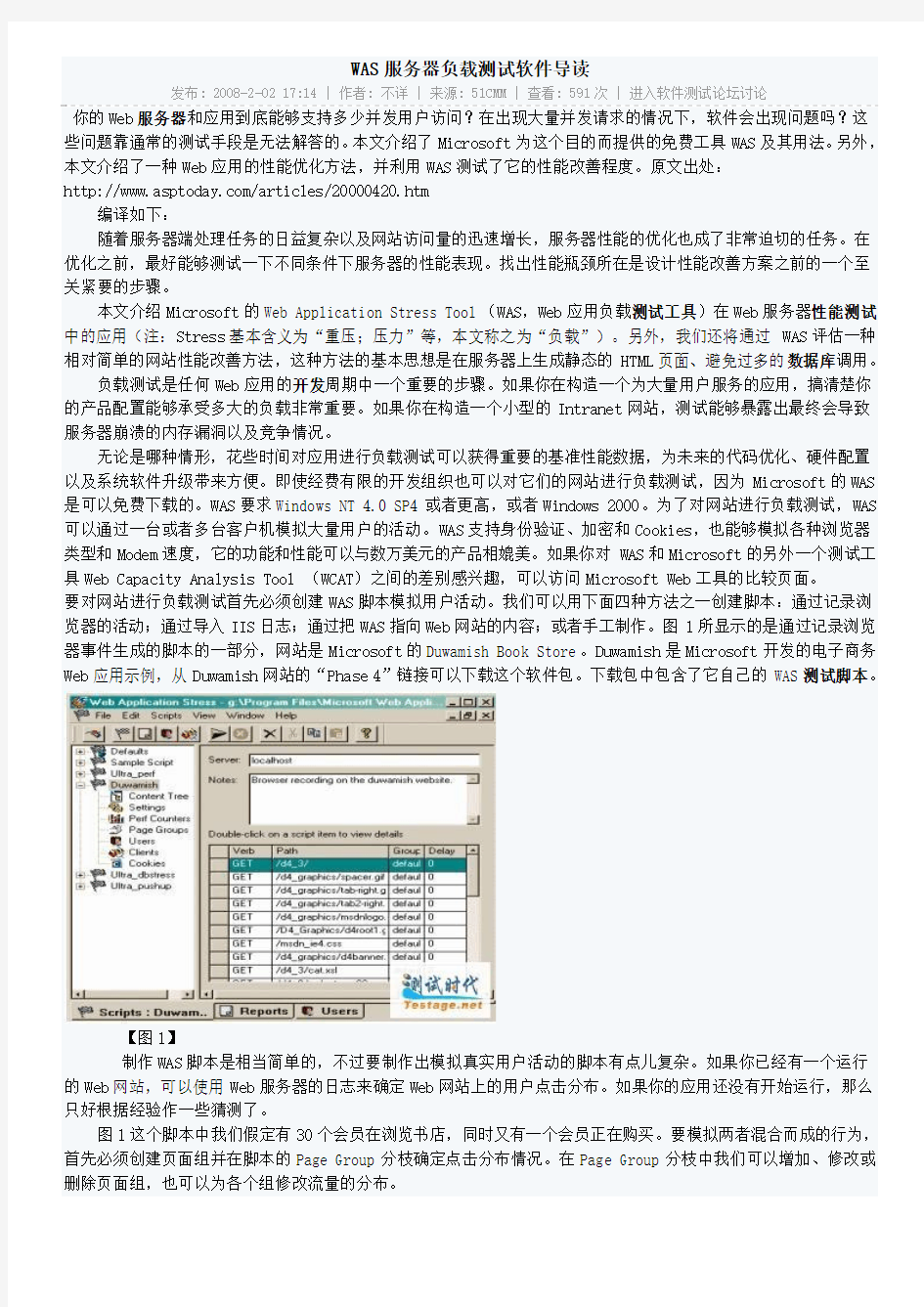

要对网站进行负载测试首先必须创建WAS脚本模拟用户活动。我们可以用下面四种方法之一创建脚本:通过记录浏览器的活动;通过导入IIS日志;通过把WAS指向Web网站的内容;或者手工制作。图1所显示的是通过记录浏览器事件生成的脚本的一部分,网站是Microsoft的Duwamish Book Store。Duwamish是Microsoft开发的电子商务Web应用示例,从Duwamish网站的“Phase 4”链接可以下载这个软件包。下载包中包含了它自己的WAS测试脚本。

【图1】

制作WAS脚本是相当简单的,不过要制作出模拟真实用户活动的脚本有点儿复杂。如果你已经有一个运行的Web网站,可以使用Web服务器的日志来确定Web网站上的用户点击分布。如果你的应用还没有开始运行,那么只好根据经验作一些猜测了。

图1这个脚本中我们假定有30个会员在浏览书店,同时又有一个会员正在购买。要模拟两者混合而成的行为,首先必须创建页面组并在脚本的Page Group分枝确定点击分布情况。在Page Group分枝中我们可以增加、修改或删除页面组,也可以为各个组修改流量的分布。

图2显示了grp_browse和grp_buy这两个页面组以及30比1的流量分布。

【图2】

创建了页面组之后,我们就可以在主脚本视图中赋予各个请求不同的页面组,如图3所示。为每个请求指定页面组相当于告诉WAS如何分布流量。记住在本例中对grp_buy组页面的请求约占总数的3%,而对grp_browse 组页面的请求约占97%。

【图3】

如果需要在查询字符串中传递“名字-值”对,可以用WAS的查询字符串编辑器来定义各个变量的所有可能的值。在输入变量值后,既可以要求WAS顺序地使用变量的各个值,也可以要求WAS在请求时随机选择变量值。这在一定程度上增加了脚本所模拟行为的真实性,也可以帮助避免缓冲对测试结果的影响准备好测试脚本之后,我们可以调整测试配置以便观察不同条件下的应用性能。图4是WAS的设置界面。

【图4】

Stress Level和Stress multiplier这二个项决定了访问服务器的并发连接的数量。Microsoft建议不要选择超过100的Stress Level值。如果要模拟的并发连接数量超过100个,可以调整Stress multiplier或使用多个客户机。在负载测试期间WAS将通过DCOM与其他客户机协调。有关在测试中使用多个客户机的更多信息,参见https://www.360docs.net/doc/4d9170649.html,/kb/hkb13.htm。

如果网站提供个性化服务,要进行身份验证或使用Cookies,我们还要为WAS提供一个用户目录。WAS中的用户存储了发送给服务器的密码以及服务器发送给客户端的Cookies。增加用户数量并不增加Web服务器的负载。必须提供足够数量的用户以满足并发连接的要求(Stesss Level乘以Stress Multiplier)。有关线程、用户、Cookies 相互作用的更多信息请参见https://www.360docs.net/doc/4d9170649.html,/Threads/WASThreads.htm。

WAS允许设置warmup(热身)时间,一般可以设置为1分钟。在warmup期间WAS开始执行脚本,但不收集统计数据。warmup时间给MTS、数据库以及磁盘缓冲等一个机会来做准备工作。如果在warmup时间内收集统计数据,这些操作的开销将影响性能测试结果。

设置页面提供的另外一个有用的功能是限制带宽(throttle bandwidth)。带宽限制功能能够为测试模拟出Modem(14.k K,28.8 K,56 K)、ISDN(64 K,128 K)以及T1(1.54 M)的速度。使用带宽限制功能可以精确地

预测出客户通过拨号网络或其他外部连接访问Web服务器所感受的性能。

要理解这些不同的设置对应用的影响,有必要了解如何使用WAS收集性能数据。

使用WAS,从远程Windows NT和Windows 2000机器获取和分析性能计数器(Performance Counter)是很方便的。加入计数器要用到图5所示的Perf Counters分枝。

【图5】

在测试中选择哪些计数器显然跟测试目的有关。虽然下面这个清单不可能精确地隔离出性能瓶颈所在,但对一般的Web服务器性能测试来说却是一个好的开始。

· 处理器:CPU使用百分比(% CPU Utilization)

· 线程:每秒的上下文切换次数(Context Switches Per Second (Total))

· ASP:每秒请求数量(Requests Per Second)

· ASP:请求执行时间(Request Execution Time)

· ASP:请求等待时间(Request Wait Time)

· ASP:置入队列的请求数量(Requests Queued)

CPU使用百分比反映了处理器开销。CPU使用百分比持续地超过75%是性能瓶颈在于处理器的一个明显的迹象。每秒上下文切换次数指示了处理器的工作效率。如果处理器陷于每秒数千次的上下文切换,说明它忙于切换线程而不是处理ASP脚本。

每秒的ASP请求数量、执行时间以及等待时间在各种测试情形下都是非常重要的监测项目。每秒的请求数量告诉我们每秒内服务器成功处理的ASP请求数量。执行时间和等待时间之和显示了反应时间,这是服务器用处理好的页面作应答所需要的时间。

我们可以绘出随着测试中并发用户数量的增加每秒请求数量和反应时间的变化图。增加并发用户数量时每秒请求数量也会增加。然而,我们最终会达到这样一个点,此时并发用户数量开始“压倒”服务器。如果继续增加并发用户数量,每秒请求数量开始下降,而反应时间则会增加。要搞清楚硬件和软件的能力,找出这个并发用户数量开始“压倒”服务器的临界点非常重要。

置入队列的ASP请求数量也是一个重要的指标。如果在测试中这个数量有波动,某个COM对象所接收到的请求数量超过了它的处理能力。这可能是因为在应用的中间层使用了一个低效率的组件,或者在ASP会话对象中存储了一个单线程的单元组件。

运行WAS的客户机CPU使用率也有必要监视。如果这些机器上的CPU使用率持续地超过75%,说明客户机没有足够的资源来正确地运行测试,此时应该认为测试结果不可信。在这种情况下,测试客户机的数量必须增加,或者

减小测试的Stress Level。

每次测试运行结束后WAS会生成详细的报表,即使测试被提前停止也一样。WAS报表可以从View菜单选择Reports 查看。下面介绍一下报表中几个重要的部分。

如果这是一个新创建的测试脚本,你应该检查一下报表的Result Codes部分。这部分内容包含了请求结果代码、说明以及服务器返回的结果代码的数量。如果这里出现了404代码(页面没有找到),说明在脚本中有错误的页面请求。

页面摘要部分提供了页面的名字,接收到第一个字节的平均时间(TTFB),接收到最后一个字节的平均时间(TTLB),以及测试脚本中各个页面的命中次数。TTFB和TTLB这两个值对于计算客户端所看到的服务器性能具有重要意义。TTFB反映了从发出页面请求到接收到应答数据第一个字节的时间总和(以毫秒计),TTLB包含了TTFB,它是客户机接收到页面最后一个字节所需要的累计时间。

报表中还包含了所有性能计数器的信息。这些数据显示了运行时各个项目的测量值,同时还提供了最大值、最小值、平均值等。报表实际提供的信息远远超过了我们这里能够介绍的内容。为了给你一个有关表所提供信息种类的印象,图6摘录了一个报表实例。

【图6】

随着Internet应用的日益广泛,用户的要求和期望也在不断地发展。今天的客户期待个性化的可定制的方案,期待这些方案不仅简单,而且快速、可靠、成本低廉。对于能够适应用户需求不断变动的可定制页面来说,静态HTML已经退出了舞台,比如内容根据客户请求变化的页面就是其中一例。这一切都要求系统保存相关的数据,例如有关用户本身以及用户可能请求哪些信息的数据。

紧跟这些趋势的Web开发者已经开始提供可定制的Web网站。象搜索数据之类的任务现在可以由服务器执行而无需客户干预。然而,这些变革也导致了一个结果,这就是许多网站都在使用大量的未经优化的数据库调用,从而使得应用性能大打折扣。

我们可以使用以下几种方法来解决这些问题:

1. 优化ASP代码。

2. 优化数据库调用。

3. 使用存储过程。

4. 调整服务器性能。

优秀的网站设计都会关注这些问题。然而,与静态页面的速度相比,任何数据库调用都会显著地影响Web网站的响应速度,这主要是因为在发送页面之前必须单独地为每个访问网站的用户进行数据库调用。

这里提出的性能优化方案正是基于以下事实:访问静态HTML页面要比访问那些内容依赖于数据库调用的页面要快。它的基本思想是:在用户访问页面之前,预先从数据库提取信息写入存储在服务器上的静态HTML页面。为了保证这些静态页面能够及时地反映不断变化的数据库数据,必须有一个调度程序管理静态页面的生成。

当然,这种方案并不能够适应所有的情形。例如,如果是从持续变化的大容量数据库提取少量信息,这种方案是不合适的。不过可以适用该方案的场合还是很多。

为了保证能够在合适的时间更新静态HTML页面,把下面的代码加入到相应的ASP页面前面:

随着Internet应用的日益广泛,用户的要求和期望也在不断地发展。今天的客户期待个性化的可定制的方案,期待这些方案不仅简单,而且快速、可靠、成本低廉。对于能够适应用户需求不断变动的可定制页面来说,静态HTML 已经退出了舞台,比如内容根据客户请求变化的页面就是其中一例。这一切都要求系统保存相关的数据,例如有关用户本身以及用户可能请求哪些信息的数据。

紧跟这些趋势的Web开发者已经开始提供可定制的Web网站。象搜索数据之类的任务现在可以由服务器执行而无需客户干预。然而,这些变革也导致了一个结果,这就是许多网站都在使用大量的未经优化的数据库调用,从而使得应用性能大打折扣。

我们可以使用以下几种方法来解决这些问题:

1. 优化ASP代码。

2. 优化数据库调用。

3. 使用存储过程。

4. 调整服务器性能。

优秀的网站设计都会关注这些问题。然而,与静态页面的速度相比,任何数据库调用都会显著地影响Web网站的响应速度,这主要是因为在发送页面之前必须单独地为每个访问网站的用户进行数据库调用。

这里提出的性能优化方案正是基于以下事实:访问静态HTML页面要比访问那些内容依赖于数据库调用的页面要快。它的基本思想是:在用户访问页面之前,预先从数据库提取信息写入存储在服务器上的静态HTML页面。为了保证这些静态页面能够及时地反映不断变化的数据库数据,必须有一个调度程序管理静态页面的生成。

当然,这种方案并不能够适应所有的情形。例如,如果是从持续变化的大容量数据库提取少量信息,这种方案是不合适的。不过可以适用该方案的场合还是很多。

为了保证能够在合适的时间更新静态HTML页面,把下面的代码加入到相应的ASP页面前面:

每当该页面被调用,脚本就会提取最后的更新时间并将它与当前时间比较。如果两个时间之间的差值大于预定的数值,Update.asp脚本就会运行;否则,该ASP页面把余下的HTML代码发送给浏览器。

最后更新时间从Application变量得到,它的第一次初始化由global.asa完成。具体的更新时间间隔应根据页面内容的更新要求调整。

如果每次访问ASP页面的时候都要提供最新的信息,或者输出与用户输入密切相关,这种方法并不实用,但这种方法可以适应以固定的时间间隔更新信息的场合。

如果数据库内容由客户通过适当的ASP页面更新,要确保静态页面也能够自动反映数据的变化,我们可以在ASP 页面中调用Update脚本。这样,每当数据库内容改变时服务器上也有了最新的静态HTML页面。

另一种处理频繁变动数据的办法是借助Microsft SQL Server 7.0的Web助手向导(Web Assist ant Wizard),这

服务器负载均衡的设计与实现

服务器负载均衡的设计与实现 在该架构中OpenFlow控制器可以获取每个服务器的运行状态,并根据运行状态分发用户请求,最大程度地利用每台服务器的计算资源,并且可以在系统运行期间动态地添加或删除服务器,使系统具备很高的灵活性。 1、动态负载均衡架构的整体设计 负载均衡架构是在一个非结构化的网络中使用集中式的控制器实现多台服务器共同对外提供服务。OpenFlow网络中的所有交换机都连接在一个控制器上,每台服务器有两块网卡,一块网卡连接到OpenFlow网络对用户提供网络服务,另一块通过以太网交换机和控制器相连,以便控制器通过SNMP协议获取服务器的运行状态,具体架构如图所示。 在上述负载均衡架构中控制器是网络的核心,其主要功能有四个,分别为: 保证网络正常的通信、获取服务器的运行状态、通过负载均衡算法计算服务器的综合负载、向交换机下发流表项以转发用户请求;控制器的模块设计如图所示。 本文阐述的负载均衡架构可以工作在任意openflow网络中,而不是专门为某个服务器

所设计的负载均衡,控制器的首要任务就是保证网络可以提供正常的数据转发服务,为了保证网络既可以为其他服务提供基础支持又保证负载均衡能够正常工作,在控制器的转发控制中有两个模块,第一个模块负责负载均衡服务,第二个模块负责网络的基本通信。当一个数据包到达Openflow交换机后,如果交换机找不到可以匹配的流表项,就会向控制发送packet-in消息,控制器收到packet-in消息之后首先交给负载均衡模块,由负载均衡模块处理该消息,如果该数据包的目的IP 不是负载均衡所负责的网络服务,如果该数据包的目的IP不是负载均衡所负责的网络服务,负载均衡模块就不会做任何处理而是直接packet-in 消息传递给网络通信模块,以保证其它业务正常通信。如果该数据包的目的IP是负载均衡所负责的网络服务,负载均衡模块就向交换机下发流表项让交换机完成负载均衡服务。 为了有效地利用计算资源,控制器还需要根据服务器的运行状态转发用户请求,因此控制器还要完成这方面的工作。在此架构中每台服务器都有一块通过以太网交换机和控制器相连的网卡,控制器通过以太网交换机和服务器通信,利用SNMP协议获取服务器的运行状态。在此架构中就算没有和服务器相连的网卡,控制器也可以通过Openflow网络和服务器通信,本文之所以没有这么做是因为控制器直接和连接在openflow网络中的服务器通信需要交换机把所有服务器所发送的消息封装成packet-in消息发送给交换机,控制器也必须通过向交换机发送packet-out消息才能把数据发送给服务器,这样做会给交换机和控制器同时带来很大的压力。 因为服务器的运行状态必须由多条信息才能描述清楚,所以就算得到服务器的运行状态之后,也无法根据多条信息判断哪台服务器的负载最低。因此本文在控制器中运行了一个负载均衡算法,控制器会把服务的运行状态作为负载均衡算法的参数代入到服务器综合负载的运算中,计算出服务器的综合负载,并根据综合负载得到负载最小的服务器。 负载均衡的核心内容就是让交换机分发用户的请求,用户请求的第一个数据包到达交换级之后,交换机会通过packet-in消息把数据包发送给控制器,控制器中的负载均衡模块会通过SNMP协议获取所有服务器的运行状态,并根据运行状态计算服务器的综合负载,之后把用户的请求转发给综合负载最小的服务器。 2、动态负载均衡架构的设计与实现 负载均衡常用的算法有随机、轮训和最小连接数,原因是这三种算法很容易用硬件实现,这三种算法中最小连接数算法的效果是最理想的,但是如果集群中的服务器在CPU、内存、网络带宽上的配置不相同,这三个算法都不能充分地发挥服务器集群的计算能力。在openflow网络中,网络的控制层由软件制定,负载均衡算法也可以集成在控制器中,使用软件完成,这样可以更准确地评估服务器的负载情况。本文阐述的负载均衡方案中就设计了一个负载均衡算法,根据服务器的运行状态计算服务器的综合负载,并返回综合负载最小的服务器。该算法可以在服务器性能差距较大的集群中充分发挥每一台服务器的计算能力,算法的具体实现过程如下: 1)动态反馈当前服务器负载量 主要收集每台服务器CPU和内存的使用率,这些信息并不能直接表示一台服务器的负载情况,所以使用公式1把CPU和内存信息转换为服务器的负载量,其中LC为第i台服务器CPU的使用率,LM为第i台内存的使用率,r1和r2为权值,用于强调该服务类型对各个部分的不同影响程度,r1+r2=1,LS为计算得出的第i台服务器负载量 LS=r1LC+r2*LM 2)服务器处理能力计算; 集群中服务器的性能也可能不同,在计算服务器负载的时候还要考虑服务器的处理能力,第i台服务器的处理能力使用C(i)表示,C的计算方法如公式所示,其中P为第i台服务器CPU的个数,M为第i台服务器内存的大小,r1和r2为权值,r1+r2=1。

软件测试工具大全

软件测试工具汇总 一、工具汇总 1.免费工具 下表中针对WEB页面或B/S结构进行功能和性能测试的工具有: 开源功能自动化测试工具:PureTest,OpenSTA,Watir、Selenium、MaxQ、WebInject、Fitnesse 开源性能自动化测试工具:Jmeter、OpenSTA、DBMonster PureTest Minq公司功能测试商业 免费 本是业内商业自动化测试工具之一,如今PureTest已经免费。它专注于对WEB应用程序进行功能自动化测试,并即时对WEB页面元素进行检 测,对HTTP请求、响应进行诊断分析。 PureTest is an application which is primarily used to setup scenarios of tasks, execute and debug them. Even though it supports testing a variety of applications it is especially useful for debugging and snooping of web applications. PureTest includes a HTTP Recorder and Web Crawler which makes it useful for generic verification of HTTP requests and web content checking. The normal way to access web sites is via a browser; however, there are times when it is desirable to bypass the browser and access a site from a program, including: Debugging of HTTP requests and responses Automated web site testing The HTTP Recorder simplifies the process of capturing all requests that are exchanged between a browser and the web server. Then use PureTest to replay each request in order to carefully watch the HTTP data that is transferred on the wire (HTTP headers, request parameters, response headers and response content). The Web Crawler is useful to pro-actively verify the consistence of a static web structure. It reports various metrics, broken links and the structure of the crawled web. Test scenarios that be saved to file and later be repeated, to verify that you server applictaion works as expected. This can be done using the PureTest debugger in the grapical user interface, but also using a command line interface. PureLoad Minq公司负载压力测 试 商业 免费 PureLoad正是一款基于Java开发的网络负压测试工具,它的Script代码 完全使用XML,所以,这些代码的编写很简单,可以测试各种C/S程序, 如SMTP Server等。它的测试报表包含文字和图形并可以输出为HTML 文件。由于是基于Java的软件,所以,可以通过Java Beans API来增强 软件功能。

服务器负载均衡技术

HUAWEI USG6000V系列NFV防火墙技术白皮书之---服务器负载均衡技术白皮书 华为技术有限公司 Huawei Technologies Co., Ltd.

目录 1背景和概述 (2) 2全局服务器负载均衡(GSLB) (3) 3本地服务器负载均衡(LSLB) (4) 3.1使用目的MAC地址转换的服务器负载均衡(DR) (4) 3.2使用网络地址转换实现的服务器负载均衡(L4 SLB) (5) 3.3使用轻量代理和网络地址转换的服务器负载均衡(L4 lwProxy SLB) (7) 3.4使用全量Socket 代理的服务器负载均衡(L7 Socket Proxy SLB) (9) 3.4.1socket代理加业务会话关联保持 (9) 3.4.2根据URL类型不同的分担,静态资源访问和动态计算访问分开多种服务 器10 3.4.3SSL卸载 (10) 3.4.4链路优化:压缩、协议优化、本地cache、多路复用 (11) 3.5业务保持技术 (13) 4华为USG防火墙支持的SLB功能列表 (14)

1 背景和概述 随着互联网的快速发展,用户访问量的快速增长,使得单一的服务器性能已经无法满足大量用户的访问,企业开始通过部署多台服务器来解决性能的问题,由此就产生了服务器负载均衡的相关技术方案。 在实际的服务器负载均衡应用中,由于需要均衡的业务种类以及实际服务器部署场景的不同(比如是否跨地域、跨ISP数据中心等),存在多种负载均衡的技术。如下典型的组网方式如图所示: 服务提供方为了支撑大批量的用户访问,以及跨不同地域、不同接入ISP的用户都能够获得高质量的业务访问体验,其已经在不同地域、不同ISP数据中心搭建了服务器,这样就带来一个需求,也就是客户的访问能够就近、优先选择同一个ISP数据中心的服务器,从而获得高质量的业务访问体验。 同时,基于单台服务器能够提供的业务访问并发是有限的,那么就自然想到使用多台服务器来形成一个“集群”,对外展现出一个业务访问服务器,以满足大量用户访问、而且可以根据业务访问量的上升可以动态的进行业务能力扩容的需要。

Gatling-压力测试工具-实用技术

Gatling实用技术 ----高性能轻量级压力测试工具

文档管理信息表 文档修改记录表

项目背景 开发部门需要压力测试,但依赖QA的压力测试组不够便捷,因为其行动周期较长(业务讲解,计划制定,脚本匹配,文档撰写....),另外QA组使用的工具也比较专业,如果让开发部门自己用也不那么轻便。否能找到一种方法,让开发人员跑一跑压力测试呢(在专业的QA压力测试组介入以前)? 抛弃笨重的Loadrunner和功能有限的JMeter,我们找到了Gatling(格林机炮),一个高性能轻量级的测试工具 本文档适用对象 ?有一定编程基础的开发人员 ?对应用性能有很高要求的开发团队 本文不适合的对象 ?希望所有功能均由图形界面完成的使用者 本文阅读时间 1~2小时,建议分部阅读,中间安排充足的时间实验。

1 Gatling简介 Gatling的Scala基础封装是基于Akka编程的,它是非阻塞异步编程模型,可以高效执行并有极高的容错率。 ?专用web测试。 ?像LR那样录制脚本,不用从零开始。 ?脚本使用scala语言,易懂,易修改,控制灵活。 ?基于JVM,随拷随用。(对比LoadRunner的客户端安装以及JMeter需要XWindow 组件,这个方便很多),操作接近apache的ab。 ?原生支持NIO,并发性能很好,即使性能较差的电脑也能发起很大的负载压力。 ?基于HTML的报表,简单易读。 2 Gatling入门 2.1 准备工作 2.1.1 下载 下载地址:https://https://www.360docs.net/doc/4d9170649.html,/excilys/gatling/wiki/Downloads jdk6对应1.5版本,jdk7以上对应2.0版本。 本文档使用1.5.2版本进行演示。 2.1.2配置环境变量 需要配置好JAVA_HOME和 GATLING_HOME环境变量,后者指向Gatling的根目录。

负载均衡器部署方式和工作原理

负载均衡器部署方式和工作原理 2011/12/16 小柯信息安全 在现阶段企业网中,只要部署WEB应用防火墙,一般能够遇到负载均衡设备,较常见是f5、redware的负载均衡,在负载均衡方面f5、redware的确做得很不错,但是对于我们安全厂家来说,有时候带来了一些小麻烦。昨日的一次割接中,就遇到了国内厂家华夏创新的负载均衡设备,导致昨日割接失败。 在本篇博客中,主要对负载均衡设备做一个介绍,针对其部署方式和工作原理进行总结。 概述 负载均衡(Load Balance) 由于目前现有网络的各个核心部分随着业务量的提高,访问量和数据流量的快速增长,其处理能力和计算强度也相应地增大,使得单一的服务器设备根本无法承担。在此情况下,如果扔掉现有设备去做大量的硬件升级,这样将造成现有资源的浪费,而且如果再面临下一次业务量的提升时,这又将导致再一次硬件升级的高额成本投入,甚至性能再卓越的设备也不能满足当前业务量增长的需求。 负载均衡实现方式分类 1:软件负载均衡技术 该技术适用于一些中小型网站系统,可以满足一般的均衡负载需求。软件负载均衡技术是在一个或多个交互的网络系统中的多台服务器上安装一个或多个相应的负载均衡软件来实现的一种均衡负载技术。软件可以很方便的安装在服务器上,并且实现一定的均衡负载功能。软件负载均衡技术配置简单、操作也方便,最重要的是成本很低。 2:硬件负载均衡技术 由于硬件负载均衡技术需要额外的增加负载均衡器,成本比较高,所以适用于流量高的大型网站系统。不过在现在较有规模的企业网、政府网站,一般来说都会部署有硬件负载均衡设备(原因1.硬件设备更稳定,2.也是合规性达标的目的)硬件负载均衡技术是在多台服务器间安装相应的负载均衡设备,也就是负载均衡器来完成均衡负载技术,与软件负载均衡技术相比,能达到更好的负载均衡效果。 3:本地负载均衡技术

软件测试中负载压力测试主流工具介绍

软件测试中负载压力测试主流工具介绍 从软件性能测试的发展前景来看,对于工具的依赖性会越来越强。可以预见,在不久的将来,专门从事软件性能测试的软件工具会形成一个不小的市场。目前,市场上的性能测试的工具种类已经很多,但从其工作的侧重点上,可以将这些工具简单的划分为以下四种:负载压力测试工具、资源监控工具、故障定位工具以及调优工具。下面主要介绍一下负载压力测试工具。 负载性能测试工具的原理是通过录制、回放脚本、模拟多用户同时访问被测试系统,制造负载,产生并记录各种性能指标,生成分析结果,从而完成性能测试的任务。 目前,主流的负载性能测试工具有: QA Load 这是Compuware公司开发的一套针对客户/服务器系统、企业资源配置(ERP)和电子商务应用的自动化负载测试工具。

QALoad是QACenter性能版的一部分,它通过可重复的、真实的测试能够彻底地度量应用的可扩展性和性能。QACenter汇集完整的跨企业的自动测试产品,专为提高软件质量而设计。QACenter可以在整个开发生命周期、跨越多种平台、自动执行测试任务。 SilkPerformer: 这是一款在工业领域最高级的企业级负载测试工具。不管企业电子商务应用的规模大小及其复杂性,通过SilkPerformer,均可以在部署前预测它的性能。它可以模仿成千上万的用户在多协议和多计算的环境下工作。可视的用户化界面、实时的性能监控和强大的管理报告可以帮助我们迅速的解决问题,可以通过最小的测试周期保证系统的可靠性,优化性能和确保应用的可扩充性。 LoadRunner: 这是由HP公司开发的一款较高规模适应性的,自动负载测试工具。

负载均衡的基础原理说明

大家都知道一台服务器的处理能力,主要受限于服务器自身的可扩展硬件能力。所以,在需要处理大量用户请求的时候,通常都会引入负载均衡器,将多台普通服务器组成一个系统,来完成高并发的请求处理任务。 之前负载均衡只能通过DNS来实现,1996年之后,出现了新的网络负载均衡技术。通过设置虚拟服务地址(IP),将位于同一地域(Region)的多台服务器虚拟成一个高性能、高可用的应用服务池;再根据应用指定的方式,将来自客户端的网络请求分发到

服务器池中。网络负载均衡会检查服务器池中后端服务器的健康状态,自动隔离异常状态的后端服务器,从而解决了单台后端服务器的单点问题,同时提高了应用的整体服务能力。 网络负载均衡主要有硬件与软件两种实现方式,主流负载均衡解决方案中,硬件厂商以F5为代表目前市场占有率超过50%,软件主要为NGINX与LVS。但是,无论硬件或软件实现,都逃不出基于四层交互技术的“转发”或基于七层协议的“代理”这两种方式。四层的转发模式通常性能会更好,但七层的代理模式可以根据更多的信息做到更智能地分发流量。一般大规模应用中,这两种方式会同时存在。 2007年F5提出了ADC(Application delivery controller)的概念为传统的负载均衡器增加了大量的功能,常用的有:SSL卸载、压缩优化和TCP连接优化。NGINX也支持很多ADC的特性,但F5的中高端型号会通过硬件加速卡来实现SSL卸载、压缩优化这一类CPU密集型的操作,从而可以提供更好的性能。 F5推出ADC以后,各种各样的功能有很多,但其实我们最常用的也就几种。这里我也简单的总结了一下,并和LVS、Nginx对比了一下。

软件测试工具选型报告

软件测试工具选型报告软件质量管理平台大盘点 传统的软件质量管理关注在特定的测试活动,例如负载/压力测试、功能/回归测试、缺陷跟踪等,近年来有一个明显的趋势是关注全面的质量管理,质量管理的关注点由“找BUG”转移到确保业务目标和客户需求得以更好地满足。 质量保证部门(QA)需要管理和验证的内容包括: 1、确保业务功能的满足:为了降低后期测试的压力和代价,需要把前期的需求管理做好。 2、项目状态的评估:现在可以发布产品了吗?软件质量状况如何?产品安全性如何? 3、风险评估:对软件的修改、安全性需求的增加的同时,如何控制变更的代价? 质量管理应该包括软件的整个生命周期(ALM),各软件厂商也纷纷推出自己的质量管理平台,它们各有特点,今天我们就来盘点一下这些质量管理平台和工具,希望对企业进行工具选型时能提供一些参考。 AutomatedQA –技术型 AutomatedQA提供了完整的软件质量产品和简单的许可证模型,对于技术型的测试团队而言比较有吸引力。例如其测试工具TestComplete支持多种脚本语言、支持数据驱动测试和对象驱动测试,而且把性能测试、功能测试、单元测试都集成在一起,可谓是“多合一”,而且售价比较低(最低单用户价格$999)。 AutomatedQA在国外有一批忠实的“追随者”,尤其是那些技术型的公司,测试人员大部分是软件工程师类型的,而不是业务分析型的。AutomatedQA主要通过邮件进行售后技术支持。虽然提供培训服务,并且也有多家服务合作伙伴,但是对于企业级用户而言,缺乏完整的技术服务体系结构。 AutomatedQA的产品能很好地整合到微软的Visual Studio Team System产品线中,但是对于Eclipse缺乏类似的整合。提供了版本管理系统的接口,但是缺乏与流行的需求管理工具的整合。对新技术的支持比较及时,例如支持对基于SVG(Scalable Vector Graphics)的用户界面的测试,支持64位的应用程序等。 AutomatedQA的产品线包括: 1、TestComplete –功能测试、负载测试和单元测试自动化工具。 2、AQtime –性能分析工具。单用户价格$599。 3、AQdevTeam –缺陷跟踪和项目管理工具。 4、Automated Build Studio –构建管理工具,能调用各种应用程序进程,例如测试执行。单用户价格$349。

十个免费的压力测试工具

当一套程序写完或者一台服务器配置完成后,相必很多朋友会像我一样,非常想知道它到底能够承受多大的负载压力,那在本文中,就给大家介绍十个免费的可以用来进行Web的负载/压力测试的工具,这样,你就可以知道你的服务器以及你的Web应用能够顶得住多少的并发 当一套程序写完或者一台服务器配置完成后,相必很多朋友会像我一样,非常想知道它到底能够承受多大的负载压力,那在本文中,就给大家介绍十个免费的可以用来进行Web的负载/压力测试的工具,这样,你就可以知道你的服务器以及你的Web应用能够顶得住多少的并发量,以及你的网站的性能。 Grinder Grinder是一个开源的JVM负载测试框架,它通过很多负载注射器来为分布式测试提供了便利。支持用于执行测试脚本的Jython脚本引擎HTTP测试可通过HTTP代理进行管理。根据项目网站的说法,Grinder的主要目标用户是“理解他们所测代码的人——Grinder不仅仅是带有一组相关响应时间的‘黑盒’测试。由于测试过程可以进行编码——而不是简单地脚本化,所以程序员能测试应用中内部的各个层次,而不仅仅是通过用户界面测试响应时间。 Pylot Pylot是一款开源的测试Webservice性能和扩展性的工具,它运行HTTP负载测试,这对容量计划,确定基准点,分析以及系统调优都很有用处。Pylot产生并发负载(HTTPRequests),检验服务器响应,以及产生带有metrics的报表。通过GUI或者shell/console来执行和监视testsuites。

Web Capacity Analysis Tool(WCAT) 这是一种轻量级负载生成实用工具,不仅能够重现对Web服务器(或负载平衡服务器场)的脚本HTTP请求,同时还可以收集性能统计数据供日后分析之用。WCAT是多线程应用程序,并且支持从单个源控制多个负载测试客户端,因此您可以模拟数千个并发用户。该实用工具利用您的旧机器作为测试客户端,其中每个测试客户端又可以产生多个虚拟客户端(最大数量取决于客户端机器的网络适配器和其他硬件)。 您可以选择使用HTTP 1.0还是HTTP 1.1请求,以及是否使用SSL。并且,如果测试方案需要,您还可以使用脚本执行的基本或NTLM身份验证来访问站点的受限部分。(如果您的站点使用cookie、表单或基于会话的身份验证,那您可以创建正确的GET或POST请求来对测试用户进行身份验证。)WCAT还可管理您站点可能设置的任何cookie,所以配置文件和会话信息将永久保存。 fwptt

几种负载均衡策略比较~

PS:Nginx/LVS/HAProxy是目前使用最广泛的三种负载均衡软件,本人都在多个项目中实施过,参考了一些资料,结合自己的一些使用经验,总结一下。 一般对负载均衡的使用是随着网站规模的提升根据不同的阶段来使用不同的技术。具体的应用需求还得具体分析,如果是中小型的Web应用,比如日PV小于1000万,用Nginx就完全可以了;如果机器不少,可以用DNS轮询,LVS所耗费的机器还是比较多的;大型网站或重要的服务,且服务器比较多时,可以考虑用LVS。一种是通过硬件来进行进行,常见的硬件有比较昂贵的F5和Array等商用的负载均衡器,它的优点就是有专业的维护团队来对这些服务进行维护、缺点就是花销太大,所以对于规模较小的网络服务来说暂时还没有需要使用;另外一种就是类似于Nginx/LVS/HAProxy的基于Linux的开源免费的负载均衡软件,这些都是通过软件级别来实现,所以费用非常低廉。 目前关于网站架构一般比较合理流行的架构方案:Web前端采用 Nginx/HAProxy+Keepalived作负载均衡器;后端采用MySQL数据库一主多从和读写分离,采用LVS+Keepalived的架构。当然要根据项目具体需求制定方案。 下面说说各自的特点和适用场合。 一、Nginx Nginx的优点是: 1、工作在网络的7层之上,可以针对http应用做一些分流的策略,比如针对域名、目录结构,它的正则规则比HAProxy更为强大和灵活,这也是它目前广泛流行的主要原因之一,Nginx单凭这点可利用的场合就远多于LVS了。 2、Nginx对网络稳定性的依赖非常小,理论上能ping通就就能进行负载功能,这个也是它的优势之一;相反LVS对网络稳定性依赖比较大,这点本人深有体会; 3、Nginx安装和配置比较简单,测试起来比较方便,它基本能把错误用日志打印出来。LVS的配置、测试就要花比较长的时间了,LVS对网络依赖比较大。 3、可以承担高负载压力且稳定,在硬件不差的情况下一般能支撑几万次的并发量,负载度比LVS相对小些。 4、Nginx可以通过端口检测到服务器内部的故障,比如根据服务器处理网页返回的状态码、超时等等,并且会把返回错误的请求重新提交到另一个节点,不过其中缺点就是不支持url来检测。比如用户正在上传一个文件,而处理该上传的节点刚好在上传过程中出现故障,Nginx会把上传切到另一台服务器重新处理,而LVS就直接断掉了,如果是上传一个很大的文件或者很重要的文件的话,用户可能会因此而不满。 5、Nginx不仅仅是一款优秀的负载均衡器/反向代理软件,它同时也是功能强大的Web应用服务器。LNMP也是近几年非常流行的web架构,在高流量的环境中稳定性也很好。 6、Nginx现在作为Web反向加速缓存越来越成熟了,速度比传统的Squid服务器更快,可以考虑用其作为反向代理加速器。 7、Nginx可作为中层反向代理使用,这一层面Nginx基本上无对手,唯一可以对比

A10服务器负载均衡解决方案解读

1SJ tit works ***** 单位 A10负载均衡解决方案 A10 Networks Inc. 1SJ tit works

目录 1.项目概述 (1) 2.需求分析及讨论 (1) 2.1应用系统所面临的共性问题 (1) 2.2需求分析 (2) 3.A10公司负载均衡解决方案 (3) 3.1网络结构图 (3) 3.2A10负载均衡解决方案 (3) 3.2.1APP Server负载均衡的实现 (4) 3.2.2应用优化的实现 (4) 3.3解决方案说明 (5) 3.4方案的优点 (6) 4.A10 AX的优点及各型号指标总结 (7) 5.A10公司简介 (7) 6.AX介绍 (8) 6.1 A10公司AX简介 (8) AX系列功能 (8)

1. 项目概述 2. 需求分析及讨论 2.1应用系统所面临的共性问题 随着用户量增大及业务的发展,一个应用系统往往会出现各种问题。瓶颈可能出现在服务器、存储、网络设备,带宽等的性能不足,而运行一旦出现故障给业务带来的影响范围是巨大的,服务器可能出现的问题表现为如下几点: ?高可用问题 关健性应用要求7*24稳定运行不被中断,高可用性问题被放在首要位置。 ?利用“不平衡”现象 数据的大集中使得服务器的访问压力日益增大,服务器性能往往会成为一个系统的瓶颈,随着性能问题的产生,单点故障的发生也将比较频繁,为了解决这些问题,传统的方式多为采取更换更好的服务器并且采用双机备份系统提供服务的方式,这样必然存在 一半的资源浪费的情况,而在压力不断上升的情况下,这种动作讲不断的重复,不但服务器的利用率不平衡,而且持续引起投资的浪费。 ?“峰值”问题 服务器的处理多存在“波峰”和“波谷”的变化。而且“波峰”时,业务量大小的变化又不规律,这就使服务器不得不面对“峰值堵塞”问题。原有解决方法为增加服务器或主机数量,提高处理能力。但仍存在性能不平衡问题,且这样做,投资成本大。 ?多米诺”现象 单台服务器的设置,不可避免会出现“单点故障”,需要进行服务器“容错”。为实现容错,往往在主服务器旁安置一台或多台备份服务器。但这样做,平时只有一台服务器工作,其它服务器处于空闲状态,无法完全利用所有服务器的处理资源,当出现“峰值堵塞”时,“多米 诺”效应往往会发生,即所有服务器连续被“堵”至“死”。最终的结果将导致系统的瘫痪。 ?“扩展”不便 随着物理和应用的集中,服务器上所要处理的数据量(traffic )增大,客户交易产生

压力测试工具

10大主流压力测试工具推荐 在移动应用和Web服务正式发布之前,除了进行必要的功能测试和安全测试,为了保证互联网产品的服务交付质量,往往还需要做压力/负载/性能测试。然而很多传统企业在试水互联网+的过程中,往往由于资源或产品迭代速度等原因忽视了这一块工作,导致新产品上线之后频繁出现卡顿等严重影响用户体验的问题。那么互联网产品为什么要进行压力/负载/性能测试,又有哪些工具帮我们实现呢,本文将为您细说端详。 压力/负载/性能测试之异同 在产品研发过程中,常常会混淆压力/负载/性能测试这三者之间的区别,这三种测试到底有什么不同呢? 压力测试(StressTesting),也称为强度测试,通过模拟实际应用的软硬件环境及用户使用过程的系统负荷,长时间或超大负荷地运行测试软件,来测试被测系统的性能、可靠性、稳定性等。压力测试需要确定一个系统的瓶颈或者不能接收的性能点,来获得系统能提供的最大的服务级别。通俗地讲,压力测试是为了发现在什么条件下您的应用程序的性能会变得不可接受。 负载测试(Load Testing)通常被定义为给被测系统加上它所能操作的最大任务数的过程,负载测试有时也会被称为“容量测试”或者“耐久性测试/持久性测试”,其目标是确定并确保系统在超出最大预期工作量的情况下仍能正常运行。对于WEB应用来讲,负载则是并发用户或者HTTP连接的数量。负载测试通过测试系统在资源超负荷情况下的表现,以发现设计上的错误或验证系统的负载能力。在这种测试中,将使测试对象承担不同的工作量,以评测和评估测试对象在不同工作量条件下的性能行为,以及持续正常运行的能力。

性能测试(PerformanceTesting)的目的不是去找系统Bugs,而是排除系统的性能瓶颈,并为回归测试建立一个基准。而性能测试的操作,实际上就是一个非常小心受控的测量分析过程:“运行负载试验->测度性能->调试系统”。在理想的情况下,被测应用在这个时候已经是足够稳定,所以这个过程得以顺利进行。性能测试还有另一个目标就是建立一组被测系统的基准数据。应用在网络上的性能测试重点是利用成熟先进的自动化技术进行网络应用性能监控、网络应用性能分析和网络预测。 虽然三种测试的目的截然不同,但其测试操作的环节都是基本一致的,因此一次测试过程中完全可以包含性能测试、负载测试、压力测试三个方面的内容,所使用的测试工具往往大同小异。 10大主流压力/负载/性能测试工具推荐 市面上流行的压力/负载/性能测试工具多是来自国外,同时由于开发的目的和侧重点不同,其功能也有很大差异,下面就为您简单介绍10款目前最常见的测试产品。 1 LoadRunner LoadRunner是一种预测系统行为和性能的负载测试工具,通过模拟实际用户的操作行为进行实时性能监测,来帮助测试人员更快的查找和发现问题。LoadRunner适用于各种体系架构,能支持广泛的协议和技术,为测试提供特殊的解决方案。企业通过LoadRunner 能最大限度地缩短测试时间,优化性能并加速应用系统的发布周期。 LoadRunner提供了3大主要功能模块:VirtualUser Generator(用于录制性能测试脚本),LoadRunner Controller(用于创建、运行和监控场景),LoadRunner Analysis(用于分析性能测试结果)既可以作为独立的工具完成各自的功能,又可以作为LoadRunner的一部分彼此衔接,与其他模块共同完成软件性能的整体测试。

服务器负载均衡三种部署方式典型配置..

目录 服务器负载均衡三种部署方式典型配置 (2) 【应用场景】 (2) 【工作原理】 (2) 【三种方式的典型配置方法】 (3) 一、服务器负载均衡NA T模式配置 (3) 1、配置拓扑 (3) 2、拓扑说明 (3) 3、设备配置及说明 (4) 二、服务器负载均衡DR模式配置 (16) 1、配置拓扑 (16) 2、拓扑说明 (16) 3、设备配置及说明 (16) 三、服务器负载均衡NA T模式旁路部署配置 (23) 1、配置拓扑 (23) 2、拓扑说明 (23) 3、设备配置及说明 (23)

服务器负载均衡三种部署方式典型配置 服务器负载均衡部署方式可以分为三种方式:网络地址转换模式(NAT)、直接路由(DR)模式、NAT模式旁路部署。 【应用场景】 1、NA T模式应用场景:用户允许修改网络拓扑结构,此模式同时可以实现加速和流控的功 能。 2、DR模式应用场景:用户不允许修改网络拓扑结构,但是此模式配置需要修改服务器配 置。 3、NA T模式旁路模式应用场景:用户既不允许修改网络拓扑结构,也不允许修改服务器配 置。 【工作原理】 1、NAT模式:负载均衡设备分发服务请求时,进行目的IP地址转换(目的IP地址为实服务的IP),通过路由将报文转发给各个实服务。 客户端将到虚拟IP的请求发送给服务器群前端的负载均衡设备,负载均衡设备上的虚服务接收客户端请求,依次根据持续性功能、调度算法,选择真实服务器,再通过网络地址转换,用真实服务器地址重写请求报文的目标地址后,将请求发送给选定的真实服务器;真实服务器的响应报文通过负载均衡设备时,报文的源地址被还原为虚服务的虚拟IP,再返回给客户,完成整个负载调度过程。 2、DR模式:负载均衡设备分发服务请求时,不改变目的IP地址,而将报文的目的MAC 替换为实服务的MAC后直接把报文转发给实服务。 DR方式的服务器负载均衡时,除了负载均衡设备上配置了虚拟IP,真实服务器也都配置了虚拟IP,真实服务器配置的虚拟IP要求不能响应ARP请求。实服务除了虚拟IP,还需要配置一个真实IP,用于和负载均衡设备通信,负载均衡设备和真实服务器在同一个链路域内。发送给虚拟IP的报文,由负载均衡设备分发给相应的真实服务器,从真实服务器返回给客户端的报文直接通过交换机返回。

负载均衡软件实现与硬件实现方案

该文档是word2003—word2007兼容版 软件、硬件负载均衡部署方案 目录 1、硬件负载均衡之F5部署方案 (2) 1.1网络拓扑结构 (2) 1.2反向代理部署方式 (3) 2软件负载均衡方案 (4) 2.1负载均衡软件实现方式之一- URL重定向方式 (4) 2.2负载均衡软件实现方式之二- 基于DNS (5) 2.3负载均衡软件实现方式之三- LVS (8) 2.4负载均衡软件实现方式之四- 专业负载均衡软件 (16) 总结: (16)

1、硬件负载均衡之F5部署方案 对于所有的对外服务的服务器,均可以在BIG-IP上配置Virtual Server实现负载均衡,同时BIG-IP可持续检查服务器的健康状态,一旦发现故障服务器,则将其从负载均衡组中摘除。 BIG-IP利用虚拟IP地址(VIP由IP地址和TCP/UDP应用的端口组成,它是一个地址)来为用户的一个或多个目标服务器(称为节点:目标服务器的IP地址和TCP/UDP应用的端口组成,它可以是internet的私网地址)提供服务。因此,它能够为大量的基于TCP/IP的网络应用提供服务器负载均衡服务。根据服务类型不同分别定义服务器群组,可以根据不同服务端口将流量导向到相应的服务器。BIG-IP连续地对目标服务器进行L4到L7合理性检查,当用户通过VIP请求目标服务器服务时,BIG-IP根椐目标服务器之间性能和网络健康情况,选择性能最佳的服务器响应用户的请求。如果能够充分利用所有的服务器资源,将所有流量均衡的分配到各个服务器,我们就可以有效地避免“不平衡”现象的发生。 利用UIE+iRules可以将TCP/UDP数据包打开,并搜索其中的特征数据,之后根据搜索到的特征数据作相应的规则处理。因此可以根据用户访问内容的不同将流量导向到相应的服务器,例如:根据用户访问请求的URL将流量导向到相应的服务器。 1.1网络拓扑结构 网络拓扑结构如图所示:

5类软件测试工具

目前主流的测试工具主要有以下5类: 1.负载压力测试工具 这类测试工具的主要目的是度量应用系统的可扩展性和性能,是一种预测系统行为和性能的自动化测试工具。在实施并发负载过程中,通过实时性能监测来确认和查找问题,并针对所发现问题对系统性能进行优化,确保应用的成功部署。负载压力测试工具能够对整个企业架构进行测试,通过这些测试,企业能最大限度地缩短测试时间,优化性能和加速应用系统的发布周期。 2.功能测试工具 通过自动录制、检测和回放用户的应用操作,将被测系统的输出记录同预先给定的标准结果比较,功能测试工具能够有效地帮助测试人员对复杂的企业级应用的不同发布版本的功能进行测试,提高测试人员的工作效率和质量。其主要目的是检测应用程序是否能够到预期的功能并正常运行。 3.白盒测试工具 白盒测试工具一般是针对代码进行测试,测试中发现的缺陷可以定位到代码级。根据测试工具原理的不同,又可以分为静态测试工具和动态测试工具。静态测试工具直接对代码进行分析,不需要运行代码,也不需要对代码编译链接和生成可执行文件。静态测试工具一般是对代码进行语法扫描,找出不符合编码规范的地方,根据某种质量模型评价代码的质量,生成系统的调用关系图等。动态测试工具一般采用“插桩”的方式,在代码生成的可执行文件中插入一些监测代码,用来统计程序运行时的数据。它与静态测试工具最大的不同是,动态测试工具要求被测系统实际运行。 4.测试管理工具 一般而言,测试管理工具对测试需求、测试计划、测试用例、测试实施进行管理,并且测试管理工具还包括对缺陷的跟踪管理。测试管理工具能让测试人员、开发人员或其他的IT 人员通过一个中央数据仓库,在不同地方就能交互信息。 5.测试辅助工具 这些工具本身并不执行测试,例如它们可以生成测试数据,为测试提供数据准备。 参加完“2005年IT测试技术研讨会”以后,谢常君对软件测试和网络测试的主流厂商和产品有了更全面的了解。不过最让他高兴的是结识了一批企业的代表和专家。 一个阳光明媚的下午,谢常君约上某位专家在一个咖啡馆会面。“非常谢谢你能前来,我这次约你出来是希望你可以给我一些专业的建议。”谢常君说,“我们公司近期可能需要采购一些测试工具,但是我们对此了解不多,希望你可以帮我们。”接下来,这位专家就首先从测试工具的分类开始讲起…… IT测试工具集锦 Radview TestView系列 Radview公司的TestView系列Web性能测试工具和WebLoad Analyzer性能分析工具,旨在测试Web应用和Web服务的功能、性能、程序漏洞、兼容性、稳定性和抗攻击性,并且能够在测试的同时分析问题原因和定位故障点。 整套Web性能测试和分析工具包含两个相对独立的子系统:Web性能测试子系统Web 性能分析子系统。其中Web性能测试子系统包含3个模块:TestView Manager、WebFT以及WebLoad。Web性能分析子系统只有WebLoad Analyzer。 左图表达了在一个完整的测试系统中,TestView Manager用来定制、管理各种测试活动;WebLoad模拟多个用户行为进行测试,所测试的是系统性能,容量,稳定性和抗攻击性;

Web_Application_Stress_Tool(WAS,Web应用负载测试工具)详细说明

Web Application Stress Tool(WAS,Web应用负载测试工具)详细说明https://www.360docs.net/doc/4d9170649.html,/view/cc84fb84b9d528ea81c779ca.html 百度文库:lindazhao1234 pswd:linda_123 你的Web服务器能够支持多少个并发用户的访问呢?你遇到过服务器遭受过DD OS的攻击而瘫痪吗?在这里给大家介绍微软网站测试人员开发的著名网站压力测试软件,Microsoft的Web Application Stress Tool(WAS,Web应用负载测试工具),而且还是免费的哦。 其下载地址:https://www.360docs.net/doc/4d9170649.html,/download/a/8/2/a82e7ba7-c772-4ec4-b186-2cf147f42 c11/setup.exe WAS是一款网站性能测试评估软件。它通过模拟大量并发用户同时访问服务器,以获取服务器的承受能力。像这种软件是把“双刃剑”,就看你用在哪一方面啦。如果没用好就会给你的服务器造成一定的损失,用好了可以及时的发现你的服务器能承受多大压力负载。以便及时的采取相应的措施防范。 要对网站进行负载测试首先需要创建WAS脚本来模拟用户访问等活动。 创建脚本的方法: 通过记录浏览器的活动; 通过导入IIS日志; 通过把WAS指向Web网站的内容; 或者手工制作。 这里我用是通过记录浏览器事件生成的脚本的一部分, 一:测试前的准备 1.在测试前清空IE浏览器其它网站的缓存和Cookies等临时文件。

二:测试脚本制作 1.打开WAS,点击Record 2.勾选要记录的活动

服务器网络负载均衡实施方案

服务器网络负载均衡实施方案 一、技术方案 使用Windows Server 2003 网络负载平衡技术,可以实现WWW等诸多系统服务的负载平衡功能。 网络负载均衡是由多台服务器以对称的方式组成一个服务器集合,每台服务器都具有等价的地位,都可以单独对外提供服务而无须其他服务器的辅助。通过某种负载分担技术,将外部发送来的请求均匀分配到对称结构中的某一台服务器上,而接收到请求的服务器独立地回应客户的请求。均衡负载能够平均分配客户请求到服务器列阵,籍此提供快速获取重要数据,解决大量并发访问服务问题。 二、配置要求 1.服务器需要安装双网卡,一块用于负载平衡,一块用于服务器内部通讯。 2.用于集群的服务器,系统管理员密码最好一致,以免引起不必要的麻烦。 3.将网络属性中,不必要的协议都去掉,只保留TCP/IP 和Microsoft 的协议。 4.两台服务器的应用程序用IIS发布。 三、实施步骤 准备两台应用服务器,并配上两个IP地址,在其中一台服务器设置新建群集,步骤如下:1.点击开始→程序→管理工具→网络负载平衡管理器,如下图所示: 2.选择网络负载平衡集群→鼠标右键→新建集群,如下图所示: 3. 配置群集参数 IP 地址: 指对外提供服务的虚拟IP地址。 完整的Internet名:指对外服务的域名,最好和真实环境配置一致。 其余的保持默认设置,如下图示例:

4. 本例中的集群对外只提供一个服务IP地址,所以“附加群集IP地址”不需要再添加,如下图示例: 5.端口规则中,默认是允许所有的TCP,UDP,如下图所示: 6. 本例中,我们只希望实现80端口的集群,我们可以编辑规则,如下图示例: