双机集群的实施与维护(信产部IBM小型机)

一、HACMP 双机系统配置计划

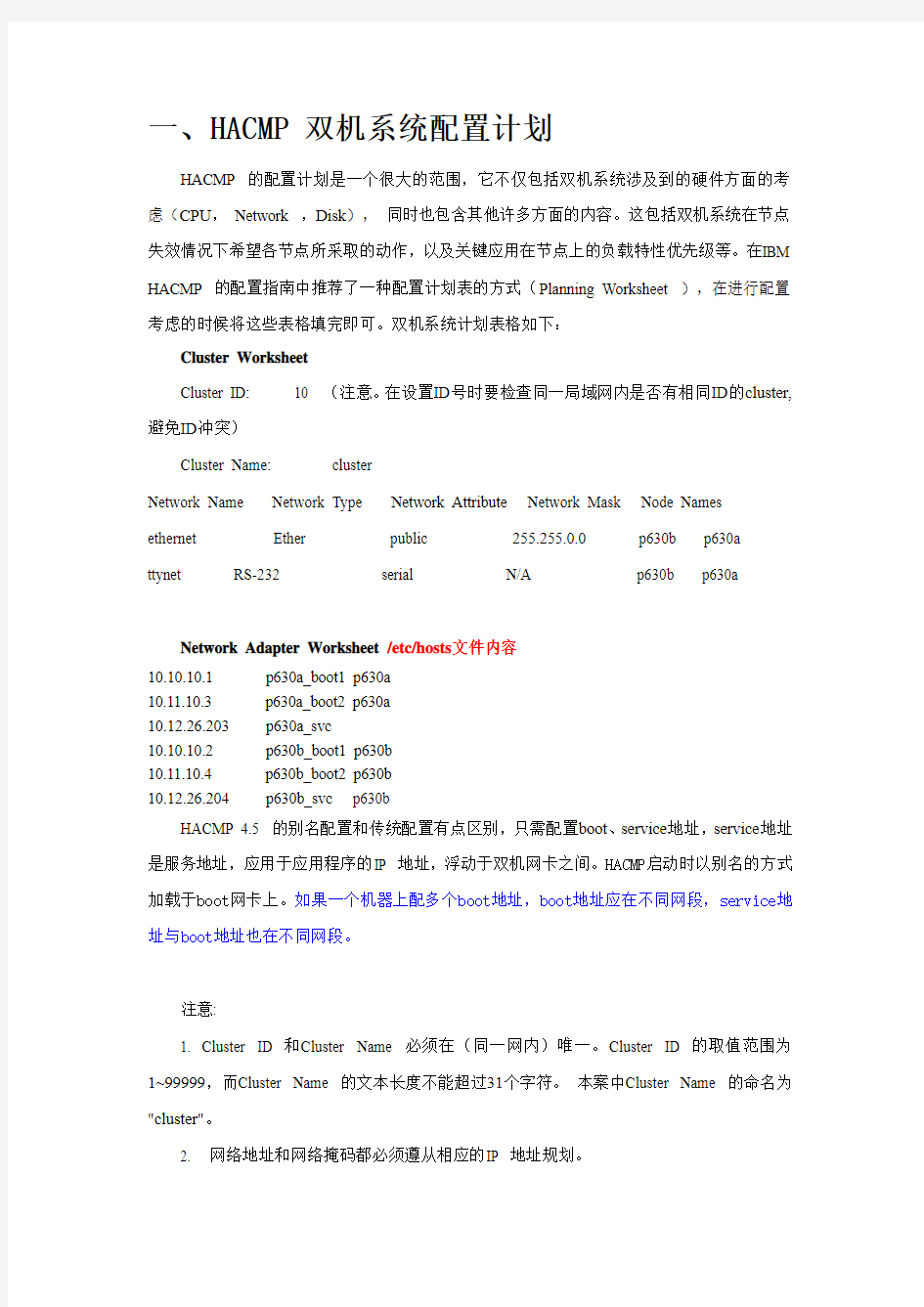

HACMP 的配置计划是一个很大的范围,它不仅包括双机系统涉及到的硬件方面的考虑(CPU,Network ,Disk),同时也包含其他许多方面的内容。这包括双机系统在节点失效情况下希望各节点所采取的动作,以及关键应用在节点上的负载特性优先级等。在IBM HACMP 的配置指南中推荐了一种配置计划表的方式(Planning Worksheet ),在进行配置考虑的时候将这些表格填完即可。双机系统计划表格如下:

Cluster Worksheet

Cluster ID: 10 (注意。在设置ID号时要检查同一局域网内是否有相同ID的cluster,避免ID冲突)

Cluster Name: cluster

Network Name Network Type Network Attribute Network Mask Node Names ethernet Ether public 255.255.0.0 p630b p630a ttynet RS-232 serial N/A p630b p630a

Network Adapter Worksheet /etc/hosts文件内容

10.10.10.1 p630a_boot1 p630a

10.11.10.3 p630a_boot2 p630a

10.12.26.203 p630a_svc

10.10.10.2 p630b_boot1 p630b

10.11.10.4 p630b_boot2 p630b

10.12.26.204 p630b_svc p630b

HACMP 4.5 的别名配置和传统配置有点区别,只需配置boot、service地址,service地址是服务地址,应用于应用程序的IP 地址,浮动于双机网卡之间。HACMP启动时以别名的方式加载于boot网卡上。如果一个机器上配多个boot地址,boot地址应在不同网段,service地址与boot地址也在不同网段。

注意:

1. Cluster ID 和Cluster Name 必须在(同一网内)唯一。Cluster ID 的取值范围为1~99999,而Cluster Name 的文本长度不能超过31个字符。本案中Cluster Name 的命名为"cluster"。

2. 网络地址和网络掩码都必须遵从相应的IP 地址规划。

磁盘阵列上卷组和文件系统的划分表格就省略了,因为它们对双机系统的拓扑结构没有任何影响。

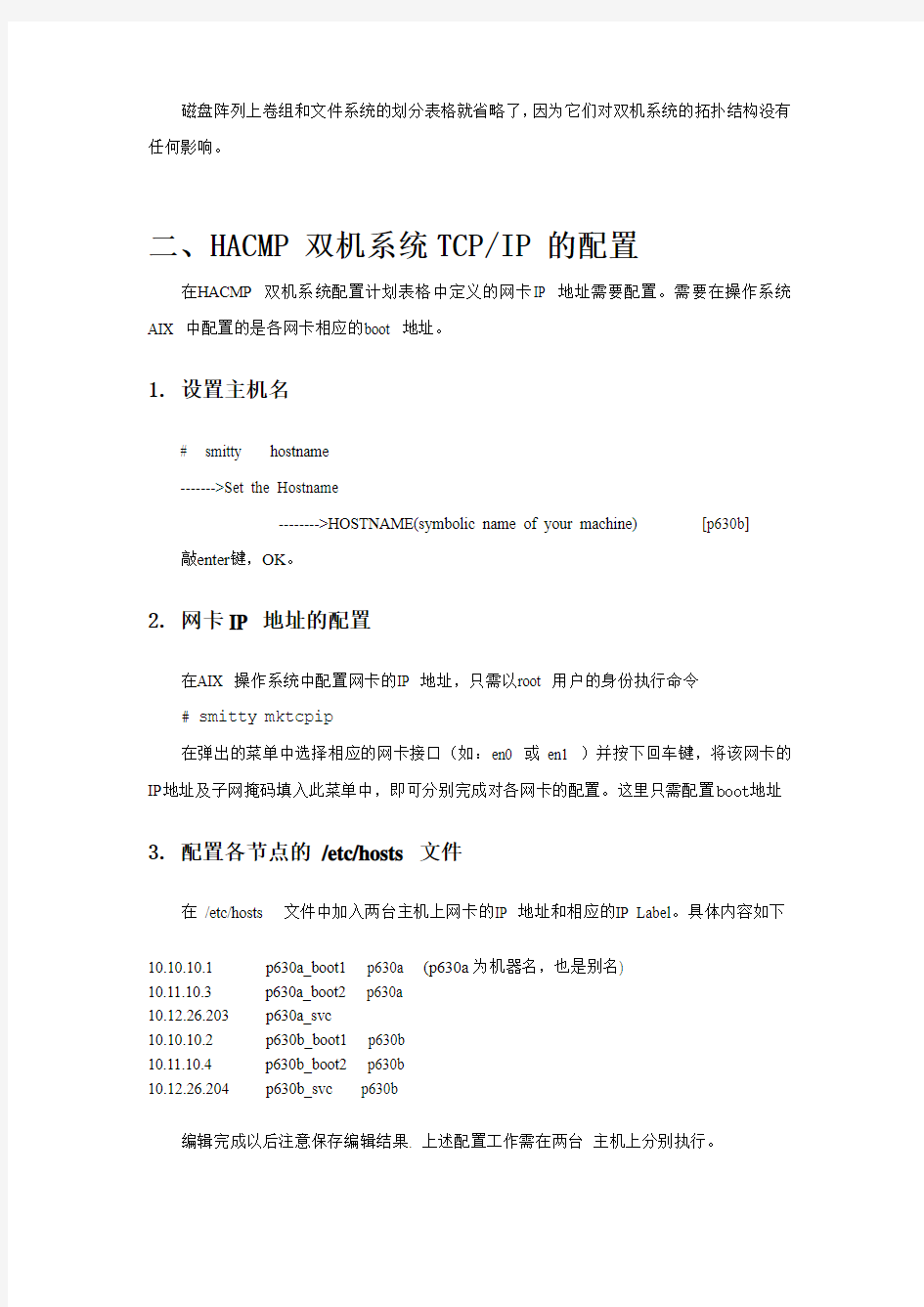

二、HACMP 双机系统TCP/IP 的配置

在HACMP 双机系统配置计划表格中定义的网卡IP 地址需要配置。需要在操作系统AIX 中配置的是各网卡相应的boot 地址。

1. 设置主机名

# smitty hostname

------->Set the Hostname

-------->HOSTNAME(symbolic name of your machine) [p630b] 敲enter键,OK。

2. 网卡IP 地址的配置

在AIX 操作系统中配置网卡的IP 地址,只需以root 用户的身份执行命令

# smitty mktcpip

在弹出的菜单中选择相应的网卡接口(如:en0 或en1 )并按下回车键,将该网卡的IP地址及子网掩码填入此菜单中,即可分别完成对各网卡的配置。这里只需配置boot地址

3. 配置各节点的/etc/hosts 文件

在/etc/hosts 文件中加入两台主机上网卡的IP 地址和相应的IP Label。具体内容如下

10.10.10.1 p630a_boot1 p630a (p630a为机器名,也是别名)

10.11.10.3 p630a_boot2 p630a

10.12.26.203 p630a_svc

10.10.10.2 p630b_boot1 p630b

10.11.10.4 p630b_boot2 p630b

10.12.26.204 p630b_svc p630b

编辑完成以后注意保存编辑结果. 上述配置工作需在两台主机上分别执行。

4. 编辑各节点的/.rhosts 文件

把两个节点配置成相互信任的主机,即在两台机器上分别编辑/.rhosts 文件,内容如下:

p630a_boot1

p630a_boot2

p630a_svc

p630b_boot1

p630b_boot2

p630b_svc

完成后可用rlogin 命令检测/.rhosts 文件是否生效(使用rlogin 登陆对方机器时不需使用password)。

5. 检查网络配置的正确性

用ping 命令检查各定义的网卡的连通性,直到所有的网卡都是连通的才做下一步的操作。

配置tty 设备

1. 检查tty设备是否已经配置

若没有配置则使用下列菜单定义tty 设备:

smitty tty

---> Add a TTY

选择tty 类型(rs232) 并按下回车键,选择串口设备“s3”并按下回车键(最好不要用S1

口),在此菜单中填写Port Number [0 ]

将光标移至此字段,按下

2. 检查串口通信的连通性(把串口线连在相应的串口)

在p630a 上使用命令

# cat < /dev/tty0

在p630b 上使用命令

# cat /etc/hosts > /dev/tty0

观察p630a 上显示的数据是否正确并确保没有乱码。

6.定义卷组

创建卷组datavg,注意要把auto varyonvg选项关闭。并在另一台机器上importvg 该配置(把vg的ID号设成一样)。

三、HACMP 双机系统软件的安装

在两台主机上分别安装HACMP 软件。

1、将HACMP安装盘放入CD-ROM,安装HACMP 软件包及其patch

smitty installp

--> Install and Update from LATEST Available Software

按下

Cluster.adt.es

Cluster.es.clvm (concurrent)

Cluster.es.cspoc

Cluster.es.plugins

Cluster.license

在安装菜单中设置选项Accept new license agreements 为YES.

2.安装HACMP 的补丁

用Smitty installp . (在https://https://www.360docs.net/doc/7d10513997.html,/server/aix.fixdist

网址可下载),安装方法和HACMP软件一样(如果对补丁没有把握,将在安装菜单中commit选项设为NO);

也可用smitty update_all命令安装补丁.

HACMP软件安装好以后要重启机器。

# shutdown –Fr

四、HACMP的配置

一、定义群组拓扑结构(Cluster Topology)

选择其中一个节点完成下列步骤。假设我们选择节点p630b 完成下列操作。

1、配置双机拓扑结构(Cluster Topology)

a、进入Cluster Topology 配置主菜单

smitty hacmp

--> Cluster Configuration

--> Cluster Topology

即可看见双机拓扑配置主菜单。

b、定义Cluster (Cofigure Cluster)

选择Configure Cluster --> Add a Cluster Definition

对Cluster ID 域填入10

对Cluster Name 域填入cluster

回车,系统执行命令。然后按

c、定义构成Cluster 的节点(Configure Nodes)

选择Configure Nodes --> Add Cluster Nodes

在Node Names 域填入p630a p630b(中间用空格分开)

回车,系统执行命令,.然后按

d、定义Cluster中网卡(Configure Adapter)

配置boot地址

选择Configure Networks

------> Configure IP-based Networks

------->Add initial interface

敲enter, OK;F3回到上一个菜单.

IP Label p630b_boot1

Network Name ethernet

Network Attribute public

Network Type 敲F4选择ether

Node name p630b 或敲F4选择p630b

同样的方法定义p630b_boot2,p630a_boot1,p630a_boot2. 配置service地址

选择Configure Networks

------> Configure IP-based Networks

------->Add Mutiple Service IP label to a network

敲enter, OK;F3回到上一个菜单.

同样的方法定义p630a_svc.

更改service网卡的属性

选择Configure Networks

------> Configure IP-based Networks

------->Change / Show an IP-based Adapter

主要修改service网卡的节点属性,在node name域选入p630b,同样方法改p630a_svc属性为p630a.

配置串口

Configure Non IP-based Networks

-------> Add a Non IP-based Adapter

Adapter Label p650b_tty

Network Nme ttynet

Device name /dev/tty0

Node Name p630b

Network Type 敲F4选择rs232

回车,系统执行命令,.然后按

同样定义p650a_tty

e、检查Cluster Topology 定义是否正确

选择Show Cluster Topology,在其子菜单下有很多可以查看的方式,这里不一一细述。

f、同步群组中各节点上的拓扑定义

选择Synchronize Cluster Topology

对Ignore Cluster Verification Errors? 域选择no

对Emulate or Actual? 域选择Actual

回车,系统执行命令。观察系统在同步的过程中是否出现错误。若有错误则仔细检查配置步骤。若没有错误则表明Cluster Topology 已配置成功,然后退回到Cluster Configuration 配置主菜单。

二、配置资源(Cluster Resource Group)

1. 定义资源组 "dbres"

创建资源组:

选择Define Resource Groups

---> Add a Resource Group

并按下

1)依次填写下列字段:

Resource Group Name [dbres]

Node Relationship [cascading]

Participating Node Names [p630a p630b]

2)按下

3)按下

2. 定义application server "dbapp"

a、选择Cluster Resources > Define Application Servers > Add an Application Serve r

b、依次填写下列字段:

Server Name [dbapp]

Start Script [/etc/StartSybase]

Stop Script [/etc/StopSybase]

c、按下

d、按下

3. 定义Application Monitor (根据需要而定,可以不定义)

本案使用"Custom Application Monitor" 对应用系统进行监测(前提:/home/cluster/monitor.sh 文件已编辑正确)。具体配置方法如下:

选择Configure Application Monitoring

---> Define Custom Application Monitor

---> Add Custom Application Monitor 选择"-RG"后按下

Application Server Name dbapp

Monitor Method [/home/cluster/monitor.sh]

Monitor Interval [30]

Hung Monitor Signal [9]

Stabilization Interval [180]

Restart Count [0]

Restart Interval [0]

Action on Application Failure [fallover]

Notify Method []

Cleanup Method [/etc/StopSybase]

Restart Method [/etc/StartSybase]

按下

按下

4. 定义资源组中的资源

1)选择Define Resource Groups

--> Change/Show Resources/Attributes for a Resource Group

2)从显示的资源组中选择要配置的资源组(RG)

3)在随后显示的菜单中依次填入:

Service IP Label [p630b_svc]

Volume Groups [datavg bkvg]

Application Servers [dbapp]

其它各字段取其默认值。

4)按下

5)按下

5. 同步资源组

与同步Cluster 拓扑结构相同,在Cluster Resources主菜单中选择

Synchronize Cluster Resources

按下

至此,IBM HAESCRM全部安装配置完毕,oracle数据库和应用软件安装配置正确完成,则启动HA系统即可对外提供服务;并且可以对HACMP双机系统进行一系列功能和性能验证测试。

五、IBM HACMP 双机系统的管理和维护

本节将说明HACMP 双机软件的一些基本管理和维护命令。这些命令将会在HACMP 双机系统的日常工作中经常用到。

1. HACMP 双机系统的启动

要启动HACMP 双机系统,必须要有root 用户的权限分别进入到Cluster 各节点主机。在命令行上执行下述命令即可:

# smit clstart

或

# /usr/sbin/cluster/etc/rc.cluster -boot -N -i

需要注意的是在双机系统中,HACMP 双机软件先启动的节点将成为主节点拥有资源,并对外提供关键服务,后启动的节点将成为备节点。

Oracle 和应用系统作为群集系统资源组的一部分将随HACMP 自动启动(/home/cluster/start.sh中定义)。

2. HACMP 双机系统的关闭

要关闭某节点上的HACMP 双机软件,必须要有该节点root 用户的权限。以root 用户进入到该节点主机,在命令行上执行下述命令即可:

# smit clstop

或

# clstop -gr

需要注意的是若该节点是主节点,并且备节点上的HACMP 软件亦正常运行,则需注意clstop 关闭模式的三种选项的不同:

a、forced 是指立即关闭双机软件,不调用任何客户应用的善后处理例程,不释放资源。

b、graceful 是指在关闭双机软件时,将调用客户应用预定义的善后处理例程,释放资源。

c、takeover 是指该节点将关闭双机软件并释放资源,请求备节点进行接管。如该节点是备节点,则此关闭模式选项没有多大意义。

另外,关闭HACMP 将自动关闭应用和Oracle 数据库(/home/cluster/stop.sh中定义)。

3. 查询HACMP 双机系统的状态

在双机系统的运行过程中管理员经常需要知道双机系统的当前状态,才有可能对双机系统出现的异常情况进行恢复处理,以保证双机系统的高可用性和高容错性。查询HACMP 双机系统的状态,只需以root 用户进入需要查询的节点,进行下列操作:

首先检查HACMP 双机软件在该节点是否已启动。命令如下:

# lssrc -g cluster

若是系统显示出下面类似的信息,则说明HACMP 双机软件已正常启动:Subsystem Group PID Status

clstrmgrES cluster 22500 active

clsmuxpdES cluster 23674 active

clinfoES cluster 28674 active

在已确认双机软件HACMP 正常启动的情况下,在命令行执行下述命令来察看双机系统的当前状态:

# /usr/sbin/cluster/clstat -a

如果双机系统一切工作正常,则系统将显示下述类似信息:

clstat - HACMP for AIX Cluster Status Monitor

-------------------------------------------------------------------

Cluster: cluster_shenzhen(100) Thu Jan 20 08:45:17 TAIST 2000 State: UP Nodes: 2

SubState: STABLE

Node: p630a State: UP

Interface: service_ip(0) Address: 10.1.1.10

State: UP

Interface: p630a_tty(0) Address: 0.0.0.0

State: UP

Node: p630b State: UP

Interface: p630b_boot(0) Address: 10.1.1.2

State: UP

Interface: p630b_tty(0) Address: 0.0.0.0

State: UP

# /usr/sbin/cluster/clfindres (看系统双机资源状态)

#/usr/es/sbin/cluster/utilities/clshowres -n'p630b' (看系统双机资源配置一个节点情况)

#/usr/es/sbin/cluster/utilities/clshowres -g'appres' (看系统双机资源配置一个资源情组配置)#clshowres

Resource Group Name dbres

Node Relationship cascading

Site Relationship ignore

Participating Node Name(s) p630b p630a

Node Priority

Service IP Label p630b_svc

Filesystems ALL

Filesystems Consistency Check fsck

Filesystems Recovery Method sequential

Filesystems/Directories to be exported

Filesystems to be NFS mounted

Network For NFS Mount

V olume Groups datavg

Concurrent Volume Groups

Disks

GMD Replicated Resources

PPRC Replicated Resources

AIX Connections Services

AIX Fast Connect Services

Shared Tape Resources

Application Servers dbapp

Highly Available Communication Links

Primary Workload Manager Class

Secondary Workload Manager Class

Miscellaneous Data

Automatically Import V olume Groups false

Inactive Takeover false

Cascading Without Fallback false

SSA Disk Fencing false

Filesystems mounted before IP configured false

Run Time Parameters:

Node Name p630b Debug Level high Format for hacmp.out Standard

Node Name p630a Debug Level high Format for hacmp.out Standard Resource Group Name appres Node Relationship cascading Site Relationship ignore Participating Node Name(s) p630a p630b Node Priority

Service IP Label p630a_svc Filesystems ALL Filesystems Consistency Check fsck Filesystems Recovery Method sequential Filesystems/Directories to be exported

Filesystems to be NFS mounted

Network For NFS Mount

V olume Groups frontvg bkvg Concurrent Volume Groups

Disks

GMD Replicated Resources

PPRC Replicated Resources

AIX Connections Services

AIX Fast Connect Services

Shared Tape Resources

Application Servers

Highly Available Communication Links

Primary Workload Manager Class

Secondary Workload Manager Class

Miscellaneous Data

Automatically Import V olume Groups false

Inactive Takeover false Cascading Without Fallback false

SSA Disk Fencing false Filesystems mounted before IP configured false

Run Time Parameters:

Node Name p630a Debug Level high Format for hacmp.out Standard

Node Name p630b

Debug Level high

Format for hacmp.out Standard

4. 备份HACMP 双机系统的配置

#smitty hacmp

--> Cluster Configuration

--> Cluster snapshot

在cluster Snapshot Name 中键入保存的文件名(可任取),如ss7_cluster;

在cluster Snapshot Description 中键入描述内容(可任取),如ss7 cluster config。

配置文件会保存在/user/es/sbin/cluster/snapshot/ 目录。备份的文件可用来做配置恢复。

保存*.odm *.info

5. 网卡接管功能测试

在HACMP正常启动状态下,任意节点上拔去主用网卡的网线,或执行命令

# ifconfig en0 down en0为主用网卡

HA将启动主备网卡切换脚本Swap_adapter, 并完成主备网卡间的IP地址切换,可以通过执行命令

#netstat -i

重新插入网线,HA将执行join_standby脚本,但不再执行主备网卡IP地址切换。

5. 节点间资源接管功能测试

a、在HACMP正常启动状态下,主节点上同时拔去主备用网卡的网线,或执行命令

# ifconfig en0 down e n0为备用网卡

# ifconfig en1 down e n1为主用网卡

b、在HACMP正常启动状态下,主节点上执行

# smitty clstop

选择Shutdown mode 为takeover方式

c、在HACMP正常启动状态下,主节点上拔去其电源线,系统将掉点关机。

以上三种情况下,HA都将执行节点间共享资源组的接管,在备用机上执行事件前后的状态如下:

# netstat –i (监测网卡配置状态)

#lsvg -o

rootvg

切换后

# netstat -i

# lsvg -o

rootvg

datavg

6. monitor检控功能验证

本案中配置了双机检控应用功能(/home/cluster/monitor.sh),对应用、数据库和HA的状态进行检控。在HA双机正常启动时,主用机上关闭oracle数据库进程、运行switchflag进程或HA进程等,HA将依据Monitor.sh所定义的运行规范进行双机资源组的切换。在备用机上采用同样方法检控到的现象与节点间资源接管类似。