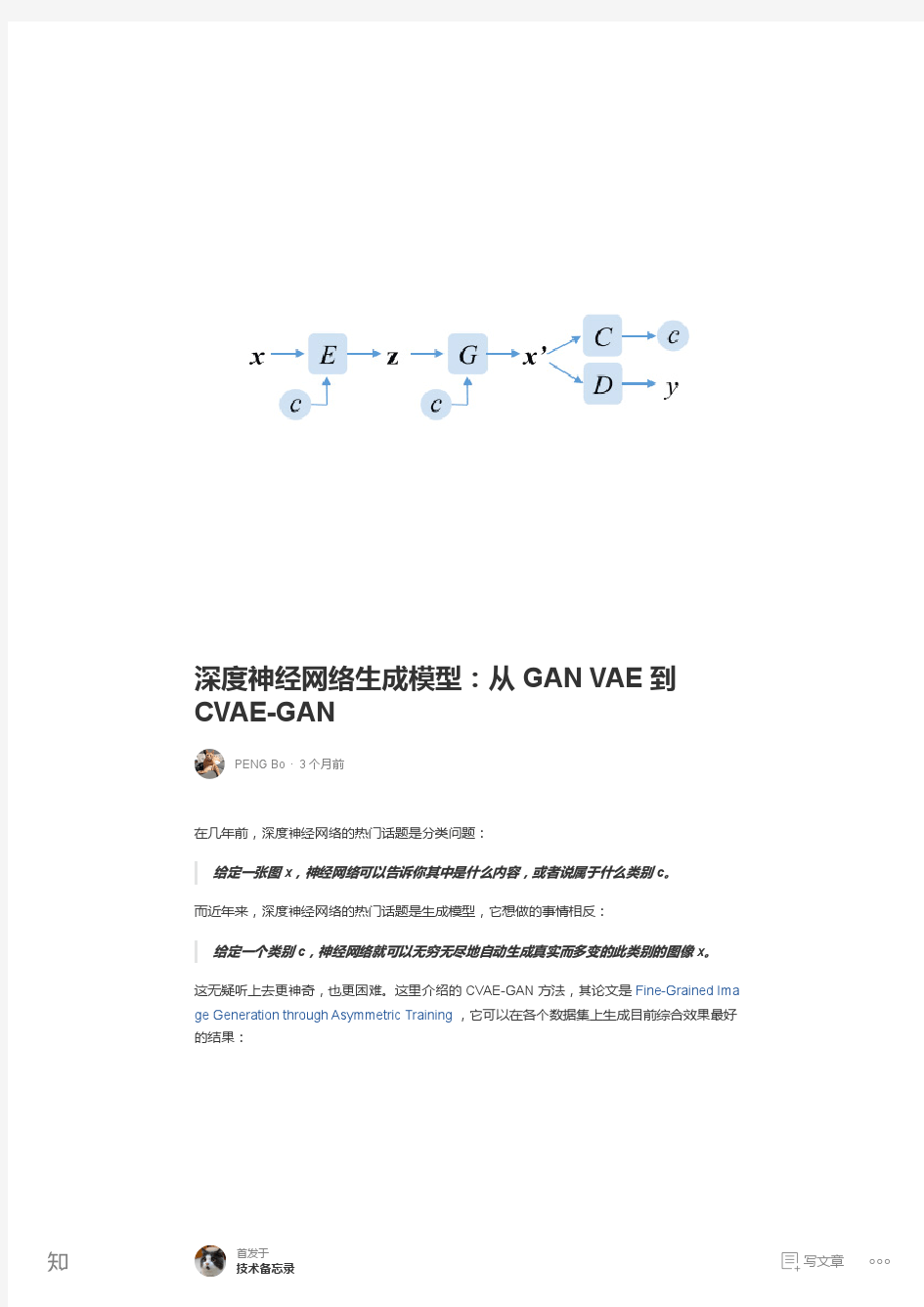

深度神经网络生成模型:从 GAN VAE 到 CVAE-GAN - 知乎专栏

(完整版)深度神经网络及目标检测学习笔记(2)

深度神经网络及目标检测学习笔记 https://youtu.be/MPU2HistivI 上面是一段实时目标识别的演示,计算机在视频流上标注出物体的类别,包括人、汽车、自行车、狗、背包、领带、椅子等。 今天的计算机视觉技术已经可以在图片、视频中识别出大量类别的物体,甚至可以初步理解图片或者视频中的内容,在这方面,人工智能已经达到了3岁儿童的智力水平。这是一个很了不起的成就,毕竟人工智能用了几十年的时间,就走完了人类几十万年的进化之路,并且还在加速发展。 道路总是曲折的,也是有迹可循的。在尝试了其它方法之后,计算机视觉在仿生学里找到了正确的道路(至少目前看是正确的)。通过研究人类的视觉原理,计算机利用深度神经网络(Deep Neural Network,NN)实现了对图片的识别,包 括文字识别、物体分类、图像理解等。在这个过程中,神经元和神经网络模型、大数据技术的发展,以及处理器(尤其是GPU)强大的算力,给人工智能技术 的发展提供了很大的支持。 本文是一篇学习笔记,以深度优先的思路,记录了对深度学习(Deep Learning)的简单梳理,主要针对计算机视觉应用领域。 一、神经网络 1.1 神经元和神经网络 神经元是生物学概念,用数学描述就是:对多个输入进行加权求和,并经过激活函数进行非线性输出。 由多个神经元作为输入节点,则构成了简单的单层神经网络(感知器),可以进行线性分类。两层神经网络则可以完成复杂一些的工作,比如解决异或问题,而且具有非常好的非线性分类效果。而多层(两层以上)神经网络,就是所谓的深度神经网络。 神经网络的工作原理就是神经元的计算,一层一层的加权求和、激活,最终输出结果。深度神经网络中的参数太多(可达亿级),必须靠大量数据的训练来“这是苹在父母一遍遍的重复中学习训练的过程就好像是刚出生的婴儿,设置。.果”、“那是汽车”。有人说,人工智能很傻嘛,到现在还不如三岁小孩。其实可以换个角度想:刚出生婴儿就好像是一个裸机,这是经过几十万年的进化才形成的,然后经过几年的学习,就会认识图片和文字了;而深度学习这个“裸机”用了几十年就被设计出来,并且经过几个小时的“学习”,就可以达到这个水平了。 1.2 BP算法 神经网络的训练就是它的参数不断变化收敛的过程。像父母教婴儿识图认字一样,给神经网络看一张图并告诉它这是苹果,它就把所有参数做一些调整,使得它的计算结果比之前更接近“苹果”这个结果。经过上百万张图片的训练,它就可以达到和人差不多的识别能力,可以认出一定种类的物体。这个过程是通过反向传播(Back Propagation,BP)算法来实现的。 建议仔细看一下BP算法的计算原理,以及跟踪一个简单的神经网络来体会训练的过程。

趋势分析之深度神经网络

趋势分析之深度神经网络 深度神经网络(Deepl Neural Networks, DNN)从字面上理解就是深层次的神经网络。自从Hinton和Salakhutdinov在《Science》上发表的论文解决了多层神经网络训练的难题后,随着研究的深入,各种深度神经网络模型如雨后春笋般涌现出来。 2012年Krizhevsky等人设计的包含5个卷积层和3个全连接层的AlexNet,并将卷积网络分为两个部分在双CPU上进行训练;2014年Google研发团队设计的22层GoogleNet;同年牛津大学的Simonyan和Zisserman设计出深度为16-19层的VGG网络;2015年微软亚洲研究院的何凯明等人提出了152层的深度残差网络ResNet,最新改进后的ResNet网络深度可达1202层;2016年生成式对抗网络GAN获得广泛关注。 深度神经网络热度变化图 下面我们将用Trend analysis分析深度神经网络领域内的研究热点。 (点击链接即可进入Deep Neural Networks Trend Analysis: https://https://www.360docs.net/doc/a69992661.html,/topic/trend?query=Deep%20Neural%20Network%20) 通过Trend analysis的分析挖掘结果我们可以看到,当前该领域的热点研究话题有feature

extraction、speech recognition、face recognition、information retrieval、object recognition、cell cycle等。近年来,深度神经网络由于优异的算法性能,已经广泛应用于图像分析、语音识别、目标检测、语义分割、人脸识别、自动驾驶、生物医学等领域,而根据分析结果可知语音识别是该领域热门研究话题top 1。 深度神经网络在工业界也得到了广泛的应用,Google、Facebook、Microsoft、IBM、百度、阿里巴巴、腾讯、科大讯飞等互联网巨头也纷纷开展深度神经网络的研究工作,并且成功应用于谷歌Now、微软OneNote手写识别、Cortana语音助手、讯飞语音输入法等。 附一. 深度神经网络领域5位代表学者 Dong Yu (俞栋) Tara N. Sainath

基于深度学习的图像字幕生成方法研究

基于深度学习的图像字幕生成方法研究 发表时间:2019-02-28T15:08:21.577Z 来源:《基层建设》2018年第36期作者:王珊珊 [导读] 摘要:几年之前,由于计算能力的不足以及大规模图像字幕数据集的缺少,这就导致了国外很少有人做这方面的研究,其所得到的结果也让人不尽满意,在国内更是鲜有人涉及这个方向。 华风气象影视技术中心北京 100000 摘要:几年之前,由于计算能力的不足以及大规模图像字幕数据集的缺少,这就导致了国外很少有人做这方面的研究,其所得到的结果也让人不尽满意,在国内更是鲜有人涉及这个方向。不过,随着近两年计算机运算能力的提高、深度学习(DL)的发展以及众多大规模图像字幕数据集的出现,这才使得这项任务重新回归到人们的视野并逐渐成为了计算机视觉与自然语言处理领域中的一个研究热点。本文就图像字幕生成任务中所涉及的深度学习算法,在总结前人提出的各种网络及其成效的基础上,研究适合图像字幕生成任务的深度学习模型,为该研究方向提供一定的指导意义。 关键词:深度学习;图像字幕;生成方法 1图像字幕生成概述 图像字幕生成是继图像识别、目标定位、图像分割后又一新型计算机视觉任务。在计算机视觉发展的初期,研究者们尝试利用计算机程序来模拟人类视觉系统,并让其告诉我们它看到了什么,这也就是最基本的图像识别。继图像识别之后,人们又提出更高的要求,即在识别的基础上确定目标在图像中的位置或将其从图像中分割出来。但是,上述任务都是将图像划分到一个或者多个离散的标签中去,它既没有描述出图像中各个对象的关系,也没有给出图像中正在发生的事情。为此,图像字幕生成应运而生,图像字幕生成方法也开始逐渐产生、发展并不断成熟起来。上个世纪七十年代,研究者们认为要让计算机理解它所看到的是什么东西时,必须像人眼一样具有立体视觉。在这种认知的情况下,研究者们希望把物体的三维结构从图像中恢复出来,并在此基础上再让计算机理解和判断。到了八九十年代,研究人员发现要让计算机理解图像,不一定要先恢复物体的三维结构,而是靠物体所具有的一些表面或局部特征。例如,当计算机识别一个苹果时,假设计算机事先知道苹果的形状纹理等特征,并且建立了这样一个先验知识库,那么计算机就可以将看到的物体的特征与先验知识库中的特征进行匹配。如果能够匹配,计算机就可以被认为理解了这个物体。随后,研究者们又利用这些特征,设计各种分类器来达到理解图像的目的。在计算机理解图像的基础上,研究者们又设计不同的算法来实现目标定位、图像分割、简单的图像字幕生成。其中,传统的图像字幕生成方法就是在得到图像里面的不同物体的基础上,采用自然语言处理技术通过一些检索的方法生成对应的字幕描述。 2基于深度学习的图像字幕生成方法研究 深度学习是机器学习(ML)领域中的一个新的研究方向,它的概念来源于人工神经网络(ANN)的研究,其实质就是通过构建机器学习模型和利用海量的训练数据,来逐层变化特征,以提升分类或者预测的准确性。同传统的机器学习方法一样,深度学习也有监督学习和无监督学习之分,不同学习框架下建立的学习模型也是不同的。 2.1基于卷积与循环神经网络的图像字幕生成 2.1.1基于卷积神经网络的图像特征提取 图像特征提取是指计算机经过一系列算法将一幅原始RGB图像转化成一个特征向量或一个特征矩阵,该向量或矩阵就在其空间中代表了这幅图像。图像特征一般包括低级特征和高级特征。常见的低级特征包括颜色特征、纹理特征、形状特征、空间关系特征。低级特征的优点是计算简单直接,缺点是对图像敏感,不能反映图像本身所包含的对象信息。图像的高级特征是指该特征包含了一定的语义信息,利用该特征可以更加容易地识别该图像所包含的内容。本文将利用最先进的卷积神经网络结构进行图像特征提取,常见的有AlexNet、VGG、GoogleNet、ResNet等,这些网络在ImageNet图像分类比赛(ImageNet是由美国斯坦福大学计算机视觉实验室建立的,目前世界上最大的图像识别数据库)中可以达到与人类相媲美的优异结果。本文同大多数计算机视觉应用一样,将采用在ImageNet数据集上预训练好的卷积神经网络,然后通过迁移学习的方法将其用于图像字幕生成任务。对于上述任何一个卷积神经网络可以将其简化成如下图的结构: 2.1.2基于循环神经网络的语言建模与生成 图像可以通过卷积神经网络转变成含有高级语义信息的特征向量。类似的,对于句子也要将其转换成向量才能方便后续处理。一般的,句子往往是由很多个单词组成,将每个单词转变成成一个有意义的词向量比向量化整个句子处理起来更加灵活。有了词向量以后,句子则可以通过一系列按顺序排列的词向量表示。为了能表示出所有字幕,本章将字幕集出现过的所有单词组成一个集合,并将该集合形象化地称为“字典(V ocabulary)”。对于字典里的所有单词,可以将其按顺序排列,并将其序号作为其唯一索引。假设字典的大小为V,即字典共包含V个单词。对于每一个单词,为了方便可以将其进行独热(One-hot)编码,即用长度为V的向量S表示,该向量除了单词对应的索引位为1以外其余全部为0。one-hot编码只是给出了单词的唯一索引信息,想要将其应用在其他任务中就必须将其特征向量化,即word2vec (Word to Vector)。常见的word2vec模型有CBoW(Continuous Bag of Words)模型、Skip-grams模型,采用这些模型就必须单独将其在语料库上训练,这同样会导致模型不能进行端到端训练。近些年,研究证明循环神经网络是一种非常适合该任务的时序模型,它不仅可以根据语句的上下文信息完成word2vec,还可以非常方便地生成新的句子。 2.2基于注意力机制模型的图像字幕生成 2.2.1图像特征提取 上一节的图像字幕生成模型所提取的图像特征是来自卷积神经网络最后的全连接层,它是一个一维向量。因此,它只包含了图像全局的语义信息,而丢失了图像内容之间的位置信息。对于图像的卷积运算来说,它有一个很好的特点,就是卷积的结果能够保留输入图像大致的位置信息。因此,不含有全连接网络的卷积神经网络同样具有这个性质。根据上述思想,为了将每个特征向量与二维图像内容的位置

深度学习系列(7):神经网络的优化方法

机器?学习中,梯度下降法常?用来对相应的算法进?行行训练。常?用的梯度下降法包含三种不不同的形式,分别是BGD 、SGD 和MBGD ,它们的不不同之处在于我们在对?目标函数进?行行梯度更更新时所使?用的样本量量的多少。 以线性回归算法来对三种梯度下降法进?行行?比较。 ?一般线性回归函数的假设函数为: (即有n 个特征)对应的损失函数为下图即为?一个?二维参数和组对应的损失函数可视化图像:批量量梯度下降法(Batch Gradient Descent ,简称BGD )是梯度下降法最原始的形式,它的具体思路路是在更更新每?一参数时都使?用所有的样本来进?行行更更新,其数学形式如下: 深度学习系列列(7):神经?网络的优化?方法?一、Gradient Descent [Robbins and Monro, 1951,Kiefer et al., 1952] = h θ∑j =0n θj x j L (θ)=12m ∑i =1 m (h ()?)x i y i 2θ0θ11.1 BGD (Batch Gradient Descent )

还是以上?面?小球的例例?子来看,momentum ?方式下?小球完全是盲?目被动的?方式滚下的。这样有个缺 三、NAG (Nesterov accelerated gradient )[Nesterov, 1983]

点就是在邻近最优点附近是控制不不住速度的。我们希望?小球可以预判后?面的“地形”,要是后?面地形还是很陡峭,那就继续坚定不不移地?大胆?走下去,不不然的话就减缓速度。 当然,?小球?自?己也不不知道真正要?走到哪?里里,这?里里以 作为下?一个位置的近似,将动量量的公式更更改为: 相?比于动量量?方式考虑的是上?一时刻的动能和当前点的梯度,?而NAG 考虑的是上?一时刻的梯度和近似下?一点的梯度,这使得它可以先往前探探路路,然后慎重前进。 Hinton 的slides 是这样给出的: 其中两个blue vectors 分别理理解为梯度和动能,两个向量量和即为momentum ?方式的作?用结果。?而靠左边的brown vector 是动能,可以看出它那条blue vector 是平?行行的,但它预测了了下?一阶段的梯度是red vector ,因此向量量和就是green vector ,即NAG ?方式的作?用结果。 momentum 项和nesterov 项都是为了了使梯度更更新更更加灵活,对不不同情况有针对性。但是,?人?工设置?一些学习率总还是有些?生硬,接下来介绍?几种?自适应学习率的?方法 训练深度?网络的时候,可以让学习率随着时间退?火。因为如果学习率很?高,系统的动能就过?大,参数向量量就会?无规律律地变动,?无法稳定到损失函数更更深更更窄的部分去。对学习率衰减的时机把握很有技巧:如果慢慢减?小,可能在很?长时间内只能浪费计算资源然后看着它混沌地跳动,实际进展很少;但如果快速地减少,系统可能过快地失去能量量,不不能到达原本可以到达的最好位置。通常,实现学习率退?火有三种?方式: θ?γv t ?1 =γ+ηJ (θ?γ) v t v t ?1?θv t ?1θ=θ?v t 四、学习率退?火

(完整版)深度神经网络全面概述

深度神经网络全面概述从基本概念到实际模型和硬件基础 深度神经网络(DNN)所代表的人工智能技术被认为是这一次技术变革的基石(之一)。近日,由IEEE Fellow Joel Emer 领导的一个团队发布了一篇题为《深度神经网络的有效处理:教程和调研(Efficient Processing of Deep Neural Networks: A Tutorial and Survey)》的综述论文,从算法、模型、硬件和架构等多个角度对深度神经网络进行了较为全面的梳理和总结。鉴于该论文的篇幅较长,机器之心在此文中提炼了原论文的主干和部分重要内容。 目前,包括计算机视觉、语音识别和机器人在内的诸多人工智能应用已广泛使用了深度神经网络(deep neural networks,DNN)。DNN 在很多人工智能任务之中表现出了当前最佳的准确度,但同时也存在着计算复杂度高的问题。因此,那些能帮助DNN 高效处理并提升效率和吞吐量,同时又无损于表现准确度或不会增加硬件成本的技术是在人工智能系统之中广泛部署DNN 的关键。 论文地址:https://https://www.360docs.net/doc/a69992661.html,/pdf/1703.09039.pdf 本文旨在提供一个关于实现DNN 的有效处理(efficient processing)的目标的最新进展的全面性教程和调查。特别地,本文还给出了一个DNN 综述——讨论了支持DNN 的多种平台和架构,并强调了最新的有效处理的技术的关键趋势,这些技术或者只是通过改善硬件设计或者同时改善硬件设计和网络算法以降低DNN 计算成本。本文也会对帮助研究者和从业者快速上手DNN 设计的开发资源做一个总结,并凸显重要的基准指标和设计考量以评估数量快速增长的DNN 硬件设计,还包括学界和产业界共同推荐的算法联合设计。 读者将从本文中了解到以下概念:理解DNN 的关键设计考量;通过基准和对比指标评估不同的DNN 硬件实现;理解不同架构和平台之间的权衡;评估不同DNN 有效处理技术的设计有效性;理解最新的实现趋势和机遇。 一、导语 深度神经网络(DNN)目前是许多人工智能应用的基础[1]。由于DNN 在语音识别[2] 和图像识别[3] 上的突破性应用,使用DNN 的应用量有了爆炸性的增长。这些DNN 被部署到了从自动驾驶汽车[4]、癌症检测[5] 到复杂游戏[6] 等各种应用中。在这许多领域中,DNN 能够超越人类的准确率。而DNN 的出众表现源于它能使用统计学习方法从原始感官数据中提取高层特征,在大量的数据中获得输入空间的有效表征。这与之前使用手动提取特征或专家设计规则的方法不同。 然而DNN 获得出众准确率的代价是高计算复杂性成本。虽然通用计算引擎(尤其是GPU),已经成为许多DNN 处理的砥柱,但提供对DNN 计算更专门化的加速方法也越来越热门。本文的目标是提供对DNN、理解DNN 行为的各种工具、有效加速计算的各项技术的概述。 该论文的结构如下:

神经网络及深度学习

可用于自动驾驶的神经网络及深度学习 高级辅助驾驶系统(ADAS)可提供解决方案,用以满足驾乘人员对道路安全及出行体验的更高要求。诸如车道偏离警告、自动刹车及泊车辅助等系统广泛应用于当前的车型,甚至是功能更为强大的车道保持、塞车辅助及自适应巡航控制等系统的配套使用也让未来的全自动驾驶车辆成为现实。 作者:来源:电子产品世界|2017-02-27 13:55 收藏 分享 高级辅助驾驶系统(ADAS)可提供解决方案,用以满足驾乘人员对道路安全及出行体验的更高要求。诸如车道偏离警告、自动刹车及泊车辅助等系统广泛应用于当前的车型,甚至是功能更为强大的车道保持、塞车辅助及自适应巡航控制等系统的配套使用也让未来的全自动驾驶车辆成为现实。 如今,车辆的很多系统使用的都是机器视觉。机器视觉采用传统信号处理技术来检测识别物体。对于正热衷于进一步提高拓展ADAS功能的汽车制造业而言,深度学习神经网络开辟了令人兴奋的研究途径。为了实现从诸如高速公路全程自动驾驶仪的短时辅助模式到专职无人驾驶旅行的自动驾驶,汽车制造业一直在寻求让响应速度更快、识别准确度更高的方法,而深度学习技术无疑为其指明了道路。 以知名品牌为首的汽车制造业正在深度学习神经网络技术上进行投资,并向先进的计算企业、硅谷等技术引擎及学术界看齐。在中国,百度一直在此技术上保持领先。百度计划在2019 年将全自动汽车投入商用,并加大全自动汽车的批量生产力度,使其在2021 年可广泛投入使用。汽车制造业及技术领军者之间的密切合作是嵌入式系统神经网络发展的催化剂。这类神经网络需要满足汽车应用环境对系统大小、成本及功耗的要求。 1轻型嵌入式神经网络 卷积式神经网络(CNN)的应用可分为三个阶段:训练、转化及CNN在生产就绪解决方案中的执行。要想获得一个高性价比、针对大规模车辆应用的高效结果,必须在每阶段使用最为有利的系统。 训练往往在线下通过基于CPU的系统、图形处理器(GPU)或现场可编程门阵列(FPGA)来完成。由于计算功能强大且设计人员对其很熟悉,这些是用于神经网络训练的最为理想的系统。 在训练阶段,开发商利用诸如Caffe(Convolution Architecture For Feature Extraction,卷积神经网络架构)等的框架对CNN 进行训练及优化。参考图像数据库用于确定网络中神经元的最佳权重参数。训练结束即可采用传统方法在CPU、GPU 或FPGA上生成网络及原型,尤其是执行浮点运算以确保最高的精确度。 作为一种车载使用解决方案,这种方法有一些明显的缺点。运算效率低及成本高使其无法在大批量量产系统中使用。 CEVA已经推出了另一种解决方案。这种解决方案可降低浮点运算的工作负荷,并在汽车应用可接受的功耗水平上获得实时的处理性能表现。随着全自动驾驶所需的计算技术的进一步发展,对关键功能进行加速的策略才能保证这些系统得到广泛应用。 利用被称为CDNN的框架对网络生成策略进行改进。经过改进的策略采用在高功耗浮点计算平台上(利用诸如Caffe的传统网络生成器)开发的受训网络结构和权重,并将其转化为基于定点运算,结构紧凑的轻型的定制网络模型。接下来,此模型会在一个基于专门优化的成像和视觉DSP芯片的低功耗嵌入式平台上运行。图1显示了轻型嵌入式神经网络的生成

深度神经网络及目标检测学习笔记

深度神经网络及目标检测学习笔记 https://youtu.be/MPU2HistivI 上面是一段实时目标识别的演示,计算机在视频流上标注出物体的类别,包括人、汽车、自行车、狗、背包、领带、椅子等。 今天的计算机视觉技术已经可以在图片、视频中识别出大量类别的物体,甚至可以初步理解图片或者视频中的内容,在这方面,人工智能已经达到了3岁儿童的智力水平。这是一个很了不起的成就,毕竟人工智能用了几十年的时间,就走完了人类几十万年的进化之路,并且还在加速发展。 道路总是曲折的,也是有迹可循的。在尝试了其它方法之后,计算机视觉在仿生学里找到了正确的道路(至少目前看是正确的)。通过研究人类的视觉原理,计算机利用深度神经网络(DeepNeural Network,NN)实现了对图片的识别,包括文字识别、物体分类、图像理解等。在这个过程中,神经元和神经网络模型、大数据技术的发展,以及处理器(尤其是GPU)强大的算力,给人工智能技术的发展提供了很大的支持。 本文是一篇学习笔记,以深度优先的思路,记录了对深度学习(Deep Learning)的简单梳理,主要针对计算机视觉应用领域。 一、神经网络 1.1 神经元和神经网络 神经元是生物学概念,用数学描述就是:对多个输入进行加权求和,并经过激活函数进行非线性输出。 由多个神经元作为输入节点,则构成了简单的单层神经网络(感知器),可以进行线性分类。两层神经网络则可以完成复杂一些的工作,比如解决异或问题,而且具有非常好的非线性分类效果。而多层(两层以上)神经网络,就是所谓的深度神经网络。 神经网络的工作原理就是神经元的计算,一层一层的加权求和、激活,最终输出结果。深度神经网络中的参数太多(可达亿级),必须靠大量数据的训练来设置。训练的过程就好像是刚出生的婴儿,在父母一遍遍的重复中学习“这是苹

【CN109933661A】一种基于深度生成模型的半监督问答对归纳方法和系统【专利】

(19)中华人民共和国国家知识产权局 (12)发明专利申请 (10)申请公布号 (43)申请公布日 (21)申请号 201910266295.X (22)申请日 2019.04.03 (71)申请人 上海乐言信息科技有限公司 地址 200030 上海市徐汇区番禺路1028号 数娱大厦8楼 (72)发明人 褚善博 沈李斌 (51)Int.Cl. G06F 16/332(2019.01) (54)发明名称 一种基于深度生成模型的半监督问答对归 纳方法和系统 (57)摘要 本发明公开了一种基于深度生成模型的半 监督问答对归纳方法和系统,该方法包括以下步 骤:通过候选问答对生成方法从输入的对话数据 中整理出候选问答对;通过采用基于深度生成模 型的问答对评价方法对所述候选问答对打分;根 据所述候选问答对打分结果利用问答对筛选方 法得到高质量问答对;通过半监督学习方式对所 述深度生成模型进行预先训练后再应用到所述 问答对评价方法中。通过以上方式能够进行自动 化的问答对归纳,极大减少了人工参与并获取高 质量的问答对。权利要求书4页 说明书13页 附图3页CN 109933661 A 2019.06.25 C N 109933661 A

权 利 要 求 书1/4页CN 109933661 A 1.一种问答对归纳方法,其特征在于,问答对归纳的自动化方法包括以下步骤: 通过候选问答对生成方法从输入的对话数据中整理出候选问答对; 通过采用基于深度生成模型的问答对评价方法对所述候选问答对打分; 根据所述候选问答对打分结果利用问答对筛选方法得到高质量问答对; 通过半监督学习方式对所述深度生成模型进行预先训练后再应用到所述问答对评价方法中。 2.一种问答对归纳方法,其特征在于,问答对归纳的自动化方法包括以下步骤: 通过候选问答对生成方法从输入的对话数据中整理出候选问答对; 通过采用基于深度生成模型的问答对评价方法对所述候选问答对打分; 根据所述候选问答对打分结果利用问答对筛选方法得到高质量问答对; 通过半监督学习方式对所述深度生成模型进行预先训练后再应用到所述问答对评价方法中。 3.根据权利要求1所述的问答对归纳方法,其特征在于,所述问答对评价方法使用的半监督学习方式训练的深度生成模型可采用序列到序列(Sequence to Sequence)的深度生成模型,如,基于Transformer的Sequence to Sequence模型,和基于LSTM和GRU等的 encoder、decoder的sequence to sequence模型,还可采用统计机器翻译中用到的生成模型。 4.根据权利要求3所述的问答对归纳方法,其特征在于,所述基于Transformer的Sequence to Sequence模型参数设置为:multi-head的数量设置为8,encoder和decoder中layer为6,进一步地,所述模型的输入端使用预训练的字向量拼接所述字的位置向量,进一步地,使用word2vec训练字向量,字向量维度设置为100。 5.根据权利要求3所述的问答对归纳方法,其特征在于,所述半监督学习方式训练的深度生成模型采用的可采用自学习(Self Learning)的半监督方法、基于EM(Expectation Maximization)算法的生成式半监督方法以及基于图的半监督学习等。 6.根据权利要求5所述的问答对归纳方法,其特征在于,所述采用自学习方式训练的基于Transformer的Sequence to Sequence模型训练步骤进一步包括: 通过问答对生成方法从训练用对话数据中获得训练数据,进一步,从中采样,其中,采样部分数据标记为“未审阅有效问答对”,生成数据集De,剩余部分标记为“未审阅问答对”,生成数据集Dw; 通过人工审阅过程对所述“未审阅有效问答对”数据集De进行审核,得到高质量的问答对数据集Dc; 使用所述数据集Dc与所述数据集Dw作为训练数据,采用所述自学习方式对所述基于Transformer的Sequence to Sequence模型进行训练。 7.根据权利要求6所述的问答对归纳方法,其特征在于,所述问答对生成方法可通过基于启发式规则实现,执行步骤进一步包括: 将训练用对话数据中问题语句和回复语句按照长度过滤,筛选出满足长度条件的对话语句; 按照位置顺序,分别判断每个回复语句在所述对话语句中是否位于两个问题语句之间,或者是否紧接最后一个问题语句且位于所述对话语句的结束句处,若是,寻找对应回复 2

(完整word版)深度学习-卷积神经网络算法简介

深度学习 卷积神经网络算法简介 李宗贤 北京信息科技大学智能科学与技术系 卷积神经网络是近年来广泛应用在模式识别、图像处理领域的一种高效识别算法,具有简单结构、训练参数少和适应性强的特点。它的权值共享网络结构使之更类似与生物神经网络,降低了网络的复杂度,减少了权值的数量。以二维图像直接作为网络的输入,避免了传统是被算法中复杂的特征提取和数据重建过程。卷积神经网络是为识别二维形状特殊设计的一个多层感知器,这种网络结构对于平移、比例缩放、倾斜和其他形式的变形有着高度的不变形。 ?卷积神经网络的结构 卷积神经网络是一种多层的感知器,每层由二维平面组成,而每个平面由多个独立的神经元组成,网络中包含一些简单元和复杂元,分别记为C元和S元。C元聚合在一起构成卷积层,S元聚合在一起构成下采样层。输入图像通过和滤波器和可加偏置进行卷积,在C层产生N个特征图(N值可人为设定),然后特征映射图经过求和、加权值和偏置,再通过一个激活函数(通常选用Sigmoid函数)得到S层的特征映射图。根据人为设定C层和S层的数量,以上工作依次循环进行。最终,对最尾部的下采样和输出层进行全连接,得到最后的输出。

卷积的过程:用一个可训练的滤波器fx去卷积一个输入的图像(在C1层是输入图像,之后的卷积层输入则是前一层的卷积特征图),通过一个激活函数(一般使用的是Sigmoid函数),然后加一个偏置bx,得到卷积层Cx。具体运算如下式,式中Mj是输入特征图的值: X j l=f?(∑X i l?1?k ij l+b j l i∈Mj) 子采样的过程包括:每邻域的m个像素(m是人为设定)求和变为一个像素,然后通过标量Wx+1加权,再增加偏置bx+1,然后通过激活函数Sigmoid产生特征映射图。从一个平面到下一个平面的映射可以看作是作卷积运算,S层可看作是模糊滤波器,起到了二次特征提取的作用。隐层与隐层之间的空间分辨率递减,而每层所含的平面数递增,这样可用于检测更多的特征信息。对于子采样层来说,有N 个输入特征图,就有N个输出特征图,只是每个特征图的的尺寸得到了相应的改变,具体运算如下式,式中down()表示下采样函数。 X j l=f?(βj l down (X j l?1) +b j l)X j l) ?卷积神经网络的训练过程 卷积神经网络在本质上是一种输入到输出的映射,它能够学习大量的输入和输出之间的映射关系,而不需要任何输入和输出之间的精确数学表达式。用已知的模式对卷积网络加以训练,网络就具有了输

单目深度估计文献翻译unsupervised monocular depth estimation with left-right consistency

左右(视差)一致的非监督式单目深度估计 摘要 以学习为基础的方法已经在对单张图片的深度估计上取得了可观的结果。大多数现有的方法是将深度预测作为监督式的回归问题来处理,然而这种方式需要大量相应的真实深度数据用于训练。然而,单单从复杂环境中获取高质量的深度数据就已经很有难度了。我们将在本文中对已有方式进行创新,不再对深度数据进行训练,而是训练更容易获得的双目立体连续镜头。 我们提出了一种新颖的训练目标,即使在缺少真实深度数据的情况下,仍然能够使用卷积神经网络来完成单张图片的深度估计。利用极线几何限制,我们通过训练有图像重构损失函数的网络生成了视差图像。我们曾发现单独进行图像重构会导致深度图像质量很差。为了解决这个问题,我们提出了一个新颖的训练损失函数,可以使左右图像产生的视差趋于一致,以此来提高当前方式的表现和健壮度。我们的方法在KITTI 驾驶数据集上展示出艺术般的单目深度估计效果,甚至优于基于真实深度数据的监督式学习的效果。 1.简介 在计算机视觉领域,对图片进行深度估计已经有了很久的历史。目前的成熟方式依赖于连续动作、X 射线下的形状、双目和多视角立体模型。然而,多数的上述技术是基于可获取相关场景的观测数据的假设。其中,数据可能是多角度的,或者观测是在不同的光线环境下进行的。为了突破这个限制,近期涌现出大量在监督式学习下对单目深度识别的讨论。这些方法试图直接在线下通过大量真实深度数据训练的模型来对图像中的每一个像素进行深度估计。这些方法虽然已经取得巨大的成功,但是是建立在可获取大量图像数据集和相应的像素深度的情况下的。 在单张图像里获取不受外表干扰的场景形状是机器感知的基础问题。很多此类的应用,比如在计算机图形学中合成对象的插入、在计算机摄影学中对深度的合成、机器人抓握,会使用深度为线索进行人体姿

基于深度学习的创意三维体素模型的建模系统的构建方法与制作流程

本技术涉及三维体素模型的建模领域,其公开了一种基于深度学习的创意三维体素模型的建模系统的构建方法,构建一种可自动生成具有创意性的三维体素模型,同时具有可交互编辑功能的建模系统。该方法包括:A、制作三维模型的体素数据集以及组成三维模型的语义部件数据集;B、搭建三维模型的生成模型以及三维模型组成部件的生成模型,并采用体素数据集和语义部件数据集分别进行训练;C、基于训练后的三维模型的生成模型中的编码器和训练后的三维模型组成部件的生成模型中的编码器构建语义结构模型,并进行训练;D、将训练后的语义结构模型整合入系统中作为建模算法,同时为用户提供交互界面以及针对生成的三维模型组件的可控编辑接口。 权利要求书 1.基于深度学习的创意三维体素模型的建模系统的构建方法,其特征在于, 包括以下步骤: A、制作三维模型的体素数据集以及组成三维模型的语义部件数据集; B、搭建三维模型的生成模型以及三维模型组成部件的生成模型,并采用体素数据集和语义部件数据集分别进行训练;

C、基于训练后的三维模型的生成模型中的编码器和训练后的三维模型组成部件的生成模型中的编码器构建语义结构模型,并进行训练; D、将训练后的语义结构模型整合入系统中作为建模算法,同时为用户提供交互界面以及针对生成的三维模型组件的可控编辑接口。 2.如权利要求1所述的基于深度学习的创意三维体素模型的建模系统的构建方法,其特征在于, 步骤A中,基于已知数据集ShapeNetCore,并进行人工的分类和对齐来制作三维模型的体素数据集;然后利用MeshLab软件对ShapeNetCore数据集提供的三维模型的部件根据语义结构进行分割和分类,以此制作组成三维模型的语义部件数据集。 3.如权利要求1所述的基于深度学习的创意三维体素模型的建模系统的构建方法,其特征在于, 步骤B中,采用整体变分自编码器作为三维模型的生成模型,采用部件变分自编码器作为三维模型组成部件的生成模型;采用KL散度和二进制交叉熵作为损失函数,利用体素数据集中的数据训练所述整体变分自编码器;采用KL散度和二进制交叉熵作为损失函数,利用三维模型的语义部件数据集中的数据训练所述部件变分自编码器。 4.如权利要求3所述的基于深度学习的创意三维体素模型的建模系统的构建方法,其特征在于, 所述整体变分自编码器和部件变分自编码器均采用编码器-解码器的结构,编码器和解码器均由深度卷积神经网络组成;其中,部件变分自编码器采用的卷积层数少于整体变分自 编码器采用的卷积层数。 5.如权利要求1所述的基于深度学习的创意三维体素模型的建模系统的构建方法,其特征在于,

神经网络11大常见陷阱及应对方法

深度学习的这些坑你都遇到过吗?神 经网络11 大常见陷阱及应对方法【新智元导读】如果你的神经网络不工作,该怎么办?本文作者列举了搭建神经网络时可能遇到的11个常见问题,包括预处理数据、正则化、学习率、激活函数、网络权重设置等,并提供解决方法和原因解释,是深度学习实践的有用资料。 如果你的神经网络不工作,该怎么办?作者在这里列出了建神经网络时所有可能做错的事情,以及他自己的解决经验。 1.忘记规范化数据 2.忘记检查结果 3.忘记预处理数据 4.忘记使用正则化 5.使用的batch太大 6.使用了不正确的学习率 7.在最后层使用了错误的激活函数 8.你的网络包含了Bad Gradients 9.初始化网络权重不正确 10.你使用的网络太深了 11.使用隐藏单元的数量不对 忘记规范化数据了

问题描述 在使用神经网络时,思考如何正确地规范化数据是非常重要的。这是一个无法改变的步骤——假如这一步骤没有小心、正确地做,你的网络就几乎不可能工作。由于这个步骤非常重要,在深度学习社区中也是众所周知的,所以它很少在论文中被提及,因此初学者常常在这一步出错。 怎样解决? 一般来说,规范化(normalization)的意思是:将数据减去均值,再除以其方差。通常这是对每个输入和输出特征单独做的,但你可能经常会希望对特征组做或特别主翼处理某些特征的规范化。 为什么? 我们需要对数据进行规范化的主要原因是大部分的神经网络流程假设输入和输出数据都以一个约是1的标准差和约是0的均值分布。这些假设在深度学习文献中到处都是,从权重初始化、激活函数到训练网络的优化算法。 还需要注意 未训练的神经网络通常会输出约在-1到1范围之间的值。如果你希望输出其他范围的值(例如RBG图像以0-255范围的字节存储)会出现一些问题。在开始训练时,网络会非常不稳定,因为比如说预期值是255,网络产生的值是-1或1——这会被大多数用于训练神经网络的优化算法认为是严重的错误。这会产生过大的梯度,可能导致梯度爆炸。如果不爆炸,那么训练的前几个阶段就是浪费的,因为网络首先学习的是将输出值缩小到大致是预期的范围。如果规范化了数据(在这种情况下,你可以简单地将数值除以128再减去1),就不会发生这些问题。 一般来说,神经网络中特征的规模也决定了其重要性。如果输出中的有一个特征规模很大,那么与其他特征相比它会产生更大的错误。类似地,输入中的大规模特征将主导网络并导致下游发生更大的变化。因此,使用神经网络库的自动规范化往往是不够的,这些神经网络库会在每个特征的基础上盲目地减去平均值并除以方差。你可能有一个输入特征,通常范围在0.0到0.001之间——这个特征的范围如此之小,因为它是一个不重要的特征(在这种情况下,你可能不想重新scale),或者因为与其他特征相比它有一些小的单元(在这种情

BP神经网络及深度学习研究 - 综述

BP神经网络及深度学习研究 摘要:人工神经网络是一门交叉性学科,已广泛于医学、生物学、生理学、哲学、信息学、计算机科学、认知学等多学科交叉技术领域,并取得了重要成果。BP(Back Propagation)神经网络是一种按误差逆传播算法训练的多层前馈网络,是目前应用最广泛的神经网络模型之一。本文将主要介绍神经网络结构,重点研究BP神经网络原理、BP神经网络算法分析及改进和深度学习的研究。 关键词:BP神经网络、算法分析、应用 1引言 人工神经网络(Artificial Neural Network,即ANN ),作为对人脑最简单的一种抽象和模拟,是人们模仿人的大脑神经系统信息处理功能的一个智能化系统,是20世纪80 年代以来人工智能领域兴起的研究热点。人工神经网络以数学和物理方法以及信息处理的角度对人脑神经网络进行抽象,并建立某种简化模型,旨在模仿人脑结构及其功能的信息处理系统。 人工神经网络最有吸引力的特点就是它的学习能力。因此从20世纪40年代人工神经网络萌芽开始,历经两个高潮期及一个反思期至1991年后进入再认识与应用研究期,涌现出无数的相关研究理论及成果,包括理论研究及应用研究。最富有成果的研究工作是多层网络BP算法,Hopfield网络模型,自适应共振理论,自组织特征映射理论等。因为其应用价值,该研究呈愈演愈烈的趋势,学者们在多领域中应用[1]人工神经网络模型对问题进行研究优化解决。 人工神经网络是由多个神经元连接构成,因此欲建立人工神经网络模型必先建立人工神经元模型,再根据神经元的连接方式及控制方式不同建立不同类型的人工神经网络模型。现在分别介绍人工神经元模型及人工神经网络模型。 1.1人工神经元模型 仿生学在科技发展中起着重要作用,人工神经元模型的建立来源于生物神经元结构的仿生模拟,用来模拟人工神经网络[2]。人们提出的神经元模型有很多,其中最早提出并且影响较大的是1943年心理学家McCulloch和数学家W.Pitts在分析总结神经元基本特性的基础上首先提出的MP模型。该模型经过不断改进后,形成现在广泛应用的BP神经元模型。人工神经元模型是由人量处理单元厂泛互连而成的网络,是人脑的抽象、简化、模拟,反映人脑的基本特性。一般来说,作为人工神经元模型应具备三个要素: (1)具有一组突触或连接,常用 w表示神经元i和神经元j之间的连接强度。 ij (2)具有反映生物神经元时空整合功能的输入信号累加器 。

深度神经网络

1. 自联想神经网络与深度网络 自联想神经网络是很古老的神经网络模型,简单的说,它就是三层BP网络,只不过它的输出等于输入。很多时候我们并不要求输出精确的等于输入,而是允许一定的误差存在。所以,我们说,输出是对输入的一种重构。其网络结构可以很简单的表示如下: 如果我们在上述网络中不使用sigmoid函数,而使用线性函数,这就是PCA模型。中间网络节点个数就是PCA模型中的主分量个数。不用担心学习算法会收敛到局部最优,因为线性BP网络有唯一的极小值。

在深度学习的术语中,上述结构被称作自编码神经网络。从历史的角度看,自编码神经网络是几十年前的事情,没有什么新奇的地方。 既然自联想神经网络能够实现对输入数据的重构,如果这个网络结构已经训练好了,那么其中间层,就可以看过是对原始输入数据的某种特征表示。如果我们把它的第三层去掉,这样就是一个两层的网络。如果,我们把这个学习到特征再用同样的方法创建一个自联想的三层BP网络,如上图所示。换言之,第二次创建的三层自联想网络的输入是上一个网络的中间层的输出。用同样的训练算法,对第二个自联想网络进行学习。那么,第二个自联想网络的中间层是对其输入的某种特征表示。如果我们按照这种方法,依次创建很多这样的由自联想网络组成的网络结构,这就是深度神经网络,如下图所示:

注意,上图中组成深度网络的最后一层是级联了一个softmax分类器。 深度神经网络在每一层是对最原始输入数据在不同概念的粒度表示,也就是不同级别的特征描述。 这种层叠多个自联想网络的方法,最早被Hinton想到了。 从上面的描述中,可以看出,深度网络是分层训练的,包括最后一层的分类器也是单独训练的,最后一层分类器可以换成任何一种分类器,例如SVM,HMM等。上面的每一层单独训练使用的都是BP算法。相信这一思路,Hinton早就实验过了。 2. DBN神经网络模型 使用BP算法单独训练每一层的时候,我们发现,必须丢掉网络的第三层,才能级联自联想神经网络。然而,有一种更好的神经网络模型,这就是受限玻尔兹曼机。使用层叠波尔兹曼机组成深度神经网络的方法,在深度学习里被称作深度信念网络DBN,这是目前非

基于风格化对抗自编码器的图像生成算法

基于风格化对抗自编码器的图像生成算法 发表时间:2019-01-02T14:25:51.980Z 来源:《信息技术时代》2018年3期作者:孙力军,李潘[导读] 在本论文中提出了一种用于自动图像生成的基于自编码器的生成对抗网络(GAN),我们称之为“风格化对抗式自编码器”。不同于已有的生成式自编码器(通常会在隐向量上施加一个先验分布)(成都理工大学,四川成都 610059) 摘要:在本论文中提出了一种用于自动图像生成的基于自编码器的生成对抗网络(GAN),我们称之为“风格化对抗式自编码器”。不同于已有的生成式自编码器(通常会在隐向量上施加一个先验分布),我们提出的方法是将隐变量分成两个分量:风格特征和内容特征,这两个分量都是根据真实图像编码的。这种隐向量的划分让我们可以通过选择不同的示例图像来任意调整所生成图像的内容和风格。此外这个GAN 网络中还采用了一个多类分类器来作为鉴别器,这能使生成的图像更具真实感。结果表明风格化对抗式自编码器能显著改善对应的监督识别任务。 关键词:GAN;自编码器;模型 1 引言 生成式自然图像建模是计算机视觉和机器学习领域的一个基本研究问题。早期的研究更关注生成网络建模的统计原理,但由于缺乏有效的特征表征方法,相应结果都局限于某些特定的模式。深度神经网络已经展现出了在学习表征方面的显著优势,并且已经被证明可有效应用于鉴别式视觉任务(比如图像分类和目标检测),与贝叶斯推理或对抗训练一起催生出了一系列深度生成模型。我们在本论文中提出了一种名为风格化对抗式自编码器(SAAE)的全新生成模型,该模型是使用一种对抗式来训练风格化自编码器。内容特征和风格特征都是根据示例图像编码的,并且不会在隐变量的分布上使用任何先验假设。带有给定内容和风格的目标图像可以根据组合起来的隐变量解码得到,这意味着我们可以通过选择不同的示例内容和/或风格图像来调整输出图像。 2 风格化对抗式自编码器 生成网络由两个编码器(Enc和Ens)和一个解码器(Dec)构成。其中 Enc 将内容图像编码成内容隐含表征或特征z_c,Ens 将风格图像编码成风格隐含表征或特征 z_s。Dec 解码组合后的隐含表征并得到输出图像。为了方便起见,我们使用生成器 G 表示 Enc、Ens 和 Dec 的组合。 已有 GAN 中的鉴别器的输出是表示该输出 x 是真实图像的概率 y = Dis(x) ∈ [0,1]。而鉴别器 D 的训练目标是最小化二元交叉熵:L_{dis} = ?log(Dis(x))?log(1?Dis(G(z)))。G 的目标是生成 D 无法将其与真实图像区分开的图像,即最大化 Ldis。我们提出的生成网络包含两个特征提取网络流程,之后再跟上一个生成网络。内容特征提取器和风格特征提取器都有三个无下采样的卷积层,这样能尽可能多地保留示例图像的细节信息。输入的风格图像和内容图像可能有不同的尺寸。 3 实验 我们使用了评估了我们的方法:为监督识别任务生成训练数据。深度神经网络(DNN)已经在监督学习方面表现出了显著的优越性,但它却依赖于大规模有标注训练数据。在小规模训练数据上,深度模型很容易过拟合。我们还使用 SAAE 模型为识别中国汽车牌照任务生成了训练数据。我们通过测量在 DR-PLATE 数据集上的识别准确度而对数据生成的质量进行了评估。根据实验表明加入到训练数据集中的生成数据越多,模型收敛得越慢,但分类准确度却越来越好。这个结果表明我们的 SAAE 模型能够通过生成数据提升监督学习的表现。 4 结论 我们提出了一种全新的深度自编码器网络,它可以分别编码来自两个示例图像的内容特征和风格特征并根据这两个特征解码得到新图像。使用了多类分类器作为鉴别器,这能更好地建模生成的图像的变化情况,并能有效地迫使生成网络生成更具真实感的结果。我们开发了一种三步式训练策略,以确保我们提出的风格化对抗式自编码器的收敛。参考文献 [1]Ian Goodfellow, Jean Pouget-Abadie, Mehdi Mirza, Bing Xu, DavidWarde-Farley,Sherjil Ozair, Aaron Courville, and Yoshua Bengio. 2014. Generative adversarialnets. In Advances in Neural Information Processing Systems. 2672–2680. [2]Anders Boesen Lindbo Larsen, S?ren Kaae S?nderby, and Ole Winther. 2015.Autoencoding beyond pixels using a learned similarity metric. arXiv preprint arXiv:1512.09300 (2015). [3]Shaoqing Ren, Kaiming He, Ross Girshick, and Jian Sun. 2015. Faster R-CNN:Towards real-time object detection with region proposal networks. In Advances in neural information processing systems. 91–99..