基于视频的人脸表情识别方法研究

2008,44(17)ComputerEngineeringandApplications计算机工程与应用

1引言

近几年来,表情识别技术在计算机视觉和模式识别领域逐步成为一个重要的研究热点,也提出了数个基于图像或视频的表情识别算法和系统。事实上,自20世纪70年代以来,人们在该领域已经进行了广泛的研究,试图找出人脸表情与情绪之间的关系。Ekman[1]是该研究领域的开创者,他提出,除了中性(没有表情)人脸之外,Ekman将人脸表情分为6个代表性的基本类别,这就是所谓的高兴,沮丧,生气,害怕,吃惊和厌恶[2]。此后,许多研究者就开始研究如何分析人脸特征并测量这些特征的运动以对不同的人脸表情进行分类。有些方法[3]从单幅图像提取人脸特征,将这些特征作为一个分类系统的输入,该分类系统自动对这些输入进行分类,从而判断人脸的表情。但是,众所周知,在表情的作出过程中,时域信息起着很重要的作用。仅仅基于单张静态图片进行表情分析通常并不能很鲁棒地作出正确的分类。因此,也有一些方法[4-7]通过分析视频中的动态人脸表情过程引入了时域特征来进行表情识别,首先通过跟踪人脸特征,然后测量人脸的运动量,然后根据运动的动态过程来判断是哪种基本表情,并在识别过程中采用HMM(HiddenMarkovModel)。这种方法使得识别的准确率比较稳定,但是由于脸部的运动比较复杂,未对脸部运动进行细分,导致识别率无法较大提高。

鉴于前述方法的优点和不足之处,提出一种新的基于视频序列的人脸表情识别方法。事实上,我们可以注意到,嘴巴的运动实际上有时候并不一定代表是在做出某种表情,而只是在说话而已,有些时候却也反映出某种特定的表情,比如吃惊时会张大嘴巴,高兴时眼睛会眯起同时嘴角上翘等。所以,在新的方

基于视频的人脸表情识别方法研究

倪宁1,卢刚2

NINing1,LUGang2

1.杭州科技职业技术学院计算机系,杭州310012

2.浙江财经学院信息学院,杭州310018

1.DepartmentofComputer,HangzhouPolyTechniqueCollege,Hangzhou310012,China

2.CollegeofInformation,ZhejiangUniversityofFinanceandEcomonics,Hangzhou310018,China

E-mail:hz_lugang@163.com

NINing,LUGang.Approachonvideo-basedexpressionrecognition.ComputerEngineeringandApplications,2008,44(17):198-200.

Abstract:Expressionrecognitionisbecomingoneofthelatestchallengesincomputervisionandpatternrecognitioninrecentyears.Inthispaper,acomputervisionsystemincludingbothfacialfeatureextractionandexpressionrecognitionisproposed.Facialmotionfeaturestrackingandextractionareperformedontheemotionalspeakingvideofirst.Differentwithpreviousapproach,seg-menttheextractedfeaturevectorsstreamintotwoclassifications.Oneisexpressionfeaturevectorstream.Theotheristhevisualspeechone.Then,basedonCHMM(CoupledHiddenMarkovModel),whichkeepsthestateasynchronyofthetwoobservationse-quenceswhilepreservingtheirnaturalcorrelationthroughtheprocess,expressionrecognitionisperformed.TheexperimentalresultsshowthatthecoupledHMMoutperformsthemulti-streamHMMinvideobasedemotionrecognition.

Keywords:facialexpressionrecognition;CHMM;featurevectorsegmentation

摘要:近年来,表情识别逐渐成为计算机视觉和模式识别领域的研究热点之一。给出了一个包含人脸特征提取和表情识别的计算机视觉系统,通过对视频中人脸兼容运动特征的跟踪,提取人脸运动特征向量序列,与以往的方法不同,提取到的特征向量流被分割为两类,一类是表情特征向量流,另一类是视觉语音特征向量流。然后,利用基于CHMM(CoupleHiddenMarkovModel)的表情识别模型,进行人脸表情的识别,该模型允许两个向量流根据其各自的时域特征以异步方式进行处理,同时保持这两个向量流在时域上的自然关联。实验表明该方法优于传统的单通道处理方法。

关键词:人脸表情识别;CHMM;特征向量分割

DOI:10.3778/j.issn.1002-8331.2008.17.059文章编号:1002-8331(2008)17-0198-03文献标识码:A中图分类号:TP391

基金项目:浙江省科技厅重大科技专项和优先主题项目(No.2007C3050)。

作者简介:倪宁(1975-),女,讲师,主研方向为CAD/CAM、CSCW等;卢刚(1974-),男(汉族),副教授,主研方向:网络安全、计算机视觉、计算机图形图像处理。

收稿日期:2007-12-25修回日期:2008-03-12

198

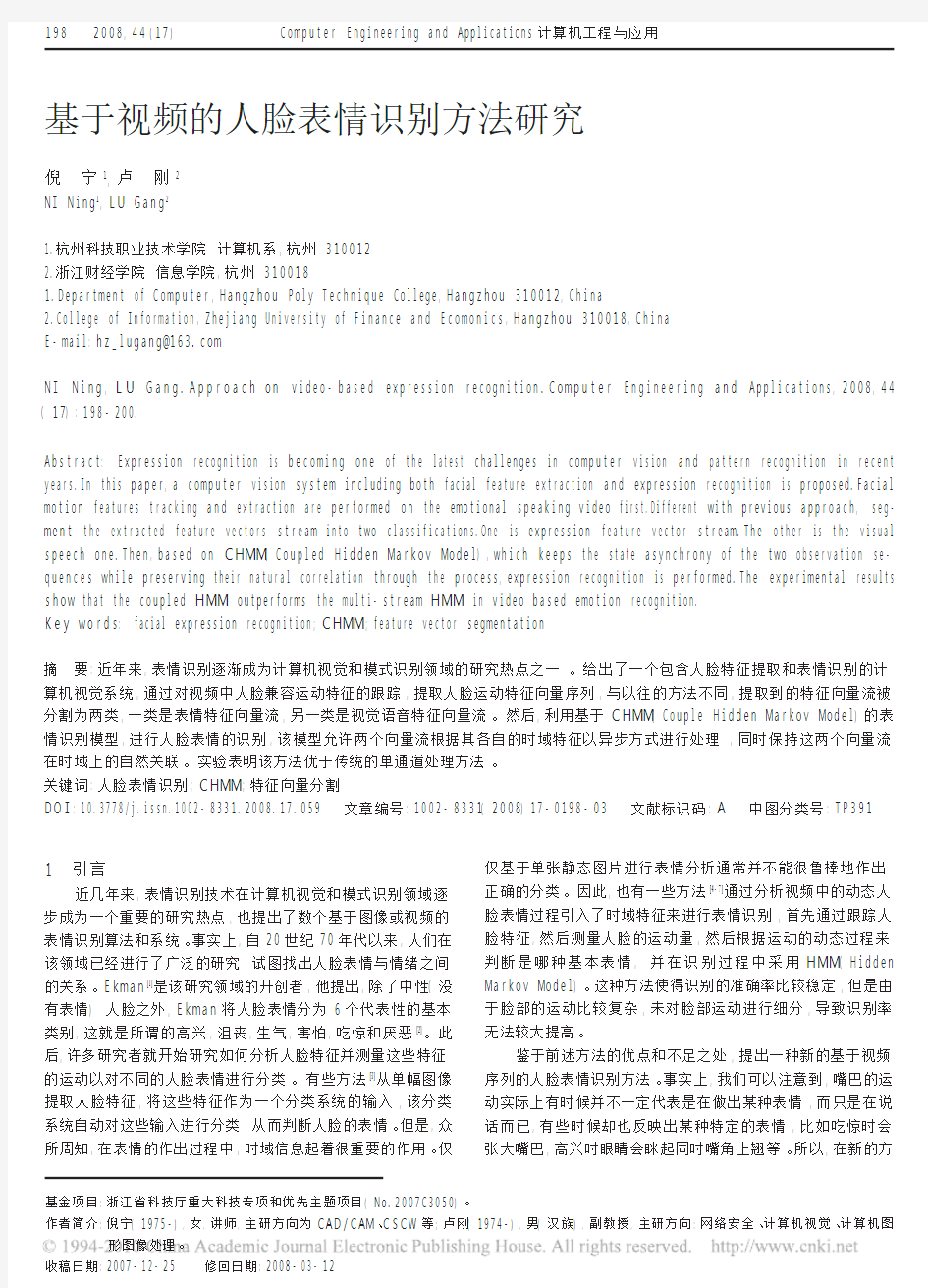

2008,44(17)法中,人脸的运动特征被分为两类:视觉语音特征和表情特征。后者对于人脸表情的识别是至关重要的,而前者则可以对后者起到辅助作用,所以将这两类特征向量分别参数化,从而获得两个相应的特征向量。HMM非常适合用于处理时空信号,但前述两个特征向量序列对于识别结果有不同的作用效果,简单地把这两个向量序列作为一个整体用于HMM的输入就无法区别这两个的不同权重,从而从整体上降低系统的识别准确率,所以传统的多数据流输入HMM不适合这种情形。在作者的模型中,采用CHMM(CoupledHMM)将两个特征向量序列分别进行模型化,在保持视觉语音特征和表情特征状态异步的情况下根据每个通道的可靠性将它们的似然度相加。系统框架如图

1所示。第二章主要论述CHMM的训练;第三章,介绍了人脸

特征的提取和向量化;接下来给出了实验结果及其分析,最后对该表情识别方法进行了总结和展望。

2CHMM模型

系统中引入一种基于CHMM[8]的人脸表情识别模型,CHMM

是为了多种多媒体应用而对HMM的推广,它可以整合两个输入数据流。CHMM可以看作是HMM的一个集合,每一个对应于一个输入数据流,其中t时刻每一个HMM的离散节点状态由t-1时所有相关的HMM离散节点来决定的。CHMM定义请参考文献[9]。

要使模型能够进行识别,就必须先对其进行训练。最大似然训练是一种易于理解且使用广泛的方法,然而由于参数的迭代,最大似然估计只能收敛于局部最优,这使得模型初始参数的选择变得至关重要。在以往的方法中,前向算法[11]

通常用于

估计用于训练HMM的最佳状态序列。不同于前向算法,在这里采用Viterbi算法用于模型训练参数的确定,文献[10]中证明

Viterbi算法能够确定最优状态序列使观测样本序列得到最大

似然。Viterbi算法的基本思想与前向算法类似,每次只考虑前后相邻的两个时刻的计算,由t=1开始一直推进到t=T结束。

主要的不同在于两个时间之间的计算过程,产生对应于最短或者最佳路径的最大值的控制被临时存放起来而不是累加起来,这样,对于最后的计算状态序列,所保存的最佳控制可以基于路径回溯来恢复状态空间轨迹。应用于CHMM的Viterbi算法可以直接扩展得到。如下所示:

(1)初始化

δ0(j,l)=πs

0(j)πe

0(l)bs

t(j)be

t(l)(1)ψ0(j,l)=0(2)

(2)递归

δt(j,l)=maxx,y

{δt-1(x,y)aj|x,yz}

bs

t(x)be

t(y)(3)ψt(j,l)=argmaxx,y

{δt-1(x,y)aj|x,zal|x,y}

(4)

(3)结束P=maxj,l

{δT(j,l)}

(5)

{qs

T,qe

T}=argmaxj,l

{δT(j,l)}

(6)

(4)回退

{qst,qet}=ψt+1{

qst+1,qe

t+1}(7)

用于建立Codebook的K-means算法可参考文献[8]。最后,训练6个用于识别6个基本表情的CHMM,另外训练一个

CHMM用于识别中性人脸。

3人脸特征提取和向量化

3.1人脸特征跟踪

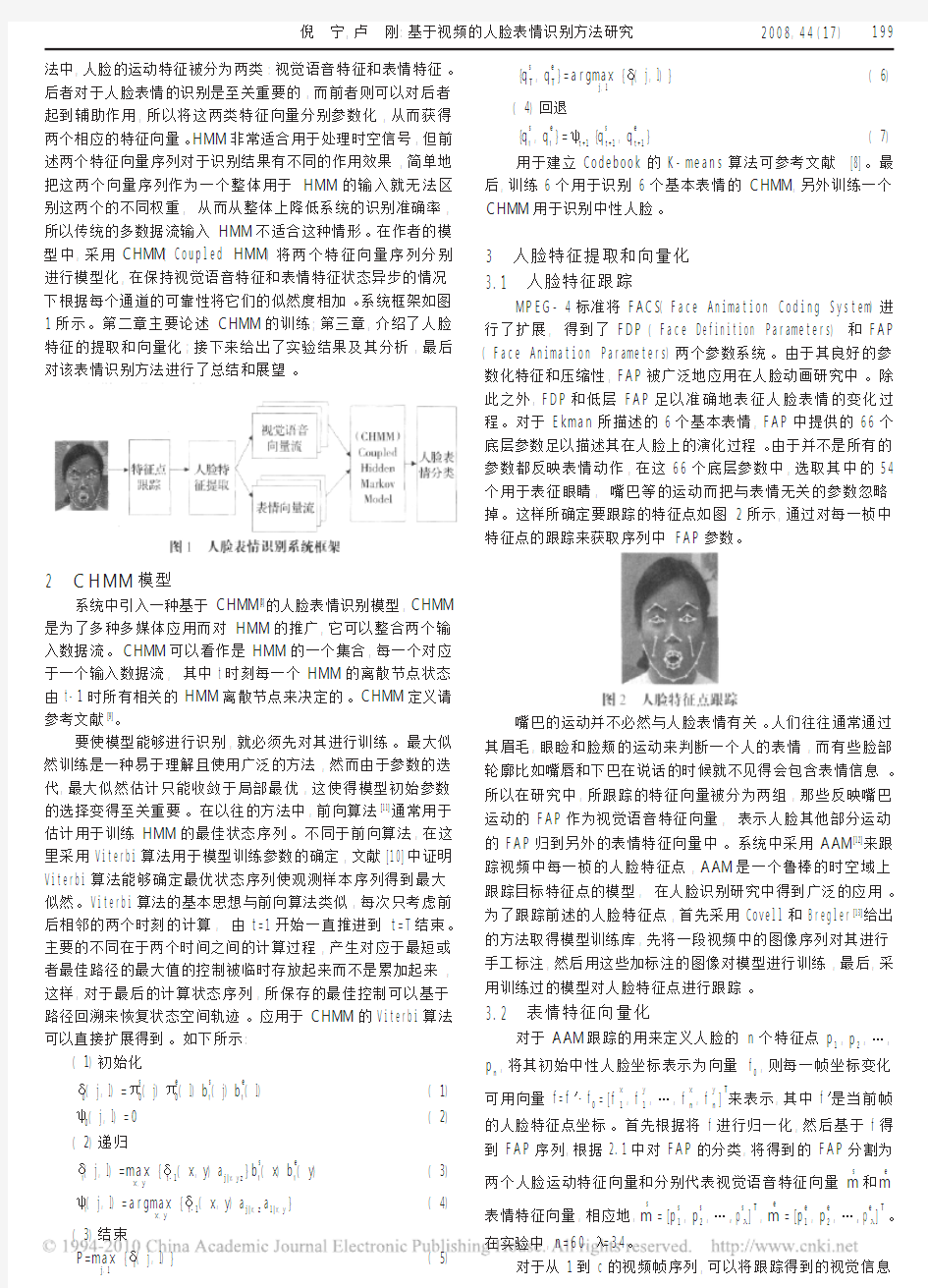

MPEG-4标准将FACS

(FaceAnimationCodingSystem)进行了扩展,得到了FDP(FaceDefinitionParameters)和FAP(FaceAnimationParameters)两个参数系统。由于其良好的参数化特征和压缩性,FAP被广泛地应用在人脸动画研究中。除此之外,FDP和低层FAP足以准确地表征人脸表情的变化过程。对于Ekman所描述的6个基本表情,FAP中提供的66个底层参数足以描述其在人脸上的演化过程。由于并不是所有的参数都反映表情动作,在这66个底层参数中,选取其中的54个用于表征眼睛,嘴巴等的运动而把与表情无关的参数忽略掉。这样所确定要跟踪的特征点如图2所示,通过对每一桢中特征点的跟踪来获取序列中FAP参数。

嘴巴的运动并不必然与人脸表情有关。人们往往通常通过其眉毛,眼睑和脸颊的运动来判断一个人的表情,而有些脸部轮廓比如嘴唇和下巴在说话的时候就不见得会包含表情信息。所以在研究中,所跟踪的特征向量被分为两组,那些反映嘴巴运动的FAP作为视觉语音特征向量,表示人脸其他部分运动的FAP归到另外的表情特征向量中。系统中采用AAM[12]来跟踪视频中每一桢的人脸特征点,AAM是一个鲁棒的时空域上跟踪目标特征点的模型,在人脸识别研究中得到广泛的应用。为了跟踪前述的人脸特征点,首先采用Covell和Bregler[13]给出的方法取得模型训练库,先将一段视频中的图像序列对其进行手工标注,然后用这些加标注的图像对模型进行训练,最后,采用训练过的模型对人脸特征点进行跟踪。

3.2表情特征向量化

对于AAM跟踪的用来定义人脸的n个特征点p1,p2,…,

pn,将其初始中性人脸坐标表示为向量f0,则每一帧坐标变化

可用向量f=f′-f0=[fx

1,fy

1,…,fx

n,fyn]T

来表示,其中f′是当前帧的人脸特征点坐标。首先根据将f进行归一化,然后基于f得到FAP序列,根据2.1中对FAP的分类,将得到的FAP分割为

两个人脸运动特征向量和分别代表视觉语音特征向量ms

和me

表情特征向量,相应地,ms

=[ps

1,ps

2,…,psλ]T

,me

=[pe

1,pe

2,…,peλ]T。在实验中,n=60,λ=34。

对于从1到c的视频帧序列,可以将跟踪得到的视觉信息

倪宁,卢刚:基于视频的人脸表情识别方法研究

199

2008,44(17)ComputerEngineeringandApplications计算机工程与应用

按照上述的定义抽取出来,从而得到两个向量流MS

和ME

:

MS

=[ms1,ms2,…,ms

c](8)ME

=[me

1,me

2,…,me

c]

(9)

这两个向量流用于表情识别模型的输入。

4识别

在识别阶段,两个输入所占的权重是通过实验根据其所

起的作用大小来确定的。形式上,对于观测样本向量Qs,e

t,t时刻的观测概率为

b!s,e

t(i)=bt

(Os,et|qs,et)αse

(10)

其中,指数αs+αe=1并且αs,α

e≥0。每个CHMM首先用20个样本视频片断来进行训练,然后对64个测试用例进行识别,识别结果如表1所示。

基于CHMM的人脸表情识别系统识别率比较稳定,而且好于以往系统[3,5]。

表中的列代表表情识别系统作出的选择。

5结论和展望

文中给出了一个基于CHMM的人脸表情识别系统。为了

更准确地判断人脸表情,将AAM跟踪提取的人脸特征进行分割,建立视觉语音和表情两个特征向量流。给出一个基于

CHMM的人脸表情识别模型,根据输入的两个特征向量流判

断该视频片断中的人脸表情。实验结果证明,该模型优于传统的基于HMM的识别方法。而从整体而言,该系统由于以往的基于静态图像的人脸表情识别系统。

在今后的工作中,将进一步提高当前模型的效率和鲁棒性。除此之外,研究如何将其应用于面向移动终端的低比特率人脸动画合成也是未来的工作重点之一。另外,该模型也可用

于智能机器人以及智能人机交互等领域。

参考文献:

[1]EkmanP,FriensenWV.Facialactioncodingsystem:investigator’s

guide[M].[S.l.]:ConsultingPsychologistsPress,1978.

[2]EkmanP.Strongevidenceforuniversalsinfacialexpressions:Aare-

plytorussel’smistakencritique[J].PsychologistBulletin,1994,115(2):268-287.

[3]CohenI,SebeN,CozmanFG,etal.Learningbayesiannetwork

classifiersforfacialexpressionrecognitionwithbothlabeledandunlabeleddata[C]//ProceedingsofIEEEConferenceonComputerVisionandPatternRecognition,2003.

[4]CohenI,SebeN,ChenL,etal.Facialexpressionrecognitionfrom

videosequencetemporalandstaticmodeling[J].ComputerVisionandImageUnderstanding,SpecialIssueonFacialRecognition,2003,91(1-2):160-187.

[5]MonteP,BonafonteA,LandabasoJL.Emotionrecognitionbasedon

MPEG4facialanimationparameters[C]//ProceedingsofIEEEInter-nationalConferenceonAcoustics,Speech,andSignalProcessing,2002.

[6]CohenI,SebeN,GargA,etal.Facialexpressionrecognitionform

videosequences[C]//ProceedingsofInternationalConferenceonMul-timediaandExpo

(ICME),2002,Ⅱ:121-124.[7]HuTianming,DeSilvaLC,SenguptaK.AhybridapproachofNN

andHMMforfacialexpressionclassification[J].PatternRecognitionLetters,2002,23

(11):1303-1310.[8]NefianAV,LiangLuhong,PiXiaobo,etal.AcoupledHMMfor

audio-visualspeechrecognition[C]//ProceedingsofIEEEInterna-tionalConferenceonAcoustics,Speech,andSignalProcessing,2002.

[9]SongMingli,BuJiajun,ChenChun.Expressionrecognitionfrom

videousingcoupledhiddenMarkovmodel[C]//ProceedingsofIEEETENCON2004,2004.

[10]RabinerLR.AnintroductiontohiddenMarkovmodels[J].IEEE

ASSPMagzine,1986:4-16.

[11]RanbinerLR.AtutorialonhiddenMarkovmodelsandselected

applicationinspeechrecognition[J].ProceedingsofIEEE,1989,77(2):257-285.

[12]CootesTF,EdwardsGJ,TaylorCJ.Activeappearancemodels[C]//

ProceedingsofEuropeanConferenceonComputerVision1998,2:484-498.

[13]CovellM,BreglerC.Eigen-points[C]//ProceedingsofIEEEInter-

nationalConferenceonImageProcessing,1996:471-474.

吃惊高兴生气害怕厌恶沮丧中性总计

吃惊1310000014

高兴190000010

生气

009010010

害怕2011000013

厌恶

00007007

沮丧

00010809

中性

00000156

总计

1610101189569

表1人脸表情识别结果

[13]ThevenazP,BluT,UnserM.Imageinterpolationandresampling[J].

Academic,2000,19:9-15.

[14]CoxGS,deJagerG.Asurveyofpointpatternmatchingtech-

niquesandanewapproachtopointpatternrecognition[C]//Com-municationsandSignalProcessing,1992:243-248.

[15]梁志敏,高洪明,王志江,等.摄象机标定中亚像素级角点检测算法[J].

焊接学报,2006,27(2):101-104.

[16]Grancharov,V,KleijnWB,GeorgievA.sub-pixelregistrationof

noisyimages[C]//2006IEEEInternationalConferenceonAcoustics,SpeechandSignalProcessing,2006,2.

(上接194页)

200

开题报告:人脸识别

北方工业大学 本科毕业设计(论文)开题报告书 题目:基于直方图差值比较方法的人脸识别系统指导教师: 专业班级: 学号: 姓名: 日期:2013年3月20日

一、选题的目的、意义 近些年来,有关人脸的处理已受到广大研究人员越来越多的重视,如人脸识别、人脸定位、面部表情识别、人脸跟踪等。人脸处理系统在安全系统的身份认证、智能人机接口、图像监控、视频检索等领域有着广泛的应用前景。 此外在进行人工智能的研究中,人们一直想做的事情就是让机器具有像人类一样的思考能力,以及识别事物、处理事物的能力,因此从解剖学、心理学、行为感知学等各个角度来探求人类的思维机制、以及感知事物、处理事物的机制,并努力将这些机制用于实践,如各种智能机器人的研制。 同时,进行人脸图像识别研究也具有很大的使用价依。如同人的指纹一样,人脸也具有唯一性,也可用来鉴别一个人的身份。人脸图像的自动识别系统较之指纹识别系统、DNA鉴定等更具方便性,因为它取样方便,可以不接触目标就进行识别,从而开发研究的实际意义更大。并且与指纹图像不同的是,人脸图像受很多因素的干扰:人脸表情的多样性;以及外在的成像过程中的光照,图像尺寸,旋转,姿势变化等。使得同一个人,在不同的环境下拍摄所得到的人脸图像不同,有时更会有很大的差别,给识别带来很大难度。因此在各种干扰条件下实现人脸图像的识别,也就更具有挑战性。 人脸图像识别除了具有重大的理论价值以及极富挑战性外,还其有许多潜在的应用前景,利用人脸图像来进行身份验证,可以不与目标相接触就取得样本图像,而其它的身份验证手段,如指纹、眼睛虹膜等必须通过与目标接触或相当接近来取得样木,在某些场合,这些识别手段就会有不便之处。

基于深度学习的视频人脸识别方法

硕士学位论文 基于深度学习的视频人脸识别方法 THE VIDEO FACE RECOGNITION METHOD BASED ON THE DEEP LEARNING 由清圳 哈尔滨工业大学 2012年12月

国内图书分类号:TP391.9 学校代码:10213国际图书分类号:621.3 密级:公开 硕士学位论文 基于深度学习的视频人脸识别方法 硕士研究生:由清圳 导师:丁宇新副教授 申请学位:工程硕士 学科、专业:计算机技术 所在单位:深圳研究生院 答辩日期:2012年12月 授予学位单位:哈尔滨工业大学

Classified Index: TP391.9 U.D.C: 621.3 Thesis for the Master Degree of Engineering THE VIDEO FACE RECOGNITION METHOD BASED ON THE DEEP LEARNING Candidate:Qingzhen You Supervisor:Associate Prof. Yuxin Ding Academic Degree Applied for:Master of Engineering Speciality:Computer Technology Affiliation:Shenzhen Graduate School Date of Defence:December , 2012 Degree-Conferring-Institution:Harbin Institute of Technology

摘要 本文的视频人脸检测识别方法的基本设计思想是,在给出一段视频文件以及这个视频文件的字幕和剧本之后,可以自动的对视频中的人物进行检测和识别,不需要任何的训练样本。视频人脸检测识别方法主要由四个部分组成:字幕剧本融合部分,人脸检测部分,样本集自动生成部分和基于深度学习的人脸识别部分。本文将深度学习算法引入到了视频人脸识别中来,有两方面的重要意义,一方面,视频人脸的识别要求算法具备一定的抗干扰能力,并且能够保证一定的实时性,本文的实验与分析表明,深度学习算法具备这方面的要求;另一方面,从深度学习算法特性的角度来说,深度学习算法最大的缺点就是构造深度模型需要大量的样本,这很大程度上限制了深度学习算法的应用,然而本文所设计的基于视频的人脸检测模块可以轻松的产生数万、数十万的样本,从而满足了深度学习算法的大样本集要求。 基于深度学习模型的人脸识别部分是整个系统的重点,这一部分主要有两方面的意义:一,经历了视频人脸的检测部分之后,虽然视频人脸集合中人脸的纯度有了很大的提升,但是依然会存在一些杂质,因此必须通过识别模块来进一步的过滤掉人脸集合中的杂质;二,通过视频所得到的帧文件中,经常会出现多张人脸同时出现的情况,在这种情况下,视频人脸的检测部分是无法将说话者与人脸进行对应的,必须通过识别模块才能区分出一个帧中的多个人脸。 基于深度学习模型的人脸识别部分主要包含三个模块:数据预处理模块、深度学习模块和识别模块。数据预处理模块主要由数据整合和构造数据立方体两个部分组成。深度学习模块通过两个具体过程来实现:RBM调节和深度模型的反馈微调。RBM的调节过程是自下而上的各个层间的调节过程,以这种方式来初始化整个深度模型的系统权值,而深度模型的反馈微调,首先进行自下而上的识别模型转换,然后再进行自上而下的生成模型转换,最后通过不同层次之间的不断调节,使生成模型可以重构出具有较低误差的原样本,这样就得到了此样本的本质特征,即深度模型的最高抽象表示形式。经过深度学习模型的处理,可以得到降维之后的样本特征,在此基础上运用识别模块,本文中所采用的识别方法是人工神经网络的识别方法。 关键词:人脸检测;肤色模型;深度学习;识别模型;生成模型;人工神经网络

人脸识别技术的应用背景及研究现状

1.人脸识别技术的应用 随着社会的不断进步以及各方面对于快速有效的自动身份验证的迫切要求,生物特征识别技术在近几十年中得到了飞速的发展。作为人的一种内在属性,并且具有很强的自身稳定性及个体差异性,生物特征成为了自动身份验证的最理想依据。当前的生物特征识别技术主要包括有:指纹识别,视网膜识别,虹膜识别,步态识别,静脉识别,人脸识别等。与其他识别方法相比,人脸识别由于具有直接,友好,方便的特点,使用者无任何心理障碍,易于为用户所接受,从而得到了广泛的研究与应用。除此之外,我们还能够对人脸识别的结果作进一步的分析,得到有关人的性别,表情,年龄等诸多额外的丰富信息,扩展了人脸识别的应用前景。当前的人脸识别技术主要被应用到了以下几个方面:(1)刑侦破案公安部门在档案系统里存储有嫌疑犯的照片,当作案现场或通过其他途径获得某一嫌疑犯的照片或其面部特征的描述之后,可以从数据库中迅速查找确认,大大提高了刑侦破案的准确性和效率。 (2)证件验证在许多场合(如海口,机场,机密部门等)证件验证是检验某人身份的一种常用手段,而身份证,驾驶证等很多其他证件上都有照片,使用人脸识别技术,就可以由机器完成验证识别工作,从而实现自动化智能管理。 (3)视频监控在许多银行,公司,公共场所等处都设有24小时的视频监控。当有异常情况或有陌生人闯入时,需要实时跟踪,监控,识别和报警等。这需要对采集到的图像进行具体分析,且要用到人脸的检测,跟踪和识别技术。 (4)入口控制入口控制的范围很广,既包括了在楼宇,住宅等入口处的安全检查,也包括了在进入计算机系统或情报系统前的身份验证。 (5)表情分析根据人脸图像中的面部变化特征,识别和分析人的情感状态,如高兴,生气等。此外,人脸识别技术还在医学,档案管理,人脸动画,人脸建模,视频会议等方面也有着巨大的应用前景。 2.人脸识别技术在国外的研究现状 当前很多国家展开了有关人脸识别的研究,主要有美国,欧洲国家,日本等,著名的研究机构有美国MIT的Media lab,AI lab,CMU的Human-Computer I nterface Institute,Microsoft Research,英国的Department of Engineerin g in University of Cambridge等。综合有关文献,目前的方法主要集中在以下几个方面: (1)模板匹配 主要有两种方法,固定模板和变形模板。固定模板的方法是首先设计一个或几个参考模板,然后计算测试样本与参考模板之间的某种度量,以是否大于阈值来判断测试样本是否人脸。这种方法比较简单,在早期的系统中采用得比较

面部表情识别实验报告分析

面部表情识别实验 实验报告 小组成员: 面部表情识别实验 西南大学重庆 400715

摘要:情绪认知是一种复杂的过程,它包含观察、分析、判断、推理等,是借助于许多线索,特别是借助面部那些活动性更大的肌肉群的运动而实现的。所以,情绪认知的准确度受多种因素的影响。 当我们与他人相互交往的时候,不管是不是面对面。我们都正在不断的表达着情绪,同时又正在观察,解释着的对方做出的表情,在人际交往过程中,情绪的表达和认知是十分的迅速和及时,那么人是借助于哪些表情来认知他人的情绪的呢?情绪识别实际上并不是针对表情本身的,而是针对这它背后的意义。例如:皱眉可能是一种情绪的表现,我们见到这种面部表情就试图解释潜在于它背后的情绪。尖锐,短促,声音嘶哑可能是一种情绪表现,我们听到这种语言表情就试图解释潜在于它背后的情绪捶胸,顿足可能是一种情绪的表现,我们见到这种动作表情就是试图解释潜在于它背后的情绪。对于这个复杂的问题,心理学家曾经做过许多的研究。 面部表情认知的研究可分为两个步骤:第一步是面部表情刺激物的制作或选择,这可以用专门拍摄(录像)或图示来描画,也可以用完全装扮出的活生生的表情或自发的表情等。第二步时对表情进行识别评定。也可以用多种方法,如自由评定法,即让被试自由地对表情给出情绪词汇;或限制评定法,即向被试提供各种提供各种情绪词汇或情绪情境,要求被试只能根据所提供的情绪词汇或者情绪情境进行分类或者匹配等;或参照自由评定法,即向被试提供参考线索(如情境,人格特征等),让其说出所表达的情绪的词汇等。 关键词:情绪表情认知线索

1 前言 传统心理学把情绪列为心理现象的三大方面之一。情绪也是心理学理论体系中一个不可缺少的研究环节。情绪(emotion)是体验,又是反应;是冲动,又是行为;它是有机体的一种复合状态。情绪的表现有和缓的和激动的,细微的和强烈的,轻松的和紧张的等诸多形式,广泛地同其他心理过程相联系。自古以来,科学家们十分注意探讨情绪之奥妙,但与情绪的重要性不相适应的是,长期以来情绪研究一直是心理学尤其是实验心理学研究中的一个薄弱环节。造成这一现象的最主要原因是情绪所特有的复杂性以及由此衍生出来的情绪研究方法学上的困难。我国心理学家孟昭兰(1987)将理论认为面部表情是传递具体信息的外显行为面部表情是提供人们在感情上互相了解的鲜明标记。情绪过程既包括情绪体验,也包括情绪表现,而表情既是情绪的外部表现,也是情绪体验的发生机制;既是最敏锐的情绪发生器,也是最有效的情绪显示器。这就从机制上说明了以面部肌肉运动模式作为情绪标志的根据。 面部表情(facial expression_r)的发生是有其客观的物质基础的:表情按面部不同部位的肌肉运动而模式化,面部反应模式携带着心理学的意义,那就是或快乐、或悲伤等具体情绪。但是,对表情进行测量的原则在于:所要测量的是面孔各部位的肌肉运动本身,而不是面部所给予观察者的情绪信息。该实验将14名被试分为两组进行表情认知的实验,实验目的在于通过实验了解面部表情认知的基本

人脸识别

人脸识别项目 一、目的 用有监督学习机制设计并实现模式识别方法,用于进行人脸面部特征识别,如性别(男性、女性)、年龄(儿童、青少年、成年、老年)、佩戴眼镜(是、否)、戴帽子(是、否)、表情(微笑、严肃)等。 二、内容 人脸识别是模式识别的一个重要的应用领域。其识别过程包括:特征提取与选取、分类(包括训练与测试)、分类器性能评估。 三、数据 四个文本文件: faceR: 训练数据,100个属性(其中第一个属性是编号,其余99个是本征脸(eigenface) 属性参数,共2000个人脸的数据。 faceS: 测试数据,100个属性(其中第一个属性是编号,其余99个是本征脸(eigenface) 属性参数,共2000个人脸的数据。 faceDR: 对faceR文件中的每一个人脸数据的说明。 faceDS: 对faceS文件中的每一个人脸数据的说明。 提示:由于数据是真实数据,会有以下情况: 1)有缺失数据(如1228, 1808, 4056, 4135, 4136, and 5004),建议将有缺失数据的人脸记录不予考虑 2)有错误数据,建议对有错误的人脸记录不予考虑 原始数据:各个人脸的原始图象数据在目录rawdata中 四、要求 1)将数据导入MATLAB 2)确定分类的目标(可以是下面的一个目标,或多个目标的组合) a)性别(男性、女性) b)年龄(儿童、青少年、成年、老年) c)佩戴眼镜(是、否) d)戴帽子(是、否) e)表情(微笑、严肃)等。 3)选用一种分类算法(距离分类器、Bayes分类器、SVM、ANN 或Decision Trees),先用faceR中的数据对分类器进行训练,然后用faceS中的数据对训练好的分类器 的性能(分类准确率)作出评估。当然,有些分类算法需要验证数据,可以根据需 要从faceR或faceS中随机抽取验证数据,验证数据的数据量应该不少于500个人 脸记录。 4)用MATLAB编程实现模式识别的整个过程(可以直接调用相关的函数)。 5)完成项目报告,具体内容包括: a)模式识别问题的说明,重要是说明分类的目标 b)模式识别过程的说明:采用何种分类算法,改算法的基本原理,是否进行了特 征提取或特征选取,程序的基本流程框图,训练的结果,测试的结果,分类器

【CN110084152A】一种基于微表情识别的伪装人脸检测方法【专利】

(19)中华人民共和国国家知识产权局 (12)发明专利申请 (10)申请公布号 (43)申请公布日 (21)申请号 201910285839.7 (22)申请日 2019.04.10 (71)申请人 武汉大学 地址 430072 湖北省武汉市武昌区珞珈山 武汉大学 (72)发明人 王中元 王光成 肖晶 何政 (74)专利代理机构 武汉科皓知识产权代理事务 所(特殊普通合伙) 42222 代理人 魏波 (51)Int.Cl. G06K 9/00(2006.01) G06K 9/62(2006.01) G06N 3/04(2006.01) (54)发明名称 一种基于微表情识别的伪装人脸检测方法 (57)摘要 本发明针对伪装人脸识别的问题,公开了一 种基于微表情识别的伪装人脸检测方法,首先采 集不同情境和不同摄像环境下的伪装与真实人 脸的微表情视频序列,再通过基于卷积神经网络 (CNN)和长短记忆模块(LSTM)的微表情识别模型 对伪装和真实人脸的微表情序列进行特征提取, 并引入微表情熵和皮尔逊系数来分析二者微表 情特征空间的差异,接着采用K -means聚类方法 对不同情境下和不同视觉质量的伪装与真实人 脸的微表情特征空间进行聚类;最后构建伪装和 真实人脸的微表情特征差异分析模型并进行伪 装人脸检测。与现有人脸活体检测技术相比,本 发明能够有效识别高仿人脸面膜伪装和面部化 妆伪装。权利要求书2页 说明书4页 附图2页CN 110084152 A 2019.08.02 C N 110084152 A

1.一种基于微表情识别的伪装人脸检测方法,其特征在于,包括以下步骤: 步骤1:采集伪装和真实人脸在不同情境和不同摄像环境下产生的微表情视频序列,包括高兴、惊讶、悲伤、愤怒、厌恶和恐惧等六种基本微表情; 步骤2:利用一种基于CNN和LSTM的微表情识别网络来提取微表情特征,通过微表情熵和皮尔逊相关系数来量化真实人脸和伪装人脸微表情特征空间的差异; 步骤3:利用K -means聚类方法对不同情境和不同视觉质量的伪装和真实人脸的微表情特征空间进行聚类,分析不同情境和不同视觉质量对伪装与真实人脸微表情区别显著性的影响; 步骤4:构建伪装和真实人脸的微表情特征差异分析模型; 微表情由构成微表情的微动作组成,真实人脸的面部微动作丰富且细腻,伪装人脸的面部微动作呆板且稀疏以至于表达能力有限;当微动作稀疏到预定程度时,伪装人脸就只存在一种表情,此时不存在微表情; 步骤5:根据所述伪装和真实人脸的微表情特征差异分析模型进行伪装人脸检测。 2.根据权利要求1所述的基于微表情识别的伪装人脸检测方法,其特征在于:步骤1中,采用诱发式的方法来采集微表情视频序列。 3.根据权利要求1所述的基于微表情识别的伪装人脸检测方法,其特征在于,步骤2的具体实现包括以下子步骤: 步骤2.1:采用基于CNN和LSTM的微表情识别方法来提取伪装和真实人脸的微表情特征; 通过CNN提取将每个微表情帧编码成特征向量;将CNN提取的特征向量通过LSTM得到最终包括时空特性的微表情特征;所提取的特征为softmax层之前的长度为128的一维向量; 步骤2.2:通过微表情熵的数值大小来辨识真实和伪装人脸;微表情熵的计算方式如 下: 其中,p i 步骤2.1中提取的微表情特征值,n=128表示提取的一维特征空间的长度;当微表情空间包含的面部微动作越复杂时微表情熵的值越大,反之微表情熵越小代表微表情空间的微动作越稀疏; 步骤2.3:通过皮尔逊相关系数预测伪装和真实人脸微表情特征空间的相关性;皮尔逊 相关系数的计算方式如下: 其中,X和Y分别代表两组微表情特征空间, 和分别表示两组向量X和Y的均值;ρ范围为-1到+1,0代表无相关性,负值为负相关,正值为正相关;当两组微表情特征空间都为真实或伪装人脸微表情特征空间时,ρ值越接近1;当两组微表情特征空间分别为真实和伪装人脸微表情特征空间时,ρ值越小。 4.根据权利要求1所述的基于微表情识别的伪装人脸检测方法,其特征在于,步骤3的具体实现包括以下子步骤: 权 利 要 求 书1/2页2CN 110084152 A

基于eigenfaces的人脸识别算法实现大学论文

河北农业大学 本科毕业论文(设计) 题目:基于Eigenfaces的人脸识别算法实现 摘要 随着科技的快速发展,视频监控技术在我们生活中有着越来越丰富的应用。在这些视频监控领域迫切需要一种远距离,非配合状态下的快速身份识别,以求能够快速识别所需要的人员信息,提前智能预警。人脸识别无疑是最佳的选择。可以通过人脸检测从视频监控中快速提取人脸,并与人脸数据库对比从而快速识别身份。这项技术可以广泛应用于国防,社会安全,银行电子商务,行政办公,还有家庭安全防务等多领域。 本文按照完整人脸识别流程来分析基于PCA(Principal Component Analysis)的人脸识 别算法实现的性能。首先使用常用的人脸图像的获取方法获取人脸图像。本文为了更好的分析基于PCA人脸识别系统的性能选用了ORL人脸数据库。然后对人脸数据库的图像进行了简单的预处理。由于ORL人脸图像质量较好,所以本文中只使用灰度处理。接着使用PCA提取人脸特征,使用奇异值分解定理计算协方差矩阵的特征值和特征向量以及使用最近邻法分类器欧几里得距离来进行人脸判别分类。 关键词:人脸识别PCA算法奇异值分解定理欧几里得距离

ABSTRACT With the rapid development of technology, video surveillance technology has become increasingly diverse applications in our lives. In these video surveillance urgent need for a long-range, with rapid identification of non-state, in order to be able to quickly identify people the information they need, advance intelligence warning. Face recognition is undoubtedly the best choice. Face detection can quickly extract human faces from video surveillance, and contrast with the face database to quickly identify identity. This technology can be widely used in national defense, social security, bank e-commerce, administrative offices, as well as home security and defense and other areas. In accordance with the full recognition process to analyze the performance of PCA-based face recognition algorithm. The first to use the method of access to commonly used face images for face images. In order to better analysis is based on the performance of the PCA face recognition system selected ORL face database. Then the image face database for a simple pretreatment. Because ORL face image quality is better, so this article uses only gray scale processing. Then use the PCA for face feature extraction using singular value decomposition theorem to calculate the covariance matrix of the eigenvalues and eigenvectors, and use the Euclidean distance of the nearest neighbor classifier to the classification of human face discrimination. KEYWORDS: face recognition PCA algorithm SVD Euclidean distance

视频监控中低分辨率人脸识别

视频监控中低分辨率人脸识别 发表时间:2019-01-02T16:19:32.767Z 来源:《知识-力量》2019年3月中作者:王鑫汪国强 [导读] 针对视频监控中的低分辨率识别问题,本文介绍了研究现状和存在的问题,对于传统LR人脸识别算法作了详细的介绍。然后针对传统研究算法存在的问题与不足 (黑龙江大学,黑龙江哈尔滨 150000) 摘要:针对视频监控中的低分辨率识别问题,本文介绍了研究现状和存在的问题,对于传统LR人脸识别算法作了详细的介绍。然后针对传统研究算法存在的问题与不足,又介绍了目前研究最火热的基于深度学习的超分辨率重建人脸识别算法并对未来的发展趋势作了简单的叙述。 关键词:深度学习;人脸识别;超分辨率;监控视频 1.前言 随着“平安城市”、“智慧城市”等国家政策的提出,安防受到全面重视。而“雪亮工程”、“天网工程”更是偏重于以视频监控系统为基础,从人体固有特征出发,对个人身份进行认证鉴定。人脸作为最重要的身份特征之一,具有非接触、非侵犯性等优点,与监控视频中监控对象非接触的特点相契合,因此监控视频中人脸识别获得了快速的发展。 2.存在的问题和研究现状 视频监控中的人脸识别技术,与传统的对静态图像的人脸识别不同,不是人脸迎合摄像头,而是由摄像头来捕捉人脸。监控系统是在非约束状态进行人脸采集的,易受光照、所处人群、角度、环境、表情姿态等因素的影响,多数是模糊的、质量偏低的、低分辨率的,这造成了数据库中的正面高清图像与监控系统获取的真实画面存在较大的差异。因此要想达到比较好的识别效果,人脸识别技术首要解决的问题就是这个问题,即低分辨率人脸识别问题。 目前业内一般把低分辨率人脸识别分为两种:一种是直接方法,即分辨率稳健特征表达方法,另一种方法是间接的方法,即对低分辨率样本进行超分辨率重建,得到含有较多特征信息的高分辨率图像,然后再使用常规人脸识别方法进行识别。 3.传统低分辨率人脸识别 LR人脸识别与SR人脸识别过程类似,分别对基准集和测试集样本提取分辨率稳健特征,对所提取特征进行比较,得出身份判定结果。与SR图像不同之处在于维度的不匹配,所以传统的解决思路又三种: 3.1 上采样 即图像插值,如最近邻插值、双三次等。对LR图像进行上采样操作,即在现有的人脸信息上拟合新的像素点,使其变换成与参考图像具有相同尺寸的高分辨率图像,然后再提取特征,利用传统人脸识别方法进行分类识别。 3.2 下采样 即图像缩小,将SR图像下采样到和待识别LR图像一样的尺寸大小,再提取特征,直接和LR待识别图像提取的特征进行匹配,虽然解决了维度不匹配问题,不会产生噪声,但会减少鉴别性的人脸信息。 3.3 统一特征空间 即中间分辨率空间。对SR图像进行特征降维,LR图像进行特征扩展,映射到同一特征空间中。统一特征空间直接解决特征维度不匹配问题,但最优的非线性耦合映射并没有较好的方法直接获取,由于是从两端的样本集同时向统一空间映射,复杂的变换会带来新的干扰。 4.超分辨率重建的低分辨率人脸识别 图像超分辨率(super resolution,SR)技术旨在提高低分辨率(low resolution,LR)图像的分辨率,同时最小化附加视觉伪影,人脸超分辨率重建,也称为“人脸幻想”。主要有基于插值、重建、学习的三种重建算法。 4.1 基于插值的重建方法 该方法主要有最近邻插值、双线性插值以及三次插值等方法,理论依据是假设图像为连续的,那么图像新增位置的像素可以通过相邻像素值计算得出,从而实现图像的超分辨率重建。该类方法只是增加了图像像素的个数,而没有增加额外的高频信息,因此图像的质量不是太高。 (1)最近邻插值 最近邻插值法是最简单的灰度值插值,将变换后的图像中的原像素点最邻近像素的灰度值赋给原像素点。 (2)双线性插值 在x,y方向上分别进行一次线性插值,对目标图像(x,y)先通过最近邻插值映射到源图的(X+u,Y+v),u、v是小数部分,由于图像坐标都为整数,因此上述点不存在,所以取其附近四个领域点(X,Y)、(X,Y+1)、(X+1,Y)、(X+1,Y+1)的像素值,进行权值计算,得到目标图像(X,Y)处的像素值达到重建的目的。 (3)双三次插值 对周边16个点进行插值运算,具体可描述为目标图像(X,Y)坐标先映射到源图像的坐标(X+u,Y+v),接着找到该点最近的16个像素点将每个点的像素值按照不同的权值求和即得到待插值点的像素值。 4.2 基于重建的重建方法 其原理是通过观测LR样本来实现对SR的约束。通常用未知HR的先验知识作为正则化项来规范SR重建这个病态问题的解,确定性和随机方法是实现正则化的两种不同方式。 (1)最大后验概率算法(MAP) 该算法先给图像一个先验模型,模型由马尔可夫随机场确定,接着根据LR图像系列,实现目标SR图像达到最大后验概率。一般分为三个步骤:一、用两个随机的过程分别表示输入的LR和SR图像;二、接着使SR图像的后验概率值最大值;三、将后验概率的最大值公式按照

基于MATLAB的人脸识别

基于MATLAB的人脸识别

————————————————————————————————作者: ————————————————————————————————日期:

图像识别 题目:基于MATLAB的人脸识别 院系:计算机科学与应用系 班级: 姓名: 学号: 日期:

设计题目基于MATLAB的人脸识别设 计技术参数 测试数据库图片10张训练数据库图片20张图片大小1024×768 特征向量提取阈值 1 设计要求综合运用本课程的理论知识,并利用MATLAB作为工具实现对人脸图片的预处理,运用PCA算法进行人脸特征提取,进而进行人脸匹配识别。 工作量 两周的课程设计时间,完成一份课程设计报告书,包括设计的任务书、基本原理、设计思路与设计的基本思想、设计体会以及相关的程序代码; 熟练掌握Matlab的使用。 工作计划第1-2天按要求查阅相关资料文献,确定人脸识别的总体设计思路; 第3-4天分析设计题目,理解人脸识别的原理同时寻求相关的实现算法;第5-8天编写程序代码,创建图片数据库,运用PCA算法进行特征提取并编写特征脸,上机进行调试; 第9-12天编写人脸识别程序,实现总体功能; 第13-14天整理思路,书写课程设计报告书。 参考资料1 黄文梅,熊佳林,杨勇编著.信号分析与处理——MATALB语言及应用.国防科技大学出版社,2000 2 钱同惠编著.数字信号处理.北京:机械工业出版社,2004 3 姚天任,江太辉编著.数字信号处理.第2版.武汉:武汉理工大学出版社,2000 4 谢平,林洪彬,王娜.信号处理原理及应用.机械工业出版社,2004 5刘敏,魏玲.Matlab.通信仿真与应用.国防工业出版社,2005 6 楼顺天.基于Matlab7.x 的系统分析与设计.西安电子科技大学,2002 7孙洪.数字信号处理.电子工业出版社,2001 目录 引言?错误!未定义书签。 1 人脸识别技术?错误!未定义书签。 1.1人脸识别的研究内容?错误!未定义书签。 1.1.1人脸检测(Face Detection)........... 错误!未定义书签。

2019年微表情识别-读脸读心最新考试答案

2019年微表情识别-读脸读心最新满分考试答案 一、单选题(题数:40,共 40.0 分) 1.愉悦的识别要点包括的表情形态和意义,以下错误的是?()A A.瞪眼 B.咧嘴 C.嘴角上扬 D.超乎预期的满足和开心 2. 微表情是指持续时间多长的表情?() B A、1/2秒 B、不足1/5秒 C、5秒 D、以上都不对 3. 关于猜测选放的墙的测试哪一项描述是错误的?()B A、李博士回应天蝎座,b型血、警号3867问题时目光低视,摇头说我不知道是控制的对抗反应 B、在听到十八岁那年考上了海洋大学出现快速眨眼,点头是思考比对时的真实反应 C、在听到这成为了您神探之路的起点时出现连连点头是高度认同的下意识反应 D、人在接受有效刺激时也能完全控制自己的情绪反应 4. 冻结反应的形态意义哪一项描述是错误的?()D A、面部的惊讶 B、肢体的约束 C、呼吸的控制 D、肢体冰冷 5. 有意控制的动作的形态意义哪一项描述是错误的?()D A、可以出现在面部表情 B、可以出现在身体动作 C、可以出现在站姿或坐姿 D、可以控制出汗或面部颜色 6. 国内探索微表情应用研究的实战机构不包括哪些?()D A、公安机构 B、检察机构

C、安全机构 D、环保机构 7. 反应性行为的形态意义哪一项描述是错误的?() D A、包括副语言行为 B、包括头部反应 C、是难以自主控制的生理反应 D、是可以自主控制的生理反应 8. 关于表达者表达解析哪一项描述是正确的?() B A、疏忽几个表情动作的观察不影响准确判断其真实内心 B、是准确认识表达者内心的基础和前提 C、只要盯着其眼动反应就能准确判断其真实内心 D、只要关注其情绪与事件性质是否一致就能准确判断其真实内心 9. 爱恨反应的形态意义哪一项描述是错误的?() D A、爱的时候会主动亲近对方 B、恨的时候会主动拉开距离 C、身体间的距离,可以体现出人和人之间的心理距离 D、人的内心的喜爱与厌恶是不能从表情动作中表达出来的 10. 保罗·埃克曼研究的微表情主要在哪个领域?() C A、身体动作 B、副语言 C、面部表情 D、以上都不对 11. 仰视反应的形态意义哪一项描述是错误的?() D A、头和肢体向上是正仰视反应 B、头和肢体向下是负仰视反应 C、有身份地位差异的握手是正或负仰视反应的体现 D、头和肢体远离刺激源 12. 关于松明猜测硬币藏匿手的测试哪一项描述是错误的?()D A、王力宏上台即双手叉腰或抱胸是紧张的对抗反应

视频门禁之动态人脸识别侦测门禁、通道、梯控系统解决方案

视频门禁之人脸识别监控系统解决方案 一、需求背景 在公共场所,人流量巨大,依靠人力无法有效地在流动的人群中发现布控目标,在不干扰群众自由通行的情况下,很难快速方便的辨别其身份。传统方式,案发后常常需要出动整个侦查队加班加点反复看视频,不但耗费大量警力而且容易错过追捕时机。 为了对付各种各样的刑事犯罪,保护国家和人民群众的生命财产安全,保证各行各业和国家重点部门的正常运转,采用高科技手段预防和制止犯罪已成为平安城市建设的需要。随着人脸识别技术的发展,诸多人像比对系统已经在公安的治安、刑侦等业务中获得有效的应用。公安部门在特殊场所追缉在逃人员一直以来是个很棘手的问题。由多奥自主研发的领先的人脸识别技术,将动态人脸识别技术应用于视频监控中,从而使在不易被监控目标察觉的情况下,达到中远距离识别验证后台报警提示的效果。 将动态人脸识别技术与视频监控相结合,对重点监控区域进行人脸识别布控,对于协助公安干警快速侦破案件,避免犯罪事件的发生,维护社会和谐稳定,创建平安和谐城市具有重要的意义。

二、系统概述 人脸识别布控系统,把各处采集到的人脸信息与布控人脸进行比对,能够同时进行多路视频分析比对,在发现目标后迅速提示并将警情推送至客户端。此外,系统还支持单目标多张照片批量导入,多目标批量照片导入等各种导入方式,在降低了技术人员的工作量同时大幅提高了安保人员的工作效率。即使抓拍人在行进中转头、低头仍然能做出准确跟踪和抓拍。 系统采用服务器/客户端结构。服务器保存黑名单人员的面部信息,实现人员识别和报警的功能,而客户端实时接收来自一个或多个通道摄像头的面部数据,并和黑名单中的人员进行对比。

人脸表情识别

图像处理与模式识别 ------人脸表情识别介绍摘要:人脸表情是我们进行交往和表达情绪的一种重要手段,不经过特殊训练,人类对其面部表情往往很难掩饰,所以,通过对人脸表情进行分析,可以获得重要的信息。人脸表情识别是人机交互的智能化实现的一个重要组成部分,也是模式识别、图像处理领域的一个重要研究课题,近几年来,受到了越来越多的科研人员的关注。 本文综述了国内外近年来人脸表情识别技术的最新发展状况,对人脸表情识别系统所涉及到的关键技术: 人脸表情特征提取,做了详细分析和归纳。 关键词:人脸定位;积分投影;人脸表情识别;流形学习;局部切空间排列Abstract:Facial expression is a kind of important means that we communicate and express the special training, People often difficult to conceal their facial , by the analyzing facial expression, we can obtain important information. Facial expression recognition is an important component that the implementation of human-computer interaction, and an important research topic in the field of pattern recognition, image processing, in recent years, more and more researchers focus on this topic. In this paper,we present the latest development of this area,and give a detailed analysisand summary for facial

人脸识别介绍

人脸识别技术是生物识别技术的一种,它结合了图像处理、计算机图形学、模式识别、可视化技术、人体生理学、认知科学和心理学等多个研究领域。从二十世纪六十年代末至今,人脸识别算法技术的发展共经历了如下四个阶段: 1. 基于简单背景的人脸识别 这是人脸识别研究的初级阶段。通常利用人脸器官的局部特征来描述人脸。但由于人脸器官没有显著的边缘且易受到表情的影响,因此它仅限于正面人脸(变形较小)的识别。 2. 基于多姿态/表情的人脸识别 这是人脸识别研究的发展阶段。探索能够在一定程度上适应人脸的姿态和表情变化的识别方法,以满足人脸识别技术在实际应用中的客观需求。 3. 动态跟踪人脸识别 这是人脸识别研究的实用化阶段。通过采集视频序列来获得比静态图像更丰富的信息,达到较好的识别效果,同时适应更广阔的应用需求。 4. 三维人脸识别 为了获得更多的特征信息,直接利用二维人脸图像合成三维人脸模型进行识别,即将成为该领域的一个主要研究方向。 人脸识别技术的研究范围主要包括以下几个方面: 1. 人脸检测:在输入的图像中寻找人脸区域。 2. 人脸的规范化:校正人脸在尺度、光照和旋转等方面的变化。 3. 特征提取:从人脸图像中映射提取一组能反映人脸特征的数值表示样本。 4. 特征匹配:将待识别人脸与数据库中的已知人脸比较,得出相关信息。 人脸识别流程 1图像预处理 1.1 图像去噪 一般来说,自然界中的噪声可以看成是一种随机信号。根据图像获取的途径人脸图像获取 人脸检测 定位人脸区域 预处理 特征抽取 人脸特征 对比识别 结果 人脸特征库

不同,噪声的融入也有多种方式: 1. 图像是直接以数字形式获取的,那么图像数据的获取机制会不可避免地 引入噪声信号; 2. 在图像采集过程中,物体和采集装置的相对运动。或采集装置的抖动, 也会引入噪声,使图像变的模糊不清; 3. 在图像数据的电子传输过程中,也不同程度的引入噪声信号。 这些噪声信号的存在,严重的情况会直接导致整幅图像的不清晰,图象中的景物和背景的混乱。对于用于人脸识别的图像。由于噪声的引入,将不可避免地造成识别率的下降。对图像噪声的消除可以通过两个途径:空间域滤波或频率域滤波。消除噪声的方法很多,对于不同的噪声应该采用不同的除噪方法。主要的方法是:线性滤波、中值滤波、维纳滤波以及小波去噪等。 1.2 增强对比度 为了使人脸在图像中更为突出以便于下一步的特征提取,增强图像对比度是很有必要的。增强对比度有很多种方法,常见的有直方图均衡化和“S ”形变换等方法。 “S ”形变换方法将灰度值处于某一范围(人脸特征范围)内的像素灰度分布差距拉开,从而保证了对比度的提高,但此方法降低了其他灰度值的对比度。而直方图均衡化则是将像素的灰度分布尽量展开在所有可能的灰度取值上,这样的方法同样能使得图像的对比度提高。 将彩色图像转化成灰度图像是人脸识别方法中常见的处理过程,虽然转化过程丢失了一部分色彩信息,但是灰度图像拥有更小的存储空间和更快的计算速度。文献[1]给出了一种能够将RGB 色彩转换成灰度级且适于突出人脸区域对比度的转换模型:()5.0144.0587.0299.0,+?+?+?=b g r y x f ;其中f 代表灰度值,r ,g ,b 分别表示Red,Green,Blue 分量的值。 文献[2]通过将人脸彩色图像从RGB 色彩空间转换到RIQ 色彩空间,得到了更适于频谱分析的特征分量。

微表情及其应用

微表情及肢体语言的奥秘 微表情介绍 微表情,是内心流露与掩饰,是心理学名词。“微表情”最短可持续1/25秒,虽然一个下意识的表情可能只持续一瞬间,但这是种烦人的特性,很容易暴露情绪。通过研究微表情可以判断一些更加准确的信息 人的脸部可以传达信息,是一种信息传输器,人们无意识的表情会无法控制的表现在面部,“微表情”一闪而过,通常甚至清醒的作表情的人和观察者都察觉不到。比起人们有意识做出的表情,“微表情”更能体现人们真实的感受和动机。 肢体语言介绍 肢体语言,是指由身体的各种动作代替语言本身来表情达意的一种特殊语言。通俗讲是指通过头、眼、颈、手、肘、臂、身、胯、腿、足等人体部位的协调活动向交流对象传达信息,借表情达意的一种沟通方式。不同的肢体语言在不同情况下所传达的不同心理意义。 前人研究状况 微表情这一概念最早由美国心理学家保罗〃埃克曼在1969年提出。当时,一个名叫玛丽的重度抑郁症患者告诉主治医生,想要回家看看自己的剑兰和花猫。提出请求的时候,她显得神情愉悦而放松,

不时地眯起眼睛微笑,摆出一副撒娇的模样。令人震惊的是,玛丽在回家之后,尝试了3种方法自杀,结果未遂。 事后,埃克曼将当时的视频反复播放,用慢镜头仔细检视,突然在两帧图像之间看到了一个稍纵即逝的表情,那是一个生动又强烈的极度痛苦的表情,只持续了不到1/15秒。后来,埃克曼将其称为“微表情”。 1978年,埃克曼发布了面部动作编码系统。在这一系统中,人脸部的肌肉有43块,可以组合出1万多种表情,其中3000种具有情感意义。埃克曼根据人脸解剖学特点,将其划分成若干相互独立又相互联系的运动单元。分析这些运动单元的运动特征及其所控制的主要区域以及与之相关的表情,就能得出面部表情的标准运动。2002年,这个系统进行了一次升级,对表情的捕捉准确率达到了90%。 研究内容 现阶段中学生研究本课题可以研究微表情在现实生活中的应用,一些微表情和肢体语言的含义及在生活中的发现与理解。 现实生活中的应用 在社会层面,目前针对微表情的研究已经应用到各个领域。在国家安全领域,有些训练有素的危险人物可能轻易就通过测谎仪的检测,但是专业人员可以通过微表情通过微表情,发现他们

基于ARM的视频人脸识别系统设计与实现

基于ARM的视频人脸识别系统设计与实现 发表时间:2018-10-22T09:48:05.817Z 来源:《防护工程》2018年第12期作者:招永铸 [导读] 现代社会对个人身份认证的方便性和有效性要求越来越高,传统的身份认证方法面临着严峻的挑战, 本文设计和实现了一种基于ARM 嵌入式视频的实时人脸识别系统,经测试验证了其实用性以及实时性,可以推广应用。 招永铸 广东鼎华科技股份有限公司广东佛山 528000 摘要:现代社会对个人身份认证的方便性和有效性要求越来越高,传统的身份认证方法面临着严峻的挑战, 本文设计和实现了一种基于ARM 嵌入式视频的实时人脸识别系统,经测试验证了其实用性以及实时性,可以推广应用。 关键词:ARM嵌入式;远程视频;实时;人脸识别 人脸作为一种人体生物特征,具有难以伪造、不会遗失、随身携带、方便易用等特点。人脸识别技术特指利用分析、比较人脸视觉特征信息进行身份鉴别的计算机技术,是模式识别在图像领域中的具体运用,其应用前景非常广阔,可以应用到身份证件的鉴别、自动门禁控制系统、银行取款机、家庭安全,图片检索等领域。可传统的人脸识别系统以电脑为平台,体积大,使用不灵活,而嵌入式ARM平台具有体积小、低功耗、高性能、低成本的特点,因此基于ARM平台开发人脸识别系统具有重要的应用价值。 1.基本结构及工作原理 远程视频实时人脸识别系统的设计,集视频前端和显示终端为一体。视频前端采用搭载了linux操作系统的三星公司ARM 芯片作为开发环境,外部接有UVC 摄像头和无线网卡等。为了减轻CPU 的工作压力,UVC 摄像头自带DSP 芯片自动压缩采集到的图像为MJPEG 格式,然后再将无线网卡设置为AP热点模式而无需路由器的介入,并通过它来建立起一个视频前端服务器,用以接收控制信号和发送视频。显示终端基于Qt+OpenCV 的开发环境,首先接收视频前端传来的视频流并进行图像的预处理,并结合相应算法实现最终的视频监控以及人脸识别等功能,总体硬件框架如图1所示 图1 总体硬件框架 2.视频前端部分设计 2.1 硬件部分选型 视频前端采用三星公司的ARM9系列S3C2440作为处理器,工作频率可达400 MHz,完全能够满足高效的视频采集和视频传输要求,同时该处理器也内置各类控制器,对于引脚的控制十分方便,易于开发。 摄像头模块采用百问网公司的UVC 摄像头,它既可以支持USB接口,也可以支持CMOS接口。USB模块上集成了DSP 芯片,可以自动将图像压缩成MJPEG 格式从而避免了软压缩的缺陷,减少CPU 的压力从而大幅提高性能。CMOS模组为OV7740,最大分辨率640*480。无线网卡选用美国ATHEROS AR9271 高阶芯片,材料全部采用知名供应商,且获得了FCC,ROHS,支持IEEE802.11B/G/N协议,传输速率相对较高。 2.2 软件部分设计 视频前端软件部分设计需先进行uboot移植,linux内核移植和根文件系统的制作,同时根据相应要求编写或调试相关驱动程序以满足外设要求,最后编写上层应用程序。操作系统采用Linux 3.4内核。对内核的配置工作,内核支持的菜单项更加容易操作Makefile 中的模块,删除不必要的驱动模块从而缩小体积和加快速度。 新版本的内核中支持了USB 总线的框架,将通用层包装起来,差异层提取出来以供修改,大大减少开发周期,设计使用的摄像头驱动程序是基于V412框架的视频设备标准的,其为应用层提供了函数调用的基础。当接入设备时,会触发硬件中断,内核会去识别它并且根据其设备描述符找到与之匹配的设备驱动程序,从而可以在应用层使用底层函数接口来操作摄像头硬件。视频的采集流程如图2所示。 图2视频采集流程图 在采集到视频数据后需要发送到上位机去显示,在网络传输部分采用TCP 协议,通过socket编程使得视频前端作为服务器端,上位机作