信息论基础与编码

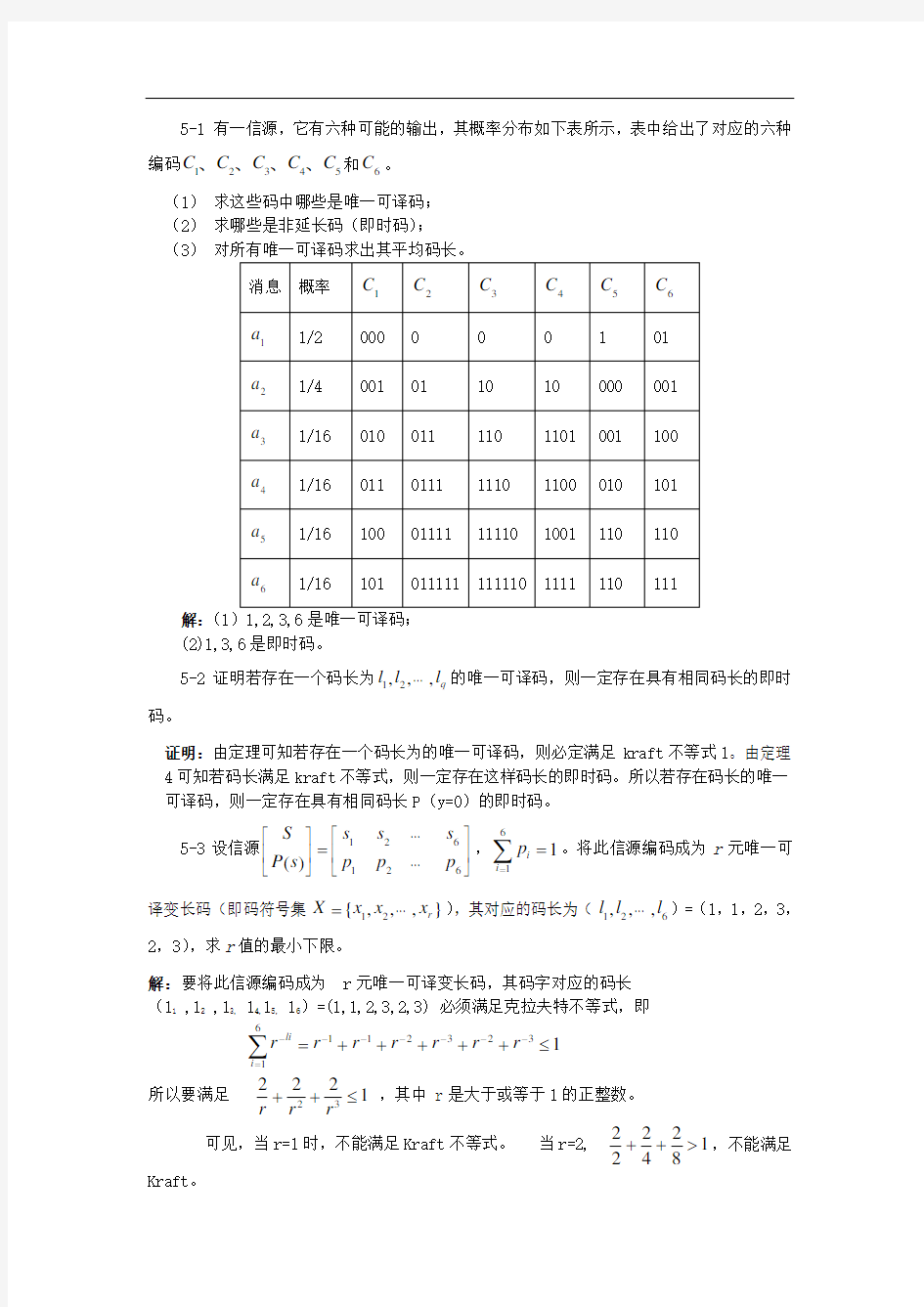

5-1 有一信源,它有六种可能的输出,其概率分布如下表所示,表中给出了对应的六种编码12345C C C C C 、、、、和6C 。

(1) 求这些码中哪些是唯一可译码; (2) 求哪些是非延长码(即时码);

(3) 对所有唯一可译码求出其平均码长。

解:(1(2)1,3,6是即时码。

5-2证明若存在一个码长为12,,,q l l l ???的唯一可译码,则一定存在具有相同码长的即时码。

证明:由定理可知若存在一个码长为的唯一可译码,则必定满足kraft 不等式1。由定理4可知若码长满足kraft 不等式,则一定存在这样码长的即时码。所以若存在码长的唯一可译码,则一定存在具有相同码长P (y=0)的即时码。

5-3设信源1

2

61

26()s s s S p p p P s ???

??

??=???????

????,61

1i i p ==∑。将此信源编码成为r 元唯一可译变长码(即码符号集12{,,,}r X x x x =???),其对应的码长为(126,,,l l l ???)=(1,1,2,3,2,3),求r 值的最小下限。

解:要将此信源编码成为 r 元唯一可译变长码,其码字对应的码长

(l 1 ,l 2 ,l 3, l 4,l 5, l 6)=(1,1,2,3,2,3) 必须满足克拉夫特不等式,即

13232116

1

≤+++++=------=-∑r r r r r r r

i li

所以要满足

12

2232≤++r

r r ,其中 r 是大于或等于1的正整数。 可见,当r=1时,不能满足Kraft 不等式。 当r=2, 18

2

4222>++,不能满足

Kraft 。

当r=3,

127

262729232<=++,满足Kraft 。 所以,求得r 的最大值下限值等于3。

5-4设某城市有805门公务电话和60000门居民电话。作为系统工程师,你需要为这些用户分配电话号码。所有号码均是十进制数,且不考虑电话系统中0、1不可用在号码首位的限制。(提示:用异前缀码概念) (1)如果要求所有公务电话号码为3位长,所有居民电话号码等长,求居民号码长度1L 的最小值;

(2)设城市分为A 、B 两个区,其中A 区有9000门电话,B 区有51000门电话。现进一步要求A 区的电话号码比B 区的短1位,试求A 区号码长度2L 的最小值。

解:(a) 805门电话要占用1000个3位数中的805个,即要占用首位为0~ 7的所有数字及以8为首的5个数字。因为要求居民电话号码等长, 以9为首的数字5位长可定义10 000个号码,6位长可定义100 000 个号码。所以min L 16=。

或由Craft 不等

式,有

8051060000101

31?+?≤--L 解得 L 1103

180********

5488≥--?=-log ., 即

min L 16=

(b) 在(a)的基础上,将80为首的数字用于最后5个公务电话,81~86 为首的6位数用于B 区51 000个号码,以9为首的5位数用于A 区9 000 个号码。所以,min L 25=。或

由Draft 不等式,有 80510

900010510001013

122?+?+?≤---+L L ()

或 80510

900051000101013

12?++??≤---()L

解得L 210

3

18051090005100

4859≥--?+=-log . 即min L 25=

5-5求概率分布为)152,152,51,51,31(的信源的二元霍夫曼码。讨论此码对于概率分布为

)5

1

,51,51,51,51(的信源也是最佳二元码。 解:信源的概率分布为:

)152

,152,51,51,31()(=i s p

二元霍夫曼码:00,10,11,010,011,码长:2,2,2,3,3

当信源给定时,二元霍夫曼码是最佳二元码。所以对于概率分布为)51,51,51,51,51(的信源,

其最佳二元码就是二元霍夫曼码。这二元霍夫曼码一定是三个信源符号的码长为2(码符号/信源符号),另二个信源符号的码长为3(码符号/信源符号),其平均码长最短。因此,上

述对概率分布为)152

,152,51,51,31(信源所编的二元霍夫曼码也是概略分布为

)5

1

,51,51,51,51(信源的最佳二元码。 5-6 设二元霍夫曼码为(00,01,10,11)和(0,10,110,111),求出可以编得这些霍夫曼码的信源的所有概率分布。

解:由题意 假设信源所发出的是个符号的概率为 )P(S )P(S )P(S )P(S 1234≥≥≥ 由霍夫曼编码的特点知:1)P(S )P(S )P(S )P(S 1234=+++

根据霍夫曼编码的方法,每次概率最小的两个信源符号合并成一个符号,构成新的缩减信源,直至最后只剩两个符号。而且当缩减信源中的所有符号概率相等时,总是将合并的符号放在最上面。所以,对于二元霍夫曼码为(00,01,10,11)来说,每个信源都要缩减一次,所以34()()P S P S +要大于1()P S 和2()P S ,这时必有

12111

P(S )P(S ),P(S )33

+≥≤

同理对于二元霍夫曼码为(0,10,110,111)有

34111

P(S )P(S ),P(S )>33

+<

信源概率分布满足以上条件则其霍夫曼编码符合题意。

5-7 设一信源有K =6个符号,其概率分别为:123()1/2,()1/4,()1/8P s P s P s ===,45()()1/20P s P s ==,6()1/40P s =,对该信源进行霍夫曼二进制编码,并求编码效率。

解:相应的Huffman 编码是:{1,01,001,0001,00000,00001}。平均码长=,熵= () 1.94

0.9951.95

log 2H X L η=

==

5-8 设信源概率空间为:

()??????s P S =??

????9.0,1.0,21s s , (1)求()S H 和信源冗余度;

(2)设码符号为X ={0,1},编出S 的紧致码,并求紧致码的平均码长L ;

(3)把信源的N 次无记忆扩展信源N

S 编成紧致码,试求N =2,3,4,∞时的平均码长

???

? ??N L N

; (4)计算上述N =1,2,3,4这四种码的编码效率和码冗余度。

解:(1)信源

()=??

?

???s P S ??

?

???9.01.021s s 其 ()()()≈-

=∑=i

i i

s P s P s H log 2

1

比特/符号

剩余度()=-

=2

log 1s H γ=%

(2)码符号X={0,1},对信源S 编紧致码为:1s 0→,12→s 其平均码长L =1 码符号/信源符号 (3) 当N=2时

()??????i P S α2=???

???====81.0,09.0,09.0,

01.0,,,224133212111s s s s s s s s αααα 紧致码(即霍夫曼码)为

,4α ,3α ,2α 1α

码字i W 0 , 10 , 110 , 111 码长i l 1 , 2 , 3 , 3

平均码长???

? ??N L

N

=()i i i l P ∑=4

1α≈0.645 码符号/信源符号 N=3时,()??

?

???i P S α3=

()()()()()()()()??

?

??

???????32

2

2

2223876543219.0,

9.01.0,9.01.0,9.01.0,

9.01.0,9.01.0,9.01.0,1.0,

,,,

,,,

αααααααα

对信源3S 进行霍夫曼编码,其紧致码为

,8α ,7α ,6α ,5α

,4α ,3α ,2α

1α

码字i W 0 , 100 , 101 , 110 , 11100 , 11101 , 11110 ,

11111

码长i l 1 , 3 , 3 , 3 , 5 , 5 , 5 ,

5

平均码长 ???

?

??N L N

=31()i

i i

l

P ∑=8

1

α≈0.533 码符号/信源符号

N=4时,()???

???i P S α4=

()()()()()()()()()()()??

?,

9.01.0,9.01.0,9.01.0,9.01.0,9.01.0,9.01.0,9.01.0,1.0,

,,,,,,,2222223333487654321αααααααα

()()()()()()()()()()()??

?

43

3

3

3

2222221615141312111099.0,

9.01.0,9.01.0,9.01.0,9.01.0,

9.01.0,9.01.0,9.01.0,

,,,,

,,αααααααα

对信源4S 进行霍夫曼编码,其紧致码为

,16α ,15α ,14α ,13α

,12α ,11α ,10α

,9α

码字i W 0 , 100 , 101 , 110 , 1110 , 111110 , 1111000 , 1111001,

码长i l 1 , 3 , 3 , 3 , 4 , 6 , 7 , 7 ,

,8α ,7α ,6α ,5α

,4α ,3α ,2α 1α

码字i W 1111010 , 1111011 , 1111110 , 1 , 0 , 1 , 00 , 01

码长i l 7 , 7 , 7 , 9 , 9 , 9 , 10 , 10

平均码长???

? ??N L

N

=41()≈∑=i

i i

l

P 16

1

α0.493 码符号/信源符号

N=∞时,根据香农第一定理,其紧致码的平均码长

∞

→N lim

N L N =

()

r

s H log ≈0.469 码符号/信源符号 (4) 编码效率 ()

()

L S H L S H r =

=

η (r=2)

码剩余度 1-()()L

S H L S H r -=-=11η (r=2) 所以 N=1 编码效率≈1η0.469 码剩余度≈=% N=2 ≈2η ≈=% N=3 ≈3η ≈=12%

N=4 ≈4η ≈=%

从本题讨论可知,对于变长紧致码,当N 不很大时,就可以达到高效的无失真信源编码。 5-9设信源空间为:????

??)s (P S =1234

56780.40.20.10.10.050.050.050.05s s s s s s s s ?????

?,码符号为X ={0,1,2},试构造一种三元紧致码。

解:得信源符号 s 1 s 2 s 3 s 4 s 5 s 6 s 7 s 8 三元紧致码 1 00 02 20 21 22 010 011

5-10 某气象员报告气象状态,有四种可能的消息:晴、云、雨和雾。若每个消息是等概的,那么发送每个消息最少所需的二元脉冲数是多少?又若四个消息出现的概率分别是1/4,1/8,1/8和1/2,问在此情况下消息所需的二元脉冲数是多少?如何编码?

解: 第一种情况:需要二元脉冲数两个,可表示四种状态,满足我们的要求。

第二种情况:我们采用霍夫曼可编为1/2编为 1;1/4编为01,1/8编为000和001,

脉冲数显然。

5-11 若某一信源有N 个符号,并且每个符号等概率出现,对这信源用最佳霍夫曼码进行二元编码,问当2i N =和2i N = 1 +(i 是正整数)时,每个码字的长度等于多少?平均码长是多少?

解:当2()i

N i = =正整数时用霍夫曼编码方法进行最佳编码,由于每个符号是等概率分布的,所以每个符号码长应相等,这样平均码长最短,而且信源符号个数正好等于i 2,则满足: i

l

q 22==,所以每个码字的码长i L i l i ==,。

当i N 2=个1时,因为每个符号等概率分布出现,所以每个符号的码长也应该基本相等,但现在信源符号个数不是正好等于i 2,所以必须有两个信源符号的码长延长一位码长,这样平均码长最短。

所以12+=i N 时12-i

个码字的码长为i l i =,其余2个码字的码长为1≠i 。平均码长

1

22

++

=i

i L 。 5-12 若有一信源

12,()0.8,0.2s s S P s ????=????????

每秒钟发出个信源符号。将此信源的输出符号送入某一个二元信道中进行传输(假设信道是

无噪无损的),而信道每秒钟只传递2个二元符号。试问信源不通过编码能否直接与信道连接?若通过适当编码能否在此信道中进行无失真传输?若能连接,试说明如何编码并说明原因。

解:信源

12,()0.8,0.2s s s P s ??

??=????????,其信源熵 2

1/()()log ()0.722i i i H s P s P s ==-≈ ∑比特符号

而其每秒钟发出个信源符号,所以信源输出的信息速率为:

/2.66()

2.660.7221921t R H s /?≈ =?≈? 符号秒比特符号比特/秒

.

送入一个二元无噪无损信道,此信道的最大信息传输率(信道容量)/1C = 比特符号。

而信道每秒钟只传输两个二元符号,所以信道的最大信息传输速率为:

//22t C C ?/=? = 比特符号符号秒比特秒

可见:t t R C <。

根据无噪信道编码定理(即无失真信源编码定理),因t t R C <。所以总能对信源的输出进行适当的编码,使此信源能在此信道中进行无失真地传输。如果对信源不进行编码,直接将信源符号1s 以“0”符号传送,2s 以“1”符号传送,这时因为信源输出为(二元信源符号/秒),

大于2(二元信道符号/秒),就会使信道输入端造成信源符号的堆积,信息不能按时发送出去。所以,不通过编码此信源不能直接与信道连接。若要连接,必须对信源的输出符号序列进行编码,也就是对此信源的N 次扩展信源进行编码。但扩展次数越大,编码越复杂,设备的代价也越大,所以尽量使扩展的次数N 少,而又能使信源在此信道中无失真传输。先考虑

2N =,并对二次扩展信源进行霍夫曼编码,得:

211122122,,,()0.64,0.16,0.16,0.04i j s s s s s s s s s P s s ?? ??=???? ?????

?

二元霍夫曼码

0,10,110,111

得:

2 1.56L = 二元符号/二个信源符号二元符号/信源符号

L=0.78

二次扩展编码后,送入信道的传输速率为:

/0.78 2.66 /?? ≈ 二元符号信源符号信源符号秒

二元符号/秒

二元符号/秒

2.075>2 所以,必须考虑3N =即对三次扩展信源进行霍夫曼编码,得:

3111112121211122212221222,,,,,,,()0.512,0.128,0.128,0.128,0.032,0.032,0.032,0.008i j k s s s s s s s s s s s s s s s s s s s s s s s s s P s s s ?? ??=???? ?????? 二元霍夫曼码1,000,001,010,01100,01101,01110,01111

得:

3 2.184L = 二元符号/三个信源符号二元符号/信源符号

L=0.728

三次扩展码后,送入信道额传输速率为:

/0.728 2.66 /?? ≈ 二元符号信源符号信源符号秒

二元符号/秒

二元符号/秒

1.9365<2 此时,就可以在信道中进行无失真传输了。

5-13 现有一幅已离散量化后的图像,图像的灰度量化分成8级,如下表所示。表中数字为相应像素上的灰度级。

另有一无噪无损二元信道,单位时间(秒)内传输100个二元符号。

(1)现将图像通过给定的信道传输,不考虑图像的任何统计特性,并采用二元等长码,问需多长时间才能传送完这幅图像?

(2)若考虑图像的统计特性(不考虑图像的像素之间的依赖性),求这图像的信源熵

()H S ,并对每个灰度级进行霍夫曼最佳二元编码,问平均每个像素需用多少二元码符号来

表示?这时需多少时间才能传送完这幅图像?

(3)从理论上简要说明这幅图像还可以压缩,而且平均每个像素所需的二元码符号数可以小于()H S 比特。 解:(1)3秒。(2)秒。

5-14设某无记忆二元信源,概率1p =P (1)=,0p =P (0)=,采用下述游程编码方案:第一步,根据0的游程长度编成8个码字,第二步,将8个码字变换成二元变长码,如下表所示:

(1) 试问最后的二元变长码是否是唯一可译码; (2) 试求中间码对应的信源序列的平均长度1L ;

(3) 试求中间码对应的变长码二元码码字的平均长度2L ;

(4) 计算比值21/L L ,解释它的意义,并计算这种游程编码的编码效率;

(5) 若用霍夫曼编码,对信源的四次扩展信源进行直接编码,求它的平均码长L (对应于每一个信源符号),并计算编码效率,试将此方法与游程编码方法进行比较;

(6) 将上述游程编码方法一般化,可把21s

个信源序列(上例中s =3)变换成二元变

长码,即2s 个连零的信源序列编为码字0,而其他信源序列都编成s +1位的码字.若信源输出零的概率为0p ,求2L /1L 的一般表达式,并求0p =时s 的最佳值。

解: (1) 根据唯一可译码的判断方法可知,最后的二元变长码是非延长码(即时码,所以它是唯一可译码。

(2) 因为信源是二元无记忆信源,所以有P(s i )= P(s i1) P(s 2)…P(s in ) 其中 s i =( s i1 s i2…s in ) s i1, s i2,…s in ?{0,1}

已知p 1=P(1)=, p 0=P(0)=,可求得信源符号序列的概率P(s i )。根据编码,可排出下列表

根据表可计算 L 1=

10()i i i P S l =?

≈ 信源符号/中间码 (3) 根据表计算 L 2=8

20

()i i i P S l =?

≈ 二元码/中间码

(4)

2

1

L L ≈ 二元码/信源符号 此值为每个信源符号所需的二元码符号数,也就是无记忆二元信源采用游程编码后每个二元信源符号所需的平均码长。

可计算无记忆二元信源的信息熵

H(S) =- 2

1

()log ()i i i P S P S =?≈ 比特/信源符号

所以,这种游程编码的效率

η=

21

()

/H S L L ≈≈ % (其中因为二元编码所以H r (S)=H(S))

(5)若对无记忆二元信源的次扩展信源直接进行霍夫曼编码,可得

L 4=1

()i i i P S l =?≈ 二元码/4个信源符号

得 L = 二元码/信源符号 编码效率η=

()

H S L

≈≈ % 此编码效率低于游程编码方法。这是因为霍夫曼码只考虑N =4(固定值)时进行压缩,使概率大的对应于短码,概率小的对应于长码。但无记忆二元信源符号“0”出现的概率p 0很大,所以在信源输出序列中符号“0”连续出现的概率较大,而连续出现符号“1”的概率极小。游程编码正是考虑了这些特性,使N 较长(N =8)的连续出现的符号“0”序列压缩成一个二元码符号。所以,游程编码的编码效率较高。当然,当N 很大时(N =8)霍夫曼编码效率会提高,但其编码方法没有游程编码方法来得简单。 (6) 一般游程编码方法是将2s +1个信源序列中一个2s

个连续为零的序列编成码字0,而其他信源序列编成码长为s+1的码字,所以根据表中类似计算可得

L 1=212

100

1

2s

s

i s i ip p p -=+? 其中p 0为信源中符号“0”出现的概率, p 1为符号“1”出现的概率,有p 0+ p 1=1。

展开上式,得 L 1 = p 0+ 2p 1 p 0+3 p 12

0p + (21102)

s p p -+2

02s

s p

=(1- p 0)[(1+2 p 0+32

0p + (2102)

s p -)]+202s

s p

=(1+2p 0+32

p +…+21

2s s

p

-+20

2s

s

p )-( p 0+220p +33

0p

+…+

20

2s s

p )

=(1+ p 0+20p +…+21

0s

p -)

=2

11s

p p --

根据表中类似计算,得

L 2=(s+1)212

100

1

s

s

i i p p p -=+? =(s+1) [(1- p 0)(1+ p 0+2

0p +…+210s p -)]+2

0s

p

=(s+1)(1-20s

p )+20

s p

=1+s(1-20s

p )

得

2

1

L L 的一般表达式为

L =21L L =0

020

1(1)1s

p s p p -+-- 当p 0=, p 1=时,求s 的最佳值,也就是求s 取某值时L 最短。可采用将L 对s 求偏导来解,但所得为超越方程,所以我们采用数值求解方法。 令 s =2 2s

=4 L =

s =3 2s =8 L = s =4 2s =16 L = s =5 2s =32 L = s =6 2s =64 L = s =7 2s =128 L = s =8 2s =256 L =

所以得最佳

当p 0=时二元信源的信息熵

H(S) = H ≈ 比特/信源符号

可见,当s =7时, L 已极接近H(S),编码效率达到%

5-15有两个信源X 和Y 如下:

1

234567()0.20.190.180.170.150.10.01X x x x x x x x P x ????=????????

1

23456789()0.490.140.140.070.070.040.020.020.01Y y y y y y y y y y P y ????=????????

(1)分别用霍夫曼码编成二元变长唯一可译码,并计算编码效率; (2)分别用香农编码法编成二元变长唯一可译码,并计算编码效率; (3)分别用费诺编码法编成二元变长唯一可译码,并计算编码效率; (4)从X ,Y 两种不同信源来比较这三种编码方法的优缺点。 5-16 将幅度为、频率为800Hz 的正弦信号输入采样频率为8000Hz 采样保持器后,通过一个如题图5-16所示量化数为8的中升均匀量化器。试画出均匀量化器的输出波形。

题图 5-16

5-17 已知某采样时刻的信号值x 的概率密度函数()p x 如题图5-17所示,将x 通过一个量化数为4的中升均匀量化器得到输出q x 。试求:

(1) 输出q x 的平均功率2

[]q S E x =;

(2) 量化噪声q e x x =-的平均功率

2

[]q N E e =; (3) 量化信噪比/q S N 。

题图 5-17

5-18 在CD 播放机中,假设音乐是均匀分布,采样频率为,采用16比特的中升均匀量化器进行量化。试确定50分钟音乐所需要的比特数,并求量化信噪比/q S N 。

5-19 采用13折线A 律非均匀量化编码,设最小量化间隔为?,已知某采样时刻的信号值x =635?。

(1)试求该非均匀量化编码c ,并求其量化噪声e ;

(2)试求对应于该非均匀量化编码的12位均匀量化编码'

c 。

5-20 将正弦信号()sin(1600)x t t π=输入采样频率为8kHz 采样保持器后通过13折线A 律非均匀量化编码器,设该编码器的输入范围是[-1,1]。试求在一个周期内信号值

sin(0.2)i x i π=,0,1,,9i =???的非均匀量化编码i c ,0,1,,9i =???。

5-21将正弦信号()0.25sin(400)x t t π=输入采样频率为4kHz 采样保持器后通过差分

脉冲编码调制器,设该调制器的初始值00q d =,%00x =,采用码长为4的均匀量化编码,

量化间隔?=。试求在半个周期内信号值0.25sin(0.1)i x i π=,0,1,,9i =???的差分脉冲编码

i c 和量化值'i x ,0,1,,9i =???。

信源信道编码

青岛农业大学 本科生课程论文 论文题目联合信源信道编码的原理及其在通信中的应用学生专业班级信息与计算科学09级1班 学生姓名(学号)董晨晨(20093991) 指导教师吴慧 完成时间 2012年6月27日 2012 年 6 月 27 日

课程论文任务书 学生姓名董晨晨指导教师吴慧 论文题目联合信源信道编码的原理及其在通信中的应用 论文内容(需明确列出研究的问题):由于通信的根本目的是将消息有效而可靠地从信源传到信宿,信源编码的目的在于提高系统的有效性,信道编码理论核心是提高系统的可靠性,因此在编码时应在一定的传信率条件下,通过有规律的增加冗余度保证信息以尽可能小的差错概率从信源传到信宿,并且充分利用系统资源。基于这种情况下,提出了信源信道联合编码,可以跟随信道的变化充分利用通信系统的资源,达到最好的端对端的通信效果。本文主要研究了以下几个方面的问题:(1)信源信道联合编码的原理;(2)信源信道联合编码的研究方向;(3)信源信道联合编码的关键技术;(4)联合编码在通信系统方面的应用。 资料、数据、技术水平等方面的要求:通过书籍报刊杂志、网络等各种渠道广泛搜集资料,充分利用现有文献,借鉴他人的学术成果,做到了资料翔实,数据准确,引用规范,论证充分。论文符合一般学术论文的写作规范,具备学术性、科学性和一定的创造性。文字流畅、语言准确、要点清楚,有独立的观点和见解。内容理论联系实际,计算数据准确,涉及到他人的观点、统计数据或计算公式标明出处,结论写的概括简短。 发出任务书日期2012.6.20完成论文日期2012.6.27 教研室意见(签字) 院长意见(签字)

课程论文成绩评定表

信息论基础各章参考答案

各章参考答案 2.1. (1)4.17比特 ;(2)5.17比特 ; (3)1.17比特 ;(4)3.17比特 2.2. 1.42比特 2.3. (1)225.6比特 ;(2)13.2比特 2.4. (1)24.07比特; (2)31.02比特 2.5. (1)根据熵的可加性,一个复合事件的平均不确定性可以通过多次实验逐步解除。如果我们使每次实验所获得的信息量最大。那么所需要的总实验次数就最少。用无砝码天平的一次称重实验结果所得到的信息量为log3,k 次称重所得的信息量为klog3。从12个硬币中鉴别其中的一个重量不同(不知是否轻或重)所需信息量为log24。因为3log3=log27>log24。所以在理论上用3次称重能够鉴别硬币并判断其轻或重。每次实验应使结果具有最大的熵。其中的一个方法如下:第一次称重:将天平左右两盘各放4枚硬币,观察其结果:①平衡 ②左倾 ③右倾。ⅰ)若结果为①,则假币在未放入的4枚币,第二次称重:将未放入的4枚中的3枚和已称过的3枚分别放到左右两盘,根据结果可判断出盘中没有假币;若有,还能判断出轻和重,第三次称重:将判断出含有假币的三枚硬币中的两枚放到左右两盘中,便可判断出假币。ⅱ)若结果为②或③即将左盘中的3枚取下,将右盘中的3枚放到左盘中,未称的3枚放到右盘中,观察称重砝码,若平衡,说明取下的3枚中含假币,只能判出轻重,若倾斜方向不变,说明在左、右盘中未动的两枚中其中有一枚为假币,若倾斜方向变反,说明从右盘取过的3枚中有假币,便可判出轻重。 (2)第三次称重 类似ⅰ)的情况,但当两个硬币知其中一个为假,不知为哪个时, 第三步用一个真币与其中一个称重比较即可。 对13个外形相同的硬币情况.第一次按4,4,5分别称重,如果假币在五个硬币的组里,则鉴 别所需信息量为log10>log9=2log3,所以剩下的2次称重不能获得所需的信息. 2.6. (1)215 log =15比特; (2) 1比特;(3)15个问题 2. 7. 证明: (略) 2.8. 证明: (略) 2.9. 31)(11= b a p ,121 )(21=b a p , 121 )(31= b a p , 61)()(1312= =b a b a p p , 241)()()()(33233222= ===b a b a b a b a p p p p 。 2.10. 证明: (略) 2.11. 证明: (略)

数字通信中的信源编码和信道编码.(优选)

数字通信中的信源编码和信道编码 摘要:如今社会已经步入信息时代,在各种信息技术中,信息的传输及通信起着支撑作用。而对于信息的传输,数字通信已经成为重要的手段。本论文根据当今现代通信技术的发展,对信源编码和信道编码进行了概述性的介绍. 关键词:数字通信;通信系统;信源编码;信道编码 Abstract:Now it is an information society. In the all of information technologies, transmission and communication of information take an important effect. For the transmission of information, Digital communication has been an important means. In this thesis we will present an overview of source coding and channel coding depending on the development of today’s communica tion technologies. Key Words:digital communication; communication system; source coding; channel coding 1.前言 通常所谓的“编码”包括信源编码和信道编码。编码是数字通信的必要手段。使用数字信号进行传输有许多优点, 如不易受噪声干扰, 容易进行各种复杂处理, 便于存贮, 易集成化等。编码的目的就是为了优化通信系统。一般通信系统的性能指标主要是有效性和可靠性。所谓优化,就是使这些指标达到最佳。除了经济性外,这些指标正是信息论研究的对象。按照不同的编码目的,编码可主要分为信源编码和信道编码。在本文中对此做一个简单的介绍。 2.数字通信系统 通信的任务是由一整套技术设备和传输媒介所构成的总体——通信系统来完成的。电子通信根据信道上传输信号的种类可分为模拟通信和数字通信。最简单的数字通信系统模型由信源、信道和信宿三个基本部分组成。实际的数字通信系统模型要比简单的数字通信系统模型复杂得多。数字通信系统设备多种多样,综合各种数字通信系统,其构成如图2-l所示。 图2-1 数字通信系统模型 信源编码是以提高通信有效性为目的的编码。通常通过压缩信源的冗余度来实现。采用的一般方法是压缩每个信源符号的平均比特数或信源的码率。 信道,通俗地说是指以传输媒质为基础的信号通路。具体地说,信道是指由有线或无线电线路提供的信号通路。信道的作用是传输信号,它提供一段频带让信号通过,同时又给信号加以限制和损害。 信道编码是以提高信息传输的可靠性为目的的编码。通常通过增加信源的冗余度来实现。采用的一般方法是增大码率或带宽。与信源编码正好相反。在计算机科学领域,信道编

信息论基础》试卷(期末A卷

《信息论基础》答案 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X ,其概率分布为1 23x x x X 1 11P 244?? ?? ? =?? ????? ,其信源剩余度为94.64%;若对该信源进行十次扩展,则每十个符号的平均信息量是 15bit 。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b ,最小瞬时电压为a 。若消息从放大器中输出,则该信源的绝对熵是∞;其能在每个自由度熵的最大熵是log (b-a )bit/自由度;若放大器的最高频率为F ,则单位时间内输出的最大信息量是 2Flog (b-a )bit/s. 5. 若某一 信源X ,其平均功率受限为16w ,其概率密度函数是高斯分布时,差熵的最大值为 1 log32e 2 π;与其熵相等的非高斯分布信源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r (S))。 8、当R=C 或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,,=≥≤?”或“?” (1)当X 和Y 相互独立时,H (XY )=H(X)+H(X/Y)。 (2)假设信道输入用X 表示,信道输出用Y 表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) 《信息论基础》试卷第1页 《信息论基础》试卷答案 一、填空题(共25分,每空1分) 1、连续信源的绝对熵为 无穷大。(或()()lg lim lg p x p x dx +∞-∞ ?→∞ --?? ) 2、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。 3、无记忆信源是指 信源先后发生的符号彼此统计独立 。 4、离散无记忆信源在进行无失真变长编码时,码字长度是变化的。根据信源符号的统计特性,对概率大的符号用 短 码,对概率小的符号用 长 码,这样平均码长就可以降低,从而提高 有效性(传输速率或编码效率) 。 5、为了提高系统的有效性可以采用 信源编码 ,为了提高系统的可靠性可以采用 信道编码 。 6、八进制信源的最小熵为 0 ,最大熵为 3bit/符号 。 7、若连续信源输出信号的平均功率为1瓦特,则输出信号幅度的概率密度函数为 高斯分布(或()0,1x N 2 2 x - )时,信源具有最大熵,其值为 0.6155hart(或 1.625bit 或 1lg 22 e π)。 8、即时码是指 任一码字都不是其它码字的前缀 。 9、无失真信源编码定理指出平均码长的理论极限值为 信源熵(或H r (S)或()lg H s r ),此 时编码效率为 1 ,编码后的信息传输率为 lg r bit/码元 。 10、一个事件发生的概率为0.125,则自信息量为 3bit/符号 。 11、信源的剩余度主要来自两个方面,一是 信源符号间的相关性 ,二是 信源符号概率分布的不均匀性 。 12、m 阶马尔可夫信源的记忆长度为 m+1 ,信源可以有 q m 个不同的状态。 13、同时扔出一对均匀的骰子,当得知“两骰子面朝上点数之和为2”所获得的信息量为 lg36=5.17 比特,当得知“面朝上点数之和为8”所获得的信息量为 lg36/5=2.85 比特。 14.在下面空格中选择填入的数学符号“=,≥,≤,>”或“<” H(XY) = H(Y)+H(X ∣Y) ≤ H(Y)+H(X) Joint Source-Channel Decoding of Huffman Codes with LDPC Codes Zhonghui Mei and Lenan Wu Abstract In this paper, we present a joint source-channel decoding algorithm (JSCD) for LDPC codes by exploiting the redundancy of the Huffman coded sources.When the number of Huffman codes increases, just a moderate complexity is added for our algorithm by increasing the size of the lookup table, which is used to estimate the information bit probability based on the source redundancy. Key words - LDPC, Variable length codes (VLC), Huffman code, sum-product algorithm (SPA), joint source-channel decoding (JSCD) I. INTRODUCTION Recently in [1]-[4] several joint source-channel decoding algorithms for variable length codes (VLC) have been proposed. All of these algorithms consider the overall sequence of variable length codeword to exploit the source redundancy. The drawback is that the symbols have to be synchronized in order to limit error propagating. Furthermore, when the number of VLC increases, the decoding complexity of these algorithms explodes. In this paper we present a JSCD algorithm for LDPC codes in combination with Huffman coded sources. The error correcting property of our JSCD algorithm mainly depends on channel codes rather than source redundancy. In order to exploit the source redundancy, we estimate the information bit probability with just some corresponding bits before it, which simplifies the decoding algorithm significantly. The rest of the paper is organized as follows. Section II presents the Huffman coded source model. The JSCD algorithm for LDPC codes is described in section III. Section IV provides the simulation results. Section V concludes this paper. II. HUFFNAN CODED SOURCE MODEL Let denotes a sequence of information bits coded by VLC (e.g. a Huffman code). In [1], [3] and [4], they consider the overall sequence and express the source redundancy with . In order to compute , [3] and [4] design a trellis to illustrate statistics of the source sequence. When the number of the trellis states increases, the computational complexity of will rise explosively. ],......,,,[321n s s s s S =),......,,,()(21n s s s s p S p =)(S p )(S p In this paper, we make use of the source redundancy with , as is illustrated in Fig.1 and table 1. k is chose to be larger than the maximum length of Huffman codes. When the number of VLC increases, we only need to expand the lookup table. In addition, for we just estimate one bit probability with a small part bit of the information sequence every time, the error propagation phenomenon has been avoided successfully. ]),......,,[|(11?+??i k i k i i s s s s p 信息论基础理论与应用考试题 一﹑填空题(每题2分,共20分) 1.信息论研究的目的就是要找到信息传输过程的共同规律,以提高信息传输的 (可靠性)﹑(有效性)﹑保密性和认证性,使信息传输系统达到最优化。 (考点:信息论的研究目的) 2.电视屏上约有500×600=3×510个格点,按每点有10个不同的灰度等级考虑,则可组成5 31010?个不同的画面。按等概计算,平均每个画面可提供的信息量约为(610bit /画面)。 (考点:信息量的概念及计算) 3.按噪声对信号的作用功能来分类信道可分为 (加性信道)和 (乘性信道)。 (考点:信道按噪声统计特性的分类) 4.英文电报有32个符号(26个英文字母加上6个字符),即q=32。若r=2,N=1,即对信源S 的逐个符号进行二元编码,则每个英文电报符号至少要用 (5)位二元符号编码才行。 (考点:等长码编码位数的计算) 5.如果采用这样一种译码函数,它对于每一个输出符号均译成具有最大后验概率的那个输入符号,则信道的错误概率最小,这种译码规则称为(最大后验概率准则)或(最小错误概率准则)。 (考点:错误概率和译码准则的概念) 6.按码的结构中对信息序列处理方式不同,可将纠错码分为(分组码)和(卷积码)。 (考点:纠错码的分类) 7.码C={(0,0,0,0),(0,1,0,1),(0,1,1,0),(0,0,1,1)}是((4, 2))线性分组码。 (考点:线性分组码的基本概念) 8.定义自信息的数学期望为信源的平均自信息量,即(11()log ()log ()()q i i i i H X E P a P a P a =??==-????∑)。 重庆邮电大学2007/2008学年2学期 《信息论基础》试卷(期末)(A卷)(半开卷) 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X,其概率分布为 123 x x x X 111 P 244 ?? ?? ? = ?? ? ?? ?? ,其信源剩余度为94.64%;若对该信源进行十次扩展,则 每十个符号的平均信息量是 15bit。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b,最小瞬时电压为a。若消息从放大器中输出,则该信源的绝对熵是∞;其能在每个自由度熵的最大熵是log(b-a)bit/自由度;若放大器的最高频率为F,则单位时间内输出的最大信息量是 2Flog(b-a)bit/s. 5. 若某一信源X,其平均功率受限为16w,其概率密度函数是高斯分布时,差熵的最大值为1 log32e 2 π;与其 熵相等的非高斯分布信源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限制为信源熵(或H(S)/logr= H r(S))。 8、当R=C或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,, =≥≤?”或“?” (1)当X和Y相互独立时,H(XY)=H(X)+H(X/Y)。 (2)假设信道输入用X表示,信道输出用Y表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) 《信息论基础》答案 一、填空题(共15分,每空1分) 1、若一连续消息通过某放大器,该放大器输出的最大瞬时电压为b,最小瞬时电压为a。 若消息从放大器中输出,则该信源的绝对熵是无穷大;其能在每个自由度熵的最 大熵是log b-a 。 2、高斯白噪声信道是指信道噪声服从正态分布,且功率谱为常数。 3、若连续信源的平均功率为 5 W,则最大熵为1.2 Iog10 e ,达到最大值的条件是高 斯信道。 4、离散信源存在剩余度的原因是信源有记忆(或输岀符号之间存在相关性)和不 等概。 5、离散无记忆信源在进行无失真变长信源编码时,编码效率最大可以达到 1 。 6、离散无记忆信源在进行无失真变长信源编码时,码字长度是变化的。根据信源符号 的统计特性,对概率大的符号用短码,对概率小的符号用长码,这样平均码长 就可以降低,从而提高编码效率。 7、八进制信源的最小熵为0 ,最大熵为3bit 。 8、一个事件发生概率为,则自信息量为3bit 。 9、在下面空格中选择填入数字符号“,,,”或“ <” H XY 二HY HXY HY H X 二、判断题(正确打",错误打X)(共5分,每小题1分) 1)离散无(")记忆等概信源的剩余度为0 。 2) 离散无记忆信源N次扩展源的熵是原信息熵的N倍(") 3) 互信息可正、可负、可为零。 (") 4) 信源的真正功率P 永远不会大于熵功率P ,即P P (X ) 5) 信道容量与信源输出符号的概率分布有关。 (X ) 、(5分)已知信源的概率密度函数p x如下图所示,求信源的相对熵 * p x 0.5 4 h x 2 p x log p x dx 1bit自由度 四、(15分)设一个离散无记忆信源的概率空间为P x 0.5 0.5 它们通过干扰信道,信道输出端的接收信号集为丫= 示。 试计算: (1)信源X中事件x的自信息量;(3分) (2)信源X的信息熵;(3分) (3)共熵H XY ; ( 3 分) (4)噪声熵H Y X ;(3分) (5)收到信息丫后获得的关于信源X的平均信息量。(1)I x11bit (2)H丄,丄1bit/符号 2 2,已知信道出书概率如下图所 (3 分) 3-1 设有一离散无记忆信源,其概率空间为12()0.60.4X x x P x ???? =? ??? ???? ,信源发出符号通过一干扰信道,接收符号为12{,}Y y y =,信道传递矩阵为516 61344P ???? =? ?????? ? ,求: (1)信源X 中事件1x 和2x 分别含有的自信息量; (2)收到消息j y (j =1,2)后,获得的关于i x (i =1,2)的信息量; (3)信源X 和信宿Y 的信息熵; (4)信道疑义度(/)H X Y 和噪声熵(/)H Y X ; (5)接收到消息Y 后获得的平均互信息量(;)I X Y 。 解:(1)12()0.737,() 1.322I x bit I x bit == (2)11(;)0.474I x y bit =,12(;) 1.263I x y bit =-,21(;) 1.263I x y bit =-, 22(;)0.907I x y bit = (3)()(0.6,0.4)0.971/H X H bit symbol == ()(0.6,0.4)0.971/H Y H bit symbol == (4)()(0.5,0.1,0.1,0.3) 1.685/H XY H bit symbol == (/) 1.6850.9710.714/H X Y bit symbol =-= (/)0.714/H Y X bit symbol = (5)(;)0.9710.7140.257/I X Y bit symbol =-= 3-2 设有扰离散信道的输入端是以等概率出现的A 、B 、C 、D 四个字母。该信道的正 确传输概率为0.5,错误传输概率平均分布在其他三个字母上。验证在该信道上每个字母传输的平均信息量为0.21比特。 证明:信道传输矩阵为: 目录 1 课程设计目的 (1) 2 课程设计正文 (1) 2.1 调制原理 (1) 2.2 解调原理 (3) 2.3 程序分析 (3) 3 课程设计总结 (9) 4 参考文献 (9) 1 课程设计目的 通过我们对这次CDIO 二级项目的学习和理解,综合运用课本中所学到的理论知识完成一个以香农编码为信源编码、(7,4)循环码为信道编码的2FSK 信号调制解调的课程设计。以及锻炼我们查阅资料、方案比较、团结合作的能力。学会了运用MA TLAB 编程来实现2FSK 调制解调过程,并且输出其调制及解调过程中的波形,并且讨论了其调制和解调效果,增强了我们的动手能力,为以后学习和工作打下了基础。 2 课程设计正文 本次课程设计我们所做的课题是一个以香农编码为信源编码、(7,4)循环码为信道编码的2FSK 信号调制解调的CDIO 项目,这就要求我们需要完成信源编码、信道编码、信号的调制解调以及误码率分析等问题。 图1 数字通信系统模型 数字信号的传输方式分为基带传输和带通传输,在实际应用中,大多数信道具有带通特性而不能直接传输基带信号。为了使数字信号在带通信道中传输,必须使用数字基带信号对载波进行调制,以使信号与信道的特性相匹配。这种用数字基带信号控制载波,把数字基带信号变换为数字带通信号的过程称为数字调制。 2.1 调制原理 用基带信号)(t f 对高频载波的瞬时频率进行控制的调制方式叫做调频,在数字调制系统中则称为频移键控(FSK)。频移键控在数字通信中是使用较早的一种调制方式,这种方式实现起来比较容易,抗干扰和抗衰落的性能也较强。其缺点是占用频带较宽,频带利用串不够高,因此,额移键控主要应用于低、中速数据的传输,以及衰落信道与频带较宽 信息论基础1答案 《信息论基础》答案 一、填空题(本大题共10小空,每小空1分,共20分) 1.按信源发出符号所对应的随机变量之间的无统计依赖关系,可将离散信源分为有记忆信源和无记忆信源两大类。 2.一个八进制信源的最大熵为3bit/符号 3.有一信源X ,其概率分布为 123x x x X 111P 2 44?? ?? ?=?? ??? ?? , 其信源剩余度为94.64%;若对该信源进行十次扩展,则每十个符号的平均信息量是 15bit 。 4.若一连续消息通过放大器,该放大器输出的最大瞬间电压为b ,最小瞬时电压为a 。若消息从放大器中输出,则该信源的绝对熵是 ∞ ;其能在每个自由度熵的最大熵是log (b-a ) bit/自由度;若放大器的最高频率为F ,则单位时间内输出的最大信息量是 2Flog (b-a )bit/s. 5. 若某一 信源X ,其平均功率受限为 16w,其概率密度函数是高斯分布时,差熵的 最大值为1log32e π;与其熵相等的非高斯分布信2 源的功率为16w ≥ 6、信源编码的主要目的是提高有效性,信道编码的主要目的是提高可靠性。 7、无失真信源编码的平均码长最小理论极限 (S))。 制为信源熵(或H(S)/logr= H r 8、当R=C或(信道剩余度为0)时,信源与信道达到匹配。 9、根据是否允许失真,信源编码可分为无失真信源编码和限失真信源编码。 10、在下面空格中选择填入数学符号“,,, =≥≤?”或“?” (1)当X和Y相互独立时,H(XY)=H(X)+H(X/Y)。 (2)假设信道输入用X表示,信道输出用Y 表示。在无噪有损信道中,H(X/Y)> 0, H(Y/X)=0,I(X;Y) 信源编码与信道编码解析 摘要:衡量一个通信系统性能优劣的基本因素是有效性和可靠性,有效性是指信道传输信息的速度快慢,可靠性是指信道传输信息的准确程度。在数字通信系统中,信源编码是为了提高有效性,信道编码是为了提高可靠性,而在一个通信系统中,有效性和可靠性是互相矛盾的,也是可以互换的。我们可以用降低有效性的办法提高可靠性,也可以用用降低可靠性的办法提高有效性。本文对信源编码和信道编码的概念,作用,编码方式和类型进行了解析,以便于更好的理解数字通信系统的各个环节。 关键字:信源编码信道编码 Abstract: the measure of a communication system the basic factor is quality performance efficiency and reliability, effectiveness refers to channel to transfer information machine speed, reliability is to point to the accuracy of the information transmission channel. In digital communication system, the source coding is in order to improve the effectiveness, channel coding is in order to improve the reliability, and in a communication system, effectiveness and reliability is contradictory, is also can be interchanged. We can use to reduce the availability of improving the reliability, also can use to improve the effectiveness of reduces reliability. In this paper, the source coding and channel coding concept, function, coding mode and the types of analysis, in order to better understand all aspects of digital communication systems. Key words: the source coding channel coding 中图分类号:TN911.21 文献标识码:A 文章编号: 1引言 数字通信系统: 信源是把消息转化成电信号的设备,例如话筒、键盘、磁带等。 信源编码的基本部分是压缩编码。它用于减小数字信号的冗余度,提高数字信号的有效性,如果是模拟信源,则它还包括数模转换功能,在某些系统中,信源编码还包括加密功能。 信源编码和信源解码 字、符号、图形、图像、音频、视频、动画等各种数据本身的编码通常称为信源编码,信源编码标准是信息领域的基础性标准。无论是数字电视、激光视盘机,还是多媒体通信和各种视听消费电子产品,都需要音视频信源编码这个基础性标准。 大家用电脑打字一定很熟悉,当你用WORD编辑软件把文章(DOC文件)写完,存好盘后,再用PCTOOLS工具软件把你的DOC文件打开,你一定能看到你想象不到的东西,内容全是一些16进制的数字,这些数字叫代码,它与文章中的字符一一对应。现在我们换一种方法,用小画板软件来写同样内容的文章。你又会发现,用小画板软件写出来的BMP文件,占的内存(文件容量)是DOC文件的好几十倍,你知道这是为什么?原来WORD编辑软件使用的是字库和代码技术,而小画板软件使用的是点阵技术,即文字是由一些与坐标位置决定的点来组成,没有使用字库,因此,两者在工作效率上相差几十倍。[信源]->[信源编码]->[信道编码]->[信道传输+噪声]->[信道解码]->[信源解码]->[信宿] 目前模拟信号电视机图像信号处理技术就很类似小画板软件使用的点阵技术,而全数字电视机的图像信号处理技术就很类似WORD编辑软件使用的字库和代码技术。实际上这种代码传输技术在图文电视中很早就已用过,在图文电视机中一般都安装有一个带有图文字库的译码器,对方发送图文信号的时候只需发送图文代码信息,这样可以大大地提高数据传输效率。 对于电视机,显示内容是活动图像信息,它哪来的“字库”或“图库”呢?这个就是电视图像特有的“相关性”技术问题。原来在电视图像信号中,90%以上的图像信息是互相相关的,我们在模拟电视机中使用的Y/C(亮度信号/彩色信号)分离技术,就是利用两行图像信号的相关性,来进行Y/C分离。如果它们之间内容不相关,Y/C信号则无法进行分离。全数字信号电视也一样,如果图像内容不相关,则图像信号压缩也就要免谈。如果图像内容有相关性,那么上一幅图像的内容就相当于下一幅图像的“图形库”,或一幅图像中的某部分就是另一部分的“图形库”,因此,下一幅图像或图像中某一个与另一个相关的部分,在发送信号时,只需发送一个“代码”,而传送一个“代码”要比送一个“图形库”效率高很多,显示时也只需把内容从“图形库”中取出即可,这就是MPEG图像压缩的原理。 利用电视信号的相关性,可以进行图像信号压缩,这个原理大家已经明白,但要找出图像相关性的内容来,那就不是一件很容易的事情,这个技术真的是太复杂了。为了容易理解电视图像的相关性,我们不妨设想做一些试验,把图像平均分成几大块,然后每一块,每一块的进行比较,如果有相同的,我们就定义它们有相关性;如果没有相同的,我们继续细分下去,把每大块又分成几小块,一直比较下去,最后会发现,块分得越细,相同块的数目就越多,但分得太细需要的代码也增多,所以并不是分得越细越好。我们在看VCD的时候经常发现,如果VCD读光盘数据出错,就会在图像中看到“马赛克”,这些“马赛克”就是图像分区时的最小单位,或把数码相片进行放大,也可以看到类似“马赛克”的小区,这就是数码图像的最小“图形库”,每个小“图形库”都要对应一个“代码”。 在单幅图像中找出相关性的几率并不是很大的,所以对单幅图像的压缩率并不很大,这个通过观察数码相片的容量就很容易明白,如果把寻找相关性的范围扩大到两幅图像,你就会发现,具有相关性的内容太多了,这是因为运动物体对于人的眼睛感觉器官来说,是很慢 信源编码 Assignment of CH2 1、(a)画出一般通信系统结构的组成框图,并详细说明各部分的作用或功能; 信源信源编码信道编码调制 噪声信道传输 , 信宿信源解码信道解码解调 图1、一般数字通信系统框图 各部分功能: 1、信源和信宿:信源的作用是把消息转换成原始的电信号;信宿的作用是 把复原的电信号转换成相应的消息。 . 2、信源编码和信源解码:一是进行模/数转换,二是进行数据压缩,即设法降低信号的数码率;信源解码是信源编码的逆过程。 3、信道编码和信道解码:用于提高信道可靠性、减小噪声对信号传输的影响;信道解码是信道编码的反变换。 4、调制和解调:将信息调制为携带信息、适应在信道中传输的信号。数字 " 解调是数字调制的逆变换。 5、信道:通信的通道,是信号传输的媒介。 (b)画出一般接收机和发射机的组成框图,并分别说明信源编解码器和信道编 解码器的作用; … 高频振荡器高频放大调制高频功放天线 " 音频功放 信 号 图2、一般发射机框图(无线广播调幅发射机为例) 天线 信号放大器混频器解调器音频放大器 信 号 本地振荡器 图3、一般接收机框图(无线广播调幅发射机为例) 信源编解码器作用:它通过对信源的压缩、扰乱、加密等一系列处理,力求 用最少的数码最安全地传输最大的信息量。信源编解码主要解决传输的有效性问题。 信道编解码器作用:使数字信息在传输过程中不出错或少出错,而且做到自 动检错和尽量纠错。信道编解码主要解决传输的可靠性问题。 (c)信源编码器和解码器一般由几部分组成,画出其组成图并给以解释。 信源编码器 时频分析量化熵编码 信道传输 时频分析反量化熵解码 信源解码器 图 4、信源编解码器框图 时频分析部分:信源编码器对信源传送来的信号进行一定方法的时域频域分析,建立一个能够表达信号规律性的数学模型,从而得知信号中的相关性和多余度,分析出信号数据中可以剔除或减少的部分(比如人感知不到的高频率音频信号或者看不见的色彩信号等等),以决定对后续数据的比特分配、编码速率等处理问题。 量化部分:根据时频分析的结果,为了更加简洁地表达利用该模型的参数, 减少精度,采取相应量化方法对信号进行量化,减小信号的多余度和不相关性, WCDMA技术的信源编码和信道编码 WCDMA网络是全球商用时间最长,技术成熟、可演进性最好的,全球第一个3G商用网络就是采用WCDMA制式。我国采用了全球广泛应用的WCDMA 3G技术,目前已全面支持HSDPA/HSUPA,网络下载理论最高速率达到14.4Mbps。2G无线宽带的最高下载速度约为150Kbps,我国的WCDMA网络速度几乎是2G网络速度的100倍。支持业务最广泛,基于WCDMA成熟的网络和业务支撑平台,其所能实现的3G业务非常丰富。无线上网卡、手机上网、手机音乐、手机电视、手机搜索、可视电话、即时通讯、手机邮箱、手机报等业务应用可为用户的工作、生活带来更多的便利和美妙享受。终端种类最多,截至2008年底,支持WCDMA商用终端的款式数量超过2000款,全球主要手机厂商都推出了为数众多的WCDMA手机。国内覆盖广泛,截至2009年9月28日,联通3G网络已成功在中国大陆285个地市完成覆盖并正式商用,新覆盖的城镇数量还在不断增长中,联通3G网络和业务已经覆盖了中国绝大部分的人口和地域。开通国家最广,可漫游的国家和地区最多,截至2008年底,全球已有115个国家开通了264个WCDMA网络,占全球3G商用网络的71.3%。截至2009年9月28日,中国联通已与全球215个国家的395个运营商开通了。 WCDMA的优势明显,技术成熟,在WCDMA物理层来看,信源编码和信道编码是WCDMA技术的基础,信源编码是采用语音编码技术,AMR语音编码技术是由基于变速率多模式语音编码技术发展而来,主要原理在于:语音编码器模型由一系列能提供多种编码输出速率与合成质量的声码器构成AMR支持八种速率。鉴于不同信源比特对合成语音质量的影响不同AMR 语音编码器输出的话音比特在传输之前需要按照它们的主观重要性来排序分类,分别采用不同保护程度的信道编码对其进行编码保护。 信源编码AMR模式自适应选择编码器模式以更加智能的方式解决信源和信道编码的速率匹配问题,使得无线资源的配置和利用更加灵活和高效。实际的语音编码速率取决于信道条件,它是信道质量的函数。而这部分工作是解码器根据信道质量的测量参数协助基站来完成,选择编码模式,决定编码速率。原则上在信道质量差时采用低速率编码器,就能分配给信道编码更多的比特冗余位来实现纠错,实现更可靠的差错控制。在信道质量好、误比特率较低时采用高速率编码器,能够提高语音质量。在自适应过程中,基站是主要部分,决定上下行链路采用的速率模式。 信源编码AMR编码器原理,WCDMA系统的AMR声码器共有八种编码模式,它们的输出比特速率不同。为了降低成本和复杂度,八种模式都采用代数码本激励线性预测技术,它们编码的语音特征参量和参量提取方法相同,不同的是参量的量化码本和量化比特数。AMR语音编码器根据实现功能大致可分为LPC分析、基音搜索、代数码本搜索三大部分。其中LPC分析完成的主要功能是获得10阶LPC滤波器的-.个系数,并将它们转化为线谱对参数,并对LSF进行量化;基音搜索包括了开环基音分析和闭环基音分析两部分,以获得基音延迟和基音增益这两个参数;代数码本搜索则是为了获得代数码本索引和代数码本增益,还包括了码本增益的量化。 第10讲 信源编码的性能指标 1. 无失真信源编码的冗余度压缩原理 为了压缩冗余度,必须改造信源输出符号的统计特性。一方面要尽量提高任一时刻输出符号的概率分布的均匀性,另一方面要尽量消除前后输出符号的统计相关性。因此,无失真信源编码的实质是将信源尽可能地改造为均匀分布的无记忆信源。这种信源的通信效率是最大的。改造后的新信源是由原信源和编码器共同组成的,称为编码后的信源。设f 是信源S 的一个编码,X 是编码后的信源,则三者之间的关系表示如下 f S X ??→ 信源编码f 所用的码元可以与信源S 的符号不同,一般是某个信道的输入符号。 从数据处理这个角度来看,编码f 是一个数据处理器,输入信源S 的数据,输出信源X 的数据。从通信的角度看,编码f 是一个信道,输入信源S 的数据,输出信源X 的数据。 无失真信源编码的目的是无损压缩,即用尽可能少的数据表示数据中的所有信息,不能破坏数据原有信息。这相当于提高信息传输效率,使之接近于1。因此,度量无失真编码的压缩性能可以看编码后信息传输效率,称为编码效率。编码效率越接近于1,无损压缩性能越好。下面介绍信源编码的5个性能指标,包括平均码长、码率、编码效率、编码冗余度和压缩率。 2. 平均码长 平均码长是信源编码的一个关键的性能指标。在已知信源熵的前提下,根据平均码长,可以计算出无损压缩编码的码率和编码效率。 定义2.1 设f 是一个N-分组码,各码字的码长分别记为,1i l i q ≤≤,对应的N 长分组的概率为i p ,则f 的平均码长定义为 11(/ q i i i L p l N ==∑码元信源) 注:在有的教材中,当平均码长的单位转化为“比特/信源”时,称为编码速率。本课程用不到这个概念。 讨论:用平均码长估计编码后的数据长度 设S 是一个离散无记忆信源,:f S C →是信源S 的一个编码,其平均码长为L 。令12n s s s s =?是一个信源序列。假设用f 对该数据进行编码,试估计编码后码元序列的长度。 对于信源数据12n s s s s =?,我们令L i 表示信源符号s i 所对应的码字f (s i )的长度,则编码后的数据长度为12+++n L L L 。我们把L i 视为随机变量,则对于任何i ,我们有[]i E L L =。 因为S 是离散无记忆的,所以{L i }是独立同分布随机序列。根据辛钦大数定理,我们有信息论基础及答案

基于Huffman信源编码和LDPC信道编码的联合译码算法

信息论基础理论与应用考试题及答案

信息论基础》试卷(期末A卷

信息论基础答案2

信息论基础与编码课后题答案第三章

以香农编码为信源编码、(7,4)循环码为信道编码的2FSK信号的调制解调

信息论基础1答案

信源编码与信道编码解析

信源编码和信源解码

信源编码(数据压缩)课程课后题与答案(第二章)

WCDMA技术的信源编码和信道编码

第10讲 信源编码的性能指标