轨迹数据挖掘:概述

轨迹数据挖掘:概述

Trajectory Data Mining: An Overview

位置采集和移动计算技术的进步已经产生了大量的空间轨迹数据,这些数据代表了移动物体(如人,车辆和动物)的移动性。在过去十年中,已经提出了许多技术来处理,管理和挖掘轨迹数据,促进了广泛的应用。在本文中,我们对轨迹数据挖掘的主要研究进行了系统的调研,提供了该领域的全景及其研究课题的范围。根据轨迹数据的推导,轨迹数据预处理,轨迹数据管理以及各种挖掘任务(如轨迹模式挖掘,异常值检测和轨迹分类)的路线图,调研探讨了连接,相关性,以及这些现有技术之间的差异。这项调研还介绍了将轨迹转换为其他数据格式(如图,矩阵和张量)的方法,可以应用更多的数据挖掘和机器学习技术。最后,提出了一些公共轨迹数据集。这项调研可以帮助塑造轨迹数据挖掘领域,从而快速了解这一领域对社区的影响。

类别和主题描述符:H.2.8 [数据库管理]:数据库应用- 数据挖掘,空间数据库和GIS; I.2.6 [人工智能]:学习- 知识获取

一般术语:算法,测量,实验

附加关键词和短语:时空数据挖掘,轨迹数据挖掘,轨迹压缩,轨迹索引和检索,轨迹模式挖掘,轨迹异常值检测,轨迹不确定性,轨迹分类,城市计算

1.引言

空间轨迹是由地理空间中的运动物体产生的轨迹,通常由一系列时间顺序的点表示,例如p1 →p2 → · · · → p n,其中每个点包括地理空间坐标集和时间戳,如p = (x, y, t)。

位置采集技术的进步产生了无数的空间轨迹,代表了各种移动物体(如人,车辆和动物)的移动性。这些轨迹为我们提供了前所未有的信息来了解移动物体和位置,促进了基于位置的社交网络[Zheng 2011],智能交通系统和城市计算领域的广泛应用[Zheng et al. 2014b]。这些应用的流行又要求系统地研究新的计算技术,以从轨迹数据中发现知识。在这种情况下,轨迹数据挖掘已经成为越来越重要的研究课题,引起了计算机科学,社会学和地理学等众多领域的关注。

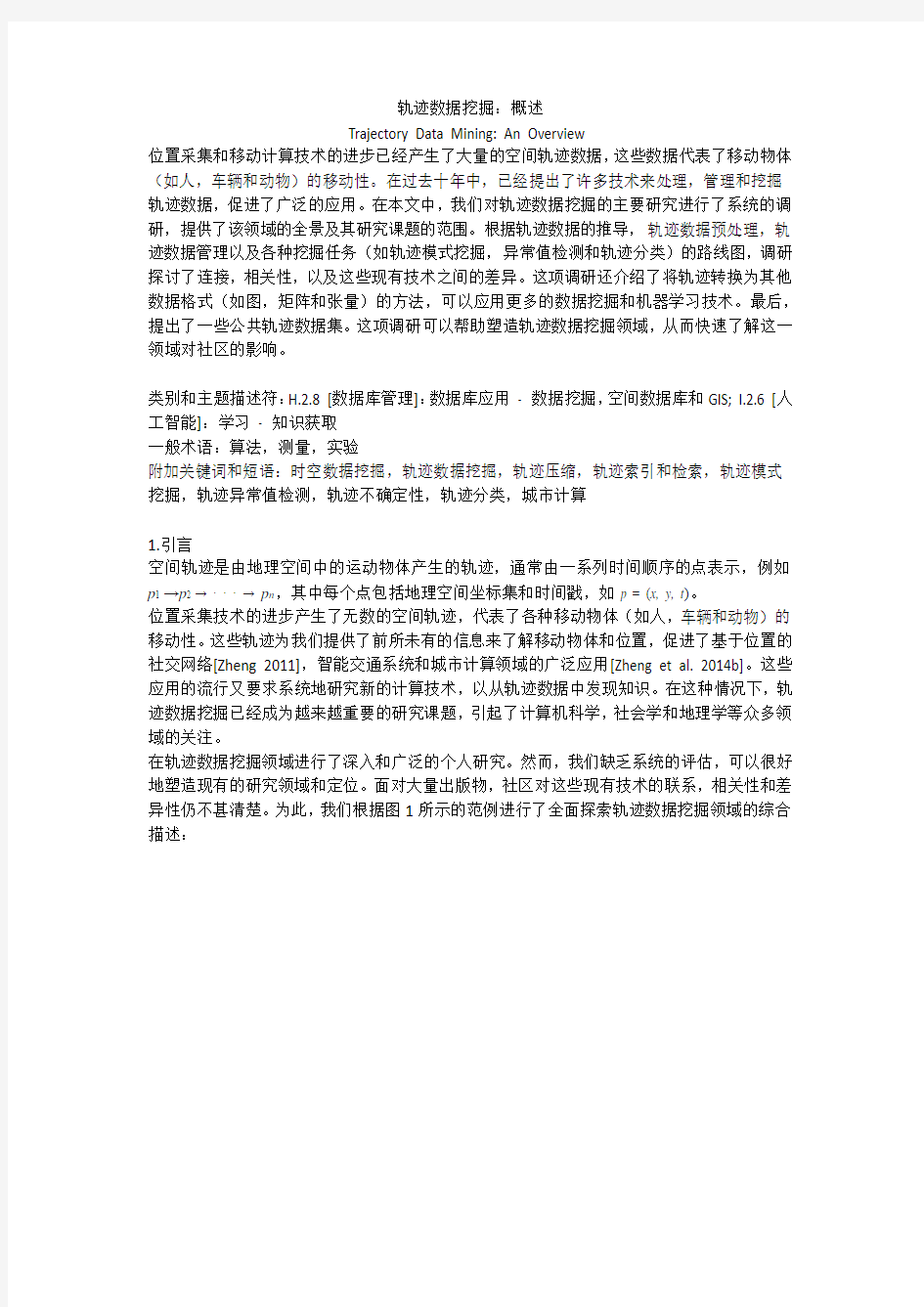

在轨迹数据挖掘领域进行了深入和广泛的个人研究。然而,我们缺乏系统的评估,可以很好地塑造现有的研究领域和定位。面对大量出版物,社区对这些现有技术的联系,相关性和差异性仍不甚清楚。为此,我们根据图1所示的范例进行了全面探索轨迹数据挖掘领域的综合描述:

第一,在第2节中,我们将生成轨迹的数据源分为四组,列出了每个组中轨迹数据可以启用的几个关键应用。

第二,在使用轨迹数据之前,我们需要处理诸如噪声过滤,轨迹分割和地图匹配等诸多问题。这个阶段称为轨迹预处理,这是许多轨迹数据挖掘任务的基本步骤。噪声滤波的目标是从轨迹中去除可能由位置定位系统的差信号(例如,在城市峡谷中行驶时)引起的一些噪声点。轨迹压缩是为了压缩轨迹的大小(为了减少通信,处理和数据存储中的开销),同时保持轨迹的效用。停留点检测算法识别移动物体在一定距离阈值内停留一段时间的位置。停留点可以代表用户已经去过的餐厅或商场,比轨迹中的其他点具有更多的语义含义。轨迹分割通过时间间隔,空间形状或语义含义将轨迹划分成片段,用于进一步的过程,如聚类和分类。地图匹配旨在将轨迹的每个点投射到真正产生点的相应路段上。我们详细介绍第3节中的轨迹预处理。

第三,许多在线应用程序需要即时挖掘轨迹数据(例如,检测交通异常),呼吁有效的数据管理算法可以从大轨迹语料库快速检索满足某些标准(例如时空约束)的特定轨迹。通常有两种主要类型的查询:最近邻[the nearest neighbors]和范围查询[range queries]。前者还与距离度量相关联,例如两个轨迹之间的距离。另外,对于两种类型(历史和最近)的轨迹,需要不同的管理方法。我们将在第4节介绍轨迹索引和检索。

第四,根据前两个步骤,我们可以进行挖掘任务,如轨迹模式挖掘,轨迹不确定性,异常值检测和分类。

- 轨迹不确定性:物体连续移动,而其位置只能在离散时间进行更新,从而使运动物体在两个更新之间的位置不确定。为了增强轨迹的实用性,一系列研究试图建模和减少轨迹的不确定性。另一方面,一个研究的分支旨在用户公开她的轨迹时保护用户的隐私。我们在第5节回顾轨迹的不确定性。

- 轨迹模式挖掘:大量的空间轨迹提供了分析移动对象的移动模式的机会,这可以通过包含某种模式的个体轨迹或一组共享相似模式的轨迹来表示。在第6节中,我们调研了四种模式策略:伴行模式,轨迹聚类,周期模式和频繁序列模式。

- 轨迹分类:使用受监督的学习方法,我们可以将轨迹或分段轨迹划分为某些类别,可以

是行走(如远足和餐饮)或不同的运输模式,如步行和驾驶。我们在第7节中给出了轨迹分类的例子。

- 轨迹异常检测:与轨迹数据中经常发生的轨迹模式不同,轨迹异常值可以是与某些相似度量方面与其他项显着不同的项(轨迹或轨迹段),也可以是不符合预期模式的事件或观察(由轨迹集合表示)(例如由车祸引起的交通拥堵)。第8节介绍轨迹数据的异常检测。

最后,除了研究原始形式的轨迹之外,我们还可以将轨迹转换为其他格式,如图,矩阵和张量(见图1右侧)。轨迹的新表征利用现有的挖掘技术(例如,图挖掘,协同过滤(CF),矩阵因式分解(MF)和张量分解(TD)),扩展和多样化了轨迹数据挖掘的方法。在第9节中,我们给出转换的代表性例子。

这篇文章的贡献有四个方面。首先,本文介绍了轨迹数据挖掘的框架,为该领域定义了范围和路线图。该框架提供了人们可以快速了解并进入该领域的全景图。第二,个人研究工作在这个框架的每一层都有良好的定位,分类和连接。专业人员可以轻松找到解决问题所需的方法,或找到未解决的问题。第三,本文提出了将轨迹转移到其他格式的愿景,可以应用多种现有的挖掘技术。这扩大了轨迹数据挖掘的原始范围,推进了该领域的方法和应用。第四,我们收集人们可以获得各种公共轨迹数据集进行研究的来源列表。我们还介绍了关于轨迹数据研究的会议和期刊。

2.轨迹数据

在本节中,我们将生成轨迹的数据源分为四个主要类别,简要介绍了每个类别中的几个应用场景。代表人类流动性的轨迹数据可以帮助建立更好的社交网络[Bao et al. 2015; Zheng 2011; Zheng et al. 2012b]和旅游推荐[Zheng and Xie 2011b; Zheng et al. 2011c; Zheng et al. 2009b]。(1)人员流动:长期以来,人们以空间轨迹的形式,被动地,积极地记录着现实世界的运动。

活动记录:旅行者使用GPS轨迹记录他们的旅行路线,以记住旅程并与朋友分享经验。自行车和慢跑者记录运动分析的踪迹。在Flickr中,一系列地理标记的照片可以制定空间轨迹,因为每张照片都有一个位置标签和一个对应于照片拍摄地点和时间的时间戳。类似地,在基于位置的社交网络中的用户的“签入”可以被视为轨迹,按时间顺序排列。

无线记录:携带移动电话的用户无意中产生由具有相应转换时间的小区塔ID序列表示的许多空间轨迹。此外,信用卡的交易记录还指示持卡人的空间轨迹,因为每个交易包含表示交易发生的位置的时间戳和商家ID。

(2)运输车辆的流动性:我们日常生活中出现了大量配备GPS的车辆(如出租车,公共汽车,船只和飞机)。例如,主要城市的许多出租车都配备了GPS传感器,可以以一定的频率报告带时间戳的位置。这样的报告制定了大量可用于资源分配的空间轨迹[Yuan et al. 2011b, 2013b],流量分析[Wang et al. 2014; Yuan et al. 2013a],改善交通网络[Zheng et al. 2011a]。(3)动物流动:生物学家一直在收集动物像老虎和鸟类的移动轨迹,目的是研究动物的迁徙痕迹,行为和生活情况[Lee et al. 2007; Li et al. 2010c]。

(4)自然现象的流动:气象学家,环保人士,气候学家和海洋学家正在忙于收集一些自然现象的轨迹,如飓风,龙卷风和洋流。这些轨迹捕捉到环境和气候的变化,帮助科学家处理自然灾害,保护我们生活的自然环境。

3.轨迹数据预处理

本节介绍了在开始挖掘任务之前处理轨迹所需的四项基本技术,包括噪声滤波,停留点检测,轨迹压缩和轨迹分割。

3.1 噪声滤波

由于传感器噪声和其他因素,如在城市峡谷中收到较差的定位信号,空间轨迹永远不会完全准确。有时,错误是可接受的(例如,车辆的几个GPS点落在实际驾驶车辆的道路之外),这可以通过地图匹配算法来修复(在3.5节中介绍)。在其他情况下,如图2所示,像p5这样的噪声点的误差太大(例如距离其真实位置几百米),以得出诸如行进速度等有用的信息。因此,在开始采矿任务之前,我们需要从轨迹中滤除这些噪点。虽然这个问题还没有完全解决,但现有的方法分为三大类。

均值(或中值)滤波器[Mean (or Median) Filter]:对于测量点z i,(未知)真实值的估计是z i 及其n-1个前驱在时间上的平均值(或中值)。均值(中值)滤波器可以被认为是覆盖时间上相邻z i值的Sliding Window。在图2所示的例子中,如果我们使用Sliding Window大小为5的均值滤波器,则。处理极端误差时,中值滤波器比均值滤波器鲁棒性强。均值(中值)滤波器适用于处理具有密集表示的轨迹中的各个噪声点,如p5。然而,当处理多个连续的噪声点时,例如p10,p11和p12,需要较大尺寸的Sliding Window。这导致计算的均值(或中值)和点的真实位置之间的误差更大。当轨迹的采样率非常低(即两个连续点之间的距离可能长于几百米)时,均值和中值滤波器不再是很好的选择。

Kalman和粒子滤波器[Kalman and Particle Filters]:从Kalman滤波器估计的轨迹是测量和运动模型之间的折衷。除了给出符合物理学规律的估计之外,Kalman滤波器还给出了诸如速度等高阶运动状态的原理估计。虽然Kalman滤波器通过假设线性模型和Guass噪声来获得效率,但是粒子滤波器放宽了这些假设,以获得更一般但效率较低的算法。Lee和Krumm [2011]可以找到使用Kalman和粒子滤波器修复噪声轨迹点的类似教程的介绍。

粒子滤波的初始化步骤是从初始分布生成P粒子,j =1, 2, . . . , P。例如,这些粒子将具有零速度并且在Guass分布的初始位置测量周围聚集。第二步是“重要性抽样”,它使用动态模型P(x i|x i-1)概率地模拟粒子在一个时间步长上的变化。第三步使用测量模型计算所有粒子的“重要性权重”。更重要的权重对应于更好地被测量支持的粒子。然后重要的权重被归一化,所以它们相加到一个。当从与归一化重要性权重成正比的中选择一组新的P粒子时,循环中的最后一步是“选择步骤”。最后,我们可以通过来计算权重和。

Kalman和粒子滤波器模拟测量噪声和轨迹的动力学。然而,它们取决于初始位置的测量。如果轨迹中的第一点嘈杂,则两个滤镜的有效性会显着下降。

基于启发式的异常检测[Heuristics-Based Outlier Detection]:虽然先前提到的滤波器在轨迹中用估计值替代噪声测量,但是第三类方法通过使用异常值检测算法从轨迹直接去除噪声点。

噪声滤波方法已被用于T-Drive [Yuan et al. 2010a,2011a,2013a]和GeoLife [Zheng et al. 2009a 的; Zheng et al.2010]项目,首先根据点与其后继者之间的时间间隔和距离(我们称之为段)计算轨迹中每个点的行进速度。切断速度大于阈值(例如,300km / h)的片段,例如p4 → p5, p5 → p6, 和p9 → p10(图2中虚线所示)。假设噪声点的数量比普通点小得多,像p5和p10这样的分离点可以被认为是异常值。一些基于距离的异常值检测可以很容易地找出在距离d 内的p5的邻居的数量小于整个轨迹中的点的比例。同样,可以过滤p10,p11和p12。虽然这样的算法可以处理轨迹中的初始误差和数据稀疏问题,但是设置阈值d和p仍然基于启发式。

3.2 停留点检测

空间点在轨迹上并不是等重要的。有些地方表示人们停留了一段时间的地方,如购物中心和旅游景点,或加油车辆的加油站,我们称这种点为“停留点”。如图3(a)所示,轨迹中出现两种停留点。一个是单点位置,例如,Stay Point 1,用户保持静止一段时间。这种情况是非常罕见的,因为用户的定位设备通常在相同的位置产生不同的读数。第二种类型,如图3(a)所示的“Stay Point 2”,更为普遍地观察到轨迹,表示人们移动的地方(例如,如图3(b)和3(c)所示)或保持静止但定位读数会转移。

有了这样的停留点,我们可以将一系列时间戳-空间点P的轨迹转化为有意义的地方S,

因此促进了各种应用,如旅游建议[Zheng and Xie 2011b; Zheng et al. 2011c],目的地预测[Ye et al. 2009],出租车推荐[Yuan et al. 2011b, 2013b]和天然气消费量估计[Zhang et al. 2013, 2015]。另一方面,在一些应用中,例如,估计路径的行进时间[Wang et al. 2014]和行车路线建议[Yuan et al. 2013a],这样的停留点应该在预处理期间从轨迹中移除。

Li 等[2008]首先提出了停留点检测算法。该算法首先检查定位点(例如,p5)与其后继者之间的距离是否大于给定阈值(例如,100m)的轨迹。然后,它测量定位点和距离阈值内的最后一个后继(即p8)之间的时间间隔。如果时间间隔大于给定的阈值,则检测到停留点(由p5,p6,p7和p8表征);该算法开始从p9检测下一个停留点。Yuan等[2011b, 2013b]基于密度聚类的思想改进了这种停留点检测算法。在找到p5到p8是候选停留点(使用p5作为定位点)之后,他们的算法进一步检查p6的后继点。例如,如果从p9到p6的距离小于阈值,则p9将被添加到停留点。

3.3 轨迹压缩

基本上,我们可以每秒记录移动物体的时间戳地理坐标。但是,这需要大量的电池电量和通信,计算和数据存储的开销。此外,许多应用程序并不真正需要这样的位置精度。为了解决

这个问题,提出了两类轨迹压缩策略(基于轨迹的形状),旨在减少轨迹的大小,同时不会损害其新数据表示的精确度[Lee and Krumm 2011]。一种是线下压缩(即批处理模式),它可以在轨迹完全生成后减小轨迹的大小。另一种是在线压缩,当对象行进时,立即压缩轨迹。

距离度量[Distance Metric]:除了两种策略之外,还有两个距离度量来测量压缩误差:垂直Euclid距离和时间同步Euclid距离。如图4所示,假设我们将具有12个点的轨迹压缩成三个点(即p1, p7和p12)的表示,则两个距离度量是连接p i 和的段的长度的总和,图4(a)和4(b)。后一距离假定在p1和p7之间行进恒定速度,通过时间间隔计算上每个原始点的投影。

离线压缩[Offline Compression]:给定由一系列时间戳点组成的轨迹,批量压缩算法旨在通过从原始轨迹丢弃具有可忽略的误差的一些点来生成近似轨迹。这与线简化问题相似,已经在计算机图形学和地图学研究领域进行了研究[McMaster 1986]。

一个称为Douglas-Peucker[Douglas and Peucker 1973] 的著名算法被用于近似原始轨迹。如图5(a)所示,Douglas-Peucker的想法是用近似的线段代替原始轨迹,例如。如果替换不符合指定的错误要求(在本例中使用垂直Euclid距离),则通过选择贡献最大误差的点作为分割点(例如p4),将原始问题递归地分解为两个子问题。该过程一直持续到近似值和原始轨迹之间的误差低于指定误差。原始Douglas-Peucker算法的复杂度为,其中N 是轨迹中的点数。其改进实现了[Hershberger and Snoeyink 1992]。为了确保近似轨迹是最佳的,Bellman算法[Bellman 1961]采用了一种复杂度为的动态规划技术。

在线数据缩减[Online Data Reduction]:随着许多应用程序需要及时传输轨迹数据,已经提出了一系列在线轨迹压缩技术来确定新获取的空间点是否应当保留在轨迹中。在线压缩方法有两大类。一种是基于窗口的算法,例如Sliding Window算法[Keogh et al. 2001]和Open Window算法[Maratnia and de By 2004]。另一个是基于移动物体的速度和方向。

Sliding Window算法的想法是使具有有效线段的增长Sliding Window中的空间点适应,并继续增长Sliding Window,直到近似误差超过某个误差界限。如图5(b)所示,p5将首先保

留为p3的错误超过阈值。然后,算法从p5开始并保留p8。其他几点可以忽略不计。与Sliding Window算法不同,Open Window算法[Maratnia and de By 2004]应用Douglas-Peucker算法的启发式来选择窗口中最大误差的点(例如,图5(b)中的p3)到近似轨迹段。然后将此点用作新的定位点来近似其后继。

另一类算法将速度和方向作为在线轨迹压缩的关键因素。例如,Potamias等[2006]使用从最后两个位置导出的安全区域和给定的阈值来确定新获取的点是否包含重要信息。如果新的数据点位于安全区域内,则该位置点被认为是冗余的,因此可以被丢弃;否则,它被包括在近似轨迹中。

压缩与语义含义[Compression with Semantic Meaning]:一系列研究[Richter et al. 2012; Chen et al. 2009]旨在在压缩轨迹时保持轨迹的语义含义。例如,在基于位置的社会网络[Zheng 2011]中,用户留下来的一些特殊点,拍摄照片或者改变方向将比其他显示轨迹语义含义更重要。Chen 等[2009]提出了一种轨迹简化(TS)算法,其考虑了形状骨架和上述特征点。TS首先使用轨迹分割算法将轨迹划分为步行和非行进段(Zheng et al. 2008a](见第3.4节)。一个点由其航向变化度和与其邻居的距离加权。

另一个研究分支[Kellaris et al. 2009年;Song et al. 2014]考虑了运输网络约束的轨迹压缩。例如,我们可以减少同一路段上的冗余点。只要移动物体在从定位点到当前位置的最短路径上行进,我们甚至可以在定位点之后丢弃所有新获取的点。这个工作分支通常需要地图匹配算法的支持(参见第3.5节)。2014年,PRESS [Song et al. 2014]被提出将轨迹的空间表示与其时间表示相分离。PRESS由混合空间压缩算法和误差有限时间压缩算法组成,分别压缩轨迹的空间和时间信息。空间压缩将频繁的序列模式挖掘技术与Huffman编码相结合,以减小轨迹的大小;也就是说,频繁行进的路径可以用较短的代码表示,因此可节省存储空间。

3.4 轨迹分割

在许多情况下,例如轨迹聚类和分类,我们需要进一步将一个轨迹进行分割。分割不仅减少了计算复杂度,而且使我们能够挖掘更丰富的知识,如子轨迹模式,从而超出了我们从整个轨迹中学到的知识。一般来说,有三种类型的分割方法。

第一类是基于时间间隔。例如,如图6(a)所示,如果两个连续采样点之间的时间间隔大于给定的阈值,则将轨迹在两点分为两部分,即p1 → p2和p3 → · · · → p9。有时,我们可以

将轨迹划分成相同时间长度的段。

第二类方法是基于轨迹的形状。例如,如图6(b)所示,我们可以通过转向点来划分轨迹,即方向在阈值上改变幅度。或者我们可以使用线简化算法,如Douglas-Peucker算法,来识别保持轨迹形状的关键点,如图6(c)所示。然后通过这些关键点将轨迹分割成段。类似地,Lee等[2007]提出通过使用最小描述语言(MDL)的概念来划分轨迹,该概念由两个部分组成:L(H) 和L(D|H)。L(H)是假设H的描述的长度(以位为单位);而L(D|H)是借助于假设对数据的描述的长度(以位为单位)。解释D的最佳假设H是最小化L(H)和L(D|H)之和的那个。更具体地说,它们使用L(H)表示分割段的总长度(如和),而让L(D|H)表示原始轨迹与新轨迹之间的总(垂直和角度)距离分区段。使用近似算法,它们找到从轨迹最小化L(H) + L(D|H)的特征点的列表。通过这些特征点将轨迹划分成段。

第三类方法是基于轨迹中点的语义含义。如图6(d)所示,基于其包含的停留点,可以将轨迹分成段,即p1 → p2 → p3和p8 → p9。我们是否应该在分割结果中保留停留点取决于应用程序。例如,在旅行速度估计的任务中,我们应该删除出租车停放等待乘客的停留点(出租车的轨迹)[Yuan et al. 2013b]。相反,为了估计两个用户之间的相似性[Lee et al. 2008],我们只能关注停留点序列,同时跳过两个连续停留点之间的其他原始轨迹点。

另一种基于语义意义的轨迹分割是将轨迹划分成不同运输模式的部分,例如驾驶,乘坐公共汽车和步行。例如,Zheng 等[2008a,2008b,2010c]提出了一种基于步行的分割方法。关键的观点是人们必须走过两种不同的交通模式之间的过渡。因此,我们可以首先根据点的速度(p ·v)和加速度(p ·a)来区分轨迹中的步态点和非步行点。如图7(a)所示,轨迹可分为备选步行段和非步行段。然而,实际上,如图7(b)所示,例如,当总线在交通拥堵中缓慢移动时,可以将非步行段的几点检测为可能的步行点。另一方面,由于定位误差,步行段的几点可能超过行驶速度(v t)的上限,因此被识别为非步行点。为了解决这个问题,如果段的距离或时间间隔小于阈值,则将段合并到其后向段中。之后,如图7(c)所示,如果段的长度超过阈值,则将段视为特定段。否则,它被视为不确定细分。由于普通用户在短距离内不频繁地改变其运输模式,如果连续不确定段数超过一定阈值(在本示例中为三个),则将不确定的段合并成一个非步行段。之后,从每个段提取特征以确定其确切模式。

3.5 地图匹配

地图匹配是将原始纬度/经度坐标序列转换为路段序列的过程。了解车辆所在的道路对于评估交通流量,引导车辆的导航,预测车辆的行驶路线以及检测起点与目的地之间最常见的行进路径等是重要的。地图匹配不是一个容易的问题,因为parallel roads, overpasses 和spurs [Krumm 2011]。基于所使用的附加信息或轨迹中考虑的采样点的范围,有两种方法来对地图匹配方法进行分类。

根据所使用的附加信息,地图匹配算法可以分为四组:几何[Greenfeld 2002],拓扑[Chen et al. 2003; Yin and Wolfson 2004],概率[Ochieng et al. 2004; Pink and Hummel 2008; Quddus et al. 2006]和其他先进技术[Lou et al. 2009年; Newson and Krumm 2009; Yuan et al.2010b]。几何地图匹配算法考虑道路网络中各个链路的形状,例如将GPS点与最近的道路相匹配。拓扑算法注意道路网络的连通性。代表性算法是使用Fréchet距离来测量GPS序列和候选路线序列之间的拟合的算法[Brakatsouls et al. 2005]。为了处理嘈杂和低采样率的轨迹,概率算法[Ochieng et al. 2004; Pink and Hummel 2008; Quddus et al. 2006]明确规定了GPS噪声,并考虑通过道路网络的多个可能路径找到最佳路线。最近出现了更先进的地图匹配算法,其包括路网的拓扑和轨迹数据中的噪声,例如Lou等[2009],Newson和Krumm [2009],Yuan等[2010 b]。这些算法找到了一系列道路段,它们同时靠近嘈杂的轨迹数据,形成了通过道路网络的合理路线。

根据考虑的采样点的范围,地图匹配算法可以分为两类:局部/增量和全局方法。局部/增量算法[Civilis et al. 2005; Chawathe 2007]遵循从已经匹配的部分顺序扩展解决方案的贪心策略。这些方法尝试基于距离和方位相似度找到局部最优点。局部/增量方法运行非常有效,通常在在线应用程序中采用。然而,当轨迹的采样率低时,匹配精度降低。相反,全局算法[Alt et al. 2003; Brakatsouls et al. 2005]旨在将整个轨迹与道路网络相匹配,例如,考虑到前提和后继者的一点。全局算法比局部方法更准确,但效率更低,通常应用于已经生成完整轨迹的离线任务(例如挖掘频繁轨迹模式)。

高级算法[Lou et al. 2009; Newson and Krumm 2009; Yuan et al. 2010b]结合局部和全局信息(或几何,拓扑和概率)来处理低采样率轨迹的映射。如图8(a)所示,Lou[2009]等人提出的算法首先找到在轨迹中每个点的圆内的局部候选路段。例如,路段,,和在距离p i的圆内,并且,和是这些路段上的候选点。p i和候选点之间的距离表示p i 可以与候选点匹配的概率。这个概率可以被认为是由正态分布建模的局部和几何信息:

该算法还考虑了每两个连续轨迹点的候选点之间的转移概率。例如,如图8(b)所示,考虑到p i-1和p i+1,更有可能是p i的真正匹配。两个候选点之间的转移概率由他们的Euclid 距离和道路网络距离之间的比率表示。转移实际上是基于道路网的拓扑信息。最后,如图8(c)所示,组合局部和转移概率,映射匹配算法找到一个最大化匹配全局概率的路径(在候选图上)。这个想法类似于隐马尔科夫模型(HMM),其中发射概率和转移概率被认为是找到一系列观察结果的最可能的状态序列[Newson and Krumm 2009]。

4.轨迹数据管理

挖掘大量轨迹是非常耗时的,因为我们需要访问轨迹的不同样本或轨迹的不同部分多次。这需要有效的数据管理技术,可以快速检索所需的轨迹(或轨迹的一部分)。与移动对象的当前位置相关的移动对象数据库不同,本节中引入的轨迹数据管理涉及移动对象的行进历史。Deng等对轨迹数据管理进行了更全面的调研[2011]。

4.1 轨迹索引和检索

有两种主要类型的查询:K-最近邻(KNN)查询和范围查询,如图9所示。范围查询检索落入(或相交)空间(或时空)范围的轨迹。例如,如图9(a)所示,范围查询可帮助我们检索过去一个月下午2点至4点之间通过给定矩形区域R的车辆轨迹。然后,可以使用检索的轨迹(或段)来导出诸如分类和预测的数据挖掘任务的特征,例如行进速度和交通流量。回答这种时空范围查询有三种方法。

第一种方法将时间视为2D地理空间以外的第三维,构建基于轨迹的3D-Rtree,如图10(a)所示。然后,水疗时间范围查询被制定为三维(3D)查询框。因此,回答这样的查询意味着在3D查询框内找到3D-Rtree上的节点。3D-Rtree适用于在近期(例如,过去几个小时)内生成的轨迹的索引。然而,当要索引的轨迹的时间跨度持续很长时间(即,新生成的轨迹的更多段将被插入到3D-Rtree索引中)时,限制不同轨迹段的3D框之间的重叠更频繁地出现。这导致索引结构的频繁更新和检索轨迹时节点访问的显着增加。虽然ST-R树和TB树[Pfoser et al. 2000]已经提出解决这个问题,不同3D框之间的重叠仍然随着时间的推移而不断增加。

第二种方法将时间段划分为多个时间间隔,为每个间隔中生成的轨迹构建一个单独的空间索引,如R-tree。索引结构不随时间变化的部分由两个时隙共享。代表索引结构是多版本的R-tree,如Rt-Tree [Xu et al. 1990],HR-Tree [Tao and Papadias 2001]和H + R-Tree [Tao and Papadias 2001],如图10(b)所示。给定时空范围查询,这样的索引首先找到落在时间范围内的时隙,然后从这些时隙的每个空间索引检索与空间查询范围相交的轨迹。

第三种方法将地理空间划分为网格,然后为落在每个网格中的轨迹构建时间索引。如图10(c)所示,CSEtree [Wang et al. 2008]将网格划分为几个细分。落在网格中的每个段由其坐标是段的开始时间和结束时间的2D点表示。然后这些点由混合B +树索引。当检索满足时空查询的轨迹时,CSE树首先找到与查询的空间范围相交的网格,然后搜索落在查询的时间范围内的轨迹段的这些网格的混合B +树。最后,CSE-tree合并从不同网格检索的轨迹段(及其开始和结束时间)的ID。

KNN查询以最小总距离到几点(标题为KNN点查询[Chen et al. 2010; Tao et al. 2002; Tang et al. 2011])或特定轨迹(标题为KNN轨迹查询[Yi et al. 1998; Agrawal et al. 1993])。

如图9(b)所示,KNN点查询的示例是检索靠近两个给定餐馆的车辆的轨迹(例如,q1 和q2)。有时,查询点之间的顺序也被考虑[Chen et al. 2010],例如,找到首先通过q1和q2的顶部k 最近轨迹。没有订单,Tr1是最接近两点的轨迹。但是,考虑到订单后,Tr2变为最近的。KNN点查询更多地涉及轨迹是否提供与查询位置的良好连接,而不是轨迹是否类似于查询的形状。另外,查询点的数量通常很小,在应用程序中可以相距很远。因此,我们无法顺序连接这些查询点以制定轨迹,然后调用为KNN轨迹查询设计的解决方案。

如图9(c)所示,KNN轨迹查询可以找到通过特定路线行驶的人员的GPS日志。为了回答这样的查询,第一步是定义两个轨迹之间的相似度/距离函数。然后,有效的查询处理算法被设计为解决在大量候选轨迹上搜索的问题。有时,我们需要检索通过特定路径的车辆轨迹。实现目标有两种方法。

一个是将道路网络上的路径视为轨迹,并使用KNN轨迹查询来检测靠近路径的轨迹。另一种方法是首先通过使用地图匹配算法将轨迹转换成路段的序列,然后构建一些索引结构来管理路径和通过它们的轨迹之间的关系。图11给出了基于后缀树的索引结构[Wang et al. 2014],其管理穿过道路网络的四个轨迹Tr1, Tr2, Tr3和Tr4。这里,索引树中的每个节点代表路段;树上的每个路径对应于道路网上的路线。每个节点存储从根到节点的路径的轨迹的ID和行进时间。例如,t r1→r2→r3表示行驶路径r1 → r2 → r3的时间。

通过搜索树,我们可以轻松获取通过路径的轨迹ID,并通过哈希表检索每个轨迹的点(如图11的右下角所示)。如果内存不够大,每个轨迹的详细内容可以存储在磁盘上。因为索引的大小随着轨迹数的增加而快速增长,所以这种索引只适用于管理最近生成的轨迹。

4.2 轨迹距离/相似度

当回答KNN查询或聚类轨迹时,我们需要计算一个轨迹和几个点之间的距离(或者我们可以说相似度),或者两个轨迹之间的距离。

点q和轨迹A之间的距离通常用从q到距离A的最近点的距离来测量,表示为D (q, A) = min p∈A D (p, q);例如,图9(b)所示的q1和p2。将从单个点q到多个查询点Q的距离扩展的方法是或以相似的方式写成。使用指数函数的直觉是为更紧密匹配的点对分配更大的贡献,同时为那些遥远的对赋予更低的价值。Chen等[2010]定义最佳的连接距离,可以测量轨迹和有或没有一个顺序的几个点之间的距离。

两个轨迹之间的距离通常通过某种轨迹点之间的距离聚合来测量。最近距离使用两个轨迹(A, B)中的点之间的最小距离来表示轨迹的相似度,即。假设两个轨迹具有相同的长度,对和对距离使用来自两个轨迹的对应点的总和来表示距离,即

。由于假设可能不符合实际情况,因此提出了动态时间归整(DTW)距离,以便根据需要“重复”一些点数以获得最佳对齐方式[Agrawal et al. 1993]。由于来自轨迹的一些噪声点可能导致轨迹之间的较大距离,所以采用最长公共子序列(LCSS)的概念来解决这个问题。基于LCSS的距离允许在计算轨迹距离时跳过一些噪点,使用阈值δ来控制我们可以走多远的时间,以便将一个点从轨迹到另一个轨迹的点匹配。另一个阈值ε用于确定两个点(来自两个不同轨迹)是否匹配。Chen和Ng [2004]提出了在实序列上的编辑距离(EDR),其在使用阈值ε来确定匹配时与LCSS类似,同时对两个匹配的子轨迹之间的间隙给予惩罚。Chen 等[2005]还提出了通过使用恒定的参考点计算距离来实现DTW和EDR 的优点结合实际罚款距离(ERP)距离。请注意,DTW不是度量,因为它不满足三角不等式。EDR是度量,因此可以用于修剪不必要的轨迹。

基本上,提出LCSS和编辑距离来匹配字符串。用于匹配两个轨迹时,需要设置一个阈值ε;这并不是容易的。K-BCT [Chen et al. 2010] 是轨迹的无参数相似性度量,结合了DTW和LCSS 的优点。在匹配过程中,K-BCT可以重复一些轨迹点,并跳过包括异常值在内的不匹配的轨迹点。

两个轨迹段之间的距离:轨迹段的距离度量是基于分段的最小边界矩形(MBR)[Jeung et al.2011]。如图12(a)所示,两段(L1, L2)的MBR分别为(B1, B2),其中每一个由下边界点(x l, y l)和上边界点(x u, y u)的坐标描述。基于MBR的距离D min(B1, B2)被定义为从(B1, B2)的任何两个点之间的最小距离,计算为

其中两个间隔之间的距离被定义为

在图12(a)所示的两个示例中,L1 和L2之间的距离分别为0和。

如图12(b)所示,Lee 等[2007]提出了一个名为“Trajectory-Hausdorff距离(D Haus)”的距离函数,它是三项的加权和:(1)测量两个轨迹之间的距离的总垂直距离(),(2)捕获两个轨迹之间的长度差的平行距离(),(3)反映两个轨迹之间的取向差的角距离()。从形式上看,

其中,w1, w2和w3是取决于应用的权重。

5.轨迹不确定性

随着移动物体的位置以一定的时间间隔被记录,我们获得的轨迹数据通常是物体的真实运动的样本。一方面,物体在两个连续采样点之间的移动变得未知(或称为不确定)。为此,我们期望减少轨迹的不确定性。另一方面,在某些应用中,为了保护用户的隐私,为了防止轨迹泄漏,我们需要使轨迹更加不确定。

5.1 减少轨迹数据的不确定性

以非常低的采样率记录了许多轨迹,导致物体在采样点之间的移动不确定,我们称之为不确定的轨迹。例如,如图13(a)所示,每几分钟记录出租车(p1, p2, p3)的GPS坐标,以减少通信负荷,从而在两个连续的采样点之间产生多个可能的路径。如图13(b)所示,像FourSquare 这样的基于位置的社交网络服务的人员登记记录如果按照时间顺序连接,就可以被视为轨迹。由于人们不经常检查,两个连续签到之间的时间间隔(和距离)可能是几个小时(几公里)。因此,我们不知道用户如何在两个签入之间进行访问。如图13(c)所示,为了节约能源,安装在候鸟上的GPS记录器只能每隔半天发送一次位置记录。因此,一只鸟飞过两个特定地点的路径是相当不确定的。

5.5.1 建模查询轨迹的不确定性

几种模型的不确定性与适当的查询评估技术[Pfoser and Jensen 1999; Cheng et al. 2008]已经提出用于移动对象数据库来回答查询,例如,“对象是否可能与查询窗口相交”。如图13(b)所示,我们不知道由三个应该通过范围查询R检索蓝色签入,而不对轨迹的不确定性进行建模。这些技术中的许多技术旨在为两个采样点之间的不确定物体的位置提供保守的界限。这通常通过使用诸如圆柱体之类的几何物体[Trajcevski et al. 2004,2009]或珠[Trajcevski et al. 2010]作为轨迹近似。这些模型很少涉及数据挖掘,因此不是我们文章的重点。最近的方法在每个时间点都使用独立的概率密度函数[Cheng et al.2004]或随机过程[Qiao et al.2010;Xu et al. 2013; Emrich et al. 2012; Niedermayer et al. 2014](例如,Markov链),以更好地模拟对象的不确定位置并回答不同的查询。

5.5.2 不确定轨迹的路径推理

与上述模型不同,目标在于通过不同查询来检索现有轨迹,一系列新技术推测(或称“构造”)移动物体可能行进的最可能的k路线(即,缺失的子轨迹)基于一系列不确定轨迹的几个采样点之间。主要的见解是,相同/相似路线的共享(或部分共享)的轨迹可以互相补充,使自己更加完整。换句话说,可以通过在相同/相似的路线上(或部分地)交叉参考其他轨迹来内插不确定的轨迹,即“uncertain + uncertain → certain”。例如,给定许多不确定的轨迹出租车(图13(a)中由不同的着色点标记),我们可以推断蓝色路径是最可能的路线(p1, p2, p3)。同样,根据许多用户的登记数据,如图13(b)所示,我们可以发现蓝色曲线是三个蓝色签入之间最可能的旅行路径。同样,鉴于许多鸟类的GPS迹线不确定,我们可以确定鸟类在几个地点上飞行的路径。减少轨迹的不确定性可以支持科学研究,并能够实现许多应用,如

旅游推荐和交通管理。有两种类型的方法来补充不确定的轨迹。

一个设计用于在道路网络设置中生成的轨迹[Zheng et al.2012a]。将这一类别的方法与地图匹配算法分开设置在两个方面。首先,减少轨迹不确定度的方法利用了许多其他轨迹的数据,而地图匹配算法只使用单个轨迹的几何信息和道路网络的拓扑信息。第二,不确定性方法处理的轨迹采样率可能非常低,例如超过10分钟。这似乎几乎不可能用于地图匹配算法。

另一个是移动物体(如飞鸟或远足山的人)不遵循道路网路径[Wei et al.2012] 的一个自由的空间,如图13(b)和13(c)所示。主要挑战有两个方面。一个是确定可能与一系列查询点相关的那些轨迹。另一个是构建一个可以逼近一堆相关轨迹的路线。如图14(a)所示,Wei等[2012]提出的方法首先将地质分割成统一的网格(网格的大小取决于所需的推理精度),然后将轨迹映射到这些网格上。如果通过它们的轨迹满足以下两个规则之一,则可以连接一些网格以形成区域:(1)如果两个轨迹段的起始点位于两个地理空间相邻的网格(g1, g2),两段的终点位于同一网格中,两段行进时间相似,则两个网格(g1, g2)可以连接的。(2)如果起始点位于相同的网格中,并且终点落在作为相邻的网格(g4, g5)中,则两者的行进时间段相似,则可以连接网格(g4, g5)。

在将不相交的网格转换为连接区域后,如图14(b)所示,我们可以构建一个节点为网格的可路线图。基于通过两个网格的轨迹推断图中两个相邻网格之间的方向和行进时间。最后,如图14(c)所示,给出了三个查询点,我们可以基于路线算法找到图上最可能的路线。要找到更详细的路径,可以在通过识别的路线的轨迹上执行回归。

Su 等[2013]提出了一种基于定位的校准系统,其将轨迹对准一组固定定位点。该方法考虑了定位点和轨迹之间的空间关系。它还从历史轨迹训练推理模型,以提高校准。

5.2 轨迹数据隐私

一系列技术旨在保护用户免受用户的轨迹披露所引起的隐私泄露[Abul et al.2008;Xue et al.2013;Zhou and Mokbel 2011] ,而不是使轨迹更加确定。这种技术试图模糊用户的位置,同时确保服务的质量或轨迹数据的效用。我们需要保护用户轨迹数据免受隐私泄露的两个主要场景。

一个是实时连续的基于位置的服务,例如告诉我周围1公里的交通状况。在这种情况下,用户可能不希望在使用服务时完全透露她当前的位置。与简单位置隐私不同,轨迹中连续样本之间的时空相关性可能有助于推断用户的确切位置。在这种情况下试图保护隐私泄露的技术包括空间隐藏[Mokbel et al.2007],混合区[Beresford and Stajano 2003],路径混淆[Hoh et al.2010],基于短ID的Euler直方图[Xie et al.2010],虚拟轨迹[Kido et al.2005]等。

二是出版历史轨迹。收集个人的许多轨迹可能允许攻击者推断她的家庭和工作场所,从而识别个人身份。在这种情况下保护用户隐私的主要技术包括基于聚类的[Abul et al. 2008],基于泛化的[Nergiz et al. 2009],基于抑制的[Terrovitis and Mamoulis 2008]和基于网格的[Gid'ofalvi et al. 2007]方法。关于轨迹隐私的综合调研可以在[Chow and Mokbel 2011]中找到。

6.轨迹数据挖掘

在本节中,我们研究了可以从单个轨迹或一组轨迹中发现的四种主要类型的模式:伴行模式,轨迹聚类,序列模式和周期模式。

6.1 伴行模式

这个分支的研究是发现一组在一段时间内一起移动的对象,如flock[Gudmundsson and Kreveld 2006; Gudmundsson et al. 2004] convoy[Jeung et al. 2008a, 2008b], swarm[Li et al. 2010a], traveling companion [Tang et al. 2012a, 2012b], and gathering [Zheng et al. 2013; Zheng et al. 2014a]。这些模式可以帮助研究物种的迁移,军事监视和交通事件检测等。这些模式可以基于以下因素彼此区分:组的形状或密度,组中的对象的数量和模式的持续时间。

具体来说,flock是一组在一些用户指定大小的盘中一起行进至少k个连续时间戳的对象。flock的一个主要问题是预定义的圆盘,这可能不能很好地描述一个群体在现实中的形状,因此可能会导致所谓的lossy-flock问题。为了避免对移动组的尺寸和形状的刚性限制,提出了通过采用基于密度的聚类来捕获任何形状的通用轨迹挖掘的convoy。代替使用磁盘,convoy需要在k个连续时间点内密集连接一组对象。然而在连续的时间段内对flock和convoy 都有严格的要求。Li et al. [2010a] 提出了一种更通用的轨迹模式,称为swarm,它是持续至少k个(可能不是连续的)时间戳的对象簇。然而convoy和swarm需要将整个轨迹加载到内存中进行模式挖掘时,traveling companion [Tang et al. 2012a]使用数据结构(称为traveling buddy)从正在流式传输到系统的轨迹中不断地发现convoy/swarm样式。所以,traveling companion模式可以被认为是convoy和swarm的在线(和增量)检测方式。

为了发现一些事件,如庆祝活动和游行,对象加入并经常离开事件,gathering模式[Zheng et al. 2013a, 2014a]进一步减少了上述模式的限制,允许一个群体的成员逐渐演变。gathering 的每个聚类应至少包含m p参与者,它们是出现在该gathering的至少k p聚类中的对象。由于gathering模式用于检测事件,因此还要求检测到的图案的几何属性(如位置和形状)相对稳定。

图15(a)说明了这些模式。如果时间戳的设定要求是k = 2,则组是从t1到t3的flock。虽然o5是该群的同伴,但由于flock定义所使用的磁盘的固定大小,因此它不能被包含在内。另一方面,由于是从t1到t3的基于密度的连接,convoy可以将o5包括在组中。在非连续时间段t1和t3期间,五个对象也形成一个swarm。如图15(b)所示,如果我们设置k p= 2和m p= 3,则是一个gathering。不是gathering,因为C5离C2和C3太远。

上述模式挖掘算法通常使用基于密度的距离度量(在Euclid空间中)来找到移动对象的群集。Jensen等人[2007]通过考虑移动物体的语义因素,如航向和速度来扩展距离度量。

6.2 轨迹聚类

为了找到不同移动物体共享的代表性路径或共同趋势,我们通常需要将类似的轨迹组合成clusters。一般的聚类方法是用特征向量表示轨迹,表示两个轨迹之间的相似度与它们的特征向量之间的距离。然而,由于不同的轨迹包含不同和复杂的属性,例如长度,形状,采样率,点数和它们的顺序,所以不同的轨迹生成具有均匀长度的特征向量是不容易的。此外,难以将轨迹中的点的顺序和空间属性编码为其特征向量。

鉴于前面提到的挑战,已经做了一系列技术工作。由于轨迹之间的距离度量已在4.2节中介绍,因此我们将重点介绍为轨迹提出的聚类方法。请注意,本节中讨论的聚类方法专用于自由空间中的轨迹(即,没有道路网络约束)。虽然有一些出版物(例如Kharrat et al. [2008])讨论了道路网络设置中的轨迹聚类,但是这个问题实际上可以通过地图匹配和图聚类算法的组合来解决。也就是说,我们可以首先使用地图匹配算法将轨迹投影到道路网络上,然后使用图聚类算法在路网上找到子图(即道路集合)。

Gaffney和Smyth [1999]和Cadez等[2000]提出通过使用回归混合模型和期望最大化(EM)算法将类似轨迹组合成clusters。该算法针对两个整个轨迹之间的总距离聚类轨迹。然而,移动的物体很少一起旅行在现实世界中的整个路径。为此,Lee等[2007]提出将轨迹划分为线段,并使用Trajectory - Hausdorff距离构建近距离轨迹段,如图16(a)所示。之后会为每个分组集合找到一个代表性的路径。由于轨迹数据经常被逐渐接收,所以Li等[2010b]进一步提出了增量聚类算法,旨在降低接收轨迹的计算成本和存储。Lee [2007]和Li [2010]都采用了一个Micro-and-Macroclustering框架。该框架是Aggarwal等[2003]处理聚类数据流提出的。也就是说,他们的方法首先找到轨迹段的微簇(如图16(b)所示),然后将微簇组成宏簇(如图16(c)所示)。Li工作的一个重要见解[Li et al. 2010b]认为新数据只会影响接收新数据的地方,而不是遥远的地区。

6.3 轨迹挖掘序列模式

研究的一个分支是从单个轨迹或多个轨迹中找到序列模式。这里,序列模式是指以相似的时间间隔行进公共位置序列的一定数量的移动物体。旅行顺序中的位置不一定是连续的。例如,

两个轨迹A和B,

共享一个共同的序列,因为访问次数和旅行时间是相似的(虽然l2和l4在轨迹A中不是连续的)。当语料库(通常称为支持)中出现这样的公共序列超过阈值时,就会检测到序列轨迹模式。寻找这种模式可以有利于旅游推荐[Zheng and Xie 2011b; Giannotti et al. 2007] ,生活模式理解[Ye et al. 2009] ,下一个位置预测[Monreale et al. 2009] ,估计用户相似度[Xiao et al. 2014; Li et al. 2008] 和轨迹压缩[Song et al. 2014]。

为了从轨迹中检测序列模式,我们首先需要在序列中定义一个(公共)位置。理想情况下,在轨迹数据中,像来自社交网络服务的用户签入序列一样,每个位置被标记为唯一的身份(例如餐厅的名称)。如果两个位置共享相同的身份,那么它们是相似的。然而,在许多GPS轨迹中,每个点的特征在于一对GPS坐标,其在每个模式实例中都不会重复。这使得来自两个不同轨迹的点不能直接比较。此外,GPS轨迹可以由数千个点组成。没有妥善处理,这些点将导致巨大的计算成本。

6.3.1 自由空间中的序列模式挖掘

基于线简化的方法[Line-Simplification-Based Methods]:2005年提出了旨在应对上述问题的早期解决方案[Cao et al. 2005]。该解决方案首先通过使用像DP的线简化算法[Douglas and Peucker 1973]来识别轨迹的关键点。然后,将轨迹的碎片组合到每个简化的线段附近,以便计数每个线段的支撑。不考虑轨迹中两点之间的行进时间。

基于聚类的方法[Clustering-Based Methods]:最近,解决上述问题的更一般的方法是将不同轨迹的点聚类到感兴趣的区域。然后,轨迹中的点由点所属的簇ID表示。因此,轨迹被重新形成为在不同轨迹之间可比较的簇ID序列。

例如,如图17(a)所示,三个轨迹可表示为

其中l1,l2和l3是点簇。在转换之后,我们可以通过使用现有的序列模式挖掘算法如PrefixSpan [Pei et al. 2011] and CloseSpan [Yan et al. 2003]来挖掘有时间限制的序列模式。在此示例中,将支持阈值设置为3,我们可以找到是序列模式,如果

其中ρ是保证两个行进时间相似的比率阈值。同样地,如果类似于,类似于,

则将支持阈值设置为2,是序列模式。朝着这个方向,Giannotti等[2007]将城市划分为统一网格,根据每个网格中的GPS点的密度将这些网格分组到感兴趣的区域。然后提出一种先验的算法来检测感兴趣区域的序列模式。

关于更多地关注位置的语义意义的应用,我们可以首先检测每个轨迹的停留点,将轨迹变成一个停留点序列(见第3.2节)。之后,我们可以将这些停留点集中到制定感兴趣的区域,并使用停留点所属的簇ID来表示轨迹。遵循这一策略,Ye 等[2009]提出从个人的GPS轨迹挖掘生活模式。Xiao等[2010,2014]提出了一种基于图的序列匹配算法,以找到两个用户轨迹共享的序列模式,然后使用这些模式来估计两个用户之间的相似性。

6.3.2 路网中的序列模式挖掘

当将序列模式挖掘问题应用于道路网络设置时,我们可以首先使用地图匹配算法将每个轨迹映射到道路网络上。然后,轨迹由路段ID的序列表示,可以将其视为字符串。因此,针对字符串设计的某些序列模式挖掘算法(如LCSS和后缀树[Suffix Tree])可以适应于寻找序列轨迹模式。图17(b)示出了表示图11中描绘的四个轨迹的后缀树。这里,节点是路段,并且从根到节点的路径对应于表示轨迹的字符串的后缀。例如,T r1由字符串r1 → r2 → r6表示,其中r2 → r6和r6是字符串的后缀。与每个链接相关联的数字表示遍历路径的轨迹数,即支持字符串模式。例如,通过r1 → r2和穿过r1 → r2 → r6的轨迹有两个轨迹(T r1和T r2)。在构建这样的后缀树之后,我们可以找到具有大于给定阈值的支持的频繁模式(即,树上的路径),其复杂度为O(n)。请注意,后缀树的大小可以比原始轨迹大得多。因此,当轨迹数据集的大小非常大时,我们需要在其后缀树的深度上设置约束。另外,从后缀树导出的顺序模式必须是连续的。虽然没有明确考虑时间约束,但考虑到路径的速度约束,两个对象在同一路径上的行进时间应该是相似的。

朝着这个方向,Song等[2014]使用后缀树来检测频繁的轨迹模式,然后利用它们与Huffman Encoding结合来压缩轨迹。Wang等[2014]采用后缀树来查找频繁的轨迹模式,用于在估计查询路径的行进时间时减少子拉伸的组合的候选。

6.4 轨迹挖掘周期模式

移动物体通常具有周期性的活动模式。例如,人们每个月都要去购物,动物从一个地方逐年迁移到另一个地方。这种周期性行为为长时间的历史提供了深刻而简明的解释,有助于压缩轨迹数据并预测移动物体的未来移动。

周期模式挖掘已被广泛地用于时间序列数据。例如,Yang 等试图从(分类)时间序列中发现异步模式[Yang et al.2003],令人惊讶的周期性模式[Yang et al. 2001],和差距罚分的模式[Yang et al. 2002]。由于空间位置的模糊性,为时间序列数据设计的现有方法不能直接适用于轨迹。为此,Cao等[2007]提出了一种从轨迹中检索最大周期模式的有效算法。该算法遵循类似于频繁模式挖掘的范例,其中需要(全局)最小支持阈值。然而,在现实世界中,周期性行为可能更复杂,涉及多个交错周期,部分时间跨度和时空噪声和异常值。

为了处理这些问题,Li等[2010c]提出了一种用于轨迹数据的两阶段检测方法。在第一阶段,该方法通过使用基于密度的聚类算法(如KDE)来检测运动对象频繁访问的几个参考点。然后将移动物体的轨迹变换为一些二进制时间序列,每个时间序列指示移动物体在参考点处的“in”(1)和“out”(0)状态。通过对每个时间序列应用傅立叶变换和自相关方法,可以计算每个参考点的周期值。第二阶段通过使用层次聚类算法总结了部分移动序列的周期性行为。2012年,Li等[2012]进一步研究[Li et al. 2010c]从不完整和稀疏的数据源挖掘周期性模式。

7.轨迹分类

轨迹分类旨在区分不同状态的轨迹(或其部分),如运动,交通模式和人类活动。用语义标签标记原始轨迹(或其段)将轨迹的价值提升到下一层次,这可以促进诸如旅行建议,生活经验共享和上下文感知计算之类的许多应用。

一般来说,轨迹分类由三个主要步骤组成:(1)使用分割方法将轨迹划分成段。有时候,每个单个点被认为是最小推理单位。(2)从每个段(或点)中提取特征。(3)构建一个模型来对每个细分(或点)进行分类。由于轨迹本质上是一个序列,我们可以利用现有的序列推理模型,例如动态贝叶斯网络(DBN),隐马尔可夫模型(HMM)和条件随机场(CRF),它们将来自局部点(或段)的信息和序列模式在相邻点(或段)之间。

使用一系列802.11无线电信号,LOCADIO [Krumm and Horvitz 2004]采用隐马尔可夫模型将设备的运动分为两种状态:静态和移动。基于GSM信号的轨迹,Timothy等[2006]试图将用户的移动性分为三个状态,包括静止,步行和驾驶。Zhu[2011]等根据其GPS轨迹,旨在推断一辆出租车的状态,包括被占用,非占用和停放。他们首先使用基于停留点的检测方法,在轨迹上寻找可能的停泊场所。然后,出租车轨迹被这些停泊的地方划分成段(参见图6(d))。对于每个段,它们提取一组结合单个轨迹的知识,多个出租车的历史轨迹以及诸如道路网络和兴趣点(POI)的地理数据的特征。之后,提出了一种两阶段推理方法,将段的状态分为被占用或非占用。该方法首先使用识别的特征来训练局部概率分类器,然后通过隐马尔可夫模型全局地考虑旅行模式。

Zheng等[2008a,2008b]通过运输模式对用户的轨迹进行分类,其中包括驾驶,骑自行车,巴士和步行。由于人们通常在一次旅行中改变运输方式,所以首先根据基于步行的分割方法将轨迹划分成多个段(详见图7)。提取一组特征,例如航向变化率,停止速率和速度变化率,被馈送到决策树分类器中。基于推论结果,考虑到不同地点的不同交通模式之间的转移概率,进行了基于图的后处理步骤来修正可能的错误推理。

Liao等[2004]和Patterson等[2003]提出了一种基于位置的活动识别和重要位置发现的层次推理模型,如图18(a)所示。首先将GPS轨迹划分为10米段,然后通过使用基于CRF的地图匹配算法将每个轨迹投影到相应的街道区块上。基于对这些街道补丁提取的特征,该模型将GPS点序列分类为一系列活动,如a1, a2, . . . , a n(如步行,驾驶和睡眠),同时识别一个人的重要位置,如P1和P2(例如家庭,工作和公共汽车站)。Yin等[2004]提出了一种基于DBN的推理模型,以推断用户的活动以及根据WIFi信号序列的高级目标。图18(b)给出了DBN的结构,其中底层包含原始WIFi信号的输入;第二层是这些信号被接收的位置的列表;顶级对应于用户活动。最后,根据推断的活动顺序推断出高层次的目标。

8.轨迹异常检测

数据清洗数据分析数据挖掘

数据清洗 1.基本概念 数据清洗从名字上也看的出就是把"脏"的"洗掉",指发现并纠正数据文件中可识别的错误的最后一道程序,包括检查数据一致性,处理无效值和缺失值等。因为数据仓库中的数据是面向某一主题的数据的集合,这些数据从多个业务系统中抽取而来而且包含历史数据,这样就避免不了有的数据是错误数据、有的数据相互之间有冲突,这些错误的或有冲突的数据显然是我们不想要的,称为"脏数据"。我们要按照一定的规则把"脏数据""洗掉",这就是数据清洗。而数据清洗的任务是过滤那些不符合要求的数据,将过滤的结果交给业务主管部门,确认是否过滤掉还是由业务单位修正之后再进行抽取。不符合要求的数据主要是有不完整的数据、错误的数据、重复的数据三大类。数据清洗是与问卷审核不同,录入后的数据清理一般是由计算机而不是人工完成。 主要类型 残缺数据 这一类数据主要是一些应该有的信息缺失,如供应商的名称、分公司的名称、客户的区域信息缺失、业务系统中主表与明细表不能匹配等。对于这一类数据过滤出来,按缺失的内容分别写入不同Excel文件向客户提交,要求在规定的时间内补全。补全后才写入数据仓库。 折叠错误数据

这一类错误产生的原因是业务系统不够健全,在接收输入后没有进行判断直接写入后台数据库造成的,比如数值数据输成全角数字字符、字符串数据后面有一个回车操作、日期格式不正确、日期越界等。这一类数据也要分类,对于类似于全角字符、数据前后有不可见字符的问题,只能通过写SQL语句的方式找出来,然后要求客户在业务系统修正之后抽取。日期格式不正确的或者是日期越界的这一类错误会导致ETL运行失败,这一类错误需要去业务系统数据库用SQL 的方式挑出来,交给业务主管部门要求限期修正,修正之后再抽取。 折叠重复数据 对于这一类数据--特别是维表中会出现这种情况--将重复数据记录的所有字段导出来,让客户确认并整理。 数据清洗是一个反复的过程,不可能在几天内完成,只有不断的发现问题,解决问题。对于是否过滤,是否修正一般要求客户确认,对于过滤掉的数据,写入Excel文件或者将过滤数据写入数据表,在ETL开发的初期可以每天向业务单位发送过滤数据的邮件,促使他们尽快地修正错误,同时也可以做为将来验证数据的依据。数据清洗需要注意的是不要将有用的数据过滤掉,对于每个过滤规则认真进行验证,并要用户确认。 数据分析是指用适当的统计分析方法对收集来的大量数据进行分析,提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。这一过程也是质量管理体系的支持过程。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。

数据挖掘概述

数据挖掘概述 阅读目录 ?何为数据挖掘? ?数据挖掘背后的哲学思想 ?数据挖掘的起源 ?数据挖掘的基本任务 ?数据挖掘的基本流程 ?数据挖掘的工程架构 ?小结 回到顶部何为数据挖掘? 数据挖掘就是指从数据中获取知识。 好吧,这样的定义方式比较抽象,但这也是业界认可度最高的一种解释了。对于如何开发一个大数据环境下完整的数据挖掘项目,业界至今仍没有统一的规范。说白了,大家都听说过大数据、数据挖掘等概念,然而真正能做而且做好的公司并不是很多。

笔者本人曾任职于A公司云计算事业群的数据引擎团队,有幸参与过几个比较大型的数据挖掘项目,因此对于如何实施大数据场景下的数据挖掘工程有一些小小的心得。但由于本系列博文主要是结合传统数据挖掘理论和笔者自身在A云的一些实践经历,因此部分观点会有较强主观性,也欢迎大家来跟我探讨。 回到顶部数据挖掘背后的哲学思想 在过去很多年,首要原则模型(first-principle models)是科学工程领域最为经典的模型。 比如你要想知道某辆车从启动到速度稳定行驶的距离,那么你会先统计从启动到稳定耗费的时间、稳定后的速度、加速度等参数;然后运用牛顿第二定律(或者其他物理学公式)建立模型;最后根据该车多次实验的结果列出方程组从而计算出模型的各个参数。通过该过程,你就相当于学习到了一个知识--- 某辆车从启动到速度稳定行驶的具体模型。此后往该模型输入车的启动参数便可自动计算出该车达到稳定速度前行驶的距离。 然而,在数据挖掘的思想中,知识的学习是不需要通过具体问题的专业知识建模。如果之前已经记录下了100辆型号性能相似的车从启动到速度稳定行驶的距离,那么我就能够对这100个数据求均值,从而得到结果。显然,这一过程是是直接面向数据的,或者说我们是直接从数据开发模型的。 这其实是模拟了人的原始学习过程 --- 比如你要预测一个人跑100米要多久时间,你肯定是根据之前了解的他(研究对象)这样体型的人跑100米用的多少时间做一个估计,而不会使用牛顿定律来算。 回到顶部数据挖掘的起源 由于数据挖掘理论涉及到的面很广,它实际上起源于多个学科。如建模部分主要起源于统计学和机器学习。统计学方法以模型为驱动,常常建立一个能够产生数据的模型;而机器学习则以算法为驱动,让计算机通过执行算法来发现知识。仔细想想,"学习"本身就有算法的意思在里面嘛。

大数据一体化教学实训平台简介

大数据一体化教学实训平台简介 大数据一体化教学实训平台是由泰迪科技自主研发,旨在为高校大数据相关专业提供一体化教学实训环境及课程资源。 本平台共包含9大模块:云资源管理平台、教学管理平台、大数据分析平台、Python 数据挖掘建模平台、R语言数据挖掘建模平台、大数据开发实训平台、Python编程实训平台、R语言编程实训平台、大数据整合平台。以教学管理平台、云资源管理平台为支撑,以优质的课程、项目案例资源为核心,并以自主研发的数据挖掘建模平台为实训工具,把课程、软件、硬件内容统一结合,满足高校大数据教学与实训的一体化平台。 大数据一体化教学实训平台架构(总)

大数据一体化教学实训平台架构(理学方向) 大数据一体化教学实训平台架构(工学方向)

大数据一体化教学实训平台特点 ?B/S架构:可直接通过客户机的浏览器对服务器端的一体化教学实训平台进行访问。?模块丰富:提供软硬件管理、教学管理、实验实训等系列模块,满足不同的教学与实训场景使用。 ?拓展性强:教师自主开设新课程、添加各种课程资源与活动,满足用户的个性化需求。?单点登录:用户只需一次登录即可访问所有的教学与实训平台,解决了登录繁琐、操作不便等问题。 ?资源一体:提供教学大纲、教学视频、教学PPT、课后习题、实验指导书、实验数据、实验代码、实验环境等一系列的教学实训资源,全方位解决实际教学与实训过程中所遇到的问题。 ?教学一体:分别提供“教”与“学”的软件环境,教学与实训模块深度融合,真正实现一体化。 ?软硬件一体:硬件环境采用云柜的方式进行搭建,内部集成机柜、服务器(部署一体化教学实训平台)、供配电、UPS、变频空调、应急通风等,整个云柜架构和谐统一、方便安装与维护。 云资源管理平台简介 云资源管理平台主要对实验室云虚拟化资源进行管理及维护,负责对实验室所有软件系统进行管理与监控,将云存储资源、服务器资源和网络资源整合,然后通过虚拟化搭建私有云平台,在私有云平台上搭建教学管理平台与一系列的大数据实训平台。 云资源管理平台功能及特点 ●支持系统资源实时统计和监控 ●支持云主机批量操作和管理 ●支持云主机模板创建与分配 ●支持操作日志查看和可视化分析 ●支持物理服务器集群管理 ●支持基础网络与私有网络 ●云硬盘可独立挂于云主机 ●平台系统高可用,容错性强 ●云主机性能卓越,媲美物理机

数据挖掘与分析心得体会

正如柏拉图所说:需要是发明之母。随着信息时代的步伐不断迈进,大量数据日积月累。我们迫切需要一种工具来满足从数据中发现知识的需求!而数据挖掘便应运而生了。正如书中所说:数据挖掘已经并且将继续在我们从数据时代大步跨入信息时代的历程中做出贡献。 1、数据挖掘 数据挖掘应当更正确的命名为:“从数据中挖掘知识”,不过后者显得过长了些。而“挖掘”一词确是生动形象的!人们把数据挖掘视为“数据中的知识发现(KDD)”的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤! 由此而产生数据挖掘的定义:从大量数据中挖掘有趣模式和知识的过程!数据源包括数据库、数据仓库、Web、其他信息存储库或动态地流入系统的数据。作为知识发现过程,它通常包括数据清理、数据集成、数据变换、模式发现、模式评估和知识表示六个步骤。 数据挖掘处理数据之多,挖掘模式之有趣,使用技术之大量,应用范围之广泛都将会是前所未有的;而数据挖掘任务之重也一直并存。这些问题将继续激励数据挖掘的进一步研究与改进! 2、数据分析 数据分析是指用适当的统计方法对收集来的大量第一手资料和第二手资料进行分析,以求最大化地开发数据资料的功能,发挥数据的作用。是为了提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。 数据分析有极广泛的应用范围。典型的数据分析可能包含以下三个步: 1、探索性数据分析:当数据刚取得时,可能杂乱无章,看不出规律,通过作图、造表、用各种形式的方程拟合,计算某些特征量等手段探索规律性的可能形式,即往什么方向和用何种方式去寻找和揭示隐含在数据中的规律性。 2、模型选定分析,在探索性分析的基础上提出一类或几类可能的模型,然后通过进一步的分析从中挑选一定的模型。 3、推断分析:通常使用数理统计方法对所定模型或估计的可靠程度和精确程度作出推断。 数据分析的目的是把隐没在一大批看来杂乱无章的数据中的信息集中、萃取和提炼出来,以找出所研究对象的内在规律。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。数据分析是组织有目的地收集数据、分析数据,使之成为信息的过程。这一过程是质量管理体系的支持过程。在产品的整个寿命周期,包括从市场调研到售后服务和最终处置的各

数据挖掘工程师工作的职责概述

数据挖掘工程师工作的职责概述 1 职责: 1、针对具体的业务场景需求、定义数据分析及挖掘问题; 2、使用统计学分析方法、挖掘算法、构建有效且通用的数据分析模型,对数据挖掘方案进行验证、开发、改进和优化,实现数据挖掘的功能应用; 3、搭建高扩展高性能的数据分析模型库,作为数据分析团队的基础工具; 4、完成领导安排的其他工作。 任职要求: 1、计算机、统计学、数学相关专业,本科及以上学历; 2、3年及以上相关工作经验,985和211大学的优秀毕业生可放宽至2年以上; 3、熟悉PHM的应用背景、功能定义、系统架构、关键技术; 4、熟练掌握Python进行数据挖掘;会使用Java进行软件开发者优先考虑; 5、熟悉常用数据挖掘算法如分类、聚类、回归、关联规则、神经网络等及其原理,并具备相关项目经验; 6、熟悉数据仓库,熟练使用SQL语言,有良好的数据库编程经验; 7、具备较强的独立解决问题的能力,勤奋敬业、主动性和责任心强。 2 职责: 1、水务行业的数据分析、数据挖掘工作,包括数据模型的需求分析、模型开发和结果分析; 2、按需完成基础数据的清洗、整合与去噪,为分析与建模提供支撑。 3、根据业务需求构建合适的算法及通过数据挖掘、机器学习等手段不断优化策略及算法。 4. 跟踪学习新的建模和数据挖掘技术,与同事共享知识和经验。 任职要求:

1. 计算机、数学、物理等相关专业本科及以上学历, 211、985高校优先 2.具有数据挖掘、机器学习、概率统计基础理论知识,熟悉并应用过常用分类、聚类 等机器学习算法; 3.熟练掌握R编程,熟悉数据库开发技术,并有实际生产使用经验者优先; 4. 学习能力强,拥有优秀的逻辑思维能力,工作认真负责,沟通能力良好,团队合 作意愿强,诚实、勤奋、严谨。 3 职责: 1、负责时间序列分析类算法的维护和设计实现; 2、负责海量内容和业务数据的分析和挖掘、建模,快速迭代算法,提升算法效果; 3、参与搭建和实现大数据平台下的算法处理程序; 4、应用各种机器学习、数据挖掘技术进行数据分析与数据挖掘; 5、根据业务需求进行数学建模,设计并开发高效算法,并对模型及算法进行验证和 实现。 【职位要求】 1、2021届应届毕业生,本科及以上学历,985/211毕业院校优先考虑,计算机软件、通讯相关专业; 2、熟悉linux操作,熟悉oracle数据库及sql语言; 3、掌握数据分析/挖掘方法及相关算法; 4、有R语言开发能力优先; 5、有运营商数据分析,模型构建经验优先。 4 职责: 1、根据公司自主产品需求,研究设计相应数据挖掘方案及算法,分析数据,设计方案,构建原型,快速实现对于数据分析、挖掘的需求;

数据挖掘简介

数据挖掘综述

数据挖掘综述 摘要:数据挖掘是一项较新的数据库技术,它基于由日常积累的大量数据所构成的数据库,从中发现潜在的、有价值的信息——称为知识,用于支持决策。数据挖掘是一项数据库应用技术,本文首先对数据挖掘进行概述,阐明数据挖掘产生的背景,数据挖掘的步骤和基本技术是什么,然后介绍数据挖掘的算法和主要应用领域、国内外发展现状以及发展趋势。 关键词:数据挖掘,算法,数据库 ABSTRACT:Data mining is a relatively new database technology, it is based on database, which is constituted by a large number of data coming from daily accumulation, and find potential, valuable information - called knowledge from it, used to support decision-making. Data mining is a database application technology, this article first outlines, expounds the background of data mining , the steps and basic technology, then data mining algorithm and main application fields, the domestic and foreign development status and development trend. KEY WORDS: data mining ,algorithm, database 数据挖掘产生的背景 上世纪九十年代.随着数据库系统的广泛应用和网络技术的高速发展,数据库技术也进入一个全新的阶段,即从过去仅管理一些简单数据发展到管理由各种计算机所产生的图形、图像、音频、视频、电子档案、Web页面等多种类型的复杂数据,并且数据量也越来越大。在给我们提供丰富信息的同时,也体现出明显的海量信息特征。信息爆炸时代.海量信息给人们带来许多负面影响,最主要的就是有效信息难以提炼。过多无用的信息必然会产生信息距离(the Distance of Information-state Transition,信息状态转移距离,是对一个事物信息状态转移所遇到障碍的测度。简称DIST或DIT)和有用知识的丢失。这也就是约翰·内斯伯特(John Nalsbert)称为的“信息丰富而知识贫乏”窘境。因此,人们迫切希望能对海量数据进行深入分析,发现并提取隐藏在其中的信息.以更好地利用这些数据。但仅以数据库系统的录入、查询、统计等功能,无法发现数据中存在的关系和规则,无法根据现有的数据预测未来的发展趋势。更缺乏挖掘数据背后隐藏知识的手段。正是在这样的条件下,数据挖掘技术应运而生。 数据挖掘的步骤 在实施数据挖掘之前,先制定采取什么样的步骤,每一步都做什么,达到什么样的目标是必要的,有了好的计划才能保证数据挖掘有条不紊的实施并取得成功。很多软件供应商和数据挖掘顾问公司投提供了一些数据挖掘过程模型,来指导他们的用户一步步的进行数据挖掘工作。比如SPSS公司的5A和SAS公司的SEMMA。 数据挖掘过程模型步骤主要包括:1定义商业问题;2建立数据挖掘模型;3分析数据;4准备数据;5建立模型;6评价模型;7实施。 1定义商业问题。在开始知识发现之前最先的同时也是最重要的要求就是了

数据清洗数据分析数据挖掘

数据清洗1.基本概念 数据清洗从名字上也看的出就是把"脏"的"洗掉",指发现并纠正数据文件中可识别的错误的最后一道程序,包括检查数据一致性,处理无效值和缺失值等。因为中的数据是面向某一主题的数据的集合,这些数据从多个业务系统中抽取而来而且包含历史数据,这样就避免不了有的数据是错误数据、有的数据相互之间有冲突,这些错误的或有冲突的数据显然是我们不想要的,称为""。我们要按照一定的规则把"""洗掉",这就是数据清洗。而数据清洗的任务是过滤那些不符合要求的数据,将过滤的结果交给业务主管部门,确认是否过滤掉还是由业务单位修正之后再进行抽取。不符合要求的数据主要是有不完整的数据、错误的数据、重复的数据三大类。数据清洗是与问卷审核不同,录入后的数据清理一般是由计算机而不是人工完成。 主要类型 残缺数据 这一类数据主要是一些应该有的信息缺失,如的名称、分公司的名称、客户的区域信息缺失、业务系统中主表与明细表不能匹配等。对于这一类数据过滤出来,按缺失的内容分别写入不同Excel文件向客户提交,要求在规定的时间内补全。补全后才写入。 错误数据 这一类错误产生的原因是业务系统不够健全,在接收输入后没有进行判断直接写入造成的,比如数值数据输成全角数字、字符串数据后面有一个回车操作、日期格式不正确、日期越界等。这一类数据也要分类,对于类似于、数据前后有

不可见字符的问题,只能通过写语句的方式找出来,然后要求客户在业务系统修正之后抽取。日期格式不正确的或者是日期越界的这一类错误会导致ETL运行失败,这一类错误需要去业务用SQL的方式挑出来,交给业务主管部门要求限期修正,修正之后再抽取。 重复数据 对于这一类数据--特别是维表中会出现这种情况--将重复数据记录的所有字段导出来,让客户确认并整理。 数据清洗是一个反复的过程,不可能在几天内完成,只有不断的发现问题,解决问题。对于是否过滤,是否修正一般要求客户确认,对于过滤掉的数据,写入Excel文件或者将过滤数据写入数据表,在ETL开发的初期可以每天向业务单位发送过滤数据的邮件,促使他们尽快地修正错误,同时也可以做为将来验证数据的依据。数据清洗需要注意的是不要将有用的数据过滤掉,对于每个过滤规则认真进行验证,并要用户确认。 数据分析是指用适当的统计分析方法对收集来的大量数据进行分析,提取有用信息和形成结论而对数据加以详细研究和概括总结的过程。这一过程也是的支持过程。在实用中,数据分析可帮助人们作出判断,以便采取适当行动。 类型 在统计学领域,有些人将数据分析划分为描述性统计分析、探索性数据分析以及验证性数据分析;其中,探索性数据分析侧重于在数据之中发现新的特征,而验证性数据分析则侧重于已有假设的证实或证伪。 探索性数据分析是指为了形成值得假设的检验而对数据进行分析的一种方法,是对传统统计学假设检验手段的补充。该方法由美国着名统计学家约翰·图基(John Tukey)命名。

数据挖掘_概念与技术(第三版)部分习题答案汇总

1.4 数据仓库和数据库有何不同?有哪些相似之处? 答:区别:数据仓库是面向主题的,集成的,不易更改且随时间变化的数据集合,用来支持管理人员的决策,数据库由一组内部相关的数据和一组管理和存取数据的软件程序组成,是面向操作型的数据库,是组成数据仓库的源数据。它用表组织数据,采用ER数据模型。 相似:它们都为数据挖掘提供了源数据,都是数据的组合。 1.3 定义下列数据挖掘功能:特征化、区分、关联和相关分析、预测聚类和演变分析。使用你熟悉的现实生活的数据库,给出每种数据挖掘功能的例子。 答:特征化是一个目标类数据的一般特性或特性的汇总。例如,学生的特征可被提出,形成所有大学的计算机科学专业一年级学生的轮廓,这些特征包括作为一种高的年级平均成绩(GPA:Grade point aversge)的信息, 还有所修的课程的最大数量。 区分是将目标类数据对象的一般特性与一个或多个对比类对象的一般特性进行比较。例如,具有高GPA 的学生的一般特性可被用来与具有低GPA 的一般特性比较。最终的描述可能是学生的一个一般可比较的轮廓,就像具有高GPA 的学生的75%是四年级计算机科学专业的学生,而具有低GPA 的学生的65%不是。 关联是指发现关联规则,这些规则表示一起频繁发生在给定数据集的特征值的条件。例如,一个数据挖掘系统可能发现的关联规则为:major(X, “computing science”) ? owns(X, “personal computer”) [support=12%, confidence=98%] 其中,X 是一个表示学生的变量。这个规则指出正在学习的学生,12% (支持度)主修计算机科学并且拥有一台个人计算机。这个组一个学生拥有一台个人电脑的概率是98%(置信度,或确定度)。 分类与预测不同,因为前者的作用是构造一系列能描述和区分数据类型或概念的模型(或功能),而后者是建立一个模型去预测缺失的或无效的、并且通常是数字的数据值。它们的相似性是他们都是预测的工具: 分类被用作预测目标数据的类的标签,而预测典型的应用是预测缺失的数字型数据的值。 聚类分析的数据对象不考虑已知的类标号。对象根据最大花蕾内部的相似性、最小化类之间的相似性的原则进行聚类或分组。形成的每一簇可以被看作一个对象类。聚类也便于分类法组织形式,将观测组织成类分 层结构,把类似的事件组织在一起。 数据演变分析描述和模型化随时间变化的对象的规律或趋势,尽管这可能包括时间相关数据的特征化、区分、关联和相关分析、分类、或预测,这种分析的明确特征包括时间序列数据分析、序列或周期模式匹配、和基于相似性的数据分析 2.3 假设给定的数据集的值已经分组为区间。区间和对应的频率如下。――――――――――――――――――――――――――――――――――――― 年龄频率――――――――――――――――――――――――――――――――――――― 1~5 200 5~15 450 15~20 300 20~50 1500 50~80 700 80~110 44 ―――――――――――――――――――――――――――――――――――――计算数据的近似中位数值。 解答:先判定中位数区间:N=200+450+300+1500+700+44=3194;N/2=1597 ∵ 200+450+300=950<1597<2450=950+1500; ∴ 20~50 对应中位数区间。

数据挖掘技术

第6卷(A版) 第8期2001年8月 中国图象图形学报 Jou rnal of I m age and Grap h ics V o l.6(A),N o.8 A ug.2001 基金项目:国家自然科学基金项目(79970092)收稿日期:2000206222;改回日期:2000212214数据挖掘技术吉根林1),2)孙志挥2) 1)(南京师范大学计算机系,南京 210097) 2)(东南大学计算机系,南京 210096) 摘 要 数据挖掘技术是当前数据库和人工智能领域研究的热点课题,为了使人们对该领域现状有个概略了解,在消化大量文献资料的基础上,首先对数据挖掘技术的国内外总体研究情况进行了概略介绍,包括数据挖掘技术的产生背景、应用领域、分类及主要挖掘技术;结合作者的研究工作,对关联规则的挖掘、分类规则的挖掘、离群数据的挖掘及聚类分析作了较详细的论述;介绍了关联规则挖掘的主要研究成果,同时指出了关联规则衡量标准的不足及其改进方法,提出了分类模式的准确度评估方法;最后,描述了数据挖掘技术在科学研究、金融投资、市场营销、保险业、制造业及通信网络管理等行业的应用情况,并对数据挖掘技术的应用前景作了展望. 关键词 数据挖掘 决策支持 关联规则 分类规则 KDD 中图法分类号:T P391 T P182 文献标识码:A 文章编号:100628961(2001)0820715207 Survey of the Da ta M i n i ng Techn iques J I Gen2lin1,2),SU N Zh i2hu i2) 1)(D ep art m ent of co mp u ter,N anj ing N or m al U niversity,N anj ing210097) 2)(D ep art m ent of co mp u ter,S ou theast U niversity,N anj ing210096) Abstract D ata m in ing is an em erging research field in database and artificial in telligence.In th is paper,the data m in ing techn iques are in troduced b roadly including its p roducing background,its app licati on and its classificati on. T he p rinci pal techn iques u sed in the data m in ing are su rveyed also,w h ich include ru le inducti on,decisi on tree, artificial neu ral netw o rk,genetic algo rithm,fuzzy techn ique,rough set and visualizati on techn ique.A ssociati on ru le m in ing,classificati on ru le m in ing,ou tlier m in ing and clu stering m ethod are discu ssed in detail.T he research ach ievem en ts in associati on ru le,the sho rtcom ings of associati on ru le m easu re standards and its i m p rovem en t,the evaluati on m ethods of classificati on ru les are p resen ted.Ex isting ou tlier m in ing app roaches are in troduced w h ich include ou tlier m in ing app roach based on statistics,distance2based ou tler m in ing app roach,data detecti on m ethod fo r deviati on,ru le2based ou tlier m in ing app roach and m u lti2strategy m ethod.F inally,the app licati on s of data m in ing to science research,financial investm en t,m arket,in su rance,m anufactu ring indu stry and comm un icati on netw o rk m anagem en t are in troduced.T he app licati on p ro spects of data m in ing are described. Keywords D ata m in ing,D ecisi on suppo rt,A ssociati on ru le,C lassificati on ru le,KDD 0 引 言 数据挖掘(D ata M in ing),也称数据库中的知识发现(KDD:Know ledge D iscovery in D atabase),是指从大型数据库或数据仓库中提取人们感兴趣的知识,这些知识是隐含的、事先未知的潜在有用信息,提取的知识一般可表示为概念(Concep ts)、规则(R u les)、规律(R egu larities)、模式(Pattern s)等形式[1].大家知道,如今已可以用数据库管理系统来存储数据,还可用机器学习的方法来分析数据和挖掘大量数据背后的知识,而这两者的结合就促成了数

数据挖掘研究现状及发展趋势

数据挖掘研究现状及发展趋势摘要:从数据挖掘的定义出发,介绍了数据挖掘的神经网络法、决策树法、遗传算法、粗糙集法、模糊集法和关联规则法等概念及其各自的优缺点;详细总结了国内外数据挖掘的研究现状及研究热点,指出了数据挖掘的发展趋势。 关键词:数据挖掘;挖掘算法;神经网络;决策树;粗糙集;模糊集;研究现状;发展趋势 Abstract:From the definition of data mining,the paper introduced concepts and advantages and disadvantages of neural network algorithm,decision tree algorithm,genetic algorithm,rough set method,fuzzy set method and association rule method of data mining,summarized domestic and international research situation and focus of data mining in details,and pointed out the development trend of data mining. Key words:data mining,algorithm of data mining,neural network,decision tree,rough set,fuzzy set,research situation,development tendency 1引言 随着信息技术的迅猛发展,许多行业如商业、企业、科研机构和政府部门等都积累了海量的、不同形式存储的数据资料[1]。这些海量数据中往往隐含着各种各样有用的信息,仅仅依靠数据库的查询检索机制和统计学方法很难获得这些信息,迫切需要能自动地、智能地将待处理的数据转化为有价值的信息,从而达到为决策服务的目的。在这种情况下,一个新的技术———数据挖掘(Data Mining,DM)技术应运而生[2]。 数据挖掘是一个多学科领域,它融合了数据库技术、人工智能、机器学习、统计学、知识工程、信息检索等最新技术的研究成果,其应用非常广泛。只要是有分析价值的数据库,都可以利用数据挖掘工具来挖掘有用的信息。数据挖掘典型的应用领域包括市场、工业生产、金融、医学、科学研究、工程诊断等。本文主要介绍数据挖掘的主要算法及其各自的优缺点,并对国内外的研究现状及研究热点进行了详细的总结,最后指出其发展趋势及问题所在。 江西理工大学

数据挖掘分类实验详细报告概论

《数据挖掘分类实验报告》 信息安全科学与工程学院 1120362066 尹雪蓉数据挖掘分类过程 (1)数据分析介绍 本次实验为典型的分类实验,为了便于说明问题,弄清数据挖掘具体流程,我们小组选择了最经典的决策树算法进行具体挖掘实验。 (2)数据准备与预处理 在进行数据挖掘之前,我们首先要对需要挖掘的样本数据进行预处理,预处理包括以下步骤: 1、数据准备,格式统一。将样本转化为等维的数据特征(特征提取),让所有的样 本具有相同数量的特征,同时兼顾特征的全面性和独立性 2、选择与类别相关的特征(特征选择) 3、建立数据训练集和测试集 4、对数据集进行数据清理 在本次实验中,我们选择了ILPD (Indian Liver Patient Dataset) 这个数据集,该数据集已经具有等维的数据特征,主要包括Age、Gender、TB、DB、Alkphos、Sgpt、Sgot、TP、ALB、A/G、classical,一共11个维度的数据特征,其中与分类类别相关的特征为classical,它的类别有1,2两个值。 详见下表: 本实验的主要思路是将该数据集分成训练集和测试集,对训练集进行训练生成模型,然后再根据模型对测试集进行预测。 数据集处理实验详细过程:

●CSV数据源处理 由于下载的原始数据集文件Indian Liver Patient Dataset (ILPD).csv(见下图)中间并不包含属性项,这不利于之后分类的实验操作,所以要对该文件进行处理,使用Notepad文件,手动将属性行添加到文件首行即可。 ●平台数据集格式转换 在后面数据挖掘的实验过程中,我们需要借助开源数据挖掘平台工具软件weka,该平台使用的数据集格式为arff,因此为了便于实验,在这里我们要对csv文件进行格式转换,转换工具为weka自带工具。转换过程为: 1、打开weka平台,点击”Simple CLI“,进入weka命令行界面,如下图所示: 2、输入命令将csv文件导成arff文件,如下图所示: 3、得到arff文件如下图所示: 内容如下:

【最全最详细】数据分析与挖掘实验报告

《数据挖掘》实验报告 目录 1.关联规则的基本概念和方法 (2) 1.1数据挖掘 (2) 1.1.1数据挖掘的概念 (2) 1.1.2数据挖掘的方法与技术 (2) 1.2关联规则 (3) 1.2.1关联规则的概念 (3) 1.2.2关联规则的实现——Apriori算法 (4) 2.用Matlab实现关联规则 (6) 2.1Matlab概述 (6) 2.2基于Matlab的Apriori算法 (7) 3.用java实现关联规则 (11) 3.1java界面描述 (11) 3.2java关键代码描述 (14) 4、实验总结 (19) 4.1实验的不足和改进 (19) 4.2实验心得 (20)

1.关联规则的基本概念和方法 1.1数据挖掘 1.1.1数据挖掘的概念 计算机技术和通信技术的迅猛发展将人类社会带入到了信息时代。在最近十几年里,数据库中存储的数据急剧增大。数据挖掘就是信息技术自然进化的结果。数据挖掘可以从大量的、不完全的、有噪声的、模糊的、随机的实际应用数据中,提取隐含在其中的,人们事先不知道的但又是潜在有用的信息和知识的过程。 许多人将数据挖掘视为另一个流行词汇数据中的知识发现(KDD)的同义词,而另一些人只是把数据挖掘视为知识发现过程的一个基本步骤。知识发现过程如下:·数据清理(消除噪声和删除不一致的数据) ·数据集成(多种数据源可以组合在一起) ·数据转换(从数据库中提取和分析任务相关的数据) ·数据变换(从汇总或聚集操作,把数据变换和统一成适合挖掘的形式) ·数据挖掘(基本步骤,使用智能方法提取数据模式) ·模式评估(根据某种兴趣度度量,识别代表知识的真正有趣的模式) ·知识表示(使用可视化和知识表示技术,向用户提供挖掘的知识)。 1.1.2数据挖掘的方法与技术 数据挖掘吸纳了诸如数据库和数据仓库技术、统计学、机器学习、高性能计算、模式识别、神经网络、数据可视化、信息检索、图像和信号处理以及空间数据分析技术的集成等许多应用领域的大量技术。数据挖掘主要包括以下方法。 神经网络方法:神经网络由于本身良好的鲁棒性、自组织自适应性、并行处理、分布存储和高度容错等特性非常适合解决数据挖掘的问题,因此近年来越来越受到人们的关注。典型的神经网络模型主要分3大类:以感知机、bp反向传播模型、函数型网络为代表的,用于分类、预测和模式识别的前馈式神经网络模型;以hopfield的离散模型和连续模型为代表的,分别用于联想记忆和优化计算的反馈式神经网络模型;以art模型、koholon模型为代表的,用于聚类的自组织映射方法。神经网络方法的缺点是"黑箱"性,人们难以理解网络的学习和决策过程。 遗传算法:遗传算法是一种基于生物自然选择与遗传机理的随机搜索算法,是一种仿生全局优化方法。遗传算法具有的隐含并行性、易于和其它模型结合等性质使得它在数据挖掘中被加以应用。sunil已成功地开发了一个基于遗传算法的数据挖掘工具,利用该工具对两个飞机失事的真实数据库进行了数据挖掘实验,结果表明遗传算法是进行数据挖掘的有效方法之一。遗传算法的应用还体现在与神经网络、粗糙集等技术的结合上。如利用遗传算法优化神经网络结构,在不增加错误率的前提下,删除多余的连接和隐层单元;用遗传算法和bp算法结合训练神经网络,然后从网络提取规则等。但遗传算法的算法较复杂,收敛于局部极小的较早收敛问题尚未解决。 决策树方法:决策树是一种常用于预测模型的算法,它通过将大量数据有目的分类,从

数据挖掘技术及其应用

数据挖掘毕业论文 ---------数据挖掘技术及其应用 摘要:随着网络、数据库技术的迅速发展以及数据库管理系统的广泛应用,人们积累的数据越来越多。数据挖掘(Data Mining)就是从大量的实际应用数据中提取隐含信息和知识,它利用了数据库、人工智能和数理统计等多方面的技术,是一类深层次的数据分析方法。本文介绍了数据库技术的现状、效据挖掘的方法以及它在Bayesian网建网技术中的应用:通过散据挖掘解决Bayesian网络建模过程中所遇到的具体问题,即如何从太规模效据库中寻找各变量之间的关系以及如何确定条件概率问题。 关键字:数据挖掘、知识获取、数据库、函数依赖、条件概率 一、引言: 数据是知识的源泉。但是,拥有大量的数据与拥有许多有用的知识完全是两回事。过去几年中,从数据库中发现知识这一领域发展的很快。广阔的市场和研究利益促使这一领域的飞速发展。计算机技术和数据收集技术的进步使人们可以从更加广泛的范围和几年前不可想象的速度收集和存储信息。收集数据是为了得到信息,然而大量的数据本身并不意味信息。尽管现代的数据库技术使我们很容易存储大量的数据流,但现在还没有一种成熟的技术帮助我们分析、理解并使数据以可理解的信息表示出来。在过去,我们常用的知识获取方法是由知识工程师把专家经验知识经过分析、筛选、比较、综合、再提取出知识和规则。然而,由于知识工程师所拥有知识的有局限性,所以对于获得知识的可信度就应该打个 折扣。目前,传统的知识获取技术面对巨型数据仓库无能为力,数据挖掘技术就应运而生。 数据的迅速增加与数据分析方法的滞后之间的矛盾越来越突出,人们希望在对已有的大量数据分析的基础上进行科学研究、商业决策或者企业管理,但是目前所拥有的数据分析工具很难对数据进行深层次的处理,使得人们只能望“数”兴叹。数据挖掘正是为了解决传统分析方法的不足,并针对大规模数据的分析处理而出现的。数据挖掘通过在大量数据的基础上对各种学习算法的训练,得到数据对象间的关系模式,这些模式反映了数据的内在特性,是对数据包含信息的更高层次的抽象[1]。目前,在需要处理大数据量的科研领域中,数据挖掘受到越来越多

数据挖掘及其应用

《数据挖掘论文》 数据挖掘分类方法及其应用 课程名称:数据挖掘概念与技术 姓名 学号: 指导教师: 数据挖掘分类方法及其应用 作者:来煜 摘要:社会的发展进入了网络信息时代,各种形式的数据海量产生,在这些数据的背后隐藏这许多重要的信息,如何从这些数据中找出某种规律,发现有用信息,越来越受到关注。为了适应信息处理新需求和社会发展各方面的迫切需要而发展起来一种新的信息分析技术,这种局势称为数据挖掘。分类技术是数据挖掘中应用领域极其广泛的重要技术之一。各种分类算法有其自身的优劣,适合于不同的领域。目前随着新技术和新领域的不断出现,对分类方法提出了新的要求。 。 关键字:数据挖掘;分类方法;数据分析 引言 数据是知识的源泉。但是,拥有大量的数据与拥有许多有用的知识完全是两回事。过去几年中,从数据库中发现知识这一领域发展的很快。广阔的市场和研究利益促使这一领域的飞速发展。计算机技术和数据收集技术的进步使人们可以从更加广泛的范围和几年前不可想象的速度收集和存储信息。收集数据是为了得到信息,然而大量的数据本身并不意味信息。尽管现代的数据库技术使我们很容易存储大量的数据流,但现在还没有一种成熟的技术帮助我们分析、理解并使数据以可理解的信息表示出来。在过去,我们常用的知识获取方法是由知识工程师把专家经验知识经过分析、筛选、比较、综合、再提取出知识和规则。然而,由于知识工程师所拥有知识的有局限性,所以对于获得知识的可信度就应该打个折扣。目前,传统的知识获取技术面对巨型数据仓库无能为力,数据挖掘技术就应运而生。 数据的迅速增加与数据分析方法的滞后之间的矛盾越来越突出,人们希望在对已有的大量数据分析的基础上进行科学研究、商业决策或者企业管理,但是目前所拥有的数据分析工具很难对数据进行深层次的处理,使得人们只能望“数”兴叹。数据挖掘正是

大数据时代的空间数据挖掘综述

第37卷第7期测绘与空间地理信息 GEOMATICS &SPATIAL INFORMATION TECHNOLOGY Vol.37,No.7收稿日期:2014-01-22 作者简介:马宏斌(1982-),男,甘肃天水人,作战环境学专业博士研究生,主要研究方向为地理空间信息服务。 大数据时代的空间数据挖掘综述 马宏斌1 ,王 柯1,马团学 2(1.信息工程大学地理空间信息学院,河南郑州450000;2.空降兵研究所,湖北孝感432000) 摘 要:随着大数据时代的到来,数据挖掘技术再度受到人们关注。本文回顾了传统空间数据挖掘面临的问题, 介绍了国内外研究中利用大数据处理工具和云计算技术,在空间数据的存储、管理和挖掘算法等方面的做法,并指出了该类研究存在的不足。最后,探讨了空间数据挖掘的发展趋势。关键词:大数据;空间数据挖掘;云计算中图分类号:P208 文献标识码:B 文章编号:1672-5867(2014)07-0019-04 Spatial Data Mining Big Data Era Review MA Hong -bin 1,WANG Ke 1,MA Tuan -xue 2 (1.Geospatial Information Institute ,Information Engineering University ,Zhengzhou 450000,China ; 2.Airborne Institute ,Xiaogan 432000,China ) Abstract :In the era of Big Data ,more and more researchers begin to show interest in data mining techniques again.The paper review most unresolved problems left by traditional spatial data mining at first.And ,some progress made by researches using Big Data and Cloud Computing technology is introduced.Also ,their drawbacks are mentioned.Finally ,future trend of spatial data mining is dis-cussed. Key words :big data ;spatial data mining ;cloud computing 0引言 随着地理空间信息技术的飞速发展,获取数据的手 段和途径都得到极大丰富,传感器的精度得到提高和时空覆盖范围得以扩大,数据量也随之激增。用于采集空间数据的可能是雷达、红外、光电、卫星、多光谱仪、数码相机、成像光谱仪、全站仪、天文望远镜、电视摄像、电子 显微镜、CT 成像等各种宏观与微观传感器或设备,也可能是常规的野外测量、人口普查、土地资源调查、地图扫描、 地图数字化、统计图表等空间数据获取手段,还可能是来自计算机、 网络、GPS ,RS 和GIS 等技术应用和分析空间数据。特别是近些年来,个人使用的、携带的各种传感器(重力感应器、电子罗盘、三轴陀螺仪、光线距离感应器、温度传感器、红外线传感器等),具备定位功能电子设备的普及,如智能手机、平板电脑、可穿戴设备(GOOGLE GLASS 和智能手表等),使人们在日常生活中产生了大量具有位置信息的数据。随着志愿者地理信息(Volunteer Geographic Information )的出现,使这些普通民众也加入到了提供数据者的行列。 以上各种获取手段和途径的汇集,就使每天获取的 数据增长量达到GB 级、 TB 级乃至PB 级。如中国遥感卫星地面站现在保存的对地观测卫星数据资料达260TB ,并以每年15TB 的数据量增长。比如2011年退役的Landsat5卫星在其29年的在轨工作期间,平均每年获取8.6万景影像,每天获取67GB 的观测数据。而2012年发射的资源三号(ZY3)卫星,每天的观测数据获取量可以达到10TB 以上。类似的传感器现在已经大量部署在卫 星、 飞机等飞行平台上,未来10年,全球天空、地空间部署的百万计传感器每天获取的观测数据将超过10PB 。这预示着一个时代的到来,那就是大数据时代。大数据具有 “4V ”特性,即数据体量大(Volume )、数据来源和类型繁多(Variety )、数据的真实性难以保证(Veracity )、数据增加和变化的速度快(Velocity )。对地观测的系统如图1所示。 在这些数据中,与空间位置相关的数据占了绝大多数。传统的空间知识发现的科研模式在大数据情境下已经不再适用,原因是传统的科研模型不具有普适性且支持的数据量受限, 受到数据传输、存储及时效性需求的制约等。为了从存储在分布方式、虚拟化的数据中心获取信息或知识,这就需要利用强有力的数据分析工具来将