概率图模型表示理论_计算机科学刘建伟,黎海恩, 罗雄麟

收稿日期:2009-10-1 基金项目:本课题得到国家重点基础研究发展计划项目(973计划)(2012CB720500);国家自然科学基金项目(21006127),中国石油大学(北京)基础学科研究基金项目资助(JCXK-2011-07)。作者简介:刘建伟,男,1966年生,博士,副研究员,主要研究方向:智能信息处理,概率图模型表示理论

刘建伟1

,黎海恩1

, 罗雄麟1

(中国石油大学(北京)自动化研究所,北京 100249)1

摘 要 概率图模型结合概率论与图论的知识,利用图来表示与模型有关变量的联合概率分布,近年已成为不确定性推理的研究热点,在人工智能、机器学习和计算机视觉等领域有广阔的应用前景。主要研究概率图模型的表示方法,讨论如何利用概率网络中的独立性来简化联合概率分布的方法表示。首先介绍单个节点上的条件概率分布的表示模型及其引起的独立性,包括表格CPD 、确定性CPD 、特定上下文CPD 、因果影响CPD 、高斯模型和混合模型,并把单个分布模型推广到指数分布族中。然后详细介绍贝叶斯网络中的独立性以及图与概率分布的关系,讨论高斯分布和指数分布族的贝叶斯网络表示理论。再详细描述马尔可夫网络的参数化问题及其独立性,也讨论高斯分布和指数分布族的马尔可夫网络表示理论。还给出两种局部有向图模型:条件随机场和链图。并且描述基于模板的概率模型表示,包括动态贝叶斯网络和状态观测模型这两种暂态模型,以及盘模型和概率关系模型这两种对象关系领域的有向概率模型,而且给出对象关系领域的无向表示。最后对概率图模型表示理论和方法所面临的问题及前景进行展望。

关键词 概率图模型;贝叶斯网络;马尔可夫网络;动态贝叶斯网络;概率关系模型;条件随机场;链图;指数分布族;局部概率模型

中图分类号:TP181 文献标识码:A

Representation theory of Probabilistic Graphical Models

LIU Jian-Wei 1, LI Hai-En 1, LUO Xiong-Lin 1

(Research Institute of Automation, China University of Petroleum, Beijing 102249, China )1

Abstract Probabilistic Graphical models bring together graph theory and probability theory in a formalism, so the joint probabilistic distribution of variables in the model can be represented using graph. In recent years, probabilistic graphical models have become the

focus of the research in uncertainty inference, because of its bright prospect for the application in artificial intelligence, machine learning, computer vision and so forth. This work introduces the representations of probabilistic graphical models and discusses how to represent the joint probabilistic distribution compactly using the independences in the network. First, models of the conditional probabilistic distribution of single node and their independences are introduced, including tabular CPD, deterministic CPD, context-specific CPD, CPD of causal influence, Gaussian models and hybrid models, and a general framework called the exponential family that encompasses a broad range of distributions are defined. Then Bayesian network representation and its independence properties are described in detail, as well as the Bayesian network of Gaussian distribution and exponential family. This work also introduces Markov network representation, independence properties in Markov network and Markov network of Gaussian distribution and exponential family. We also give two partially directed models, conditional random fields and chain graph models. In addition, this work discusses template-based representations, including temporal models that contain dynamic Bayesian network and state-observation models, directed probabilistic models for object-relational domains which contain plate models and probabilistic relational models, and undirected representation for object-relational domains. Finally, this work raises some questions that probabilistic graphical models are facing with and discusses its development in the future.

Key words probabilistic graphical model; Bayesian network; Markov network; dynamic Bayesian network; probabilistic relational model; conditional random field; chain graph; exponential family; local probabilistic model

1 引言

概率图模型把概率论与图论结合在一起,为多变量统计建模提供有力的框架。它利用图来表达随机变量间的依赖关系。概率图模型由两部分组成:网络结构图和参数模型。

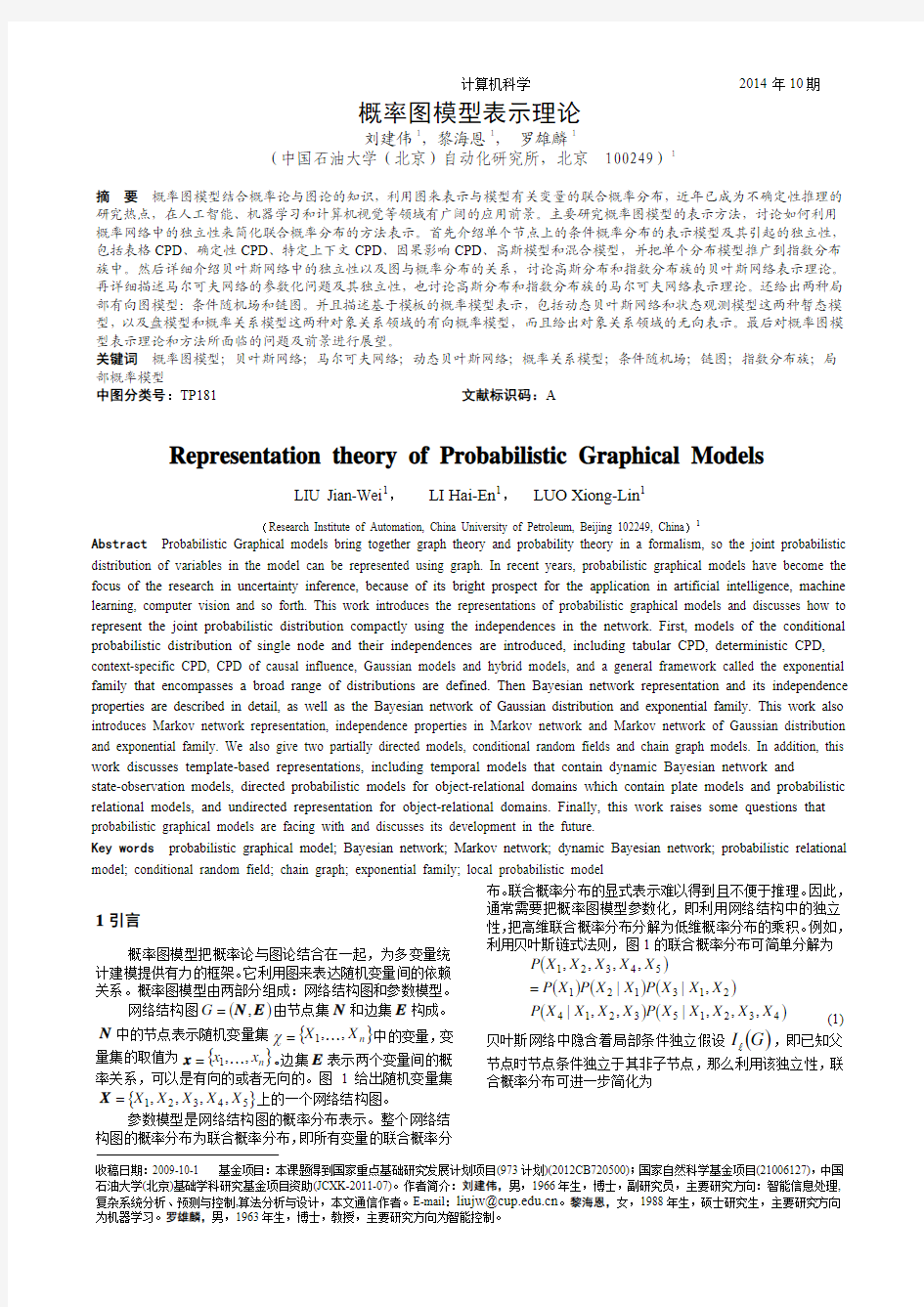

网络结构图()E N ,=G 由节点集N 和边集E 构成。N 中的节点表示随机变量集{}n X X ,,1K =χ中的变量,变

量集的取值为{}n x x ,,1K =x 。

边集E 表示两个变量间的概率关系,可以是有向的或者无向的。图1给出随机变量集

{}54321,,,,X X X X X =X 上的一个网络结构图。 参数模型是网络结构图的概率分布表示。整个网络结构图的概率分布为联合概率分布,即所有变量的联合概率分

布。联合概率分布的显式表示难以得到且不便于推理。因此,

通常需要把概率图模型参数化,即利用网络结构中的独立性,把高维联合概率分布分解为低维概率分布的乘积。例如,利用贝叶斯链式法则,图1的联合概率分布可简单分解为

()

()()()

()()43215321421312154321,,,|,,|,||,,,,X X X X X P X X X X P X X X P X X P X P X X X X X P = (1)

贝叶斯网络中隐含着局部条件独立假设()G I l

,即已知父

节点时节点条件独立于其非子节点,那么利用该独立性,联

合概率分布可进一步简化为

()

()()()

()()35242132154321||,|,,,,X X P X X P X X X P X P X P X X X X X P = (2) 因此,独立性在概率图模型的表示中十分重要,可以简化联合概率分布的表示。讨论概率图模型的表示,主要是讨论其网络结构中的独立性,以及网络结构与概率分布之间的关系。

图 1 简单贝叶斯网络

根据边有无方向性,概率图模型可以分为三类:

(1)有向图模型

有向图模型,也叫做贝叶斯网络(Bayesian Network ,BN)[1]

,其网络结构图使用有向无环图,有向边表示节点间的有向条件依赖关系。其参数模型中,需要为每个节点定义条件概率分布(Conditional Probabilistic Distribution ,CPD),联合概率分布就是所有CPD 的乘积。 (2)无向图模型 无向图模型,也叫做马尔可夫网络(Markov Network ,MN)[2-3],其网络结构图为无向图,无向边表示相邻变量间的直接概率相互作用。其参数模型中,需要为图中每个团定义势函数,或者叫做因子(Factor),联合概率分布就是这些因子的乘积。 (3)局部有向模型 局部有向模型,即同时存在有向边和无向边的模型,

包括条件随机场(Conditional Random Field ,CRF)[4]和链图

(Chain Graph)[5]。

根据表示的侧重点不同,概率图模型又可分两类:

(1)基于变量的概率图模型

基于变量的概率图模型确定某个固定随机变量集X

的联合概率分布,如贝叶斯网络、马尔可夫网络、条件随机

场和链图等。

(2)基于模板的概率图模型[6]

基于模板的概率图模型能够在结构丰富的、由多个不

同类型且相互关联的对象组成的空间上定义联合概率分布,

它构建的单个紧凑模型为同一类型的整个分布类提供模板。

这类模型根据应用场景不同又可分为两种:暂态模型,包括

动态贝叶斯网络(Dynamic Bayesian Network, DBN)[7]和状态

观测模型;对象关系领域的概率模型[8],包括盘模型(Plate

Model, PM)和概率关系模型(Probabilistic Relational Model,

PRM)[9-10]。

概率图模型的发展给不确定性推理的研究带来空前的

变化。早在1979年Duda 等人开发的Prospector 专家系统,

以及1984年Buchanan 等人开发的Mycin 专家诊断系统就

开始不确定性推理的研究工作。但是这些体系使用产生式规

则框架,缺乏正式的语义,在推理模式中也存在重大问题。

另外,人工智能领域研究者提出的模糊逻辑、可能性理论和

D-S 可信函数[11-12]

,也能较好地处理不确定性情况。然而,在Pearl 等人开发的贝叶斯网络框架[13]以及在进行有效推理

的概率模型推动下[14],概率图模型在不确定性推理上显示出很大的优势。 贝叶斯网络是由路径分析(Path Analysis)、因果模式

(Cause Pattern)和影响图(Influence Diagram)[15]等发展演变过

来的。1988年,Pearl 建立起贝叶斯网络体系,给出许多基本概念,如独立映射(Independence-map ,I-映射)、完美映射(Perfect map ,P-映射)、d-分离(d-separation)、独立等价(Independence- Equivalence ,I-等价)等[16-17]。后来这些基本

理论得到不断发展和补充[18-21]。早期的贝叶斯网络主要应用在医疗专家系统中,如David Heckerman 及其同事研究开发

出的Pathfinder 系统[22-23]

。作为一个诊断工具,该系统的诊断效果超过了专业医师,这极大推动了概率图方法的发展,使得概率图模型在90年代成为研究的热点。目前,BN 逐渐成为人工智能[24]、模式识别[25]和数据挖掘[26]等领域的研究热点。Pearl 指出贝叶斯网络是表示独立关系的最基本网络。还存在许多贝叶斯网络的变种,它们使用非概率“参数化”的局部依赖模型,即节点上的参数模型并不使用概率分布。这样的例子有逻辑微积分学[27],D-S 可信函数[28],可能

性理论[29],定性数量级概率[30],以及区间约束概率[31]。

贝叶斯网络的无环性约束,限制了它对变量相互作用的表示能力。而基于无向图的马尔可夫网络能解决相互作用

的表示问题。Hammersley 和Clifford 的研究工作解决了无向

图表示和吉布斯分布之间的联系[32],使得马尔可夫网络的

参数化得以实现。Pearl 和Paz 对MN 的独立性深入研究,推动了MN 独立性研究的发展[33-34]。MN 在计算机视觉领域中的应用,也极大推动了无向图模型的研究。MN 在计算机视觉中的应用包括图像处理[35]、三维重构[36] 和目标识别[37]等。近年来,还提出可分解马尔可夫网络

(Decomposable Markov Network)[38-40]和马尔可夫逻辑网络(Markov Logic Network)[41-42]等。 基于变量的表示不能处理暂态过程和多个对象复杂关系的问题。80年代末出现的隐马尔可夫模型(Hidden Markov Model, HMM)[43]和动态贝叶斯网络[44]解决了暂态过程的概率表示问题。后来的研究工作根据这两种模型开发出更丰富

的表示语言,如混合记忆马尔可夫模型(Mixed-Memory

Markov Model)[45]、因式化HMM(Factorial HMM)[46-47]、层次HMM(hierarchical HMM)[48-49]等。HMM 与DBN 之间有着密切的关系,在一定情况下HMM 可用来表示DBN [50-52]。对象关系领域的概率模型则能处理多个不同类型对象的复杂关系,它起源于90年代提出的基于知识的模型构建理论。对象关系领域的概率模型包括盘模型[53]和概率关系模型[54-55]

。Heckerman 等人还基于或有依赖的PRM 表示,定义了一种使PM 和PRM 相一致的表示语言[56]。近几年的研究焦点主要是为结构不确定性建模,包括为关系不确定性和对象不确定性建模。其中,对象不确定性的对象身份推理已经在多个领域中应用,包括数据关联[57-58]、自然语言文本中的共指消解[59]以及引文匹配[60-61]

等。Milch 等人定义了BLOG(贝叶斯逻辑)[62-63]

,用来为对象数量不确定性建模。 本文首先从单节点的局部概率模型入手,第2节先介绍节点变量的概率分布表示;3~6节再从整体上讨论概率网络的性质,其中第3节说明贝叶斯网络的相关基础概念和多种情况下的表示,第4节讨论马尔可夫网络的参数化、独立性以及其在多种情况下的表示,第5节分析条件随机场和链图这两种局部有向模型,第6节描述基于模板表示的概率图模型;最后,第7节给出总结与展望。 为了表示的统一性,先约定文中所使用的符号。由于节点表示随机变量,所以文中提到的节点也即随机变量。随机变量集为{}n X X ,,1K =χ,变量集的取值为{}n x x ,,1K =x 。一般,节点为大写体,其取值为小写体。

某个节点X 的所有取值为其值域()X R 。节点X 的父节点为X F ,非子节点为X ,邻结点为X N ,边界节点为X B 。离散概率分布用P 表示,连续概率分布用p 表示。满足某一独立性的分布,如满足()Z Y X |⊥的分布P 表示为

()Z Y X P ||⊥=。

2 概率图中节点变量的概率分布表示

概率图模型的参数化是利用全局结构中的独立性把高维联合分布分解为低维CPD 或因子的乘积。节点变量的CPD 或因子的概率分布表示,称为局部概率分布表示。由于CPD 比因子带有更多的约束条件,下面选择根据CPD 来表示局部概率分布。

离散节点变量的概率分布表示,包括表格CPD 、确定性CPD 、上下文说明CPD 和因果影响CPD 。连续节点变量的概率分布表示,主要有高斯模型。同时带有离散节点变量和连续节点变量的概率分布表示,主要使用混合模型。前述局部概率分布都是单个分布的概率表示,而指数分布族可表示一类分布族的概率分布。下面详细介绍这些局部概率分布模型。 2.1 表格CPD

表格CPD ,也称为条件概率表(Conditional Probability Table ,CPT),它把条件概率分布()X F X P |编码为一个表格。变量X 和X F 的每个联合取值的条件概率分布都对应表格中的一项,表格中的每一项都不为负,并且

()()

1|=∑∈X R x X f x P 。

几乎所有离散CPD 都可以用表格CPD 来表示,在推理算法中也可以很自然地使用表格CPD ,因此它是贝叶斯网络的一个重要部分。但是表格CPD 有两个显著的缺点:(1)当节点随机变量的值域为无穷时(节点为连续随机变量),不可能在一个表格中存储所有CPD 。即使节点为离散随机变量,描述表格CPD 所需的参数个数是X 和X F 联合取值的个数,即()()X R F R X ?,该参数个数随父节点个数的增加而指数增加。(2)表格CPD 忽略了CPD 内部的结构,没有利用CPD 内部结构的规律性来减少参数个数。 2.2 确定性CPD 2.2.1 表示

确定性CPD 中变量X 是其父节点X F 的确定性函数,

即存在函数()()X R F R f X a :,使得

()()

??

?==其他

1

|X X f f x f x P (3)

确定性CPD 比表格CPD 更加简洁,在计算机中占用更少空间。在很多领域的建模中都会用到确定性关系,而且确定性变量也有助于简化复杂模型的变量上下文依赖性。 2.2.2 独立性

定义1 令G 为网络结构图,n X X ??K 1为G 中的一条迹。令Z 为观测变量的一个子集。已知Z 时,如果满足下面的条件,迹n X X ??K 1是活动的:

(a)当有一个v-结构11+?←→i i i X X X 时,即两个父节点指向同一子节点时,i X 或它的一个子节点属于Z 。

(b)此迹上没有其他节点属于Z 。

定义2 令X 、Y 、Z 为G 中三个节点集。如果已知Z 时任意节点X ∈X 和Y ∈Y 之间不存在活动迹,那么说已知Z 时X 和Y 是d-分离的,表示为()Z Y X |;G d 。用

()G I 表示与d-分离对应的全局独立集:

()()(){}Z Y X Z Y X |;:|G d G I ⊥= (4)

定义3 令X 、Y 、Z 为G 中三个节点集,其中Z

不仅包含所有观测变量,而且包含可由观测变量确定的所有变量。如果已知Z 时任意节点X ∈X 和Y ∈Y 之间不存在活动迹,那么说已知Z 时X 和Y 是确定性分离的。

定义4 令X 、Y 、Z 为两两不相交变量集合,C 为某个变量集合(可能与Z Y X U U 重叠的集合),并令

()C R c ∈。如果

()()()0c ,,,|,,|>=Z Y Z X Z Y X P c P c P 其中 (5) 那么说已知Z 和上下文c 时X 和Y 是特定上下文独立的

(Context-Specific Independency ,CSI)[64],表示为()c c ,|Z Y X ⊥。

图 2 带有确定性CPD 的网络

考虑图2的例子,C 是A 和B 的确定性函数。已知A 和B 时,C 的值也确定了,因此D 和E 是独立的,即()B A E D ,|⊥。但是,Pearl 提出的d-分离概念并不能发现该独立性。Geiger 等人把d-分离的概念扩展到带有确定性CPD 的贝叶斯网络中,称为确定性分离[65]。令G 为网络结构,并令D 、X 、Y 、Z 为变量集合。若已知Z 时X 与Y 是确定性分离的,那么对所有()G I P l =|的分布P 来说,其中每个D ∈X 时()X F X P |都是确定性CPD ,有

()Z Y X ||⊥=P 。

只已知图结构和确定性CPD 的集合时,只能发现当变量为其父节点的确定性函数时的独立性。但是,某些特殊确定性函数可能隐含着其他的独立性,这类独立性只有当某些变量取特殊值时才存在,如CSI 中的情况。 2.3 特定上下文CPD

2.3.1 表示

特定上下文CPD 中,已知子集X F ?U 的特定取值u 时,其余父节点的取值与CPD 是不相关的,即X f 取不同值时分布()X f X P |是等价的。发现这种特定上下文独立的表示有两种:树CPD 和规则CPD 。

(1)树CPD

Boutilier 等人提出使用完全划分的树CPD 来编码上下文和参数之间的映射[66]。为了避免混淆,与BN 中使用的节点和边相对比,对树CPD 使用t-节点和箭头来描述。树CPD 是一棵有根树,它表示变量X 的CPD 。树中的t-节点有两种:树叶t-节点和内部t-节点。树叶t-节点表示分布()X P ,内部t-节点表示某个变量X F Z ∈。每个内部t-节点有一组向外的箭头指向其子节点,对()Z R z i ∈而言,每个箭头都

计算机科学 2014年10期

与唯一赋值i z Z =相关联。

图 3

()213|X X X P 的树CPD

例如,考虑前面图1所给出的CPD ()213|X X X P ,所有变量都是二值变量。假设已知01=x 时2x 的取值与该CPD

不

相

关

,

即

()

0,0|213==x x X P 与

()1,0|213==x x X P 等价。那么()213|X X X P 的树CPD

如图3所示,其内部t-节点是1X 和2X ,

树叶t-节点表示概率分布()3X P 。该树CPD 能发现已知01=x 时3X 与2X 是特定上下文独立的。

(2)规则CPD

定义5 规则ρ是一对p ;c ,其中c 是变量集C 的某个子集的赋值,[]1,0∈p 。定义C 为ρ的定义域,表示为[]ρD 。

树CPD 是全局表示模型,能发现单个变量的完整CPD 。而规则CPD [67]能实现特定上下文依赖的细粒度表示。每个规则对应CPD 中的一项,说明该项所应用的上下文及其取值。如基于规则的CPD ()X F X P |是一组规则R ,使得:

a .对每个规则R ∈ρ有[]{}X F X D U ?ρ。

b .对{}X F X U 的每个赋值()X f x ,,有一个规则

R c ∈p ;使得c 与()X f x ,相容,即c 可以等价于()

X f x ,或者c 是()X f x ,的子集,表示为()X f x ,~c 。此时,说

()p f F x X P X X ===|。

c .生成的CPD ()X F X P |是一个合法CPD ,其中

()∑=x

X f x P 1|。

前面所述的CPD ()213|X X X P 也可以用一组规则来

表示:

65

.0;1,1,1:35.0;0,1,1:8.0;1,0,1:2.0;0,0,1:4.0;1,0:6.0;0,0:3216321532143213312311================x x x x x x x x x x x x x x x x ρρρρρρ (6)

由规则1ρ和2ρ可以看出,已知01=x 时3X 与2X 是特定上下文独立的。

前面是把规则看作CPD 的分解,我们也可以把规则看作整个联合分布的细粒度分解。令B 为贝叶斯网络,假设B 中的每个CPD ()X F X P |都表示为一组规则X R 。令R 定义为并集X X R χ∈U ,变量集X 的任意取值x 的概率都可如下计算

()∏∈=

c

x R c x ~,;p p

P (7)

2.3.2 独立性 定义6 令p ;c =ρ为规则,c C =为上下文。如果

c ′与c 相容,那么说c ~ρ。此时,令[][]c c c c D D ?′′=′′,

即c ′′的定义域为[][]c c D D ?′,而[]]c c D D ?′中的变量与

c ′中该变量的取值一致。定义简化规则为[]p ;c c ′′=ρ。

对一组规则R 来说,简化规则集合为[][]{}c R c c R ~,:ρρρ∈=。

定义7 令()x F X P |为CPD ,X F Y ∈,并令c 为上

下文。如果()x F X P |满足{

}()c ′?⊥,|Y F Y X X c ,其中X F c c =′,即X F 中变量的取值要与c 中该变量的取值一

致,那么说已知上下文c 时边X Y →是虚假的。

定义8 令X 、Y 、Z 为G 中三个节点集,c 为上

下文。如果消去已知上下文c 时的所有虚假边之后,

已知Z 时X 和Y 还是d-分离的,那么说已知Z 时X 和Y 是CSI-分离的。

一般地,如果定义c 为与X 的树型CPD 有关的上下文,那么已知上下文c 时X 独立于其他的父节点[]c D F x ?。但是,还可能会存在其他CSI 的表述。为了描述的一般化,下面采用规则CPD 进行分析,来寻找所有CSI 的表述。

先举例说明简化规则和虚假边的概念。如果把CPD ()213|X X X P 的规则约束在上下文01=x 上,那么其简化规则集为

4

.0;1:6.0;0:3231==x x ρρ (8)

只留下与01=x 相容的规则,并且把11=x 从所出现的规则中消去。由前面知道,已知01=x 时3X 与2X 是特定上下文独立的,因此,在01=x 时边32X X →是虚假的。

令R 为规则CPD 的规则,[]c R 为R 中与c 相容的简

化规则。令x F ?Y 为X 的某个父节点子集,使得

[]0/=c Y D I 。如果对每个简化规则[]c R ∈ρ有

[]0/=ρD I Y ,那么()c Y Y X ,|?⊥X c F 。但是,该检查

过程并不完整,没有考察实际参数值,因此会漏掉对特定参

数取值而言为真的其他独立;而且该过程只检验已知上下文和其他父节点时X 和某个父节点间的独立性。为此,Boutilier 等人定义了CSI-分离的概念,把d-分离的概念扩展到包含特定上下文独立的网络中。令G 为一个网络结构,P 为使得()G I P l =|的一个分布,c 为上下文,X 、Y 、Z 为变量集。如果在上下文c 中已知Z 时X 与Y 是CSI-分离的,那么()c Z Y X ,||c P ⊥=。 2.4 因果影响CPD

因果影响CPD 中变量Y 的分布由k 个原因k X X ,,1K 的某个子集决定。Y 以任意方式依赖于其父节点,父节点i X 以复杂方式相互作用,但其每个取值组合都与其他取值组合无关,即相互保持独立分布。每个原因i X 独立地影响

Y ,并且几个原因的影响能以某种方式简单组合。下面介

绍因果影响的两种模型:噪声或模型(Noisy-Or Model)和广义线性模型。然后再给出因果影响相互作用的一般定义。 2.4.1 噪声或模型

噪声或模型中[68],原因之间的相互作用为逻辑或关系,

并且每个原因带有噪声。令Y 为二值随机变量,它有k 个二值父节点k X X ,,1K 。如果存在k+1个噪声参数

k λλλ,,,10K 使得

()()

()∏=??==1:0111,,|0i

i x X i i k X X y P λλK (9)

()()()???

????????==∏=1:01111,,|1i i x X i i k X X y P λλK (10) 那么CPD ()k X X Y P ,,|1K 是一个噪声或模型,其中0λ为泄露概率,表示无论任何情况1=y 总是发生的概率,即()1=y P ;i λ为1=i x 引起1=y 发生的概率。

2.4.2 广义线性模型

广义线性模型中,子节点Y 的值由父节点i X 所决定,且两者保持线性函数关系。

令Y 为可取m 个值的变量,它有k 个父节点k X X ,,1K 。如果对每个m j ,,1K =都存在k+1个权值

k j j j ,1,0,,,ωωωK ,使得

()∑=+=k i i i j j k j X X X 1

,0,1,,ωωK l (11)

()()

()

()()

∑

=′′=

=m

j k j k j k X X X X X X j y P 1

111,,exp ,,exp ,,|K l K l K (12)

那么,CPD ()k X X Y P ,,|1K 是一个多类逻辑斯蒂模型。 2.4.3 因果影响相互作用的一般定义

定义9 如果x y y x ?=?,那么说确定性二值函数y x ?是可交换的;如果()()z y x z y x ??=??,那说y x ?是可结合的。如果存在一个可交换可结合的函数y x ?使得

()k k x x x x x f ???=L K 211,,,那么说函数()k x x f ,,1K 是

一个对称可分解的函数。

定义10 如果条件分布()k X X Y P ,,|1K 的局部结构

具有如图4所描述的结构,则说()k X X Y P ,,|1K 具有对称的因果影响独立(Independency of Causal Influence ,ICI)[69],其中Z 的CPD 是一个确定性对称可分解函数f 。若不同变量i Z 的CPD 是相同的,那该CPD 显示出完全对称的ICI 属性。

图 4 因果影响独立

含有不同噪声模型()i i X Z P |和不同对称可分解函数的对称ICI 模型的实例有很多。噪声或模型使用对称可分解的逻辑或函数和简单的带有二值变量的噪声模型。广义线性模型使用i Z 来生成i i X ω,然后相加做为对称可分解函数

f ,最后的阈值效果在已知Z 时Y 的分布中体现。

2.5 高斯模型

前面的局部概率模型中变量是基于离散空间的。为连续变量建模的通用方法是把连续变量离散化,但是离散值会相当多,并且会损失两个离散值之间的结构特征。虽然高斯模型带有强假设,如远离均值时分布指数衰减,以及变量间存在线性相互作用,但是数学上易于处理。而且根据中心极限定理,高斯模型能作为实际连续分布的一个较好近似。使用高斯模型来表示节点的连续分布。

定义11 令Y 为有连续父节点k X X ,,1K 的连续变量。我们说Y 服从线性高斯模型,如果存在参数k ββ,,0K 和2σ使得 ()()

21101;,,|σβββk k k x x N x x Y p L K ++= (13)

其向量表示为

()()

20;|σββx N x Y p T += (14)

2.6 混合模型

混合模型是同时含有离散和连续变量的模型。此模型中,需要处理两种情况:带有连续和离散父节点的连续变量,带有连续和离散父节点的离散变量[70]。

定义12 令X 为连续变量,并令{}m U U ,,1L =U 为其离散父节点,{

}k Y Y ,,1L =Y 为其连续父节点。如果对每个取值()U R u ∈有k+1个系数1,0,,+k u u a a L 和一个方差

2u σ使得

()?

??

?????+=∑=21,0,;,|u

k i i i u u y a a N y u X p σ (15) 那么说X 服从条件线性高斯模型(Conditional Linear

Gaussian ,CLG)CPD [71]。

定义13 如果每个离散变量只有离散父节点,并且每个连续变量有一个CLG 的CPD ,那么贝叶斯网络称为CLG

网络[72]。

首先考虑连续子节点X 的情况,采用CLG 模型。CLG 模型不允许连续变量有离散子节点,它引入一个混合权平均高斯模型的概率分布。该混合形式对离散变量的每个取值包含一个高斯分量;分量的权值是取值的概率。因此,混合分量的个数在最坏情况下是离散变量个数的指数倍。

带有连续父节点的离散子节点的情况中,一般使用阈值模型。例如,假设二值离散变量U 有连续父节点Y ,其阈值模型为

{}??

?≤==其它

05

.080

8

.01y u P (16)

但是在阈值模型中,概率的变化是Y 的一个非连续函数,从数学角度来看是很不方便的。可以利用逻辑斯蒂模型或者它的多项式展开来解决这个问题。 2.7 指数分布族

前面只关注于单个分布的表示,现在考虑指数分布族[73]

。直观上,分布族就是具有相同参数化形式、只在特定参数的选择上有所不同的分布集合。一旦选择了网络的全局结构和局部结构,就定义了一个分布族,它可由CPD 的特殊参数选择来获得。 2.7.1 基本定义

定义14 令χ为变量集。χ上的指数分布族由四部分

来定义:

(a)从χ的取值到K R 的充分统计量函数K R →x :τ;

计算机科学 2014年10期

(b)由凸集M R ?O 定义的参数空间;

(c)从M R 到K R 的自然参数函数K M R R t →:; (d) χ上的测度A 。 每个参数向量O ∈θ说明了分布族中的一个分布θP :

()()()()(){}

ξτθξθξθ,exp 1

t A Z P =

(17) 其中()()ξτθ,t 是向量()θt 和()ξτ的内积,()()()(){∑=ξ

ξτθξθ,exp t A Z 是P 的有限划分函数。指

数分布族P 定义为:{}O ∈=θθ:P P 。

指数分布族是有相似函数形式的概率分布类的简洁表示。分布族中的成员分布是由参数向量θ来确定的。充分统计量函数τ是对概率所有可能取值的总结。函数t 把参数映射到充分统计量空间中。测度A 给不依赖于参数的取值赋予权值。

实际中所遇到的几乎所有参数分布都可以表示成指数分布族,包括泊松分布、指数分布、几何分布、伽马分布等。

通常可以构建编码多个相同分布类的指数分布族,但是分布类的指数分布族表示需要满足以下要求:(1)参数空间O 有较好的特性,特别是要作为M

R 的开凸集;(2)指数分布族是非冗余的,即参数的每个选择表示唯一分布,也就是当θθ′≠时有θθ′≠P P 。可以验证当且仅当函数t 是可逆的,分布族才是非冗余的。这样的指数分布族叫做可逆指数分布族。

2.7.2 线性指数分布族

线性指数分布族是指数分布族的一个特殊类型,由函数t 为恒等式函数的分布族组成,这意味着参数的维数与数据表示的维数一样。对已知的充分统计量函数来说,这样的参数也叫做自然参数。当使用自然参数时,分布简化为

()()

(){ξτθθξθ,exp 1Z P =

(18)

参数空间O 需满足容许性条件:容许自然参数集合(自然参

数空间)为可被归一化的自然参数集合

(){}{}

∫∞<∈=ξξτθθd R K ,exp :O (19)

在有限离散空间的分布情况下,所有参数选择都会产生归一化分布,并且K

R =O 。自然参数空间是开凸集的指数分布族叫做线性指数分布族。

3 贝叶斯网络

BN 由两个部分构成:网络结构图G 和局部CPD 集P 。 (1)BN 的结构图G 是一个有向无环图,其节点表示随机变量n X X ,,1K ,边表示随机变量间的有向依赖。贝叶斯网络的结构图G 隐含着局部条件独立假设:对每个变量i X 有()

i

X X i F C X |⊥。这表明,已知父节点时,i X 与其非子

节点条件独立。

(2)贝叶斯网络的CPD 集P ,是网络结构图G 中每个节点所对应的CPD 的集合。P 中的概率值表示子节点与其父节点间的关联程度,没有父节点的节点概率则为其先验概率。

设n X X ,,1K 为随机变量,那么贝叶斯网络的联合概率分布可参数化表示为:

()()

∏=i

X i n i

F X P X X P |,,1K (20)

结构图G 与分布P 之间的关系是通过独立映射和因式分解的概念来描述的。图G 本身就隐含着局部条件独立性,

而Pearl 又给出d-分离的概念来定义图G 中的全局独立性。两个不同的结构图只要满足相同的独立性,那么这两个图具有独立等价性。已知分布P ,还可以构造反映其独立性的图G 。讨论这些独立性及相关概念,目的主要是使联合概率分布可简化表示。本节最后还介绍BN 中的一种特殊网络,条件贝叶斯网络;以及简单讨论高斯模型的BN 和指数分布族

的BN 。

3.1 图G 与分布P 的关系

3.1.1 独立映射(Independence-map ,I-映射)

定义15 令P 为χ的分布,定义()P I 为P 的独立断言集,即在P 中使()Z Y X |⊥成立的集合。

定义16 令K 为任意图对象,其独立集为()K I ,如果()I K I ?,那么说K 是独立集I 的一个I-映射。

如果G 是()P I 的I-映射,那么说G 也是P 的I-映射。由定义16可看出,当G 是P 的一个I-映射时,G 中的任意

独立性必须包含在P 中,而P 可能含有没有反映在G 中的额外独立性。 3.1.2 因式分解

定义17 令G 为变量n X X ,,1K 的BN 图,那么相同空间上的分布P 可以根据G 来因式分解,如果P 能够表示为

()()

∏==n

i X i n i

F X P X X P 1

1|,,K (21)

如果G 是P 的一个I-映射,那么P 可以根据G 来因式分解,即G 隐含的条件独立假设可以将分布P 因式分解成小的CPD 。相反,如果能根据结构图G 来分解P ,那么G 是P 的一个I-映射。 3.2 图G 中的独立

BN 利用独立性把高维联合概率分布分解为局部CPD 的乘积,从而实现简洁表示。所以,独立性在贝叶斯网络中尤其重要。前面提到,图G 隐含局部条件独立假设:对每个变量i X 有()

i

X X i F C X |⊥,该独立集表示为()G I l 。先

介绍由d-分离概念定义的全局独立性,再引出两个图的独立等价概念。 3.2.1 d-分离

由定义16可知,P 可能含有没有反映在G 中的额外独立性,那根据G 因式分解的每一个分布P 是否存在其他独立集?Pearl 提出的d-分离概念能从结构G 的细节中说明P 包含的独立性,使该问题得到很好的解决。

由定义2知道,d-分离概念给出网络的全局独立集:

()()(){}Z Y X Z Y X |;:|G d G I ⊥= (22) (1)d-分离的健全性 d-分离的健全性是指,如果分布P 根据G 来因式分解,那么()()P I G I ?。也就是说,P 满足d-分离提出的所有全局独立性。

(2)d-分离的完备性

定义18 如果当

()()

P I ∈⊥Z Y X |时有

()Z Y X |;G d ,那么分布P 关于图G 是可信的,也就是P

中的任意独立性都反映在图的d-分离属性中。

d-分离的完备性[74]是指,如果G 中已知Z 时X 和Y 不是d-分离的,那么根据G 因式分解的分布P 中已知Z 时

X 和Y 是依赖的。

Meek 还给出d-分离完备性的测度论概念[75]

:

对在图G 上因式分解的几乎全部分布P 来说,也就是对除了CPD 参数化空间中的零测度的集合之外的所有分布来说,有()()G I P I =。这个结论在两个方面强化了d-分离的完备性:(1)该观点揭示了存在一个分布关于图是可信的,也就是图中的所有依赖关系同时成立于分布中;(2)这个属性不仅适用于单个分布,而且也适用于G 上分解的几乎所有分布。

Shachter 提出了贝叶斯球算法[76],可用于求d-分离及其相关问题。

3.2.2 独立等价(Independence- Equivalence ,I-等价)

定义19 如果()()21K I K I =,那么χ上的两个结构图1K 和2K 是I-等价的[77]。χ上所有图的集合被划分为一系列相互排斥并且穷举的I-等价类,这是由I-等价关系诱导产生的等价类集合。

定义20 χ上BN 图G 的骨架是χ上的一个无向图,若G 包含一条有向边()Y X ,,那骨架包含一条无向边

{}Y X ,。

定义21 如果X 和Y 之间无有向边,那么v-结构X →Z ←Y 是一个不道德集。若存在这样一条边,它就叫做v-结构的覆盖边。

d-分离的概念用结构G 的细节来说明分布P 的独立性,该观点有一个重要的含义:不同的BN 结构可以完全等价,只要它们编码了相同的独立假设集。

两个图的I-等价表明,可根据其中一个图因式分解的任意分布P 也可根据另一个图因式分解得到。判断两个图是否I-等价的方法是:1G 和2G 为χ上的两个图,如果1G 和

2G 有相同的骨架和相同的v-结构集合,那么他们是I-等价

的。但反向不成立。引入不道德集的概念,可给出其反方向:1G 和2G 为χ上的两个图,只有在他们是I-等价时,1G 和

2G 有相同的骨架和相同的不道德集。

根据覆盖边的方向,可给出I-等价的另一种描述方法。当且仅当存在网络图序列G G G G k ′==,,1K ,并且序列中每一个图都I-等价于G ,

使得i G 和1+i G 的唯一差别是覆盖边的反向,那么说两个图G 和G ′是I-等价的。 3.3 由分布集P 来构造结构图G

希望构造能反映概率分布P 中独立性的图G ,并通过

检测G 中的d-分离性从而检测P 的独立性。即在某一程度上构建一个网络结构图G ,使G 的独立集是P 的独立集的一个合理替代。但是,以下的讨论并不会给出分布P 的充分说明以及构造图G 的实际过程,只是从概念上理解其构造过程。构造过程依赖于两个重要概念:最小I-映射和完美映射(Perfect map ,P-映射)。 3.3.1 最小I-映射

定义22 如果图K 是独立集I 的一个I-映射,并且移动K 中的任一条边都会使它不再是I-映射,那么K 是I 的最小I-映射。

构造表示分布P 的图G 的一个方法是,构造分布P 的任意一个最小I-映射的图G 。怎样获得分布P 独立集的最小I-映射?假设已知某一变量序列{}n X X ,,1K ,依次检测每

个变量i X ,n i ,,1K =。对每个i X ,选择{}n X X ,,1K 中的某个最小子集U 作为i X 在G 中的父节点集,要求U 满足{}()U U |,,11?⊥?i i X X X K ,

并且从U 中任意去掉一个节点后将不再满足该性质。那么令U 为的i X 的父节点集。

U 的选择并不唯一。但是,如果分布为正,即对所有变量χ的任意取值x 有()0>x P ,那么给定变量序列时父节点集的选择是唯一的。

然而,G 是P 的最小I-映射时,并不能保证G 确实包含了P 的独立性结构,因而引出P-映射概念。 3.3.2 P-映射

定义23 若()I K I =,那么说图K 是独立集I 的一个P-映射。若()()P I K I =,那么K 是P 的一个P-映射。 当G 是P 的最小I-映射时,并不能保证G 可以发现P 的所有独立性,而我们的目的是找出能精确发现分布P 独立性的结构G ,所以引入完美映射的概念。如果图G 是分布P 的P-映射,那么可以从G 中直接读出P 的所有独立性。

Pearl 和Verma 以I-等价类的形式提出构建分布P-映射的第一个算法[78]。该算法后来得到发展和补充[79]。由于分布P 可以有多个I-等价的P-映射,所以算法需要返回整个等价类。前面说到,两个图有相同骨架和相同不道德集,那这两个图I-等价。所以通过从已知分布P 的独立性中辨识P-映射*G 的骨架和不道德集,就可以为P-映射*G 构建I-等价类。

3.4 条件贝叶斯网络

定义24 已知X 时Y 上的条件贝叶斯网络B 定义为一个有向无环图,其节点为Z Y X U U ,其中X 、Y 和Z 互不相交。X 中的变量称为输入变量,Y 中的变量称为输出变量,而Z 中的变量称为压缩变量。图G 中,X 中的变量没有父节点。Z Y U 中的变量具有CPD 。利用链式法则,该网络定义一个条件概率分布:

()()∏∈=

Z

Y X Z Y U X X B F X P P ||, (23)

分布()X Y |B P 定义为()X Z Y |,B P 的边缘分布:

()()∑=Z

X Z Y X Y |,|B B P P (24)

定义25 令Y 为有k 个父节点k X X ,,1L 的随机变量。

如果CPD ()k X X Y P ,,|1L 表示为已知k X X ,,1L 时Y 上的

条件贝叶斯网络,那么它就是一个压缩CPD 。

条件BN 只是一个BN 片段,并不是完整的BN 。该片段没有说明片段中所有变量的联合概率分布,只说明了某个变量的CPD 。因此,条件BN 可以用来说明节点上的CPD ,可以作为第2节所描述的局部概率模型的表示[80]。

条件BN 的一个重要应用是定义压缩CPD 。压缩表示不仅可以使模型简化,更容易理解,而且描述一个由低级子系统组成的复杂系统时,只需为每个子系统单独地建模,而不用考虑其低级成分的内部模型。 3.5 高斯模型的贝叶斯网络

定义26 定义高斯模型的贝叶斯网络为,全部变量是连续的、全部CPD 是线性高斯模型的贝叶斯网络。

高斯模型情况下的BN 中[81],G 为线性高斯模型网络,P 为联合多元高斯分布。先介绍多元高斯模型及其特性,然后说明线性高斯模型网络和联合多元高斯分布之间的等价性。

3.5.1 基本参数化

n X X ,,1K 组成的多元高斯分布是一个具有n 维均值

向量μ和对称的n n ×维协方差阵∑的概率分布,其密度函数定义为

计算机科学 2014年10期

()()()()??

?????∑??∑

=?μμπx x x p T n 1

2

122

1exp 21 (25) 其中∑是∑的行列式。矩阵∑是正定的:对任意n

R x ∈且

0≠x ,有0≥∑x x T 。正定矩阵∑能保证是非奇异的,因

此它有非零行列式值。

因为正定矩阵是可逆的,可以根据协方差阵的逆矩阵

1?∑=J 来定义高斯模型,该逆阵叫做信息阵。该表示方法

引出高斯密度的另一种形式。由于

()()()()[]

μμμμμμμJ J x Jx x x J x x x T T T T T +??=???=?∑???22

1

2121

1 (26) 最后一项为常数,所以得到:

()()??

?

???+?∝x J Jx x x p T T μ21exp (27)

该高斯密度的公式一般称为信息形式,向量μJ h =叫做势

能向量。由于当且仅当1?∑是正定时∑是正定的,所以当且仅当信息阵是对称正定时,信息形式才定义一个有效的高斯密度。

3.5.2 高斯模型的运算

对分布的操作主要有两种运算:计算变量集Y 某个子集的边缘分布,以及计算已知z Z =的某个取值时的条件分布。

(1)边缘分布的计算采用协方差形式,只需要计算两两协方差。若{}Y X ,的联合分布的均值和协方差作如下分解:

()???

?

??????????∑∑∑∑????????=YY YX XY XX

Y X N Y X p ;,μμ (28) 其中n X R ∈μ,m

Y R ∈μ,XX ∑是n n ×维矩阵,XY ∑是

m n ×维矩阵,T XY YX ∑=∑是n m ×维矩阵,YY ∑是m m ×维矩阵。那么Y 的边缘分布是正态分布()YY Y N ∑;μ。

(2)条件分布计算采用信息形式,只需要对协方差阵求逆。把z Z =的值代入信息形式中,该过程把某些二次项转换成线性项或者常数项,并把某些线性项转换成常数项。 3.5.3 高斯模型的独立性

对多元高斯模型来说,从分布的参数中可直接得到其独立性。令n X X X ,,1K =服从联合正态分布()∑;μN ,那

么当且仅当0,=∑j i 时,i X 与j X 独立。

考虑高斯分布()()∑=;,,1μN X X p n K ,并令

1?∑=J 为信息阵。那么,当且仅当{}()

j i j i X X X X p ,||?⊥=χ时0,=j i J 。信息阵发现了已

知其它所有变量时两个变量间的独立性。

3.5.4 线性高斯模型网络和联合多元高斯分布之间的等价性

(1)线性高斯模型网络总是能定义联合多元高斯分布 令父节点为k X X ,,1K 的变量Y 的线性高斯模型为:()(

)2

0;|σ

ββx x T

N Y p +=。假设k

X

X ,,1

K 具有联合高

斯分布,其分布为()∑;μN 。那么:

(a)Y 的分布是正态分布()()

2

;Y Y N Y p σμ=,其中μββμT Y +=0,ββσσ∑+=T Y 22

;

(b){}Y X ,上的联合分布是正态分布,其中[]∑=∑=k

j j i j i Y X Cov 1

,;β。

因此,如果B 是线性高斯模型的贝叶斯网络,那么它具有联合高斯模型分布。

(2)由多元高斯分布能构造线性高斯模型网络

令{}n X X ,,1K =χ,并令p 为χ的联合高斯分布。给定χ上n X X ,,1K 的任意序列,可以构建一个贝叶斯网络图G 和一个G 上的贝叶斯网络B ,使得:

(a){}11,,??i X X X F i

K ;

(b)B 中i X 的CPD 是其父节点的线性高斯模型; (c)G 是p 的最小I-映射。 3.6 贝叶斯网络的指数分布族

贝叶斯网络中,如果所有CPD 都来自一个指数分布族,

那么这些CPD 的乘积也是在该指数分布族中。因此,带有指数CPD 的贝叶斯网络定义了一个指数分布族。但是,要想得到贝叶斯网络的指数分布族表示,需要保证每个CPD 都是局部归一化的。对指数CPD 来说,把τ的维数扩大常数维就可以实现,那么()θt 中相匹配的元素就能作为划分函数的对数。

一般来说,虽然带有适当CPD 的贝叶斯网络定义了一个指数分布族,但是该分布族一般不是线性分布族。特别地,任意包含不道德集的网络都不能产生一个线性指数分布族。

4 马尔可夫网络

在为实际现象建模时,有许多现象变量之间的相互影

响关系是没有方向性的,因此,无向图模型能更好地表示这类现象的概率模型。

与BN 一样,MN 也由两部分构成:网络结构图H 和因子集Φ。

(1)MN 的结构图H 是无向图,其节点表示随机变量,其无向边表示相邻变量间的直接概率相互作用。若H 的子图中任意两个节点都有边相连,那么称该子图为完全子图(complete subgraph)。完全子图的变量集叫做团(clique)。

(2)MN 的因子集()(){}K K D D φφ,,11K =Φ,也叫做势函数集(potential function)。因子并没有像CPD 那样对应于

条件概率,而是表示变量间的相互作用。下面只讨论非负实因子。

由于因子并不对应于条件概率,所以MN 的参数化表示并不像BN 的那样直观。需要把MN 与吉布斯分布联系起来,建立起吉布斯分布与因子乘积的等价关系,那么MN 的联合概率分布可分解为因子的乘积。利用因子图和对数线性模型,MN 可进行更高细粒度的参数化。MN 中包含三种独立性[33]:全局独立、两两独立和局部独立。通过分析其独立性,可以使MN 的联合概率分布表示更加简洁。本节最后还会介绍高斯模型的马尔科夫随机场和MN 的指数分布族表示形式。 4.1 参数化

4.1.1 吉布斯分布和马尔可夫网络

Hammersley 和Clifford 首次发现马尔可夫随机场和吉布斯分布之间的联系:一个随机场是关于邻域系统的马尔可夫随机场,当且仅当该随机场是关于邻域系统的吉布斯分布。这个等价条件解决了MN 的参数化问题,建立起吉布斯分布与因子乘积的等价关系。下面先介绍因子的概念以及

因子的运算,再利用因子来定义吉布斯分布的参数化过程,并与图H 联系起来。

(1)因子

定义27 令D 为随机变量集合,定义因子φ为从

()D R 到R 的函数。如果因子所有的输入是非负的,那么这个因子也是非负的。变量集合D 叫做因子的定义域,表示为[]φD 。

定义28 令X 、Y 、Z 为互不相交的变量集,并令()Y X ,1φ和()Z Y ,2φ为两个因子。定义因子乘积21φφ×也

为一个因子()R R a Z Y X ,,:ψ,如下表示

()()()Z Y Y X Z Y X ,,,,21φφψ×= (29)

由定义27可知,联合概率分布和CPD 也是因子。然而,CPD 和联合概率分布必须满足归一化约束,即分布中数值之和必须为1。

根据定义28给出的因子乘积的概念,下面可以定义吉布斯分布的无向参数化,即把吉布斯分布分解为因子的乘积。

(2)吉布斯分布的参数化以及与图H 的关系

定义29 分布ΦP 是由因子集

()(){}K K D D φφ,,11K =Φ来参数化的吉布斯分布,其定义

如下

()()n n X X P Z

X X P ,,~

1,,11K K ΦΦ=

(30) 其中()()()()m m n X X P D D D φφφ×××=ΦL K 22111,,~

是非

归一化测度值,而()∑Φ=n

X X n X X P Z ,,11,,~

K K 是一个归一化

常量,叫做划分函数。

定义30 如果每个()K k k ,,1K =D 都是H 的完全子图,那么说分布ΦP 根据马尔可夫网络H 分解,其中

()(){}K K D D φφ,,11K =Φ。

由于参数化过程把因子与完全子图的团联系起来,马尔可夫网络参数化的因子通常也叫做团势。因为每个完全子图都是某个团的一个子集,所以只考虑最大团的因子可以减少参数化中的因子个数。

因此,MN 的联合概率分布是一个吉布斯分布,其参数化可表示为

()()∏==m

k k k n Z X X P 1

11,,D φK (31)

其中,m 为H 中团的个数,k φ为第k 个团的因子,k D 为第k 个团的所有随机变量,()∑∏==n X X m

k k k Z K 11

D φ为划分函

数。

4.1.2 高细粒度参数化

(1)因子图

定义31 因子图[82]F 是包含两类节点的无向图:变量节点(用椭圆形表示)和因子节点(用正方形表示)。该图只包含变量节点和因子节点之间的边。因子图F 通过因子集来参数化,每个因子节点V 与一个因子φ有关,φ的定义域是图中V 的邻节点变量集。如果分布P 能够表示为这种形式的因子集,那么说P 在F 上分解。

马尔可夫网络结构一般没有发现吉布斯参数化的所有结构,不能从图结构中看出参数化中的因子是否包含最大团或其子集。而因子图能使网络中的因子结构更加明确[83]。例如,如图5所示,从因子图中可直接看到因子与团的关系。

(a) (b) (c) 图 5 相同马尔可夫网络的不同因子图

(a)团A 、B 、C 上的马尔可夫网络完全子图;(b)三个变量上只有一个因子的因子图;(c)两两变量上都有因子的因子图。

(2)对数线性模型

定义32 令D 为变量子集。定义特征()D f 为从D 到R 的函数。

定义33 如果分布P 与下面两个集合有关

(a)特征集()(){}k k f f D D F ,,11K =,其中每个i D 是H 的完全子图;

(b)权值集k ωω,,1K ; 使得

()()??

?????=∑=k i i i i n f Z X X P 11exp 1

,D ωK (32)

那么说P 是马尔可夫网络图H 上的对数线性模型。

把因子变换到对数空间中有()()()D D εφ?=exp ,其中()()D D φεln ?=称为能量函数。特征与能量函数有关,是一个没有非负要求的因子。利用特征集和权值集可以给出分布P 的对数线性模型。当变量值域较大时,对数线性模型可以为分布提供更加简洁的表示。

现在,马尔可夫网络的参数化有三种表示:因子乘积、因子图、对数线性模型。对数线性模型比因子图具有更高细粒度的表示,而因子图比因子乘积具有更高细粒度的表示能力。因子图适用于学习推理,而对数线性模型适用于模型参数化。

4.1.3 过参数化

在使用细粒度因子图或对数线性模型表示时,马尔可夫网络的参数化一般都是过参数化的。也就是说,对任意给定的分布,模型中存在多种参数选择方式来描述概率分布。例如,图中有两个团{}B A ,和{}C B ,。能量函数()B A ,1ε不仅包含A 和B 之间相互作用的信息,而且还包含单个变量A 和B 的分布信息。相同地,()C B ,2ε也给出了单个变量B 和C 的分布信息。与B 有关的信息可以放在任意一个团中,或者B 的作用可以用某种方式分离在两个团中,从而导致在说明同一个分布时有多种不同的方法。解决过参数化的方法有两种:正规参数化和消除冗余。

(1)正规参数化

正规参数化能很自然地避免吉布斯分布P 的参数化中的含糊不清,它要求分布P 为正。H 上吉布斯分布的正规参数化是通过所有非空团上的能量函数集来定义的。

先给出一些符号定义。()

*

*1*,,n x x K =ξ是χ的特定取

值,这种取值可任意选取。对于任意变量集Z 和包含Z 的

χ的某个子集的任意赋值x 来说,定义赋值Z x 为Z x ,

也就是Z 中变量的取值与x 中该变量的取值一致。相反地,

定义*Z ?ξ为Z ?χξ*

,

也就是*ξ中的值为Z 外变量的取值。现在构造一个赋值()

*,Z Z x ?ξ。那么团D 的正规能量函

计算机科学 2014年10期

数为()()(

)

∑

????=

D

Z Z

Z Z D D

d d **,ln 1ξεP 。 所以正吉布斯分布P 的正规参数化表示为

()()??

?

????=∑i i i

P D D ξεξ*exp (33) (2)消除冗余

由于对数线性模型参数化表示有足够的细粒度,从而可以消除冗余而又不会损失表达能力,下面使用对数线性模型参数化表示。检测和消除冗余的方法来自于线性代数。令k f f ,,1K 为具有权值{}k ωωω,,1K =的特征集,这样形成分布P 的对数线性表示。如果存在系数k ααα,,,10K 使得

对所有ξ有()0

0=+

∑i

i i f ξαα,那么具有权值

{}k k αωαωω++=′,,11K 的对数线性模型同样能表示P 。

因此,线性相关的特征集是冗余的。非冗余的特征集中的特征是非线性相关的。只有当特征集是非冗余时,每个权值集描述一个唯一的分布。也就是说,当k f f ,,1K 为非冗余特征集时,并令k R ∈′ωω,,若ωω′≠,有ωω′≠P P 。 4.2 独立性

马尔科夫网络中的独立性有全局独立、两两独立和局部独立三种。根据马尔科夫网络的独立性,可以由分布P 构造网络图H 。 4.2.1 全局独立假设

定义34 令H 为一个马尔可夫网络结构图,并令k X X X ???K 21为H 中的一条路径。令χ?Z 为观测变量集。如果任意i X 都不包含于Z 中,k i ,,1K =,那么路径k X X X ???K 21在已知Z 时是活动的。

定义35 如果已知Z 时,在任意节点X ∈X 和Y ∈Y 之间没有活动路径,那么说已知Z 时X 和Y 是分离的,表示为()Z Y X |;H s 。定义与H 有关的全局独立集为:

()()(){}Z Y X Z Y X |;:|H s H I ⊥= (34)

(1)分离的健全性

任意根据H 分解的分布都满足分离隐含的全局独立性。令P 为χ上的一个分布,H 为χ上的一个MN 结构。如果P 是根据H 分解的一个吉布斯分布,那么H 是P 的一个I-映射。但其反方向只适用于P 为正分布的情况,即对变量集χ的任意取值x 都有()0>x P 的情况。也就是说,令P 为χ上的正分布,H 为χ上的马尔可夫网络图,如果H 是P 的I-映射,那么P 是根据H 分解的吉布斯分布。

(2)分离的完备性

如果H 中X 和Y 在给定Z 时不是分离的,那么给定Z 时在某个根据H 分解的分布P 中X 和Y 是依赖的。利用测度论可以得到,对于几乎所有在H 上分解的分布P 来说,也就是对于所有除因子参数化空间中的测度为零点集之外的所有分布来说,有()()H I P I =。 4.2.2 局部马尔可夫假设

定义36 令H 为MN ,定义与H 有关的两两独立集(pairwise independencies)为:

(){}(){}H Y X Y X Y X H I p ???⊥=:,χ (35)

定义37 对给定图H ,H 中X 的马尔可夫毯(Markov

blanket)为H 中X 的邻点,表示为()X MB H 。定义与H 有关的局部独立集(local independencies)为:

(){}()()(){}

χχ∈??⊥=X X MB X M X X H I H H :l (36) 在很多情况下,局部马尔可夫独立假设也是很有价值的。它关注于分布的较小独立性集合,并能有效简化分布P 寻找I-映射的过程。

两两独立集的定义较为直观,当给定图中所有其它结点时,X 与Y 是独立的。

局部独立集的定义是间接定义,在给定直接邻点时X 与图中其它的结点独立。

此时,已经给出三种独立假设集合:全局独立集()H I 、两两独立集()H I P 和局部独立集()H I l 。对于一般分布来说,()H I P 严格弱于()H I l ,而()H I l 也严格弱于()H I 。

但是,对于正分布来说,三种独立假设是等价的。 4.2.3 由分布P 构建网络结构图H

定义38 若U ?X 并且U 是节点的最小集合,使得{}()()P I X X ∈??⊥U U |χ,那么集合U 是分布P 中X 的马尔可夫毯。

有了结构图H 和分布P 的独立性关系后,如何构造分布P 的最小I-映射?前面提到的局部马尔可夫假设为构建最小I-映射提供了两种方法:一种是基于两两马尔可夫独立,另一种是基于局部独立。

第一种方法,如果X 和Y 是两两独立的,即给定所有其他结点时X 和Y 是独立的,那么在X 和Y 之间引入一条边{}Y X ,,所得到的马尔可夫网络图H 是P 的唯一最小I-映射。

第二种方法,令P 为正分布。对每一个节点X ,令()X MB P 为满足定义38的最小节点集U 。通过对所有X 和所有()X MB Y P ∈引入一条边{}Y X ,来定义图H ,那么马尔可夫网络H 是P 的唯一最小I-映射。

4.3 高斯模型马尔可夫随机场(Gaussian Markov Random

Field ,GMRF)

定义39 如果对所有j i ≠,有0,,,≥?

j

j i i j i J J J ,则

由信息阵1?Σ=J 参数化的二次MRF 是吸引的(attractive)。如果对所有i ,有

∑≠ j i i j i J J ,,,则MRF 是对角占优的。 定义40 二次MRF 的参数化如下 ()2 210i i i i i i i x d x d d x ++=ε (37) ()2 ,202 ,02,11,10,01,00,,j j i i j i j i j i j j i i j i j i j i j i x a x a x x a x a x a a x x +++++=ε (38) 若对所有i ,有02>i d ;并对所有j i ,,22×矩阵? ???????j i j i j i j i a a a a ,20,11 ,11,0222是半正定的,那么称二次MRF 为两两归一化的。 高斯模型马尔可夫随机场[84-85],是通过无向图模型来表示多元高斯分布。首先说明高斯分布如何表示MRF ,然后说明MRF 如何定义高斯分布,并给出两个检验条件判断MRF 是否能有效定义高斯分布。 (1)高斯分布如何表示为MRF 高斯分布表示MRF ,可以直接从高斯模型的信息形式中推导出来。由3.5节知道,高斯模型的信息形式的参数化使用协方差的逆阵,即信息阵1?Σ=J ,概率密度的信息形 式为 ()()?? ? ???+?∝x J Jx x x p T T μ21exp (39) 把信息形式分解为两类:一类包含单变量i X ,另一类包含变量i X 、j X 的组合。只包含单变量i X 的项为 i i i i i x x J h +? 2,2 1 (40) 包含i X 、j X 组合对的项为: [] j i j i i j i j j i j i x x J x x J x x J ,,,2 1 ?=+? (41) 信息形式直接引出一个两两关系马尔可夫网络,其节点势能来自于势能向量和信息阵的对角元素,其边势能来自于信息阵的非对角元素。因此,任意高斯分布可表示为带有二次节点和边势能的两两关系马尔可夫网络。该马尔可夫网络一般称为高斯模型马尔可夫随机场(GMRF)。 (2)MRF 如何定义高斯分布 考虑任意带有二次节点和边势能的两两关系马尔可夫网络。忽略常数因子,常数因子可被合并到划分函数中去,这样就可以写出节点和边的能量函数: ()2 210i i i i i i i x d x d d x ++=ε (42) ()2 ,202,02,11,10,01,00,,j j i i j i j i j i j j i i j i j i j i j i x a x a x x a x a x a a x x +++++= ε (43) 通过合并,可以用对数二次形式重新表示这样的势能集合: ()?? ????+?=′x Jx x x p T T h 21 exp (44) 其中不失一般性地假设J 是对称的。当且仅当J 是正定阵 时,该马尔可夫网络定义一个有效高斯分布。 然而,与高斯模型的贝叶斯网络的情况不一样,不是每个二次节点和边势能的集合都引出一个合法的高斯分布。要检验MRF 是否有效,需要产生完整的信息阵,并检验它是否正定。首先介绍两个简单检验。 第一个检验是,令p ′为二次两两关系MRF ,若J 是吸引的,那么p ′定义一个有效高斯模型MRF ;若J 是对角占优的,那么p ′定义一个有效高斯模型MRF 。 第二个检验是,令p ′为二次两两关系MRF ,如果p ′是两两归一化的,那么它定义一个有效高斯分布。 4.4 马尔可夫网络的指数分布族 定义41 非归一化指数因子分布族Φ由τ、t 、A 和 O 定义,该分布族中的一个因子为 ()()()(){}ξτθξξφθ,exp t A =。 定义42 令k ΦΦ,,1K 为指数因子分布族,其中每个 i Φ由i τ、i t 、i A 和i O 定义。k ΦΦ,,1K 的组合为分布族k Φ××Φ×ΦL 21, 它 是 由 k k O O O ×××∈=L o L o o 2121θθθθ来参数化的,定义如 下 ()()()()()?? ? ?????? ?????Λ=∝∑∏∏i i i i i i i t P i ξτθξξφξθθ,exp (45) 其中i θφ是第i 个因子分布族中的一个因子。 在MN 的对数线性模型中,有如下形式的分布 ()()?? ?????= ∑=k i i i i n f Z X X P 11exp 1 ,D ωK (46) 这样的分布显然是一个线性指数分布族,其充分统计量函数是特征函数的向量()()()k k d f d f ,,11K =ξτ。通过选择合适的特征函数,可以设计一个对数线性模型来表示已知的离散马尔可夫网络结构。这足以说明离散马尔可夫网络是线性指数分布族。 在乘积形式的分布中,各项的乘积形式对应于指数分布族的一个简单组合。由定义42看出,指数因子的乘积是带有()()()()ξτξτξτξτk o L o o 21=和自然参数 ()()()()k k t t t t θθθθo L o o 2211=的指数分布族。这说明,如 果马尔可夫网络中的势能有指数表示形式,那么势能的乘积 也是一个指数分布族。而且,线性指数因子分布族的乘积还是一个线性指数分布族。 5 局部有向模型 本节介绍两种局部有向模型:条件随机场和链图。 5.1 条件随机场 定义43 条件随机场是节点对应于Y X U 的无向图H ;参数模型为因子集()()m m D D φφ,,11K ,变量集X D ?i 。网络编码的条件分布如下: ()() ()X Y X X Y ,~ 1|P Z P = (47) ()()∏==m i i i P 1 ,~ D X Y φ (48) ()()∑=Y X Y X ,~ P Z (49) 只要H 中的两个变量共同出现在某个因子的值域中,那他们由一条无向边连接。 CRF 是一个无向图,其参数化方式与马尔可夫网络的参数化一样,但是CRF 可以编码条件概率分布()X Y |P ,这里Y 是目标变量集,X 是观测变量的不相交集。CRF 的定义与马尔可夫网络的定义的唯一区别是划分函数()X Z 中使用了不同的归一化,当X 取不同值x 时其划分函数的值也不相同。 CRF 表示的一个主要优点是避免编码X 中变量的分布,这样就可以将大量相当复杂或难以理解的观测变量独立性集融入到模型中。CRF 同样可以包含没有简单参数形式的连续变量分布。所以可以使用领域知识来定义一个丰富特征集合,而不用考虑联合概率分布的建模。 Lafferty 等人首次提出CRF 的表示框架[86],随后CRF 在许多领域中得到广泛应用,如自然语言处理、计算机视觉 等。后来Sutton 和McCallum 又引入跳跃链CRF [87] ,而Sutton 等人引入因子CRF [88] 。 5.2 链图 链图[89]建立于CRF 表达之上, 并可以处理局部有向模型的独立假设。在局部有向无环图(Partially Directed Acyclic Graph ,PDAG)中,节点可以不相交地划分为多个链单元。在同一个链单元中两个节点间的边一定是无向的,而不同链单元中两个节点间的边一定是有向的。因此,PDAG 也称为链图。下面讨论链图的分解和独立假设。 5.2.1 链图的因式分解 定义44 令K 为一个PDAG ,l K K K ,,1为其链单元。定义i F K 为i K 中节点的父节点。K 的道德图是一个无向图 []K M ,首先把任意节点对l K ,,1,,=∈i F Y X i K 用无向 计算机科学 2014年10期 边连接起来,然后把所有有向边转换为无向边,就可以产生 []K M 。 定义45 令K 为一个PDAG ,l K K K ,,1 为其链单元。 链图分布是通过因子集()()m i i i ,,1K =D φ来定义的,每个 i D 是道德图[]K M 中的一个完全子图。将每个因子() i i D φ与一个链单元j K 联系起来,使得i F i i K K D U ?,并且定义() i F P i K K |为含有这些因子的CRF ,i i K Y =, i F i K X =。现在定义 ()() ∏==l 1 |i i i F P P K K χ (50) PDAG K 的结构可用来因式分解联合概率分布,把联合概率分布作为已知父节点时每个链单元的乘积。链图模型中的每个链单元i K 都与一个定义() i F P i K K |的CRF 有关。 如果分布P 能表示为K 上的链图分布,那么说分布P 根据K 来因式分解。 5.2.2 链图中的独立 定义46 令K 为PDAG ,定义与K 有关的两两独立集为: (){}()(){}X X P ND Y Y X Y X ND Y X K I ∈?⊥=,,:,|不相交 (51) 定义47 令K 为PDAG ,定义与K 有关的局部独立集为: ()(){}χ∈?⊥=X B B ND X K I X X X :|l (52) 定义48 令χ?Z Y X ,,为三个不相交集合,并令 Z Y X U U =U 。如果在无向图[][] Z Y X U U +K M 中已知Z 时X 与Y 是分离的,那么说已知Z 时X 与Y 是c-分离 的。 定义49 令K 为PDAG ,定义与K 有关的全局独立为: ()()} , ,,:|{分离的是与时已知??⊥=c K I Y X Z Z Y X Z Y X χ (53) 在PDAG 中,X 的父节点集和X 的邻节点集的并集是X 的边界节点集,表示为X B 。定义46泛化了无向图的两两独立:在无向图中,节点没有子节点,所以χ=X C 。类似地,不难说明这些独立同样存在于有向图中。定义47泛化了有向和无向图的局部独立。对于有向图而言,X C 是非子节点集,而X B 是父节点集。对于无向图而言,X C 是χ,而X X N B =。c-分离[90]的概念泛化了无向图的分离概念以及有向图的d-分离概念。 对于非正分布来说,这三个独立假设并不等价。全局独立隐含局部独立,而局部独立隐含两两独立。但是对于正分布来说,这三种定义等价。 6 基于模板的表示 无论是贝叶斯网络还是马尔可夫网络,都是用来表示某个固定随机变量集χ的联合概率分布。由于这类表示方法的侧重点是随机变量集,所以称此类模型为基于变量的模型。然而,在许多领域中,概率模型要应用于更加复杂的空间,而不能把模型编码为某个固定的变量集。基于模板的表示主要应用于两个场景。第一个是暂态建模,用动态贝叶斯网络语言构造一个描述系统动态属性的单个紧凑模型,在不同时间轨迹上产生不同分布。第二个应用场景是为具有相互关联关系的多个对象建模。 首先描述基于模板表示的基本框架,主要有三个重要概念:模板属性、实例化和模板因子。 (1)模板属性(Template Attributes) 定义50 属性A 为函数()k U U A ,,1K ,值域为集合()A R ,参数i U 为与特定类[]i U Q 相关联的类型逻辑变量。元组k U U ,,1K 称为属性A 的参数特征,表示为()A α。 模板在模型中被多次实例化,它可以对具有相同值域和同一语义的多个随机变量模型进行编码。模板属性可以是单个对象的性质,也可能是整个对象元组的性质。一般把对象分为满足φ=j i Q Q I 和 U i i Q Q =的类。 (2)实例化(Instantiations) 定义51 令Q 为类集合,N 为Q 上的模板属性集合。对每个Q ∈Q 对象骨架K 为一个固定的有限对象集合 []Q O K 。定义 [][][][][]k K K k K U Q O U Q O U U O ××=L K 11,, (54) 缺省时[]()[]A O A K K α=Γ为A 的参数特征中逻辑变量可能取值的集合。对象骨架也确定了合法赋值 []()[]A O A K K α?Γ的子集。 定义52 令K 为Q 、N 上的对象骨架。定义底层随 机变量集为 []()[]{}A A A K K Γ∈=γγχ: (55) [][]U A N K N A K χχ∈= (56) 给定模板属性集合,可以把其实例化来产生同一类型 多个随机变量的概率空间。 (3)模板因子 定义53 模板因子是定义在模板属性元组l K A A ,,1上的函数ξ, j A 的值域为()A R 。它定义了从 ()()l L A R A R ××1到R 的一个映射。给定随机变量元组l K X X ,,1,使得对所有l K ,,1=j 有()() j j A R X R =。定 义()l K X X ,,1ξ为从X 到R 的实例化因子。 本节介绍的暂态模型有动态贝叶斯网络和状态观测模型,其中动态观测模型又包括隐马尔可夫模型和线性动态系统。HMM 与DBN 有着密切关系,也可以用HMM 来表示DBN 。对象关系领域的概率模型可以表示多个对象间的复杂相互作用,它的有向图表示包括盘模型和概率关系模型,它也可以使用无向图来表示。对象关系领域的概率模型还可以编码结构不确定性。结构不确定性主要有两种类型:关系不确定性,为对象间相关关系不确定的分布建模;对象不确定性,为领域中实际对象的存在不确定或数量不确定的分布 建模[91] 。但本文不对结构不确定性的建模进行展开讨论。 6.1 暂态模型 暂态模型用于动态场景建模,系统状态随着时间的变化而改变。假定系统状态表示为某个随机变量集χ的值。 用()t i X 表示变量i X 在时刻t 的实例化,i X 不再是取某个值的变量,而是模板变量,模板变量在时间t 内的不同时刻上实例化。()t i X 是值域为()i X R 的变量。对于变量集 χ?X ,用()()21:21t t t t } 2 1,:t t t t ∈X 。用符号()t t ′:x 表示该变量集的一个取值。 以下给出三个简化假设,使模型表示问题更易于处理。 假设1 离散假设。把时间轴离散为时间段:系统状态的测量值由预先设定的等间隔时间粒度Δ采集。这样就 把随机变量集限制为()()L ,,10χχ ,其中()t χ是表示时刻 Δ?t 的系统状态的底层随机变量。 假设2 马尔可夫假设。如果对所有0≥t ,有()()()( ) t t t χχχ|1:01?+⊥,那么模板变量χ的动态系统满足 马尔可夫假设。这样的系统称为马尔可夫系统。概率分布可以简化为 ()( ) ()()() ()()()∏∏?=+?=+==1 11 :01:0||T t t t T t t t T P P P χχχχχ (57) 假设3 平稳假设。如果对所有t ,()()()t t P χχ|1 +都是 相同的,那么说马尔可夫动态系统是平稳的。这样可以使用转换模型()χχ|′P 来表示过程,所以对任意0≥t ,有 ()()( ) ()ξχξχξχξχ=′=′==′=+||1P P t t (58) 6.1.1 动态贝叶斯网络(Dynamic Bayesian Network ,DBN) 定义54 χ的二时间段贝叶斯网络(2-time-slice Bayesian Network ,2-TBN)是已知I χ时χ′上的条件贝叶斯网络,其中χχ∈I 是接口变量集,接口变量I χ在时刻t 的值对时刻t+1的变量有直接影响。 定义55 动态贝叶斯网络[7,44]是→B B ,0的组合,其 中0B 是()0χ的贝叶斯网络, 表示状态的初始分布,而→B 是随机过程的2-TBN 。对任意时间跨度0≥T ,()T :0χ 的分布 定义为展开的贝叶斯网络,其中,对任意n i ,,1L =,有: (a)()0i X 的结构和CPD 与0B 中i X 的结构和CPD 一 样; (b)对0>t ,()t i X 的结构和CPD 与→B 中i X ′的结构和CPD 一样。 在条件贝叶斯网络中,只有变量χ′有父节点或CPD 。接口变量I χ在时刻t 的值对时刻t+1的变量有直接影响。因此,只有I χ中的变量才能成为χ′中变量的父节点。如图6,1X 、2X 、3X 和4X 是接口变量。2-TBN 表示条件概率分布 ()()() ∏=′′=′=′n i X I I i Pa X P P P 1 |||χχχχ (59) 对每个模板变量i X 来说,CPD () i X i F X P ′′|是一个模板因子:由于存在多个变量()t i X ,该模板因子将在模型中多次被实例化。 根据前面的假设,只需要表示初始状态分布和转换模型()χχ|′P ,就可以在无限轨线上表示概率分布。转换模型是用2-TBN 表示的CPD 。 由HMM 构建的DBN 有两类[50]:因式化HMM [92]和耦合HMM [93],如图7所示。因式化HMM 的2-TBN 结构为链i i X X ′→(n i ,,1L =)的集合,并带有一个为所有变量i X ′子节点的观测变量Y 。 耦合HMM 也是由链i i X X ′→的集合构成,但是每条链都是一个带有观测变量i Y 的HMM 。这些链通过状态变量直接相互作用,每条链都能作用于其相 邻链。 6.1.2 状态观测模型(State-Observation Model) 状态观测模型是另一种暂态模型。状态观测模型假定两个独立性假设成立:状态变量由马尔可夫方式产生,使得()()()()() t t t X X X |1:01?+⊥;以及已知时刻t 的状态变量时, 时刻t 的观测变量条件独立于整个状态序列:()()()()()() t t t t X X X O |,:11:0∞+?⊥。因此,状态观测模型由两部分组成:转换模型()X X P |′和观测模型()X O P |。 状态观测模型包含两类:隐马尔可夫模型和线性动态系统。 (1)隐马尔可夫模型(Hidden Markov Model ,HMM) HMM [43,94]是比较简单的状态观测模型,如前面所说,它也可作为DBN 的特殊情况。HMM 的转换模型()S S P |′可用有向带环图来编码,节点表示系统的不同状态,即()S R 中的值。如果从s 到s ′的转换有可能,那么从s 到s ′之间有一条有向弧,即()0|>′s s P 。从s 到s ′的边标注了转换概率()s s P |′。 HMM 的转换图与编码图模型的图,在本质上是不同的。转换图的节点是状态变量,或者是状态变量的可能值;有向边表示状态之间的可能转换,或者表示CPD 中概率为零的项。因此,离开节点的边权之和必须为1。注意到,这种基于图的表示方法没有编码HMM 的观测模型。在某些情况中,观测模型是确定性的,对每个s 都只存在一个观测变量o ,()1|=s o P 。此时,观测变量标注在与状态有关的节点上。 (2)线性动态系统(Linear Dynamical System ,LDS) LDS 表示带有高斯噪声的一个或多个随时间演化的实值变量的系统。这样的系统也叫卡尔曼滤波器。LDS 可视为所有变量为连续变量且变量依赖关系为线性高斯模型的DBN 。 LDS 表示为状态观测模型,其状态变量和观测变量都是随机向量,转换模型和观测模型都使用矩阵来编码,如下定义 ()()()()() Q AX N X X P t t t ;|11??= (60) ()()()()()R HX N X O P t t t ;|= (61) 其中A 是定义线性转换模型的n n ×矩阵,Q 是定义与系统 动态性有关的高斯噪声的m n ×矩阵,H 是定义线性观测模型的m n ×矩阵,R 是定义与观测变量有关的高斯噪声的m m ×矩阵。 开关线性动态系统(Switching Linear Dynamical System ,SLDS)[95]是既包含线性连续动态性也包含离散变量的系统。系统在离散模式之间进行开关切换。 计算机科学 2014年10期 (a) (b) (c) 图 6 (a)2-TBN→ B;(b)初始时间0网络;(c)三时间段展开的 DBN (a) (b) 图 7 两类HMM构建的DBN:(a)因式化HMM构建的DBN; (b)耦合HMM构建的DBN 6.2对象关系域的有向概率模型 对象关系域上有向概率模型,是基于模板表示的另一 个应用,包括盘模型和概率关系模型。 6.2.1盘模型 定义56 对于每个带有参数特征k U U, ,1K的模板属 性N A∈,盘模型[53] Plate M定义: (a)模板父节点集合()() {} l l K U B U B F A, ,1 1 =,使得对 每个()i i U B有{}k i U U U, ,1K ∈。变量i U是父节点i B的参 数特征。 (b)模板CPD()A F A P|。 定义57 盘模型Plate M和对象骨架K定义如下的底 层贝叶斯网络Plate M K B。令()k U U A, ,1K为N中的任意模板 属性,对任意赋值[]A u U u U K k k Γ ∈ =a K a, ,1 1 γ, 底层网络中存在变量)γA,()γA的父节点为()γB(所有 A F B∈),()γA的实例化CPD为()() ()γ γA Pa A P|。 盘模型是由Gilks等人提出,后来作为在模型内或模型 间共享参数的语言。盘模型中,对象类型称为盘。多个同类 对象共享相同的属性集和相同的概率模型,“盘”表示一摞 同类对象。模板属性嵌入在盘中,如果属性A嵌入在盘 k Q Q, ,1K的集合中,可把A视为与参数特征k U U, ,1K相 关,其中每个逻辑变量i U在盘(类)i Q的对象上取值。盘模 型允许多个盘以各种方式叠加在一起,如盘嵌套和盘相交。 当已知对象集时,实例化这些对象能诱导出一个底层 贝叶斯网络Plate M K B,该网络说明了[]N K χ上的联合分布。 但是盘模型有一个显著缺点,它约束()k U U A, ,1K只 依赖于形式为()k i i U U B, , 1 K的属性,其中 k i i U U, , 1 K是 k U U, ,1K的一个子元组。这个约束条件使我们不能编码对 象之间的概率依赖关系网络。 6.2.2概率关系模型(Probabilistic Relational Models,PRM) 盘模型的最大限制是对属性父节点的参数特征的约 束。下面对盘模型放松这种限制,Friedman等人提出了概率 关系模型[9-10,96-97]。首先引入或有依赖(Contingent Dependencies)模型[56]的概念,再描述在底层网络的CPD中 如何编码或有依赖,以及如何处理带环的问题。 (1)或有依赖模型 定义58 对模板属性A来说,定义或有依赖模型为一 个元组,由以下成分组成: (a)父节点参数特征()A F α,它是类型逻辑变量i U的一 个元组,使得()()A F A α α?。 (b)警卫谓词表达式Γ,它是根据参数特征()A F α上的 模板属性集ΓA F来定义的二值逻辑表达式。 (c)模板父节点集()() {} l l K U B U B F A, ,1 1 =,使得对每 个()i i U B有()A i F Uα ?。 定义59 概率关系模型PRM M和对象骨架K定义一 个如下描述的底层贝叶斯网络PRM M K B。令()k U U A, ,1K为 N中的任意模板属性。对任意[]A K Γ ∈ γ,底层网络存在 变量()γA。对任意A A F F B U Γ ∈和()()A F Aα α?的任意取 值γ′,变量()γA的父节点为实例化变量()γγ′, B。 或有依赖模型说明了特定依赖存在的上下文。 PRM PRM M对每个N A∈定义一个或有依赖模型和一个模 板CPD。PRM中的模板父节点定义为底层网络中父节点取 值的模板,这个模板对应于适当类型对象逻辑变量的特定赋 值。然而,父节点逻辑变量集不一定是子节点逻辑变量的子 集。由定义59可以看出,出现在警卫谓词表达式中的属性 也是底层变量的父节点。 (2)底层网络中的CPD 首先利用警卫谓词表达式结构,假设警卫谓词表达式 是基本关系结构的特征,并且事先固定好。通过定义关系骨 架Γ K,可以编码这个假设。Γ K定义了事先给定的某个事 件集(通常是对象间的关系集),并且Γ K不是概率模型的一 部分。当警卫谓词表达式中的属性值被说明为关系骨架的一 部分时,可以利用该信息去确定模型中的有限父节点集。使 用或有依赖可以利用由骨架确定的关系来产生更简化的模 型,并且明确使模型为无环的。 然而,警卫谓词表达式的使用不能完全处理PRM中 CPD参数化的定义问题。因为父节点的实例数量事先是不 知道的,并且可能是无限多个。因此需要定义一种机制来说 明模板水平上的父节点数量为变量的局部依赖模型。可以利用聚合CPD(Aggregator CPD)来实现,聚合CPD 使用聚合统计数或者变量父节点集合的和。它把同类父节点组合到一个CPD 中,把CPD 集合() {} l i Y Y X P i j i i ,,1:,,|,1,K K =组合到一个联合CPD ( ) l j l l j Y Y Y Y X P ,1,,11,1,,,,,,|1K K K 中。 (3)检查无环性 定义60 模板依赖模型PRM M 的模板依赖图,对每个 模板水平属性A 包含一个节点,无论A A F F U Γ 中是否存在 类型B 的属性,图中都包含一条从B 到A 的有向边。 通过检查生成的任意底层网络是否无环,可以获得一个一致概率分布。其中一种方法是构建一个编码底层级潜在依赖关系的模板依赖图。如果模型PRM M 的模板依赖图是无环的,那么由PRM M 产生的任意底层网络也是无环的。然而,PRM M 的模板依赖图中的一个环并不意味着由 PRM M 引起的每一个底层网络是有环的。 6.3 无向表示 定义61 关系马尔可夫网络(Relational Markov Network ,RMN)是根据模板特征集Γ来定义的,其中每个Γ∈γ包含: (a)实值模板特征 γ f ,其参数为 ()()(){}l l K U A U A N ,,11=γ; (b)权值R ∈γω。 定义()γα使得对所有i 有()γα∈i U 。 定义62 给定RMN RMN M 和对象框架K ,可以定义如下的底层吉布斯分布RMN M K P : (a)网络中的变量为[]N K χ; (b)对每个特征模板Γ∈γ和每个赋值()[]γαγK Γ∈, RMN M K P 包含一项()() γωγγf ?exp 。 前面描述的基于模板的表示使用有向图模型,其实也可以用无向图模型来表示。关系域的无向概率模型起源于Taskar 等人提出的关系马尔可夫网络框架[8,98]。Richardson 和Domingos 给出一种基于逻辑公式的特征表示方法,即马尔可夫逻辑网[41-42,99]。在马尔可夫逻辑网络中,团的说明与势能中特征的说明没有分离。当然,模型是根据逻辑公式集来定义的,每个公式都与一个权值关联。在避免局部归一化要求和无环性约束中,无向表示具有更大的灵活性。 但是,无向模型也存在着问题,不利于对特定大小的值域通过学习或手工构建基于模板的模型,而且也不利于把无向模型应用于不同大小的模型中。值域大小对概率分布的影响是变化的,因此在每次应用时都需要评估模型在此场景中的学习能力。 7 总结与展望 本文综述了概率图模型的表示方法及其独立性,梳理了节点上的多种局部概率模型,并总结了贝叶斯网络及其扩展、马尔科夫网络及其扩展、局部有向模型和基于模板表示模型的表示方法和独立性。 虽然概率图模型已在多个领域中成功应用,但是仍有许多关于概率图模型的表示方面的问题有待进一步解决。 (1)在BN 中,参数的选择会对推理的结论产生影响。我们希望即使网络参数发生相当大的变化,只会引起网络性能上的较小退化。如何分析和尽量消除这种影响有待进一步研究。 (2)目前,可以通过与不同参数有关的网络来测量网络对参数方差的灵敏度,但是如何评价灵敏度的性质以及有效估计灵敏度的问题还有待回答。 (3)DBN 结构假设了所应用的系统为平稳动态系统,即系统为时不变齐次系统,但是在实际中所遇到的多数系统都不符合平稳假设。因此,非平稳DBN 是一个研究方向。另外,DBN 需要把时间轴离散化,然而这样会损失信息。虽然已提出连续DBN ,但是其理论还需深化。 (4)对象关系领域的概率模型可以为对象间相互关系网络的不确定性建模,甚至可以为实际对象集的不确定性建模,但是在结构丰富的概率空间中如何选择合适的分布类型来表示联合概率分布,特别是引入当前比较热门的关系语言,如逻辑符号、函数符号和量词等,该问题就更加复杂。 (5)对象关系领域的概率模型表示方法是基于知识的模型构建方法,其语义依赖于模型实例化所产生的底层网络。然而,该方法是有问题的,该过程产生的模型为推理算法带来了很大的挑战。首先,所产生的底层网络相当巨大,比通过手工构建的模型大得多;其次,由于变量间的多相互作用,该模型的连接相当稠密;而且,关系的结构不确定性和对象存在的结构不确定性也会导致模型的连接更加稠密。这些问题有待进一步解决。 (6)基于模板的概率模型,除了本文所描述的基于逻辑的表示之外,近年来还出现一种程序语言框架,称为归纳逻辑程序(Inductive Logic Programming ,ILP)。它把随机变量视为从其输入到其输出的随机函数。定义随机函数后,就可以在多个空间重复使用该函数。更重要地是,可以定义函数来调用其它函数,或者定义函数来递归调用函数本身。基于该框架的语言包括概率上下文自由语法和面向对象贝叶斯网络。但是,该表示方法与概率结合的理论还需深入研究。 参考文献 [1] H. Langseth, L. Portinale. Bayesian networks in reliability[J]. Reliability Engineering and System Safety, 2007, 92 (1): 92–108. [2] Roberto Santana, Siddhartha Shakya. Probabilistic Graphical Models and Markov Networks[J]. Markov Networks in Evolutionary Computation, 2012, 14(1):3-19. [3] Siddhartha Shakya, Roberto Santana. A Review of Estimation of Distribution Algorithms and Markov Networks[J]. Markov Networks in Evolutionary Computation, 2012, 14(1):21-37. [4] Christopher J. P., Jerod J. W., Lam C. T., et al. On Learning Conditional Random Fields for Stereo: Exploring Model Structures and Approximate Inference[J]. International Journal of Computer Vision, 2012, 99(3):319-337. [5] Golumbic M. C., Maffray F., Morel G . A characterization of chain probe graphs[J]. Annals of Operation Research, 2009, 188(1):175-183. [6] Xiao Sun, Degen Huang. Nested Template-based Model for Chinese-Japanese Machine Translation[C]. Proceedings of 14th International Conference on Computational Science and Engineering, 2011, 161-166. 计算机科学 2014年10期 [7] K. Murphy. Dynamic Bayesian networks: representation, inference and learning[D]. Ph.D. Thesis, UC Berkley, 2002. [8] L. Getoor, B. Taskar. Introduction to Statistical Relational Learning[M], MIT Press, 2007. [9] Friedman N., Getoor L., Koller D., et al. Learning probabilistic relational models[C]. Proceedings of the 16th International Joint Conference on Artificial Intelligence, 1999, 1300-1307. [10] Gabriela Medina-Oliva, Philippe Weber, Eric Levrat, et al. Use of probabilistic relational model (PRM) for dependability analysis of complex systems[C]. Proceedings of 12th IFAC Symposium on Large Scale Systems: Theory and Applications, 2010. [11] Glenn Shafer, Judea Pearl. Readings in uncertain reasoning[M]. Morgan Kaufmann Publishers Inc. San Francisco, CA, 1990. [12] J.Y. Halpern. A logical approach to reasoning about uncertainty: a tutorial[M]. Springer Netherlands, 1998, 141–155. [13] Pearl J. Probabilistic reasoning in intelligent systems: networks of plausible inference[M]. San Mateo, California, Morgan Kaufmann Publishers, 1988, 117-133. [14] S. L. Lauritzen, D. J. Spiegelhalter. Local Computations with Probabilities on Graphical Structures and Their Application to Expert Systems[J]. Journal of the Royal Statistical Society, Series B (Methodological), 1988, 50(2):157-224. [15] A. P. Dawid. Influence Diagrams for Causal Modelling and Inference[J]. International Statistical Review, 2002, 70(2):161–189. [16] D. Geiger, T.S. Verma, J. Pearl. Identifying independence in Bayesian networks[J]. Networks, 1990, 20(5):507-534. [17] Thomas Verma , Judea Pearl. Causal networks: semantics and expressiveness[C]. Proceedings of the Fourth Annual Conference on Uncertainty in Artificial Intelligence, 1990, 69-78. [18] Giovanni M. M., Nanny W. Matrix representations and independencies in directed acyclic graphs[J]. Annals of Statistics, 2009, 37(2):961-978. [19] Tyler J. VanderWeele, James M. Robins. Minimal sufficient causation and directed acyclic graphs[J]. Annals of Statistics, 2009, 37(3):1437-1465. [20] David Heckerman. A Tutorial on Learning with Bayesian Networks[J]. Studies in Computational Intelligence, 2008, 15:33-82. [21] D. Koller, N. Friedman. Probabilistic Graphical Models: Principles and Techniques[M]. MIT Press, 2009. [22] David E. Heckerman, Bharat N. Nathwani. An evaluation of the diagnostic accuracy of Pathfinder[J]. Computers and Biomedical Research, 1992, 25(1):56-74. [23] Sajda P. Machine learning for detection and diagnosis of disease[J]. Annual Review of Biomedical Engineering, 2006, 8:537-565. [24] P. Larra?aga, S. Moral. Probabilistic graphical models in artificial intelligence[J]. Applied Soft Computing, 2011, 11(2):1511-1528. [25] Leonardo Chang, Miriam M. D., L.E. Sucar. A Bayesian approach for object classification based on clusters of SIFT local features[J]. Expert Systems with Applications, 2012, 39(2):1679-1686. [26] Sandeep Raghuram, Yuni Xia, Jiaqi Ge. AutoBayesian: Developing Bayesian Networks Based on Text Mining[C]. Database Systems for Advanced Applications. Springer Berlin Heidelberg, 2011, 450-453. [27] Wolfgang Rautenberg. Complete logical Calculi[C]. A Concise Introduction to Mathematical Logic, 2010, 91-134. [28] Ryan Martin, Jianchun Zhang, Chuanhai Liu. Dempster–Shafer Theory and Statistical Inference with Weak Beliefs[J]. Statistical Science, 2010, 25(1):72-87. [29] Didier Dubois, Henri Prade. Possibility theory and formal concept analysis: Characterizing independent sub-contexts[J]. Fuzzy Sets and Systems, 2012, 196:4-6. [30] Zoran Ognjanovi?, Aleksandar Perovi?, Miodrag Ra?kovi?. Logics with the Qualitative Probability Operator[J]. Logic Journal of the IGPL, 2008, 16(2):105-120. [31] FG Cozman. Graphical models for imprecise probabilities[J]. International Journal of Approximate Reasoning, 2005, 39(2-3):167-184. [32] Noel Cressie, Subhash Lele. New Models for Markov Random Fields[J]. Journal of Applied Probability, 1992, 29(4):877-884. [33] Dan Geiger, Judea Pearl. Logical and Algorithmic Properties of Conditional Independence and Graphical Models[J]. Annals of Statistics, 1993, 21(4):2001-2021. [34] Nanny Wermuth. Probability distributions with summary graph structure[J]. Bernoulli, 2011, 17(3):845-879. [35] Murthy V.S., Gupta S., Mohanta D.K. Digital image processing approach using combined wavelet hidden Markov model for well-being analysis of insulators[J]. Image Processing, 2011, 5(2):171-183. [36] Jiamin Ye. Image Filtering with Associative Markov Networks for ECT With Distinctive Phase Origins[J]. IEEE Sensors Journal, 2012, 12(7):2435-2443. [37] Morariu V.I., Davis L.S. Multi-agent event recognition in structured scenarios[C]. Computer Vision and Pattern Recognition, IEEE Conference Publication, 2011, 3289-3296. [38] J. Gregor , M. G. Thomason. Hybrid pattern recognition using Markov networks[J]. IEEE. Trans. on Pattern Analysis and Machine and Intelligence, 1993, 15(6):651-656. [39] Y. Xiang, V. Lesser. A constructive graphical model approach for knowledge-based systems: a vehicle monitoring case study[J]. Computational Intelligence, 2003, 19(3):284-309. [40] Y. Xiang. Comparing alternative methods for inference in multiply sectioned Bayesian networks[J]. Inter. J. Approximate Reasoning, 2003, 33(3): 235-254. [41] Matthew Richardson, Pedro Domingos. Markov logic networks[J]. Machine Learning, 2006, 62(1-2):107-136. [42] David Andrzejewski, Xiaojin Zhu, Mark Craven. A Framework for Incorporating General Domain Knowledge into Latent Dirichlet Allocation Using First-Order Logic[C]. Proceedings of the 22nd International Joint Conference on Artificial Intelligence, 2011. [43] Rabiner L, Juang B. An introduction to hidden Markov models[J]. ASSP Magazine, IEEE, 1986, 3(1):4-16. [44] Thomas Dean, Keiji Kanazawa. A model for reasoning about persistence and causation[J]. Computational Intelligence, 1989, 5(2):142-150. [45] Lawrence K. Saul, Michael I. Jordan. Mixed Memory Markov Models: Decomposing Complex Stochastic Processes as Mixtures of Simpler Ones[J]. Machine Learning, 1999, 37(1):75-87. [46] Zoubin Ghahramani, Michael I. Jordan. Factorial Hidden Markov Models[J]. Machine Learning, 1997, 29(2-3):245-273. [47] Martin J. Wainwright, Michael I. Jordon. Graphical Models, Exponential Families, and Variational Inference[J]. Machine Learning, 2008, 1(1-2):1-305. [48] Shai Fine, Yoram Singer, Naftali Tishby. The Hierarchical Hidden Markov Model: Analysis and Applications[J]. Machine Learning, 1998, 32(1):41-62. [49] Thi Duong, Dinh Phung, Hung Bui. Efficient duration and hierarchical modeling for human activity recognition[J]. Artificial Intelligence, 2009, 173(7-8):830-856. [50] Padhraic Smyth, David Heckerman, Michael I. Jordon. Probabilistic Independence Networks for Hidden Markov Probability Models[J]. Neural Computation, 1997, 9(2):227-269. [51] KP Murphy. Dynamic bayesian networks: Representation, inference and learning[D]. Ph.D. thesis, UC Berkeley, Computer Science Division, 2002. [52] Baah G.K, Podgurski A, Harrold M.J. The Probabilistic Program Dependence Graph and Its Application to Fault Diagnosis[J]. Software Engineering, 2010, 36(4):528-545. [53] W. R. Gilks, A. Thomas, D. J. Spiegelhalter. A Language and Program for Complex Bayesian Modelling[J]. The Statistician, 1994, 43(1):169-177. [54] Lisa Getoor, Nir Friedman, Daphne Koller. Learning probabilistic models of link structure[J]. Machine Learning, 2003, 3:679-707. [55] Elisabetta Fersini, Enza Messina, Francesco Archetti. Web page classification: a probabilistic model with relational uncertainty[C]. Proceedings of the Computational intelligence for knowledge-based systems design, and 13th international conference on Information processing and management of uncertainty, 2010, Dortmund, Germany. [56] Heckerman D., Meek C., Koller D. Probabilistic entity-relationship models, PRMs, and plate models[C]. In Proceedings of the ICML-2004 Workshop on Statistical Relational Learning and its Connections to Other Fields, Banff, Canada: IMLS, 2007, 55–60. [57] Songhwai Oh, Sastry S. A polynomial-time approximation algorithm for joint probabilistic data association[C]. Proceedings of American Control Conference, 2005, 1283-1288. [58] Songhwai Oh, Russell S., Sastry S. Markov Chain Monte Carlo Data Association for Multi-Target Tracking[J]. Automatic Control, 2009, 54(3):481-497. [59] Culotta A., Wick M., McCallum A. First-order probabilistic models for coreference resolution[C]. NAACLHLT, 2007, 81-88. [60] Ben Wellner, Andrew McCallum, Fuchun Peng. An integrated, conditional model of information extraction and coreference with application to citation matching[C]. In Proceedings of the 20th Conference on Uncertainty in Artificial Intelligence, 2004, 593-601. [61] Poon H, Domingos P. Joint inference in information extraction[C]. In Proceedings of the 22nd National Conference on Artificial Intelligence, 2007, 913-918. [62] Milch B., Marthi B., Russell S., et al. BLOG: Probabilistic models with unknown objects[C]. In International joint conference on artificial intelligence, 2005, 1352-1359. [63] Kristian Kersting, Luc De Raedt. Basic principles of learning Bayesian logic programs[C]. Probabilistic inductive logic programming, 2008, 189-221. 计算机科学 2014年10期 [64] David H. Glass. Likelihoods and Explanations in Bayesian Networks[J]. Studies in Computational Intelligence, 2008, 109:325-341. [65] VanderWeele, T. J., Robins, J. M. Signed directed acyclic graphs for causal inference[J]. Journal of the Royal Statistical Society: Series B (Statistical Methodology), 2010, 72: 111–127. [66] Craig Boutilier, Nir Friedman, Moises Goldszmidt, Daphne Koller. Context-specific independence in Bayesian networks[C]. Proceedings of the Twelfth international conference on Uncertainty in artificial intelligence, 1996, 115-123. [67] Poole, D. First-order probabilistic inference[C]. Proceedings of the Eighteenth International Joint Conference on Artificial Intelligence, Mexico: Morgan Kaufmann , 2003, 985–991. [68] Guo Li, Jianmin Gao, Fumin Chen. Construction of causality diagram model for diagnostics[C]. Proceedings of Reliability and Maintainability Symposium, 2008, 97-102. [69] M.A.J. van Gerven, P.J.F. Lucas, Th.P. van der Weide. A generic qualitative characterization of independence of causal influence[J]. International Journal of Approximate Reasoning, 2008, 48(1):214-236. [70] Uri Lerner, Eran Segal, Daphne Koller. Exact inference in networks with discrete children of continuous parents[C]. Proceedings of the 17th conference on Uncertainty in artificial intelligence, 2001, 319-328. [71] Phan H. Giang, Prakash P. Shenoy. Decision making on the sole basis of statistical likelihood[J]. Artificial Intelligence, 2005, 165(2):137-163. [72] Rónán Daly, Qiang Shen, Stuart Aitken. Learning Bayesian networks: approaches and issues[J]. The Knowledge Engineering Review, 2011, 26(2):99-157. [73] Percy Liang, Michael I. Jordan, Dan Klein. Learning from measurements in exponential families[C]. Proceedings of the 26th Annual International Conference on Machine Learning, 2009, 641-648. [74] Mathias Niepert, Dirk Van Gucht, Marc Gyssens. Logical and algorithmic properties of stable conditional independence[J]. International Journal of Approximate Reasoning, 2010, 51(5):531-543. [75] Jiji Zhang, Peter Spirtes. Detection of Unfaithfulness and Robust Causal Inference[J]. Minds and Machines, 2008, 18(2):239-271. [76] R.D. Shachter. Bayes-ball: The rational pastime[C]. Proceedings of the Fourteenth Conference on Uncertainty in Artificial Intelligence, 1998, 480–487. [77] Daly R., Shen Q. Learning Bayesian network equivalence classes with ant colony optimization[J]. Journal of Artificial Intelligence Research, 2009, 35(1):391–447. [78] J. Pearl, T. Verma. An algorithm for deciding if a set of observed independencies has a causal explanation[C]. Proceedings of Eighth Conference in Uncertainty in Artificial Intelligence, 1992, 323-330. [79] Marco Baioletti, Giuseppe Busanello, Barbara Vantaggi. Finding P–Maps and I–Maps to Represent Conditional Independencies[J]. Lecture Notes in Computer Science, 2011, 6717:239-250. [80] David Maxwell Chickering, David Heckerman, Christopher Meek. A Bayesian approach to learning Bayesian networks with local structure[C]. Proceedings of the Thirteenth conference on Uncertainty in artificial intelligence, 1997, 80-89. [81] Seth Sullivant. Algebraic geometry of Gaussian Bayesian networks[J]. Advances in Applied Mathematics, 2008, 44(4):482-513. [82] Loeliger H. A. An introduction to factor graphs[J]. Signal Processing Magazine, 2004, 21(1):28-41. [83] Brendan J. Frey. Extending factor graphs so as to unify directed and undirected graphical models[C]. Proceedings of the 19th conference on Uncertainty in Artificial Intelligence, 2003, 257-264. [84] Hae-Ryoung Song, Montserrat Fuentes, Sujit Ghosh. A comparative study of Gaussian geostatistical models and Gaussian Markov random field models[J]. Journal of Multivariate Analysis, 2008, 99(8):1681-1697. [85] Lindgren, F., Rue, H., Lindstr?m, J. An explicit link between Gaussian fields and Gaussian Markov random fields: the stochastic partial differential equation approach[J]. Journal of the Royal Statistical Society: Series B (Statistical Methodology), 2011, 73: 423–498. [86] John D. Lafferty, Andrew McCallum, Fernando C. N. Pereira. Conditional Random Fields: Probabilistic Models for Segmenting and Labeling Sequence Data[C]. Proceedings of the Eighteenth International Conference on Machine Learning, 2001, 282-289. [87] Michel Galley. A skip-chain conditional random field for ranking meeting utterances by importance[C]. Proceedings of the 2006 Conference on Empirical Methods in Natural Language Processing, 2006, 364-372. [88] Charles Sutton, Khashayar Rohanimanesh, Andrew McCallum. Dynamic conditional random fields: factorized probabilistic models for labeling and segmenting sequence data[J]. Machine Learning Research, 2007, 8:693-723. [89] Mathias Drton. Discrete chain graph models[J]. Bernoulli, 2009, 15(3):736-753. [90] Milan Studeny, Remco R. Bouckaert. On Chain Graph Models for Description of Conditional Independence Structures[J]. The Annals of Statistics, 1998, 26(4):1434-1495. [91] Fersini E., Messina E., Archetti F. Probabilistic Relational Models with Relational Uncertainty: An Early Study in Web Page Classification[C]. Proceedings of International Joint Conferences on Web Intelligence and Intelligent Agent Technologies, 2009, 139-142. [92] Wohlmayr M., Stark M., Pernkopf F. A Probabilistic Interaction Model for Multipitch Tracking With Factorial Hidden Markov Models[J]. Audio, Speech, and Language Processing, 2011, 19(4):799-810. [93] W. P. Malcolm, Novi Quadrianto, Lakhdar Aggoun. State Estimation Schemes for Independent Component Coupled Hidden Markov Models[J]. Stochastic Analysis and Applications, 2010, 18(3):430-446. [94] Mark Gales, Steve Young. The application of hidden Markov models in speech recognition[J]. Foundations and Trends in Signal Processing, 2008, 1(3):195-304. [95] Quinn J.A., Williams C.K.I., McIntosh N. Factorial Switching Linear Dynamical Systems Applied to Physiological Condition Monitoring[J]. Pattern Analysis and Machine Intelligence, 2009, 31(9):1537-1551. [96] Catherine Howard, Markus Stumptner. Automated compilation of Object-Oriented Probabilistic Relational Models[J]. International Journal of Approximate Reasoning, 2009, 50(9):1369-1398. [97] K?nig J., Nordstr?m L., Ekstedt M. Probabilistic Relational Models for assessment of reliability of active distribution management systems[C]. Proceedings of IEEE 11th International Conference on Probabilistic Methods Applied to Power Systems (PMAPS), 2010, 454-459. [98] Huaiyu Wan, Youfang Lin, Caiyan Jia, Houkuan Huang. Community-Based Relational Markov Networks in Complex Networks[J]. Lecture Notes in Computer Science, 2011, 6954:301-310. [99] Katsumasa Yoshikawa, Sebastian Riedel, Masayuki Asahara, Yuji Matsumoto. Jointly identifying temporal relations with Markov Logic[C]. Proceedings of the Joint Conference of the 47th Annual Meeting of the ACL and the 4th International Joint Conference on Natural Language Processing of the AFNLP, 2009, 405-413. Koller 教授把决策作为一种单独的模块进行讲解,但我认为,决策和推理本质上是一样的,都是在假设已知CPD或者势函数的情况下对模型给出结论。 1、决策==逐利 决策的基本思想很intuitive,并且非常有用。在赌博行为中,最后获得的钱与硬币的正反,赌注的大小有关。硬币的正反显然是随机变量,而赌注的大小却是决策量。显而易见的是,决策的最终目的是使得某个期望最大化。再举一个视觉中的例子,对于双目配准算法而言,左相机对应右相机的像素可以认为是随机变量。但是否将两个像素配在一起却可以认为是一个决策(假设像素一一对应,如果甲配了乙就不能配丙了,希望配准的最终结果是尽可能正确的)。故决策的数学表达为: 其中,P(X|A)表示在给定决策下,随机变量X的概率。U(x,a)表示给定决策下,x发生所获得的收益。简单的决策如图所示: 2、决策的方法 显然从上面的分析可知,我们要做的决策就是使得期望最大化的那个。换一个角度来看,如果每次的决策都是未知的,决策取决于已知信息,决策影响最终结果,如果决策也是随机变量,我们应该把获利最多的那个决策组作为我们所需采取的决策库。换而言之,凡事应有a,b,c三策,不同的策略对应不同的情况。显然,我们所需要采取的策略取决于已知的信息(Action的父节点)。而策略组本身就是一个随机变量。 如图所示,如果变量真实值无法观测,只能通过一个传感器(survey)来进行推测时,决策应该取决于S的值。S的值又和其所有父节点(M)的值相关。MEU表示所选择的策略。 显然,我们需要P(S)deta(F|S)U(F,M),然后P(S)需要对P(M,S)进行边际获得。故表达式如上。带入数据发现 用列表法、树状图法求概率有招 刘琛 概率问题是中考中的热点问题,与概率有关的题目形式多样,但其中最主要的是考查利用列表法或树状图法求随即事件的概率.而利用列表法或树状图法求随即事件的概率,关键要注意以下三点: (1)注意各种情况出现的可能性务必相同;(2)其中某一事件发生的概率= 各种情况出现的次数 某一事件发生的次数 ;(3)在考察各种情况出现的次数和某一事件发生的次数时不能重 复也不能遗漏.(4)用列表法或树状图法求得概率是理论概率,而实验估计值是频率,它通常受到实验次数的影响而产生波动,因此两者不一定一致,实验次数较多时,频率稳定于概率,但并不完全等于概率. 例1 田忌赛马是一个为人熟知的故事,传说战国时期,齐王与田忌各有上、中、下三匹马,同等级的马中,齐王的马比田忌的马强.有一天,齐王要与田忌赛一次,赢得两局者为胜,看样子田忌似乎没有什么胜的希望,但是田忌的谋士了解到主人的上、中等马分别比齐王的中、下等马要强. (1). 如果齐王将马按上中下的顺序出阵比赛,那么田忌的马如何出阵,田忌才能取胜? (2). 如果齐王将马按上中下的顺序出阵,而田忌的马随机出阵比赛,田忌获胜的概率是多少?(要求写出双方对阵的所有情况) 分析:正确理解题意,将齐王和田忌的马正确排列,而后恰当列表. 解:(1)由于田忌的上、中等马分别比齐王的中、下等马强,当齐王的马按上、中、下顺序出阵时,田忌的马按下、上、中的顺序出阵,田忌才能取胜. (2).当田忌的马随机出阵时,双方马的对阵情况如下表: 双方马的对阵中,只有一种对阵情况田忌能赢,所以田忌获胜的概率 P= 6 1. 例2 “石头、剪刀、布”是广为流传的游戏,游戏时甲、乙双方每次出“石头”、“剪刀”、“布”三种手势中一种,规定“石头”胜“剪刀”、“剪刀”胜“布”、“布”胜“石头”,同样手势不分胜负,假定甲、乙两人每次都是等可能地出这三种手势,用画树状图或列表的方法分别求出一次游戏中两人同种手势的概率和甲获胜的概率.(提示:为书写方便,解答时可以用S 表示“石头”,用J 表示“剪刀”,用B 表示“布”) 解析:解法一:一次游戏、甲、乙两人随机出手势的所有可能的结果如下图: 所有可能出的结果:(S ,S )(S ,J )(S ,B )(J ,S )(J ,J )(J ,B )(B ,S )(B ,J )(B ,B ) 软件学报ISSN 1000-9825, CODEN RUXUEW E-mail: jos@https://www.360docs.net/doc/d5268833.html, Journal of Software,2013,24(11):2476?2497 [doi: 10.3724/SP.J.1001.2013.04486] https://www.360docs.net/doc/d5268833.html, +86-10-62562563 ?中国科学院软件研究所版权所有. Tel/Fax: ? 概率图模型研究进展综述 张宏毅1,2, 王立威1,2, 陈瑜希1,2 1(机器感知与智能教育部重点实验室(北京大学),北京 100871) 2(北京大学信息科学技术学院智能科学系,北京 100871) 通讯作者: 张宏毅, E-mail: hongyi.zhang.pku@https://www.360docs.net/doc/d5268833.html, 摘要: 概率图模型作为一类有力的工具,能够简洁地表示复杂的概率分布,有效地(近似)计算边缘分布和条件分 布,方便地学习概率模型中的参数和超参数.因此,它作为一种处理不确定性的形式化方法,被广泛应用于需要进行 自动的概率推理的场合,例如计算机视觉、自然语言处理.回顾了有关概率图模型的表示、推理和学习的基本概念 和主要结果,并详细介绍了这些方法在两种重要的概率模型中的应用.还回顾了在加速经典近似推理算法方面的新 进展.最后讨论了相关方向的研究前景. 关键词: 概率图模型;概率推理;机器学习 中图法分类号: TP181文献标识码: A 中文引用格式: 张宏毅,王立威,陈瑜希.概率图模型研究进展综述.软件学报,2013,24(11):2476?2497.https://www.360docs.net/doc/d5268833.html,/ 1000-9825/4486.htm 英文引用格式: Zhang HY, Wang LW, Chen YX. Research progress of probabilistic graphical models: A survey. Ruan Jian Xue Bao/Journal of Software, 2013,24(11):2476?2497 (in Chinese).https://www.360docs.net/doc/d5268833.html,/1000-9825/4486.htm Research Progress of Probabilistic Graphical Models: A Survey ZHANG Hong-Yi1,2, WANG Li-Wei1,2, CHEN Yu-Xi1,2 1(Key Laboratory of Machine Perception (Peking University), Ministry of Education, Beijing 100871, China) 2(Department of Machine Intelligence, School of Electronics Engineering and Computer Science, Peking University, Beijing 100871, China) Corresponding author: ZHANG Hong-Yi, E-mail: hongyi.zhang.pku@https://www.360docs.net/doc/d5268833.html, Abstract: Probabilistic graphical models are powerful tools for compactly representing complex probability distributions, efficiently computing (approximate) marginal and conditional distributions, and conveniently learning parameters and hyperparameters in probabilistic models. As a result, they have been widely used in applications that require some sort of automated probabilistic reasoning, such as computer vision and natural language processing, as a formal approach to deal with uncertainty. This paper surveys the basic concepts and key results of representation, inference and learning in probabilistic graphical models, and demonstrates their uses in two important probabilistic models. It also reviews some recent advances in speeding up classic approximate inference algorithms, followed by a discussion of promising research directions. Key words: probabilistic graphical model; probabilistic reasoning; machine learning 我们工作和生活中的许多问题都需要通过推理来解决.通过推理,我们综合已有的信息,对我们感兴趣的未 知量做出估计,或者决定采取某种行动.例如,程序员通过观察程序在测试中的输出判断程序是否有错误以及需 要进一步调试的代码位置,医生通过患者的自我报告、患者体征、医学检测结果和流行病爆发的状态判断患者 可能罹患的疾病.一直以来,计算机科学都在努力将推理自动化,例如,编写能够自动对程序进行测试并且诊断 ?基金项目: 国家自然科学基金(61222307, 61075003) 收稿时间:2013-07-17; 修改时间: 2013-08-02; 定稿时间: 2013-08-27 概率图模型中的推断 王泉 中国科学院大学网络空间安全学院 2016年11月 ?推断问题回顾 ?精确推断:信念传播 –信念传播算法回顾 –信念传播在HMM中的应用?近似推断:吉布斯采样–吉布斯采样算法回顾 –吉布斯采样在LDA中的应用 ?推断问题回顾 ?精确推断:信念传播 –信念传播算法回顾 –信念传播在HMM中的应用?近似推断:吉布斯采样–吉布斯采样算法回顾 –吉布斯采样在LDA中的应用 ?已知联合概率分布 P x 1,?,x n ,估计 –x Q 问题变量;x E 证据变量;x Q ∪x E =x 1,?,x n P R =1 P R =0 0 P R =1G =1= ? P B =0.001 P E =0.002 P A B ,E =0.95 P A B ,?E =0.94 P A ?B ,E =0.29 P A ?B ,?E =0.001 P J A =0.9 P J ?A =0.05 P M A =0.7 P M ?A =0.01 P B =1E =0,J =1=? P x Q x E =x Q ,x E x E ?已知联合概率分布 P x 1,?,x n ,估计 –x Q 问题变量;x E 证据变量;x Q ∪x E =x 1,?,x n P x Q x E =x Q ,x E x E 观测图片 y i 原始图片 x i y ?=argmax P y x 朴素贝叶斯 x ?=argmax P x y 图像去噪 ?精确推断:计算P x Q x E的精确值 –变量消去 (variable elimination) –信念传播 (belief propagation) –计算复杂度随着极大团规模的增长呈指数增长,适用范围有限?近似推断:在较低的时间复杂度下获得原问题的近似解–前向采样 (forward sampling) –吉布斯采样 (Gibbs sampling) –通过采样一组服从特定分布的样本,来近似原始分布,适用范围更广,可操作性更强 读懂概率图模型:你需要从基本概念和参数估计开始 选自statsbot作者:Prasoon Goyal机器之心编译参与:Panda 概率图模型是人工智能领域内一大主要研究方向。近日,Statsbot 团队邀请数据科学家Prasoon Goyal 在其博客上分两部分发表了一篇有关概率图模型的基础性介绍文章。文章从基础的概念开始谈起,并加入了基础的应用示例来帮助初学者理解概率图模型的实用价值。机器之心对该文章进行了编译介绍。 第一部分:基本术语和问题设定 机器学习领域内很多常见问题都涉及到对彼此相互独立的 孤立数据点进行分类。比如:预测给定图像中是否包含汽车或狗,或预测图像中的手写字符是0 到9 中的哪一个。 事实证明,很多问题都不在上述范围内。比如说,给定一个句子「I like machine learning」,然后标注每个词的词性(名词、代词、动词、形容词等)。正如这个简单例子所表现出的那样:我们不能通过单独处理每个词来解决这个任务——「learning」根据上下文的情况既可以是名词,也可以是动词。这个任务对很多关于文本的更为复杂的任务非常重要,比如从一种语言到另一种语言的翻译、文本转语音等。 使用标准的分类模型来处理这些问题并没有什么显而易见 的方法。概率图模型(PGM/probabilistic graphical model)是一种用于学习这些带有依赖(dependency)的模型的强大框架。这篇文章是Statsbot 团队邀请数据科学家Prasoon Goyal 为这一框架编写的一份教程。 在探讨如何将概率图模型用于机器学习问题之前,我们需要先理解PGM 框架。概率图模型(或简称图模型)在形式上是由图结构组成的。图的每个节点(node)都关联了一个随机变量,而图的边(edge)则被用于编码这些随机变量之间的关系。 根据图是有向的还是无向的,我们可以将图的模式分为两大类——贝叶斯网络(?Bayesian network)和马尔可夫网络(Markov networks)。 贝叶斯网络:有向图模型 贝叶斯网络的一个典型案例是所谓的「学生网络(student network)」,它看起来像是这样: 这个图描述了某个学生注册某个大学课程的设定。该图中有5 个随机变量:课程的难度(Difficulty):可取两个值,0 表示低难度,1 表示高难度 学生的智力水平(Intelligence):可取两个值,0 表示不聪明,1 表示聪明 学生的评级(Grade):可取三个值,1 表示差,2 表示中,3 表示优 概率图模型介绍与计算 01 简单介绍 概率图模型是图论和概率论结合的产物,它的开创者是鼎鼎大名的Judea Pearl,我十分喜欢概率图模型这个工具,它是一个很有力的多变量而且变量关系可视化的建模工具,主要包括两个大方向:无向图模型和有向图模型。无向图模型又称马氏网络,它的应用很多,有典型的基于马尔科夫随机场的图像处理,图像分割,立体匹配等,也有和机器学习结合求取模型参数的结构化学习方法。严格的说他们都是在求后验概率:p(y|x),即给定数据判定每种标签y的概率,最后选取最大的后验概率最大的标签作为预测结果。这个过程也称概率推理(probabilistic inference)。而有向图的应用也很广,有向图又称贝叶斯网络(bayes networks),说到贝叶斯就足以可以预见这个模型的应用范围咯,比如医疗诊断,绝大多数的机器学习等。但是它也有一些争议的地方,说到这就回到贝叶斯派和频率派几百年的争议这个大话题上去了,因为贝叶斯派假设了一些先验概率,而频率派认为这个先验有点主观,频率派认为模型的参数是客观存在的,假设先验分布就有点武断,用贝叶斯模型预测的结果就有点“水分”,不适用于比较严格的领域,比如精密制造,法律行业等。好吧,如果不遵循贝叶斯观点,前面讲的所有机器学习模型都可以dismiss咯,我们就通过大量数据统计先验来弥补这点“缺陷”吧。无向图和有向图的例子如(图一)所示: 图一(a)无向图(隐马尔科夫)(b)有向图 概率图模型吸取了图论和概率二者的长处,图论在许多计算领域中扮演着重要角色,比如组合优化,统计物理,经济等。图的每个节点都可看成一个变量,每个变量有N个状态(取值范围),节点之间的边表示变量之间的关系,它除了 A B C 与《用列表法、树状图求不确定事件的概率》有关的中考题集锦 第1题. (2005 芜湖课改)在科技馆里,小亮看见一台名为帕斯卡三角的仪器,如图所示,当一实心小球从入口落下,它在依次碰到每层菱形挡块时,会等可能地向左或向右落下. (1)试问小球通过第二层A 位置的概率是多少? (2)请用学过的数学方法模拟试验,并具体说明小球下落到第三层B 位置和第四层C 位置处的概率各是多少? 解: 答案:方法1:①实心小球在碰到菱形挡块时向左或向右下落是等可能性的∴经过一个菱形挡块后向左或 向右下落的概率各是原概率的一半. 画树状图可知,落到A 点位置的概率为111442 +=. ②同理可画树状图得,落到B 点位置的概率为113 488+=. ③同理可画树状图得,落到C 点位置的概率为131 16164 +=. (注:①中画图1分,算出概率2分.②、③中画图2分,算出概率2分.) 方法2:(1) 实心小球碰到每个菱形挡块时向左或向右是等可能性的,因此小球下落到A 的可能性会有以 下的途径{左右,右左}两种情况, 而下落到第二层,共{左左,左右,右左,右右}四种情况. 由概率定义得21()42 P A = =. (2)同理,到达第三层B 位置会有以下途径{左右右,右左右,右右左}三种情况. 而下落到第三层共有{左左左,左左右,左右左,左右右,右左左,右左右,右右左,右右右}八种情况. 由概率定义得3()8 P B = . (3)同理,到达第四层C 位置会有{左左左右,左左右左,左右左左,右左左左}四种情况. A B C 而下落到第四层共有{左左左左,左左左右,左左右左,左右左左,右左左左,左右左右,左右右左,左左右右,右左左右,右左右左,右右左左,右右右左,右右左右,右左右右,左右右右,右右右右}共16情况. 由概率定义得41()164 P C = =. 方法3:本题也可用贾宪三角方法,先算出小球下落路径条数,如下图.由题意知:小球经过每条路径的可能性相同. 由概率定义易得221 ()12142 P A = ==++, (其中画图2分,算出概率2分) 33 ()13318 P B = =+++, (其中画图2分,算出概率2分) 441 ()14641164 P C ===++++. (其中画图2分,算出概率2分) 第2题. (2005 泉州课改)把大小和形状一模一样的6张卡片分成两组,每组3张,分别标上数字1,2,3.将这两组卡片分别放入两个盒子中搅匀,再从中各随机抽取一张,试求取出的两张卡片数字之和为偶数的概率(要求用树状图或列表方法求解). 答案: 解:(法1)画树状图 由上图可知,所有等可能结果共有9种,其中两张卡片数字之和为偶数的结果有5种. 59 P ∴= (法2)列表如下: 5种. 1 2 3 1 (1,1) (1,2) (1,3) 2 (2,1) (2,2) (2,3) 3 (3,1) (3,2) (3,3) A B C 1 2 3 1 2 3 1 2 3 1 2 3 第一组 第二组 第 二 组 第 一 组 在之前的消息传递算法中,谈到了聚类图模型的一些性质。其中就有消息不能形成闭环,否则会导致“假消息传到最后我自己都信了”。为了解决这种问题,引入了一种称为团树(clique tree)的数据结构,树模型没有图模型中的环,所以此模型要比图模型更健壮,更容易收敛。 1.团树模型 链模型是一种最简单的树模型,其结构如下图所示,假设信息从最左端传入则有以下式子。 假设要对变量CD 进行推断,则应该求Belief(3) = deta 2->3 *deta 4->3 * phi(3). 从这里可以看出,团树算法是一种精确推断算法。它和变量消除算法在理论推导上是等价的。 上面的例子只是一种非常简单的团树,团树的本质还是聚类图,只不过是一种特殊的聚类图。对于更一般的概率图,也可以生成团树图。 其中,每个cluster都是变量消除诱导图中的一个最小map。 2.团树模型的计算 从上面分析可知,团树模型本质上和变量消除算法还有说不清道不明的关系(团树模型也是精确推理模型)。但是这个算法的优势在于,它可以利用消息传递机制达到收敛。之前提过,聚类图模型中的收敛指的是消息不变。除此之外,聚类图的本质是一种数据结构,它可以储存很多中间计算结果。如果我们有很多变量ABCDEF,那么我们想知道P(A),则需要执行一次变量消除。如果要计算P(B)又要执行一次变量消除。如果中途得到了某个变量的观测,又会对算法全局产生影响。但是使用团树模型可以巧妙的避免这些问题。 首先,一旦模型迭代收敛之后。所有的消息都是不变的,每个消息都是可以被读取的。 每个团的belief,实际上就是未归一划的联合概率,要算单个变量的概率,只需要把其他的变量边际掉就行。这样一来,只需要一次迭代收敛,每个变量的概率都是可算的。并且算起来方便。 其次,如果对模型引入先验知识比如A = a 时,我们需要对D 的概率进行估计。按照变量消除的思路又要从头来一次。但是如果使用团树结构则不用,因为A的取值只影 概率图模型 过去的一段时间里,忙于考试、忙于完成实验室要求的任务、更忙于过年,很长时间没有以一种良好的心态来回忆、总结自己所学的东西了。这几天总在想,我应该怎么做。后来我才明白,应该想想我现在该做什么,所以我开始写这篇博客了。这将是对概率图模型的一个很基础的总结,主要参考了《PATTERN RECOGNITION and MACHINE LEARNING》。看这部分内容主要是因为LDPC码中涉及到了相关的知识。概率图模型本身是值得深究的,但我了解得不多,本文就纯当是介绍了,如有错误或不当之处还请多多指教。 0. 这是什么? 很多事情是具有不确定性的。人们往往希望从不确定的东西里尽可能多的得到确定的知识、信息。为了达到这一目的,人们创建了概率理论来描述事物的不确定性。在这一基础上,人们希望能够通过已经知道的知识来推测出未知的事情,无论是现在、过去、还是将来。在这一过程中,模型往往是必须的,什么样的模型才是相对正确的?这又是我们需要解决的问题。这些问题出现在很多领域,包括模式识别、差错控制编码等。 概率图模型是解决这些问题的工具之一。从名字上可以看出,这是一种或是一类模型,同时运用了概率和图这两种数学工具来建立的模型。那么,很自然的有下一个问题 1. 为什么要引入概率图模型? 对于一般的统计推断问题,概率模型能够很好的解决,那么引入概率图模型又能带来什么好处呢? LDPC码的译码算法中的置信传播算法的提出早于因子图,这在一定程度上说明概率图模型不是一个从不能解决问题到解决问题的突破,而是采用概率图模型能够更好的解决问题。《模式识别和机器学习》这本书在图模型的开篇就阐明了在概率模型中运用图这一工具带来的一些好的性质,包括 教学大纲 统计推理和学习(Statistical Inference and Learning)是信号处理、模式识别、通信系统等工程应用中处理不确定性的一个重要方法。新兴的(概率)图模型是概率论与图论相结合的产物,为各种统计推理和学习提供了一个统一的灵活框架。 本课程介绍图模型基本理论,包括:图论相关知识,图模型上条件独立性,有向图模型(贝叶斯网络)、无向图模型(马尔可夫随机场),图模型的统计推理算法,图模型的学习算法(参数学习和结构学习)等,以及图模型在语音识别、图像处理、计算机视觉、通信信道编码(Turbo-coding)等应用中的具体实例。具体包括如下内容:第一章引言 统计推理和学习的概念 第二章图模型 图论相关知识(简介) 图模型上条件独立性(d-separation,Bayes ball) 有向图模型(贝叶斯网络),无向图模型(马尔可夫随机场) 在图模型框架下介绍: 多元高斯模型、 主成分分析(PCA)、 混合分布(Mixtures)、 因子分析(FA)、 隐马尔科夫模型(HMM) 第三章图模型上的推理(Inference) 图论知识深入:簇(Cliques)、可分解图(Decomposable graph),连接树(Junction tree),规范化(Moralization),三角化(Triangulation)等概念 Junction Tree算法 对HMM的前向-后向算法、Viterbi算法,线性动态系统的Kalman滤波的统一描述 1 第四章图模型的参数学习(Parameter Learning) 完整数据下的最大似然(ML)参数估计 不完整数据(Incomplete Data)下的ML参数估计(EM算法) 完整数据下的贝叶斯学习 不完整数据下的贝叶斯学习 第五章图模型的结构学习(Structure Learning) 模型选取准则,包括最小描述长度(Minimum Description Length,MDL),贝叶斯信息准则(Bayesian Information Criterion,BIC)等 结构EM算法(Structural EM) 结构的贝叶斯学习 第六章图模型的应用选讲 图模型在语音识别应用中的实例 图模型在图像处理应用中的实例 图模型在计算机视觉应用中的实例 图模型在通信信道编码(Turbo-coding)应用中的实例 (前面各章中配合理论的讲解,相应有应用实例的介绍。) 2 个性化教学辅导教案 姓名年级:初一教学课题列表法和树状法求概率 阶段基础()提高()强化()课时计划第()次课 共()次课 教学目标知识点:方法: 重点难点重点:难点: 教学内容与教学过程课前 检查作业完成情况:优□良□中□差□建议__________________________________________概率问题是中考中的热点问题,与概率有关的题目形式多样,但其中最主要的是考查利用列表法或树状图法求随即事件的概率.而利用列表法或树状图法求随即事件的概率,关键要注意以下三点: (1)注意各种情况出现的可能性务必相同; (2)其中某一事件发生的概率= 各种情况出现的次数 某一事件发生的次数 ; (3)在考察各种情况出现的次数和某一事件发生的次数时不能重复也不能遗漏.(4)用列表法或树状图法求得概率是理论概率,而实验估计值是频率,它通常受到实验次数的影响而产生波动,因此两者不一定一致,实验次数较多时,频率稳定于概率,但并不完全等于概率. 例1田忌赛马是一个为人熟知的故事,传说战国时期,齐王与田忌各有上、中、下三匹马,同等级的马中,齐王的马比田忌的马强.有一天,齐王要与田忌赛一次,赢得两局者为胜,看样子田忌似乎没有什么胜的希望,但是田忌的谋士了解到主人的上、中等马分别比齐王的中、下等马要强. (1). 如果齐王将马按上中下的顺序出阵比赛,那么田忌的马如何出阵,田忌才能取胜? (2). 如果齐王将马按上中下的顺序出阵,而田忌的马随机出阵比赛,田忌获胜的概率是多少?(要求写出双方对阵的所有情况) 分析:正确理解题意,将齐王和田忌的马正确排列,而后恰当列表. 中、下顺序出阵时,田忌的马按下、上、中的顺序出阵,田忌才能取胜. (2).当田忌的马随机出阵时,双方马的对阵情况如下表: 齐王的马 上中下 上中下 上中下 上中下 上中下 上中下 田忌的马 上中下 上下中 中上下 中下上 下上中 下中上 双方马的对阵中,只有一种对阵情况田忌能赢,所以田忌获胜的概率 P=61. 例2 “石头、剪刀、布”是广为流传的游戏,游戏时甲、乙双方每次出“石头”、“剪刀”、“布”三种手势中一种,规定“石头”胜“剪刀”、“剪刀”胜“布”、“布”胜“石头”,同样手势不分胜负,假定甲、乙两人每次都是等可能地出这三种手势,用画树状图或列表的方法分别求出一次游戏中两人同种手势的概率和甲获胜的概率.(提示:为书写方便,解答时可以用S 表示“石头”,用J 表示“剪刀”,用B 表示“布”) 解析:解法一:一次游戏、甲、乙两人随机出手势的所有可能的结果如下图: 所有可能出的结果:(S ,S )(S ,J )(S ,B )(J ,S )(J ,J )(J ,B )(B ,S )(B ,J )(B ,B ) 从上面的树状图可以看出,一次游戏可能出现的结果共有9种,而且每种结果出现的可能性相同. 所以,P (出同种手势)=93=31 P (甲获胜)=93=31 解法二:一次游戏,甲、乙两人随机出手势的所有可能的结果如下表: 概率图模型介绍与计算. 概率图模型介绍与计算 01 简单介绍概率图模型是图论和概率论结合的产物,它的开创者是鼎鼎大名的Judea Pearl,我十分喜欢概率图模型这个工具,它是一个很有力的多变量而且变量关系可视化的建模工具,主要包括两个大方向:无向图模型和有向图模型。无向图模型又称马氏网络,它的应用很多,有典型的基于马尔科夫随机场的图像处理,图像分割,立体匹配等,也有和机器学习结合求取模型参数的结构化学习方法。严格的说他们都是在求后验概率:p(y|x),即给定数据判定每种标签y的概率,最后选取最大的后验概率最大的标签作为预测结果。这个过程也称概率推理(probabilistic inference)。而有向图的应用也很广,有向图又称贝叶斯网络(bayes networks),说到贝叶斯就足以可以预见这个模型的应用范围咯,比如医疗诊断,绝大多数的机器学习等。但是它也有一些争议的地方,说到这就回到贝叶斯派和频率派几百年的争议这个大话题上去了,因为贝叶斯派假设了一些先验概率,而频率派认为这个先验有点主观,频率派认为模型的参数是客观存在的,假设先验分布就有点武断,用贝叶斯模型预测的结果就有点“水分”,不适用于比较严格的领域,比如精密制造,法律行业等。好吧,如果不遵循贝叶斯观点,前面讲的所有机器学习模型都可以dismiss咯,我们就通过大量数据统计先验来弥补这点“缺陷”吧。无向图和有向图的例子如(图一)所示: 图一 (a)无向图(隐马尔科夫) (b)有向图 概率图模型吸取了图论和概率二者的长处,图论在许多计算领域中扮演着重要角色,比如组合优化,统计物理,经济等。图的每个节点都可看成一个变量,个状态(取值范围),节点之间的边表示变量之间的关系,它除N每个变量有. 了可以作为构建模型的语言外,图还可以评价模型的复杂度和可行性,一个算法的运行时间或者错误界限的数量级可以用图的结构性质来分析,这句话说的范围很广,其实工程领域的很多问题都可以用图来表示,最终转换成一个搜索试问还有什么问题不是搜索问题?目标就是快速的定位到目标,或者查找问题,树是图,旅行商问题是基于图,染色问题更是基于图,他们具有不同的图的结 构性质。对于树的时间复杂度我们是可以估算出来的,而概率图模型的一开始 用树状图或列表法求概率 学习目标: 1、在具体情境中进一步了解概率的意义,体会概率是描述不确定现象的数学模型. 2、了解必然事件和不可能事件发生的概率,了解事件发生的可能性及游戏规则 的公平性。能运用树状图计算简单事件发生的概率. 学习重点难点: 重点:用树状图法、列表法预测事件的概率。 难点:用概率分析事件。 导学流程: 一、复习预习 1.下列事件中确定事件是( ) A.掷一枚六个面分别标有1~6的数字的均匀骰子,骰子停止转动后偶数点朝上 B.从一副扑克牌中任意抽出一张牌,花色是红桃 C.任意选择电视的某一频道,正在播放动画片 D.在同一年出生的367名学生中,至少有两人的生日是同一天. 2.下列事件中,是必然事件的是() A.打开电视机,正在播放新闻 B.父亲年龄比儿子年龄大 C.通过长期努力学习,你会成为数学家 D.下雨天,每个人都打着雨伞 3.在对某次实验次数整理过程中,某个事件出现的频率随实验次数变化折线图如图,这个图中折线变化的特点是_______,估计该事件发生的概率_________________. 4. 在100张奖券中,有4张中奖,某人从中任抽1张,则他中奖的概率是() A.1 25 B. 1 4 C. 1 100 D. 1 20 5.在一个不透明的袋中装有降颜色外其余都相同的3个小球,其中一个红球、两个黄球.如果第一次先从袋中摸出一个球后不再放回,第二次再从袋中摸出一个,那么两次都摸到黄球的概率是。 二、自主学习 1、下面是两个可以自由转动的转盘,每个转盘被分成了三个相等的扇形,小明和小亮用它们做配紫色(红色与蓝色能配成紫色)游戏,你认为配成紫色与 配不成紫色的概率相同吗?(提示:列表,列举,树状图) 解题思路:三种方法求概率 法一: 《用树状图或表格求概率》习题 一、填空题: 用列表的方法求下列各事件发生的概率,并用所得的结果填空. 1.从1、2、3、4、5这五个数字中,先随意抽取一个,然后从剩下的四个数中再抽取一个,则两次抽到的数字之和为偶数的概率是___________; 2.有五条线段,其长度分别为1、3、5、7、9,从中任取三条,以这三条线段为边能够成一个三角形的概率是____________; 3.现有10个型号相同的杯子,其中一等品7个,二等品2个,三等品1个,从中任取两个杯子都是一等品的概率是_______________. 4.三个袋中各装有2个球,其中第一个袋和第二个袋中各有一个红球和一个黄球,第三个袋中有一个黄球和一个黑球,现从三个袋中各摸出一个球,则摸出的三个球中有2个黄球和一个红球的概率为_________. 5.已知函数5y x =-,令12x =,1,32,2,52,3,72,4,92 ,5,可得函数图象上的十个点.在这十个点中随机取两个点11()P x y ,,22()Q x y ,,则P Q ,两点在同一反比例函数图象上的概率是___________. 二、选择题: 1.十字路口的交通信号灯每分钟红灯亮30秒,绿灯亮25秒,黄灯亮5 秒.当你抬头看信号灯时,是黄灯的概率为( ) A .112 B .13 C .512 D .12 2.同时掷两颗均匀的骰子,下列说法中正确的是( ). (1)“两颗的点数都是3”的概率比“两颗的点数都是6”的概率大; (2)“两颗的点数相同”的概率是16 ; (3)“两颗的点数都是1”的概率最大; (4)“两颗的点数之和为奇数”与 “两颗的点数之和为偶数”的概率相同. A .(1)(2) B .(3)(4) C .(1)(3) D .(2)(4) 三、解答题: 1.有两组卡片,第一组卡片共3张,分别写着2、2、3;第二组卡片共5张,分别写着1、2、2、3、3. 试用列表的方法求从每组中各抽取一张卡片,两张都是2的概率. 2.小明、小芳做一个“配色”的游戏.右图是两个可以自由转动的转盘,每个转盘被分成面 第2课时用画树状图法求概率 教学目标 【知识与技能】 理解并掌握列表法和树状图法求随机事件的概率.并利用它们解决问题,正确认识在什么条件下使用列表法,什么条件下使用树状图法. 【过程与方法】 经历用列表法或树状图法求概率的学习,使学生明白在不同情境中分析事件发生的多种可能性,计算其发生的概率,解决实际问题,培养学生分析问题和解决问题的能力. 【情感态度】 通过求概率的数学活动,体验不同的数学问题采用不同的数学方法,但各种方法之间存在一定的内在联系,体会数学在现实生活中应用价值,培养缜密的思维习惯和良好的学习习惯. 【教学重点】 会用列表法和树状图法求随机事件的概率. 区分什么时候用列表法,什么时候用树状图法求概率. 【教学难点】 列表法是如何列表,树状图的画法. 列表法和树状图的选取方法. 教学过程 一、情境导入,初步认识 播放视频《田忌赛马》,提出问题,引入新课. 齐王和他的大臣田忌均有上、中、下马各一匹,每场比赛三匹马各出场一次,共赛三次,以胜的次数多者为赢.已知田忌的马比齐王的马略逊色,即:田忌的上马不敌齐王的上马,但胜过齐王的中马;田忌的中马不敌齐王的中马,但胜过齐王的下马;田忌的下马不敌齐王的下马.田忌屡败后,接受了孙膑的建议,结果两胜一负,赢了比赛. (1)你知道孙膑给的是怎样的建议吗? (2)假如在不知道齐王出马顺序的情况下,田忌能赢的概率是多少呢? 【教学说明】情境激趣,在最短时间内激起学生的求知欲和探索的欲望. 二、思考探究,获取新知 1.用列表法求概率 课本第136页例2. 分析:由于每个骰子有6种可能结果,所以2个骰子出现的可能结果就会有36种.我们用怎样的方法才能比较快地既不重复又不遗漏地求出所有可能的结果呢?以第一个骰子的点数为横坐标,第二个骰子的点数为纵坐标,组成平面直角坐标系第一象限的一部分,列出表格并填写. 【教学说明】教师引导学生列表,使学生动手体会如何列表,指导学生体会列表法对列举所有可能的结果所起的作用,总结并解答.指导学生如何规范的应用列表法解决概率问题. 由例2可总结得: 当一个事件要涉及两个因素并且可能出现的结果数目较多时,通常采用列表法. 运用列表法求概率的步骤如下: ①列表;②通过表格确定公式中m、n的值;③利用P(A)=m/n计算事件的概率. 思考把“同时掷两个骰子”改为“把一个骰子掷两次”,还可以使用列表法来做吗? 答:“同时掷两个骰子”与“把一个骰子掷两次”可以取同样的试验的所有可能结果,因此,作此改动对所得结果没有影响. 2.树状图法求概率. 课本第138页例3. 分析:分步画图和分类排列相关的结论是解题的关键.弄清题意后,先让学生思考,从3个口袋中每次各随机地取出1个球,共取出3个球,就是说每一次试验涉及到3个步骤,这样的取法共有多少种呢?你打算用什么方法求得? 介绍树状图的方法: 第一步:可能产生的结果为A和B,两者出现的可能性相同且不分先后,写在第一行. 第二步:可能产生的结果有C、D和E,三者出现可能性相同且不分先后, Stanford概率图模型(Probabilistic Graphical Model)L2 Stanford概率图模型(Probabilistic Graphical Model)—第二讲Template Models and Structured CPDs概率图模型(Probabilistic Graphical Model)系列来自Stanford公开课Probabilistic Graphical Model中Daphne Koller 老师的讲解。(https://https://www.360docs.net/doc/d5268833.html,/pgm-2012-002/class/index)主要内容包括(转载请注明原始出处https://www.360docs.net/doc/d5268833.html,/yangliuy)1. 贝叶斯网络及马尔可夫网络的概率图模型表示及变形。2. Reasoning 及Inference 方法,包括exact inference(variable elimination, clique trees) 和approximate inference (belief propagation message passing, Markov chain Monte Carlo methods)。3. 概率图模型中参数及结构的learning方法。4. 使用概率图模型进行统计决策建模。第二讲. Template Models and Structured CPDs.1 Template Models模版图模型,是对图模型更加紧凑的描述方式。模版变量是图模型中多次重复出现的变量,例如多个学生的智商、多门课程的难度。而模版图模型描述了模版变量如何从模版中继承依赖关系,典型的TemplateModels有动态贝叶斯模型DBN、隐马尔科夫模型HMM及PlateModels。动态贝叶斯模型主要是在贝叶斯网络中引入了马尔科夫假设和时间不变性。这几个模型将在后面几讲中再深入介绍,下面看 教学日历 上课时间:第四大节(15:20~16:55) 上课地点:六教6A403 大节课次内容 (1)9月13日第一章引言 统计推理和学习的概念 (2)9月20日第二章图模型 图论相关知识 有向图模型(贝叶斯网络) (3)9月27日图模型上条件独立性(d-separation,Bayes ball)无向图模型(马尔可夫随机场) (4) 10月4日 国庆放假 (5)10月11日在图模型框架下介绍: 多元高斯模型、 主成分分析(PCA)、 混合分布(Mixtures)、 (6)10月18日因子分析(FA)、 隐马尔科夫模型(HMM) (7)10月25日第三章图模型上的推理(Inference) 图论知识深入:簇(Cliques)、可分解图(Decomposable graph),连接树(Junction tree),规范化(Moralization),三角化(Triangulation)等 (8) 11月1日 图论知识深入(续) 1 (9) 11月8日 Junction Tree算法 (10) 11月15日 Junction Tree算法(续) (11) 11月22日 HMM的前向-后向算法、Viterbi算法 (12) 11月29日 线性动态系统的Kalman滤波 (13)12月6日第四章图模型的参数学习(Parameter Learning) 完整数据下的最大似然(ML)参数估计 不完整数据(Incomplete Data)下的ML参数估计(EM算法)完整数据下的贝叶斯学习 不完整数据下的贝叶斯学习 (14)12月13日第五章图模型的结构学习(Structure Learning) 模型选取准则,包括最小描述长度(Minimum Description Length,MDL),贝叶斯信息准则(Bayesian Information Criterion,BIC)等 结构EM算法(Structural EM) 结构的贝叶斯学习 (15)12月20日第六章图模型的应用选讲 图模型在语音识别应用中的实例 图模型在图像处理应用中的实例 (16)12月27日图模型在计算机视觉应用中的实例 图模型在通信信道编码(Turbo-coding)应用中的实例 2 基于采样的推理算法利用的思想是概率= 大样本下频率。故在获得图模型以及CPD的基础上,通过设计采样算法模拟事件发生过程,即可获得一系列事件(联合概率质量函数)的频率,从而达到inference的目的。 1、采样的做法 使用采样算法对概率图模型进行随机变量推理的前提是已经获得CPD。举个简单的例子,如果x = x1,x2,x3,x4的概率分别是a1,a2,a3,a4.则把一条线段分成a1,a2,a3,a4,之后使用Uniform采样,x落在1处,则随机变量取值为a1...依次类推,如图所示。 显然,采样算法中最重要的量就是采样的次数,该量会直接影响到结果的精度。关于采样次数有以下定理: 以简单的贝叶斯模型为例,如果最终关心的是联合概率,条件概率,单一变量的概率都可以使用采样算法。 下图共需要设置1+1+4+2+3 =11 个uniform采样器,最终得到N个结果组合(d0i1g1s0l1等)。最后计算每个组合出现的频率即可获得联合概率分布。通过边缘化则可获得单一变量概率。如果是条件概率,则去除最终结果并将符合条件的取出,重新归一化即可。 总结可知,采样算法有以下性质: 1.精度越高,结果越可靠,需要的采样次数也越多。 2.所关心的事件发生的概率很小,则需要很大的采样次数才能得到较为准确的结果。 3.如果随机变量的数量很多,则采样算法会非常复杂。故此算法不适用于随机变量很多的情况。 2、马尔科夫链与蒙特卡洛算法 马尔科夫链是一种时域动态模型,其描述的随机变量随着时间的推进,在不同状态上跳跃。实际上,不同的状态是随机变量所可能的取值,相邻状态之间是相关关系。引入马尔科夫链的目的是为了描述某些情况下,随机变量的分布无法用数学公式表达,而可利用马尔科 夫链进行建模。把随机变量的取值视为状态,把随机变量视为跳蚤。马尔科夫链如下图所示:机器学习 —— 概率图模型(推理:决策)

用列表法、树状图法求概率精编版

概率图模型研究进展综述

概率图模型中的推断

读懂概率图模型:你需要从基本概念和参数估计开始

概率图模型介绍与计算

树状图和列表法求概率的05年中考题(含答案)-

机器学习 —— 概率图模型(推理:团树算法)

概率图模型

概率图模型理论及应用教学大纲

树状图和列表法

概率图模型介绍与计算

列表法或树状图求概率

《用树状图或表格求概率》习题

第2课时 用画树状图法求概率(教案)

Stanford概率图模型(Probabilistic Graphical Model)L2

概率图模型理论及应用教学日历

机器学习 —— 概率图模型(推理:采样算法)