高斯基组库

https://www.360docs.net/doc/d76859045.html,/TBL/tbl.html

https://www.360docs.net/doc/d76859045.html,/wzou/qcsc/calclink/bas.html

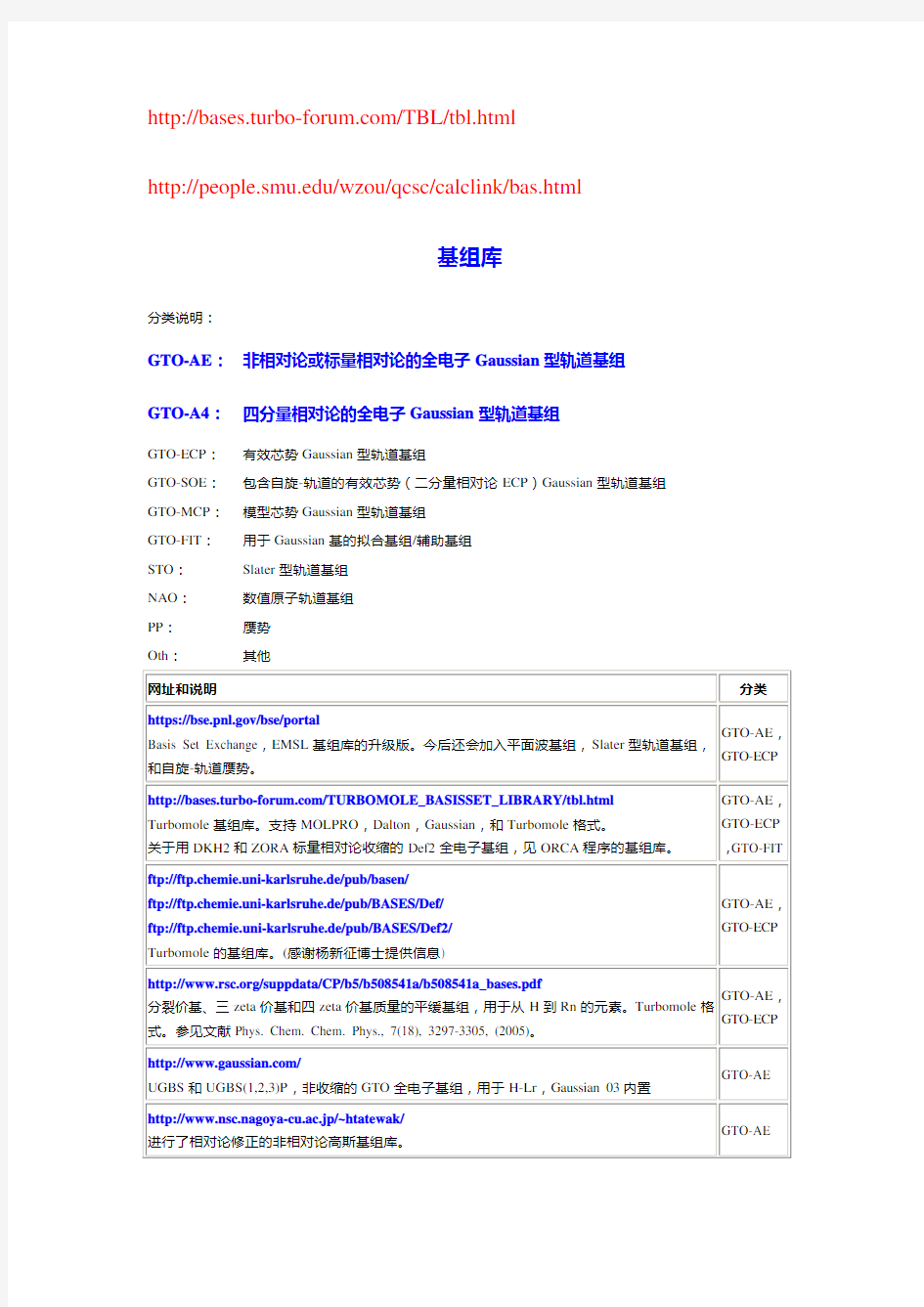

基组库

分类说明:

GTO-AE:非相对论或标量相对论的全电子Gaussian型轨道基组GTO-A4:四分量相对论的全电子Gaussian型轨道基组

GTO-ECP:有效芯势Gaussian型轨道基组

GTO-SOE:包含自旋-轨道的有效芯势(二分量相对论ECP)Gaussian型轨道基组GTO-MCP:模型芯势Gaussian型轨道基组

GTO-FIT:用于Gaussian基的拟合基组/辅助基组

STO:Slater型轨道基组

NAO:数值原子轨道基组

PP:赝势

Oth:其他

svm核函数matlab

clear all; clc; N=35; %样本个数 NN1=4; %预测样本数 %********************随机选择初始训练样本及确定预测样本******************************* x=[]; y=[]; index=randperm(N); %随机排序N个序列 index=sort(index); gama=23.411; %正则化参数 deita=0.0698; %核参数值 %thita=; %核参数值 %*********构造感知机核函数************************************* %for i=1:N % x1=x(:,index(i)); % for j=1:N % x2=x(:,index(j)); % K(i,j)=tanh(deita*(x1'*x2)+thita); % end %end %*********构造径向基核函数************************************** for i=1:N x1=x(:,index(i)); for j=1:N x2=x(:,index(j)); x12=x1-x2; K(i,j)=exp(-(x12'*x12)/2/(deita*deita)); End End %*********构造多项式核函数**************************************** %for i=1:N % x1=x(:,index(i)); % for j=1:N % x2=x(:,index(j)); % K(i,j)=(1+x1'*x2)^(deita); % end %end %*********构造核矩阵************************************ for i=1:N-NN1 for j=1:N-NN1 omeiga1(i,j)=K(i,j); end end

Matlab工具箱中的BP与RBF函数

Matlab工具箱中的BP与RBF函数 Matlab神经网络工具箱中的函数非常丰富,给网络设置合适的属性,可以加快网络的学习速度,缩短网络的学习进程。限于篇幅,仅对本章所用到的函数进行介绍,其它的函数及其用法请读者参考联机文档和帮助。 1 BP与RBF网络创建函数 在Matlab工具箱中有如表1所示的创建网络的函数,作为示例,这里只介绍函数newff、newcf、newrb和newrbe。 表 1 神经网络创建函数 (1) newff函数 功能:创建一个前馈BP神经网络。 调用格式:net = newff(PR,[S1 S2...S Nl],{TF1 TF2...TF Nl},BTF,BLF,PF) 参数说明: ?PR - R个输入的最小、最大值构成的R×2矩阵; ?S i–S NI层网络第i层的神经元个数; ?TF i - 第i层的传递函数,可以是任意可导函数,默认为'tansig',可

设置为logsig,purelin等; ?BTF -反向传播网络训练函数,默认为'trainlm',可设置为trainbfg,trainrp,traingd等; ?BLF -反向传播权值、阈值学习函数,默认为'learngdm'; ?PF -功能函数,默认为'mse'; (2) newcf函数 功能:创建一个N层的层叠(cascade)BP网络 调用格式:net = newcf(Pr,[S1 S2...SNl],{TF1 TF2...TFNl},BTF,BLF,PF) 参数同函数newff。 (3) newrb函数 功能:创建一个径向基神经网络。径向基网络可以用来对一个函数进行逼近。newrb函数用来创建一个径向基网络,它可以是两参数网络,也可以是四参数网络。在网络的隐层添加神经元,直到网络满足指定的均方误差要求。 调用格式:net = newrb(P,T,GOAL,SPREAD) 参数说明: ?P:Q个输入向量构成的R×Q矩阵; ?T:Q个期望输出向量构成的S×Q矩阵; ?GOAL:均方误差要求,默认为0。 ?SPREAD:分散度参数,默认值为1。SPREAD越大,网络逼近的函数越平滑,但SPREAD取值过大将导致在逼近变化比较剧烈的函数时神经元过多,若SPREAD取值过小,则导致在逼近平滑函数时,

高斯(核)函数简介

高斯(核)函数简介 1函数的基本概念 所谓径向基函数(Radial Basis Function简称RBF),就是某种沿径向对称的标量函数。通常定义为空间中任一点x到某一中心xc之间欧氏距离的单调函数,可记作k(||x-xc||),其作用往往是局部的,即当x远离xc时函数取值很小。最常用的径向基函数是高斯核函数,形式为k(||x-xc||)=exp{-||x-xc||^2/(2*σ)^2)}其中xc为核函数中心,σ为函数的宽度参数,控制了函数的径向作用范围。 高斯函数具有五个重要的性质,这些性质使得它在早期图像处理中特别有用.这些性质表明,高斯平滑滤波器无论在空间域还是在频率域都是十分有效的低通滤波器,且在实际图像处理中得到了工程人员的有效使用.高斯函数具有五个十分重要的性质,它们是: (1)二维高斯函数具有旋转对称性,即滤波器在各个方向上的平滑程度是相同的.一般来说,一幅图像的边缘方向是事先不知道的,因此,在滤波前是无法确定一个方向上比另一方向上需要更多的平滑.旋转对称性意味着高斯平滑滤波器在后续边缘检测中不会偏向任一方向. (2)高斯函数是单值函数.这表明,高斯滤波器用像素邻域的加权均值来代替该点的像素值,而每一邻域像素点权值是随该点与中心点的距离单调增减的.这一性质是很重要的,因为边缘是一种图像局部特征,如果平滑运算对离算子中心很远的像素点仍然有很大作用,则平滑运算会使图像失真. (3)高斯函数的付立叶变换频谱是单瓣的.正如下面所示,这一性质是高斯函数付立叶变换等于高斯函数本身这一事实的直接推论.图像常被不希望的高频信号所污染(噪声和细纹理).而所希望的图像特征(如边缘),既含有低频分量,又含有高频分量.高斯函数付立叶变换的单瓣意味着平滑图像不会被不需要的高频信号所污染,同时保留了大部分所需信号. (4)高斯滤波器宽度(决定着平滑程度)是由参数σ表征的,而且σ和平滑程度的关系是非常简单的.σ越大,高斯滤波器的频带就越宽,平滑程度就越好.通过调节平滑程度参数σ,可在图像特征过分模糊(过平滑)与平滑图像中由于噪声和细纹理所引起的过多的不希望突变量(欠平滑)之间取得折衷. (5)由于高斯函数的可分离性,大高斯滤波器可以得以有效地实现.二维高斯函数卷积可以分两步来进行,首先将图像与一维高斯函数进行卷积,然后将卷积结果与方向垂直的相同一维高斯函数卷积.因此,二维高斯滤波的计算量随滤波模板宽度成线性增长而不是成平方增长. 2函数的表达式和图形 在这里编辑公式很麻烦,所以这里就略去了。可以参看相关的书籍,仅给出matlab绘图的

第3章神经网络3-径向基函数网络(n)

第三章径向基函数网络 (44) 3.1 径向基函数(Redial Basis Function,RBF) (44) 3.2 径向基函数参数的选取 (46) c的选取 (46) 3.2.1 基函数中心 p 3.2.2权系数 的确定 (47) 3.3 高斯条函数 (48)

)(1 )(p h P p p λx g ?∑==第三章 径向基函数网络 径向基函数网络利用具有局部隆起的所谓径向基函数来做逼近或分类问题。它可以看作是一种前馈网络,所处理的信息在工作过程中逐层向前流动。虽然它也可以像BP 网络那样利用训练样本作有教师学习,但是其更典型更常用的学习方法则与BP 网络有所不同,综合利用了有教师学习和无教师学习两种方法。对于某些问题,径向基函数网络可能比BP 网络精度更高。 3.1 径向基函数(Redial Basis Function ,RBF ) [Powell 1985]提出了多变量插值的径向基函数方法。稍后[Broomhead 1988]成功地将径向基函数用于模式识别。径向基函数可以写成 ||)1 (||)(∑=-= P p p c x p x g ?λ (3.1.1) 其中N R x ∈表示模式向量;N P p p R c ?=1 }{ 是基函数中心;j λ是权系数;?是选定的非线性基函数。(3.1.1)可以看作是一个神经网络,输入层有N 个单元,输入模式向量x 由此进入网络。隐层有P 个单元,第p 个单元的输入为||||p p c x h -=,输出为)(p h ?。输出层1个单元, 输出为 。 假设给定了一组训练样本11},{R R y x N J j j j ??=。当j y 只取有限个值(例如,取0,1或±1)时,可以认为是分类问题;而当j y 可取任意实数时,视为逼近问题。网络学习(或训练)的任务就是利用训练样本来确定输入层到隐层的权向量p c 和隐层到输出层的权系数p λ,使得 J j y x g j j ,,1 ,)( == (3.1.2) 为此,当P J =时,可以简单地令 P p x c p p ,,1 , == (3.1.3) 这时(3.1.2)成为关于{}p λ的线性方程组,其系数矩阵通常可逆,因此有唯一解(参见[MC])。在实践中更多的情况是P J >。这时, (3.1.2)一般无解, 只能求近似解。我们将在下一节详细讨论这种情况。 常用的非线性基函数有以下几种: 1) 高斯基函数 确定了}{p c 后,可以选取如下的高斯基函数来构造径向基函数: )()(1x x g P p p p ∑==?λ (3.1.4a) 式中

核函数

SVM 小结 理论基础: 机器学习有三类基本的问题,即模式识别、函数逼近和概率密度估计. SVM 有着严格的理论基础,建立了一套较好的有限训练样本下机器学习的理论框架和通用方法。他与机器学习是密切相关的,很多理论甚至解决了机器学习领域的其他的问题,所以学习SVM 和机器学习是相辅相成的,两者可以互相促进,有助于机器学习理论本质的理解。 VC 维理论:对一个指示函数集,如果存在h 个样本能够被函数集中的函数按所有可能的2h 种形式分开,则称函数集能够把h 个样本打散;函数集的VC 维就是它能打散的最大样本数目。VC 维反映了函数集的学习能力,VC 维越太则学习机器越复杂(容量越太)。 期望风险:其公式为[](,,(,))(,)y R f c y f y dP y χχχχ?=?,其中(,,(,))c y f y χχ为损失函数,(,)P y χ为概率分布,期望风险的大小可以直观的理解为,当我们用()f χ进行预测时,“平均”的损失程度,或“平均”犯错误的程度。 经验风险最小化(ERM 准则)归纳原则:但是,只有样本却无法计算期望风险,因此,传统的学习方法用样本定义经验风险[]emp R f 作为对期望风险的估计,并设计学习算法使之最小化。即所谓的经验风险最小化(ERM 准则)归纳原则。经验风险是用损失函数来计算的。对于模式识别问题的损失函数来说,经验风险就是训练样本错误率;对于函数逼近问题的损失函数来说,就是平方训练误差;而对于概率密度估计问题的损失函数来说,ERM 准则就等价于最大似然法。但是,经验风险最小不一定意味着期望风险最小。其实,只有样本数目趋近于无穷大时,经验风险才有可能趋近于期望风险。但是很多问题中样本数目离无穷大很远,那么在有限样本下ERM 准则就不一定能使真实风险较小。ERM 准则不成功的一个例子就是神经网络和决策树的过学习问题(某些情况下,训练误差过小反而导致推广能力下降,或者说是训练误差过小导致了预测错误率的增加,即真实风险的增加)。 结构风险最小化理论(SRM):所以,在有限样本情况下,仅仅用ERM 来近似期望风险是行不通的。统计学习理论给出了期望风险[]R f 与经验风险[]emp R f 之间关系: [][]()emp h R f R f l φ≤+

核函数

生存?还是毁灭?——哈姆雷特 可分?还是不可分?——支持向量机 之前一直在讨论的线性分类器,器如其名(汗,这是什么说法啊),只能对线性可分的样本做处理。如果提供的样本线性不可分,结果很简单,线性分类器的求解程序会无限循环,永远也解不出来。这必然使得它的适用范围大大缩小,而它的很多优点我们实在不原意放弃,怎么办呢?是否有某种方法,让线性不可分的数据变得线性可分呢? 有!其思想说来也简单,来用一个二维平面中的分类问题作例子,你一看就会明白。事先声明,下面这个例子是网络早就有的,我一时找不到原作者的正确信息,在此借用,并加进了我自己的解说而已。 例子是下面这张图: 我们把横轴上端点a和b之间红色部分里的所有点定为正类,两边的黑色部分里的点定为负类。试问能找到一个线性函数把两类正确分开么?不能,因为二维空间里的线性函数就是指直线,显然找不到符合条件的直线。 但我们可以找到一条曲线,例如下面这一条:

显然通过点在这条曲线的上方还是下方就可以判断点所属的类别(你在横轴上随便找一点,算算这一点的函数值,会发现负类的点函数值一定比0大,而正类的一定比0小)。这条曲线就是我们熟知的二次曲线,它的函数表达式可以写为: 问题只是它不是一个线性函数,但是,下面要注意看了,新建一个向量y和a: 这样g(x)就可以转化为f(y)=

径向基分类器简介

径向基函数神经网络模型与学习算法1985年,Powell提出了多变量插值的径向基函数(Radical Basis Function, RBF)方法。1988年,Moody和Darken提出了一种神经网络结构,即RBF 神经网络,属于前向神经网络类型,它能够以任意精度逼近任意连续函数,特别适合于解决分类问题。 RBF网络的结构与多层前向网络类似,它是一种三层前向网络。输入层由信号源结点组成;第二层为隐含层,隐含层节点数目视所描述问题的需要而定,隐单元的变换函数是对中心点径向对称且衰减的非负非线性函数;第三层为输出层,它对输入模式的作用做出响应。从输入空间到隐含层空间的变换是非线性的,而从隐含层空间的输出层空间变换是线性的。 RBF网络是的基本思想是:1)用RBF作为隐单元的“基”构成隐含层空间,将输入矢量直接映射到隐含空间(即不需要通过权连接);2)当RBF的中心点确定后,映射关系也就确定;3)隐含层空间到输出空间的映射是线性的。隐含层空间到输出空间的映射是线性的,即网络的输出是隐单元输出的线性加权和。此处的权即为网络可调参数。由此可见,从总体上看,网络由输入到输出的映射是非线性的,而网络输出对可调参数而言却又是线性的。这样网络的权就可由线性方程直接解出,从而大大加快学习速度并避免局部极小问题。1.1 RBF神经元结构 径向基神经网络的神经元结构如图1所示,径向基神经网络的激活函数采用径向基函数,通常定义为空间任一点到某一中心之间欧氏

距离的单调函数。由图1所示的径向基神经元结构可以看出,径向基神经网络的激活函数是以输入向量和权值向量之间的距离dist作为自变量的。径向基神经网络的激活函数的一般表达式为 2 -d i s t R(d i s t)=e(1) 图1 径向基神经元模型 1.2 RBF神经网络结构 由输入层、隐含层和输出层构成的一般径向基神经网络结构如图2所示。在RBF网络中,输入层仅仅起到传输信号的作用,与前面所讲述的神经网络相比较,输入层和隐含层之间可以看做是连接权值为1的连接。输出层和隐含层所完成的任务是不同的,因而它们的学习策略也不相同。输出层是对线性权进行调整,采用的是线性优化策略。因而学习速度较快。而隐含层是对激活函数(格林函数或高斯函数,一般取高斯)的参数进行调整,采用的是非线性优化策略,因而学习速度较慢。

高斯核函数

高斯核函数所谓径向基函数(Radial Basis Function 简称RBF), 就是某种沿径向对称的标量函数。通常定义为空间中任一点x到某一中心xc之间欧氏距离的单调函数, 可记作k(||x-xc||), 其作用往往是局部的, 即当x远离xc时函数取值很小。 最常用的径向基函数是高斯核函数,形式为k(||x-xc||)=exp{- ||x-xc||^2/(2*σ)^2) } 其中xc 为核函数中心,σ为函数的宽度参数, 控制了函数的径向作用范围。 计算机视觉中的作用 在计算机视觉中,有时也简称为高斯函数。高斯函数具有五个重要的性质,这些性质使得它在早期图像处理中特别有用.这些性质表明,高斯平滑滤波器无论在空间域还是在频率域都是十分有效的低通滤波器,且在实际图像处理中得到了工程人员的有效使用.高斯函数具有五个十分重要的性质,它们是:(1)二维高斯函数具有旋转对称性,即滤波器在各个方向上的平滑程度是相同的.一般来说,一幅图像的边缘方向是事先不知道的,因此,在滤波前是无法确定一个方向上比另一方向上需要更多的平滑.旋转对称性意味着高斯平滑滤波器在后续边缘检测中不会偏向任一方向.(2)高斯函数是单值函数.这表明,高斯滤波器用像素邻域的加权均值来代替该点的像素值,而每一邻域像素点权值是随该点与中心点的距离单调增减的.这一性质是很重要的,因为边缘是一种图像局部特征,如果平滑运算对离算子中心很远的像素点仍然有很大作用,则平滑运算会使图像失真.(3)高斯函数的付立叶变换频谱是单瓣的.正如下面所示,这一性质是高斯函数付立叶变换等于高斯函数本身这一事实的直接推论.图像常被不希望的高频信号所污染(噪声和细纹理).而所希望的图像特征(如边缘),既含有低频分量,又含有高频分量.高斯函数付立叶变换的单瓣意味着平滑图像不会被不需要的高频信号所污染,同时保留了大部分所需信号.(4)高斯滤波器宽度(决定着平滑程度)是由参数σ表征的,而且σ和平滑程度的关系是非常简单的.σ越大,高斯滤波器的频带就越宽,平滑程度就越好.通过调节平滑程度参数σ,可在图像特征过分模糊(过平滑)与平滑图像中由于噪声和细纹理所引起的过多的不希望突变量(欠平滑)之间取得折衷.(5)由于高斯函数的可分离性,大高斯滤波器可以得以有效地实现.二维高斯函数卷积可以分两步来进行,首先将图像与一维高斯函数进行卷积,然后将卷积结果与方向垂直的相同一维高斯函数卷积.因此,二维高斯滤波的计算量随滤波模板宽度成线性增长而不是成平方增长.

径向基函数神经网络.docx

径向基函数神经网络模型与学习算法 1985年,Powell提出了多变量插值的径向基丙数(Radical Basis Function, RBF)方法。1988 年,Moody 和Darken 提出了一种神经网络结构,即RBF 神经网络,属于前向神经网络类型,它能够以任意精度逼近任意连续函数,特别适合于解决分类问题。 RBF网络的结构与多层前向网络类似,它是一种三层前向网络。输入层由信号源结点组成;第二层为隐含层,隐单元数视所描述问题的需要而定,隐单元的变换函数RBFO是对中心点径向对称且衰减的非负非线性函数;第三层为输出层,它对输入模式的作用作出响应。从输入空间到隐含层空间的变换是非线性的,而从隐含层空间的输出层空间变换是线性的。 RBF网络的基本思想是:用RBF作为隐单元的“基”构成隐含层空间,这样就可以将输入矢量直接(即不需要通过权接)映射到隐空间。当RBF的屮心点确定以后,这种映射关系也就确定了。而隐含层空间到输出空间的映射是线性的,即网络的输出是隐单元输出的线性加权和。此处的权即为网络可调参数。由此可见,从总体上看,网络市输入到输出的映射是非线性的,而网络输出对叮调参数而言却又是线性的。这样网络的权就可由线性方程直接解岀,从而大大加快学习速度并避免局部极小问题。 1.1RBF神经网络模型 径向基神经网络的神经元结构如图1所示。径向基神经网络的激活函数采用径向基函数,通常定义为空间任一点到某一中心之间欧氏距离的单调函数。由图1所示的径向基神经元结构可以看出,径向基神经网络的激活函数是以输入向量和权值向量之间的距离||dist||作为自变量的。径向基神经网络的

激活函数的一般表达式为 /?(||dist||)= e~yist^(1) 图1径向基神经元模型 随着权值和输入向量之间距离的减少,网络输出是递增的,当输入向量和权值向量一致时,神经元输出1。在图1中的b为阈值,用于调整神经元的灵敏度。利用径向基神经元和线性神经元可以建立广义回归神经网络,该种神经网络适用于函数逼近方面的应用;径向基神经元和竞争神经元可以组建概率神经网络,此种神经网络适用于解决分类问题。 由输入层、隐含层和输岀层构成的一般径向基神经网络结构如图2所示。在RBF网络中,输入层仅仅起到传输信号的作用,与前面所讲述的神经网络相比较,输入层和隐含层之间可以看做连接权值为1 的连接。输出层和隐含层所完成的任务是不同的,因而它们的学习策略也不相同。输岀层是对线性权进行调整,采用的是线性优化策略。因而学习速度较快。而隐含层是对激活函数(格林函数或高斯函数,一般取高斯)的参数进行调整,采用的是非线性优化策略,因而学习速度较慢。

BP算法及径向基函数网络

BP 算法及径向基函数网络 B0503194班 高翔 1050319110 杨柳青 1050319113 题目1: 2.5 利用BP 算法及Sigmoid 算法,研究以下各函数的逼近问题: (1) 1 () , 1x 100f x x = ≤≤ (2) 10()log x , 1x 10f x =≤≤ (3) ()exp() , 1x 10f x x =-≤≤ (4) ()sin , 1x 2 f x x π =≤≤ 解:该题可以采用BP 神经网络或者是径向基函数网络来解决,首先给出我们利用BP 网络的解决方法,关于如何利用径向基函数网络来解决问题,放在2.6 题中的通过径向基函数网络解决XOR 问题一起讨论。 一、 概述 人工神经网络作为一门20世纪中叶起步的新技术,随着其理论的逐步完善,其应用日益广泛,应用领域也在不断拓展,已经在各个工程领域里得到了广泛的应用。通常神经网络技术主要应用在以下方面。 模式信息处理和模式识别。 最优化问题计算。 信息的智能化处理。 复杂控制。 信号处理。 在1959年,当时的两位美国工程师B.Widrow 和M.Hoff 提出了自适应线形元件。在 1969年,人工智能的创始人之一M.Minsky 和S.Papert 指出单层感知器只能够进行线形分类,对线形不可分的输入模式,哪怕是简单的异或逻辑运算,单层感知器也无能为力,而解决其的唯一方法就是设计训练出具有隐含层的多层神经网络。这一难题在1986年得到了解决。 1986年,D.E. Rumelhart 等人提出解决多层神经网络权值修正的算法——误差反向传播法(Error Back-Propagation )。这种算法也通常被应用在BP (Back-Propagation Network )中。 在目前,在人工神经网络的实际应用中,绝大部分的神经网络模型(80%--90%)是采

核函数

核函数 (2010-12-23 23:08:30) 分类:工作篇 标签: 校园 高斯核函数 所谓径向基函数(Radial Basis Function 简称 RBF), 就是某种沿径向对称的标量函数。通常定义为空间中任一点x到某一中心xc之间欧氏距离的单调函数, 可记作 k(||x-xc||), 其作用往往是局部的 , 即当x远离xc时函数取值很小。 高斯核函数 - 常用公式 最常用的径向基函数是高斯核函数 ,形式为 k(||x-xc||)=exp{- ||x-xc||^2/(2*σ)^2) } 其中xc为核函数中心,σ为函数的宽度参数 , 控制了函数的径向作用范围。 核函数简介 (1)核函数发展历史 早在1964年Aizermann等在势函数方法的研究中就将该技术引入到机器学习领域,但是直到1992年Vapnik等利用该技术成功地将线性SVMs推广到非线性SVMs时其潜力才得以充分挖掘。而核函数的理论则更为古老,Mercer定理可以追溯到1909年,再生核希尔伯特空间(ReproducingKernel Hilbert Space, RKHS)研究是在20世纪40年代开始的。 (2)核函数方法原理 根据模式识别理论,低维空间线性不可分的模式通过非线性映射到高维特征空间则可能实现线性可分,但是如果直接采用这种技术在高维空间进行分类或回归,则存在确定非线性映射函数的形式和参数、特征空间维数等问题,而最大的障碍则是在高维特征空间运算时存在的“维数灾难”。采用核函数技术可以有效地解决这样问题。 设x,z∈X,X属于R(n)空间,非线性函数Φ实现输入间X到特征空间F的映射,其中F属于R(m),n<

代理模型中的径向基函数以及matlab程序

径向基函数 利用样本点x i的响应值, 通过基函数的线性叠加来计算待测点x 处响应值的径向基模型的基本形式如下: f x=w i??r i n i=1 =w Tφ 其中权系数w=w1,w2,···,w n T,φ= ?r1,?r2,···,?r n T r i= x?x i是待测点x与样本点x i之间的欧氏距离 ?r是径向函数 常用的径向函数有Gauss函数?r=exp ?r 2 c2 Multiquadric函数?r=r2+c21 2,c是给定大于零的常数 根据插值条件f x j=y i j=1,···,n,可得方程组 ??w=Y 矩阵?= ?ij= ? x i?x j 向量Y=y1,?,y n T i,j=1,?,n 在样本点不重合且函数?为征订函数,上式存在唯一解 w=??1?Y

附:MATLAB程序 %求解RBF方程的系数 function b=RBFMain() clc; clear; %读取插值点的数据 Num=xlsread('set_of_test.xlsx'); [row,line]=size(Num); %读取插值点的结果 F=xlsread('result_of_weight.xlsx'); %计算r值 r=eye(row); for i=1:row for j=1:row temp=0; for k=1:line temp=temp+(Num(i,k)-Num(j,k))^2; end r(i,j)= sqrt(temp+1); end end %求解方程系数 b=r\F; %写入excel xlswrite('set_of_coefficient.xlsx',b); end %RBF径向基函数主程序 function result=RBFMain2() clear;clc; %插值点 Input=xlsread('set_of_test.xlsx'); [row,line]=size(Input); %需要预测的一组插值点 X=xlsread('set_of_indict.xlsx'); %读取系数 b=xlsread('set_of_coefficient.xlsx'); %计算r值 r=[]; for i=1:row temp=0;

基于径向基函数神经网络的函数逼近

基于径向基函数神经网络的函数逼近 刘君尧1,邱 岚2 (1.深圳信息职业技术学院,广东深圳 518029;2.中国移动广西公司,广西南宁 530022) 【摘 要】在介绍了径向基函数神经网络原理的基础上,应用该网络进行函数逼近的实现,并探讨散步常数的选取对逼近效果的影响。 【关键词】径向基函数;神经网络;散布常数;函数逼近 【中图分类号】TP183 【文献标识码】A 【文章编号】1008-1151(2009)09-0039-01 (一)引言 径向基函数(Radial Basis Function)神经网络是由 J.Moody和C.Darken于20世纪 80年代末提出的一种神经网 络,径向基函数方法在某种程度上利用了多维空间中传统的 严格插值法的研究成果。在神经网络的背景下,隐藏单元提 供一个“函数”集,该函数集在输入模式向量扩展至隐层空 间时为其构建一个任意的“基”,这个函数集中的函数就被称 为径向基函数。目前,径向基函数多用于函数逼近和分类问 题的研究。 (二)RBF神经网络模型 最基本的径向基函数神经网络包含三层,由一些感知单 元组成的输入层、包含一个具有径向基函数神经元的隐层和 一个具有线性神经原的输出层。 1.RBF径向基神经元模型 径向基函数神经元的传递函数有多种形式,最常用的形 式是高斯函数(radbas)。采用高斯基函数,具备如下优点: ①表示形式简单,即使对于多变量输入也不增加太多的复杂 性;②径向对称;③光滑性好,任意阶导数存在;④由于该 基函数表示简单且解析性好,因而便于进行理论分析。 输入向量p 图1径向基传递函数 径向基网络的神经元模型结构如图2所示。由该图可见, radbas的输入为输入矢量p和权值向量W之间的距离乘以阈 值b。 图2 径向基函数神经元模型 2.RBF神经网络的结构 径向基函数网络包括输入层、隐层和输出层,如图3所 示。输入信号传递到隐层,隐层有S1个神经元,节点函数为 高斯函数;输出层有S2个神经元,节点函数一般采用简单的 线性函数。 图3 径向基函数网络基本结构图 (三)RBF神经网络应用于函数逼近 RBF神经网络在进行函数逼近的实现时,往往在网络设计 之初并不指定隐层神经元的个数,而是在每一次针对样本集 的训练中产生一个径向基神经元,并尽可能最大程度地降低 误差,如果未达到精度要求,则继续增加神经元,直到满足 精度要求或者达到最大神经元数目。这样避免了设计之初存 在隐层神经元过少或者过多的问题。训练过程中,散布常数 的选取非常重要。 1.函数逼近的RBF神经网络 已知输入向量P和输出向量T,通过构建径向基函数神经 网络来进行曲线拟合,从而找到一个函数能够满足这21个数 据点的输入/输出关系,绘制训练样本如图所示。 输入向量P:-1:0.1:1; 输出向量T:0.9500 0.5700 0.0300 -0.2800 -0.5800 -0.6200 -0.4800 -0.1400 0.2100 0.4700 0.5000 0.3800 0.1700 -0.1200 -0.3200 -0.4200 0.3500 -0.1300 0.2120 0.4200 0.5100; 应用MATLAB神经网络工具箱中的newrb()函数快速构建 一个径向基函数网络,并且网络根据输入向量和期望值自动 进行调整,从而实现函数逼近,预先设定均方差精度为0.0001, 散布常数为1。实验结果如图4所示。可见,应用径向基函数 进行函数逼近非常有效。 图4网络输出与目标值比较(下转第19页)【收稿日期】2009-06-02 【作者简介】刘君尧(1979-),女,湖南汨罗人,深圳信息职业技术学院讲师,硕士研究生,研究方向为神经网络。

径向基核函数 (Radial Basis Function)–RBF

径向基核函数 (Radial Basis Function)–RBF 发表于297 天前?技术, 科研?评论数 8?被围观 3526 views+ 论文中又提到了RBF,虽然是个简单的核函数,但是也再总结一下。关于SVM中的核函数的选择,比较简单和应用比较广的是RBF。 所谓径向基函数 (Radial Basis Function 简称 RBF), 就是某种沿径向对称的标量函数。通常定义为空间中任一点x到某一中心xc之间欧氏距离的单调函数 , 可记作 k(||x-xc||), 其作用往往是局部的 , 即当x远离xc时函数取值很小。 最常用的径向基函数是高斯核函数 ,形式为 k(||x-xc||)=exp{- ||x-xc||^2/(2*σ)^2) } 其中xc为核函数中心,σ为函数的宽度参数 , 控制 了函数的径向作用范围。 建议首选RBF核函数,因为: 1.能够实现非线性映射;(线性核函数可以证明是他的一个特例;SIGMOID 核函数在某些参数上近似RBF的功能。) 2.参数的数量影响模型的复杂程度,多项式核函数参数较多。 3.the RBF kernel has less numerical difficulties. ———–那么,还记得为何要选用核函数么?———– 对于这个问题,在Jasper’s Java Jacal博客《SVM入门(七)为何需要核函数》中做了很详细的阐述,另外博主对于SVM德入门学习也是做了很详细的阐述,有兴趣的可以去学习,丕子觉得这个文章写得相当好,特意转载了过来,留念一下。 如果提供的样本线性不可分,结果很简单,线性分类器的求解程序会无限循环,永远也解不出来。这必然使得它的适用范围大大缩小,而它的很多优点我们实在不原意放弃,怎么办呢?是否有某种方法,让线性不可分的数据变得线性可分呢? 例子是下面这张图:

径向基函数网络中的高斯核宽度优化

径向基函数网络中的高斯核宽度的优化 Nabil Benoudjit1, Cédric Archambeau1, Amaury Lendasse2, John Lee1, Michel Verleysen1,? 1 Université Catholique de Louvain - Microelectronics Laboratoy, Place du Levant 3, B-1348 Louvain-la-Neuve, Belgium, Phone : +32-10-47-25-40, Fax : +32-10-47-21-80 Email : {benoudjit, archambeau, lee, verleysen}@dice.ucl.ac.be 2 Université Catholique de Louvain – CESAME, Avenue G. Lema?tre 4, B-1348 Louvain-la-Neuve, Belgium, Email : lendasse@auto.ucl.ac.be 摘要:径向基函数网络经常通过一个三阶段的程序得到训练。在学术文献中,很多论文致力于 对于高斯核位置的估计,以及其权重的计算。同时,也有很少有人关注高斯核宽度的估计。在 本文中,第一,我们提出了一种探索式的优化方法对于高斯核宽度进行优化,以达到改善一般 化训练过程的目的。其次,我们从理论上和实际应用上对我们的方法进行了验证。 1.引言 人工神经网络(ANN)被大量应用于分类估计和函数估计。最近,已经证明很多人工神经网络都是广义函数的近似。因此,他们常被用来进行函数插值。 在人工神经网络分类中,我们发现了径向基函数网络(RBF)和多层感知器(MLP)。两者都是多层网络,而且他们都可以认为是连接器模型。两者都需要通过一个足够大的数据集合学习近似的过程,从而达到被训练的目的。即使这样,径向基网络和多层感知器的训练过程是不一样的。 多层感知器通过一个可控的技术被训练,其方法是:求解一个非线性约束方程集来计算权重集。相反,径向基函数网络的训练方法可以被分解为一个无控的部分和一个可控的线性部分。无控的更新技术是前向而且相对快速的。同时,它的可控部分通过求解一个线性问题实现,因此也是快速的。所以,径向基函数网络的实现方法可以充分的减少运算时间并节约运算资源。 2.径向基网络函数 一个径向基网络函数是一个三层的人工神经网络。考虑一个未知的函数()? x f:,在一个径向基函数网络中,) ?d → f通过一系列d维的径向基函数来近似估 (x