机器学习算法介绍及相关参考文献

Linear Discriminant Analysis

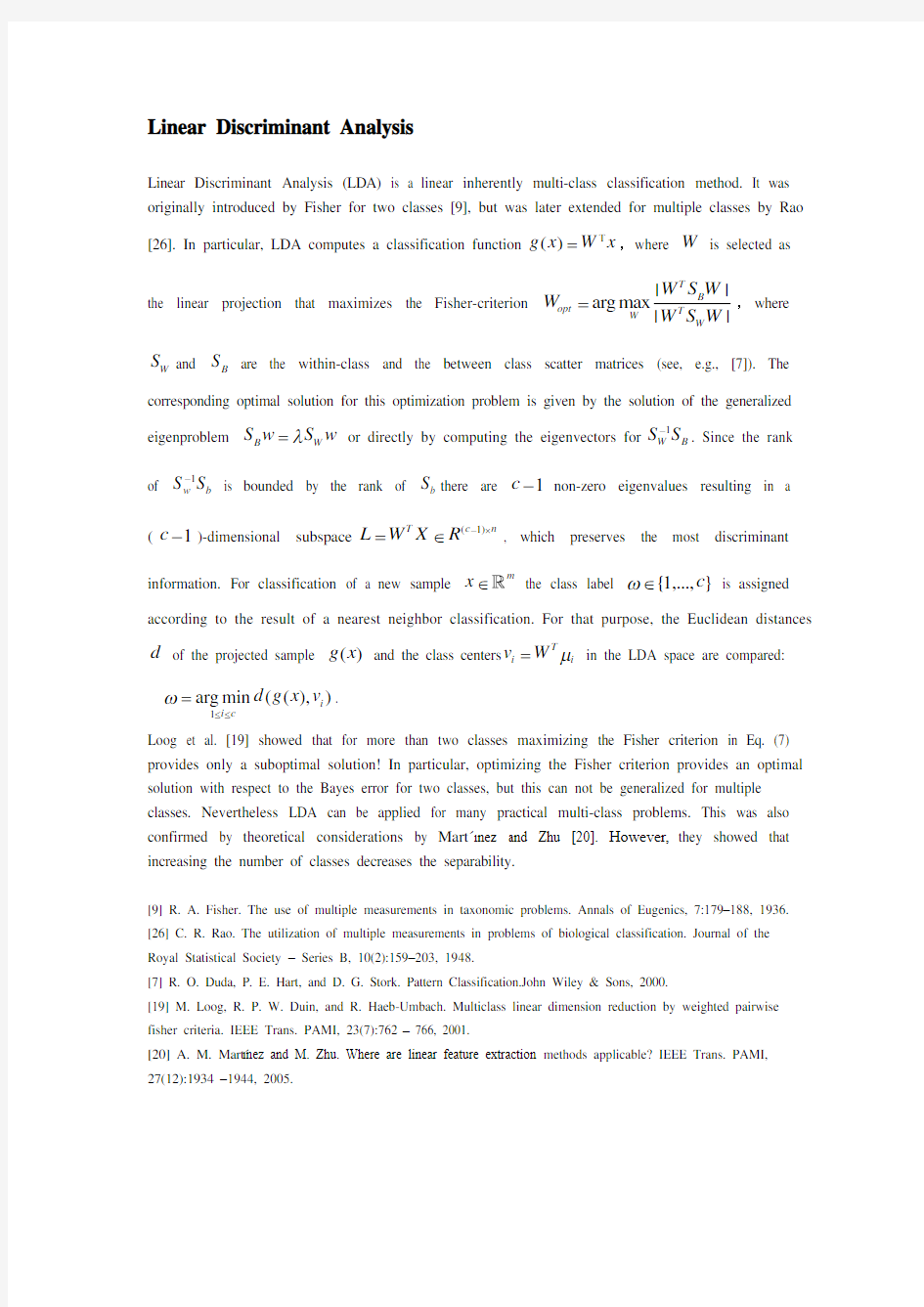

Linear Discriminant Analysis (LDA) is a linear inherently multi-class classification method. It was originally introduced by Fisher for two classes [9], but was later extended for multiple classes by Rao [26]. In particular, LDA computes a classification function

()g x W x T =,where W is selected as the linear projection that maximizes the Fisher-criterion

||

arg max ||T B opt

T

W W

W S W W W S W =,where W S and B S are the within-class and the between class scatter matrices (see, e.g., [7]). The

corresponding optimal solution for this optimization problem is given by the solution of the generalized eigenproblem B W S w S w λ= or directly by computing the eigenvectors for 1

W B S S -. Since the rank

of

1

w b S S - is bounded by the rank of b S there are 1c - non-zero eigenvalues resulting in a

(1c -)-dimensional subspace (1)T

c n

L W X R

-?=∈, which preserves the most discriminant

information. For classification of a new sample m

x ∈

the class label

{1,...,}c ω∈ is assigned

according to the result of a nearest neighbor classification. For that purpose, the Euclidean distances

d of th

e projected sample ()g x and the class centers T i i v W μ= in the LDA space are compared:

1arg min ((),)i i c

d g x v ω≤≤=.

Loog et al. [19] showed that for more than two classes maximizing the Fisher criterion in Eq. (7) provides only a suboptimal solution! In particular, optimizing the Fisher criterion provides an optimal solution with respect to the Bayes error for two classes, but this can not be generalized for multiple classes. Nevertheless LDA can be applied for many practical multi-class problems. This was also confirmed by theoretical considerations by Mart′?nez and Zhu [20]. However, they showed that increasing the number of classes decreases the separability.

[9] R. A. Fisher. The use of multiple measurements in taxonomic problems. Annals of Eugenics, 7:179–188, 1936. [26] C. R. Rao. The utilization of multiple measurements in problems of biological classification. Journal of the Royal Statistical Society – Series B, 10(2):159–203, 1948.

[7] R. O. Duda, P. E. Hart, and D. G. Stork. Pattern Classification.John Wiley & Sons, 2000.

[19] M. Loog, R. P. W. Duin, and R. Haeb-Umbach. Multiclass linear dimension reduction by weighted pairwise fisher criteria. IEEE Trans. PAMI, 23(7):762 – 766, 2001.

[20] A. M. Mart′?nez and M. Zhu. Where are linear feature extraction methods applicable? IEEE Trans. PAMI, 27(12):1934 –1944, 2005.

Multi Kernel Learning

Recently, Multiple Kernel Learning (MKL) [25, 16, 29] has become a quite popular method to combine data from multiple information sources. The main idea is to create a weighted linear combination of the kernels obtained from each information source. Moreover, in Rakotomamonjy etal. [25] it was shown that by using multiple kernels instead of one a more effective decision function can be obtained. In particular, the kernel (,)x x 'K can be considered a convex combination of M

basis kernels

(,)j x x 'K :1

(,)(,)M

j j j K x x d K x x =''=∑, where 0j d ≥ are the weights of the kernels

j K and

1

1M j j d ==∑

. Thus, the decision function ()g x of an SVM with multiple kernels can be

represented as

1

()(,)N

i i i i g x y K x x b α==-∑

1

1

(,)N M

i i j j i i j y d K x x b α=='=-∑∑,

where

i x are the training samples and {1,1}i y ∈-+ are the corresponding class labels. Hence,

when training an MKL model the goal is to learn both, the coefficients i α and the weights m d , in

parallel.

[25] A. Rakotomamonjy, F. R. Bach, S. Canu, and Y. Grandvalet. SimpleMKL. J. of Machine Learning Research, 9:2491–2521, 2008.

[16] G. R. G. Lanckriet, T. d. Bie, N. Cristianini, M. I. Jordan, and W. S. Noble. A statistical framework for genomic data fusion. Bioinformatics, 20(16):2626–2635, 2004.

[29] S. Sonnenburg, B. S. Bernhard, P. Bennett, and E. ParradoHern′andez. Large scale multiple kernel learning. J. of Machine Learning Research, 7, 2006.

AdaBoost Learning

AdaBoost [6] is a popular machine learning method combining properties of an efficient classifier and feature selection. The discrete version of AdaBoost defines a strong binary classifier H

1

()sgn(())T t t t H z h z α==∑1

()sgn(())T

t t t H z h z α==∑

using a weighted combination of T weak learners h t with weights a t . At each new round t, AdaBoost selects a new hypothesis

t h that best classifies training samples with high classification error in the

previous rounds. Each weak learner

may explore any feature f of the data z. In the context of visual object recognition it is attractive to define f in terms of local image properties over image regions r and then use AdaBoost for selecting features maximizing the classification performance. This idea was first explored by Viola and Jones

Adaboost 算法是1995年由Yoav Freund 和Robert E .Schapire 提出的,是目前最具实用价值的机器学习方法之一,它是一种迭代的学习方法,可以将一组弱学习算法提升为一个强学习算法。Adaboost 算法本身是通过改变数据分布来实现的,它根据每次训练集中每个样本的分类是否正确,以及上次的总体分类准确率,来确定每个样本的权值,将每次训练得到的弱分类器最后融合起来,作为最后的决策分类器。这里所说的弱分类器是指它的分类结果应该比随机猜想的准确性稍高,即准确率大于50, 随着弱分类器个数的增加,最终集成的强分类器的错误率将趋近于零[6].

行人检测问题实质上是一个两类分类问题,其检测结果只有人和非人两种。本文采用了一种改进的Adaboost 算法,该算法的特点是使每一个弱分类器对应于一个特征,根据错误率最小的原则选择弱分类器,即在。Freund 提出的Adaboost 算法的迭代过程中计算针对样本集的分类最小错误率选择弱分类器。该算法的简单描述如下:

定义X 表示样本空间,Y 表示样本类别标识集合,此处限定{1,0}Y =,分别对应样本的正和负。假定共有K 个特征。已知1122(,),(,),(,)N N x y x y x y ???构成训练样本集,其中

,i i x X y Y ∈∈,假设样本集中共有p N 个正样本,n N 个负样本,p n N N N +=。

1. 初始化样本权重

1,1,1

12112i N

p

i i i i n

x N x N ωω=???==?

???∑为正样本,为负样本

2. for t=1,2,…,T(T 为最大训练轮数) (1)归一化样本权重分布:

j v ,,,1

,

1,2,,t i

t i N

t i

i i N ωωω

==

=???∑

(2)对于每个特征,在给定的样本权重分布下训练弱分类器

,1()0t j t j

t j p v p f x otherwise

θ

? 其中j v 为第j 个特征值,,,,1

|()|,1,2,,N

t j

t i t j i i i e f x y j K ω==-=???∑为阈值,{1,1}i p ∈-表示

不等号的偏置方向,1,2,,j K =???。

(3)计算每个弱分类器对样本集的分类错误率:

,,,1

|()|,1,2,,N

t j t i t j i i i e f x y j K ω==-=???∑

(4)选择第t 轮训练的最优弱分类器()t h x : 令,arg min t j j

k e =,则,()()t t k h x f x =

,并且对样本集的分类错误率,t t k e ζ=

(5)更新样本权重:

11,,,

1,2,,t

t i t i t i N εωωβ-+==??? (4)

若i x 被t h 正确分类,则0t ε=,否则1t ε=,其中1t t t

ζβζ=

-

3. 最终强分类器

最终的强分类器由T 个弱分类器线性叠加而成:

1

ln

t t

αβ

=1

2

1

1

1

()()0T T t t t

t t r h x H x otherwise

αα==?≥?=?

??∑

∑

(5)

其中1r r ?+

单个强分类器训练过程

由于特征数目巨大,若按照传统的Adaboost 算法, 分类器的训练过程是非常耗时的,故此对训练过程引入以下3点改进: (1) 特征筛选:传统的Adaboost 算法在每一轮的训练过程中遍历所有弱分类器,然后挑出一个最优的弱分类器。由于矩形特征数目庞大,且性能参差不齐,故此在训练之前在初始权重情况下先进行一次特征筛选,挑选一批性能较高的弱分类器。选取的原则为0.4t e <,然后进行Adaboost 的训练过程。特征筛选用在层状分类器的前几层是尤为重要的,因为前几层强分类器的设计原则就是集合少量性能较高的弱分类器,提高检测速度,剔除非行人样本。 (2)阈值选取:传统的Adaboost 算法在弱分类器的最优阈值j θ选取上也是采用大范围数值遍历的方法。对单个特征()j v x 而言,所有的训练样本对于此特征的特征值可表示为

123(),(),(),()j j j j n v x v x v x v x ???,因此只要求得min ()j i i

v x 和max ()j i i

v x ,1,2,,i n =???,最

优阈值j θ只需在区间[min ()j i i

v x ,max ()j i i

v x ]内遍历寻找即可,从而缩小遍历空间,减少

训练时间。

(3)权重更新:传统的Adaboost 算法在每轮训练过程后都需要进行样本权重更新,以加重对错误分类的样本的关注度。但是随着训练轮数不断增加, 由式(4)可知,已经被正确分类的样本的权重会不断减小,从而导致分类器对其关注度逐渐减小,很可能逐渐破坏已经生成的较准确的分类规则,因此限制部分困难样本的权重扩张是非常必要的。假设每轮训练后的 正负样本权重之和分别为,|0

n

i N n t i

i y S ω

==

∑,,|1

p

i N p t i

i y S ω

==

∑,限定:1n p S S =。式(4) 中的样本

权重更新将在各自的目标类内进行。这样可以保持已经生成的较为准确的分类规则,减少分类器训练的轮数,从而提高检测速度。 层状分类器设计

层状分类器设计的原则是保证正样本检测率(99.5%)不变的情况下,逐层减小负样本的错检率。训练过程中正样本不变,在该层被正确分类的负样本将被剔除,重新加入新的负样本,作为下一层分类器训练集中的负样本。前端强分类器设计的目的就是尽可能的排除非人样本,因此要求该分类器结构简单,检测速度快, 由于Adaboost 算法中每层的强分类器的阈值是最优选定的(式(5)),为了保证以最少的弱分类器构造强分类器,可能需要手动调整每层强分类器的阈值,以达到对正样本预定的检测率。越往后的分类器结构越复杂,就需要大量的弱分类器来构造,以提高样本整体的检测性能。 由算法的训练过程可知,当已经获得的分类器对于某些样本分类正确,那么减小这些样本的

权重;当分类错误,增加这些样本的权重 J 。这样,后面训练提取的简单分类器就会更加强化对这些分类错误样本的训练。最终,通过权重组合所有的弱分类器以形成强分类器.

多检测窗口合并

由于检测器对尺度变化和位置平移较为敏感,可能导致对同一目标产生多个检测结果的现象发生,因此需要引入检测窗口的合并以将这些重叠的窗口合并为一个。合并的原则较为简单,如果两个矩形1R 和2R 相交的面积S 与两个矩形面积的比值均大于0.6,那么就将这两个矩形求其平均窗口合并为一个矩形,否则视其为两个不同的目标。

[18] who used AdaBoost to train an efficient face detector by selecting a discriminative set of local Haar features.

[6] Y. Freund and R. E. Schapire. A decision-theoretic generalization of on-line learning and an application to boosting. J. of Comp. and Sys. Sc., 55(1):119–139, 1997.

[18] P. Viola and M. Jones. Rapid object detection using a boosted cascade of simple features. In Proc. CVPR, pages I:511-518, 2001.

机器学习10大算法-周辉

机器学习10大算法 什么是机器学习呢? 从广泛的概念来说,机器学习是人工智能的一个子集。人工智能旨在使计算机更智能化,而机器学习已经证明了如何做到这一点。简而言之,机器学习是人工智能的应用。通过使用从数据中反复学习到的算法,机器学习可以改进计算机的功能,而无需进行明确的编程。 机器学习中的算法有哪些? 如果你是一个数据科学家或机器学习的狂热爱好者,你可以根据机器学习算法的类别来学习。机器学习算法主要有三大类:监督学习、无监督学习和强化学习。 监督学习 使用预定义的“训练示例”集合,训练系统,便于其在新数据被馈送时也能得出结论。系统一直被训练,直到达到所需的精度水平。 无监督学习 给系统一堆无标签数据,它必须自己检测模式和关系。系统要用推断功能来描述未分类数据的模式。 强化学习 强化学习其实是一个连续决策的过程,这个过程有点像有监督学习,只是标注数据不是预先准备好的,而是通过一个过程来回调整,并给出“标注数据”。

机器学习三大类别中常用的算法如下: 1. 线性回归 工作原理:该算法可以按其权重可视化。但问题是,当你无法真正衡量它时,必须通过观察其高度和宽度来做一些猜测。通过这种可视化的分析,可以获取一个结果。 回归线,由Y = a * X + b表示。 Y =因变量;a=斜率;X =自变量;b=截距。 通过减少数据点和回归线间距离的平方差的总和,可以导出系数a和b。 2. 逻辑回归 根据一组独立变量,估计离散值。它通过将数据匹配到logit函数来帮助预测事件。 下列方法用于临时的逻辑回归模型: 添加交互项。 消除功能。 正则化技术。 使用非线性模型。 3. 决策树 利用监督学习算法对问题进行分类。决策树是一种支持工具,它使用树状图来决定决策或可能的后果、机会事件结果、资源成本和实用程序。根据独立变量,将其划分为两个或多个同构集。 决策树的基本原理:根据一些feature 进行分类,每个节点提一个问题,通过判断,将数据分为两类,再继续提问。这些问题是根据已有数据学习出来的,再投

机器学习-PLA算法

最近在跟台大的这个课程,觉得不错,想把学习笔记发出来跟大家分享下,有错误希望大家指正。 一机器学习是什么? 感觉和 Tom M. Mitchell的定义几乎一致, A computer program is said to learn from experience E with respect to some class of tasks T and performance measure P, if its performance at tasks in T, as measured by P, improves with experience E. 简而言之,就是我们想要机器在某些方面有提高(如搜索排名的质量,即NDCG提高),就给机器一些数据(用户的点击数据等各种)然后让机器获得某些经验(Learning to rank的一种模型,也就是数学公式)。这里有点需要强调,那就是提高指标,必须要有某种指标可以量化这种提高,这点还是很关键的,工业界做机器学习,首先关注data,其次就是有无成型的measurement,可以使Precision/Recall,也可以是NDCG等。 二什么时候可以用机器学习?

其实就三要素: 1.有规律可以学习; 2.编程很难做到; 3.有能够学习到规律的数据; 编程很难做到可以有多种,大部分原因是系统太复杂,很难用Rule-based 的东西去解决,例如搜索排名,现在影响排名的因素有超多几百种,不可能去想出这些因素的规则,因此,这时候用机器学习就是恰到好处。特别是移动互联网的今天,用户更容易接触互联网,产生的数据越来越多,那么要找到某些不容易实现的规律,用机器学习就是很好的了,这也是为啥机器学习这么火,其实我学机器学习不仅仅是一种投资(肯定它未来的发展前途),我想做的事情还有一点,就是通过它更深刻的理解人脑的学习过程,提高自己的学习效率和思维能力。 三具体如何用机器学习?

机器学习综述

机器学习综述 摘要:为了对高层次结构的抽象的表示,需要有能够对深层结构学习的模型。深层结构是由非线性的多层次组成,如神经网络有许多隐藏的层。深层结构的参数优化是一项困难的任务,例如最近提出的深信念网络(DBN)学习算法很好解决了该问题并取得了一定的成功。深度学习是机器学习中一个非常接近AI的领域,其动机在于建立、模拟人脑进行分析学习的神经网络。 关键词:神经网络,无监督,深度学习,AI 1 引言 机器学习的核心是学习。机器学习的研究主旨是使用计算机模拟人类的学习活动,它是研究计算机识别现有知识、获取新知识、不断改善性能和实现自身完善的方法。机器学习研究的就是如何使机器通过识别和利用现有知识来获取新知识和新技能。它是人工智能的一个重要的研究领域。这里的学习意味着从数据中学习, 它包括有监督学习( Supervised Learning )、无监督学习( Unsupervised Learning) 和半监督学习( Semi- Supervised Learning )三种类别。 目前在机器学习研究领域影响较大的是H. Simon 的观点:学习是系统中的任何改进,这种改进使得系统在重复同样的工作或进行类似的工作时,能完成得更好。学习的基本模型就是基于这一观点建立起来的。 深度学习是机器学习研究中的一个新的领域,其动机在于建立、模拟人脑进行分析学习的神经网络,它模仿人脑的机制来解释数据,例如图像,声音和文本。深度学习是无监督学习的一种。深度学习的概念源于人工神经网络的研究。含多隐层的多层感知器就是一种深度学习结构。深度学习通过组合低层特征形成更加抽象的高层表示属性类别或特征,以发现数据的分布式特征表示。 深度学习的概念由Hinton等人于2006年提出。基于深信度网(DBN)提出非监督贪心逐层训练算法,为解决深层结构相关的优化难题带来希望,随后提出多层自动编码器深层结构。此外Lecun等人提出的卷积神经网络是第一个真正多层结构学习算法,它利用空间相对关系减少参数数目以提高训练性能。 深度学习中的主要困难,特别是在模式分类运用中,在数据的维数中学习的复杂性呈指数的线性增长。主流的方法是克服“维数灾难”,通过使用预处理数据的方式,这样能够降维以至于更够有效的处理。降维指的是特征提取,结果可

机器学习算法分类与趋势分析

机器学习算法分类与趋势分析

机器学习算法的分类是棘手的,有几种合理的分类,他们可以分为生成/识别,参数/非参数,监督/无监督等。 例如,Scikit-Learn的文档页面通过学习机制对算法进行分组。这产生类别如:1,广义线性模型,2,支持向量机,3,最近邻居法,4,决策树,5,神经网络等 但从我们的经验来看,这并不总是算法分组最为实用的方法。那是因为对于应用机器学习,你通常不会想,“今天我要训练一个支持向量机!”相反,你心里通常有一个最终目标,如利用它来预测结果或分类观察。 所以在机器学习中,有一种叫做“没有免费的午餐”的定理。简而言之,它的意思就是说没有任何一种算法可以完美地解决每个问题,这对于监督式学习(即预测性建模)尤其重要。 例如,你不能说神经网络总是比决策树好,反之亦然。有很多因素在起作用,比如数据集的大小和结构。因此,您应该为您的问题尝试许多不同的算法,同时使用数据的“测试集”来评估性能并选择优胜者。 当然,你尝试的算法必须适合你的问题,这就是选择正确的机器学习算法的重要性之所在。打个比方,如果你需要清理你的房子,你可以使用真空吸尘器,扫帚或拖把,但是你不会拿出一把铲子然后开始挖掘。

因此,我们想要介绍另一种分类算法的方法,即通过机器学习所负责的任务来分类。 机器学习的任务 1.回归 回归是一种用于建模和预测连续数值变量的监督学习任务。例如预测房地产价格,股价变动或学生考试分数。 回归任务的特征是具有数字目标变量的标记数据集。换句话说,对于每个可用于监督算法的观察结果,您都有一些“基于事实”的数值。

1.1。(正则化)线性回归 线性回归是回归任务中最常用的算法之一。它最简单的形式是试图将一个直的超平面整合到你的数据集中(即当你只有两个变量的时候,你只能得到一条直线)。正如您可能猜到的那样,当数据集的变量之间存在线性关系时,它的效果是非常好的。 实际上,简单的线性回归经常被正则化的同类算法(LASSO,Ridge和Elastic-Net)所忽略。正则化是一种惩罚大系数的技术,以避免过度拟合,它应该调整其惩罚的力度。

机器学习的十种经典算法详解

机器学习的十种经典算法详解 毫无疑问,近些年机器学习和人工智能领域受到了越来越多的关注。随着大数据成为当下工业界最火爆的技术趋势,机器学习也借助大数据在预测和推荐方面取得了惊人的成绩。比较有名的机器学习案例包括Netflix根据用户历史浏览行为给用户推荐电影,亚马逊基于用户的历史购买行为来推荐图书。那么,如果你想要学习机器学习的算法,该如何入门呢?就我而言,我的入门课程是在哥本哈根留学时选修的人工智能课程。老师是丹麦科技大学应用数学和计算机专业的全职教授,他的研究方向是逻辑学和人工智能,主要是用逻辑学的方法来建模。课程包括了理论/核心概念的探讨和动手实践两个部分。我们使用的教材是人工智能的经典书籍之一:Peter Norvig教授的《人工智能——一种现代方法》,课程涉及到了智能代理、基于搜索的求解、对抗搜索、概率论、多代理系统、社交化人工智能,以及人工智能的伦理和未来等话题。在课程的后期,我们三个人还组队做了编程项目,实现了基于搜索的简单算法来解决虚拟环境下的交通运输任务。我从课程中学到了非常多的知识,并且打算在这个专题里继续深入学习。在过去几周内,我参与了旧金山地区的多场深度学习、神经网络和数据架构的演讲——还有一场众多知名教授云集的机器学习会议。最重要的是,我在六月初注册了Udacity的《机器学习导论》在线课程,并且在几天前学完了课程内容。在本文中,我想分享几个我从课程中学到的常用机器学习算法。机器学习算法通常可以被分为三大类——监督式学习,非监督式学习和强化学习。监督式学习主要用于一部分数据集(训练数据)有某些可以获取的熟悉(标签),但剩余的样本缺失并且需要预测的场景。非监督式学习主要用于从未标注数据集中挖掘相互之间的隐含关系。强化学习介于两者之间——每一步预测或者行为都或多或少有一些反馈信息,但是却没有准确的标签或者错误提示。由于这是入门级的课程,并没有提及强化学习,但我希望监督式学习和非监督式学习的十个算法足够吊起你的胃口了。监督式学习1.决策树:决策树是一种决策支持工具,它使用树状图或者树状模型来表示决策过程以及后续得到的结果,包括概率事件结果等。请观察下图来理解决策树的结构。 从商业决策的角度来看,决策树就是通过尽可能少的是非判断问题来预测决策正确的概

人工智能之机器学习常见算法

人工智能之机器学习常见算法 摘要机器学习无疑是当前数据分析领域的一个热点内容。很多人在平时的工作中都或多或少会用到机器学习的算法。这里小编为您总结一下常见的机器学习算法,以供您在工作和学习中参考。 机器学习的算法很多。很多时候困惑人们都是,很多算法是一类算法,而有些算法又是从其他算法中延伸出来的。这里,我们从两个方面来给大家介绍,第一个方面是学习的方式,第二个方面是算法的类似性。 学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为训练数据,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中垃圾邮件非垃圾邮件,对手写数字识别中的1,2,3,4等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与训练数据的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(LogisTIc Regression)和反向传递神经网络(Back PropagaTIon Neural Network) 非监督式学习: 在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means 算法。 半监督式学习: 在此学习方式下,输入数据部分被标识,部分没有被标识,这种学习模型可以用来进行预

机器学习常见算法分类汇总

机器学习常见算法分类汇总 ?作者:王萌 ?星期三, 六月25, 2014 ?Big Data, 大数据, 应用, 热点, 计算 ?10条评论 机器学习无疑是当前数据分析领域的一个热点内容。很多人在平时的工作中都或多或少会用到机器学习的算法。这里IT经理网为您总结一下常见的机器学习算法,以供您在工作和学习中参考。 机器学习的算法很多。很多时候困惑人们都是,很多算法是一类算法,而有些算法又是从其他算法中延伸出来的。这里,我们从两个方面来给大家介绍,第一个方面是学习的方式,第二个方面是算法的类似性。 学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习:

在监督式学习下,输入数据被称为“训练数据”,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中“垃圾邮件”“非垃圾邮件”,对手写数字识别中的“1“,”2“,”3“,”4“等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与“训练数据”的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(Logistic Regression)和反向传递神经网络(Back Propagation Neural Network) 非监督式学习: 在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means算法。 半监督式学习:

机器学习算法简介

决策树算法: 1.算法简介 决策树是一种简单高效并且具有强解释性的模型,广泛应用于数据分析领域。其本质是一颗自上而下的由多个判断节点组成的树。 2.算法示意: 图1 决策树示意图 3.算法示例: 预测小明今天出不出门打球 图2 训练数据 图3 训练生成的决策树 4.对应的场景 故障预测中,通过决策树算法对带标签的历史数据进行训练,自动分类出哪些是故障数据哪些是正常数据。

基于最小生成树的k中心点算法: 1.算法简介 基于最小生成树的K中心点(K-mediods)算法是一种聚类算法,由K中心点(K-mediods)算法衍生而来,而K中心点算法是由K-means算法衍生而来。其中聚类算法是能够将具有相似属性的一组数据归为一类的一种算法。 K-means算法的思想是,对于给定的样本集,按照样本之间的距离大小,将样本集划分为K个簇。让簇内的点尽量紧密的连在一起,而让簇间的距离尽量的大。而K中心点算法通过对K-means算法计算簇的方法加以改进得来,基于最小生成树的K中心点算法通过对K 中心点算法求取初始中心点的方法改进得来。 2.算法示意 图4 K-means算法示意图 图5 基于最小生成树的k中心点算法示意图 3.对应场景 故障拓扑关联中通过基于最小生成树的k中心点算法动态计算故障阈值,这样可以令机器自动识别哪些是故障数据哪些是正常数据,可避免人工干预,提高工作效率。 Apriori算法: 1.算法简介 Apriori算法是一种挖掘关联规则的频繁项集算法,其核心思想是通过候选集生成和情节的向下封闭检测两个阶段来挖掘频繁项集。 Apriori算法的基本思想是:首先找出所有的频集,这些项集出现的频繁性至少和预定义的最小支持度一样。然后由频集产生强关联规则,这些规则必须满足最小支持度和最小可信度。然后使用第1步找到的频集产生期望的规则,产生只包含集合的项的所有规则,其中每一条规则的右部只有一项,这里采用的是中规则的定义。一旦这些规则被生成,那么只有那

机器学习概述

龙源期刊网 https://www.360docs.net/doc/e0387065.html, 机器学习概述 作者:李炜 来源:《科技视界》2017年第12期 【摘要】机器学习成为人工智能、模式识别领域的共同研究热点,其理论方法已经被广 泛应用于解决实际工程应用及科学领域的复杂问题。随着技术的快速发展,以统计为基础的机器学习受到人们的关注,并在语音、自然语言、视觉等领域获得成功应用。本文主要阐述了机器学习的分类,介绍几种常用的机器学习方法。 【关键词】机器学习分类;人工智能;P-N Leraning 0 概述 机器学习是实现人工智能领域的一个重要的研究分支,其研究的主要内容是实现利用计算机程序让带有处理器及计算功能的机器可以随着经验的增加提高处理问题的性能。目前,机器学习的理论已经被广泛的应用到,如智能视频监控、生物识别、无人驾驶等各个领域。 1 机器学习的发展及分类 机器学习基本上可分为 4 个阶段。第一阶段:上世纪 50 年代到 60 年代中期,系统通过自身不断的学习输入、输出反馈,完善系统参数及本身的性能。第二阶段:从 1960 年代中叶到70 年代中,该阶段主要是对系统结构的研究,如通过逻辑结构或者图结构来解释描述机器内 部结构。第三阶段的时间是从上世纪 70 年代中到 80 年代中期,主要通过研究学习策略和学习方法来提高改善学习的效率,同时引入知识数据库,此阶段机器学习取得了长足的发展;1986 年至今,神经网络的引入,及人工智能的需要,人们对机器学了得连接机制进行了研 究。 目前机器学习领域的研究一般可分四类,即无监督学习、监督学习、半监督学习以及增强学习[1-2]。 1.1 无监督学习 无监督学习是一种自学习的分类方式,对没标记的训练样本进行学习,发掘未知数据间隐藏的结构关系。无监督学习和核密度估计方法非常相似。常用的无监督学习有关联规则学习和聚类学习 1.2 监督学习 监督学习是有人工参与的一种学习。监督学习一般分为 3 步,第一标记样本,第二训练,第三模型概率估计。其大概过程如下:(1)输入样本的特征向量和样本类别标记,(2)训

机器学习十大算法的每个算法的核心思想、工作原理、适用情况及优缺点

5-1简述机器学习十大算法的每个算法的核心思想、工作原理、适用情况及优缺点等。 1)C4.5算法: ID3算法是以信息论为基础,以信息熵和信息增益度为衡量标准,从而实现对数据的归纳分类。ID3算法计算每个属性的信息增益,并选取具有最高增益的属性作为给定的测试属性。 C4.5算法核心思想是ID3算法,是ID3算法的改进,改进方面有: 1)用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2)在树构造过程中进行剪枝 3)能处理非离散的数据 4)能处理不完整的数据 C4.5算法优点:产生的分类规则易于理解,准确率较高。 缺点: 1)在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算 法的低效。 2)C4.5只适合于能够驻留于内存的数据集,当训练集大得无法在内存容纳时程 序无法运行。 2)K means 算法: 是一个简单的聚类算法,把n的对象根据他们的属性分为k个分割,k < n。算法的核心就是要优化失真函数J,使其收敛到局部最小值但不是全局最小值。 ,其中N为样本数,K是簇数,r nk b表示n属于第k个簇,u k是第k个中心点的值。 然后求出最优的u k 优点:算法速度很快 缺点是,分组的数目k是一个输入参数,不合适的k可能返回较差的结果。 3)朴素贝叶斯算法: 朴素贝叶斯法是基于贝叶斯定理与特征条件独立假设的分类方法。算法的基础是概率问题,分类原理是通过某对象的先验概率,利用贝叶斯公式计算出其后验概率,即该对象属于某一类的概率,选择具有最大后验概率的类作为该对象所属的类。朴素贝叶斯假设是约束性很强的假设,假设特征条件独立,但朴素贝叶斯算法简单,快速,具有较小的出错率。 在朴素贝叶斯的应用中,主要研究了电子邮件过滤以及文本分类研究。

机器学习算法汇总:人工神经网络、深度学习及其它

学习方式 根据数据类型的不同,对一个问题的建模有不同的方式。在机器学习或者人工智能领域,人们首先会考虑算法的学习方式。在机器学习领域,有几种主要的学习方式。将算法按照学习方式分类是一个不错的想法,这样可以让人们在建模和算法选择的时候考虑能根据输入数据来选择最合适的算法来获得最好的结果。 监督式学习: 在监督式学习下,输入数据被称为“训练数据”,每组训练数据有一个明确的标识或结果,如对防垃圾邮件系统中“垃圾邮件”“非垃圾邮件”,对手写数字识别中的“1“,”2“,”3“,”4“等。在建立预测模型的时候,监督式学习建立一个学习过程,将预测结果与“训练数据”的实际结果进行比较,不断的调整预测模型,直到模型的预测结果达到一个预期的准确率。监督式学习的常见应用场景如分类问题和回归问题。常见算法有逻辑回归(Logistic Regression)和反向传递神经网络(Back Propagation Neural Network) 非监督式学习:

在非监督式学习中,数据并不被特别标识,学习模型是为了推断出数据的一些内在结构。常见的应用场景包括关联规则的学习以及聚类等。常见算法包括Apriori算法以及k-Means算法。 半监督式学习: 在此学习方式下,输入数据部分被标识,部分没有被标识,这种学习模型可以用来进行预测,但是模型首先需要学习数据的内在结构以便合理的组织数据来进行预测。应用场景包括分类和回归,算法包括一些对常用监督式学习算法的延伸,这些算法首先试图对未标识数据进行建模,在此基础上再对标识的数据进行预测。如图论推理算法(Graph Inference)或者拉普拉斯支持向量机(Laplacian SVM.)等。 强化学习:

面向对象方法学概述资料

9.1 面向对象方法学概述 9.2 面向对象的概念 9.3 面向对象建模 9.4 对象模型 9.5 动态模型 9.6 功能模型 9.7 3种模型之间的关系 传统的软件工程方法学曾经给软件产业带来巨大进步,部分地缓解了软件危机,使用这种方法学开发的许多中、小规模软件项目都获得了成功。但是,人们也注意到当把这种方法学应用于大型软件产品的开发时,似乎很少取得成功。 在20世纪60年代后期出现的面向对象编程语言Simula-67中首次引入了类和对象的概念,自20世纪80年代中期起,人们开始注重面向对象分析和设计的研究,逐步形成了面向对象方法学。到了20世纪90年代,面向对象方法学已经成为人们在开发软件时首选的范型。面向对象技术已成为当前最好的软件开发技术。 9.1 面向对象方法学概述 9.1.1 面向对象方法学的要点 面向对象方法学的出发点和基本原则,是尽可能模拟人类习惯的思维方式,使开发软件的方法与过程尽可能接近人类认识世界解决问题的方法与过程,也就是使描述问题的问题空间(也称为问题域)与实现解法的解空间(也称为求解域)在结构上尽可能一致。 面向对象方法学所提供的“对象”概念,是让软件开发者自己定义或选取解空间对象,然后把软件系统作为一系列离散的解空间对象的集合。应该使这些解空间对象与问题空间对象尽可能一致。这些解空间对象彼此间通过发送消息而相互作用,从而得出问题的解。也就是说,面向对象方法是一种新的思维方法,它是把程序看作是相互协作而又彼此独立的对象的集合。

概括地说,面向对象方法具有下述4个要点: (1) 认为客观世界是由各种对象组成的,任何事物都是对象,复杂的对象可以由比较简单的对象以某种方式组合而成。按照这种观点,可以认为整个世界就是一个最复杂的对象。因此,面向对象的软件系统是由对象组成的,软件中的任何元素都是对象,复杂的软件对象由比较简单的对象组合而成。 由此可见,面向对象方法用对象分解取代了传统方法的功能分解。 (2) 把所有对象都划分成各种对象类(简称为类,class),每个对象类都定义了一组数据和一组方法。数据用于表示对象的静态属性,是对象的状态信息。因此,每当建立该对象类的一个新实例时,就按照类中对数据的定义为这个新对象生成一组专用的数据,以便描述该对象独特的属性值。 (3) 按照子类(或称为派生类)与父类(或称为基类)的关系,把若干个对象类组成一个层次结构的系统(也称为类等级)。在这种层次结构中,通常下层的派生类具有和上层的基类相同的特性(包括数据和方法),这种现象称为继承(inheritance)。 (4) 对象彼此之间仅能通过传递消息互相联系。对象与传统的数据有本质区别,它不是被动地等待外界对它施加操作,相反,它是进行处理的主体,必须发消息请求它执行它的某个操作,处理它的私有数据,而不能从外界直接对它的私有数据进行操作。 重点:如果仅使用对象和消息,则这种方法可以称为基于对象的(object-based)方法,而不能称为面向对象的方法;如果进一步要求把所有对象都划分为类,则这种方法可称为基于类的(class-based)方法,但仍然不是面向对象的方法。只有同时使用对象、类、继承和消息的方法,才是真正面向对象的方法。 9.1.2 面向对象方法学的优点 1. 与人类习惯的思维方法一致 2. 稳定性好 3. 可重用性好(重点) 用已有的零部件装配新的产品,是典型的重用技术,例如,可以用已有的预制件建筑一幢结构和外形都不同于从前的新大楼。重用是提高生产率的最主要的方法。

分享最适合新手入门的10种机器学习算法

分享最适合新手入门的10种机器学习算法 编者按:Medium博主James Le近日在网络上分享了他认为的最适合新手的机器学习算法,并授权论智进行编译。以下是我们对原文的编译,如有错误还请指出。 在机器学习界,有这样一个“没有免费午餐”的定理。简单地说,该理论认为,没有一种算法能解决所有问题,尤其对监督学习而言。 例如,你不能认为神经网络总比决策树要好,或决策树永远优于神经网络。这其中还有许多因素需要考虑,比如你的数据量大小和数据结构。 这样就导致我们在面对一个问题时需要尝试不同的算法,同时还要用测试的数据集来评估算法的性能,选出最合适的那一种。 当然,你所选的算法必须适合你的问题,就像当我们需要清理房子的时候,可以使用吸尘器、扫把或拖把,但不会用铲子来挖地。 首要原则 然而,在为监督式机器学习创建预测模型之前,要记得一条最重要的原则: 机器学习算法可以看做学习一种目标函数(f),该函数是输入变量(X)到输出变量(Y)的完美映射:Y=f(X) 这是一个通用的学习任务,我们希望用新输入的变量(X)能输出预测变量(Y)。我们不知道函数(f)是什么样子的,或者什么形式的。如果我们知道的话就直接使用了,不需要再用机器学习算法从大量的数据中学习它。 最常见的机器学习类型是学习映射Y=f(X),用它来预测Y的值。这被称为预测建模或预测分析,我们的目标是做出最准确的预测。 对于想了解机器学习基础知识的新手,以下是数据科学家最常用的10种机器学习算法。 1.线性回归 线性回归也许是数据科学和机器学习中最知名、最好理解的算法了吧。 预测建模主要关注的是,以可解释性为基础,将模型的误差降到最小并尽量作出最准确的预测。我们将借鉴、多次使用甚至“窃取”包括数据统计在内的多个不同领域的算法,从

机器学习算法介绍整理

机器学习 有三种主要类型的机器学习:监督学习、非监督学习和强化学习 监督学习 一组标记数据。计识别每种标记的新样本。监督学习的两种主要类型是分类和回归。 在分类中,机器被训练成将一个组划分为特定的类。分类的一个简单例子是电子邮件帐户上的垃圾邮件过滤器。 在回归中,机器使用先前的(标记的)数据来预测未来。天气应用是回归的好例子。使用气象事件的历史数据(即平均气温、湿度和降水量),你的手机天气应用程序可以查看当前天气,并在未来的时间内对天气进行预测。 无监督学习 数据是无标签的。由于大多数真实世界的数据都没有标签,这些算法特别有用。无监督学习分为聚类和降维。聚类用于根据属性和行为对象进行分组。这与分类不同,因为这些组不是你提供的。聚类的一个例子是将一个组划分成不同的子组(例如,基于年龄和婚姻状况),然后应用到有针对性的营销方案中。降维通过找到共同点来减少数据集的变量。大多数大数据可视化使用降维来识别趋势和规则。 强化学习 使用机器的个人历史和经验来做出决定。强化学习的经典应用是玩游戏。与监督和非监督学习不同,强化学习不涉及提供“正确的”答案或输出。相反,它只关注性能。这反映了人类是如何根据积极和消极的结果学习的。很快就学会了不要重复这一动作。同样的道理,一台下棋的电脑可以学会不把它的国王移到对手的棋子可以进入的空间。然后,国际象棋的这一基本教训就可以被扩展和推断出来,直到机器能够打(并最终击败)人类顶级玩家为止。 回归算法 这可能是最流行的机器学习算法,线性回归算法是基于连续变量预测特定结果的监督学习算法。另一方面,Logistic回归专门用来预测离散值。这两种(以及所有其他回归算法)都以它们的速度而闻名,它们一直是最快速的机器学习算法之一。 k-最近邻算法(有监督算法,分类算法)也称为KNN。KNN用于分类,比较数据点的距离,并将每个点分配给它最接近的组。给一个新的数据时,离它最近的k 个点中,哪个类别多,这个数据就属于哪一类。K表示K个邻居,不表示距离,因为需要求所有邻居的距离,所以效率低下。 优点:可以用来填充缺失值,可以处理非线性问题 调优方法:K值的选择,k值太小,容易过拟合 应用:样本数少,特征个数较少,kNN更适合处理一些分类规则相对复杂的问题,在推荐系统大量使用

几种机器学习算法原理入门教程

几种机器学习算法原理入门教程 一、机器学习的过程 机器学习的过程:从本质上来说,就是通过一堆的训练数据找到一个与理想函数(f)相接近的函数。 在理想情况下,对于任何适合使用机器学习的问题,在理论上都是会存在一个最优的函数让每个参数都有一个最合适的权重值,但在现实应用中不一定能这么准确得找到这个函数。所以,我们要去找与这个理想函数相接近的函数。只要是能够满足我们的使用的函数,我们就认为是一个好的函数。 这个训练数据的过程通常也被解释为: 在一堆的假设函数(Hypothesis set)中,它是包含了各种各样的假设,其中包括好的和坏的假设。 我们需要做的就是:从这一堆假设函数中挑选出它认为最好的假设函数(g)——这个假设函数是与理想函数(f)最接近的。

机器学习这个过程就像是:在数学上,我们知道了有一个方程和一些点的坐标,用这些点来求这个方程的未知项从而得出完整的方程。 但在机器学习上,我们往往很难解出来这个完整的方程是什么。所以,我们只能通过各种手段求最接近理想情况下的未知项取值,使得这个结果最接近原本的方程。 二、什么问题适合用机器学习解决 机器学习不是万能的,并不能解决所有的问题。 通过以上机器学习的过程可以看出来,实质上,机器学习是:通过已知经验找到规律来进行预测。 银行想知道应该发放多少贷款给某个客户时,可以根据过往成功放贷的数据找出每个贷款区间的人群特点、自身的房车资产状况等,再看看这个客户的特点符合哪个区间,以此去确定应该发放多少贷款,这就是适合用机器学习去解决的问题。

对于适合用机器学习解决的问题,台大的林轩田教授为我们总结了三个要素: 1.有规律可以学习 2.编程很难做到 3.有能够学习到规律的数据 只要满足这三个条件的问题,我们都可以挑选合适的算法去解决。 基于以上的条件,通常我们可以用机器学习解决三类问题: 1.预测(回归):根据已知数据和模型,预测不同客户应该发放的贷款 额度是多少 2.判别(分类):与预测有点类似,也是根据模型判别这个客户属于过 往哪一类客户的概率有多大 3.寻找关键因素:客户的属性非常多,通过模型我们可以找出对放贷影 响最大的因素是什么 三、几种常见的模型和算法

机器学习10大经典算法.

1、C4.5 机器学习中,决策树是一个预测模型;他代表的是对象属性与对象值之间的一种映射关系。树中每个节点表示某个对象,而每个分叉路径则代表的某个可能的属性值,而每个叶结点则对应从根节点到该叶节点所经历的路径所表示的对象的值。决策树仅有单一输出,若欲有复数输出,可以建立独立的决策树以处理不同输出。从数据产生决策树的机器学习技术叫做决策树学习, 通俗说就是决策树。 决策树学习也是数据挖掘中一个普通的方法。在这里,每个决策树都表述了一种树型结构,他由他的分支来对该类型的对象依靠属性进行分类。每个决策树可以依靠对源数据库的分割进行数据测试。这个过程可以递归式的对树进行修剪。当不能再进行分割或一个单独的类可以被应用于某一分支时,递归过程就完成了。另外,随机森林分类器将许多决策树结合起来以提升分类的正确率。决策树同时也可以依靠计算条件概率来构造。决策树如果依靠数学的计算方法可以取得更加理想的效果。决策树一般都是自上而下的来生成的。 选择分割的方法有好几种,但是目的都是一致的:对目标类尝试进行最佳的分割。从根到叶子节点都有一条路径,这条路径就是一条“规则”。决策树可以是二叉的,也可以是多叉的。对每个节点的衡量: 1)通过该节点的记录数 2)如果是叶子节点的话,分类的路径 3)对叶子节点正确分类的比例。 有些规则的效果可以比其他的一些规则要好。由于ID3算法在实际应用中存在一些问题,于是Quilan提出了C4.5算法,严格上说C4.5只能是ID3的一个改进算法。相信大家对ID3算法都很.熟悉了,这里就不做介绍。 C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: 1) 用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2) 在树构造过程中进行剪枝; 3) 能够完成对连续属性的离散化处理; 4) 能够对不完整数据进行处理。

关于机器学习的十大经典算法

关于机器学习的十大经典算法 1、C4.5 C4.5算法是机器学习算法中的一种分类决策树算法,其核心算法是ID3算法.C4.5算法继承了ID3算法的优点,并在以下几方面对ID3算法进行了改进: 1)用信息增益率来选择属性,克服了用信息增益选择属性时偏向选择取值多的属性的不足; 2)在树构造过程中进行剪枝; 3)能够完成对连续属性的离散化处理; 4)能够对不完整数据进行处理。 C4.5算法有如下优点:产生的分类规则易于理解,准确率较高。其缺点是:在构造树的过程中,需要对数据集进行多次的顺序扫描和排序,因而导致算法的低效。 2、Thek-meansalgorithm即K-Means算法 k-meansalgorithm算法是一个聚类算法,把n的对象根据他们的属性分为k个分割,k 轻松看懂机器学习十大常用算法 通过本篇文章可以对ML的常用算法有个常识性的认识,没有代码,没有复杂的理论推导,就是图解一下,知道这些算法是什么,它们是怎么应用的,例子主要是分类问题。 每个算法都看了好几个视频,挑出讲的最清晰明了有趣的,便于科普。 以后有时间再对单个算法做深入地解析。 今天的算法如下: 1.决策树 2.随机森林算法 3.逻辑回归 4.SVM 5.朴素贝叶斯 6.K最近邻算法 7.K均值算法 8.Adaboost 算法 9.神经网络 10.马尔可夫 1. 决策树 根据一些 feature 进行分类,每个节点提一个问题,通过判断,将数据分为两类,再继续提问。这些问题是根据已有数据学习出来的,再投入新数据的时候,就可以根据这棵树上的问题,将数据划分到合适的叶子上。 2. 随机森林 视频 在源数据中随机选取数据,组成几个子集 S 矩阵是源数据,有 1-N 条数据,A B C 是feature,最后一列C是类别 由 S 随机生成 M 个子矩阵 这 M 个子集得到 M 个决策树 将新数据投入到这 M 个树中,得到 M 个分类结果,计数看预测成哪一类的数目最多,就将此类别作为最后的预测结果 3. 逻辑回归 视频 当预测目标是概率这样的,值域需要满足大于等于0,小于等于1的,这个时候单纯的线性模型是做不到的,因为在定义域不在某个范围之内时,值域也超出了规定区间。 所以此时需要这样的形状的模型会比较好 那么怎么得到这样的模型呢? 这个模型需要满足两个条件大于等于0,小于等于1 大于等于0 的模型可以选择绝对值,平方值,这里用指数函数,一定大于0 小于等于1 用除法,分子是自己,分母是自身加上1,那一定是小于1的了 再做一下变形,就得到了 logistic regression 模型 机器学习十大算法 目录 0. 引言 (1) 0.1监督学习 (1) 0.2无监督学习 (1) 0.3强化学习 (1) 0.4通用机器学习算法列表 (1) 1. 线性回归(Linear Regression) (2) 2. 逻辑回归(Logistic Regression) (3) 3. 决策树(Decision Tree) (4) 4. 支持向量机(SVM –Support Vector Machine) (5) 5. 朴素贝叶斯(Naive Bayes) (6) 6. K近邻(KNN –K- Nearest Neighbors) (8) 7. K均值(K-Means) (9) 8. 随机森林(Random Forest) (10) 9. 降维算法(Dimensionality Reduction Algorithms) (11) 10.梯度提升算法(Gradient Boosting Algorithms) (11) 10.1 GBM (11) 10.2 XGBoost (12) 10.3 LightGBM (12) 10.4. Catboost (13) 11. 总结 (14) 0.引言 整体来说,机器学习算法可以分为3大类: 0.1 监督学习 工作原理:该算法由自变量(协变量、预测变量)和因变量(结果变量)组成,由一组自变量对因变量进行预测。通过这些变量集合,我们生成一个将输入映射到输出的函数。训练过程达到我们设定的损失阈值停止训练,也就是使模型达到我们需要的准确度等水平。 监督学习的例子:回归,决策树,随机森林,KNN,逻辑回归等 0.2无监督学习 工作原理:在无监督学习算法中,我们没有目标或结果变量来预测。通常用于不同群体的群体聚类。 无监督学习的例子:Apriori算法,K-means。 0.3强化学习 工作原理:强化学习(reinforcement learning),又称再励学习、评价学习,学习不是单一方法,而是一种机器学习方式,在智能控制机器人及分析预测等领域有许多应用。 强化学习例子:马尔可夫决策过程 0.4通用机器学习算法列表 此处列举常用的机器学习算法,这些算法几乎可以应用于所有的数据问题: 1. 线性回归 2. Logistic回归 3. 决策树 机器学习方法及应用 1、机器学习 学习是生物中枢神经系统的高级整合技能之一,是人类获取知识的重要途径和人类智能的重要标志,按照人工智能大师H·Simon的观点[1]:学习就是系统在不断重复的工作中对本身能力的增强或改进,使得系统在下一次执行同样或相类似的任务时,会比原来做得更好或效率更高。 机器学习则是计算机获取知识的重要途径和人工智能的重要标志,是一门研究怎样用计算机来模拟或实现人类学习活动的学科,是研究如何使机器通过识别和利用现有知识来获取新知识和新技能。一般认为,机器学习是一个有特定目的的知识获取过程,其内部表现为从未知到已知这样一个知识增长过程,其外部表现为系统的某些性能和适应性的改善,使得系统能完成原来不能完成或更好地完成原来可以完成的任务。它既注重知识本身的增加,也注重获取知识的技能的提高。 1.1 机器学习基本模型 以H·Simon的学习定义作为出发点,建立如图1的基本模型。在机器学习的过程中,首要的因素是外部环境向系统提供信息的质量。外部环境是以某种形式表达的外界信息集合,它代表外界信息来源;学习是将外界信息加工为知识的过程,先从环境获取外部信息,然后对这些信息加工形成知识,并把这些知识放入知识库中;知识库中存放指导执行部分动作的一般原则,由于环境向学习系统提供的信息形形色色,信息质量的优劣直接影响到学习部分容易实现还是杂乱无章。而知识库则是影响学习系统设计的第二个因素,由于知识库可能不同,表达方式各有特点,在选择表示方式上要兼顾表达能力强、易于推理、易于完善及扩展知识表示等几个方面的要求。执行环节是利用知识库中的知识完成某种任务的过程,并把完成任务过程中所获得的一些信息反馈给学习环节,以指导进一步的学习。 1.2机器学习的发展和研究目标 机器学习是人工智能研究较为年轻的分支,它的发展过程大体上分为四个时期[2]。 第一阶段是20世纪50年代中叶到60年代中叶,属于热烈时期。在这个时期,所研究的是“没有知识”的学习,即“无知”学习。其研究目标是各类自组织系统和自适应系统,其主要研究方法是不断修改系统的控制参数和改进系统的执行能力,不涉及与具体任务有关的知识。本阶段的代表性工作是:塞缪尔(Samuel)的下棋程序。但这种学习的结果远不能满足人们对机器学习系统的期望。 第二阶段是在60年代中叶到70年代中叶,被称为机器学习的冷静时期。本阶段的研究目标是模拟人类的概念学习过程,并采用逻辑结构或图结构作为机器内部描述。本阶段的代表性工作有温斯顿(Winston)的结构学习系统和海斯罗思(Hayes-Roth)等的基本逻辑的归纳学习系统。轻松看懂机器学习十大常用算法知识分享

机器学习的算法资料

机器学习算法及其应用