libmad音频解码库分析

MAD(libmad)是一个开源的高精度MPEG音频解码库,支持MPEG-1标准。libmad

提供24-bit(量化精度)的PCM输出,完全定点计算,非常适合在没有浮点

支持的嵌入式硬件平台上使用。使用libmad提供的一系列API可以实现MP3

文件的解码。

、、

数字信号是对连续变化的模拟信号进行抽样、量化和编码产生的,称为PCM

(pulse code modulation),即脉冲编码调制

“mad.h”头文件定义了libmad的数据结构及API函数[15]。

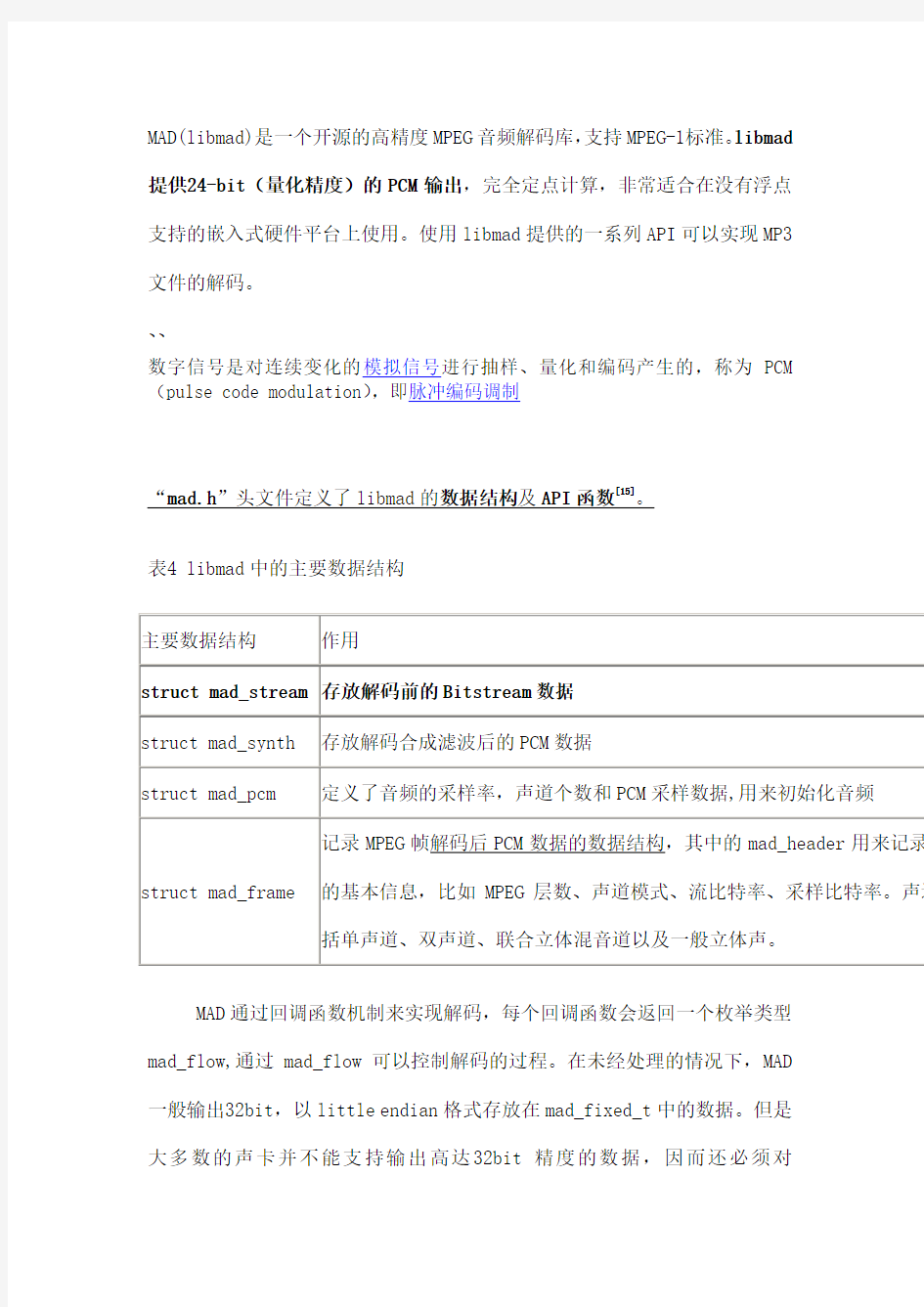

表4 libmad中的主要数据结构

主要数据结构作用

struct mad_stream存放解码前的Bitstream数据

struct mad_synth存放解码合成滤波后的PCM数据

struct mad_pcm定义了音频的采样率,声道个数和PCM采样数据,用来初始化音频

struct mad_frame 记录MPEG帧解码后PCM数据的数据结构,其中的mad_header用来记录的基本信息,比如MPEG层数、声道模式、流比特率、采样比特率。声道括单声道、双声道、联合立体混音道以及一般立体声。

MAD通过回调函数机制来实现解码,每个回调函数会返回一个枚举类型mad_flow,通过mad_flow可以控制解码的过程。在未经处理的情况下,MAD 一般输出32bit,以little endian格式存放在mad_fixed_t中的数据。但是大多数的声卡并不能支持输出高达32bit精度的数据,因而还必须对

mad_fixed_t进行量化,圆滑处理以及抖动,使到采样信号降到16bit精度。MAD负责的只是解码的过程,它工作过程是:从外部获取输入,逐帧解码,在解码的过程中返回信息,然后得到解码结果。开发人员要手动设置输入输出。

编程实现解码的方法为:初始化mad_decoder,里面包含了指向输入、输出、滤波、错误和消息回调函数的指针。

通过mad_decoder_init()实现初始化[16]。

struct mad_decoder decoder;

struct my_playbuf playbuf; //设置数据缓冲区mad_decoder_init( &decoder,

&playbuf,

input_func, //回调输入函数

header_func, //处理帧头信息

/*filter*/0, //滤波(未设置,置0)

output_func, //输出函数

/*error*/ 0, //错误

/* message */ 0);// 信息函数

在这个初始化函数里面,回调输入函数指向了input_func,处理帧头信息的函数指向了header_func,而输出函数则为output_func。其它的滤波,错误

和信息函数没有设置,置0。

接着,MAD进入了一个解码的循环过程:

当解码函数里面的数据解码完毕时,调用input_func函数;

当input_func函数告知解码函数全部数据已经解码完毕,则MAD处理退出;对帧头进行解码,调用header_func函数;

对帧中的主数据进行解码;

调用filter_func函数;

将解码数据输出,调用output_func函数;

重复上述步骤。

MAD在每进行一帧的解码结束后都会询问mad_flow的状态,以决定是否进行下一帧的解码。enum mad_flow的数据结构(枚举变量)定义如下:

enum mad_flow{

MAD_FLOW_CONTINUE = 0x0000, /*继续进行下一帧的解码*/ MAD_FLOW_STOP = 0x0010, /*停止对该比特流的解码并正常退出*/ MAD_FLOW_BREAK = 0x0010, /*停止对该比特流的解码并返回错误*/ MAD_FLOW_IGNORE = 0x0020 /*不解码该帧,跳入下一帧*/

};

大多数情况下回调函数会返回MAD_FLOW_CONTINUE。要自定义实现的回调函数的声明格式为:

enum mad_flow (*input_func)(void *, struct mad_stream *);

enum mad_flow (*header_func)(void *, struct mad_header const *); enum mad_flow (*filter_func)(void *, struct mad_stream const *, struct mad_frame *);

enum mad_flow (*output_func)(void *, struct mad_header const *, struct mad_pcm *);

enum mad_flow (*error_func)(void *, struct mad_stream *, struct mad_frame *);

enum mad_flow (*message_func)(void *, void *, unsigned int *);

其中void *指针将缓冲数据传递给这些回调函数,由回调函数对数据进行处理。

Input_func函数一般会执行以下操作:

if (more_data_available)

buffer = refill_buffer();

mad_stream_buffer(stream, buffer, length_of_buffer);

return MAD_FLOW_CONTINUE;

else return MAD_FLOW_STOP;

header_func函数会根据mad_header指向的帧头从中读取重要的帧信息,如

将读取到的帧长度赋值给mad_timer_t,可以从mad.h中得知存放这些信息

的数据结构。

在output_func函数中,利用指向PCM数据的指针mad_pcm,执行类似以下操

作:

mad_fixed_t *left_ch = pcm->samples[0], *right_ch =pcm->samples[1]; //将采样数据分别输出到左右声道

int nsamples = pcm->length;

signed int sample;

unsigned char * buffer = some_buffer;

unsigned char * ptr = buffer;

while (nsamples--)

{

sample = (signed int) do_downsample(*left_ch++)

*ptr++ = (unsigned char) (sample >> 0);

*ptr++ = (unsigned char) (sample >> 8);

sample = (signed int) do_downsample(*right_ch++)

*ptr++ = (unsigned char) (sample >> 0);

*ptr++ = (unsigned char) (sample >> 8);

//处理左右声道采样数据,输出16bit little endian格式PCM

}

定义好各回调函数之后,便可以开始解码:

mad_decoder_run(&decoder, MAD_DECODER_MODE_SYNC);

解码完毕后,调用mad_decoder_finish(&decoder);

libmad简介

MAD (libmad)是一个开源的高精度 MPEG 音频解码库,支持 MPEG-1(Layer I, Layer II 和 LayerIII(也就是 MP3)。LIBMAD 提供 24-bit 的 PCM 输出,完全是定点计算,非常适合没有浮点支持的平台上使用。使用 libmad 提

供的一系列 API,就可以非常简单地实现 MP3 数据解码工作。在 libmad 的

源代码文件目录下的 mad.h 文件中,可以看到绝大部分该库的数据结构和

API 等。

本文用到的 libmad 中的主要数据结构有:struct mad_stream, struct mad_synth, struct mad_frame。它们的定义如下:

清单 1:libmad 中的主要数据结构

struct mad_stream {

unsigned char const *buffer; /* input bitstream buffer */

unsigned char const *bufend; /* end of buffer */

unsigned long skiplen; /* bytes to skip before next frame */

int sync; /* stream sync found */

unsigned long freerate; /* free bitrate (fixed) */

unsigned char const *this_frame; /* start of current frame */

unsigned char const *next_frame; /* start of next frame */

struct mad_bitptr ptr; /* current processing bit pointer */

struct mad_bitptr anc_ptr; /* ancillary bits pointer */

unsigned int anc_bitlen; /* number of ancillary bits */

unsigned char (*main_data)[MAD_BUFFER_MDLEN];

/* Layer III main_data() */

unsigned int md_len; /* bytes in main_data */

int options; /* decoding options (see below) */

enum mad_error error; /* error code (see above) */

};

如果缓冲区最后一个 MPEG 数据帧只有部分数据包括在缓冲区中,那么struct mad_stream中的next_frame域指到不完整数据的开始地址。由于

缓冲区的 MPEG 数据帧不一定完整,所以不完整的 MPEG 帧的数据必须拷贝

到下一次解码操作的缓冲区中,进行再次解码。这里我们还看到bufend指

向缓冲区数据的最后地址,也就是最后一字节的地址加 1 的位置。

mad_stream.bufend –mad_stream.next_frame就是剩余的未被解码的MPEG 帧的数据的字节数量(假设此帧在缓冲区中不完整)。mad_stream的error域用来记录操作mad_stream得到的错误代码。错误代码在 mad.h 中

有很详细的定义。

清单 2:错误代码在 mad.h 中的详细定义

struct mad_synth {

mad_fixed_t filter[2][2][2][16][8]; /* polyphase filterbank outputs */ /* [ch][eo][peo][s][v] */

unsigned int phase; /* current processing phase */

struct mad_pcm pcm; /* PCM output */

};

mad_synth中的关键域pcm保存解码和合成后得到的 PCM 数据。

清单 3:mad_synth 中的关键域

struct mad_pcm {

unsigned int samplerate; /* sampling frequency (Hz) */

unsigned short channels; /* number of channels */

unsigned short length; /* number of samples per channel */ mad_fixed_t samples[2][1152]; /* PCM output samples [ch][sample] */ };

struct mad_pcm定义了音频的采样率、每个声道个数以及最后的 PCM 采样

数据。这些参数可用来初始化音频设备。

清单 4:struct mad_pcm

struct mad_frame {

struct mad_header header; /* MPEG audio header */

int options; /* decoding options (from stream) */

mad_fixed_t sbsample[2][36][32]; /* synthesis subband filter samples */

mad_fixed_t (*overlap)[2][32][18]; /* Layer III block overlap data

*/

};

mad_frame是记录 MPEG 帧解码后的数据的数据结构,其中的mad_header

尤其重要,其用来记录 MPEG 帧的一些基本信息,比如 MPEG 层数、声道模式、流比特率、采样比特率等等。声道模式包括单声道、双声道、联合立体

混音声以及一般立体声。

清单 5:mad_frame

enum mad_mode {

MAD_MODE_SINGLE_CHANNEL = 0, /* single channel */

MAD_MODE_DUAL_CHANNEL = 1, /* dual channel */

MAD_MODE_JOINT_STEREO = 2, /* joint (MS/intensity) stereo */

MAD_MODE_STEREO = 3 /* normal LR stereo */

};

struct mad_header {

enum mad_layer layer; /* audio layer (1, 2, or 3) */

enum mad_mode mode; /* channel mode */

int mode_extension; /* additional mode info */

enum mad_emphasis emphasis; /* de-emphasis to use */

unsigned long bitrate; /* stream bitrate (bps) */

unsigned int samplerate; /* sampling frequency (Hz) */

unsigned short crc_check; /* frame CRC accumulator */

unsigned short crc_target; /* final target CRC checksum */

int flags; /* flags */

int private_bits; /* private bits */

mad_timer_t duration; /* audio playing time of frame */

};

下面就本文使用的 API 的功能做简单介绍。

在本文中用到的 API 包括:

void mad_stream_init(struct mad_stream *)

void mad_synth_init(struct mad_synth *);

void mad_frame_init(struct mad_frame *);

以上3个 API 初始化解码需要的数据结构。

void mad_stream_buffer(struct mad_stream *, unsigned char const *, unsigned long);

此函数把原始的未解码的 MPEG 数据和mad_stream数据结构关联,以便使

用mad_frame_decode( )来解码 MPEG 帧数据。

int mad_frame_decode(struct mad_frame *, struct mad_stream *);

把mad_stream中的 MPEG 帧数据解码。

void mad_synth_frame(struct mad_synth *, struct mad_frame const *);

把解码后的音频数据合成 PCM 采样。

void mad_stream_finish(struct mad_stream *);

void mad_frame_finish(struct mad_frame *);

mad_synth_finish(struct mad_synth);

以上 3 个 API 在解码完毕后使用,释放 libmad 占用的资源等。

音频的编解码

音频编码解码基本概念介绍 对数字音频信息的压缩主要是依据音频信息自身的相关性以及人耳对音频信息的听觉冗余度。音频信息在编码技术中通常分成两类来处理,分别是语音和音乐,各自采用的技术有差异。 语音编码技术又分为三类:波形编码、参数编码以及混合编码。 波形编码:波形编码是在时域上进行处理,力图使重建的语音波形保持原始语音信号的形状,它将语音信号作为一般的波形信号来处理,具有适应能力强、话音质量好等优点,缺点是压缩比偏低。该类编码的技术主要有非线性量化技术、时域自适应差分编码和量化技术。非线性量化技术利用语音信号小幅度出现的概率大而大幅度出现的概率小的特点,通过为小信号分配小的量化阶,为大信号分配大的量阶来减少总量化误差。我们最常用的G.711标准用的就是这个技术。自适应差分编码是利用过去的语音来预测当前的语音,只对它们的差进行编码,从而大大减少了编码数据的动态范围,节省了码率。自适应量化技术是根据量化数据的动态范围来动态调整量阶,使得量阶与量化数据相匹配。G.726标准中应用了这两项技术,G.722标准把语音分成高低两个子带,然后在每个子带中分别应用这两项技术。 参数编码:广泛应用于军事领域。利用语音信息产生的数学模型,提取语音信号的特征参量,并按照模型参数重构音频信号。它只能收敛到模型约束的最好质量上,力图使重建语音信号具有尽可能高的可懂性,而重建信号的波形与原始语音信号的波形相比可能会有相当大的差别。这种编码技术的优点是压缩比高,但重建音频信号的质量较差,自然度低,适用于窄带信道的语音通讯,如军事通讯、航空通讯等。美国的军方标准LPC-10,就是从语音信号中提取出来反射系数、增益、基音周期、清/浊音标志等参数进行编码的。MPEG-4标准中的HVXC声码器用的也是参数编码技术,当它在无声信号片段时,激励信号与在CELP时相似,都是通过一个码本索引和通过幅度信息描述;在发声信号片段时则应用了谐波综合,它是将基音和谐音的正弦振荡按照传输的基频进行综合。 混合编码:将上述两种编码方法结合起来,采用混合编码的方法,可以在较低的数码率上得到较高的音质。它的特点是它工作在非常低的比特率(4~16 kbps)。混合编码器采用合成分析技术。

LM386 电路原理 音频放大器

LM386 电路原理 LM386是一种音频集成功放,具有自身功耗低、电压增益可调整、电源电压范围大、外接元件少和总谐波失真小等优点,广泛应用于录音机和收音机之中。 一、 LM386内部电路 LM386内部电路原理图如图所示。与通用型集成运放相类似,它是一个三级放大电路。 第一级为差分放大电路,T1和T3、T2和T4分别构成复合管,作为差分放大电路的放大管;T5和T6组成镜像电流源作为T1和T2的有源负载;T3和T4信号从管的基极输入,从T2管的集电极输出,为双端输入单端输出差分电路。使用镜像电流源作为差分放大电路有源负载,可使单端输出电路的增益近似等于双端输出电容的增益。 第二级为共射放大电路,T7为放大管,恒流源作有源负载,以增大放大倍数。 第三级中的T8和T9管复合成PNP型管,与NPN型管T10构成准互补输出级。二极管D1和D2为输出级提供合适的偏置电压,可以消除交越失真。

引脚2为反相输入端,引脚3为同相输入端。电路由单电源供电,故为OTL电路。输出端(引脚5)应外接输出电容后再接负载。 电阻R7从输出端连接到T2的发射极,形成反馈通路,并与R5和R6构成反馈网络,从而引入了深度电压串联负反馈,使整个电路具有稳定的电压增益。 二、 LM386的引脚图 LM386的外形和引脚的排列如右图所示。引脚 2为反相输入端,3为同相输入端;引脚5为 输出端;引脚6和4分别为电源和地;引脚1 和8为电压增益设定端;使用时在引脚7和地 之间接旁路电容,通常取10μF。 LM386的外形和引脚的排列如右图所示。引脚2为反相输入端,3为同相输入端;引脚5为输出端;引脚6和4分别为电源和地;引脚1和8为电压增益设定端;使用时在引脚7和地之间接旁路电容,通常取10μF。 查LM386的datasheet,电源电压4-12V或5-18V(LM386N-4);静态消耗电流为4mA;电压增益为20-200dB;在1、8脚开路时,带宽为300KHz;输入阻抗为50K;音频功率0.5W。 尽管LM386的应用非常简单,但稍不注意,特别是器件上电、断电瞬间,甚至工作稳定后,一些操作(如插拔音频插头、旋音量调节钮)都会带来的瞬态冲击,在输出喇叭上会产生非常讨厌的噪声 查LM386的datasheet,电源电压4-12V或5-18V(LM386N-4);静态消耗电流为4mA;电压增益为20-200dB;在1、8脚开路时,带宽为300KHz;输入阻抗为50K;音频功率0.5W。 尽管LM386的应用非常简单,但稍不注意,特别是器件上电、断电瞬间,甚至工作稳定后,一些操作(如插拔音频插头、旋音量调节钮)都会带来的瞬态冲击,在输出喇叭上会产生非常讨厌的噪声。 1、通过接在1脚、8脚间的电容(1脚接电容+极)来改变增益,断开时增益为20dB。因此用不到大的增益,电容就不要接了,不光省了成本,还会带来好处--噪音减少,何乐而不为? 2、PCB设计时,所有外围元件尽可能靠近LM386;地线尽可能粗一些;输入音频信号通路尽可能平行走线,输出亦如此。这是死理,不用多说了吧。 3、选好调节音量的电位器。质量太差的不要,否则受害的是耳朵;阻值不要太大,10K最合适,太大也会影响音质,转那么多圈圈,不烦那! 4、尽可能采用双音频输入/输出。好处是:“+”、“-”输出端可以很好地抵消共模信号,故能有效抑制共模噪声。 5、第7脚(BYPASS)的旁路电容不可少!实际应用时,BYPASS端必须外接一个电解电容到地,起滤除噪声的作用。工作稳定后,该管脚电压值约等于电源电压的一半。增大这个电容

数字音视频编解码技术标准工作组

数字音视频编解码技术标准工作组 A VS Mxxxx: 201X年XX月 来源: 包括作者、单位名称等与创作者相关的信息 标题: 状态: 描述文件的版本或其他需要说明的信息,例如视频提案、DRM信息等 ___________________________________________________ 正文 中国数字音视频编解码技术标准工作组 会员提案专利披露与许可承诺表 根据《中国数字音视频编解码技术标准工作组知识产权政策》第十四、十五、十六条等相关规定,A VS会员在向工作组各专题组提交技术提案时应填写本《会员提案专利披露与许可承诺表》,作为该提案的必要组成部分同时提交。 专题组名称:音频□视频□系统□DRM□ 提案A VS文档编号:_ 提案日期:________ 提案标题: 提案会员名称:_ 提案代表姓名(印刷体):Email: 提案代表通讯地址:邮编 电话:______ __ 传真:__ ______________________ 提案会员应当通过选中表A或者通过选中并填写表B相关部分完成此表。表C可以自愿填写。下列表格均可根据实际需要增加表格行。 表A: 提案会员在其实际知晓的范围内已获知本提案不涉及提案会员和他人的专利、专利申请和专利计划。□ 表B-1: 在中华人民共和国已获得授权的专利和/或已公开的专利申请□ 如果本提案中包含提案会员或其关联者在中华人民共和国已获得授权的专利和/或已公开的专利申请,提案会员应当填写下表: 表B-2: 在中华人民共和国未公开的专利申请□ 如果提案会员的缺省许可义务不是RAND-RF或者POOL,当提案会员或其关联者有与此提案相关的未公

视音频编解码技术及应用

工科类 信息工程学院本科论文 题目:视音频编解码技术及应用 别系:信息工程学院 专业:信息工程 届次: 2012届 学号: 2012041183 姓名:焦杰 指导教师:杨宇老师 2014年9月28日

视音频编解码技术及应用 (——视音频编解码技术及应用 焦杰 【摘要】首先分析了在各个不同的历史阶段为满足不同的需求而提出的各种音频编解码器,讨论了最常见编解码器的特征和性能。然后考虑了它们对当前和未来移动通信需求的适应性,比较了各种音频编解码器的性能。最后给出了一些音频编解码器在移动通信系统中的应用。 【关键词】音频编解码器;增强的高效高级音频编码;增强的自适应多码率宽带音频编码;可变速率多模式宽带音频编码;谱带恢复。 1 引言 当今,各种各样的音频编解码器广泛应用于Et常生活中。选择哪种编解码器通常取决于以下因素:音频素材的内容类型、可用通信速率和收听场合对音质的要求。可能影响编解码器选择的其它因素,还包括标准化情形、专利费和市场品牌。尽管MP3格式已获得了很大的成功,但它不适合于移动设备。近来,效率较高的编解码器(如AAC和AMR)已被提出,并为适应移动的音频应用而不断改进。 笔者将通过揭示音频编码和解码的技术原理、标准化情形以及涉及可用技术和市场需求的编解码器的适应性来评估最常见的音频编解码器,同时也考虑到移动通信领域在硬件和软件上的发展状况,分析现有和将来的音频应用,以阐明对移动音频的需求和期待。 2 音频编解码器的历史背景 音频编解码器的简短历史可追溯到20世纪80年代中期,德国Fraunhofer 研究所首先开始从事高质量、低码率的音频编码研究。他们的项目作为面向市场的尤里卡(Eureka)研究计划(EU一147)的一个部分得到了欧盟的财政资助。1989

(完整)流媒体传输协议及音视频编解码技术

1.1音视频编解码技术 1.1.1 MPEG4 MPEG全称是Moving Pictures Experts Group,它是“动态图象专家组”的英文缩写,该专家组成立于1988年,致力于运动图像及其伴音的压缩编码标准化工作,原先他们打算开发MPEG1、MPEG2、MPEG3和MPEG4四个版本,以适用于不同带宽和数字影像质量的要求。 目前,MPEG1技术被广泛的应用于VCD,而MPEG2标准则用于广播电视和DVD等。MPEG3最初是为HDTV开发的编码和压缩标准,但由于MPEG2的出色性能表现,MPEG3只能是死于襁褓了。MPEG4于1999年初正式成为国际标准。它是一个适用于低传输速率应用的方案。与MPEG1和MPEG2相比,MPEG4更加注重多媒体系统的交互性和灵活性MPEG1、MPEG2技术当初制定时,它们定位的标准均为高层媒体表示与结构,但随着计算机软件及网络技术的快速发展,MPEG1、MPEG2技术的弊端就显示出来了:交互性及灵活性较低,压缩的多媒体文件体积过于庞大,难以实现网络的实时传播。而MPEG4技术的标准是对运动图像中的内容进行编码,其具体的编码对象就是图像中的音频和视频,术语称为“AV对象”,而连续的AV对象组合在一起又可以形成AV场景。因此,MPEG4标准就是围绕着AV对象的编码、存储、传输和组合而制定的,高效率地编码、组织、存储、传输AV 对象是MPEG4标准的基本内容。 在视频编码方面,MPEG4支持对自然和合成的视觉对象的编码。(合成的视觉对象包括2D、3D动画和人面部表情动画等)。在音频编码上,MPEG4可以在一组编码工具支持下,对语音、音乐等自然声音对象和具有回响、空间方位感的合成声音对象进行音频编码。 由于MPEG4只处理图像帧与帧之间有差异的元素,而舍弃相同的元素,因此大大减少了合成多媒体文件的体积。应用MPEG4技术的影音文件最显著特点就是压缩率高且成像清晰,一般来说,一小时的影像可以被压缩为350M左右的数据,而一部高清晰度的DVD电影, 可以压缩成两张甚至一张650M CD光碟来存储。对广大的“平民”计算机用户来说,这就意味着, 您不需要购置DVD-ROM就可以欣赏近似DVD质量的高品质影像。而且采用MPEG4编码技术的影片,对机器硬件配置的要求非常之低,300MHZ 以上CPU,64M的内存和一个8M显存的显卡就可以流畅的播放。在播放软件方面,它要求也非常宽松,你只需要安装一个500K左右的MPEG4 编码驱动后,用WINDOWS 自带的媒体播放器就可以流畅的播放了 AV对象(AVO,Audio Visual Object)是MPEG-4为支持基于内容编码而提出的重要概念。对象是指在一个场景中能够访问和操纵的实体,对象的划分可根据其独特的纹理、运动、形状、模型和高层语义为依据。在MPEG-4中所见的音视频已不再是过去MPEG-1、MPEG-2中图像帧的概念,而是一个个视听场景(AV场景),这些不同的AV场景由不同的AV对象组成。AV对象是听觉、视觉、或者视听内容的表示单元,其基本单位是原始AV对象,它可以是自然的或合成的声音、图像。原始AV对象具有高效编码、高效存储与传输以及可交互性的特性,它又可进一步组成复合AV对象。因此MPEG-4标准的基本内容就是对AV对象进行高效编码、组织、存储与传输。AV对象的提出,使多媒体通信具有高度交互及高效编码的能力,AV对象编码就是MPEG-4的核心编码技术。 MPEG-4不仅可提供高压缩率,同时也可实现更好的多媒体内容互动性及全方位的存取性,它采用开放的编码系统,可随时加入新的编码算法模块,同时也可根据不同应用需求现场配置解码器,以支持多种多媒体应用 1.1.2 H264 H.264是由ITU-T的VCEG(视频编码专家组)和ISO/IEC的MPEG(活动图像编码专家组)联合组建的联合视频组(JVT:joint video team)提出的一个新的数字视频编码标准,

各种音视频编解码学习详解 h264

各种音视频编解码学习详解h264 ,mpeg4 ,aac 等所有音视频格式 编解码学习笔记(一):基本概念 媒体业务是网络的主要业务之间。尤其移动互联网业务的兴起,在运营商和应用开发商中,媒体业务份量极重,其中媒体的编解码服务涉及需求分析、应用开发、释放license收费等等。最近因为项目的关系,需要理清媒体的codec,比较搞的是,在豆丁网上看运营商的规范标准,同一运营商同样的业务在不同文档中不同的要求,而且有些要求就我看来应当是历史的延续,也就是现在已经很少采用了。所以豆丁上看不出所以然,从wiki上查。中文的wiki信息量有限,很短,而wiki的英文内容内多,删减版也减肥得太过。我在网上还看到一个山寨的中文wiki,长得很像,红色的,叫―天下维客‖。wiki的中文还是很不错的,但是阅读后建议再阅读英文。 我对媒体codec做了一些整理和总结,资料来源于wiki,小部分来源于网络博客的收集。网友资料我们将给出来源。如果资料已经转手几趟就没办法,雁过留声,我们只能给出某个轨迹。 基本概念 编解码 编解码器(codec)指的是一个能够对一个信号或者一个数据流进行变换的设备或者程序。这里指的变换既包括将信号或者数据流进行编码(通常是为了传输、存储或者加密)或者提取得到一个编码流的操作,也包括为了观察或者处理从这个编码流中恢复适合观察或操作的形式的操作。编解码器经常用在视频会议和流媒体等应用中。 容器 很多多媒体数据流需要同时包含音频数据和视频数据,这时通常会加入一些用于音频和视频数据同步的元数据,例如字幕。这三种数据流可能会被不同的程序,进程或者硬件处理,但是当它们传输或者存储的时候,这三种数据通常是被封装在一起的。通常这种封装是通过视频文件格式来实现的,例如常见的*.mpg, *.avi, *.mov, *.mp4, *.rm, *.ogg or *.tta. 这些格式中有些只能使用某些编解码器,而更多可以以容器的方式使用各种编解码器。 FourCC全称Four-Character Codes,是由4个字符(4 bytes)组成,是一种独立标示视频数据流格式的四字节,在wav、a vi档案之中会有一段FourCC来描述这个AVI档案,是利用何种codec来编码的。因此wav、avi大量存在等于―IDP3‖的FourCC。 视频是现在电脑中多媒体系统中的重要一环。为了适应储存视频的需要,人们设定了不同的视频文件格式来把视频和音频放在一个文件中,以方便同时回放。视频档实际上都是一个容器里面包裹着不同的轨道,使用的容器的格式关系到视频档的可扩展性。 参数介绍 采样率 采样率(也称为采样速度或者采样频率)定义了每秒从连续信号中提取并组成离散信号的采样个数,它用赫兹(Hz)来表示。采样频率的倒数叫作采样周期或采样时间,它是采样之间的时间间隔。注意不要将采样率与比特率(bit rate,亦称―位速率‖)相混淆。

音频放大电路的组成及原理

第二章高保真电路的组成及基本原理 2.1电路整体方案的确定 音频功率放大器的基本功能是把前级送来的声频信号不失真地加以放大,输出足够的功率去驱动负载(扬声器)发出优美的声音。放大器一般包括前置放大和功率放大两部分,前者以放大信号振幅为目的,因而又称电压放大器;后者的任务是放大信号功率,使其足以推动扬声器系统。 功率放大电路是一种能量转换电路,要求在失真许可的范围内,高效地为负载提供尽可能大的功率,功放管的工作电流、电压的变化范围很大,那么三极管常常是工作在大信号状态下或接近极限运用状态,有甲类、乙类、甲乙类等各种工作方式。为了提高效率,将放大电路做成推挽式电路,功放管的工作状态设置为甲乙类,以减小交越失真。常见的音频功放电路在连接形式上主要有双电源互补推挽功率放大器OCL(无输出电容)、单电源互补推挽功率放大器OTL(无输出变压器)、平衡(桥式)无变压器功率放大器BTL等。由于功放管承受大电流、高电压,因此功放管的保护问题和散热问题也必须要重视。 OCL电路由于性能比较好,所以广泛地应用在高保真扩音设备中。本课题输出级选用OCL功率放大器,偏置电路选用甲乙类功放电路。为了使电路简单,信号失真小,本电路选用反馈型音调控制电路。为了不影响音调控制电路,要求前置输入阻抗比较高,输出阻抗低,本级电路选用场效应管共源放大器和源级跟随器组成。 高保真音频放大器组成框图 2.2 OCL功率放大器的原理 OCL功率放大器电路通常可分成:功率输出级、推动级和输入级三部分。根据给定技术指标,选择下图所示电路 功率输出级是由四个三极管组成的复合管准互补对称电路,可以得到较大的输出功率。再用一些电阻来减小复合管的穿透电流,增加电路的稳定性。前置电路用NPN型三极管组成恒压电路,保证功率输出管有合适的初始电流,以克服交越失真。 推动级采用普通共射放大电路。 输入级部分由三极管组成差动放大电路,减小电路直流漂移。 2.3音调控制电路的原理 常用的音调控制电路有三种:一种是衰减式RC音调控制电路,其调节范围

音频编解码介绍

音频编解码原理介绍 一.为什么要进行音频编解码 二.音频编解码原理 三.几种基本音频编解码介绍 一、为什么要进行音频编解码 随着人们对多媒体图像和声音的要求越来越高,在高清晰数字电视(HDTV)和数字电影中不仅应有高质量的图像,也应当具有CD质量的立体声。因为用数字方法记录声音比用模拟方法记录声音具有更强的优势,例如传输时抗噪声能力强、增加音频动态范围、多次翻录没有信号衰减等。但是数字声音最大的缺陷是记录的数据量大,表现在两个方面:其一是在传输过程中,传输数字声音需要占用很宽的传输带宽;其二是在存储过程中,需要占用大量的存储空间。所以在数字音频中需要采用数字音频压缩技术,对音频数据进行压缩。 二、音频编解码原理 每张CD光盘重放双声道立体声信号可达74分钟。VCD视盘机要同时重放声音和图像,图像信号数据需要压缩,其伴音信号数据也要压缩,否则伴音信号难于存储到VCD光盘中。 一、伴音压缩编码原理 伴音信号的结构较图像信号简单一些。伴音信号的压缩方法与图像信号压缩技术有相似性,也要从伴音信号中剔除冗余信息。人耳朵对音频信号的听觉灵敏度有规律性,对于不同频段或不同声压级的伴音有其特殊的敏感特性。在伴音数据压缩过程中,主要应用了听觉阈值及掩蔽效应等听觉心理特性。 1、阈值和掩蔽效应 (1) 阈值特性 人耳朵对不同频率的声音具有不同的听觉灵敏度,对低频段(例如100Hz以下)和超高频段(例如16KHZ以上)的听觉灵敏度较低,而在1K-5KHZ的中音频段时,听觉灵敏度明显提高。通常,将这种现象称为人耳的阈值特性。若将这种听觉特性用曲线表示出来,就称为人耳的阈值特性曲线,阈值特性曲线反映该特性的数值界限。将曲线界限以下的声音舍弃掉,对人耳的实际听音效果没有影响,这些声音属于冗余信息。 在伴音压缩编码过程中,应当将阈值曲线以上的可听频段的声音信号保留住,它是可听频段的主要成分,而那些听觉不灵敏的频段信号不易被察觉。应当保留强大的信号,忽略舍弃弱小的信号。经过这样处理的声音,人耳在听觉上几乎察觉不到其失真。在实际伴音压缩编码过程中,也要对不同频段的声音数据进行量化处理。可对人耳不敏感频段采用较粗的量化步长进行量化,可舍弃一些次要信息;而对人耳敏感频段则采用较细小的量化步长,使用较多的码位来传送。 (2)掩蔽效应 掩蔽效应是人耳的另一个重要生理特征。如果在一段较窄的频段上存在两种声音信号,当一个强度大于另一个时,则人耳的听觉阈值将提高,人耳朵可以听到大音量的声音信号,而其附近频率小音量的声音信号却听不到,好像是小音量信号被大音量信号掩蔽掉了。由于其它声音信号存在而听不到本声音存在的现象,称为掩蔽效应。 根据人耳的掩蔽特性,可将大音量附近的小音量信号舍弃掉,对实际听音效果不会发生影响。既使保留这些小音量信号,人耳也听不到它们的存在,它属于伴音信号中的冗余信息。舍弃掉这些信号,可以进一步压缩伴音数据总量。

数字音视频编解码技术标准工作组知识产权政策

数字音视频编解码技术标准工作组知识产权政策

————————————————————————————————作者:————————————————————————————————日期:

数字音视频编解码技术标准工作组知识产权政策 (2004年9月12日第十次工作会议通过实施) (2008年3月29日第二十四次工作会议修订) 第一章、总则 第一条本知识产权政策文件(“知识产权政策”)规定了中国数字音视频编解码技术标准工作组(“工作组”)的与制订A VS技术标准的整个过程及其所产生的标准文 档相关的知识产权的管理规则。 第二条通过签署A VS会员协议,会员书面承诺该会员及其关联者及其工作组成员同意并遵守本知识产权政策的条款。 第三条本知识产权政策是A VS会员协议的必要组成部分,并通过引用纳入会员协议。 第二章、定义 第四条对于在本知识产权政策中使用并且在A VS章程、A VS会员协议和A VS章程细则中已有定义的词语,其含义应遵从有关文件中的定义。以下词语在本知识产 权政策中定义为以下含义: 1、“符合部分”仅指有关产品或服务中实施并符合最终A VS 标准的所有相关规范性要求的特定部分,这些规范性要求应当 在最终A VS标准中明确公开,并且其目的是为了使产品或服 务能够实现该最终AVS标准所定义的解码、编码、发送数字 媒体或识别和实施权利管理。 2、“必要权利要求”是指根据授权或公布专利的所在国法律, 被最终A VS标准的符合部分不可避免地侵权的该专利中的某 一权利要求,且仅限于该权利要求。 专利的某一权利要求被不可避免地侵权,是指该侵权不可能在 实施最终A VS标准时通过采用另一个技术上可行的不侵权的 实施方式予以避免。 必要权利要求不包括,并且许可也不适用于:(1)不符合上文 规定的其他权利要求,即使该权利要求包含在同一件专利中; (2)在最终的A VS标准文档中引用或以参考方式包括在内的 其他标准中涉及的权利要求;(3)制造或使用符合最终AVS 标准文档的任何产品、服务及其部分时可能必要,但没有明确 地在该标准文档中描述的实现技术。 3、“专利”是指许可方或其关联者拥有的或者在无需向非关联 第三方付费的情况下有权许可的,在任何国家授权的任何专 利、可执行的发明证书、授权的实用新型、或公布提请异议的 任何可执行的专利申请或实用新型申请,但不包括外观设计专 利和外观设计登记。 4、“规范性参考文件”是指并非由工作组制定而是通过引用包

音频编解码技术的延时问题

SBC编解码器在A2DP协议里是必不可少的。由于是将信号以帧的形式填充到蓝牙数据包中,其整体延迟时间比较高,主要归于以下几个因素: 1.编解码器延迟:每个音频编解码器在将数据进行编码、解码并发出去之前会造成一定的内部延迟。传统的编解码器已检测到高达50ms的编解码器延迟。 2.传输延迟:A2DP传输层采用数据包结构。工程师在使用基于SBC或感知的帧填充数据包时,有两个方案选择:其一是将一个帧放入大型蓝牙数据包中(图1);其二是将一个帧分解成两个蓝牙数据包(图2)。采用第一个方案会降低数据传输的稳健性,而在第二个方案中,解码器只有在接收到两个蓝牙数据包以后才能对分解帧进行解码,因此将大大增加传输延迟时间。 图1

图2 apt-X是CSR 公司专有的一种编码格式,压缩率4:1(约352 kbit/s),号称可以达到CD 音质。由于是专有格式,必须要求播放设备与接受设备均采用CSR的蓝牙模块才行。 特点:无缓冲,低延迟,如果出现数据包损失的话,几乎无需重传数据。apt-X不同于SBC,它采用无框架结构。解码过程中,aptX编解码器无需等待便可高效地对蓝牙数据包进行填充,也就是说,一旦它接收到数据包便即刻启动解码过程,无需等待(图3)。此外,aptX采用固定压缩率算法,可在传输过程中始终提供相同的比特率,从而保证每个配备aptX的产品输出相同的音质。 aptX具备的一系列独特特性在提供专业的音频性能及稳健性的同时,还可保证40ms的编解码延迟。 图3 关于解码方式的一个比喻: 我们可以想象一个四车道的高速公路经过一座只有单车道的桥。使用aptX技术相当于桥头上的收费站将四车道上的车流处理(或编码)成单车道队列,使其能够穿桥而过。然后,在桥尾有另一个收费站将单车道车流又处理(或解码)回四车道。 SBC、AAC 和MP3技术的这些收费站,会限制通过车辆所允许携带的汽油量,这样每辆车都必须将超出限量的汽油放掉。当他们通过桥另一端的收费站后,虽然汽油也许不会全部用完,但肯定比来时要少很多。此外,一旦您过了桥,之前放掉的汽油不会再还给您。换句话说,您永远失去了这些汽油。对重现音频这一事件来说,相当于上述几种解码方法使用更具破坏性的压缩技术来处理音频数据,使其能通过蓝牙传输,这意味着它们将扔掉自认为不重要的音频元素,仅重现有限的音频带宽。 SBC与aptX差别: 与SBC(Sub-Band Codec子带编解码)技术相比,aptX的优势比较明显: 在频率响应方面,aptX可以在整个频率范围内真实还原音频,SBC则会随着频率的增高,信号渐弱,从而导致失真显著。

各种音视频编解码学习详解

各种音视频编解码学习详解 编解码学习笔记(一):基本概念 媒体业务是网络的主要业务之间。尤其移动互联网业务的兴起,在运营商和应用开发商中,媒体业务份量极重,其中媒体的编解码服务涉及需求分析、应用开发、释放license收费等等。最近因为项目的关系,需要理清媒体的codec,比较搞的是,在豆丁网上看运营商的规范标准,同一运营商同样的业务在不同文档中不同的要求,而且有些要求就我看来应当是历史的延续,也就是现在已经很少采用了。所以豆丁上看不出所以然,从wiki上查。中文的wiki信息量有限,很短,而wiki的英文内容内多,删减版也减肥得太过。我在网上还看到一个山寨的中文wiki,长得很像,红色的,叫―天下维客‖。wiki的中文还是很不错的,但是阅读后建议再阅读英文。 我对媒体codec做了一些整理和总结,资料来源于wiki,小部分来源于网络博客的收集。网友资料我们将给出来源。如果资料已经转手几趟就没办法,雁过留声,我们只能给出某个轨迹。 基本概念 编解码 编解码器(codec)指的是一个能够对一个信号或者一个数据流进行变换的设备或者程序。这里指的变换既包括将信号或者数据流进行编码(通常是为了传输、存储或者加密)或者提取得到一个编码流的操作,也包括为了观察或者处理从这个编码流中恢复适合观察或操作的形式的操作。编解码器经常用在视频会议和流媒体等应用中。 容器 很多多媒体数据流需要同时包含音频数据和视频数据,这时通常会加入一些用于音频和视频数据同步的元数据,例如字幕。这三种数据流可能会被不同的程序,进程或者硬件处理,但是当它们传输或者存储的时候,这三种数据通常是被封装在一起的。通常这种封装是通过视频文件格式来实现的,例如常见的*.mpg, *.avi, *.mov, *.mp4, *.rm, *.ogg or *.tta. 这些格式中有些只能使用某些编解码器,而更多可以以容器的方式使用各种编解码器。 FourCC全称Four-Character Codes,是由4个字符(4 bytes)组成,是一种独立标示视频数据流格式的四字节,在wav、avi档案之中会有一段FourCC来描述这个AVI档案,是利用何种codec来编码的。因此wav、avi大量存在等于―IDP3‖的FourCC。 视频是现在电脑中多媒体系统中的重要一环。为了适应储存视频的需要,人们设定了不同的视频文件格式来把视频和音频放在一个文件中,以方便同时回放。视频档实际上都是一个容器里面包裹着不同的轨道,使用的容器的格式关系到视频档的可扩展性。 参数介绍 采样率 采样率(也称为采样速度或者采样频率)定义了每秒从连续信号中提取并组成离散信号的采样个数,它用赫兹(Hz)来表示。采样频率的倒数叫作采样周期或采样时间,它是采样之间的时间间隔。注意不要将采样率与比特率(bit rate,亦称―位速率‖)相混淆。 采样定理表明采样频率必须大于被采样信号带宽的两倍,另外一种等同的说法是奈奎斯特频率必须大于被采样信号的带宽。如果信号的带宽是100Hz,那么为了避免混叠现象采样频率必须大于200Hz。换句话说就是采样频率必须至少是信号中最大频率分量频率的两倍,否则就不能从信号采样中恢复原始信号。 对于语音采样: ?8,000 Hz - 电话所用采样率, 对于人的说话已经足够 ?11,025 Hz ?22,050 Hz - 无线电广播所用采样率 ?32,000 Hz - miniDV 数码视频camcorder、DAT (LP mode)所用采样率 ?44,100 Hz - 音频CD, 也常用于MPEG-1 音频(VCD, SVCD, MP3)所用采样率

音频编码及常用格式

音频编码及常用格式 音频编码标准发展现状 国际电信联盟(ITU)主要负责研究和制定与通信相关的标准,作为主要通信业务的电话通信业务中使用的语音编码标准均是由ITU负责完成的。其中用于固定网络电话业务使用的语音编码标准如ITU-T G.711等主要在ITU-T SG 15完成,并广泛应用于全球的电话通信系统之中。目前,随着Internet网络及其应用的快速发展,在2005到2008研究期内,ITU-T将研究和制定变速率语音编码标准的工作转移到主要负责研究和制定多媒体通信系统、终端标准的SG16中进行。 在欧洲、北美、中国和日本的电话网络中通用的语音编码器是8位对数量化器(相应于64Kb/s的比特率)。该量化器所采用的技术在1972年由CCITT (ITU-T的前身)标准化为G.711。在1983年,CCIT规定了32Kb/s的语音编码标准G.721,其目标是在通用电话网络上的应用(标准修正后称为G.726)。这个编码器价格虽低但却提供了高质量的语音。至于数字蜂窝电话的语音编码标准,在欧洲,TCH-HS是欧洲电信标准研究所(ETSI)的一部分,由他们负责制定数字蜂窝标准。在北美,这项工作是由电信工业联盟(TIA)负责执行。在日本,由无线系统开发和研究中心(称为RCR)组织这些标准化的工作。此外,国际海事卫星协会(Inmarsat)是管理地球上同步通信卫星的组织,也已经制定了一系列的卫星电话应用标准。 音频编码标准发展现状 音频编码标准主要由ISO的MPEG组来完成。MPEG1是世界上第一个高保真音频数据压缩标准。MPEG1是针对最多两声道的音频而开发的。但随着技术的不断进步和生活水准的不断提高,有的立体声形式已经不能满足听众对声音节目的欣赏要求,具有更强定位能力和空间效果的三维声音技术得到蓬勃发展。而在三维声音技术中最具代表性的就是多声道环绕声技术。目前有两种主要的多声道编码方案:MUSICAM环绕声和杜比AC-3。MPEG2音频编码标准采用的就是MUSICAM环绕声方案,它是MPEG2音频编码的核心,是基于人耳听觉感知特性的子带编码算法。而美国的HDTV伴音则采用的是杜比AC-3方案。MPEG2规定了两种音频压缩编码算法,一种称为MPEG2后向兼容多声道音频编码标准,简称MPEG2BC;另一种是称为高级音频编码标准,简称MPEG2AAC,因为它与MPEG1不兼容,也称MPEG NBC。MPEG4的目标是提供未来的交互多媒体应用,它具有高度的灵活性和可扩展性。与以前的音频标准相比,MPEG4增加了许多新的关于合成内容及场景描述等领域的工作。MPEG4将以前发展良好但相互独立的高质量音频编码、计算机音乐及合成语音等第一次合并在一起,并在诸多领域内给予高度的灵活性。

音频编解码原理讲解和分析

音频编码原理讲解和分析 作者:谢湘勇,算法部,xie.chris@https://www.360docs.net/doc/f817291895.html, 2007-10-13 简述 (2) 音频基本知识 (2) 采样(ADC) (3) 心理声学模型原理和分析 (3) 滤波器组和window原理和分析 (6) Window (6) TDAC:时域混叠抵消,time domain aliasing cancellation (7) Long and short window、block switch (7) FFT、MDCT (8) Setero and couple原理和分析 (8) 量化原理和分析 (9) mp3、AAC量化编码的过程 (9) ogg量化编码的过程 (11) AC3量化编码的过程 (11) Huffman编码原理和分析 (12) mp3、ogg、AC3的编码策略 (12) 其他技术原理简介 (13) 比特池技术 (13) TNS (13) SBR (13) 预测模型 (14) 增益控制 (14) OGG编码原理和过程详细分析 (14) Ogg V orbis的引入 (14) Ogg V orbis的编码过程 (14) ogg心理声学模型 (15) ogg量化编码的过程 (16) ogg的huffman编码策略 (17) 主要音频格式编码对比分析 (19) Mp3 (19) Ogg (20) AAC (21) AC3 (22) DRA(A VS内的中国音频标准多声道数字音频编码) (23) BSAC,TwinVQ (24) RA (24) 音频编码格式的对比分析 (25) 主要格式对比表格如下 (26) 语音编码算法简介 (26) 后处理技术原理和简介 (28) EQ (28)

常见的音频编码标准

常见的音频编码标准 在自然界中人类能够听到的所有声音都称之为音频,它可能包括噪音、声音被录制下来以后,无论是说话声、歌声、乐器都可以通过数字音乐软件处理。把它制作成CD,这时候所有的声音没有改变,因为CD本来就是音频文件的一种类型。而音频只是储存在计算机里的声音。演讲和音乐,如果有计算机加上相应的音频卡,我们可以把所有的声音录制下来,声音的声学特性,音的高低都可以用计算机硬盘文件的方式储存下来。反过来,我们也可以把储存下来的音频文件通过一定的音频程序播放,还原以前录下的声音。自然界中的声音非常复杂,波形极其复杂,通常我们采用的是脉冲代码调制编码,即PCM编码。PCM通过抽样、量化、编码三个步骤将连续变化的模拟信号转换为数字编码。然而,3G网络带来了移动多媒体业务的蓬勃发展,视频、音频编解码标准是多媒体应用的基础性标准,但其种类较多,有繁花渐欲迷人眼之感。那么常见的编码技术就是我们必须知道的,下面我们介绍一下最常见的编码技术。 1.PCM PCM 脉冲编码调制是Pulse Code Modulation的缩写。PCM编码的最大的优点就是音质好,最大的缺点就是体积大。我们常见的Audio CD就采用了PCM编码,一张光盘的容量只能容纳72分钟的音乐信息。 2.W A V WA V是Microsoft Windows本身提供的音频格式,由于Windows本身的影响力,这个格式已经成为了事实上的通用音频格式。实际上是Apple电脑的AIFF格式的克隆。通常我们使用W A V格式都是用来保存一些没有压缩的音频,但实际上W A V格式的设计是非常灵活(非常复杂)的,该格式本身与任何媒体数据都不冲突,换句话说,只要有软件支持,你甚至可以在W A V格式里面存放图像。之所以能这样,是因为W A V文件里面存放的每一块数据都有自己独立的标识,通过这些标识可以告诉用户究竟这是什么数据。在WINDOWS 平台上通过ACM(Audio Compression Manager)结构及相应的驱动程序(通常称为CODEC,编码/解码器),可以在W A V文件中存放超过20种的压缩格式,比如ADPCM、GSM、CCITT G.711、G.723等等,当然也包括MP3格式。 虽然W A V文件可以存放压缩音频甚至MP3,但由于它本身的结构注定了它的用途是存放音频数据并用作进一步的处理,而不是像MP3那样用于聆听。目前所有的音频播放软件和编辑软件都支持这一格式,并将该格式作为默认文件保存格式之一。这些软件包括:Sound Forge, Cool Edit Pro, 等等。 3.MP3 MP3它的全称是MPEG(MPEG:Moving Picture Experts Group) Audio Layer-3,1993年由德国夫朗和费研究院和法国汤姆生公司合作发展成功。刚出现时它的编码技术并不完善,它更像一个编码标准框架,留待人们去完善。这个比喻相信大家都会同意。MP3是Fraunhofer-IIS研究的研究成果。MP3是第一个实用的有损音频压缩编码。在MP3出现之前,一般的音频编码即使以有损方式进行压缩能达到4:1的压缩比例已经非常不错了。但是,MP3可以实现12:1的压缩比例,这使得MP3迅速地流行起来。MP3之所以能够达到如此高的压缩比例同时又能保持相当不错的音质是因为利用了知觉音频编码技术,也就是利用了人耳的特性,削减音乐中人耳听不到的成分,同时尝试尽可能地维持原来的声音质量。 由于MP3是世界上第一个有损压缩的编码方案,所以可以说所有的播放软件都支持它,否则就根本没有生命力。在制作方面,也曾经产生了许多第三方的编码工具。不过随着后来Fraunhofer-IIS宣布对编码器征收版税之后很多都消失了。目前属于开放源代码并且免费的

视音频编解码技术发展现状和展望(四)

视音频编解码技术发展现状和展望(四) 4视音频编解码技术展望 由于数字视频编码的核心是对信号进行压缩,所以不断提高编码压缩效率仍是混合编码的主要发展目标。但是追求更高的压缩效率需要对传统的“变换+运动补偿+基于视觉的量化+熵编码”框架有所突破,给视频编码性能带来新的提升。 可伸缩的视频编码技术因为具有良好的网络适应性,所以围绕它的应用,尤其是网络环境下的应用,会越来越多。可以预见,在未来的网络视频监控中,可伸缩技术将是保证网络传输质量的一个重要实现技术。 而多视点编码方法的研究会集中在多视点视频的采集与校准,场景深度及几何信息获取(立体匹配),多视点视频编码,多视点视频通信,新视图渲染以及最终的交互或立体显示等6大关键上,这些技术的突破会为自由视点电视(FTV)、立体电视(3DTV)和沉浸感视频会议的应用提供技术支持。 作为SVC、MVC等各类视频编码的基础,混合框架的编码仍有很强的生命力。同时随着网络、通信、娱乐业对数字媒体的广泛需求,A VS、H.264这一代标准被普遍接受,相应的产品开发工作相当重要。包括编解码芯片、整机和系统。应用领域涉及数字电视、卫星电视、移动电视、手机电视、网络电视、时移电视机、新一代光盘存储媒体、安防监控、智能交通、会议电视、可视电话、数字摄像机等等。其中,安防监控领域是音视频编解码技术的主要应用领域之一。编解码技术在这个领域的应用,需要结合安防监控领域的特殊需求进行研究。只有在这个方向掌握有自主知识产权的核心技术,我国的安防监控产业才能健康持续的发展。 5 参考文献 1. ThomasWiegand, G.J.S., Senior Member, IEEE, Gisle Bj?ntegaard, and Ajay Luthra, Senior Member, IEEE, Overview of the H.264/AVC Video Coding Standard. IEEE TRANSACTIONS ON CIRCUITS AND SYSTEMS FOR VIDEO TECHNOLOGY, 2003. 13(7): p. 17. 2. 周秉锋, 郑.叶., JVT草案中的核心技术综述.软件学报, 2004. 15(1): p. 11. 3. Ostermann, J., Hybrid Coding: Where Can Future Ga ins Come from?” 2005. 4. Julien Reichel, H.S., Mathias Wien, Scalable Video Coding – Working Draft 2, JVT, Editor. 2005. 5. Dr Francesco Ziliani, J.-C.M., Scalable Video Coding In Digital Video Security. 2005. p. 19. 6. Wallace Kai-Hong Ho; Wai-Kong Cheuk; Lun, D.P.-K., Content-based scalable H.263 video coding for road traffic monitoring. IEEE Transactions on Multimedia, 2005. 7(4): p. 9. 7. Ser-Nam Lim; Davis, L.S.E., A., Scalable image-based multi-camera visual surveillance system, in AVSS.2003. 2003. 8. Nicolas, H., Scalable video compression scheme for tele-surveillance applications based on cast shadow detection and modelling, in Image Processing, 2005. ICIP 2005. IEEE International Conference on. 2005. 9. May, A.T., J.; Hobson, P.; Ziliani, F.; Reichel, J.;, Scalable video requirements for surveillance applications. Intelligent Distributed Surveilliance Systems, IEE, 2004: p. 4. 10. 陶钧, 王., 张军, 姜志宏, 三维小波视频编码的可伸缩性研究.小型微型计算机系统,

中国数字音视频编解码技术标准规定工作组

中国数字音视频编解码技术标准工作组 会员提案专利披露与许可承诺表 根据《中国数字音视频编解码技术标准工作组知识产权政策》第十四、十五、十六条等相关规定,AVS会员在向工作组各专题组提交技术提案时应填写本《会员提案专利披露与许可承诺表》,作为该提案的必要组成部分同时提交。 专题组名称:音频□视频□系统□DRM□ 提案AVS文档编号:_ 提案日期:________ 提案标题: 提案会员名称:_ 提案代表姓名(印刷体):Email: 提案代表通讯地址:邮编 电话:______ __ 传真:__ ______________________ 提案会员应当通过选中表A或者通过选中并填写表B相关部分完成此表。表C可以自愿填写。下列表格均可根据实际需要增加表格行。 表A: 提案会员在其实际知晓的范围内已获知本提案不涉及提案会员和他人的专利、专利申请和专利计划。□ 表B-1: 在中华人民共和国已获得授权的专利和/或已公开的专利申请□如果本提案中包含提案会员或其关联者在中华人民共和国已获得授权的专利和/或已公开的专利申请,

表B-2: 在中华人民共和国未公开的专利申请□ 如果提案会员的缺省许可义务不是RAND-RF或者POOL,当提案会员或其关联者有与此提案相关的未公开的中华人民共和国专利申请时,提案会员必须选中此表。 表B-3: 在中华人民共和国之外已获得授权的专利和/或已公开的专利申请□如果本提案中包含提案会员或其关联者在中华人民共和国之外已获得授权的专利和/或已公开的专利申请,提案会员应当填写下表: 表B-4: 在中华人民共和国之外未公开的专利申请□ 如果提案会员的缺省许可义务不是RAND-RF或者POOL,当提案会员或其关联者有与此提案相关的在中华人民共和国之外的未公开的专利申请时,提案会员必须选中此表。 提案会员可在下表中自愿披露上述未公开的专利申请的具体情况及选择许可承诺: