基于拼音索引的中文模糊匹配算法

ISSN 100020054CN 1122223 N

清华大学学报(自然科学版)J T singhua U niv (Sci &Tech ),2009年第49卷第S 1期

2009,V o l .49,N o .S 116 31

132821332

基于拼音索引的中文模糊匹配算法

曹 犟1,2

, 邬晓钧2

, 夏云庆2

, 郑 方

2

(1.清华大学计算机科学与技术系,北京100084;

2.清华信息科学技术国家实验室技术创新和开发部语音和语言技术中心,北京100084)

收稿日期:2009203219

基金项目:国家自然科学基金资助项目(60703051)作者简介:曹犟(1984—),男(汉),湖北,硕士研究生。通讯联系人:郑方,研究员,E 2m ail :fzheng @tsinghua .edu .cn

摘 要:主流商业搜索引擎主要基于关键词精确匹配技术。为提高在用户的输入错误时的检索效率,提出了有索引的汉语模糊匹配算法。该算法采用汉字、拼音和拼音改良的编辑距离这3种汉字相似程度的不同度量方式,对用户查询进行扩展,将模糊匹配转化为多个精确匹配,对精确匹配的结果按与查询串的相似程度进行排序。在实验中,将该方法应用于网页文本语料库中。在使用基于拼音改良的编辑距离度量方式时,在时间和空间复杂度增长不大的情况下,该方法取得了60.42%的准确率与50.41%召回率。关键词:文件信息处理;拼音索引;模糊匹配;查询扩展中图分类号:T P 391.1 文献标识码:A 文章编号:100020054(2009)S 121328205

P i ny i n -i ndexed m ethod for approx i m a te ma tch i ng i n Ch i nese

CAO J ia ng

1,2

,W U Xia o jun 2,XI A Yunq ing 2,ZHENG Fa ng

2

(1.D epart m en t of Co m puter Sc ience and Technology ,Tsi n ghua Un iversity ,Be ij i n g 100084,Ch i n a ;

2.Cen ter for Speech and Language Technolog ies ,D iv ision of Techn ica l I nnova tion and D evelop m en t ,Tsi nghua Nationa l Labora tory for I nfor ma tion Sc ience and Technology ,Be ij i ng 100084,Ch i na )Abstract :T he exact m atch ing of keyw o rds is key to popular comm ercial search engines .A Ch inese app roxi m ate m atch ing m ethod w ith an index structure w as developed to ach ieve better retrieval w hen the inpu t con tains erro rs .T h ree types of si m ilarity m easu rem en t betw een two Ch inese strings w ere developed based on the character edit 2distance,the P inyin edit 2distance and the P inyin i m p roved edit 2distance .T he si m ilarity m easurem en ts w ere used to expand the user ’s query so that the app rox i m ate m atch ing task can be rep resented as several exact m atch ing sub 2task s .T he results of these exact m atch ings are m erged and so rted by their si m ilarity to the o riginal query .T ests on a w ebpage tex t database gave a 50.4%recall rate w ith the P inyin i m p roved edit 2distance w ith a 60.4%p recisi on w ith a s m all increase in ti m e and space comp lex ity .Key words :p inyin 2indexed;P inyin (spelling of Ch inese )index;app roxi m ate m atch ing;query expansi on

现有的主流商业信息检索系统大部分采用基于关键词精确匹配的检索技术,取得了一定的成果[1]

。但是在实际应用中,用户的查询输入与检索系统数据库的构建都不可能完全正确[2]

。用户对于搜索主题所处的领域不了解,采用不合适的查询词,会导致查询词的覆盖范围大大缩小[3]

;在中文信息检索系统中,用户还常会输入同音或近音的错别字。模糊检索根据用户输入的模糊特征来检索匹配内容,可处理精确的关键词匹配所无法解决的这些问题[4]

。

在英文检索系统中,通常对用户输入的单词进

行拼写纠错,就能解决大多数问题[5]

。系统先搜索单

词表,找出所有与查询串中单词的编辑距离(edit distance )在一定限度之内的所有词汇,再根据这些词汇来执行精确检索,即可在一定程度上实现模糊

检索[4]

。所以,英文模糊检索的主要研究集中在快速

简捷的字符串的模糊匹配算法方面[6-7]。考虑到查询串的整体性,文[8]提出了块索引的方法,通过二步的模糊匹配过程,找到与查询串整体编辑距离在一定限度之内的串的位置。

汉语是典型的非字母语言,把任意两个汉字的差别都算成同一个值不够精确。绝大多数汉字都是表意单元,词语的搭配灵活多样,难以建立完整的词表用于纠错。所以汉语的模糊检索无法照搬英文中的方法,目前的研究主要集中在快速的汉字串模糊匹配算法方面[9-10]。其中,文[9]的研究工作改善了模糊匹配的时空复杂度,在实际系统中算法的时间复杂度可以达到子线性,在实际的实验中也取得了很好的效果。然而,遍历整个文本集来寻找相似串的出现位置,虽然可以比较准确地完成模糊检索任务,

,时间开销依然难以接受。

本文提出一种基于汉语拼音的模糊检索方法。与前述思路不同,通过扩展原始的查询串,将模糊检索任务转化为若干精确匹配的检索任务,从而大大降低算法复杂度。

1 汉字串相似度度量

参考英文基于字母编辑距离的度量方式,本文提出3种汉字串相似度的度量方式:基于汉字的编辑距离、基于拼音的编辑距离,以及基于拼音改良的编辑距离。

1.1 基于汉字的编辑距离

将单个汉字作为编辑距离中的距离度量单位,即:两个汉字串之间的距离,等于使它们完全一样所需的最少替换、插入或者删除的汉字个数。

1.2 基于拼音的编辑距离

由于汉语拼音输入法的广泛使用,大部分用户的输入错误都表现为同音字或者近音字的替换误用,对Sogou实验室所提供的用户日志的分析结果也证实了这一点。基于此,本文提出了基于拼音的编辑距离来衡量汉字串的相似度。如果把拼音串简单地看作广义的英文字母串,则替换、插入或者删除一个字母后,所得结果不一定是合法的拼音串。因此应从音节的角度来分析拼音串的差别。

对于一个单独的音节来说,它与另外一个音节的差异总可以分解为以下三种变化:声母变化、韵母变化和声调变化。声母、韵母和声调的可能取值都是有限的,可以枚举定义从一种取值变为另一种取到所有与它编辑距离为n的音节。例如,要找到所有与它编辑距离是2的音节,那么变化可能是声母改变1个距离单位,韵母改变1个距离单位,声调改变0个距离单位;或者声母改变2个距离单位,韵母和声调没有发生改变。这只是一个排列组合的问题。

如果给所有音节编号,将音节整体看作一个特殊的单字,那么基于拼音的编辑距离可认为是基于汉字的编辑距离的细化,即不同的汉字之间根据拼音的近似程度有不同的距离,而不是笼统地将任意两个汉字的距离都计为1。

1.3 基于拼音改良的编辑距离

根据前述基于拼音的编辑距离定义,音节 li3 和 n i3 的编辑距离是1, li3 和 p i3 的编辑距离也是1。但是这2组音节的差异从发音机理角度来看, li3 与 n i3 更加近似。类似的例子如:音节 lin3 与 ling3 的差异较小,而 lin3 和 lan3 的差异较大。

基于以上考虑,提出改良的编辑距离计算方式如下。

1)发音相似(容易发生替换错误)的声母或韵母之间差异小于1。例如, l 和 n 、 z 和 zh 、 c 和 ch 等声母对, in 和 ing 、 en 和 eng 等韵母对,对音节编辑距离的贡献小于1(本文实验中赋予0.5的替换代价),这样的声母和韵母对一共是9对。对于其余的声母或者韵母对的替换代价的计算,则依然采用方法二中的使用字符编辑距离的计算方法。

2)若同一音节的声母和韵母同时发生改变,则在计算编辑距离时给予一个正的惩罚值(本文实验中取值为2)。根据这一计算方式,对于音节串A=

I1I2I3…I n(其中I i,i=1,2,…,n代表一个音节),若I2在声母和韵母上同时发生差异为1的变化得到新的音节串B=I

1I

′

2I3

…I

n

,I1和I3各发生一个声母或

韵母的差异为1的变化得到新的音节串C=I′

1I2I

′

3…

I n,则C与A之间的编辑距离为2,小于B与A之间的编辑距离4。

3)音调变化导致的差异小于1。由于音调错误比较常见和普遍,而且广泛使用的各种拼音输入法都不要求用户输入音调,所以可认为音调差异小于一般声母和韵母之间的差异,因而,按照发音相似的韵母和声母对一样的处理方式,这种差异在本文实验中赋予0.5的替换代价。

在本文实验中,由于将所有小于1的差异都赋

9231

曹 犟,等: 基于拼音索引的中文模糊匹配算法

值为0.5,因此将所有的差异都乘以2之后,可以得到结果为整数的编辑距离,而这并不影响不同串之间相似度大小的比较。

2 索引与查询扩展

依据具体的距离度量方式,可以扩展原始的查询串,将模糊匹配转化成多个相关的精确匹配,实现检索任务,步骤是:首先对查询串进行编辑距离由小到大的扩展,然后对扩展出的查询串进行精确匹配,精确匹配的结果在去重之后再按照查询串的编辑距离由小到大进行排序,最后将排序的检索结果返回给用户。2.1 建立索引

在本文提出的模糊检索系统中,以离线方式对文本数据集中的单字或者音节建立索引。这是因为,在第1节中所提出的3种距离度量方式都以单字或音节作为最小的考察和计算单位。当采用2种基于拼音的距离度量方式时,要先将文本逐句地转成拼音串(逐句进行拼音的自动标注可以更好地联系上下文处理多音字、变音字等拼音现象),然后再以音节为单位构建索引。

在文本数据集的索引表中,需要记录索引头(本索引对应的单字或者音节),以及索引头在文本数据集合中出现过的所有位置(文本号以及在文本中出现的具体位置)。2.2 汉字串近邻空间

在对原始查询串进行扩展时,需要引入汉字串

近邻空间的概念。

定义1 在具体的汉字串相似度度量方式下,所有与目标串编辑距离为m 的汉字串组成的集合,称为该目标串的m 近邻空间。m 近邻空间中每一个汉字串,称为该目标串的一个m 近邻串。

将查询串按编辑距离进行由小到大的扩展,其实质就是依次计算查询串的各个近邻空间。而近邻空间内汉字串的数量,直接影响遍历该近邻空间的时间复杂度。下面以基于汉字的编辑距离为例,对近邻空间进行分析。

令汉语体系全部汉字的集合为2,则所有长度

为n 的汉字串总数为 2 n

。对于一个长度为n (n 远小于 2 )的汉字串X ,它的0近邻空间显然只包含它自身。

对于X 的1近邻空间,编辑距离可能由替换、插入和删除这3种方式之一造成。以替换为例,长度为的汉字串共有个可能的替换位置,每个替换都有

2 -1个候选的替换汉字,因此只考虑替换可得到

n ( 2 -1)个与X 编辑距离为1的汉字串。对插入和删除操作进行类似的分析可知:只考虑插入可以得

到约(n +1) 2 个汉字串,只考虑删除则可以得到n 个汉字串。所以总的来说,12近邻空间内所有汉字串的数目大约是(2n +1) 2 。在实际应用中,n 一般不超过10, 2 的大小至少在103

数量级上,所以12近邻空间内汉字串的数目也至少是103

的数量级。

对于X 的m 近邻空间内的串,一共发生了m 处替换、插入或删除。可近似地认为串X 共有(n +1)个位置能够插入汉字,有n 个位置的汉字能够删除或者替换。假设在m 处变化中有a 次插入,m -a 次

删除或替换,则可产生新的汉字串约C a n +1 2 a

×C m -a

n

2

m -a

个(其中C a

n +1表示组合数,下同),因此m

近邻空间内所有串的数目大约为

∑m

a =0

C

a n +1

C m -a

n

2 m

=C m

2n +1 2 m

.

在实际应用中,虽然m 的取值通常不超过n 2,但m 近邻空间内的串仍然数量巨大。

对于如此数量级的近邻空间,不可能逐一访问其中每个近邻串来进行检索。即使有可能在较小的时间开销内判断某个汉字串是否符合中文语法,从而去掉许多不合理的近邻串,这一判断过程需要进行的次数也是惊人的。因此,必须通过其他的方式来遍历近邻空间,完成对原始查询串的扩展。2.3 查询扩展和模糊检索

依然以基于汉字的编辑距离度量方式为例,介绍本文的模糊检索系统进行查询扩展并检索的过程。

令用户输入的查询串为A =a 1a 2…a n ,其中a i

(i =1,2,…,n )是汉字。在A 的1近邻空间中,所有因a i 被替换所生成的串有B i =a 1a 2…a i -1x a i +1…a n 的形式,其中x ∈2且x ≠a i 。B i 实际上代表 2 -1个不同汉字串,称B i 为通配串。在检索时,先分别精确地检索两个子串B i 1=a 1a 2…a i -1和B i 2=a i +1a i +2…

a n 在数据集中出现的位置,然后对两个子串的位置

进行比较,找到串B i 1和串B i 2同时出现且B i 1在B i 2的i +1个位置前出现的文本。由于替换可能发生在n 个

不同的位置,所以类似的通配串有n 个。对于插入和删除两种改变方式,可构造类似的通配串扩展并检索。

分析上述过程的复杂度。考虑插入、删除和替换这3种操作,则在12近邻空间内通配串的总数目大

331清华大学学报(自然科学版)2009,49(S 1)

约是3n,每个串通过至多2次的精确匹配实现模糊

检索。考虑到精确匹配的结果可以被不同的通配串共享,实际上只需经过2n-1次精确匹配即可实现12近邻空间内的所有串的检索,这相对于12近邻空间内串的总数量大大减少了。

对于A的m近邻空间(m>1),方法是类似的。在编辑距离为m时,可近似认为串有2n+1个位置可能发生改变,相应通配串的数目约为C m

2n+1。由于进行精确匹配的通配串的子串实际上都是原输入串的子串,而原输入串的子串总数量为n(n+1) 2,所以实际最多进行n(n+1) 2次精确匹配。

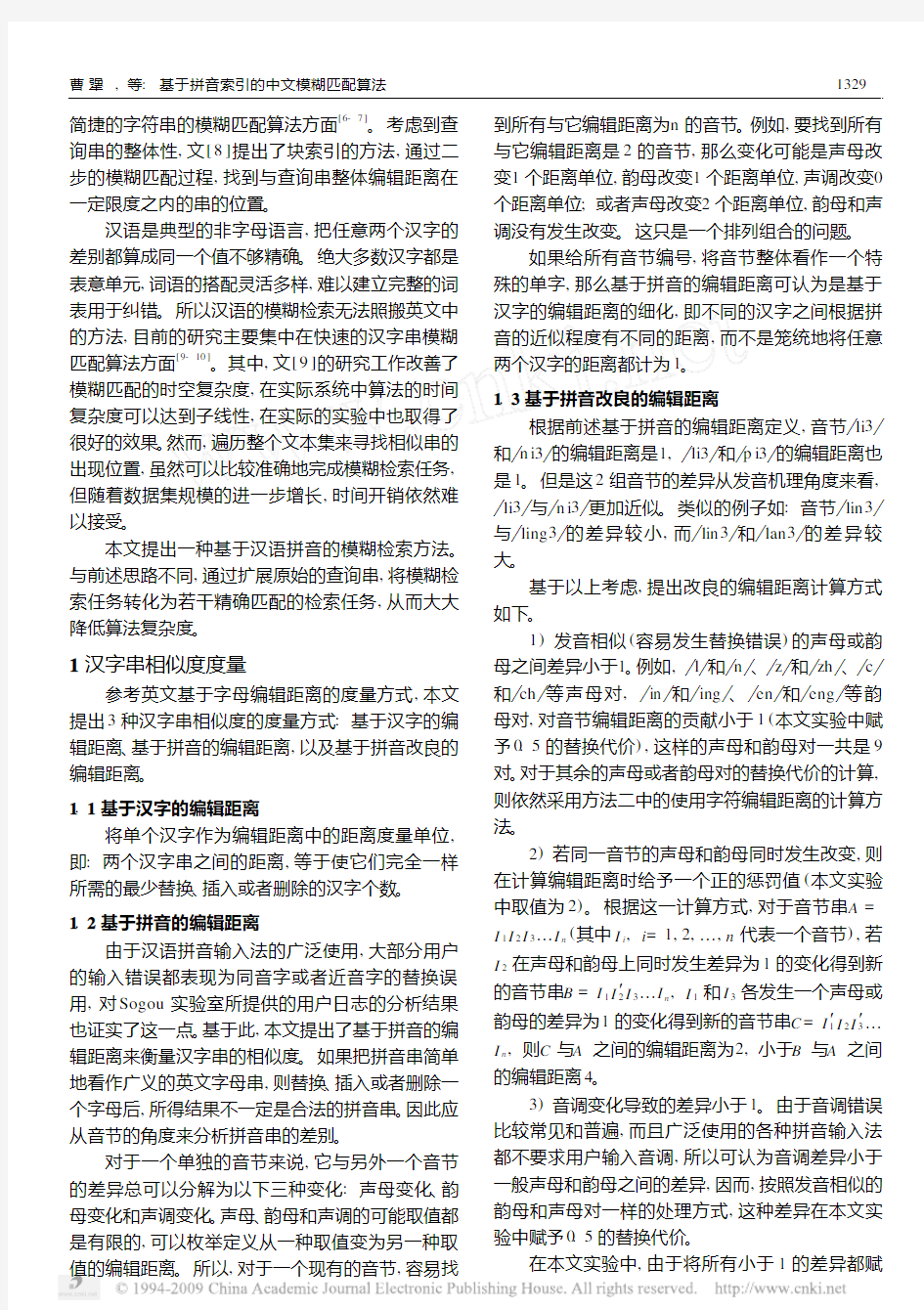

随着m的增长(m 上述查询扩展是在基于汉字的编辑距离度量方式下实现的。当采用基于拼音的两种编辑距离度量方式时,总体思路类似,区别在以下2点:1)在获取用户查询串之后,首先将它转换为拼音串;2)在查 询串的扩展过程中,替换生成的通配串B i中的x不可能取所有音节,而是与a i差异为1的音节集合W 中的元素,因此在考察子串B i1 和B i2的相对位置关系时,需要判断它们之间的那个音节是否属于集合W。 对于以上得到的查询结果,首先要进行去重,然后按照它们被检索出来时所考虑的编辑距离,从小到大依次排列,反馈给用户。 综上所述,通过将用户查询扩展并分割成多个精确匹配的查询,避免了逐一遍历整个近邻空间的操作,仅仅在通常的精确检索的几倍时间内,完成模糊检索的任务。 3 实 验 对于本文中提出的查询扩展算法的正确性,也就是说查询扩展算法是否按照定义的距离度量方式从“近”到“远”的返回相应的文本,在算法层面上已经得到了证明,对于输出结果的抽查也保证了这一点。 同时,本文提出的基于索引的匹配方法相比较常见的依次顺序匹配的方法在时间复杂度上的差异十分明显,所以并不是关注的焦点。 因而,设计实验的主要目的在于考察以上几种 不同的距离度量方式,是否能够很好的满足用户的需求,因而设计了以下几组实验进行测试比较: 3.1 实验设计 实验中使用的文本数据来源于搜狐—清华大学联合实验室(Sogou,搜狗实验室)提供的网页文本数据集合,从中选取了约4万篇长度处于整个数据集合平均长度附近的文本。这些文本全部来源于真实网页,并且去除了h tm l标引符号,只保留了文本内容。文本数据集的总大小为79.3M B,每个文本的平均长度为930个汉字。将这些数据作为实验中待匹配的文本。 实验中一共采用了400组用户查询串作为匹配的目标串。每组查询串由一个错误查询和与之对应的正确查询组成。错误查询全部来源于Sogou实验室提供的用户查询日志,由人工选取其中一些明显有错的查询,并且人工对它进行了更正。为了不失一般性,在选取的过程中没有刻意挑选错误类型为拼音的查询串,因而这些错误查询能够在一定程度上代表信息检索系统实际的用户错误输入情况。经统计,这些错误查询的平均长度为6个汉字,其中95%左右是拼音相关错误。 在实际的实验中,错误串可以被认为代表用户给予搜索引擎的错误输入,而人工更正则代表用户的真实意图。因而使用错误输入进行匹配的结果,是否能够满足用户的真实意图,就是要考察的重要指标。 3.2 评测指标 假设查询串B是错误查询,串A是它的人工更正。对A进行精确匹配的检索,得到结果集包含有n 个结果:8={W 1 ,W2,W3,…,W n},把8视作本组查询的标准输出。 如果对串B进行精确匹配的检索,则无法得到正确的查询结果。在实验中,分别利用第2节中提到的3种编辑距离度量方式来对错误串进行模糊检 索。令排序后输出的前p个文本构成集合?={X 1 , X2,X3,…,X p},而且在这p个文本中,若有x个文本在集合8中,则认为模糊匹配系统Top p的准确率为x p,召回率为x n。这两个指标可以用来实际反映本文提出的模糊匹配系统对于用户意图的匹配程度。 3.3 实验结果和分析 实验所用的文本集合规模为4万,正确的查询 1331 曹 犟,等: 基于拼音索引的中文模糊匹配算法 串一共400个,它们得到的检索结果8平均含大约7篇文本。其中,包含结果数不多于3的query有31. 25%,包含结果数不多于10的query有78.75%,包含结果数不多于30的query有97.5%。 完成了3组对比实验。实验数据结果如表1。其中,Top3、Top10和Top30分别指在前3个、前10个和前30个查询返回结果的集合上进行统计和计算的结果。 表1 模糊匹配系统的准确率和召回率 距离度量方式 准确率 %召回率 % Top3Top10Top30Top3Top10Top30 基于汉字 31.4818.1511.7745.3360.9875.57基于拼音 53.7028.2316.8251.4076.5589.52基于拼音的改进60.4234.1719.6254.3184.4591.70 从表1可以看出,在准确率和召回率这2项指标上,2种基于拼音的度量方式都比基于汉字的度量方式有较大提高,这是由于拼音能够更好地刻画汉字串之间的相似程度。基于拼音改良的度量方式,在准确率和召回率上,都取得了最好的实验结果,说明引入语音学知识对性能提高有帮助。 从表1还可以看出,前30个查询结果已经能够达到90%左右的召回率,而返回前30个结果,一般只需要对原始的错误查询串扩展出不多于10次的扩展。此外,对于4万个文本组成的共79.3M B的文本集合,建立的索引(单级索引,未压缩)大小在100 M B左右,基于音节建立的索引与基于单字建立的索引相比,大小并没有显著增加。 4 结论与未来工作 本文所提出的基于拼音改良的编辑距离度量方式,依然存在一些局限性。虽然在实际检索系统的输入中,拼音相关错误占有非常高的比例(在Sogou用户日志的统计中,这一比例超过了90%),但是对于其他类型的错误,例如形近字和近义词带来的错误,本方法提出的距离度量方法并不能很好地进行度量和表征,依然有待进一步的研究。 同时,工作在方法依然有较大的改进空间:可以引入语言学方面的知识,以及根据用户日志的实际统计结果,对于每一种改变赋予的权值采用更细致合理的规定。如果两个汉字串的相似度不能方便地转换成整数,如何完备地对查询进行扩展,也是值得研究的问题。 未来,计划研究本文提出的查询扩展和检索思路在多级索引下的应用,考察模糊检索的性能,并进行相应的算法改进。同时,结合汉语中的词汇和二元拼音文法进行拼音索引,引入这些先验知识可以有效地降低查询扩展的次数,同时实际的用户大部分也是以词为单位进行输入,引入词汇知识可以更好地匹配用户的实际情况。 致谢 本文在研究工作中,使用了搜狗(Sogou)实验室无偿开放的文本数据和用户日志,在此表示衷心的感谢。 参考文献 (References) [1]M anning C,R aghavan P,Schütze H.Introducti on to Info r m ati on R etrieval.[M].Cam bridge U niversity P ress. 2008. [2]M itra M,Singhal A,Buck ley C.I mp roving A utom atic Q uery Expansi on[C] P roc of the21st A nn Int A CM2S IG I R Conference on R eser and D ev in Info R etrieval, 1998. [3]A rauj o M,N avarro G,Ziviani N.L arge text search ing allow ing erro rs[C] P roc W SP97.V alparaiso,Chile: Carleton U niversity P ress.1997,8:2-20. [4]N avap ro G.A guided tour to app roxi m ate string m atch ing [J].A CM C o m p u ting S u rvey s,2001,33(1):31-88. [5]Boyer R,M oo re J.A fast string search ing algo rithm[J]. C o mm unications of the A CM,1977,20(10):762-772. [6]T arh i o J,U kkonen E.A pp roxi m ate Boyer2M oo re string m atch ing[J].S IA M J on Co m p u ting,1993,22(2):243- 260. [7]Knuth D,M o rris J,P ratt V.Fast pattern m atching in strings[J].S IA M J on C o m p u ting,1977,6(2):323- 350. [8]Baeza2Yates R,N avarro G.B lock2addressing indices fo r app roxi m ate text retrieval[J].J A m S oc Inf o S ci,2000, 51(1):69-82. [9]王静帆,邬晓钧,夏云庆,等.中文信息检索系统的模糊匹 配算法研究和实现[J].中文信息学报,2007,21(6):59- 64. WAN G J ingfan,WU X iao jun,X I A Yunqing,et al.A n app roxi m ate string m atching algo rithm fo r Ch inese info rm ati on retrieval system s[J].J C h in Inf o P roc,2007, 21(6):59-64.(in Ch inese) [10]陈儒.面向短信过滤的中文信息模糊匹配技术[D].哈尔滨: 哈尔滨工业大学信息检索实验室.2003. CH EN R u.A pp roxi m ate String M atch ing A lgo rithm fo r Cell2phone N o tes F iltering[D].Info R etrieval L ab,H arbin Institute of T echno logy,2003.(in Ch inese) 2331清华大学学报(自然科学版)2009,49(S1) ISSN 100020054CN 1122223 N 清华大学学报(自然科学版)J T singhua U niv (Sci &Tech ),2009年第49卷第S 1期 2009,V o l .49,N o .S 116 31 132821332 基于拼音索引的中文模糊匹配算法 曹 犟1,2 , 邬晓钧2 , 夏云庆2 , 郑 方 2 (1.清华大学计算机科学与技术系,北京100084; 2.清华信息科学技术国家实验室技术创新和开发部语音和语言技术中心,北京100084) 收稿日期:2009203219 基金项目:国家自然科学基金资助项目(60703051)作者简介:曹犟(1984—),男(汉),湖北,硕士研究生。通讯联系人:郑方,研究员,E 2m ail :fzheng @tsinghua .edu .cn 摘 要:主流商业搜索引擎主要基于关键词精确匹配技术。为提高在用户的输入错误时的检索效率,提出了有索引的汉语模糊匹配算法。该算法采用汉字、拼音和拼音改良的编辑距离这3种汉字相似程度的不同度量方式,对用户查询进行扩展,将模糊匹配转化为多个精确匹配,对精确匹配的结果按与查询串的相似程度进行排序。在实验中,将该方法应用于网页文本语料库中。在使用基于拼音改良的编辑距离度量方式时,在时间和空间复杂度增长不大的情况下,该方法取得了60.42%的准确率与50.41%召回率。关键词:文件信息处理;拼音索引;模糊匹配;查询扩展中图分类号:T P 391.1 文献标识码:A 文章编号:100020054(2009)S 121328205 P i ny i n -i ndexed m ethod for approx i m a te ma tch i ng i n Ch i nese CAO J ia ng 1,2 ,W U Xia o jun 2,XI A Yunq ing 2,ZHENG Fa ng 2 (1.D epart m en t of Co m puter Sc ience and Technology ,Tsi n ghua Un iversity ,Be ij i n g 100084,Ch i n a ; 2.Cen ter for Speech and Language Technolog ies ,D iv ision of Techn ica l I nnova tion and D evelop m en t ,Tsi nghua Nationa l Labora tory for I nfor ma tion Sc ience and Technology ,Be ij i ng 100084,Ch i na )Abstract :T he exact m atch ing of keyw o rds is key to popular comm ercial search engines .A Ch inese app roxi m ate m atch ing m ethod w ith an index structure w as developed to ach ieve better retrieval w hen the inpu t con tains erro rs .T h ree types of si m ilarity m easu rem en t betw een two Ch inese strings w ere developed based on the character edit 2distance,the P inyin edit 2distance and the P inyin i m p roved edit 2distance .T he si m ilarity m easurem en ts w ere used to expand the user ’s query so that the app rox i m ate m atch ing task can be rep resented as several exact m atch ing sub 2task s .T he results of these exact m atch ings are m erged and so rted by their si m ilarity to the o riginal query .T ests on a w ebpage tex t database gave a 50.4%recall rate w ith the P inyin i m p roved edit 2distance w ith a 60.4%p recisi on w ith a s m all increase in ti m e and space comp lex ity .Key words :p inyin 2indexed;P inyin (spelling of Ch inese )index;app roxi m ate m atch ing;query expansi on 现有的主流商业信息检索系统大部分采用基于关键词精确匹配的检索技术,取得了一定的成果[1] 。但是在实际应用中,用户的查询输入与检索系统数据库的构建都不可能完全正确[2] 。用户对于搜索主题所处的领域不了解,采用不合适的查询词,会导致查询词的覆盖范围大大缩小[3] ;在中文信息检索系统中,用户还常会输入同音或近音的错别字。模糊检索根据用户输入的模糊特征来检索匹配内容,可处理精确的关键词匹配所无法解决的这些问题[4] 。 在英文检索系统中,通常对用户输入的单词进 行拼写纠错,就能解决大多数问题[5] 。系统先搜索单 词表,找出所有与查询串中单词的编辑距离(edit distance )在一定限度之内的所有词汇,再根据这些词汇来执行精确检索,即可在一定程度上实现模糊 检索[4] 。所以,英文模糊检索的主要研究集中在快速 武汉工程大学 文献检索课 综合实习报告 检索课题(中英文):Today’s average car cortains more than 15000 separate, individual parts that must work together.These parts can grouped into four major categories:engine,body,chassis and electrical equipment. 现代汽车有超过15000个零件组成,分成几个必须在一起工作的功能部分,重要包括4个功能部分:引擎,车身,底盘和控制。 姓名: X X 学号: 系(院):总成绩______________________ 班级(文献检索课): 说明及要求 1、本报告中的题录格式书写要求:第一作者、文献标题、文献出处(刊名、年、卷期、起止页码),参照以下格式: Morse SP. Factors in the emergence of infectious disease. Emerg Infect Dis 1995; 53(2): 117-21 2、若指定数据库查不到相关文献,写出检索式,在“检出篇数”一项内填写零。 3、检出篇数指按检索词或检索式实际检出的篇数,而非经人工筛选的切题篇数。列出题录可经人工筛选出最切题的。 4、检索式包括检索词、字段限定、检索途径(简单或高级检索等) 5、在检索结果不理想时,如检出篇数为零时可进行检索词调整,在报告中应对检索策略作说明。 6、“综合检索实习报告”为本课程考核形式,5月30日前由各班班长统一收齐后交报告的打印稿。如两份检索报告相同,两份都记为零分。 编辑距离:是指两个字串之间,由一个转成另一个所需的最少编辑操作次数;俄罗斯科学家Vladimir Levenshtein在1965年提出这个概念;编辑距离越小的两个字符串越相似,当编辑距离为0时,两字符串相等。 距离:两个子串之间的“差异”叫做距离。 海明距离:相同位相同值的个数。 Hash函数:就是把任意长度的输入(又叫做预映射,pre-image),通过散列算法,变换成固定长度的输出,该输出就是散列值。这种转换是一种压缩映射,也就是,散列值的空间通常远小于输入的空间,不同的输入可能会散列成相同的输出,所以不可能从散列值来确定唯一的输入值。简单的说就是一种将任意长度的消息压缩到某一固定长度的消息摘要的函数。 Simhash算法:分为5个步骤:分词(带权重w)、hash(得hash值)、加权(hash值*w)、合并(多关键词)、降维(海明距离)。 算法伪代码: 1,将一个f维的向量V初始化为0;f位的二进制数S初始化为0; 2,对每一个特征:用传统的hash算法对该特征产生一个f位的签名b。对i=1到f: 如果b的第i位为1,则V的第i个元素加上该特征的权重; 否则,V的第i个元素减去该特征的权重。 3,如果V的第i个元素大于0,则S的第i位为1,否则为0; 4,输出S作为签名。 通配符:一种特殊语句,主要有星号(*)和问号(?),用来模糊搜索文件。当查找文件夹时,可以使用它来代替一个或多个真正字符;当不知道真正字符或者懒得输入完整名字时,常常使用通配符代替一个或多个真正的字符。 TF词频(Term Frequency):是指某一个给定的词语在该文件中出现的次数。一种统计方法, 大数据常用的算法(分类、回归分析、聚类、关联规则) 在大数据时代,数据挖掘是最关键的工作。大数据的挖掘是从海量、不完全的、有噪声的、模糊的、随机的大型数据库中发现隐含在其中有价值的、潜在有用的信息和知识的过程,也是一种决策支持过程。其主要基于人工智能,机器学习,模式学习,统计学等。通过对大数据高度自动化地分析,做出归纳性的推理,从中挖掘出潜在的模式,可以帮助企业、商家、用户调整市场政策、减少风险、理性面对市场,并做出正确的决策。目前,在很多领域尤其是在商业领域如银行、电信、电商等,数据挖掘可以解决很多问题,包括市场营销策略制定、背景分析、企业管理危机等。大数据的挖掘常用的方法有分类、回归分析、聚类、关联规则、神经网络方法、Web 数据挖掘等。这些方法从不同的角度对数据进行挖掘。 (1)分类。分类是找出数据库中的一组数据对象的共同特点并按照分类模式将其划分为不同的类,其目的是通过分类模型,将数据库中的数据项映射到摸个给定的类别中。可以应用到涉及到应用分类、趋势预测中,如淘宝商铺将用户在一段时间内的购买情况划分成不同的类,根据情况向用户推荐关联类的商品,从而增加商铺的销售量。 (2)回归分析。回归分析反映了数据库中数据的属性值的特性,通过函数表达数据映射的关系来发现属性值之间的依赖关系。它可以应用到对数据序列的预测及相关关系的研究中去。在市场营销中,回归分析可以被应用到各个方面。如通过对本季度销售的回归分析,对下一季度的销售趋势作出预测并做出针对性的营销改变。 (3)聚类。聚类类似于分类,但与分类的目的不同,是针对数据的相似性和差异性将一组数据分为几个类别。属于同一类别的数据间的相似性很大,但不同类别之间数据的相似性很小,跨类的数据关联性很低。(4)关联规则。关联规则是隐藏在数据项之间的关联或相互关系,即可以根据一个数据项的出现推导出其他数据项的出现。关联规则的挖掘过程主要包括两个阶段:第一阶段为从海量原始数据中找出所有的高频项目组;第二极端为从这些高频项目组产生关联规则。关联规则挖掘技术已经被广泛应用于金融行业企业中用以预测客户的需求,各银行在自己的ATM 机上通过捆绑客户可能感兴趣的信息供用户了解并获取相应信 中科院大博士是如何进行文献检索和阅读 一.如何进行文献检索 我是学自然科学的,平时确实需要不少外文文献,对于自然科学来讲英文文献检索首推Elsevier,Springer等。虽然这些数据库里面文献已经不算少了。但是有时还会碰到查不到的文献,而这些文献的数据库我们所在研究所或大学又没有买,怎么办?我基本通过以下向个途径来得到文献。 1.首先在Google 学术搜索里进行搜索,里面一般会搜出来你要找的文献,在Google学术搜索里通常情况会出现“每组几个”等字样,然后进入后,分别点击,里面的其中一个就有可能会下到全文,当然这只是碰运气,不是万能的,因为我常常碰到这种情况,所以也算是得到全文文献的一条途径吧。可以试一下。同时,大家有没有发现,从Google学术搜索中,还可以得到一些信息,Google学术搜索中会显示出你搜索文章的引用次数,不过这个引用次数不准确,但是从侧面反应了这篇文章的质量,经典文章的引用次数绝对很高的.同时如果你用作者进行搜索时,会按引用次数出现他写的全部的文章,就可以知道作者的哪些文章比较经典,在没有太多时间的情况下,就可以只看经典的. 2.如果上面的方法找不到全文,就把文章作者的名字或者文章的title在Google 里搜索(不是Google 学术搜索),用作者的名字来搜索,是因为我发现很多国外作者都喜欢把文章的全文(PDF)直接挂在网上,一般情况下他们会把自己的文章挂在自己的个人主页(home page)上,这样可能也是为了让别的研究者更加了解自己的学术领域,顺便推销自己吧。这样你就有可能下到你想要的文献的全文了。甚至可以下到那个作者相近的内容的其它文章。如果文献是由多个作者写的,第一作者查不到个人主页,就接上面的方法查第二作者,以此类推。用文章的title来搜索,是因为在国外有的网站上,例如有的国外大学的图书馆可能会把本校一年或近几年的学术成果的Publication的PDF全文献挂在网上,或者在这个大学的ftp上也有可能会有这样类似的全文.这样就很可能会免费下到你想要的全文了. 3.如果上面两个方法都没有查到你要的文献,那你就直接写邮件向作者要。一般情况下作者都喜欢把自己的文献给别人,因为他把这些文献给别人,也相当于在传播他自己的学术思想。下面是本人向老外作者要文献的一个常用的模板: Dear Professor ××× I am in ××× Institute of ×××, Chinese Academy of Sciences.I am writing to request your assistance. I search one of your papers: 。。。。。。。。。。。。。。。。。(你的文献题目) ISSN 1000-0054CN 11-2223/N 清华大学学报(自然科学版)J Tsingh ua Univ (Sci &Tech ),2009年第49卷第S1期 2009,V o l.49,N o.S1 16/31 1328-1332 基于拼音索引的中文模糊匹配算法 曹 犟 1,2 , 邬晓钧2, 夏云庆2, 郑 方 2 (1.清华大学计算机科学与技术系,北京100084; 2.清华信息科学技术国家实验室技术创新和开发部语音和语言技术中心,北京100084) 收稿日期:2009-03-19 基金项目:国家自然科学基金资助项目(60703051)作者简介:曹犟(1984—),男(汉),湖北,硕士研究生。通讯联系人:郑方,研究员,E-mail :fz h eng@tsinghua.ed https://www.360docs.net/doc/192779078.html, 摘 要:主流商业搜索引擎主要基于关键词精确匹配技术。为提高在用户的输入错误时的检索效率,提出了有索引的汉语模糊匹配算法。该算法采用汉字、拼音和拼音改良的编辑距离这3种汉字相似程度的不同度量方式,对用户查询进行扩展,将模糊匹配转化为多个精确匹配,对精确匹配的结果按与查询串的相似程度进行排序。在实验中,将该方法应用于网页文本语料库中。在使用基于拼音改良的编辑距离度量方式时,在时间和空间复杂度增长不大的情况下,该方法取得了60.42%的准确率与50.41%召回率。关键词:文件信息处理;拼音索引;模糊匹配;查询扩展中图分类号:T P 391.1 文献标识码:A 文章编号:1000-0054(2009)S1-1328-05 Pinyin -indexed method for approximate matching in Chinese CAO Jiang 1,2,WU Xiaoj un 2,XIA Yunqing 2,ZH ENG Fang 2 (1.Department of C omputer Sc ience and Technology ,Tsinghua University ,Beijing 100084,China ; 2.Center f or Speech and Language Technologies ,Division of Technical Innovat ion and Development ,Tsinghua National Laboratory for Information Science and Technology ,Beijing 100084,China )Abstract :The exac t matching of keyw o rds is key to popular comm ercial sear ch eng ines.A Chinese appro ximate matching method with an index structure wa s dev eloped to achiev e be tter r etriev al when the input contains err o rs.Thr ee types of simila rity measurement betw een two Chinese strings w ere dev eloped ba sed on the charac ter edit-dista nce,the Pinyin edit-dista nce and the Pinyin impr ov ed edit-distance.The similarity measurem ents w ere used to ex pand the use r ’s quer y so tha t the approx ima te ma tching task can be r epr esented a s sev e ral ex act matching sub-ta sks.T he results o f these exac t ma tching s ar e merg ed a nd so r ted by their simila rity to th e o rigina l quer y.Tests o n a w ebpag e tex t database gav e a 50.4%recall ra te with the Pinyin impr ov ed edit-distance with a 60.4%precisio n with a sma ll increase in time and space co mplexity.Key words :pinyin-index ed;Pinyin (spelling of Chinese)index;appro ximate ma tching;que ry ex pansion 现有的主流商业信息检索系统大部分采用基于关键词精确匹配的检索技术,取得了一定的成果[1] 。但是在实际应用中,用户的查询输入与检索系统数 据库的构建都不可能完全正确[2] 。用户对于搜索主题所处的领域不了解,采用不合适的查询词,会导致 查询词的覆盖范围大大缩小[3] ;在中文信息检索系统中,用户还常会输入同音或近音的错别字。模糊检索根据用户输入的模糊特征来检索匹配内容,可处理精确的关键词匹配所无法解决的这些问题[4] 。 在英文检索系统中,通常对用户输入的单词进 行拼写纠错,就能解决大多数问题[5] 。系统先搜索单词表,找出所有与查询串中单词的编辑距离(edit distance )在一定限度之内的所有词汇,再根据这些词汇来执行精确检索,即可在一定程度上实现模糊 检索[4] 。所以,英文模糊检索的主要研究集中在快速 DOI:10.16511/https://www.360docs.net/doc/192779078.html, k i .qh dxxb.2009.s1.019 一个新颖的基于模糊逻辑的车辆导航地图匹配算法以及应用本文提出了一个新的实时的基于模糊逻辑的地图匹配算法。主要有3种因素影响了地图匹配的可靠性,包括车辆位置和匹配路段之间的距离,车辆方向与路段方向之间的夹角,当前路径的连通性。对于距离角度以及连通性的模糊规则被提出来预测匹配的可靠性。这样两个评估匹配可靠性的指标被引出了,一个是可信度的下限的低局限性,另一个是可信度的最大值与第二大的值之间差别的极限误差。因此,一个实时的基于模糊逻辑的地图匹配系统就出现了。应用在基于路径地图的GPS和基于导航的GIS的实时数据,这种方法已经被证实并且结果证明了改进方法的有效。 地图匹配;模糊逻辑;可信度;GPS;GIS;路径网络 地图匹配技术在车辆导航系统中已经成为关键的问题。研究地图匹配算法来改进车辆定位的精确性已经取得很多成就。在目前的研究中,一个基于地图匹配方法的可能性是使用统计理论代替确定性方法。在一个整体的陆地车辆定位系统中已经采纳了一种卡尔曼滤波器模型。对于自动车辆定位与导航,一个数字路径地图的数据库已经形成用以支持地图匹配。对于地图匹配的路径识别,加权2维平面测距已经应用到近似估算功能中。一种基于D-S证据理论的地图匹配被提出来应用于车辆位置和方向的信息的概率分布功能。然而,由于道路因素的复杂性,传统的地图算法不能够处理更加困难环境,因此已经改进的实时地图匹配算法仍需更深的研究。 本文中,一种新颖的基于模糊逻辑地图匹配方法被提出来。有3个影响地图匹配可靠性的因素。对于距离,角度以及连通性的模糊规则已经被提出,并且估计匹配可靠性的指标也已经获得。大量的来自于GPS与GIS地图匹配的数据已被统计的分析。 可靠性指标的测定以及它们之间的权重是地图匹配的关键问题。有许多影响地图匹配可靠性的因素,包括移动跟踪,路径相似度以及弯曲度。在本篇文章中,主要涉及三个影响匹配可靠性的因素,即车辆位置与匹配路段之间的距离,车辆方向与路段方向之间的夹角,路径连通性。在地图匹配过程中,认定路径连通性,距离以及夹角被构建用来测定不同观察数据间的权重。路径可靠性被预测,并且具有最大可靠性值的路径被选作匹配路段,且匹配结果被核实。 假设在一个任意的时间点,车辆的位置是P i(Xi,Y i),当前路段端点是A(Xa,Y a)和B(Xb,Yb),被匹配的路段的函数表示如下: Y=k(X-Xa)+Y a (1) 这里k=(Yb-Y a)/(Xb-Xa)且Xa不等于Xb。 从车辆位置到匹配路段的垂直点的横坐标为 X=Xi+(Yi-Y a)k+Y a*k2/1+k2 (2) 当且仅当判定函数B满足B=(X-Xa)(X-Xb)<=0,这个车辆位置到匹配路段的投影点在匹配路段上,且距离为 D i=|k(Xi-Xa)-Yi+Y a|/开根号1+k的平方(3) 如果判定函数B满足B>0,投影点将在路段的延长线上,因此此路段将被排除。在Xa=Xb的情况下,判定函数B即为B=(Yi-Y a)(Yi-Yb),而如果满足B<=0,那么距离将变成Di=|Xi-Xa|。 如果距离大于30米的话,路径成为匹配路段的可能性很小;如果距离接近于零,那么匹配的可能性很大。因此根据以上规则,影响匹配可靠性的距离函数可以表达为 中科院大牛博士是如何进行文献检索和阅读 --好习惯受益终生一、如何进行文献检索 我是学自然科学的,平时确实需要不少外文文献,对于自然科学来讲英文文献检索首推Elsevier,Springer等。虽然这些数据库里面文献已经不算少了。但是有时还会碰到查不到的文献,而这些文献的数据库我们所在研究所或大学又没有买,怎么办?我基本通过以下向个途径来得到文献。 1.首先在Google 学术搜索里进行搜索,里面一般会搜出来你要找的文献,在Google 学术搜索里通常情况会出现“每组几个”等字样,然后进入后,分别点击,里面的其中一个就有可能会下到全文,当然这只是碰运气,不是万能的,因为我常常碰到这种情况,所以也算是得到全文文献的一条途径吧。可以试一下。同时,大家有没有发现,从Google学术搜索中,还可以得到一些信息,Google学术搜索中会显示出你搜索文章的引用次数,不过这个引用次数不准确,但是从侧面反应了这篇文章的质量,经典文章的引用次数绝对很高的.同时如果你用作者进行搜索时,会按引用次数出现他写的全部的文章,就可以知道作者的哪些文章比较经典,在没有太多时间的情况下,就可以只看经典的。 2.如果上面的方法找不到全文,就把文章作者的名字或者文章的title在Google 里搜索(不是Google 学术搜索),用作者的名字来搜索,是因为我发现很多国外作者都喜欢把文章的全文(PDF)直接挂在网上,一般情况下他们会把自己的文章挂在自己的个人主页(home page)上,这样可能也是为了让别的研究者更加了解自己的学术领域,顺便推销自己吧。这样你就有可能下到你想要的文献的全文了。甚至可以下到那个作者相近的内容的其它文章。如果文献是由多个作者写的,第一作者查不到个人主页,就接上面的方法查第二作者,以此类推。用文章的title来搜索,是因为在国外有的网站上,例如有的国外大学的图书馆可能会把本校一年或近几年的学术成果的Publication的PDF全文献挂在网上,或者在这个大学的ftp 上也有可能会有这样类似的全文.这样就很可能会免费下到你想要的全文了。 3.如果上面两个方法都没有查到你要的文献,那你就直接写邮件向作者要。一般情况下作者都喜欢把自己的文献给别人,因为他把这些文献给别人,也相当于在传播他自己的学术思想。下面是本人向老外作者要文献的一个常用的模板: Dear Professor ××× I am in ×××Institute of ×××, Chinese Academy of Sciences.I am writing to request your assistance. I search one of your papers: 。。。。。。。。。。。。。。。。。(你的文献题目) but I can not read full-text content, would you mind sending your papers by E-mail? Thank you for your assistance. Best wishes !(or best regards) ××× 本人的经验是讲英语的国家的作者给文章的机率会大,一般你要就会给,其它不讲英语的国家,如德国,法国,日本等国家的作者可能不会给。出于礼貌,如果你要的文献作者E-mail 多关键字模糊匹配的终端适配算法 应用软件开发 功能需求规格书 版本号 2.0.0 修订记录 日期修订版本修改章节修改描述作者 2014-08-01 1.0 新建袁勇 2014-10-09 2.0 补充袁勇 目录 1前言 3 1.1编写目的 (3) 1.2文档范围说明................................................................................................... 错误!未定义书签。 1.3文档适用读者 (3) 1.4术语、定义及缩略语 (3) 2终端适配模糊算法 (4) 2.1终端适配模糊算法简介 (4) 1前言 1.1编写目的 本文档的目的主要是介绍多关键字模糊匹配的终端适配算法的流程和处理逻辑。 1.2文档适用读者 文档适用于对开发测试人员,和终端适配相关的专业人士。 1.3术语、定义及缩略语 缩写英文名称中文描述 FRS Function Requirement Specification功能规格说明书 FTP File Transfer Protocol文件传输协议 HTTP Hypertext Transfer Protocol超文本传输协议 IMEI International Mobile Equipment Identity国际移动设备标识 OS Operating System操作系统 SFTP Secure File Transfer Protocol安全文件传输协议 SNMP Simple Network Management Protocol简单网络管理协议 WAP Wireless Access Protocol无线接入协议 WAPGW WAP Gateway WAP网关 URL Uniform Resource Locator统一资源定位器 UA User Agent一个特殊字符串头,使得 服务器能够识别客户使用 终端名称、操作系统及版 本、CPU 类型、浏览器及 版本、浏览器渲染引擎等 信息 一、字符串匹配 字符串匹配指的是从文本中找出给定字符串(称为模式)的一个或所有出现的位置。本文的算法一律输出全部的匹配位置。模式串在代码中用x[m]来表示,文本用y[n]来,而所有字符串都构造自一个有限集的字母表Σ,其大小为σ。 根据先给出模式还是先给出文本,字符串匹配分为两类方法: ·第一类方法基于自动机或者字符串的组合特点,其实现上,通常是对模式进行预处理; ·第二类方法对文本建立索引,这也是现在搜索引擎采用的方法。 本文仅讨论第一类方法。 文中的匹配算法都是基于这样一种方式来进行的:设想一个长度为m的窗口,首先窗口的左端和文本的左端对齐,把窗口中的字符与模式字符进行比较,这称为一趟比较,当这一趟比较完全匹配或者出现失配时,将窗口向右移动。重复这个过程,直到窗口的右端到达了文本的右端。这种方法我们通常叫sliding window。 对于穷举法来说,找到所有匹配位置需要的时间为O(mn),基于对穷举法改进的结果,我们按照每一趟比较时的比较顺序,把这些算法分为以下四种: 1. 从左到右:最自然的方式,也是我们的阅读顺序 2. 从右到左:通常在实践中能产生最好的算法 3. 特殊顺序:可以达到理论上的极限 4. 任意顺序:这些算法跟比较顺序没关系(例如:穷举法) 一些主要算法的简单介绍如下: 从左到右 采用哈希,可以很容易在大部分情况下避免二次比较,通过合理的假设,这种算法是线性时间复杂度的。它最先由Harrison提出,而后由Karp和Rabin全面分析,称为KR算法。 在假设模式长度不大于机器字长时,Shift-Or算法是很高效的匹配算法,同时它可以很容易扩展到模糊匹配上。 MP是第一个线性时间算法,随后被改进为KMP,它的匹配方式很类似于自动机的识别过程,文本的每个字符与模式的每个字符比较不会超过logΦ(m+1),这里Φ是黄金分隔比1.618,而随后发现的类似算法——Simon算法,使得文本的每个字符比较不超过1+log2m,这三种算法在最坏情况下都只要2n-1次比较。(抱歉限于我的水平这一段既没看懂也没能查证,大家就看个意思吧) 基于确定性有限自动机的算法对文本字符刚好只用n次访问,但是它需要额外的O(mσ)的空间。 一种叫Forward Dawg Matching的算法同样也只用n次访问,它使用了模式的后缀自动机。Apostolico-Crochemore算法是一种简单算法,最坏情况下也只需要3n/2次比较。 1.利用维普高级检索功能检索2012-2016年以来以“图书馆”和“自闭症服务” 为关键词,且发表在核心期刊上的论文(其他选项框使用默认值)。 1).请并写出查询过程; 登录维普,选择高级检索。按要求,分别输入关键词“图书馆”和“自闭症服务”,选择连接方式“与”,时间选择2012-2016,在期刊范围中勾选“核心期刊”,按下方“检索”按钮。 查询结果为以下2篇 2).请写下被引次数最高的论文题目、第一作者、发表年份、期刊名称; 《图书馆自闭症儿童服务研究》,束漫,2013年,《图书与情报》 3).请列出该论文的引证文献题目。 《美国图书馆自闭症儿童服务及其推动因素研究》,《图书馆开展自闭症儿童有效服务探究》,《关爱星星的孩子--自闭症儿童阅读案例分析》 2.在维普数据库中检索2006-2016年“题名或关键词”为“阅读推广”的文章。 并显示检索报告。 查询结果为3695篇 3.利用万方数据库检索2006-2016年,会议由“河北省图书馆学会”或”福建省 图书馆学会”主办,主题为“阅读推广”的会议论文有多少篇? 查询结果为52篇 4 .利用万方数据库检索”屠呦呦”所拥有的关于“青蒿素”的相关专利,并写出其中最新的一件专利的详细信息,包括:专利类型、申请号、申请日期、公开号、公告号、分类号、申请人、发明人、主申请人地址、国别省市代码、主权项和法律状态。 专利类型:发明专利 申请(专利)号:CN99109669.X 申请日期: 1999年7月5日 公开(公告)日:2001年2月14日 公开(公告)号:CN1283458 分类号:A61K31/47,A61K31/00,A,A61,A61K,A61K31 申请(专利权)人:屠呦呦,杨岚 发明(设计)人:屠呦呦,杨岚基于拼音索引的中文模糊匹配算法

文献检索(完整版)

多关键词模糊匹配算法名词解释

大数据常用的算法

文献检索和阅读技术指导

基于拼音索引的中文模糊匹配算法_曹犟

模糊逻辑地图匹配算法

博士生文献检索和阅读方法

多关键字模糊匹配的终端适配算法

匹配算法一

中文数据库文献检索作业