如何批量提取word&excel文档中的邮件地址,特殊编号内容

如何批量提取word&excel文档中的邮件地址,特殊编号内容

小李是一家网络公司的新人,今天一早,老板给他一份Word文档,其中有很多电子邮件,但却混杂在中文文字之中。老板要求小张,尽快把文档中数百个电子邮件地址提取出来,以便群发公司广告邮件。

由于邮箱地址是混杂在中文文字之中,且几乎没有其它规律可循,而如果手工复制出来,估计三天三夜也弄不好,小张头大了一圈,也没有想出可行的办法。幸好老员工林子哥哥看小张可怜,给他支了一招,不到1分钟,就又好又快地完成了任务。

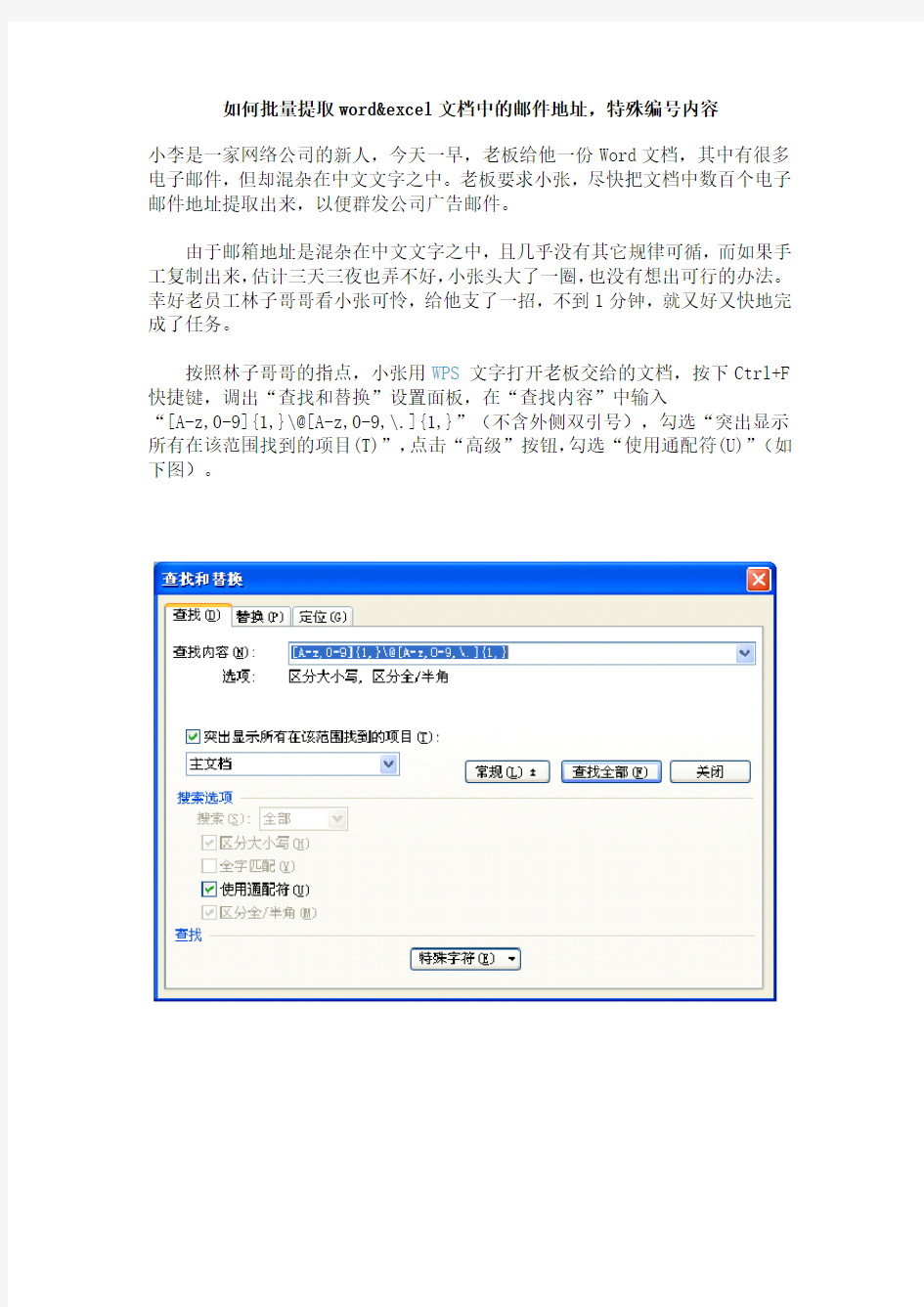

按照林子哥哥的指点,小张用WPS文字打开老板交给的文档,按下Ctrl+F 快捷键,调出“查找和替换”设置面板,在“查找内容”中输入

“[A-z,0-9]{1,}\@[A-z,0-9,\.]{1,}”(不含外侧双引号),勾选“突出显示所有在该范围找到的项目(T)”,点击“高级”按钮,勾选“使用通配符(U)”(如下图)。

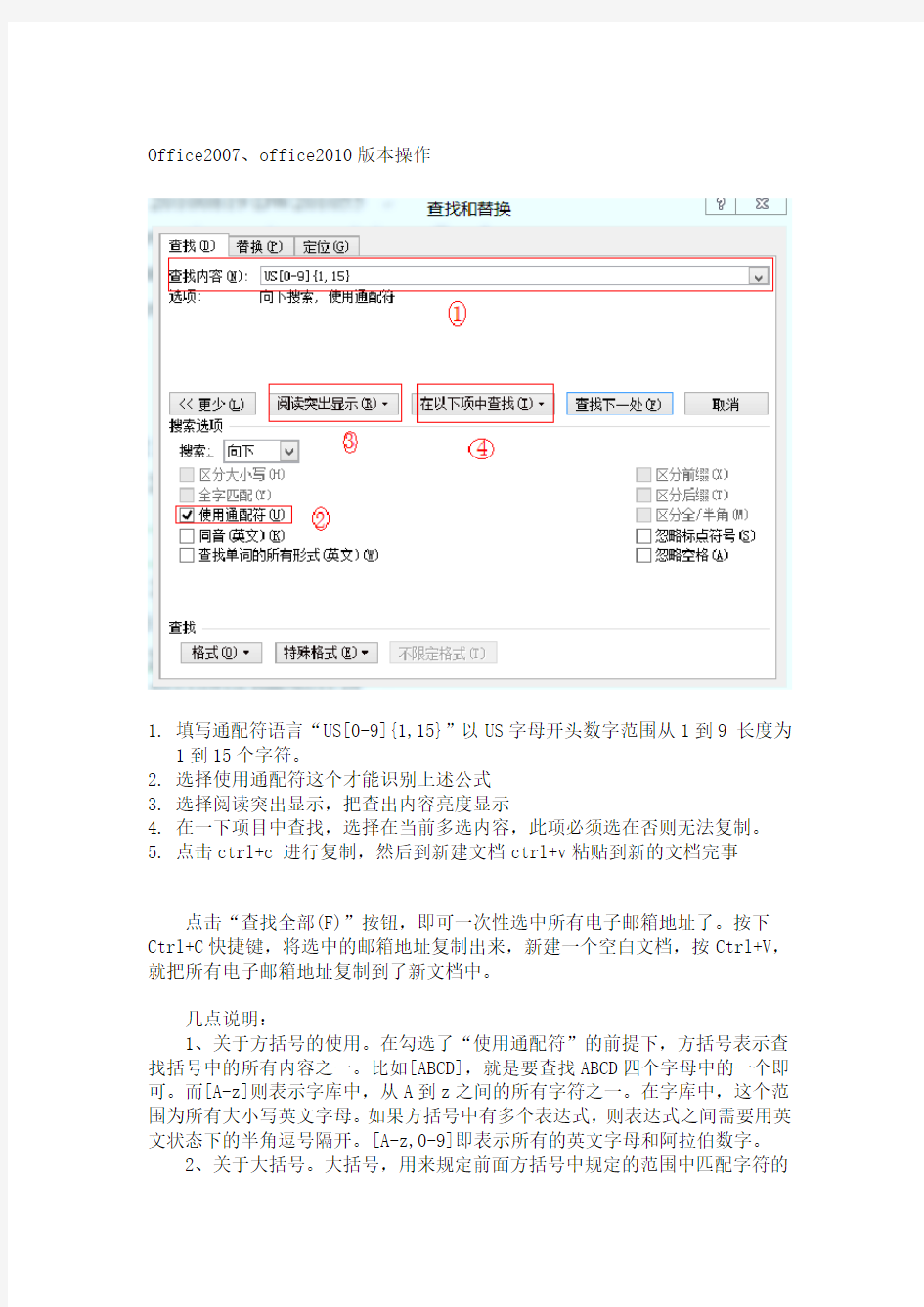

Office2007、office2010版本操作

1.填写通配符语言“US[0-9]{1,15}”以US字母开头数字范围从1到9 长度为

1到15个字符。

2.选择使用通配符这个才能识别上述公式

3.选择阅读突出显示,把查出内容亮度显示

4.在一下项目中查找,选择在当前多选内容,此项必须选在否则无法复制。

5.点击ctrl+c 进行复制,然后到新建文档ctrl+v粘贴到新的文档完事

点击“查找全部(F)”按钮,即可一次性选中所有电子邮箱地址了。按下Ctrl+C快捷键,将选中的邮箱地址复制出来,新建一个空白文档,按Ctrl+V,就把所有电子邮箱地址复制到了新文档中。

几点说明:

1、关于方括号的使用。在勾选了“使用通配符”的前提下,方括号表示查找括号中的所有内容之一。比如[ABCD],就是要查找ABCD四个字母中的一个即可。而[A-z]则表示字库中,从A到z之间的所有字符之一。在字库中,这个范围为所有大小写英文字母。如果方括号中有多个表达式,则表达式之间需要用英文状态下的半角逗号隔开。[A-z,0-9]即表示所有的英文字母和阿拉伯数字。

2、关于大括号。大括号,用来规定前面方括号中规定的范围中匹配字符的

个数。比如“g[o]{1,2}d”,可以查到“god”和“good”两个单词中的任意一个。如果省略了逗号后面的数字,则表示匹配个数等于超过前一个数字的所有范围。如[A-Z]{4,},就表示连续4个以上的大写英文字母

3、关于反斜杠。在使用通配符情况下,有些字符本身是作为通配符使用的,如问号(?)、星号(*)等。如果要查找这些符号本身,则需要在前面加个反斜杠(\)。如上例中的“@”和“.”,要查找它们,前面都需要加上反斜杠。

电子邮件试题及答案

《信息技术基础》(电子邮件部分) 强化练习 1.如果E-mail地址是wang@https://www.360docs.net/doc/b37494060.html,,那么用该邮箱地址发送邮件范围:()A.只能是云南 B.只能是中国 C.只能是教育部门 D.可以是全世界 2.某同学以myname为用户名在新浪网(https://www.360docs.net/doc/b37494060.html,)注册的电箱地址应该是:() A myname@https://www.360docs.net/doc/b37494060.html, B.https://www.360docs.net/doc/b37494060.html, C.myname.sina@com D.https://www.360docs.net/doc/b37494060.html,@myname 3.使用WEB方式(直接在网站上)收发电子邮件时,以下描述错误的是:() A.不用设置SMTP服务域名 B.不用设置POP3服务域名 C.不用输入账号和密码登录 D.可以在附件中插入图片文件 4.在撰写邮件时,在收件人对话框的“收件人”栏中:() A.只能输入一个人的收件地址 B.只能输人多个人的收件地址 C.既可以输入一个人的收件地址又可以输人多个人的收件地址 D.只能输入收件人的姓名 5.要将一封电子邮件同时发送给几个人,可以在收件人栏中输入他们的地址,并用()分隔。 (A)”(B)。(C),(D) / 6.关于发送电子邮件,下列说法中正确的是()。 (A)你必须先接入Internet,别人才可以给你发送电子邮件 (B)你只有打开了自己的计算机,别人才可以给你发送电子邮件 (C)只要有E-Mail地址,别人就可以给你发送电子邮件 (D)别人只要接入了Internet,就可以给你发送电子邮件 7.要给某人发电子邮件,必须知道他的()。 (A)电话号码(B)家庭地址(C)姓名(D)E-Mail地址 8.在发送电子邮件时,在邮件中()。 (A)只能插入一个图形附件(B)只能插入一个声音附件 (C)只能插入一个文本附件(D)可以根据需要插入多个附件 9.电子邮件从本质上来说就是()。 (A)浏览(B)电报(C)传真(D)文件 10.小明写了一份研究性学习结题报告电子文档,投稿前就稿子审阅修订问题需要与身在国外留学的叔叔进行较长时间的交流。你认为小明应该采用的较合理的信息交流方式是:() (A)电报 (B)电话 (C)书信 (D)电子邮件 11.下列主要用于电子邮件收发和管理的软件是() (A)FrontPage (B)Outlook Express (C)ACDSee (D)WinRAR 12.接收电子邮件的协议是() (A)SMTP (B)HTTP (C)POP3 (D)TCP/IP 13.在电子邮件中所包含的信息() (A)只能是文字信息 (B)只能是文字和图形图像信息 (C)只能是文字与声音信息 (D)可以是文字、声音和图形图像信息 14.把电子邮件发送到收件人的电子信箱中,所采用的邮件传输协议是()

文本特征提取方法

https://www.360docs.net/doc/b37494060.html,/u2/80678/showart_1931389.html 一、课题背景概述 文本挖掘是一门交叉性学科,涉及数据挖掘、机器学习、模式识别、人工智能、统计学、计算机语言学、计算机网络技术、信息学等多个领域。文本挖掘就是从大量的文档中发现隐含知识和模式的一种方法和工具,它从数据挖掘发展而来,但与传统的数据挖掘又有许多不同。文本挖掘的对象是海量、异构、分布的文档(web);文档内容是人类所使用的自然语言,缺乏计算机可理解的语义。传统数据挖掘所处理的数据是结构化的,而文档(web)都是半结构或无结构的。所以,文本挖掘面临的首要问题是如何在计算机中合理地表示文本,使之既要包含足够的信息以反映文本的特征,又不至于过于复杂使学习算法无法处理。在浩如烟海的网络信息中,80%的信息是以文本的形式存放的,WEB文本挖掘是WEB内容挖掘的一种重要形式。 文本的表示及其特征项的选取是文本挖掘、信息检索的一个基本问题,它把从文本中抽取出的特征词进行量化来表示文本信息。将它们从一个无结构的原始文本转化为结构化的计算机可以识别处理的信息,即对文本进行科学的抽象,建立它的数学模型,用以描述和代替文本。使计算机能够通过对这种模型的计算和操作来实现对文本的识别。由于文本是非结构化的数据,要想从大量的文本中挖掘有用的信息就必须首先将文本转化为可处理的结构化形式。目前人们通常采用向量空间模型来描述文本向量,但是如果直接用分词算法和词频统计方法得到的特征项来表示文本向量中的各个维,那么这个向量的维度将是非常的大。这种未经处理的文本矢量不仅给后续工作带来巨大的计算开销,使整个处理过程的效率非常低下,而且会损害分类、聚类算法的精确性,从而使所得到的结果很难令人满意。因此,必须对文本向量做进一步净化处理,在保证原文含义的基础上,找出对文本特征类别最具代表性的文本特征。为了解决这个问题,最有效的办法就是通过特征选择来降维。 目前有关文本表示的研究主要集中于文本表示模型的选择和特征词选择算法的选取上。用于表示文本的基本单位通常称为文本的特征或特征项。特征项必须具备一定的特性:1)特征项要能够确实标识文本内容;2)特征项具有将目标文本与其他文本相区分的能力;3)特征项的个数不能太多;4)特征项分离要比较容易实现。在中文文本中可以采用字、词或短语作为表示文本的特征项。相比较而言,词比字具有更强的表达能力,而词和短语相比,词的切分难度比短语的切分难度小得多。因此,目前大多数中文文本分类系统都采用词作为特征项,称作特征词。这些特征词作为文档的中间表示形式,用来实现文档与文档、文档与用户目标之间的相似度计算。如果把所有的词都作为特征项,那么特征向量的维数将过于巨大,从而导致计算量太大,在这样的情况下,要完成文本分类几乎是不可能的。特征抽取的主要功能是在不损伤文本核心信息的情况下尽量减少要处理的单词数,以此来降低向量空间维数,从而简化计算,提高文本处理的速度和效率。文本特征选择对文本内容的过滤和分类、聚类处理、自动摘要以及用户兴趣模式发现、知识发现等有关方面的研究都有非常重要的影响。通常根据某个特征评估函数计算各个特征的评分值,然后按评分值对这些特征进行排序,选取若干个评分值最高的作为特征词,这就是特征抽取(Feature Selection)。

如何抓取网页数据,以抓取安居客举例

如何抓取网页数据,以抓取安居客举例 互联网时代,网页上有丰富的数据资源。我们在工作项目、学习过程或者学术研究等情况下,往往需要大量数据的支持。那么,该如何抓取这些所需的网页数据呢? 对于有编程基础的同学而言,可以写个爬虫程序,抓取网页数据。对于没有编程基础的同学而言,可以选择一款合适的爬虫工具,来抓取网页数据。 高度增长的抓取网页数据需求,推动了爬虫工具这一市场的成型与繁荣。目前,市面上有诸多爬虫工具可供选择(八爪鱼、集搜客、火车头、神箭手、造数等)。每个爬虫工具功能、定位、适宜人群不尽相同,大家可按需选择。本文使用的是操作简单、功能强大的八爪鱼采集器。以下是一个使用八爪鱼抓取网页数据的完整示例。示例中采集的是安居客-深圳-新房-全部楼盘的数据。 采集网站:https://https://www.360docs.net/doc/b37494060.html,/loupan/all/p2/ 步骤1:创建采集任务 1)进入主界面,选择“自定义模式”

如何抓取网页数据,以抓取安居客举例图1 2)将要采集的网址复制粘贴到网站输入框中,点击“保存网址”

如何抓取网页数据,以抓取安居客举例图2 步骤2:创建翻页循环 1)在页面右上角,打开“流程”,以展现出“流程设计器”和“定制当前操作”两个板块。将页面下拉到底部,点击“下一页”按钮,在右侧的操作提示框中,选择“循环点击下一页”,以建立一个翻页循环

如何抓取网页数据,以抓取安居客举例图3 步骤3:创建列表循环并提取数据 1)移动鼠标,选中页面里的第一个楼盘信息区块。系统会识别此区块中的子元素,在操作提示框中,选择“选中子元素”

如何抓取网页数据,以抓取安居客举例图4 2)系统会自动识别出页面中的其他同类元素,在操作提示框中,选择“选中全部”,以建立一个列表循环

期刊电子邮件地址

1. 编辑单位:安徽电气工程职业技术学院学报编辑部xbbjb999@https://www.360docs.net/doc/b37494060.html, 2. 编辑单位:安徽电子信息职业技术学院学报编辑部ahdzxxzyjsxyxb@https://www.360docs.net/doc/b37494060.html, 3. 编辑单位:《安徽工业大学(社科版)》编辑部xbskb@https://www.360docs.net/doc/b37494060.html, 4. 编辑单位:安徽广播电视大学学报编辑部xuebao@https://www.360docs.net/doc/b37494060.html, 5. 编辑单位:《安徽技术师范学院学报》编辑部ahttcxb@https://www.360docs.net/doc/b37494060.html, 6. 编辑单位:《安徽教育学院学报》编辑部ahjy-xb@https://www.360docs.net/doc/b37494060.html, 7. 编辑单位:《安徽理工大学学报》编辑部xuebao@https://www.360docs.net/doc/b37494060.html, 8. 编辑单位:《安徽农业大学学报(社科版)》编辑部ahndskxb@https://www.360docs.net/doc/b37494060.html, 9. 编辑单位:《安徽师范大学学报》ahsd@https://www.360docs.net/doc/b37494060.html, 10. 编辑单位:《安徽水利水电职业技术学院学报》编辑部sdxyxb@https://www.360docs.net/doc/b37494060.html, 11. 编辑单位:安徽卫生职业技术学院学报编辑委员会amcxbb@https://www.360docs.net/doc/b37494060.html, 12. 编辑单位:安庆师范学院学报编辑部xuebao@https://www.360docs.net/doc/b37494060.html, 13. 编辑单位:《鞍山科技大学学报》编辑部asgt@https://www.360docs.net/doc/b37494060.html, 14. 编辑单位:鞍山市师范学院学报编辑部assfxyxb@https://www.360docs.net/doc/b37494060.html,;assfxyxb@https://www.360docs.net/doc/b37494060.html, 15. 编辑单位:宝鸡文理学院杂志社bjwl@https://www.360docs.net/doc/b37494060.html, 16. 编辑单位:北方工业大学学报编辑部xuebao@https://www.360docs.net/doc/b37494060.html, 17. 编辑单位:《北华大学学报》编辑部bhdxxb@https://www.360docs.net/doc/b37494060.html, 18. 编辑单位:北京工商大学学报编辑部xuebao@https://www.360docs.net/doc/b37494060.html, 19. 编辑单位:北京工业大学学报编辑部xuebaosk@https://www.360docs.net/doc/b37494060.html, 20. 编辑单位:《北京航空航天大学学报》编辑部bhskxb@https://www.360docs.net/doc/b37494060.html, 21. 编辑单位:北京化工大学学报(社会科学版)编辑 部skxb@https://www.360docs.net/doc/b37494060.html,;shekexuebao@https://www.360docs.net/doc/b37494060.html, 22. 编辑单位:《北京机械工业学院学报》编委会bjgy@https://www.360docs.net/doc/b37494060.html, 23. 编辑单位:《北京交通大学学报(社会科学版)》编辑部bfxbsk@https://www.360docs.net/doc/b37494060.html, 24. 编辑单位:《北京教育学院学报》编辑部bjjx@https://www.360docs.net/doc/b37494060.html, 25. 编辑单位:北京财贸管理干部学院学报编辑部bjcaimao@https://www.360docs.net/doc/b37494060.html,;bjb@https://www.360docs.net/doc/b37494060.html, 26. 编辑单位:北京市计划劳动管理干部学院编辑部https://www.360docs.net/doc/b37494060.html, 27. 编辑单位:《北京邮电大学学报(社会科学版)》编辑部xielei@https://www.360docs.net/doc/b37494060.html, 28. 编辑单位:《北京政法职业学院学报》编辑部xuebao_6256@https://www.360docs.net/doc/b37494060.html, 29. 编辑单位:兵团教育学院学报编辑部btjy-xuebao@https://www.360docs.net/doc/b37494060.html, 30. 编辑单位:渤海大学学报编辑部woshi909@https://www.360docs.net/doc/b37494060.html, 31. 编辑单位:《昌吉学院学报》编辑部cjxy@https://www.360docs.net/doc/b37494060.html,;cjxykyc@https://www.360docs.net/doc/b37494060.html, 32. 编辑单位:《长安大学学报》(社会科学版)编辑部cask@https://www.360docs.net/doc/b37494060.html, 33. 编辑单位:《长春大学学报》编辑部xueb@https://www.360docs.net/doc/b37494060.html, 34. 编辑单位:长春工程学院学报编辑部xb503@https://www.360docs.net/doc/b37494060.html,

网页链接提取方法

https://www.360docs.net/doc/b37494060.html, 网页链接提取方法 网页链接的提取是数据采集中非常重要的部分,当我们要采集列表页的数据时,除了列表标题的链接还有页码的链接,数据采集只采集一页是不够,还要从首页遍历到末页直到把所有的列表标题链接采集完,然后再用这些链接采集详情页的信息。若仅仅靠手工打开网页源代码一个一个链接复制粘贴出来,太麻烦了。掌握网页链接提取方法能让我们的工作事半功倍。在进行数据采集的时候,我们可能有提取网页链接的需求。网页链接提取一般有两种情况:提取页面内的链接;提取当前页地址栏的链接。针对这两种情况,八爪鱼采集器均有相关功能实现。下面介绍一个网页链接提取方法。 一、八爪鱼提取页面内的超链接 在网页里点击需要提取的链接,选择“采集以下链接地址”

https://www.360docs.net/doc/b37494060.html, 网页链接提取方法1 二、八爪鱼提取当前地址栏的超链接 从左边栏拖出一个提取数据的步骤出来(如果当前页已经有其他的提取字段,这一步可省略)点击“添加特殊字段”,选择“添加当前页面网址”。可以看到,当前地址栏的超链接被抓取下来

https://www.360docs.net/doc/b37494060.html, 网页链接提取方法2 而批量提取网页链接的需求,一般是指批量提取页面内的超链接。以下是一个使用八爪鱼批量提取页面内超链接的完整示例。 采集网站: https://https://www.360docs.net/doc/b37494060.html,/search?initiative_id=tbindexz_20170918&ie=utf8&spm=a21 bo.50862.201856-taobao-item.2&sourceId=tb.index&search_type=item&ssid=s5-e&commend=all&imgfile=&q=手表&suggest=history_1&_input_charset=utf-8&wq=&suggest_query=&source=sugg est

国内主要信息抓取软件盘点

国内主要信息抓取软件盘点 近年来,随着国内大数据战略越来越清晰,数据抓取和信息采集系列产品迎来了巨大的发展 机遇,采集产品数量也出现迅猛增长。然而与产品种类快速增长相反的是,信息采集技术相 对薄弱、市场竞争激烈、质量良莠不齐。在此,本文列出当前信息采集和数据抓取市场最具 影响力的六大品牌,供各大数据和情报中心建设单位采购时参考: TOP.1 乐思网络信息采集系统 乐思网络信息采系统的主要目标就是解决网络信息采集和网络数据抓取问题。是根据用户自定义的任务配置,批量而精确地抽取因特网目标网页中的半结构化与非结构化数据,转化为结构化的记录,保存在本地数据库中,用于内部使用或外网发布,快速实现外部信息的获取。 主要用于:大数据基础建设,舆情监测,品牌监测,价格监测,门户网站新闻采集,行业资讯采集,竞争情报获取,商业数据整合,市场研究,数据库营销等领域。 TOP.2 火车采集器 火车采集器是一款专业的网络数据采集/信息挖掘处理软件,通过灵活的配置,可以很轻松迅速地从网页上抓取结构化的文本、图片、文件等资源信息,可编辑筛选处理后选择发布到网站后台,各类文件或其他数据库系统中。被广泛应用于数据采集挖掘、垂直搜索、信息汇聚和门户、企业网信息汇聚、商业情报、论坛或博客迁移、智能信息代理、个人信息检索等领域,适用于各类对数据有采集挖掘需求的群体。 TOP.3 熊猫采集软件 熊猫采集软件利用熊猫精准搜索引擎的解析内核,实现对网页内容的仿浏览器解析,在此基础上利用原创的技术实现对网页框架内容与核心内容的分离、抽取,并实现相似页面的有效比对、匹配。因此,用户只需要指定一个参考页面,熊猫采集软件系统就可以据此来匹配类似的页面,来实现用户需要采集资料的批量采集。 TOP.4 狂人采集器 狂人采集器是一套专业的网站内容采集软件,支持各类论坛的帖子和回复采集,网站和博客文章内容抓取,通过相关配置,能轻松的采集80%的网站内容为己所用。根据各建站程序

2020最新高考语文文本阅读方法与信息的提取筛选

第一、二讲文本阅读方法与信息的提取筛选 一、从语基到阅读,巩固与过渡 [2019 年全国卷I 真题] 阅读下面的文字,完成17-19 题。 中国传统音乐包括民间音乐、宗教音乐、??音乐、宫廷音乐等类别,其中??音乐的 代表主要就是古琴艺术。但随着传统??阶层在中国的消失,古琴艺术逐渐_________ ,甚? 被社会遗忘。直到2003 年,中国的古琴艺术被联合国教科?组织列?“?类?头和非物质遗产代表作名录”,这种过去对?化有着深刻影响的艺术形式,才重新_______了?机。(),但我认为这恰恰是它的?个特点。正因为古琴音量小,使得它是直接和你的?进?交流的乐器,是最个?化的乐器。我国古代就有“琴者,?也”“琴者,禁也”的说法。“琴者,?也”即弹 琴是为了和自?的?灵对话,与?自然交流,与三五“知音”互相欣赏;“琴者,禁也”即弹琴 是为了_______自?,也说明在古??目中,琴不仅是?件乐器,也是________ 的?具。 17.依次填入文中横线上的词语,全都恰当的一项是()(3 分) A. 边缘化获得制约放松身心 B. 私人化获得制约修身养性 C. 私人化焕发约束放松身心 D. 边缘化焕发约束修身养性 18.下列填入文中括号内的语句,衔接最恰当的一项是()(3 分) A.古琴的缺点是音量小,这是很多人的看法 B.音量小作为古琴的一个缺点,被很多人所批评 C.音量小是古琴的一个缺点,很多人都是这么认为的 D.古琴音量小,很多人认为这是它的一个缺点 19.文中画横线的句子有语病,下列修改最恰当的一项是()(3 分) A.正因为古琴音量小,所以使得它是直接和你的心进行交流的最个人化的乐器。 B.正是古琴音量小,使得它是直接和你的心进行交流的乐器,是最个人化的乐器。 C.正是音量小,使得古琴成为直接和你的心进行交流的乐器,是最个人化的乐器。 D.正因为音量小,使得古琴成为直接和你的心进行交流的最个人化的乐器。

网页正文提取

我为开源做贡献,网页正文提取——Html2Article 2014-1-7 14:38|发布者: 红黑魂|查看: 16722|评论: 4|原作者: StanZhai|来自: 博客园 摘要: 为什么要做正文提取一般做舆情分析,都会涉及到网页正文内容提取。对于分析而言,有价值的信息是正文部分,大多数情况下,为了便于分析,需要将网页中和正文不相干的部分给剔除。可以说正文提取的好坏,直接影响了分 ... 为什么要做正文提取 一般做舆情分析,都会涉及到网页正文内容提取。对于分析而言,有价值的信息是正文部分,大多数情况下,为了便于分析,需要将网页中和正文不相干的部分给剔除。可以说正文提取的好坏,直接影响了分析结果的好坏。 对于特定的网站,我们可以分析其html结构,根据其结构来获取正文信息。先看一下下面这张图: 正文部分,不同的网站,正文所在的位置不同,并且Html的结构也不同,对于 爬虫而言,抓取的页面是各种各样的,不可能针对所有的页面去写抓取规则来提取正文内容,因此需要一种通用的算法将正文提取出来。

现有的网页正文提取算法 ?基于标签用途的正文提取算法(比如title或h1,h2标签一般用作标题,p一 般表示正文段落,根据标签的含义去提取正文) ?基于标签密度判定(这个简单,说白了就是字符统计,正文部分html标签的密度比较低,确定一个阈值,按照标签密度提取正文部分) ?基于数据挖掘思想的网页正文抽取方法(这里会涉及到统计学和概率论的一些知识,在高深点就成了机器学习了,没有深入研究) ?基于视觉网页块分析技术的正文抽取(CV这种高端大气上档次的东西,岂是 我等这么容易就能研究明白的。虽然实现上复杂,但就提取效果而言,这种方法提取的精度还是不错的) 前2中方法还是比较容易实现的,主要是处理简单,先前我把标签密度的提取算法实现了,但实际用起来错误率还是蛮高的;后2种方法在实现上就略复杂了,从算法效率上讲应该也高不了哪去。 我们需要的是一种简单易实现的,既能保证处理速度,提取的准确率也不错的算法。于是结合前两种算法,研究网页html页面结构,有了一种比较好的处理思 路,权且叫做基于文本密度的正文提取算法吧。后来从网上找了一下类似的算法,发现也有使用类似的处理方法来处理正文提取的,不过还是有些不同。接下来跟大家分享一下这个算法的一些处理思想。 网页分析 我任意取了百度,搜狐,网易的一篇新闻类网页,拿来作分析。 先看一篇百度的文章 任正非为什么主动与我合影,https://www.360docs.net/doc/b37494060.html,/article/2011 首先请求这个页面,然后过滤到所有的html标签,只保留文本信息,我们可以 看到正文信息集中在一下位置:

最全的网页图片采集方法

https://www.360docs.net/doc/b37494060.html, 最全的网页图片采集方法 1、图片采集 在八爪鱼中,采集图片有以下几大步 1、先采集网页图片的地址链接url 2、通过八爪鱼提供的专用图片批量下载工具将URL转化为图片 八爪鱼图片批量下载工具:https://https://www.360docs.net/doc/b37494060.html,/s/1c2n60NI 2、常见应用情景 1)非瀑布流网站纯图片采集 采集示例:豆瓣网图片采集教程https://www.360docs.net/doc/b37494060.html,/tutorial/tpcj-7 2)瀑布流网站纯图片采集 这类瀑布流网站的采集需要按下面的步骤对采集规则进行设置: ①点击采集规则打开网页步骤的高级选项; ②勾选页面加载完成后下滚动; ③填写滚动的次数及每次滚动的间隔; ④滚动方式设置为:直接滚动到底部; 完成上面的规则设置后,再对页面中图片的url进行采集

https://www.360docs.net/doc/b37494060.html, 采集示例:百度网图片采集教程https://www.360docs.net/doc/b37494060.html,/tutorial/bdpiccj 3)文章图文采集 需要将文章里的文字和图片都采集下来,一般有两种方法 方法1:判断条件,设置判断条件分别采集文字和图片 采集示例:https://www.360docs.net/doc/b37494060.html,/tutorial/txnewscj 方法2:先整体采集文字,再循环采集图片 采集示例:https://www.360docs.net/doc/b37494060.html,/tutorial/ucnewscj 3、教程目的 采集图片URL这个步骤,以上图片采集教程中都有详细说明,不再赘述。本文将重点讲解图片采集的采集技巧和注意事项。 4、采集图片URL操作步骤 以下演示一个采集图片URL的具体操作步骤,以百度图片url采集为例。不同的网站图片url会遇到不同的情况,请大家灵活处理。

网页抓取工具如何进行http模拟请求

网页抓取工具如何进行http模拟请求 在使用网页抓取工具采集网页是,进行http模拟请求可以通过浏览器自动获取登录cookie、返回头信息,查看源码等。具体如何操作呢?这里分享给大家网页抓取工具火车采集器V9中的http模拟请求。许多请求工具都是仿照火车采集器中的请求工具所写,因此大家可以此为例学习一下。 http模拟请求可以设置如何发起一个http请求,包括设置请求信息,返回头信息等。并具有自动提交的功能。工具主要包含两大部分:一个MDI父窗体和请求配置窗体。 1.1请求地址:正确填写请求的链接。 1.2请求信息:常规设置和更高级设置两部分。 (1)常规设置: ①来源页:正确填写请求页来源页地址。 ②发送方式:get和post,当选择post时,请在发送数据文本框正确填写发布数据。 ③客户端:选择或粘贴浏览器类型至此处。 ④cookie值:读取本地登录信息和自定义两种选择。 高级设置:包含如图所示系列设置,当不需要以上高级设置时,点击关闭按钮即可。 ①网页压缩:选择压缩方式,可全选,对应请求头信息的Accept-Encoding。 ②网页编码:自动识别和自定义两种选择,若选中自定义,自定义后面会出现编

码选择框,在选择框选择请求的编码。 ③Keep-Alive:决定当前请求是否与internet资源建立持久性链接。 ④自动跳转:决定当前请求是否应跟随重定向响应。 ⑤基于Windows身份验证类型的表单:正确填写用户名,密码,域即可,无身份认证时不必填写。 ⑥更多发送头信息:显示发送的头信息,以列表形式显示更清晰直观的了解到请求的头信息。此处的头信息供用户选填的,若要将某一名称的头信息进行请求,勾选Header名对应的复选框即可,Header名和Header值都是可以进行编辑的。 1.3返回头信息:将详细罗列请求成功之后返回的头信息,如下图。 1.4源码:待请求完毕后,工具会自动跳转到源码选项,在此可查看请求成功之后所返回的页面源码信息。 1.5预览:可在此预览请求成功之后返回的页面。 1.6自动操作选项:可设置自动刷新/提交的时间间隔和运行次数,启用此操作后,工具会自动的按一定的时间间隔和运行次数向服务器自动请求,若想取消此操作,点击后面的停止按钮即可。 配置好上述信息后,点击“开始查看”按钮即可查看请求信息,返回头信息等,为避免填写请求信息,可以点击“粘贴外部监视HTTP请求数据”按钮粘贴请求的头信息,然后点击开始查看按钮即可。这种捷径是在粘贴的头信息格式正确的前提下,否则会弹出错误提示框。 更多有关网页抓取工具或网页采集的教程都可以从火车采集器的系列教程中学习借鉴。

文本挖掘论文:WEB文本信息的提取

文本挖掘论文:WEB文本信息的提取 【摘要】随着网络信息的迅速发展,网络信息量日益增加,怎样从海量的网络上提取有用的信息是web文本挖掘技术的重要应用方向。本文提出一种web文本挖掘系统的设计模型,为实现更深层次的信息处理做准备。 【关键词】文本挖掘 web 信息处理 一引言 web挖掘从数据挖掘发展而来,因此,其定义与我们熟知的数据挖掘定义相类似。但是,web挖掘与传统的数据挖掘相比有许多独特之处,web挖掘的对象是大量、异质、分布的web文档。由于web文档本身是半结构化或无结构的,且缺乏机器可理解的语义,因此,有些数据挖掘技术并不适用于web挖掘,即使可用也需要建立在对web文档进行预处理的基础之上。 二 web文本挖掘系统的设计 web文本挖掘系统能自由漫游web站点,在web上能按照某种策略进行远程数据的搜索与获取,并将挖掘文本集合在系统的本地数据库中。系统原型图,见图1。 1.文档采集器 利用信息访问技术将分布在多个web服务器上的待挖掘文档集成在web挖掘系统的本地数据库中。

2.文本预处理器 利用启发式规则和自然语言处理技术从文本中抽取出代表其特征的元数据,并存放在文本特征库中,作为文本挖掘的基础。 3.文本分类器 利用其内部知识库,按照预定义的类别层次,对文档集合或者其中的部分子集合内容进行分类。 4.文本聚类器 利用其内部知识库对文档集合或其中的部分子集的内容进行聚类。 5.多维文本分析引擎 web文本挖掘系统以引进文本超立方体模型和多维文本分析技术,为用户提供关于文档的多维视图。多维文本分析引擎还具有统计、分析功能,从而能够揭示文档集合的特征分布和趋势。此外,多维文本分析引擎还可以对大量文档的集合进行特征修剪,包括横向文档选择和纵向特征投影两种方式。 6.用户接口模块 在用户与多维文本分析引擎之间起桥梁作用。它为用户提供可视化的接口,将用户的请求转化为专用语言传递给多维文本分析引擎,并将多维文本分析引擎返回的多维文本视

网页数据抓取方法详解

https://www.360docs.net/doc/b37494060.html, 网页数据抓取方法详解 互联网时代,网络上有海量的信息,有时我们需要筛选找到我们需要的信息。很多朋友对于如何简单有效获取数据毫无头绪,今天给大家详解网页数据抓取方法,希望对大家有帮助。 八爪鱼是一款通用的网页数据采集器,可实现全网数据(网页、论坛、移动互联网、QQ空间、电话号码、邮箱、图片等信息)的自动采集。同时八爪鱼提供单机采集和云采集两种采集方式,另外针对不同的用户还有自定义采集和简易采集等主要采集模式可供选择。

https://www.360docs.net/doc/b37494060.html, 如果想要自动抓取数据呢,八爪鱼的自动采集就派上用场了。 定时采集是八爪鱼采集器为需要持续更新网站信息的用户提供的精确到分钟的,可以设定采集时间段的功能。在设置好正确的采集规则后,八爪鱼会根据设置的时间在云服务器启动采集任务进行数据的采集。定时采集的功能必须使用云采集的时候,才会进行数据的采集,单机采集是无法进行定时采集的。 定时云采集的设置有两种方法: 方法一:任务字段配置完毕后,点击‘选中全部’→‘采集以下数据’→‘保存并开始采集’,进入到“运行任务”界面,点击‘设置定时云采集’,弹出‘定时云采集’配置页面。

https://www.360docs.net/doc/b37494060.html, 第一、如果需要保存定时设置,在‘已保存的配置’输入框内输入名称,再保存配置,保存成功之后,下次如果其他任务需要同样的定时配置时可以选择这个配置。 第二、定时方式的设置有4种,可以根据自己的需求选择启动方式和启动时间。所有设置完成之后,如果需要启动定时云采集选择下方‘保存并启动’定时采集,然后点击确定即可。如果不需要启动只需点击下方‘保存’定时采集设置即可。

网页内容如何批量提取

https://www.360docs.net/doc/b37494060.html, 网页内容如何批量提取 网站上有许多优质的内容或者是文章,我们想批量采集下来慢慢研究,但内容太多,分布在不同的网站,这时如何才能高效、快速地把这些有价值的内容收集到一起呢? 本文向大家介绍一款网络数据采集工具【八爪鱼数据采集】,以【新浪博客】为例,教大家如何使用八爪鱼采集软件采集新浪博客文章内容的方法。 采集网站: https://www.360docs.net/doc/b37494060.html,/s/articlelist_1406314195_0_1.html 采集的内容包括:博客文章正文,标题,标签,分类,日期。 步骤1:创建新浪博客文章采集任务 1)进入主界面,选择“自定义采集”

https://www.360docs.net/doc/b37494060.html, 2)将要采集的网址URL复制粘贴到网站输入框中,点击“保存网址”

https://www.360docs.net/doc/b37494060.html, 步骤2:创建翻页循环

https://www.360docs.net/doc/b37494060.html, 1)打开网页之后,打开右上角的流程按钮,使制作的流程可见状态。点击页面下方的“下一页”,如图,选择“循环点击单个链接”,翻页循环创建完成。(可在左上角流程中手动点击“循环翻页”和“点击翻页”几次,测试是否正常翻页。) 2)由于进入详情页时网页加载很慢,网址一直在转圈状态,无法立即执行下一个步骤,因此在“循环翻页”的高级选项里设置“ajax加载数据”,超时时间设置为5秒,点击“确定”。

https://www.360docs.net/doc/b37494060.html, 步骤3:创建列表循环 1)鼠标点击列表目录中第一个博文,选择操作提示框中的“选中全部”。 2)鼠标点击“循环点击每个链接”,列表循环就创建完成,并进入到第一个循环项的详情页面。

百度贴吧内容抓取工具-让你的网站一夜之间内容丰富

百度贴吧内容抓取工具-让你的网站一夜之间内容丰富 [hide]

var $getreplytime=1; var $showimg=1; var $showcon=1; var $showauthor=1; var $showreplytime=1; var $showsn=0; var $showhr=0; var $replylista=array(); var $pat_reply="<\/a>(.+?)

<\/td>\r\n<\/tr><\/table>"; var $pat_pagecount="尾页<\/font><\/a>"; var $pat_title="(.+?)<\/font>"; var $pat_replycon="<\/td>\r\n \r\n