元线性回归模型的参数估计

§2.2 一元线性回归模型的参数估计

单方程计量经济学模型分为线性模型和非线性模型两大类.在线性模型中,变量之间的关系呈线性关系;在非线性模型中,变量之间的关系呈非线性关系.线性回归模型是线性模型的一种,它的数学基础是回归分析,即用回归分析方法建立的线性模型,用以揭示经济现象中的因果关系.

一元线性回归模型是最简单的计量经济学模型,在模型中只有一个解释变量,其一般形式是:

i i i X Y μββ++=10 i=1,2,…n (2.2.1) 其中,Y 为被解释变量,X 为解释变量,0β与1β为待估参数,μ为随机干扰项. 一、一元线性回归模型的基本假设

回归分析的主要目的是要通过样本回归函数(模型)SRF 尽可能准确地估计总体回归函数(模型)PRF.估计方法有多种,其种最广泛使用的是普通最小二乘法(ordinary least squares, OLS ).

为保证参数估计量具有良好的性质,通常对模型提出若干基本假设.如果实际模型满足这些基本假设,普通最小二乘法就是一种适用的估计方法;如果实际模型不满足这些基本假设,普通最小二乘法就不再适用,而要发展其它方法来估计模型.所以,严格地说,下面的基本假设并不是针对模型的,而是针对普通最小二乘法的.

对模型(2.2.1),基本假设包括对解释变量X 的假设,以及对随机扰动项μ的假设: 假设1:解释变量X 是确定性变量,不是随机变量,而且在重复抽样中取固定值. 假设2:随机误差项μ具有0均值、同方差及不序列相关性.即 )(i E μ=0 i=1,2,…n )(i Var μ=2

σ i=1,2,…n

),(j i Cov μμ=0 i ≠j i,j=1,2,…n

假设3:随机误差项与解释变量之间不相关.即

),(i i X C o v μ=0 i=1,2,…n

假设4:随机误差项服从0均值、同方差、零协方差的正态分布.即

),0(~2σμN i i=1,2,…n

需注意的是,如果假设1、2成立,则假设3成立,因为这时显然有),(i i X Cov μ= 0)]([)(())]())(([(=--=--i i i i i i i i E E X E X E X E X E μμμμ;

另外,如果假设4成立,则假设2成立,因为对两正态分布变量来说,零协方差就意味着两变量相互独立.

以上假设也称为线性回归模型的经典假设或高斯(Gauss )假设,满足该假设的线性回归模型,也称为经典线性回归模型(Classical Linear Regression Model, CLRM ).

另外,在进行模型回归时,还有两个暗含的假设:

假设5:随着样本容量的无限增加,解释变量X 的样本方差趋于一有限常数.即

∞→→-∑n Q n X X

,

/)(2

假设6:回归模型是正确设定的.

假设5旨在排除时间序列数据出现持续上升或下降的变量作为解释变量,因为这类数据不仅使大样本统计推断变得无效,而且往往产生所谓的伪回归问题(spurious regression problem ).关于伪回归的确切含义将在第九章中讨论.假设6也被称为模型没有设定偏误(specification error ),它的确切含义将在第五章中讨论.

在实际建立模型的过程中,除了随机误差项的正态假设外,对模型是否满足其他假设都要进行检验.这就是“建立计量经济学模型步骤”中“计量经济学检验”的任务.对于随机误差项的正态假设,根据中心极限定理,当样本容量趋于无穷大时,都是满足的. 二、参数的普通最小二乘估计(OLS )

已知一组样本观测值(i i X Y ,),(i=1,2,…n ),要求样本回归函数尽可能好地拟合这组

值,即样本回归线上的点i

Y ?与真实观测点i Y 的“总体误差”尽可能地小,或者说被解释变量的估计值与观测值应该在总体上最为接近,最小二乘法(Ordinary least squares, OLS )给出的判断标准是:二者之差的平方和

2

1

)?(i

n

i

Y Y

Q -=

∑=2101

))??((i n

i X Y ββ+-∑ (2.2.2) 最小.即在给定样本观测值之下,选择出0

?β、1?β能使i Y 与i Y ?之差的平方和最小. 为什么用平方和?因为样本回归线上的点i

Y ?与真实观测点i Y 之差可正可负,简单求和可能将很大的误差抵消掉,只有平方和才能反映二者在总体上的接近程度.这就是最小二乘

原理.

根据微积分学的运算,当Q 对 β0、 β1

的一阶偏导数为0时,Q 达到最小.即 ??β??βQ

Q 0

1

00??????

?==

可推得用于估计0

?β、1?β的下列方程组: ?????=--=--∑∑0)??(0)??(1010i i i i

i X X Y X Y ββββ (2.2.3)

或 ???∑+∑=∑∑+=∑21010?

???i

i i i i

i X X X Y X n Y ββββ (2.2.4) 解得:

???

????∑-∑∑∑-∑=∑-∑∑∑-∑∑=2

212220)(?)(?i i i i i i i i i i i i i X X n X Y X Y n X X n X Y X Y X ββ (2.2.5)

方程组(2.2.3)或(2.2.4)称为正规方程组(normal equations ).记

()22221

)(∑∑∑∑-

=-=i i i i

X n

X X X x

∑∑∑∑∑-=--=i i i i i i i i Y X n

Y X Y Y X X y x 1

))((

(2. 2.5)的参数估计量可以写成:

?????-=∑∑=X

Y x y x i i i 1021

???

βββ (2.2.6)

称为OLS 估计量的离差形式(deviation form ).在计量经济学中,往往以小写字母表示对均

值的离差.由于0

?β、1?β的估计结果是从最小二乘原理得到的,故称为普通最小二乘估计量(ordinary least squares estimators ).

顺便指出,记Y Y y i

i -=??,则有 ∑--=++-+=i

n i i i e X X e X X y 111

010)(?)??()??(?βββββ

可得

i

i x y 1??β= (2.2.7) 其中,用到了正规方程组的第一个方程

∑∑=+-=0))??((10

i

i

i

X Y e ββ

.(2.2.7)式也称为样本回归函数的离差形式.

在结束普通最小二乘估计的时候,需要交代一个重要的概念,即“估计量”(estimator )和“估计值”(estimate)的区别.由(2.2.5)式或(2.2.6)式给出的参数估计结果是由一个具

体样本资料计算出来的,它是一个“估计值”,或者“点估计”,是参数估计量 β0和 β1的一个具体数值;但从另一个角度,仅仅把(2.2.5)或(2.2.6)看成 β0和 β1的一个表达式,那么,则是i Y 的函数,而i Y 是随机变量,所以 β0和 β1也是随机变量,在这个角度上,称之为“估计量”.在本章后续内容中,有时把 β0和 β1作为随机变量,有时又把 β0和 β1

作为确定的数值,道理就在于此.

三、参数估计的最大或然法(ML)

最大或然法(Maximum Likelihood, ML),也称最大似然法,是不同于最小二乘法的另一种参数估计方法,是从最大或然原理出发发展起来的其它估计方法的基础.虽然其应用没有最小二乘法普遍,但在计量经济学理论上占据很重要的地位,因为最大或然原理比最小二乘原理更本质地揭示了通过样本估计母体参数的内在机理,计量经济学理论的发展,更多地是以最大或然原理为基础的,对于一些特殊的计量经济学模型,只有最大或然方法才是很成功的估计方法.

对于最小二乘法,当从模型总体随机抽取n 组样本观测值后,最合理的参数估计量应

该使得模型能最好地拟合样本数据.而对于最大或然法,当从模型总体随机抽取n 组样本观测值后,最合理的参数估计量应该使得从模型中抽取该n 组样本观测值的概率最大.显然,这是从不同原理出发的两种参数估计方法.

从总体中经过n 次随机抽取得到样本容量为n 的样本观测值,在任一次随机抽取中,样本观测值都以一定的概率出现,如果已经知道总体的参数,当然由变量的频率函数可以计算其概率.如果只知道总体服从某种分布,但不知道其分布参数,通过随机样本可以求出总体的参数估计量.以正态分布的总体为例.每个总体都有自己的分布参数期望和方差,如果已经得到n 组样本观测值,在这些可供选择的总体中,哪个总体最可能产生已经得到的n 组样本观测值呢?显然,要对每个可能的正态总体估计取得n 组样本观测值的联合概率,然后选择其参数能使观测值的联合概率为最大的那个总体.将样本观测值联合概率函数称为变量的或然函数.在已经取得样本观测值的情况下,使或然函数取极大值的总体分布参数所代表的总体具有最大的概率取得这些样本观测值,该总体参数即是所要求的参数.通过或然函数极大化以求得总体参数估计量的方法被称为极大或然法.

在满足基本假设条件下,对一元线性回归模型:

i i i X Y μββ++=10 i=1,2,…n

随机抽取n 组样本观测值i i X Y ,(i=1,2,…n ),假如模型的参数估计量已经求得到,为 β0和 β1

,那么i Y 服从如下的正态分布:

i Y ~),??(210σββi

X N + 于是,i Y 的概率函数为 210)??(2121

)(i

i X Y i e

Y P ββσπ

σ---

=

i=1,2,…,n

因为i Y 是相互独立的,所以Y 的所有样本观测值的联合概率,也即或然函数为:

),,,(),?,?(21210n

Y Y Y P L ???=σββ 2102

2

)??(21)2(1i

i n

X Y n

e

ββσσ

π--∑-=

(2.2.8)

将该或然函数极大化,即可求得模型参数的极大或然估计量.

由于或然函数的极大化与或然函数的对数的极大化是等价的,所以,取对数或然函数如下:

2102

*)??(21)2l n ()

l n (i

i X Y n L L ββσσπ--∑-

-== (2.2.9) 对L *

求极大值,等价于对210)??(i i X Y ββ--∑ 求极小值.210)??(i

i X Y ββ--∑极小值的条件为:

???????=--∑=--∑0)??(?0)??(?2101

2100i i i i X Y X Y βββ??βββ

??

解得模型的参数估计量为:

???

????∑-∑∑∑-∑=∑-∑∑∑-∑∑=2

212

220)(?)(?i i i i i i i i i i i i i X X n X Y X Y n X X n X Y X Y X ββ

可见,在满足一系列基本假设的情况下,模型结构参数的最大或然估计量与普通最小

二乘估计量是相同的.

例2.2.1:在上述家庭可支配收入-消费支出例中,对于所抽出的一组样本数,参数估计的计算可通过下面的表2.2.1进行.

表2.2.1 参数估计的计算表

由(2.2.8)式计算得:

777.07425000

5769300

?21

==

=∑∑i

i

i x

y

x β

172.1032150777.01567??0

0-=?-=-=X Y ββ 因此,由该样本估计的回归方程为:

i

i X Y 777.0172.103?+-= 四、最小二乘估计量的性质

当模型参数估计出后,需考虑参数估计值的精度,即是否能代表总体参数的真值.一般地,由于抽样波动的存在,以及所选估计方法的不同,都会使估计的参数与总体参数的真值有差距,因此考察参数估计量的统计性质就成了衡量该估计量“好坏”的主要准则.

一个用于考察总体的估计量,可从如下几个方面考察其优劣性:(1)线性性,即它是否是另一随机变量的线性函数;(2)无偏性,即它的均值或期望值是否等于总体的真实值;(3)有效性,即它是否在所有线性无偏估计量中具有最小方差.(4)渐近无偏性,即样本

容量趋于无穷大时,它的均值序列趋于总体真值;(5)一致性,即样本容量趋于无穷大时,它是否依概率收敛于总体的真值;(6)渐近有效性,即样本容量趋于无穷大时,它在所有的一致估计量中具有最小的渐近方差.

这里,前三个准则也称作估计量的小样本性质(small-sample properties ),因为一旦某估计量具有该类性质,它是不以样本的大小而改变的.拥有这类性质的估计量称为最佳线性无偏估计量(best liner unbiased estimator, BLUE ).当然,在小样本情形下,有时很难找到最佳线性无偏估计量,这时就需要考察样本容量增大时估计量的渐近性质.后三个准则称为估计量的大样本或渐近性质(large-sample or asymptotic properties ).如果小样本情况下不能满足估计的准则,则应扩大样本容量,考察参数估计量的大样本性质. 可以证明,在经典线性回归的假定下,最小二乘估计量是具有最小方差的线性无偏估计量.

1、线性性,即估计量0

?β、1?β是i Y 的线性组合. 由(2.2.6)式知

∑∑∑∑∑∑∑∑∑=+

=-=

=i i i

i

i

i

i i

i i

i

i

i Y k x

x Y x

Y x x Y Y x x

y

x 222

21

)(?β

其中,∑=

2

i

i

i x x k .同样地 ∑∑∑∑=-=-=-=i i i i i i i Y w Y k X n X Y k Y n

X Y )1

(1??1

0ββ 其中,i i k X n

w -=

1

. 2、无偏性,即估计量0

?β、1?β的均值(期望)等于总体回归参数真值0β与1β. 由线性性得

∑∑∑∑∑++=++==i i i i i i i i i i k X k k X k Y k μββμβββ10101

)(? 易知,02==

∑∑∑i

i i

x

x k ,

∑=1i

i

X

k ,故

∑+=i i k μββ11? ∑∑=+=+=1

1

1

1)()()?(β

μβμββi

i

i

i

E k k E E

同样地,容易得出

∑∑=+=+=00

0)()()()?(βμβ

μββi i i

i

E w E w E E

3、有效性(最小方差性),即在所有线性无偏估计量中,最小二乘估计量0

?β、1?β具有最小方差.

首先,由1?β、0

?β是关于i Y 的线性函数可求得它们的方差

∑∑∑=++==)var()var()var()?var(21021i

i i i i i i k X k Y k μμβββ =∑∑∑=???? ?

?2222

2i i i x x x σσ (2.2.10) ∑∑∑-=++==221020)/1()var()var()?var(σμβββi

i i i i i k X n X w Y w 22

22

222221121σσ????

? ?

????

?

??+-=????????+-??? ??=∑∑∑∑i i i i i x x X k X n n k X k X n n 2222

22

222

21σσσ∑∑∑∑∑=

+=???

? ?

?+

=i

i i

i

i x

n X x

n X n x x X

n (2.2.11)

其次,假设*1

?β是其他估计方法得到的关于1β的线性无偏估计量: ∑=i

i Y c *1

?β

其中,i i i d k c +=,i d 为不全为零的常数,则容易证明①

)?var()?var(1

*1ββ≥ 同理,设*0?β是其他估计方法得到的关于0β的线性无偏估计量,则有 )?v a r ()?v a r (0

*0ββ≥ 由以上分析可以看出,普通最小二乘估计量(ordinary least Squares Estimators )具有线

性性、无偏性、最小方差性等优良性质,称为最佳线性无偏估计量(best linear unbiased estimator, BLUE ),这就是著名的高斯-马尔可夫定理(Gauss-Markov theorem ).显然这些优良的性质依赖于对模型的基本假设.

由于最小二乘估计量拥有一个“好”的估计量所应具备的小样本特性,它自然也拥有大

样本特性.如对1

?β的一致性来说,易知 ∑∑∑∑∑+

=+=+=)

/lim()/lim()lim()lim()lim()?lim(212

111n x P n x P x x P P k P P i i i i

i i i i μβμβμββ

等式右边第二项分子是X 与μ的样本协方差的概率极限,它等于总体协方差),(μX Cov ,根据基本假设,其值为0;而分母是X 的样本方差的概率极限,由基本假设为一有限常数Q ,

因此

1

110)?lim(βββ=+=Q

P 五、参数估计量的概率分布及随机干扰项方差的估计

1、参数估计量0

?β和1?β的概率分布 为了达到对所估计参数精度测定的目的,还需进一步确定参数估计量的概率分布.由于

普通最小二乘估计量0?β和1?β分别是i Y 的线性组合,因此0?β、1?β的概率分布取决于Y.在μ是正态分布的假设下,Y 是正态分布,则0

?β和1?β也服从正态分布,其分布特征由其均值和方差唯一决定.由此可得

),(~?2

2

1

1∑i

x

N σββ ),

(~?2220

0σββ∑∑i

i x

n X N

于是,0

?β和1?β的标准差分别为: ∑=22?/1

i x σσβ (2.2.12)

∑∑=

2

2

2?0

i i x n X σσβ (2.2.13)

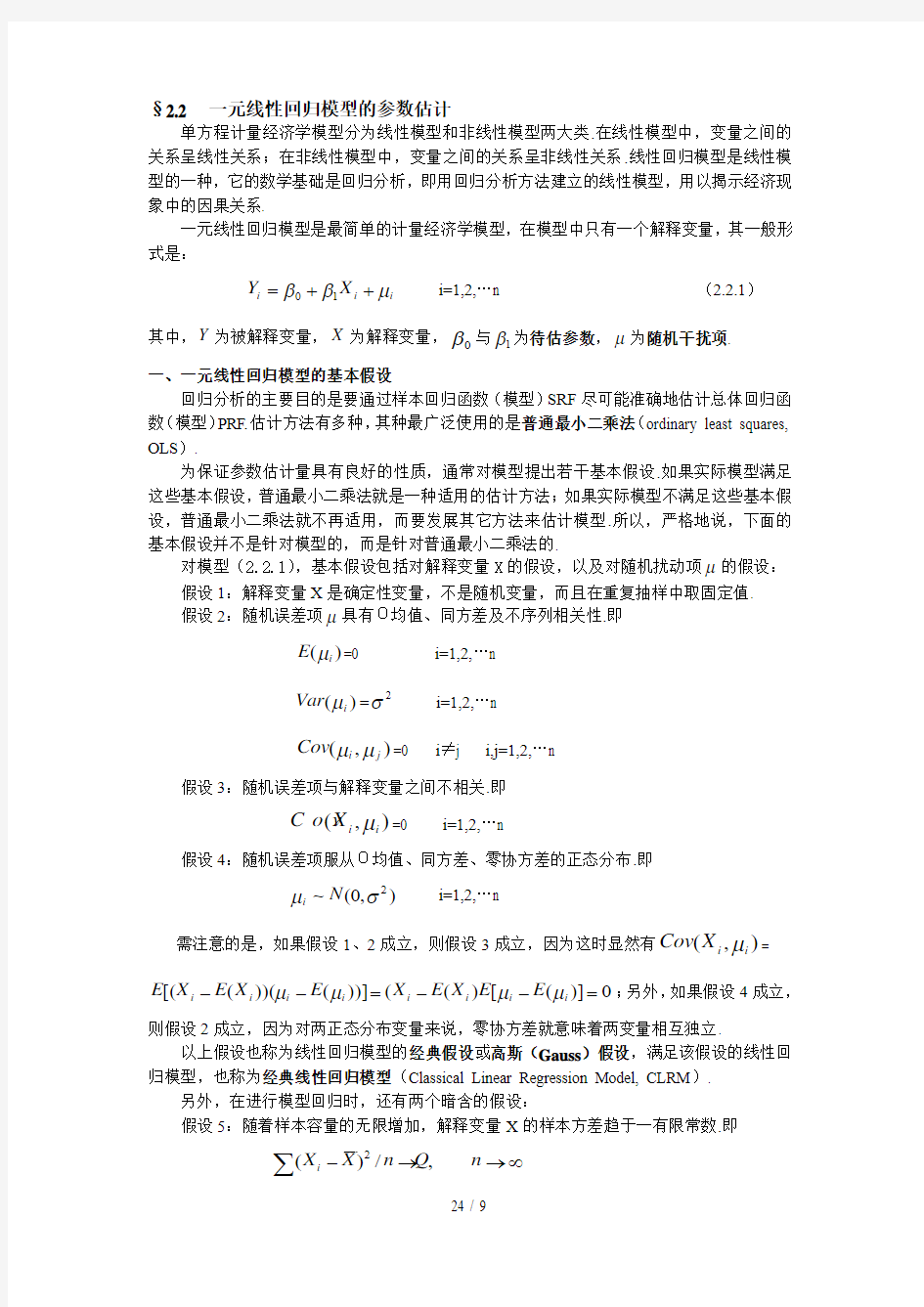

标准差可用来衡量估计量接近其真实

值的程度,进而判断估计量的可靠性(图2.2.1). 图2.2.1

2、随机误差项μ的方差2

σ的估计

在估计的参数0

?β和1?β的方差表达式中,都含有随机扰动项的方差2

σ.由于2

σ实际上是未知的,因此0

?β和1?β的方差实际上无法计算,这就需要对其进行估计.由于随机项i μ不可观测,只能从i μ的估计——残差i e 出发,对总体方差2σ进行估计.可以证明2

σ的最小二乘估计量为①

2

?22

-=

∑n e

i

σ

(2.2.14)

它是关于2

σ的无偏估计量.在最大或然估计法中,由或然方程

0)??(210212*2

2

2

=--∑+-=i i n X Y L ββ?σ?σσ 也可解得2

σ的如下最大或然估计量:

n

e

X Y n

i

i i ∑=--∑=22102)??(1?ββσ (2.2.15)

对照(2.2.14)知,2

σ的最大或然估计量不具无偏性,但却具有一致性.

在随机误差项μ的方差2

σ估计出后,参数0

?β和1?β的方差和标准差的估计量分别是: 1?β的样本方差: ∑=2

22??1

i

x

S σβ

(2.2.16) 1?β的样本标准差: ∑=2

??1i

x S σβ

(2.2.17)

0?β的样本方差: ∑∑=2222??0

i i x n X S σβ

(2.2.18) 0?β的样本标准差: ∑∑=22

??0

i i

x n X

S σβ

(2.2.19)

计量经济学-一元线性回归预测模型-Eviews6

数学与统计学院实验报告 院(系):数学与统计学学院学号:姓名: 实验课程:计量经济学指导教师: 实验类型(验证性、演示性、综合性、设计性):综合性 实验时间:2017年 3 月 1 日 一、实验课题 一元线性回归预测模型 二、实验目的和意义 用回归模型预测木材剩余物 (1)用Eviews软件建立y关于x的回归方程,并对模型和参数做假设检验; (2)求y t的点预测和平均木材剩余物产出量E(y t)的置信区间预测。 (3)假设乌伊岭林业局2000年计划采伐木材20万m3,求木材剩余物的点预测值。 三、解题思路 1、录非结构型的数据; 2、进行描述性统计,列出回归模型;通过看t、f等统计量,检验回归模型是否正确 3、运用forecast进行内预测(1-16样本),可以得到yf的点预测;再运用[yf+se]、[yf-se]进行区间估计(运用excel操作) 4、将样本范围改到17个,令x=20,运用forecast进行外预测(17-17) 四、实验过程记录与结果

翠峦11.69 32.7 乌马河 6.8 17 美溪9.69 27.3 大丰7.99 21.5 南岔12.15 35.5 带岭 6.8 17 朗乡17.2 50 桃山9.5 30 双丰 5.52 13.8 2、用Eviews软件建立y关于x的回归方程,并对模型和参数做假设检验;

模型为:y=0.404280x-0.762928 通过上表t、f统计量的p值<0.05,以及残差图基本在两倍标准差的范围内波动,可以得出该模型通过原假设。 3、求yt的点预测和平均木材剩余物产出量E(yt)的置信区间预测。Yt的点估计:

一元线性回归模型的置信区间与预测

§2.5 一元线性回归模型的置信区间与预测 多元线性回归模型的置信区间问题包括参数估计量的置信区间和被解释变量预测值的置信区间两个方面,在数理统计学中属于区间估计问题。所谓区间估计是研究用未知参数的点估计值(从一组样本观测值算得的)作为近似值的精确程度和误差范围,是一个必须回答的重要问题。 一、参数估计量的置信区间 在前面的课程中,我们已经知道,线性回归模型的参数估计量^ β是随机变量 i y 的函数,即:i i y k ∑=1?β,所以它也是随机变量。在多次重复抽样中,每次 的样本观测值不可能完全相同,所以得到的点估计值也不可能相同。现在我们用参数估计量的一个点估计值近似代表参数值,那么,二者的接近程度如何?以多大的概率达到该接近程度?这就要构造参数的一个区间,以点估计值为中心的一个区间(称为置信区间),该区间以一定的概率(称为置信水平)包含该参数。 即回答1β以何种置信水平位于() a a +-1 1?,?ββ之中,以及如何求得a 。 在变量的显著性检验中已经知道 ) 1(~^ ^ ---= k n t s t i i i βββ (2.5.1) 这就是说,如果给定置信水平α-1,从t 分布表中查得自由度为(n-k-1)的临界值 2 αt ,那么t 值处在() 22,ααt t -的概率是α-1。表示为 α αα-=<<-1)(2 2 t t t P 即 α ββαβα-=<-< -1)(2 ^ 2 ^ t s t P i i i

α ββββαβα-=?+<

非参数回归模型

非参数回归模型 非参数回归模型也叫多元回归模型,它是一种脱离于混沌理论的多条路段分析方法。它是对当前路段和几条相邻路段的交通流信息对当前路段进行交通流预测的单条路段分析的扩展。它不需要先验知识,只需要有足够的历史数据即可。它的原理是:在历史数据库中寻找与当前点相似的近邻,并根据这些近邻来预测下一时间段的流量。该算法认为系统所有的因素之间的内在联系都蕴含在历史数据中,因此直接从历史数据中得到信息而不是为历史数据建立一个近似模型。非参数回归最为一种无参数、可移植、预测精度高的算法,它的误差比较小,且误差分布情况良好。尤其通过对搜索算法和参数调整规则的改进,使其可以真正达到实时交通流预测的要求。并且这种方法便于操作实施,能够应用于复杂环境,可在不同的路段上方便地进行预测。能够满足路网上不同路段的预测,避免路段位置和环境对预测的影响。随着数据挖掘技术左键得到人们的认可和国内外学者的大量相关研究,使得非参数回归技术在短时交通流预测领域得到广泛应用。 非参数回归的回归函数()X g Y =的估计值()X g n 一般表示为: ()()∑==n i i i i n Y X W X g 1 其中,Y 为以为广策随机变量;X 为m 维随机变量;(Xi,Yi )为第i 次观测值,i=1,...,n ;Wi(Xi)为权函数.非参数回归就是对g(X)的形状不加任何限制,即对g (X )一无所知的情况下,利用观测值(Xi,Yi ),对指定的X 值去估计Y 值。由于其不需要对系统建立精确的数学模型,因此比较适合对事变的、非线性的系统进行预测,符合对城市交通流的预测,同时可以与历史平均模型实现优缺点的互补。 K 近邻法 Friedman 于1977年提出了K 近邻法。其并不是让所有的数据都参与预测,而是以数据点到X 点的距离为基础,甲醛是只有离X 最近的K 个数据被用来估计相应的g(X)值。可以引入欧式空间距离d ,然后按这个距离将X1,X2,...,Xn 与X 接近的程度重新排序:Xk1,...,Xkn,取权值如下: Wki(X:X1,...,Xn)=ki,i=1,..,n 将与X 最近的前K 个观测值占有最大的权K=1,其余的观测值赋予权值k=0.最终得到应用于短时交通流预测的K 近邻法可表示为: ()()()()K t V t V g t V K i i ∑=+==+111

非线性模型参数估计的遗传算法

滨江学院 毕业论文(设计)题目非线性模型参数估计的遗传算法 院系大气与遥感系 专业测绘工程 学生姓名李兴宇 学号200923500** 指导教师王永弟 职称讲师 二O一三年五月二十日

- 目录- 摘要 (3) 关键词 (3) 1.引言 (3) 1.1 课题背景 (3) 1.2 国内外研究现状 (4) 1.3 研究的目的和意义 (4) 1.4 论文结构 (5) 2.遗传算法简介 (5) 2.1 遗传算法的起源 (5) 2.2 遗传算法的基本思想 (6) 2.2.1 遗传算法求最优解的一般步骤 (7) 2.2.2 用技术路线流程图形式表示遗传算法流程 (7) 2.3 遗传算法的基本原理及设计 (8) 2.3.1 适应度设计 (8) 2.3.2 遗传算子操作 (9) 3.遗传算法的应用实例 (9) 3.1 非线性模型参数估计 (10) 3.2 实例分析 (10) 4.结语 (12) 参考文献 (12) 英文题目 (14) - 1 -

- 2 - 致谢 (15)

非线性模型参数估计的遗传算法 李兴宇 南京信息工程大学滨江学院测绘工程专业,南京 210044 摘要:关于非线性模型计算中的参数估计是十分棘手的问题,为此常常将这样的问题转化成非线性优化问题解决,遗传算法作为一种具有强适应性的全局搜索方法而被频繁的应用于非线性系统参数估计的计算当中,本文介绍了遗传算法及其理论基础,阐述了遗传算法在非线性模型参数估计中的应用的起源和发展,引入实例说明了遗传算法在非线性模型参数估计的实际运用中的实现,并概述了基于遗传算法的非线性参数模型估计具体解算过程,将使用遗传算法得到的结果与其他算法的解算结果进行比较,结果表明:遗传算法是一种行之有效的搜索算法,能有效得到全局最优解,在今后的研究中值得推广。 关键词:遗传算法非线性模型参数估计应用 1.引言 1.1课题背景 当前科学技术的发展和研究已经进入了进入各个领域、多个学科互相交叉、互相渗透和互相影响的时代,生命科学的研究与工程科学的交叉、渗透和相互补充提高便是其中一个非常典型的例子,同时也表现出了近代科学技术发展的一个新的显著特点。遗传算法研究工作的蓬勃发展以及在各个领域的广泛应用正是体现了科学发展过程的的这一明显的特点和良好的趋势。 非线性科学是一门研究复杂现象的科学,涉及到社会科学、自然科学和工程技术等诸多领域,在测绘学的研究中,尤其是在测量平差模型的研究和计算过程中,大量引入的都是非线性函数方程模型,而对于非线性模型的解算,往往过程复杂。遗传算法的出现为研究工作提供了一种求解多模型、多目标、非线性等复杂系统的优化问题的通用方法和框架。 对于非线性系统的解算,传统上常用的方法是利用其中参数的近似值将非线性系统线性化,也就是线性近似,测绘学中通常称之为线性化,经过线性化之后,将其视为线性模型并利用线性模型的解算方法得到结果,这就很大程度的简化了解算步骤,减少了工作量,但同时会带来新的问题,运用这种传统方法得到的数据结果存在的误差较大、精度不足等问题。利用线性近似方法对非线性模型进行参数估计,精度往往取决于模型的非线性强度。 - 3 -

多元线性回归分析预测法

多元线性回归分析预测法 (重定向自多元线性回归预测法) 多元线性回归分析预测法(Multi factor line regression method,多元线性回归分析法) [编辑] 多元线性回归分析预测法概述 在市场的经济活动中,经常会遇到某一市场现象的发展和变化取决于几个影响因素的情况,也就是一个因变量和几个自变量有依存关系的情况。而且有时几个影响因素主次难以区分,或者有的因素虽属次要,但也不能略去其作用。例如,某一商品的销售量既与人口的增长变化有关,也与商品价格变化有关。这时采用一元回归分析预测法进行预测是难以奏效的,需要采用多元回归分析预测法。 多元回归分析预测法,是指通过对两上或两个以上的自变量与一个因变量的相关分析,建立预测模型进行预测的方法。当自变量与因变量之间存在线性关系时,称为多元线性回归分析。 [编辑] 多元线性回归的计算模型[1] 一元线性回归是一个主要影响因素作为自变量来解释因变量的变化,在现实问题研究中,因变量的变化往往受几个重要因素的影响,此时就需要用两个或两个以上的影响因素作为自变量来解释

因变量的变化,这就是多元回归亦称多重回归。当多个自变量与因变量之间是线性关系时,所进行的回归分析就是多元性回归。 设y为因变量,为自变量,并且自变量与因变量之间为线性关系时,则多元线性回归模型为: 其中,b0为常数项,为回归系数,b1为固定时,x1每增加一 个单位对y的效应,即x1对y的偏回归系数;同理b2为固定时,x2每增加一个单位对y的效应,即,x2对y的偏回归系数,等等。如果两个自变量x1,x2同一个因变量y呈线相关时,可用二元线性回归模型描述为: 其中,b0为常数项,为回归系数,b1为固定时,x2每增加一 个单位对y的效应,即x2对y的偏回归系数,等等。如果两个自变量x1,x2同一个因变量y呈线相关时,可用二元线性回归模型描述为: y = b0 + b1x1 + b2x2 + e 建立多元性回归模型时,为了保证回归模型具有优良的解释能力和预测效果,应首先注意自变量的选择,其准则是: (1)自变量对因变量必须有显著的影响,并呈密切的线性相关; (2)自变量与因变量之间的线性相关必须是真实的,而不是形式上的; (3)自变量之彰应具有一定的互斥性,即自变量之彰的相关程度不应高于自变量与因变量之因的相关程度; (4)自变量应具有完整的统计数据,其预测值容易确定。 多元性回归模型的参数估计,同一元线性回归方程一样,也是在要求误差平方和()为最小的前提下,用最小二乘法求解参数。以二线性回归模型为例,求解回归参数的标准方程组为 解此方程可求得b0,b1,b2的数值。亦可用下列矩阵法求得

常见非线性回归模型

常见非线性回归模型 1.简非线性模型简介 非线性回归模型在经济学研究中有着广泛的应用。有一些非线性回归模型可以通 过直接代换或间接代换转化为线性回归模型,但也有一些非线性回归模型却无 法通过代换转化为线性回归模型。 柯布—道格拉斯生产函数模型 y AKL 其中L和K分别是劳力投入和资金投入, y是产出。由于误差项是可加的, 从而也不能通过代换转化为线性回归模型。 对于联立方程模型,只要其中有一个方程是不能通过代换转化为线性,那么这个联立方程模型就是非线性的。 单方程非线性回归模型的一般形式为 y f(x1,x2, ,xk; 1, 2, , p) 2.可化为线性回归的曲线回归 在实际问题当中,有许多回归模型的被解释变量y与解释变量x之间的关系都不是线性的,其中一些回归模型通过对自变量或因变量的函数变换可以转化为

线性关系,利用线性回归求解未知参数,并作回归诊断。如下列模型。 (1)y 0 1e x (2)y 0 1x2x2p x p (3)y ae bx (4)y=alnx+b 对于(1)式,只需令x e x即可化为y对x是线性的形式y01x,需要指出的是,新引进的自变量只能依赖于原始变量,而不能与未知参数有关。 对于(2)式,可以令x1=x,x2=x2,?,x p=x p,于是得到y关于x1,x2,?, x p 的线性表达式y 0 1x12x2 pxp 对与(3)式,对等式两边同时去自然数对数,得lnylnabx ,令 y lny, 0 lna, 1 b,于是得到y关于x的一元线性回归模型: y 0 1x。 乘性误差项模型和加性误差项模型所得的结果有一定差异,其中乘性误差项模型认为yt本身是异方差的,而lnyt是等方差的。加性误差项模型认为yt是等 方差的。从统计性质看两者的差异,前者淡化了y t值大的项(近期数据)的作用, 强化了y t值小的项(早期数据)的作用,对早起数据拟合得效果较好,而后者则 对近期数据拟合得效果较好。 影响模型拟合效果的统计性质主要是异方差、自相关和共线性这三个方面。 异方差可以同构选择乘性误差项模型和加性误差项模型解决,必要时还可以使用 加权最小二乘。

非参数回归模型资料

非参数回归模型

精品资料 仅供学习与交流,如有侵权请联系网站删除 谢谢2 非参数回归模型 非参数回归模型也叫多元回归模型,它是一种脱离于混沌理论的多条路段分析方法。它是对当前路段和几条相邻路段的交通流信息对当前路段进行交通流预测的单条路段分析的扩展。它不需要先验知识,只需要有足够的历史数据即可。它的原理是:在历史数据库中寻找与当前点相似的近邻,并根据这些近邻来预测下一时间段的流量。该算法认为系统所有的因素之间的内在联系都蕴含在历史数据中,因此直接从历史数据中得到信息而不是为历史数据建立一个近似模型。非参数回归最为一种无参数、可移植、预测精度高的算法,它的误差比较小,且误差分布情况良好。尤其通过对搜索算法和参数调整规则的改进,使其可以真正达到实时交通流预测的要求。并且这种方法便于操作实施,能够应用于复杂环境,可在不同的路段上方便地进行预测。能够满足路网上不同路段的预测,避免路段位置和环境对预测的影响。随着数据挖掘技术左键得到人们的认可和国内外学者的大量相关研究,使得非参数回归技术在短时交通流预测领域得到广泛应用。 非参数回归的回归函数()X g Y =的估计值()X g n 一般表示为: ()()∑==n i i i i n Y X W X g 1 其中,Y 为以为广策随机变量;X 为m 维随机变量;(Xi,Yi )为第i 次观测值,i=1,...,n ;Wi(Xi)为权函数.非参数回归就是对g(X)的形状不加任何限制,即对g (X )一无所知的情况下,利用观测值(Xi,Yi ),对指定的X 值去估计Y 值。由于其不需要对系统建立精确的数学模型,因此比较适合对事变的、非线性的系统进行预测,符合对城市交通流的预测,同时可以与历史平均模型实现优缺点的互补。 K 近邻法 Friedman 于1977年提出了K 近邻法。其并不是让所有的数据都参与预 测,而是以数据点到X 点的距离为基础,甲醛是只有离X 最近的K 个数据被用来估计相应的g(X)值。可以引入欧式空间距离d ,然后按这个距离将X1,X2,...,Xn 与X 接近的程度重新排序:Xk1,...,Xkn,取权值如下: Wki(X:X1,...,Xn)=ki,i=1,..,n 将与X 最近的前K 个观测值占有最大的权K=1,其余的观测值赋予权值k=0.最终得到应用于短时交通流预测的K 近邻法可表示为:

多元线性回归预测模型论文

多元线性回归统计预测模型 摘要:本文以多元统计分析为理论基础,在对数据进行统计分析的基础上建立多元线性回归模型并对未知量作出预测,为相关决策提供依据和参考。重点介绍了模型中参数的估计和自变量的优化选择及简单应用举例。 关键词:统计学;线性回归;预测模型 一.引言 多元线性回归统计预测模型是以统计学为理论基础建立数学模型,研究一个随机变量Y与两个或两个以上一般变量X 1,X 2,…,Xp 之间相依关系,利用现有数据,统计并分析,研究问题的变化规律,建立多元线性回归的统计预测模型,来预测未来的变化情况。它不仅能解决一些随机的数学问题,而且还可以通过建立适当的随机模型进而解决一些确定的数学问题,为相关决策提供依据和参考。 目前统计学与其他学科的相互渗透为统计学的应用开辟新的领域。并被广泛的应用在各门学科上,从物理和社会科学到人文科学,甚至被用来工业、农业、商业及政府部门。而多元线性回归是多元统计分析中的一个重要方法,被应用于众多自然科学领域的研究中。多元线性回归分析作为一种较为科学的方法,可以在获得影响因素的前提下,将定性问题定量化,确定各因素对主体问题的具体影响程度。 二.多元线性回归的基本理论 多元线性回归是多元统计分析中的一个重要方法,被广泛应用于众多自然科学领域的研究中。多元线性回归分析的基本任务包括:根据因变量与多个自变量的实际观测值建立因变量对多个自变量的多元线性回归方程;检验、分析各个自变量对因自变量的综合线性影响的显著性;检验、分析各个自变量对因变量的单纯线性影响的显著性,选择仅对因变量有显著线性影响的自变量,建立最优多元线性回归方程;评定各个自变量对因变量影响的相对重要性以及测定最优多元线性回归方程的偏离度等。由于多数的多元非线性回归问题都可以化为多元线性回归问题,所以这里仅讨论多元线性回归。许多非线性回归和多项式回归都可以化为多元线性回归来解决,因而多元线性回归分析有着广泛的应用。 2.1 多元线性回归模型的一般形式 设随机变量y 与一般变量12,, ,p x x x 线性回归模型为 01122...p p y x x x ββββε=+++++ (2.1) 模型中Y为被解释变量(因变量),而12,,,p x x x 是p 个可以精确测量并可控制的一般变 量,称为解释变量(自变量)。p =1时,(2.1)式即为一元线性回归模型,p 大于2时,(2.1)

非线性模型参数估计的EViews操作

非线性模型参数估计的EViews 操作 例3.5.2 建立中国城镇居民食品消费需求函数模型。根据需求理论,居民对食品的消费需求函数大致为: ()01,,f P P X Q =。 其中,Q 为居民对食品的需求量,X 为消费者的消费支出总额,P1为食品价格指数,P0为居民消费价格总指数。 表3.5.1 中国城镇居民消费支出及价格指数 单位:元 资料来源:《中国统计年鉴》(1990~2007) 估计双对数线性回归模型μββββ++++=031210n n n P L LnP X L Q L 对应的非线性模型: 3 21 1ββ βP P AX Q = 这里需要将等式右边的A 改写为0 e β。取0β,1β,2β,3β的初值均为1。

Eviews操作: 1、打开EViews,建立新的工作文档:File-New-Workfile,在Frequency选择Annual,在Start date输入“1985”,End date输入“2006”,确认OK。 2、输入样本数据:Object-New Object-Group,确认OK,输入样本数据。 图1 3、设置参数初始值:在命令窗口输入“param c(1) 1 c(2) 1 c(3) 1 c(4) 1”,回车确认。 4、非线性最小二乘法估计(NLS):Proc-Make Equation,在NLS估计的方程中写入Q=EXP(C(1))*X^C(2)*P1^C(3)*P0^C(4),方程必须写完整,不能写成Q C(1) X P1 P0。确定输出估计结果:

图2 NLS注意事项: 1).参数初始值: 如果参数估计值出现分母为0等情况将导致错误,解决办法是:手工设定参数的初始值及范围,比如生产函数中的c(2)肯定是介于0-1之间的数字。 eviews6.0中并没有start 的选项,只有iteration的次数和累进值得选择。只能通过param c(1) 0.5 c(2) 0.5来设置。 2).迭代及收敛 eviews用Gauss Seidel迭代法求参数的估计值。迭代停止的法则:基于回归函数或参数在每次迭代后的变化率,当待估参数的变化百分比的最大值小于事先给定的水平时,就会停止迭代。当迭代次数到了迭代的最大次数时也会停止,或者迭代过程中发生错误也会停止。

非参数统计模型

非参数统计第二次作业 ——局部多项式回归与样条回归 习题一: 一、本题是研究加拿大工人收入情况,即年龄(age)和收入(income)的关系。 此次共调查了205个加拿大工人的年龄和收入,所有工人都是高中毕业。且本题设定因变量为log.income,协变量为age,运用统计方法来拟合log.income 与age之间的函数关系。 二、模型的建立 1.估计方法的选取 拟合两个变量之间的函数关系,即因变量和协变量之间的关系,用回归估计的方法,回归估计包括参数回归估计和非参数回归估计。参数估计是先假定某种数学模型或已知总体的分布,例如总体服从正态分布,其中某些参数未知,如总体均值、方差等,然后利用样本去估计这些未知参数,常用的方法有极大似然估计,Bayes估计等,线性模型可以用最小二乘法估计。 非参数估计是不假定具有某种特定的数学模型,或总体分布未知,直接利用样本去估计总体的数学模型,常用的方法有局部多项式回归方法和样条函数回归方法。 本题调查了205个加拿大工人的年龄和收入,但是加拿大工人年龄和收入的具体分布未知,即这两个变量所能建立的数学模型未知,而且由协变量和因变量所形成的散点图可以看出它不符合某种特定的已知模型,需要进一步研究,然后拟合它们之间的函数关系。因此本题选用非参数回归估计的方法,来拟合因变量和协变量之间的关系。 针对此问题分别采用非参数估计中的局部多项式回归和样条函数回归方法对log.income 与age之间的函数关系进行估计。 2.局部多项式回归方法 局部多项式的思想是在某个点x附近,用一个多项式函数来逼近未知的光滑函数g(x)。选定局部邻域的大小h,对于任意给定某个点x 0,在其小邻域内展开泰勒公式,用一个p阶多项式来局部逼近g(x),然后再用极大似然估计。 (1)加拿大工人的收入(log.income)与年龄(age)之间的散点图如下所示:

matlab建立多元线性回归模型并进行显著性检验及预测问题

matlab建立多元线性回归模型并进行显着性检验及预测问题 例子; x=[143 145 146 147 149 150 153 154 155 156 157 158 159 160 162 164]'; X=[ones(16,1) x]; 增加一个常数项Y=[88 85 88 91 92 93 93 95 96 98 97 96 98 99 100 102]'; [b,bint,r,rint,stats]=regress(Y,X) 得结果:b = bint = stats = 即对应于b的置信区间分别为[,]、[,]; r2=, F=, p= p<, 可知回归模型y=+ 成立. 这个是一元的,如果是多元就增加X的行数! function [beta_hat,Y_hat,stats]=regress(X,Y,alpha) % 多元线性回归(Y=Xβ+ε)MATLAB代码 %? % 参数说明 % X:自变量矩阵,列为自变量,行为观测值 % Y:应变量矩阵,同X % alpha:置信度,[0 1]之间的任意数据 % beta_hat:回归系数 % Y_beata:回归目标值,使用Y-Y_hat来观测回归效果 % stats:结构体,具有如下字段 % =[fV,fH],F检验相关参数,检验线性回归方程是否显着 % fV:F分布值,越大越好,线性回归方程越显着 % fH:0或1,0不显着;1显着(好) % =[tH,tV,tW],T检验相关参数和区间估计,检验回归系数β是否与Y有显着线性关系 % tV:T分布值,beta_hat(i)绝对值越大,表示Xi对Y显着的线性作用% tH:0或1,0不显着;1显着 % tW:区间估计拒绝域,如果beta(i)在对应拒绝区间内,那么否认Xi对Y显着的线性作用 % =[T,U,Q,R],回归中使用的重要参数 % T:总离差平方和,且满足T=Q+U % U:回归离差平方和 % Q:残差平方和 % R∈[0 1]:复相关系数,表征回归离差占总离差的百分比,越大越好% 举例说明 % 比如要拟合y=a+b*log(x1)+c*exp(x2)+d*x1*x2,注意一定要将原来方程线化% x1=rand(10,1)*10; % x2=rand(10,1)*10; % Y=5+8*log(x1)+*exp(x2)+*x1.*x2+rand(10,1); % 以上随即生成一组测试数据 % X=[ones(10,1) log(x1) exp(x2) x1.*x2]; % 将原来的方表达式化成Y=Xβ,注意最前面的1不要丢了

一元线性回归分析实验报告

一元线性回归在公司加班制度中的应用 院(系): 专业班级: 学号姓名: 指导老师: 成绩: 完成时间:

一元线性回归在公司加班制度中的应用 一、实验目的 掌握一元线性回归分析的基本思想和操作,可以读懂分析结果,并写出回归方程,对回归方程进行方差分析、显著性检验等的各种统计检验 二、实验环境 SPSS21.0 windows10.0 三、实验题目 一家保险公司十分关心其总公司营业部加班的程度,决定认真调查一下现状。经10周时间,收集了每周加班数据和签发的新保单数目,x 为每周签发的新保单数目,y 为每周加班时间(小时),数据如表所示 y 3.5 1.0 4.0 2.0 1.0 3.0 4.5 1.5 3.0 5.0 2. x 与y 之间大致呈线性关系? 3. 用最小二乘法估计求出回归方程。 4. 求出回归标准误差σ∧ 。 5. 给出0 β∧与1 β∧ 的置信度95%的区间估计。 6. 计算x 与y 的决定系数。 7. 对回归方程作方差分析。 8. 作回归系数1 β∧ 的显著性检验。 9. 作回归系数的显著性检验。 10.对回归方程做残差图并作相应的分析。

11.该公司预测下一周签发新保单01000 x=张,需要的加班时间是多少? 12.给出0y的置信度为95%的精确预测区间。 13.给出 () E y的置信度为95%的区间估计。 四、实验过程及分析 1.画散点图 如图是以每周加班时间为纵坐标,每周签发的新保单为横坐标绘制的散点图,从图中可以看出,数据均匀分布在对角线的两侧,说明x和y之间线性关系良好。 2.最小二乘估计求回归方程

用SPSS 求得回归方程的系数01,ββ分别为0.118,0.004,故我们可以写出其回归方程如下: 0.1180.004y x =+ 3.求回归标准误差σ∧ 由方差分析表可以得到回归标准误差:SSE=1.843 故回归标准误差: 2= 2SSE n σ∧-,2σ∧=0.48。 4.给出回归系数的置信度为95%的置信区间估计。 由回归系数显著性检验表可以看出,当置信度为95%时:

第7章 非线性模型参数估值

第7章 非线性模型参数估值 7.1 引言 数学模型是观测对象各影响因素相互关系的定量描述。在获得实验数据并做了整理之后,就要建立数学模型。这一工作在科学研究中有着十分重要的意义。 人们选用的模型函数可以是经验的,可以是半经验的,也可以是理论的。模型函数选定之后,需要对其中的参数进行估值并确定该估值的可靠程度。对于线性模型,待求参数可用线性最小二乘法求得,即用前一章中介绍的确定线性回归方程的方法。对于非线性模型,通常是通过线性化处理而化为线性模型,用线性最小二乘法求出新的参数,从而再还原为原参数。这种方法在处理经验模型时,简便易行,具有一定的实用价值。但要注意到,这样做是使变换后的新变量y '的残差平方和(即剩余平方和)最小,这并不能保证做到使原变量y 的残差平方和也达最小值。因此,得到的参数估计值就不一定是最佳的估计值。可见在求理论模型的参数时,这种线性化的方法尚有其不足之处。此外,还有些数学模型无法线性化,所以用线性化的方法是行不通的。为此,需要一种对非线性模型通用的(不管是经验模型还是理论模型,不管这个模型能否线性化),能够得到参数最佳估计值的参数估计方法。 在工程中,特别是在化学工程中的数学模型大多是非线性、多变量的。设y ?为变量x 1,x 2,…,x p ,的函数,含有m 个参数b 1,b 2,…,b m ,则非线性模型的一般形式可表示为: =y ?f (x 1,x 2,…,x p ;b 1,b 2,…,b m ) (7.1) 或写为 ),(?b x f y = (7.2) 式中x 为p 维自变量向量,b 为m 维参数向量。 设给出n 组观测数据 x 1 ,x 2 ,… ,x n y 1 ,y 2 ,… ,y n 我们的目的是由此给出模型式(7.2)中的参数b 的最佳估计值。可以证明,这个最佳估计值就是最小二乘估计值。 按最小二乘法原理,b 应使Q 值为最小,即 ∑==-=n i i i y y Q 12min )?( 或写成 ∑==-=n i i i f y Q 1 2min )],([b x (7.3) 现在的问题是根据已知的数学模型和实验数据,求出使残差平方和最小,即 目标函数式(7.3)取极小值时的模型参数向量b 。这显然是一个最优化的数学问题,可以采用逐次逼近法求解。这种处理方法实质上是逐次线性化法或某种模式的搜索法。在下面各节中将介绍几个适用方法。

自回归模型的参数估计案例

自回归模型的参数估计案例 案例一: 建立中国长期货币流通量需求模型。中国改革开放以来,对货币需求量(Y)的影响因素,主要有资金运用中的贷款额(X)以及反映价格变化的居民消费者价格指数(P)。 长期货币流通量模型可设定为 120e t t t t P Y X βμββ=+++ (1) 其中,e t Y 为长期货币流通需求量。由于长期货币流通需求量不可观测,作局部调整: 11()e t t t t Y Y Y Y δ---=- (2) 其中,t Y 为实际货币流通量。 将(1)式代入(2)得短期货币流通量需求模型: 0121(1)t t t t t Y X P Y δβδβδβδδμ-=+++-+ 表1中列出了1978年到2007年我国货币流通量、贷款额以及居民消费者价格指数的相关数据。 表1 年份 货币流通量Y (亿元) 居民消费者价格指数P (1990年=100) 贷款额X (亿元) 1978 212.0 46.2 1850.0 1979 267.7 47.1 2039.6 1980 346.2 50.6 2414.3 1981 396.3 51.9 2860.2 1982 439.1 52.9 3180.6 1983 529.8 54.0 3589.9 1984 792.1 55.5 4766.1 1985 987.8 60.6 5905.6 1986 1218.4 64.6 7590.8 1987 1454.5 69.3 9032.5

1988 2134.0 82.3 10551.3 1989 2344.0 97.0 14360.1 1990 2644.4 100.0 17680.7 1991 3177.8 103.4 21337.8 1992 4336.0 110.0 26322.9 1993 5864.7 126.2 32943.1 1994 7288.6 156.7 39976.0 1995 7885.3 183.4 50544.1 1996 8802.0 198.7 61156.6 1997 10177.6 204.2 74914.1 1998 11204.2 202.6 86524.1 1999 13455.5 199.7 93734.3 2000 14652.7 200.6 99371.1 2001 15688.8 201.9 112314.7 2002 17278.0 200.3 131293.9 2003 19746.0 202.7 158996.2 2004 21468.3 210.6 178197.8 2005 24031.7 214.4 194690.4 2006 27072.6 217.7 225347.2 2007 30375.2 228.1 261690.9 对局部调整模型0121(1)t t t t t Y X P Y δβδβδβδδμ-=+++-+运用OLS 法估计结果如图1: 图1 回归估计结果 由图1短期货币流通量需求模型的估计式: 1202.50.03577.45570.7236t t t t Y X P Y -=-+++

非线性模型参数估计方法步骤

EViews非线性模型参数估计方法步骤 1.新建EViews工作区,并将时间序列X、P1和P0导入到工作区; 2.设定参数的初始值全部为1,其方法是在工作区中其输入下列命令 并按回车键 param c(1) 1 c(2) 1 c(3) 1 c(4) 1 3.估计非线性模型参数,其方法是在工作区中其输入下列命令并按 回车键 nls q=exp(c(1))*x^c(2)*p1^c(3)*p0^c(4) 4.得到结果见table01(91页表3. 5.4结果)(案例一结束) Dependent Variable: Q Method: Least Squares Date: 03/29/15 Time: 21:44 Sample: 1985 2006 Included observations: 22 Convergence achieved after 9 iterations Q=EXP(C(1))*X^C(2)*P1^C(3)*P0^C(4) Coefficient Std. Error t-Statistic Prob. C(1) 5.567708 0.083537 66.64931 0.0000 C(2) 0.555715 0.029067 19.11874 0.0000 C(3) -0.190154 0.143823 -1.322146 0.2027 C(4) -0.394861 0.159291 -2.478866 0.0233 R-squared 0.983631 Mean dependent var 1830.000 Adjusted R-squared 0.980903 S.D. dependent var 365.1392 S.E. of regression 50.45954 Akaike info criterion 10.84319 Sum squared resid 45830.98 Schwarz criterion 11.04156 Log likelihood -115.2751 Hannan-Quinn criter. 10.88992 Durbin-Watson stat 0.672163 (92页表3.5.5结果)(案例二过程) 5.新建EViews工作区,并将时间序列X、P1和P0导入到工作区;

基于核估计的多变量非参数随机模型初步研究

基于核估计的多变量非参数随机模型初步研究 王文圣1,丁晶1 (1.四川大学水利水电学院,四川成都 610065) 摘要:本文基于核估计理论构造了多变量非参数模型。该模型是数据驱动的、不需识别和假定序列相依形式和概率分布形式的一类随机模型,克服了多变量参数模型的不足。实例统计试验表明,建议的多变量非参数模型是有成效的,为随机水文学发展提供了一些新思路。 关键词:核估计;多变量非参数模型;随机模拟;实用性检验 中图分类号:P333.9文献标识码:A 流域水资源的开发利用,不仅需要单站水文信息,而且需要流域内各站的水文信息。进行多站水文序列模拟的一个重要手段就是建立多站(变量)随机模型。目前,多变量随机模型[1]比较成熟的有自回归模型和解集模型。这两类模型的共同点是用有限个参数的线性函数关系描述水文现象。因此简便实用,能表征水文序列的统计特性和一般变化规律,但缺点也明显:①水文序列是一时间不可逆过程,而参数模型描述的是可逆过程,因此大多数参数模型难以反映其涨落不对称性;②水文现象受流域下垫面、人类活动、气候等多因素影响而变化错综,是一个高度复杂的非线性系统,而多数参数模型仅能表征变量及变量之间的线性相依结构,忽略了占据重要位置的非线性性;③水文变量概率密度函数复杂且未知,某一指定概率分布与真实分布存在着差异。如图1、2所示,正态分布、P-Ⅲ型分布都与直方图相差甚远,但χ2检验并不拒绝P-Ⅲ型分布和正态分布;而核估计和k最近邻估计与直方图比较接近。即概率分布具有不确定性;④模型参数由于抽样误差和估计方法不同具有不确定性。 为克服参数模型之不足,文献[2]提出了单变量非参数模型,径流模拟表明是满意的。在此基础上,本文基于核估计理论构造了多变量非参数模型。该模型避开了序列相依形式和模型结构的假设,不涉及模型参数估计,能反映各种复杂关系,较参数模型优越。以中国金沙江流域屏山站和宜宾—屏山区间两站日流量过程随机模拟为例,对建议模型进行了应用研究。 1 核估计理论[3] 1.1 多维核估计定义设X为d维随机变量,X1,X2,……X n为X的一样本。X的概率密度函数f(X)的核估计定义如下: (1)

线性回归和灰色预测模型案例

预测未来2015年到2020年的货运量 灰色预测模型 是通过少量的、不完全的信息,建立数学模型并做出预测的一种预测方法.当我们应用运筹学的思想方法解决实际问题,制定发展战略和政策、进行重大问题的决策时,都必须对未来进行科学的预测. 预测是根据客观事物的过去和现在的发展规律,借助于科学的方法对其未来的发展趋势和状况进行描述和分析,并形成科学的假设和判断. 灰色系统的定义 灰色系统是黑箱概念的一种推广。我们把既含有已知信息又含有未知信息的系统称为灰色系统.作为两个极端,我们将称信息完全未确定的系统为黑色系统;称信息完全确定的系统为白色系统.区别白色系统与黑色系统的重要标志是系统各因素之间是否具有确定的关系。

建模原理 模型的求解

原始序列为: ) 16909 15781 13902 12987 12495 11067 10149 9926 9329 10923 7691())6(),...1(()0()0()0(==x x x 构造累加生成序列 ) 131159,114250,98469,84567,71580,59085, 48018,37869,27943,18614,7691())6(),...1(()1()1()1(==x x x 归纳上面的式子可写为 称此式所表示的数据列为原始数据列的一次累加生成,简称为一次累加生成. 对(1)X 作紧邻均值生成 ,.... 2)) 1()((21)()1() 1() 1(=-+=k k z k z k z MATLAB 代码如下: x=[7691 18614 27943 37869 48018 590857 71580 84567 98469 114250 131159]; z(1)=x(1); for i=2:6 z(i)=0.5*(x(i)+x(i-1)); end format long g z z = Columns 1 through 3 7691 13152.5 23278.5 Columns 4 through 6 32906 42943.5 319437.5

非参数回归模型与半参数回归模型

第七章 非参数回归模型与半参数回归模型 第一节 非参数回归与权函数法 一、非参数回归概念 前面介绍的回归模型,无论是线性回归还是非线性回归,其回归函数形式都是已知的,只是其中参数待定,所以可称为参数回归。参数回归的最大优点是回归结果可以外延,但其缺点也不可忽视,就是回归形式一旦固定,就比较呆板,往往拟合效果较差。另一类回归,非参数回归,则与参数回归正好相反。它的回归函数形式是不确定的,其结果外延困难,但拟合效果却比较好。 设Y 是一维观测随机向量,X 是m 维随机自变量。在第四章我们曾引进过条件期望作回归函数,即称 g (X ) = E (Y |X ) (7.1.1) 为Y 对X 的回归函数。我们证明了这样的回归函数可使误差平方和最小,即 22)]([min )]|([X L Y E X Y E Y E L -=- (7.1.2) 这里L 是关于X 的一切函数类。当然,如果限定L 是线性函数类,那么g (X )就是线性回归函数了。 细心的读者会在这里立即提出一个问题。既然对拟合函数类L (X )没有任何限制,那么可以使误差平方和等于0。实际上,你只要作一条折线(曲面)通过所有观测点(Y i ,X i )就可以了是的,对拟合函数类不作任何限制是完全没有意义的。正象世界上没有绝对的自由一样,我们实际上从来就没有说放弃对L(X)的一切限制。在下面要研究的具体非参数回归方法,不管是核函数法,最近邻法,样条法,小波法,实际都有参数选择问题(比如窗宽选择,平滑参数选择)。 所以我们知道,参数回归与非参数回归的区分是相对的。用一个多项式去拟合(Y i ,X i ),属于参数回归;用多个低次多项式去分段拟合(Y i ,X i ),叫样条回归,属于非参数回归。 二、权函数方法 非参数回归的基本方法有核函数法,最近邻函数法,样条函数法,小波函数法。这些方法尽管起源不一样,数学形式相距甚远,但都可以视为关于Y i 的线性组合的某种权函数。也就是说,回归函数g (X )的估计g n (X )总可以表为下述形式: ∑==n i i i n Y X W X g 1 )()( (7.1.3)