叶中行信息论答案

信息论第五章答案解析

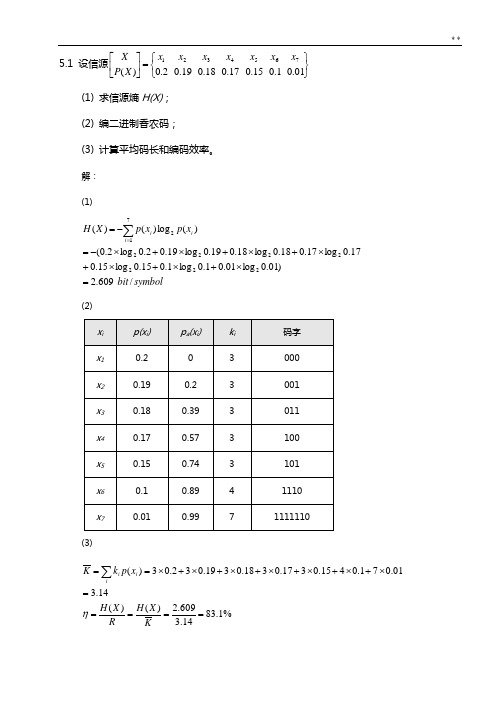

5.1 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X (1) 求信源熵H(X); (2) 编二进制香农码; (3) 计算平均码长和编码效率。

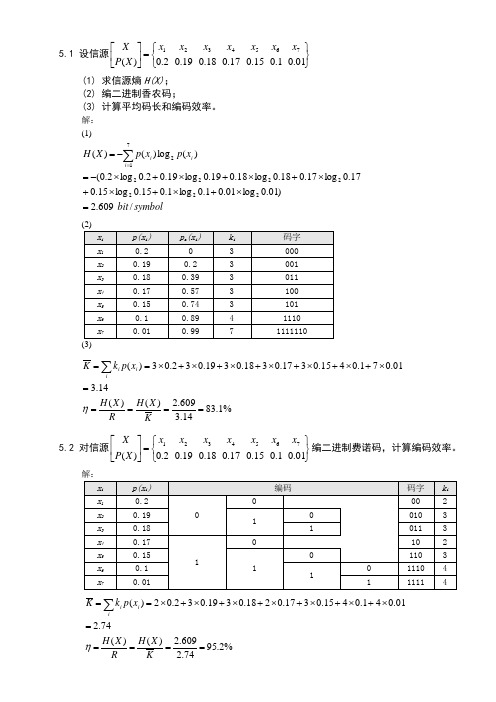

解: (1)symbolbit x p x p X H i i i /609.2)01.0log 01.01.0log 1.015.0log 15.017.0log 17.018.0log 18.019.0log 19.02.0log 2.0()(log )()(2222222712=⨯+⨯+⨯+⨯+⨯+⨯+⨯-=-=∑= (2)(3)%1.8314.3609.2)()(14.301.071.0415.0317.0318.0319.032.03)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η5.2 对信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X 编二进制费诺码,计算编码效率。

解:%2.9574.2609.2)()(74.201.041.0415.0317.0218.0319.032.02)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η5.3 对信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X 编二进制和三进制哈夫曼码,计算各自的平均码长和编码效率。

解:二进制哈夫曼码:%9.9572.2609.2)()(72.201.041.0415.0317.0318.0319.022.02)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η三进制哈夫曼码:%4.913log 8.1609.2log )()(8.1)01.01.015.017.018.019.0(22.01)(22=⨯====+++++⨯+⨯==∑m LKX H R X H x p k K ii i η5.4 设信源⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡12811281641321161814121)(87654321x x x x x x x x X P X (1) 求信源熵H(X);(2) 编二进制香农码和二进制费诺码;(3) 计算二进制香农码和二进制费诺码的平均码长和编码效率; (4) 编三进制费诺码;(5) 计算三进制费诺码的平均码长和编码效率;解: (1)symbolbit x p x p X H i i i /984.1128log 1281128log 128164log 64132log 32116log 1618log 814log 412log 21)(log )()(22222222812=⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯=-=∑==127/64 bit/symbol (2)二进制香农码:二进制费诺码:(3)香农编码效率:%100984.1984.1)()(64/127984.17128171281664153214161381241121)(======⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η费诺编码效率:%100984.1984.1)()(984.17128171281664153214161381241121)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η (4)(5)%3.943log 328.1984.1log )()(328.14128141281364133212161281141121)(22=⨯=⋅===⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑m K X H R X H x p k K ii i η5.5 设无记忆二进制信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡1.09.010)(X P X先把信源序列编成数字0,1,2,……,8,再替换成二进制变长码字,如下表所示。

信息论基础教材习题答案.docx

第

9.6共有28=256个码字,不能由一个码字的循环产生所有的码字,因为码长为8位,由一个码字循环移位 最多能产生8个码字。

9.7根据伴随式定义:5(x)=j(x) [mod g(x)],由于码多项式都是g(x)的倍式,如果接受矢量y(x)是码多 项式,则它的的伴随式等于0,如果y(Q不是码多项式,则伴随式s(Q不等于0。

0

0

0

0

0

1

1

0

1

0

0

0

0

0

0

0

0

0

0

1

0

1

0

0

1

0

0

0

0

0

0

0

0

0

1

1

0

0

0

0

1

0

0

0

0

0

0

0

0

1

1

1

0

0

0

0

1

0

0

0

0

0

0

1

0

0

1

G =

0

0

0

0

0

1

0

0

0

0

0

1

1

1

0

0

0

0

0

0

0

1

0

0

0

0

1

0

1

1

0

0

0

0

0

0

0

1

0

0

0

1

1

0

0

0

0

0

0

0

0

0

0

信息论PPt(叶中行)..

LZ算法

i

反之,对给定的满足上述不等式的一组 (l1,l2,...,lm ),必存在以它们为码字长的一个 即时码

例 设二进制码树中X (a1 , a2 , a3 , a4 ), l1 1, l2 2, l3 2, l4 3, 应用克莱夫特不等式判断是否为唯一 可译码

例 设离散信源 s6 S s1 s2 pi 1 p( s) p p p6 i 1 2 将此信源编码成r元唯一可译码,其对应的码长 为(l1 ,l2 , ,l6 )=(1,1,2,3,2,3),求r值的下限

第3章 数据压缩和信源编码

§3.1 等长码 §3.2 变长编码 §3.3 哈夫曼码 §3.4 香农码和费诺玛

§3.1 等长码

• 信源编码:以提高通信有效性为目的的编码。通常 通过压缩信源的冗余度来实现。采用的一般方法是 压缩每个信源符号的平均比特数或信源的码率。即 同样多的信息用较少的码率传送,使单位时间内传 送的平均信息量增加,从而提高通信的有效性。

*

3.5 通用信源编码

本节将主要介绍 • LZ算法, • 改进的LZ-Welcn 算法 • Kieffer-Yang算法, • LZ算法基于符号串匹配的算法,而LZWelcn 算法是基于字典的算法,它们都是 利用信源输出符号自身的信息来进行压缩 编码。Kieffer-Yang算法(简称YK算法)则 兼顾了字符串匹配和算术码结构的优点。

0 11 00 11

0 10 00 01

1 10 100 1000

1 01 001 0001

6 、同价码: 每个码字占相同的传输时间

7.码的N 次扩展: 若码C :{W1 , W2 ,..., Wq },B :{Bi (Wi1Wi 2 ...WiN )},则 码B称为码C的N 次扩展码

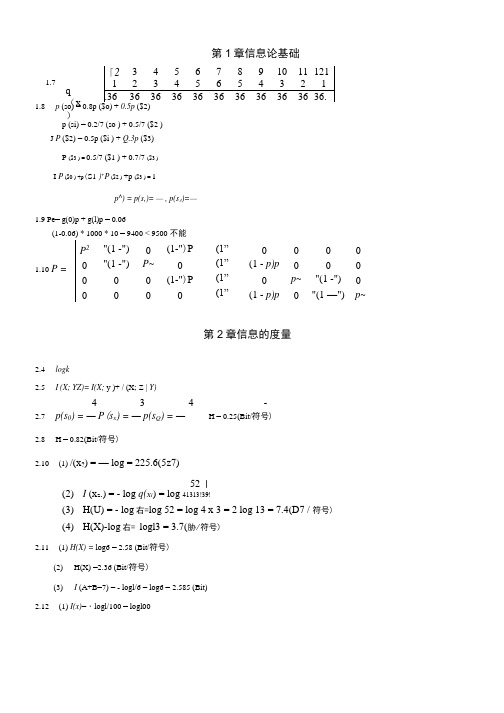

信息论第二、三章习题解答

信息论(I )第二、三章 习题解答4.1 同时掷两个正常的骰子,也就是各面呈现的概率是61,求: (1)“3和5同时出现”这一事件的自信息量。

(2)“两个1同时出现”这一事件的自信息量。

(3)两个点数的各种组合(无序对)的熵或平均信息量。

(4)两个点数之和(即2,3…12构成的子集)的熵。

(5)两个点数中至少有一个是1的自信息。

4.2 消息符号集的概率分布和二进制代码如下表(1)求消息的符号熵。

(2)每个消息符号所需要的平均二进制码的个数或平均代码长度。

进而用这个结果求码序列中的一个二进制码的熵。

(3)当消息是由符号序列组成时,各符号之间若相互独立,求其对应的二进制码序列中出现0和1的无条件概率0p 和1p ,求相邻码间的条件概率10110100,,,P P P P 。

解答见第三章课件!4.3 某一无记忆信源的符号集为{0,1},已知0p =14,1p =34(1)求符号的平均信息熵。

(2)由100个符号构成的序列,求某一特定序列{例如有m 个“0”和(m -10)个“1”}的自信息量的表达式。

(3)计算(2)中的序列的熵。

解:(1)()()0113014408113,;;log ..i i ix p p bitH x p p symb ∈==∴=-=∑(2)这是一个求由一百个二进制符号构成的序列中的某一特定(如有m 个“0”和100-m 个“1” )序列的自信息,问题是要求某一特定序列而不是某一类序列(如含有m 个“0”的序列)(){}[]()()()()1001001001001344m 0100-m 110013100441341515844;!!!log log ..m mm m m m mmm m m m m m m mP x where x A x P A C P x m m bit I x P x m x ---⎛⎫⎛⎫= ⎪ ⎪⎝⎭⎝⎭=∈⎛⎫⎛⎫∴==⎪ ⎪-⎝⎭⎝⎭⎡⎤⎛⎫⎛⎫∴=-=-=+⎢⎥ ⎪ ⎪⎝⎭⎝⎭⎢⎥⎣⎦其中含有个“”和个“”(3)这里有两种解法,因为是无记忆信源序列,所以单符号熵转序列熵很容易!()()()121001008113.m bit H X H x x x H x x∴==⨯=另一种解法是利用二项式定理来解。

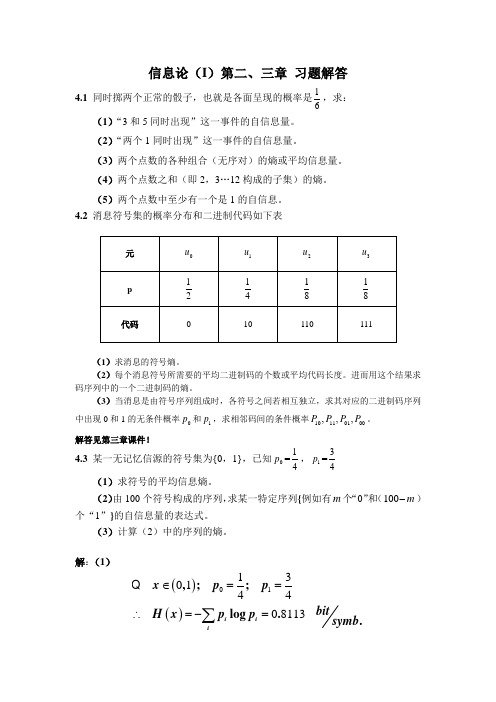

信息论第五章答案

5.1 设信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X (1) 求信源熵H(X); (2) 编二进制香农码;(3) 计算平均码长和编码效率。

解: (1)symbolbit x p x p X H i i i /609.2)01.0log 01.01.0log 1.015.0log 15.017.0log 17.018.0log 18.019.0log 19.02.0log 2.0()(log )()(2222222712=⨯+⨯+⨯+⨯+⨯+⨯+⨯-=-=∑=%1.8314.3609.2)()(14.301.071.0415.0317.0318.0319.032.03)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η5.2 对信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X 编二进制费诺码,计算编码效率。

%2.9574.2609.2)()(74.201.041.0415.0317.0218.0319.032.02)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η5.3 对信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡01.01.015.017.018.019.02.0)(7654321x x x x x x x X P X 编二进制和三进制哈夫曼码,计算各自的平均码长和编码效率。

解:%9.9572.2609.2)()(72.201.041.0415.0317.0318.0319.022.02)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η%4.913log 8.1609.2log )()(8.1)01.01.015.017.018.019.0(22.01)(22=⨯====+++++⨯+⨯==∑m LK X H R X H x p k K ii i η5.4 设信源⎪⎭⎪⎬⎫⎪⎩⎪⎨⎧=⎥⎦⎤⎢⎣⎡12811281641321161814121)(87654321x x x x x x x x X P X (1) 求信源熵H(X);(2) 编二进制香农码和二进制费诺码;(3) 计算二进制香农码和二进制费诺码的平均码长和编码效率; (4) 编三进制费诺码;(5) 计算三进制费诺码的平均码长和编码效率;解: (1)symbolbit x p x p X H i i i /984.1128log 1281128log 128164log 64132log 32116log 1618log 814log 412log 21)(log )()(22222222812=⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯=-=∑==127/64 bit/symbol (2)二进制费诺码:香农编码效率:%100984.1984.1)()(64/127984.17128171281664153214161381241121)(======⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η费诺编码效率:%100984.1984.1)()(984.17128171281664153214161381241121)(=====⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑KX H R X H x p k K ii i η(5)%3.943log 328.1984.1log )()(328.14128141281364133212161281141121)(22=⨯=⋅===⨯+⨯+⨯+⨯+⨯+⨯+⨯+⨯==∑m K X H R X H x p k K ii i η5.5 设无记忆二进制信源⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡1.09.010)(X P X先把信源序列编成数字0,1,2,……,8,再替换成二进制变长码字,如下表所示。

信息论第一章(叶中行)

定理1.3.1

D(p||q) 0,且等号成立的充要条件是,

( p x)=q(x)对所有的x 成立。

系1.3.2 (熵最大定理)H(X ) log ,其中等号成立的 充要条件是X 服从均匀分布( p x)= 母集中所包含元素的个数。 1

,其中 表示字

系1.3.2 (熵最大定理)H(X ) log ,其中等号成立的 充要条件是X 服从均匀分布( p x)= 母集中所包含元素的个数。 1

x

=- ( p x) p( y | x) log p( y | x)

x y

=- p ( x, y ) log p ( y | x)

x y

=-Elogp (Y | X )

定理 1.2.2(链法则) H (X,Y) = H (X)+ H (Y | X)

定理 1.2.2(链法则) H (X,Y) = H (X)+ H (Y | X)

注1: 由于X 和Y的对称性,可知 H (X,Y) = H (Y)+ H (X | Y)=H (Y , X)

注2: 类似于H (Y | X),我们可以定义 H (Y , Z | X)如下: H (Y , Z | X)=- p( x, y, z ) log p( y, z | x)

x y z

第1章 随机变量的信息度量

§1.1 自信息 §1.2 熵、联合熵、条件熵 §1.3 相对熵和互信息 §1.4 信息量的一些基本性质 §1.5 广义熵 习题课

§1.1 自信息

• 信息:通信领域指通信的消息;信号处理 方面指包括了数字、数据、图像、语音等 进行运算和处理所需的条件、内容和结果 • 信源:消息的来源。 • 信源的分类:离散信源和连续信源 • 信源的表示方法:用随机变量X表示一个 离散信源,X的可能取值,即信源可能输 出的不同符号用集合χ表示

信息论答案完整版

/8

⎥ ⎦

,其发出的消息为(202

120

130

213

001

203 210 110 321 010 021 032 011 223 210),求:

(1) 此消息的自信息是多少?

(2) 在此消息中平均每个符号携带的信息量是多少?

解:(1)因为离散信源是无记忆的,所以它发出的消息序列中各个符号是无依赖的,统计独立的。因

在研究香农信源编码定理的同时,另外一部分科学家从事寻找最佳编码(纠错码)的研究工作,并 形成一门独立的分支——纠错码理论。

1959 年香农发表了“保真度准则下的离散信源编码定理”,首先提出了率失真函数及率失真信源 编码定理。从此,发展成为信息率失真编码理论。

香农 1961 年的论文“双路通信信道”开拓了网络信息论的研究。 现在,信息理论不仅在通信、计算机以及自动控制等电子学领域中得到直接的应用,而且还广泛地 渗透到生物学、医学、生理学、语言学、社会学、和经济学等领域。

I (a4

=

3)

=

− log

P(a4 )

=

− log

1 8

=

log2

8=3(比特)

此消息中共有 14 个符号“0”,13 个符号“1”,12 个符号“2”和 6 个符号“3”,则此消息的自

信息是

I = 14I (a1 = 0) +13I (a2 = 1) +12I (a3 = 2) + 6I (a4 = 3) ≈ 14×1.415 +13× 2 +12× 2 + 6× 3 ≈ 87.71(比特)

此,此消息的自信息就等于各个符号的自信息之和。则可得:

I

(a1

=

信息论基础

教师:吴旭 手机:18236888638 Email:wuxu@

1

信息论与编码原理

教பைடு நூலகம்: 曹雪虹,张宗橙.信息论与编码(第二版). 9 2009 北京:清华大学出版社,200

2

参考书:

1.叶中行.信息论基础.北京:高等教育出版社, 2.孙丽华,陈荣伶 .信息论与编码.江西:科学技 术出版社,2002 3.田丽华.编码理论.西安:西安电子科技大学 出版社,2003 4.张鸣瑞,邹世开.编码理论.北京:北京航天航空 出版社,1990 5. 姜丹.信息论与编码.北京:中国科学技术大学 出版社, 2004 6. 曹雪虹,张宗橙.信息论与编码.北京:北京邮 电大学出版社, 2001 7. 傅祖芸.信息理论与编码学习辅导及精选题 解.北京:电子工业出版社,2004

1.2 通信系统的模型

�

�

通信系统的模型是什么?各部件的功能 作用是什么? 通信系统的性能指标有哪些?

28

信息论基础的重要性

�

�

�

信息论是信息科学和技术的基本理论,信息科 学大厦的地基; 没有信息论的基础,从事通信与信息领域的研 究和创新是不可能的事情; 总之,信息论是高层次信息技术人才必不可少 的基础知识。

� 信息的基本概念在于它的不确定性,任 何已经确定的事物都不含有信息。 例.如果你问你的同学“明天是星期几”,则 答案中含有多少信息量? 情况一.你不知道今天是星期几 情况二.你知道今天是星期一 � 通信过程是一种消除不确定性的过程, 不确定性的消除,就获得了信息。 例.同学对你说”你编码原理考试通过了”, 你得到了消息,获得了信息吗?

�

信息:是指各个事物运动的状态及状态变化的方式。 人们从来自对周围世界的观察得到的数据中获得信 息。信息是抽象的意识或知识,它是看不见、摸不 到的。人脑的思维活动产生的一种想法,当它仍储 存在脑子中的时候就是一种信息。信息是信号与消 息的更高表达层次。三个层次中,信号最具体,信 息最抽象。它们三者之间的关系是哲学上的内涵与 外延的关系。