第二章-信息论基本概念(1)

信息论名词解释

信息论部分基本概念和名词术语消息(或称为符号):信息的数学表达层,它虽不是一个物理量,但是可以定量地加以描述,它是具体物理信号的进一步数学抽象,可将具体物理信号抽象为两大类型:自信息量:一个随机事件发生某一结果后所带来的信息量成为自信息量,定义为其发生概率对数的负值。

平均互信息:表达平均互信息量的熵I(X;Y), 是确定通过信道的信息量的多少,因此称它为信道传输率或传信率。

I(X;Y)就是接收到符号Y后平均每个符号获得的关于后平均每个符号获得的关于X的信息量——平均意义上每传送一个符号流经信道的平均信息量。

离散平稳无记忆信源:假定随机变量欲裂的长度是有限的,如果信源输出地信息序列中,符号之间的无相互依赖关系,则称这类信源为离散平稳无记忆信源。

信源冗余度:信源熵的相对率为信源实际的信息熵与同样符号数的最大熵的比值:η=H无穷/H0,定义信源的冗余度为1减去信源熵的相对率η,即ξ=1-η。

信道容量:信道在单位时间上能够传输的最大信息量。

平稳信源:概率分布函数与时间起点无关,平稳信源是有记忆的,记忆的长度有限。

香农信息:信息是事物运动状态或存在方式的不确定性的描述。

无记忆信道:在某一时刻信道的输出消息仅与当时的信道输入消息有关,而与前面时刻的信道输入或输出消息无关。

有记忆信道:在任意时刻信道的输出消息不仅与当时信道的输入消息有关,而且还与以前时刻的信道输入消息和(或)输出消息有关。

信道疑义度(含糊度) H(X|Y):表示在输出端接收到Y后,发送端X尚存的平均不确定性。

这个对X尚存的不确定性是由于干扰引起的。

信道散布度H(Y|X):表示在已知X后,对于输出Y尚存的平均不确定性;平均失真度:定义平均失真度为失真函数的数学期望,及d(xi,yi)在X和Y 得联合概率空间P(XY)中的统计平均值:D=E[D(xi,yi)] ,起是在平均的意义上,从总体上对整个系统失真情况的描述。

失真函数d(xi,yj):是人为规定的,给出规定时应该考虑解决问题的需要以及失真可能引起的损失、风险和主观上感觉的差别等因素。

信息论基本概念_OK

X:a1 a2

aq

p(akm1 / a a k1 k2 akm )

同时满足:

k1,k2, ,km,km1 1,2, ,q

q

p(akm1 / ak1 ak2

km1 1

akm ) 1

k1,k2, ,km 1,2, ,q

【注】当m=1时,为一阶马尔可夫信源。

4

•对于具有M个不同的状态空间,M2个转移概率可排成一转移矩阵:

P(1 | 1) P(1| 2) P

P(2 |1) P(M |1) P(2 | 2) P(M | 2)

• 每行元素代表同一P起(1| 始M )状P态(2 |到MM) 个 不P(同M 终| M止) 状态的转移概率; • 每列元素代表M个不同起始状态到同一终止状态的转移概率;

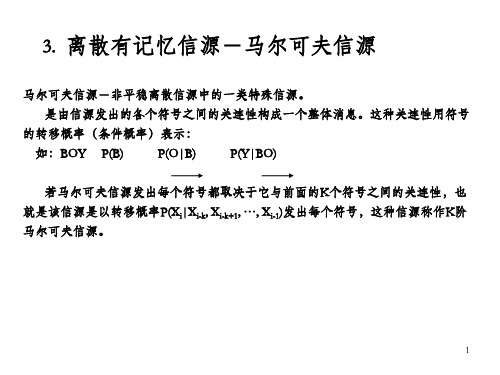

马尔可夫信源-非平稳离散信源中的一类特殊信源。

是由信源发出的各个符号之间的关连性构成一个整体消息。这种关连性用符号

的转移概率(条件概率)表示:

如:BOY P(B)

P(O|B)

P(Y|BO)

若马尔可夫信源发出每个符号都取决于它与前面的K个符号之间的关连性,也 就是该信源是以转移概率P(Xi|Xi-k, Xi-k+1, …, Xi-1)发出每个符号,这种信源称作K阶 马尔可夫信源。

p(Ei ) p(E j / Ei ) logp(E j / Ei )

i1 j 1

qm q

p(Ei ) p(ak / Ei ) logp(ak / Ei )

i1 k 1

其中p(Ei )(i 1, 2, , qm )是m阶马尔可夫信源稳定后的状态极限概率,

p(E j / Ei )是状态之间的一步转移概率。 18

第二章 信息论基本概念

一个信源总是包含着多个符号消息,各个符号消息又按概率 空间的先验概率分布,它的不确定度是各个符号的不确定度的数 学期望(即概率加权的统计平均值) 它的熵(平均不确定度)H(X)定义为: H(X)= E[I(x)]= P(X)I(X) =- P(X)log2P(X) X

X

若信源X中的符号的概率空间简化表示为: X1,X2, „,XN X,PX= P1, P2,„, PN 则熵(平均不确定度)H(X)可写成: N H(X)=- PilogPi 注意:∵ I(X)为非负, P(X)为非负,且0≤P(X)≤1 ∴ H(X)也为非负

0.8 0.2

其中X1表示摸出的球为红球事件,X2表示摸出的球为白球事件

若告知摸出的是红球,则事件的自信息量为 I(X1)=-logP(X1)=-log20.8 bit 若告知摸出的是白球,则事件的自信息量为 I(X2)=-logP(X2)=-log20.2 bit 若取回后又放回摸取,如此摸取n此,红球出现的次数nP(X1), 白球出现的次数为nP(X2),则总信息量为 I=nP(X1)I(X1)+nP(X2)I(X2) 而平均随机摸取一次所获得的信息量为 H(X)= 1/n [nP(X1)I(X1)+nP(X2)I(X2)] =-[P(X1)logP(X1)+P(X2)logP(X2)] 2 =- P(Xi)logP(Xi)

符号xi对联合事件符号yj zk之间的互信息量定义为: I(xi ; yj zk)= logP(xi|yj zk)/ P(xi) „„„„*

三. 条件互信息量 含义:在给定zk条件下,xi与yj之间的互信息量

条件互信息量I(xi ; yj|zk)定义为: I(xi ; yj|zk)= logP(xi|yj zk)/ P(xi|zk) 从上式,可使*式写成: I(xi ; yj zk)= I(xi ; zk) + I(xi ; yj|zk) 推导如下: I(xi ; yj zk)= log P(xi|yj zk)/ P(xi)

信息论编码 第二章信息度量1

50个红球,50个黑球

Y

20个红球,其它4种 颜色各20个

Z

问题:能否度量、如何度量??

2.3.2信源熵数学描述

信源熵

• 定义:信源各个离散消息的自信息量的数学期望 (即概率加权的统计平均值)为信源的平均信息 量,一般称为信源的信息熵,也叫信源熵或香农 熵,有时也称为无条件熵或熵函数,简称熵。 • 公式: n 1 H ( X ) = E[ I ( xi )] = E[log2 ] = −∑ p( xi ) log2 p( xi ) p( xi ) i =1 • 熵函数的自变量是X,表示信源整体,实质上是无 记忆信源平均不确定度的度量。也是试验后平均 不确定性=携载的信息 信息量为熵 • 单位:以2为底,比特/符号 • 为什么要用熵这个词,与热熵的区别?

3

( 2)

∑ p ( x ) = 1, ∑ p ( y

i =1 m i j =1

n

m

j

) = 1,∑ p ( xi / y j ) = 1,

i =1 n

n

概 率 复 习

∑ p( y

j =1 n

j

/ xi ) = 1, ∑ ∑ p ( xi y j ) = 1

j =1 i =1 m

m

( 3) ( 4) (5)

1

对天气x1 ,Q p( x1 / y1 ) = 0,∴不必再考虑x1与y1之间 信息量

对天气 x 2 : I ( x 2 : y 1 ) = log

2

p ( x 2 / y1 ) = log p ( x2 )

2

1/ 2 = 1( bit ) 1/ 4

同理 I ( x 3 : y 1 ) = I ( x 4 : y 1 ) = 1( bit ), 这表明从 y 1 分别得到了

第二章-信息论基本概念(2)(1)

前面所述熵为单符号信源情况, 前面所述熵为单符号信源情况,是最简单的离散 信源。事务是普遍联系的,两个随机变量 , 之间 信源。事务是普遍联系的,两个随机变量X,Y之间 也是相互联系的,比如: 在某种程度上 也是相互联系的,比如:

1、 离散无记忆信源 扩展信源 、 离散无记忆信源(扩展信源 扩展信源) 概率空间: (1)定义:若单符号离散信源 概率空间: )定义:若单符号离散信源X概率空间

X a1 , a2 , L , ai , L , aq P( X ) = p(a ), p(a ),L , p(a ),L , p(a ) , ∑ p(ai ) = 1 i 2 i q 1

0( p )

q

X

[例] 二进制对称信道 例

1( p )

q q

q

0

Y

1

H ( X ) = H ( p) = − p log p − p log p

I(X;Y)

H (Y / X ) = H (q) = −q log q − q log q

H (Y ) = H ( pq + pq)

0

1-H(q) 0.5 I(X;Y) H(p) 1 p

5. 数据处理定理 I(X;Z) ≤ I(X;Y) I(X;Z) ≤ I(Y;Z) [意义 信息不增原理 意义] 信息不增原理 原理—— 意义 处理, 每经一次 处理,可能丢失一部分信息 X Y P(Z/;Y) = H(X) – H(X/Y) = H(Y) – H(Y/X) H(XY) = H(X) + H(Y/X) = H(Y) + H(X/Y) I(X;Y) = H(X) + H(Y)- H(XY) -

通信原理知识要点

通信原理知识要点第一章概论1 、通信的目的2 、通信系统的基本构成●模拟信号、模拟通信系统、数字信号、数字通信系统●两类通信系统的特点、区别、基本构成、每个环节的作用3 、通信方式的分类4 、频率和波长的换算5 、通信系统性能的度量6 、传码速率、频带利用率、误码率的计算第二章信息论基础1 、信息的定义2 、离散信源信息量的计算(平均信息量、总信息量)3 、传信率的计算4 、离散信道的信道容量5 、连续信道的信道容量:掌握香农信道容量公式第三章信道与噪声了解信道的一般特性第四章模拟调制技术1 、基带信号、频带信号、调制、解调2 、模拟调制的分类、线性调制的分类3 、 AM 信号的解调方法、每个环节的作用第五章信源编码技术1 、低通、带通信号的采样定理(例 5 - 1 、例 5 -2 )2 、脉冲振幅调制3 、量化:●均匀量化:量化电平数、量化间隔、量化误差、量化信噪比●非均匀量化: 15 折线 u 律、 13 折线 A 律4 、 13 折线 A 律 PCM 编码(过载电压问题- 2048 份)5 、 PCM 一次群帧结构( P106 )6 、 PCM 系统性能分析7 、增量调制 DM 、增量脉码调制 DPCM :概念、特点、与 PCM 的比较第六章数字基带信号传输1 、熟悉数字基带信号的常用波形2 、掌握数字基带信号的常用码型3 、无码间干扰的时域条件、频域条件(奈奎斯特第一准则)4 、怎样求“等效”的理想低通()5 、眼图分析(示波器的扫描周期)6 、均衡滤波器第七章数字调制技术1 、 2ASK 、 2FSK 、 2PSK 、 2DPSK 的典型波形图2 、上述调制技术的性能比较3 、 MASK 、 MFSK 、 MPSK 、 MDPSK 、 QPSK 、 QDPSK 、 MSK ( h=0.5 )、APK 的含义、特点4 、数字调制技术的改进措施第七章复用与多址技术1 、复用与多址技术的基本概念、分类、特点、目的(区别)2 、同步技术的分类、应用第九章差错控制技术1 、常用的差错控制方式( ARQ 、 FEC 、 HEC )、优缺点2 、基本概念3 、最小码距与检错纠错能力的关系4 、常用的简单差错控制编码(概念、特点、编写)5 、线性分组码:基本概念、特点6 、汉明码的特点6 、循环码●概念●码字的多项式描述、模运算、循环多项式的模运算●循环码的生成多项式●根据生成多项式求循环码的:码字、(典型)生成矩阵、监督多项式、(典型)监督矩阵较大题目的范围1 、信息量的度量2 、信道容量的计算3 、 13 折线 A 律 PCM 编码4 、均衡效果的计算5 、数字调制波形的绘制6 、 HDB3 编码、解码7 、循环码重点Part I 基础知识1. 通信系统的组成框图 , 数字 / 模拟通信系统的组成框图。

第二章基本信息论1_信源不确定性-精品文档

X 0 1 2 3 4 5 6 7 8 9 例 3 : p ( X ) 0 . 1 0 . 1 0 . 1 0 . 1 0 . 1 0 . 1 0 . 1 0 . 1 0 . 1 0 . 1

信息速率和信道容量的概念,离散有噪

信道的熵速率,可疑度的物理解释,连 续有噪信道的信道容量

三种多用户信道模型及其信道容量 信源编码原理,等长编码和变长编码

常用的信源编码:山农费诺编码、哈夫

曼编码和L-D编码

本章作业

P113: 1-9,11,15,17,20,21

2.1 信源及信源的不确定性

发生概率小的事件不确定性大, 发生概率大的事件不确定性小 4)两个独立事件的联合信息量应等于它们分别 信息量之和

三、信息度量

信源消息 x i 的自信息量:

Ix () l o g p () x i i

表示信源发出一个消息 x i 所含有(或所提供)的 非平均自信息量

ห้องสมุดไป่ตู้

也表示通信发生前,信源发送消息 x i 的不确定度。

n

p (x gp (x i )lo i)

即信源的非平均不确定度

条件自信息量

I (/ x ) l o g p (/ x ) i y j i y j

y 已 知 的 条 件 下 , 发 生 x 所 带 来 的 信 息 量 j i

信宿接收到消息 y j 后,对信源发送消息 x i 尚存的不 确定度。

从信宿端看,信息量的定义:

I(信息量)=不肯定程度的减少量

log p( xi / y j ) p( xi )

信息论基础课件2[1][1].1.1- 2

![信息论基础课件2[1][1].1.1- 2](https://img.taocdn.com/s3/m/5d523fd3360cba1aa811da2f.png)

a2

…

ar p(ar)

p(a2) …

0 p(a i ) 1i 1,2, r

p(a i ) 1

信息论与编码-信源熵

需要注意的是,大写字母X,Y,Z代表随机变量,指 的是信源整体,带下标的小写字母代表随机事件的 某一结果或信源的某个元素。两者不可混淆。

信息论与编码-信源熵

(4) 如p(xi)=1,则I(xi) =0 ;(必然事件不含有任何不确定 性,所以不含有任何信息量)

(5) 自信息量也是一个随机变量,它没有确定的值。

信息论与编码-信源熵

例2、 设有12枚同值硬币,其中有一枚为假币,且只知道假币

的重量与真币的重量不同,但不知究竟是轻是重。现采 用天平比较两边轻重的方法来测量(因无法码)。问至 少需要称多少次才能称出假币? 解:用天平每称一次能获得一定的信息量,能消除部分的不 确定性。测量若干次后,能消除全部不确定性,获得全部信 息,也就能确定出假币。 设“在12枚同值硬币中,某一枚为假币”该事件为a, p(a ) 1 / 12 则 p 又设“假币是重、或是轻”该事件为b,则(b) 1 / 2

(5)当X与Y相互独立时,

p( y j / xi ) p( y j ), p( xi / y j ) p( xi ), p( xi y j ) p( xi ) p( y j )

( 6) p( x i / y j ) p( x i y j )

p( x i y j )

i 1

n

p( y j / xi )

i 1 n j 1 i 1 j 1 i 1

n

m

n

m

n

p( xi y j ) p( y j ), p( xi y j ) p( xi )

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

{

离散信源 连续信源

2

1. 连续信源 连续信源是指发出在时间和幅度上都是连续分布的 连续消息(模拟消息)的信源,如语言、图像、图 形等都是连续消息。

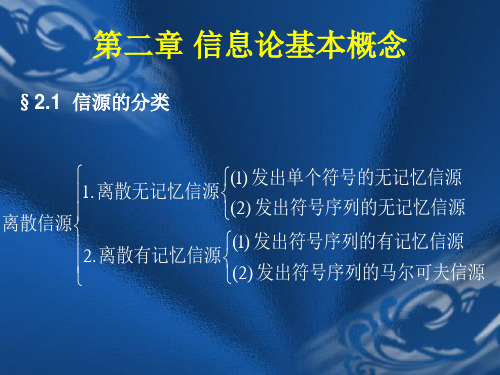

2. 离散信源 离散信源是指发出在时间和幅度上都是离散分布的 离散消息的信源,如文字、数字、数据等符号都是 离散消息。 发出单个符号的无记忆信源 离散无记忆信源 发出符号序列的无记忆信源 离散信源 发出符号序列的有记忆信源 离散有记忆信源 发出符号序列的马尔可夫信源

这三个信息量单位之间的转换关系如下:

1 nat=log2e

l.433 bit, l Hartley =log 10 3.322 bit

2

12

3. 不确定度

定义:随机事件的不确定度在数量上等于它的自信息量.

说明:

a. 两者的单位相同,但含义却不相同。 b. 具有某种概率分布的随机事件不管发生与否,都存 在不确定度,不确定度表征了该事件的特性,而自 信息量是在该事件发生后给予观察者的信息量。

18

解:信源符号的自信息量:

1 I ( x1 ) log2 1.415 3/8

1 I ( x2 ) I ( x3 ) log2 2 1/ 4

单位都是 bit/符号

1 I ( x4 ) log 3 1/8

信源无记忆,发出的符号串中各符号统计独立,由自信 息量的可加性,符号串自信息量等于各符号自信息量之和:

p( xi ) 0, p( xi ) 1

i 1

p( xi )为符号 x i的先验概率。

6

概率空间

X x1 P p( x ) 1

xn p( x2 ) p( xn ) x2

状态空间X中各状态 xi 相互独立。

举例(二进制信源):

第二章 信息论的基本概念

第一节 信源的描述和分类 第二节 离散信源的信息论概念 第三节 离散信源的熵

1

第一节 信源的描述和分类

一、香农信息论的基本点

用随机变量或随机矢量来表示信源,运用概率论和 随机过程的理论来研究信息。

二、信源的分类

按照信源发出的消息在时间上和幅度上的分布情况 可将信源分成离散信源和连续信源两大类 信源

20

(7)在布袋中放入81枚硬币,它们的外形完全相同。

已知有一枚硬币与其它80枚硬币重量不同,但不知

这个硬币比其它硬币的重量是重还是轻。问确定随

意取出的一枚硬币恰好是重量不同硬币的所获得的 信息量是多少?并进一步确定它比其它硬币是重还

是轻所需要的信息量是多少?

解: (a) P(A)=1/81,I(A)=-lbP(A)=6.34(bit)。 (b) P(B)=1/2,P=P(A)×P(B)=1/162;

符号),意味着其不确定性可用2位二进制数字来度 量(00、01、10、11)。 若取4为对数底,自信息量为1(四进制单位/符号), 意味着其不确定性可用1位四进制数字来度量(0、1、

2、3)。

16

(4)英文字母中“e‖ 出现的概率为0.105,“c‖出现的概

率为0.023,“o‖出现的概率为 0.001。分别计算它们的

11

d. 自信息量单位的确定

• • • • 在信息论中常用的对数底是 2 ,信息量的单位为比特 (bit),用log2或lb表示;( bit /符号) 若取自然对数,则信息量的单位为奈特( nat ),用 loge或ln表示;(nat/符号) 若以 10为对数底,则信息量的单位为哈脱莱 (Hartley), 用log10或lg表示;(hartley/符号) 若对数底为r,则信息量的单位为r进制用单位/符号。

15

(3)具有四个取值符号的随机变量 X [ x1 , x2 , x3 , x4 ] 各符号概率相等,均为1/4,各符号的自信息量:

1 I ( x1 ) I ( x2 ) I ( x3 ) I ( x4 ) lb 2(bit / 符号) 4

注:

bit的含义是二进制数字(0、1),自信息量为2(bit/

8

(一)

本节的重点内容: 1. 信息量?

自信息量

2. 自信息量? 3. 不确定度? 4. 联合自信息量? 5. 条件自信息量?

9

(一)

1. 信息量

自信息量

I(信息量)=不确定程度的减少量 即 收信者收到一个消息后,所获得的信息量等于收到 信息前后不确定程度减少的量。(举例)

2. 自信息量

定义:一个随机事件的自信息量定义为其出现概率 对数的负值:

i 1 j 1 N M

二元联合符号的自信息量称为联合自信息量:

I ( xi , y j ) lbp( xi , y j )

同理,三元联合符号的联合自信息量:

bit/二元符号

I ( xi , y j , zk ) lbp( xi , y j , zk )

bit/三元符号

22

注意:

a. 当(xi,yj)相互独立时,有P(xi,yj)=P(xi)P(yj),那

解:将棋子方格从第一行开始按顺序编号,得到一个序号集合

{zl | l 1, 2,

,64}

棋子落入的方格位置可以用取值于序号集合的随机变量Z来描述

Z {zl | l 1, 2, ,64}

26

(1)由于棋子落入任一方格都是等可能的,则

1 p( zl ) l 1,2, 64

,64

棋子落入某方格的不确定性就是自信息量

定义两种条件自信息量:

p( y j | xi )

bit/符号 bit/符号

I ( xi | y j ) lbp( xi | y j ) I ( y j | xi ) lbp( y j | xi )

注意:

在给定yj条件下,随机事件xi所包含的不确定度在数值上 与条件自信息量相同,但两者含义不同。

I 14I ( x1 ) 13I ( x2 ) 12I ( x3 ) 6I ( x4 ) 87.81(bit / 符号)

平均一个符号的自信息量:

I / 45 87.81/ 45 1.95(bit / 符号)

19

(6)同时抛掷一对质地均匀的骰子,每个骰子各面

朝上的概率均为1/6,试求:

(a)事件“3和5同时发生”的自信息量? (b)事件“两个1同时发生”的自信息量? (c)事件“两个点数中至少有一个是1‖的自信息量?

解: (a) 存在两种情况:甲3乙5,甲5乙3。 P(A)=1/36×2=1/18,I(A)=-lbP(A)=4.17(bit)。

(b) 存在一种情况:甲1乙1。

P(B)=1/36,I(B)=-lbP(B)=5.17(bit)。 (c) P(C)=1-5/6×5/6=11/36,I(C)=-lbP(C)=1.17(bit)。

24

条件自信息量物理意义: 条件自信息量的物理意义,要根据具体情况来做出相应的解释 如果X是观察输入,Y是观察输出:

p( xi | y j )

后验概率

I ( xi | y j ) lbp( xi | y j ) p( y j | xi ) 转移概率

在观察到符号yj的条件下xi还剩下的不确定性

I ( xi ) log p( xi )

10

说明:

a. 自信息量 I ( xi ) 是非负的。

b. 对于离散无记忆信源,符号串中各符号统计独 立,符号串自信息量具有可加性:

I logp( xi )

i

c. 因为概率 p( xi ) 越小,x i的出现就越稀罕,一旦出

现,所获得的信息量也就较大。由于 xi是随机出 现的,它是X的一个样值,所以是一个随机量。 而 I ( xi ) 是 xi 的函数,它必须也是一个随机量。

的自信息量为:

I(0)= I(1)= - log2 (1/2)=log22=1 bit/符号

( 2 )若是一个 m 位的二进制数,因为该数的每一位可 从0, 1两个数字中任取一个,因此有2m个等概率的可 能组合。所以I= -log2(1/2m)=m bit/符号,就是需要m 比特的信息来指明这样的二进制数。

么就有 I(xi,yj)=I(xi)+I(yj)。 b. (xi,yj) 所包含的不确定度在数值上也等于它们的 自信息量。

23

5. 条件自信息量

定义: 联合随机变量 XY {( xi , y j ) | i 1,2...N; j 1,2,...M } 有两种条件概率

p( xi | y j )

{

{ {

3

•

离散无记忆信源 离散无记忆信源所发出的各个符号是相互独立的,发出 的符号序列中的各个符号之间没有统计关联性,各个符 号的出现概率是它自身的先验概率。 离散有记忆信源 离散有记忆信源所发出的各个符号的概率是有关联的。 发出单个符号的信源 发出单个符号的信源是指信源每次只发出一个符号代 表一个消息; 发出符号序列的信源 发出符号序列的信源是指信源每次发出一组含二个以 上符号的符号序列代表一个消息。

5

三、先验概率及概率空间的形式 一般信源可用一个概率空间来描述,信源的不确 定程度可用该概率空间的可能状态数目及其概率 来描述。

先验概率

一个离散信源发出的各个符号消息的集合为: 它们的概率分别为:

n

X {x1, x2 ,, xn } ——状态空间

P { p( x1 ), p( x2 ),, p( xn )}

自信息量。

解:“e‖的自信息量 I(e)= - lb0.105=3.25 (bit/符号) “c‖的自信息量 I(c)= -lb0.023=5.44 (bit/符号)

“o‖的自信息量 I(o)= -lb 0.001=9.97 (bit/符号)

17

(5)某离散无记忆信源(DMS,Discrete Memoryless Source)的概