loadrunner监控Hbase Hadoop

简述hadoop的主要功能模块

简述hadoop的主要功能模块Hadoop是一个开源的分布式计算平台,主要用于处理大规模数据集的存储和处理。

它由Apache基金会开发和维护,并且是一个高度可靠和可扩展的平台。

Hadoop提供了许多功能模块,包括HDFS、MapReduce、YARN等。

下面将对这些功能模块进行详细说明。

一、HDFSHDFS(Hadoop Distributed File System)是Hadoop的分布式文件系统,它被设计用于存储大规模数据集。

它采用了Master/Slave架构,其中NameNode作为Master节点管理整个文件系统的命名空间和访问控制,并且负责将文件划分为块并将其存储在DataNode上。

DataNode作为Slave节点存储实际数据块,并且定期向NameNode报告其健康状态。

二、MapReduceMapReduce是一种基于分布式计算的编程模型,可以有效地处理大规模数据集。

它主要由两个阶段组成:Map阶段和Reduce阶段。

在Map阶段中,输入数据被划分为若干个小块,并且每个小块都会被传递到不同的节点进行处理。

在每个节点上,数据会被映射为键值对,并且通过用户定义的Map函数进行转换。

在Reduce阶段中,所有相同键的值被汇总在一起,并且通过用户定义的Reduce函数进行聚合。

MapReduce可以用于各种各样的任务,如数据清洗、数据挖掘等。

三、YARNYARN(Yet Another Resource Negotiator)是Hadoop的资源管理器,它负责管理集群中的资源,并为应用程序分配资源。

YARN采用了Master/Slave架构,其中ResourceManager作为Master节点管理整个集群中的资源,并且负责接受来自客户端的应用程序请求。

NodeManager作为Slave节点运行在每个节点上,并且负责监控该节点上运行的应用程序以及向ResourceManager报告其健康状态。

hadoop的故障检测机制、任务调度机制

hadoop的故障检测机制、任务调度机制Hadoop的故障检测机制:1. 心跳检测:Hadoop集群中的每个节点都会定期向NameNode发送心跳信号。

如果NameNode在一定周期内没有收到该节点的心跳信号,就会认为该节点已经宕机或者出现了故障,并将其标记为不可用。

2. 数据完整性检测:在Hadoop集群中,每个数据块都会有多个副本,如果某个数据块的任何一个副本出现了故障,NameNode会立即将其标记为不可用,并从其他可用的副本中选择一个新的副本进行读取。

3. 数据节点检测:Hadoop会定期检测数据节点的存储状态,如果某个节点的存储已经满了或者磁盘出现了故障,NameNode会将该节点标记为不可用,并将存储在该节点上的数据块迁移到其他节点。

4. JobTracker监控:在Hadoop集群中,JobTracker会监控所有的任务,并对任务的执行情况进行监控。

如果一个任务长时间没有执行,或者执行失败,JobTracker会重新分配任务,并将日志记录下来,以便后期进行分析。

Hadoop的任务调度机制:1.FIFO调度:FIFO调度是最简单的调度策略,它按照任务的提交顺序,依次调度执行。

由于FIFO调度没有考虑任务的执行时间和优先级,因此可能会导致低优任务长时间等待高优任务执行完毕的情况。

2. Fair调度:Fair调度是基于任务优先级的调度策略,它会将任务按照优先级进行分配,并且为每个任务保证公平的执行时间。

Fair调度还可以设置不同用户之间的资源占用比例,以保证不同任务之间的公平性。

3. Capacity调度:Capacity调度是基于资源容量的调度策略,它可以为不同的用户分配不同的资源容量,以便满足不同用户之间的需求。

Capacity调度还可以设置不同用户之间的优先级,以保证高优任务能够优先执行。

4. Deadline调度:Deadline调度是一种基于任务完成时间的调度策略,它可以根据任务的截止时间来进行调度,以保证任务能够在规定的时间内完成。

hbase应用场景

hbase应用场景

HBase是一种基于Hadoop的分布式列存储系统,它可以存储海量的结构化和非结构化数据。

以下是HBase的几个常见的应用场景: 1. 日志存储:HBase可以用于存储各种类型的日志数据,如网络流量数据、服务器日志、应用程序日志等。

使用HBase可以方便地进行数据的检索和分析,以便更好地了解系统的运行状况和问题。

2. 大数据分析:HBase可以用于存储大规模的结构化和非结构化数据,这些数据可以来自于不同的数据源,如传感器、社交媒体、云存储等。

使用HBase可以快速地进行数据分析,从而提供更好的业务洞察力。

3. 实时计算:HBase可以作为实时计算平台的一个存储组件,支持实时查询和数据的即时更新,这对于需要实时计算和实时决策的业务非常有帮助。

4. 物联网:HBase可以用于存储来自物联网设备的数据,例如传感器和其他物联网设备。

使用HBase可以方便地存储和管理这些设备产生的大量数据,并进行实时分析和决策。

5. 应用程序存储:HBase可以用于存储应用程序的状态和数据,例如电子商务应用程序、社交媒体应用程序等。

使用HBase可以方便地管理这些数据,从而提供更好的用户体验。

总之,HBase可以应用于各种各样的业务场景,包括但不限于数据存储、数据分析、实时计算、物联网和应用程序存储等。

使用HBase 可以帮助企业更好地管理和分析数据,提高业务洞察力和决策能力。

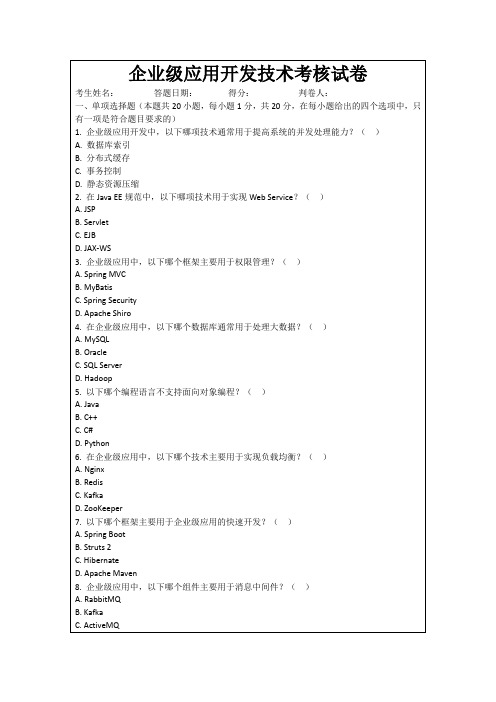

企业级应用开发技术考核试卷

B. SOAP

C. CORBA

D. JSON-RPC

15.以下哪个技术主要用于实现分布式系统的服务注册与发现?()

A. Eureka

B. Consul

C. ZooKeeper

D. Etcd

16.企业级应用中,以下哪个组件主要用于实时通信?()

A. WebSocket

B. HTTP

3. Hadoop适合批处理,Spark适合实时处理。Hadoop基于磁盘,Spark基于内存。Hadoop稳定,Spark性能高。

4.容器化技术简化部署,保证环境一致性,促进CI/CD流程自动化。通过容器编排(如Kubernetes)实现滚动更新、蓝绿部署,提高部署效率和稳定性。

3.分布式系统中,CAP定理包含的三个基本特性是______、______和______。()

4.在微服务架构中,服务之间进行通信的常用协议是______。()

5.数据库事务隔离的四个级别分别是______、______、______和______。()

6.下列哪种编程语言被称为“函数式编程语言”:______。()

1.请简述企业级应用开发中,如何实现一个高并发的用户登录系统,并说明需要考虑的技术要点。

2.描述微服务架构的优势和可能面临的挑战,以及如何解决这些挑战。

3.在大数据处理领域,请比较Hadoop和Spark的异同点,并说明它们各自适合解决哪类问题。

4.请阐述容器化技术在企业级应用部署中的作用,以及它如何影响持续集成和持续部署(CI/CD)流程。

7. √

8. √

9. ×

10. √

五、主观题(参考)

1.实现高并发用户登录系统,需要采用分布式缓存、数据库分库分表、使用高效的加密算法和限流措施。技术要点包括缓存一致性、数据库事务、安全性、系统容量规划和性能监控。

Hadoop集群监控工具推荐与使用指南

Hadoop集群监控工具推荐与使用指南引言:Hadoop作为大数据处理的重要工具,被广泛应用于各个领域。

然而,随着Hadoop集群规模的不断扩大,集群监控变得越来越重要。

本文将介绍几种常用的Hadoop集群监控工具,并提供使用指南,帮助用户更好地管理和监控Hadoop集群。

一、Hadoop集群监控的重要性在大规模Hadoop集群中,监控是确保集群正常运行的关键。

通过监控,我们可以及时发现并解决潜在的问题,提高集群的性能和稳定性。

同时,监控还可以帮助我们了解集群的负载情况,从而进行合理的资源分配和调整。

因此,选择一款适合的Hadoop集群监控工具至关重要。

二、Hadoop集群监控工具推荐1. AmbariAmbari是一款由Apache开源的Hadoop集群管理和监控工具。

它提供了直观的Web界面,可以方便地监控集群的各个组件状态、资源使用情况等。

Ambari还支持自定义报警和通知机制,可以及时发现并解决问题。

此外,Ambari还提供了集群配置管理、服务管理等功能,使集群管理更加便捷。

2. GangliaGanglia是一款用于分布式系统性能监控的工具,也被广泛应用于Hadoop集群监控。

它采用了分布式的架构,可以实时收集和展示集群的各项指标,如CPU使用率、内存使用率、网络流量等。

Ganglia还支持图表展示和历史数据查询,方便用户进行性能分析和调优。

3. NagiosNagios是一款开源的网络监控工具,可以用于监控Hadoop集群的各个组件和服务。

它提供了丰富的插件和报警机制,可以灵活配置监控策略。

Nagios还支持可视化展示和报表生成,方便用户进行集群状态的实时监控和历史数据分析。

三、Hadoop集群监控工具的使用指南1. 安装和配置根据所选监控工具的官方文档,下载并安装相应的软件包。

在安装完成后,根据集群规模和需求,进行相应的配置,如指定监控对象、设置报警阈值等。

2. 监控指标的选择根据集群的特点和需求,选择需要监控的指标。

运行Hadoop集群时的性能监控指南

运行Hadoop集群时的性能监控指南随着大数据时代的到来,Hadoop已经成为了处理海量数据的重要工具。

然而,要确保Hadoop集群的高效运行,需要对其性能进行监控和调优。

本文将介绍一些运行Hadoop集群时的性能监控指南,帮助您更好地管理和优化集群。

1. 硬件资源监控在运行Hadoop集群时,首先要确保硬件资源的充足和稳定。

通过监控CPU、内存、磁盘和网络的使用情况,可以及时发现资源瓶颈和故障。

可以使用一些开源工具如Ganglia、Zabbix等进行硬件资源的实时监控和报警。

2. Hadoop集群监控Hadoop集群本身也提供了一些监控工具,如Hadoop Metrics、Hadoop JobHistory等。

通过这些工具,可以实时监控集群的运行状态、任务的执行情况以及各个节点的负载情况。

这些监控数据可以帮助管理员及时发现和解决问题,保证集群的高可用性和高性能。

3. 日志监控Hadoop集群的各个组件都会产生大量的日志信息,这些日志信息对于故障排查和性能优化非常重要。

通过使用工具如ELK(Elasticsearch、Logstash和Kibana)等,可以实时收集、分析和可视化Hadoop集群的日志信息。

这样可以快速定位问题的根源,提高故障排查的效率。

4. 数据监控Hadoop集群的数据是其核心资产,因此对数据的监控也非常重要。

可以使用工具如Apache Ambari、Cloudera Manager等来监控数据的存储和处理情况。

通过监控数据的读写速度、数据分布情况等指标,可以及时发现数据倾斜和热点问题,并采取相应的措施进行优化。

5. 作业监控Hadoop集群通常会同时运行多个作业,因此对作业的监控也是必不可少的。

可以使用工具如Apache Oozie、Azkaban等来监控作业的执行情况和性能指标。

通过监控作业的运行时间、资源消耗等指标,可以及时发现作业的性能问题,并进行调优。

6. 集群调优除了监控集群的运行情况,还需要进行一些调优工作来提高集群的性能。

Hadoop 生态系统介绍

Hadoop 生态系统介绍Hadoop生态系统是一个开源的大数据处理平台,它由Apache基金会支持和维护,可以在大规模的数据集上实现分布式存储和处理。

Hadoop生态系统是由多个组件和工具构成的,包括Hadoop 核心,Hive、HBase、Pig、Spark等。

接下来,我们将对每个组件及其作用进行介绍。

一、Hadoop核心Hadoop核心是整个Hadoop生态系统的核心组件,它主要由两部分组成,一个是Hadoop分布式文件系统(HDFS),另一个是MapReduce编程模型。

HDFS是一个高可扩展性的分布式文件系统,可以将海量数据存储在数千台计算机上,实现数据的分散储存和高效访问。

MapReduce编程模型是基于Hadoop的针对大数据处理的一种模型,它能够对海量数据进行分布式处理,使大规模数据分析变得容易和快速。

二、HiveHive是一个开源的数据仓库系统,它使用Hadoop作为其计算和存储平台,提供了类似于SQL的查询语法,可以通过HiveQL 来查询和分析大规模的结构化数据。

Hive支持多种数据源,如文本、序列化文件等,同时也可以将结果导出到HDFS或本地文件系统。

三、HBaseHBase是一个开源的基于Hadoop的列式分布式数据库系统,它可以处理海量的非结构化数据,同时也具有高可用性和高性能的特性。

HBase的特点是可以支持快速的数据存储和检索,同时也支持分布式计算模型,提供了易于使用的API。

四、PigPig是一个基于Hadoop的大数据分析平台,提供了一种简单易用的数据分析语言(Pig Latin语言),通过Pig可以进行数据的清洗、管理和处理。

Pig将数据处理分为两个阶段:第一阶段使用Pig Latin语言将数据转换成中间数据,第二阶段使用集合行处理中间数据。

五、SparkSpark是一个快速、通用的大数据处理引擎,可以处理大规模的数据,支持SQL查询、流式数据处理、机器学习等多种数据处理方式。

《Hadoop平台搭建与应用》项目HBase环境搭建与基本操作

HBase集群监控工具使用

使用HBase Shell

HBase Shell是一个交互式shell程序,可以用于管理和操作HBase。

使用HBase Browser

HBase Browser是一个Web应用程序,可以查看HBase的状态、表结构等信息,也可以进行数据浏览、操作 等。

HBase集群常见问题与解决方案

THANKS

创建表时,需要指定表的名称和列族名称及属性 。

删除表时,使用`disable`命令禁用表,然后 使用`drop`命令删除表。

HBase表的数据读取与写入

HBase表中的数据包括行键、列族、列限定符和时间戳等。

读取数据时,使用HBase Shell或HBase API通过行键或过滤器进行查询。

写入数据时,通过HBase Shell或HBase API向表中插入、更新或删除数据,HBase会自动将数据存储 到相应的列族中。

07

总结与展望

HBase学习总结

HBase是一个高可扩展、高可用、面向列的分布 式数据库系统,运行在Hadoop分布式文件系统 (HDFS)之上,提供了高性能的随机读/写访问 能力。

HBase具有非常灵活的表结构定义能力,支持动 态数据模型和数据版本控制,这使得HBase在处 理半结构化和非结构化数据方面具有很强的能力 。

HBase Java API基本操作

连接HBase

创建表

插入数据

查询数据

使用HBase的Java API连接到 HBase集群。

通过Java代码创建HBase表,需 要定义表名、列族等信息。

向HBase表中插入数据,需要指 定表名、行对象、列对象和数据 值。

根据行号、列名或者时间戳等条 件查询HBase表中的数据,需要 指定表名、行号、列名和时间戳 等条件。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

以前做过一个性能测试项目,基于nginx+Hbase+Hadoop,第一次接触开源的东西,遇到各种问题,印象深的是Hbase和Hadoop的监控,当时也搜索到可以用开源的监控工具或写代码通过JMX取JVM的信息。

在摸索的过程中发现一种更简单方便的办法,不用监控工具和写大量代码,直接用loadrunner脚本(该办法可能不专业,但是能用,可以让项目尽快进行,仅供参考)。

我们知道Hbase开放了60010和60030端口,Hadoop开放的50070端口,以web的方式查看master、region和hadoop的性能状况(比如查看master只需要在浏览器输入http://IP:60010/),可以查看进程的heap、request、queue使用情况,这些指标正是性能测试需要关注的。

而这些信息是通过JMX传递,在浏览器中输入http://IP:port/jmx,会以json的格式返回此刻进程JVM的情况,效果如截图。

master信息

json信息

看到这些信息之后,我的第一反应就是这些返回的信息可用loadrunner的web_reg_save_param函数保存起来,然后写到txt里面。

所以决定Hbase和Hadoop的资源监控流程:

1、loadrunner定时获取json

2、讲关键指标保存到txt

3、用excel生成趋势图

loadrunner脚本:

Action()

{

int filename;

int i;

int len;

char * item;

//hbase region

lr_think_time(10);

lr_start_transaction("heap");

web_reg_save_param_ex(

"ParamName=regionHeap",

"LB= : ",

"RB=\n },",

SEARCH_FILTERS,

"Scope=Body",

"IgnoreRedirections=Yes",

"RequestUrl=*/jmx*",

LAST);

web_url("jmx",

"URL=http://IP:60030/jmx",

"Resource=1",

"RecContentType=application/json",

"Referer=",

"Snapshot=t1.inf",

LAST);

lr_error_message("region is %s", lr_eval_string("{regionHeap}"));

//hadoop namenode

web_reg_save_param_ex(

"ParamName=nameNodeHeap",

"LB= : ",

"RB=\n },",

SEARCH_FILTERS,

"Scope=Body",

"IgnoreRedirections=Yes",

"RequestUrl=*/jmx*",

LAST);

web_url("jmx",

"URL=http://IP:50070/jmx",

"Resource=1",

"RecContentType=application/json",

"Referer=",

"Snapshot=t1.inf",

LAST);

lr_error_message("nameNodeHeap is %s", lr_eval_string("{nameNodeHeap}")); //hbase master

web_reg_save_param_ex(

"ParamName=masterHeap",

"LB= : ",

"RB=\n },",

SEARCH_FILTERS,

"Scope=Body",

"IgnoreRedirections=Yes",

"RequestUrl=*/jmx*",

LAST);

web_url("jmx",

"URL=http://IP:60010/jmx",

"Resource=1",

"RecContentType=application/json",

"Referer=",

"Snapshot=t1.inf",

LAST);

lr_error_message("master is %s", lr_eval_string("{regionHeap}"));

lr_end_transaction("heap",LR_AUTO);

//write text

filename=fopen("E:\\cowen\\B2C\\monitor\\master.txt","a");//w-write,r-read,a-append

fprintf(filename,"%s",lr_eval_string("{masterHeap}"));

fprintf(filename,"%s","\n");

fclose(filename);

filename=fopen("E:\\cowen\\B2C\\monitor\\region.txt","a");//w-write,r-read,a-append

fprintf(filename,"%s",lr_eval_string("{regionHeap}"));

fprintf(filename,"%s","\n");

fclose(filename);

filename=fopen("E:\\cowen\\B2C\\monitor\\namenode.txt","a");//w-write,r-read,a-append

fprintf(filename,"%s",lr_eval_string("{nameNodeHeap}"));

fprintf(filename,"%s","\n");

fclose(filename);

return0;

}

效果图。