NetApp RAID技术

NetApp基础知识介绍

NetApp 基础知识介绍----周波 2010-1-27 一、NetApp硬件基础知识1、NetApp四种核心产品:Filer/Nearstore/Netcache/V-Series;Filer—指存储设备。

提供生产数据的原始存储,具有很高的可行性和性能,并提供快速、简单、可靠的数据访问;Nearstore—也叫备份数据存储。

提供备份数据或归档数据的存储,与磁带库相比,它具有更快和更有效的方法去访问数据。

它是专业的近线存储,是在线原始存储与离线备份存储之间的桥梁;Netcache—也称临时缓存。

它提供临时存储或常用数据的缓存,专业用于内容分配,把内容移动到网络的另一端以改进性能和优化带宽。

由于数据拷贝缓存接近用户,用户不用通过网络传送就可以得到数据。

它还进行访问控制与过滤、应用加速和流控。

V-Series—虚拟化存储,允许Data ONTAP软件通过现有的光纤通道SAN结构来访问多个代理存储阵列;2、NetApp系统硬件组件和存储硬件组件系统硬件组件PSU—冗余电源Fan—冗余风扇CPU—主处理芯片系统内存—主内存NVRAM—不可挥发RAM,掉电时保留数据Expansion—扩展适配卡,不同型号产品可以有0-n个,功能为让系统控制外围设备,譬如NIC /网卡。

NIC—网络接口卡,通过主板上以太网口提供访问网络和网络协议。

Console口—Console连接是物理的或远程终端,用来配置和监控NetApp系统,也可以运行诊断和收集系统信息。

Bootdevice—系统启动时用它来初始化系统。

WAFL—操作系统中的文件系统,Write Anywhere File Layout,任意位置写入文件布局。

W AFL是基于数据块的,使用没有片段的4KB大小数据块。

W AFL结合NVRAM、RAID、Snapshot的设计是NetApp的独特之处。

WAFL的主要特点及其所带来的优势包括:永远一致性的文件系统:任何时刻文件系统均处于一致性的状态,即使遇到非正常断电或不正常关机后,也不需执行硬盘检查,即可在复电后2分钟内迅速提供服务。

NetApp磁盘阵列安装手册(图文教程)

NetApp磁盘阵列安装手册目录目 录 (1)一、磁盘阵列的系统安装 (2)1.1初始化磁盘阵列 (2)1.2输入 license序列号 (8)1.3配置 CIFS (9)1.4在机头中安装阵列操作系统 (11)二、磁盘阵列的SSL 安全认证配置 (13)2.1通过浏览器来管理磁盘阵列 (13)2.2配置 SSL安全认证 (15)三、磁盘阵列的空间配置和分配 (18)3.1在 aggr0中添加新的磁盘 (18)3.2消除磁盘 Aggregate的快照预留空间 (22)3.3缩小卷 vol0的磁盘空间 (22)3.4创建新的 Volume (27)3.5消除 Volume的快照预留空间 (31)3.6在新建卷上的参数修改 (33)3.7在 IBM主机上安装 NetApp磁盘路径管理软件 (34)3.8创建 LUN存储单元 (36)3.8.1开启 FCP功能 (36)3.8.2创建一个 Qtree (38)3.8.3创建一个 Lun存储单元 (39)3.8.4在主机上使用 LUN来存储数据 (44)1一、 磁盘阵列的系统安装1.1初始化磁盘阵列NetApp FAS3020C是NetApp产品中一款有双机头的磁盘阵列,需要先在每个机头中安装好操作系统,才能正常使用。

安装步骤如下:11,通过笔记本电脑或其它Windows平台PC机的串口,连接到机头上的串口上;22,通过超级终端,以默认值连接来进行操作;操作过程如下:CFE version 3.0.0 based on Broadcom CFE: 1.0.40Copyright (C) 2000,2001,2002,2003 Broadcom Corporation.Portions Copyright (c) 2002-2005 Network Appliance, Inc.CPU type 0xF29: 2800MHzTotal memory: 0x80000000 bytes (2048MB)CFE> bye输入bye 后,开始启动;CFE version 3.0.0 based on Broadcom CFE: 1.0.40Copyright (C) 2000,2001,2002,2003 Broadcom Corporation.Portions Copyright (c) 2002-2005 Network Appliance, Inc.CPU type 0xF29: 2800MHzTotal memory: 0x80000000 bytes (2048MB)Starting AUTOBOOT press any key to abort...Loading: 0x200000/24732624 0x19963d0/33360796 0x3966f70/1995456 Entry at 0x00200000 Starting program at 0x00200000Press CTRL-C for special boot menu提示按CTRL-C后弹出启动菜单;Special boot options menu will be available.Mon Mar 20 07:54:25 GMT [cf.nm.nicTransitionUp:info]: Interconnect link 0 is UPNetApp Release 7.0.3: Fri Dec 2 06:00:21 PST 2005Copyright (c) 1992-2005 Network Appliance, Inc.Starting boot on Mon Mar 20 07:54:14 GMT 2006(1) Normal boot.(2) Boot without /etc/rc.(3) Change password.(4) Initialize all disks.(4a) Same as option 4, but create a flexible root volume.(5) Maintenance mode boot.Selection (1-5)?4a这里选择4a,初始化所有的磁盘,并且创建一个root卷,此卷将用于操作系统的安装;Zero disks and install a new file system? y选择y,确认将所有的磁盘零化,并且安装新的文件系统;This will erase all the data on the disks, are you sure? Y选择y,确认将删除磁盘上的所有数据;Zeroing disks takes about 80 minutes. .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... .................................................................................................................................................................... ..................................................................Mon Mar 20 09:15:30 GMT [raid.disk.zero.done:notice]: Disk 0a.23 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR16HQC00007617E7VE] : disk zeroing complete...............Mon Mar 20 09:15:34 GMT [raid.disk.zero.done:notice]: Disk 0a.18 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18YGC000076187JGK] : disk zeroing complete ....................Mon Mar 20 09:15:40 GMT [raid.disk.zero.done:notice]: Disk 0a.20 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18MYR0000761769S1] : disk zeroing complete .............Mon Mar 20 09:15:43 GMT [raid.disk.zero.done:notice]: Disk 0a.22 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18QV900007617LZY3] : disk zeroing complete ..................Mon Mar 20 09:15:48 GMT [raid.disk.zero.done:notice]: Disk 0a.16 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18PE1000076187KXZ] : disk zeroing complete ...............Mon Mar 20 09:15:52 GMT [raid.disk.zero.done:notice]: Disk 0a.21 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR17PT300007617M1P2] : disk zeroing complete .................................................................................................................................................................... ...............Mon Mar 20 09:16:42 GMT [raid.disk.zero.done:notice]: Disk 0a.17 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR18Y6700007617695Y] : disk zeroing complete .................................................................................................................................................................... .............Mon Mar 20 09:18:44 GMT [raid.disk.zero.done:notice]: Disk 0a.19 Shelf ? Bay ? [NETAPP X276_S10K7288F10 NA01] S/N [3KR1911Z0000761769R8] : disk zeroing completeMon Mar 20 09:18:45 GMT [raid.vol.disk.add.done:notice]: Addition of Disk /aggr0/plex0/rg0/0a.18 Shelf 1 Bay 2 [NETAPP X276_S10K7288F10 NA01] S/N [3KR18YGC000076187JGK] to aggregate aggr0 has completed successfullyMon Mar 20 09:18:45 GMT [raid.vol.disk.add.done:notice]: Addition of Disk /aggr0/plex0/rg0/0a.17 Shelf 1 Bay 1 [NETAPP X276_S10K7288F10 NA01] S/N [3KR18Y6700007617695Y] to aggregate aggr0 has completed successfullyMon Mar 20 09:18:45 GMT [raid.vol.disk.add.done:notice]: Addition of Disk /aggr0/plex0/rg0/0a.16 Shelf 1 Bay 0 [NETAPP X276_S10K7288F10 NA01] S/N [3KR18PE1000076187KXZ] to aggregate aggr0 has completed successfullyMon Mar 20 09:18:45 GMT [wafl.vol.add:notice]: Aggregate aggr0 has been added to the system. Mon Mar 20 09:18:46 GMT [fmmbx_instanceWorke:info]: no mailbox instance on primary side Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0a.18 is a primary mailbox disk Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0a.17 is a primary mailbox diskMon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: normal mailbox instance on primary side Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0b.18 is a backup mailbox disk Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: Disk 0b.17 is a backup mailbox disk Mon Mar 20 09:18:47 GMT [fmmbx_instanceWorke:info]: normal mailbox instance on backup side Mon Mar 20 09:18:48 GMT [lun.metafile.dirCreateFailed:error]: Couldn't create vdisk metafile directory /vol/vol0/vdisk.DBG: Set filer.serialnum to: 1071155ifconfig e0a mediatype autoConfiguring onboard ethernet e0a.Contacting DHCP server.Ctrl-C to skip DHCP search ...Mon Mar 20 09:18:48 GMT [rc:info]: Contacting DHCP serverMon Mar 20 09:18:52 GMT [rc:info]: DHCP config failedConfiguring e0a using DHCP failed.NetApp Release 7.0.3: Fri Dec 2 06:00:21 PST 2005System ID: 010******* (); partner ID: <unknown> ()System Serial Number: 1071155 ()System Rev: E0slot 0: System BoardProcessors: 1Memory Size: 2048 MBslot 0: Dual 10/100/1000 Ethernet Controller VIe0a MAC Address: 00:a0:98:03:88:13 (auto-unknown-cfg_down)e0c MAC Address: 00:a0:98:03:88:10 (auto-unknown-cfg_down)e0d MAC Address: 00:a0:98:03:88:11 (auto-unknown-cfg_down)slot 0: FC Host Adapter 0a8 Disks: 2176.0GB1 shelf with ESH2slot 0: FC Host Adapter 0b8 Disks: 2176.0GB1 shelf with ESH2slot 0: Fibre Channel Target Host Adapter 0cslot 0: Fibre Channel Target Host Adapter 0dslot 0: SCSI Host Adapter 0eslot 0: NetApp ATA/IDE Adapter 0f (0x000001f0)0f.0 245MBslot 3: NVRAMMemory Size: 512 MBPlease enter the new hostname []: headb输入这个机头的主机名,这里举例为headb;Do you want to configure virtual network interfaces? [n]: y问是否要配置虚拟网卡,如果要创建的话,输入y;Number of virtual interfaces to configure? [0] 1输入要配置几块虚拟网卡,如配置1块虚拟网卡,就输入1;Name of virtual interface #1 []: vif1输入虚拟网卡的名称,这里举例为vif1;Is vif1 a single [s] or multi [m] virtual interface? [m] s选择虚拟网卡的类型是single还是multi,这里选择s;Number of links for vif1? [0] 2虚拟网卡所包含真实网卡的数量,如果用两块网卡绑定成一块虚拟网卡就输入2;Name of link #1 for vif1 []: e0a输入用于绑定的真实网卡的设备名,可以从阵列设备后面的网络接口上看到;Name of link #2 for vif1 []: e0b输入用于绑定的真实网卡的设备名,可以从阵列设备后面的网络接口上看到;Please enter the IP address for Network Interface vif1 []: 192.168.0.88输入虚拟网卡的IP地址;Please enter the netmask for Network Interface vif1 [255.255.255.0]:输入虚拟网卡的掩码,默认就直接回车;Should virtual interface vif1 take over a partner virtual interface during failover? [n]: y是否允许虚拟网卡在故障时切换到另一个机头上,输入y;The clustered failover software is not yet licensed. To enablenetwork failover, you should run the 'license' command forclustered failover.会提示说没有输入Clustered failover功能的license,需要输入才能实现网络切换功能;Please enter the partner virtual interface name to be taken over by vif1 []: vif1输入另一个机头上的会被切换过来的虚拟网卡的名字;Please enter media type for vif1 {100tx-fd, tp-fd, 100tx, tp, auto (10/100/1000)} [auto]:输入虚拟网卡的类型,一般是自适应,选默认auto;Please enter the IP address for Network Interface e0c []:输入网卡e0c的IP地址,不设置就直接回车;Should interface e0c take over a partner IP address during failover? [n]: n是否允许网卡e0c在故障时切换到另一个机头上,这里不配置就输入n;Please enter the IP address for Network Interface e0d []:输入网卡e0d的IP地址,不设置就直接回车;Should interface e0d take over a partner IP address during failover? [n]: n是否允许网卡e0d在故障时切换到另一个机头上,这里不配置就输入n;Would you like to continue setup through the web interface? [n]: n问是否通过web方式来进行继续的安装,输入n,不需要;Please enter the name or IP address of the default gateway:输入默认网关的名字和IP地址,无须输入就直接回车;The administration host is given root access to the filer's/etc files for system administration. To allow /etc root accessto all NFS clients enter RETURN below.Please enter the name or IP address of the administration host:输入超级管理主机的主机名或IP地址,没有就直接回车;Where is the filer located? []: nanjing问磁盘阵列设备的位置,可以随便写,比如南京,就输入nanjing;Do you want to run DNS resolver? [n]:是否配置DNS,输入n,不配置;Do you want to run NIS client? [n]:是否配置NIS,输入n,不配置;This system will send event messages and weekly reports to Network Appliance Technical Support. To disable this feature, enter "options autosupport.support.enable off" within 24 hours. Enabling Autosupport can significantly speed problem determination and resolution should a problem occur on your system. For further information on Autosupport, please see: /autosupport/ Press the return key to continue.提示说,阵列系统默认的自动发送事件日志和周报告功能是打开的,如果需要关闭,请输入options autosupport.support.enable off。

NetApp统一存储双活方案(参考模板)

NetAp统一存储双活方案NetApp统一存储双活方案1、双活存储架构建设目标系统灾难是指IT系统发生重要业务数据丢失或者使业务系统停顿过长时间(不可忍受)的事故。

可能引发系统灾难的因素包括:•系统软、硬件故障,如:软、硬件缺陷、数据库或其他关键应用发生问题、病毒、通信障碍等;•机房环境突发性事故,如:电源中断、建筑物倒塌、机房内火灾等;•人为因素,如:因管理不完善或工作人员操作不当、人为蓄意破坏、暴力事件等;•自然灾害:如火灾、地震、洪水等突发而且极具破坏性的事故。

其特点是突发性、高破坏强度、大范围。

在灾难性事故的影响下,计算中心机房的硬件设备会部分或完全损坏,造成业务的停顿。

请参见下图:当前用户IT系统缺乏有效的灾难防范手段,难以在灾难发生后,不间断或者迅速地恢复运行。

灾难恢复就是在IT系统发生系统灾难后,为降低灾难发生后造成的损失,重新组织系统运行,从而保证业务连续性。

其目标包括:●保护数据的完整性、一致性,使业务数据损失最少;●快速恢复业务系统运行,保持业务的连续性。

灾难恢复的目标一般采用RPO和RTO两个指标衡量。

技术指标RPO、RTO:RPO (Recovery Point Objective): 以数据为出发点,主要指的是业务系统所能容忍的数据丢失量。

即在发生灾难,容灾系统接替原生产系统运行时,容灾系统与原生产中心不一致的数据量。

RPO是反映恢复数据完整性的指标,在半同步数据复制方式下,RPO等于数据传输时延的时间;在异步数据复制方式下,RPO基本为异步传输数据排队的时间。

在实际应用中,同步模式下,RPO一般为0,而在非同步模式下,考虑到数据传输因素,业务数据库与容灾备份数据库的一致性是不相同的,RPO表示业务数据与容灾备份数据的时间差。

换句话说,发生灾难后,启动容灾系统完成数据恢复,RPO就是新恢复业务系统的数据损失量。

RTO (Recovery Time Objective):即应用的恢复时间目标。

NETAPP介绍

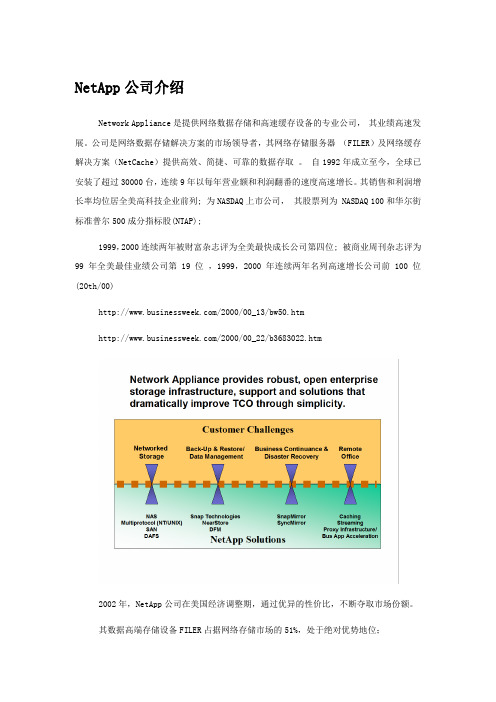

NetApp公司介绍Network Appliance是提供网络数据存储和高速缓存设备的专业公司,其业绩高速发展。

公司是网络数据存储解决方案的市场领导者,其网络存储服务器(FILER)及网络缓存解决方案(NetCache)提供高效、简捷、可靠的数据存取。

自1992年成立至今,全球已安装了超过30000台,连续9年以每年营业额和利润翻番的速度高速增长。

其销售和利润增长率均位居全美高科技企业前列; 为NASDAQ上市公司,其股票列为 NASDAQ 100和华尔街标准普尔500成分指标股(NTAP);1999,2000连续两年被财富杂志评为全美最快成长公司第四位; 被商业周刊杂志评为99年全美最佳业绩公司第19位,1999,2000年连续两年名列高速增长公司前100位(20th/00)/2000/00_13/bw50.htm/2000/00_22/b3683022.htm2002年,NetApp公司在美国经济调整期,通过优异的性价比,不断夺取市场份额。

其数据高端存储设备FILER占据网络存储市场的51%,处于绝对优势地位;其高速缓存设备NETCACHE占2000年CACHE市场的41%,全球最大的10家国家级电信,有九家用其加速用户访问,处于市场领先位置;NetApp的哲学是‘Simple is best’,通过Appliance方式为用户提供快速、简单、可靠的数据服务。

以网络为核心的革新设计获得业界迅速认同,是美国最成功的企业之一,经过5年发展进入世界500强,其成功的数据管理和部署方案,通过消除管理复杂度,为用户带来价值。

以系统的方式设计:使应用服务与数据管理分离,解决数据存储、移动、部署的问题。

Appliance的设计原则:软件优化导致性能的提高远远超出硬件的提高,专门的目的导致管理的简单和系统可用性的提高。

开放的标准:业界创新和技术的领导,集成SAN和NAS的优点。

支持SAN方式的数据备份,NAS的数据共享。

netapp的RAID DP技术

1.1N etApp RAID技术NetApp可以提供WAFL Optimized intelligent RAID 4(增强型RAID 4) 、双校验盘RAID DP 、SyncMirror和组合型RAID等多种技术手段,不仅满足传统RAID 的四种需求目标—安全、经济、效率、扩充,另外对资料安全还提供更多层不影响资料服务的线上防护机制:硬盘区块验证系统 (Block-level checksum),当有一颗硬盘故障时,RAID 系统可保护资料不会流失,但是硬盘无故障时,如果某个硬盘的区块 (Block) 资料有错误时,RAID将无法侦测与更正,此时读取的的资料将会错误。

WAFL内建硬盘区块验证系统 (Block-level checksum) 功能,在RAID所写入资料的Block都会加写checksum在每颗硬盘上,每次读取资料时都会同时检查checksum值。

若检查不符时,就会利用RAID的Parity将该Block进行修复与更正,如此所读出的资料就可得到正确性的保障了。

硬盘扇区检查系统 (Disk scrubbing),每周WAFL会自动自我扫描检查每颗有资料的硬盘所有区块,检查的周期与时间长度亦可自行调整,于所定的时间内未完成时,也会在下次检查时继续未完成的部分。

如此可以提早剔除将会故障的扇区,提供更安全、稳定的硬盘环境,更进一步降低风险。

文件系统线上检查系统 (Online File System Check),一般的文件系统检查都必须在离线状态下才能进行(例如 fsck 和 scandisk),不仅需要漫长的等待时间,更造成服务的中断,文件系统容量越大时,服务停顿的时间就越长。

为避免任何可能造成文件系统错误的因素,同时避免因着检查而让服务中断,WAFL 具有独步全球的线上进行文件系统检查的能力,进行检查时仍可正常提供资料服务,达到同时兼顾安全、不带来服务停顿的效果。

1.1.1增强型RAID4+NetApp Filer使用WAFL Optimized intelligent RAID 4(增强型RAID 4) 提供硬盘保护机制。

NetApp 技术简介

第1章NetApp 技术简介1.1 NetApp RAID技术介绍NetApp可以提供WAFL Optimized intelligent RAID 4(增强型RAID 4) 、双校验盘RAID DP 、SyncMirror和组合型RAID等多种技术手段,不仅满足传统RAID的四种需求目标—安全、经济、效率、扩充,另外对资料安全还提供更多层不影响资料服务的线上防护机制:✓硬盘区块验证系统(Block-level checksum),当有一颗硬盘故障时,RAID系统可保护资料不会流失,但是硬盘无故障时,如果某个硬盘的区块(Block) 资料有错误时,RAID将无法侦测与更正,此时读取的的资料将会错误。

WAFL内建硬盘区块验证系统(Block-level checksum)功能,在RAID所写入资料的Block都会加写checksum在每颗硬盘上,每次读取资料时都会同时检查checksum值。

若检查不符时,就会利用RAID的Parity将该Block进行修复与更正,如此所读出的资料就可得到正确性的保障了。

(专利申请中)✓硬盘扇区检查系统(Disk scrubbing),每周WAFL会自动自我扫描检查每颗有资料的硬盘所有区块,检查的周期与时间长度亦可自行调整,于所定的时间内未完成时,也会在下次检查时继续未完成的部分。

如此可以提早剔除将会故障的扇区,提供更安全、稳定的硬盘环境,更进一步降低风险。

✓文件系统线上检查系统(Online File System Check),一般的文件系统检查都必须在离线状态下才能进行(例如fsck 和scandisk),不仅需要漫长的等待时间,更造成服务的中断,文件系统容量越大时,服务停顿的时间就越长。

为避免任何可能造成文件系统错误的因素,同时避免因着检查而让服务中断,WAFL具有独步全球的线上进行文件系统检查的能力,进行检查时仍可正常提供资料服务,达到同时兼顾安全、不带来服务停顿的效果。

Netapp磁盘阵列的安装与配置

1、安装SANtricity Storage Management软件1) 进入安装页面后,会出现安装目录选择页面,根据需要选择安装目录并点击“Next”,如图所示。

2) 根据用户的环境配置选择安装方式。

推荐使用“Typical”安装模式,单击“Next”进入下一步安装步骤,如图所示。

3)选择自动启动系统监控器,点击“Next”进入下一步安装,如图所示。

4)点击“Next”进入下一步安装,如图所示。

5)点击“Done”完成安装,如图所示。

2、添加磁盘阵列点击“开始”->“程序”->“SANtricity Storage Manager Clinet”,选择“Automatic”,如图所示。

存储阵列出厂默认的双控制器两个网口的IP设置为:192.168.128.101和 192.168.128.102,需要将主机服务器和控制器IP地址设置成同一个网段,通过Out-of-Band以太网带外管理方式,这样才能检测出磁盘阵列。

3、配置卷组和卷单击存储阵列进入Array Management界面,点击菜单项“Storage &Copy Services”,在Total Unconfigured Capacity上右键点击“Create Volume Group”,如图所示。

点击next,输入Volume Group name,如图所示点击next,选择RAID5,如图所示点击Finish,自动进入Create Volume界面,按如图所示进行设置初始化卷,大概需要16分钟左右,如图所示4、定义主机组和主机点击菜单项“Host Mappings”,在Default Group上右键点击Define->Host Group,如图所示输入host group name ,如图所示右键点击Host Group 1->Define->Host,如图所示输入主机名,如图所示点击next,添加wwn号,按如图所示进行设置点击next,选择操作系统,如图所示点击next,单击Finish,选择“No”,如图所示5、添加磁盘阵列映射右键点击Host test1->Add LUN Mapping,如图所示点击Add,按如图所示进行设置完成以上操作后,查看服务管理器中是否能看到新的磁盘,如图所示。

NetAppRAID4与RAID5比较

WAFL文件系统是netapp自己设计的,运行在netapp专用操作系统DATA ONTAP上的一个文件系统,WAFL是“Write Anywhere File Layout”的意思,即“任意位置写入文件布局”的缩写。

正因为有WAFL的这个特点,所以才有了RAID4+,一个改进型的raid4,使得没有校验瓶颈存在,而且能随意扩充硬盘的raid方式。

如果说传统的存储方式中,如果修改一个数据块,我们必须先定位到那个数据块,然后再修改,在我的前面写的raid5内部分析中,我们也看到了,如果修改一个单独的数据,我们必须先读出这个数据与校验,然后修改数据,计算校验,最后写入到同样的位置,这些特点,不仅仅是raid决定的,而且也是运行在raid之上的文件系统决定的。

在WAFL中,如果它也修改一个数据,他可能不管以前的数据的位置,直接把新数据与新校验写到新的位置,之后更改指针,告诉文件系统说,新的数据在这里,而不是原来那里了。

这么做还有一个最大的好处就是,新的数据可能等到足够多以后,可以凑齐raid的一个条带以后,一起写进去,就可以大大的提高写的速度。

raid4+就在WAFL的配合下诞生了,传统的raid4是把所有的校验写在一块单独的硬盘上的,如果数据修改量很大,那么这个单独的硬盘就变成了性能瓶颈,而raid4+可以最大可能的把一个条带的数据,一次性的写入,所以,使得校验盘与其它的盘基本相当的写入量,而没有瓶颈出现。

而且,当这个raid组想增加硬盘的时候,只是简单的放入新的硬盘即可,任意位置写的规则可以保证新的硬盘马上就被使用起来。

WAFL与raid4+为了尽量保证把数据合并后一次性写入,就必须依赖cache,在cache中才可以等到一定数量的数据之后再一起分批写入,而且,本身WAFL的日志也是记录在cache中的,也包括WAFL的inode的指针操作,也都是在cache 中完成。

所以,netapp也必须依赖电池或者ups对cache实施保护。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.1 N ET A PP RAID技术NetApp可以提供WAFL Optimized intelligent RAID 4(增强型RAID 4) 、双校验盘RAID DP 、SyncMirror和组合型RAID等多种技术手段,不仅满足传统RAID的四种需求目标—安全、经济、效率、扩充,另外对资料安全还提供更多层不影响资料服务的线上防护机制:•硬盘区块验证系统(Block-level checksum),当有一颗硬盘故障时,RAID系统可保护资料不会流失,但是硬盘无故障时,如果某个硬盘的区块(Block) 资料有错误时,RAID将无法侦测与更正,此时读取的的资料将会错误。

WAFL内建硬盘区块验证系统(Block-level checksum) 功能,在RAID所写入资料的Block都会加写checksum在每颗硬盘上,每次读取资料时都会同时检查checksum值。

若检查不符时,就会利用RAID的Parity将该Block进行修复与更正,如此所读出的资料就可得到正确性的保障了。

(专利申请中)•硬盘扇区检查系统(Disk scrubbing),每周WAFL会自动自我扫描检查每颗有资料的硬盘所有区块,检查的周期与时间长度亦可自行调整,于所定的时间内未完成时,也会在下次检查时继续未完成的部分。

如此可以提早剔除将会故障的扇区,提供更安全、稳定的硬盘环境,更进一步降低风险。

•文件系统线上检查系统(Online File System Check),一般的文件系统检查都必须在离线状态下才能进行(例如fsck 和scandisk),不仅需要漫长的等待时间,更造成服务的中断,文件系统容量越大时,服务停顿的时间就越长。

为避免任何可能造成文件系统错误的因素,同时避免因着检查而让服务中断,WAFL具有独步全球的线上进行文件系统检查的能力,进行检查时仍可正常提供资料服务,达到同时兼顾安全、不带来服务停顿的效果。

1.1.1 增强型RAID4+RAID技术原来分为RAID 1到RAID 5 等几级。

最常使用的是RAID 1,3和5。

RAID 0,过去一些人使用其来指磁盘条带化,它基本上是没有校验盘的RAID 4机制。

由于磁盘条带之间没有数据冗余,使用RAID这个名词容易引起误解。

RAID 1是简单的磁盘镜像。

所有数据在两个单独的盘上重复存在。

RAID 1十分安全,但加倍了磁盘存储的成本。

RAID 3是与RAID 4类似,在每组盘中使用单一的校验盘,但是RAID 3中条带划分较小,使得每一个操作都要跨越阵列中所有的磁盘。

例如,一个块数据中的第一个字节可能在第一个盘上,第二个字节在第二个盘上,诸如此类。

RAID 3经常处于磁头同步状态以减少等待时间,RAID 3适于单一大文件以高数据率进行读写的应用,诸如超级计算机和图形图像处理。

对于多用户并行发起众多互不相关磁盘操作的应用则不适宜。

作为对比,RAID 4盘组中的每一个数据盘都可以同时满足一个单独用户的请求。

RAID 5与RAID 4类似,但与RAID 4拥有独立校验盘不同,RAID 5在阵列中所有磁盘上存储校验信息。

RAID 5的主要的优势在于它可以防止校验盘本身成为读写瓶颈。

主要的缺点是不能方便的将一块新磁盘添加到现有的RAID组中。

如果要向已有的磁盘组中加入新盘,必须加入一个新的磁盘组。

如果一个RAID 5盘组采用8个盘构成,那么新加磁盘必须以8个为一组,一次性添加。

NetApp Filer使用WAFL Optimized intelligent RAID 4(增强型RAID 4) 提供硬盘保护机制。

传统的RAID 4、RAID 5中对文件系统的结构与应用考虑的并不是很多。

NetApp采用的增强型RAID4与以上介绍的WAFL文件系统结合非常紧密,并经过了专门的优化。

通过同时优化文件系统与RAID机制,NetApp RAID在提供RAID保护机制的同时,没有带来类似RAID 5的性能损耗。

同时,RAID结构可以迅速、简便的加以动态扩充。

通过增强型RAID 4,如果一块磁盘上的一个数据块损坏,盘组中的校验盘将重新计算该数据块上的数据。

并且该数据块将被映射到磁盘中新的位置上。

如果某个磁盘整体损坏,校验盘能防止任何数据丢失。

当替换损坏的磁盘时,校验盘被将自动重新计算其内容。

增强型RAID 4阵列在同一个盘组中使用一个磁盘作为校验盘,其它作为数据盘。

每个磁盘均划分为4KB大小的数据块。

一道磁盘条带包括每个数据磁盘的一个数据块和校验盘的数据块。

条带中任意一个数据块的数据丢失,均能通过校验计算重新得出。

图1:增强型RAID 4 磁盘布局以上图片数字展示了Filer中的增强型RAID4阵列中的条带是如何划分的。

我们可以通过简单的数学运算模拟RAID机制。

如:校验数据数据1 数据2 数据312 3 7 2如果数据盘之一失败,例如“数据2”,数据然能通过简单的算术计算重建:数据2 = 校验数据-数据1-数据3= 12 -3 -2= 7实际上,RAID系统中不是采用加减运算,而是采用异或运算来实现RAID功能。

但是如果一个条带中出现两处错误,则无法用这种方法重新计算出所有数据。

需要依靠下文介绍的NetApp专利技术—RAID DP。

1.1.2 消除校验盘瓶颈面向UNIX和Windows等操作系统的RAID外围设备厂商较少采用RAID 4,因为在通用文件系统下,RAID4校验盘容易成为瓶颈。

但是WAFL文件系统利用其灵活的“任意位置写入文件布局”特性,继承了RAID 4固有的优势,并且避免了其校验盘瓶颈,最大限度的发挥了RAID 4的效率。

WAFL不同于通用文件系统的一个例子是,伯克利快速文件系统(FFS)设计中专门为一次写入一个文件做了优化。

结果是可以为不同的文件把数据块散布到磁盘的不同位置上。

下图左半部显示了FFS如何为不相关的三个文件分配RAID阵列空间。

当例子中每块数据盘仅仅写入2次时,校验盘要做6次写入。

更重要的是,校验数据写入分布过于分散,导致磁盘寻道时间消耗。

图2:伯克利快速文件系统(FFS)和WAFL文件系统写入空间分配特点由于通用文件系统,如上图所示的FFS,并不是专门为RAID 4文件布局设计的,它趋向于散布写入数据盘,引发校验盘的过度寻址操作,从而带来瓶颈。

而WAFL文件系统的设计方式确保能够最大限度地减少校验盘寻址操作。

上图右半部对比显示了WAFL如何分配同样的数据块,从而使得RAID 4更加有效。

WAFL总是把相关的数据块写到彼此邻近的条带中,消除校验盘上的长时间寻址操作。

只要可能,WAFL也把多重数据块写到同样的条带中,从而进一步减少校验盘上的阻塞。

FFS在上图左半部中使用六道独立的条带,因此致使六个校验盘块需要更新。

上图右半部中,WAFL使用仅仅3道条带,即只有三个校验块需要更新。

从而大大提高了RAID性能,消除了校验盘瓶颈。

1.1.3 RAID DP传统的单一奇偶校验RAID技术,能为单个故障磁盘驱动器提供保护。

需要警告的是,在重建故障磁盘时必须确保不能发生其他磁盘故障,而且不能在读操作过程中出现不可修复的误码。

如果在重建过程中出现上面任何一种事件,那么保留在RAID阵列或卷中的部分或所有数据就可能会丢失。

随着现代更大的磁盘存储介质的出现,由于磁盘容量显著增加,而误码率仍是原来的水平,这就使得出现不可修复的误码的可能性相当高。

因此,传统的单一奇偶校验RAID保护数据的方法已经超出了其保护极限。

更高一级的RAID数据保护已经发展到RAID双奇偶校验,也称作RAID DP,它可以应用于整个网络应用数据存储产品线。

从DATAONTAP™ 6.5版开始,NetApp推出了双奇偶校验RAID,叫做RAID DP。

本文给出RAID DP的概览和RAID DP如何在各种磁盘故障情况下动态提高数据的容错性。

其他所涉及的关键领域包括RAID DP的费用是(它是免费的)、特殊硬件要求(无),以及如何将现存的RAID4卷升级到RAID DP(非常容易)。

这里将借助对双磁盘故障的恢复情形来说明RAID DP如何做到允许卷既能不间断地提供数据,又能同时对两块故障磁盘上损失的数据进行重建。

在最基本的层面上,RAID DP为卷中的每个RAID组增加了第二个奇偶校验磁盘。

RAID 组是建立卷的基本结构。

每一个传统的NetApp RAID4组都有一些数据磁盘和一个奇偶校验磁盘,而一个卷通常会包括一个或多个RAID4组。

而RAID4卷上的奇偶校验磁盘则通过RAID4组上的磁盘对行奇偶校验进行存储,额外的RAID DP奇偶校验磁盘则通过RAID DP 组上的磁盘存储对角线上的奇偶校验。

通过RAID DP上的这两个奇偶校验条,(一个传统的水平奇偶校验和一个对角线奇偶校验,即使同一RAID 组上的两个磁盘发生故障时也能得到数据保护。

在RAID DP中,仍然使用了传统的RAID4水平奇偶校验结构,并且这种结构已成为RAID DP结构的子集换句话说,RAID DP并没有改变RAID4在NetApp存储上的工作方式。

数据通过每一行的奇偶校验计算被写入水平行,并被视作双奇偶校验中的行,这个同样的过程仍会保留到RAID DP中。

实际上,如果是单一磁盘故障,或是从坏数据块中的读取错误,或者出现误码,那么RAID4的行奇偶校验方法就是进行数据恢复的唯一手段,无需采用RAID DP。

在这种情况下,RAID DP的对角线奇偶校验组件仅仅是行奇偶校验组件周围的保护层。

RAID4水平行奇偶校验下列图表说明了在传统NetApp RAID4解决方案中使用水平行奇偶校验的方法,也是您了解RAID DP和双奇偶校验的第一步。

图3:RAID4水平行奇偶校验图表代表了传统的RAID4 组,使用包括4个数据磁盘(前4列,标注为“D”)和一列奇偶校验磁盘(最后一列,标注为“P”)的单向奇偶校验。

上面图表中的行显示了实施传统NetApp RAID4时使用的标准4KB块。

上面图表中的第二行在每个4KB 块和行中数据的奇偶校验计算中添加了一些样例数据,随后存储在奇偶校验磁盘上相应的块中。

在这种情况下,计算奇偶校验的方式是向每个水平块中添加值,然后将这些值的和存储为奇偶校验值(3 + 1 + 2 + 3 = 9)。

实际上,奇偶校验是通过专门的OR(XOR)过程进行计算,但其它情况也与此例非常相似。

如果需要从单一故障中重建数据,则产生奇偶校验的过程将与此相反。

例如,当RAID4 恢复上面第一列的数据值3时,如果第一个磁盘发生故障,就会从奇偶校验中存储的值中减去剩余磁盘上的值(9- 3 - 2 - 1 = 3)。

这个通过单一奇偶校验RAID重建的例子,应该有助于从概念上理解为什么能够对单一磁盘故障提供数据保护。