minhash

python minhashlsh函数原理

python minhashlsh函数原理Python MinHashLSH函数原理MinHashLSH是一种常用的近似最近邻搜索算法,它可以在大规模数据集中高效地找到与给定查询相似的数据项。

在Python中,MinHashLSH函数是通过使用MinHash算法和LSH(局部敏感哈希)技术实现的。

MinHash算法是一种用于计算相似度的技术,它可以将大规模数据集中的每个数据项表示为一个固定长度的签名。

这个签名可以用于计算两个数据项之间的相似度,从而实现近似最近邻搜索。

MinHash算法的核心思想是将数据项表示为一个集合,并使用随机哈希函数将集合中的元素映射到一个固定长度的向量中。

通过比较这些向量的相似度,可以计算出数据项之间的相似度。

LSH技术是一种用于高效搜索相似数据项的技术,它可以将数据集分成多个桶,并将相似的数据项放入同一个桶中。

LSH技术的核心思想是使用多个哈希函数将数据项映射到多个桶中,从而实现快速搜索相似数据项。

LSH技术可以大大减少搜索时间,特别是在大规模数据集中。

MinHashLSH函数是将MinHash算法和LSH技术结合起来使用的函数。

它首先使用MinHash算法将数据集中的每个数据项表示为一个固定长度的签名,然后使用LSH技术将这些签名分成多个桶。

当需要搜索与给定查询相似的数据项时,MinHashLSH函数会首先将查询表示为一个签名,然后使用LSH技术在相应的桶中搜索相似的数据项。

由于MinHashLSH函数使用了MinHash算法和LSH技术,因此它可以在大规模数据集中高效地搜索相似数据项。

总之,Python MinHashLSH函数是一种用于近似最近邻搜索的算法,它使用MinHash算法和LSH技术实现。

通过将数据项表示为一个固定长度的签名,并使用LSH技术将这些签名分成多个桶,MinHashLSH函数可以在大规模数据集中高效地搜索相似数据项。

minhash聚类推荐算法

MinHash(最小哈希算法)

• 最小哈希原理介绍 • MinHash是基于Jaccard Index相似度(海量 数据不可行)的算法,一种降维的方法A,B 两个集合:A = {s1, s3, s6, s8, s9} B = {s3, s4, s7, s8, s10} • MinHash的基本原理:在A∪B这个大的随机 域里,选中的元素落在A∩B这个区域的概率, 这个概率就等于Jaccard的相似度

Items i Items j Jaccard (Items i ,Items j ) Items i Items j

推荐算法

• 计算用户u与item(新闻)的推荐度的公式是

Score(u ,item )

sim(u, cluster ) Clickcount (cluster , item) i

用户Minhash聚类推荐算法

为什么要用MinHash算法

• 在协同过滤推荐中,需要根据用户点击过的 新闻记录来给求用户之间的相似度。通常通过 遍历这两个集合中的所有元素,统计这两个集 合中相同元素的个数,来表示集合的相似度; 这一步也可以看成特征向量间相似度的计算 (欧氏距离,余弦相似度)。当这两个集合里 的元素数量异常大(特征空间维数很大),同 时又有很多个集合需要判断两两间的相似度时, 传统方法会变得十分耗时,最小哈希 (minHash)可以用来解决该问题。

i i 1 n

n

其中:

是用户u所属的第i个聚类, 是用户u与聚类 的相似度, 是聚类 中所有用户对 item的点击数量.

聚类相似度算法

• 计算用户ui与所属聚类cluster的相似度的公 式是:

Sim(ui ,cluster )

Jaccard j

flink 中 minhashlsh 的用法 -回复

flink 中minhashlsh 的用法-回复Flink是一个用于大规模分布式数据处理的开源框架,提供了许多内置的算法和工具来处理流数据、批处理和迭代计算。

其中,MinHashLSH (MinHash Locality Sensitive Hashing)是Flink中的一个非常有用的算法,用于高效地近似近邻搜索、相似度计算和数据聚类。

本文将介绍MinHashLSH的概念、原理、用法和一些实际应用案例。

1. MinHash和Locality Sensitive Hashing简介在详细讨论MinHashLSH之前,我们先对MinHash和Locality Sensitive Hashing进行简要介绍。

# 1.1 MinHashMinHash是一种用于近似相似度计算的算法。

它通过将数据集中的每个元素表示为一个固定长度的签名(signature)向量,从而实现高效的相似度计算。

MinHash算法的核心思想是将集合的每个元素映射到一个随机排列(permutation)的最小值,然后通过比较这些最小值的集合来判断元素之间的相似度。

具体来说,对于一个数据集D,MinHash将其每个元素进行一系列随机排列(Permutation),然后对每个排列的结果选择最小值作为该元素的签名。

通过比较两个元素的签名,我们可以估计它们之间的相似度,即它们共同最小值的比例。

# 1.2 Locality Sensitive Hashing (LSH)LSH是一种用于高效近似最近邻搜索的算法。

其核心思想是使用哈希函数将相似的数据映射到同一个桶中,并通过在这些桶中搜索来快速找到近似最近邻。

LSH的一个重要特点是,哈希函数能够将相似的数据映射到相同的桶中,而不太相似的数据则可能被映射到不同的桶中。

在实际应用中,LSH常用于解决诸如近似近似搜索、数据聚类和相似度计算等问题。

2. MinHashLSH概述MinHashLSH算法将MinHash和LSH相结合,实现了高效的近似近邻搜索和相似度计算。

datasketch minhash示例

datasketch minhash示例Datasketch Minhash示例引言:在大数据时代,如何高效地处理海量数据成为了一个重要的问题。

而数据的近似查询是其中一个关键的挑战。

Datasketch Minhash是一种常用的数据近似查询算法,它可以帮助我们快速地找到相似的数据项。

本文将为读者介绍Datasketch Minhash的原理和示例,帮助读者更好地理解和应用这一算法。

一、什么是Datasketch Minhash?Datasketch Minhash是一种基于概率的数据近似查询算法。

它通过将数据集合表示为一个固定长度的签名,然后比较签名之间的相似性来判断数据项之间的相似程度。

Minhash算法的核心思想是将数据集合中的每个元素映射为一个固定长度的签名,通过比较签名之间的相似性来判断数据项之间的相似程度。

二、Datasketch Minhash的原理1. Shingling将数据集合拆分为一个个的子集合,这些子集合称为shingles。

每个shingle可以是一个单词、一个字符、一个词组等。

通过shingling,我们将数据集合表示为一个个的子集合,方便后续的处理。

2. Hashing接下来,将每个shingle映射为一个固定长度的签名。

这里我们使用hash函数来完成映射。

hash函数可以将任意长度的输入映射为固定长度的输出。

3. MinhashingMinhashing是Datasketch Minhash算法的核心步骤。

对于每个数据集合,我们随机选择一组hash函数,并计算每个shingle的hash值。

然后,我们选取每个hash函数的最小值作为该数据集合的签名。

通过这样的方式,我们可以将数据集合表示为一个固定长度的签名。

4. Jaccard相似性通过比较不同数据集合之间的签名,我们可以计算它们之间的相似性。

常用的相似性度量指标是Jaccard相似性,它可以衡量两个数据集合的相似程度。

基本局部敏感哈希算法总结

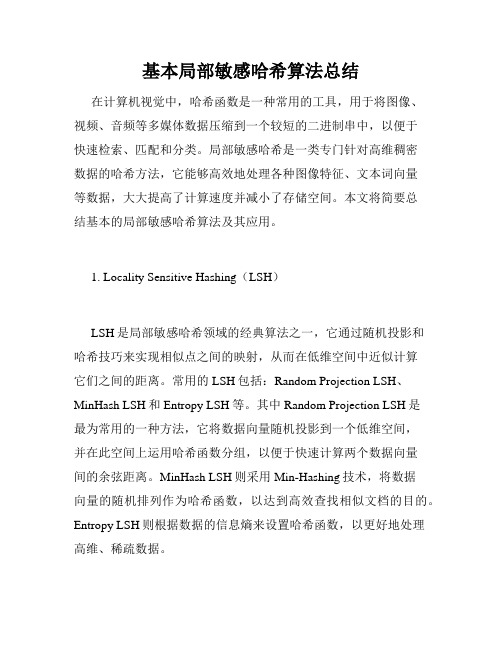

基本局部敏感哈希算法总结在计算机视觉中,哈希函数是一种常用的工具,用于将图像、视频、音频等多媒体数据压缩到一个较短的二进制串中,以便于快速检索、匹配和分类。

局部敏感哈希是一类专门针对高维稠密数据的哈希方法,它能够高效地处理各种图像特征、文本词向量等数据,大大提高了计算速度并减小了存储空间。

本文将简要总结基本的局部敏感哈希算法及其应用。

1. Locality Sensitive Hashing(LSH)LSH是局部敏感哈希领域的经典算法之一,它通过随机投影和哈希技巧来实现相似点之间的映射,从而在低维空间中近似计算它们之间的距离。

常用的LSH包括:Random Projection LSH、MinHash LSH和Entropy LSH等。

其中Random Projection LSH是最为常用的一种方法,它将数据向量随机投影到一个低维空间,并在此空间上运用哈希函数分组,以便于快速计算两个数据向量间的余弦距离。

MinHash LSH则采用Min-Hashing技术,将数据向量的随机排列作为哈希函数,以达到高效查找相似文档的目的。

Entropy LSH则根据数据的信息熵来设置哈希函数,以更好地处理高维、稀疏数据。

2. Product Quantization(PQ)PQ是一种哈希和量化相结合的方法,将高维向量分成若干子向量,对每个子向量进行独立的量化(如K-means聚类),得到若干计算中心点后,再编码为低维二进制码。

这些码排列组合,构成最终的哈希表。

常用的PQ算法包括:Product Quantization based Hashing、Fast Similarity Search in Large Databases using PQ-Hamming Distance及Robust Product Quantization等。

PQ广泛应用于图像、视频、音频等内容检索和机器学习等任务领域。

3. Locality-Sensitive Binary Code(LSBC)LSBC是一种适用于高维稠密数据的二进制编码技术,它与LSH的区别在于数据将被量化为二进制码,而不是哈希表。

AI自然语言处理 文本去重与质量评估

AI自然语言处理文本去重与质量评估AI自然语言处理:文本去重与质量评估引言近年来,随着人工智能技术的发展和应用领域的拓宽,自然语言处理(NLP)作为AI的重要分支之一,受到了广泛关注和研究。

而在NLP中,文本去重和质量评估是两个至关重要的任务,本文将详细介绍这两个课题的概念、方法和挑战。

一、文本去重1. 概念文本去重即为在大规模文本数据集中寻找并删除重复的或者相似度较高的文档。

对于海量数据而言,文本去重可以降低存储空间的要求,并简化后续处理过程,提升系统效率。

2. 方法文本去重的方法主要包括基于哈希的方法、基于特征的方法和基于机器学习的方法。

基于哈希的方法常用的有MinHash和SimHash算法。

MinHash通过随机排列和哈希函数生成固定长度的签名,比较文档间的签名相似度来判断是否重复。

SimHash基于向量表示和海明距离,通过位向量计算文档的哈希值,进而确定文档的相似性。

基于特征的方法则主要利用文档的语义和结构信息进行比对。

常用的特征包括文档中的单词、短语、句子或者其他结构,通过提取和匹配这些特征来判断文本的重复性。

基于机器学习的方法通过构建适当的分类模型,将文本去重问题转化为二分类问题,即判断一对文档是否相似。

这需要大量的训练数据和特征工程的支持,但可以获得较高的准确率。

3. 挑战文本去重面临着准确度和效率两方面的挑战。

对于准确度而言,不同语种、领域和文本形式的差异都会影响去重效果。

例如,在处理非结构化文本时,基于特征的方法可能遇到词序问题,导致匹配结果不准确。

而在效率方面,由于数据规模庞大,快速高效的去重算法对于实际应用至关重要。

因此,如何在保证准确性的前提下,实现高效的去重成为了一个挑战。

二、文本质量评估1. 概念文本质量评估旨在确定文本的可用性和可靠性。

在NLP任务中,文本质量评估可以用于过滤垃圾信息、判断文件的真实性和提高后续任务的效果等。

2. 方法文本质量评估的方法包括基于规则的方法、基于机器学习的方法和基于深度学习的方法。

一种基于MinHash的改进新闻文本聚类算法

一种基于MinHash的改进新闻文本聚类算法王安瑾【摘要】The continuous development of information technology has brought about the rapid growth of news texts on the Internet.In the face of a large number of news texts, it is very important to cluster them effectively.Based on the above requirements, we propose an improved DBSCAN clustering algorithm based on MinHash.In order to solve the problem of high data dimension, high computational complexity and large resource consumption in traditional vector space model text clustering, this algorithm uses MinHash to reduce the dimension of all text feature word sets, thus effectively reducing the wastes of resources.Jaccard coefficient is calculated for any two-by-two data in the obtained characteristics matrix, and each result is compared with the neighborhood radius Eps in DBSCAN clustering and calculated whether all the neighboring nodes whose distances are greater than the neighborhood radius Eps is greater than or equal to MinPts.Therefore, we can determine whether the text is a core point and whether clusters can beformed.Experiment shows that the algorithm has a better effect on news text clustering and can effectively cluster the intricate news text on the Internet.%信息技术的不断发展, 带来的是网络上新闻文本的快速增长, 面对大量的新闻文本, 对其进行有效聚类就显得十分重要.基于上述需求, 提出一种基于MinHash的DBSCAN聚类算法.针对传统向量空间模型文本聚类存在的数据维度高、计算复杂度大、资源消耗多的问题, 该算法使用Min Hash对所有文本的文本特征词集合进行降维, 从而有效减少了资源的浪费.对新得到的特征矩阵中的数据任意两两计算Jaccard系数, 将每一个结果与DBSCAN聚类中给定的邻域半径Eps 进行比较并计算所有距离大于邻域半径Eps的点的周围节点数目是否大于等于形成一个簇所需要的最小点数MinPts, 由此可以判断该文本是否为核心点, 是否可以形成簇.实验结果表明, 该方法对于新闻文本聚类有着很好的效果, 可以对网络上错综复杂的新闻文本进行有效的聚类.【期刊名称】《计算机技术与发展》【年(卷),期】2019(029)002【总页数】4页(P39-42)【关键词】Min Hash;Jaccard系数;DBSCAN;文本聚类【作者】王安瑾【作者单位】东华大学计算机科学与技术学院, 上海 200000【正文语种】中文【中图分类】TP301.60 引言随着互联网的发展,网络新闻中文本数量日益增多,每天用户面临的各个网站的新闻可以用数以万计来形容。

文本查重 算法

文本查重算法

文本查重算法主要用于检测文本的相似度或重复度,以下是几种常见的文本查重算法:

字符串匹配算法:这是最基本的文本相似度计算方法,主要通过将两个文本字符串进行逐个字符的比较,计算相同字符的数量占总字符数的比例来判断文本的相似度。

但是,这种方法对于大量文本的比对速度较慢,且只能检测出完全相同的文本。

哈希算法:哈希算法可以快速计算出文本的哈希值,然后通过比对哈希值来判断文本的相似度。

但是,哈希算法存在哈希冲突的问题,即不同的文本可能会产生相同的哈希值,从而导致误判。

N-gram算法:N-gram算法是一种基于文本分词的方法,将文本分成N个连续的词组,然后比对词组的相似度来判断文本的相似度。

N-gram算法可以识别出部分相似的文本,相对于字符串匹配算法和哈希算法,其检测精度更高。

向量空间模型算法:向量空间模型算法是一种基于文本向量化的方法,将文本转换成向量,然后计算向量之间的相似度来判断文本的相似度。

这种方法可以识别出语义相似的文本,相对于其他算法,其检测精度更高。

此外,还有一些其他的文本查重算法,如Jaccard相似度算法、MinHash算法、SimHash算法等。

这些算法各有优缺点,可

以根据具体的应用场景和需求选择合适的算法进行文本查重。

请注意,文本查重算法的选择和使用需要考虑到文本的长度、复杂度、语言特性等因素,以及算法的准确性、效率和可扩展性等因素。

在实际应用中,可能需要结合多种算法和技术来提高查重的准确性和效率。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

simJ(C1,C2) = 2/5 = 0.4

Identifying Similar Sets?

Signature Idea

Hash columns Ci to signature sig(Ci) simJ(Ci,Cj) approximated by simH(sig(Ci),sig(Cj))

Key Observation

sparsity would miss interesting part of columns sample would get only 0’s in columns

Overload notation: A = # of rows of type A Claim

simJ(Ci , C j ) =

A A + B+C

Pick – P random row permutations MinHash Signature

sig(C) = list of P indexes of first rows with 1 in column C

[

]

Both are A/(A+B+C) Look down columns Ci, Cj until first non-TypeD row h(Ci) = h(Cj) type A row

Suppose row Rj has 1 in column Ci For each hk,

Example

R1 R2 R3 R4 R5 C1 1 0 1 1 0 C2 0 1 1 0 1

C1 slots h(1) = 1 g(1) = 3 h(2) = 2 g(2) = 0 h(3) = 3 g(3) = 2 1 3 1 3 1 2 1 2 1 2 C2 slots 2 0 2 0 2 0 0 0

Technique to limit candidate pairs?

A-Priori does not work Locality Sensitive Hashing (LSH)

2

Hale Waihona Puke Comparing Signatures

Signature Matrix S

Rows = Hash Functions Columns = Columns Entries = Signatures

Compute – Pair-wise similarity of signature columns Problem

Set Similarity Finding Near Duplicates

Set Similarity (Jaccard measure)

simJ(Ci , C j ) =

Ci I C j Ci U C j

(Adapted from slides and material from Rajeev Motwani and Jeff Ullman)

One-pass Implementation

For each Ci and hk, keep “slot” for min-hash value Initialize all slot(Ci,hk) to infinity Scan rows in arbitrary order looking for 1’s

MinHash fits column signatures in memory But comparing signature-pairs takes too much time

h(x) = x mod 5 g(x) = 2x+1 mod 5

h(4) = 4 g(4) = 4 h(5) = 0 g(5) = 1

1

Example

Signatures S1 Perm 1 = (12345) 1 Perm 2 = (54321) 4 Perm 3 = (34512) 3 S2 2 5 5 S3 1 4 4

Implementation Trick

Permuting rows even once is prohibitive Row Hashing

View sets as columns of a matrix; one row for each element in the universe. aij = 1 indicates presence of item i in set j Example

C1 C2 0 1 1 0 1 0 1 0 1 0 1 1

Min Hashing

Randomly permute rows Hash h(Ci) = index of first row with 1 in column Ci Suprising Property Why?

P h(Ci ) = h(C j ) = simJ (Ci , C j )

Min-Hash Signatures

Similarity of signatures

Let simH(sig(Ci),sig(Cj)) = fraction of permutations where MinHash values agree Observe E[simH(sig(Ci),sig(Cj))] = simJ(Ci,Cj)

Pick P hash functions hk: {1,…,n} {1,…,O(n)} Ordering under hk gives random row permutation

R1 R2 R3 R4 R5

C1 1 0 1 1 0

C2 0 1 0 0 1

C3 1 1 0 1 0

Similarities 1-2 1-3 2-3 Col-Col 0.00 0.50 0.25 Sig-Sig 0.00 0.67 0.00

For columns Ci, Cj, four types of rows

A B C D Ci 1 1 0 0 Cj 1 0 1 0

Naï Approach ve

Sample P rows uniformly at random Define sig(Ci) as P bits of Ci in sample Problem