【原创】R语言时变参数VAR随机模型数据分析报告论文(代码数据)

R语言回归模型项目分析报告论文

R语言回归模型项目分析报告论文摘要本文旨在介绍并分析一个使用R语言实现的回归模型项目。

该项目主要探究了自变量与因变量之间的关系,并利用R语言的回归模型进行了预测和估计。

本文将首先介绍项目背景和数据来源,接着阐述模型的构建和实现过程,最后对结果进行深入分析和讨论。

一、项目背景和数据来源本项目的目的是探究自变量X1、X2、X3等与因变量Y之间的关系。

为了实现这一目标,我们收集了来自某一领域的实际数据,数据涵盖了多个年份和多个地区的情况。

数据来源主要是公开可用的数据库和相关文献。

在数据处理过程中,我们对缺失值、异常值和重复值进行了适当处理,以保证数据的质量和可靠性。

二、模型构建和实现过程1、数据预处理在构建回归模型之前,我们对数据进行预处理。

我们检查并处理缺失值,采用插值或删除的方法进行处理;我们检测并处理异常值,以防止其对回归模型产生负面影响;我们进行数据规范化,将不同尺度的变量转化为同一尺度,以便于回归分析。

2、回归模型构建在数据预处理之后,我们利用R语言的线性回归函数lm()构建回归模型。

我们将自变量X1、X2、X3等引入模型中,然后通过交叉验证选择最佳的模型参数。

我们还使用了R-squared、调整R-squared、残差标准误差等指标对模型性能进行评价。

3、模型实现细节在构建回归模型的过程中,我们采用了逐步回归法(stepwise regression),以优化模型的性能。

逐步回归法是一种回归分析的优化算法,它通过逐步添加或删除自变量来寻找最佳的模型。

我们还使用了R语言的arima()函数进行时间序列分析,以探究时间序列数据的规律性。

三、结果深入分析和讨论1、结果展示通过R语言的回归模型分析,我们得到了因变量Y与自变量X1、X2、X3等之间的关系。

我们通过表格和图形的方式展示了回归分析的结果,其中包括模型的系数、标准误差、t值、p值等指标。

我们还提供了模型的预测值与实际值之间的比较图,以便于评估模型的性能。

【原创】R语言破产模型分析报告 (附代码数据)

R语言破产模型分析报告1、引言对保险人而言,资产和负债是影响保险人稳定经营至关重要的因素。

资产和负债的差额称为盈余,简记作:U(t)=A(t)−L(t),t>0其中A(t)表示时刻t的资产,L(t)表示时刻t的负债,t=0时刻的盈余被称为初始盈余,简记为u,即U(0)=u。

对这个初步的理论模型进行简化并根据实际情况设置一些假定情况,会得出很多不同的盈余过程模型,最经典的有古典盈余过程模型:U(t)=u+ct−S(t);u≥0,c>0这是一个以u为初值,以时间t为指标集的随机过程。

其中{S(t),t>0}称为总理赔过程,满足:S(t)={X1+X2+⋯XN(t),N(t)>00 ,N(t)=0N(t)表示[0,t]内的总理赔次数,Xi表示[0,t]内第i次理赔的金额。

根据这个古典盈余过程模型可以引出破产模型,在这个盈余过程模型中,一方面有连续不断的保费收入并以速度c进行积累,另一方面则是不断会有理赔需要支付,因此这是一个不断跳跃变化的过程。

从保险人的角度来看,当然希望ct−S(t)恒大于0,否则就有可能出现U(t)<0的情况,这种情况可以定义为理论意义上的破产。

从研究保险人破产角度出发,可以把这个盈余过程模型看做一个特殊的破产模型。

2、相关概念概述2.1、指数分布随机变量的密度函数为:f(x;λ)={λe −λx,x≥00 ,x<0则称随机变量服从指数分布。

2.2、泊松分布泊松过程中,第k次随机事件与第k+1次随机事件出现的时间间隔服从指数分布。

泊松分布适合于描述单位时间内随机事件发生的次数的概率分布。

如某一服务设施在一定时间内受到的服务请求的次数,电话交换机接到呼叫的次数、汽车站台的候客人数、机器出现的故障数、自然灾害发生的次数等等。

泊松分布的概率质量函数为:P(X=k)=e−λλk k!泊松分布的参数λ是单位时间内随机事件的平均发生率。

两个独立且服从泊松分布的随机变量,其和仍然服从泊松分布。

r语言向量误差修正模型系数解读

R语言向量误差修正模型(VECM)是一种用于多变量时间序列建模的方法,它可以帮助我们理解变量之间的长期和短期关系。

在本文中,我将深入探讨VECM模型的系数解读,并结合个人观点和理解,为您解析这一主题。

1. VECM模型简介VECM模型是向量自回归模型(VAR)的扩展,它在处理非平稳时间序列数据时具有很高的适用性。

与VAR模型不同的是,VECM模型考虑了变量之间的协整关系,从而可以分离长期均衡关系和短期动态调整过程。

2. VECM模型系数解读在VECM模型中,系数的解读非常重要。

我们需要关注模型的截距项和趋势项,它们代表了长期均衡关系的影响。

我们需要关注误差修正项的系数,它代表了模型中的短期调整过程。

通过这些系数的解读,我们可以更好地理解变量之间的动态关系。

3. 长期均衡关系解读当我们在VECM模型中发现存在协整关系时,我们可以通过截距项和趋势项来解读长期均衡关系。

截距项代表了长期均衡关系的水平,而趋势项则代表了长期均衡关系的变化趋势。

通过对这些系数的解读,我们可以揭示变量之间的长期关系。

4. 短期动态调整解读除了长期均衡关系,VECM模型还可以帮助我们理解变量之间的短期动态调整过程。

误差修正项的系数代表了短期动态调整的速度和方向,通过对这些系数的解读,我们可以了解变量之间的短期动态关系。

5. 个人观点和理解在我看来,VECM模型的系数解读是非常重要的。

通过深入理解模型系数的含义,我们可以更好地把握多变量时间序列数据的动态特性,从而做出更准确的预测和分析。

我认为在解读系数时,需要结合实际问题的背景和领域知识,以便更好地理解变量之间的关系。

总结与回顾通过本文的阐述,我们对VECM模型的系数解读有了更深入的理解。

从长期均衡关系到短期动态调整,每个系数都承载着丰富的信息,帮助我们理解变量之间的复杂关系。

在实际应用中,我们需要综合运用VECM模型的系数解读和领域知识,从而做出准确的预测和分析。

通过本文的讨论,相信您已经对r语言向量误差修正模型系数解读有了更深入的了解。

R语言arima模型时间序列分析报告(附代码数据)

R语言arima模型时间序列分析报告(附代码数据)【原创】定制撰写数据分析可视化项目案例调研报告(附代码数据)有问题到淘宝找“大数据部落”就可以了R语言arima模型时间序列分析报告library(openxlsx)data=read.xlsx("hs300.xlsx")XXX收盘价(元)`date=data$日期date=as.Date(as.numeric(date),origin="1899-12-30")#1998-07-05#绘制时间序列图plot(date,timeseries)timeseriesdiff<-diff(timeseries,differences=1)plot(date[-1],timeseriesdiff)【原创】定制撰写数据分析可视化项目案例调研报告(附代码数据)有问题到淘宝找“大数据部落”就可以了#时间序列分析之ARIMA模型预测#我们可以通过键入下面的代码来得到时间序列(数据存于“timeseries”)的一阶差分,并画出差分序列的图:#时间序列分析之ARIMA模型预测#从一阶差分的图中可以看出,数据仍是不平稳的。

我们继续差分。

【原创】定制撰写数据分析可视化项目案例调研报告(附代码数据)有问题到淘宝找“大数据部落”就可以了#时间序列分析之ARIMA模型预测#二次差分(上面)后的时间序列在均值和方差上确实看起来像是平稳的,随着时间推移,时间序列的水平和方差大致保持不变。

因此,看起来我们需要对data进行两次差分以得到平稳序列。

#第二步,找到合适的ARIMA模型#如果你的时间序列是平稳的,或者你通过做n次差分转化为一个平稳时间序列,接下来就是要选择合适的ARIMA模型,这意味着需要寻找ARIMA(p,d,q)中合适的p值和q值。

为了得到这些,通常需要检查[平稳时间序列的(自)相关图和偏相关图。

#我们使用R中的“acf()”和“pacf”函数来分别(自)相关图和偏相关图。

【原创】R语言通过ARIMA建模进行预测研究实例报告论文(附代码数据)

本文是我们通过时间序列和ARIMA模型预测拖拉机销售的制造案例研究示例的延续。

您可以在以下链接中找到以前的部分:第1部分:时间序列建模和预测简介第2部分:在预测之前将时间序列分解为解密模式和趋势第3部分:ARIMA预测模型简介在本部分中,我们将使用图表和图表通过ARIMA预测PowerHorse拖拉机的拖拉机销售情况。

我们将使用前一篇文章中学到的ARIMA建模概念作为我们的案例研究示例。

但在我们开始分析之前,让我们快速讨论一下预测:诺查丹玛斯的麻烦人类对未来和ARIMA的痴迷 - 由Roopam撰写人类对自己的未来痴迷- 以至于他们更多地担心自己的未来而不是享受现在。

这正是为什么恐怖分子,占卜者和算命者总是高需求的原因。

Michel de Nostredame(又名Nostradamus)是一位生活在16世纪的法国占卜者。

在他的着作Les Propheties (The Prophecies)中,他对重要事件进行了预测,直到时间结束。

诺查丹玛斯的追随者认为,他的预测对于包括世界大战和世界末日在内的重大事件都是不可挽回的准确。

例如,在他的书中的一个预言中,他后来成为他最受争议和最受欢迎的预言之一,他写了以下内容:“饥饿凶猛的野兽将越过河流战场的大部分将对抗希斯特。

当一个德国的孩子什么都没有观察时,把一个伟大的人画进一个铁笼子里。

“他的追随者声称赫斯特暗指阿道夫希特勒诺查丹玛斯拼错了希特勒的名字。

诺查丹玛斯预言的一个显着特点是,他从未将这些事件标记到任何日期或时间段。

诺查丹玛斯的批评者认为他的书中充满了神秘的专业人士(如上所述),他的追随者试图强调适合他的写作。

为了劝阻批评者,他的一个狂热的追随者(基于他的写作)预测了1999年7月世界末日的月份和年份 - 相当戏剧化,不是吗?好吧当然,1999年那个月没有发生任何惊天动地的事情,否则你就不会读这篇文章。

然而,诺查丹玛斯将继续成为讨论的话题,因为人类对预测未来充满了痴迷。

R语言实验报告范文

R语言实验报告范文实验报告:基于R语言的数据分析摘要:本实验基于R语言进行数据分析,主要从数据类型、数据预处理、数据可视化以及数据分析四个方面进行了详细的探索和实践。

实验结果表明,R语言作为一种强大的数据分析工具,在数据处理和可视化方面具有较高的效率和灵活性。

一、引言数据分析在现代科学研究和商业决策中扮演着重要角色。

随着大数据时代的到来,数据分析的方法和工具也得到了极大发展。

R语言作为一种开源的数据分析工具,被广泛应用于数据科学领域。

本实验旨在通过使用R语言进行数据分析,展示R语言在数据处理和可视化方面的应用能力。

二、材料与方法1.数据集:本实验使用了一个包含学生身高、体重、年龄和成绩的数据集。

2.R语言版本:R语言版本为3.6.1三、结果与讨论1.数据类型处理在数据分析中,需要对数据进行适当的处理和转换。

R语言提供了丰富的数据类型和操作函数。

在本实验中,我们使用了R语言中的函数将数据从字符型转换为数值型,并进行了缺失值处理。

同时,我们还进行了数据类型的检查和转换。

2.数据预处理数据预处理是数据分析中的重要一步。

在本实验中,我们使用R语言中的函数处理了异常值、重复值和离群值。

通过计算均值、中位数和四分位数,我们对数据进行了描述性统计,并进行了异常值和离群值的检测和处理。

3.数据可视化数据可视化是数据分析的重要手段之一、R语言提供了丰富的绘图函数和包,可以用于生成各种类型的图表。

在本实验中,我们使用了ggplot2包绘制了散点图、直方图和箱线图等图表。

这些图表直观地展示了数据的分布情况和特点。

4.数据分析数据分析是数据分析的核心环节。

在本实验中,我们使用R语言中的函数进行了相关性分析和回归分析。

通过计算相关系数和回归系数,我们探索了数据之间的关系,并对学生成绩进行了预测。

四、结论本实验通过使用R语言进行数据分析,展示了R语言在数据处理和可视化方面的强大能力。

通过将数据从字符型转换为数值型、处理异常值和离群值,我们获取了可靠的数据集。

【原创】R语言数据可视化分析报告(附代码数据)

Vis 3这个图形是用另一个数据集菱形建立的,也是内置在ggplot2包中的数据集。

library(ggthemes)

ggplot(diamonds)+geom_density(aes(price,fill=cut,color=cut),alpha=0.4,size=0.5)+labs(title='Diamond Price Density',x='Diamond Price (USD)',y='Density')+theme_economist()

library(ggplot2)

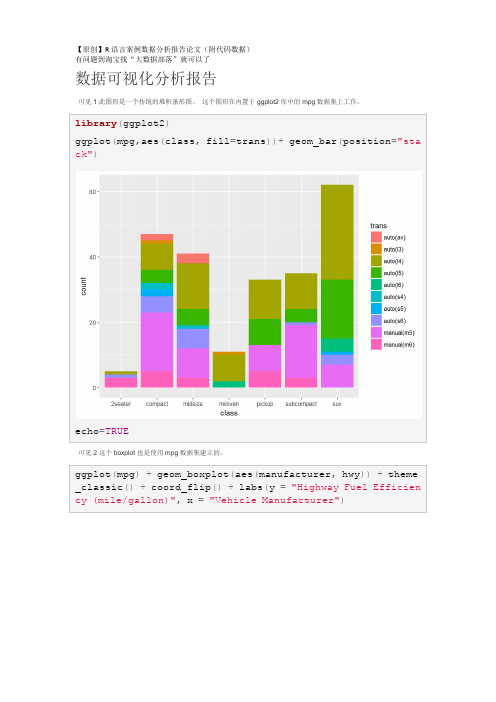

ggplot(mpg,aes(class,fill=trans))+geom_bar(position="stack")

echo=TRUE

可见2这个boxplot也是使用mpg数据集建立的。

ggplot(mpg)+geom_boxplot(aes(manufacturer,hwy))+theme_classic()+coord_flip()+labs(y="Highway Fuel Efficiency (mile/gallon)",x="Vehicle Manufacturer")

echo=TRUE

另外,我正在使用ggplot2软件包来将线性模型拟合到框架内的所有数据上。

ggplot(iris,aes(Sepal.Length,Petal.Length))+geom_point()+geom_smooth(method=lm)+theme_minimal()+theme(panel.grid.major=element_line(size=1),panel.grid.minor=element_line(size=0.7))+labs(title='relationship between Petal and Sepal Length',x='Iris Sepal Length',y='Iris Petal Length')

【原创】R语言用Rshiny探索广义线性混合模型(GLMM)和线性混合模型(LMM)数据分析报告(附代码数据)

咨询QQ:3025393450有问题百度搜索“”就可以了欢迎登陆官网:/datablogR语言用Rshiny探索lme4广义线性混合模型(GLMM)和线性混合模型(LMM)数据分析报告随着lme4软件包的改进,使用广义线性混合模型(GLMM)和线性混合模型(LMM)的工作变得越来越容易。

当我们发现自己在工作中越来越多地使用这些模型时,我们(作者)开发了一套工具,用于简化和加快与的merMod对象进行交互的常见任务lme4。

该软件包提供了那些工具。

安装# development versionlibrary(devtools)install_github("jknowles/merTools")# CRAN version -- coming sooninstall.packages("merTools")咨询QQ:3025393450有问题百度搜索“”就可以了欢迎登陆官网:/datablogRshiny的应用程序和演示演示此应用程序功能的最简单方法是使用捆绑的Shiny应用程序,该应用程序会在此处启动许多指标以帮助探索模型。

去做这个:devtools::install_github("jknowles/merTools")library(merTools)m1 <- lmer(y ~ service + lectage + studage + (1|d) + (1|s), data=InstEval)shinyMer(m1, simData = InstEval[1:100, ]) # just try the first 100 rows of data在第一个选项卡上,该功能提供了用户选择的数据的预测间隔,这些预测间隔是使用predictInterval包中的功能计算得出的。

通过从固定效应和随机效应项的模拟分布中进行采咨询QQ:3025393450有问题百度搜索“”就可以了欢迎登陆官网:/datablog样,并将这些模拟估计值组合起来,可以为每个观测值生成预测分布,从而快速计算出预测间隔。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

咨询QQ:3025393450

有问题百度搜索“”就可以了

欢迎登陆官网:/datablog

R语言时变参数VAR随机模型数据分析报告

来源:大数据部落

摘要

时变参数VAR随机模型是一种新的计量经济学方法,用于在具有随机波动率和相关状态转移的时变参数向量自回归(VAR)的大模型空间中执行随机模型规范搜索(SMSS)。

这是由于过度拟合的关注以及这些高度参数化模型中通常不精确的推断所致。

对于每个VAR系数,这种新方法自动确定它是恒定的还是随时间变化的。

此外,它可用于将不受限制的时变参数VAR收缩到固定VAR因此,提供了一种简单的方法(概率地)在时变参数模型中施加平稳性。

我们通过局部应用证明了该方法的有效性,我们在非常低的利率期间调查结构性冲击对政府支出对美国税收和国内生产总值(GDP)的动态影响。

引言

向量自回归(VAR)广泛用于宏观经济学中的建模和预测。

特别是,VAR已被用于理解宏观经济变量之间的相互作用,通常通过估计脉冲响应函数来表征各种结构性冲击对关键经济变量的影响。

状态空间模型

咨询QQ:3025393450

有问题百度搜索“”就可以了

欢迎登陆官网:/datablog

允许时间序列模型中的时变系数的流行方法是通过状态空间规范。

具体而言,假设ÿ 是Ñ 对因变量的观测的×1向量,X 是Ñ ×上解释变量的观测矩阵,β是状

态的×1向量。

然后可以将通用状态空间模型编写为(1)

(2)

这种一般的状态空间框架涵盖了宏观经济学中广泛使用的各种时变参数(TVP)回归模型,并已成为分析宏观经济数据的标准框架。

然而,最近的研究引起了人们的担忧,过度拟合可能是这些高度参数化模型的问题。

此外,这些高维模型通常给出不精确的估计,使任何形式的推理更加困难。

受这些问题的影响,研究人员可能希望有一个更简约的规范,以减少过度参数化的潜在问题,同时保持状态空间框架的灵活性,允许系数的时间变化。

例如,人们可能希望拥有一个具有时不变系数的默认模型,但是当有强有力的时间变化证据时,这些系数中的每一个都可以转换为随时间变化的。

通过这种方式,人们可以保持简洁的规范,从而实现更精确的估计,同时最大限度地降低模型错误指定的风险。

结果

我们实施了Gibbs采样器,以获得VECM模型中参数的25,000个后抽取。

BKK采用类似的“标准化”系列的方法,只影响先前的规范,只要在后验计算中适当考虑转换即可。

或者,可以使用原始系列并使用训练样本来指定先验,虽然这在操作上更加复杂。

值得注意的是,我们在SMSS和TVP-SVECM规范中应用了相同的标准化。

我们的算法实现也使用了三个广义Gibbs步骤算法的稳定性,通过跟踪所有抽样变量的低效率因素和复制模拟运行多次验证。

SMSS产生的IRF与对角线转换协方差的比较,具有完全转换协方差的SMSS和基准TVP-SVECM在2000Q1的支出减少1%之后的20个季度。

咨询QQ:3025393450

有问题百度搜索“”就可以了

欢迎登陆官网:/datablog

2000年第一季度的税收(虚线)和支出(实线)对1%的支出冲击的中位数冲动响应。

结束语

时变VAR广泛用于通过估计脉冲响应函数来研究结构冲击对关键经济变量的动态影响。

然而,由于这些模型是高度参数化的,因此推断通常是不精确的,并且通常难以得出结论。

在本文中,我们提出了一种新方法,允许数据决定VAR中的参数是时变的还是时不变的,从而允许模型在系数的时间变化很小时自动切换

咨询QQ:3025393450

有问题百度搜索“”就可以了

欢迎登陆官网:/datablog

到更简约的规范。

通过在状态方程的方差之前引入Tobit,计算许多指标的任务被大大简化。

还有问题吗?请在下面留言!。