第6章 神经网络中的线性变换共22页

6线性空间与线性变换

与A中的

对应,就记

在映射下的像, 在下的原像.

返回

上一页

下一页

的像的全体构成的集合称为的像集,记作 (A),即

例

设A=R, B=R+, (x)=x2+3是R到R+的一个映

射, 它把 x 映射到 x2+3 , 7 是 -2在 下的像.

返回

上一页

下一页

定义6 设U,V是R上的两个线性空间,是V到U 上的一个映射,如果满足

(4) 对任何a∈R+,有 a a 1 a a 1 1 (a-1叫做a的负元素);

(5) 1 a a a ; k (6) k ( a ) k a a (k ) a;

1

(7 ) (k ) a a

(k )

故

1 x1 0 x2 x3 0 x4 0 1 1 0 0 0 0 1 2 0 x1 x 2 x1 x2 x2 . 1 x3 x3 2 x4 x4

因此 f(x)在基

下的坐标为

返回

上一页

下一页

返回

上一页

下一页

于是

返回

上一页

下一页

在线性空间Vn中取定一个基 ,则Vn中 的向量 与n维数组向量空间Rn中的向量(x1,x2,…xn)之 间有一个一一对应的关系,且这个对应关系保持线性 组合的对应,即设 则

Vn与Rn有相同的结构,称为Vn与Rn同构。 一般地,设V与U是R上的两个线性空间,如果在 它们的元素之间有一一对应关系,且这个对应关系保 持线性组合的对应,那么就说线性空间V与U同构。

第6章线性变换和特征值

第6章线性变换和特征值线性变换是线性代数中的重要概念,它是指一个向量空间V到另一个向量空间W之间的映射,满足线性性质。

线性变换在实际应用中有着广泛的应用,特别是在计算机图形学、信号处理、物理学等领域中。

在进行线性变换时,我们通常会对向量进行一系列的操作,如旋转、缩放、投影等。

这些操作可以通过矩阵来表示,因为矩阵可以将一些向量操作统一起来,从而方便计算。

线性变换可以用一个矩阵A表示,对于输入向量x,其变换结果y=Ax。

线性变换的一个重要性质是保持向量的线性组合。

即对于任意的向量x1, x2和标量a,b,有T(ax1 + bx2) = aT(x1) + bT(x2)。

这一性质在实际应用中非常有用,它保证了线性变换的结果仍然是向量空间中的向量。

在线性代数中,我们研究的是向量空间的特征,即向量空间中的一些特殊向量。

对于一个线性变换T,其特征向量是满足T(v)=λv的非零向量v,其中λ是一个标量,称为特征值。

特征向量和特征值可以用来描述线性变换对向量的“拉伸”和“旋转”效果。

特征值和特征向量的计算是线性代数中的关键问题。

一般来说,我们可以通过求解线性变换对应矩阵的特征方程来求解特征值和特征向量。

特征方程是一个关于特征值λ的方程,其形式为det(A - λI) = 0,其中A是线性变换对应的矩阵,I是单位矩阵。

特征值和特征向量在实际应用中有着广泛的应用。

例如,在计算机图形学中,特征值和特征向量可以用来描述3D模型的形状变化。

在信号处理中,特征值和特征向量可以用来解决滤波和降噪问题。

除了特征值和特征向量,线性变换还有一些重要的性质。

例如,对于矩阵为A的线性变换T和标量c,有T(cA)=cT(A),称为线性变换的齐次性质。

此外,线性变换的核是指所有使得T(v)=0的向量v的集合,而像是指线性变换T的所有可能输出向量的集合。

总结起来,线性变换是线性代数中的重要概念,它可以用矩阵来表示,并且具有许多重要的性质。

特征值和特征向量是线性变换的重要度量指标,可以用来描述线性变换的效果。

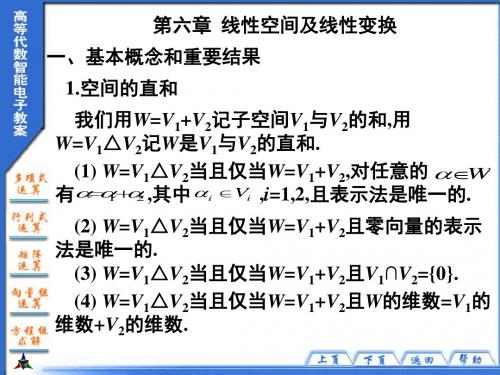

第六章 线性空间与线性变换

其中α, β ,γ 是V 中的任意元素, k,l 是数域 F 中任意数.V 中适合(3)的元素 0 称为零元

素;适合(4)的元素 β 称为α 的负元素,记为 − α .

下面我们列举几个线性空间的例子.

例1 数域 F 上的所有 n 维列向量集 F n 算规则,它是数域 F 上的一个线性空间.特别 地,当 F=R 时,R n 称为 n 维实向量空间;当 F=C 时,C n 称为 n 维复向量

设α = x1ε1 + x2ε 2 + L+ xnε n = y1η1 + y2η2 + L+ ynηn ,则

⎜⎛ x1 ⎟⎞ ⎜⎛ y1 ⎟⎞

⎜ ⎜ ⎜⎜⎝

第 4 页 共 19 页

第六章 线性空间与线性变换

二、同构关系

1.映射

设 M,N 是两个集合.如果给定一个法则ϕ ,使 M 中的每个元素 a 都有 N 中的一

个唯一确定的元素 a' 与之对应,则称ϕ 是集合 M 到集合 N 的一个映射. a' ∈ N 称为 a 在

映射ϕ 下的像,而 a 称为 a' 在映射ϕ 下的原像.记作ϕ(a) = a' . M 中元素在ϕ 下像的全

2) 把(1)式形式地写为

⎜⎛ x1 ⎟⎞

α

=

(ε1,ε

2

,L,

ε

n

)

⎜ ⎜ ⎜⎜⎝

x2 M xn

⎟ ⎟ ⎟⎟⎠

.

(η1,η2 ,L,ηn ) = (ε1,ε 2 ,L,ε n )A.

第 6 页 共 19 页

第六章 线性空间与线性变换

6.3 线性变换的概念

(1)线性变换就是保持线性 组合的对应的变换 .

( 2) 一般用黑体大写字母T , A, B,代表线性 变换, T 或T代表元素在变换T下的象.

第六章 线性空间与线性变换

§6.3 线性变换的概念

3.从线性空间 V n 到其自身的线性变换

如果U m V n , 那么T是一个从线性空间 V n 到其 自身的线性变换 , 称为线性空间 V n中的线性变换.

第六章 线性空间与线性变换

§6.3 线性变换的概念

第六章

线性空间与线性变换

第六章 线性空间与线性变换

§6.3 线性变换的概念

一、线性变换的概念

1.映射 线性空间中向量之间的联系,是通过线性空 间到线性空间的映射来实现的.

定义1 设有两个非空集合 A, B , 如果对于A中任一 元素 , 按照一定规则 , 总有 B中一个确定的元素 和它对应, 那么, 这个对应规则称为从集 合A到集合 B的变换(或映射), 记作

下面主要讨论线性空间V n 中的线性变换.

第六章 线性空间与线性变换

§6.3 线性变换的概念

二、线性变换的性质

1. T 0 0, T T ;

2.若 k1 1 k2 2 km m , 则 T k1T 1 k2T 2 kmT m ;

(1) 任给 1 , 2 Vn , 有 T 1 2 T 1 T 2 ;

(2) 任给 Vn , k R, 都有T k kT .

那么, 就称T为从Vn到U m的线性变换.

第六章 线性空间与线性变换

§6.3 线性变换的概念

说明

3. 若 1 , 2 ,, m 线性相关, 则T 1 , T 2 ,, T m亦线性相关.

神经网络的数学基础

(四)内积

内积是许多神经网络操作的基础

但是这并不是惟一可能的内积形式!!!

(五)范数

如果一个标量函数 ||x||满足以下一些性 质,则称其为范数:

范数基于内积的定义:

(1) x 0 (2) x 0 x 0 (3)标量a,有: a x ax (4) x y x y

面的研究。现在我们来寻 求搜索参数空间和确定性能曲面最优点的算法(求给 定神经网络的最优权值和偏置值)

性能优化

最速下降法 牛顿法 共轭梯度法

最速下降法

牛顿法

共轭梯度法

(二)矩阵表示

对于两个有限维向量空间之间的任意线性变 换都存在与其相应的矩降表示。

基变换

特征值和特征向量

3 性能曲面和最优点

性能学习开发的背景知识: 泰勒级数 方向导数 极小点 优化的必要条件 二次函数

(一)泰勒级数

方向导数

极小点

优化的必要条件

神经网络的数学基础

1 2 3 4 信号与权值向量空间 神经网络中的线性变换 性能曲面和最优点 性能优化

1 信号与权值向量空间

线性向量空间 线性无关 生成空间 内积 范数 正交性 向量展开式

(一)线性向量空间的定义

一个线性向量空间X是一组定义在标量域F上且满足如 下条件的元素集合:

(7)向量展开式

如果向量空间X的基集 {u1,u2,…,un},那么任 意向量x∈X有唯一的 展开式: n

i 1

x ai ui a1u1 a2u2 anun

所以,有限维向量空间中的任意向量都可以用一列数来表 示:

x a1 , a2 , , an

思考:如何求系数ai ?

线性变换的定义和性质

汇报人:XX

• 线性变换的基本概念 • 线性变换的基本性质 • 线性变换的矩阵表示 • 线性变换的应用举例 • 线性变换与空间结构的关系

01

线性变换的基本概念

定义与性质

线性变换定义

保持原点不动

保持向量共线性

保持向量比例不变

线性变换是一种特殊的映射, 它保持向量空间中的加法和数 乘运算的封闭性。即对于向量 空间V中的任意两个向量u和v 以及任意标量k,都有 T(u+v)=T(u)+T(v)和 T(kv)=kT(v)。

矩阵性质

线性变换的矩阵表示具有一些特殊的性质。例如,两个线性变换的复合对应于它们矩阵的乘积;线性变换的可逆 性对应于矩阵的可逆性;线性变换的特征值和特征向量对应于矩阵的特征值和特征向量等。

02

线性变换的基本性质

线性变换的保线性组合性

线性组合保持性

对于任意标量$a$和$b$,以及向量 $mathbf{u}$和$mathbf{v}$,线性 变换$T$满足$T(amathbf{u} + bmathbf{v}) = aT(mathbf{u}) + bT(mathbf{v})$。

通过引入复数和极坐标等 概念,可以将某些函数图 像进行旋转。

微分方程中的线性变换

变量代换

通过适当的变量代换,可以将某些非线性微分方 程转化为线性微分方程,从而简化求解过程。

拉普拉斯变换

将时间域内的微分方程通过拉普拉斯变换转换到 频域内,从而方便求解和分析。

傅里叶变换

将时间域内的函数通过傅里叶变换转换到频域内 ,可以分析函数的频率特性和进行滤波等操作。

数乘保持性

对于任意标量$k$和向量$mathbf{v}$,线性变换$T$满足$T(kmathbf{v}) = kT(mathbf{v})$。

线性变换知识点总结

线性变换知识点总结一、引言线性变换是线性代数中的重要概念,它是在向量空间中的一种特殊映射。

线性变换具有许多重要的性质和应用,因此研究线性变换对于理解线性代数和应用数学有着重要的意义。

本文将从线性变换的基本概念、性质和应用进行总结,希望能够帮助读者对线性变换有更深入的理解。

二、线性变换的定义线性变换是向量空间之间的一种映射,具体来说,设V和W是两个向量空间,f:V→W是从V到W的映射。

如果对于V中的任意向量u、v和任意标量a,b,都有f(au+bv)=af(u)+bf(v)那么f称为一个线性变换。

三、线性变换的矩阵表示线性变换可以用矩阵来表示,假设V和W是n维向量空间,我们选择V和W的基,那么可以得到V和W中的向量可以用n维列向量表示。

设f:V→W是一个线性变换,选择V和W的基分别为{v1,v2,...,vn}和{w1,w2,...,wn},那么f的矩阵表示为[f]=(f(v1) f(v2) ... f(vn))其中f(vi)表示w中的基向量wi在f映射下的像,也就是f(vi)对应的列向量。

根据线性变换的定义,我们可以得到映射f的矩阵表示满足下列关系f(av1+bv2)=af(v1)+bf(v2)等价于[f](av1+bv2)=a[f]v1+b[f]v2其中[f]v1和[f]v2为f(v1)和f(v2)的列向量表示。

四、线性变换的性质1. 线性变换的保直性线性变换f:V→W将V中的任意向量线性映射到W中,这种映射保持向量之间的直线性质,即通过f映射后的图像仍然是一条直线。

这是线性变换的一个重要性质,它保证了线性变换后的图像具有一些有用的性质,比如直线上的点在f映射后仍然在同一条直线上。

2. 线性变换的局部性线性变换f:V→W保持向量之间的“相对位置”不变,即如果向量v1和v2之间的相对位置关系在V中是一定的,那么在映射f下,向量f(v1)和f(v2)之间的相对位置关系也是一定的。

这一性质对于理解线性变换的几何意义有着重要的作用,它意味着线性变换可以保持向量之间的某些几何性质。

最新-线性空间及线性变换-PPT文档资料

例6.1.4 (中南大学,2019年)设P是一个数域,A是Pn×n 中一个矩阵,令F(A)={f(A)|f(x)∈P[x]}.证明:

(4) 任一空间是数乘变换的不变子空间.

(5) 设W是线性空间V的子空间且W L(1,2, ,r),

则W是A的不变子空间当且仅当 / Ai W,i=1,2,…,r.

(6) 设V1是线性变换/A的不变子空间,则对任一多 项式f, V1是f(A)的不变子空间.

(7) 设/A和/B是线性变换且/A/B=/B/A, V 是/A的 特征子空间,则V 也是/B的不变子空间.

若这两个向量组都线性无关,则 L (1 ,2 , ,s ) L (1 ,2 , ,t)

的维数等于齐次方程组 x 1 1 x 2 2 x ss y 1 1 y 2 2 y tt 0

的解空间的维数.

证明:设W 1 1,2, ,s, W 21,2, ,t ,那么

若I,A,A2,…,Am线性相关,那么存在一组不全为零的 数k0,k1,…,km∈P,使得:

k0I+k1A+k2A2+…+kmAm=0.

令h(x)=k0+k1x+k2x2+…+kmxm,显然有h(A)=0且

(h (x) )m (m (x),) 这将与 m()是A的最小多项式矛盾.于

是I,A,A2,…,Am线性无关,那么I,A,A2,…,Am构成F(A)的

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

对角化

A B - 1 A B 1 0 1 1 0 11 2 1 0 1 1 0 1 0 2

设 B z 1z 2z n

其中{z1,z2,…,zn}是一个矩阵A的特征值。然后求

考虑一个线性变换: X→X(定义域和值域相同)。分别称 满足下式的那些不等于0的向量 和标量λ分别是特征 向量和特征值:

假设选择了n维向量空间X的一个基, 那么 或

现在,重新看看前面的旋转实例。如果采用标准基集,

那么变换的矩阵是

coθs sinθ Asinθ coθsλ

有

coθsλ sinθ

(1)一个被称为定义域的元素集合X={ }

(2)一个被称为值域的元素集合Y={ }

(3)一个将每个

和一个元素

相联系的

规则。

线性变换 一个变换 是线性的,如果

1)对所有的

2)对所有的

假设某个变换 是在二维空间 中将一个向量旋转 角,

如图6-2所示。图6-3和图6-4表示该旋转变换满足线性变 换定义中的条件1。图6-5表示旋转变换满足线性变换定 义中的条件2。

yA x 0 1..0 43 1 3 6 0 0 .6 .69 6 9 1 0 7 0 1..0 43 1 3 6

yB1y01.5

110.616 1 0.933

2/3 2/30.6161.033 1/3 2/30.93 30.416

这些向量表示在图6-10中。

6.2.4 特征值和特征向量 特征值 特征向量

1 1Leabharlann 5 1//3 6ssiiθ n θ n

4/3siθn 1/3siθncoθs

取θ=30°

A01..043137

0.667 0.699

0.866 0.5

A

0.5

0.866

为了检验这些矩阵是否正确,假设和 x

向量是: 1

1

0

相对应的测试

x

0

.5

变换后的测试向量是

0.86 60.51 0.61 6 yA x 0.5 0.86 0 6 .5 0.93 3

6.2.2 矩阵表示 设

个向量

是向量空间X的一个基底,

是向量空间Y的一个基。即是对任意两 ,有

设 是一个定义域为X值域为Y的线性变换 那么 可以写成

此式正好是下面形式的矩阵乘

a11 a12 a21 a22 am1 am2

a1nx1 y1

a2nx2 y2

amnxn

yn

下面将以旋转变换为例,来讨论变换的矩阵表示,看

λ2 3 λ 2 (λ 1 )λ( 2 ) 0

得特征值 λ1-1,λ2-2

为了找到其特征向量,求解

-1-λ

0

-21-λZ00

首先将λ1代入上式,可得

或

1

z1

0

将λ2代入,

或

1

z2

1

下面两式验证了结果的正确性:

1 11 1 1 A z1 0 2 0 0 ( 1 ) 0 λ1z1

向量

可写成

得到如下新的矩阵表示:

a11 a12 a21 a22 am1 am2

a1nx1 y1 a2nx2 y2

amnxn ym

或

A′(x′)=y′

那么,A和A’之间的关系是什么呢?要解答这个问题, 必须找出两个基集之间的关系。首先,由于每个ti是x的一 个元素,那么可以按照X原先基集的形式展开:

λ1 0 0

B-1 AB

定义一个列为wi的矩阵:Bw=[w1 w2 … wm] y=Bwy′

现在将X=x′1t1+x′2t2+…+x′ntn=Btx′ 和y=Bwy′代入到 Ax=y,可得

ABtX′=Bwy′

如果我们用Bw-1乘以上式的两边,有[Bw-1ABt]x′=y′

基变换

A′=[Bw-1ABt]

相似变换

现在利用基{t1,t2}找到一个新的矩阵表示(如图6-9所 示)。

其次,因为每个wi是Y的一个元素,所以也可以按照Y原 先基集的形式展开:

所以,基向量可以写成如下的列向量表示形式:

t 1 i

t ti

2 i

t ni

w 1 i

w w i

2i

w mi

定义一个列为ti的矩阵:Bt=[t1 t2 … tn] X=x′1t1+x′2t2+…+x′ntn=Btx′

sinθ

coθsλ 0

或 λ 2-2 λcos θ+((cos θ)2+(sin θ)2)= λ2-2 λcos θ+1=0

该等式的根是 λ1=cos θ+jsin θ, λ2=cos θ-jsin θ

考虑另外一个矩阵:

A

-1

0

1 -2

为了找到其特征值,必须求解 -1-λ 1

0

-2-λ 0

或

看 如何找到该变换的矩阵表示。这里的定义域和值域相

同(

)。为简单起见,对其采用标准基

如图6-6所示。

第1步是对第一个基向量进行变换,并且

以基向量的形式展开变换后的向量。如果

将向量s1逆时针旋转一个角度 ,可得

如图6-7所示。

第2步是对第二个基向量进行变换。如果将向量s2逆时针 旋转一个角度 ,可得 如图6-8所示。完整的矩阵表示可以由下式给出:

6.1 目的 本章接着第五章继续讨论神经网络分析所需要的数学

基础。第五章复习了有关向量空间的内容,本章将探讨在 神经网络中所采用的线性变换。 6.2 理论和实例

hopfield网络通过下式同步对网络输出进行修改

a(t+1)=satlin(Wa(t)+b)

6.2.1 线性变换

变换 一个变换由以下三部分组成

6.2.3 基变换

考虑一个线性变换:

是向量空间X的一个基, 一个基。所以有

。设 是向量空间Y的

所以,如果

那么变换 或

的矩阵表示形式是

a11 a12 a21 a22 am1 am2

a1nx1 y1

a2nx2

y2

amnxn ym

Ax=y

现在假设对X和Y使用不同的基集。设{t1,t2,…,tn}是X 的新基集,{w1,w2,…,wm}是Y的新基集。那么,向量 可写成

第一步,按照标准基的形式对t1和t2进行 展开。观察图6-9可知:t1=s1+0.5s2

t2=-s1+s2

t1

1

0

.5

1

t2

1

现在可以得到矩阵

Btt1

,

t201.5

1 1

1 1 BwBt 0.5 1

AB w1ABt 21//33

2/3coθssiθ n1 2/3siθ n coθs0.5