第3章_离散信源(1)题与答案

信息论与编码理论习题答案

信息论与编码理论习题答案LG GROUP system office room 【LGA16H-LGYY-LGUA8Q8-LGA162】第二章 信息量和熵八元编码系统,码长为3,第一个符号用于同步,每秒1000个码字,求它的信息速率。

解:同步信息均相同,不含信息,因此 每个码字的信息量为 2⨯8log =2⨯3=6 bit因此,信息速率为 6⨯1000=6000 bit/s掷一对无偏骰子,告诉你得到的总的点数为:(a) 7; (b) 12。

问各得到多少信息量。

解:(1) 可能的组合为 {1,6},{2,5},{3,4},{4,3},{5,2},{6,1})(a p =366=61得到的信息量 =)(1loga p =6log = bit (2) 可能的唯一,为 {6,6})(b p =361得到的信息量=)(1logb p =36log = bit 经过充分洗牌后的一副扑克(52张),问:(a) 任何一种特定的排列所给出的信息量是多少?(b) 若从中抽取13张牌,所给出的点数都不相同时得到多少信息量?解:(a) )(a p =!521信息量=)(1loga p =!52log = bit (b) ⎩⎨⎧⋯⋯⋯⋯花色任选种点数任意排列13413!13)(b p =1352134!13A ⨯=1352134C 信息量=1313524log log -C = bit 随机掷3颗骰子,X 表示第一颗骰子的结果,Y 表示第一和第二颗骰子的点数之和,Z 表示3颗骰子的点数之和,试求)|(Y Z H 、)|(Y X H 、),|(Y X Z H 、)|,(Y Z X H 、)|(X Z H 。

解:令第一第二第三颗骰子的结果分别为321,,x x x ,1x ,2x ,3x 相互独立,则1x X =,21x x Y +=,321x x x Z ++=)|(Y Z H =)(3x H =log 6= bit )|(X Z H =)(32x x H +=)(Y H=2⨯(361log 36+362log 18+363log 12+364log 9+365log 536)+366log 6= bit )|(Y X H =)(X H -);(Y X I =)(X H -[)(Y H -)|(X Y H ]而)|(X Y H =)(X H ,所以)|(Y X H = 2)(X H -)(Y H = bit或)|(Y X H =)(XY H -)(Y H =)(X H +)|(X Y H -)(Y H 而)|(X Y H =)(X H ,所以)|(Y X H =2)(X H -)(Y H = bit),|(Y X Z H =)|(Y Z H =)(X H = bit )|,(Y Z X H =)|(Y X H +)|(XY Z H =+= bit设一个系统传送10个数字,0,1,…,9。

信息论与编码习题与答案第三章

由于 ,每个二元符号的信息量为1bit,14000个符号14000bit的信息,传输14000bit的信息需要时间

不能无失真的传输

=

bit/symbol

(3)当接收为 ,发为 时正确,如果发的是 则为错误,各自的概率为:

则错误概率为:

(4)

从接收端看平均错误概率为

(5)从发送端看的平均错误概率为:

(6)能看出此信道不好。原因是信源等概率分布,从转移信道来看正确发送的概率x1→y1的概率0.5有一半失真;x2→y2的概率0.3有严重失真;x3→y3的概率0完全失真。

(1)接收端收到一个符号后得到的信息量H(Y);

(2)计算噪声熵 ;

(3)计算接收端收到一个符号 的错误概率;

(4)计算从接收端看的平均错误概率;

(5)计算从发送端看的平均错误概率;

(6)从转移矩阵中能看出该新到的好坏吗?

(7)计算发送端的H(X)和 。

解:(1)

(2)联合概率 ,后验概率

H(Y/X)=

解:由题意可知该二元信道的转移概率矩阵为: 为一个BSC信道所以由BSC信道的信道容量计算公式得到:

3-6设有扰离散信道的传输情况分别如图3-17所示。求出该信道的信道容量。

解:信道转移概率矩阵为P= 该信道为离散对称信道DMC

3-7发送端有三种等概率符号 , ,接收端收到三种符号 ,信道转移概率矩阵为

3.1设二元对称信道的传递矩阵为

(1)若P(0)= 3/4,P(1)= 1/4,求H(X), H(X/Y), H(Y/X)和I(X;Y);

(2)求该信道的信道容

其最佳输入分布为

3.3在有扰离散信道上传输符号0和1,在传输过程中每100个符号发生一个错误,已知P(0)=P(1)=1/2,信源每秒内发出1000个符号,求此信道的信道容量。

(信息论)第3章离散信源

k = 1, 2, L, N

② 连续无记忆信源 若在 N 维随机矢量 X 中,每个随机变量 X k 是连续随 机变量,且相互独立,则 N 维随机矢量 X 的联合概率密 度函数为

p (X ) = ∏ p k

k =1 N

6

有记忆信源

{

无限记忆信源

有限记忆信源

有限记忆信源可用有限状态马尔可夫链来描述。当信 源记忆长度为 m+1 时,也就是信源每次发出的符号仅与前 m 个符号有关,与更前面的符号无关。这样的信源称为 m 阶马尔可夫信源。此时可用条件概率分布描述信源的统计 特性。

H (X ) = E[I (xi )] = −∑ p(xi ) log p(xi )

i =1

q

(3.7)

信源熵 是从平均意义上表征信源总体统计特征的一个 量,是信源的统计平均不确定性的描述。

10

例:设信源符号集

1 率分别为 p ( x1 ) = , 2

X = {x1 , x2 , x3 , x4 }

k

或 a 2 的概率。

14

2、离散无记忆二进制信源 X 的三次扩展信源 、

N X 3 = ( X 1 , X 2 , X 3 ) 共输出 q 个消息 三次扩展信源

符号,q=2, N=3。所以二进制三次扩展信源的符号序列 共有8个, ai , i = 1, 2, L, 8。它可等效为一个具有8个消息 符号的新信源 X 。同时每个消息符号具有如下的概率分 布

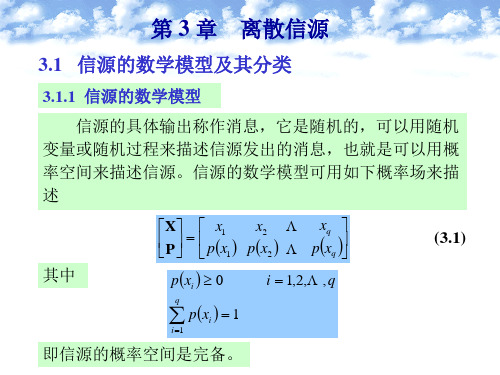

(3.1)

其中

p ( xi ) ≥ 0

i = 1,2,L, q

∑ p(x ) = 1

i =1 i

q

即信源的概率空间是完备。

1

① 离散信源的数学模型 其数学模型为离散型的概率空间:

第3章 离散信源

自信息的例子

【 例 , 增 】 一 信 源 有 4 种 输 出 符 号 码 , xi(i=0,1,2,3) , 且 p(xi)=1/4。设信源向信宿发出x3,但由于传输中的干扰,接 收者收到x3后,认为其可信度为0.9。于是信源再次向信宿发 送该符号x3,信宿无误收到。问: (1) 信源在两次发送中发出的信息量各是多少? (2) 信宿在两次接收中得到的信息量又各是多少?

• 得到信源的样本空间为符号集

X={x1, x2, x3, x4, x5, x6}。 各消息都是等概率出现的

X的概率分布就是各消息出现的先验概率:

p(x1)=p(x2)=p(x3)=p(x4)=p(x5)=p(x6)=1/6, 信源的数学模型为:

X P( X

)

1x/16

x2 1/ 6

x3 1/ 6

按照信源符号彼此之间的依存关系,离散信源又可分为: 离散无记忆信源和离散有记忆信源 • 离散无记忆信源:信源发出的一个个消息符号是相互 独立的。 - 前面已经出现的信源符号对后面将要出现哪个信源 符号没有影响; - 即:各符号序列中的各个符号之间是没有统计关联 的关系; - 各个符号的出现概率是它自身的先验概率。 - 离散无记忆信源包含发出单符号的无记忆离散信源 和发出符号序列的无记忆离散信源。

信源熵的例子1

【例3-5,P31】计算机中常见的信源是二元信源,二元 信源可以描述为

X 0 1 0 1

P

p

q

p

1 p

则二元信源的熵为

H(X ) p log p (1 p)log(1 p) • 如例3-3,p=1/2 H(X)=1比特/符号

说明

➢ 二元信源的信息熵H(X)是 概率p的函数,通常用H(p) 表示。

第3章 离散信源

时间长度为bi,则该信源的时间熵定义为:Ht(X)=H(X)/b. 其中b为信源符号的

平均时间长度。

M

b p( xi ) bi

i 1

s / 符号

离散信源的时间熵(续)

K重符号序列离散无记忆信源的时间熵:

K K Ht (X ) H(X ) / B

bit / s 其中B Kb

为K重符号序列消息的平均时间长度。由于信源无记忆,上式也可以写成:

bit / s

由于信源有记忆,所以有:

K ( H t X ) KH ( X ) (Kb) KH ( X ) /(Kb) H ( X ) / b

bit / s

有记忆信源与无记忆信源相比,对外提供信息量的速度下降了。

离散信源的时间熵(续)

马尔可夫信源的时间熵: 若信源从状态Si转移到状态Sj,发出的符号是xij,它的时间长度设为bij,则 信源从状态Si发生转移并发出一个符号时,符号的平均长度为:

信源分类

若离散信源输出符号彼此间相互独立,而且所有符号服从同一种概率分布,则称之 为简单无记忆信源;

若输出符号间彼此相关,且每个符号只与它前面的一个符号相关,而这种相关性可 以用符号间的转移概率来描述,则称之为马尔可夫信源。

离散信源的熵

单符号离散无记忆信源熵: 若信源X含有M个符号,而且每个符号相互独立,则当信源每次发送一个 符号代表一条消息时,其信源熵可以表示为:

H(X ) 100% H ( X )max

信源符号的相关性越大,信源效率越低,要提高信源效率,要设法降 低符号之间的相关性。

信源的效率与冗余度(续)

(2)信源冗余度:

H ( X )max H ( X ) H(X ) R 1 1 100% H ( X )max H ( X )max

第三章离散信源及离散熵

电子科技大学

H(X) = −∑p(xi )lbp(xi )

i =1

4

1 1 1 1 1 1 = − lb − lb − lb × 2 2 2 4 4 8 8

2011-3-13

1 1 1 1 1 1 = lb2 + lb4 + lb8 = + × 2 + × 3 2 4 4 2 4 4 bol = 1.75(bit / sym )

2011-3-13

1、离散平稳信源及其数学模型 对于多符号离散信源发出的符号序列 X1X2 L 如果任意两个不同时刻k …, 如果任意两个不同时刻k和l,k=1,2, …, l=1,2, …,其概率分布相同,即 …,其概率分布相同, P(Xk ) = P(Xl ) 则称该多符号离散信源为一维离散平稳 信源。 信源。

该信源的离散熵

2011-3-13

H(X1X2 ) = −∑p(ai )lbp(ai )

= −∑∑p(xi1 xi 2 )lbp(xi1 xi 2 )

i1 =1i 2 =1 n n n n

n2

电子科技大学

i =1

= −∑∑p(xi1 xi 2 )lbp(xi1 )p(xi 2 / xi1 )

i1 =1i 2 =1

电子科技大学

H(X) = −∑p(i)lbp(i)

i =1

6

1 1 bol = − lb × 6 = lb6 = 2.585(bit / sym ) 6 6

2011-3-13

例2,求某一天简单的天气气象这一信源 的离散熵。 的离散熵。 该信源的数学模型为: 解: 该信源的数学模型为:

) ) ) 雨 x1(晴 x2(阴 x3( ) x4(雪 X 1 1 1 P(X) = 1 2 4 8 8

高等教育《信息论》第3章离散信源

X

P

x1

px1

x2

px2

xq

p

xq

(3.5)8

信源输出信息量的度量

定义 3.2.2 设信源 X 中,事件 xi 发生的概率为 pxi ,

则所含有的自信息量定义为

de f

I xi log pxi

(3.6)

定义 3.2.2 给出的自信息量的函数形式有如下性质:

① 信源中信息的量度与输出符号发生的概率有关。

000, 001, 011, 111,100,110, 010,101

5

3.1.2 信源的分类 无记忆信源

① 离散无记忆信源 信源发出的消息符号彼此是统计独立的,并且具有

相同的概率分布,其 N 维随机矢量的联合概率分布为

N

N

p X p X k aik pik

k 1

k 1

i 1, 2, , q

其中 N 可为有限正整数或可数无穷值。通常,总限定 N 是有限的,故只限于讨论“有限离散信源”。若在这随机

矢量中的每个随机变量Xk , k 1, 2, , N 都是离散的,则可 用N重离散概率空间的数学模型来描述这类信源。

X

P

a1

pa1

a2

pa2

aqN p aqN

(3.4)

其中

9

自信息量 I xi 是指某一信源发出某一消息符号 xi 所含

有的信息量,所发出的信息符号不同,它们含有的信息量

也就各不相同,故自信息量 I xi 是一个随机变量,不能用

它来作为整个信源输出信息的信息测度。为此,需要引入 平均自信息量,即信息熵来作为信源输出信息的信息测度。

定义 3.2.3 信源输出的各消息的自信息量的数学期望为 信源的平均自信息量,或称为信源的信息熵。

信息论与编码姜丹第三版答案

信息论与编码习题参考答案 第一章单符号离散信源信息论与编码作业是 74页,1.1的(1)(5),1.3,1.4,1.6,1.13,1.14 还有证明熵函数的 连续性、扩展性、可加性1.1同时掷一对均匀的子,试求:(1) “2和6同时出现”这一事件的自信息量; (2) “两个5同时出现”这一事件的自信息量; (3) 两个点数的各种组合的熵; ⑷两个点数之和的熵;(5) “两个点数中至少有一个是 1”的自信息量。

解:样本空间:N =c ;c ; =6 X6 =36n 12(1) R =—”1(a) =—log R =log18=4.17bitN 36 n 2 1(2) F 2 N =36 I (a) = -log F 2 =log36 =5.17bit (3) 信源空间:2 36 1.H(x)=15 log 6 log 36 = 4.32bit36 2 36(4)log 36+ — l og 36 — log 36 — log 迸36 2 36 3 36 4 log 塑 + — log 36 =3.71bit5 36 6 (5) F 3 =匹 二11. 1(a) - Tog F 3 -log 36 =1.17bit N 36 111.2如有6行、8列的棋型方格,若有两个质点A 和B ,分别以等概落入任一方格内,且它2H(r.卫36们的坐标分别为(Xa,Ya) , (Xb,Yb),但A,B不能同时落入同一方格内。

(1)若仅有质点A,求A落入任一方格的平均信息量;(2)若已知A已落入,求B落入的平均信息量;(3)若A,B是可辨认的,求A,B落入的平均信息量。

解:1(1) 幕A落入任一格的概率:P(a i) I (aj =-log P(aJ = log 484848.H(a) - P(a j)log P(aJ = log 48 =5.58biti 41(2) ;在已知A落入任一格的情况下,B落入任一格的概率是:P(bJ = —47.I(b) - -logP(b i) =log4748.H(b) = -' P(b i)log P(b i) =log47 =5.55biti -11 1(3) AB同时落入某两格的概率是P(ABJ二一一48 47.I(ABJ =-log P(AB i)48 47H(AB」-八P(ABJIog P(ABJ =log(48 47)=11.14biti 二1.3从大量统计资料知道,男性中红绿色盲的发病率为7%,女性发病率为0.5%.如果你问一位男士:“你是否是红绿色盲?”他的回答可能是:“是”,也可能“不是”。

第3章-离散信源(1)题与答案

3.1 设有一离散无记忆信源,其概率空间为⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。

求:(1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解: (1)此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2)此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==3.2 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡4/34/110)(X P X(1) 求信息符号的平均熵;(2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。

解: (1)bit x p x p X H ii i 811.043log 4341log 41)(log )()(=⎪⎭⎫ ⎝⎛+-=-=∑(2)bit m x p x I x p mi i m mm i 585.15.4143log)(log )(434341)(100100100100100+=-=-==⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=---(3)bit X H X H 1.81811.0100)(100)(100=⨯==3.5 某信源的消息符号集的概率分布和二进制代码如题表3.2所列。

题表 3.2(1) (2) 求每个消息符号所需要的平均二进制码的个数或平均代码长度。

进而用这一结果求码序列中的一个二进制码的熵;(3) 当消息是由符号序列组成时,各符号之间若相互独立,求其对应的二进制码序列中出现0和1的无条件概率0p 和1p ,求相邻码间的条件概率1/0p 、0/1p 、1/1p 、0/0p 。

《信息论与编码基础》唐朝京 课后答案

H ( X N ) = NH ( X ) = 1000 × 13.288 = 13288 bit / symbol

N=

w.

H ( X N ) 2.1 × 10 6 = = 158037 H (X ) 13.288

课

后

i

∑ p( x ) = 1.07 > 1 。

i

6

答

案 网

= −(0.2 log 2 0.2 + 0.19 log 2 0.19 + 0.18 log 2 0.18 + 0.17 log 2 0.17 + 0.16 log 2 0.16 + 0.17 log 2 0.17)

' p1' = p1 − ε , p 2 = p 2 + ε ,其中 0 < 2ε ≤ p1 − p 2 ,而其他概率值不变。试证明由

此所得新的概率空间的熵是增加的,并用熵的物理意义作以解释。

证: H = H ( P 1 LP 1 log P 1 −P 2 log P 2 − q ) = −P

课

后

H ' = H (P q) 1 −ε, P 2 + ε, P 3LP

案 网

x2(不是大学生) 0.75

课后答案网

2.3 掷两颗骰子,当其向上的面的小圆点之和是 3 时,该消息包含的信息量是多 少?当小圆点之和是 7 时,该消息所包含的信息量又是多少?

解: 1)因圆点之和为 3 的概率 p ( x ) = p (1, 2) + p (2,1) =

解: 1)

H ( X ) = log 2 n = log 2 128 = 7 bit / symbol

ww

2) 3)

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

3.1 设有一离散无记忆信源,其概率空间为⎭⎬⎫⎩⎨⎧=====⎥⎦⎤⎢⎣⎡8/14/1324/18/310)(4321x x x x X P X 该信源发出的信息序列为(202 120 130 213 001 203 210 110 321 010 021 032 011 223 210)。

求:(1) 此消息的自信息量是多少?(2) 此消息中平均每符号携带的信息量是多少?解: (1)此消息总共有14个0、13个1、12个2、6个3,因此消息发出的概率是:62514814183⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=p此消息的信息量是:bit p I 811.87log =-=(2)此消息中平均每符号携带的信息量是:bit n I 951.145/811.87/==3.2 某一无记忆信源的符号集为{0, 1},已知信源的概率空间为⎭⎬⎫⎩⎨⎧=⎥⎦⎤⎢⎣⎡4/34/110)(X P X(1) 求信息符号的平均熵;(2) 由100个符号构成的序列,求某一特定序列(例如有m 个“0”和(100 - m )个“1”)的自信息量的表达式; (3) 计算(2)中序列的熵。

解: (1)bit x p x p X H ii i 811.043log 4341log 41)(log )()(=⎪⎭⎫ ⎝⎛+-=-=∑(2)bit m x p x I x p mi i m mm i 585.15.4143log)(log )(434341)(100100100100100+=-=-==⎪⎭⎫ ⎝⎛⨯⎪⎭⎫ ⎝⎛=---(3)bit X H X H 1.81811.0100)(100)(100=⨯==3.5 某信源的消息符号集的概率分布和二进制代码如题表3.2所列。

题表 3.2(1) (2) 求每个消息符号所需要的平均二进制码的个数或平均代码长度。

进而用这一结果求码序列中的一个二进制码的熵;(3) 当消息是由符号序列组成时,各符号之间若相互独立,求其对应的二进制码序列中出现0和1的无条件概率0p 和1p ,求相邻码间的条件概率1/0p 、0/1p 、1/1p 、0/0p 。

解: (1)bit x p x p X H ii i 75.181log 8181log 8141log 4121log 21)(log )()(=⎪⎭⎫ ⎝⎛+++-=-=∑(2)bit X H LX H N X H l x p l E L N ii i i 1)(1)(1)(75.1381381241121)()(====⨯+⨯+⨯+⨯===∑(3)设消息序列长为N ,则0u 、1u 、2u 、3u 的个数分别为8/ ,8/ ,4/ ,2/N N N N 个。

则0的个数为8708181412NN N N N =⨯+⨯+⨯+⨯ 而1的个数为8738281402NN N N N =⨯+⨯+⨯+⨯因而5.010==p p212141/ 21212121/21212121/ 212141/1111/11010/10000/01101/0====⨯===⨯=====p p p p p p p p p p p p3.7 设有一个信源,它产生0,1序列的信息。

该信源在任意时间而且不论以前发生过什么消息符号,均按P(0) = 0.4,P(1) = 0.6的概率发出符号。

(1) 试问这个信源是否是平稳的;(2) 试计算H(X 2), H(X 3/X 1X 2)及H ∞;(3) 试计算H(X 4)并写出X 4信源中可能有的所有符号。

解: (1)这个信源是平稳无记忆信源。

因为有这些词语:“它在任意时间....而且不论以前发生过什么符号...........……” (2)bitX H X X X X H H bit x p x p X H X X X H bitX H X H N N N N ii i 971.0)().../(lim 971.0)6.0log 6.04.0log 4.0()(log )()()/( 942.1)6.0log 6.04.0log 4.0(2)(2)(12132132====+-=-===+⨯-==-∞>-∞∑(3)1111111011011100101110101001100001110110010101000011001000010000的所有符号: 884.3)6.0log 6.04.0log 4.0(4)(4)(44X bit X H X H =+⨯-==3.11 有一马尔可夫信源,已知转移概率为3/2)/(11=S S p ,3/1)/(12=S S p ,1)/(21=S S p ,0)/(22=S S p 。

试画出状态转移图,并求出信源熵。

解:bitS S p S S p S p H S p S p S p S p S p S p S p S p S p S p S p S S p S p S S p S p S p S S p S p S S p S p S p iji j i j i 689.0 31log 314332log 3243 )/(log )/()(4/1)(4/3)(1)()()(31)()(31)()()(32)()/()()/()()()/()()/()()(2121121221112122222121111=⎪⎭⎫ ⎝⎛⨯+⨯-=-=⎩⎨⎧==⎪⎩⎪⎨⎧=+=⎪⎪⎩⎪⎪⎨⎧=+=⎩⎨⎧+=+=∑∑∞2/33.21黑白传真机的信息元只有黑色和白色两种X ={黑,白},一般气象图上黑色出现的概率为P(黑) = 0.3,白色出现的概率为P(白) = 0.7,黑白消息前后没有关联,其转移概率为P(白/白) = 0.9,P(黑/白) = 0.1,P(白/黑) = 0.2,P(黑/黑) = 0.8。

求该一阶马尔可夫信源的不确定性H(X/X),并画出该信源的状态转移图。

解:bitS S p S S p S p H S p S p S p S p S p S p S p S p S p S p S p S p S S p S p S S p S p S p S S p S p S S p S p S p iji j i j i 553.0 9.0log 9.0321.0log 1.0322.0log 2.0318.0log 8.031 )/(log )/()(3/2)(3/1)(1)()()(2)()(2.0)(9.0)()(1.0)(8.0)()/()()/()()()/()()/()()(21211212221112122222121111=⎪⎭⎫⎝⎛⨯+⨯+⨯+⨯-=-=⎩⎨⎧==⎩⎨⎧=+=⎩⎨⎧+=+=⎩⎨⎧+=+=∑∑∞3.23 设信源产生A, B, C 三种符号2/1)/(=B B p ,4/1)/()/(==B C p B A p ,8/5)/(=A A p ,4/1)/(=A B p ,8/1)/(=A C p ,8/5)/(=C C p ,4/1)/(=C B p ,8/1)/(=C A p 。

试计算冗余度。

解:⎪⎪⎪⎩⎪⎪⎪⎨⎧++=++=++=)(85)(41)(81)()(41)(21)(41)()(81)(41)(85)(C B A C C B A B C B A A s p s p sp s p s p s p s p s p s p s p s p s pp(黑/黑)=0.8S 1S 2p(白/白)=0.9138.03log 366.111 366.1 85log 853141log 413181log 8131 41log413121log 213141log 4131 81log813141log 413185log 8531 )/(log )/()(3/1)(3/1)(3/1)(1)()()()()()(0333=-=-==⎥⎦⎤⨯+⨯+⨯+⨯+⨯+⨯+⎢⎣⎡⨯+⨯+⨯-=-=⎪⎩⎪⎨⎧===⎩⎨⎧=++==∞∞∑∑∑H H R bit p e e p e e p e p H s p s p s p s p s p s p s p s p s p ijki j i j i CB AC B A C B A3.26 一阶马尔可夫信源的状态图如下图所示。

信源X 的符号集为{0, 1, 2}。

(1) 求平稳后信源的概率分布; (2) 求信源的熵H ∞。

解: (1)⎪⎪⎪⎩⎪⎪⎪⎨⎧+=+=+=)(43)(31)()(41)(32)()(41)(43)(323122311s p s p s p s p s p s p s p s p s p⎪⎩⎪⎨⎧===⎪⎩⎪⎨⎧==11/4)(11/3)(11/4)()(43)()()(3211231s p s p s p s p s p s p s p(2)bite e p e e p e p H ijki j i j i 840.0 43log 4311441log 41114 31log3111332log 32113 41log4111443log 43114 )/(log )/()(333=⎥⎦⎤⨯+⨯+⨯+⨯+⎢⎣⎡⨯+⨯-=-=∑∑∑∞。