linux挂载阵列

Linux下查看Raid磁盘阵列信息的方法

Linux下查看Raid磁盘阵列信息的⽅法Linux下查看软、硬raid信息的⽅法。

软件raid:只能通过Linux系统本⾝来查看cat /proc/mdstat可以看到raid级别,状态等信息。

硬件raid:最佳的办法是通过已安装的raid⼚商的管理⼯具来查看,有cmdline,也有图形界⾯。

如Adaptec公司的硬件卡就可以通过下⾯的命令进⾏查看:# /usr/dpt/raidutil -L all可以看到⾮常详细的信息。

当然更多情况是没有安装相应的管理⼯具,只能依靠Linux本⾝的话⼀般我知道的是两种⽅式:# dmesg |grep -i raid# cat /proc/scsi/scsi显⽰的信息差不多,raid的⼚商,型号,级别,但⽆法查看各块硬盘的信息。

另外经过实际测试,Dell的服务器可以通过命令来显⽰,⽽HP、IBM等的服务器通过上⾯的命令是显⽰不出的。

只能够通过装硬件⼚商的管理⼯具来查看。

cat /proc/scsi/scsi可以看到是SCSI上的设备。

⼀般情况可以看到RAID级别。

lspci可以看到RAID卡的型号。

==========================================================rpm -ivh MegaCli-1.01.09-0.i386.rpm命令使⽤:MegaCli -LDInfo -Lall -aALL 查raid级别MegaCli -AdpAllInfo -aALL 查raid卡信息MegaCli -PDList -aALL 查看硬盘信息MegaCli -AdpBbuCmd -aAll 查看电池信息MegaCli -FwTermLog -Dsply -aALL 查看raid卡⽇志MegaCli常⽤参数介绍MegaCli -adpCount 【显⽰适配器个数】MegaCli -AdpGetTime –aALL 【显⽰适配器时间】MegaCli -AdpAllInfo -aAll 【显⽰所有适配器信息】MegaCli -LDInfo -LALL -aAll 【显⽰所有逻辑磁盘组信息】MegaCli -PDList -aAll 【显⽰所有的物理信息】MegaCli -AdpBbuCmd -GetBbuStatus -aALL |grep ‘Charger Status’ 【查看充电状态】MegaCli -AdpBbuCmd -GetBbuStatus -aALL【显⽰BBU状态信息】MegaCli -AdpBbuCmd -GetBbuCapacityInfo -aALL【显⽰BBU容量信息】MegaCli -AdpBbuCmd -GetBbuDesignInfo -aALL 【显⽰BBU设计参数】MegaCli -AdpBbuCmd -GetBbuProperties -aALL 【显⽰当前BBU属性】MegaCli -cfgdsply -aALL 【显⽰Raid卡型号,Raid设置,Disk相关信息】磁带状态的变化,从拔盘,到插盘的过程中。

-linux挂载磁盘阵列

linux挂载磁盘阵列在许多项目中,都会把数据存放于磁盘阵列,以确保数据安全或者实现负载均衡。

在初始安装数据库系统和数据恢复时,都需要先挂载磁盘阵列到系统中。

本文记录一次在linux系统中挂载磁盘的操作步骤,以及注意事项。

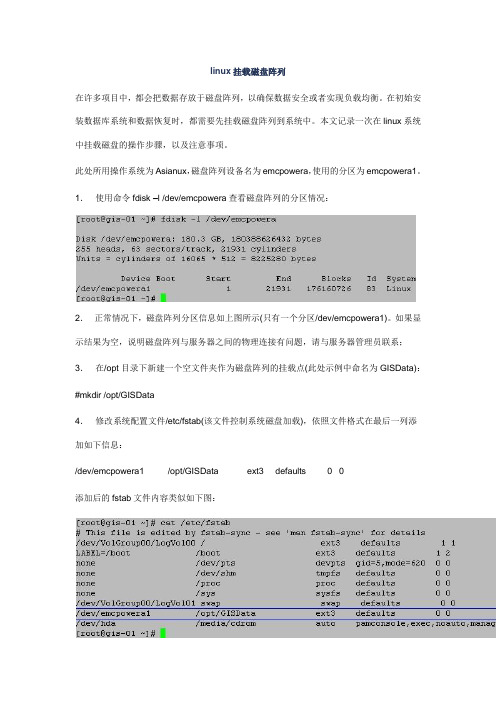

此处所用操作系统为Asianux,磁盘阵列设备名为emcpowera,使用的分区为emcpowera1。

1.使用命令fdisk –l /dev/emcpowera查看磁盘阵列的分区情况:2.正常情况下,磁盘阵列分区信息如上图所示(只有一个分区/dev/emcpowera1)。

如果显示结果为空,说明磁盘阵列与服务器之间的物理连接有问题,请与服务器管理员联系;3.在/opt目录下新建一个空文件夹作为磁盘阵列的挂载点(此处示例中命名为GISData):#mkdir /opt/GISData4.修改系统配置文件/etc/fstab(该文件控制系统磁盘加载),依照文件格式在最后一列添加如下信息:/dev/emcpowera1 /opt/GISData ext3 defaults 0 0添加后的fstab文件内容类似如下图:5.重启机器后登录系统,使用命令df –lhT –B G查看当前的文件系统:6.正常情况下,显示的文件系统信息如上图所示,则挂载磁盘阵列成功;若显示的结果中不包含磁盘阵列分区信息,则磁盘阵列挂载失败,请与服务器管理员联系。

注意事项:挂载好磁盘阵列,在数据库服务器运行过程中,如果发生断电后自动重启,则会发现数据库无法加载数据,也找不到磁盘阵列。

这时可以再手动启动服务器一次,便能顺利加载磁盘阵列。

个人推测可能是在来电后磁盘阵列和服务器同时自动启动,但因为磁盘阵列的启动速度不如服务器,所以服务器加载磁盘阵列失败。

不用软驱,在CentOS linux上也能安装RAID驱动程序

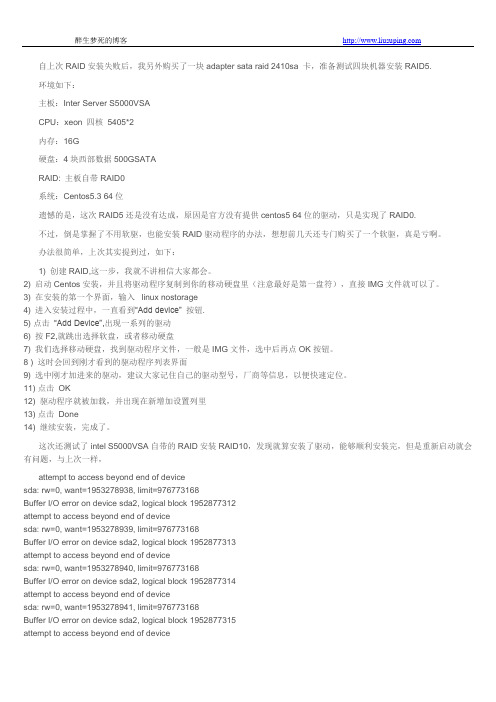

自上次RAID安装失败后,我另外购买了一块adapter sata raid 2410sa 卡,准备测试四块机器安装RAID5.环境如下:主板:Inter Server S5000VSACPU:xeon 四核5405*2内存:16G硬盘:4块西部数据500GSATARAID: 主板自带RAID0系统:Centos5.3 64位遗憾的是,这次RAID5还是没有达成,原因是官方没有提供centos5 64位的驱动,只是实现了RAID0.不过,倒是掌握了不用软驱,也能安装RAID驱动程序的办法,想想前几天还专门购买了一个软驱,真是亏啊。

办法很简单,上次其实提到过,如下:1) 创建RAID,这一步,我就不讲相信大家都会。

2) 启动Centos安装,并且将驱动程序复制到你的移动硬盘里(注意最好是第一盘符),直接IMG文件就可以了。

3) 在安装的第一个界面,输入linux nostorage4) 进入安装过程中,一直看到“Add device” 按钮.5) 点击“Add Device”,出现一系列的驱动6) 按F2,就跳出选择软盘,或者移动硬盘7) 我们选择移动硬盘,找到驱动程序文件,一般是IMG文件,选中后再点OK按钮。

8 ) 这时会回到刚才看到的驱动程序列表界面9) 选中刚才加进来的驱动,建议大家记住自己的驱动型号,厂商等信息,以便快速定位。

11) 点击OK12) 驱动程序就被加载,并出现在新增加设置列里13) 点击Done14) 继续安装,完成了。

这次还测试了intel S5000VSA自带的RAID安装RAID10,发现就算安装了驱动,能够顺利安装完,但是重新启动就会有问题,与上次一样,attempt to access beyond end of devicesda: rw=0, want=1953278938, limit=976773168Buffer I/O error on device sda2, logical block 1952877312attempt to access beyond end of devicesda: rw=0, want=1953278939, limit=976773168Buffer I/O error on device sda2, logical block 1952877313attempt to access beyond end of devicesda: rw=0, want=1953278940, limit=976773168Buffer I/O error on device sda2, logical block 1952877314attempt to access beyond end of devicesda: rw=0, want=1953278941, limit=976773168Buffer I/O error on device sda2, logical block 1952877315attempt to access beyond end of devicesda: rw=0, want=1953278942, limit=976773168Buffer I/O error on device sda2, logical block 1952877316attempt to access beyond end of devicesda: rw=0, want=1953278943, limit=976773168Buffer I/O error on device sda2, logical block 1952877317attempt to access beyond end of devicesda: rw=0, want=1953278944, limit=976773168Buffer I/O error on device sda2, logical block 1952877318attempt to access beyond end of devicesda: rw=0, want=1953278945, limit=976773168Buffer I/O error on device sda2, logical block 1952877319attempt to access beyond end of devicesda: rw=0, want=1953278938, limit=976773168Buffer I/O error on device sda2, logical block 1952877312由此,我判断是自带的RAID不支持,4块500G硬盘构成的将近1T的容量,其实还是觉得奇怪,可事实如此,哎.除非这块主板有问题。

Linux系统挂载硬盘

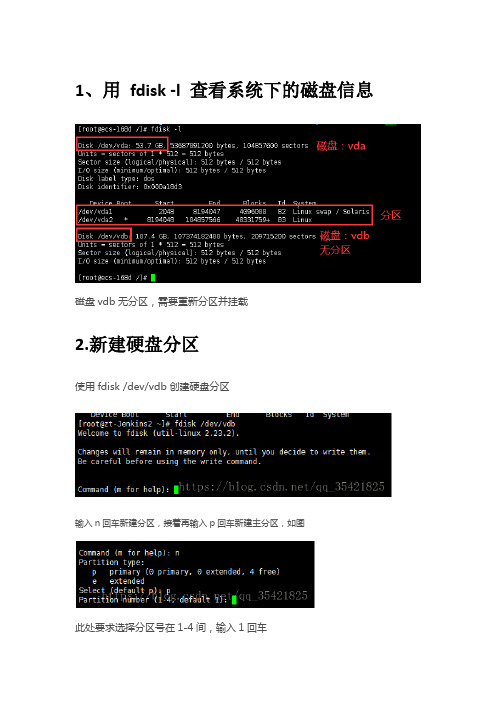

1、用fdisk -l 查看系统下的磁盘信息

磁盘vdb无分区,需要重新分区并挂载

2.新建硬盘分区

使用fdisk /dev/vdb创建硬盘分区

输入n回车新建分区,接着再输入p回车新建主分区,如图

此处要求选择分区号在1-4间,输入1回车

First cylinder (1-2610, default 1):这里是设置分区起始的柱面,直接回车选择默认即可,回车后如下图

Last cylinder, +cylinders or +size{K,M,G}(1-2610, default 2610):此处是设置分区结束柱面,直接回车选择默认即可.完成后输入p查看分区是否成功,输入p回车,如下图:显示分区成功

最后输入w回车,进行保存退出。

现在再用fdisk –l查看磁盘分区情况

3、使用mkfs -t ext3 /dev/vdb1 格式化分区为ext3格式。

4、挂在磁盘到/yonyou目录下

使用mkdir /yonyou 创建目录

使用mount /dev/vdb1 /yonyou将磁盘挂载到yonyou目录

mount查看挂载详情

5、修改yonyou目录权限

使用chmod -R 777 /yonyou修改目录权限为可写

6、如果想让服务器重启后,挂载的磁盘不需要重新挂载,可以使用vim /etc/fstab

仿照此文件之前存在的去进行添加:磁盘名挂载的目录格式化的格式defaults 1 1

编辑后保存并退出

/dev/vdb1 /yonyou ext3 defaults 1 1

建议最好重启一次服务器保证磁盘已挂载正常。

linux系统磁盘管理(磁盘阵列)

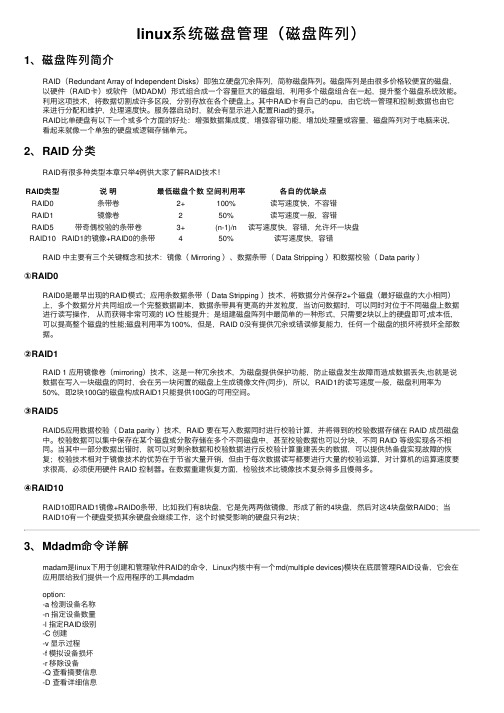

linux系统磁盘管理(磁盘阵列)1、磁盘阵列简介RAID(Redundant Array of Independent Disks)即独⽴硬盘冗余阵列,简称磁盘阵列。

磁盘阵列是由很多价格较便宜的磁盘,以硬件(RAID卡)或软件(MDADM)形式组合成⼀个容量巨⼤的磁盘组,利⽤多个磁盘组合在⼀起,提升整个磁盘系统效能。

利⽤这项技术,将数据切割成许多区段,分别存放在各个硬盘上。

其中RAID卡有⾃⼰的cpu,由它统⼀管理和控制;数据也由它来进⾏分配和维护,处理速度快。

服务器启动时,就会有显⽰进⼊配置Riad的提⽰。

RAID⽐单硬盘有以下⼀个或多个⽅⾯的好处:增强数据集成度,增强容错功能,增加处理量或容量,磁盘阵列对于电脑来说,看起来就像⼀个单独的硬盘或逻辑存储单元。

2、RAID 分类RAID有很多种类型本章只举4例供⼤家了解RAID技术!RAID类型说明最低磁盘个数空间利⽤率各⾃的优缺点RAID0条带卷2+100%读写速度快,不容错RAID1镜像卷250%读写速度⼀般,容错RAID5带奇偶校验的条带卷3+(n-1)/n读写速度快,容错,允许坏⼀块盘RAID10RAID1的镜像+RAID0的条带450%读写速度快,容错RAID 中主要有三个关键概念和技术:镜像( Mirroring )、数据条带( Data Stripping )和数据校验( Data parity )①RAID0RAID0是最早出现的RAID模式;应⽤条数据条带( Data Stripping )技术,将数据分⽚保存2+个磁盘(最好磁盘的⼤⼩相同)上,多个数据分⽚共同组成⼀个完整数据副本,数据条带具有更⾼的并发粒度,当访问数据时,可以同时对位于不同磁盘上数据进⾏读写操作,从⽽获得⾮常可观的 I/O 性能提升;是组建磁盘阵列中最简单的⼀种形式,只需要2块以上的硬盘即可;成本低,可以提⾼整个磁盘的性能;磁盘利⽤率为100%,但是,RAID 0没有提供冗余或错误修复能⼒,任何⼀个磁盘的损坏将损坏全部数据。

Linux上实现RAID5

在linux中实现raid5主要目的:实现磁盘阵列保证数据文件的冗余性!需要的磁盘个数:三块以上我们在这里添加六块硬盘其中四块做磁盘阵列,1块做预备(spare)磁盘,还有一块留作备用注意:raid5 的磁盘使用率是N-1 也就是说四个100G的硬盘可用空间是300G。

实验步骤:1.查看一下系统中的磁盘设备fdisk –l2.接下来创建raid了使用的命令是mdadm,如果没有请先安装mdadm软件包Rhel5的光盘中有!mdadm --create --auto=yes /dev/md0 --level=5 --raid-devices=4 --spare-devices=1/dev/sd[b-f]参数解释:--create//表示要创建raid--auto=/yes /dev/md0//新建立的软件磁盘陈列设备为md0,md序号可以为0-9--level=5 //磁盘阵列的等级,这里是reid5--raid-devices //添加作为预备(spare)磁盘的块数/dev/sd[b-f] //磁盘阵列所使用的设备,还可以写成“/dev/sdb/dev/sdd /dev/sde /dev/sdf”同样可以缩写为:mdadm –C/dev/md0 –l5 –n4 –x1 /dev/sd[b-f]查看RAID是否成功的创建是否运行的正常,有两种方法查看详细信息:mdadm --detail /dev/md0命令查看RAID的详细信息较为简单的查看:可以直接查看/proc/mdstat 的文件看到RAID运行的情况cat /proc/mdstat格式化并且挂载和使用创建的RAIDmkfs.exe3 /dev/md0 //格式化raid5磁盘为mkfs.exemikdir /mnt/raid5//在/mnt下创建/raid5 文件夹,用于挂载md0的mount /dev/md0 /mnt/raid5//将md0 挂载到raid5上去查看一下挂载情况df –hT试一下新加上的RAID是不是可以使用,向里面写入文件设置开机自动启动RAID以及自动挂载让RAID开机启动,RIAD配置文件名字为mdadm.conf , 这个文件默认是不存在的,要自己建立.该配置文件存在的主要作用是系统启动的时候能够自动加载软RAID,同时也方便日后管理. 说明下,mdadm.conf文件主要由以下部分组成:DEVICES选项制定组成RAID所有设备, ARRAY选项指定阵列的设备名、RAID级别、阵列中活动设备的数目以及设备的UUID号. 自动启动raid先建立/etc/mdadm.conf 这个文件mdadm --detail --scan > /etc/mdadm.conf要对这个文件做一下改动:vi /etc/mdadm.conf在设置RAID的自动挂载修改文件vi /etc/fstab在里面加上一行/dev/md0 /mnt/raid5 ext3 defaults 0 0模拟RAID5中的磁盘损坏,验证spare磁盘的功能(在raid5中允许一块磁盘的损坏,也就是我们设置的spare磁盘会立即的替换坏掉的磁盘进行raid的重建,保障数据的安全性):mdadm –manage /dev/md0 –fail /dev/sdd //使用此命令设置sdd成为出错的状态再来查看一下磁盘的信息:mdadm –-detail /dev/md0简单的查看一下RAID的情况:创建完成也就是说明raid5 已经自动的恢复了!查看一下raid5是不是可以正常使用!向里面写写数据。

磁盘阵列(IPSAN)挂载Windows和Linux测试过程

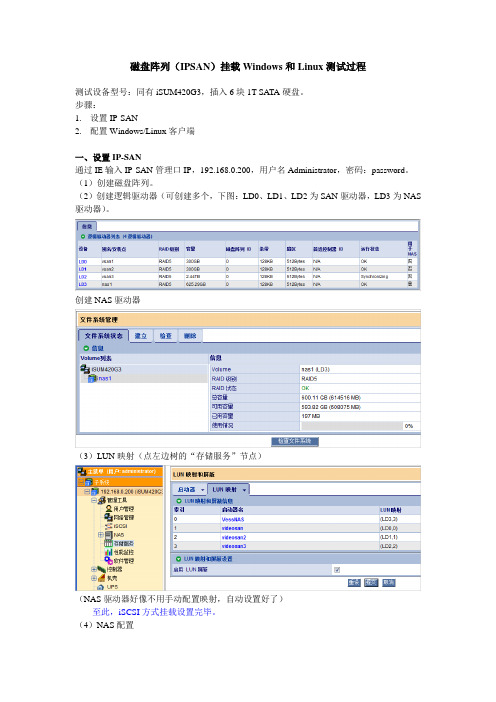

磁盘阵列(IPSAN)挂载Windows和Linux测试过程测试设备型号:同有iSUM420G3,插入6块1T SATA硬盘。

步骤:1.设置IP-SAN2.配置Windows/Linux客户端一、设置IP-SAN通过IE输入IP-SAN管理口IP,192.168.0.200,用户名Administrator,密码:password。

(1)创建磁盘阵列。

(2)创建逻辑驱动器(可创建多个,下图:LD0、LD1、LD2为SAN驱动器,LD3为NAS 驱动器)。

创建NAS驱动器(3)LUN映射(点左边树的“存储服务”节点)(NAS驱动器好像不用手动配置映射,自动设置好了)------至此,iSCSI方式挂载设置完毕。

(4)NAS配置●创建NAS用户●在协议控制中可以启动所需的服务(若启用NAS,配置Windows(CIFS)协议即可):●文件共享中可设置共享文件夹。

(此时windows客户端直接用\\192.168.0.201访问共享目录即可)二、Windows/Linux客户端设置1、WinXP/2003中连接iSCSI需要安装iSCSI Initiator(从微软网站上下载最新的,如Initiator-2.08-build3825-x86fre.exe)。

安装后启动:(1)在Gereral中设置启动器名(Initiator Node Name)。

※必须与IP-SAN里面配置的启动器名一致!Windows iSCSI Initiator(2)Discovery中输入IP-SAN数据口IP。

也可以点Advanced设置相关信息:(3)在target页面中连接。

(4)在Windows管理→磁盘管理中可发现新的磁盘。

(注意WinXP下无法挂载2T以上的驱动器,因此如果IPSAN里设置的驱动器大小超过2T,XP磁盘管理将无法发现新磁盘!)。

上面的磁盘分区类型为GPT磁盘,可转换为MBR磁盘(最大分区为2T)。

Linux下Raid配置详细过程(图文)

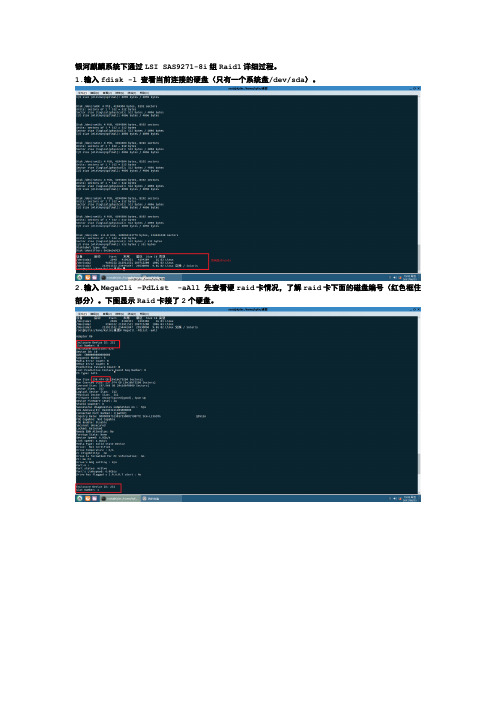

银河麒麟系统下通过LSI SAS9271-8i组Raid1详细过程。

1.输入fdisk -l 查看当前连接的硬盘(只有一个系统盘/dev/sda)。

2.输入MegaCli –PdList -aAll 先查看硬raid卡情况,了解raid卡下面的磁盘编号(红色框住部分)。

下图显示Raid卡接了2个硬盘。

3.输入命令“MegaCli –CfgLdAdd –r1 [252:0, 252:1] Direct –a0”将当前Raid卡上的2个硬盘组成Raid1。

4.使用命令“MegaCli –CfgDsply -a0”查看配置后的RAID信息。

如下图红色部位显示当前的Raid类型为Raid1。

4.使用命令“MegaCli -LdInit -start –full -l0 -a0”初始化Raid。

5.使用命令“MegaCli -LdInit –showprog -l0 -a0”查看初始化进度。

6.初始化完成后在系统设备节点下新增一设备 /dev/sdb,即为当前创建成功的Raid1。

7.通过命令“fdisk /dev/sdb”来创建分区,通过mount /dev/sdb /mnt 挂载设备。

注意:

创建Raid时如果遇到“the specified physical disk does not have the

appropriate attributes to。

”

1.执行MegaCli –PDMakeGood –PhysDrv ‘[252:0,252:1]’ –Force –aAll (清除硬盘

为Good状态)。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

1.在linux机器上使用磁阵当磁阵配置完毕后,该磁阵在linux操作系统看来,就是一个磁盘,即外接磁阵或内置磁盘在linux机器上的使用是完全相同的。

在/dev目录下应能看见该磁阵的设备文件。

例如,在linux 机器上原只有一个SCSI磁盘/dev/sda,现在增加了一个SCSI磁阵dev/sdb,这个/dev/sdb设备文件就是已同linux机器连接的磁阵。

如果看不到该设备文件,则需查找原因。

如果linux机器不在运行业务,应重启机器。

要能够使用磁阵(磁盘),必须要经过3个步骤:磁盘分区,分区格式化,文件系统挂载到某一目录。

(1)磁盘分区先检查所有linux已识别的所有磁盘的状态:[root@ftpnode2 ~]# fdisk -lDisk /dev/sda: 146.6 GB, 146685296640 bytes255 heads, 63 sectors/track, 17833 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 13 104391 83Linux/dev/sda2 14 17833 143139150 8eLinux LVMDisk /dev/sdb: 1796.7 GB, 1796776919040 bytes255 heads, 63 sectors/track, 218445 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDisk /dev/sdb doesn't contain a valid partition table磁阵/dev/sdb还没有分区,需要对其进行分区。

本操作因为要把整个磁阵的容量都放在一个目录下使用,所以只配置一个分区。

[root@ftpnode2 ~]# fdisk /dev/sdbDevice contains neither a valid DOS partition table, nor Sun, SGI or OSF disklabelBuilding a new DOS disklabel. Changes will remain in memory only,until you decide to write them. After that, of course, the previouscontent won't be recoverable.The number of cylinders for this disk is set to 218445.There is nothing wrong with that, but this is larger than 1024,and could in certain setups cause problems with:1) software that runs at boot time (e.g., old versions of LILO)2) booting and partitioning software from other OSs(e.g., DOS FDISK, OS/2 FDISK)Warning: invalid flag 0x0000 of partition table 4 will be corrected by w(rite)Command (m for help): mCommand actiona toggle a bootable flagb edit bsd disklabelc toggle the dos compatibility flagd delete a partitionl list known partition typesm print this menun add a new partitiono create a new empty DOS partition tablep print the partition tableq quit without saving changess create a new empty Sun disklabelt change a partition's system idu change display/entry unitsv verify the partition tablew write table to disk and exitx extra functionality (experts only)Command (m for help): nCommand actione extendedp primary partition (1-4)pPartition number (1-4):First cylinder (1-218445, default 1): 1Last cylinder or +size or +sizeM or +sizeK (1-218445, default 218445): 200000Command (m for help): pDisk /dev/sdb: 1796.7 GB, 1796776919040 bytes255 heads, 63 sectors/track, 218445 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 200000 1606499968+ 83 LinuxCommand (m for help): wThe partition table has been altered!Calling ioctl() to re-read partition table.Syncing disks.[root@ftpnode2 ~]#分区后的检查:[root@ftpnode2 ~]# fdisk -lDisk /dev/sda: 146.6 GB, 146685296640 bytes255 heads, 63 sectors/track, 17833 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sda1 * 1 13 104391 83 Linux/dev/sda2 14 17833 143139150 8e Linux LVMDisk /dev/sdb: 1796.7 GB, 1796776919040 bytes255 heads, 63 sectors/track, 218445 cylindersUnits = cylinders of 16065 * 512 = 8225280 bytesDevice Boot Start End Blocks Id System/dev/sdb1 1 200000 1606499968+ 83 Linux[root@ftpnode2 ~]#磁阵/dev/sdb的分区已经完成,分区设备名为/dev/sdb1,容量为1800GB。

(2)分区格式化linux用于文件/目录读写的文件系统均为ext3的格式/类型,将分区/dev/sdb1用下面的命令格式化为ext3的文件系统格式:[root@ftpnode2 ~]# mkfs.ext3 /dev/sdb1mke2fs 1.35 (28-Feb-2004)Filesystem label=OS type: LinuxBlock size=4096 (log=2)Fragment size=4096 (log=2)200818688 inodes, 401624992 blocks20081249 blocks (5.00%) reserved for the super userFirst data block=0Maximum filesystem blocks=40265318412257 block groups32768 blocks per group, 32768 fragments per group16384 inodes per groupSuperblock backups stored on blocks:32768, 98304, 163840, 229376, 294912, 819200, 884736, 1605632, 2654208,4096000, 7962624, 11239424, 20480000, 23887872, 71663616, 78675968,102400000, 214990848Writing inode tables: doneCreating journal (8192 blocks): doneWriting superblocks and filesystem accounting information: doneThis filesystem will be automatically checked every 29 mounts or180 days, whichever comes first. Use tune2fs -c or -i to override.[root@ftpnode2 ~]#注:上述格式化未使用任何参数,均为默认值。

如果需要根据该磁阵实际存储对象进行优化的话,可使用相关参数让磁阵容量的利用最大化。

(3)文件系统挂载到某一目录挂载/dev/sdb1前,文件系统的检查:[root@ftpnode2 ~]# df -kFilesystem1K-blocks Used Available Use% Mounted on/dev/mapper/V olGroup00-LogV ol00138851328 3172424 128625592 3% / /dev/sda1 101086 13522 82345 15% /bootnone 517164 0 517164 0% /dev/shm[root@ftpnode2 ~]#将/dev/sdb1挂载到/unicom目录:[root@ftpnode2 ~]#mount /dev/sdb1 /unicom[root@ftpnode2 ~]#挂载/dev/sdb1后,文件系统的检查:[root@ftpnode2 ~]# df -kFilesystem 1K-blocks Used Available Use% Mounted on/dev/mapper/V olGroup00-LogV ol00138851328 3172424 128625592 3% //dev/sda1 101086 13522 82345 15% /bootnone 517164 0 517164 0% /dev/shm/dev/sdb1 1581292204 110656 1500856552 1% /unicom[root@ftpnode2 ~]#挂载后测试一下读/写/删除操作:cd /unicomdate > testcat ./testrm ./test最后,为了在系统重启后磁阵能够自动挂载,需在/etc/fstab 文件中增加一个条目,即该文件中的/dev/sdb1这一行。