信息的度量

信息的度量

3.1 具有概率特性的信息

以具有概率特性的反导弹知识为例, 为有效指挥控制反导作战, 对来袭导弹 的到达率搜集信息并处理, 获得所需信息(知识, 如来袭导弹到达率),以得到最有 效作战决策。广义的信息包括知识, 知识是信息的高级发展。假设导弹防御决策 所需的相对知识为在j 时间段单位时间内来袭导弹的到达比例, 需求其熵和知识 量。 设x 为在j 时间段单位时间内来袭导弹的比例,即x= h/q。 其中, h为j时间段单 位时间内来袭导弹到达的数量; q为在j - 1时间段来袭导弹的剩余量,x 为随机变 量。x 的熵H ( x )表明x 的信息量。在信息论中x 的熵(单位: 奈特)表示为:

3.2 非各态历经过程特性的信息语用学度量

非各态历经过程特性的信息语用学计量与按采样定理的采样函数值xi ( t ) 的价值和效用内容有关。设非各态历经过程特性的信息价值和效用可能性为Q (x), 则非各态历经过程特性的信息采样的语用学度量信息量为:

I lbQ x lb1

N

Qx

换算法, 计算带宽Δ f。按采样间隔h= 1 / ( 2Δf )进行采样(采样定理)。可得采样 数N = 2ΔfT。可以证明, N = 2ΔfT 是过程时间函数x ( t)最多的独立符号数。可 推算上述3种过程特性的信息采样序列中每个采样的语法信息量为:

F k

2

I - lb1

2fT lb2fT lbN

N

( 9)

其中, Rxi 1 , R (x )与Δf , T, 采样次序以及语义内容有关。非各态历经过程

i 1

特性的信息采样序列的总信息量为: I= N lb1 /R (x ) ( 10)

3.信息的语用学度量(P ragmatics measure ofinformation)

1.4 信息及其度量

I = log

P(x) = - loga

1.4 信息及其度量

二、度量信息量的方法

I = log

1 p(x) a P(x) = - loga

a=2—比特(bit);

a=e—奈特(nat);

a=10—哈特莱(Det);

1.4 信息及其度量

二、度量信息量的方法

1、离散消息

P(x ) 1)信源每个符号的自信息量;I(xi ) = - log2 i(bit)

越不可能发生的 事件,带来的信 息量越大!

例:

1.4 信息及其度量

二、度量信息量的方法

信息量是概率P(x)的函数; I=f[P(x)] P(x)越小,I越大; P(x)→1时, I→0 P(x)→0时, I→∞

若干个互相独立事件构成的消息,信息具有相加性;

I[P(x1)P(x2)…]=I[P(x1)]+I[P(x2)]+…

1.4 信息及其度量

信息是消息的内涵(有效内容,不确定性); 通信的目的:传输消息中所包含的信息; 信息量—对消息中内容的不确定性的定量描述;

1.4 信息及其度量

一、度量信息量的原则

能度量任何消息,与消息的种类无关;

度量方法与消息的重要程度无关; 消息中所含的信息量与消息中内容的不确定性有关;

I总 23I0 14I1 13I 2 7I3 108(bit)

利用熵的概念来计算: H 1.906 (b/符号)

I总 57 H 57 1 906 108.64(bit)

评注

1.4 信息及其度量

2、连续消息

1 f (x) a

信息的度量

How to measure Information?

信息论基础

本章内容

• 信息及其度量

• 平均信息量-熵

• 通过信道的平均信息量-互信息量 • 信息不增原理 • 各种信息量之间的关系 • 连续随机变量的信息度量

参考书:沈振元等,“通信系统原理”,第11章(PP412-437)

戴善荣, “信息论与编码基础”, 第2章

p ( xi , yj ) p ( xi / yj ) = p ( yj ) p ( xi , yj ) p ( yj / xi ) = p ( xi )

3 联合自信息量和条件自信息量 设输入和输出都可以用离散概率空间来表示:

X = {A, P},其中A={ai}; Y = {B, Q}, 其中B={bj}

Y y1 , y 2 , , y j , P(Y ) = p( y ), p( y ), , p( y ), 2 j 1

这里p(yj)(j=1,2,3等)是集合Y中各个消息 y1,y2 ,y3 …出现的概率。

收信者获得的信息量

当信宿接到集合Y中的一个消息符号后,接收 者重新估计关于信源的各个消息 发生的概率 就变成条件概率,这种条件概率又称为后验概 率。 收信者收到一个消息后,所获得的信息量等 于收到消息前后不确定程度的减少量。

i n n 1 1 pi) ln 2 = 0, ( n = 1, pi = 1) i =1 i =1

n 1 1 p( 1) = ( i i =1 p n ln 2 i=1 n

1

i

故有H ( x ) H 0 0,即等概时有最大熵

例

一个二进制信元X,两个符号出现的概率分别为p和1-p,

信息论——信息的度量

信息论——信息的度量信息的度量 信息具可度量性,其⼤⼩取决于信息所消除的不确定性 举例如下: 消息A:中国⼥⼦乒乓球队夺取亚运会冠军。

消息B:中国男⼦⾜球队夺取世界杯赛冠军。

从事件的描述上来看,其主题内容⼤致相同,那么我们是否可以认为事件A和事件B具有相同的信息量呢?显然是不⾏的。

根据以往经验,我们可以认为事件A是⼀个⼤概率事件,所以事件A的不确定性⽐较⼩,故当事件A发⽣时,我们从这个消息中得到的信息(消除的不确定度)很⼩。

同理对事件B⽽⾔,由于是个极⼩概率事件,我们得到的信息很⼤。

由此我们可以推断:消息B的信息量⼤于消息A。

对于⼀个事件X,我们假设其不确定性为 I(p1) ,其中 p1 是事件X的先验概率。

对应于事件X的消息X所消除的不确定性为 I(p2)。

那么在我们获取了消息X之后,事件X的不确定性就变为了 I(p1)-I(p2) ,由此我们可以知道当我们对⼀个事物的信息获取的越多,其不确定性就越⼩,当其不确定性变为0时,该事件就被确定下来了,我们对其⽆法再获取更多的信息量了。

直观定义: 收到某消息获取的信息量=不确定性减少量=收到该消息前后某事件的不确定性差信息量的数学表⽰ 理论依据(信息量具有的性质): 1.⾮负性对于⼀个事件⽽⾔,当事件被完全确定时,即我们⽆法获取更多信息时,其信息量为0,因此⽆法⽐0更⼩。

2.单调性是先验概率的单调递减函数,即某事件的发⽣概率越⼤,其信息量就越⼩。

3.对于事件A 若 P(a)=0 则 I(Pa)=+∞ 若 P(a)=1 则 I(Pa)=0。

4.两个独⽴事件的联合信息量应等于它们分别的信息量之和。

I(xi)具有两个含义: 1.事件发⽣前,表⽰该事件发⽣的不确定性。

2.事件发⽣后,表⽰该事件所提供的信息量。

术语解释 先验概率(prior probability)是指根据以往经验和分析得到的概率。

信息量的度量

信息量的计算

接着可以计算系统B所包含的关于系统A即篮球 水平高的信息量,由公式可知:

可以计算系统B所包含的关于系统A篮球水平不高 的信息量,由公式可知:

6

信息量的计算

一分球(B1)关于篮球水平(A)的信息量为:

二分球(B2)关于篮球水平(A)的信息量为:

三分球(B3)关于篮球水平(A)的信息量为:

再通过调用函数fft(y);psd(y);rcep (y)对该振动信号进行频域内的性能分析。

12

幅度

振动信号的时域波形

振动信号的时域波形 8 6 4 2 0 -2 -4 -6 -8

0 0.2 0.4 0.6 0.8 1 1.2 1.4 1.6 1.8 2 时 间 /秒

从拟合的时域波形图中可以看到振动波形有逐 渐衰减的趋势。

14

振动信号的功率谱

振动信号的功率谱 40

30

Power Spectrum Magnitude (dB)

20

10

0

-10

-20

-30 0

50 100 150 200 250 300 350 400 450 500

Frequency

功率谱的意义在于它可以对信号中的周期成分进行分

析,上图绘制的是具有95%置信区间的功率谱密度,由上

图可知系统中存在着100Hz和250Hz的周期成分,若是在

实际的系统中可以根据周期成分结合故障的特征频率来确

定故障的类型。

15

振动信号的倒谱

振动信号的倒谱 3

2.5

2

1.5

幅 度 /dB

1

0.5

0

-0.5

0

500

1000

1500

第1章 基本概念6(信息的度量和香浓公式)

1.8 多路复用

波分复用WDM

光通信中的复用技术,原理同FDM

24

1.8 多路复用

图1-19 三种复用示意图

时间 1 23 4

FD M

频率

时间

4

3 2 1

TD M

频率

时间

1234

CDM 频 率

码型

25

1.10 通信系统的性能评价

主要性能指标

有效性 可靠性

27

模拟通信系统的主要性能指标

17

1.8 多路复用

物理信道与逻辑信道

物理信道:指信号通过的通信设备和传 输介质。

逻辑信道:一个物理信道中传输一路信 号的通道。如一个频段、一个时隙等。

18

1.8 多路复用

多路复用的概念

多路复用:在一个物理信道中,利用特 殊技术传输多路信号,即在一条物理信 道中产生多条逻辑信道。

… …

n路 信号 输入

复 用

解 复 一 条物 理 信 道 用

n个 逻 辑 信 道

图1―18 多路复用示意图

n路 信号 输出

19

1.8 多路复用

频分复用FDM

通过调制技术将多路信号分别调制到频 谱互不重叠的频带上,同时传输的一种 多路复用方式。

信号时间上重叠,频谱互不重叠

20

1.8 多路复用

时分复用TDM

通过脉冲调制等技术将多路信号分时在 信道上传输的一种多路复用方式。

香农公式

C Blb(1 S ) (bit/s) N

式中,C 为信道容量(bit / s或b/s) B 为信道带宽(Hz) S/N 是系统的输出信噪比

11

1.7 信息量与香农公式

例子

若一帧电视图像的信息量为99600bit, 电视的帧频为30Hz,为使接收端收到良 好的图像,要求信道的信噪比S/N=1000, 10lgS/N=30dB,求信道的带宽B。

第1章 信源模型及信息的度量

6

二元联合信源

有两个信源X,Y

, an a2 , X a1 , P ( x) P (a ), P (a ), , P (a ) n 1 2

, bm b2 , Y b1 , P ( y ) P (b ), P (b ), , P(b ) 1 m 2

, aq a2 , X a1, P ( x) P (a ), P (a ), , P (a ) q 1 2

例:

a2 a1 P ( ) 0.01 0.99

b1 b2 P ( ) 0 .4 0 .6

可பைடு நூலகம்性公理:

两个消息独立,则 I (ai , b j ) I (ai ) I (b j ) 对同一条消息,观察两次所得到的信息量等 于两次分别收到的信息量之和

I (ai ; b j ck ) I (ai ; b j ) I (ai ; ck / b j )

例题

说明信息论在我们日常生活中的指导意义

P(X): p

1. p=0.5时; H(X)=-0.5log0.5+(-0.5log0.5)=1 bit/符号 2. p=0.99,1-p=0.01时;

H(X)=-0.99log0.99+(-0.01 log0.01)=0 .08bit/符号

3. p=0,1-p=1(或p=1,1-p=0)时; H(X)=-0log0+(-1 log1)=0 bit/符号

XY——样本值共有 m n 个

p ( x i y j ) p ( y j ) p ( xi / y j ) p ( x i ) p ( y j / x i )

信息论与编码第二章答案

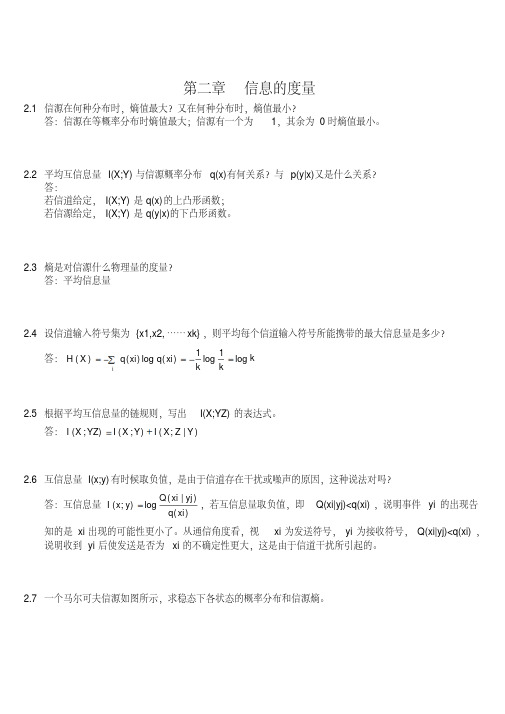

第二章信息的度量2.1信源在何种分布时,熵值最大?又在何种分布时,熵值最小?答:信源在等概率分布时熵值最大;信源有一个为1,其余为0时熵值最小。

2.2平均互信息量I(X;Y)与信源概率分布q(x)有何关系?与p(y|x)又是什么关系?答:若信道给定,I(X;Y)是q(x)的上凸形函数;若信源给定,I(X;Y)是q(y|x)的下凸形函数。

2.3熵是对信源什么物理量的度量?答:平均信息量2.4设信道输入符号集为{x1,x2,……xk},则平均每个信道输入符号所能携带的最大信息量是多少?答:kk k xi q xi q X H i log 1log 1)(log )()(2.5根据平均互信息量的链规则,写出I(X;YZ)的表达式。

答:)|;();();(Y Z X I Y X I YZ X I 2.6互信息量I(x;y)有时候取负值,是由于信道存在干扰或噪声的原因,这种说法对吗?答:互信息量)()|(log );(xi q yj xi Q y x I ,若互信息量取负值,即Q(xi|yj)<q(xi),说明事件yi 的出现告知的是xi 出现的可能性更小了。

从通信角度看,视xi 为发送符号,yi 为接收符号,Q(xi|yj)<q(xi),说明收到yi 后使发送是否为xi 的不确定性更大,这是由于信道干扰所引起的。

2.7一个马尔可夫信源如图所示,求稳态下各状态的概率分布和信源熵。

答:由图示可知:43)|(41)|(32)|(31)|(41)|(43)|(222111110201s x p s x p s x p s x p s x p s x p 即:43)|(0)|(41)|(31)|(32)|(0)|(0)|(41)|(43)|(222120121110020100s s p s s p s s p s s p s s p s s p s s p s s p s s p 可得:1)()()()(43)(31)()(31)(41)()(41)(43)(210212101200s p s p s p s p s p s p s p s p s p s p s p s p得:114)(113)(114)(210s p s p s p )]|(log )|()|(log )|()[()]|(log )|()|(log )|()[()]|(log )|()|(log )|()[(222220202121211111010100000s s p s s p s s p s s p s p s s p s s p s s p s s p s p s s p s s p s s p s s p s p H 0.25(bit/符号)2.8一个马尔可夫信源,已知:0)2|2(,1)2|1(,31)1|2(,32)1|1(x x p x x p x x p x x p 试画出它的香农线图,并求出信源熵。

- 1、下载文档前请自行甄别文档内容的完整性,平台不提供额外的编辑、内容补充、找答案等附加服务。

- 2、"仅部分预览"的文档,不可在线预览部分如存在完整性等问题,可反馈申请退款(可完整预览的文档不适用该条件!)。

- 3、如文档侵犯您的权益,请联系客服反馈,我们会尽快为您处理(人工客服工作时间:9:00-18:30)。

东南大学移动通信国家重点实验室

4

信息论与编码课件

2.1 度量信息的基本思路

2.1.1单符号离散信源

➢ 单符号离散信源的实例 ✓ 掷骰子每次只能是1,2,3,4,5,6中的某一个; ✓ 天气预报可能是晴、阴、雨、雪、风、冰雹…

中的一种或其组合以及温度、污染等;

✓ 二进制通信中传输的只是1、0两个数字;等等。

2.1.2度量信息的基本思路

➢例2.1 一个, 0等概的二进制随机序列,求任一 码元的自信息量。

解:任一码元不是为0就是为1 因为 P(0) = P(1) = 1/2 所以 I (0) = I (1) = – lb (1/2) = 1(bit)

✓ 例如,假设天气预报中的天气及温度变化是与污染程 度相关性很小甚至几乎完全独立的,则信源的每一个 输出就能分成独立的两部分。

➢ 直观地,传递xi所包含的信息量是分别传递xi1 和xi2所得到的信息量的和。

东南大学移动通信国家重点实验室

8

信息论与编码课件

2.1 度量信息的基本思路

2.1.2度量信息的基本思路

➢ 信源空间通常用如下方式来描述:

X: [X P]: P(X) :

x1 , P( x1 ),

x2 , , xi , , P(x2 ), , P(xi ),

,

➢显然,信源空间必定是一个完备集,即

N

P(xi ) 1 i 1

xN

P(xN ) (2.1) (2.2)

东南大学移动通信国家重点实验室

1 P( xi

)

lb P( xi

)

为事件xi的自信息量。

(2.3)

东南大学移动通信国家重点实验室

11

信息论与编码课件

2.1 度量信息的基本思路

2.1.2度量信息的基本思路

➢ I(xi)实质上是无量纲的 ➢ 为研究问题的方便,根据对数的底定义信息量的量纲

✓ 对数的底取2,则信息量的单位为比特(bit); ✓ 取e(自然对数),则单位为奈特(nat); ✓ 取10(常用对数),则单位为哈特。 ✓ 利用换底公式容易求得:

1nat1.44bit

1Hart3.32bit

➢ 在通信及目前的绝大多数信息传输系统中,都是以二 进制为基础的,因此信息量单位以比特最为常用

➢ 在没有特别说明的情况下,通常(2.3)式的量纲即为比 特,且底数2被省略。

东南大学移动通信国家重点实验室

12

信息论与编码课件

2.1 度量信息的基本思路

信息论与编码课件

东南大学移动通信国家重点实验室

1

信息论与编码课件

第2章 信息的度量

➢信息论的发展是以信息可以度量为基础 的,度量信息的量称为信息量。

➢对于随机出现的事件,它的出现会给人 们带来多大的信息量?

➢考虑到通信系统或很多实际的信息传输 系统,对于所传输的消息如何用信息量 的方法来描述?

➢本章将围绕这些问题展开讨论。

6

信息论与编码课件

2.1 度量信息的基本思路

2.1.2度量信息的基本思路

➢ 考虑一个单符号离散信源,它的输出被传送给对此感 兴趣的一方。

➢ 设x1为最大可能的输出,xN为最小可能的输出。 ✓ 例气如,x,N为假冰设雹信或源其输它出强代对表流天天气气情。况,x1为晴或多云天 ✓ 哪个输出包含更多的信息,x1还是xN? ✓ 直观地,传递xN 给出了更多的信息。 ➢ 由此可以合理地推算信源输出的信息量应该是输出事

东南大学移动通信国家重点实验室

2

信息论与编码课件

2.1 度量信息的基本思路

2.1.1单符号离散信源

➢ 从讨论信源的特征入手,给出定量度量信息 的方法。

➢ 以天文学范畴的事件为例。

✓ 小行星撞击地球、月食、日食、流星雨、星系的产生 与消亡等等,都是天文学内一个个离散的事件

✓ 如果将一个事件用一个符号来表示,则一个符号代表 一个完整的消息

✓ 如果把都是天文学内的事件看作是天文学这个“信源” 输出的符号,则这个信源可以看作是单符号离散信源。

东南大学移动通信国家重点实验室

3

信息论与编码课件

2.1 度量信息的基本思路

2.1.1单符号离散信源

➢由此给出如下定义: • 定义2.1

如果信源发出的消息是离散的、有限 或无限可列的符号或数字,且一个符号 代表一条完整的消息,则称这种信源为 单符号离散信源。

➢ 这种符号或数字都可以看作某一集合中的事件, 每个符号或数字(事件)都是信源中的元素, 它们的出现往往具有一定的概率。

➢ 因此,信源又可以看作是具有一定概率分布的 某一符号集合。

东南大学移动通信国家重点实验室

5

信息论与编码课件

2.1 度量信息的基本思路

2.1.1单符号离散信源

• 定义2.2

若信源的输出是随机事件X,其出现概率为P(X),,则它 们所构成的集合,称为信源的概率空间或简称为信源空 间。

X中出现xi、Y中出现yj的联合信息量 I (xi ,yj) = I (x i) + I (yj)

➢ 只有对数函数能够同时满足以上条件。

东南大学移动通信国家重点实验室

10

信息论与编码课件

2.1 度量信息的基本思路

2.1.2度量信息的基本思路

➢定义2.3

事件xi的出现所带来的信息量

I (xi

)

lb

件的概率的减函数。 ➢ 信息量的另一个直观属性是,某一输出事件的概率的

微小变化不会很大地改变所传递的信息量,即信息量 应该是信源输出事件概率的连续减函数。

东南大学移动通信国家重点实验室

7

信息论与编码课件

2.1 度量信息的基本思路

2.1.2度量信息的基本思路

➢ 假设与输出xi相关的信息能被分成独立的两部 分,比如xi1与xi2,即xi = { xi1,xi2 }。

➢ 若信源中事件xi的出现所带来的信息量用 I(xi)来表示并称之为事件xi的自信息量,

➢ 则概率为p(xi)的信源输出xi所包含的信息 量I(xi)必须满足以下几个条件:

东南大学移动通信国家重点实验室

9

信息论与编码课件

2.1 度量信息的基本思路

2.1.2度量信息的基本思路

1. 信的源取输值出无x关i所。包含的信息量仅依赖于它的概率,而与它 2. I (xi)是P(xi)的连续函数。 3. I (xi)是P(xi)的减函数,即: ✓ 如果P(xi) > P(xj),则I(xi) < I(xj)。 ✓ 极限情况,若P(xi) = 0, 则 I(xi) → ∞; ✓ 若 P(xi) = 1, 则I(xi) = 0。 4.若两个单符号离散信源(符号集合X, Y )统计独立, 则